Contenuto, analisi del

Contenuto, analisi del

1. Definizione

La locuzione 'analisi del contenuto' copre un vasto campo di procedure metodologiche che hanno il fine di tracciare con rigore un sintetico profilo di grandi quantità di testi e di altri tipi di comunicazione, da particolari punti di vista, vale a dire avendo in mente una serie di interrogativi specifici.

Si possono indicare, a titolo di esempio, varie domande, alcune molto ampie, altre molto limitate, le risposte alle quali possono essere ottenute mediante l'utilizzo di procedure di analisi del contenuto: qual è l'immagine del ruolo della donna nei telefilm prodotti in certi anni da certe emittenti televisive? Qual è stato l'atteggiamento prevalente di un determinato quotidiano italiano nei confronti del terrorismo negli anni 1975-1980? Quali sono i personaggi politici che compaiono con maggiore frequenza nei servizi giornalistici di un particolare canale televisivo?

I tipi di domande cui è ragionevole rispondere con particolari tecniche analitiche sono, ovviamente, altrettanto problematici dei tipi di scomposizione analitica cui è ragionevole sottoporre un corpo di comunicazione. È importante non nutrire un'illimitata fiducia nell'analisi del contenuto, ma è altrettanto importante non soggiacere al pregiudizio 'umanistico' di coloro che considerano inadeguata qualsiasi procedura analitica e quantitativa ai fini della comprensione di un testo. La discussione di questi rischi contrapposti può utilmente cominciare da una riflessione critica sulla definizione classica di 'analisi del contenuto' formulata da Bernard Berelson (v., 1952, p. 18). Secondo questo autore, la content analysis (il termine inglese è di uso corrente anche in Italia proprio per indicare una metodologia di ricerca nata e sviluppatasi nelle scienze sociali nordamericane) "è una tecnica per la descrizione obiettiva, sistematica e quantitativa del contenuto manifesto della comunicazione". Quasi tutti i termini di questa definizione, nata - come vedremo - nel contesto della scuola di H. Lasswell e da esso fortemente influenzata, possono essere messi in discussione e riformulati.

1. È oggi ben difficile parlare dell'analisi del contenuto come di una tecnica di ricerca e non piuttosto come di un insieme di tecniche di ricerca, spesso molto diverse tra di loro se non concorrenti e perfino contraddittorie. Poiché non esiste attualmente nessuna scuola egemone che organizzi le pratiche di osservazione sistematica di testi e di altri tipi di comunicazione, da alcuni decenni proliferano modelli di analisi non solo, come sempre accade, sul versante che potremmo chiamare artigianale (tecniche ad hoc costruite su specifici e occasionali progetti di ricerca), ma anche sul versante delle formalizzazioni teoriche che pretendono di avere validità generale.

2. Appare problematico lo stesso termine 'descrizione': non solo la riflessione epistemologica ha via via reso generalmente deboli le pretese di pura descrizione, ma la stessa semiotica ha mostrato per via empirica, oltre che per via di deduzioni teoriche, il carattere non univoco, quando non equivoco, della maggior parte degli atti comunicativi. La ricezione di un atto comunicativo, sia che dia luogo soltanto a una rappresentazione mentale, sia che stimoli nuove rappresentazioni simboliche come risposte o come interpretazioni, implica operazioni di selezione e di ricollocazione in nuovi contesti. Ciò, tuttavia, non conduce a quella forma di relativismo che potremmo chiamare ermeneutico, fondato sull'idea che non si possa distinguere tra "lettura adeguata" e "lettura non adeguata" (come sostiene Betti - v., 1955 - nella sua discussione su Gadamer, che del resto è relativa a un concetto più ampio di interpretazione), bensì postula una pratica inesauribilità delle letture adeguate. Ciò significa, in termini più vicini all'analisi del contenuto, che qualsiasi operazione che suddivida un insieme simbolico di elementi, classifichi questi ultimi nell'ambito di modalità di variabili e ne calcoli la numerosità entro ogni classe, nonché misuri le relazioni tra variabili, non potrà essere considerata come una sorta di riformulazione sintetica dell'insieme originario, bensì soltanto come una selezione più o meno corretta di aspetti e di dimensioni.

3. Ne deriva la necessità di precisare e riformulare il fine dell''obiettività', che non può consistere nella riproduzione dell'oggetto analizzato, bensì soltanto, come vedremo, nell'adozione di procedure di analisi che siano, in linea di principio, ripetibili e standardizzabili. Ciò significa anche che se possiamo pretendere che l'analisi di un testo sia obiettiva, non possiamo tuttavia pretendere che venga in tal modo eliminata la possibilità di altre analisi obiettive non contraddittorie, proprio come è possibile una 'lettura' corretta senza che vengano escluse altre letture corrette. Come in altri ambiti metodologici, anche nell'analisi del contenuto il problema dell'obiettività, anziché essere lasciato al senso comune - come tende a fare lo stesso Berelson - deve essere posto in termini di rapporto tra ipotesi e procedure di analisi.

4. È molto frequente che il lavoro scientifico venga qualificato come 'sistematico'; non è sempre chiaro tuttavia - e non lo è neppure in Berelson - cosa si intenda per 'sistematico'. Possiamo escludere che Berelson si riferisca alla necessità di collegare l'analisi a qualche teoria generale; egli sottolinea, più semplicemente, la regola di non percorrere in modo spontaneo l'insieme simbolico in analisi, ma di indagarlo alla luce di una problematica ben definita e con procedure classificatorie unidimensionali e logicamente 'complete'.

5. L'analisi del contenuto si distingue da altri modi di indagine su testi o su altri insiemi simbolici proprio perché l'adozione di ipotesi definite e di procedure analitiche rigorose permette normalmente di ottenere distribuzioni trattabili statisticamente. Ciò non esclude l'indagine su un insieme limitato (ad esempio poche poesie o poche interviste narrative), dove l'aspetto quantitativo possa restare per così dire implicito, sostituito più che adeguatamente da espressioni approssimative come 'molti', 'pochi' o 'quasi nessuno', ecc., e addirittura, come nei collages, sostituito da semplici elencazioni di esempi. Definendo l'analisi del contenuto come necessariamente quantitativa, Berelson avrebbe forzato gli orientamenti dello stesso insegnamento di Lasswell, il quale apprezzava molto, ad esempio, una ricerca pionieristica come quella di G. C. Thompson (Public opinion and Lord Beaconsfield, 1875-1880, pubblicata nel 1886), dove l'indagine su molti e svariati documenti inglesi del periodo della guerra russo-ottomana era condotta senza fare uso alcuno di tecniche statistiche. Lasswell riteneva rigorose e pertinenti le categorie entro le quali il materiale era stato classificato e considerava del tutto legittima la forma del racconto mediante collage; criticava soltanto il fatto che l'autore non avesse esplicitato i criteri di selezione con i quali aveva scelto gli elenchi di citazioni e parafrasi. Si deve comunque concludere, a difesa dell'orientamento decisamente quantitativo di Berelson, che, di fronte a corpi di comunicazione che in questo settore di studi sono normalmente molto grandi, è difficile costruire analisi convincenti dei dati senza ricorrere alle forme ordinate e sintetiche del trattamento statistico.

6. La decisione di Berelson di confinare l'analisi del contenuto entro lo studio del contenuto manifesto è anch'essa discutibile. La restrizione al contenuto manifesto sarebbe da rifiutare se in tal modo si volesse escludere la possibilità di individuare associazioni inconsce e modelli mentali semiconsci o preconsci; del resto, sia in direzione dell'inconscio, sia in direzione del preconscio, non mancano interessanti tentativi di analisi del contenuto (ad esempio, v. Hauld e Murray, 1955; v. Mahl, 1959; v. Scheidmann, 1969). Tuttavia, la limitazione al contenuto manifesto può risultare plausibile in altro senso: se all'analisi del contenuto si richiede di adottare procedure analitiche ripetibili o standardizzabili, è opportuno che le regole di classificazione non presentino un grado così elevato di complessità e di incertezza da generare applicazioni casuali. È bene, invece, che si fondino su indicatori chiaramente definiti e facilmente riconoscibili a livello della competenza analitica richiesta. I criteri con cui isolare le unità da classificare e con cui attribuire un'unità a una classe o a una categoria devono quindi fondarsi su segni 'manifesti'. In questo senso, l'analisi del contenuto riduce l'arbitrio interpretativo in sede di rilevazione dei dati, non incentiva esplorazioni raffinate ma scarsamente documentabili e resta dunque una procedura d'indagine molto diversa dall'analisi ermeneutica.

7. Infine, può essere messa in discussione la stessa locuzione di content analysis, la cui fortuna risale soprattutto a Harold Lasswell e Nathan Leites (v., 1949). Si tratta di una locuzione che ha trovato e trova alcune difficoltà a essere tradotta letteralmente e utilizzata in contesti culturali e scientifici che hanno sviluppato una sensibilità raffinata nello studio dei fatti comunicativi. Così, in Germania, è sorta qualche controversia sull'uso del termine Inhaltanalyse, al quale si vorrebbe sostituire il termine Aussagenanalyse, proprio per non trascurare in linea di principio gli aspetti formali della comunicazione (v. Maletzke, 1963); così, in Francia, dove ancora nel 1961 Duverger annotava la rarità dei lavori di analyse du contenu, si preferiscono oggi locuzioni molto più specifiche, come analyse des données textuelles, analyse lexicale, oppure analyse propositionnelle du discours, sempre con esplicite prese di distanza dalla locuzione lasswelliana; in Italia, infine, quasi soltanto i sociologi continuano a parlare di 'analisi del contenuto', un'espressione che per vari motivi sembra a molti troppo semplice, quando non rozza.

Tuttavia è forse meglio mettere da parte le discussioni terminologiche troppo raffinate. Infatti, da un lato risulta utile raccogliere sotto uno stesso termine, che sia nello stesso tempo semplice e generale, un'ampia famiglia di procedure di analisi di insiemi simbolici (non solo testuali), in quanto i prestiti fra queste diverse procedure si sono rivelati spesso molto proficui; dall'altro lato, il termine 'contenuto' non deve necessariamente indurre a preconcette esclusioni di parti rilevanti della comunicazione. A partire da Saussure, infatti, il termine 'contenuto' non si pone propriamente in contrapposizione con il termine 'forma', bensì con il termine 'espressione', o 'ambito fonico', o, più in generale, 'ambito dei significanti'. Con il termine 'analisi del contenuto' si esclude pertanto soltanto quel tipo di studi, peraltro legittimo, che tende a cogliere sul piano dei significanti materiali (suoni, lettere, ecc.) processi di significazione autonomi rispetto alla relazione codificata tra significanti e significati, sulla scia di alcune classiche analisi freudiane (per una rassegna dei presupposti di questo tipo di studi v. Farassino, 1974), oppure dell'originale analisi letteraria avviata da Jakobson e da Lévi-Strauss (v. Vidal Beneyto, 1981). L'analisi del contenuto esclude dunque soltanto una piccola e particolare regione del vasto campo degli eventi comunicativi.

Possiamo quindi concludere questa discussione critica dell'impostazione di Berelson definendo l'analisi del contenuto come un insieme di procedure di scomposizione analitica e di classificazione dei testi e di altri insiemi simbolici, orientate al controllo empirico di determinate ipotesi su elementi della comunicazione (emittenti, messaggi, destinatari e loro relazioni).

2. Le pratiche di analisi del contenuto: cenni storici

A partire dagli anni sessanta sono state avanzate, soprattutto in Europa, numerose critiche radicali alle pratiche di analisi del contenuto più comuni, caratterizzate da conteggi di frequenza su determinate parole-chiave o su reti sinonimiche e parasinonimiche di parole-chiave o su temi individuati a livello di senso complessivo. Queste critiche sono nate perlopiù in contesti disciplinari linguistici o di semiotica e hanno riguardato, in concreto, una tradizione di ricerche che era diventata tipica della sociologia delle comunicazioni di massa.

La polemica contro l'analisi del contenuto ha inteso in genere sottolineare la complessità e la non trasparenza dei fatti comunicativi, pluridimensionali sia a livello di senso (si pensi, ad esempio, al gioco sottile che in molti messaggi si instaura tra livello denotativo e livello connotativo: v. Barthes, 1964), sia a livello di situazione pragmatica, dove un processo di comunicazione si svolge normalmente attraverso codici multipli (lingua, idioletti, mimica, intonazione) ed è attraversato da continui feedbacks tra gli interlocutori. In proposito può sembrare davvero troppo generico il riferimento al contesto contenuto nel modello di Lasswell: "Chi dice che cosa a chi in quali condizioni e con quali effetti".

Ancorché utile, questa esaltazione della complessità comunicativa ha trascurato sistematicamente di porre in rilievo che, qui come per altri tipi di eventi sociali, l'indagine non può e non deve dar conto dell'intera complessità del proprio oggetto; deve anzi operare una riduzione drastica della complessità a favore di quegli elementi o di quegli aspetti che sono pertinenti o rilevanti rispetto alle specifiche ipotesi di ricerca (v. Rositi, 1982, pp. 117-130). Si prenda, ad esempio, un'indagine sugli editoriali dei quotidiani; essa sarebbe destinata al fallimento se pretendesse di costruire, con metodi statistici, una sorta di descrizione sintetica del loro contenuto complessivo e non volesse soltanto sottoporre a verifica una determinata ipotesi di rilievo teorico: ad esempio, per citare una ricerca italiana (v. Addario e Segatti, 1984), l'ipotesi che negli editoriali dell'organo dell'associazione degli industriali le asserzioni di tipo valoriale aumentano di frequenza quando il soggetto dell'azione è in posizione di forza, mentre in situazioni di conflitto a esito incerto prevalgono le asserzioni di tipo strategico-fattuale.

Molte pratiche 'ingenue' di analisi del contenuto rivelano, a ben guardare, operazioni ragionevoli di riduzione della complessità, dove ciò che è sottratto all'analisi è difficilmente considerabile come pertinente all'ipotesi in gioco. Certamente una migliore consapevolezza teorica della complessità dei fatti comunicativi potrebbe migliorare le concrete pratiche di analisi del contenuto, rendendo più avvertite e più chiare le opzioni di inclusione/esclusione; ma il pericolo opposto è quello che si incentivi un orientamento all'esplorazione esaustiva, sterile sul piano conoscitivo.

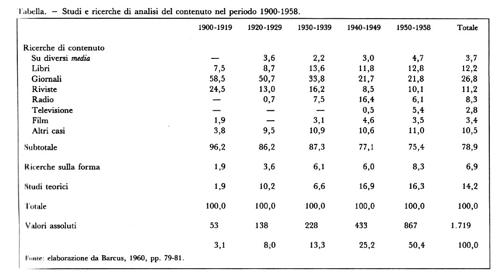

Si pongono inoltre problemi concreti di economia della ricerca. Come si vede dalla tabella, i metodi di analisi del contenuto si sono sviluppati, negli Stati Uniti, man mano che si sviluppavano i mezzi di comunicazione di massa, e hanno dunque risposto al bisogno crescente di sottoporre a indagine vaste quantità di materiale comunicativo: l'universo delle comunicazioni di massa ha ben presto superato le capacità osservative di qualsiasi singolo individuo, e perfino quelle di intere comunità di osservatori, imponendo il problema di nuove tecniche di organizzazione delle conoscenze.

Sebbene l'analisi del contenuto possa applicarsi con utilità anche a insiemi ristretti di comunicazioni, in quanto le operazioni automatiche di scomposizione analitica e di calcolo di frequenze e cofrequenze possono individuare relazioni inosservate da una lettura orientata al senso complessivo, resta vero che questa metodologia è volta prevalentemente a indagini estensive su grandi campioni di messaggi, che sono normalmente di scarso valore intrinseco, sia conoscitivo che estetico. È inevitabile ricorrere a una sorta di principio dell'utilità marginale: occorre incrementare la raffinatezza metodologica solo fino al punto in cui è possibile migliorare la significatività dei dati rispetto alle specifiche ipotesi della ricerca.

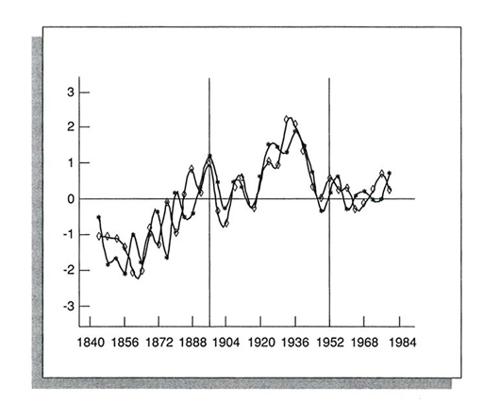

Come Janowitz e Schulze dissero con franchezza già nel 1961, metodi semplici hanno dato spesso in questo campo risultati più interessanti che complessi apparati di codifica e di elaborazione statistica. Ad esempio, può risultare ancor oggi istruttivo leggere la ricerca che Rudolf Arnheim condusse nel 1941 su 43 programmi radiofonici a puntate (per un totale di 596 unità) con un gruppo di analisti composto da 47 studenti universitari. Egli mise in evidenza una serie di aspetti assai significativi: elevata presenza, tra i personaggi, di liberi professionisti di classe media (non di classe superiore) e di casalinghe (mogli e fidanzate); forte accentuazione dei problemi derivanti dai rapporti personali (corteggiamento, matrimonio, famiglia, amicizie) e scarso peso dei problemi della sfera economica e tanto meno della sfera pubblico-politica; collocazione in primo piano del valore della responsabilità individuale; regola del lieto fine; ecc. Tali risultati, ottenuti con un metodo abbastanza semplice ma assai affidabile, furono molto importanti, perché da allora si incominciò a delineare, in contrapposizione all'immagine della cultura moderna come accozzaglia di disparati prodotti culturali, l'idea di una 'cultura di massa' come insieme coerente di valori e di credenze. I dati della figura, ad esempio, hanno senza dubbio importanza per una storia sociopolitica degli Stati Uniti: essi sono stati ottenuti misurando semplicemente la frequenza delle parole di significato 'economico' su tutte le parole usate nei programmi elettorali dei partiti repubblicano e democratico in più di cento anni di storia americana, ha ottenuto dei dati sicuramente importanti per una storia sociopolitica degli Stati Uniti: in un primo periodo, che grosso modo va fino al 1894, la tematizzazione economica cresce in entrambi i partiti, ma in modo alternato (se sale per i repubblicani decresce per i democratici, e viceversa); fra il 1895 e il 1934 la crescita è costante, e parallela per entrambi i partiti; dal 1935 al 1951 la frequenza misurata diminuisce per entrambi i partiti; dal 1952 a oggi la curva sembra stabilizzarsi, ma appare di nuovo il meccanismo dell'alternanza. Ovviamente esistono ricerche di analisi del contenuto che adottano modelli molto più complessi e ugualmente raggiungono buoni risultati; abbiamo fatto questi due esempi di procedure relativamente semplici solo per mostrare come un'apologia astratta della complessità metodologica sarebbe, in questo come in altri campi, comunque arbitraria. La conclusione sensata è che devono essere adottate le procedure analitiche più adeguate a ciò che si sta cercando.

Le proposte di modelli canonici per l'analisi del contenuto hanno avuto tutte vita breve e travagliata. Un tentativo in questa direzione fu quello di Lasswell negli anni quaranta, coronato dal trattato di Berelson (v., 1952). Oggi può sembrare che avanzino pretese di questo tipo, pur con quadri di riferimento teorici molti diversi, varie correnti francesi di linguistica a sfondo sociologico. In genere questi tentativi si riconoscono per l'uso di tipologie assiomatiche con pretese di validità universale, su cose come parole, concetti, stati di cose, azioni-tipologie, che in realtà denunciano, a ben guardare, soltanto i particolari fini conoscitivi dei loro autori (in quanti modi possono classificarsi le azioni? "in innumerevoli modi" avrebbe risposto il Wittgenstein delle Ricerche filosofiche). Ci si dovrebbe inoltre sincerare (avanziamo questa ipotesi senza argomentarla) che la proposta di modelli canonici non corrisponda in questo caso, come chiaramente accadeva in Lasswell, all'idea di poter ridurre la società alla sua componente comunicativa, e quindi al miraggio di poter trovare in questa componente il formulario di ogni varietà sociale.

3. Tipi di analisi del contenuto

Tutti i metodi di analisi del contenuto consistono essenzialmente in una scomposizione dell'unità comunicativa in elementi più semplici (unità di classificazione) e nella classificazione di questi ultimi entro variabili categoriali, avendo predefinito l'unità di contesto (che può coincidere con la stessa unità di classificazione) cui occorre far riferimento nell'atto di classificare. Per esempio: possono essere scelti come unità di classificazione tutti i riferimenti ai partiti italiani nei titoli di un quotidiano; ciascuna di queste unità sarà poi classificata entro variabili (favorevole/sfavorevole, presente/passato, vertici/base, ecc.) rispetto a ciò che è detto nel solo titolo (unità di contesto).

Trascuriamo in questa sede il problema del campionamento, che fu centrale nella riflessione metodologica di Lasswell e che, a nostro parere, non può essere semplicemente trasferito in questo campo, senza adattamenti, da altri tipi di ricerca (in particolare il campo delle comunicazioni di massa è preordinato secondo generi, fluisce in routines ben note, ha precise forme di ritualizzazione, in breve offre una variabilità minore di quella riscontrabile in una popolazione umana vivente).Le due operazioni di scomposizione e di classificazione devono avvenire in modo affidabile, vale a dire sulla base di un sistema di regole che devono essere seguite: a) correttamente; b) in qualsiasi momento; c) da chiunque le intenda e le accetti. Krippendorff (1978) ha definito con un certo rigore questi tre requisiti di affidabilità (reliability), ma solo per la fase della codifica: a) stabilità: quando lo stesso analista ripete a distanza di tempo le stesse scelte sullo stesso contenuto; b) riproducibilità: quando più analisti fanno le stesse scelte sullo stesso contenuto; c) accuratezza: quando le scelte degli analisti sono le stesse già definite come ottimali (se si possiede una codificazione standard di riferimento). L'affidabilità può essere verificata all'inizio del lavoro degli analisti e poi controllata di nuovo in fasi intermedie e alla fine. Ovviamente è improbabile che si raggiunga un'affidabilità assoluta e occorre definire qualche soglia soddisfacente (per esempio il 95% di scelte comuni fra vari analisti in un congruo numero di prove). In alcuni casi, in particolare per operazioni complesse, il singolo analista viene sostituito da gruppi di analisti che lavorano insieme sugli stessi materiali e le cui decisioni sono vincolate dal criterio dell'unanimità.Ciò che tuttavia differenzia più chiaramente i vari tipi di analisi del contenuto è il modo in cui si attua la scomposizione. Con qualche forzatura, possiamo delineare la seguente tipologia.

1. Le unità di classificazione coincidono con gli elementi 'significanti' o con gli elementi della struttura linguistica che, in un senso tradizionale, potremmo chiamare grammaticali (è difficile applicare questo tipo di analisi a comunicazioni non linguistiche o non solo linguistiche, per esempio il cinema, dove non sembrano riconoscibili elementi grammaticali minimi). Si possono così analizzare tutti gli aggettivi, tutti i verbi, tutti i sostantivi, o tutte le parole, oppure scomporre il testo in frasi elementari standardizzate (per esempio riportando all'attivo tutte le frasi passive, ecc.).

Questo tipo di scomposizione è il più frequente nella content analysis americana: esso assicura un tasso relativamente alto di automatismo e dunque garantisce (talvolta solo in apparenza) una maggiore obiettività.

Nascono ovviamente problemi relativi alla classificazione: se si deve classificare, ad esempio, l'aggettivo 'altezzoso' in base all'alternativa 'sicurezza/insicurezza di sé', si sceglierà in ogni caso la categoria 'sicurezza'? In risposta a questi problemi, e per promuovere l'accumulazione di dati comparabili, si è tentato di produrre dei dizionari per la classificazione automatica: così, lo Stanford political dictionary di North e Holsti (elaborato sulla base teorica di Osgood), il Lasswell value dictionary e lo Harvard IV psychosocial dictionary, che presenta un'interessante struttura ad albero. A parte il fatto che le prove sperimentali condotte per validare questi dizionari non hanno sempre dato buoni risultati (v. Weber, 1985, pp. 24-40), resta il dubbio se la plurivocità semantica naturale di ogni parola non venga addirittura accresciuta in 'letture' indipendenti dal contesto. È per questo che i programmi di elaborazione (software) che utilizzano questi dizionari includono generalmente procedure che permettono la rilettura, nel contesto, delle parole selezionate (key-word-in-context). In tal modo, tuttavia, si vanifica in misura consistente la promessa di una classificazione automatica.

I problemi di classificazione sono in un certo senso superati con l''analisi delle contingenze', elaborata da C. E. Osgood e da I. Pool De Sola (una chiara presentazione in De Lillo: v., 1971, pp. 32-43). Essa tende a individuare la struttura di relazione tra parole selezionate di un testo (o di un insieme di testi), confrontando, per ogni coppia di parole, il numero di volte in cui esse appaiono vicine (entro uno stesso paragrafo o entro altre suddivisioni arbitrarie) con il numero delle volte in cui avrebbero dovuto probabilisticamente apparire vicine. Si può poi procedere a un'analisi di cluster della matrice di contingenze così ottenuta, analisi che segnala il grado di associazione nel o nei testi di espressioni determinate. Il metodo non può comunque distinguere tra associazioni intenzionali, o controllate logicamente dalla fonte, e associazioni di tipo inconscio. Per questa distinzione risulta di nuovo decisiva la conoscenza dei contesti.

In Francia è stato elaborato, sulla base della modellistica statistica di J. P. Benzecri, un metodo di esplorazione statistica automatica delle parole (detto "analisi delle corrispondenze lessicali" da E. Amaturo - v., 1988 -, che ne ha fornito un'agile esposizione critica), per il quale è disponibile uno specifico programma di elaborazione denominato SPAD. Se, ad esempio, analizziamo un insieme di interviste 'libere' o narrative, per ciascuna di esse possiamo: a) ottenere il lessico, con la frequenza di ciascuna parola; b) aggregare le parole di eguale radice ed eliminare quindi le radici la cui frequenza non supera una soglia considerata minima; c) applicare l'analisi delle corrispondenze alla matrice delle parole/casi alla fine ottenuta, e confrontare le parole in relazione al loro profilo di distribuzione fra i casi, oppure i casi in relazione alla loro somiglianza sotto il profilo lessicale (per le più recenti applicazioni dell'analisi delle corrispondenze a testi si usa il programma ALCESTE: v. Reinert, 1987).Infine, a livello di modelli che assumono la frase come unità di classificazione, devono citarsi almeno la evaluative assertion analysis, sviluppata, tra gli altri, da C. E. Osgood (v. De Lillo, 1971, pp. 43-51) e la più recente analyse propositionnelle du discours (v. Ghiglione e altri, 1985), che si basa su un complesso apparato teorico linguistico-sociologico e su un corpo molto articolato di regole per la trascrizione dei testi e per la codifica.

2. Le unità di classificazione non hanno una riconoscibilità linguistica e possiedono tuttavia, all'interno dell'unità di contesto, un'evidenza relativamente elevata. Così in un campione di film possiamo classificare i personaggi più importanti rispetto a più variabili (tipi psicologici, tipi sociali, sesso, bellezza, età, ecc.); oppure isolare in determinati serials televisivi tutte le relazioni diadiche e classificarle (v. Buonanno, 1983); oppure individuare i passaggi esplicitamente polemici negli articoli di fondo dei quotidiani; oppure definire le singole strutture di azione, per esempio in un telegiornale (v. Grossi, 1984, pp. 459-477).

In tutti questi casi le classificazioni non possono essere decise senza riferimento a un'unità di contesto (il film, il teledramma, l'articolo, la notizia, ecc.) più ampia dell'unità di classificazione. Da ciò si capisce come i singoli giudizi analitici presentino il rischio di dipendere in modo eccessivo e non controllato dalla soggettività degli analisti: diverso grado di attenzione e di memorizzazione, diversa rilevanza emotiva attribuita ai particolari, ecc. La problematicità delle operazioni analitiche cresce ulteriormente quando le unità diventano meno facilmente riconoscibili, come nel caso dei mitemi di Lévi-Strauss (v., 1958) o delle funzioni narrative di Propp (v., 1928; v. Bremond, 1964); ma questi sono da considerarsi esempi estremi, non solo ampiamente discutibili, ma anche tipici di una ricerca intensiva piuttosto che estensiva.È importante mettere in rilievo il fatto che l'incertezza delle operazioni di scomposizione e di classificazione può ridursi notevolmente se le definizioni delle regole sono chiare, se i percorsi logici da seguire per definire il giudizio sono guidati da vincoli procedurali, se la scelta e l'addestramento delle équipes di analisti sono accurati; inoltre, quel che si perde in standardizzazione delle operazioni analitiche si guadagna in sede d'interpretazione dei dati, in quanto con queste procedure si ottengono dati che normalmente sono più immediatamente significativi rispetto alle ipotesi e meno bisognosi di ardite inferenze speculative.

3. Non vi è scomposizione di elementi, ma l'unità di classificazione coincide con l'unità di contesto. Nelle procedure di questo tipo è come se, invece di somministrare un questionario a un soggetto, lo somministrassimo a un film, o a una risposta discorsiva di un intervistato, o a un racconto, o a una immagine pubblicitaria. Così potremmo 'chiedere' a un film se c'è lieto fine, quanti scacchi subisce l'eroe, se appaiono soggetti collettivi, ecc.Sulla questione dell'affidabilità di questo tipo di analisi può ripetersi quanto già detto per il secondo tipo. Si può ancora accennare che secondo e terzo tipo presentano problemi peculiari a livello di misurazione, in quanto decidere se dare peso 1 a tutte le unità di classificazione (che sono anche unità di contesto) oppure ponderarle in modo differenziato, per durata o per lunghezza o per rilievo, è difficile e la scelta va, comunque, giustificata caso per caso. Ma ovviamente questo problema si riduce con campioni molto numerosi, per i quali può valere il principio della compensazione probabilistica degli errori.

4. L'uso dei calcolatori nell'analisi del contenuto

Lo sviluppo di metodologie che tendono ad automatizzare le operazioni di scomposizione e di classificazione è stato senza dubbio incentivato dall'utilizzo dei calcolatori elettronici. Il fatto di disporre di macchine e di programmi di elaborazione che in pochi minuti possono ottenere lessici, frequenze lessicali, confronti tipologici, misure di associazione tra forme lessicali, ecc., anche su migliaia di pagine di testo, ha rappresentato certamente l'occasione per dar corpo al miraggio di un'analisi oggettiva dei testi. In realtà anche i pochi accenni fatti mostrano che in nessun caso tutto procede automaticamente e che il ricercatore è comunque sempre chiamato a operare delle scelte non marginali: soglie di frequenza minima, aggregazioni tematiche, parafrasi, campionamento, ecc. Del resto non si vede perché, almeno ai livelli attuali di elaborazione delle tecniche di programmazione, il calcolatore debba essere usato per evitare l'esercizio di una capacità autonoma di giudizio analitico da parte del ricercatore, piuttosto che per aiutare il ricercatore stesso con le potenti funzioni di archiviazione e reperimento dati di cui è capace.Il primo programma di calcolo finalizzato all'analisi del contenuto è il GENERAL INQUIRER, sviluppato da P. Y. Stone e altri fra il 1961 e il 1966 (v. De Lillo, 1971, pp. 52-54). Fra i programmi oggi maggiormente utilizzati si segnalano: il TEXPACK, prodotto dal Centro di metodologia e analisi dei dati campionari dell'Università di Mannheim, che contiene lessici ed effettua conteggi di frequenze, ricerca dei contesti delle parole chiave, procedure per la costruzione di dizionari, procedure di reperimento dati, ecc.; l'OXFORD CONCORDANCE ~PROGRAM, elaborato da S. Hockey e I. Marriot nel 1982, più lento del precedente, ma più economico; lo SPAD, prodotto a Parigi da L. Lebart e A. Morineaux, che contiene, tra l'altro, un programma per l'analisi delle corrispondenze lessicali; il T & S (TEXTS & STATISTICS), prodotto dall'autore di questo articolo, che è un sistema integrato per l'analisi statistica di dati alfanumerici che consente, tra l'altro, oltre all'analisi delle corrispondenze lessicali, anche l'analisi delle contingenze per insiemi semantici. Viene regolarmente pubblicata, inoltre, una rivista dal titolo "Computer and the humanities" che contiene aggiornamenti sui programmi di elaborazione per l'analisi dei testi.

Nei prossimi anni è ragionevole attendersi un ulteriore e crescente sviluppo dei programmi di elaborazione per l'analisi del contenuto.

Bibliografia

Addario, N., Segatti, P., Forme di ideologia. Identità e azione nella comunicazione politica di una associazione industriale, Milano 1984.

Amaturo, E., L'analisi delle corrispondenze lessicali. Una proposta per il trattamento automatico di dati testuali, in La ricerca dell'industria culturale (a cura di M. Livolsi e F. Rositi), Roma 1988, pp. 95-106.

Arnheim, R., The world of daytime serial, in Radio research: 1942-1943 (a cura di P. F. Lazarsfeld e F. N. Stanton), New York 1943.

Barcus, F. E., Communications content: analysis of the research 1900-1958, Ann Arbor, Mich., 1960.

Barthes, R., Éléments de sémiologie, in "Communications", 1964, n. 4 (tr. it.: Elementi di semiologia, Torino 1967).

Berelson, B., Content analysis in communication research, Glencoe, Ill., 1952.

Betti, E., Teoria generale dell'interpretazione, 2 voll., Milano 1955.

Bremond, C., Le message narratif, in "Communications", 1964, n. 4.

Buonanno, M., Cultura di massa e identità femminile. L'immagine della donna in televisione, Torino 1983.

De Lillo, A. (a cura di), L'analisi del contenuto, Bologna 1971.

Farassino, A., Censura, sintomo, linguaggio, in "Ikon", 1974, LXXXVIII-LXXXIX, pp. 347-404.

Ghiglione, R., Matalon, B., Bacri, N., Les dires analysés. L'analyse propositionnelle du discours, Paris 1985.

Grossi, G. (a cura di), La RAI sotto analisi. 1977-1980: le ricerche promosse dalla Verifica Programmi Trasmessi, Torino 1984.

Hauld, F., Murray, E. J., Content analysis. Studies of psychotherapy, in "Psychological bulletin", 1955, LII.

Holsti, O. R., Content analysis, in The handbook of social psychology (a cura di G. Lindzey ed E. Aronson), Reading, Mass., 1968.

Janowitz, M., Schulze, R., Tendances de la recherche dans le domaine des communications de masse, in "Communications", 1961, n. 1.

Krippendorff, K., Content analysis: an introduction to his methodology, Beverly Hills, Cal., 1980 (tr. it.: Analisi del contenuto: introduzione metodologica, Torino 1983).

Lasswell, H. D., Leites, N. (a cura di), Language of politics: studies in quantitative semantics, New York 1949 (tr. it.: Il linguaggio della politica: studi di semantica quantitativa, Torino 1979).

Lévi-strauss, L'anthropologie structurale, Paris 1958 (tr. it. Antropologia strutturale, Milano 1966).

Mahl, G. F., Exploring emotional status by content analysis, in Trends of content analysis (a cura di I. Pool De Sola), Urbana, Ill., 1959, pp. 89-130.

Maletzke, G., Psychologie der Massenkommunikation, Hamburg 1963.

Pool De Sola, I. (a cura di), Trends of content analysis, Urbana, Ill., 1959.

Propp, V. J., Morfologija skazki, Moskva 1928 (tr. it.: Morfologia della fiaba, Torino 1966).

Reinert, M., Un logiciel d'analyse des données textuelles: alceste, in Analyse des données et informatique, Atti del convegno di Versailles, Les Chesnay 1987.

Rositi, F., L'analisi del contenuto come interpretazione, Torino 1971.

Rositi, F., I modi dell'argomentazione e l'opinione pubblica, Torino 1982.

Scheidmann, E. S., Logical content analysis: an explication of styles of codifying, in Analysis of communication content (a cura di G. Gerbner), New York 1969.

Vidal Beneyto, J. (a cura di), Posibilidades y limites del análisis estructural, Madrid 1981.

Weber, R. P., Basic content analysis, Beverly Hills, Cal., 1985.