Atmosfera. Lo strato limite

Atmosfera. Lo strato limite

Si definisce strato limite atmosferico (SLA) o strato limite planetario (SLP) la parte della troposfera direttamente influenzata dalla superficie terrestre e che risponde alle sue variazioni con scale dei tempi inferiori o uguali a un'ora.

Lo studio dello SLA è di fondamentale importanza perché al suo interno si concentra la quasi totalità della biosfera e viene resa disponibile la gran parte dell'energia utilizzata per i moti atmosferici. La misura delle variabili meteorologiche, lo studio dei processi, e la determinazione dei flussi di energia osservati nello SLA sono quindi essenziali per una corretta previsione meteorologica e per una valutazione accurata delle velocità di dispersione o di accumulo degli inquinanti rilasciati in atmosfera come conseguenza dell'attività umana.

La grande variabilità osservata nello SLA, causata dalle diverse condizioni atmosferiche e caratteristiche della superficie, rende complessa la trattazione analitica dei processi osservati. In aggiunta, la turbolenza, ingrediente principale dei processi di scambio e di trasporto nello SLA, rende impossibile un approccio analitico classico a causa del suo comportamento caotico. Pertanto le teorie che si sono sviluppate dal 1940 fino ai nostri giorni si basano principalmente sullo studio statistico dei campi della velocità e delle grandezze fisiche che caratterizzano lo SLA.

Gli studi teorici, le parametrizzazioni, la modellistica numerica e il cosiddetto principio di similarità sono strumenti fondamentali per un approccio che vuole considerare in maniera adeguata i complessi processi osservati nello SLA e per stimare correttamente i parametri non misurabili direttamente. La grande varietà nello SLA osservato rende difficile trovare relazioni generali tra le diverse grandezze caratterizzate dai processi turbolenti. Nonostante la loro intrinseca complessità, i processi dello SLA presentano però alcune caratteristiche ricorrenti che suggeriscono lo sviluppo di relazioni empiriche tra le variabili di interesse. Una metodologia utilizzata per ricavare queste relazioni empiriche è quella suggerita dalla teoria della similarità, che si basa sull'organizzazione delle variabili osservate in gruppi adimensionali. Un'analisi dimensionale (teoria Pi di Buckingham) del processo osservato consente di organizzare gruppi adimensionali dalle variabili selezionate: se la scelta dei gruppi è fatta in maniera appropriata, dovrebbe aversi una relazione tra le diverse variabili a carattere universale, tale cioè da trovare conferma nelle diverse condizioni in cui uno SLA di un certo tipo si può realizzare.

Ovviamente sono però le osservazioni dirette che costituiscono il punto di partenza per ogni tipo di indagine. Sulla base delle osservazioni vengono sviluppate le teorie, le parametrizzazioni e i modelli, che ampliano e aiutano a generalizzare la conoscenza e la descrizione dei processi osservati. Una buona programmazione di studi di tipo osservativo richiede la conoscenza approfondita della strumentazione, del suo principio di funzionamento, del significato e dei limiti delle stesse misure. Se, per esempio, consideriamo la misura del vento fatta con un anemometro (misura in situ) essa sarà diversa da quella di un telesensore che invece fornisce una misura che è il risultato dell'integrazione su un volume di aria.

Misurazioni nello SLA

La strumentazione adatta a fare misure nello SLA non è l'unico requisito da scegliere nella programmazione di una campagna di misura. È necessario avere una conoscenza approfondita del sensore che si vuole utilizzare e dei suoi limiti, definire la modalità di raccolta dei dati, valutare i potenziali problemi che uno strumento potrebbe avere operando nell'ambiente in cui si vogliono fare le misure.

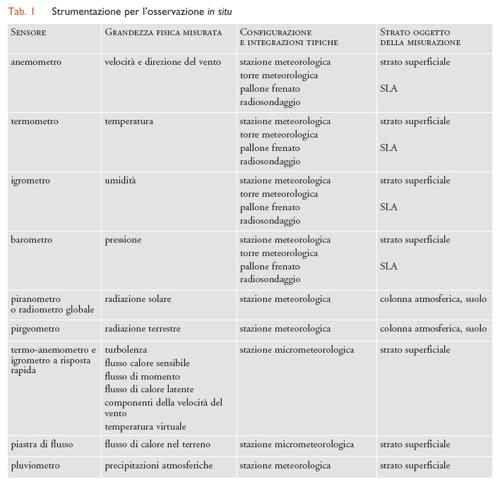

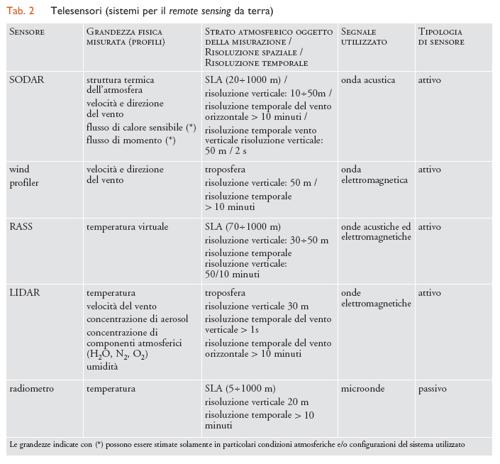

I sensori per misurazioni nello SLA si possono dividere, in prima approssimazione, in due categorie: (a) sensori per la misurazione diretta o in situ che consentono una misurazione di tipo locale. Questi sensori possono essere posizionati su torri meteorologiche di diversa altezza, su palloni frenati o liberi, su aerei. I sensori per le misurazioni in situ comprendono i sensori a risposta rapida, per la misurazione delle grandezze turbolente (rapidamente variabili), e i sensori per la misurazione delle grandezze medie; (b) sensori di telerilevamento attivi o passivi: si tratta in questo caso di strumenti che, posizionati a terra o su aereo, effettuano misurazioni relative a volumi di aria che non sono a diretto contatto con lo strumento utilizzato per la misurazione. I telesensori attivi emettono nell'atmosfera un segnale, acustico o elettromagnetico. Dall'analisi degli echi prodotti dall'interazione di questi segnali con l'atmosfera si ricava, utilizzando opportuni algoritmi, l'informazione sulla/e grandezze fisiche che si vogliono misurare. I telesensori passivi utilizzano invece come sorgenti, il terreno (che emette nell'infrarosso e nelle microonde), l'atmosfera (che emette nell'infrarosso) e il Sole (che emette quelle del visibile).

Le misurazioni in situ, quali per esempio quelle della velocità del vento, della temperatura, dell'umidità ‒ fatte ponendo i sensori su stazioni meteorologiche a una quota standard di 10 m o su torri meteorologiche (che possono raggiungere anche 300 m) ‒ consentono osservazioni che riguardano principalmente la parte più bassa dello SLA denominata strato superficiale, che è la parte di atmosfera (10% dello SLA) a diretto contatto con la superficie terrestre e quindi più facilmente accessibile. I palloni frenati o liberi sono utilizzati generalmente in campagne di misurazione di breve durata in quanto richiedono un impegno, in termini di risorse umane, piuttosto elevato. Le misurazioni con i radiosondaggi vengono realizzate prevalentemente su base giornaliera, secondo standard internazionali e forniscono un dato di ingresso fondamentale per i modelli utilizzati per le previsioni meteorologiche.

La necessità di misurare l'andamento delle principali grandezze meteorologiche con la quota era già nota nei primi studi sull'atmosfera, cosicché tentativi di ottenere informazioni quantitative sui profili di grandezze medie (temperatura, umidità, vento) nello SLA attraverso il sollevamento dei sensori con palloni frenati o liberi sono documentati già alla fine del XVIII secolo.

I telesensori, di origine più recente, sono stati sviluppati a partire dagli anni Sessanta del secolo scorso a seguito dei progressi della tecnologia e degli studi sull'interazione delle onde acustiche ed elettromagnetiche con l'atmosfera. Il loro avvento ha prodotto un notevole impulso nello studio e nelle osservazioni dello SLA per la loro capacità di estendere le misure all'intero SLA, spesso con un'elevata risoluzione spazio-temporale. In particolare l'uso dei primi SODAR (Sound detection and ranging) in configurazione monostatica ha consentito di evidenziare, in maniera chiara ed efficace, la ricchezza dei fenomeni presenti nello SLA; dalle stratificazioni termiche notturne, in cui occasionalmente sono visibili anche onde di gravità, al rapido sviluppo verticale dello strato rimescolato nelle prime ore del mattino. Il successivo uso delle tecniche LIDAR (Light detection and ranging) e RADAR (Radio detection and ranging) per gli studi dello SLA hanno ulteriormente esteso le possibilità di osservazione misurando grandezze fisiche diverse e spesso complementari.

Poiché i sensori per le misurazioni in situ e i telesensori, per molti aspetti, sono tra loro complementari il loro uso combinato consente di campionare i fenomeni di interesse per lo SLA nella loro struttura tridimensionale, con una adeguata risoluzione spazio-temporale (tab. 1, tab. 2).

Sensori per le misurazioni in situ

I sensori per le misurazioni in situ sono quelli da più lungo tempo utilizzati per lo studio dei processi osservati nello strato superficiale. Se questi sensori sono a risposta lenta, consentono di ottenere una misura media della grandezza osservata; se, invece, sono a risposta rapida forniscono una misura delle grandezze che caratterizzano la turbolenza. Alla prima categoria appartengono tipicamente gli strumenti per la misurazione del vento, della temperatura, dell'umidità e dell'energia radiante. Alla seconda i sensori per la misurazione dei flussi di momento, di calore sensibile e latente, e di massa. Da questi ultimi si possono calcolare le grandezze medie se i valori istantanei sono integrati su un intervallo di tempo appropriato (5÷10 minuti). In particolari condizioni di omogeneità orizzontale i gradienti delle grandezze medie possono essere usati per la stima dei flussi mediante relazioni proposte da Monin-Obukhov.

Misurazioni delle grandezze medie

In una stazione meteorologica tipica vengono comunemente misurate le grandezze meteorologiche standard: la pressione, la temperatura, l'umidità, la velocità e la direzione del vento. I sensori utilizzati nelle stazioni meteorologiche sono in genere strumenti a risposta lenta, relativamente semplici, adatti a misurazioni di lunga durata delle sole grandezze medie. Questi sensori non consentono la misurazione diretta delle grandezze che caratterizzano la turbolenza atmosferica. Alcuni di questi sensori, in particolare gli anemometri, i termometri, gli igrometri e i barometri, se installati su una torre meteorologica, o trasportati da palloni liberi o frenati, consentono la misurazione dei profili delle grandezze meteorologiche relative.

Anemometro. - Il sensore usato per la misurazione della velocità e della direzione del vento è l'anemometro. Quelli più comunemente usati sono: (a) anemometri a coppe, in cui la velocità del vento è stimata dal movimento di rotazione fatto da un mulinello a coppe mobili attorno a un asse verticale. Una banderuola, posta sullo stesso asse, misura la direzione di provenienza del vento; (b) anemometri triassiali a elica, costituiti da tre eliche di materiale leggero montate su assi perpendicolari. Le tre componenti della velocità del vento sono determinate dalla velocità di rotazione delle eliche. Il posizionamento ideale per un anemometro è a un'altezza standard di 10 m sul livello del suolo e in un'area libera di ostacoli per un raggio di almeno 50÷100 m. Velocità del vento inferiori a 0,5 ms−1 possono non essere sufficienti a mettere in moto le parti meccaniche e quindi non sono misurabili. Se ben costruiti e calibrati l'accuratezza di questi strumenti può raggiungere l'1% del valore misurato.

Termometro. - Il sensore usato per la misurazione della temperatura è il termometro. Il suo funzionamento si basa sugli effetti fisici prodotti dalla variazione della temperatura sulla parte sensibile dello strumento. I termometri sono costituiti generalmente da: (a) termistori, nei quali per effetto della variazione della temperatura viene prodotta una variazione di resistenza in un semiconduttore; (b) termometri a resistenza, che sfruttano le variazioni di resistenza di un conduttore (in genere il platino) al variare della temperatura; (c) termometri al quarzo, che utilizzano la variazione della frequenza di risonanza di un cristallo di quarzo al variare della temperatura. Per tutti questi sensori gli errori di misura sono generalmente inferiori a 0,1 °C.

I termometri che utilizzano i termistori sono i più sensibili in quanto hanno una relazione resistenza-temperatura di tipo esponenziale ma allo stesso tempo sono i meno accurati. I termometri a resistenza hanno invece una relazione resistenza-temperatura lineare; per questo sono frequentemente usati sia per misurare la temperatura sia le sue variazioni. I termometri al quarzo sono quelli più stabili e affidabili. La frequen-za varia linearmente con la temperatura e possono raggiungere, in teoria, un'accuratezza di 0,001 °C. Questa accuratezza viene purtroppo degradata dagli schermi di protezione dalla radiazione, e dalla ventilazione. Questi termometri sono particolarmente adatti alla misurazione dei profili di temperatura.

Igrometro. - Un discorso a parte meritano gli igrometri, per la difficoltà nella misurazione di questo parametro e le diverse definizioni usate per indicare il contenuto di vapore d'acqua nell'atmosfera: pressione di vapore d'acqua (in mb), umidità assoluta (massa di vapore d'acqua per unità di volume), umidità specifica (massa di vapore d'acqua per massa di aria umida), rapporto di mescolamento (massa di vapore d'acqua su massa di aria secca), umidità relativa (massa di vapore d'acqua in un volume di aria su massa di vapore d'acqua nello stesso volume alla stessa pressione e volume, ma in condizioni di saturazione). I sensori per la misurazione dell'umidità possono essere di vario tipo. Alcuni si basano sulla variazione della capacità di un condensatore costituito da un dielettrico le cui caratteristiche si modificano in funzione dell'umidità che viene rilevata; oppure sulla capacità che hanno i capelli o alcune specie di setole di variare in lunghezza al variare dell'umidità nell'aria. Tra gli igrometri, il più comunemente utilizzato nelle capannine meteorologiche è lo psicrometro. Questo strumento misura la temperatura dell'aria con un termometro asciutto (bulbo asciutto) e, separatamente, con un termometro avente il bulbo bagnato. Da queste due misure si ricava l'umidità relativa. L'accuratezza di questo strumento è riconducibile all'accuratezza della misura della temperatura, e quindi al corretto funzionamento della ventilazione e dalla schermatura dalla radiazione diretta. In condizioni ottimali uno psicrometro ha una accuratezza dell'ordine del 5%.

Barometro. - Il sensore usato per la misurazione della pressione viene chiamato barometro, che rileva la pressione che una colonna di aria esercita in un determinato punto. Qualora questo sensore utilizzi un liquido, la misurazione in condizioni di equilibrio è data dal confronto tra la pressione della colonna d'aria e quella della colonna del liquido. Talvolta vengono utilizzate invece capsule aneroidi, cioè recipienti chiusi di metallo deformabile, parzialmente prive di aria che si deformano in funzione della variazione della pressione esercitata all'esterno.

Alla prima tipologia di sensori appartiene il barometro a mercurio progettato nel 1644 da Evangelista Torricelli, costituito essenzialmente da una vaschetta riempita di mercurio entro cui è immerso un tubo di vetro di circa 1 metro, chiuso nella parte superiore e riempito parzialmente di mercurio (nella parte rimanente viene fatto il vuoto). Dal confronto dell'altezza della co-lonna di mercurio rispetto al livello del mercurio nella vaschetta, si ottiene una misura della pressione atmosferica. Le capsule aneroidi sono molto più maneggevoli e per questo vengono utilizzate nei radiosondaggi: dalla differen-za della pressione misurata rispetto a quella al suolo, si determina la quota cui si trova la sonda. L'accuratezza ottenibile con le capsule aneroidi è tipicamente di qualche millibar ed è inferiore alla misura ottenibile con i barometri a mercurio.

Misurazione delle grandezze turbolente

Anemometro ultrasonico. - Lo strumento comunemente usato per la misura dei flussi turbolenti è l'anemometro ultrasonico detto anche termoanemometro.

Il principio di funzionamento di un anemometro ultrasonico si basa sulla misurazione del tempo di percorrenza di un segnale acustico lungo il percorso emettitore-ricevitore nei due sensi. Il tempo di percorrenza, infatti, dipende dalla temperatura dell'aria e dal moto dell'aria entro cui il suono si propaga: la velocità del vento è una funzione della differenza dei tempi di percorrenza nei due sensi, la temperatura è una funzione della somma degli stessi tempi. Gli anemometri ultrasonici possono essere a due assi (biassiali) se si vuole misurare solamente la velocità orizzontale del vento, oppure a tre assi (triassiali) se si vogliono misurare anche le fluttuazioni della velocità del vento lungo la verticale. La frequenza di campionamento di questi anemometri può variare nell'intervallo 10÷100 Hz. Un anemometro ultrasonico triassiale è costituito da 3 coppie emettitore-ricevitore posti a una certa distanza. Semplici considerazioni geometriche consentono la derivazione delle tre componenti u, v, w della velocità del vento nelle direzioni di interesse. Per quanto riguarda la temperatura, quella che viene misurata da un anemometro sonico è la temperatura virtuale dell'aria, ossia la temperatura che dovrebbe avere l'aria secca per eguagliare la densità dell'aria umida alla stessa pressione.

Il flusso turbolento di una certa grandezza g è stimato utilizzando il metodo dell'eddy correlation (correlazione di turbolenza) che utilizza la covarianza tra le fluttuazioni della velocità verticale (w′) e la grandezza (g′) della quale si vuole calcolare il flusso. La covarianza è una grandezza che indica il livello di correlazione tra due variabili. Utilizzando il solo anemometro ultrasonico si potranno calcolare le grandezze medie (velocità e direzione del vento, temperatura virtuale dell'aria), le varianze delle fluttuazioni delle singole componenti del vento, e le covarianze tra w′e le fluttuazioni delle altre grandezze misurate quali u′ (w′u′ è il flusso di momento), T′(w′T′ è il flusso di temperatura).

Qualora si associ all'anemometro ultrasonico un sensore a risposta rapida per la misurazione di altri scalari quali per esempio H2O o CO2 si potranno stimare rispettivamente i flussi di calore latente e di CO2.

Radiometro. - Per misurare la radiazione si utilizzano i radiometri.

L'energia disponibile per i moti atmosferici attraverso i flussi turbolenti è il risultato del bilancio radiativo tra la radiazione solare a onda corta (0,3÷3,0 μm) e la radiazione infrarossa a onda lunga (3÷100 μm ). I sensori di radiazione solare (0,4÷3 μm) e terrestre (3÷30 μm) si suddividono in varie classi in relazione alla parte dello spettro considerato.

Il sensore per la misurazione della radiazione a onda corta è il piranometro, il cui elemento sensibile è un disco metallico, diviso in settori colorati aventi diversi valori di albedo, e protetto da una cupola di polietilene trasparente a tutta la radiazione solare. Ogni settore è termicamente collegato al giunto di una termocoppia, questi giunti collegati in modo opportuno forniscono in uscita una tensione che dipende dalla temperatura tra i settori e quindi dalla radiazione incidente.

Il sensore per la misurazione della radiazione a onda lunga è il pirgeometro. Esso è costituito da una termopila che fornisce un segnale in microvolt proporzionale allo scambio di radiazione nel lontano infrarosso tra il sensore e la sorgente di segnale.

Qualora si voglia misurare la radiazione netta, ovvero la somma algebrica tra la radiazione a onda corta (trasmessa dall'atmosfera e riflessa dal terreno) e a onda lunga (diffusa dall'atmosfera ed emessa dal terreno) si possono usare due piranometri (rispettivamente rivolti verso l'alto e in direzione del terreno) e due pirgeometri anche essi rivolti verso l'alto e in direzione del terreno. Diversamente, si può usare il radiometro netto o pirradiometro che è costituito da due piranometri (di solito a termopila) orientati in direzione opposta. La differenza tra il piranometro e il piranometro netto è che quest'ultimo, dovendo misurare anche la componente a onda lunga, deve utilizzare superfici protettive (in genere polimeri) che consentono il passaggio della radiazione a onda lunga e a onda corta.

Osservazioni nello SLA realizzate con misurazioni in situ

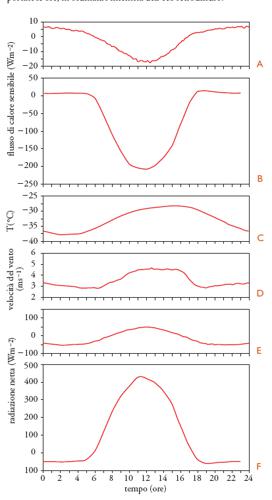

Di seguito viene mostrato, per alcune tipologie di SLA tipici delle regioni polari e delle medie latitudini, l'andamento di alcune grandezze misurate utilizzando la strumentazione in situ al fine di mostrarne l'andamento e le caratteristiche.

Le osservazioni delle regioni polari sono relative a una campagna di misurazione presso la stazione di Concordia a Dome C (75o 06′S, 123o 23′E) durante l'estate australe del 1999, quelle alle medie latitudini si riferiscono al sito sperimentale presso la sezione romana dell'ISAC (Istituto di Scienze dell'Atmosfera e del Clima). La stazione di Concordia è situata a una quota di 3306 m sul livello del mare nella parte est del plateau antartico; la sede dell'ISAC si trova nell'area di ricerca di Tor Vergata, in una zona periferica della città di Roma.

Lo SLA nelle regioni polari è prevalentemente caratterizzato, durante l'intero anno, da condizioni di forte stabilità termica, a eccezione della parte centrale del giorno durante l'estate australe. Lo SLA alle medie latitudini (in condizioni di alta pressione) mostra, invece, una chiara dipendenza dal ciclo diurno con uno SLA convettivo nelle ore più calde e uno SLA stabile nelle ore notturne.

Le misure di turbolenza atmosferica sono state fatte con un anemometro ultrasonico modello Metek USA-1 installato su un palo meteorologico a una quota di 3,6 m sulla superficie della neve. Nella fig. 4A è mostrata la variazione media giornaliera del flusso di calore sensibile durante il periodo estivo (fine dicembre-gennaio). Ogni punto rappresenta la media su 10 minuti; in ascisse è riportato il tempo misurato in ore. I valori negativi tra le 6.00 e le 17.00 ora solare indicano che, in corrispondenza del riscaldamento della superficie a causa della radiazione netta disponibile, si genera un flusso di calore sensibile diretto dalla superficie verso l'atmosfera, che sottrae energia termica alla superficie. Il valore di picco è raggiunto intorno alle 12.00. I valori positivi indicano un flusso di calore diretto in direzione opposta. Un diagramma analogo è mostrato per le stesse ore, per un mese estivo (agosto), ma alle medie latitudini relativamente alla stazione di Roma Tor Vergata (fig. 4B). In questo caso il flusso di calore sensibile durante le ore centrali della giornata è circa 15 volte superiore a quello osservato in Antartide. Di notte, sia in Antartide sia a Tor Vergata, si osservano valori positivi del flusso di calore sensibile: questo indica un trasferimento di energia termica dall'atmosfera alla superficie a causa della minore temperatura di quest'ultima che si raffredda per irraggiamento nell'infrarosso. Utilizzando lo stesso sensore è mostrata, per la sola stazione antartica, la temperatura media giornaliera (fig. 4C) e la velocità media del vento (fig. 4D) nella parte bassa dello SLA. Al ciclo della temperatura è associato quello della velocità del vento. I valori più elevati della velocità del vento sono osservati tra le 12.00 e le 15.00 (ora solare) quando per effetto del rimescolamento verticale l'interazione tra lo SLA e la libera atmosfera aumenta.

I processi dello SLA sono regolati in maniera sostanziale dalla radiazione netta Rn disponibile alla superficie. La Rn è la somma delle componenti a onda lunga (infrarosso) diffusa dall'atmosfera (LW) ed emessa dalla superficie nevosa (LW) e delle componenti a onda corta (visibile) trasmessa attraverso l'atmosfera (SW) e riflessa dalla superficie nevosa (SW).

Nella fig. 4E è mostrato l'andamento medio giornaliero della radiazione netta in Antartide e presso l'area di ricerca di Roma Tor Vergata (fig. 4F) per un mese estivo. Il picco della radiazione netta in entrambe le stazioni è raggiunto alle 12.00 ora solare, ma la radiazione netta disponibile alla stazione di Tor Vergata è cinque volte superiore a quella di Dome C. Di notte si osservano valori negativi intorno ai 50 Wm−2.

Strumentazione per la telemisurazione e osservazioni

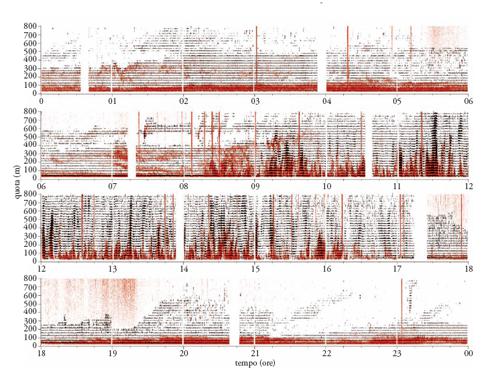

SODAR. Il SODAR, è un telesensore di tipo attivo che utilizza le onde acustiche per sondare l'atmosfera. Nella configurazione più semplice (configurazione monostatica), viene usata una stessa antenna per emettere toni acustici e per ricevere gli echi. La frequenza dei toni acustici è compresa tipicamente nell'intervallo 1,5÷5 kHz. Il segnale misurato consiste in echi prodotti dall'interazione delle onde acustiche con l'atmosfera nei primi 500÷1000 metri. Nella configurazione monostatica la causa prevalente degli echi è rappresentata dalle fluttuazioni di temperatura sulla scala della mezza lunghezza d'onda utilizzata dallo strumento. L'intensità degli echi viene comunemente registrata in formato facsimile. In questo tipo di registrazione l'eco ricevuto dopo l'emissione del tono acustico (della durata di 50÷200 ms) viene registrato come una traccia verticale in cui la gradazione di nero è proporzionale all'intensità dell'eco e l'altezza del punto sulla traccia indica il ritardo con cui questo viene ricevuto, e quindi la quota da cui proviene. Se le tracce vengono poste in maniera sequenziale una adiacente all'altra viene visualizzata la struttura termica dello SLA e la sua evoluzione in funzione del tempo, che viene riprodotta in un fac-simile. La sua risoluzione verticale può variare tra 10 e 30 m in funzione della frequenza usata. Anche il raggio di azione varia in funzione della frequenza: le frequenze alte (dell'ordine di 5 kHz) che si attenuano più rapidamente consentono con difficoltà il raggiungimento di quote superiori a 150 m. I SODAR che invece usano frequenze di 2 kHz possono raggiungere, in assenza di rumore ambientale, anche i 1000 m.

Nella fig. 5, in rosso, è riportato, come esempio di giornata tipica alle medie latitudini, il record giornaliero degli echi registrati da un SODAR durante una campagna di misurazione a Turbigo (Milano). In ascissa sono riportate le ore, in ordinata l'intensità dell'eco retrodiffuso. Dalle 00.00 alle 08.00 ora solare, l'inversione termica dovuta al raffreddamento del terreno viene visualizzata come una zona di echi più intensi prodotti dalle fluttuazioni termiche causate dall'azione combinata dell'inversione termica e del gradiente verticale di vento. Più in alto, sono presenti stratificazioni orizzontali dovute alle fluttuazioni termiche all'interfaccia tra correnti, a temperatura diverse, che scorrono l'una sull'altra. Per effetto del riscaldamento del terreno, dopo l'alba inizia la convezione (sul record alle 08.20). L'aria a contatto del terreno riscaldandosi si solleva verso l'alto dando luogo alle cosiddette termiche o piume convettive. Le forti fluttuazioni verticali di temperatura presenti all'interno delle termiche fanno si che esse siano visualizzate nel facsimile del SODAR come strutture verticali coerenti. Le termiche si sollevano gradualmente interessando quote sempre maggiori. Nella parte sovrastante le termiche rimane visibile, per un certo tempo, la stratificazione notturna detta capping inversion, ovvero uno strato caratterizzato da un'inversione di temperatura che delimita e si oppone allo sviluppo verticale dello strato rimescolato. Nel primo pomeriggio, per effetto del forte rimescolamento, le termiche raggiungono la quota massima per poi diminuire e quindi scomparire del tutto (sul record dopo le 17.00) al tramonto del Sole. Subito, dopo in conseguenza della perdita di energia da parte del terreno per effetto dell'irraggiamento radiativo, si registra il raffreddamento del terreno e quindi dell'aria immediatamente sovrastante. Si chiude così il ciclo giornaliero dello SLA.

L'analisi Doppler degli echi permette di ricavare il vento radiale alle diverse quote, lungo l'asse dell'antenna. Per ottenere le componenti orizzontali e verticale della velocità del vento i toni acustici devono essere inviati in almeno tre direzioni opportunamente scelte: generalmente una verticale e le altre inclinate di 20-30° rispetto allo zenit. Dai venti radiali, utilizzando opportune relazioni trigonometriche, si ricavano le componenti orizzontali e quella verticale della velocità del vento. Sempre nella fig. 5, in grigio, si mostra un esempio di registrazione facsimile ottenuta in condizioni convettive e i moti verticali associati.

L'accuratezza nella misura del vento nei SODAR commerciali è dell'ordine di 1 ms−1. I profili del vento orizzontale vengono in genere mediati su intervalli di 5÷10 minuti Il profilo delle componenti radiali, e in particolare di quella verticale, ha invece la stessa periodicità della emissione del tono acustico (tipicamente 6 s).

Wind profiler. - Il wind profiler (profilatore di vento) è un telesensore che misura, appunto, il profilo del vento. Lo strato atmosferico oggetto dell'indagine si può estendere dallo SLA fino alla stratosfera. Il wind profiler può essere considerato un particolare tipo di RADAR, in quanto opera anche in aria chiara ovvero in assenza di nubi e precipitazioni. Lo spessore dello strato atmosferico investigato dipende dalla frequenza utilizzata, della potenza emessa e dalle dimensioni dell'antenna utilizzata. Per gli strati più bassi dell'atmosfera vengono utilizzate frequenze nella banda 900÷1300 MHz (lunghezza d'onda nell'intervallo 0,33÷0,23 m). In questo caso le dimensioni dell'antenna sono relativamente contenute e quindi il sistema è trasportabile Per la misura del vento viene emesso un fascio elettromagnetico in tre direzioni opportunamente scelte utilizzando una singola antenna ad array, in cui il fascio viene indirizzato elettronicamente, oppure tre o più antenne, ognuna delle quali emette il fascio in una determinata direzione. Utilizzando frequenze intorno ai 1000 MHz, l'interazione dell'onda elettromagnetica con l'atmosfera è molto debole per cui l'eco retrodiffuso, prodotto dalle fluttuazioni di umidità e temperatura sulla scala della mezza lunghezza dell'onda usata, è generalmente al di sotto del rumore strumentale del sistema di ricezione. Per questa ragione sono necessari elaborazioni del segnale che includono medie di tipo diverso, tali da fare emergere il segnale dal rumore di fondo.

Il vento radiale lungo l'asse di ciascuna antenna viene calcolato dalla misura dell'effetto Doppler dell'eco retrodiffuso. L'analisi prevede l'acquisizione del segnale in modo ciclico, in modo da ricavare le tre componenti del vento alle diverse quote e ricostruire, quindi, il profilo del vento. Gli assi delle antenne vengono di solito inclinati meno di 20° per evitare che i lobi laterali del segnale emesso possano interferire con eventuali ostacoli posti nelle vicinanze del wind profiler.

In presenza di precipitazioni, gli echi causati dalle idrometeore sono prevalenti e quindi la velocità verticale misurata è quella delle idrometeore. Si deve inoltre tenere conto di occasionali echi di origine non atmosferica (sciami di insetti, volatili, aerei ecc.) che sono particolarmente intensi e quindi predominano su quelli di origine atmosferica nella determinazione dell'effetto Doppler. Per filtrare il segnale di origine non atmosferica, si usano algoritmi che analizzano la coerenza delle misure su più profili successivi portando all'eliminazione di quelli anomali.

Un tipico wind profiler per ottenere le misure del profilo del vento nello SLA parte da una quota minima di circa 100 m e può raggiungere i 2÷4 km a seconda delle condizioni atmosferiche (per es., aria più o meno umida), della potenza emessa (3÷4 kW di picco), dell'area dell'antenna (ca. 4 m2) e del tempo di integrazione (3÷5 minuti per un profilo di vento). La risoluzione verticale è di circa 100 m, mentre l'errore sulla misura del vento è dell'ordine di 1ms−1

LIDAR. Il LIDAR, è uno strumento che opera utilizzando onde elettromagnetiche nel visibile o nelle immediate adiacenze: ultravioletto o vicino infrarosso. Il segnale utilizzato per sondare l'atmosfera è prodotto da un laser pulsato. Alle frequenze utilizzate, le onde elettromagnetiche interagiscono con le particelle o con le molecole presenti in atmosfera (aerosol). Le modalità di interazione tra il fascio laser e l'atmosfera sono diverse e comprendono la diffusione di Rayleigh (elastica da particelle molto più piccole della lunghezza d'onda inviata: tipicamente le molecole), la diffusione di Mie (elastica da particelle di dimensioni simili o maggiori della lunghezza d'onda inviata: tipicamente gli aerosol), e la diffusione di Raman (non elastica: condizione che si determina quando una parte dell'energia dei fotoni viene trasferita alla molecola che, per questo, passa in un diverso stato energetico). I diversi tipi di interazione rendono possibile l'uso di questo sensore per la misurazione di diversi parametri atmosferici: concentrazione di aerosol, profilo del vento, profilo della temperatura, contenuto di vapore d'acqua, e concentrazione di alcuni gas (ozono, metano ecc). Altre informazioni, quali, per esempio, l'altezza dello SLA convettivo possono essere dedotte, in maniera indiretta, dall'analisi dell'andamento con la quota dell'intensità dell'eco retrodiffuso. Infatti, al limite superiore dello SLA convettivo si rileva una discontinuità nei valori delle concentrazioni di aerosol e di contenuto di vapore d'acqua che vengono trasportati dallo strato superficiale verso l'alto e quindi rimescolati, a opera della convezione.

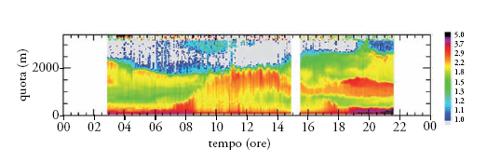

Il profilo del vento radiale nella direzione del fascio laser viene ottenuto dall'analisi Doppler degli echi prodotti dall'interazione tra l'impulso emesso dal laser e l'atmosfera. Utilizzando lunghezze d'onda di circa 2 μm si ottiene una risoluzione verticale di 30 m, una risoluzione temporale di alcuni secondi e un'accuratezza nella misura dell'ordine di 0,1 m/s. Uno dei vantaggi di questo sistema dovuto alla collimazione del fascio laser consiste nella possibilità di inclinare il fascio fino a misurare venti radiali in direzione quasi orizzontale, senza che parti di questo interagiscano (come per es., per il radar) con eventuali ostacoli. Nella fig. 6 è mostrato l'andamento del profilo della concentrazione di aerosol in funzione del tempo. L'evoluzione diurna dello SLA viene visualizzata dalla distribuzione verticale degli aerosol. In particolare sono visibili la crescita dello SLA convettivo e la formazione dello strato residuo (residual layer), cioè di quella parte dello strato ben rimescolato che persiste, dopo il tramonto, al di sopra dello SLA stabile che inizia a formarsi.

La concentrazione di alcuni costituenti dell'atmosfera (H2O, N2, O2) in funzione della quota, viene ottenuta sfruttando la diffusione Raman. In questo caso, la variazione di energia nei livelli rotovibrazionali delle molecole attraversate dal fascio laser introduce negli echi retrodiffusi un contenuto in frequenze (righe spettrali), che dipende dagli scambi energetici dell'onda incidente con i diversi tipi di molecole. Dall'analisi dell'intensità degli echi associati alle diverse righe spettrali viene determinata la concentrazione relativa delle diverse specie in atmosfera. Per il rapporto di mescolamento delle molecole dell'acqua, utilizzando un tempo di integrazione di un minuto, l'errore, all'interno dello SLA, può essere contenuto entro il 7%. La diffusione Raman può essere utilizzata anche per misurare il profilo di temperatura. In questo caso la misura si basa sull'analisi dell'inviluppo delle righe spettrali prodotte dalla diffusione anelastica della luce laser delle molecole di azoto e di ossigeno, dipendenti dalla temperatura. L'accuratezza della misura è dell'ordine di 1÷3 °C.

RASS. Il RASS (Radio acoustic sounding system) è un sistema per il telerilevamento della temperatura atmosferica che si avvale di due tecniche: radio e acustica. Il principio fisico di funzionamento si basa sulla determinazione della velocità di propagazione di un'onda acustica in atmosfera mediante radar elettromagnetico. Poiché la velocità del suono dipende dalla radice quadrata della temperatura virtuale, misurarne la velocità significa anche conoscere la temperatura virtuale dell'aria in cui l'onda acustica si propaga. La rilevazione dell'onda acustica con il radar è possibile in quanto l'onda acustica, mentre si propaga, modula localmente l'indice di rifrazione dell'onda elettromagnetica e quindi produce una diffusione o riflessione che permette al radar di localizzarla durante la sua propagazione. I RASS possono essere di due tipi: Doppler RASS e Bragg RASS.

Il Doppler RASS (D-RASS) può essere considerato un'estensione del SODAR al quale viene associato un RADAR bistatico. Il RADAR, usualmente a emissione continua, localizza la posizione delle onde acustiche rilevando il debole eco prodotto dall'interazione del segnale elettromagnetico con il treno di onde acustico. Per aumentare il rapporto segnale/rumore dell'eco, il radar usa un segnale la cui lunghezza d'onda è doppia rispetto a quella acustica rendendo possibile quell'interferenza costruttiva che va sotto il nome di risonanza di Bragg. In condizione di risonanza di Bragg la potenza del segnale ricevuto è proporzionale al quadrato del numero di cicli che formano il treno d'onde acustico. Quando vi sono forti gradienti verticali di temperatura può risultare necessario variare la lunghezza d'onda acustica utilizzata, per realizzare le condizioni di risonanza di Bragg alle diverse quote.

Il Bragg RASS (B-RASS) può essere considerato una estensione del wind profiler al quale viene associata una sorgente acustica a lunghezza d'onda variabile, centrata sulla metà della lunghezza d'onda elettromagnetica. La misura della temperatura si ottiene identificando, a ogni quota, la lunghezza acustica che rende massima la retro-diffusione dell'onda, ovvero quella che entra in risonanza di Bragg con la lunghezza d'onda elettromagnetica. Nota la frequenza emessa, e individuata la lunghezza dell'onda acustica che produce la risonanza di Bragg, si determina la velocità del suono a quella quota (c=λν , dove c è la velocità del suono, λ la lunghezza d'onda, ν la frequenza) e quindi la temperatura virtuale corrispondente.

Un aspetto che in entrambi i sistemi bisogna tenere nella dovuta considerazione è la misura dei moti verticali delle masse di aria entro le quali l'onda acustica si propaga in quanto questi moti modificano la velocità dell'onda acustica vista dal RADAR. Nel caso del D-RASS la misura della velocità verticale viene fatta dal SODAR, nel caso del B-RASS dal wind profiler. In entrambi i sistemi, intensi venti orizzontali possono limitare la quota massima raggiungibile in quanto spostano il fronte d'onda acustica rispetto all'asse dello strumento. La principale differenza tra i due sistemi riguarda le quote operative minime e massime. Nel D-RASS le misure possono iniziare al di sotto dei 100 m ma raramente raggiungono quote superiori a 1000 m. Nel B-RASS la quota minima di indagine è intorno ai 200÷300 m, mentre la quota massima, che dipende dalla frequenza utilizzata e dal vento di fondo, può raggiungere diversi chilometri. In entrambi i casi l'accuratezza con la quale viene misurata la temperatura virtuale è dell'ordine di alcuni decimi di grado mentre la risoluzione verticale è determinata dalla lunghezza del treno d'onde acustico nel D-RASS o dalla lunghezza del segnale emesso nel B-RASS.

Radiometro MTP. - Il radiometro MTP (Meteorological temperature profiler) è un radiometro passivo per il telerilevamento della temperatura nei primi 600÷1000 m di atmosfera. La tecnica utilizzata dallo strumento consiste nella misura dell'emissione atmosferica della radiazione, nella banda di assorbimento dell'ossigeno molecolare a 60 GHz per diversi angoli zenitali. In questa banda la radiazione emessa dall'atmosfera è fortemente attenuata per cui si può supporre che nel punto di misura venga rilevata solo quella proveniente da una distanza massima di 600÷1000 m. Le variazioni di temperatura modificano, per quanto debolmente, l'intensità di quest'emissione

Il MTP-5 (MTP versione 5) utilizza un'antenna di 0,5 m di diametro, ha un'apertura angolare di 6° e per diversi angoli zenitali (da 90° a 0°) misura la temperatura di brillanza. Quest'ultima è una temperatura fittizia equivalente, ovvero la temperatura che dovrebbe avere un corpo nero per irradiare la brillanza osservata a una determinata frequenza. Il profilo della temperatura atmosferica è ricavato applicando opportuni algoritmi, detti di inversione, i quali ipotizzano una certa dipendenza analitica con la temperatura di brillanza. La radiazione misurata quando l'antenna è nella direzione orizzontale (0°) viene utilizzata come riferimento e associata alla temperatura misurata da un sensore esterno posto alla stessa quota.

L'accuratezza con cui viene misurato il profilo di temperatura nello SLA con questo strumento è di circa 0,5°. Il vantaggio offerto dal radiometro MTP rispetto ai sistemi più convenzionali, quali, per esempio, i sistemi di radiosondaggio, è dovuto alla migliore risoluzione verticale e temporale della misura oltre che alla operatività semplificata dello strumento. Nell'ambito della campagna antartica del 2005, un MTP-5P (con antenna di 0,5 m e versione polare) è stato utilizzato presso la stazione di Concordia.

Modellistica dello SLA

La modellazione degli strati più bassi dell'atmosfera richiede la conservazione di alcune grandezze: quantità di moto, massa, energia, quantità del vapore acqueo. La conservazione di queste grandezze dà origine a un sistema di equazioni differenziali alle derivate parziali detto alle equazioni primitive, in quanto non presenta approssimazioni. Tale sistema permette di risolvere i moti relativi a dimensioni differenti in scala, variabili dall'ordine di 1 km a migliaia di km. Soluzioni analitiche di questo insieme di equazioni sono facilmente ricavabili per alcune approssimazioni. Nel caso di grandi scale si utilizza in genere una forma approssimata imponendo l'equilibrio idrostatico: si trascurano le accelerazioni verticali, cioè la componente verticale delle equazioni della conservazione della quantità di moto viene posta uguale a zero. Con ciò si assume che una bolla d'aria in movimento verso l'alto sia, istante per istante, in equilibrio con l'ambiente. Quest'approssimazione comporta una semplificazione delle equazioni ed elimina tutti i fenomeni associati a spostamenti verticali veloci (accelerazione verticale non nulla). Quindi le forti correnti ascensionali causate da montagne o dalle brezze, i fronti di raffica delle celle convettive, le linee di convergenza ecc., fanno parte di quei fenomeni non riproducibili da un modello idrostatico.

Per poter riprodurre la dinamica a mesoscala o a scala locale bisogna utilizzare quello che abbiamo appena definito un modello alle equazioni primitive. Questo, però, non garantisce di poter riprodurre correttamente la fenomenologia delle scale più piccole, poiché ci sono due ordini di problemi: la scala a cui vengono rilevate le osservazioni e la rappresentazione dei moti turbolenti e diffusivi presenti negli strati più bassi della troposfera. Accenniamo brevemente al primo e poi entreremo dettagliatamente nel secondo.

È noto che l'attuale rete osservativa è in grado di rilevare bene i segnali su larga scala, che vengono quindi ben riprodotti nelle condizioni necessarie a inizializzare un modello, il contrario avviene per i segnali a scala locale. Per ovviare a questo problema non è sufficiente utilizzare un modello ad alta risoluzione, in quanto, non essendo presente il segnale locale nelle condizioni iniziali esso non verrà riprodotto correttamente. Si può intervenire in due modi: attraverso l'assimilazione di dati non convenzionali e utilizzando un modello nidificato. L'assimilazione dei dati non convenzionali è uno dei temi diricerca attuali vista la grande diffusione di misure tele-rilevate da terra o da satellite. Queste misure hannogeneralmente una buona risoluzione spaziale ma temporalmente limitata (satellite) o sono puntuali e hanno un'alta risoluzione temporale e verticale (SODAR, LIDAR, radiometri alle microonde ecc.). Tali dati sono detti non convenzionali in quanto rilevano osservabili nelle variabili che non sono direttamente utilizzate dai modelli meteorologici e non vengono rilevate alle ore canoniche (00UTC, 06UTC, 12UTC, 18UTC). Di conseguenza, si determinano due problemi: (a) riportare le osservazioni nelle variabili canoniche (vento, temperatura, pressione e umidità); (b) riportare le osservazioni alle ore canoniche nelle quali vengono rilevate dalla rete osservativa globale tutte le altre variabili. Il primo viene trattato come un problema di inversione delle osservazioni, mentre il secondo attraverso l'uso dell' assimilazione variazionale (4DVAR) per poterle utilizzare nelle ore canoniche.

Alla fine di queste due procedure abbastanza complesse si ottengono dei dati che possono essere utilizzati per inizializzare un modello ad alta risoluzione. Benché le condizioni iniziali così prodotte presentino i segnali dei forzanti alle scale più risolte dai vari sensori, in genere non riescono a rilevare i forzanti locali; allora è necessario utilizzare un modello ad alta risoluzione innestato a due vie, detto two way nesting. In questo caso il modello ha al suo interno il forzante a scala locale, che agisce sulla scala meno risolta variandola, ed è quindi in grado di riprodurre con un'accuratezza maggiore i fenomeni locali.

In entrambi i casi, rimane comunque il problema della rappresentazione dello SLA, lo strato più basso dell'atmosfera che risponde direttamente a forzanti superficiali di vario tipo: frizione, evapo-traspirazione, trasferimento di calore, orografia ecc. Lo SLA è fortemente influenzato dalla superficie terrestre, quindi la sua variabilità nello spazio e nel tempo è molto maggiore di quella dell'atmosfera libera. Infatti, la superficie terrestre si scalda fortemente o si raffredda in risposta all'insolazione e attraverso i processi di trasporto a sua volta cambia lo SLA. La turbolenza è uno dei processi di trasporto più importanti. Nello SLA, il flusso orizzontale della massa d'aria è fortemente influenzato dal vento medio, che ne determina il trasporto di umidità, di calore e di momento; il trasporto verticale è dominato dalla componente turbolenta. Da quanto detto risulta chiaro che lo SLA controlla gli scambi tra l'atmosfera e il suolo e/o l'oceano, e quindi controlla il flusso di vapor acqueo e di calore. Questi due termini sono molto importanti per quel che riguarda la risposta a breve (tempo meteorologico) e lungo termine (clima) dell'atmosfera del nostro pianeta. Da qui la necessità di modellare correttamente la dinamica e la termodinamica dello SLA nei modelli climatici e di previsione meteorologica.

Questo è un problema complesso in quanto i tempi e la scala spaziale del moto turbolento sono molto diversi sia da quelli climatici sia da quelli meteorologici. Mentre le scale relative alla previsione meteorologica possono arrivare al km, per i modelli non idrostatici, la scala dei moti turbolenti, quali quelli che avvengono nello SLA, vanno dai pochi cm al km. Un esempio di tali moti è rappresentato dal riscaldamento diurno del suolo: nelle ore più calde della giornata il Sole scalda il suolo facendone evaporare l'acqua presente, determina la traspirazione delle piante e il moto turbolento trasporta il vapore acqueo dagli strati bassi nell'atmosfera libera. Il riscaldamento del suolo produce un rimescolamento dell'aria a contatto con esso innescando moti di tipo turbolento dell'ordine di 1÷100 m. È chiaro che sia i modelli a larga scala sia quelli alle scale più risolte hanno grosse difficoltà nel rappresentare correttamente i moti turbolenti.

Per poter effettuare una previsione meteorologica in genere si definisce una griglia su cui vengono integrate le equazioni e la distanza tra due punti stabilisce la risoluzione del modello; tutti i processi che avvengono a scala più piccola della distanza tra due punti sono chiamati di sottogriglia e devono essere parametrizzati. Da qui la necessità di parametrizzare il rimescolamento turbolento dello SLA che è, appunto, un processo di sottogriglia.

Per far ciò è necessario introdurre alcune definizioni: sia a una qualunque variabile meteorologica, ā la sua media spaziale sulla griglia e a′ i fenomeni di sottogriglia a essa associati. Inoltre valgono le seguenti regole di media di Reynolds : ā′=0, a′b_=0 ab=ab dove b è una qualunque altra variabile meteorologica. Se inseriamo queste definizioni nelle equazioni che governano il moto atmosferico tenendo conto delle definizioni precedenti e delle regole di Reynolds si ottengono dei termini del momento secondo del tipo a′b′ che rappresentano il flusso turbolento di una qualunque grandezza. Data questa trattazione, si ottengono almeno sei di questi termini per la sola equazione della conservazione del momento, che rappresentano la componente orizzontale e quella verticale: rispettivamente i tre termini della divergenza del flusso turbolento (u′u′,u′v′,v′v′) e i tre per il trasporto verticale turbolento (u′w′,v′w′,w′w′). Tali termini non sono noti a priori, quindi nel tentativo di trattare esplicitamente il rimescolamento turbolento abbiamo aggiunto altre incognite al nostro sistema di equazioni. Per ogni insieme finito di equazioni che descrivono il moto atmosferico la trattazione della turbolenza non permette di chiudere le equazioni: la descrizione statistica completa della turbolenza richiede un insieme infinito di equazioni. Questo problema è noto come il problema della chiusura. Una delle metodologie usate per la trattazione della turbolenza è quella di usare un numero finito di equazioni e scrivere le incognite dei flussi turbolenti in funzione delle variabili alle scale risolte. Per esempio, nella chiusura al 1o ordine i termini di rimescolamento turbolento sono espressi come funzione dei gradienti verticali della variabile alla scala risolta che è a sua volta trattata esplicitamente dalle equazioni dei momenti primi. Facciamo un esempio poniamo a=q (vapore acqueo) e b=V (campo vettoriale del vento) le cui componenti sono u, v e w. In questo caso si possono qualificare le chiusure come: (a) ordine zero, a significare che i flussi turbolenti vengono trascurati, per esempio −w′q′=0, cioè il trasporto turbolento di vapore è posto uguale a zero (la parametrizzazione di tipo bulk rientra in questa categoria); (b) ordine 1, implicando che il trasporto turbolento di vapore (momento secondo) è risolto in termini del vapore alla griglia risolta, cioè dei valori medi. Quindi:

[1] formula.

Questa è la chiusura più usata anche se presenta dei limiti in quanto k stesso varia al variare della turbolenza. È nota anche come teoria del trasporto di gradiente o k-theory; (c) ordine 2, implicando che il trasporto turbolento verticale del momento terzo è espresso attraverso un'equazione prognostica del momento secondo:

[2] formula.

Per gli ordini superiori di chiusura vale la stessa metodologia. Alcune chiusure utilizzano solo una parte delle equazioni per quella categoria di momento (per es., se nella chiusura all'ordine 1, oltre a risolvere i momenti secondi, si risolvono esplicitamente anche alcuni termini del momento terzo, la chiusura viene classificata come 1,5; se nella chiusura all'ordine 2, oltre a risolvere i momenti terzi, si risolvono alcuni termini dei momenti quarti la chiusura è di ordine 2,5 e così via).

Da quanto esposto si evince che all'aumentare dell'ordine della chiusura aumentano le equazioni e la capacità di calcolo necessaria aumenta proporzionalmente. I risultati di alcuni studi hanno mostrato che utilizzando una chiusura di ordine superiore nei modelli per la dinamica atmosferica si ottiene una rappresentazione migliore della dinamica dello SLA: si ottiene uno strato ben rimescolato che aumenta in profondità durante le ore calde della giornata; si sviluppa il jet notturno con uno strato stabile vicino al suolo; l'intensità della turbolenza cresce correttamente fino a raggiungere valori grandi nelle ore diurne, ma rimane piccola di notte. Rimane il problema relativo alla stima di k, utilizzando la mixing length theory effettuata in funzione dei gradienti verticali del vento (shear del vento). Purtroppo ci sono dei limiti a questo metodo: (a) alcune relazioni sono valide solo nel caso di turbolenza sviluppata meccanicamente cioè in una atmosfera staticamente neutra, per esempio la relazione tra w′ e u′; (b) i gradienti verticali sono lineari solo per piccole distanze. Tali limiti comportano che questa teoria sia valida solo nel caso di piccoli vortici turbolenti, ma questo non sempre è vero nello SLA. Per ovviare a questa forte limitazione, in alcune parametrizzazioni è stato introdotto un termine detto di contro gradiente che permette a k di diventare negativo facendo fluire il trasporto nella direzione opposta al gradiente. Il meccanismo fisico che si vuole rappresentare in questo modo è quello dei grandi vortici associati all'aria calda che sale e che trasportano calore verso le zone più fredde indipendentemente dal gradiente locale dell'atmosfera circostante. Questo ha permesso di far funzionare una teoria costruita per i piccoli vortici anche nel caso di quelli grandi.

Infine, accenniamo brevemente al problema della tipologia della chiusura. In merito persistono due scuole di pensiero, quella della chiusura locale e quella della chiusura non locale.

Nella chiusura di tipo locale le variabili incognite in ogni punto dello spazio sono parametrizzate in termini della variabili note o dei loro gradienti su quel punto. Cioè la chiusura locale assume che la turbolenza si comporti come un processo diffusivo (fino al 3o ordine). Nel caso della chiusura non locale, invece, le variabili incognite in ogni punto dello spazio sono parametrizzate rispetto alle variabili note su più punti. Questo significa assumere che la turbolenza è descritta da vortici, ognuno dei quali trasporta il fluido come nel processo avvettivo e necessita della costruzione della matrice di transilienza. Questo tipo di chiusura è stata usata solo fino al 1o ordine. Esistono anche altri metodi oltre al locale, e non locale il bulk e la similarità.

Bibliografia

Arya 2001: Arya, Satya P., Introduction to micrometeorology, 2. ed., San Diego, Academic Press, 2001.

Clifford 1994: Clifford, Stephen e altri, Ground-based remote profiling in atmospheric studies: an overview, "Proceedings of the IEEE", 82, 1994, pp. 313-355.

Galati, Gilardini 2000: Tecniche e strumenti per il telerilevamento ambientale, a cura di Gaspare Galati, Aldo Gilardini, Roma, Consiglio Nazionale delle Ricerche, 2000.

Kaimal, Finnigan 1994: Kaimal, Jagadish C. - Finnigan, John J., Atmospheric boundary layer flows: their structure and measurements, New York, Oxford University Press, 1994.

King, Turner 1997: King, John C. - Turner, John, Antarctic meteorology and climatology, Cambridge, Cambridge University Press, 1997.

Lenschow 1986: Probing the atmospheric boundary layer, edited by Donald H. Lenschow, Boston, American Meteorological Society, 1986.

Nieuwstadt, van Dop 1982: Atmospheric turbulence and air pollution modelling, edited by Frans T. Nieuwstadt, Han van Dop, Dordrecht, Reidel, 1982.

Sozzi 2002: Sozzi, Roberto - Georgiadis, Teodoro - Valentini, Mauro, Introduzione alla turbolenza atmosferica: concetti, stime, misure, Bologna, Pitagora, 2002.

Stull 1988: Stull, Roland B., Introduction to boundary layer meteorology, Dordrecht, Kluwer, 1988.