autocovarianza

autocovarianza

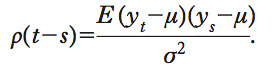

Covarianza tra elementi di una serie storica in diversi istanti di tempo. L’a. è quindi una misura del grado di dipendenza o memoria delle variabili che compongono una serie storica. Nel caso di una serie storica stazionaria {yt} a media μ e varianza σ2, l’a. tra yt e ys dipende solo dalla loro distanza ∣t−s∣ e si scrive (per t≥s) yt−s= E(yt−μ) (ys−μ). In particolare, y0=σ2 coincide con la varianza del processo. L’a., vista come funzione della distanza ∣t−s∣, è detta funzione di autocovarianza. Dividendo per la varianza del processo, si ottiene la funzione di autocorrelazione che, sempre nel caso di una serie storica stazionaria, si scrive

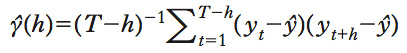

Dalla disuguaglianza di Cauchy-Shwartz, risulta che yh≤σ2, il che implica ρ(h)2≤1. Come la correlazione, l’autocorrelazione è una misura assoluta, indipendente dalla scala delle variabili yt che compongono il processo. Un’autocorrelazione uguale a più o meno 1 equivale a una perfetta relazione lineare tra yt e ys, positiva o negativa, vale a dire che esistono due costanti a e b per cui yt=a+bys. Se invece ρ(∣s−t∣)=0, vuol dire che le due variabili yt e ys sono incorrelate. Data una serie storica di lunghezza T, stazionaria in media e varianza, y1, ..., yt, è possibile stimare in maniera consistente la funzione di a. tramite lo stimatore

dove ŷ è la media campionaria della serie storica. In un modello di regressione con serie storiche la presenza di autocorrelazione negli errori è un problema che può portare a una perdita di efficienza nella stima dei minimi quadrati e a una stima non corretta della varianza delle stime dei coefficienti di regressione. Un possibile test per la verifica della presenza di autocorrelazione negli errori è il test di Durbin-Watson (➔).