Epidemiologia: morbilità e mortalità

Epidemiologia: morbilità e mortalità

L'epidemiologia è una disciplina collocata nell'ambito della medicina e della sanità pubblica. I suoi contributi principali consistono nel misurare la frequenza di malattie o di condizioni di salute, nel fornire le basi per l'adozione di misure di prevenzione a livello di popolazione e nel guidare gli interventi di prevenzione, diagnosi e terapia nei singoli pazienti. Esempi delle domande più frequentemente poste agli epidemiologi sono: qual è l'incidenza dell'epatite C fra gli adolescenti, o la prevalenza del diabete nella popolazione? Qual è la probabilità che un individuo di cinquantacinque anni, fumatore e iperteso, sia interessato da un evento cardiovascolare nei dieci anni successivi? Come cambia il rischio qualora egli inizi una terapia anti-ipertensiva e smetta di fumare? Serve sottoporsi a una pratica di screening per fare una diagnosi precoce di una patologia e quindi diminuire i rischi per il paziente? Come si valuta l'efficacia di una nuova terapia? Perché nell'Europa del Nord ci si ammala di più di cardiopatia coronarica rispetto all'Europa del Sud? Perché in alcune popolazioni l'ipertensione arteriosa è più frequente rispetto ad altre popolazioni? Perché alcuni ipertesi vengono colpiti da ictus, mentre altri no?

Come si può notare da queste domande, gran parte delle attività di quantificazione delle malattie e di verifica di ipotesi causali che si affrontano in medicina e sanità pubblica è di tipo epidemiologico. L'epidemiologia è caratterizzata da strumenti teorici e misure pratiche che permettono di stabilire la frequenza (ossia l'incidenza e la prevalenza) di alcune patologie, nonché di valutare l'importanza dei fattori di rischio o dei potenziali determinanti di malattie o eventi relativi alla salute. Gli studi epidemiologici possono dunque essere sia di tipo descrittivo sia di tipo eziologico. In quest'ultima categoria rientrano le ricerche volte a valutare una relazione causa-effetto, che possono essere sperimentali oppure osservazionali. L'epidemiologia ha quindi un ruolo centrale nella medicina e nella sanità pubblica. Grazie a essa è possibile valutare l'efficacia e la sicurezza dei trattamenti medici. L'uso dei dati epidemiologici può anche essere utile nella diagnosi precoce delle malattie (screening), proprio mediante l'analisi statistica dei processi causali coinvolti nell'insorgere di una patologia.

I risultati di uno studio epidemiologico possono però essere distorti da diversi fattori, cui bisogna prestare particolare attenzione: la composizione del campione o la peculiare natura di una patologia possono, per esempio, portare a sottostimare o sovrastimare l'importanza di un fattore di rischio o della frequenza di una condizione. Va inoltre sottolineata la difficoltà che l'epidemiologia incontra nello stabilire precisi criteri che identifichino senza dubbi una relazione di causalità tra diverse variabili; l'esempio più noto è quello dell'associazione tra fumo di sigarette e numerose patologie, tra cui il cancro ai polmoni. L'adozione delle numerose leggi per limitare i danni del fumo di sigaretta è uno dei tanti esempi del contributo fattivo dell'epidemiologia alla gestione dei rischi sanitari presenti nella società odierna.

Misure epidemiologiche

Una condizione indispensabile per svolgere un'attività epidemiologica consiste nell'ottenere conoscenze sulla frazione N/D, dove D sta per il totale della popolazione in studio e N è il numero di malati o il numero di soggetti inizialmente sani che si ammaleranno nel tempo, appartenenti alla stessa popolazione. Se si conosce solo il numeratore senza far riferimento alla popolazione si fa medicina clinica; se invece si lavora solo con il denominatore si fa demografia. L'epidemiologia lavora su grandi numeri, ma soprattutto sul rispetto e sulla conoscenza del rapporto sopra descritto. Le misure in epidemiologia appartengono a due categorie: le 'misure di frequenza' e le 'misure di effetto'. Le prime (divise in incidenza e prevalenza) servono a misurare la frequenza con la quale insorge un evento acuto, o è presente uno stato in una popolazione; le seconde consentono di stimare se un determinato fattore di rischio, o un fattore protettivo, modifichi la frequenza con la quale si verificano gli eventi di interesse nella popolazione.

Incidenza

Le principali misure di frequenza sono l'incidenza ‒ proporzione di incidenza e densità di incidenza ‒ e la prevalenza. L'incidenza misura la frequenza con la quale insorgono nuovi eventi in una popolazione a rischio, cioè priva dell'evento all'origine dello studio. L'incidenza di un evento (malattia, morte, ecc.) in una popolazione è la proporzione di popolazione che sviluppa l'evento (o si ammala o muore) in un periodo di tempo predefinito. Questa misura prende il nome di 'proporzione di incidenza' o anche di 'incidenza cumulativa'. La proporzione di incidenza può variare da un minimo di zero, quando nessun soggetto della popolazione a rischio sviluppa l'evento in studio, a un massimo di 1 (100%) quando tutti i soggetti a rischio lo sviluppano. I soggetti in studio rappresentano una popolazione chiusa, in quanto l'inclusione dipende da una circostanza iniziale che non può essere modificata: per esempio, avere effettuato una vaccinazione. In generale, la proporzione di incidenza (PI) di un evento si misura come il rapporto tra i nuovi eventi e la popolazione candidata all'inizio dello studio.

La proporzione di incidenza può anche essere interpretata come probabilità di insorgenza dell'evento in studio all'interno della popolazione. A livello di individuo, ci si riferisce al rischio di sviluppare l'evento. Un esempio di proporzione di incidenza è fornito dal cosiddetto 'tasso d'attacco', misura frequentemente utilizzata nell'epidemiologia delle malattie infettive o cardiovascolari, che considera il numero di eventi che si verificano in una popolazione a rischio, indipendentemente dal fatto che si tratti di un primo evento o di una ricaduta. Un altro esempio di incidenza è la letalità, che si riferisce alla proporzione di decessi sul totale dei soggetti ammalati ed esprime la gravità di una malattia. Tenuto conto che la letalità, come qualunque forma di proporzione di incidenza, è fortemente influenzata dalla durata dell'osservazione, è indispensabile definire l'intervallo temporale preso in esame (per es., letalità a un'ora, a ventiquattro ore, a ventotto giorni, a sei mesi, a un anno). La mortalità nei trenta giorni successivi a un intervento di by-pass aorto-coronarico è una letalità: al numeratore della proporzione vi sono i soggetti deceduti entro trenta giorni dall'intervento e al denominatore tutti coloro che sono stati sottoposti all'intervento stesso. Se, per esempio, la mortalità complessiva nei trenta giorni successivi a un intervento di by-pass è stata nelle cardiochirurgie italiane dell'1,5%, questa proporzione nella popolazione di pazienti sottoposti all'intervento può anche essere interpretata come rischio individuale per un paziente medio che esegue l'intervento stesso. Se l'attenzione si concentra sul complemento della letalità si ottiene la sopravvivenza, e cioè la proporzione di soggetti in una popolazione che non si ammala, o non sviluppa l'evento, in un determinato intervallo di tempo.

Una persona può trovarsi a far parte di una popolazione a rischio non a seguito di una circostanza iniziale, ma in rapporto alla durata di permanenza o meno in una condizione di rischio. Si parla, in questi casi, di 'popolazione aperta' in quanto ciascun soggetto può passare da una condizione di rischio a una di assenza di rischio e viceversa. Per esempio, nel corso di un trattamento con farmaci anticoagulanti vi è un certo rischio di eventi avversi quali le emorragie. Tale condizione di rischio è presente durante il trattamento, si azzera quasi completamente in seguito alla sospensione e si ripresenta a un'eventuale ripresa del trattamento. Ciascun soggetto può essere esposto per un tempo variabile e quindi, conta (pesa) non in quanto singola persona, ma in rapporto alla durata di permanenza in trattamento. Il contributo di ciascun soggetto al periodo di rischio prende il nome di 'tempo-persona'. La misura di incidenza che si calcola in una popolazione aperta prende il nome di 'densità di incidenza' e si ottiene dividendo il numero di nuovi eventi (di malattia, di morte, ecc.) che insorgono in una popolazione, per la somma dei tempi di osservazione (tempi persona) di tutti gli individui della popolazione.

Dato che al denominatore vi è la somma dei tempi di osservazione di ciascun individuo della popolazione in studio, la densità di incidenza può variare fra 0 (quando non si verificano eventi) e infinito (nel caso in cui tutti gli individui sviluppano l'evento in un tempo infinitesimo), e ha come unità di misura il reciproco del tempo (t−1). La densità di incidenza tiene conto, quindi, non solo del verificarsi di nuovi eventi, ma anche della velocità con la quale questi insorgono. All'incidenza si fa in genere riferimento come tasso di incidenza, anche se a rigore si può parlare di tasso di incidenza solo nel caso della densità di incidenza, e cioè quando il denominatore è rappresentato da tempi persona.

Prevalenza

Mentre l'incidenza riguarda il verificarsi di nuovi eventi, la prevalenza misura la frequenza con la quale è presente uno stato (o condizione o malattia) in una popolazione. La prevalenza misura quindi la proporzione di popolazione che presenta la condizione o malattia di interesse. Per esempio, affermare che la prevalenza del morbo di Alzheimer nella popolazione ultrasessantacinquenne è del 5% significa che, in media, ogni cento persone di età superiore a 65 anni, cinque sono affette da questa patologia. La prevalenza può essere riferita a un qualunque sottogruppo di popolazione (identificato in base all'età, al sesso, a una condizione fisiopatologica, ecc.). Per esempio, si può parlare di prevalenza di osteoporosi nella popolazione femminile in postmenopausa, di prevalenza di retinopatia fra i pazienti con diabete, ecc. L'entità della prevalenza è determinata da due valori: la frequenza con la quale si verificano nuovi eventi della condizione di interesse nella popolazione (l'incidenza) e la durata della condizione stessa. In una situazione di equilibrio (steady state), l'incidenza di nuovi casi e la durata della malattia sono costanti nel tempo; il numero di persone che si ammalano (e diventano casi prevalenti) è uguale al numero di coloro che smettono di essere malati (perché guariscono o muoiono). In questa situazione, la prevalenza può essere calcolata come prodotto dell'incidenza (I) per la durata media (D).

La prevalenza, essendo una proporzione, non ha unità di misura e può variare fra 0 e 1 (0-100%). Una malattia anche molto frequente ma di breve durata, perché di rapida guarigione o perché rapidamente fatale, potrebbe avere una prevalenza minore di una malattia più rara ma con evoluzione lenta. Per esempio, nonostante l'influenza possa raggiungere livelli di incidenza elevati (nei periodi epidemici invernali si ammala oltre il 30% della popolazione), la prevalenza di influenza nei periodi estivi è praticamente zero. Viceversa, nonostante l'incidenza annuale di nuovi casi di aritmie che richiedono l'impianto di un pacemaker sia quasi irrilevante, tenuto conto che lo stato di portatore è cronico, si raggiungono livelli di prevalenza più consistenti nella popolazione. Una misura utilizzata sempre più spesso nella letteratura epidemiologica è la life-time prevalence ('prevalenza nel corso della vita'), la quale identifica la probabilità che, nello svolgimento dell'intera vita, un individuo sviluppi una condizione o una malattia. Un esempio è fornito da affermazioni del tipo "nel corso della vita circa il 20% della popolazione ha almeno un episodio di depressione maggiore, che richiede un intervento terapeutico di sostegno". Questa misura si identifica, in realtà, con la proporzione di incidenza (o incidenza cumulativa), in quanto esprime la proporzione di individui che sviluppa una determinata condizione o malattia nel corso di un determinato periodo di tempo, fra coloro che ne erano privi all'inizio del periodo in esame. La prevalenza misura la frequenza di uno stato. È, quindi, uno strumento idoneo alla rappresentazione (quantificazione) di condizioni che presentano una lunga durata. Il concetto di prevalenza è anche di grande utilità per effettuare la diagnosi a livello individuale. Infatti, la probabilità diagnostica che in una persona sia presente una certa condizione o malattia è equivalente alla prevalenza della stessa condizione o malattia in una popolazione di individui con caratteristiche simili (per fattori di rischio e sintomi di presentazione) a quelle del soggetto di interesse.

Misure di effetto

Una volta quantificata la frequenza di una malattia in una popolazione che presenta uno specifico insieme di fattori di rischio, il passaggio successivo è quello di verificare se la misura ottenuta è diversa rispetto a quella di una popolazione che presenta fattori di rischio differenti. Per esempio, se noi conosciamo l'incidenza di trombosi venosa profonda fra le donne che usano contraccettivi orali di terza generazione, ci rimane ancora da chiarire se questa incidenza è maggiore, o minore, rispetto a quella di donne che utilizzano, per esempio, i contraccettivi di seconda generazione. Le misure di effetto servono a confrontare l'incidenza in gruppi differenti. Assumiamo, per esempio che, sulla base di studi effettuati, la densità di incidenza di trombosi venosa profonda fra le donne che usano contraccettivi orali sia di circa 3 per 10.000 anni-persona per i contraccettivi di terza generazione, e di circa 2 per 100.000 anni-persona per quelli di seconda generazione. Come accennato in precedenza, l'incidenza consente di ottenere una stima, oltre che del complesso degli eventi attesi in base ai livelli d'uso, anche del rischio individuale. Per esempio, una donna che utilizzi per circa 10 anni un contraccettivo orale di terza generazione ha una probabilità di circa lo 0,3% di sviluppare una trombosi venosa (10×3 per 10.000).

Il confronto delle incidenze può essere rappresentato sia come differenza sia come rapporto. Nella differenza fra incidenze di due popolazioni si ottiene una stima del numero di eventi che si sarebbe potuto prevenire utilizzando, per esempio, il farmaco meno rischioso: nel caso appena esposto, un evento ogni 10.000 anni-persona. Se questa differenza viene rapportata alla popolazione con l'incidenza maggiore, otteniamo una stima della proporzione di eventi che si sarebbero prevenuti passando al farmaco meno rischioso. Questa misura è anche nota come 'rischio attribuibile fra gli esposti' (RAe), o frazione eziologica o frazione prevenibile. Con i dati precedenti si ottiene: RAe=(3/10.000−2/10.000)/(3/10.000)=33%. Questa misura indica che il 33% degli eventi che si verificano fra le donne che fanno uso di contraccettivi di terza generazione si sarebbe potuto prevenire utilizzando i contraccettivi di seconda generazione. Si potrebbe anche essere interessati a conoscere l'impatto sul complesso della popolazione dell'esposizione in studio: si parla in questo caso di 'rischio attribuibile nella popolazione' (RAp), il quale esprime l'effetto atteso, di popolazione, in conseguenza della rimozione di un fattore di rischio. Se p è la proporzione di popolazione esposta al fattore di rischio in studio, allora il rischio attribuibile di popolazione si calcola come RAp=RAe * p. Come si vede, l'effetto complessivo non dipende solo dall'entità della differenza fra incidenze, ma anche dalla diffusione dell'esposizione. Ovviamente, quanto maggiore è la diffusione di un fattore di rischio, tanto prevalente è la potenziale riduzione di eventi ottenibile con la sua rimozione (e viceversa).

Oltre che come differenza, la relazione fra incidenze può anche essere espressa sotto forma di rapporto tra le incidenze di due popolazioni. Quest'ultimo è anche noto come 'rapporto fra tassi' (rate ratio) o come 'rischio relativo' (relative risk), a seconda che ci si riferisca a densità di incidenza (come nel caso in discussione) o a proporzioni di incidenza. In entrambe le situazioni, comunque, il rapporto indica di quanto l'incidenza di un evento sia maggiore (o minore) in un gruppo che presenta una certa esposizione rispetto a un gruppo di non esposti, o con un'esposizione alternativa. Per esempio, nel caso precedente il rapporto fra tassi è pari a 1,5 (3/10.000:2/10.000) e indica che nelle donne che utilizzano i contraccettivi di terza generazione vi è un aumento del 50% del rischio di sviluppare una trombosi venosa profonda rispetto alle donne che usano contraccettivi di seconda generazione. Ovviamente, la relazione fra le due incidenze può anche essere invertita: in questo caso il rapporto fra tassi è di 0,67 (2/10.000:3/10.000) e indica che nel primo gruppo l'incidenza è il 33% più bassa rispetto al secondo gruppo.

Il rischio relativo (o il rapporto fra tassi) è una delle misure più frequentemente usate per sintetizzare i risultati degli studi epidemiologici sperimentali e non sperimentali. È utile osservare che il rischio relativo (o rapporto fra tassi) e il rischio attribuibile sono collegati: RAe=(RR−1)/RR. In alcuni casi, il confronto fra incidenze non avviene fra gruppi con esposizioni differenti, ma fra un gruppo di esposti e la popolazione generale. Ciò accade, per esempio, per i gruppi con medesime esposizioni lavorative, per i quali può essere difficile individuare un gruppo di controllo simile per caratteristiche generali tranne che per l'esposizione in studio. Si utilizza, in questi casi, l'incidenza nella popolazione generale, a parità di età e sesso, assumendo che, se il gruppo di esposti è relativamente ridotto rispetto alla popolazione generale, non ne dovrebbe influenzare l'incidenza. Confrontando il numero di eventi osservati (O) nel gruppo di esposti con il numero di eventi attesi (A) in base all'incidenza della popolazione generale, si ottiene una misura nota come SMR (Standardised morbidity ratio, o Standardised mortality ratio) o 'rapporto standardizzato di morbilità o di mortalità', rappresentata dal rapporto tra 'numero di eventi osservati' e 'numero di eventi attesi'. Questa misura viene interpretata come il rischio relativo: una SMR maggiore di 1 indica che si osservano più casi di quelli attesi in base all'incidenza della popolazione generale, e viceversa per una SMR minore di 1.

Studi epidemiologici

In rapporto alla finalità dell'indagine, gli studi epidemiologici possono essere classificati in eziologici, cioè mirati a studiare la possibile relazione causale fra un'esposizione (o un fattore di rischio) e un evento, e in descrittivi, cioè mirati a ottenere una misura di frequenza di una malattia o di un fattore di rischio. Gli studi eziologici possono essere suddivisi in sperimentali e non sperimentali (anche detti osservazionali), in rapporto al ruolo assunto dallo sperimentatore o osservatore.

Studi sperimentali

La principale caratteristica degli studi sperimentali consiste nel fatto che lo sperimentatore manipola le condizioni nelle quali avviene l'esperimento, in modo da isolare il contributo, l'effetto, di un intervento specifico. In medicina, l'applicazione più frequente delle sperimentazioni riguarda la valutazione delle terapie, e si realizza di norma attraverso il confronto fra gruppi di popolazione nei tassi di incidenza di eventi (complicanze, decessi, ecc.). L'attribuzione dei soggetti ai gruppi in studio viene decisa dallo sperimentatore. In particolare, al fine di valutare il contributo specifico di un intervento, l'intento dello sperimentatore è quello di creare gruppi a confronto il più possibile simili per tutte le caratteristiche che possono influenzare l'esito, tranne appunto l'intervento in studio. I gruppi a confronto possono essere resi simili utilizzando diverse tecniche. Si può, innanzitutto, appaiare a ciascun soggetto, che in un gruppo presenti una certa caratteristica (per es., età, sesso, pressione arteriosa, ecc.), un altro con le stesse caratteristiche nel gruppo di confronto. Il limite principale di questa modalità è che, mano a mano che aumentano le caratteristiche per le quali si intende effettuare l'appaiamento, si riduce notevolmente la probabilità di trovare un soggetto con le stesse caratteristiche.

Il metodo più frequentemente utilizzato per rendere simili i gruppi a confronto è quello della randomizzazione, la quale consiste nell'attribuzione casuale dei soggetti ai diversi gruppi in studio. Il principale vantaggio rispetto alle altre tecniche disponibili è quello di produrre gruppi a confronto che, all'aumentare del numero dei soggetti coinvolti, tendono a essere simili non solo per le caratteristiche note (e sulle quali si potrebbe teoricamente fare l'appaiamento), ma anche per tutte le altre caratteristiche individuali. La randomizzazione, inoltre, con la realizzazione di gruppi simili, fornisce le condizioni per l'applicazione delle tecniche statistiche di analisi dei dati. Gli studi sperimentali possono riguardare interventi di prevenzione primaria (come l'eliminazione di un fattore di rischio ambientale), di profilassi (per es., una vaccinazione), o terapeutici (quali una terapia farmacologica o un trattamento chirurgico). Se l'attribuzione dei soggetti ai trattamenti in studio avviene a livello non individuale ma di interi gruppi di popolazione, si realizza una 'sperimentazione di comunità' (community trial). In entrambi i casi, l'eventuale differenza di incidenza che si osserva fra i gruppi può essere attribuita in modo causale all'intervento in studio.

Studi non sperimentali

Gli studi non sperimentali sono disegnati con l'obiettivo di simulare una sperimentazione in tutti i casi in cui ragioni etiche o pratiche la rendano impraticabile. La caratteristica che contraddistingue tali studi rispetto a quelli sperimentali riguarda l'attribuzione dei soggetti, che non è definita dal ricercatore (come parte di un protocollo di studio). La possibilità di confrontare i gruppi considerati (nei fattori prognostici e nella raccolta delle informazioni) è il principale determinante della validità (cioè dell'assenza di distorsioni, o bias) di questi studi.

Studi di coorte

Una coorte può essere rappresentata da un qualunque gruppo di individui che condivida una determinata caratteristica o esposizione: un fattore di rischio, l'anno di nascita, la professione, l'uso di un farmaco, ecc. Gli studi di coorte sono anche detti longitudinali, in quanto i soggetti in studio sono seguiti nel tempo, per valutare l'incidenza con la quale insorgono eventi fra coloro che presentano o meno l'esposizione in studio. Tipicamente, l'incidenza di eventi in una coorte che presenta una determinata esposizione viene confrontata con quella in una coorte simile, tranne che per l'assenza dell'esposizione. L'intento è quello di ricreare gruppi a confronto (coorti) che siano simili per i fattori di rischio dell'evento, tranne che nell'esposizione in studio. Così come negli studi sperimentali, l'eventuale differenza di incidenza può essere interpretata in modo causale. In rapporto all'obiettivo specifico dello studio, i gruppi di popolazione possono essere seguiti per periodi di tempo anche considerevolmente lunghi (per es., diversi decenni). In questi casi, dopo un esame iniziale vengono effettuati riesami periodici a intervalli regolari (per es., sei mesi, un anno, cinque anni, ecc.) che servono a cogliere le variazioni nei fattori di rischio (per es., variazione del peso) o il passaggio dallo stato di assenza di malattia a quello di presenza di malattia. Gli studi di coorte possono riguardare anche soggetti che presentano una determinata malattia. Essi vengono seguiti nel tempo per studiarne l'evoluzione (storia naturale), anche al fine di mettere in evidenza fattori prognostici dell'evoluzione. Si parla in questi casi di 'studi di prognosi'. Uno dei fattori limitanti degli studi di coorte è che tendono a essere molto lunghi, costosi e complessi da gestire.

Studi caso-controllo

Non deve trarre in inganno la presenza della parola controllo. In tutti gli studi epidemiologici è presente un confronto fra un gruppo che presenta l'esposizione (o il trattamento) di interesse e un altro che non possiede alcuna esposizione o ha un'esposizione alternativa. Uno studio caso-controllo va concepito come uno studio di coorte nel quale: i 'casi' rappresentano tutti i casi di malattia che si sarebbero verificati in una ipotetica coorte, cioè il numeratore dei tassi di incidenza; i 'controlli' rappresentano un campione della popolazione che ha dato origine ai casi, cioè del denominatore dei tassi di incidenza. Uno studio caso-controllo può essere effettuato su qualsiasi popolazione di pazienti (casi). I controlli sono soggetti senza l'evento/malattia in studio, e devono essere selezionati in modo da rappresentare coloro che, se avessero sviluppato la malattia, sarebbero stati selezionati come casi. Casi e controlli sono confrontati riguardo all'esistenza di una caratteristica o di un'esposizione rilevante, che si vuole testare quale determinante dell'evento in studio. Come in uno studio di coorte, la rilevazione dell'esposizione deve precedere la malattia (compresi i sintomi di esordio) e deve essere rilevata con la stessa qualità per casi e controlli.

Negli studi caso-controllo, a differenza di quelli di coorte, viene spesso a mancare una chiara identificazione della popolazione di origine e non è di conseguenza possibile calcolare l'incidenza. Tuttavia, gli studi caso-controllo consentono di calcolare una misura di effetto equivalente al rischio relativo: l'Odds ratio (OR). Come per il rischio relativo, l'OR indica quante volte l'incidenza di un evento è maggiore (o minore) fra gli esposti rispetto ai non esposti. L'OR è quindi una misura che fornisce le stesse informazioni del rischio relativo, anche in mancanza di misure di incidenza. Gli studi caso-controllo sono particolarmente indicati per valutare una relazione causale nella quale l'evento è raro e/o si verifica dopo un lungo periodo di induzione (il tempo necessario perché una causa possa produrre un determinato effetto). Spesso gli studi caso-controllo sono presentati come retrospettivi, in quanto al momento in cui vengono condotti sia l'esposizione sia l'evento di interesse si sono già verificati. Tuttavia, è importante tenere presente che, come negli studi di coorte, la relazione in studio è sempre fra esposizione ed evento (o malattia o decesso), nel senso che l'esposizione deve comunque precedere l'insorgenza dell'evento.

Studi trasversali

Gli studi trasversali consistono nell'esaminare un campione di popolazione in un dato momento al fine di misurare, contemporaneamente, la prevalenza di una condizione e la presenza di un'esposizione. Si possono considerare, in qualche modo, una fotografia di uno stato della realtà. Sono studi soprattutto utilizzati per effettuare indagini sullo stato di salute della popolazione e per la programmazione dei servizi sanitari. Sono misure di prevalenza molti degli indicatori utilizzati nella descrizione dello stato di salute della popolazione. Inoltre, gran parte dell'assistenza sanitaria deve essere programmata sulla base delle esigenze espresse dalla prevalenza delle malattie croniche. Che si tratti dell'assistenza agli anziani non autosufficienti, dei servizi per tossicodipendenti, del follow up dei pazienti diabetici, o ipertesi, o asmatici, o affetti da morbo di Parkinson, e così via, il carico di lavoro è sostanzialmente determinato da quella quota di pazienti che continua a far parte del pool dei casi prevalenti anche dopo ciascun episodio di assistenza.

Sono invece meno frequenti gli studi trasversali condotti con finalità di tipo eziologico. In primo luogo, vi sono difficoltà nell'interpretare correttamente la sequenza temporale fra esposizione e malattia. Soprattutto per condizioni insorte da diversi anni, può diventare difficile accertare se un possibile fattore di rischio abbia preceduto o meno l'insorgenza della malattia. In secondo luogo, anche se la relazione temporale è definita (e il fattore in studio precede l'insorgenza della malattia) ciò non è sufficiente per identificare il fattore in studio quale causa (e non addirittura quale fattore protettivo) della malattia in esame. La ragione è che i casi di malattia prevalenti sono una selezione di tutti i casi di malattia, rappresentata da coloro che sono sopravvissuti. In una popolazione di questo tipo, alcune delle caratteristiche possedute non solo non sono causa della malattia in esame, ma potrebbero rappresentarne la causa della sopravvivenza. Per questi motivi, ormai quasi tutti gli studi di epidemiologia eziologica riguardano solo casi incidenti della malattia in studio.

Studi descrittivi di morbilità e mortalità

Per descrivere lo stato di salute di una popolazione è importante conoscerne l'ampiezza, la struttura e la crescita negli anni. Bisogna inoltre identificare i sottogruppi vulnerabili in termini di impatto di malattia, come gli anziani, le donne nel periodo riproduttivo, i bambini. Il censimento, condotto periodicamente, descrive le varie caratteristiche della popolazione ed è la principale fonte di informazione utilizzata dai governi per scopi economici e sociali. Nel censimento, tuttavia, sono raccolte poche informazioni sullo stato di salute. Gli eventi chiave e i fenomeni correlati con la struttura della popolazione sono i decessi (mortalità), le nascite (fertilità), i matrimoni e le migrazioni (immigrazioni ed emigrazioni); i primi tre costituiscono la base per le statistiche demografiche disponibili e obbligatorie per tutti i Paesi industrializzati; non sono sempre attendibili per i Paesi in via di sviluppo.

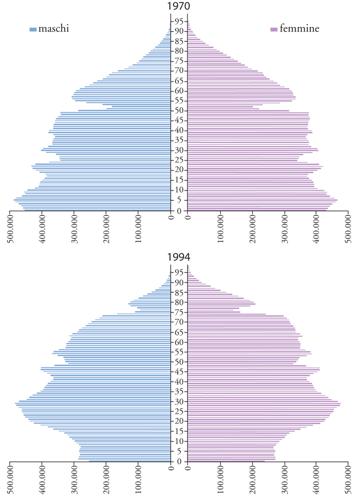

La variazione della composizione per età della popolazione italiana è documentata nella fig. 2 dal confronto delle piramidi relative alla distribuzione per età della popolazione italiana per gli anni 1970 e 1994: la notevole e progressiva riduzione della natalità, che si è verificata in questi anni, ha prodotto una sensibile riduzione della base, ovvero di quella porzione del grafico relativa alle fasce di età più giovani e, contemporaneamente, la riduzione della mortalità nelle età più anziane ha portato all'ampliamento dell'apice della piramide; l'allargamento della porzione superiore è maggiore nelle donne che, a partire dalla quarta decade di età costituiscono la maggioranza della popolazione. Anche l'aspettativa di vita è aumentata: oggi nella popolazione italiana, una delle più longeve, la speranza di vita alla nascita si aggira intorno ai 79 anni per gli uomini e agli 82 anni per le donne, con un incremento di un anno di vita media ogni 3-4 anni di calendario. La proporzione di persone di età uguale o superiore a 65 anni aumenta di conseguenza: oggi si attesta intorno al 16% e si stima che nel 2050 sarà intorno al 30%, mentre la proporzione di grandi anziani (età uguale o superiore a 80 anni) è attesa intorno all'11%.

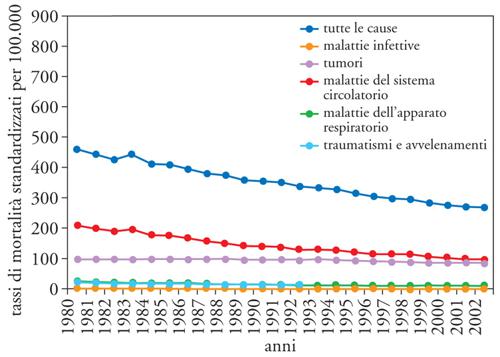

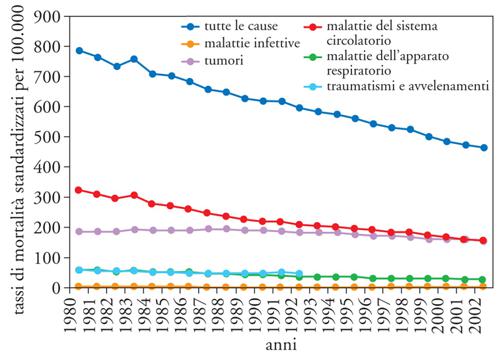

La disponibilità di oltre un ventennio di dati di mortalità rilevati e codificati dall'ISTAT con criteri omogenei offre l'opportunità per delineare un quadro dell'evoluzione della mortalità per causa (figg. 3 e 4). Sono state considerate la mortalità totale, per malattie infettive, per tutti i tumori, per le malattie del sistema circolatorio, per le malattie dell'apparato respiratorio e per traumatismi e avvelenamenti: il quadro che emerge è caratterizzato da un lento e graduale decremento in entrambi i sessi della mortalità totale. Questo quadro favorevole è il risultato della positiva evoluzione della mortalità per le principali cause, e in particolare per quelle dovute alle malattie del sistema circolatorio. I determinanti alla base di questa riduzione vanno ricercati nella prevenzione primaria e secondaria; nell'identificazione dei fattori di rischio, quali l'abitudine al fumo e l'eccessivo peso corporeo; nei trattamenti medici in presenza di condizioni altrimenti a elevato rischio di morte, siano essi farmacologici, come le medicine contro l'ipertensione arteriosa e i farmaci trombolitici nella fase acuta della malattia, o investano le tecniche chirurgiche come, in ambito cardiochirurgico, i by-pass e le protesi valvolari.

Rilevazione degli eventi e dell'esposizione

Indipendentemente dal tipo di studio, è importante che la rilevazione di un evento, dello stato di malattia, dell'esposizione o di un fattore di rischio, avvenga in modo accurato e riproducibile. Per accuratezza, si intende la capacità di un metodo di fornire misure vicine alla realtà e per ogni tipo di analisi possono essere identificati i limiti entro i quali una tecnica può essere considerata accurata. Per precisione, si intende la capacità di un metodo di fornire misure coerenti quando utilizzate più volte (anche se i valori possono non essere accurati). Metodologie validate e oggettive consentono che la rilevazione sia accurata anche se effettuata da più osservatori e in tempi diversi. Esempi tipici di metodologie oggettive sono i questionari sul fumo, sull'attività fisica, sull'alimentazione, quando validati da misure dirette quali il tiocianato, le prove da sforzo, la vitamina C nel siero. Devono, inoltre, essere stabiliti i criteri diagnostici per definire la presenza di un evento (o malattia). Questi devono essere standardizzati e in grado di limitare l'influenza soggettiva. Un esempio tipico concerne la definizione di infarto del miocardio: il criterio diagnostico utilizzato in clinica può essere differente da quello utilizzato in uno studio epidemiologico. Una definizione accurata e riproducibile di infarto del miocardio è basata sulla combinazione di dolore (sede e durata), enzimi cardiaci (valori entro le 72 ore dall'inizio della sintomatologia), elettrocardiogramma (letto secondo il codice Minnesota), storia pregressa di cardiopatia ischemica, autopsia. Particolare attenzione va rivolta alla possibilità che la diagnosi degli eventi possa essere influenzata dalla conoscenza di un'esposizione precedente o di un fattore di rischio. In questi casi, la modalità più frequentemente utilizzata consiste nella restrizione ai casi manifesti e più gravi, i quali arrivano alla diagnosi in ogni caso, indipendentemente appunto dalle conoscenze di contesto.

Fonti di informazione

I sistemi di raccolta dei dati medico-sanitari non sono progettati per ottenere informazioni il cui scopo primario sia la ricerca epidemiologica. Per esempio, i certificati di morte sono stati creati per scopi demografici, gli archivi sull'assenteismo dal lavoro per la determinazione delle cause di inabilità al lavoro e per finalità pensionistiche. Queste sono le ragioni per le quali le singole fonti di informazione presentano diverse limitazioni: pertanto, esse vanno utilizzate congiuntamente per ottenere un quadro il più valido possibile sullo stato di salute o di malattia della popolazione. Va ricordato inoltre che tali fonti variano nel tempo e nello spazio: pertanto bisogna valutarle per il loro utilizzo a seconda dell'obiettivo da affrontare. Di seguito verranno descritte le principali fonti informative utilizzabili per scopi epidemiologici: i certificati di morte, i registri e i dati correnti raccolti per altre finalità all'interno del Servizio sanitario nazionale (SSN).

Certificati di morte

Questi certificati sono di grande interesse in epidemiologia, in quanto riguardano eventi certi, raccolti in modo sistematico e continuo in tutti i Paesi del mondo, e vengono utilizzati in statistiche facilmente accessibili. Queste statistiche sono costruite sulla base della causa principale di morte, vengono pubblicate ogni anno, ma sono rese note in forma completa e sufficientemente dettagliata con un ritardo di tre-quattro anni. I criteri diagnostici per la codifica dei certificati di morte sono definiti a livello internazionale (International classification of diseases and causes of death) e la nomenclatura viene aggiornata dall'Organizzazione Mondiale della Sanità. Il numero di decessi per anno fornisce il numeratore degli indicatori di mortalità, mentre il denominatore (la popolazione) viene ricavato dal censimento o dalle stime intervallari della popolazione. Un indicatore della qualità della rilevazione delle cause di morte è costituito dalla proporzione di decessi che risultano nella categoria 'morti per causa sconosciuta': si considerano poco attendibili i dati di mortalità nei quali tale categoria superi il 5%.

Registri di malattia

Da molti anni esistono sistemi di registrazione obbligatoria per alcune malattie infettive, il cui inconveniente principale è rappresentato da una notevole sottostima dei casi denunciati. Denunce obbligatorie sono quelle per incidenti sul lavoro, malattie professionali, malformazioni congenite, aborto, malattie rare. In tempi più recenti sono stati attivati registri per malattie croniche, come i registri tumori e i registri per le malattie cardiovascolari, che presentano notevoli complessità organizzative. Questi registri sono riferiti a un'intera comunità (regione, provincia o comune) e raccolgono, appaiano e validano informazioni su casi raccolti sia attraverso i certificati di morte sia attraverso le cartelle cliniche; forniscono informazioni importanti sugli eventi fatali e non fatali, sulla letalità e sulla sopravvivenza a breve e a lungo termine.

Archivi di dati correnti del SSN

Rientrano in questo insieme di dati quelli raccolti routinariamente all'interno del SSN, rappresentati innanzitutto dalle schede di dimissione ospedaliera (SDO), dalle prescrizioni di farmaci, dalle prescrizioni di accertamenti diagnostici. Tali informazioni possono essere collegate tramite il codice individuale dell'assistito. Anche in questo caso, nell'utilizzare questi dati per scopi epidemiologici, bisogna tenere conto della diversa finalità per la quale sono stati raccolti. Per esempio, le diagnosi di dimissione contenute nelle SDO, per poter essere utilizzate all'interno di studi epidemiologici, devono di norma essere verificate con un confronto con le cartelle cliniche. Ancora, i dati di prescrizioni di farmaci in medicina generale rappresentano una informazione estremamente puntuale e di qualità. Tuttavia, i dati si riferiscono all'evento della prescrizione, o meglio alla dispensazione del farmaco dalla farmacia, e quindi sono un indicatore in parte indiretto, per quanto fortemente correlato, di esposizione a livello individuale. Sempre più frequentemente, infine, i clinici di medicina generale, per l'organizzazione della propria attività ambulatoriale, tengono nota di diagnosi, esami di laboratorio e terapie farmacologiche prescritte utilizzando software costruiti ad hoc per facilitare la pratica clinica. Gli archivi che ne derivano possono rappresentare una fonte molto ricca di dati, a condizione tuttavia che la qualità della registrazione, relativamente all'uniformità dei criteri diagnostici e alla completezza delle informazioni, sia adeguata.

Gli screening

Lo scopo fondamentale dello screening è quello di identificare precocemente una condizione di malattia in modo da poterne modificare la storia naturale. Affinché sia utile effettuare uno screening nella popolazione si devono realizzare due condizioni essenziali. In primo luogo, deve essere disponibile un intervento efficace, cioè in grado di migliorare la prognosi (diminuire l'incidenza di complicanze o ridurre la letalità). In assenza di interventi efficaci, l'anticipazione diagnostica che si ottiene non rappresenta un miglioramento della sopravvivenza, ma solo un aumento del tempo in cui si convive con la malattia. In secondo luogo, deve essere disponibile un test in grado di identificare una malattia nella fase asintomatica, e cioè prima della diagnosi clinica. Poiché i test di screening sono progettati per essere applicati su una vasta popolazione, essi devono essere semplici, veloci, poco costosi e non devono arrecare danno alla popolazione.

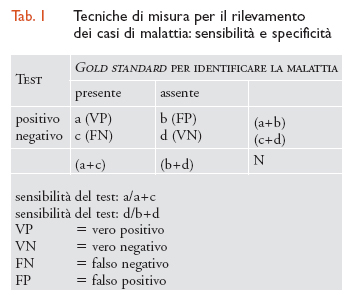

Le tecniche utilizzate per rilevare i casi di malattia dovrebbero essere in grado di separare un caso da un 'non caso', ma in termini pratici nessuna tecnica è in grado di operare una discriminazione completa nella popolazione. La capacità di una metodica di discriminare i sani dai malati viene valutata mediante la sensibilità e la specificità. La sensibilità è la capacità di un test di riconoscere il maggior numero possibile di veri positivi: un test è tanto più sensibile quanto più è in grado di identificare i malati. La specificità è la capacità di un test di riconoscere il maggior numero possibile di veri negativi; in altre parole un test è tanto più specifico quanto più è in grado di identificare le persone sane. È difficile sviluppare tecniche che siano contemporaneamente molto specifiche e molto sensibili: di solito se viene artificialmente aumentata la sensibilità, si riduce la specificità e viceversa. Sensibilità e specificità si misurano quando è a disposizione uno standard di riferimento (gold standard, tab. 1).

All'entusiasmo che ha accompagnato i primi anni di applicazione degli screening è utile unire una maggiore dose di cautela. Oltre al caso già citato dell'anticipazione diagnostica, si deve tenere conto che risultati apparentemente buoni di alcuni screening possono derivare dal fatto che i soggetti che vi si sottopongono sono autoselezionati, cioè persone in genere più attente al loro stato di salute. Infine, oltre ai possibili rischi che possono accompagnare l'esecuzione di un test di screening (si pensi ai rischi seppure molto limitati di perforazione dell'intestino durante l'esecuzione di una colonscopia), va considerato che la diagnosi di una malattia rende gli individui più ansiosi sul proprio futuro. Questo è il motivo per cui i programmi di screening dovrebbero essere valutati attraverso studi sperimentali accuratamente controllati e valutati attraverso un'analisi beneficio-rischio. Il principio accettato è che uno screening dovrebbe essere fatto solo se può essere integrato con un programma di terapia medica; in pratica, questo implica non solo l'esistenza di una terapia adeguata, ma anche la possibilità di seguire nel tempo coloro che risultano positivi allo screening.

Relazione di causalità

La valutazione della relazione di causalità in epidemiologia è stata affrontata con due approcci, tuttora molto seguiti ma parzialmente differenti. Il primo, proposto da Austin B. Hill, considera i diversi aspetti di un'associazione non casuale tra due variabili, al fine di decidere se la relazione tra le due variabili è quella causale. Hill ha quindi identificato una serie di criteri per la valutazione della relazione causale: (a) forza dell'associazione: più elevata è la stima del rischio relativo e maggiore è la probabilità che vi sia una relazione causale; (b) consistenza e analogia: riguardano la possibilità che l'associazione sia stata osservata ripetutamente da diverse persone, in luoghi, circostanze e momenti differenti; (c) specificità: se l'associazione fra esposizione ed evento in studio è specifica vi è una maggiore probabilità di una relazione causale; (d) relazione temporale: la causa deve precedere l'effetto; (e) relazione dose-risposta: la presenza di una curva dose-risposta, come nel caso della relazione fra fumo e tumore del polmone, può essere un indizio molto importante di causalità; (f) plausibilità e coerenza: entrambi i criteri fanno riferimento al fatto che un'interpretazione causale dei dati non deve essere in conflitto con le conoscenze circa la storia naturale e la biologia della malattia; (g) evidenza sperimentale: la rimozione di un fattore causale riduce l'incidenza della malattia?

Qual è il problema di questi criteri? Nonostante il largo uso all'interno della letteratura scientifica, già Hill riconosceva che non esistevano regole semplici da seguire per identificare una relazione causale. In definitiva, con l'eccezione del criterio temporale, che è parte della relazione di causalità, nessun criterio può fornire evidenze inconfutabili a favore o contro un'ipotesi causale. Un approccio in parte alternativo alla definizione della causalità è quello che si può desumere dall'analisi degli studi sperimentali. In questi studi, infatti, l'interpretazione di un nesso causale fra intervento in studio ed effetto non è mediata dall'applicazione di criteri di interpretazione. Più semplicemente, la differenza di incidenza fra i gruppi a confronto viene direttamente interpretata come effetto dell'intervento in studio.

Per analogia, si può tenere un punto di vista simile anche per gli studi epidemiologici non sperimentali. In questi studi si può concludere che un'esposizione (o fattore di rischio, o trattamento) è causa di un evento (voluto o indesiderato) se, in assenza di distorsioni, e tenuto conto dell'effetto del caso, l'incidenza di eventi fra gli utilizzatori è diversa da quella fra i non utilizzatori, a parità di tutti gli altri potenziali determinanti dell'evento in studio. In assenza di distorsioni o bias (nella selezione della popolazione e nella raccolta delle informazioni sull'esposizione e sulla malattia), e tenuto conto del possibile effetto del caso, il problema, da un punto di vista concettuale, si riduce a quello del controllo dei determinanti estranei. Una differenza di incidenza fra gruppi a confronto può dipendere da una relazione fra esposizione e malattia, la quale potrebbe essere causale, oppure dovuta a fattori estranei (anche noti come 'confondenti'), oppure essere l'esito di entrambe le possibilità. Nonostante la difficoltà pratica di rendere operative queste condizioni, il loro vantaggio è quello di richiamare l'attenzione su aspetti che riguardano la validità degli studi, piuttosto che sulle interpretazioni dei risultati.

Un esempio di causalità: fumo di sigarette e tumore del polmone

Una delle più importanti scoperte derivate dagli studi epidemiologici è stata la scoperta dell'associazione fra fumo di sigarette e tumore del polmone. La pianta del tabacco è originaria delle Americhe, dove cresceva allo stato selvatico, e veniva utilizzata dai nativi in contesti cerimoniali. Il tabacco, introdotto in Europa alla metà del XVI sec., venne inizialmente utilizzato come medicinale. Il primo caso dichiarato di tumore alle labbra risale al 1795 in una persona che fumava la pipa. Fino ai primi anni del Novecento i casi di tumore al polmone riportati sono stati pochi e nessun testo di medicina riportava i danni del fumo sulla salute. Già però i dati sul consumo pro capite di sigarette e la mortalità per tumore del polmone mostravano un andamento analogo. Nel 1950 furono pubblicati cinque studi caso-controllo: tutti si basavano su informazioni raccolte attraverso un questionario su persone ammalate o decedute per questo tipo di tumore, e mostravano una stretta associazione fra consumo di sigarette e tumore al polmone (OR 12,9). Era evidente anche la relazione dose/risposta: l'OR cresceva con l'aumentare del numero di sigarette fumate al giorno.

Dopo questi risultati Richard Doll e Austin B. Hill hanno effettuato uno studio di coorte prospettico sui medici inglesi, raccogliendo, attraverso un questionario, informazioni sulle loro abitudini al fumo. Su 59.600 medici contattati, il 68% aderì allo studio e fu seguito nei successivi 10 anni per verificare la mortalità. Come atteso, più elevata era l'età, maggiore era la mortalità. Tuttavia, più alto era il consumo giornaliero di sigarette, maggiore era anche il gradiente di mortalità. Trattandosi di uno studio di coorte fu possibile studiare non solo la mortalità per tumore del polmone, ma anche quella per altre malattie, come la bronchite cronica, la tubercolosi, le malattie cerebro- e cardiovascolari, le cause violente. Inoltre, vennero indagati anche altri aspetti, come l'effetto di smettere di fumare: confrontato con i non fumatori, il rischio di tumore al polmone si riduceva con l'aumentare del numero di anni di astinenza dal fumo. Nel 1964 l'ufficio del Surgeon General degli Stati Uniti ha pubblicato un importante rapporto, Smoking and health, che ha segnato la prima azione nella campagna contro il fumo: "Cigarettes smoking is a health hazard of sufficient importance in the United States to warrant appropriate remedial actions". Da quel momento, diversi studi sono stati intrapresi e la ricerca continua sulle conseguenze del fumo sulla salute, sulle mutazioni che produce, sulle sostanze carcinogenetiche. La conoscenza degli effetti del fumo ha provocato un graduale ma sostanziale cambiamento nei comportamenti sociali, fino al varo di leggi a protezione dei non fumatori, come quella approvata in Italia nel 2004 che ha vietato il fumo in tutti i locali pubblici.

Bibliografia

Fletcher 1996: Fletcher, Robert H. - Fletcher, Suzanne W. - Wagner, Edward H., Clinical epidemiology: the essentials, 3. ed., Baltimore-London, Williams & Wilkins, 1996.

Hill 1965: Hill, Austin B., The environment and the disease: association or causation?, "Proceedings of the Royal Society of Medicine", 58, 1965, pp. 295-300.

Rose 1992: Rose, Geoffrey, The strategy of preventive medicine, Oxford, Oxford University Press, 1992 (trad. it.: Le strategie della medicina preventiva, Roma, Il pensiero scientifico, 2001).

Rothman 2002: Rothman, Kenneth J., Epidemiology: an introduction, Oxford, Oxford University Press, 2002.

Szklo, Nieto 1999: Szklo, Moyses - Nieto, F. Javier, Epidemiology: beyond the basics, Gaithersburg (Md.), Aspen, 1999.