Fisica

Fisica

di Bruno Ferretti

Fisica

sommario: 1. Introduzione. a) Obiettività secondo Poincaré. b) Storia naturale e fisica. c) Il metodo sperimentale e il metodo teorico. d) Storicità della scienza. 2. Il tentativo classico verso l'unità dell'immagine fisica del mondo. a) Il tentativo meccanicistico. b) Il campo elettromagnetico; teoria della relatività; coronamento e inizio della crisi della fisica classica. c) La meccanica statistica. 3. La fisica del sec. XX. Fisica quantica. a) La prova della struttura atomica della materia e i paradossi che ne sorgon. b) Il quanto d'azione. c) Dualità corpuscolare-ondulatoria. d) Fisica del nucleo; interazioni forti e deboli; fisica delle particelle elementari. 4. Questioni di metodo e di valore. a) Obiettività e arbitrarietà; errori di misura e indefinizione. b) Concetto di ‛obiettività classica' e principio di conplementarità. c) L'esperimento e la genesi delle teorie; il ‛dilemma del teorico'. d) Questioni di valore. □ Bibliografia.

1. Introduzione

a) Obiettività secondo Poincaré

Il mondo empirico si presenta come un continuum sui generis; dico sui generis perché non si tratta di continuità matematica, e nemmeno di una realizzazione di un continuo matematico (v., per es., Poincarè, 1903, p. 34).

Questo continuum presenta una estrema variabilità ed una estrema mutevolezza. Nonostante questo, noi pretendiamo di descriverlo con un linguaggio. Ciò non sarebbe possibile se, almeno in via approssimata, nel mondo empirico non fossero riconoscibili certe invarianze.

È compito della scienza naturale cercare di precisare e definire queste invarianze, e soprattutto di determinarne criticamente le connessioni strutturali e i limiti di applicabilità a una corretta descrizione dell'esperienza.

Vi è un tipo di invarianza generale che è comune a tutte le scienze naturali, e fa parte dei fondamenti della metodologia scientifica: è l'invarianza che, per esempio secondo Poincaré, serve a definire un certo concetto di obiettività. Ne riporterò la definizione con le parole stesse di Poincaré: ‟Quello che ci garantisce l'obiettività del mondo in cui viviamo è il fatto che questo mondo è comune ad altri esseri pensanti [...]. Questa è dunque la prima condizione dell'obiettività: ciò che è obiettivo dev'essere comune a diversi intelletti e, di conseguenza, si deve poterlo trasmettere dall'uno all'altro" (v. Poincarè, 1904, p. 212). In altre parole, ciò che è obiettivo è ciò che è invariante nella conoscenza dei diversi esseri umani. Una tale definizione comporta immediatamente che qualunque enunciato obiettivo deve essere controllabile: il suo valore di verità deve risultare in modo non ambiguo per il tramite di operazioni (logiche o empiriche) definite in modo da poter essere eseguite in via di principio da ogni essere umano, e con risultati indipendenti dal particolare individuo che le esegue.

b) Storia naturale e fisica

Naturalmente non è strettamente richiesto, nè d'altra parte nella maggior parte dei casi è possibile, che il controllo sia diretto; per esempio una delle fonti essenziali della conoscenza della natura è la conoscenza dei fatti o accadimenti naturali. Ora, ogni fatto, a stretto rigore, è essenzialmente irripetibile, quindi non può essere in se stesso direttamente controllabile dopo che è avvenuto.

Quando la conoscenza di singoli fatti, o di insiemi di fatti dati, è importante per sé, come accade nelle scienze aventi uno spiccato carattere storico (per esempio la paleontologia), sono controllabili e sottoposte a controllo obiettivo certe conseguenze o tracce lasciate dai fatti che direttamente interessano. Ciò del resto è vero non solo per la ‛storia naturale', ma anche per le scienze storiche propriamente dette.

Nel caso della fisica, non interessa in se stessa la conoscenza di singoli fatti, e questa è importante solo perché strumentale alla conoscenza di ‛invarianze naturali' le più generali possibili. Cerchiamo di spiegare mediante esempi cosa intendiamo con la locuzione, volutamente vaga, ‛le più generali possibili'.

Si consideri un sistema planetario costituito da una stella e da un solo pianeta. Le leggi della meccanica, la legge gravitazionale di Newton, che sono applicabili, per esempio, a tutti i sistemi planetari e in tal senso (in realtà in un senso molto più generale) sono invarianti, interessano la fisica. Interessa la fisica anche il fatto, deducibile dalle predette leggi, che (almeno nell'approssimazione in cui i due corpi in questione si possono considerare punti materiali sottratti a perturbazioni esterne) la velocità areale del moto planetario è invariante nel tempo. Quale sia il particolare valore di questo invariante, nel caso specifico, non è interessante in se stesso per la fisica; interessa invece l'astronomia; è infatti un dato che dipende dalla storia particolare di quel sistema planetario.

Ancora: gli specifici caratteri, relativamente invarianti, che definiscono una specie biologica, interessano la biologia. Le leggi della meccanica quantica, che rendono ragione della stabilità delle molecole proteiche e degli acidi nucleici - i quali costituiscono il fondamento materiale microscopico dell'invarianza delle specie biologiche (v. Monod, 1970; tr. it., p. 88) - interessano la fisica. Però le invarianze propriamente biologiche non sono riducibili meramente alla fisica; esse, se non altro, dipendono dalla storia particolare della vita, come essa è sorta e come si è evoluta sulla terra, storia che in se stessa esce dal campo della fisica.

Si potrebbe esser tentati di dire che in ogni fatto che si verifica in natura sono riconoscibili aspetti contingenti e determinazioni necessarie, e che la fisica cerca di astrarre dalla ‛contingenza' per dedicarsi allo studio della ‛pura necessità'. Questa distinzione tra contingenza e necessità non è però priva di ambiguità.

c) Il metodo sperimentale e il metodo teorico

L'idea stessa che esistono delle invarianze (leggi, regolarità, ecc.) di tipo estremamente generale, verificabili cioè nei più diversi ‛sistemi' (dai sistemi astronomici a quelli biologici) e nelle più diverse circostanze, suggerisce l'ipotesi che i complicati e variabilissimi fenomeni, i quali spontaneamente si presentano in natura, debbano essere analizzabili in termini di fenomeni essenzialmente più semplici, in cui le invarianze cercate si manifestino con sufficiente chiarezza. In particolare, poiché le leggi della fisica debbono essere invarianti per ‛traslazioni temporali' (ossia non debbono dipendere dall'origine dalla quale si comincia a misurare il tempo), questi ‛fenomeni semplici' debbono essere ‛riproducibili'.

Prescindendo dal caso di certi fenomeni astronomici, come i moti planetari, fenomeni che siano riproducibili con sufficiente approssimazione si ottengono, in generale, solo in circostanze artefatte.

Ecco perché la fisica è sorta veramente con la nascita del metodo sperimentale, secondo il quale il ricercatore, prima di accingersi ad ogni osservazione o misura, deve ‛creare' le circostanze in cui si produrranno i fenomeni che lo interessano, in modo tale che questi fenomeni siano, per quanto possibile, semplici, ‛puliti' e, come si è detto, riproducibili.

A questo scopo occorrono in generale misure, e misure precise. Infatti un enunciato relativo ad accadimenti naturali, che esprima risultati in forma numerica e con indicazione di limiti di errore, è in genere molto meno equivocabile, e quindi più facilmente obiettivo, di un enunciato che sia solo qualitativo. La ‛quantificazione' diventa poi indispensabile quando si debbano fissare in modo obiettivo le circostanze sperimentali in cui va eseguito un dato esperimento; quindi quasi sempre sono necessarie delle misure già quando si preparano le precise condizioni artefatte in cui debbono svolgersi i fenomeni che interessano.

La questione del ‛controllo' degli enunciati obiettivi in una scienza sperimentale diventa così particolarmente semplice, almeno in linea di principio, data la riproducibilità dei fenomeni interessati. Infatti, ogni controllo implica, in modo più o meno esplicito e chiaro a seconda dei casi, la verifica di una ‛predizione particolare'.

Affinché il controllo sia significativo, occorre che il verificarsi della predizione sia pure significativo. Ora, il verificarsi di una previsione quantitativa precisa è, ceterisparibus, molto più significativo del verificarsi di una predizione, sia pure anche quantitativa, ma poco precisa. Per esempio, è estremamente più facile indovinare con esattezza, del tutto casualmente, un numero di una cifra, che un numero di dieci cifre.

D'altra parte, la precisione in se stessa non basta a costituire alcun significato. È solo all'interno di un discorso che sia già, per sé, significativo, ossia all'interno di una teoria, che la precisione può diventare strumento discriminante tra fondamentali alternative, e quindi mutuare un significato talvolta di decisiva importanza obiettiva.

Non è una circostanza fortuita che il modo quantitativo di descrivere i fenomeni, connaturale al metodo sperimentale, sia anche connaturale all'uso del metodo matematico impiegato nello sviluppare le teorie della fisica.

Il metodo matematico permette innanzitutto di caratterizzare in modo logicamente preciso gli invarianti e le invarianze di cui abbiamo parlato fin qui in modo piuttosto vago.

Esistono quantità invarianti aventi un carattere universale, come, ad esempio, la velocità della luce nel vuoto, o l'esponente - 2 al quale è elevata la distanza e che è caratteristico della legge gravitazionale di Newton. Oppure, esistono quantità invarianti rispetto a certe operazioni di trasformazione, come, ad esempio, l'energia di un sistema isolato che è invariante per traslazione temporale. Esistono, inoltre, strutture logiche esprimibili mediante equazioni, come le equazioni di Maxwell, e invarianze di proprietà formali di certe strutture logiche, per certe trasformazioni, come ad esempio l'invarianza delle equazioni di Maxwell per le trasformazioni del gruppo di Poincaré.

Così il metodo matematico, tra l'altro, contribuisce in modo essenziale alla definizione dei concetti fisici tramite le loro correlazioni logiche chiaramente espresse nelle strutture matematiche in cui i concetti stessi sono nominati.

Tuttavia, non si deve pensare che il valore di una teoria fisico-matematica sia limitato al fatto che essa permette di formalizzare concetti e leggi meramente suggerite dalla esperienza.

Il valore massimo di una valida teoria consiste nella possibilità che essa fornisce di scoprire profonde e molto spesso del tutto insospettate relazioni tra differenti campi di esperienze, relazioni che permettono nuove controllabili predizioni e alle volte addirittura la scoperta di interi domini empirici di tipo totalmente diverso da quelli previamente conosciuti.

Così la teoria del campo elettromagnetico di Maxwell, includendo in una formulazione matematica precisa alcune geniali intuizioni di Faraday, ha permesso non solo di unificare l'ottica con l'elettromagnetismo, ma di predire, in via di principio in modo completo, e in via di fatto in molti dettagli, l'esistenza del totalmente nuovo e ricchissimo campo di esperienze costituito dalla fenomenologia delle onde hertziane, scoperte sperimentalmente in laboratorio solo vent'anni dopo la previsione teorica, e poi in natura, come onde radioastronomiche, parecchio tempo dopo.

Trionfi di questa importanza sono rari nella storia della scienza, e tuttavia sono quelli che meglio, più profondamente e chiaramente, ne qualificano gli scopi, la natura e il valore.

d) Storicità della scienza

Abbiamo detto che le teorie scientifiche rendono possibili la definizione dei concetti scientifici, l'espressione delle regolarità che si riscontrano in natura, sotto forma dileggi dinamiche o di altre strutture logiche, e infine la connessione di leggi e strutture particolari in strutture via via più ampie, generali e complete.

Si deve ora sottolineare il fatto importantissimo che concetti, strutture, metodi e risultati scientifici non hanno un carattere metastorico; nascono tutti, si mutano e si caratterizzano diversamente con il progresso stesso della scienza, in un processo che possiamo ben dire dialetticamente evolutivo.

In questo processo, non è tanto importante l'influenza storica dovuta a rapporti e interazioni della ricerca scientifica con le altre attività che si svolgono nella società umana, quanto una certa interna ragione evolutiva, intrinseca al formarsi della scienza, ragione che ne configura l'autonomia e che si deve tener presente e intendere anche se si è interessati in primo luogo a un solo momento di tale processo, ad esempio l'attuale. Il trascurarlo non può farsi senza esporsi al pericolo di una comprensione parziale, superficiale e distorta, anche del ristretto oggetto che può direttamente interessare.

Per questa ragione noi, che pure siamo principalmente interessati ad alcuni aspetti essenziali della problematica della fisica del secolo presente, troviamo indispensabile tratteggiare, prima di entrare in tale problematica, come essa si presentasse nel secolo passato.

V'è del resto un ‛invariante', che sembra dominare tutto lo sviluppo storico della scienza e fissarne ‛quasi metastoricamente' lo scopo ultimo: la ricerca della ‛unità dell'immagine fisica del mondo'. Scrive, per esempio, Planck (v., 1933; tr. it., p. 11): ‟La scienza della natura, fin dai suoi primordi, ha sempre avuto come ultimo e massimo scopo quello di riuscire a compendiare l'estremamente varia molteplicità dei fenomeni fisici in un sistema unitario, possibilmente in un'unica formula".

La ricerca di questa unità conferisce alla fisica la sua posizione singolare tra le scienze della natura: come abbiamo detto, la fisica si occupa delle invarianze naturali, le più generali.

Così facendo fornisce un potente strumento ‛esplicativo' alle altre scienze: una invarianza particolare che formi oggetto di studio di qualche scienza della natura che non sia la fisica, potrà essere considerata ‛completamente spiegata' quando sarà ridotta da una parte alle ‛leggi universali' della fisica, e dall'altra a un evento, o serie di eventi, di carattere contingente o storico, accaduti nel divenire della natura.

In tal modo la fisica fornisce anche un potente strumento di unificazione tra le diverse scienze della natura.

Questo potere unificatore della fisica era già stato supposto, più con lungimirante ardimento che con argomenti solidamente fondati, fin dal sorgere della scienza moderna, e questa ipotesi era stata corroborata, in modo significativo ma comunque non decisivo, dalle scoperte scientifiche del secolo passato.

Ma l'evidenza a favore di questa ipotesi generale della scienza è diventata esplosiva, per così dire, nel secolo presente, talché mai da quando la visione unitaria del mondo derivante dalla filosofia aristotelica era stata dimostrata illusoria, giustappunto dalle scoperte che hanno dato luogo al sorgere delle scienze moderne, si è stati così vicini all'ideale dell'‛unità dell'immagine fisica del mondo'. Questo risultato, penso, è uno dei maggiori titoli di autentica gloria non solo del pensiero scientifico, ma dell'intera problematica civiltà del sec. XX.

2. Il tentativo classico verso l'unità dell'immagine fisica del mondo

a) Il tentativo meccanicistico

È il tentativo che è stato più chiaramente e arditamente espresso per la prima volta nel modello generale del mondo secondo Laplace. Esso è stato suggerito dagli straordinari successi della meccanica celeste, dalla quale, d'altra parte, si originano o si precisano alcuni dei concetti e dei costrutti teorici fondamentali, quali quello di sistema fisico, di stato dinamico di un sistema, di massa, di quantità di moto, di momento angolare, di energia cinetica, di interazione, di energia potenziale e infine, soprattutto, di legge dinamica del moto. Questi concetti permangono, mutatis mutandis, nella meccanica relativistica e nella meccanica quantica, le quali hanno preso origine nel nostro secolo.

Per comprendere la ragione intrinseca del successo della meccanica celeste, è bene ricordare alcune cose, le quali, d'altra parte, costituiscono un esempio che si presta ad illustrare quella ‛ragione interna dell'evolversi della scienza', a cui accennavamo nell'introduzione.

Newton si fondò sulle leggi di Keplero e sulle idee di Galileo per ‛divinare insieme: a) il ‛concetto strutturale generale' di legge dinamica del moto; b) quali fossero in concreto queste leggi generali dinamiche del moto; e, infine, c) quale fosse la ‛legge della forza' agente tra gravi in funzione della massa e della distanza.

Ora, le leggi di Keplero sono leggi cinematiche di forma semplice ed elegante, che servono a descrivere il moto dei pianeti in una certa approssimazione.

Le leggi di Newton sono anch'esse di forma semplice ed elegante, ma di ben altra portata; la loro è una semplicità potente e sublime, ed esse posseggono una generalità che per secoli è sembrata veramente universale.

Le leggi di Keplero sono ben lungi dall'essere esatte; la loro approssimazione si deve considerare grossolana con gli standard odierni. Una descrizione meramente cinematica del moto dei pianeti, fatta con la precisione dei mezzi di osservazione e di misura odierni, conduce alla conclusione che questo moto è estremamente complicato, e nessuna semplicità apparente ne risulta all'infuori della semplicità profonda che è come nascosta nelle leggi dinamiche del moto; tale semplicità non sarebbe senz'altro estraibile, per così dire, dai dati di osservazione, se non si usassero giustappunto le leggi dinamiche stesse.

Naturalmente dalle leggi di Newton non si deducono, a rigore, le leggi di Keplero per il moto planetario, se non nel caso, estremamente schematico, di soli due punti materiali, gravitanti l'uno rispetto all'altro, e sottratti ad ogni altra interazione. Il moto che si deduce dalle leggi di Newton è quello effettivo, quale corrisponde alle più raffinate osservazioni possibili anche con la tecnica odierna - con l'unica eccezione del moto del perielio di Mercurio, di cui diremo poi - e anche per il caso più complicato e sofisticato del moto dei satelliti artificiali.

Le leggi di Newton risultano così dotate non solo di intrinseca semplicità e bellezza, fondata in modo ben più profondo della semplicità delle leggi di Keplero, ma di un potere di predizione che è senza precedenti.

Un esempio clamoroso e ben noto dell'efficacia di tale potere di predizione è offerto dalla scoperta del pianeta Nettuno, compiuta per merito di Adams e Leverrier nel 1846, dopo che la posizione di Nettuno era stata calcolata, in base alla teoria generale di Newton, come quella di un pianeta sconosciuto, responsabile di alcune irregolarità nell'orbita di Urano. In questo caso l'osservazione ha meramente confermato le predizioni fatte in base alla dinamica celeste. Un'analoga vicenda ha portato in questo secolo alla scoperta di Plutone, quindici anni dopo che la sua esistenza e la sua orbita erano state correttamente previste in base alla teoria.

Si può comprendere così come i fisici teorici cercassero di assumere il modello della meccanica celeste come modello onnicomprensivo nel tentativo di dare una ‛spiegazione fisica' o più modestamente una ‛descrizione fisica' unitaria di tutto il mondo.

Innanzitutto la validità illimitata, veramente universale, sia dei concetti generali della meccanica, sia delle leggi generali del moto, non era, dalla maggior parte dei fisici, nemmeno posta in discussione; ma, inoltre, a parte i ‛puristi' che volevano escludere dalla meccanica le ‛forze' e ridurre tutto ad urti tra particelle, i più mutuavano dalla meccanica celeste non solo i concetti e le leggi generali della dinamica, ma anche l'idea che tutti i sistemi fisici fossero costituiti da piccoli corpi o particelle, tra cui agissero forze di tipo centrale come nella meccanica celeste. Naturalmente non si supponeva che queste forze fossero tutte di tipo gravitazionale: una tale ipotesi sarebbe stata immediatamente contraddetta dall'esperienza. Ma la differenza fra la forza gravitazionale e queste ipotetiche forze centrali, agenti tra punti materiali o tra molecole, avrebbe dovuto essere espressa meramente da una differente legge di dipendenza dalla distanza.

Il compito del fisico teorico, una volta accettato uno schema di questo genere, era ridotto a quello di ricercare la forma di queste diverse leggi di forze centrali agenti fra le varie particelle costituenti il mondo, e poi di ricostruire, con il calcolo, i fenomeni quali appaiono all'osservazione.

Un tale programma, oltre che della fede nella meccanica e nelle forze centrali, si giovava chiaramente della rinascita dell'ipotesi atomica, la quale aveva cominciato ad imporsi con sempre maggiore vigore in seguito alle scoperte della chimica.

Tuttavia questo programma era troppo ambizioso e conteneva in sé una deficienza fatale (di cui avremo occasione di discutere); non aveva quindi alcuna possibilità di giungere al successo sperato.

Seguirono perciò abbastanza presto delusioni e uno scetticismo senz'altro eccessivo sulle possibilità della fisica teorica e in particolare della teoria atomica della materia.

Nonostante le sue limitazioni, il programma meccanicistico rese grandissimi servigi alla scienza, molto maggiori di quanto non pensassero i suoi critici. Per questa ragione ritengo opportuno ricordare, in modo un po' più tecnico di quanto non abbia fatto fino ad ora, alcuni concetti fondamentali della meccanica che ci saranno utili per il seguito.

Consideriamo, per fissare le idee, un sistema costituito da N punti materiali senza vincoli. Una configurazione del sistema sarà specificata in un istante t quando saranno assegnate le posizioni di tutti i punti costituenti il sistema rispetto a un dato riferimento. Questo potrà farsi assegnando 3N variabili indipendenti, per esempio le tre coordinate cartesiane ortogonali, rispetto a un sistema di assi rigidamente connesso con il riferimento, di ciascun punto costituente il sistema. Invece di un sistema di N punti materiali non vincolati, avremmo potuto considerare per esempio M corpi rigidi pure non vincolati: in tal caso, per specificare la configurazione del sistema sarebbero stati necessari 6M parametri indipendenti, ad esempio le coordinate dei baricentri degli M corpi e tre angoli euleriani per ciascuno dei corpi (per specificarne l'orientamento nello spazio).

In generale, si chiama ‛numero di gradi di libertà di un sistema' il numero dei parametri necessari e sufficienti per specificarne una configurazione.

Indicheremo in generale con f il numero di gradi di libertà; nel primo esempio f = 3N, nel secondo esempio f = 6M.

I parametri che, come funzioni del tempo, specificano istante per istante la configurazione del sistema si chiamano ‛coordinate lagrangiane'.

Negli esempi riportati fin qui, le coordinate lagrangiane hanno ovvi significati geometrici (e, come funzioni del tempo, cinematici) in relazione alla natura ‛corpuscolare' dei sistemi che si vogliono descrivere; ma è importante notare che una tale interpretazione geometrico-cinematica non è minimamente necessaria, e quando la si abbandoni, come avremo occasione di vedere, si può giungere ad una importante generalizzazione del concetto di sistema meccanico.

Qual è la forma generale delle leggi della meccanica, espresse mediante le coordinate lagrangiane? Questa forma generale può essere dedotta da un principio variazionale - il ‛principio di minima azione' - quando si faccia una speciale scelta del riferimento, che dovrà essere inerziale, e si introduca una funzione L delle coordinate lagrangiane qi e delle loro derivate rispetto al tempo ói (i = 1, 2, ... f), funzione detta ‛lagrangiana' e che nel caso delle forze centrali, per esempio, si riduce alla differenza tra l'energia cinetica e l'energia potenziale. L'energia cinetica è una forma quadratica nelle ó, l'energia potenziale nel caso considerato non contiene le ó; le equazioni del moto (che si ottengono imponendo l'annullarsi della variazione dell'azione, cioè dell'integrale della lagrangiana lungo un arco di traiettoria possibile, ossia compatibile con le leggi del moto) si scrivono:

Le equazioni (1), che sono in numero f, si chiamano le equazioni di Lagrange del moto. Esse sono equazioni differenziali del secondo ordine nel tempo, e la loro soluzione è determinata quando, per esempio, siano assegnati i valori di tutte le qi e di tutte le ói in un determinato istante. Per questo si dice che l'insieme dei valori delle qi e delle ói a un dato istante specifica lo ‛stato dinamico' del sistema in quell'istante.

Come è ben noto dalla teoria dei sistemi di equazioni differenziali ordinarie, un sistema di f equazioni del secondo ordine può essere ridotto, e in infiniti modi, a un sistema di 2f equazioni del primo ordine. Nel caso delle equazioni di Lagrange, uno dei modi di effettuare questa riduzione, dovuto ad Hamilton, è particolarmente interessante. Per i sistemi meccanici semplici si riesce sempre facilmente ad applicare tale procedimento.

Hamilton introdusse le nuove variabili:

pi = ∂L/∂ói, (2)

che vengono chiamate ‛variabili coniugate canonicamente delle qi' ed esprimendo le derivate ói come funzioni delle pk e delle qk ricondusse le equazioni dinamiche del moto alla forma:

ói = ∂H/∂pi; ñi = − ∂H/∂qi, (3)

dove H è, nel caso che qui interessa, la somma dell'energia cinetica e dell'energia potenziale, ossia l'energia totale del sistema. H naturalmente deve essere espressa come funzione delle qi e delle pi e prende il nome di ‛hamiltoniana'.

Le equazioni (3) sono appunto 2f equazioni differenziali del primo ordine e prendono il nome di ‛equazioni canoniche della meccanica'.

Perché le equazioni canoniche sono particolarmente interessanti? Esse sono invarianti rispetto a un'ampia classe di trasformazioni che hanno il carattere delle cosiddette ‛trasformazioni di contatto'. Questa proprietà formale ha un profondo significato fisico, il quale può essere intuito ricordando che Hamilton giunse ai suoi risultati studiando le analogie formali che potevano sussistere tra il moto di corpuscoli e la propagazione di onde. All'epoca in cui Hamilton svolgeva le sue ricerche era ancora viva la disputa tra i sostenitori della teoria corpuscolare newtoniana della luce e quelli della teoria ondulatoria di Huygens. Le proprietà di ‛contatto' delle trasformazioni per le quali sono invarianti le equazioni canoniche ricevono un'interpretazione geometrica immediata nella costruzione di Huygens relativa al propagarsi delle onde.

È noto che già nella prima metà del secolo passato le esperienze sull'interferenza della luce, e altre sulla sua velocità di propagazione nei mezzi materiali, parvero decidere in modo definitivo la disputa sulla natura della luce a favore della teoria ondulatoria. Ma, come è ben noto, la questione risorse nel secolo presente, in forma del tutto inaspettata e apparentemente paradossale. Inoltre, le equazioni canoniche della meccanica si rivelarono preziose nella meccanica statistica. Questi due fatti (non incorrelati) spiegano, e lo vedremo meglio in seguito, come la forma canonica delle equazioni della meccanica abbia un'importanza fondamentale nella meccanica quantica.

Per questo abbiamo voluto ricordare le equazioni canoniche con un dettaglio maggiore di quello che riserveremo ad altri pur fondamentali argomenti della fisica.

Con il formalismo canonico, lo stato dinamico del sistema è specificato, nella meccanica classica, quando si assegnino insieme le coordinate lagrangiane qi e i loro momenti coniugati pi. Specificato lo stato dinamico del sistema isolato in un certo istante, esso risulta determinato anche in ogni istante passato o futuro rispetto a quell'istante.

Nella concezione di Laplace il mondo non è che un enorme sistema meccanico. Ogni fenomeno che accade nel mondo può essere espresso e descritto mediante assegnate funzioni delle coordinate lagrangiane e dei loro momenti coniugati, relativi a tutti i gradi di libertà del mondo stesso; quindi, una volta assegnato lo stato del mondo in un istante qualunque, tutti gli accadimenti naturali restano perfettamente determinati. Non vi è nulla di contingente o storico nel mondo di Laplace, se non lo stato dell'universo in un qualunque istante prefissato. Questa è l'espressione esatta del determinismo meccanicistico.

Un tale modello teorico ha esercitato ed esercita tuttora un enorme fascino su molte menti. Per molti rimane un ideale nella descrizione scientifica della natura. Discute- remo questa questione e le ragioni per le quali questo modello, lungi dall'essere l'unico razionalmente possibile, appare assolutamente non plausibile.

I teorici meccanicistici, per riuscire nel loro grandioso disegno, dovevano ridurre i fenomeni termici, quelli chimici e infine quelli elettromagnetici a fenomeni puramente meccanici. Esamineremo ora per sommi capi l'esito di questi tentativi.

b) Il campo elettromagnetico; teoria della relatività; coronamento e inizio della crisi della fisica classica

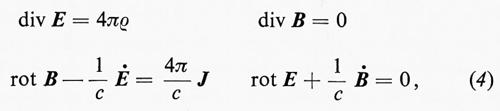

Inizieremo con il discutere i tentativi di interpretazione meccanicistica dell'elettromagnetismo. Tutta la teoria dell'elettromagnetismo è contenuta nelle equazioni di Maxwell:

nelle quali E indica il campo elettrico, B il campo magnetico, e la densità di carica elettrica, J la densità di corrente, e infine c è una costante universale uguale alla velocità della luce nel vuoto. Inoltre, alle (4) si può associare l'espressione della cosiddetta ‛forza di Lorentz', che dà la forza agente su una carica elettrica moventesi con una certa velocità in presenza di un dato campo elettrico e di un dato campo magnetico.

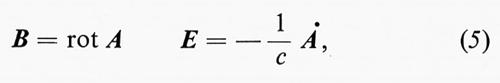

Ora, si possono scrivere le equazioni di Maxwell derivandole dal principio di minima azione applicato a un'opportuna lagrangiana e anche (nel caso più generale con qualche difficoltà che, tuttavia, è sormontabile) in forma canonica. La cosa può essere fatta molto semplicemente, per esempio, nel caso di un campo elettromagnetico, in assenza di cariche e correnti elettriche, contenuto in una cavità di volume finito e le cui pareti riflettano perfettamente le onde elettromagnetiche, introducendo le relazioni:

dove A è il cosiddetto ‛potenziale vettore', al quale imponiamo la condizione div Α = 0.

Si può allora facilmente mostrare che il campo elettromagnetico all'interno della cavità è descrivibile tramite la sovrapposizione di un'infinità numerabile di campi, ciascuno vibrante secondo un modo proprio della cavità. A ciascun modo, sia per esempio il modo n, corrisponde un'ampiezza An della vibrazione del potenziale vettore relativo a quel modo. Gli An possono pensarsi funzioni del tempo e possono assumersi come coordinate lagrangiane del sistema. L'equazione del moto per ciascuna coordinata An è allora quella di un oscillatore armonico di frequenza ben determinata dipendente dall'indice n. È chiaro che tale equazione del moto può mettersi in forma canonica e così l'intero ‛sistema del campo elettromagnetico' nella cavità diventa equivalente a un sistema meccanico avente un numero infinito di gradi di libertà e precisamente a un insieme di infiniti oscillatori armonici di frequenze ben determinate ma tutti indipendenti gli uni dagli altri. È allora immediato scrivere le equazioni canoniche del moto dell'intero sistema.

È però ben chiaro che nel caso presente le coordinate lagrangiane An hanno perso qualunque significato cinematico riferentesi a particelle; gli oscillatori di cui si parla non sono oscillatori materiali.

Per questa ragione la riduzione delle equazioni dell'elettromagnetismo alla forma canonica della meccanica non è sufficiente per affermare che l'elettromagnetismo sia ridotto a un fenomeno meccanico nel senso stretto in cui lo intendevano i meccanicisti.

Per ciò doveva essere possibile esprimere per esempio le quantità An come funzioni delle coordinate di ipotetiche particelle e far vedere poi che le equazioni di Maxwell potevano essere ricondotte alle equazioni del moto di queste particelle. Questo era esattamente il problema della riduzione in senso stretto dell'elettromagnetismo alla meccanica. Molti sforzi furono dedicati alla soluzione di questo problema da parte dei fisici teorici nella seconda metà del secolo passato. Ma la stessa sensatezza del problema fu messa in dubbio dalla scoperta di un celebre teorema di Poincaré (v., 1901). Per comprendere la portata del teorema occorre dire che le grandezze fisiche direttamente accessibili all'esperienza sono i campi E e B; le coordinate lagrangiane delle ipotetiche particelle materiali (sia pure di una materia sui generis, giacché esse erano pensate come le molecole costituenti l'ipotetico ‛etere cosmico') erano considerate viceversa come ‛variabili nascoste', cioè non direttamente accessibili all'esperienza. Ora, il teorema di Poincaré mostra che, se esiste una soluzione del problema meccanicistico dell'elettromagnetismo, allora ne esistono infinite non equivalenti. Queste infinite diverse soluzioni non comportano d'altra parte alcuna diversa predizione sperimentalmente verificabile; le variabili propriamente meccaniche sarebbero nascoste e apparentemente destinate a restare tali per sempre. Fin da allora si cominciò a dubitare molto seriamente che a tali grandezze si potesse assegnare un qualsiasi significato fisico e similmente si potesse assegnare un significato fisico a una descrizione strettamente meccanicistica dell'elettromagnetismo.

Ma il colpo praticamente definitivo contro una tale possibilità venne dalla scoperta della teoria della relatività.

Le equazioni della meccanica classica sono invarianti rispetto alle trasformazioni cinematiche di Galileo (relative a due sistemi di riferimento inerziali in moto rettilineo e uniforme l'uno rispetto all'altro):

x′ = x + vt; t′ = t, (6)

dove v è la velocità costante di traslazione parallela all'asse x.

In ciò consiste il principio di relatività classica. Le equazioni di Maxwell (4) non sono invarianti per le trasformazioni (6). In esse figura la velocità c e non vi è velocità invariante per trasformazioni di Galileo.

Secondo la fisica classica, le (4) dovevano valere pertanto solo in un determinato riferimento che naturalmente, secondo l'interpretazione meccanicistica, doveva essere il riferimento di quiete dell'etere cosmico.

Ma ogni tentativo di rivelare, mediante lo studio di opportuni fenomeni elettromagnetici, un moto rispetto al supposto etere cosmico, che sarebbe stato in certo senso un moto assoluto, regolarmente fallì.

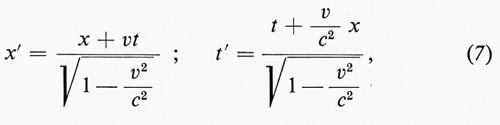

Ciò portò Einstein a formulare l'ipotesi che tutti questi fallimenti non fossero casuali, ma fossero dovuti all'esistenza di un principio generale - ‛principio di relatività ristretta einsteiniana' - secondo il quale le equazioni di Maxwell rimangono invarianti per la trasformazione che fa passare da un sistema di riferimento inerziale a un altro in moto rispetto al primo. Pertanto Einstein suppose che le trasformazioni spazio-temporali subordinate a tale passaggio non fossero le (6) di Galileo, ma le trasformazioni di Lorentz:

per le quali le equazioni di Maxwell e la velocità della luce sono invarianti (v. relatività). Naturalmente quest'ipotesi può essere consistente con la possibilità di una descrizione unitaria del mondo fisico solo se si postula che anche le leggi della meccanica siano invarianti per le trasformazioni di Lorentz; a questo scopo non è necessario cambiare la forma generale delle equazioni canoniche della meccanica; basta modificare opportunamente l'espressione della funzione hamiltoniana H.

Tutte le conseguenze della relatività ristretta einsteiniana, sia nell'elettromagnetismo, sia nella meccanica, sia nella cinematica (la quale ultima nella teoria della relatività presenta gli aspetti a prima vista più paradossali per il cosiddetto senso comune), sono state confermate dall'esperienza e queste conferme sono state numerosissime e di diversa specie.

Si suole dire che la teoria della relatività einsteiniana per le nuove concezioni che introduce sullo spazio e sul tempo segna la fine della fisica classica e l'inizio della fisica moderna. Io direi piuttosto che segna il coronamento della fisica classica, giacché essa semplicemente estende al campo elettromagnetico il principio di relatività della meccanica classica. Sotto un aspetto però la relatività ristretta einsteiniana è veramente rivoluzionaria nei riguardi delle concezioni classiche e questo aspetto ci interessa particolarmente: l'idea di ‛etere cosmico' è svuotata di ogni contenuto fisico. Nella fisica classica, prescindendo anche da ogni tentativo di stretta interpretazione meccanicistica del campo elettromagnetico, il campo stesso era interpretato come una ‛proprietà' della ‛sostanza' etere cosmico. Ora è rimasto il campo ma è scomparso l'etere (come il sorriso del gatto del Cheshire che continuava a permanere anche quando spariva il gatto). In questo modo in realtà veniva messo in crisi l'uso acritico di uno dei concetti fondamentali che la scienza classica aveva ereditato in blocco dalla metafisica aristotelica: il concetto di ‛sostanza'.

Prima di abbandonare questo argomento vorrei ricordare la generalizzazione data da Finstein della propria teoria della relatività. Secondo la relatività ristretta, come abbiamo detto, le leggi della fisica devono essere invarianti per la trasformazione cinematica che fa passare da un sistema di riferimento inerziale a un altro, pure inerziale, cioè in moto traslazionale uniforme rispetto al primo. Nella sua relatività generale, Einstein ha cercato di esprimere le leggi della fisica in modo invariante rispetto a trasformazioni di tipo generale, cercando di eliminare così il carattere privilegiato dei sistemi di riferimento inerziali.

In tal modo, basandosi sul fatto sperimentale dell'equivalenza tra la massa inerziale e quella gravitazionale, è giunto a dare una teoria di campo della gravitazione. Come nella teoria del campo elettromagnetico, quando si passa da un sistema inerziale in cui per esempio c'è solo un campo magnetico e il campo elettrico è nullo a un altro in moto rispetto al primo, si ‛crea' nel secondo sistema un campo elettrico diverso da zero, così nella teoria della relatività generale, passando da un sistema di riferimento in cui il campo gravitazionale è nullo ad un altro in moto accelerato rispetto al primo, si ‛crea' un campo gravitazionale.

Con grande profondità di pensiero, la teoria della relatività generale connette le proprietà metriche dello spazio- tempo con la ‛presenza' della materia-energia nell'universo. Non entreremo in ulteriori dettagli su questa teoria (per la quale rimandiamo all'articolo relatività). Diremo soltanto che, mentre la relatività ristretta ha avuto, come già accennato, gran copia di conseguenze confermate dall'esperienza, poche sono le conseguenze della relatività generale direttamente verificabili dall'esperienza con le tecniche attuali. Ne menzioneremo solo due: la prima è la corretta previsione del movimento del perielio di Mercurio che costituiva l'unico mistero lasciato insoluto dalla teoria newtoniana nella descrizione dei moti planetari. La seconda è la previsione che la luce debba subire l'azione del campo gravitazionale in ragione delle due leggi di equivalenza della massa-energia, dedotta già nell'ambito della relatività ristretta, e della massa inerziale-massa gravitazionale, fondamento della relatività generale.

c) La meccanica statistica

Secondo il nostro programma, dobbiamo ora discutere il tentativo classico di ridurre i fenomeni termici e quelli chimici a fenomeni puramente meccanici. Questo tentativo è naturalmente basato sulla teoria atomica della materia, ed è stato realmente determinante, come vedremo, per i grandi progressi della fisica del secolo presente. Ciò è innanzitutto dovuto alla creazione della meccanica statistica, necessaria se si vogliono interpretare le proprietà fisiche macroscopiche dei corpi, e in particolare quelle termiche, sul fondamento della teoria atomica.

Era già chiaro infatti, fino dall'antichità, che gli atomi, se realmente fossero esistiti, avrebbero dovuto essere molto piccoli rispetto ai corpi che cadono sotto l'osservazione diretta dei sensi, cioè rispetto ai corpi macroscopici. Ciò comporta il fatto che il numero degli atomi eventualmente contenuti in qualunque corpo macroscopico deve essere estremamente elevato, e quindi che un corpo macroscopico, se pur può essere considerato come un mero sistema meccanico, deve essere necessariamente un sistema meccanico con un enorme numero di gradi di libertà. È perciò impossibile una descrizione completa ed esatta del moto interno di questo sistema meccanico, nonché risolvere le equazioni del moto. Infatti sarebbe impossibile assegnare il preciso stato dinamico iniziale del sistema costituito da un corpo macroscopico comunque piccolo. Fortunatamente, ciò non è neppure necessario, poiché a noi basterebbe poter specificare il comportamento macroscopico dei corpi (ad esempio, la legge che dà la pressione di un gas in funzione della sua temperatura e del suo volume) a partire dalla forma generale delle leggi dinamiche del moto che noi ben conosciamo, e, tutt'al più, dalla specificazione delle leggi delle forze di interazione tra gli atomi. Ora, ciò diviene possibile se le leggi macroscopiche che ci interessano sono proprietà di opportune medie sugli stati dinamici microscopici del sistema, e questo è precisamente il caso. Naturalmente, però, a stretto rigore, leggi dinamiche e leggi di forza non saranno del tutto sufficienti; dovremo in un modo o in un altro introdurre delle ipotesi di tipo probabilistico, allo scopo di dare un senso preciso alle proprietà medie che ci interessano. Queste ipotesi probabilistiche dovranno essere consistenti con le leggi del moto, da una parte, e servire poi effettivamente a descrivere l'apparente semplicità del comportamento macroscopico dei corpi (quale espressa per esempio dalle classiche leggi della termologia) in termini di medie sui complicatissimi movimenti microscopici dei costituenti elementari dei corpi stessi.

Nacque così nel secolo passato, principalmente per merito di Maxwell e di Boltzmann, una nuova disciplina, la meccanica statistica, che appunto doveva almeno parzialmente rispondere ai problemi posti nel programma or ora delineato (v. meccanica statistica).

Nella teorizzazione della meccanica statistica risulta particolarmente preziosa, come abbiamo già detto, la formulazione canonica delle leggi della dinamica.

Nella meccanica statistica è molto conveniente far uso del cosiddetto ‛spazio delle fasi'. Lo spazio delle fasi, per un sistema con f gradi di libertà, ha 2f dimensioni e un suo punto generico ha come coordinate cartesiane ortogonali le qi e le pi (variabili canoniche del sistema).

Se per esempio le condizioni esterne imposte al sistema sono tali che esso è confinato entro un volume finito V dello spazio ordinario e se, inoltre, l'energia del sistema è in qualche modo limitata - ciò che accade, per esempio, se si impone direttamente che essa sia compresa tra il valore E e il valore E + ΔE - allora il volume dello spazio delle fasi che può essere disponibile per il punto P, rappresentante lo stato dinamico del sistema, è anch'esso limitato. Se si considera ora un grande insieme di sistemi tutti uguali che siano ciascuno all'equilibrio termodinamico e tutti con un'energia compresa tra E ed E + ΔE, con ΔE infinitesimo, si dice che la distribuzione dei punti che rappresentano i loro stati dinamici microscopici nello spazio delle fasi è ‛microcanonica'.

Tutta la meccanica statistica può essere agevolmente dedotta dall'ipotesi che in una distribuzione microcanonica i punti rappresentativi siano uniformemente distribuiti nella porzione di spazio delle fasi accessibile a ciascun sistema.

Noi non potremo, per ragioni di brevità, far cenno ai numerosi e importanti lavori teorici fatti per saggiare la consistenza di questa ipotesi statistica con le leggi della dinamica (ricerche sui teoremi ergodici e quasi ergodici, le quali hanno avuto importanti sviluppi proprio nel secolo presente; v., per es., Khinchin, 1949). Diremo solo che l'ipotesi si può considerare pienamente giustificata dalla verifica delle sue conseguenze, alcune delle quali assai dirette e controllate positivamente da numerosi risultati sperimentali.

Per la meccanica e la termodinamica statistica ha una grande importanza la nozione di ‛distribuzione canonica', cioè la distribuzione dei punti rappresentativi degli stati di un grandissimo numero di sistemi identici, ciascuno, per esempio, con f gradi di libertà e ciascuno in equilibrio termico con un bagno di calore alla stessa temperatura T. Il bagno di calore è concepito come un sistema meccanico avente un grandissimo numero di gradi di libertà, in tutti i casi estremamente maggiore di f.

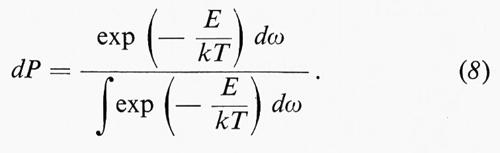

La distribuzione dei punti rappresentativi nello spazio delle fasi dei sistemi a f gradi di libertà nel caso canonico è deducibile dall'ipotesi statistica fatta sulle distribuzioni microcanoniche ed è espressa tramite la legge canonica di Boltzmann:

In tale legge dP rappresenta la probabilità di trovare il punto rappresentativo del sistema entro l'elemento di volume dello spazio delle fasi dω = Πfidqidpi, E è l'energia che ha il sistema quando il suo punto rappresentativo si trova nell'elemento dω dello spazio delle fasi, T è la temperatura e k è una costante universale detta costante di Boltzmann.

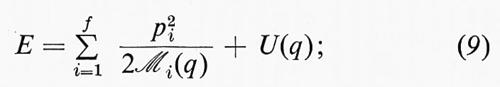

Nei sistemi meccanici che noi consideriamo (forze centrali), con una scelta opportuna delle coordinate lagrangiane qi, è sempre possibile esprimere l'energia nella forma:

ℳi(q), U(q) sono funzioni solo delle qi; U(q) è l'energia potenziale. Il termine p²i/2ℳi(q) può essere evidentemente interpretato come energia cinetica dell'i-esimo grado di libertà.

Si deduce dalla legge di Boltzmann che il valor medio dell'energia cinetica di ciascun grado di libertà è indipendente dal grado di libertà stesso, ed è precisamente uguale a kT/2; è questo il celebre teorema dell'equipartizione dell'energia cinetica, il quale, come vedremo, è, in certe condizioni, verificabile direttamente dall'esperienza e come tale è uno dei fondamenti della prova raggiunta in questo secolo della cosiddetta realtà dell'esistenza degli atomi.

Occorre dire a questo punto che, finché per merito di Perrin questa prova non fu raggiunta, per diverse ragioni, in parte dovute al fallimento delle teorie meccanicistiche dell'elettromagnetismo, in parte per difficoltà interne alla meccanica statistica stessa, i fisici e i chimici erano molto scettici sulla ‛realtà degli atomi' e perfino sulla sensatezza di porsi la questione se gli atomi fossero reali o no. Questo scetticismo, senz'altro eccessivo, era però prevalente alla fine del secolo passato e nei primissimi anni di quello presente.

Infine, vorrei citare, sia per la sua importanza concettuale, sia perché avremo occasione di riparlarne, una delle difficoltà in cui incorreva la meccanica statistica: il cosiddetto ‛paradosso di Loschmidt', che è il seguente: com'è possibile che le leggi della meccanica, le quali sono invarianti se si cambia il verso del tempo, almeno nel caso delle forze centrali, e quindi non possono descrivere direttamente che fenomeni reversibili, possano poi viceversa render conto dell'essenziale irreversibilità dei fenomeni macroscopici?

Questa questione, come altre interessanti per esempio la chimica, che erano però meno acutamente percepite, trovano la loro risposta più soddisfacente nel quadro della meccanica quantica come vedremo in seguito.

3. La fisica del sec. XX. Fisica quantica

a) La prova della struttura atomica della materia e i paradossi che ne sorgono

Secondo la concezione classica, condizioni necessarie e sufficienti perché un corpo macroscopico abbia realmente una struttura atomica sono le seguenti: a) il suo numero di gradi di libertà sia finito; b) sia possibile interpretare ciascuno di questi gradi di libertà come coordinata cinematica di una particella.

Il teorema dell'equipartizione dell'energia cinetica ci dà in linea di principio la possibilità di controllare sperimentalmente se la prima delle condizioni su esposte è soddisfatta e di determinare anche, almeno in alcuni casi, qual è il numero effettivo di gradi di libertà di un corpo macroscopico. Infatti, secondo il principio dell'equipartizione dell'energia, a ogni grado di libertà deve competere all'equilibrio termico la stessa energia cinetica. Poiché l'energia interna di un corpo macroscopico finito è necessariamente finita, segue che, se il numero di gradi di libertà del corpo fosse infinito, a ciascun grado di libertà all'equilibrio termodinamico dovrebbe competere un'energia cinetica nulla. Se dall'esperienza tale energia cinetica risulterà diversa da zero (e se naturalmente si crede al principio dell'equipartizione dell'energia), si dovrà necessariamente concludere che il numero di gradi di libertà del corpo è finito.

In questo modo si sarà dimostrato che la prima essenziale e caratterizzante condizione per concludere che la materia ha una struttura atomica è verificata dall'esperienza.

Questa è la linea di pensiero che ha guidato le celebri ricerche di Perrin sul moto browniano e che permette di comprenderne la fondamentale importanza.

Il moto di Brown, che può essere osservato facilmente su particelle molto minute visibili anche a un normale microscopio ottico a forte ingrandimento, era noto da un pezzo, ma era stato interpretato come dovuto a correnti di convezione del fluido in cui le particelle sono immerse, provocate da piccole accidentali differenze di temperatura; in altre parole, si era pensato che questo movimento fosse dovuto al fatto che il sistema che veniva osservato (fluido+particelle immerse) non fosse in equilibrio termodinamico.

Ora Perrin dimostrò, con una imponente serie di misure estremamente accurate, in condizioni controllatissime, che il moto browniano continua immutato anche quando il sistema si approssimi quanto si vuole all'ideale equilibrio termodinamico. Si tratta di un fenomeno che non è quindi interpretabile sul fondamento della termodinamica classica (non statistica), ma che rivela un fatto fondamentale genuino: anche all'equilibrio termodinamico l'energia cinetica relativa a un grado di libertà traslazionale di una particella continua ad essere diversa da zero. Questo è quanto precisamente è previsto dalla meccanica statistica nel caso in cui il sistema abbia un numero finito di gradi di libertà. Risulta anzi così possibile giungere a una determinazione più o meno diretta (con i metodi moderni molto diretta) del valore che ha l'energia cinetica media relativa a un grado di libertà, del valore della costante di Boltzmann (k = 1,380•10-16 erg/°C) e quindi del numero di gradi di libertà di un corpo macroscopico.

Ora la forza della prova raggiunta inizialmente con lo studio del moto browniano diventa veramente conclusiva per il fatto che la costante di Boltzmann, o equivalentemente il numero di Avogadro, può essere determinata per altre vie, alcune estremamente dirette, come la determinazione della carica elettrica elementare (e = 4,802•10-10 unità elettrostatiche) tramite l'esperienza di Millikan. Tutte queste determinazioni danno risultati concordanti entro gli errori con quello dato dalle esperienze di Perrin.

Si comprende come, in tal maniera, si sia giunti non solo a confermare i risultati ottenuti con lo studio del moto browniano, ma a dimostrare che, in certo senso almeno, gli atomi esistono e sono i costituenti dei corpi che cadono sotto la nostra esperienza diretta.

La prova fondata sul moto browniano assume però implicitamente che gli atomi, e talvolta le molecole, non abbiano gradi di libertà interni. Questo porta immediatamente a un grave paradosso. Infatti, prima ancora che Perrin compisse le sue esperienze, e i fisici ne fossero persuasi, numerosi fenomeni avevano convinto i ricercatori che prendevano sul serio la teoria atomica che se gli atomi esistevano dovevano avere una struttura interna e quindi gradi di libertà interni. Questi fenomeni erano essenzialmente relativi all'interazione tra la radiazione elettromagnetica e la materia. Innanzitutto gli spettroscopisti avevano già dimostrato da un pezzo che esistono spettri caratteristici degli elementi e quindi che, secondo la teoria atomica, si dovevano considerare caratteristici degli atomi. Inoltre, nel 1895, seguendo le indicazioni di una teoria di Lorentz sull'emissione da parte della materia di radiazioni elettromagnetiche, Zeeman aveva mostrato che un campo magnetico modifica lo spettro emesso per esempio dagli atomi, producendo caratteristiche separazioni delle righe atomiche, in alcuni casi almeno, in pieno accordo con quanto Lorentz aveva previsto (effetto Zeeman normale). Nella teoria di Lorentz le cariche elettriche che danno luogo alla densità che figura al secondo membro della prima delle equazioni (4) sono cariche possedute da particelle, i cosiddetti elettroni, e così le correnti sono dovute al moto degli elettroni. Gli elettroni si muovono secondo le leggi della meccanica classica sotto l'azione delle forze di Lorentz. Secondo la teoria, nell'espressione della separazione delle righe provenienti dalla scissione della stessa riga per effetto Zeeman, compare, oltre al campo magnetico, solo il rapporto e/m tra la carica elettrica e la massa degli elettroni.

L'anno dopo l'esperienza di Zeeman, Thomson trovò lo stesso valore per e/m studiando invece la natura dei raggi catodici. Naturalmente nulla poteva dirsi di sicuro finché non fosse stato noto almeno il valore di e, ma, come abbiamo ricordato, l'esperienza di Millikan prova direttamente l'atomicità dell'elettricità e determina il valore di e in modo univoco. Anche il valore di m può quindi essere determinato, e risulta, nel caso delle particelle dell'effetto Zeeman e dei raggi catodici, quasi duemila volte più piccolo di quello della massa dell'atomo di idrogeno (v. atomo).

Da tutti i fatti sopra riferiti, appare quasi inevitabile una conseguenza: gli elettroni sono componenti degli atomi. Questa conseguenza è confermata da infiniti altri fatti, primo tra i quali che gli atomi possono giust'appunto essere ionizzati strappando loro elettroni, mediante un'energia migliaia di volte inferiore all'energia di riposo dell'elettrone.

Ma se le cose stanno così, come abbiamo detto, gli atomi non sono in realtà atomi, ma hanno una struttura interna, quindi gradi di libertà interni. La questione è: come mai tali gradi di libertà interni non si fanno sentire a norma del principio di equipartizione dell'energia?

Il problema diventa particolarmente acuto se si entra nei dettagli della struttura atomica, come successivamente si è potuto fare per merito dei fondamentali lavori di Rutherford.

In molti casi gli atomi sono neutri. Se tali atomi contengono degli elettroni, che sono carichi negativamente, debbono contenere anche una carica positiva; Rutherford (1906), inaugurando un metodo che è rimasto a tutt'oggi il principale nello studio di strutture atomiche, nucleari e delle cosiddette particelle elementari, pensò di risolvere il problema della distribuzione della carica positiva all'interno dell'atomo, bombardando l'atomo stesso con opportuni proiettili. Usò come proiettili le particelle α, ne studiò la diffusione elastica e giunse all'importantissima conclusione che la carica elettrica positiva è concentrata, insieme alla quasi totalità della massa atomica, in una zona pressoché puntiforme rispetto alle dimensioni atomiche.

Appoggiandosi quindi a ben solide basi sperimentali, Rutherford fu in grado di formulare il suo celebre modello di atomo, in cui gli elettroni gravitano come minuscoli pianeti attratti da una forza centrale inversamente proporzionale al quadrato della distanza, come nel caso newtoniano.

Ma, per il cosiddetto teorema del viriale della meccanica statistica, l'energia cinetica media in un sistema di tipo newtoniano è pari alla metà, cambiata di segno, dell'energia potenziale media. Applicando questo teorema è facile vedere che un insieme di sistemi di tipo newtoniano ha calore specifico negativo. Come conseguenza, se è in grado di irraggiare energia elettromagnetica, come nel caso che ci interessa, esso continuerà a irraggiare indefinitamente, mentre la sua temperatura andrà continuamente aumentando. In altre parole, l'atomo di Rutherford è catastroficamente instabile.

Altre difficoltà relative ai calori specifici si venivano rivelando: nel caso dei gas, particolarmente per le molecole poliatomiche, e nel caso dei solidi, per i calori specifici a temperature molto basse. Un solido può essere schematizzato, molto grossolanamente, come un insieme di atomi oscillanti attorno a posizioni di equilibrio determinate dal suo reticolo cristallino. Se le oscillazioni non sono molto ampie, esse potranno essere considerate, sempre in un'approssimazione molto grossolana, come oscillazioni indipendenti ed armoniche. Un solido contenente n atomi è allora equivalente a un sistema di n oscillatori armonici. Per inciso, osserviamo che in questo caso, e con questo modello, gli oscillatori in gioco sono dei sistemi materiali. Ora, in un oscillatore armonico, l'energia cinetica media è uguale all'energia potenziale media. Pensando un atomo come un punto materiale, esso ha tre gradi di libertà, per cui all'equilibrio termodinamico la sua energia media è 3kT. Ne segue immediatamente la legge di Dulong e Petit. Questa legge va abbastanza bene, a temperatura ordinaria, per la maggior parte dei solidi; ma, quando si abbassa la temperatura, si trova che il calore specifico diminuisce per tutti i solidi, tendendo a zero quando la temperatura tende allo zero assoluto. Questo è ancora un fatto che sembra in patente contraddizione col principio classico dell'equipartizione dell'energia.

Se abbandoniamo per un momento la materia e passiamo a considerare la radiazione in equilibrio termodinamico all'interno di una cavità chiusa, troviamo un altro fatto catastrofico: questa volta la capacità termica di una cavità chiusa, pur in assenza di qualunque materia all'interno della cavità, appare essere infinita per il fatto che la cavità può contenere radiazione elettromagnetica. Ciò si può intendere facilmente, se ricordiamo che la radiazione elettromagnetica all'interno di una cavità chiusa, come abbiamo detto, è equivalente a un insieme di oscillatori. Ma questa volta si tratta di un insieme di infiniti oscillatori e quindi, poiché a ciascun oscillatore, all'equilibrio termodinamico, dovrebbe competere l'energia media kT, l'energia totale contenuta nella cavità dovrebbe essere infinita. Inoltre, semplicemente contando i modi di vibrazione della cavità in funzione della frequenza, si trova che quest'energia dovrebbe indefinitamente crescere verso l'ultravioletto estremo, in patente contraddizione con l'esperienza.

Tutti questi fatti hanno qualcosa in comune: non si può negare ogni validità al principio di equipartizione dell'energia, perché esso è confermato direttamente dalle esperienze di Perrin; ma, d'altra parte, tutto va come se, in certe circostanze, certi gradi di libertà fossero totalmente, o almeno parzialmente, ‛congelati'. Ma precisamente in quali circostanze, quali gradi di libertà, come e perché?

b) Il quanto d'azione

Il bandolo della matassa era già stato trovato da Planck (1900), prima delle ricerche di Perrin e di Rutherford, precisamente nello studio del problema della radiazione in una cavità chiusa all'equilibrio termodinamico.

Planck suppose che la radiazione elettromagnetica potesse raggiungere l'equilibrio termodinamico scambiando energia con ipotetici oscillatori materiali non in modo continuo, ma per ‛quanti discreti' hν, dove h deve intendersi come una nuova costante universale e ν è la frequenza dell'oscillatore materiale.

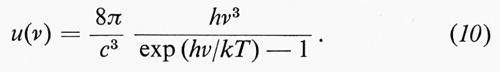

Egli giunse così alla seguente espressione per la densità di energia contenuta in una cavità chiusa, all'equilibrio termodinamico, alla temperatura T e per unità di intervallo di frequenza ν:

In tale espressione, k è la costante di Boltzmann e h è pari a:

h = 6,624•10-27 erg s.

La legge di Planck è pienamente confermata dall'esperienza, per ogni valore di T e ν per cui è stato possibile eseguire la verifica sperimentale.

Alcuni anni dopo, Einstein (1905) riprese le considerazioni di Planck, ritrovando, per via alquanto diversa e più consistente, lo stesso risultato e giungendo, insieme, all'importante concetto di fotone, di cui diremo poi.

Questa discontinuità, postulata da Planck e poi da Einstein, è del tutto estranea alla fisica classica. Come Bohr provò alcuni anni dopo, essa conduce in modo naturale a postulare che l'energia interna di atomi e molecole possa assumere soltanto valori discreti. Questa idea di Bohr è stata confermata in modo diretto dall'esperienza di Frank e Hertz, mediante lo studio dell'urto anelastico di elettroni contro atomi.

Tuttavia la struttura dei livelli energetici discreti di atomi e, peggio ancora, di molecole non è così semplice come quella postulata da Planck per gli oscillatori armonici materiali, e da Einstein estesa agli oscillatori armonici descriventi il campo elettromagnetico (livelli tutti equidistanti di una quantità hν).

Si ricava un'informazione molto più semplice e fondamentale se, invece di considerare i livelli energetici, si esamina cosa succede nello spazio delle fasi per effetto della quantizzazione. Se si considera per esempio il caso dell'oscillatore armonico, l'esame delle traiettorie del punto che rappresenta classicamente lo stato nello spazio delle fasi mostra che queste sono delle ellissi. Se si impone che i livelli energetici siano quantizzati e l'equidistanza sia hν, si trova immediatamente che l'areola compresa tra due ellissi consecutive è semplicemente h, la stessa per tutti i possibili moti armonici. Tutto va come se lo spazio delle fasi fosse suddiviso in areole uguali ad h. Ciò vale non solo per gli oscillatori, ma si generalizza a sistemi qualunque.

Questo risultato deriva da un principio generale, il cui significato fu scoperto da Heisenberg circa vent'anni dopo i lavori di Einstein, e cioè il cosiddetto ‛principio di indeterminazione'. Secondo il principio di indeterminazione, lo stato dinamico di un sistema non può essere più specificato tramite un punto nello spazio delle fasi, e in generale in uno stato qualunque le variabili dinamiche q e p sono variabili ‛indefinite'. Osserviamo subito che ciò non significa affatto che le variabili siano, per così dire, ‛mal note' ma su questo punto torneremo nel seguito. L'indefinizione Δq di una variabile lagrangiana q, e Δp del suo momento coniugato, sono legate tra di loro dall'universale e fondamentale ‛principio di indeterminazione' di Heisenberg:

(Per l'esatta definizione matematica delle indefinizioni Δp e Δq rimandiamo all'articolo quanti, teoria dei).

Si può facilmente vedere, per esempio, come il principio di indeterminazione di Heisenberg possa permettere di dar ragione della stabilità atomica, contro quanto si inferisce dall'applicazione della meccanica statistica classica al modello di Rutherford.

Infatti, quando il raggio dell'orbita di Rutherford diventa troppo piccolo, il teorema del viriale non può più applicarsi, perché, in virtù del principio di indeterminazione di Heisenberg, l'energia cinetica di un elettrone, se il raggio orbitale è r, non può essere inferiore a ≈ℏ2/2mr2 e quindi cresce con l'inverso del quadrato del raggio orbitale. Poiché l'energia potenziale negativa cresce in valore assoluto solo con l'inverso del raggio, l'energia totale ha necessariamente un minimo per distanze finite, quindi l'atomo dev'essere stabile. Se si fa il conto, ad esempio per il caso dell'atomo di idrogeno, si trova che il raggio per cui l'energia è minima ha giust'appunto l'ordine di grandezza del raggio ‛sperimentale' dell'atomo.

Così l'esistenza di h e il principio di indeterminazione di Heisenberg che ne deriva in modo semplice e diretto, dando ragione della stabilità delle proprietà atomiche, danno anche un modo di superare la gravissima fatale deficienza insita nel programma meccanicistico classico, a cui ho accennato nel paragrafo precedente, senza peraltro specificarla.

Non potrei descrivere meglio questa deficienza che con le stesse parole di Heisenberg (v., 1935; tr. it., p. 95): ‟Nondimeno [...] il compito della fisica atomica doveva sembrare insolubile. La chimica tratta infatti di qualità specifiche che in una determinata materia si presentano sempre nella stessa maniera: cioè di qualità che presentano una particolare stabilità di fronte a tutte le possibili perturbazioni [...]. Una simile stabilità è estranea ai sistemi meccanici [...]. Bisognerebbe escogitare qualità ben singolari da attribuire agli atomi se si volesse spiegare meccanicamente una simile stabilità. Questa difficoltà si rivelò nel corso di decenni come il vero problema centrale della fisica atomica, e la sua soluzione riuscì soltanto in base all'ipotesi dei quanti enunciata nel 1900 da Planck".

Prima di proseguire, voglio menzionare che di recente alcuni hanno sollevato delle obiezioni sulla ‛centralità' del problema così impostato. In fondo, si sostiene col loro argomento, tutta la catena di ragionamenti che portano alle difficoltà inerenti alla stabilità interna degli atomi, alla distribuzione della radiazione all'equilibrio termico, ecc., e fondata sull'assunto che, se è valida la meccanica classica, allora debba esser valido anche il principio dell'equipartizione dell'energia. Ma quest'ultimo principio è dedotto anche da ipotesi statistiche, in particolare dalle ipotesi statistiche fatte riguardo alle distribuzioni microcanoniche. Ora, tali ipotesi sono giustificabili, in base alle ricerche fatte sul problema ergodico, solo nel caso in cui lo spazio delle fasi accessibile al moto goda della proprietà della ‛indecomponibilità metrica'. Ma, ad esempio, un insieme di oscillatori armonici, anche lievemente perturbato con piccole perturbazioni anarmoniche, non gode di questa proprietà. Ne seguirebbe che tutta la linea di argomentazioni che abbiamo cercato di esporre precedentemente non è affatto cogente.

Pensiamo che chi argomenta in questo modo non abbia colto in verità il punto essenziale. Se il difetto, in cui cade il principio di equipartizione dell'energia, fosse meramente dovuto a mancanza di ‛indecomponibilità metrica' per i sistemi considerati, si osserverebbe che questi sistemi, invece di raggiungere un unico ben definito stato di equilibrio termodinamico, potrebbero raggiungere diversi stati di equilibrio metastabili (convertibili tramite opportune perturbazioni esterne) e dipendenti dalle condizioni iniziali. Ora, questa non è una situazione che si presenta di fatto; nella realtà si verifica invece un ben definito stato di equilibrio termodinamico; soltanto, questo stato di equilibrio non è quello previsto in base alla meccanica statistica classica, bensì quello che si può prevedere modificando la meccanica classica in modo da tener conto dell'esistenza della costante di Planck h. In altri termini, è lo stato che si può prevedere generalizzando le ipotesi statistiche classiche per adattarle alla nuova meccanica, in modo tale che, nei casi in cui gli effetti della quantizzazione siano trascurabili, si ritrovino gli stessi risultati della meccanica statistica classica.

Ricorderò qui solo che esistono due statistiche quantiche valevoli per due diverse classi di particelle: per le particelle aventi spin, cioè momento angolare intrinseco, semintero, quando espresso in unità ℏ, vale la statistica di Fermi e per le particelle a spin intero vale la statistica di Bose. Di queste statistiche diremo brevemente poi.

Così, per merito della quantizzazione, e tenuto conto che gli elettroni obbediscono alla statistica di Fermi, si sono comprese le proprietà di specifica stabilità degli atomi, le loro proprietà elettromagnetiche, e quindi ottiche, le forze interatomiche, che danno luogo alla formazione di molecole o di solidi, e quindi, almeno in linea di massima, tutte le proprietà di stabilità specifica delle molecole, le loro proprietà elettromagnetiche e, analogamente, le proprietà elastiche, ottiche, elettriche, ecc., dei solidi. Con questo non si vuol dire che tutti i problemi della fisica molecolare, della chimica, della fisica dei solidi e degli altri stati della materia siano risolti. Soltanto, si sono poste basi che si possono considerare sicure per la loro completa soluzione, almeno in via di principio, e molti tra i più importanti dei problemi menzionati sono di fatto risolti almeno approssimativamente. (Non possiamo qui naturalmente entrare in nessun dettaglio. Per questo si rimanda agli articoli quanti, teoria dei; atomo; molecole; criofisica; materia e radiazione interstellare; solidi, fisica dei; biologia molecolare; biofisica; ottica quantistica; meccanica statistica, ecc.). Non si vuole nemmeno dire che tutte queste discipline che studiano il comportamento di corpi macroscopici, o anche di molecole, perfino di molecole abbastanza semplici, siano ormai da considerarsi ‛discipline di second'ordine'; ché la comprensione dei fenomeni che esse studiano (i quali d'altra parte possono essere talvolta molto complessi e di grandissimo interesse intrinseco) può richiedere una originalità di pensiero paragonabile a quella necessaria per avanzare, per esempio, sulla ‛frontiera' della ‛fisica delle particelle elementari'. Si vuole solo dire che tutti gli oggetti fisici che sono studiati in tutte queste discipline, e cioè nella fisica atomica, nella fisica molecolare, nella chimica, nella fisica dei solidi, nella fisica dei fluidi, ecc., sono caratterizzati da un unico tipo di interazione, sufficiente a descriverne il comportamento: l'interazione elettromagnetica (se, ben inteso, si tiene conto degli effetti della quantizzazione).

Si giunge in questo modo a una grandiosa unificazione di svariatissimi rami della scienza, non solo della fisica, ma della chimica e della parte più fondamentale della biologia, la biologia molecolare, con risultati che hanno dato, tra l'altro, la prima conferma decisiva della teoria dell'evoluzione.

c) Dualità corpuscolare-ondulatoria

Naturalmente, l'introduzione della discontinuità, imposta dalla costante h, in un edificio quale quello della fisica classica che fa uso essenziale, per profonde ragioni di metodo, come vedremo, di quantità continue, non poteva avvenire senza una profonda rivoluzione concettuale nelle basi stesse della fisica; rivoluzione che, in un certo senso, coinvolge l'assetto metodologico e il significato di tutta la scienza naturale. Il primo sintomo della necessità di una tale profonda rivoluzione si è rivelato con la già ricordata introduzione da parte di Einstein del concetto di fotone. Nella sua deduzione della legge di Planck, Einstein non si limitò a considerare gli scambi di energia tra materia e radiazione, ma considerò anche gli scambi di quantità di moto. Nella deduzione di Einstein, si noti bene, era implicita l'ipotesi che la quantità di moto degli atomi che emettono o assorbono radiazione sia ben definita, tanto prima quanto dopo l'atto di assorbimento e di emissione. In base a tale ipotesi, Einstein giunse alla conclusione che la radiazione deve essere emessa dall'atomo, in un atto di emissione, non solo con una ben definita energia, hν, ma anche con una quantità di moto ben determinata (hν/c) avente una ben definita direzione (Niedelstrahlung). Ciò equivaleva a risuscitare il modello corpuscolare della luce, e i ‛corpuscoli luminiferi' furono chiamati ‛fotoni'. Così il modello corpuscolare della luce sembrava in certo modo imposto dalla quantizzazione, e riceveva del resto numerose conferme sperimentali (effetto fotoelettrico; effetto Compton; più di recente l'effetto Mössbauer, che conferma direttamente l'idea della Niedelstrahlung; ecc.).

Sorgeva allora immediatamente il problema: come interpretare gli effetti di interferenza che, viceversa, avevano imposto - in un modo che nel secolo passato si era ritenuto definitivo - il modello ondulatorio della luce?

Il problema presentava aspetti paradossali, e vale la pena di riesaminarli brevemente.

Consideriamo ad esempio l'esperienza dell'interferenza della luce, eseguita mediante un interferometro di Michelson. Supponiamo che le frange si formino sopra una lastra fotografica, considerata come una lastra ideale con rendimento pari a 1, ossia ammettiamo che ogni singolo fotone sia sicuramente rivelato. Supponiamo che l'intensità della luce monocromatica usata sia molto bassa. Noi vedremmo ora un granulo sensibile, ora l'altro, impressionato dalla luce incidente: ad ogni granulo corrisponde un fotone che sembra giungere in un posto ben determinato; solo dopo un tempo considerevole potremo riconoscere che la densità del numero dei granuli impressionati varia sulla superficie della lastra, dando luogo all'apparizione delle classiche frange d'interferenza. Ciò suggerisce immediatamente di collegare l'aspetto corpuscolare e quello ondulatorio della radiazione tramite un'ipotesi statistica: è il numero medio dei fotoni che cadono su una data superficie che è proporzionale all'energia che cade su quella superficie calcolata secondo le leggi dell'ottica ondulatoria. Se il fotone è uno solo, potremo parlare soltanto di probabilità che il fotone venga assorbito entro una data areola della lastra, e questa probabilità sarà proporzionale al modulo quadrato dell'ampiezza dell'onda incidente. Del resto, considerazioni probabilistiche erano già entrate in modo essenziale nella teoria einsteiniana che aveva condotto al concetto di fotone. Tuttavia questa stessa interpretazione probabilistica presenta degli aspetti paradossali se si considera il fotone come una particella classica. Infatti, in questo caso, dovremmo dire che ogni singolo fotone, incidendo sullo specchio semitrasparente dell'interferometro, sarà o riflesso o trasmesso. D'altra parte i singoli fotoni provenienti da una normale sorgente viaggiano in modo indipendente (e ciò è confermato da esperienze dirette). Ogni fotone va considerato isolatamente e, quindi, trattandosi di eventi mutuamente escludentisi, secondo un noto teorema del calcolo delle probabilità, la probabilità di osservare l'assorbimento del fotone in un'areola Δs dovrebbe essere uguale alla somma della probabilità che ha il fotone di essere assorbito in Δs nel caso in cui sia riflesso, più quella nel caso in cui sia trasmesso dal separatore d'onde. Ma, se così fosse, non si osserverebbero frange d'interferenza.

La difficoltà è tale che indusse Bohr, Kramers e Slater a formulare una teoria in cui la questione sul percorso del fotone perdesse completamente senso in ogni caso. Per questo, però, è necessario supporre che nei singoli processi elementari in cui interviene un singolo fotone le leggi di conservazione dell'energia e dell'impulso siano violate, e siano anch'esse leggi statistiche, valide solo per i grandi numeri. Infatti, se non è così, si può decidere in linea di principio se il fotone è riflesso o trasmesso: basta osservare se lo specchio rincula o no; se rincula, è riflesso; se no, è trasmesso. Immediatamente furono intraprese delle ricerche sperimentali, per verificare se la legge della conservazione dell'energia e dell'impulso è valida o no nei processi elementari, usando l'effetto Compton. Esperienze di Bothe e Geiger e di Compton e Simon (v. quanti, teoria dei) provarono che la legge di conservazione è valida in ogni singolo processo elementare (qualora, naturalmente, le grandezze che si misurano siano ben definite). La difficoltà così si ripresenta in pieno. La soluzione sta nel principio di indeterminazione; se si vuol stabilire se lo specchio semitrasparente rincula o no, occorre che la sua quantità di moto sia definita in modo sufficientemente preciso prima dell'arrivo del fotone. Ma in questo caso la sua posizione deve avere una certa indefinizione, maggiore o uguale al limite inferiore stabilito dal principio di indeterminazione. Con una tale indefinizione è facile vedere che scompaiono le frange: scompare così anche il paradosso.

L'analisi di questa e di molte altre simili situazioni condusse Bohr al suo celebre ‛principio di complementarità', secondo cui la realtà quantica presenta aspetti che sono tra di loro incompatibili dal punto di vista classico. Questi aspetti però non si presentano mai assieme, per cui vere e proprie antinomie possono essere sempre evitate. L'aspetto corpuscolare e quello ondulatorio della radiazione sono due aspetti complementari, secondo Bohr. Tale complementarità non è propria solo della radiazione, ma anche della ‛materia'. Così si possono osservare effetti interferenziali con elettroni, protoni, neutroni, atomi e molecole.

Come abbiamo già detto, lo stesso principio di indeterminazione implica che lo stato dinamico di un sistema non possa più essere rappresentato tramite un punto nello spazio delle fasi. Data l'esistenza dei fenomeni interferenziali, si è trovato conveniente, invece, rappresentarlo tramite una ‛funzione d'onda' (v. quanti, teoria dei) la quale obbedisce a un'equazione differenziale di propagazione che, appunto allo scopo di permettere l'interpretazione dei fenomeni interferenziali, deve essere un'equazione lineare, la cosiddetta equazione di Schrödinger:

In questa equazione ψ rappresenta la funzione d'onda, H è un operatore lineare hermitiano che, nella nuova meccanica quantica, rappresenta l'hamiltoniana del sistema e t è il tempo. Nella nuova meccanica quantica anche le q e le p sono rappresentate da operatori lineari hermitiani non commutabili (v. quanti, teoria dei). L'operatore H, nel caso dei sistemi che abbiano un corrispondente classico, è una funzione delle q e delle p formalmente uguale alla funzione H classica, a parte la specificazione eventuale dell'ordine dei fattori nel prodotto di operatori non commutabili.

Vi è così una stretta corrispondenza formale tra la meccanica quantica e la meccanica classica nella sua forma canonica o hamiltoniana. Per esempio, se si risolve la (12) nell'approssimazione dell'ottica geometrica, la ‛fase' della ψ moltiplicata per ℏ corrisponde all'azione di Hamilton. Questa corrispondenza non deve meravigliare se si ricorda quanto già avevamo detto a proposito del formalismo canonico nel capitolo precedente.