Informatica

Informatica

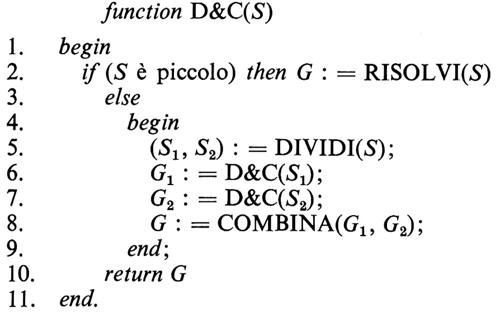

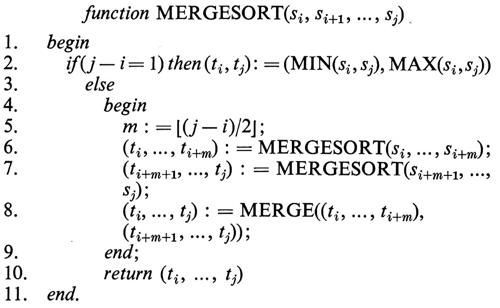

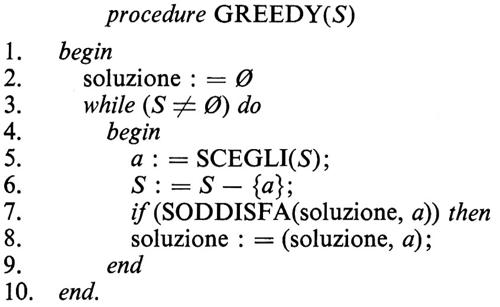

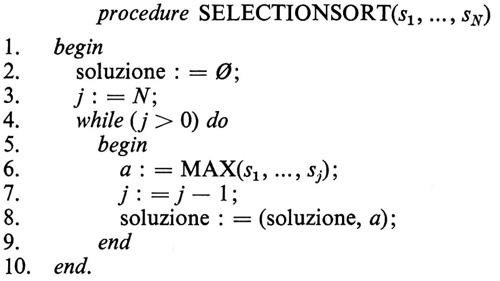

Teoria della computazione di Fabrizio Luccio

SOMMARIO: 1. Origine e motivazioni. 2. Notazione. 3. Automi finiti. 4. Automi a pila. 5. La macchina di Turing. 6. Decidibilità e indecidibilità. 7. Complessità di calcolo. 8. Problemi intrattabili. 9. I principali studi sull'argomento. □ Bibliografia.

1. Origine e motivazioni.

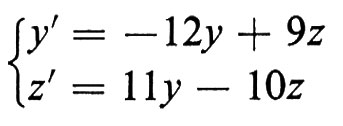

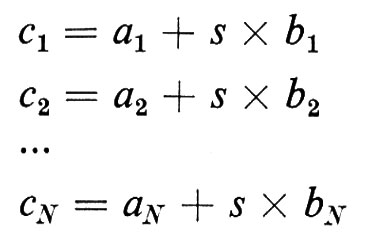

La necessità del calcolo, riconosciuta dall'uomo in tutte le civiltà ed epoche storiche, ha condotto a una sistematizzazione teorica della computazione solo in tempi recentissimi. Due fatti hanno contribuito in modo determinante allo sviluppo di questi studi: da un lato la formalizzazione del concetto di procedura di calcolo, che possiamo datare al 1936, anche se preceduta da rilevanti risultati di logica matematica ottenuti nei primi decenni del secolo; dall'altro lo sviluppo dei calcolatori a programma memorizzato, nati dal secondo conflitto mondiale e divenuti in breve tempo così importanti nelle più varie attività da richiedere approfonditi studi sull'efficienza della computazione. Nascono da questi fatti i due assi portanti della teoria della computazione, cioè la ‛computabilità' e la ‛complessità di calcolo', di cui ci occuperemo in questo articolo.

Il secondo problema di Hilbert sulla dimostrazione di compatibilità degli assiomi dell'aritmetica, posto all'inizio del secolo e rimasto insoluto anche nella formalizzazione dei Principia mathematica di Russell e Whitehead, aveva trovato una risposta negativa nel 1931 con il famoso teorema di incompletezza di Gödel, che provava l'esistenza di formule indimostrabili nel calcolo dei predicati del primo ordine, attraverso la costruzione di una di tali formule.

La prova di Gödel, basata sulla costruzione di una formula provatamente indimostrabile, lasciava aperto il problema della ‛formalizzazione della procedura' di dimostrazione, o più in generale della procedura di calcolo di una funzione. Gli anni che seguirono furono rivolti a ricercare tale formalizzazione, sotto l'ipotesi che ogni procedura dovesse consistere nella specificazione finita di una sequenza di passi, ciascuno eseguibile meccanicamente in tempo finito. Nel 1936 Turing introduceva la sua ‛macchina', che divenne il modello accettato di procedura e che rimane tale per la sua provabile equivalenza computazionale con ogni altro modello conosciuto, in particolare con i calcolatori di oggi (quando questi siano dotati di memoria sufficiente al calcolo richiesto), e per la sua equivalenza con ogni altro modello possibile, assenta nell'‛ipotesi di Church'.

La descrizione finita della procedura comporta come conseguenza che la classe di tutte le procedure è ‛numerabile', ovvero le procedure possono essere poste in corrispondenza biunivoca con i numeri naturali. Un modo pragmatico per convincersene è quello di formulare le procedure come programmi per un dato calcolatore, elencare questi programmi in ordine alfabetico rispetto ai caratteri che li compongono e assegnare poi a essi una numerazione progressiva: poiché si può banalmente dimostrare che i programmi ben formati sono infiniti, la classe dei programmi, e quindi delle procedure, ha la cardinalità degli interi.

Un argomento simile al precedente mostra che anche i dati su cui può operare una procedura, e i suoi risultati, rispondono a una descrizione finita e sono quindi numerabili. Ciò autorizza a considerare una procedura come meccanismo di calcolo di una funzione dai naturali sui naturali; anzi lo studio può essere limitato alle procedure ‛di decisione', che calcolano funzioni dai naturali su {o, 1} (decidono se accettare o respingere un'asserzione rappresentata dai dati), perché queste catturano tutte le proprietà interessanti della computabilità.

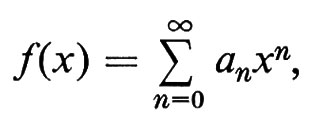

Questi fatti furono immediatamente posti in relazione con la non numerabilità della classe delle funzioni. Se infatti esistesse una numerazione f0, f1, ..., per esempio per le funzioni dai naturali su {0, 1}, si potrebbe legittimamente costruire la funzione g tale che

g(x) = 0, se fx(x) = 1; g(x) = 1, se fx(x) = 0;

per cui si avrebbe, per ogni i, g(i) ≠ fi(i). Scelta comunque una numerazione di tutte le funzioni, giungeremmo pertanto alla contraddizione che g non fa parte dell'insieme.

La formalizzazione delle procedure mise quindi in evidenza un fatto dostinato a divenire uno dei cardini della teoria della computazione: poiché la classe delle funzioni non è numerabile, mentre la classe delle procedure è numerabile, devono esistere funzioni per le quali non esiste procedura di calcolo, cioè ‛funzioni non calcolabili' (o ‛non decidibili' nel caso di codominio {0, 1}). In sostanza non esistono procedure sufficienti a calcolare tutte le funzioni possibili. Se questo fatto era in qualche misura già atteso, molto meno ovvia fu l'individuazione delle prime funzioni non calcolabili, corrispondenti a problemi matematici significativi e ben posti, e tuttavia provatamente irrisolubili; ci occuperemo di tali problemi nel seguito.

Accanto alla macchina di Turing, altri modelli computazionali più semplici sono stati sviluppati nell'ambito di diverse discipline scientifiche. Tali modelli, concepiti in origine per la soluzione di specifiche classi di problemi, hanno trovato posto in una sistematizzazione generale della teoria della computabilità con il nome di ‛automi', assieme alla macchina di Turing, che è l'automa più potente e complesso e comprende tutti gli altri come casi particolari. Studieremo nel seguito le tre principali famiglie di automi e le classi di funzioni che essi calcolano: gli ‛automi finiti', nati come modelli di reti neuroniche e di circuiti elettrici, gli ‛automi a pila', nati in campo linguistico, e infine la ‛macchina di Turing' di cui già si è detto.

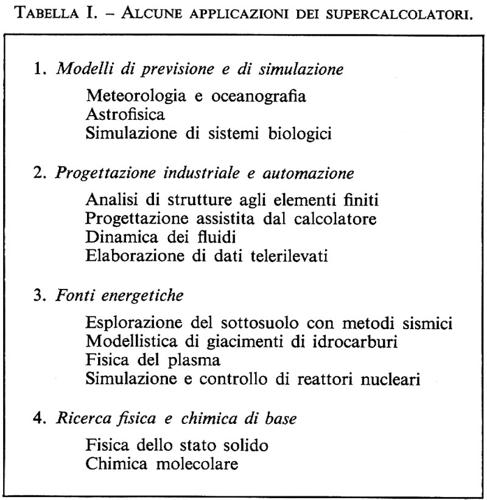

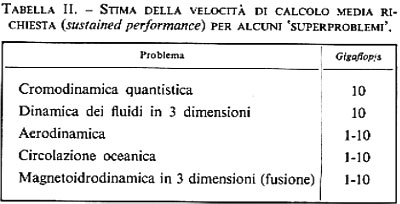

Affrontato il problema della calcolabilità, ci porremo quello della complessità dei procedimenti di calcolo, che ha origini molto più recenti. Benché possa apparire a prima vista sorprendente, lo studio dell'efficienza delle procedure ha riscosso attenzione crescente al crescere della velocità e delle dimensioni dei calcolatori ed è divenuto argomento centrale nella teoria della computazione solo nell'epoca attuale, caratterizzata da macchine estremamente potenti che dovrebbero rendere secondaria ogni preoccupazione sul modo più opportuno di impiegarle. Due motivi hanno invece generato l'effetto contrario.

Il primo, abbastanza semplice, è che l'uomo basa oggi il progresso economico e tecnologico sulla risoluzione numerica di problemi così vasti, da essere stati ritenuti praticamente non affrontabili prima dell'avvento dei grandi calcolatori. Non vi è però virtualmente limite alle dimensioni dei problemi che sarebbe utile poter risolvere e che sono ancora fuori della portata dei mezzi di calcolo: si tende perciò ad ampliare la potenza dei calcolatori e a raffinarne le tecniche di impiego, ed è a quest'ultimo aspetto che si rivolgono gli studi di complessità di calcolo.

Il secondo motivo, assai più sottile, è legato ai meccanismi del calcolo non deterministico. La macchina di Turing, nella sua più generale definizione, ha la possibilità di rispondere non deterministicamente alle stesse condizioni di ingresso, secondo un modello di comportamento definito matematicamente e simulato in pratica con l'esecuzione alternativa di tutte le azioni possibili a ogni passo. Il non determinismo non amplia la classe delle funzioni calcolabili, ma incide in modo cruciale sul tempo di calcolo, poiché una sequenza di n passi non deterministici, ciascuno dei quali preveda m alternative, è simulata attraverso mn passi deterministici.

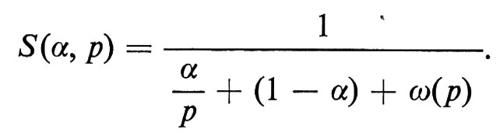

Nel decennio tra il 1960 e il 1970 si raggiunse la conclusione che la misura più significativa dell'efficienza di una procedura è l'espressione matematica del tempo che essa richiede in funzione della dimensione dei dati d'ingresso. Le procedure si divisero in ‛efficienti' e ‛inefficienti', a seconda che il tempo richiesto fosse polinomiale o esponenziale. In un famoso lavoro del 1971 sulla complessità delle procedure di dimostrazione, Cook provava che tutti i problemi risolubili con una macchina di Turing non deterministica in tempo polinomiale si riducono all'unico problema della soddisfattibilità di espressioni booleane. Negli anni seguenti si riconobbe che numerosissimi problemi ben posti e praticamente rilevanti sono computazionalmente equivalenti a quello della soddisfattibilità: esistono cioè procedure efficienti per risolverli nel modello non deterministico, ma la simulazione pratica di tali procedure è inefficiente poiché richiede tempo esponenziale. Se d'altra parte si scoprisse un algoritmo polinomiale deterministico per risolvere uno di questi problemi, lo stesso algoritmo sarebbe sufficiente a risolverli tutti in pari tempo.

L'unificazione di importanti problemi apparentemente molto diversi e il quesito formalmente ancora aperto dell'esistenza di un'efficiente procedura deterministica per risolverli hanno concentrato sugli aspetti di complessità gli studi attuali di teoria della computazione, influenzando profondamente il modo di affrontare la risoluzione algoritmica di un problema.

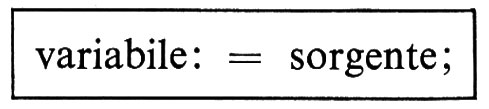

2. Notazione.

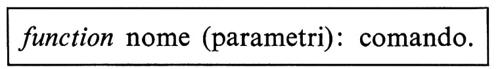

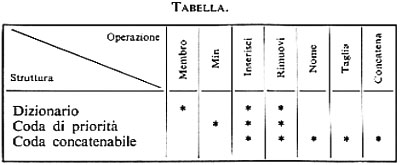

La teoria degli algoritmi è interamente basata su descrizioni finite e discrete. L'intera disciplina può essere appresa su un numero finito di testi di lunghezza finita, composti unicamente con i ‛caratteri' (o ‛simboli') di un insieme finito detto ‛alfabeto'. Non occorrono cioè illustrazioni composte di linee continue o colori sfumati, inflessioni di voce o altro, ma solo elementi tratti da un insieme che ha la cardinalità degli interi. Una volta appresa la disciplina, anche la pratica si avvale degli stessi mezzi di descrizione: tutte le computazioni eseguite da un uomo o da un calcolatore possono essere descritte con i caratteri di un alfabeto.

Poiché un alfabeto Σ è un insieme finito, la notazione di base è quella della teoria degli insiemi. Si definiscono l'insieme vuoto Ø, le relazioni di appartenenza e di contenimento, le operazioni di unione, intersezione e differenza. Si definisce la potenza 2Σ dell'insieme Σ come l'insieme di tutti i sottoinsiemi di Σ; il prodotto cartesiano Σ × Γ tra gli insiemi Σ e Γ come l'insieme di tutte le coppie ordinate (s, g) tali che s ∈Σ , g ∈ Γ. Indicheremo in genere gli alfabeti con lettere greche maiuscole; i caratteri con le prime lettere latine minuscole o con cifre numeriche.

Una ‛stringa' (o ‛parola') w su un alfabeto Σ è una sequenza finita di caratteri di Σ; la sua ‛lunghezza' ∣ w ∣ è il numero di caratteri che contiene. ε indica la stringa vuota, ∣ ε ∣ = 0. Le stringhe si indicano in genere con le ultime lettere latine minuscole, o con lettere greche minuscole. La ‛concatenazione' di due stringhe v, w è la stringa composta da v seguita da w, e si indica con vw. Per ogni stringa w si ha: εw = wε = w.

La ‛stella' Σ * di un alfabeto Σ è l'insieme (infinito) di tutte le stringhe sull'alfabeto, inclusa la stringa vuota. Un ‛linguaggio' L è un insieme finito o infinito di stringhe su Σ, cioè L ⊆ Σ *. Ovviamente Σ * è numerabile, ma non è numerabile la classe di tutti i linguaggi su Σ.

I linguaggi si indicano specificandone le proprietà che caratterizzano le loro parole. La stringa costituita da un carattere c ripetuto i ≥ 0 volte si indica con ci. Per esempio i seguenti insiemi L1, L2, L3 sono linguaggi su Σ = {a, b, c}:

L1 = {w ∣ w contiene un numero pari di simboli}; per esempio: abc2 ∈ L1;

L2 = {w ∣ w = av, v ∈ Σ *}; cioè L2 è formato dalle parole che iniziano con a, per esempio: acba, a, aab ∈ L2;

L3 = {aibi, i ≥ 0}; cioè L3 è formato dalle parole che iniziano con un arbitrario numero di a seguito dallo stesso numero di b; per esempio: ab, ε, aaaabbbb ∈ L3.

Consideriamo ora un automa (o procedura) A che dà risposte su {0, 1}. Detto Σ l'alfabeto con cui vengono codificati i dati d'ingresso, si ha che l'insieme di tutti i dati possibili è Σ * ovvero A calcola una funzione da Σ * su {0, 1}. Sotto una numerazione delle stringhe di Σ * si può affermare che tale funzione va dai naturali su {0, 1 }, ovvero A realizza una delle procedure di decisione il cui studio, come già affermato, contiene i risultati chiave della teoria della computazione. Se L è il sottoinsieme di Σ * per cui A dà risposta 1, diremo che L è il linguaggio ‛accettato' da A.

La computabilità potrà quindi essere vista come studio delle proprietà dei linguaggi accettati da diverse famiglie di automi e la complessità come studio del tempo necessario a tale accettazione, anche se l'intera questione sarà grandemente complicata dal fatto che l'automa potrebbe non fornire risposta in tempo finito.

3. Automi finiti.

Il primo modello computazionale che prendiamo in considerazione è l'‛automa finito' (brevemente a.f.). Esso è definito come un gruppo di cinque entità (S, Σ, s′, F, ∂), ove:

S è un insieme finito di ‛stati interni' (o semplicemente ‛stati');

Σ è l'alfabeto d'ingresso;

s′ ∈ S è lo ‛stato iniziale';

F ⊆ S è l'insieme degli ‛stati finali';

∂ è una ‛funzione di transizione' da S×Σ su S.

L'automa esegue una successione di ‛mosse'. Posto inizialmente nello stato s′, esso legge una stringa di ingresso α ∈ Σ * da sinistra a destra, un carattere per mossa, e assume a ogni mossa un nuovo stato indicato dalla funzione di transizione: più precisamente, posto che l'automa si trovi nello stato s ∈ S e legga il carattere c ∈ α, esso si porta nello stato ∂(s, c) e sposta la lettura sul carattere successivo di α. La stringa α è ‛accettata' se e solo se con la lettura del suo ultimo carattere l'automa si porta in uno stato finale f ∈ F.

Attraverso il meccanismo di transizione tra stati l'automa raccoglie e conserva informazione sullo svolgimento del calcolo, che consiste in sostanza nell'aggiornamento di tale informazione a ogni mossa, sulla base dei caratteri di α. Ogni stato di S corrisponde alla ‛memorizzazione' di una proprietà della porzione (‛prefisso') di a che termina sull'ultimo carattere letto. Poiché Σ * è infinito e S è finito, vi sarà in genere un numero infinito di stringhe prefisso che conducono l'automa nello stesso stato, per le quali cioè l'automa riconosce e memorizza la stessa proprietà. In particolare una proprietà è associata a ogni stato finale e caratterizza le stringhe accettabili.

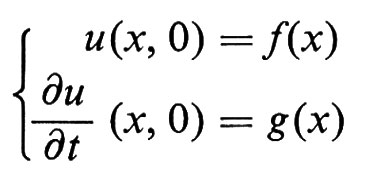

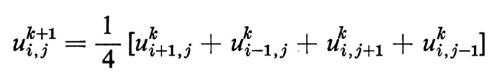

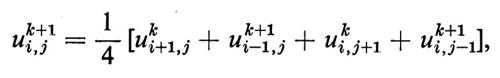

La funzione di transizione si assegna indicandone i valori ∂(s, c) in una tabella, in funzione di s e c. In alternativa si usa un ‛grafo di transizione', di interpretazione immediata se è piccola la cardinalità del dominio di definizione S×Σ. I vertici del grafo corrispondono agli stati di S; gli spigoli sono orientati ed etichettati e corrispondono alle transizioni indicate dalla funzione ∂: se ∂(s, c) = t, vi è un arco di etichetta c diretto da s a t.

Consideriamo per esempio l'automa A = ({s′, s0, s1, s2}, {0, 1}, s′, {s0}, ∂), cui è associato il grafo di transizione della fig. 1 (lo stato finale s0 è indicato a tratto spesso). A accetta tutte e sole le stringhe di 0 e 1 che rappresentano numeri binari multipli di tre, di almeno una cifra. Per esempio la stringa 10010 (codifica binaria del numero 18) causa la sequenza di transizioni s′ → s1 → s2 → s1 → s0 → s0, che termina nello stato finale s0 ed è quindi accettata da A. La stringa 1101 (codifica binaria di 13) causa le transizioni s′ → s1 → s0 → s0 → s1 e non è quindi accettata.

Per provare che l'automa A accetta tutte e sole le stringhe α ∈ {0, 1}* con le proprietà dette, indichiamo con [α] il numero binario rappresentato da α e associamo agli stati di A le seguenti proprietà delle stringhe prefisso β: s′ è lo stato iniziale, in cui si attende l'arrivo del primo carattere (ricordiamo che A non accetta la stringa vuota); si, con 0 ≤ i ≤ 2, è raggiunto per tutte e sole le stringhe β tali che [β] ≡ i mod 3 (cioè tali che i sia il resto della divisione tra [β] e 3), come si prova facilmente per induzione sulla lunghezza di β, notando che per β = ηc, con η ∈ {0, 1}* e c ∈ {0, 1}, si ha [β] = 2[η] + [c]. Per esempio, poiché si arriva in s1 con stringhe β tali che [β] ≡ 1 mod 3 e concatenando βi con 0 si ha [β0] = 2[β] + 0 ≡ 2 mod 3, si pone ∂(s1, 0) = s2 (v. fig. 1). Lo stato finale è quindi s0, associato a tutte le stringhe α con [α] ≡ 0 mod 3.

È utile estendere il dominio di definizione della funzione di transizione per designare il comportamento dell'automa in risposta a intere stringhe d'ingresso. Si introduce la nuova funzione ∂ da S×Σ* su S, definita ricorsivamente attraverso le relazioni:

∂(s, ε) = s;

∂(s, αc) = ∂(∂(s, α), c), con α ∈ Σ*, c ∈ Σ.

Si definisce allora il ‛linguaggio accettato' da un automa finito M = (S, Σ, s′, F, ∂) come l'insieme di stringhe L(M) = {α ∣ ∂(s′, α) ∈ F}. Un linguaggio (o insieme) L si dice ‛regolare' se esiste un automa finito M tale che L = L(M). Per l'automa A della fig. 1 abbiamo L(A) = {α ∣ [α] ≡ 0 mod 3, ∣ α ∣ > 0, dunque questo linguaggio è regolare.

Occupiamoci ora di una importante modificazione degli automi finiti, che ritroveremo anche negli altri modelli di calcolo. M = (S, Σ, s′, F, ∂′) è un ‛automa finito non deterministico' (brevemente a.f.n.d.) se, per uno stesso stato e uno stesso carattere letto dall'esterno, si definiscono più mosse per M. Il significato di S, Σ, s′ e F rimane invariato, mentre la funzione di transizione ∂′ è ora definita da S×Σ su 2S, cioè: ∂′(s, c) = R ⊆ S, ove R è l'insieme di tutti gli stati in cui l'automa può portarsi dallo stato g leggendo il carattere c. Tutti questi stati devono essere ‛provati' dall'automa, che segue così una molteplicità di percorsi computazionali paralleli in relazione a una stessa stringa d'ingresso. La stringa è ‛accettata' se e solo se almeno uno di questi percorsi termina in uno stato finale f ∈ F. Si noti che 2S contiene l'insieme vuoto, quindi potrebbe esistere una coppia s, c per cui ∂′(s, c) = Ø: in questo caso la nuova mossa non è definita e il percorso computazionale contenente s, c si arresta.

Immaginiamo di modificare l'automa A della fig. 1, in modo che accetti le stringhe α su {0, 1} che rappresentano numeri binari multipli di tre o di due, cioè: [α] ≡ 0 mod 3 o [α] ≡ 0 mod 2. Il nuovo automa B si costruisce spontaneamente come a.f.n.d., aggiungendo al grafo di transizione di A una nuova parte per il riconoscimento dei multipli di due e accedendo non deterministicamente da s′ all'una o all'altra parte del grafo per controllare entrambe le divisibilità. Si ha così

B = ({s′, s0, s1, s2, s3, s4}, {0,1}, s′, {s0, s3}, ∂′),

con il grafo di transizione mostrato nella fig. 2. Il non determinismo è messo in evidenza nel grafo dall'esistenza di vertici (s′ nell'esempio) da cui partono spigoli con la stessa etichetta.

Il lettore potrà provare per proprio conto che l'automa B risolve correttamente il problema posto.

Poiché un a.f.n.d. M = (S, Σ, s′, F, ∂′) può assumere diversi stati in risposta alla stessa stringa d'ingresso, è utile introdurre una nuova funzione di transizione ∂′ da 2S × Σ* su 2S, definita attraverso le relazioni:

∂′(Q, ε) = Q, con Q ⊆ S;

∂′(Q, c) = ⋃s∈Q ∂′(s, c), con Q ⊆ S, c ∈ Σ;

∂′(Q, αc) = ∂′(∂′(Q, α), c), con Q ⊆ S, α ∈ Σ*, c ∈ Σ.

Si definisce quindi il linguaggio accettato dall'a.f.n.d. M come l'insieme di stringhe L(M) = {α ∣ ???29??? s ∈ ∂′({s′}, α) tale che s ∈ F}. Per l'automa B della fig. 2 abbiamo: L(B) = {α ∣ ([α] ≡ 0 mod 3) ⋀ ([α] ≡ 0 mod 2), ∣ α ∣ > 0}.

Si può dimostrare che la classe dei linguaggi accettati dagli a.f.n.d. è esattamente quella dei linguaggi regolari. Se è ovvio che i linguaggi regolari siano accettati dagli a.f.n.d. (infatti ogni a.f. può essere considerato un caso particolare di a.f.n.d. in cui il codominio della funzione ∂′ è limitato a S), il seguente teorema dimostra che gli a.f.n.d. non accettano altri linguaggi, cioè il non determinismo non aumenta la potenza computazionale degli automi finiti.

Teorema. Sia L il linguaggio accettato da un a.f.n.d. arbitrario X. Allora esiste un a.f. (deterministico) Y che accetta L.

Il teorema si dimostra in modo costruttivo, indicando come costruire Y dagli elementi di X. In particolare ogni stato di Y, raggiunto in seguito alla lettura di una stringa a, corrisponde al sottoinsieme degli stati di X raggiunto con la lettura della stessa stringa. Quindi, se X ha n stati, Y può averne 2n ed è questa possibile esplosione delle dimensioni l'unico prezzo pagato al determinismo (vedremo che la situazione è molto diversa per le altre famiglie di automi).

Senza addentrarci nella prova del teorema, indichiamo nella fig. 3 il grafo di transizione di un a.f. C corrispondente all'a.f.n.d. B della fig. 2. I nomi degli stati di C indicano, con i loro indici, i corrispondenti sottoinsiemi di stati di B. I due automi hanno lo stesso stato d'ingresso e gli stati finali di C corrispondono a sottoinsiemi contenenti uno stato finale di B.

Abbiamo di nuovo: L(C) = L(B) = {α ∣ ([α] ≡ 0 mod 3) ⋀ ([α] ≡ 0 mod 2), ∣ α ∣ > 0}.

Tra le numerose proprietà di cui godono i linguaggi regolari, le seguenti sono assai notevoli.

Lemma. Per ogni linguaggio regolare L esiste una costante n > 0 tale che qualsiasi stringa α ∈ L, con ∣ α ∣ ≥ n può essere espressa come α = βγδ, con ∣ βγ ∣ ≤ n, ∣ γ ∣ ≥ 1, in modo che la nuova stringa α′ = βγiδ ∈ L per ogni i ≥ 0.

Il lemma è una diretta conseguenza del fatto che gli a.f. hanno un numero finito di stati. Posto n = ∣ S ∣, un'arbitraria stringa d'ingresso α condurrà l'automa almeno due volte in uno stesso stato s: la porzione di α che porta l'automa da s ancora a s può allora essere ripetuta un numero arbitrario di volte in α senza alterare l'effetto delle parti precedente e successiva della stringa.

Il lemma ha due importanti conseguenze. La prima è la possibilità di riconoscere che un linguaggio L non è regolare, se si individua una stringa α ∈ L che, comunque suddivisa in βγδ, genera stringhe α′ ∉ L. Consideriamo per esempio il linguaggio L = {aibi, i ≥ 1}. Posto che L sia regolare e che n sia la costante del lemma, la stringa α = anbn ∈ L potrebbe essere scritta come α = βγδ, con βγ = am≤n, e da questa si genererebbe la nuova stringa α′ = βγi=0δ = βδ = apbn, con p 〈 n. Poiché α′ ∉ L, questo linguaggio non è regolare. (Intuitivamente il motivo per cui un linguaggio apparentemente semplice come L non può essere accettato da un automa finito è che, per decidere se il numero delle b è uguale al numero delle a un automa dovrebbe aver ‛contato' le a, il che per una sequenza di a arbitrariamente lunga richiede memoria arbitrariamente grande).

La seconda conseguenza del lemma riguarda la possibilità di decidere se un linguaggio regolare è vuoto, finito o infinito. Dal lemma discende infatti che il linguaggio L(A) accettato da un a.f. A di n stati deve contenere almeno una stringa α tale che

∣ α ∣ 〈 n se L(A) ≠ Ø;

n ≤ ∣ α ∣ 〈 n, se L(A) è infinito.

Controllando la risposta di A su tutte le stringhe di lunghezza minore di n, o compresa tra n e 2n, si stabilisce se L(A) è vuoto o non vuoto, finito o infinito. Poiché tutte queste stringhe sono in numero finito, e l'automa A risponde a ciascuna di esse in tempo finito, il procedimento accennato è ‛effettivamente eseguibile' (anche se molto inefficiente; ma ne esistono di più rapidi). La teoria della computazione studia diverse proprietà degli insiemi, ma annette particolare importanza a quelle per cui esiste, ed è nota, una procedura di decisione.

Oltre alle proprietà viste, i linguaggi regolari godono di varie proprietà di chiusura, tra cui ricordiamo quelle espresse nel teorema seguente (la complementazione ¬L di un linguaggio L è definita come: ¬L = Σ* − L).

Teorema. La famiglia dei linguaggi regolari è chiusa sotto le operazioni di unione, intersezione e complementazione. Inoltre, dati due a.f. A1, A2, esistono (semplici) procedure per costruire un a.f. A3 tale che

L(A3) = L(A1) ⋃ L(A2);

L(A3) = L(A1) ⋂ L(A2);

L(A3) = ¬L(A1).

Due automi che accettano lo stesso linguaggio si dicono ‛equivalenti'. Una conseguenza del precedente teorema è che si può costruire un automa A4 che riconosce il linguaggio L(A4) = (L(A1) ⋂ ¬L(A2)) ⋃ (¬L(A1) ⋂ L(A2)) e si vede immediatamente che L(A4) = Ø se e solo se L(A1) = L(A2). Poiché sappiamo che esiste una procedura per decidere se L(A4) = Ø, possiamo concludere col seguente teorema.

Teorema. Esiste una procedura per decidere se due automi finiti sono equivalenti.

4. Automi a pila.

La limitazione di potenza computazionale degli automi finiti deriva dalla finitezza della loro memoria. In particolare il ricordo di una situazione è legato unicamente allo stato assunto dall'automa: poiché l'insieme degli stati è finito, il numero di situazioni memorizzabili è anch'esso finito.

Per accrescere la potenza del modello si ammette che l'automa possa registrare un numero a priori illimitato di situazioni diverse; tale registrazione viene però effettuata su un mezzo esterno, perché l'automa conservi dimensioni finite. Il primo mezzo considerato è la ‛pila', definita come una struttura che può contenere una stringa di lunghezza illimitata, composta di caratteri di un proprio alfabeto Π. L'accesso alla pila avviene sul primo carattere p (‛testa') della stringa w ivi contenuta e ha lo scopo di ‛leggere' p e di memorizzare una nuova informazione mediante l'inserzione nella pila di una stringa x che sostituisce p (per consentire l'accesso, w non può essere vuota). Posto w = py, p ∈ Π, y ∈ Π* e x ∈ Π*, l'inserzione di x causa la trasformazione della stringa contenuta nella pila da w a xy e il conseguente spostamento della testa sul primo carattere di x.

Definiamo ora l'‛automa a pila deterministico' (brevemente a.p.d.) come un gruppo di sette entità (S, Σ, Π, s′, p′, F, ∂), ove:

S è un insieme finito di ‛stati';

Σ è l'alfabeto d'ingresso;

Π è l'alfabeto della pila;

s′ ∈ S è lo ‛stato iniziale';

p′ ∈ Π è il ‛carattere iniziale';

F ⊆ S è l'insieme degli ‛stati finali';

∂ è una ‛funzione di transizione' da S×Σ×Π su S×Π* (∂ può non essere definita sull'intero dominio S×Σ×Π).

Il funzionamento dell'automa è simile a quello dell'a.f., a parte l'impiego della pila. Esso è posto inizialmente nello stato s′, con pila contenente p′, e si appresta a leggere per scansione una stringa d'ingresso α ∈ Σ*. A ogni ‛mossa' l'automa si trova in uno stato s ∈ S, legge un carattere c ∈ α e il carattere p in testa alla pila; se ∂(s, c, p) = (t, x), con t ∈ S e x ∈ Π*, esso si porta nello stato t e inserisce x nella pila (cancellandovi p); se invece ∂(s, c, p) non è definita, la computazione si arresta. La stringa α è ‛accettata' se e solo se, con la lettura del suo ultimo carattere, l'automa si porta in uno stato finale f ∈ F; in particolare α non è accettata se la computazione si arresta prima che la stringa sia letta completamente.

La funzione ∂ si assegna di solito elencandone i valori ∂(s, c, p) in una ‛tabella di transizione', in cui le righe corrispondono agli stati s e le colonne alle coppie di caratteri c, p (la rappresentazione in forma di grafo è in questo caso meno chiara della tabella).

Consideriamo per esempio l'automa a pila deterministico

D = ({s0, s1, s2, s3}, {a, b}, {0, 1}, s0, 0, {s3}, ∂),

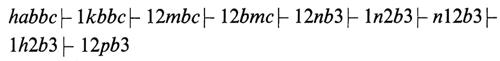

cui è associata la tabella di transizione della fig. 4. D accetta tutte e sole le stringhe del linguaggio L = {aibi, i ≥ 1}, che abbiamo riconosciuto come non regolare nel capitolo precedente. Per esempio la stringa d'ingresso aaabbb causa la seguente sequenza di transizioni tra stati, con associati contenuti della pila: s0, 0 → s1, 0 → s1, 10 → s1, 110 → s2, 10 → s2, 0 → s3, 0, che termina nello stato finale s3; la stringa è quindi accettata. La stringa aabbb causa le transizioni s0, 0 → s1, 0 → s1, 10 → s2, 0 → s3, 0, e la computazione si arresta sulla lettura dell'ultimo carattere b, perché il valore ∂(s3, b, 0) non è definito: la stringa non è quindi accettata.

Il lettore potrà dimostrare per proprio conto che l'automa D accetta tutte e sole le stringhe aibi, i ≥ 1.

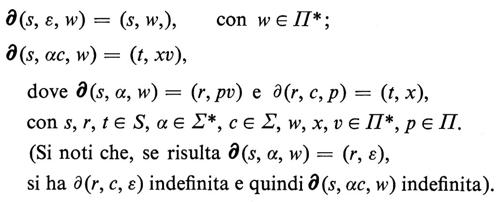

Come sempre è utile estendere il dominio di definizione della funzione ∂, per designare il comportamento dell'automa in risposta ad arbitrarie coppie di stringhe di ingresso e di pila. Si introduce a tale scopo la funzione ∂ da S×Σ*×Π* su S×Π*, definita ricorsivamente come

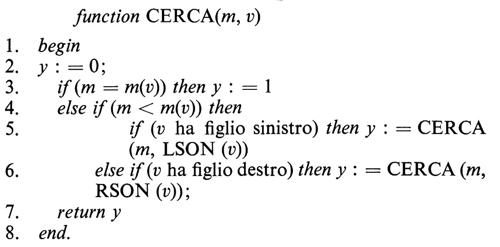

Il ‛linguaggio accettato' da un a.p.d. M = (S, Σ, Π, s′, p′, F, ∂) è allora l'insieme L(M) = {α ∣ ∂(s′, α, p′) = (f, w), f ∈ F}. Per l'automa D abbiamo L(D) = {aibi, i ≥ 1}.

A differenza di quanto avviene per gli automi finiti, il non determinismo aumenta ora la potenza computazionale del modello. M = (S, Σ, Π, s′, p′, F, ∂′) è un ‛automa a pila non deterministico' (o semplicemente ‛automa a pila', brevemente a.p., perché questo è il modello più generale) se, per uno stesso stato, uno stesso carattere d'ingresso e uno stesso carattere in testa alla pila, si definiscono più mosse per M. Il significato di S, Σ, Π, s′, p′, F rimane invariato, mentre la funzione di transizione ∂′ è definita da S×(Σ ⋃ {ε})×Π su sottinsiemi finiti di S×Π*, cioè:

Con la lettura di c, p l'automa apre r percorsi computazionali distinti e la stringa d'ingresso è ‛accettata' se e solo se almeno uno di questi percorsi termina in uno stato finale. Se c = ε, l'automa procede allo stesso modo senza leggere il carattere d'ingresso (e non avanza quindi sulla stringa d'ingresso).

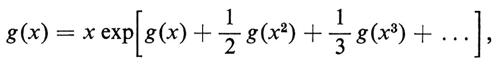

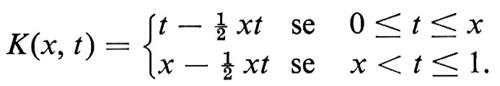

Poiché i caratteri in una pila si leggono in ordine inverso a quello in cui sono stati inseriti, un a.p. permette di riconoscere efficientemente se una stringa α è l'‛inversa' di un'altra, indicata con αι (cioè se α, letta da destra a sinistra, coincide con αι). L'automa a pila

E = ({r, s, t}, {a, b}, {0, 1, 2}, r, 0, {t}, ∂′},

cui è associata la tabella di transizione della fig. 5, accetta tutte e sole le stringhe ααι, con α ∈ {a, b}*. Nello stato r l'automa legge la stringa α e la ‛copia' nella pila, codificando i caratteri a, b rispettivamente con 1, 2; si porta poi nello stato s e prosegue la lettura, confrontando la stringa αι con quella contenuta nella pila, che viene cancellata carattere per carattere; se riemerge nella pila il carattere iniziale 0 quando la stringa d'ingresso è stata esaurita, l'automa accetta la stringa portandosi nello stato finale t per ingresso ε.

Il non determinismo interviene quando E si trova nello stato r e la stringa d'ingresso contiene due a, o due b, consecutive: in questo caso infatti l'automa non è ancora in grado di decidere se il secondo carattere appartiene anch'esso ad α o segna l'inizio di αι e considera entrambi i casi non deterministicamente. Ciò si riflette nei valori multipli: ∂′(r, a, 1) = {(r, 11), (s, ε)} e ∂′(r, b, 2) = {(r, 22), (s, ε)}.

Anche le transizioni per carattere ε possono causare comportamento non deterministico in relazione ad altre possibili transizioni, perché l'automa può procedere o non procedere nella lettura della stringa d'ingresso. Nell'automa E ciò avviene per esempio per i valori ∂′(r, ε, 0) = (t, ε), ∂′(r, a, 0) = (r, 10). Il lettore potrà verificare il funzionamento di E, provandolo su varie stringhe d'ingresso.

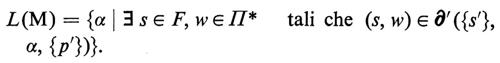

La risposta di un a.p. ad arbitrarie coppie di stringhe di ingresso e di pila può essere descritta con una funzione di transizione estesa ∂′, definita da 2S×Σ*×(sottoinsiemi finiti di Π*) su (sottoinsiemi finiti di S×Π*), che indica l'insieme di stati, con relative stringhe nella pila, che l'automa può assumere. La definizione di ∂′ in funzione di ∂′ è ovvia ma piuttosto complicata, e non è riportata qui. Il ‛linguaggio accettato' da un a.p. M = (S, Σ, Π, s′, p′, F, ∂′) è allora l'insieme

Un linguaggio L si dice ‛libero' se esiste un automa a pila M tale che L = L(M). Tra questi linguaggi si trovano i principali ‛linguaggi di programmazione', per cui la teoria degli automi a pila riveste importanza fondamentale nella traduzione e interpretazione di programmi. Per l'automa E abbiamo L(E) = {ααι, con α ∈ {a, b}*}, dunque questo linguaggio è libero. La nostra precedente affermazione che il modello deterministico sia in questo caso meno potente si esprime con il fatto che i linguaggi accettati da automi a pila deterministici costituiscono un sottoinsieme proprio dei linguaggi liberi: si può per esempio dimostrare che non esiste un a.p.d. che accetta il linguaggio L(E).

I linguaggi regolari a loro volta costituiscono un sottoinsieme dei linguaggi accettati da a.p.d., come si deduce immediatamente notando che ogni a.f. è un caso particolare di a.p.d. che ‛non impiega' la pila (ovvero ∂(s, c, p′) = (t, p′) ovunque ∂ è definita). Inoltre tale sottoinsieme è proprio per quanto abbiamo provato sul linguaggio {aibi, i ≥ 1}.

Riportiamo ora alcune delle numerosissime proprietà di cui godono i linguaggi liberi. Il primo lemma è un'estensione di quello già discusso per i linguaggi regolari, ma la sua prova è ora complessa, né esso può essere giustificato facilmente in modo intuitivo.

Lemma. Per ogni linguaggio libero L esiste una costante n > 0 tale che qualsiasi stringa α ∈ L, con ∣ α ∣ ≥ n, può essere espressa come α = βγδζη, con ∣ γδζ ∣ ≤ n, ∣ γζ ∣ ≥ 1, in modo che la nuova stringa α′ = βγiδζiη ∈ L per ogni i ≥ 0.

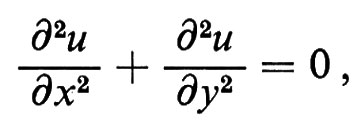

Come nei linguaggi regolari, il lemma ha due importanti conseguenze. La prima è la possibilità di riconoscere che un linguaggio L non è libero se si individua una stringa α ∈ L che, comunque suddivisa in βγδζη, genera una stringa α′ ∉ L. Poniamo per esempio che il linguaggio L = {aibici, i ≥ 1} sia libero e che n sia la costante del lemma. La stringa α = anbncn ∈ L potrebbe allora essere scritta secondo il lemma come α = βγδζη e in essa la sottostringa γδζ avrebbe lunghezza ≤ n, quindi non potrebbe contenere contemporaiìeamente a e c. La nuova stringa α′ = βγi=0δζi=0η = βδη non avrebbe allora lo stesso numero di a, b e c e non apparterrebbe a L in contrasto con il lemma. Concludiamo che {aibici, i ≥ 1} non è un linguaggio libero.

La seconda conseguenza del lemma è la possibilità di decidere se un arbitrario linguaggio libero L è vuoto, finito o infinito, con test di lunghezza finita condotti sull'a.p. che accetta L: il metodo consiste in una immediata estensione di quello già indicato per i linguaggi regolari.

Le proprietà di chiusura sono meno ricche per i linguaggi liberi che per quelli regolari. In particolare abbiamo il seguente teorema.

Teorema. 1) La famiglia dei linguaggi liberi è chiusa sotto l'operazione di unione; inoltre, dati due a.p. A1, A2, esiste una (semplice) procedura per costruire un a.p. A3 tale che L(A3) = L(A1) ⋃ L(A2); 2) la famiglia dei linguaggi liberi non è chiusa sotto le operazioni di intersezione e complementazione; inoltre, dati due a.p. A1, A2, non esistono procedure per decidere se L(A1) ⋂ L(A2) e ¬L(A1) sono linguaggi liberi (cioè se esiste un a.p. che li accetta).

Il punto 2) del teorema afferma la non esistenza di una procedura di decisione per due quesiti posti sui linguaggi liberi, ovvero l'‛indecidibilità' di tali quesiti. Abbiamo riconosciuto nel cap. 1 che devono necessariamente esistere problemi indecidibili, ma tutte le prove di indecidibilità, inclusa quella del teorema, richiedono strumenti che saranno sviluppati nel prossimo capitolo. Similmente si può dimostrare che vale un altro drastico risultato negativo per i linguaggi liberi, espresso dal teorema seguente.

Teorema. Non esiste procedura per decidere se due arbitrari automi a pila A1, A2 sono equivalenti (cioè se L(A1) = L(A2)).

5. La macchina di Turing.

L'automa più potente dal punto di vista computazionale fu introdotto da A. Turing nel 1936. Si tratta di una macchina astratta di dimensioni finite, dotata di un organo (‛testa') che scandisce le ‛celle' consecutive di un ‛nastro' esterno di lunghezza illimitata, su cui esegue operazioni di lettura e scrittura. Tale scrittura consente la memorizzazione sul nastro di un numero illimitato di eventi, ma, a differenza dell'automa a pila, la macchina può percorrere il nastro in entrambe le direzioni e recuperare l'informazione registrata in qualsiasi posizione.

Formalmente la ‛macchina di Turing' (brevemente m.t.) si definisce come un gruppo di sette entità (S, Σ, Π, s′, b, F, ∂), ove:

S è un insieme finito di ‛stati';

Σ è l'alfabeto d'ingresso;

Π è l'alfabeto del nastro, con Σ ⊂ Π;

s′ è lo ‛stato iniziale';

b è un carattere speciale del nastro, detto ‛bianco': b ∈ Π − Σ;

F ⊆ S è l'insieme degli ‛stati finali';

∂ è la ‛funzione di transizione', da S×Π su S×Π×{Á, →} (∂ può non essere definita sull'intero dominio S×Π: in particolare non è definita su F×Π).

Ammettiamo che il nastro abbia un'origine ove si trova la sua prima cella e che sia illimitato verso destra: inizialmente esso contiene una stringa d'ingresso α ∈ Σ* registrata a partire dalla prima cella, seguita da una stringa di b illimitata a destra. La macchina inizia a operare nello stato s′, con la testa posta sulla prima cella del nastro; in ogni istante essa si trova in uno stato s ∈ S, legge un carattere c ∈ Π dal nastro ed esegue una delle azioni seguenti:

se ∂(s, c) = (t, d, m), con t ∈ S, d ∈ Π, m ∈ {Á, →}, la macchina si porta nello stato t, cancella c dal nastro e scrive al suo posto d, sposta la testa sul nastro di una posizione, a sinistra, se m = Á, a destra, se m = →;

se invece ∂(s, c) non è definita (come avviene per esempio nel caso che s sia uno stato finale, s ∈ F), o se la testa si sposta a sinistra dell'origine del nastro, la macchina si arresta.

Il meccanismo di cancellazione e riscrittura dei caratteri sul nastro fa sì che la stringa iniziale αbbb... si trasformi via via in un'altra, composta in genere con i caratteri di un alfabeto Π più ampio. La stringa α è ‛accettata' se la macchina si porta in uno stato f ∈ F (ove si arresta), in un numero finito di mosse. Si noti che a questo punto il nastro può contenere una stringa qualsiasi, completata a destra da infiniti b, e la testa può trovarsi in una posizione qualsiasi del nastro. Se la macchina si arresta in uno stato di S − F, o non si arresta mai, la stringa non è accettata.

La situazione della computazione di una m.t., in un dato istante, può essere completamente descritta indicando lo stato raggiunto dalla macchina, il contenuto del nastro e la posizione della testa. Si definisce a tale scopo la ‛descrizione istantanea' (d.i.) della macchina come la stringa xsy, con x, y ∈ Π* e s ∈ S, tale che:

s è lo stato della m.t.;

xy è la stringa contenuta nel nastro fino al carattere più a destra diverso da b, o, se più a destra di esso, fino al carattere a sinistra della testa (ciò avviene se la testa, spostandosi a destra, è entrata nella stringa illimitata di b);

la testa è posta sul primo carattere di y: se y = ε la testa si trova su un carattere della stringa illimitata di b. La posizione della testa è quindi indicata nella d.i. dalla posizione del simbolo dello stato s.

Una mossa della m.t. consiste nel passaggio tra due d.i., D1, D2, e si indica col simbolo: D1 ⊢ D2. La computazione, per la stringa d'ingresso α, è una successione di mosse che partono dalla d.i. iniziale s′α.

Consideriamo per esempio la macchina:

G = ({h, k, m, n, p, q}, {a, b, c}, {a, b, c, 1, 2, 3, b}, h, b, {q}, ∂),

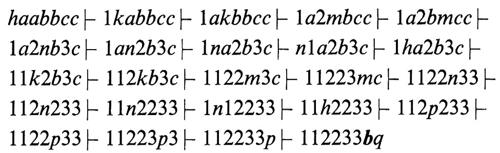

la cui funzione ∂ è specificata nella ‛tabella di transizione' della fig. 6 (il valore ∂(s, j) si trova all'incrocio tra la riga s e la colonna j). G accetta tutte e sole le stringhe del linguaggio L = {aibici, i ≥ 0), che abbiamo riconosciuto come non libero nel capitolo precedente. Per esempio, in risposta alla stringa d'ingresso aabbcc ∈ L, la macchina esegue la computazione

che si arresta nello stato finale q (∂(q, b) non è definita) accettando la stringa. In risposta alla stringa abbc ∉ L la computazione è invece

e a questo punto la macchina si arresta nello stato non finale p (infatti ∂(p, b) non è definita): la stringa non è quindi accettata. Il lettore potrà approfondire il funzionamento di G su altre stringhe.

Il passaggio tra due descrizioni istantanee D1, D2 mediante un numero arbitrario ≥ 0 di mosse consecutive si indica col simbolo: D1 ⊢* D2 (la relazione ⊢* è cioè la chiusura riflessiva e transitiva di ⊢). Si definisce così il ‛linguaggio accettato' da una m.t. M = (S, Σ, Π, s′ b, F, ∂) come l'insieme L(M) = {α ∣ α ∈ Σ*, s′α ⊢* xsy con s ∈ F e x, y ∈ Π*}. I linguaggi (o insiemi) accettati dalle m.t. si dicono ‛ricorsivamente enumerabili' (brevemente r.e.). Per la m.t. G abbiamo L(G) = {aibici, i ≥ 0}, quindi questo linguaggio è r.e..

Mettiamo in evidenza ancora una volta che una m.t. M si arresta per tutte le stringhe di L(M), mentre può arrestarsi o non arrestarsi per le stringhe non in L(M). Non esiste però in genere alcun limite superiore al tempo necessario a M per accettare una stringa e perciò non esiste criterio generale per stabilire se una computazione in corso su una stringa d'ingresso α terminerà o no. Vi sono ovviamente m.t. che si arrestano su ogni stringa accettata o non accettata, come per esempio la G della fig. 6, ma, come vedremo nel prossimo capitolo, non tutti i linguaggi r.e. sono accettati da macchine di questo tipo: vi sono quindi linguaggi r.e. per cui non è possibile stabilire, entro un tempo fissato a priori, l'appartenenza di una stringa arbitraria al linguaggio.

Questa grave e inevitabile limitazione giustifica l'introduzione di un nuovo concetto: un linguaggio (o insieme) si dice ‛ricorsivo' se esiste una m.t. M che si arresta sempre in tempo finito, tale che L = L(M). Per esempio il linguaggio {aibici, i ≥ 0} è ricorsivo, perchè è accettato dalla macchina G. Da quanto affermato dobbiamo concludere che i linguaggi ricorsivi sono un sottoinsieme proprio dei linguaggi r.e.

La costruzione di una m.t. per il riconoscimento di un linguaggio dato L è sempre piuttosto complessa, anche se L è molto semplice. Sono allora stati studiati diversi ampliamenti del modello che risultano più comodi da impiegare, ma che non aumentano la potenza computazionale del modello originale, ovvero la famiglia dei linguaggi accettati. In particolare abbiamo i seguenti teoremi.

Teorema. Sia L il linguaggio accettato da una macchina di Turing X: 1) con nastro illimitato verso destra e verso sinistra; oppure 2) con k teste che agiscono contemporaneamente e indipendentemente sul nastro; oppure 3) con k teste che agiscono contemporaneamente e indipendentemente su k nastri indipendenti. Allora esiste una m.t. Y che accetta L.

Teorema. Sia X un qualsiasi calcolatore elettronico esistente, corredato di memoria infinita e di un programma per l'accettazione di stringhe (che abbia cioè uscita 0 o 1) e sia L l'insieme di stringhe accettate da X. Allora esiste una m.t. Y che accetta L.

La prova dei precedenti teoremi consiste nel mostrare come sia possibile costruire una m.t. Y che simula il funzionamento di X.

Anche per la macchina di Turing è significativo definire un modello non deterministico. Formalmente M = (S, Σ, Π, s′, b, F, ∂′) è una ‛macchina di Turing non deterministica' (brevemente m.t.n.d.) se, per lo stesso stato e lo stesso carattere letto sul nastro, si definiscono più mosse per la macchina. Il significato di S, Σ, Π, s′, b, F resta invariato, mentre la funzione di transizione ∂′ è ora definita da S×Π su 2SΠ×{Á,→}. Una stringa è ‛accettata in t mosse' se almeno una delle computazioni cui tale stringa dà luogo raggiunge uno stato finale e la più breve computazione che raggiunge uno stato finale consiste di t mosse. Nonostante l'apparente potenziamento del modello, la famiglia dei linguaggi accettati dalle m.t.n.d. resta quella dei linguaggi r.e. Abbiamo infatti il seguente teorema.

Teorema. Se L è il linguaggio accettato da un'arbitraria m.t.n.d. X, esiste una m.t. Y che accetta L.

È interessante accennare alla prova di questo teorema. Stabilito, per ogni coppia (s, c), un ordinamento per tutti i valori della funzione ∂′(s, c) di X e indicato con k ≤ ∣ S×Π×{Á, →} ∣ il numero massimo di tali valori al variare della coppia (s, c), ciascuna delle computazioni di X per una stringa d'ingresso α potrà essere descritta con una sequenza di cifre comprese tra 1 e k, che indicano la scelta del valore ∂′ effettuata da X a ogni passo. La macchina Y genera ordinatamente una a una tutte le sequenze di cifre tra 1 e k, a partire dalle più corte. Nel nastro Y contiene α, seguita dalla sequenza di cifre β correntemente generata, seguita da una seconda copia di α su cui esegue la computazione. Questa avviene simulando la sequenza di mosse di X indicate passo per passo da β (se una cifra di β eccede il numero di mosse definite per X, Y si arresta). Se e solo se α ∈ L(X), Y si arresta accettando α.

Per quanto riguarda il numero di mosse eseguito dalle due macchine, possiamo osservare che una stringa α ∈ L accettata da X in t mosse è accettata da Y in t′ > kt-1 mosse, con k costante.

Notiamo infatti che Y si arresta in corrispondenza della sequenza β′ che rappresenta la più breve computazione accettante di X e si ha t = ∣ β′ ∣. Poiché tutte le sequenze di lunghezza 〈 t vengono generate da Y prima della β′, e tra esse quelle di lunghezza t − 1 sono kt-1 possiamo concludere che Y deve eseguire almeno kt-1 simulazioni del funzionamento di X su α e che quindi il numero delle sue mosse t′ è (molto) maggiore di kt-1.

Ammettendo che una mossa sia eseguita da una m.t. in tempo costante, i valori t e t′ rappresentano i ‛tempi di funzionamento' di X e Y per le stringhe accettate. Non ha invece particolare senso studiare il tempo di funzionamento di X, e quindi di Y, per una stringa α non accettata, poiché alcune computazioni potrebbero non terminare e non si può affermare che α non sarà accettata finché non si sono concluse tutte le computazioni.

Poiché il non determinismo non amplia la classe dei linguaggi accettati dalle macchine di Turing, gli studi di computabilità si conducono sulle m.t. (deterministiche). Il prezzo pagato è nel tempo di funzionamento, che cresce esponenzialmente se una m.t.n.d. X si simula con una m.t. Y nel modo sopra indicato. È importante però mettere in evidenza che la discussione precedente non esclude l'esistenza di una m.t. Y′ che accetti L in tempo inferiore a quello richiesto da Y, e in particolare in tempo polinomiale in t: quest'ultimo quesito è ancora irrisolto e sarà ripreso nella discussione generale sulla complessità di calcolo.

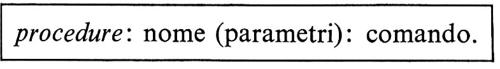

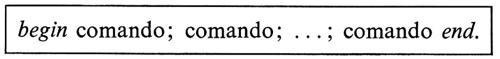

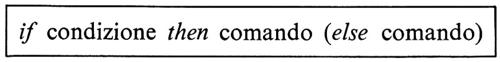

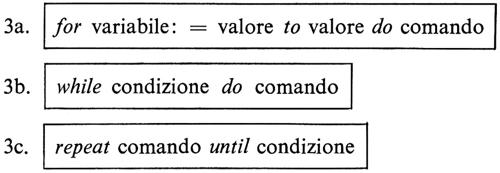

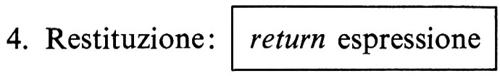

Nell'ambito dell'utilizzazione pratica dei calcolatori, le m.t.n.d. sono rappresentate da programmi ‛non deterministici' (n.d.), che prevedono l'esecuzione contemporanea di diverse frasi tutte egualmente accettabili. Ciò si ottiene in genere utilizzando il costrutto linguistico choicend A, che provoca la scelta non deterministica degli elementi di un insieme A, uno a uno. La computazione si divide quindi in ∣ A ∣ rami ogni volta che si incontra tale meccanismo, con lo stesso significato che la molteplicità di computazioni ha nella m.t.n.d.. Per essere praticamente eseguito su un singolo calcolatore, un programma n.d. X deve essere simulato da un programma deterministico Y, che realizza ogni costrutto choicend A scegliendo uno a uno in sequenza gli elementi di A. Il rapporto tra i tempi di esecuzione di X e Y è lo stesso indicato per le m.t.

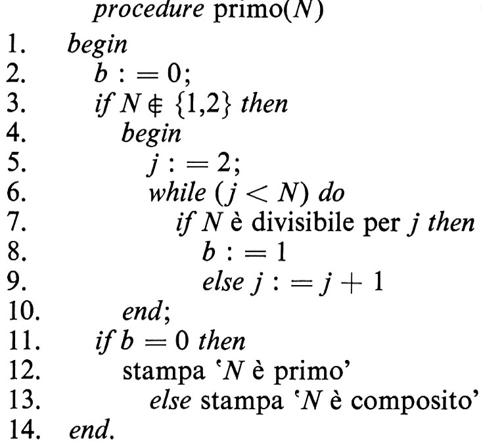

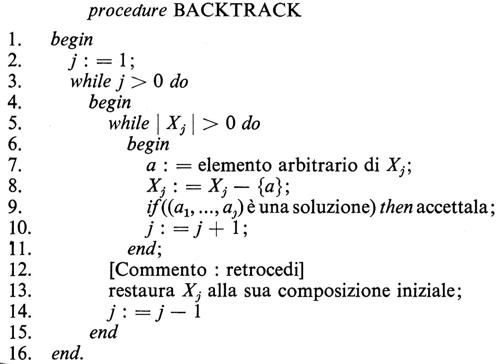

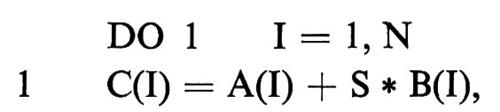

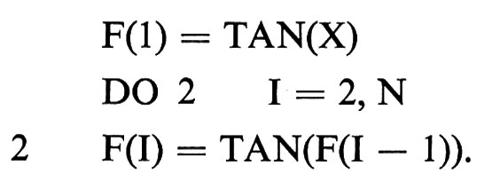

I programmi non deterministici si prestano ad affrontare problemi risolubili in modo enumerativo, attraverso successioni di scelte. Un esempio importante è il seguente.

Problema della soddisfattibilità di espressioni logiche (Psod). Data un'arbitraria espressione E costruita sulle variabili logiche x1, ..., xn con gli operatori ⋀, ⋀, ¬, stabilire se esiste un insieme di valori x1′, ..., xn′ che ‛soddisfi' la E, tale cioè che E(x1′, ..., xn′) = 1.

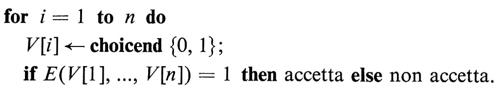

Un metodo per risolvere Psod è quello di generare tutte le possibili n-ple di valori binari per x1, ..., xn e di valutare E per ciascuna di esse. Ciò è realizzato nel seguente programma n.d. di ovvio significato, in cui le n-ple vengono costruite nel vettore V attraverso l'assegnazione non deterministica dei valori 0, 1 a ogni suo elemento V[i]:

La E è soddisfatta se e solo se almeno una delle computazioni termina su ‛accetta'. Il tempo di funzionamento del programma nel caso di accettazione è, in ordine di grandezza, t ∈ O (n +tE), ove n è il numero di operazioni per generare una n-pla e tE è il tempo per calcolare il valore di E su tale n-pla.

Il programma n.d. può essere simulato in modo ovvio con uno deterministico, che costruisce sequenzialmente in V tutte le n-ple binarie, in un ordine preassegnato, e calcola il valore di E per ciascuna di esse. Poiché nel caso peggiore l'accettazione si stabilisce dopo aver esaminato 2n n-ple, il tempo richiesto è t′ ∈ O(2n • tE) e cresce quindi esponenzialmente rispetto al tempo richiesto dal programma n.d.

6. Decidibilità e indecidibilità.

Abbiamo già incontrato varie volte problemi di decisione e abbiamo affermato l'esistenza o la non esistenza di procedure per risolverli. Discuteremo ora l'argomento in modo formale, impiegando la macchina di Turing come modello primitivo di calcolo.

Un problema ben posto deve avere una descrizione univoca, essere definito per uno o più ‛dati' e richiedere per essi un ‛risultato'. Da un punto di vista computazionale il problema è significativo se i dati possono assumere infiniti valori, ciascuno dei quali rappresenta un'‛istanza' del problema, e il risultato può assumere più di un valore. Non è infatti significativo un problema con un numero finito di istanze, poiché la computazione potrebbe ridursi alla consultazione di una tabella finita che listi i valori del risultato in funzione dei valori dei dati; né è significativo il caso in cui il risultato assuma un solo valore, perché, una volta noto per un'istanza, non sarebbe più necessario calcolarlo per le altre. Invece, come abbiamo già affermato, ha senso limitare lo studio a problemi che abbiano risultato binario (decisionali): in genere essi non chiedono di determinare una soluzione, ma solo di verificame una proprietà (per esempio l'esistenza) sufficientemente generale per mettere in luce la difficoltà intrinseca del problema.

Un esempio di problema decisionale con infinite istanze è Psod, introdotto nel capitolo precedente. L'istanza generica è un'espressione E, il risultato è l'esistenza o meno di un insieme di valori delle variabili che soddisfi la E. Si noti che il procedimento indicato per risolvere Psod scopre l'esistenza di una soluzione attraverso la sua generazione e potrebbe quindi essere applicato anche per determinare tale soluzione.

Codificate le istanze di un problema decisionale P come stringhe su un alfabeto, il linguaggio L relativo a P è definito come l'insieme delle istanze che prevedono risultato affermativo. Un procedimento di risoluzione di P può essere formalizzato come m.t. M, tale che L = L(M). Possiamo quindi trasformare il quesito sull'esistenza di una procedura effettiva di calcolo per P in uno equivalente sulla natura di L.

Se L è ricorsivo, esiste una procedura che genera sempre in tempo finito una risposta affermativa o negativa. In tal caso il problema P è ‛decidibile' e una m.t. che lo risolva è detta ‛algoritmo' per P. Se L non è ricorsivo il problema è ‛indecidibile' e non ammette algoritmo di risoluzione; tra tali problemi è comunque opportuno distinguere quelli che corrispondono a linguaggi r.e. da quelli che corrispondono a linguaggi non r.e., poichè per i primi esiste una m.t. che può non fornire tutte le risposte in tempo finito, per i secondi non esiste del tutto la m.t. Se le stringhe d'ingresso a una m.t. si interpretano come codifica di numeri naturali, la risoluzione di P corrisponde al calcolo di una funzione dai naturali su {0, 1}: problemi decidibili o indecidibili corrispondono allora a funzioni ‛calcolabili' o ‛non calcolabili'.

È a questo punto opportuno ricordare che le m.t. sono definite come gruppi di entità finite (S, Σ, Π, s′, b, F, ∂) e possono quindi essere descritte come stringhe di un opportuno alfabeto (in particolare si dimostra che è sufficiente l'alfabeto {0, 1} per descrivere tutte le m.t.). Tali stringhe possono poi essere ordinate alfabeticamente, dando luogo a un'enumerazione delle m.t., nella quale la macchina Mi corrisponde all'i-esima stringa dell'ordinamento. Similmente si possono enumerare le stringhe d'ingresso α per le m.t., indicando con αi la stringa i-esima.

Indicheremo con M〈M> la stringa che descrive la m.t. M, con 〈M, α> la stringa che descrive M assieme alla sua stringa d'ingresso α. Sarà allora legittimo impiegare 〈M, α> come stringa d'ingresso per una diversa m.t. N, per rispondere a questioni circa il comportamento di M su α. N potrà simulare il funzionamento di M, svolgendo quindi la funzione di un calcolatore che esegue un arbitrario programma M sui dati α (si ricordi che una m.t. svolge in genere la funzione di un singolo programma).

L'argomento di conteggio sulla numerabilità delle procedure e la non numerabilità delle funzioni, introdotto nel cap. 1, può ora essere formalmente ripreso in relazione alla numerazione delle m.t. Tale argomento dimostra che devono esistere funzioni non calcolabili perché per esse non vi è m.t., ovvero devono esistere problemi indecidibili cui corrispondono linguaggi non r.e. Incontriamo ora il primo di questi linguaggi, detto ‛linguaggio diagonale' (Ld), composto da tutte le stringhe αi che non sono accettate dalla m.t. Mi di pari indice.

Teorema. Il linguaggio Ld = {αi ∣ αi ∉ L(Mi), i = 0, 1, ...} non è r.e.

Il teorema si dimostra immediatamente notando che, comunque si costruisca l'enumerazione delle m.t., Ld non può essere accettato da alcuna di esse. Se infatti esistesse una Mj tale che Ld = L(Mj), la definizione di Ld condurrebbe alla contraddizione che αj ∈ Ld se e solo se αj ∉ L(Mj).

La scoperta che Ld non è r.e. permette di dimostrare l'indecidibilità di altri problemi, determinando la natura dei nuovi linguaggi in funzione della natura di Ld. Il primo di essi è relativo alla possibilità di stabilire se una m.t. arbitraria M accetta una stringa arbitraria α.

Teorema (Turing). Il linguaggio Lu = {〈M, α> ∣ α ∈ L(M)} è r.e. e non è ricorsivo.

Lu è detto ‛linguaggio universale', poiché pone la più generale delle questioni sulle macchine di Turing; la sua natura dimostra che i linguaggi ricorsivi sono un sottoinsieme proprio dei linguaggi r.e. In termini concreti il teorema afferma che non esiste algoritmo per stabilire il risultato di una computazione arbitraria (si noti che l'algoritmo non potrebbe consistere nella simulazione di tale computazione, poiché nel caso α ∉ L(M) la simulazione potrebbe non terminare in tempo finito).

Una conseguenza del teorema è che anche il linguaggio La = {〈M, a> ∣ la computazione di M su α si arresta} è r.e. e non è ricorsivo. Questo famoso risultato decreta l'indecidibilità del ‛problema dell'arresto' (Pa), ovvero stabilisce che non esiste algoritmo per decidere se una computazione arbitraria si arresta o meno.

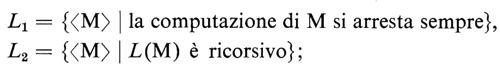

I problemi indecidibili fin qui considerati pongono questioni sulle m.t., non sui linguaggi r.e. che esse accettano. Le questioni del secondo tipo sono di solito assai più generali. Si considerino per esempio i due linguaggi:

benché essi possano apparire simili, si ha L1 ⊂ L2, poiché il fatto che L(M) sia ricorsivo implica che esiste una m.t. M′ che lo accetta e si arresta sempre, ma non implica che sia M′ = M.

In effetti per le questioni inerenti i linguaggi r.e. vale un risultato generale di indecidibilità, espresso nel seguente teorema.

Teorema (Rice). Qualsiasi proprietà dei linguaggi r.e. è indecidibile, a meno che non sia banalmente verificata da tutti i linguaggi r.e. o da nessuno di essi.

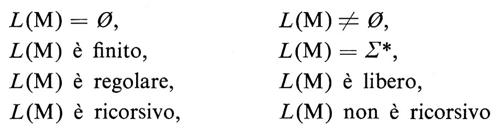

Questo teorema ha ovviamente moltissime conseguenze, alcune delle quali sono espresse nel seguente corollario.

Corollario. Per un'arbitraria m.t. M, le questioni

sono indecidibili.

Per concludere l'argomento della decidibilità, accenniamo come esempio a due conseguenze dirette che i risultati esposti hanno nell'ambito delle applicazioni. La prima deriva dall'indecidibilità del problema dell'arresto Pa. Sarebbe molto utile poter inserire un ‛filtro' all'ingresso di un calcolatore, per decidere, prima di iniziare l'esecuzione di un programma, se questo terminerà la sua computazione o, presumibilmente perché contiene un errore, entrerà in un ciclo infinito. L'indecidibilità di Pa dimostra che tale filtro non può esistere.

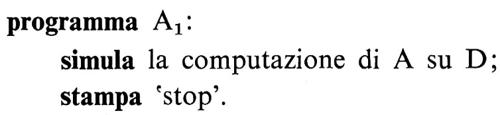

La seconda conseguenza riguarda la possibilità di stabilire se due programmi A1, A2 sono equivalenti, cioè se per uguali dati producono uguali risultati. È questo il ‛problema dell'equivalenza' (Pe) e avrebbe grande importanza poterlo risolvere, per verificare, per esempio, se programmi scritti per calcolatori diversi generano esattamente gli stessi risultati. Notiamo però che per ogni programma arbitrario A e per dati arbitrari D, possiamo formulare il seguente programma A1:

Chiaramente A1 stampa ‛stop' se e solo se la computazione di A su D si arresta. D'altra parte possiamo anche formulare il programma A2:

Poiché A2 stampa sempre ‛stop', A1 e A2 sono equivalenti se e solo se la computazione di A su D si arresta. Un algoritmo per risolvere Pe consentirebbe allora di risolvere Pa, ma, poiché quest'ultimo problema è indecidibile, dobbiamo concludere che anche Pe è indecidibile, ovvero non esiste un algoritmo per decidere se due programmi sono equivalenti.

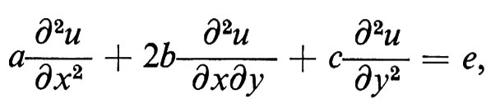

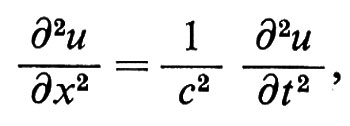

7. Complessità di calcolo.

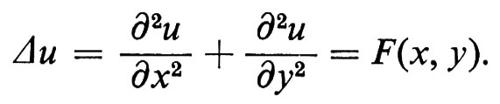

L'argomento di conteggio attraverso il quale avevamo previsto l'esistenza dei problemi indecidibili permette di dimostrare, con opportuna estensione, che tali problemi sono la grande maggioranza di tutti i problemi possibili. E quindi piuttosto sorprendente che per scoprirli sia stato necessario il genio dei logici moderni, e forse l'unico modo di spiegare questa apparente contraddizione è che l'uomo tende a porsi spontaneamente problemi decidibili. E dunque a questi ultimi che ora ci riferiremo, con lo scopo di valutare la quantità di risorse di calcolo che essi richiedono: in particolare lo ‛spazio' e il ‛tempo'.

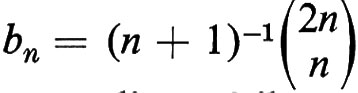

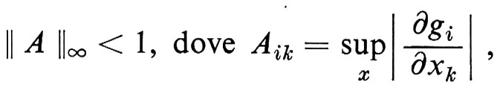

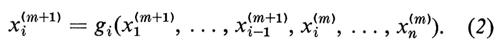

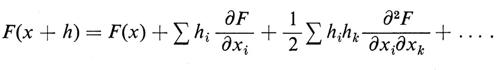

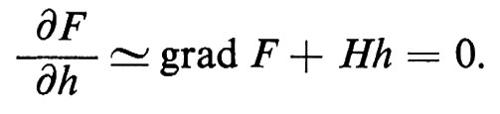

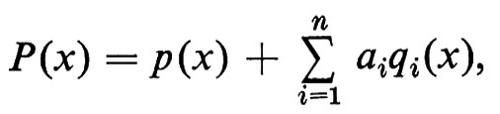

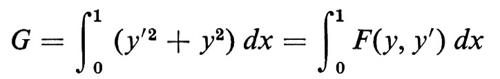

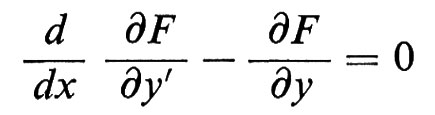

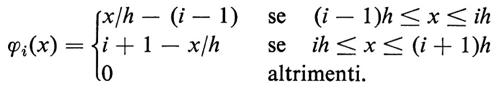

Ogni problema decidibile P è risolto da una m.t. (deterministica) M che si arresta per ogni istanza di P (M è un algoritmo per P). L'esistenza di M implica che P può essere risolto con infiniti algoritmi diversi, derivabili per esempio da M con banali aggiunte di mosse inutili; ma più interessante è considerare algoritmi che risolvano P con metodi sostanzialmente differenti e porli a confronto in base alla quantità di risorse richieste. Ciò conduce alle seguenti definizioni.

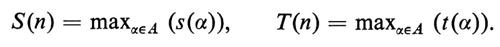

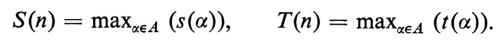

Nella computazione di M su un'arbitraria stringa d'ingresso α, sia s(α) il numero di celle diverse, oltre quelle contenenti α, visitate sul nastro dalla testa di M e sia t(α) il numero di mosse compiute da M. Considerato, per ogni numero naturale n, l'insieme A = {α ∣ ∣ α ∣ = n} di tutte le stringhe d'ingresso di lunghezza n, si dice che M ha ‛complessità in spazio' S(n) e ‛complessità in tempo' T(n), ponendo

Per ogni valore di n, la complessità di M in spazio e tempo si valuta dunque nel caso peggiore e costituisce un limite superiore alla complessità del problema P, poiché garantisce che P può essere risolto entro i valori S(n) e T(n). Si dice quindi che anche P ha complessità S(n) e T(n) in spazio e tempo, senza escludere l'esistenza di una diversa m.t. M′ che risolva P con complessità S′(n) 〈 S(n) e T′(n) 〈 T(n).

Definiamo ora le ‛classi di complessità' DSPAZIO(S(n)) e DTEMPO(T(n)) come le classi di tutti i problemi che hanno rispettivamente complessità in spazio S(n) e complessità in tempo T(n) (l'iniziale D nel nome delle classi indica che la m.t. risolvente è deterministica). Poiché per un'arbitraria m.t. di complessità in spazio o tempo f(n) è banalmente possibile costruirne un'altra che risolva lo stesso problema con complessità g(n) > f(n), abbiamo in genere DSPAZIO(f(n)) ⊆ DSPAZIO(g(n)) e DTEMPO (f(n)) ⊆ DTEMPO(g(n)). Il seguente teorema mostra che il contenimento è proprio e stabilisce una gerarchia tra le classi di complessità che contengono problemi sempre più complessi.

Teorema. Per ogni arbitraria funzione calcolabile f(n), esiste almeno un problema P tale che P ∉ DSPAZIO(f(n)) e P ∉ DTEMPO(f(n)).

Un importante legame tra le classi di spazio e tempo è espresso nel seguente teorema.

Teorema. Per un arbitrario problema P esiste una costante c tale che: 1) se P ∈ DTEMPO(f(n)), allora P ∈ DSPAZIO(cf(n)); 2) se P ∈ DSPAZIO(f(n)) e f(n) ≥ log2 n, allora P ∈ DTEMPO(cf(n)).

Il teorema mostra che la complessità in tempo è un parametro più critico della complessità in spazio, poiché può crescere esponenzialmente rispetto a quest'ultima. Approfondiremo quindi nel seguito lo studio della complessità in tempo T(n), che può essere anche detta semplicemente ‛complessità' quando tale dizione non sia ambigua, ricordando che esistono studi paralleli sulla complessità in spazio.

Si dice che una m.t. (o un algoritmo) M è ‛polinomiale' se esiste un polinomio p tale che, per ogni valore di n, sia T(n) ≤ p(n); il che equivale a dire che il problema P risolto da M appartiene a DTEMPO(p(n)). Ciò conduce alla definizione dell'importante classe P dei problemi per i quali esiste una m.t. polinomiale che li risolve:

Intuitivamente P è una classe di problemi che possono essere risolti efficientemente, poiché le m.t. deterministiche corrispondono agli usuali algoritmi programmabili e, come vedremo nel prossimo capitolo, la complessità polinomiale può essere ritenuta ragionevole anche per valori alti del grado del polinomio.

I concetti visti si estendono alla m.t. non deterministica M, e al problema P che essa risolve, con una puntualizzazione dovuta alla dissimmetria del funzionamento per le stringhe accettate e non accettate. Per una stringa d'ingresso α ∈ L(M), s(α) è il minimo numero di celle diverse visitate sul nastro, oltre quelle contenenti α, calcolato su tutte le computazioni di M e t(α) è il numero di mosse della computazione più breve. Se α ∉ L(M) si pone convenzionalmente s(α) = t(α) = 1. Considerato, per ogni n, l'insieme A = {α ∣ ∣ α ∣ = n}, le complessità in spazio e tempo di M e P si definiscono nuovamente come

Le nuove classi di complessità NDSPAZIO(S(n)) e NDTEMPO(T(n)) sono ora le classi di tutti i problemi che hanno rispettivamente complessità in spazio S(n) e complessità in tempo T(n) nel modello di calcolo non deterministico.

Limitando il nostro studio alla complessità in tempo, il risultato più generale sulla relazione tra le classi deterministiche e non deterministiche è espresso nel seguente teorema, che costituisce un sostanziale rafforzamento dell'osservazione sui tempi di funzionamento delle m.t. riportata nel cap. 5 (si noti che si pone ora un limite ‛superiore' alla complessità nel caso deterministico).

Teorema. Per un arbitrario problema P esiste una costante c tale che, se P ∈ NDTEMPO(f(n)), allora P ∈ DTEMPO(cf(n)).

Anche una m.t.n.d. (o un algoritmo n.d.) M è detta ‛polinomiale' se esiste un polinomio p tale che, per ogni valore di n, sia T(n) ≤ p(n) ovvero se il problema P risolto da M appartiene a NDTEMPO(p(n)). Ciò conduce alla definizione della classe NP dei problemi per i quali esiste una m.t.n.d. polinomiale che li risolve:

Poiché possiamo considerare una m.t. come m.t.n.d. che non presenta mai scelte multiple, segue immediatamente dalle definizioni di P e NP la relazione: P ⊆ NP. Non esiste però alcuna prova che tale inclusione sia propria, cioè che P ≠ NP, benché ciò sia normalmente ritenuto vero a causa della capacità delle m.t.n.d. polinomiali di eseguire un numero esponenziale di computazioni, e della nostra ignoranza su un modo di ottenere gli stessi risultati con una m.t. polinomiale. In effetti il risultato più generale noto può essere espresso come corollario del teorema precedente, e nulla di sostanziale aggiunge alla nostra conoscenza sulla possibilità di simulare programmi non deterministici con programmi deterministici.

Corollario. Se un problema P può essere risolto da una m.t.n.d. in tempo polinomiale p(n), allora P può essere risolto da una m.t. in tempo cp(n).

8. Problemi intrattabili.

La complessità gioca un ruolo fondamentale nello studio dell'efficienza degli algoritmi realizzati come programmi di un calcolatore. In questo caso la variabile indipendente n rappresenta lo spazio di memoria occupato dai dati d'ingresso, misurato come lunghezza della loro descrizione o qualunque numero proporzionale a essa; la funzione S(n) indica il massimo spazio di memoria occupato durante la computazione, misurato con lo stesso metro di n; la funzione T(n) indica il numero di operazioni elementari richiesto dalla computazione e risulta proporzionale al tempo di esecuzione del programma se si ammette che ogni operazione richieda lo stesso tempo costante.

Le funzioni S(n) e T(n) forniscono quindi valori proporzionali alle risorse di spazio e tempo richieste dal programma e si studiano in ordine di grandezza: questo permette di considerare tali funzioni come rappresentative dell'algoritmo prescelto, indipendentemente dal particolare calcolatore o linguaggio di programmazione impiegato. Come nel caso delle m.t., S(n) e T(n) costituiscono le ‛complessità in spazio' e ‛in tempo' del programma, o del problema che esso risolve; anche ora limiteremo lo studio alla funzione T(n), detta anche semplicemente ‛complessità'.

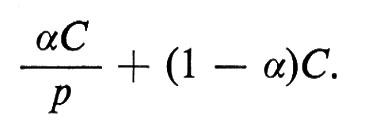

Per quanto esposto nel cap. 5 sui programmi non deterministici, la definizione della funzione T(n) può essere estesa a essi in modo ovvio. Le classi P e NP conservano il loro significato, poiché la loro definizione non è intaccata se la complessità si misura in ordine di grandezza, e restano valide le considerazioni fatte sulla loro relazione. In particolare, ricordando che i programmi non deterministici vengono simulati con programmi deterministici, dobbiamo limitare a P la classe dei problemi praticamente risolubili in tempo polinomiale.

I problemi per cui esistono, o sono noti, solo algoritmi di soluzione di complessità esponenziale sono detti ‛intrattabili', poiché il tempo richiesto per il calcolo cresce smisuratamente al crescere di n. Ovviamente anche un algoritmo polinomiale di grado molto elevato può richiedere un tempo inaccettabile al crescere di n, ma l'esistenza di un tale algoritmo autorizza a mantenere il problema tra quelli per cui vi è almeno speranza di soluzione futura, per il seguente non ovvio motivo.

Poniamo che un algoritmo di complessità polinomiale T(n) = nc e uno di complessità esponenziale T(n) = cn possano essere praticamente risolti fino a un (piccolo) valore di n su un calcolatore disponibile, e studiamo come cresce questo valore se si impiega un calcolatore più veloce. Detto m il nuovo valore trattabile in pari tempo di calcolo e osservando che impiegare un calcolatore k volte più veloce equivale a impiegare il calcolatore originale per un tempo k volte maggiore, abbiamo per l'algoritmo polinomiale: mc = knc, cioè m = k1/cn, che corrisponde a un incremento sensibile, benché percentualmente decrescente al crescere del grado c del polinomio. Per l'algoritmo esponenziale abbiamo invece cm = kcn, cioè m = logc k + n, che corrisponde a un incremento trascurabile. Concludiamo che gli algoritmi di complessità esponenziale non traggono alcun giovamento dai progressi tecnologici dei calcolatori e rimangono inevitabilmente inefficienti.

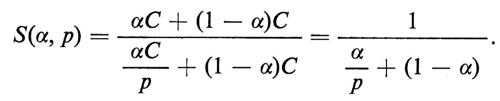

Benché sia possibile dimostrare che alcuni problemi sono sicuramente intrattabili, poiché richiedono tempo esponenziale anche in un modello di calcolo non deterministico, quasi tutti i problemi intrattabili interessanti appartengono a NP: non si conosce cioè alcun algoritmo polinomiale deterministico per risolverli, ma non vi è prova che tale algoritmo non esista. Il meccanismo di base per indagare sui problemi intrattabili è quello di ‛riduzione'. Presi due problemi P1, P2 e i relativi linguaggi L1, L2 ⊆ Σ* (insiemi delle istanze che prevedono risultato affermativo per P1 e P2), una ‛riduzione polinomiale' da P1 a P2 è una funzione f: Σ* → Σ* tale che: 1 ) esiste un algoritmo polinomiale deterministico F che calcola f (si noti che in questo caso F non è un semplice algoritmo decisionale); 2) per ogni v ∈ Σ* si ha v ∈ L1 se e solo se f(v) e L2. Si dice allora che P1 si riduce a P2 e ciò si indica con P1 ⇒ P2. Si noti che la riduzione polinomiale è transitiva, cioè P1 ⇒ P2 e P2 ⇒ P3 implica P1 ⇒ P3.

L'importanza della riduzione da P1 a P2 deriva dalla considerazione che un algoritmo A2 per risolvere P2 può essere usato per risolvere P1 attraverso le computazioni successive di F su v e di A2 su f(v). Poiché F è polinomiale, la computazione complessiva ha la complessità di A2, per cui P2 ∈ P implica P1 ∈ P, mentre P2 ∈ NP implica P1 ∈ NP, pur senza escludere che esista un algoritmo polinomiale deterministico per P1: questa situazione si descrive dicendo che ‛P2 è difficile almeno quanto P1'. Se P1 ⇒ P2 e P2 ⇒ P1 due problemi si dicono ‛polinomialmente equivalenti' e sono ‛ugualmente difficili'.

Dalla discussione precedente discende che se tutti i problemi della classe NP si riducessero a uno di essi, questo sarebbe il più difficile problema di tale classe e sarebbe quindi il primo candidato a trovarsi in NP − P nel caso che fosse P ≠ NP. La ricerca di tale problema ha quindi importanza fondamentale nello studio della relazione tra le due classi.

Formalmente un problema P si dice ‛NP-completo' se P ∈ NP e per ogni altro problema P′ ∈ NP si ha P′ ⇒ P. I problemi NP-completi sono dunque i più difficili problemi in NP e sono tutti polinomialmente equivalenti. Come vedremo, se ne conoscono moltissimi, e il primo individuato tra questi è il problema della soddisfattibilità Psod, già citato nel cap. 5. Si ha infatti il seguente teorema.

Teorema (Cook). Psod è NP-completo.

La dimostrazione del teorema di Cook è piuttosto complessa. In sostanza, dopo aver provato che Psod appartiene a NP, essa mostra come, per qualsiasi m.t.n.d. polinomiale M e per qualsiasi stringa d'ingresso α, Si possa costruire in tempo polinomiale un'espressione logica E che è soddisfatta se e solo se M accetta α. (Ricordiamo che il problema generale di stabilire se una m.t. accetta una stringa, espresso nel linguaggio Lu del cap. 6, è indecidibile. La M scelta sopra è però polinomiale e quindi non arbitraria: in particolare si arresta per ogni stringa d'ingresso).

La scoperta del primo problema NP-completo Psod è di estrema importanza, poiché permette di dimostrare che altri problemi P ∈ NP sono NP-completi provando semplicemente che Psod ⇒ P. In genere la classe dei problemi NP-completi si arricchisce di nuovi membri mostrando che un problema qualsiasi della classe si riduce a essi.

Poiché i problemi NP-completi sono polinomialmente equivalenti, l'esistenza di un algoritmo polinomiale deterministico per risolvere uno di essi implicherebbe che tutti i problemi NP-completi, e quindi tutti i problemi in NP, potrebbero essere risolti in pari tempo. Si avrebbe allora P = NP. Il fatto che tanti studi sull'argomento abbiano prodotto solo algoritmi esponenziali conforta la congettura che sia P ≠ NP, ma non sembra vicina la prova che tale affermazione sia vera o falsa, decidibile o indecidibile.

Un'altra osservazione importante su queste classi deriva dallo studio del ‛problema complementare' Pc per ogni problema P, definito in modo che abbiano risposta affermativa in Pc tutte e sole le istanze che hanno risposta negativa in P (dal punto di vista dei relativi linguaggi, poniamo Lc = {Σ* − L}). Per esempio Pcsod ha per definizione risposta affermativa per tutte e sole le espressioni logiche non soddisfattibili. Dall'ipotesi che P sia decidibile discende che anche Pc è decidibile, poiché può essere risolto da una m.t. Mc che accetta l'ingresso se e solo se questo non è accettato dalla m.t. M che risolve P.

Consideriamo ora le classi dei problemi complementari di P e NP:

co-P = {Pc ∣ P ∈ P}, co-NP = {Pc ∣ P ∈ NP}.

Se la M scelta per risolvere P è deterministica, una Mc per Pc si costruisce semplicemente in forma anch'essa deterministica, invertendo in M le condizioni di accettazione e non accettazione. Ne risulta che M e Mc hanno la stessa complessità e quindi P = co-P. Se invece M è stata scelta in forma non deterministica, la suddetta costruzione per Mc non è più valida, poiché Mc deve accettare l'ingresso se e solo se tutte le computazioni di M terminano con non accettazione. Nulla cioè risulta per questa via sulla relazione tra NP e co-NP, ma è lecita la congettura che sia NP ≠ co-NP, poiché essa è più forte della P ≠ NP: infatti, poiché P = co-P, la NP ≠ co-NP implica P ≠ NP.

In effetti per molti problemi in co-NP non è noto il contenimento in NP, e in particolare ciò non è noto per tutti i problemi NP-completi. Vale infatti il seguente risultato.

Teorema. Se esiste un problema NP-completo P e Pc ∈ NP, allora NP = co-NP.

La classe dei problemi NP-completi contiene un grandissimo numero di problemi nati in campi diversi. Rimandiamo alla bibliografia per una elencazione anche approssimativa, citandone qui, oltre Psod, tre di particolare importanza.

Problema del commesso viaggiatore (Pcv) Dato un grafo G di n vertici, ai cui spigoli sono associati pesi interi positivi, e un intero positivo k, stabilire se esiste in G un ciclo hamiltoniano la cui somma dei pesi sia ≤ k.

Problema dell'impaccamento (Pi). Dati un insieme A di n interi positivi e due interi positivi h, k, stabilire se esiste una partizione di A in k sottoinsiemi, tale che la somma degli elementi in ogni sottoinsieme sia ≤ h.

Problema delle equazioni diofantee quadratiche (Pedq). Dati tre interi positivi, a, b, c, di n cifre, stabilire se l'equazione ax2 + by + c = 0 ha radici intere.

Pcv, Pi e Pedq sono rispettivamente i capostipiti, in forma decisionale, dei problemi di percorsi su grafi, dei problemi di allocazione in una o più dimensioni e dei problemi sulla risoluzione intera di equazioni. Se si passa dalla forma decisionale a una più generale forma risolvente, chiedendo che si generi una soluzione per tali problemi, essi diventano ‛difficili almeno quanto' i corrispondenti problemi decisionali e restano pertanto intrattabili.

A causa dell'importanza pratica di numerosissimi problemi intrattabili, sono state esplorate nuove vie di soluzione. Si è così sviluppata la teoria degli ‛algoritmi approssimati', in cui le soluzioni si ottengono in tempo polinomiale con preassegnata approssimazione, e quella degli ‛algoritmi probabilistici', in cui le soluzioni generate sono corrette con preassegnata probabilità. Questi argomenti potranno essere studiati nella letteratura specializzata.

9. I principali studi sull'argomento.

Per un primo approfondimento della teoria della computazione è utile riferirsi ad alcuni libri di testo, che forniscano un sicuro ancorché essenziale riferimento. Testi classici di computabilità sono quelli di Davis (v., 1958) e di Rogers (v., 1967), mentre la complessità di calcolo ha trovato una trattazione organica in tempi molto recenti con un testo di Aho, Hopcroft e Ullman (v., 1974), che ha influenzato grandemente la progettazione di algoritmi. Tra i testi più recenti e agili, che contengono elementi sia di computabilità che di complessità, ricordiamo quelli di Hopcroft e Ullman (v., 1979), Lewis e Papadimitriou (v., 1981), Davis e Weyuker (v., 1983), Salomaa (v., 1985) e quello di Börger (v., 1985), che mette in luce la relazione tra la teoria della computazione e la logica. Tra i contributi in lingua italiana ricordiamo una significativa opera di Ausiello (v., 1975) sulla computabilità e una introduzione di Luccio (v., 1982) alla complessità, rivolta alla costruzione di algoritmi efficienti.

Seguiamo ora, nella letteratura specializzata, le origini e i principali sviluppi degli argomenti trattati in questo articolo. Gli automi finiti furono introdotti da McCulloch e Pitts (v., 1943) come modelli di reti neuroniche e furono poi sviluppati da Huffman (v., 1954) e numerosissimi altri autori in relazione ai sistemi elettronici. Il modello di automa non deterministico e la sua relazione con quello deterministico si deve a Rabin e Scott (v., 1959). Le proprietà citate per i linguaggi regolari si devono a Bar-Hillel, Perles e Shamir (v., 1961) e a numerosi altri autori. L'equivalenza tra automi è conseguenza di risultati di Huffman (v., 1954) e Nerode (v., 1958). Due noti libri che trattano di automi finiti sono opera di Minsky (v., 1967) e Arbib (v., 1970).

Gli automi a pila e la loro relazione con i linguaggi liberi sono stati inizialmente studiati da Oettinger (v., 1961), Chomsky (v., 1962) e Schutzenberger (v., 1963). Molti altri autori hanno trattato l'argomento, per il quale rimandiamo ai fondamentali testi di Ginsburg (v., 1966), Hopcroft e Ullman (v., 1969) e Salomaa (v., 1973).

La macchina di Turing, con la prima dimostrazione di indecidibilità, fu proposta da Turing (v., 1936-1937). Altri equivalenti modelli di calcolo furono proposti da Kleene (v., 1936), Church (v., 1941), Post (v., 1943) e Kolmogorov e Uspenskij (v., 1958). Il teorema di Rice è apparso in Rice (v., 1953). Ottime fonti per approfondire questo campo sono i già citati testi sulla calcolabilità e un'ulteriore opera di Davis (v., 1965). La prova di equivalenza tra la macchina di Turing e i calcolatori elettronici può essere studiata in Aho e altri (v., 1974).

Dopo alcuni studi pioneristici sulla difficoltà di calcolo delle funzioni, il primo contributo organico di complessità di calcolo si fa risalire a Hartmanis e Stearns (v., 1965). Contemporanea è l'individuazione da parte di Edmonds dei problemi in P (v. Edmonds, 1965). Lo studio dei problemi NP-completi è nato con il fondamentale lavoro di Cook (v., 1971), immediatamente sviluppato da Karp (v., 1972). La più completa trattazione disponibile su tali problemi è contenuta nell'importante testo di Garey e Johnson (v., 1979). Tra i tanti testi di complessità concreta ricordiamo quelli di Savage (v., 1976) e di Papadimitriou e Steiglitz (v., 1982).

Mentre il problema sulle classi di complessità si sta spostando verso la logica (v., per es., De Millo e Lipton, 1979; v. Börger, 1985), si sviluppa la teoria degli algoritmi approssimati e probabilistici (v. Rabin, 1977) e la teoria degli algoritmi paralleli, in appoggio allo sviluppo dei circuiti elettronici integrati (v., per es., Haines e altri, 1982). Una utilissima rassegna bibliografica sull'intero argomento e dovuta a Cook (v., 1983).

Bibliografia.

Aho, A. V., Hopcroft, J. E., Ullman, J. D., The design and analysis of computer algorithms, Reading. Mass., 1974.

Arbib, M. A., Theories of abstract automata, Englewood Cliffs 1970.

Ausiello, G., Complessità di calcolo delle funzioni, Torino 1975.

Bar-Hillel, Y., Perles, M., Shamir, E., On formal properties of simple phrase structure grammars, in ‟Zeitschrift für Phonetik. Sprachwissenschaft und Kommunicationsforschung", 1961, XIV, pp. 143-172.

Börger, E., Berechenbarkeit, Komplexität, Logik, Braunschweig 1985.

Chomsky, N., Context-free grammars and pushdown storage, in ‟MIT. Research laboratory of electronics. Quarterly progress report", 1962, n. 65.

Church, A., The calculi of lambda-conversion, Princeton 1941.

Cook, S. A., The complexity of theorem proving procedures, in Proceedings of the 3rd Association for Computing Machinery symposium on theory of computing,New York 1971.