intelligenza artificiale

intelligenza artificiale

L’intelligenza artificiale consiste in un insieme eterogeneo di tecniche e metodi volti a costruire sistemi artificiali dotati di capacità cognitive, che siano quindi capaci di riconoscere, classificare, ragionare, diagnosticare e anche agire, o che siano dotati almeno di alcune di queste proprietà. Un elenco (per altro incompleto) dei principali problemi affrontati da questa disciplina comprende il ragionamento automatico, la pianificazione, la diagnosi e classificazione automatica, la comprensione del linguaggio naturale, l’apprendimento, la robotica. Fra i metodi di ricerca, i principali da ricordare sono la logica, le reti neurali, l’elaborazione evolutiva, i modelli ad agenti e i sistemi complessi. [➔ cervello, modelli per l’attività su larga scala del; funzioni cerebrali superiori; informazione neurale; neurone; reti neurali]

Gli albori

La nascita dell’i. a. è intrecciata fortemente con lo sviluppo dei computer, di cui ha contribuito a modificare nel corso del tempo le caratteristiche e il ruolo. Inizialmente il calcolatore elettronico era considerato uno strumento per effettuare, appunto, calcoli complessi e impossibili se svolti da esseri umani, o per gestire grandi quantità di dati. I primi ricercatori di i. a. capirono però che il calcolatore è anche e soprattutto uno strumento per manipolare velocemente simboli. E se ciò è possibile, allora è anche possibile immaginare una macchina capace di simulare i processi del pensiero umano, o forse addirittura di pensare (se pensare significa soprattutto manipolare simboli). La data di nascita ufficiale dell’i. a. è il 1956: in quell’anno si tenne un seminario estivo a Dartmouth (USA) che raccolse i principali ricercatori nel settore e che contribuì in maniera decisiva a definire l’agenda delle ricerche degli anni futuri. Sorsero subito due approcci radicalmente diversi a questo argomento: quello simbolico, secondo il quale l’intelligenza è da mettere in relazione con la capacità di manipolare simboli e di dedurre conclusioni corrette sulla base di un certo insieme di premesse, e quello dinamico, basato invece sul tentativo di simulare il comportamento dei neuroni biologici e che verrà in seguito denominato, con una scelta lessicale infelice, approccio sub-simbolico.

L’approccio simbolico

Nei primi anni l’attenzione dei ricercatori si indirizzò soprattutto alla costruzione di ‘risolutori universali’ di problemi, nella convinzione che fosse possibile sviluppare metodi generali di grande potenza e applicabili con successo in molti contesti diversi. Il problema tipico era quello in cui, essendo noto un certo insieme di fatti iniziali (premesse), bisogna dimostrare la verità o la falsità di una certa conclusione (obiettivo). Si tratta quindi di generare nuovi fatti a partire dalle premesse, finché uno di questi fatti non coincide con l’obiettivo. Questo schema è applicabile alla soluzione di molti problemi specifici: per es., nel caso della diagnosi medica le premesse sono costituite da dati relativi alla situazione del paziente, e l’obiettivo coincide con la diagnosi, mentre nel gioco degli scacchi le premesse sono date dalle posizioni dei pezzi sulla scacchiera e l’obiettivo è dato dalla situazione di scacco matto.

La procedura a grafi. Un metodo per giungere all’obiettivo consiste nel generare un grafo di ricerca. All’inizio sono incluse solo le premesse, che possono essere rappresentate graficamente come i nodi di un grafo: da alcune di esse si genera un nuovo fatto, quindi un nuovo nodo, che viene aggiunto a quelli noti, ampliandone così l’insieme; il nuovo nodo viene poi collegato con un arco alle premesse utilizzate per generarlo. Si possono inoltre usare gli elementi di questo insieme per generare altri nodi e altri archi, ampliando così il grafo di ricerca, finché non si raggiunge l’obiettivo. Tuttavia, si scoprì presto che i sistemi automatici di ricerca per grafi possono facilmente ‘perdersi’ generando fatti irrilevanti; oppure possono seguire percorsi che non si avvicinano allo scopo. Vennero quindi sviluppati diversi metodi per rendere la ricerca più efficace, facendo uso di informazioni relative alla natura dell’obiettivo per guidare la generazione dei nuovi nodi.

I sistemi esperti. I primi studi di i. a. portarono allo sviluppo di strumenti molto sofisticati, alcuni dei quali sono tuttora in uso, ma l’ambizioso obiettivo di ridurre la soluzione di problemi complessi al solo sviluppo di tecniche di ricerca si rivelò irrrealizzabile. Si comprese ben presto che per affrontare problemi di una certa difficoltà bisognava fare ricorso a una notevole mole di conoscenza specifica, e ci si concentrò quindi sulla ricerca di metodi per ottenere e formalizzare le conoscenze relative al dominio a cui il problema si riferisce. Si ottennero in tal modo risultati veramente notevoli, in partic. con quelli che inizialmente vennero chiamati sistemi esperti (oggi si preferisce il termine di sistemi basati sulla conoscenza). Con i sistemi esperti, per la prima volta l’i. a. fu in grado di produrre programmi con prestazioni confrontabili con quelle di un esperto umano. Infatti, mentre nel calcolo numerico il computer si distingueva per le proprie capacità sovrumane di elaborazione, nei settori propri dell’i. a. le prestazioni dei programmi erano nettamente inferiori (talvolta in maniera imbarazzante) a quelle degli esseri umani. I primi sistemi esperti ottennero invece risultati davvero eccellenti: per es., il programma di diagnosi di malattie polmonari Mycin ottenne prestazioni confrontabili con quelle dei membri della Facoltà di medicina dell’Università di Stanford, mentre il sistema Prospector, analizzando dati sismici, ipotizzò la presenza di un giacimento di molibdeno che venne poi effettivamente ritrovato.

L’inverno dell’intelligenza artificiale. Il successo dei sistemi esperti diede il via a un periodo di euforia per le applicazioni pratiche dell’i. a., che però terminò presto quando ci si rese conto che lo sviluppo di sistemi esperti veramente efficaci richiede un impegno importante in termini di tempo e di sforzo organizzativo. La delusione, rispetto alle attese eccessive che erano state evocate, causò una crisi di rifiuto, tanto che si parlò di ‘inverno dell’intelligenza artificiale’. Ma anche questa delusione passò quando ci si rese conto che le tecnologie erano effettivamente in grado di realizzare prodotti importanti, sebbene non con la facilità che si pensava all’inizio. Da un punto di vista accademico, invece, la ricerca in i. a. non conobbe un vero e proprio calo d’interesse. In partic., gli studi sulle logiche non monotone, sui metodi di pianificazione e di ragionamento, sull’apprendimento e sulla comprensione del linguaggio naturale si svilupparono in maniera significativa, assieme a quelli relativi all’approccio dinamico.

L’approccio dinamico

L’approccio dinamico è costituito da un insieme di modelli, ispirati in senso lato alle conoscenze sui neuroni e sull’architettura del cervello, composti da molti nodi (i neuroni artificiali) interconnessi. Ogni nodo ha un valore di attivazione (una variabile numerica continua o discreta) che cambia nel tempo secondo una determinata legge. Se c’è una connessione (sinapsi) dal nodo A al nodo B, ciò implica che il valore di A può influenzare quello di B in un tempo successivo. La ricerca nell’approccio dinamico era iniziata già negli anni Quaranta del 20° sec., quando il neurofisiologo Warren S. McCulloch e il matematico Walter Pitts introdussero un modello booleano a soglia, e riuscirono a dimostrare che, per ogni funzione logica finita, esiste una rete di neuroni di questo tipo capace di realizzarla. Data la relazione fra queste reti e l’architettura del cervello il risultato ebbe un forte impatto sulla nascente disciplina della cibernetica.

Le reti neurali. I dati scoperti dai neurofisiologi suggerivano che i concetti fossero rappresentati nel cervello in maniera distribuita, come pattern di attivazione di gruppi di neuroni, anziché essere associati a un solo neurone specifico (un tipo di rappresentazione chiamata a volte ‘neurone della nonna’). Un meccanismo di autoorganizzazione, capace di generare questi gruppi di neuroni coordinati, fu proposto dallo psicologo Donald O. Hebb il quale ipotizzò che quando le attivazioni di due neuroni avvengono in maniera correlata, si modifica l’intensità della sinapsi che li unisce. Fu così possibile mostrare l’emergenza di processi cooperativi in reti neurali (➔) artificiali fornite del meccanismo di Hebb già negli anni Cinquanta. Dal punto di vista applicativo, i risultati più importanti furono però ottenuti con reti di neuroni artificiali organizzate in strati, i cosiddetti percettroni, che sono capaci di apprendere un compito a partire da una serie di esempi (per es., quello di riconoscere a quale classe appartiene un certo input). Tuttavia, inizialmente gli unici algoritmi efficaci di apprendimento operavano su percettroni a due strati (uno di input e uno di output), e in seguito queste architetture mostrarono gravi limitazioni. Una vivace polemica stimolata da alcuni fautori dell’approccio simbolico portò a una decadenza delle ricerche sulle reti neurali per tutti gli anni Settanta, ma la situazione si modificò radicalmente nel decennio successivo. La rinascita di interesse per le reti neurali in quel periodo fu dovuta a diversi fattori. Da un lato, in quegli anni si compresero diverse limitazioni dell’approccio simbolico, in partic. nella gestione di contraddizioni e di conoscenze variabili e per la difficoltà di sviluppare una base di conoscenze adeguata in domini complessi. Dall’altro lato, la ricerca sulle reti neurali ottenne risultati significativi, soprattutto con la scoperta di un efficace algoritmo di apprendimento per reti a più strati, che non soffrono delle limitazioni intrinseche dei percettroni a due strati. È anche importante osservare come la maggiore disponibilità di potenza di calcolo dei computer dell’epoca consentiva di effettuare simulazioni con una frequenza e una facilità impensabili nei periodi precedenti. Ma decisivo nella ripresa di interesse sulle reti neurali fu il coinvolgimento di altre comunità scientifiche influenti e dotate di strumenti concettuali assai raffinati. Si osservò, infatti, come i modelli booleani di reti neurali assomigliassero a modelli di materiali magnetici disordinati (i cosiddetti vetri di spin), che erano al centro dell’interesse dei fisici statistici. Inoltre, le reti neurali sono sistemi dinamici non lineari a molti gradi di libertà, e proprio in quegli anni la dinamica non lineare stava sviluppando la teoria dei sistemi caotici. Quindi fisici statistici, matematici, studiosi di sistemi dinamici iniziarono a interessarsi alle reti neurali apportando nuove competenze e nuovo entusiasmo. Anche dal punto di vista applicativo si ottennero risultati molto importanti, e oggi l’i. a. ospita contributi sia simbolici sia neurali. Questi ultimi sono chiamati a volte subsimbolici; tuttavia questa etichetta può essere fuorviante, poiché in realtà anche una rete neurale simulata su computer agisce su simboli, per es. associandoli. Meglio quindi l’espressione approccio dinamico, che enfatizza la differenza nei metodi con cui avviene l’elaborazione.

Il modello evolutivo. Un altro approccio di notevole successo è quello evolutivo, che ha dato origine a diverse scuole di pensiero (algoritmi genetici, programmazione genetica, strategie evolutive e altre ancora) che condividono un’ispirazione comune, ossia quella di rifarsi ai processi di evoluzione darwiniana. In questi sistemi non si cerca direttamente una soluzione al problema in esame (per es., un problema di classificazione) ma si genera un’intera popolazione di soluzioni. Queste ultime vengono valutate e l’informazione sulla loro adeguatezza viene utilizzata per scegliere i ‘genitori’ di una nuova generazione di soluzioni, che sono prodotte trasformando i genitori con opportuni operatori. Sebbene in questo caso non si abbia a che fare con un sistema dinamico in senso classico, anche questi sistemi evolutivi cercano di risolvere problemi complessi facendo ricorso a proprietà di autoorganizzazione, e per questo motivo possono essere considerati all’interno dell’approccio dinamico.

L’intelligenza delle macchine

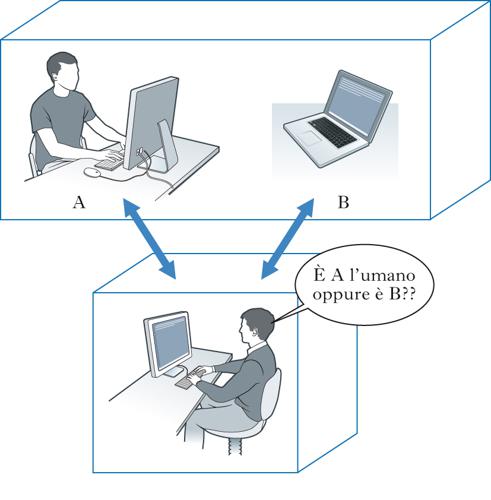

Come si è visto, le macchine possono ottenere prestazioni anche notevoli, ma è lecito considerarle davvero intelligenti? Il primo tentativo interessante di rispondere a questa domanda si deve al matematico Alan M. Turing, che immaginò (come metodo sperimentale ipotetico) una situazione in cui un intervistatore umano dialoga per mezzo di un terminale da un lato con un computer, dall’altro con un secondo essere umano. Secondo Turing, se l’intervistatore non è in grado di distinguere chi dei due è il computer e chi l’uomo in base alle rispettive risposte, allora il computer è da considerarsi una macchina intelligente. Questo metodo, appunto noto come test di Turing, è molto interessante perché è di tipo operazionale, analogo quindi a quello che ha avuto tanta importanza in fisica (si pensi all’approccio di tipo operazionale ai concetti di spazio e tempo introdotto da Albert Einstein).

Le obiezioni al test di Turing. Sono state mosse diverse obiezioni al test di Turing, fra cui la principale è quella della ‘stanza cinese’: immaginiamo un essere umano chiuso in una stanza, che riceve un insieme di ideogrammi cinesi attraverso una fessura. L’uomo possiede un insieme di manuali e tabelle che lo istruiscono su come rispondere appropriatamente a ogni insieme di ideogrammi in ingresso, e quindi egli, seguendo le istruzioni, genera ideogrammi di risposta. La stanza, vista dall’esterno come una scatola nera, supererebbe il test di Turing. Ma, secondo i ciritici di Turing, non per questo penseremmo che la persona al suo interno conosca il cinese. Quindi non basta avere una ricetta per risolvere i problemi per poter affermare di essere in presenza di vera intelligenza. Questa obiezione però trascura il fatto che la macchina, nel caso della ‘stanza cinese’, non coinciderebbe con la persona in sé – ridotta a un semplice ‘passacarte’ – ma con l’intera stanza, compresi i manuali per comporre la frase giusta. E sarebbe difficile negare al sistema nel suo complesso la capacità di tradurre.

Il dibattito sulle macchine intelligenti. Mentre tutti i sistemi artificiali esistenti non si avvicinano neppure a superare il test di Turing, esso conserva un interesse teorico perché fornisce un possibile criterio obiettivo per giudicare la qualità dei risultati. Un’obiezione più seria che può essere mossa a questo tipo di approccio è invece quella di dare un’enfasi eccessiva alle abilità linguistiche, che di per sé costituiscono solo un aspetto dell’intelligenza. Si noti che alcuni compiti molto facili per gli esseri umani sono invece molto difficili per i computer (per es., sostenere una conversazione, riconoscere i diversi oggetti in un’immagine e gestire conoscenze assai diverse fra loro), e viceversa (per es., eseguire lunghe operazioni numeriche). Ciò porta a supporre che vi siano importanti differenze strutturali fra esseri umani e computer, convinzione confermata dalle conoscenze sull’anatomia e fisiologia del cervello. Tuttavia, secondo i sostenitori dell’influente paradigma del cognitivismo, le differenze nell’hardware non sono essenziali, ciò che conta è la capacità di effettuare certe operazioni. La maggior parte dei sostenitori di questa posizione identifica inoltre questa capacità con quella di manipolare simboli in maniera analoga a quella degli esseri umani. Fra i sostenitori dell’approccio dinamico prevale invece, per così dire, un maggiore rispetto per l’hardware, e si sostiene che per costruire una macchina che pensa sia necessario usare componenti più vicini a quelli biologici. Tuttavia, i neuroni artificiali sono spesso solo ‘caricature’ di quelli biologici, per cui non è chiaro quanto questa fedeltà al biologico sia effettivamente seguita nei sistemi artificiali esistenti.

Le prospettive

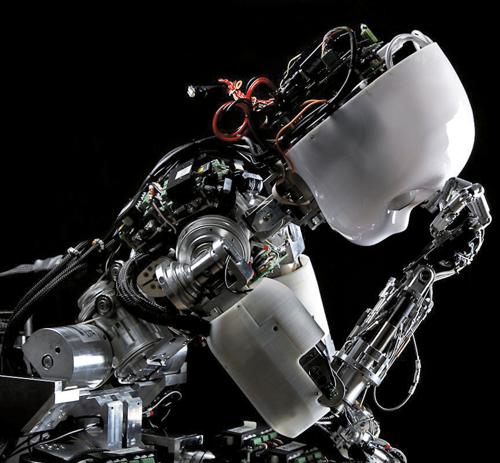

Sia i sistemi logici sia quelli neurali possono ottenere ottime prestazioni in settori specifici, mentre gli esseri umani sono in grado di integrare efficacemente gli aspetti simbolici e quelli dinamici. I tentativi di realizzare un’analoga integrazione in un sistema artificiale non hanno finora (2010) fornito risultati decisivi, e questo costituisce la principale frontiera della ricerca attuale. Gli sforzi per realizzare macchine intelligenti hanno anche portato a un ripensamento di cosa sia l’intelligenza e di dove risieda la conoscenza: mentre secondo una visione ingenua essa si trova nel cervello, appare sempre più chiaro che essa si trova distribuita anche nel corpo e nell’ambiente che lo circonda. Infatti, un filone di ricerca molto interessante è quello dell’intelligenza incarnata, in cui l’intelligenza è il risultato dell’interazione fra un corpo (per es., il corpo artificiale di un robot) e una mente, ovvero la rete neurale che lo governa (in parte). È opportuno ricordare infine la posizione di coloro secondo i quali una macchina non potrà mai pensare. Spesso i sostenitori di questa tesi fanno riferimento in maniera impropria al teorema di Gödel, che ha avuto un impatto drammatico sulla questione dei fondamenti della matematica (mostrando che essa non può essere ricondotta in toto alla logica formale), mentre ben difficilmente può avere una rilevanza diretta per quanto riguarda i processi cognitivi più abituali. Un’obiezione potenzialmente più rilevante è quella di chi sostiene che l’elaborazione digitale è intrinsecamente diversa da quella che avviene nel cervello, chiamando in causa i fenomeni quantistici di collasso della funzione d’onda di Schrödinger, pur precisando che si tratta di un’ipotesi non verificata ma suscettibile in linea di principio di verifica sperimentale. Roberto Serra