L'Età dei Lumi: la fine della conoscenza naturale 1700-1770. Luce, calore, elettricita e magnetismo

L'Eta dei Lumi: la fine della conoscenza naturale 1700-1770. Luce, calore, elettricita e magnetismo

Luce, calore, elettricità e magnetismo

A partire dagli anni Settanta del Settecento, la luce, il calore, l'elettricità e il magnetismo erano stati identificati, insieme al suono, ai fluidi aeriformi e alle proprietà estensive della materia, come i campi di studio centrali di una scienza definita da poco tempo 'fisica sperimentale'. Divenne quindi urgente rendere più precisa la metodologia della ricerca e trovare un accordo comune su di essa, cose che non erano state necessarie all'inizio del secolo, quando con il termine 'fisica' si definiva ‒ secondo la concezione aristotelica ‒ la scienza della materia e del cambiamento in generale, in cui il ruolo degli esperimenti era ancora controverso. La terminologia rimaneva però alquanto fluida; mentre i Francesi parlavano di physique expérimentale, gli Inglesi preferivano l'espressione experimental philosophy e, ancora alla fine del XVIII sec., i confini tra le discipline rimanevano poco definiti: la luce e il calore, infatti, erano studiati sia dai chimici sia dai filosofi sperimentali e il profondo interesse per l'elettricità e il magnetismo 'animali' creava un continuo sovrapporsi dei dominî della fisica e della biologia.

Durante il Settecento furono effettuate nuove e importanti scoperte, specialmente riguardo all'elettricità, il cui campo d'indagine alla fine risultò interamente modificato. Altrettanto importante fu l'interesse crescente a stabilire quali problemi dovessero essere considerati marginali o, all'opposto, centrali; anche in questo modo, dunque, la natura delle ricerche era definita con una precisione maggiore. Tra i diversi problemi si tendeva a considerare centrali quelli che sembravano in grado di gettare luce sulle questioni teoriche fondamentali; ma, poiché l'esperimento era sempre più accettato come arbitro in ultima istanza, la possibilità di sottoporre a sperimentazione contribuiva fortemente a far passare in primo piano aspetti che potevano sembrare marginali.

In seguito all'opera di Newton, divenne oggetto di discussione la questione se il moto e l'urto fossero sufficienti a spiegare ogni fenomeno naturale, come avevano supposto i filosofi corpuscolari del XVII secolo. Nei Principia (1687), Newton costruì una scienza del moto in cui i cambiamenti erano attribuiti all'azione di forze che potevano essere o no causate da urti; egli, inoltre, fornì la famosa spiegazione del moto celeste basata sulla forza gravitazionale universale che agisce tra le particelle di materia, la cui causa ammise di non conoscere ma che, a suo avviso, non era meccanica. Nell'Opticks (1704), e in particolare nelle Queries che vi aggiunse nel 1706, Newton suggerì che molti altri fenomeni potevano essere spiegati in termini di forze che agiscono a distanza tra corpuscoli distinti. Inoltre, sostenne che il metodo più appropriato per svolgere un'indagine scientifica consisteva nel procedere alla scoperta delle forze e soltanto in seguito cercare di capire da che cosa potessero essere causate.

Sino a che punto i principî metodologici di Newton furono seguiti dai filosofi sperimentali del Settecento è ancora argomento di discussione; infatti, secondo alcuni, in quest'epoca vi fu una graduale sostituzione del meccanicismo cartesiano con le idee di Newton, dapprima in Gran Bretagna intorno agli inizi del secolo, poi in Olanda uno o due decenni più tardi e infine in Francia (e conseguentemente nel resto d'Europa) verso la fine degli anni Trenta o agli inizi degli anni Quaranta, quando le idee di Newton s'imposero completamente. Questo punto di vista storiografico, nato dall'indagine sul successo della meccanica celeste newtoniana, fu esteso in seguito anche agli sviluppi della fisica sperimentale che si era ispirata all'Opticks. Non si possono negare né la grandezza delle conquiste matematiche e sperimentali di Newton, né l'impatto che esse ebbero sui suoi successori; tuttavia, definire la scienza di un intero secolo come 'newtoniana' significa ignorare l'importanza avuta da altre scuole di pensiero, come per esempio quella derivata dalle idee di Leibniz, e proporre una storia della scienza molto più lineare di quanto non rivelino le fonti originali. Una simile interpretazione implicherebbe che i filosofi sperimentali del Settecento continuassero a occuparsi solamente delle problematiche presenti all'epoca di Newton, mentre, in realtà, molte di esse erano già state accolte (oppure escluse) dal campo della ricerca scientifica. D'altra parte, è stato provato che è impossibile caratterizzare il 'newtonianesimo' in modo tale da comprendere in maniera adeguata la varietà degli approcci adottati dagli stessi filosofi naturali del Settecento che sono stati considerati appartenenti a quella tradizione di ricerca. L'influenza dell'opera di Newton e degli straordinari risultati da lui raggiunti nei confronti della scienza successiva è stato un fatto inevitabile; tuttavia, i ricercatori del Settecento non si preoccuparono di controversie ormai superate, ma s'impegnarono piuttosto nella risoluzione di problemi nuovi e alquanto diversi da quelli che avevano visto protagonisti Newton e i suoi contemporanei.

Luce

L'Opticks fu il secondo grande lascito di Newton al XVIII secolo. Dedicata essenzialmente ai fenomeni relativi al colore, poiché si basa sulla celebre decomposizione della luce bianca in raggi colorati ottenuta mediante la rifrazione attraverso un prisma, l'opera include anche un esteso resoconto delle ricerche pionieristiche sui colori di lamine sottili, di piastre spesse, di corpi naturali e, più brevemente, di quelle sulla doppia rifrazione e sulla 'inflessione' (ossia sulla diffrazione). Nella parte finale, le cosiddette Queries, sono inoltre proposte in forma interrogativa molte delle premesse teoriche di base che Newton aggiungerà via via nelle edizioni successive.

Alla loro prima pubblicazione, nel 1672, gli esperimenti di Newton con i prismi, e più in particolare le conclusioni che ne trasse, causarono un turbine di controversie. In Francia, per una intera generazione le sue idee furono addirittura rifiutate perché gli esperimenti che le corroboravano non potevano essere replicati; tuttavia, a partire dagli anni Dieci del Settecento gli scienziati francesi finirono per accettarle integralmente. Da allora in poi quasi tutti ammisero ‒ con la notevole eccezione di Johann Wolfgang von Goethe (1749-1832) ‒ che la luce bianca era una mescolanza di raggi colorati permanenti, dotati di differenti rifrangibilità.

La ricerca di Newton sui fenomeni periodici associati alla luce ha inizio negli anni Sessanta del Seicento con le indagini sui colori di una lamina sottile (gli 'anelli di Newton'). Tracciando un'audace analogia, Newton arrivò alla conclusione che i colori dei corpi naturali nascevano dall'interazione con la luce dei corpuscoli di cui erano composti, esattamente come avveniva nelle lamine sottili. La riflessione o l'assorbimento dei raggi dipendeva solamente dalle dimensioni e dalle densità dei corpuscoli coinvolti e non dalla loro composizione chimica; sembrava quindi che la teoria fornisse un metodo per determinare, tramite i colori, le dimensioni dei corpuscoli di cui i vari corpi erano considerati costituiti. Nella maggior parte dei casi, i colori, analizzati con un prisma, mostravano di essere composti da bande di diversi colori sovrapposte; le misurazioni delle lamine sottili, che non furono superate nei cento anni successivi, consentirono a Newton un preciso controllo quantitativo di tale fenomeno.

L'intero sistema era basato sulla concezione che la luce consistesse di flussi di corpuscoli in movimento rapido; infatti, sin dall'inizio Newton aveva presupposto che il fenomeno da lui considerato derivasse da corpuscoli leggeri, che provocavano vibrazioni nella materia sottile (o etere) che occupava gli spazi tra i corpuscoli dei corpi; tuttavia, quando scrisse l'Opticks, sostituì ogni riferimento alle vibrazioni dell'etere con i concetti misteriosi, anche se fenomenologicamente fondati, di 'impulsi alla facile trasmissione' e 'impulsi alla facile riflessione' della luce. In questo modo egli eliminava il problema della spiegazione delle teorie fisiche su cui si era basata la ricerca precedente, rendendola molto meno comprensibile di quanto avrebbe potuto essere. Per buona parte del XVIII sec., comunque, non furono intrapresi studi ulteriori sull'argomento, poiché sembra che gli studiosi fossero rimasti sconcertati dalla scoperta di Newton.

L'ottica geometrica, basata sulla propagazione lineare dei raggi luminosi, e la legge della riflessione ebbero origine nel mondo antico. Solo nel 1637, con l'annuncio di René Descartes della scoperta della 'legge del seno' per la rifrazione, divenne possibile realizzare una trattazione matematica anche dei raggi rifratti e quindi dei sistemi di lenti. A tale analisi i grandi matematici settecenteschi, tra cui Leonhard Euler (1707-1783), dedicarono molto tempo e molta energia; anche se, da un punto di vista fisico, il perfezionamento dei sistemi di lenti fu limitato dalla dispersione cromatica. Mediante i suoi esperimenti, Newton era arrivato alla conclusione che ogni deviazione della luce era accompagnata da dispersione, e perciò non era possibile ottenere alcun sistema di lenti privo di aberrazione cromatica. Ciononostante, nel 1747 Euler sostenne che questa idea poteva essere non corretta e, ritenendo che il funzionamento dell'occhio umano provasse il contrario, si accinse a progettare una lente composta che avrebbe dovuto essere acromatica. Sviluppi ulteriori del problema gettarono nuova luce sulle preferenze dei matematici e degli sperimentatori settecenteschi. Il ragionamento di Euler fu contestato dall'ottico londinese John Dollond (1706-1761) sulla base dei risultati riportati da Newton; in seguito, eseguendo esperimenti propri, Dollond scoprì che Newton aveva commesso errori significativi e riuscì a costruire lenti composte accettabilmente acromatiche, che trovarono una rapida diffusione tra gli astronomi. Tutt'altro che convinto, Euler respinse la rivendicazione di Dollond, sostenendo che qualunque miglioramento egli avesse apportato non poteva essere dovuto all'acromaticità delle sue lenti. Il problema consisteva nel fatto che secondo le misurazioni di Dollond sembrava che non vi fosse una relazione tra gli indici di rifrazione di diversi raggi colorati in mezzi differenti e che tali indici dovessero essere misurati individualmente caso per caso, mentre Euler sosteneva che essi dovessero sottostare a una legge matematica.

Già nei primi anni del Settecento, a seguito degli studi dell'astronomo danese Ole Christensen Römer (1644-1710), era largamente accettata, anche se non da tutti, l'idea che la luce si propagasse a una velocità molto grande ma finita, piuttosto che istantaneamente come aveva sostenuto Descartes. Nel 1676 Römer mostrò che le apparenti discrepanze nei tempi d'immersione dei satelliti di Giove scomparivano se si supponeva che la luce viaggiasse a una velocità finita e che quindi impiegasse un tempo maggiore oppure minore per raggiungere la Terra a seconda che Giove, nella sua orbita, fosse più lontano oppure più vicino al nostro pianeta. Questa conclusione, anche se fu accettata dalla maggior parte degli studiosi più importanti, rimase controversa sino a che James Bradley (1693-1762) fornì nel 1728 a suo sostegno prove indipendenti, identificando ciò che in seguito sarà definita l''aberrazione della luce': un cambiamento, nel corso dell'anno, della posizione apparente delle stelle, che Bradley spiegò con successo nei termini di un rapporto finito tra la velocità della propagazione della luce e quella della Terra nella sua orbita.

Lo studio sistematico dell'intensità della luce, detto 'fotometria', ebbe inizio con l'opera di Pierre Bouguer (1698-1758) Essai d'optique sur la gradation de la lumière, pubblicata nel 1729. Bouguer concepì una tecnica che consisteva nell'osservare due sorgenti di luce che si volevano confrontare attraverso due schermi adiacenti, variando le distanze delle sorgenti dai rispettivi schermi finché apparissero ugualmente luminose (un pannello divisorio manteneva separati i loro effetti); dato che dalla geometria era noto che l'intensità di una sorgente è inversamente proporzionale al quadrato della distanza da essa, risultava semplice calcolare le intensità relative delle due sorgenti osservate. Su questa base Bouguer condusse studi dettagliati sull'assorbimento della luce riflessa da superfici diverse o trasmessa attraverso diverse sostanze trasparenti. La stessa tecnica fu adottata da Johann Heinrich Lambert (1728-1777) nella sua ricerca pubblicata nel 1760 con il titolo Photometria.

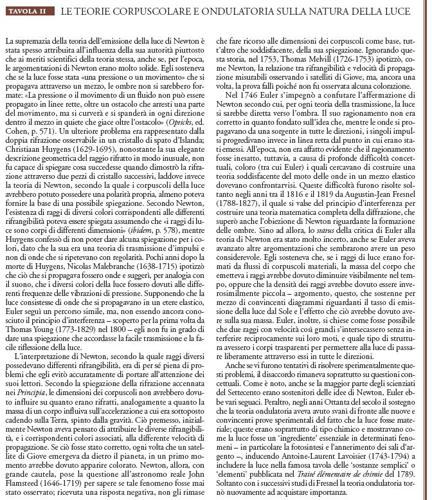

Newton, come è stato precedentemente accennato, adottò la teoria corpuscolare o 'dell'emissione' della luce contro quella 'della trasmissione' elaborata da Christiaan Huygens (1629-1695), secondo la quale la luce era costituita da impulsi trasmessi attraverso l'etere. La teoria di Newton fu largamente accettata nel XVIII sec. sia in Francia sia in Gran Bretagna, mentre a est del Reno ebbe molti seguaci la teoria della trasmissione adottata da Euler. La contrapposizione tra queste due teorie è ricordata, nei suoi tratti essenziali, nella Tav. II.

Quando dovevano spiegare l'emissione della luce, i sostenitori delle due teorie ipotizzavano che essa derivasse dalle

presunte agitazioni dei corpuscoli di cui erano composti i corpi luminosi. Per i sostenitori della teoria corpuscolare tali agitazioni espellevano a grandissima velocità la materia sottile che occupava gli spazi tra i corpuscoli costituenti i corpi; per quelli della teoria ondulatoria, invece, le agitazioni dei singoli corpuscoli sulla superficie dei corpi causavano, mediante gli urti, agitazioni analoghe nel mezzo etereo circostante, le quali si propagavano poi verso l'esterno. Euler estese quest'idea anche alla spiegazione dei colori delle superfici opache, suggerendo che la luce incidente, per il tramite di un processo analogo a quello della risonanza, facesse vibrare le particelle della superficie con frequenze che erano caratteristiche della superficie considerata, determinando in questo modo il colore dell'oggetto che era trasmesso all'esterno sotto forma di vibrazioni nell'etere circostante. Mentre tali idee avevano una certa credibilità nella spiegazione della luminosità di oggetti caldi (o, come nel caso di Euler, fortemente illuminati), in altri casi sembravano meno plausibili.

Già nel XVIII sec., in effetti, si conoscevano, ed erano oggetto di ricerche, molte sorgenti di luce 'fredda', tanto è vero che Joseph Priestley (1733-1804) dedicò ampio spazio a questi studi nella sua History and present state of discoveries relating to vision, light and colours (1772), in particolare proprio nella sezione dedicata ai suoi sviluppi nel XVIII secolo. Tra questi fenomeni quello maggiormente studiato era stata la cosiddetta 'pietra bolognese' (o 'pietra luminosa di Bologna'), già conosciuta da Galilei e sottoposta a indagini sistematiche da parte di alcuni fisici di Bologna durante i primi decenni del XVIII secolo. Tali indagini culminarono nel lavoro di Jacopo Bartolomeo Beccari (1682-1766), al quale seguì poi quello del giovane accademico francese Charles-François Dufay (1698-1739). Da entrambi era riconosciuto che la 'pietra bolognese' era soltanto una delle tante sostanze ‒ i fosfòri ‒ apparentemente capaci di assorbire la luce alla quale erano esposte per poi restituirla in seguito, nel fenomeno detto 'fosforescenza'. Tuttavia, nonostante le numerose ricerche sulla formazione di tali sostanze, la loro composizione chimica e la maniera in cui erano illuminate, le condizioni in cui avveniva la fosforescenza rimanevano poco chiare. Per di più, non era certo se la luce emessa fosse la stessa dell'illuminazione iniziale e se il colore dipendesse dallo specifico fosfòro, come sostenevano alcuni, tra i quali il professore torinese Giambattista Beccaria (1716-1781). Dal momento che nella maggior parte dei casi osservati la luce emessa era molto debole, dare una risposta a questi interrogativi risultò estremamente difficile.

Durante questo periodo furono svolte ricerche assidue anche su altre sorgenti di luce 'fredda' ‒ come in precedenza aveva fatto anche Robert Boyle (1627-1691) ‒ senza però raggiungere un parere unanime sulla natura di tale fenomeno. Tra le sorgenti studiate vi erano le lampiridi nottiluche e le lucciole, la materia organica putrescente, la superficie del mare agitato, il fosfòro creato dall'urina e gli ignes fatui, ossia i 'fuochi fatui', una misteriosa apparizione luminosa in corrispondenza dei terreni paludosi e (a detta di alcuni) dei cimiteri; inoltre, fu scoperto che anche altri tipi di apparizioni luminose potevano essere associate all'elettricità.

Fluidi sottili, calore e fuoco

Come la maggior parte degli altri filosofi naturali del Settecento, durante tutta la sua vita Newton ritenne che la materia ordinaria fosse soffusa di una o più materie sottili che servivano a individuare le cause di molti effetti osservati. In una sezione aggiunta alla seconda edizione (1713) dei Principia, Newton fece riferimento allo "spirito" come alla causa della coesione dei corpi, della forza elettrica attrattiva e repulsiva, dell'emissione, della riflessione, della rifrazione, dell'inflessione e degli effetti termici della luce, e, infine, del funzionamento dei nervi. Inoltre, per la successiva edizione dell'Opticks del 1718, egli scrisse l'abbozzo di nuove Queries in cui descriveva questa sostanza, ma non le pubblicò mai. Comunque, ne incluse altre che suggerivano l'esistenza di un etere universale che sostituiva alcune funzioni esplicative (anche se non tutte) precedentemente attribuite alla materia sottile; questo etere, espandendosi attraverso l'Universo, poteva anche spiegare la gravità; dunque, essendo la causa della gravità, esso doveva essere necessariamente imponderabile. Tuttavia, pochi fra i lettori di Newton fecero una distinzione tra la materia sottile e questo etere, in quanto dalla sua opera trassero semplicemente l'idea che, oltre all'ordinaria materia percettibile, il mondo ne contenesse una sottile in grado di penetrare ovunque.

Gli adattamenti di quest'idea divennero una delle caratteristiche della filosofia della Natura del XVIII secolo. Tuttavia, gli scritti di Newton non erano l'unica fonte a cui gli studiosi attingevano, dal momento che anche Descartes aveva fatto appello a un etere universale, sui movimenti del quale basava tutte le sue spiegazioni dei fenomeni naturali. Durante i primi decenni del secolo furono intrapresi vari tentativi per migliorare la teoria dei vortici celesti di Descartes; adattata a un livello più terrestre, la sua spiegazione del magnetismo in termini di vortici minori di un tipo speciale di materia sottile, che passavano attraverso un magnete lungo il suo asse e poi ritornavano attraverso l'aria esterna, fu adottata persino da Newton e continuò a essere largamente accettata sino ad almeno la fine degli anni Cinquanta del Settecento. Anche in molti altri casi, il meccanismo etereo proposto da Descartes fornì il punto di partenza per le spiegazioni dei fenomeni fisici sostenute nel XVIII secolo.

Altrettanto influente fu l'opera dell'olandese Herman Boerhaave (1668-1738), il quale negli Elementa chemiae (1732) sosteneva che il mondo era riempito di un 'fuoco' elastico, materiale e onnipervasivo, la cui presenza e attività erano rivelate dall'espansione dei corpi, tra i quali anche il mercurio dei termometri ideati da Daniel Gabriel Fahrenheit (1686-1736), che, perciò, erano in grado d'identificare e misurare questo fluido. In opposizione alla forza espansiva, affermava Boerhaave, ne esisteva una contrattile intrinseca alla materia ordinaria, che, appunto, faceva contrarre i corpi quando erano raffreddati; dunque, a una temperatura data, essi mantenevano un volume costante perché le due forze si trovavano in equilibrio.

Nella teoria di Boerhaave non era chiaro se l'espansione delle differenti sostanze registrata nei termometri fosse causata dall'attività o dalla semplice presenza del 'fuoco'. Altri negavano del tutto la materialità del fuoco, preferendo l'idea, già sostenuta da Newton e da Francis Bacon, che il fuoco e il calore che ne derivava fossero semplici manifestazioni di un incremento del moto tra le particelle di materia ordinaria. Il punto di vista materialista guadagnò forza nei primi anni Sessanta del Settecento con gli studi di Joseph Black (1728-1799) sui cambiamenti di stato, e precisamente dallo stato solido a quello liquido e da questo allo stato di vapore. Egli mostrò che convertendo il ghiaccio in acqua o l'acqua in vapore una certa quantità di calore scompariva, ma poteva essere recuperata invertendo il processo; giunse quindi alla conclusione che il calore non era andato distrutto ma era semplicemente diventato non rilevabile dal termometro, ossia era diventato un 'calore latente'. Inoltre, osservando i cambiamenti di temperatura nei miscugli, Black arrivò a sostenere che le varie sostanze hanno capacità diverse rispetto al calore, ossia che una data quantità di calore aumenta la temperatura di sostanze diverse in maniera quantitativamente differenziata. Le ricerche di Black si diffusero tra gli studiosi grazie alle sue lezioni, cioè soltanto oralmente, dato che egli non riuscì a pubblicare nulla in proposito. Nei primi anni Settanta del Settecento il filosofo sperimentale svedese Johan Carl Wilcke (1732-1796) arrivò in maniera indipendente a conclusioni simili che pubblicò immediatamente, provocando molta apprensione tra gli amici di Black.

Supponendo che il calore fosse materiale, sorgeva il problema di determinare se esso fosse dotato di peso oppure fosse realmente imponderabile. Vari studiosi cercarono di rispondere a quest'interrogativo in maniera sperimentale, ma le pesate erano inevitabilmente compromesse dagli effetti della spinta idrostatica, dalle correnti di convezione termica nell'aria e dalle dilatazioni disuguali dei bracci delle bilance. Boerhaave, per esempio, pesò in successione una massa di ferro fredda, poi la stessa resa incandescente e infine resa nuovamente fredda, non trovando alcun cambiamento di peso. La sua conclusione sulla effettiva imponderabilità del fuoco fu criticata da Pieter van Musschenbroek (1692-1761), il quale sosteneva che la maggiore spinta idrostatica del ferro incandescente espanso avrebbe dovuto dar luogo a una riduzione apparente di peso; il fatto che Boerhaave non avesse trovato alcun cambiamento, ancora secondo Musschenbroek, stava a indicare che il 'fuoco' era realmente pesante, abbastanza, per l'appunto, da compensare l'aumento di spinta idrostatica della massa incandescente. Inoltre, Musschenbroek sosteneva che il fatto che i metalli aumentassero di peso quando erano sottoposti a calcinazione conduceva alla stessa conclusione; argomentazione, questa, che perse forza quando fu fatta una distinzione più netta tra l'assorbimento di un agente fisico come il calore e i cambiamenti chimici quali la perdita di flogisto, che si pensava fosse coinvolto nella calcinazione. Nei loro tentativi di pesare il calore, sperimentatori successivi, fra i quali John Whitehurst (1713-1788), provarono a prendere in considerazione le fonti di errore più ovvie, ottenendo ognuno risultati differenti; la maggior parte dei ricercatori fu portata quindi a credere che effettivamente il calore fosse privo di peso.

Le ricerche di Black sul calore latente influenzarono James Watt (1736-1819), che negli anni Sessanta del Settecento apportò notevoli miglioramenti al motore a vapore. Queste ricerche coincisero con una sorta di 'esplosione' dell'interesse dei chimici per i gas, a cui contribuì anche lo stesso Black. Ispirato dalle nuove idee, Lavoisier, il quale insieme a Pierre-Simon de Laplace (1749-1827) nei primi anni Ottanta del secolo eseguì una famosa serie di esperimenti di calorimetria, sviluppò la nozione secondo cui la vaporizzazione consisteva in una combinazione tra una sostanza qualsiasi e la materia del calore o calorico, come la denominò egli stesso; la quantità di calorico necessaria per tale processo ‒ cioè il calore latente ‒ dipendeva dalle affinità chimiche agenti tra questo fluido particolare e le differenti sostanze considerate. Inoltre, generalizzando il concetto, Lavoisier suppose che i gas fossero composti da una determinata sostanza e dal calorico e che quando un gas era coinvolto in una reazione chimica liberava il suo calorico, come avveniva nel caso dell'ossigeno gassoso coinvolto nelle reazioni di combustione e di calcinazione. Così come aveva usato la bilancia per pesare le diverse specie ponderabili di una reazione chimica, Lavoisier cercò di misurare anche l'imponderabile calorico, ma con il calorimetro.

Gli esperimenti di Black, di Wilcke e di coloro che li seguirono dipendevano in forte misura dalla disponibilità di termometri attendibili, lo sviluppo dei quali rappresentò un importante passo avanti nello sviluppo della fisica settecentesca. Non è facile però attribuire tale conquista a una persona in particolare; infatti, negli ultimi decenni del XVII sec. era già opinione comune che i cambiamenti di temperatura potessero essere misurati per mezzo dell'espansione o della contrazione di un fluido di riferimento. Per poter tradurre in pratica tale convinzione in modo da fornire determinazioni comparabili tra loro, per due o tre generazioni di ricercatori si rese necessario ottenere una certa familiarità con le variabili coinvolte. I fluidi termometrici preferiti erano lo spirito di vino (alcol etilico) e il mercurio, anche se alcuni ‒ in particolar modo Lambert ‒ continuavano a sostenere l'uso dell'aria (l'acqua fu scartata in seguito alla scoperta, avvenuta nel XVII sec., che con il raffreddamento il suo volume non decresceva regolarmente, ma raggiungeva il minimo a una temperatura leggermente superiore al punto di congelamento). Inoltre, le opinioni degli studiosi divergevano anche su come definire la scala termometrica; si discuteva se fosse necessario sceglierla arbitrariamente oppure determinando due punti fissi e dividendo in parti uguali l'intervallo tra essi, o, anche, fissando un solo punto fisso e stabilendo la scala sulla base di un proporzionato incremento o decremento del volume del fluido termometrico rispetto al suo volume nel punto fisso. Tra i sostenitori di queste ultime due alternative vi erano ulteriori disaccordi; nel caso si fosse scelta l'ipotesi dei due punti fissi, ci si chiedeva in quante unità andasse suddiviso l'intervallo, mentre, nel caso di un solo punto, il problema era stabilire quale variazione proporzionata del volume dovesse corrispondere all'unità di temperatura, e, infine, in quale verso dovessero andare i numeri. Durante i primi decenni del Settecento fu proposto un ampio numero di 'scale termometriche' differenti, molte delle quali continuarono a essere usate anche dopo la fine del secolo. Ai fini pratici, predominarono tre scale, cioè quelle associate ai nomi di Fahrenheit, di René-Antoine Ferchault de Réaumur (1683-1757) e di Anders Celsius (1701-1744); le loro rispettive storie ci consentono d'illustrare molto bene le problematiche scientifiche e tecniche in esse implicate.

All'incirca nel 1717, Fahrenheit iniziò a costruire ad Amsterdam termometri a scopo commerciale, alcuni dei quali erano a mercurio e altri a spirito di vino, anche se egli preferiva il primo. In una pubblicazione del 1724, apparsa in latino nelle "Philosophical Transactions" della Royal Society di Londra, egli dichiarò che per determinare la scala aveva usato tre punti fissi, cioè la temperatura di un miscuglio di ghiaccio, acqua e sale di ammonio o sale marino, quella di un miscuglio di ghiaccio e acqua e quella di un uomo in buona salute; a questi tre punti furono attribuiti i valori, rispettivamente, di 0°, 32° e 96°. Dato che la prima temperatura non era specificata con molta precisione, essa non permetteva di stabilire un punto ben fisso; sembra quindi probabile che Fahrenheit abbia usato essenzialmente gli altri due. Per mezzo di questa scala, egli misurò il punto di ebollizione dell'acqua a 212°, scoprendo inoltre che essa variava con la pressione; poco dopo la sua morte, il punto di ebollizione dell'acqua fu considerato come punto fisso superiore, al posto della temperatura corporea.

Réaumur, invece, per i suoi termometri usò lo spirito di vino e un solo punto fisso, stabilito al punto di congelamento dell'acqua, sebbene ciò avvenisse soltanto dopo aver dedicato molti sforzi per dimostrare che si trattava di un vero e proprio punto fisso. Egli prestò molta attenzione alla standardizzazione della diluizione dello spirito di vino adoperato e nei primi anni Trenta del Settecento scelse la diluizione che comportava un'espansione di 80 parti su 1000 quando la temperatura era innalzata dal punto di congelamento dell'acqua a quello in cui bolliva lo spirito di vino. In Francia le ricerche di Réaumur divennero quelle di riferimento ‒ anche perché le ricerche di Fahrenheit erano ancora sconosciute ‒ e la scala associata al suo nome fu rapidamente adottata come standard. Tuttavia la base sulla quale Réaumur l'aveva stabilita fu fraintesa sin dall'inizio (si pensò che la temperatura più alta a cui era ricorso fosse il punto di ebollizione dell'acqua e non quello dello spirito di vino del termometro) e ben presto dimenticata. Dunque, la scala di Réaumur fu definita considerando come punti fissi quelli di congelamento e di ebollizione dell'acqua, stabilendoli rispettivamente a 0° e 80°, e dividendo la scala di un termometro a mercurio (piuttosto che a spirito di vino) uniformemente tra questi due estremi.

Celsius, al pari di Fahrenheit, preferì adoperare il mercurio come fluido termometrico e considerò i punti di congelamento e di ebollizione dell'acqua quali punti fissi della sua scala termometrica (specificando attentamente la pressione a cui questi ultimi dovevano essere determinati) e stabilendoli però, rispettivamente, a 100° e 0°; solamente diversi anni dopo la sua morte la scala fu invertita nel modo in cui oggi ci è familiare.

Lo sviluppo di termometri a vetro-fluido attendibili era strettamente collegato allo studio dell'espansione delle diverse sostanze sottoposte a riscaldamento, dato che la divisione uniforme della scala del termometro dipendeva dall'ipotesi che il fluido termometrico si espandesse uniformemente con la temperatura, il che, però, non poteva essere semplicemente presupposto. Nel caso dell'acqua, infatti, si rivelò chiaramente falso e inoltre, alla fine, fu riconosciuto che l'espansione dello spirito di vino è significativamente non lineare. Rispetto a ciò si osservò che il mercurio era di gran lunga migliore e questa è una delle ragioni per cui fu progressivamente preferito, anche se ha un coefficiente di espansione minore. Uno studio esauriente sul problema fu pubblicato nel 1772 da Jean-André Deluc (1727-1817).

Elettricità

La nozione di 'materia sottile' (sia essa il fuoco o un'altra sostanza) associata con la materia ordinaria fornì il punto di partenza per spiegare il fenomeno dell'elettricità generata per strofinio (il fenomeno che oggi chiamiamo 'effetto triboelettrico' o 'triboelettricità'). Considerata inizialmente soltanto come un'attrazione (come quella esercitata sugli oggetti vicini dall'ambra o dal vetro strofinati) e conosciuta già dai tempi antichi, durante il XVIII sec. l'elettricità fu collegata a tutta una serie di effetti sorprendenti e straordinari.

Già a partire dagli ultimi anni del XVII sec., gli studiosi che avevano scritto sull'argomento concordavano sul fatto che l'attrazione elettrica fosse dovuta all'agitazione, provocata dallo strofinio, di una materia sottile che si trovava nei pori presenti nella struttura dei corpi ordinari ed era espulsa nello spazio circostante. Tale idea persistette per tutta la prima metà del XVIII sec., anche quando la gamma dei fenomeni da spiegare aumentò notevolmente. Tuttavia, dato che l'attrazione implicava un moto verso l'interno piuttosto che verso l'esterno, era chiaro che oltre all'espulsione della materia sottile dovesse essere implicato qualche altro fenomeno; a questo riguardo, però, le opinioni non erano concordi su che cosa esso fosse e anche sulla natura della materia sottile in gioco.

A cavallo fra i secc. XVII e XVIII, Francis Hauksbee (1666 ca.-1713), studiando il cosiddetto 'fosfòro mercuriale' ‒ un'incandescenza osservata sulla superficie del mercurio di un barometro scosso ‒ riconobbe che a questo fenomeno era associata una forza elettrica attrattiva, che egli attribuì all'attrito tra il mercurio agitato e la superficie interna del tubo del barometro. Inoltre, mediante esperimenti spettacolari e usando una sfera di vetro strofinata e montata su un supporto rotante, egli mostrò che, più in generale, l'elettrizzazione era legata all'emissione di luce, sotto forma sia d'incandescenza in una sfera strofinata priva d'aria, sia di scintille in una sfera riempita d'aria. Hauksbee rilevò che normalmente la tradizionale attrazione elettrica era seguita da una repulsione e che il vetro soltanto in apparenza era permeabile all'azione elettrica, in quanto un pezzo di vetro o di zolfo strofinati, messi vicini a una sfera di vetro, agivano sui fili sospesi all'interno di questa; inoltre, egli eseguì esperimenti che sembravano mostrare la direzione del flusso della materia sottile nello spazio circostante un corpo elettrizzato. Infatti, negli esperimenti di Hauksbee sembrava che si potessero toccare, vedere e udire gli effluvi elettrici che fluivano verso l'esterno dei corpi elettrizzati. Per spiegare l'attrazione di oggetti piccoli, egli fece ricorso all'elasticità dell'aria circostante, che, a suo parere, fluiva rapidamente a sostituire la materia sottile che si spostava verso l'esterno, portando con sé ogni oggetto leggero che si trovava sul suo cammino.

La questione divenne più complicata quando nel 1731 Stephen Gray (1666-1736) annunciò la sua scoperta che la forza di attrazione dell'elettricità poteva essere trasmessa a grandi distanze, sempre che il filo trasmettitore fosse fatto di materiale appropriato e fosse adeguatamente sostenuto. Gli esperimenti, ripetuti e sistematizzati da Dufay, condussero ad una ben definita distinzione tra materiali 'elettrici', che potevano essere elettrizzati mediante strofinio ma che non trasmettevano l'azione elettrica (oggi li chiamiamo 'dielettrici' o 'isolanti elettrici'), e quelli 'non elettrici', che non potevano essere elettrizzati per strofinio ma che trasmettevano l'effetto (oggi, 'conduttori elettrici'). Dal punto di vista fenomenologico la distinzione era fuori discussione, ma dal punto di vista concettuale era difficile conciliarla con le altrettanto evidenti dimostrazioni di Hauksbee, secondo le quali il vetro, cioè un 'elettrico', era permeabile all'azione elettrica.

Dufay, inoltre, annunciò un'altra differenza, ossia quella tra l'elettricità acquisita da sostanze come il vetro e quella acquisita da sostanze resinose; per esempio, i pezzi di carta attratti dal vetro strofinato, e poi respinti dopo il contatto, successivamente erano respinti anche da altri pezzi di vetro sottoposti a strofinio, ma erano attratti dalla resina strofinata, e viceversa. Tuttavia, l'idea che esistessero due tipi diversi di elettricità fu confutata da Jean-Antoine Nollet (1700-1770), il quale si appropriò della nomina, appartenente a Dufay, di 'primo elettricista di Francia', facendo dimenticare quasi completamente l'ipotesi dualistica per svariati anni. Secondo Nollet, infatti, gli esperimenti di Dufay si riferivano semplicemente a diversi gradi di elettrizzazione e non a diversi tipi di elettricità.

Nel frattempo, il meccanismo elettrico con la sfera rotante di Hauksbeee i suoi esperimenti erano diventati molto popolari nelle conferenze sempre più numerose che avevano per argomento la fisica sperimentale. Nei primi anni Quaranta del Settecento questo congegno, rafforzato e migliorato, fu capace di produrre effetti sempre più potenti. Le scintille ottenute ‒ a volte persino da blocchi di ghiaccio! ‒ erano usate per dare fuoco ad alcol e ad altre sostanze infiammabili. Tramite questi esperimenti molti studiosi, tra cui Nollet, si convinsero che la materia sottile coinvolta fosse il 'fuoco fluido' di Boerhaave presente in tutti i corpi o qualcosa di molto simile. A questo proposito, Nollet sviluppò un'elaborata dimostrazione che ottenne un vasto consenso; egli concepì flussi di 'materia del fuoco' turbolenta provenienti dai corpi elettrizzati, mentre altri flussi si spostavano verso l'interno per sostituire la materia fuoriuscita; i corpi erano attratti o respinti a seconda che si trovassero dove era più forte il flusso in entrata o quello in uscita; la maggiore concentrazione dei flussi uscenti vicino al corpo elettrizzato spiegava perché piccoli oggetti, che inizialmente erano attratti verso il corpo, erano poi respinti quando gli arrivavano abbastanza vicino. Inoltre, quando i flussi erano sufficientemente concentrati, le particelle componenti si scontravano, facendo aprire i loro involucri di 'materia sulfurea' e lasciando uscire la 'materia del fuoco' attiva in essi contenuta, creando così una scintilla. In conformità con il suo approccio generale sulla costruzione della teoria, Nollet insisteva nel sostenere che le premesse di base di questa in particolare, lungi dall'essere puramente ipotetiche, consistevano in evidenti dati di fatto; infatti, quando gli esperimenti erano eseguiti in una stanza oscura, si poteva effettivamente vedere la materia del fuoco fluire dagli oggetti fortemente elettrizzati.

Nel 1746 Musschenbroek annunciò al mondo il celebre 'esperimento di Leida': se una bottiglia contenente acqua era elettrizzata per mezzo di un conduttore che la collegava a un meccanismo generatore, un osservatore che toccasse contemporaneamente l'acqua (oppure il conduttore in essa immerso) e la superficie esterna della bottiglia riceveva una scossa terribile.

La scoperta di Musschenbroek ebbe un'inevitabile ripercussione sugli aspetti teorici del problema. L'effetto mostrato dalla bottiglia di Leida era così spettacolare da richiedere una spiegazione preliminare prima di giungere a formulare una qualunque teoria su di esso. Sfortunatamente per Nollet, mentre la natura del fenomeno veniva gradualmente chiarita, divenne altrettanto evidente come egli non fosse in grado di darne una spiegazione coerente. Benjamin Franklin (1706-1790), nel frattempo, in una serie di lettere inviate a Londra, fornì una spiegazione alternativa che riusciva a trattare in maniera relativamente soddisfacente l'esperimento della bottiglia di Leida, ignorando tuttavia, sin dall'inizio, i tradizionali problemi di attrazione e di repulsione di natura elettrica. Per tutti gli anni Cinquanta del Settecento vi furono accesi dibattiti sulle due tesi opposte, e in seguito fu accordato maggior favore alle teorie di Nollet, anche se con il tempo ne furono accettate altre basate sulle idee di Franklin. Anche queste partivano dal presupposto che la materia ordinaria fosse penetrata da una materia sottile elastica; questa, tuttavia, non era fatta corrispondere né al fuoco di Boerhaave né all'etere di Newton, ma era un fluido specificatamente elettrico. Franklin, inoltre, supponeva che in Natura qualunque tipo di materia ordinaria contenesse una data quantità di fluido elettrico e che il processo di 'elettrizzazione' consistesse nel trasferire materia sottile fra l'oggetto che effettuava lo strofinamento e quello che lo riceveva, in modo tale che uno dei due finisse per averne una quantità maggiore di quella che aveva normalmente e l'altro una minore, il che equivaleva a dire, secondo la terminologia di Franklin, che uno era elettrizzato 'più' e l'altro 'meno'. Mentre nella teoria di Nollet la grandezza fondamentale era il 'grado di elettrizzazione' di un corpo, in quella di Franklin un corpo poteva essere 'caricato' (ossia 'elettrizzato') sia positivamente sia negativamente; dopo essere venuto a conoscenza delle ricerche di Dufay, Franklin identificò la carica positiva con l''elettricità vetrosa' e quella negativa con l''elettricità resinosa'. Inoltre, avendo notato che determinati conduttori si scaricavano vicino ad altri oggetti, Franklin ideò un esperimento, eseguito per la prima volta con successo a Parigi nel maggio del 1752, per dimostrare che le nuvole dei temporali erano elettrizzate e i fulmini erano vere e proprie scariche elettriche. La sua conclusione secondo la quale l'installazione di determinati conduttori (parafulmini) sugli edifici li avrebbe protetti dai fulmini fu considerata una grande vittoria della mente umana sulla Natura e diede una credibilità molto maggiore alle sue idee sull'elettricità in generale.

Franklin concepì la sua teoria prima di conoscere l'esperimento di Leida; egli suggerì che il fluido elettrico fosse elastico, ossia composto di particelle che si respingevano reciprocamente, così come, secondo Newton, facevano le particelle dell'aria (o quelle dell'etere). Le particelle della materia elettrica erano fortemente attratte da quelle della materia ordinaria; quando nella bottiglia di Leida l'acqua si caricava di un eccesso di fluido elettrico, questo non poteva fuoriuscire dal vetro che, essendo un elettrico, risultava impenetrabile al fluido. Tuttavia, la forza repulsiva del fluido in eccedenza presente nell'acqua poteva agire attraverso il vetro ‒ in questo modo Franklin risolveva il vecchio dilemma sul ruolo del vetro negli esperimenti sull'elettricità ‒ e respingeva dalla superficie esterna della bottiglia parte del suo fluido naturale; la superficie esterna risultava quindi carica meno, mentre l'acqua e la superficie interna erano cariche più. Quando lo sperimentatore collegava le due superfici attraverso il suo corpo, provocava in sé stesso una scossa nel momento in cui il fluido in eccesso presente nell'acqua fluiva velocemente attraverso il suo corpo verso la superficie esterna, neutralizzando così le cariche opposte. In questo modo, la teoria era in grado di spiegare correttamente quando si sarebbe avuta una scossa e quando ciò non sarebbe avvenuto per un certo numero di situazioni sperimentali differenti.

Franklin non ebbe molto successo nel fornire alla sua teoria un coerente fondamento dinamico, o nello spiegare le attrazioni e le repulsioni elettriche, e ciò che poi divenne noto con il nome di 'induzione elettrostatica', ossia l'elettrizzazione di conduttori isolati mediante la sola vicinanza a un corpo carico, piuttosto che per contatto. Egli supponeva che, quando un corpo diventava carico più, il fluido elettrico acquisito in eccesso formava un'atmosfera intorno a esso, analoga all'atmosfera dell'aria elastica che circondava la Terra e che era mantenuta al suo posto dalla forza attrattiva della gravità; un corpo scarico, oppure uno carico meno, era attratto quando entrava nell'ambito di quest'atmosfera. Tuttavia, due corpi carichi più si sarebbero respinti quando fossero venute in contatto le loro atmosfere di materia mutuamente repulsiva. Allo stesso modo, quando l'atmosfera di un corpo carico era in contatto con la massa di fluido elettrico di un conduttore non elettrizzato, i due fluidi si sarebbero respinti dando luogo a vari fenomeni d'induzione. In seguito Franklin riconobbe che anche due corpi carichi meno si respingevano sebbene non fossero circondati da atmosfere, ma non fu capace di spiegarne la ragione. Inoltre, ci si poteva chiedere perché, quando due masse di fluido erano in contatto, esse avrebbero dovuto respingersi piuttosto che unirsi semplicemente a formarne una sola. Pur riconoscendo l'esistenza del problema, Franklin non poté far altro che affermare che le due masse dovevano rimanere separate.

Nel 1759 Franz Ulrich Theodosius Aepinus (1724-1802) pubblicò una versione interamente coerente della teoria di Franklin. All'inizio, le sue idee non riscossero molto successo, ma in seguito furono adottate dai maggiori ricercatori della generazione successiva; fra questi Alessandro Volta (1745-1827) e Charles-Augustin Coulomb (1736-1806), per merito dei quali le idee di Aepinus divennero parte integrante delle principali teorie sull'elettricità. Aepinus abbandonò la nozione di Franklin secondo la quale i moti di tipo elettrico erano dovuti a interazioni da contatto tra l'atmosfera di fluido elettrico circostante un corpo carico e altri fluidi oppure la materia dei corpi ordinari; egli, infatti, era a favore di una spiegazione che faceva interamente ricorso all'azione a distanza ed era espressa in termini semimatematici. Aepinus abbandonò del tutto il concetto di 'atmosfera elettrica' e, per rendere la sua teoria coerente, non soltanto ipotizzò che le particelle del fluido elettrico si respingessero l'una dall'altra, mentre invece erano attratte da quelle di materia ordinaria (come lo stesso Franklin aveva sostenuto), ma che anche queste ultime si respingessero mutuamente! Egli, inoltre, mostrò che, senza tali premesse, le forze invocate da Franklin avrebbero implicato che due corpi non carichi avrebbero esercitato tra loro un'attrazione elettrica. Partendo da ciò, e aggiungendo sistematicamente forze che agivano nelle situazioni più svariate, Aepinus riuscì a fornire soddisfacenti spiegazioni semiquantitative di un'ampia gamma di effetti d'induzione elettrica, tra cui la straordinaria forza della scarica emessa dalla bottiglia di Leida. Tuttavia, egli non cercò mai di dare una dimostrazione interamente matematica della teoria, perché non volle speculare sulla forma della legge secondo cui le forze elettriche variavano con la distanza, anche se sospettava che fossero inversamente proporzionali al quadrato della distanza. Molti rifiutarono l'idea di Aepinus circa l'esistenza di una forza repulsiva tra le particelle della materia ordinaria, considerandola in conflitto con la teoria gravitazionale di Newton ‒ qualcosa del genere la negò anche Aepinus stesso ‒; supposero invece che in realtà esistessero due fluidi elettrici i quali in condizioni normali si neutralizzavano a vicenda, ma che erano separati, o si separavano, durante il processo di elettrizzazione. Secondo questa teoria, l'ulteriore forza repulsiva di cui parlava Aepinus era attribuita al secondo flusso elettrico piuttosto che alla materia ordinaria, ma dal punto di vista pratico era letteralmente impossibile fare una distinzione tra le due teorie.

Magnetismo

Il XVIII sec. ereditò dal passato più informazioni sul magnetismo che sull'elettricità. Il magnetismo, infatti, oltre a possedere un interesse di tipo teorico, aveva anche, con la bussola magnetica, una grande importanza pratica per la navigazione marittima di lunga distanza, e ciò assicurava all'argomento l'attenzione costante dei circoli scientifici, nonostante le perplessità e le frustrazioni provocate dall'apparente mutevolezza del fenomeno.

Per secoli il magnetismo era stato considerato come un caso esemplare di forza occulta operante nel mondo. La costruzione, da parte di Descartes, di una teoria che riconduceva tutti i fenomeni magnetici ai movimenti e agli urti di particelle di materia rappresentò forse la maggiore conquista della filosofia meccanica e, come si è fatto notare precedentemente, gli elementi centrali di questa teoria continuarono a essere largamente accettati fino agli anni Settanta. In particolare, nonostante occasionali voci dissenzienti ‒ tra cui quella di Musschenbroek, che nella prima metà del Settecento divenne la principale autorità riguardo ai fenomeni del magnetismo ‒, la maggior parte degli studiosi concordava nel ritenere che il magnetismo si potesse spiegare per mezzo di flussi di materia sottile che passavano assialmente da un polo all'altro del magnete e poi ritornavano all'interno di questo attraverso l'aria circostante, creando così una circolazione continua. Si pensava che il percorso seguito dal flusso di materia nella regione di spazio esterna al magnete fosse rivelato dai tracciati formati dalla limatura di ferro spolverata su un foglio di carta tenuto sopra un magnete; si riteneva che all'interno di quest'ultimo i flussi passassero attraverso canali particolarmente adatti a riceverli, e ciò che caratterizzava i materiali magnetizzabili era proprio la capacità di formare tali canali. Inoltre, si credeva che i tracciati creati dalla limatura di ferro nelle vicinanze di un magnete derivassero dalla pressione esercitata dal flusso di materia magnetica sulle pareti interne dei canali e che, a sua volta, il magnete esercitava sulle particelle di limatura, forzando i canali a orientarsi nella direzione del flusso; in maniera analoga ciò avveniva anche rispetto all'orientamento dell'ago di una bussola sulla superficie della Terra, che‒ seguendo le idee di William Gilbert (1544-1603) ‒ si riteneva fosse un grande magnete sferico.

Per spiegare la natura polare di un magnete, bisognava scoprire un meccanismo mediante il quale i flussi potessero scorrere nei canali in una sola direzione; sulla scia delle idee di Descartes, si supponeva che i canali fossero foderati di piccole setole funzionanti come le valvole delle vene: si appiattivano per permettere al fluido di passare liberamente in un verso, ma s'increspavano per evitare che fluisse nel senso inverso. I poli non erano altro che i punti in cui i flussi entravano e uscivano dal magnete. Quando due magneti erano messi uno accanto all'altro con i poli uguali vicini, il flusso di materia magnetica che usciva da uno dei due, non potendo entrare nei canali dell'altro a causa delle setole, generava una pressione che separava i magneti. Al contrario, quando due poli diversi erano messi di fronte, il flusso di materia uscente da un magnete entrava facilmente nell'altro; ciò dava origine a una pressione ridotta dell'etere nella regione tra i due magneti, mentre la maggiore pressione che si trovava altrove spingeva i magneti uno contro l'altro, facendo sembrare che essi si attraessero reciprocamente.

Nell'ambito di questa teoria generale esistevano opinioni diverse su argomenti più specifici, quale, per esempio, il meccanismo che dava origine alla circolazione. Mentre la maggior parte degli studiosi riteneva che i vortici magnetici fossero composti da un tipo speciale di materia sottile, i fratelli Daniel Bernoulli (1700-1782) e Johann II Bernoulli (1710-1790), in un saggio del 1746, sostenevano che essi fossero della stessa materia eterea che si trovava distribuita ovunque e che si manifestava in molti altri fenomeni naturali. Inoltre, come Descartes, essi affermavano che, mentre in un magnete alcuni canali permettevano alla 'materia sottile' di circolare in un verso, altri ne consentivano il flusso in quello inverso, creando intorno al magnete due circolazioni opposte ma parallele. Questa descrizione rappresentò una complicazione che molti altri teorici rifiutarono in favore della circolazione in una sola direzione.

Nel 1728, osservando che le croci di ferro sulle guglie delle chiese si magnetizzavano, Dufay suppose che le setole dei canali presenti nel ferro fossero così grezze da prendere la direzione del proprio peso ogni volta che erano libere di farlo e le croci, dunque, si magnetizzavano semplicemente perché le setole s'inclinavano verso il basso, sotto il loro peso. Inoltre, essendo stato osservato che gli estremi inferiori delle croci diventavano sempre poli che si orientavano verso il Nord, Dufay dedusse (almeno così egli pensava) che il flusso della circolazione magnetica fosse interno al polo che si orienta a Sud ed esterno a quello che si orienta a Nord; in questo modo la teoria appariva più solida.

Trattando della forza di gravità, spesso Newton si era riferito al magnetismo come a un esempio già noto di forza che agiva a distanza tra corpi separati. Nella seconda edizione dei Principia (1713), egli fece allusione ad alcuni tentativi intrapresi per scoprire la legge secondo cui la forza magnetica variava con la distanza, concludendo che la forza esercitata da un magnete su un altro non dipendeva dal quadrato ma dal cubo della loro distanza. Ciò spinse altri studiosi a occuparsi del problema e, ancor prima che le osservazioni di Newton fossero pubblicate, i suoi seguaci Francis Hauksbee e Brook Taylor (1685-1731) lessero alcuni rapporti alla Royal Society di Londra sui tentativi vani di scoprire questa legge. Pochi anni dopo, Musschenbroek si occupò nuovamente della questione, sospendendo un piccolo magnete sferico a un braccio di una bilancia sopra un secondo magnete sferico a varie distanze attentamente misurate. Questi esperimenti ebbero ben poco successo e infine, nel 1725, Musschenbroek, come Taylor, arrivò alla conclusione pubblicata nello stesso anno nelle "Philosophical Transactions", che non esisteva "una proporzione tra le forze e le distanze". Il problema consisteva nel fatto che, analogamente al caso della gravitazione, tutti gli studiosi avevano misurato le forze tra magneti interi, ma lo avevano fatto a distanze dello stesso ordine di grandezza delle dimensioni dei magneti stessi: in tali circostanze, in effetti, non è possibile trovare alcuna legge generale.

Come è stato già affermato, le esigenze dei navigatori costituivano un forte stimolo a effettuare ricerche sui magneti. Infatti, nel 1701, in seguito a un viaggio nell'Oceano Atlantico, Edmond Halley (1656-1742) pubblicò una carta della regione sulla quale, per la prima volta, erano tracciate le linee di congiunzione (oggi dette 'isogone magnetiche') tra i punti in cui la 'variazione della bussola' ‒ l'angolo tra la direzione indicata dalla bussola e la direzione effettiva del Nord geografico, quello che oggi chiamiamo 'declinazione magnetica' ‒ aveva lo stesso valore. Egli sperava che ciò fosse utile ai naviganti, pur essendo consapevole che la declinazione magnetica in un determinato punto variava gradualmente; alcuni anni prima (1692), lo stesso Halley aveva pubblicato uno studio notevole in cui cercava di spiegare ciò supponendo che la Terra avesse due paia di poli magnetici, uno dei quali ruotava gradualmente rispetto all'altro. Dall'epoca di Halley in poi, con l'aumento delle esplorazioni in regioni sempre più lontane dall'Europa e ancora sconosciute, divenne una pratica abituale registrare il campo magnetico lungo il percorso. Mentre tali misurazioni furono sicuramente usate dagli studiosi immediatamente successivi, esse non erano abbastanza numerose da servire per la rappresentazione cartografica sistematica su scala mondiale delle isogone e, più tardi, delle 'isocline' ‒ cioè delle linee di uguale inclinazione della direzione del campo magnetico terrestre rispetto al piano orizzontale ‒ che ebbe grande diffusione nel XIX secolo.

Nei primi anni Quaranta del Settecento un altro inglese, Gowin Knight (1713-1772), escogitò un metodo per costruire magneti artificiali che consentivano di ottenere aghi di gran lunga migliori per le bussole magnetiche, ma, nonostante avesse reso nota la sua scoperta alla Royal Society, per ragioni commerciali dispose che il suo metodo rimanesse segreto. Ciò indusse altri ‒ come John Canton (1718-1772) e John Michell (1724-1793) in Inghilterra e Henri-Louis Duhamel du Monceau (1700-1782) e il syndic des tontines Antheaulme in Francia ‒ ad affrontare il problema, riuscendo a ottenere un considerevole successo. Essi idearono il cosiddetto 'metodo del doppio contatto', che consisteva nello strofinare il ferro da magnetizzare con un paio di poli magnetici opposti mantenuti a una distanza fissa l'uno dall'altro. Il metodo fu poi perfezionato da Aepinus il quale, inoltre, nel 1759 ne fornì un'analisi completa, basata sulla teoria del magnetismo da lui elaborata in maniera radicalmente nuova e analoga alla sua versione della teoria dell'elettricità di Franklin, ben presto largamente preferita alla vecchia idea delle circolazioni magnetiche. Aepinus suppose l'esistenza non soltanto di una 'materia elettrica sottile' ma anche di un 'fluido magnetico sottile', la cui redistribuzione dava luogo a cariche magnetiche positive e negative ‒ che egli identificò con i poli magnetici rispettivamente Nord e Sud ‒ e di conseguenza anche ai vari fenomeni associati ai magneti. Le particelle di questo fluido si respingevano reciprocamente ma erano attratte da quelle del ferro e di altri materiali ferrosi, che invece si respingevano l'un l'altra. Altri tipi di materia, al contrario, lasciavano passare liberamente il fluido senza esercitare alcuna azione su di esso. La teoria attribuiva maggiore importanza al concetto di 'poli magnetici', che diventarono la sede delle forze esercitate dai magneti e non i punti di entrata e di uscita della circolazione magnetica, consentendo così ad Aepinus di dare una spiegazione coerente di tutti i maggiori fenomeni magnetici. Anche in questo caso, e per le stesse ragioni riguardanti l'elettricità, molti di coloro che accettarono le idee di base della teoria ipotizzarono l'esistenza di due fluidi magnetici e non di uno solo. Di fronte a fenomeni quali l'apparizione di due nuovi poli opposti quando un magnete era spezzato in due, la maggior parte degli studiosi seguì la teoria di Coulomb, sostenendo che i magneti fisici erano composti di magneti di dimensioni molecolari e che le analisi di Aepinus si applicavano con maggior efficacia a questi ultimi; asserirono, inoltre, che il fluido o i fluidi magnetici potevano ridistribuirsi all'interno di una molecola secondo le formule di Aepinus, ma non potevano passare da una molecola all'altra.

Verso una fisica quantitativa

La fisica del XVIII sec. non era la scienza matematizzata che conosciamo oggi; la maggior parte delle ricerche sperimentali era del tutto qualitativa, come pure le teorie sviluppate per darne una spiegazione. Infatti, come osservò Aepinus per la teoria di Franklin sull'elettricità, anche quando apparve auspicabile riformulare le teorie in termini matematici, queste erano espresse in maniera così poco precisa che era necessario sottoporle a consistenti interventi correttivi. All'incirca a partire dagli anni Sessanta aumentò il numero di sperimentatori che intrapresero ricerche di tipo quantitativo; tuttavia, fu soltanto verso la fine del secolo che i matematici iniziarono ad applicare con successo alle problematiche della fisica sperimentale alcuni degli efficaci strumenti analitici sviluppati già in precedenza.

La trasformazione di un soggetto sperimentale qualitativo in uno pienamente matematizzato non era lineare e molti sperimentatori si opponevano attivamente all'uso della matematica nella fisica. Nollet, per esempio, nell'Oratio habita (1753), affermò che l'imprecisione era inseparabile dagli esperimenti: "È pericoloso ‒ sosteneva ‒ che un fisico sviluppi troppo gusto per la geometria", dato che in fisica "quasi mai si può avere precisione o assoluta certezza" (pp. 43-44); al contrario, egli sosteneva la necessità che "l'esattezza geometrica non disdegnasse di abbassarsi all'approssimazione, caratteristica ineluttabile della fisica sperimentale" (ibidem). Tale modo di pensare fu seguito per molti anni e, persino nei primi decenni del XIX sec., molti professori di fisica tedeschi sminuivano la formulazione dei fenomeni fisici in termini matematici, con il pretesto che la matematica tendeva ad allontanare gli studiosi dal loro campo di indagine.

Seguendo Newton, altri sperimentatori erano convinti dell'importanza di scoprire leggi empiriche quantitative, ma trovarono il compito non all'altezza delle loro aspettative. Musschenbroek, negli anni Venti del Settecento, profuse notevoli sforzi per riformulare la legge che governava la forza agente tra due magneti, ma alla fine fu costretto a rinunciarvi. Retrospettivamente, oggi possiamo osservare che egli stava misurando la cosa sbagliata, in quanto allora non possedeva una teoria su cui basarsi per studiare il caso in esame.

L'incremento del commercio di strumenti scientifici svolse un ruolo fondamentale nell'incoraggiare lo sviluppo della fisica sperimentale in genere e anche nel facilitare le sperimentazioni quantitative. In particolare, sotto la spinta delle richieste provenienti dall'astronomia, dalla navigazione e dalla geodesia, soprattutto il mercato londinese degli strumenti raggiunse alti livelli di precisione nella costruzione di scale lineari e angolari e degli apparati a cui esse erano associate. Le nuove tecniche erano strettamente collegate ai progressi della fisica e impressero in tal modo a questa disciplina un indirizzo sempre più pratico e funzionale. Abbiamo precedentemente menzionato le ricerche di Dollond sulle lenti acromatiche, come anche il metodo di Knight per costruire magneti artificiali che migliorò notevolmente la qualità delle bussole dei naviganti e stimolò nuove ricerche sui magneti; inoltre, sul mercato furono immessi strumenti per misurare la declinazione magnetica ('declinometri') e l'inclinazione magnetica ('inclinometri'), molto più raffinati di quelli usati in precedenza, che spinsero studiosi entusiasti a registrare sistematicamente le variazioni quotidiane del campo magnetico terrestre. Anche barometri e termometri perfezionati trovarono immediata applicazione nelle rilevazioni meteorologiche. Il legame tra lo sviluppo di termometri accurati e i progressi nello studio dei fenomeni termici chiarirono la distinzione tra la temperatura, misurata dai termometri, e la quantità di calore. Lo sviluppo della disciplina dedicata alla misurazione di quest'ultima grandezza, la 'calorimetria', richiedeva un'attenta osservazione delle perdite di calore degli apparati, che portò all'invenzione del calorimetro a ghiaccio di Lavoisier e Laplace. Nel caso dell'elettricità, il primo tentativo di lavoro quantitativo, realizzato usando un elettroscopio, fu effettuato negli anni Quaranta del Settecento, ma la quantità che si desiderava misurare, cioè il grado di elettrizzazione, non era ben collegata sul piano teorico alle misure ottenute. Più tardi, con l'adozione del concetto di 'carica elettrica', furono ideati strumenti più perfezionati per misurarla, ossia 'elettrometri' capaci, grazie all'incorporazione dell'elettroscopio condensatore inventato da Volta, d'individuare anche piccolissime quantità di elettricità. Questi strumenti ebbero un ruolo fondamentale nelle ricerche voltiane, che nel 1800 condussero lo scienziato italiano all'invenzione della 'pila elettrica' (oggi pila chimica), come sorgente di corrente elettrica continua. Tuttavia, per molto tempo non fu chiaro che cosa gli strumenti stessero misurando: se la carica o (per analogia con l'aria) la pressione o la tensione del fluido elettrico.

Più in generale, non era affatto evidente come poter stabilire una relazione matematica tra le variabili sperimentali. La crescente precisione che i nuovi strumenti permettevano di ottenere metteva in evidenza le variazioni tra le diverse misurazioni, ma pochi fisici del Settecento si preoccupavano di come affrontare queste discrepanze. L'idea dell'errore sperimentale, la rappresentazione grafica dei dati e l'applicazione di procedimenti statistici furono sviluppati molto più tardi. Nel frattempo, i ricercatori settecenteschi, riportando dati quantitativi, presentavano spesso acriticamente lunghe serie di cifre che erano il risultato dei loro calcoli numerici, oppure annunciavano conclusioni generali sulla base di un numero di prove estremamente ridotto.

Coloro i quali aspiravano a una matematizzazione delle teorie fisiche si trovarono di fronte anche ad altri problemi. Se qualcuno avesse provato a tradurre la teoria dei vortici circolanti del magnetismo in una teoria matematica, avrebbe scoperto che era impossibile, dato che la matematica applicata all'idrodinamica disponibile all'epoca non era all'altezza del compito. In modo analogo, lo scarso sviluppo della teoria ondulatoria nei mezzi fluidi costituiva un limite notevole per Euler nei suoi tentativi di matematizzare la teoria ondulatoria della luce. Spesso una teoria espressa qualitativamente non era adeguata a una formulazione in termini matematici; per esempio, la teoria di Franklin dell'elettricità, nonostante fosse riuscita a rendere comprensibile l'esperimento di Leida, non era sufficientemente coerente per sostenerne la matematizzazione. Solamente quando i principî di base di questa teoria furono chiariti e resi mutuamente coerenti da Aepinus, che talvolta si allontanò notevolmente dalle concezioni di Franklin, essa poté essere sottoposta a un trattamento matematico. Anche allora, dato che Aepinus non fu in grado di provare che la legge della forza tra cariche elettriche era espressa nella forma dell'inverso del quadrato delle distanze, non fu possibile spingersi oltre una formulazione semimatematica della teoria. Nel 1771, Henry Cavendish (1731-1810) fece avanzare leggermente il processo, ma lo sviluppo di una teoria integralmente matematica, come quella annunciata nel 1812 da Siméon-Denis Poisson (1781-1840), richiedeva, rispetto al livello raggiunto nei primi anni Settanta del Settecento, ulteriori progressi nell'analisi matematica oltre che nella sperimentazione elettrica quantitativa.

Esisteva dunque una serie di problemi sperimentali, concettuali e matematici collegati tra di loro, in grado di ostacolare il progresso verso una fisica basata sulla sperimentazione ma espressa matematicamente. I ricercatori del Settecento non erano tutti preparati ad affrontare questi problemi. Secondo i dettami della società di allora, non erano in molti ad avere conoscenze matematiche più che rudimentali e pochi matematici accettavano i limiti entro i quali avrebbero dovuto lavorare se le loro analisi fossero state utilizzate in fisica. Coloro che colmavano la lacuna ‒ come, per esempio, Aepinus ‒ difficilmente trovavano un pubblico interessato al loro lavoro; infatti gli sperimentatori pensavano che la matematica esulasse dalle loro conoscenze, mentre i matematici trovavano l'applicazione dei loro algoritmi talmente elementare da essere priva d'interesse. Nel caso di Aepinus, come si è visto, questo atteggiamento fece sì che la sua opera fosse pienamente compresa soltanto una generazione dopo la pubblicazione. Ancora alla fine del XVIII sec., nonostante il fatto che la meccanica razionale e la fisica sperimentale avessero stabilito regole metodologiche comuni generalmente accettate, esse restavano discipline nettamente separate: dunque, l'integrazione con successo di questi due campi scientifici di attività della fisica è il prodotto di un'epoca successiva.