L'Età dei Lumi: matematica. Lo sviluppo della teoria della probabilità e della statistica

L'Eta dei Lumi: matematica. Lo sviluppo della teoria della probabilita e della statistica

Lo sviluppo della teoria della probabilità e della statistica

I primi sviluppi del calcolo delle probabilità

La nascita della teoria della probabilità può essere fatta risalire al 1654, anno in cui Blaise Pascal e Pierre de Fermat, nel tentativo di risolvere problemi legati ai giochi d'azzardo (in particolare quello riguardante la divisione della posta nel momento in cui si interrompeva una serie di giocate), introdussero la nozione di guadagno atteso (ossia di valore atteso di una variabile casuale). Nel 1657 Christiaan Huygens pubblicò il primo trattato sulla probabilità, De ratiociniis in ludo aleae, nel quale il nuovo concetto era applicato a diversi giochi d'azzardo. I suoi scritti del 1669, che non furono resi noti prima della sua morte, comprendevano anche la soluzione di problemi stocastici relativi alla mortalità. In seguito, nel 1690, riprendendo Descartes, egli affermò che la scienza naturale forniva soltanto deduzioni moralmente certe, ossia altamente probabili.

La certezza morale e l'applicazione della probabilità statistica furono discusse nella letteratura filosofica e influenzarono Jakob I Bernoulli (1654-1705), che sarebbe stato uno dei fondatori della teoria della probabilità. Nel frattempo, William Petty (1623-1687) e John Graunt (1620-1674), intorno alla metà del secolo, creavano l''aritmetica politica', i cui problemi più importanti riguardavano la statistica delle popolazioni; pur disponendo di dati estremamente imprecisi, Graunt fu in grado di compilare la prima tavola di mortalità. Nel 1694 Edmond Halley (1656-1742) calcolò la seconda e molto più precisa tavola di mortalità. Newton si serviva di procedure stocastiche per correggere la cronologia degli antichi regni e, in un manoscritto redatto tra il 1664 e il 1666, concepì un semplice esperimento per dimostrare che la probabilità geometrica era in grado di trattare casi in cui le possibilità di successo erano legate a numeri irrazionali.

Il primo teorema del limite

Con il suo Ars conjectandi, pubblicato postumo nel 1713, Jakob I Bernoulli aprì nuove prospettive per il calcolo delle probabilità. Il trattato conteneva una ristampa di quello di Huygens con l'aggiunta di commenti essenziali, di uno studio dell'analisi combinatoria, di soluzioni di alcuni problemi legati ai giochi d'azzardo e di una parte incompleta in cui egli introduceva (senza però applicarla) la definizione teorica di probabilità, tentava di creare un calcolo delle proposizioni stocastiche e dimostrava il suo immortale teorema.

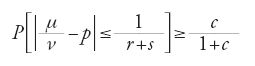

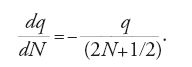

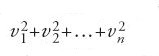

Presentiamo di seguito le linee essenziali della sua dimostrazione. Jakob Bernoulli prese in considerazione una serie di ν=(r+s)n prove indipendenti, in ciascuna delle quali l'evento studiato A si presentava con probabilità p=r/(r+s). Se il numero di tali esiti è μ, allora era possibile giungere alla dimostrazione che

dove c>0 era un numero arbitrario e ν≥8226+5758 logc. Ne seguiva che

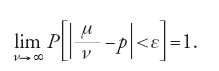

Bernoulli proponeva in questo modo la legge (debole) dei grandi numeri e stabiliva l'equivalenza tra la probabilità teorica p e la probabilità statistica μ/ν. Una volta effettuato un numero abbastanza grande di osservazioni, la seconda probabilità dava una certezza morale e non era quindi meno attendibile della prima. In pratica egli aveva cercato di scoprire se il limite [2] esistesse e se fosse realmente pari all'unità e non un numero positivo minore di 1. Quest'ultima eventualità avrebbe significato che l'induzione (dalle ν prove) era inferiore alla deduzione! Trovava quindi giustificazione, con il sostegno della probabilità teorica, l'applicazione del ragionamento stocastico ben oltre l'ambito ristretto dei giochi d'azzardo, almeno per quanto riguarda le 'prove di Bernoulli'.

Montmort

La pubblicazione nel 1708 del trattato sui giochi d'azzardo di Pierre Rémond de Montmort (1676-1719) influenzò certamente Abraham de Moivre. A differenza del primo tentativo di Huygens, il contributo di Montmort era costituito da un lungo libro ricco di soluzioni di problemi vecchi e nuovi. Uno dei problemi più antichi era quello che Galilei aveva risolto in un caso particolare per mezzo di semplici formule combinatorie: si trattava di determinare la probabilità di ottenere un punteggio pari a k lanciando n dadi, aventi ciascuno f facce (oppure aventi ciascuno un diverso numero di facce). A questo riguardo Montmort formulò il seguente enunciato oggi noto come 'formula dell'inclusione e dell'esclusione' (si veda la seconda edizione del suo libro del 1713). Data una serie di eventi A1, A2, …, An,

[3] P(∑Ai)=∑P(Ai)-∑P(AiAj )+∑P(AiAjAk)…,

dove i, j, k, … =1, 2, 3, …, n e i⟨j, i⟨ j⟨k, ecc. Questa formula costituisce un corollario stocastico dell'enunciato generale valido per insiemi A1, A2, …, An, tra loro sovrapposti in ogni modo possibile. In particolare, per f costante e uguale a 6, il problema appena formulato equivale a quello di determinare la probabilità che la somma di n variabili casuali tra loro indipendenti, che possono assumere con uguale probabilità i valori 1, 2, 3, 4, 5 e 6, sia uguale a k.

Montmort inserì nell'edizione del 1713 anche la sua corrispondenza di estrema importanza con Nikolaus I Bernoulli (1687-1759), un nipote di Jakob I Bernoulli; uno degli argomenti discussi in questa corrispondenza tra il 1711 e il 1713 riguardava un gioco di strategia, basato sia sul caso sia sulle decisioni prese. La teoria dei giochi di questo tipo è stata sviluppata soltanto nel XX secolo.

Abraham de Moivre

Abraham de Moivre (1667-1754) era un francese ugonotto. Da giovane aveva abbandonato il suo paese, per trasferirsi a Londra, a causa delle persecuzioni religiose. Nel 1697 divenne fellow della Royal Society, tuttavia era costretto a mantenersi facendo da tutore e da consulente per i giochi d'azzardo e per i servizi assicurativi.

Il principale contributo di de Moivre fu la sua The doctrine of chances (1718), dove, a partire dalla seconda edizione, inserì la propria dimostrazione del teorema del 'limite di de Moivre-Laplace' pubblicata privatamente nel 1733, ma completata, a suo dire, "almeno una dozzina di anni prima". La sua memoria del 1712, pubblicata prima dell'Ars conjectandi di Jakob I Bernoulli, può esserne considerata una versione preliminare. Fu qui che egli introdusse la definizione classica di probabilità di un evento casuale generalmente attribuita a Pierre-Simon de Laplace (1749-1827). La Doctrine era scritta per un lettore non matematico. In essa erano contenute soluzioni per molti problemi di gioco d'azzardo, anche se non erano trattati argomenti scientifici e mancava la dimostrazione di molti teoremi. Tuttavia il suo libro contiene scoperte molto importanti e sia Joseph-Louis Lagrange (1736-1813) sia Laplace ritennero opportuno tradurlo in francese.

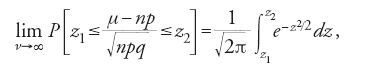

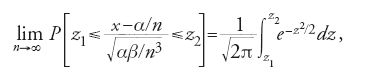

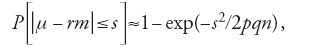

Per quanto riguarda il teorema di cui sopra, de Moivre, volendo determinare la legge che soggiace al numero di nascite dei due sessi, dimostrò che per n prove indipendenti in ciascuna delle quali l'evento studiato aveva probabilità p, il numero di 'successi' μ obbediva alla legge seguente:

dove q=1−p. Si noti che np=Eμ e npq=Dμ, ossia il valore atteso e la varianza di μ, concetto questo dovuto essenzialmente a Carl Friedrich Gauss (1777-1855). La convergenza prevista dalla [4] è uniforme rispetto a z1 e a z2, ma anche questa proprietà è stata introdotta e accertata nel XIX secolo.

Nel ricavare la sua espressione, de Moivre usò ampiamente lo sviluppo in serie di potenze di funzioni (trovando talvolta serie divergenti di cui calcolava la somma di parecchi termini).

In questo modo la distribuzione normale fece la sua comparsa. De Moivre dimostrò la [4] per il caso p=q (o a=b, per usare le sue notazioni), ma affermò correttamente che la sua formula poteva essere facilmente generalizzata al caso p≠q; inoltre, il titolo del suo studio conteneva le parole "sviluppo della binomiale (a+b)n". Tuttavia egli non fece notare che l'errore derivante dall'applicazione della sua approssimazione per valori finiti di n aumentava quanto più p (o q) si allontanavano dal valore 1/2, ovvero, in generale, non si occupò della rapidità di convergenza della [4].

Seguendo la tradizione newtoniana, de Moivre non usò il simbolo '∫' e, d'altra parte, la lingua inglese non era poi conosciuta diffusamente nel Continente; Laplace lo citò con ampia approvazione riferendosi alla formula [4], ma non fornì il riferimento esatto alla fonte e neppure formulò in modo chiaro i suoi risultati; così anche le fonti migliori e più pertinenti del XIX sec. descrissero solo superficialmente le sue scoperte. Non c'è quindi da stupirsi se per circa 150 anni quasi nessun autore del Continente si accorse del teorema di de Moivre. Nel 1812 Laplace dimostrò lo stesso teorema (donde il nome) utilizzando la formula di Maclaurin-Euler e introdusse un termine di correzione che teneva conto della finitezza del numero di prove.

I problemi di carattere scientifico spinsero in seguito gli studiosi a occuparsi di nuovi tipi di variabili casuali le cui leggi di distribuzione non coincidevano con quella binomiale di Jakob I Bernoulli e de Moivre. Tuttavia la convergenza delle somme di altre funzioni di queste variabili verso la distribuzione normale persisteva sotto condizioni molto generali e questo fatto costituisce l'essenza del teorema del limite centrale, la cui formulazione più semplice è data appunto dalla [4].

Bayes

Thomas Bayes (1701-1761) era un pastore presbiteriano. Per i suoi contributi matematici divenne fellow della Royal Society nel 1742. La sua memoria postuma fondamentale fu comunicata e presentata da Richard Price (1723-1791), anch'egli pastore presbiteriano e futuro fellow della Royal Society, nonché scrittore radicale, economista, filosofo e uno dei fondatori della scienza attuariale inglese.

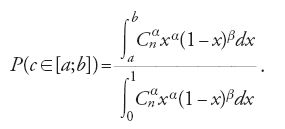

Il 'problema inverso di Bayes', come lo chiamò Price, era quello di determinare la probabilità teorica ignota di un evento a partire dalla sua probabilità statistica. I tratti essenziali del suo ragionamento sono i seguenti. Una palla cade α+β=n volte su un segmento AB di lunghezza unitaria, in modo tale che le sue posizioni su AB siano ugualmente probabili; preso su AB un punto c in modo completamente casuale, la palla cadrà α volte a sinistra di c (α 'successi') e β volte a destra di c (β 'insuccessi'); sapendo che la probabilità statistica del successo è α/n, si richiede di individuare la posizione del punto c. Per ogni intervallo [a;b] appartenente ad AB

Questa è la distribuzione a posteriori di c data la sua distribuzione uniforme a priori che rappresenta ciò che ignoriamo. La lettera x rappresenta l'incognita Ac che assume un nuovo valore per ogni prova successiva.

Attualmente noi sappiamo che

[6] P=Ib(α+1; β+1)-Ia(α+1; β+1),

dove I è il simbolo della funzione 'Beta' incompleta. Il denominatore della [5] (ossia la funzione 'Beta' completa moltiplicata per il fattore Cαn) era, come Bayes scoprì facilmente, la probabilità P=1/(n+1), ossia il numero α di successi considerati indipendentemente da Ac, per ogni valore ammissibile di α. Fino agli anni Trenta del XX sec. la stima del numeratore per grandi valori di α e di β risultò estremamente difficile e molti commentatori ritengono che Bayes non volle pubblicare la sua memoria perché considerava insufficienti i suoi tentativi in questa direzione.

In ogni caso, sembra che Bayes non fosse soddisfatto delle relazioni di passaggio al limite, dato che esse non erano applicabili al caso di valori finiti di n (così almeno asseriva Price riferendosi ai risultati di de Moivre). Tuttavia, come avrebbe dimostrato nel 1908 Heinrich Carl Franz Emil Timerding, i calcoli di Bayes avrebbero ottenuto come risultato l'espressione

dove α/n=Ex e αβ/n3=Dx.

È da notare il fatto che Bayes, il quale (come del resto de Moivre) non sapeva certamente nulla delle varianze, fu apparentemente in grado di accorgersi che, con una trasformazione formale ed elementare del primo membro della [4] del tipo

non avrebbe fornito la soluzione corretta del proprio problema.

In sostanza, il risultato principale di Bayes fu che tramite l'osservazione è possibile specificare la distribuzione (inizialmente nota solo superficialmente) di una variabile casuale. Infatti, anche se tutte le possibili posizioni di c su AB erano ritenute ugualmente probabili, le n prove portavano alla distribuzione [5].

Price fornì un esempio che presupponeva un'ignoranza iniziale completa: dopo aver osservato l'alba un milione di volte di seguito, qual è la probabilità della prossima alba? Secondo la formula [5] con a=1/2, b=1, α=106 e β=0, egli trovò che il rapporto tra i casi favorevoli e quelli sfavorevoli era la milionesima potenza di 2 su 1.

Come nel caso di de Moivre, i matematici continentali trovarono difficoltà a leggere la memoria di Bayes sia per la lingua inglese, sia per il mancato uso del simbolo di integrazione. Ma anche oggi è difficile seguire la sottigliezza del suo ragionamento.

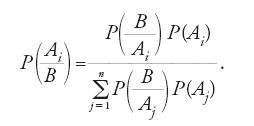

Siano P(Ai) le probabilità degli eventi incompatibili A1, A2, …, An, prima che si presenti l'evento B; supponiamo anche che B avvenga soltanto assieme a uno e solo uno degli Ai, dopo di che questi eventi assumono nuove probabilità. Si ha che

Questa è, come si dice oggi, la 'formula di Bayes' che tuttavia non appare nella sua memoria. Comunque sia, nel caso discreto, essa descrive anche la transizione da probabilità a priori a probabilità a posteriori. Fu Laplace, nello scritto Sur la probabilité des causes par les événements (1774), che la formulò, prima solo a parole e, in seguito, la dimostrò.

Laplace estese anche il metodo di Bayes trattando distribuzioni a priori non uniformi (Sur les approximations des formules qui sont fonctions de très grands nombres, 1785-1786). Senza citare Bayes, egli risolse inoltre problemi che portavano a espressioni del tipo della [5]. Il più noto è il calcolo della probabilità di un'alba già osservata α volte in precedenza. Nell'Essai philosophique sur les probabilités del 1814 egli affermò, ma non dimostrò, che tale probabilità era pari a (α+1)/(α+2). La sua spiegazione può essere trovata nelle iniziali memorie del 1774 e del 1781, nella prima delle quali egli affrontò il problema delle urne e nella seconda lo studio del rapporto tra il numero di maschi e di femmine alla nascita.

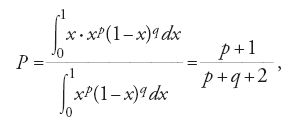

Il primo problema può essere posto nella maniera seguente: se un'urna contiene un numero infinito di palline nere e bianche, e una serie di estrazioni senza sostituzione produce p palline bianche e q nere, qual è la probabilità che la prossima pallina estratta sarà bianca? Se x rappresenta il rapporto ignoto tra le palline bianche e il numero totale di palline, allora il campione ottenuto ha probabilità xp(1−x)q; dato che tutti i valori di x dovrebbero essere considerati come egualmente probabili, la probabilità cercata sarà

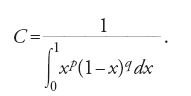

e quindi, se p=α e q=0, si ottiene la conclusione di cui sopra. Si noti che il risultato ottenuto coincide con il valore atteso di una variabile casuale con densità φ(x)=Cxp(1−x)q, dove

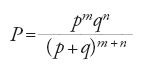

Volendo poi determinare la probabilità di estrarre m palline bianche e n nere nelle prossime (m+n) estrazioni (essendo m e n piccoli rispetto a p e a q), Laplace, effettuando questa volta calcoli approssimati, ottenne che

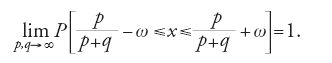

e sottolineò che tale risultato era in accordo (come avrebbe dovuto essere) con l'assunto che x≈p/(p+q). Infine, ancora nel 1774, Laplace dimostrò che, per un ω>0 arbitrario

Nel 1781 egli utilizzò questo risultato per affermare che, basandosi su un vasto insieme di dati statistici, il rapporto tra i sessi alla nascita avrebbe potuto essere calcolato con precisione arbitraria (una volta ammesso che esso rimanesse costante!).

La differenza tra i valori statistici e teorici di grandezze quali p/(p+q) avrebbe anche potuto essere stimata usando il teorema di de Moivre-Laplace; infatti, per p,q→∞, la probabilità di estrarre palline dei due colori resta costante anche quando esse non sono ricollocate dentro l'urna.

La statistica delle popolazioni

I padri dell''aritmetica politica' avevano buone ragioni per dubitare del fatto che studi quantitativi sulla popolazione fossero utili a qualcuno, se non agli alti ufficiali. Infatti i programmi sociali cominciarono ad apparire in Germania solo intorno al 1880; prima di ciò, i governi erano interessati esclusivamente ai contribuenti fiscali e agli uomini in grado di portare armi.

Il nuovo interesse verso la statistica delle popolazioni, legato allo studio del rapporto tra i sessi alla nascita, trasse origine e stimoli dal problema generale di distinguere la casualità dal progetto divino. Kepler e Newton avevano raggiunto tale obiettivo in riferimento alla natura inanimata e gli scienziati erano pronti a cercare le leggi che regolavano anche i cambiamenti nella popolazione.

Nel 1712, John Arbuthnot (1667-1735) notò che in ottantadue anni (dal 1629 al 1710) erano stati battezzati a Londra ogni anno più maschi che femmine. Ne dedusse che, se la probabilità di una nascita maschile fosse stata p=1/2, la probabilità del fatto osservato avrebbe dovuto essere pari a 2−82, ossia infinitesima. La sua conclusione fu che la predominanza di nascite maschili era dovuta a una legge divina che 'compensava' la relativamente più alta mortalità dei maschi.

La probabilità calcolata era in effetti insignificante, ma non più bassa di una qualsiasi altra distribuzione delle nascite nel corso di ottantadue anni. Se, infatti, m e f denotano un qualsiasi anno in cui sono battezzati rispettivamente più maschi e più femmine, allora, per esempio, la successione m, m, f, m, f, m, … avrebbe avuto la stessa probabilità pari a 2−82! Ancora oggi la distinzione tra successioni casuali e non casuali resta molto delicata, ma almeno la serie di Arbuthnot m, m, m, … non potrebbe essere attribuita al caso.

Tuttavia il ragionamento di Arbuthnot era debole. I battesimi non coincidevano con le nascite; i cristiani potevano avere comportamenti leggermente diversi dagli altri; per non parlare del fatto che la mortalità comparata tra i due sessi non era nota. Un punto da sottolineare è che Arbuthnot concepiva la casualità solo nel senso di uguaglianza della probabilità delle nascite maschili e femminili, laddove la presunta legge divina avrebbe potuto essere formulata in termini di una distribuzione binomiale generale con p>1/2.

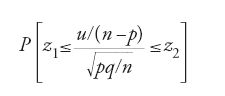

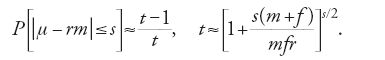

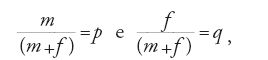

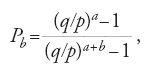

Le argomentazioni di Arbuthnot furono sviluppate da de Moivre e da Nikolaus I Bernoulli. Il risultato ottenuto da quest'ultimo è riportato in una lettera a Montmort: sia m/f il rapporto tra nascite maschili e nascite femminili registrate, n il numero totale annuale di nascite, μ il corrispondente numero di maschi e si ponga n/(m+f)=r. Si può allora dimostrare che, per s dell'ordine di √n,

Quindi t≈exp[s2(m+f)2/2mfn] e, se poniamo

ossia

Questa formula implica che Nikolaus I Bernoulli, almeno indirettamente (dato che non è presente nei suoi scritti), introdusse la legge normale come limite della distribuzione binomiale molto prima di de Moivre. Tuttavia, i suoi risultati non portavano a un teorema integrale del limite, dal momento che s doveva restare piccolo rispetto a n, né a un teorema locale.

Intorno alla metà del XVIII sec., Gottfried Achenwall (1719-1772) creò a Gottinga la scuola della Staatswissenschaft ('scienza dello Stato') il cui obiettivo era la descrizione del clima, della posizione geografica, della struttura economica e politica dei diversi Stati e la stima della popolazione tramite i dati relativi alle nascite e alle morti. Il divario tra l'aritmetica politica e la scienza dello Stato non era quindi così ampio come normalmente si crede; i manoscritti di Leibniz degli anni Ottanta del Seicento testimoniano per esempio che egli fu sia un aritmetico politico, sia uno tra i primi sostenitori della descrizione tabulare (con o senza l'uso di numeri) di un dato Stato. A partire dal XIX sec., la 'scienza dello Stato' decadde a causa dell'eterogeneità del suo oggetto di studio, mentre la statistica, così come la conosciamo, nacque più propriamente dall'aritmetica politica.

Il padre della statistica delle popolazioni fu Johann Peter Süssmilch (1707-1767). Questi raccolse una gran mole di dati sulle variazioni di popolazione, cercando di dimostrare che la Provvidenza divina era presente in tutti i campi delle statistiche sulla vita. Egli utilizzò il materiale a disposizione scorrettamente: considerò i dati relativi a città e a villaggi senza il calcolo delle medie pesate e non tenne conto delle differenze strutturali riguardanti le età per le popolazioni prese in esame. Nonostante ciò, le sue tavole di vita continuarono a essere usate ben oltre il 1800. Leonhard Euler (1707-1783) partecipò attivamente alla preparazione della seconda edizione (1765) della principale opera di Süssmilch, dal titolo Die göttliche Ordnung (L'ordine divino), e uno dei suoi capitoli è stato in parte ristampato nella sua Opera omnia. In seguito, Thomas Robert Malthus (1766-1834) adottò la tesi, contenuta in quell'opera, secondo la quale la popolazione cresce in proporzione geometrica.

Euler lasciò parecchi contributi sulla statistica delle popolazioni, ora contenuti nella sua Opera omnia. Non avendo a disposizione censimenti (nel senso moderno del termine), egli non fu in grado di riconoscere l'importanza di alcuni fattori demografici, ma introdusse concetti importanti, quali l'aumento di popolazione e il tempo di duplicazione. Egli portò a compimento la teoria matematica della mortalità, formulando alcune regole per fissare i premi delle assicurazioni sulla vita in tutte le loro forme.

Tra il 1766 e il 1771 Daniel Bernoulli (1700-1782) scrisse tre importanti contributi alla statistica delle popolazioni. Il primo prendeva in esame i benefici delle iniziali forme di 'vaiolizzazione', che erano allora le sole misure preventive contro tale malattia mortale (la vaccinazione di Jenner cominciò a diffondersi solo alla fine del secolo, mentre la vaiolizzazione era praticata sin dagli anni Venti del Settecento). Questa tecnica preventiva non era sicura: una piccola percentuale di coloro a cui venivano inoculati i germi di forme vaiolose non gravi morivano lo stesso e, per giunta, coloro che erano stati trattati diffondevano la malattia tra la popolazione. La memoria di Daniel Bernoulli fu il primo serio tentativo di studiare il fenomeno, anche se non servì a evitare il secondo dei pericoli sopra citati. In essa erano formulate ipotesi statistiche (necessariamente rozze) sulle epidemie di vaiolo ed era calcolato l'aumento medio della durata di vita prodotto dalla vaiolizzazione. Avendo egli concluso che tale aumento era pari a due anni, si dichiarò a favore del perseguimento di questa forma di prevenzione.

Jean-Baptiste Le Rond d'Alembert (1717-1783) sollevò ragionevoli obiezioni nel suo scritto Sur l'application du calcul des probabilités à l'inoculation de la petite vérole (1761). Non tutti sarebbero stati d'accordo nell'esporsi al rischio di una morte subitanea a fronte della prospettiva di vivere due anni di più. Si poneva anche il problema morale di inoculare i germi nei bambini. In sostanza egli sostenne la vaiolizzazione, ma considerò impossibile uno studio analitico del problema.

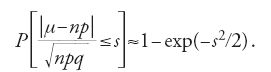

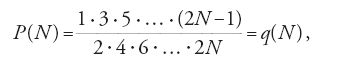

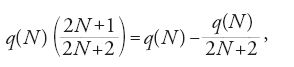

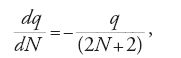

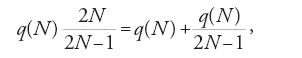

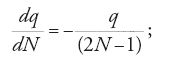

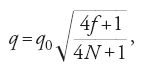

Nella seconda memoria Bernoulli studiò la durata dei matrimoni, un problema direttamente collegato a questioni assicurative. Il suo ragionamento si basava sulla soluzione, trovata nello stesso anno (1768), di un problema di estrazione da un'urna di sequenze di due colori diversi. La terza memoria fu invece dedicata al rapporto tra i sessi alla nascita. Supponendo che le nascite maschili e femminili fossero equiprobabili, egli calcolò la probabilità che m di 2N nuovi nati fossero di sesso maschile. Per m=N, ottenne

calcolando q non tramite la formula di Wallis, né per mezzo del teorema locale di de Moivre-Laplace, ma applicando, con un suo tipico procedimento, le seguenti equazioni differenziali:

e, 'in media'

La soluzione fu da lui scritta nella forma seguente

in cui, ponendo q0=q(12), si otteneva una risposta abbastanza precisa.

Usando ancora lo stesso metodo, invece dei risultati di de Moivre, Bernoulli scoprì che, per μ dell'ordine di √N,

[25] P(m=N±μ)=q exp(-μ2/N) .

Egli quindi generalizzò il suo risultato al caso in cui le probabilità delle nascite maschili e femminili fossero diverse tra loro e, basandosi su alcuni dati statistici, confrontò tra loro due possibili valori del rapporto tra i sessi senza però effettuare una scelta definita.

Una caratteristica particolare della sua memoria è che, per μ che va da 0 a 47, la probabilità totale [25] era pari a 1/2. Essendo il suo calcolo basato su una semplice somma, invece che su un'integrazione, egli non riuscì a ottenere direttamente il teorema integrale [4] di de Moivre-Laplace.

Nel 1772, Johann Heinrich Lambert (1728-1777) proseguì il lavoro di Daniel Bernoulli sulla statistica delle popolazioni. Egli propose una legge empirica per la mortalità, prese in esame il numero di bambini nelle famiglie ed estese in qualche misura la memoria di Bernoulli sul vaiolo considerando la mortalità infantile dovuta a questa malattia. Nel trattare il secondo degli argomenti suddetti, Lambert aumentò di un fattore 1/2 il numero di bambini, in maniera tale da tener conto dei nati morti e della mortalità infantile. Questo tasso di crescita era arbitrario, ma almeno costituiva un tentativo di liberare i dati da un errore sistematico grossolano. Di fatto, insieme a Daniel Bernoulli ed Euler, egli stava ponendo le basi metodologiche della demografia matematica.

La vita civile: aspetti morali ed economici

L'idea di applicare la probabilità alla vita civile e a questioni morali ed economiche fu di Jakob I Bernoulli, ma questi non ebbe il tempo di sviluppare adeguatamente tale progetto e di ottenere risultati significativi. D'altra parte, l'origine della teoria della probabilità si deve allo studio di un aspetto della vita civile, ossia ai giochi d'azzardo, che presentava problemi le cui soluzioni sarebbero poi state applicate alle scienze naturali e avrebbero dato vita a nuovi strumenti matematici utilizzabili anche nel calcolo delle probabilità.

Nel 1709, Nikolaus I Bernoulli pubblicò un saggio sull'applicazione dell'"arte della congettura" alla giurisprudenza che in parte riportava quanto Jakob I Bernoulli aveva scritto nel suo libro allora inedito, pubblicato postumo nel 1713, e nelle sue Meditationes (ossia i suoi diari), scritte non per essere pubblicate. Anche se Nikolaus I Bernoulli citò più volte lo zio, la sua scorrettezza non può essere scusata.

Egli raccomandò l'uso delle stime di longevità e guadagno (o perdita) medi per calcolare vitalizi, assicurazioni marittime, premi di lotterie e nel decidere quando una persona scomparsa doveva essere considerata morta. Sia lui, sia Jakob I Bernoulli, riguardo a quest'ultimo problema, avevano di fatto gli strumenti per confrontare tra loro in modo appropriato le diverse probabilità. Certamente la mentalità era molto cambiata da quando Kepler si era correttamente, ma semplicisticamente, rifiutato di pronunciarsi sull'eventualità che una persona scomparsa fosse viva o morta.

Riguardo al problema della mortalità (e quindi delle assicurazioni sulla vita), Nikolaus I Bernoulli introdusse di fatto il primo esempio di distribuzione uniforme continua nella storia del calcolo delle probabilità. Le assicurazioni sulla vita ispirarono, a partire dal 1725, importanti ricerche teoriche a opera di de Moivre e di Thomas Simpson (1710-1761). Anche se le società assicurative risalgono all'inizio del XVIII sec., solamente verso la metà del XIX sec. un'attività più o meno onesta, basata sulle statistiche relative alla mortalità, soppiantò gli atteggiamenti fraudolenti. Inoltre, anche se i governi cominciarono a pagare alcuni tipi di pensione addirittura a partire dal XVII sec., il loro calcolo era ampiamente indipendente dai dati sulla mortalità.

Le analisi stocastiche delle decisioni giudiziarie e delle procedure di voto nelle assemblee e per le elezioni generali cominciarono alla fine del XVIII sec., anche se molti scienziati avrebbero successivamente negato la possibilità di trattare numericamente questo tipo di eventi. Così John Stuart Mill affermò che la probabilità, applicata alla giurisprudenza, era "il vero obbrobrio dei matematici" e Jules-Henri Poincaré aggiunse che nelle corti di giustizia la gente si comportava come i "moutons de Panurge".

Era quindi problematico trovare la risposta a domande su come determinare il numero ottimale di giurati, o la maggioranza ottimale dei loro voti, affinché si riducesse al minimo la possibilità di una decisione sbagliata; oppure calcolare la probabilità di un fatto straordinario eventualmente osservato da un testimone. Marie-Jean-Antoine-Nicolas Caritat de Condorcet (1743-1794) studiò questi problemi ‒ e questioni analoghe ‒ senza grande successo. Innanzitutto, infatti, era difficile seguire la sua trattazione e, in secondo luogo, egli non fu esplicito nel dichiarare che il suo era un semplice tentativo e che voleva soltanto mostrare ciò che ci si sarebbe potuti aspettare nel caso ideale in cui le decisioni fossero prive di condizionamenti. In ogni caso, egli sottolineò il fatto che gli 'uomini' avrebbero dovuto essere colti e privi di pregiudizi. Questa tesi fu sostenuta anche da Laplace, il quale dichiarò che i rappresentanti della nazione avrebbero dovuto far parte di una élite composta da uomini colti, abituati a ragionare in modo rigoroso e indipendente.

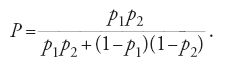

Riguardo al problema degli eventi straordinari, Condorcet propose una formula semplice (che può essere ricondotta allo studio sugli eventi stocastici di Jakob I Bernoulli contenuto nella sua Ars conjectandi e che fu usata anche da Laplace nel 1812). Se le probabilità di un evento di per sé e della veridicità del suo resoconto sono p1 e p2, allora l'evento assume una probabilità pari a

Tuttavia, questa formula è difficilmente applicabile. Infatti, per p1=10−4 e p2=0,99, P≈10−2 e quindi l'evento sarebbe stato difficilmente preso in considerazione da una corte, a meno di non trovare un secondo testimone.

Le applicazioni morali della probabilità ebbero comunque il merito di sottolineare l'importanza della statistica criminale e furono quindi utili nelle valutazioni di possibili cambiamenti nell'ordine stabilito dei procedimenti legali. Come Gauss osservò correttamente nel 1841, questi studi, anche se condotti in modo appropriato, non avrebbero avuto alcuna utilità nei casi individuali, ma avrebbero potuto fornire indicazioni al giudice per determinare il numero di testimoni e di giurati.

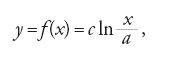

Le applicazioni della probabilità all'economia ebbero inizio con uno studio di Daniel Bernoulli del 1738. Nel cercare di risolvere il paradosso di Pietroburgo (v. oltre), egli suppose che il vantaggio y di un giocatore era legato al suo guadagno x dalla seguente equazione differenziale (che rappresenta verosimilmente la prima equazione differenziale usata nella teoria della probabilità):

con c>0, da cui

dove a era la fortuna iniziale del giocatore. Quindi Bernoulli suggerì che il valore atteso morale del guadagno, ossia ∑pif(xi)/∑pi, doveva essere preferito al valore atteso matematico ∑pixi/∑pi (essendo pi le probabilità dei rispettivi possibili guadagni). La distinzione tra guadagno e vantaggio non solo gli consentì di risolvere il paradosso (come avremo occasione di illustrare), ma anche di osservare che, in base alla sua idea, una partita condotta con correttezza diviene alla lunga svantaggiosa per entrambi i giocatori.

Il termine moral expectation fu introdotto da Gabriel Cramer (1704-1752) che aveva esposto idee simili in una lettera a Nikolaus I Bernoulli del 1732 di cui lo stesso Daniel Bernoulli pubblicò un passo. In seguito quest'ultimo applicò il concetto di valore atteso morale allo studio del trasporto navale, giungendo alla conclusione (del resto in accordo con il senso comune) che era vantaggioso trasportare le merci su numerose navi (questa affermazione fu poi dimostrata da Laplace). Il valore atteso morale iniziò a diffondersi nelle opere teoriche e Laplace gli attribuì l'aggettivo 'matematico'. Oggi tale termine è ancora utilizzato nella letteratura russa. Nel 1888, Joseph-Louis-François Bertrand dichiarò che la teoria del valore atteso morale, pur essendo diventata un classico, era tuttavia inutile. In ogni caso, gli economisti, basandosi sulla feconda idea di Daniel Bernoulli, stavano già sviluppando la teoria dell'utilità marginale.

La teoria degli errori

Il problema principale e la sua soluzione

Si supponga che m grandezze incognite x, y, z, … siano legate da un sistema ridondante di n equazioni fisicamente indipendenti (m⟨n):

[29] aix+biy+ciz+…+si=0,

i cui coefficienti sono dedotti da una teoria appropriata e i termini liberi misurati. I valori approssimati di x, y, z, … erano in genere noti, donde la linearità della [29]. Le equazioni sono linearmente indipendenti (una nozione, questa, più tarda), sicché il sistema è contraddittorio. Tuttavia occorreva sceglierne una soluzione, e questo era fatto in modo tale che i termini liberi noti (chiamiamoli vi) fossero abbastanza piccoli.

Considerando il caso di misure dirette (m=1), il problema è quello di determinare il valore 'migliore' di una costante non nota x (in questo caso ai=1), dopo averne misurato i valori s1, s2, …, sn. La scelta della media aritmetica appare scontata e sembra che questa fosse la regola generale almeno fino all'inizio del XVII secolo. In realtà, è probabile che gli astronomi dell'Antichità trattassero le loro osservazioni con una certa arbitrarietà (in questo senso anche l'astronomia non poteva essere ancora definita una scienza quantitativa). Tuttavia, l'assenza di regole stabilite può essere giustificata dalla grandezza degli errori di osservazione. Per esempio, per 'cattive' distribuzioni degli errori, la media aritmetica non è, dal punto di vista stocastico, certo migliore (anzi a volte è peggiore) di una singola osservazione. Roger Cotes (1682-1716) fu il primo ad asserire (in una pubblicazione postuma del 1722) che si sarebbe dovuto scegliere la media aritmetica, ma egli non giustificò tale consiglio, né lo formulò chiaramente.

Nel 1826, Jean-Baptiste-Joseph Fourier (1768-1830) definì il "vero oggetto dello studio" il limite della media aritmetica di n osservazioni per n→∞, e molti autori successivi, indipendentemente l'uno dall'altro e senza menzionare Fourier, introdussero la stessa definizione per il "valore vero".

Il problema classico che portò al sistema [29] fu quello relativo alla determinazione della forma della Terra. Da quando Newton aveva affermato che, dal punto di vista teorico, il nostro pianeta doveva essere un ellissoide di rotazione con il raggio equatoriale a più grande del raggio polare b, furono fatti molti tentativi per confermare (o falsificare) questa ipotesi teorica. Per determinare a e b, sarebbero state sufficienti in linea di principio due misure di arco meridiano; in pratica ne servivano molte di più, dati gli inevitabili errori delle misure geodetiche e astronomiche (nonché le deviazioni locali dalla forma generale del pianeta).

Sia detto, per inciso, che attualmente i valori accettati sono a=6378,1 km e b=6356,8 km. Il fatto che 2π×6356,8=39.941 (valore vicino a 40.000) non è casuale: nel 1791 il metro fu definito come un quarto del meridiano di Parigi diviso per 107. Questo standard 'naturale' di lunghezza sopravvisse fino al 1872, quando fu sostituito dal 'metro campione', una barra di platino custodita negli archivi. A partire dal 1960 il metro è definito in termini di lunghezza d'onda. L'introduzione del sistema metrico, assieme a questioni di carattere puramente astronomico, avevano nel frattempo richiesto nuove osservazioni, sicché il sistema [29] avrebbe dovuto essere risolto ancora di volta in volta, proprio nel momento in cui, a partire dalla metà del XIX sec., la fisica e la chimica cominciarono a porre le loro domande.

Dall'inizio del XIX sec., la condizione imposta normalmente per risolvere il sistema [29] era quella 'dei minimi quadrati': la somma

doveva assumere un valore minimo. Prima di allora erano stati impiegati diversi metodi; per esempio, per m=2, i sistemi erano spezzati in tutti i possibili sottosistemi di due equazioni, per poi calcolare il valore medio delle soluzioni trovate per ciascun sottosistema. Come si scoprì nel XIX sec., la soluzione basata sul metodo dei minimi quadrati equivaleva in effetti a una media pesata delle stesse soluzioni parziali.

Il secondo metodo importante per trattare il sistema [29], escogitato da Ruggero Giuseppe Boscovich (1711-1787), consisteva nell'applicare le condizioni:

[30] v1+v2+…+vn=0,

[31] ∣v1∣+∣v2∣+…+∣vn∣=min.

Ora, la [30] poteva essere evitata sommando tutte le equazioni del sistema [29] ed eliminando un'incognita. In questo modo, come Gauss osservò nel 1809, la [31] portava esattamente agli m residui dello zero vi, il che segue da un importante teorema nella teoria, allora non ancora nota, della programmazione lineare. In altri termini, avendo imposto la restrizione [30], restano da risolvere solo (m−1) delle n equazioni, anche se rimane aperto il problema di sceglierle in maniera adeguata. Il criterio adottato da Boscovich nel tentativo di elaborare le misure dell'arco di meridiano fu di carattere geometrico. Questo metodo fu ripetutamente applicato da Laplace per lo stesso scopo nel secondo volume del Traité de mécanique céleste (1799).

Una condizione particolare per risolvere il sistema [29] era quella di porre ∣vmax∣=min, ossia di applicare il principio del 'minimax'. È possibile che Kepler abbia fatto la sua celebre affermazione sull'impossibilità di far tornare le osservazioni con il sistema tolemaico dopo aver tentato di applicare globalmente tale principio. Nel 1749, Euler ottenne qualche successo con una sua forma rudimentale. Il principio non si basa su considerazioni stocastiche, ma trova la sua collocazione nella teoria delle decisioni e Laplace, infatti, affermò chiaramente che esso era adatto per controllare le ipotesi e non per trattare i dati osservativi.

Thomas Simpson

Torniamo alla trattazione delle osservazioni dirette. Nel 1756, Thomas Simpson dimostrò che, almeno in qualche occasione, la media aritmetica era più vantaggiosa di una singola osservazione. Per il caso discreto egli prese in considerazione sia la distribuzione uniforme sia quella triangolare. Dopo aver calcolato l'errore sulla media, egli raccomandò di adottarla come stimatore del 'valore vero' della grandezza cercata. In questo modo Simpson estendeva considerazioni di tipo stocastico a un nuovo dominio, introducendo gli errori osservativi casuali i quali assumevano diversi valori a cui erano assegnate le rispettive probabilità. Il suo strumento matematico era la funzione generatrice, introdotta da de Moivre nel 1730 per calcolare le probabilità di ottenere un determinato numero di punti lanciando un certo numero di dadi. De Moivre aveva pubblicato la soluzione del problema nel 1712, un po' prima di Montmort, che aveva usato un metodo diverso.

Riguardo allo stesso argomento, facendo senza dubbio riferimento a de Moivre, Simpson riportò gli stessi calcoli nel 1740, sottolineando l'analogia tra i due problemi. Si consideri, per esempio, la sua distribuzione triangolare con errori pari a

[32] -v, …,-2,-1, 0, 1, 2…, v,

aventi probabilità proporzionali a 1, …, (v−2), (v−1), v, (v−1), (v−2), … 1. La funzione 'generatrice' di Simpson era in questo caso

[33] f (r)=r-v+2r-v+1+…+(v+1)r0+…+2rv-1+rv

e la probabilità che la somma di t errori fosse uguale a m era rappresentata dal coefficiente di rm in f t(r).

Nel 1757 Simpson proseguì la sua ricerca sulla distribuzione triangolare continua introducendo un cambiamento di scala: gli intervalli tra interi della [32] erano ora fatti tendere a zero in modo tale che fosse possibile considerare il segmento [−v;v] come formato da un numero infinitamente grande di questi intervalli e la distribuzione come definita su un insieme continuo. Nel 1776 Lagrange estese il procedimento di Simpson ad altre distribuzioni (di rilevanza puramente accademica). In questo modo egli introdusse le trasformazioni integrali riuscendo ad applicare le funzioni generatrici alle distribuzioni continue e ottenne altri risultati generali.

Johann Heinrich Lambert

Sia φ(x;x0), dove x0 è un parametro incognito, la densità di distribuzione di n errori osservativi indipendenti x1,x2, …, xn; ne deriva che il valore del prodotto

[34] φ(x1;x0)φ(x2;x0)…φ(xn;x0)

corrisponde alla probabilità di trovare tali errori. Il massimo della [34] fornirà dunque il 'miglior' valore di x0. Si supponga ora, come sempre avviene nella teoria classica degli errori, che la densità sia φ(x−x0), ossia una curva con un singolo picco (valore modale) nel punto x=x0. La determinazione del valore vero del parametro si traduce allora nel calcolo del valore più probabile di x0. Quello di ricavare parametri incogniti presenti in leggi di densità divenne un problema centrale della statistica e il principio di massima verosimiglianza (ossia della massimizzazione del prodotto [34]) ne fornì una possibile soluzione.

Lambert fu il primo a formulare nel 1760 il principio di massima verosimiglianza per densità unimodali. Di fatto egli stava analizzando uno degli aspetti più delicati del trattamento delle osservazioni sperimentali. Egli ritornò sull'argomento nei suoi Anmerkungen und Zusätze zur practischen Geometrie (Osservazioni e aggiunte sulla geometria pratica) del 1765, questa volta nel tentativo di determinare, basandosi sul principio di ragione insufficiente, la legge di densità relativa al puntamento di uno strumento geodetico e di stimare numericamente la precisione di tali osservazioni. Alla fine del XIX sec. il principio ora ricordato fu applicato per giustificare l'esistenza dei "casi ugualmente possibili" che comparivano nella formulazione della nozione di probabilità: anche Poincaré si occupò di questa delicata questione. In realtà la sola nozione di valore atteso, se non considerata in termini di concetto astratto (quale realmente è) può difficilmente essere interpretata diversamente da "ragione insufficiente". Lambert inoltre diede una definizione della Theorie der Fehler (Teoria degli errori), includendo nel suo campo di applicazione le analisi sia stocastiche sia deterministiche degli errori. La locuzione 'teoria degli errori' fu poi adottata da Friedrich Wilhelm Bessel (1784-1846) e, anche se non fu mai usata da Laplace e da Gauss, divenne di moda verso la metà del XIX secolo.

Un esempio classico del versante deterministico della teoria degli errori è costituito dalla soluzione da parte di Cotes di ventotto problemi che riguardano le connessioni reciproche tra i differenziali di diversi elementi di triangoli piani e di triangoli sferici. In questo modo diventava possibile calcolare l'effetto degli errori osservativi sui lati di triangoli sferici misurati indirettamente.

Daniel Bernoulli

Nel 1778, Daniel Bernoulli rifiutò la media aritmetica e, senza citare Lambert, cominciò a sostenere la validità del principio di massima verosimiglianza. Prendendo come legge di densità degli errori osservativi una curva di secondo grado ed esaminando solo il caso di tre osservazioni, egli ottenne un'equazione algebrica di quinto grado in x*, lo stimatore del valore cercato. Il lavoro di Bernoulli fu commentato da Euler, che sollevò obiezioni ragionevoli al principio di massima verosimiglianza. Seguendo lo stesso procedimento di Bernoulli, senza però interpretarlo correttamente, Euler ricavò un'equazione cubica in x*, notando che essa corrispondeva al valore massimale della somma dei quadrati dei pesi delle osservazioni. Trascurando i termini più piccoli della somma, la sua condizione diventava

[35] (x*-x1)2+(x*-x2)2+…+(x*-xn)2=min,

che portava alla media aritmetica, ancora piena di vita! Dal punto di vista euristico, la [35] ricorda la condizione dei minimi quadrati (nel caso m=1, infatti, i minimi quadrati portano alla stessa media). Inoltre, Gauss, nella sua formulazione definitiva di questo famoso metodo, lo ricavò nel 1823 dal principio di massimo peso, che può essere, sempre dal punto di vista euristico, messo in relazione con la condizione [35] di Euler.

Infine, nel 1780, Bernoulli si rivolse al periodo di oscillazione del pendolo. Basandosi sulla sua memoria precedente, egli applicò la formula [25], ossia la legge normale, al calcolo dell'errore nella misura del tempo accumulato nell'arco di 24 ore. A questo scopo egli isolò gli errori casuali (momentanearum), la cui influenza era proporzionale alla radice quadrata dell'intervallo temporale appropriato, da quelli sistematici (chronicarum), che erano all'incirca costanti. Questa distinzione sopravvive tuttora, anche se con una diversa definizione.

Pierre-Simon de Laplace

Il principale risultato ottenuto da Laplace nella teoria degli errori appartiene al XIX secolo. Prima egli aveva pubblicato qualcosa in proposito in due memorie (Sur la probabilité, 1774, e Sur les probabilités, 1781), che possono essere considerate interessanti dal punto di vista moderno, ma sono scarsamente utili dal punto di vista pratico, dato che in esse si discutevano curve di densità meramente accademiche introdotte senza giustificazione. Nel 1781, Laplace già presentava la sua condizione principale per trattare le osservazioni dirette: la somma degli errori da 'temere' (à craindre), moltiplicati per le loro probabilità (ossia il valore atteso dell'errore) deve essere minima. Nel XIX sec., egli applicò lo stesso principio per dare sostegno al metodo dei minimi quadrati, che era utilizzabile solo nel caso della distribuzione normale (giustificata dalla sua dimostrazione non rigorosa del teorema del limite centrale nel caso in cui il numero di osservazioni è abbastanza grande).

Sempre nel 1781 Laplace propose come curva di densità φ(αx)=0, x=∞; φ(αx)=q≠0, x≠∞, α→0, con una scelta che anticipa la funzione δ di Dirac. In ogni caso una delle sue conclusioni era basata sulla considerazione dell'integrale di

[36] φ[α(x-x1)]φ[α(x-x2)]…φ[α(x-xn)]

(dove le xi, i=1,…, n, sono i dati osservativi), che non ha alcun significato nel linguaggio delle funzioni generalizzate.

A partire dai propri esordi la teoria degli errori fu parte integrante di quella della probabilità; tuttavia i principî su cui si basava il trattamento dei dati osservativi (di massima verosimiglianza, di minimo valore atteso assoluto, dei minimi quadrati) furono poi incorporati nella statistica.

Il determinismo di Laplace

Secondo la famosa massima di Laplace, per un'intelligenza onnisciente "nulla sarebbe incerto e il futuro, così come il passato, sarebbe davanti ai suoi occhi" (Essai philosophique sur les probabilités, ed. Dale, p. 2). Egli non diceva quindi che non è possibile conoscere esattamente le condizioni iniziali, né ovviamente poteva confrontarsi con le idee moderne sulla impredicibilità (o il caos) in meccanica.

Sin dall'inizio della carriera, Laplace rifiutava la casualità ("il caso in sé […] non ha alcuna realtà") e sottolineava anche che "la grande maggioranza dei fenomeni" può essere studiata solo in maniera probabilistica, attribuendo la nascita della "scienza del caso o delle probabilità" alla debolezza della mente. La causa reale dell'origine della probabilità era l'esistenza di leggi stocastiche che determinavano il comportamento di somme (o altre funzioni) di variabili aleatorie; ossia, in altri termini, la relazione dialettica tra l'aleatorietà di un singolo evento e la necessità presentata da un grande numero di fenomeni casuali. Si tratta di ciò che è normalmente chiamato 'determinismo statistico'.

Nel 1819, Laplace segnalò che le entrate provenienti dalla lotteria di Francia erano stabili ed osservò che lo stesso valeva per il numero di lettere rinviate al mittente in un anno (Leçons de mathématiques données à l'École normale en 1795, 1812). Pochi sanno che la più nota affermazione di Lambert-Adolphe-Jacques Quételet (1796-1874) sulla stabilità dei numeri relativi alla 'statistica morale' (dei matrimoni, suicidi, crimini) di fatto si riferiva a una stabilità all'interno di condizioni sociali costanti.

È opportuno sottolineare che nessuno ha mai affermato che la filosofia di Laplace aveva ostacolato i suoi studi astronomici e di statistica delle popolazioni (basata, come si è detto in precedenza, su un'analisi stocastica delle osservazioni). Egli riconobbe la casualità allorché si trovò a discutere le eccentricità delle orbite planetarie e le altre piccole deviazioni da "una perfetta regolarità". Inoltre, la fede nel determinismo e il riconoscimento della casualità oggettiva non ebbero inizio con Laplace. Kepler denunciava l'aleatorietà come un abuso nei confronti di Dio e tuttavia era costretto a spiegare le eccentricità attribuendole a fattori casuali. Presumibilmente, Laplace, come Immanuel Kant (1724-1804), trasse tale visione da Kepler, o anche da Newton, quando questi nell'Opticks, diceva che la "meravigliosa uniformità delle orbite planetarie" era accompagnata da "irregolarità imprevedibili […] che possono essere state originate dalle azioni reciproche delle comete e dei pianeti" (Opera, IV, p. 262). Infine, Laplace potrebbe aver trovato la sua affermazione sull'intelligenza onnisciente in scritti precedenti.

Alcuni problemi notevoli

La rovina del giocatore

Due giocatori, A e B, giocano d'azzardo fra loro finché uno dei due non è rovinato. Le domande che si possono porre sono del tipo: quanto a lungo devono giocare? Qual è la probabilità che A (o B) sia rovinato? E sarà rovinato in non più di n partite? Nella sua forma più semplice il problema fu introdotto da Huygens che lo risolse col metodo dell'induzione incompleta. Supponiamo ora che A possieda un numero di fiches pari ad a, che la probabilità che egli vinca sia p, mentre le rispettive quantità per B siano b e q (p+q=1). Sia Pa la probabilità che A perda tutte le sue fiches prima di vincere tutte quelle che appartengono a B e Pan quella che tale evento rovinoso avvenga in non più di n partite (le rispettive quantità per B siano Pb e Pbn). L'intero svolgimento del gioco può essere rappresentato come movimento di un punto C lungo un segmento formato da (a+b) unità, da b unità sulla sinistra fino ad a unità sulla destra. Dopo ogni partita, C 'salta' a sinistra con la probabilità p o a destra con la probabilità q: la partita finisce quando C raggiunge uno dei due estremi del segmento. Il 'cammino' di C tra questi estremi sarà 'casuale'; tale tipo di cammino può essere immaginato anche in uno spazio tridimensionale ed è un modello approssimato della diffusione e del moto browniano.

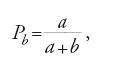

Il problema fu trattato più volte da Jakob I Bernoulli o in maniera incompleta (come Huygens) o lasciando la dimostrazione al lettore. La dimostrazione della formula si deve a de Moivre che la ottenne nel 1712 con un ragionamento ingegnoso. Egli stabilì che

per p≠q, e

per p=q.

Egli formulò anche alcune regole per calcolare sia la probabilità (Pan+Pbn) che il gioco terminasse entro n partite, sia le probabilità Pan e Pbn separatamente, considerando anche il caso a=∞. Nel 1718 de Moivre ampliò le sue ricerche, fornendo la soluzione di altri problemi, ma senza giustificare i risultati. Le sue ultime scoperte sono importanti soprattutto per il nuovo metodo su cui si basavano, il metodo delle successioni ricorrenti (o delle equazioni alle differenze).

Laplace discusse il problema della rovina del giocatore in diverse memorie. Nelle sue Recherches sur l'intégration des équations différentielles aux différences finies et sur leur application à l'analyse des hasards (1776) lo risolse per mezzo di equazioni a differenze parziali finite anche per il caso di tre giocatori. Lagrange dedicò l'ultimo paragrafo della sua memoria del 1777 su queste equazioni alla loro applicazione nella teoria della probabilità, risolvendo numerosi problemi connessi in particolare a quello della rovina del giocatore.

Il paradosso di Pietroburgo

Il paradosso si riferisce a un gioco inventato da Nikolaus I Bernoulli e descritto in una lettera a Montmort del 1713. A dà a B uno scudo se ottiene 6 al primo lancio di un dado; egli promette inoltre di dargli 2, 4, 8, … scudi, se il 6 appare al secondo, terzo, quarto, … lancio. Si tratta di sapere il valore aspettato E del guadagno di B. Lo stesso problema si pone in sostanza sostituendo il dado con una moneta. In questo caso

[39] E=1∙1/2+2∙1/4+4∙1/8+…=∞,

anche se nessun uomo ragionevole avrebbe scommesso una somma seppur modesta.

Questo importante paradosso è stato discusso fino ai giorni nostri. I suoi aspetti peculiari sono diversi: in primo luogo esso introduce una variabile con valore atteso infinito, quindi suggerisce agli studiosi di sottolineare che una bassa probabilità di guadagno (P≤α, α>0) dovrebbe essere considerata come nulla (e quindi solo pochi termini della serie infinita [39] dovrebbero essere presi in considerazione). Ma, qual è il valore massimale di α? E se ci ponessimo la stessa domanda per le probabilità P≥1−α di perdita? Non c'è alcuna risposta: tutto dipende da circostanze che sono al di fuori del dominio della matematica. Nel 1777 Georges-Louis Leclerc de Buffon (1707-1788) propose il valore α=1/10.000 (pari alla probabilità che una persona in buona salute di 56 anni morisse nell'arco delle successive 24 ore), che sembrava intuitivamente accettabile, ma era troppo basso e non fu mai realmente adottato come stima universale (si ricordi il concetto di 'certezza morale' introdotto da Descartes e Huygens e poi ripreso da Jakob I Bernoulli).

La questione spinse Daniel Bernoulli a introdurre il 'valore atteso morale' che gli consentì di risolvere il paradosso eliminando la divergenza della [39]. Il suo contributo fu pubblicato in un periodico della Academia Scientiarum Imperialis Petropolitana (Accademia Imperiale delle Scienze di Pietroburgo) e per questo il paradosso ebbe tale nome. Esso fornì anche il pretesto per uno dei primi esperimenti statistici su vasta scala: Buffon, sempre nel contributo del 1777, portò a compimento una serie di 2048 partite di Pietroburgo. La posta media pagata per partita risultò essere solo 4,9 e il numero massimo di lanci in una partita fu 9, il che avvenne solo in sei casi. Un approccio più idoneo al paradosso fu escogitato da Condorcet e, in seguito, da Sylvestre-François Lacroix (1765-1843): essi sostennero che una partita che può durare all'infinito rappresenta solo un singolo evento casuale, sicché solo una media su molte partite può dare indicazioni ragionevoli. Questa indicazione è stata ripresa da Hans Freudenthal che nel 1951 ha studiato una serie di partite di Pietroburgo con giocatori che si alternavano a caso in ciascuna di esse.

L'esperimento di Buffon era un esempio di sequenza di eventi casuali che avevano tutti la stessa probabilità di successo. Montmort testimoniò che i giocatori erano inclini a trarre conclusioni sbagliate dal modo di presentarsi delle sequenze in una serie di giochi d'azzardo indipendenti. Attualmente le sequenze sono usate per distinguere tra caso e regolarità. Supponiamo che una certa dimensione di una delle parti di una serie di macchine sia un po' più grande rispetto allo standard; che probabilità c'è che qualcosa vada male? Importanti problemi relativi alle sequenze furono risolti da de Moivre. Nel 1767 Euler affrontò problemi simili, legati alle lotterie, con un semplice approccio combinatorio. John Dalton (1766-1844) fece uso di considerazioni elementari per verificare se ci fosse una relazione tra il bel tempo e le aurore boreali. Analoghi studi meteorologici continuarono nel XIX sec. a opera di Quételet e Wladimir Peter Koeppen.

Il modello di Ehrenfest

Nel 1811 Laplace affrontò un particolare problema legato alle estrazioni da urne. L'equazione differenziale alle derivate parziali che ne ricavò era notevole di per sé, ma il problema sarebbe diventato estremamente importante per la fisica; basti dire che esso era identico al famoso modello di Ehrenfest del 1907. Il problema era stato formulato da Daniel Bernoulli il quale, come si è visto, voleva dimostrare l'utilità delle equazioni differenziali nella teoria della probabilità. Nella formulazione del 1770 fu presentato come segue: nell'urna A vi sono n palline bianche e nell'urna B n palline nere. Una pallina viene estratta da A e posta in B e viceversa. Si richiede di trovare il numero (medio) x di palline bianche in A dopo r operazioni cicliche del tipo descritto. Bernoulli generalizzò il problema al caso di tre urne con palline di tre colori diversi e risolse entrambe le versioni tramite un sistema di equazioni differenziali. Egli mise inoltre in evidenza l'esistenza di un caso limite, ossia lo stesso numero (medio) di palline di ciascun colore in tutte le urne. Attualmente tale risultato può essere dimostrato servendosi di un teorema relativo alle catene di Markov omogenee.

Nel 1777, Lagrange risolse il problema analogo per un qualsiasi numero finito di urne e palline di due colori, servendosi di equazioni alle differenze parziali finite. Laplace diede un'interpretazione poetica dei problemi di questo tipo: "Questi risultati possono essere estesi a tutte le combinazioni che si presentano naturalmente allorché le forze costanti che animano i vari elementi finiscono per assumere configurazioni regolari tali da far emergere, all'interno del caos, sistemi […] governati da leggi armoniose" (Essai philosophique, ed. Dale, p. 42). Tuttavia è difficile scoprire le sue 'forze costanti', sicché Joseph-Louis-François Bertrand, un autore successivo, espresse il concetto con parole migliori: "Il caso alla fine corregge i suoi capricci". In effetti, egli collegò la propria osservazione soltanto all'azione della legge dei grandi numeri; in questo caso, minore è il numero relativo di palline bianche in un'urna, meno probabile diventa la loro successiva estrazione.

La statistica matematica

La differenza tra teoria della probabilità e statistica consiste nel fatto che la prima è deduttiva mentre la seconda (eccetto la sua parte teorica) è induttiva e concerne il prendere decisioni in base a conclusioni tratte da dati quantitativi. La statistica matematica è nata nel XX sec. e il termine stesso non era praticamente mai stato usato prima della sua introduzione nel 1850 da parte di Carl Gustav Adolph Knies. Tuttavia i problemi legati all'inferenza induttiva sono molto più antichi: persino gli studiosi e i legislatori dell'Antichità, basandosi su dati numerici, cercavano di distinguere tra causalità e casualità, per esempio, tra le morti derivanti da un'epidemia che si stava diffondendo e quelle 'normali'. A partire dalle ricerche di Petty e di Graunt precedentemente ricordate, calcoli approssimativi di probabilità statistiche cominciarono a essere effettuati per stimare popolazioni, così come era di carattere induttivo l'approccio di Arbuthnot al problema del sesso dei nuovi nati. Il principale obiettivo della Doctrine of chances di de Moivre, come dichiarò egli stesso, era la scelta tra la casualità e il progetto.

Alla ricerca della possibilità di determinare statisticamente la probabilità di un evento casuale, Bayes aprì un intero capitolo della statistica matematica. Per Laplace, la probabilità divenne lo strumento decisivo per scoprire le leggi della Natura (mai egli fece riferimento al 'progetto divino'). Così, dopo aver stabilito in base alle osservazioni che l'esistenza di una certa grandezza astronomica era altamente probabile, egli sentiva il dovere di indagare sulle sue cause e quindi di provarne la realtà. Numerose pagine del suo classico Théorie analytique des probabilités (1812) possono essere ora considerate come contenenti argomenti di statistica, dato che si basavano sulle sue prime memorie, dove egli parlava già di "un nuovo genere di problema" e addirittura di "una nuova branca [nouvelle branche] della teoria delle probabilità". L'espressione nouvelle branche era certamente dovuta a Lagrange, che la usò in una lettera a Laplace del 13 gennaio del 1775 per denotare il modo in cui quest'ultimo aveva stimato una certa probabilità.

Un'osservazione fatta da Laplace nel 1812 può essere ricollegata con la simulazione statistica attuale. Egli estendeva uno studio di Buffon, prima annunciato in un riassunto anonimo del 1735, poi pubblicato nel 1777. Un ago di lunghezza 2r cade su un fascio di rette parallele; Buffon stimò che la probabilità che esso intersechi una retta è p=4r/πa, dove a è la distanza tra due rette adiacenti; Laplace quindi osservò che da un gran numero di tali esperimenti poteva essere dedotto il valore di π. Si noti che Buffon aveva tacitamente fatto uso della probabilità geometrica.

Un'affermazione curiosa ed errata fatta dall'astronomo William Herschel (1738-1822) mostra che la statistica era talvolta considerata più potente di quanto in realtà fosse. Egli sosteneva, in Astronomical observations and experiments tending to investigate the local arrangement of celestial bodies in space (1817), che una qualsiasi stella, "scelta in modo promiscuo" (promiscuously chosen) in un insieme di 14.000 stelle appartenenti a una delle prime sette classi di magnitudine, non "sarebbe stata verosimilmente diversa di molto da una certa dimensione media di tutte le stelle" (The scientific papers, p. 579). A differenza degli errori osservativi, le stelle (di natura fisica diversa) potevano non appartenere a una sola popolazione statistica. Infatti, solo nel caso degli errori potremmo stimare (applicando il successivo teorema di Bienaymé e Chebyshev) le deviazioni dei valori possibili di una variabile casuale dalla loro media.

La teoria dei campioni è un capitolo della statistica, ma la pratica dei campionamenti risale in Inghilterra almeno al XIII sec. per saggiare le nuove coniature. Per molti anni Herschel cercò di contare le stelle nel cielo. In un suo lavoro del 1784 egli notava che in una sezione della Via Lattea il loro numero era così grande da costringerlo a limitarsi a contare le stelle solo in sei zone promiscuously chosen, ovvero ad applicare il principio del campionamento. Egli contò anche le stelle nella parte "più vuota", per cercare di trovare il limite inferiore della sua stima del numero totale di stelle in quella zona. In assenza di censimenti, Laplace impiegò la tecnica dei campioni per calcolare il numero M di abitanti della Francia. Conoscendo la popolazione m di una piccola parte del paese (scelta come campione), il numero annuale di nascite n in quella regione e nell'intera Francia (N) e assumendo che il rapporto tra il numero di nascite e il numero di abitanti fosse costante, egli concluse che M=Nm/n. Successivamente Laplace applicò le formule ottenute nei precedenti lavori per stimare le deviazioni possibili di questo rapporto dal suo valore statistico. Nel 1928 Karl Pearson avrebbe sollevato la ragionevole obiezione che il modello a urna, usato da Laplace in questo caso, non era adeguato e che i suoi importanti calcoli approssimati non erano esatti. Tuttavia, Laplace fu il primo a studiare gli errori delle tecniche di campionamento, laddove il suo metodo di calcolo (basato sulla funzione B incompleta) non fu ulteriormente perfezionato per più di un secolo (a parte i tentativi fatti da Bayes).

Conclusioni

Lo sviluppo della teoria della probabilità incontrò una certa opposizione. Leibniz, nella sua corrispondenza con Jakob I Bernoulli, negava che la probabilità statistica potesse essere messa sullo stesso piano della sua controparte teorica. Egli sosteneva che la prima dipendeva da un'infinità di circostanze e che non poteva essere determinata in base a un numero finito di osservazioni. Bernoulli, tuttavia, osservava che ciò valeva anche per la seconda, dato che comportava spesso la necessità di calcolare rapporti tra quantità infinite (riferendosi presumibilmente alla frequenza di successi in una serie di prove di Bernoulli). Anche se più tardi Leibniz cambiò opinione, in una lettera del 1714 egli dichiarava senza alcuna giustificazione che Bernoulli aveva "coltivato" la probabilità "in seguito alle mie esortazioni".

De Moivre affermò che "vi sono scrittori, certo di una classe diversa da quella di Jakob Bernoulli, i quali insinuano che la dottrina delle probabilità non dovrebbe trovare posto in un'indagine seria", ossia che il suo studio è "banale e facile" e "piuttosto squalifica un uomo dal ragionare su qualsiasi altro argomento" (The doctrine of chances, ed. 1756, p. 254). Simpson, nel 1756, definì lo scopo della sua memoria sulla media aritmetica come quello di confutare "talune persone, di prestigio considerevole, che […] anche pubblicamente sostenevano che una singola osservazione, presa con la dovuta attenzione, era altrettanto affidabile quanto la media di un gran numero di esse" (On the advantage of taking the mean of a number of observations in practical astronomy, p. 82). In effetti, può darsi che gli scienziati persistessero nella credenza di Robert Boyle che "gli esperimenti devono essere considerati in base al loro valore e non al loro numero" (A physico-chymical essay, ed. 1772, p. 376). Tuttavia, i due approcci potevano essere complementari piuttosto che in contraddizione tra loro.

Il maggiore imputato fu tuttavia d'Alembert (il quale peraltro non aveva seguito i progressi della probabilità). Nel 1754 e ancora nel 1765 egli affermava che la probabilità di lanciare successivamente due teste era di 1/3 piuttosto che di 1/4. Egli credeva anche che dopo una successione di parecchie teste, l'evento 'croce' fosse più probabile, aggravando questo errore con un appello a determinare le probabilità in modo statistico (il che avrebbe dimostrato l'insostenibilità della sua affermazione). Infine, nel 1768, egli non era in grado di capire come mai la durata media e quella probabile della vita non coincidessero.

Euler, in una lettera a Gerhard Friedrich Müller (1705-1783) del 7 giugno 1763 (27 maggio nel calendario russo) citava la "insopportabile arroganza" di d'Alembert, dicendo che questi aveva tentato di "difendere senza la minima vergogna tutti i suoi errori". Ma quest'ultima affermazione non si riferisce soltanto alle osservazioni sulla probabilità; essa piuttosto testimonia dell'invadenza di d'Alembert in campi a lui estranei: "il medico più degno di essere consultato è quello che crede di meno nella medicina" (d'Alembert, Essai sur les élémens de philosophie, in Oeuvres, p. 167). Tuttavia d'Alembert espose anche idee ragionevoli. Egli osservò, dopo Buffon, che le piccole probabilità di guadagno avrebbero dovuto essere trascurate, notando che i benefici della vaiolizzazione dovessero essere riconsiderati.

Il nuovo secolo cominciò con la pubblicazione nel 1812 da parte di Laplace della sua Théorie. In quest'opera egli ripropose tutte le memorie sull'argomento (comprese quelle scritte tra il 1809 e il 1811), ma non riuscì a collocarle in un quadro coerente. È vero che egli applicò sempre, ove possibile, il teorema del limite di Laplace-de Moivre, tuttavia non introdusse, nemmeno a livello euristico, il concetto di variabile casuale e quindi non analizzò distintamente densità o funzioni caratteristiche.La sua teoria della probabilità apparteneva ancora alla matematica applicata e non ammetteva la possibilità di ulteriori sviluppi.

Ma che cosa si era ottenuto fino al 1801? Erano stati dimostrati i primi teoremi del limite; erano state introdotte e applicate le funzioni generatrici e le equazioni alle differenze parziali finite; gli integrali erano stati approssimati da metodi nuovi e più complicati. Lo studio dei giochi d'azzardo diede luogo a sviluppi importanti, che in futuro sarebbero stati applicati alle scienze della Natura o all'economia. Anche se la probabilità cominciò a essere ampiamente utilizzata nella statistica delle popolazioni, nell'elaborazione dei dati osservativi e anche in giurisprudenza, le scienze naturali non davano ancora un grande contributo a questa disciplina. Continuavano a essere risolti caso per caso problemi che in realtà appartenevano alla statistica matematica, finché non maturarono le condizioni che consentirono a Gauss di sviluppare il metodo dei minimi quadrati.