La grande scienza. Epidemiologia

La grande scienza. Epidemiologia

Epidemiologia

L'epidemiologia è lo studio della distribuzione e dei determinanti della salute e della malattia nelle popolazioni. La semplice descrizione della distribuzione geografica e delle tendenze temporali delle malattie ha consentito importanti scoperte. Per esempio, il chirurgo Denis Parsons Burkitt, che operava in Africa, notò che tra gli Africani malattie del colon come la diverticolosi o il cancro erano quasi sconosciute, mentre erano molto comuni tra gli Europei, e ipotizzò che le differenze fossero dovute alle abitudini alimentari, in particolare al consumo di fibre grezze, un'ipotesi recentemente confermata da studi 'analitici', ossia studi che vertono sulla ricostruzione accurata delle esposizioni e delle abitudini individuali.

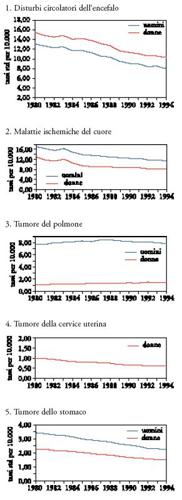

Tra le tendenze più evidenti nel corso dell'ultimo secolo, messe in luce dagli studi epidemiologici, è necessario menzionare la notevole riduzione della mortalità per malattie infettive, l'aumento (e poi la recente diminuzione) della mortalità per infarto e malattie cardio e cerebrovascolari, l'aumento della mortalità per tumori del polmone e la diminuzione della mortalità per tumori dello stomaco e per quelli della cervice uterina. L'andamento delle tendenze storiche nella mortalità in Italia, per le cause più importanti, negli ultimi decenni, è riportato nella Tav. I.

L'epidemiologia ha consentito di identificare numerosi fattori di rischio per le malattie più importanti, divenendo così la scienza di base per la prevenzione e la sanità pubblica. Tra le cause più importanti di malattie comuni che l'epidemiologia ha contribuito a identificare si ricordano: il fumo di tabacco, responsabile di circa il 30% di tutte le morti per cancro nei paesi occidentali; i cancerogeni professionali come l'amianto, alcune ammine aromatiche, alcuni metalli pesanti (cromo, arsenico, nickel); le radiazioni ionizzanti e altre esposizioni professionali o ambientali; abitudini alimentari quali una dieta carente di frutta, verdura e fibre grezze e invece ricca di sale, carne rossa e grassi saturi. È opinione comune tra gli scienziati che una sostanziale riduzione delle esposizioni menzionate porterebbe a una diminuzione del 20-30% delle morti causate dalle principali malattie degenerative.

Si è citata la causa principale della 'transizione epidemiologica' verificatasi tra il 1840 e il 1950 nei paesi occidentali e cioè la riduzione della mortalità per malattie infettive, ma ci si può chiedere che cosa abbia portato a tale riduzione. La spiegazione più nota è quella fornita da Thomas McKeown, demografo inglese.

Attraverso un'analisi delle tendenze della mortalità in Inghilterra nel periodo sopra citato, McKeown ha dimostrato in diverse pubblicazioni come negli anni in cui vennero introdotte specifiche misure sanitarie (quali i vaccini e gli antibiotici) la mortalità per gran parte delle malattie infettive si era ridotta già dell'80-90% rispetto ai livelli di partenza. Per esempio, la tubercolosi (che allora era la principale causa di morte in molti paesi europei) causava circa 4000 morti per milione di abitanti nell'Inghilterra del 1850 e solo 400 per milione negli anni 1940, allorché comparvero i primi antibiotici: una riduzione di dieci volte, con conseguente calo del 90% dei decessi (3600/4000). Un analogo crollo (di circa 10 volte) si verificò nello stesso periodo nella mortalità sia per morbillo sia per molte malattie intestinali, in particolare per quelle responsabili di un'elevata mortalità infantile e che pertanto contribuivano pesantemente ad abbassare la speranza di vita (ancora oggi, la bassa speranza di vita alla nascita nei paesi in via di sviluppo è legata soprattutto alle malattie della prima infanzia). La tesi di McKeown sosteneva che a ridurre la mortalità fu in primo luogo la maggiore disponibilità di cibi di buona qualità, inclusa un'alimentazione variata, che aumentava le difese immunitarie degli abitanti dei paesi occidentali, e in secondo luogo la disponibilità di acqua pulita.

La ricerca delle cause delle malattie

La ricerca che si occupa di scoprire le cause delle malattie è di tipo quasi esclusivamente 'osservativo', non si avvale cioè di esperimenti sull'uomo che sarebbero ovviamente non etici. Consideriamo due esempi molto recenti.

Il primo è costituito dalle ricerche epidemiologiche sulla relazione tra esposizione passiva a fumo di sigarette e cancro del polmone. Si tratta di un esempio paradigmatico per almeno tre motivi: vi sono enormi interessi economici in gioco, considerato l'elevato fatturato dell'industria del tabacco (che in vari modi ha cercato di interferire con la diffusione delle informazioni scientifiche); i dati epidemiologici influiscono direttamente sulle decisioni di sanità pubblica (per es., il divieto di fumare nei locali pubblici); come per tutte le esposizioni a bassi livelli (per es., oltre al fumo passivo, l'inquinamento atmosferico nei paesi sviluppati) l'identificazione di una relazione causale con la malattia è particolarmente complessa.

Mentre molti dei fattori di rischio menzionati sopra (a cominciare dal fumo attivo) sono stati identificati in passato con una relativa facilità grazie agli elevati livelli di esposizione, la situazione si è alquanto complicata negli ultimi decenni. Le esposizioni non lasciano un 'marchio' caratteristico nei tessuti colpiti dalle patologie, e dunque la relazione tra esposizioni e malattie croniche si deve determinare attraverso indagini epidemiologiche e sperimentali che evidenzino nessi causa-effetto probabilistici. Si deve considerare soprattutto che è cambiata la distribuzione dei rischi; infatti, si è passati da una situazione di esposizione molto elevata di piccoli gruppi di popolazione a un'esposizione a concentrazioni più basse ma di strati di popolazione più ampi. Per esempio, una volta solo gli operai erano esposti ad alti livelli di amianto o di piombo, mentre ora tutti siamo esposti a miscele a basse concentrazioni, come i gas di scarico delle automobili, oppure gli inquinanti presenti nella catena alimentare. Studiare le esposizioni professionali e ambientali oggi è più difficile, perché non si ha più quel contrasto netto tra pochi individui molto esposti e molti individui poco esposti che era proprio degli inizi dell'industrializzazione fino a circa gli anni Sessanta, oltre al fatto che l'agente causale non lascia una traccia biologica evidente del proprio passaggio.

Considerando il fenomeno del fumo passivo, sono stati condotti fino a oggi più di cinquanta studi epidemiologici sull'esposizione passiva a fumo di sigaretta perlopiù di partner non-fumatori. Naturalmente l'argomento è estremamente controverso anche a causa dei notevoli interessi economici, ma quasi tutti gli studi, condotti in paesi diversi e con metodologie differenti, mostrano un aumento di tumori del polmone negli esposti. Considerando solo le indagini più valide sul piano metodologico, quattro studi mostrano una riduzione del rischio, diciannove un aumento compreso tra il 10% e il 100%, e dieci studi più del 100% rispetto ai non-fumatori non esposti a fumo passivo. Questa distribuzione sbilanciata non può essere attribuita né al caso né a errori metodologici. Per esempio, è altamente improbabile che, come sostenuto dall'industria del tabacco, gli studi negativi non siano stati pubblicati e che questo spieghi le osservazioni riportate; infatti, sarebbero necessari più di trecento studi negativi non pubblicati per controbilanciare i risultati positivi pubblicati. Inoltre la plausibilità biologica dell'associazione è confermata da recenti osservazioni biochimiche; infatti, si è rilevato che le urine dei fumatori contengono grandi quantità di metaboliti (NNAL) di una nitrosammina specifica del tabacco (NNK, derivata dalla nicotina) e fortemente cancerogena. Le persone esposte a fumo passivo presentano una concentrazione di tali metaboliti pari all'1-5% di quanto trovato nei fumatori attivi, e questa percentuale è proporzionale all'aumento di cancro polmonare tra essi osservato. Al contrario, i non-fumatori non esposti a fumo passivo non contengono NNAL nelle urine. La maggior parte delle indagini sul fumo passivo è stata effettuata secondo un protocollo 'caso-controllo', si è basata cioè sulla raccolta retrospettiva di informazioni sull'esposizione da un gruppo di persone con cancro del polmone e un gruppo paragonabile di persone non affette da tumori.

Il secondo esempio ha come base invece un disegno epidemiologico diverso, definito 'di coorte', e riprende un tema considerato nell'introduzione, ovvero la relazione tra consumo di fibre grezze e cancro del colon. In anni recenti è stato condotto in Europa un grande studio prospettico 'di coorte' in cui 500.000 persone sono state reclutate come volontari: il loro studio ha permesso la raccolta di dettagliate informazioni sulle abitudini alimentari e un campione di sangue. Successivamente tali persone sono state 'seguite' (follow-up) per accertare l'eventuale comparsa di tumori maligni e metterli quindi in rapporto con le abitudini alimentari, gli stili di vita e le analisi di laboratorio del campione di sangue da esse prelevato (di qui la natura 'prospettica' di questo tipo di indagine e la sua denominazione 'di coorte'). Tra i primi risultati forniti dallo studio EPIC (European prospective investigation into cancer and nutrition), vi è un chiaro effetto protettivo esercitato dal consumo di fibre grezze. Infatti, su un'osservazione di 1.939.000 'persone-anno', sono stati identificati nel corso del periodo di follow-up 1065 nuovi casi di tumore del colon o del retto, tutti diagnosticati con esame istologico. Le persone che avevano effettuato un elevato consumo di fibre grezze (quintile più alto) avevano, rispetto a quelle appartenenti al quintile più basso, un rischio di cancro del colon pari al 60%, diminuito cioè del 40%. Nessuna riduzione è stata invece osservata per il cancro del retto.

Mentre nel caso del fumo passivo si è avuta un'importante conferma di tipo biologico (misurazione dei metaboliti del cancerogeno NNK nelle urine), l'interpretazione del ruolo protettivo delle fibre grezze è meno immediata. È verosimile, tuttavia, che l'associazione osservata si inscriva in un modello 'darwiniano' relativo all'insorgenza delle malattie degenerative oggi dominanti. Tale modello postula che le capacità metaboliche dell'uomo contemporaneo siano approssimativamente le stesse di quello del Paleolitico, mentre sono enormemente mutate le abitudini alimentari. Basti pensare, per esempio, che il consumo stimato di folati (agenti protettivi nei confronti di diverse malattie), così come l'assunzione di diverse vitamine, era circa 2-3 volte superiore nel Paleolitico rispetto a oggi; il consumo di fibre era addirittura 5-10 volte più elevato. Lo squilibrio tra il background genetico-metabolico e le mutate abitudini alimentari potrebbe spiegare l'incidenza particolarmente elevata nei paesi occidentali di malattie quali: diabete, ipertensione, obesità, malattie cardiovascolari e alcuni tipi di tumori come quello del colon. Questa ipotesi è sorretta dall'osservazione di popolazioni migranti o che hanno subito repentini mutamenti dietetici quali gli Indiani Pima: tra gli adulti che vivono nel Sud dell'Arizona e che hanno adottato uno stile alimentare nordamericano, il BMI (body mass index) medio è di 33,4 (corrispondente a una sicura obesità), e il 37% degli uomini e il 54% delle donne rientrano nei criteri per il diabete di tipo II; questa situazione epidemiologica contrasta fortemente con quella dei Pima che conducono un'esistenza tradizionale nel Nord del Messico.

Inoltre, va considerato che il background genetico ereditato dal Paleolitico corrisponde al concetto di thrifty genotype (genotipo volto al risparmio), cioè un orientamento del sistema metabolico verso l'immagazzinamento di energia, utile in condizioni di ristrettezze alimentari ma chiaramente controproducente nella situazione attuale dei paesi occidentali.

Studi 'caso-controllo' e 'di coorte' hanno ciascuno pregi e difetti. I risultati di entrambi i protocolli devono essere sottoposti a scrutinio attento sulla base di criteri di causalità che si vedranno oltre.

L'epidemiologia clinica: efficacia ed effetti collaterali dei trattamenti

L'epidemiologia, intesa come scienza della distribuzione e dei determinanti della salute e della malattia, studia anche l'effetto degli interventi medici, come i farmaci. Talvolta essa contribuisce anche - attraverso grandi studi prospettici - a identificare gli effetti collaterali che possono controbilanciare gli effetti benefici dei trattamenti. Si consideri, per esempio, la pubblicazione dei risultati di uno studio epidemiologico, la WHI (Women's health initiative), in cui circa 16.000 donne di 50-79 anni e in buone condizioni di salute sono state sottoposte al seguente studio sperimentale: metà sono state sorteggiate per assumere una combinazione di estrogeni e progestinici, mentre l'altra metà riceveva un placebo (una pillola priva di effetti). Da studi precedenti, non effettuati con il rigoroso protocollo della WHI, risultava che gli ormoni in menopausa, oltre ad alleviare i sintomi di quest'ultima, prevenivano l'osteoporosi e addirittura riducevano il rischio di infarto e di altre malattie cardiovascolari. Lo studio WHI è stato interrotto precocemente perché, in realtà, gli effetti collaterali negativi del trattamento con gli estroprogestinici superavano quelli positivi; infatti, fu registrato un aumento del 29% delle cardiopatie coronariche, del 26% dei tumori della mammella, del 41% dell'ictus cerebrale, del 113% delle embolie polmonari, a fronte di una diminuzione del 34% delle fratture derivanti da osteoporosi, e del 37% dei tumori del colon. Si deve comunque fare attenzione a come i risultati vengono presentati, poiché tali percentuali possono trarre in inganno: se ci si riferisce ai numeri assoluti, si ha ogni 10.000 donne che usano gli estrogeni, 7 casi in più ogni anno di cardiopatie coronariche, 8 di tumori mammari, 8 di ictus, 8 di embolie, 5 casi in meno di fratture e 6 in meno di tumori del colon.

Dall'esempio riportato si possono trarre almeno tre conclusioni: la prima è che le percentuali possono dare un'impressione distorta e drammatica del fenomeno, mentre i numeri assoluti ridimensionano il problema. La seconda conclusione, sicuramente la più importante, è che tutti gli eventi, e non solo quelli di interesse più ovvio, devono essere studiati. Alcuni eventi sono, infatti, imprevisti (e non trovano una facile spiegazione), come l'effetto preventivo sui tumori del colon. Infine, quello che conta ai fini della decisione clinica è il bilanciamento tra i rischi e i benefici in un calcolo che si rivela tutt'altro che immediato, poiché dipende non solo dalla frequenza con cui questi si manifestano, ma anche dai fattori di rischio posseduti dalle singole donne. Se è vero che complessivamente i rischi sembrano superare i benefici (31 eventi avversi contro 11 prevenuti su 1000 donne), questo è ancora più evidente se si considerano le donne che sono ad alto rischio di cardiopatia ischemica o di cancro della mammella per altri motivi. Tale conclusione vale per i trattamenti prolungati, non per quelli di breve durata volti a ridurre i sintomi fastidiosi della menopausa: in tal caso, è verosimile che un trattamento che si protragga per alcuni mesi sia decisamente più utile che dannoso. La prevenzione delle altre condizioni associate alla menopausa, quali l'osteoporosi e le malattie cardiovascolari, si effettua più efficacemente e con minori rischi attraverso altre misure: una dieta equilibrata, l'astensione dal fumo e l'esercizio fisico.

I metodi

Reti causali

La realtà biologica è per sua natura complessa. I determinanti della pressione alta, per esempio, sono molto numerosi e solo parzialmente conosciuti. A seconda degli scopi della ricerca, è possibile enumerare e classificare molto diversamente i fattori di rischio, si può infatti: (a) assumere una prospettiva di popolazione, e studiare i determinanti sociali e ambientali dell'ipertensione (per es., la classe sociale, l'attività professionale, ecc.); (b) assumere sempre una prospettiva di popolazione, ma questa volta relativa ai comportamenti, per esempio quelli alimentari (l'assunzione di sale, un potente determinante dei livelli pressori); (c) considerare ulteriormente l'individuo, studiandone la predisposizione genetica sotto forma di varianti geniche per i geni coinvolti nel metabolismo.

L'insieme di questi fattori costituisce la 'rete causale' che, secondo leggi probabilistiche, consente di spiegare la distribuzione dell'ipertensione nella popolazione e i suoi trend storici, e quindi di 'predire' l'insorgenza dell'ipertensione nei singoli individui (dall'epidemiologia eziologica all'epidemiologia clinica).

Si diceva che l'enfasi sull'uno o sull'altro dei fattori di rischio viene posta in base agli scopi degli studi effettuati. Benché entrambi siano fattori di rischio in senso epidemiologico, il consumo di sale e la presenza di polimorfismi metabolici hanno significati ben diversi sul piano pratico: sul primo è possibile agire attraverso attività di prevenzione ed educazione sanitaria, mentre i secondi consentono solamente di identificare gli individui più suscettibili (aumentando la capacità di predizione a livello individuale), ma non di intraprendere azioni preventive o terapeutiche. La distinzione tra 'prevenzione' e 'predizione' è importante sul piano pratico ed etico, anche se entrambi questi procedimenti si basano sull'identificazione di fattori di rischio.

Perché le reti causali sono probabilistiche? La spiegazione non risiede unicamente nella nostra ignoranza, nel fatto cioè che abbiamo una conoscenza soltanto parziale dei determinanti delle malattie, ma dipende anche da caratteristiche intrinseche dei fenomeni biologici. Si tratta dello stesso motivo per cui in biologia si hanno, accanto a variabili chiaramente dicotomiche come il sesso, molte variabili con una distribuzione 'gaussiana' o 'log-normale': mentre il sesso ha un unico determinante (l'abbinamento dei cromosomi X e Y), la maggior parte dei fenomeni come la pressione arteriosa è il frutto di interazioni complesse tra fattori ambientali e fattori genetici ('interazioni geni-ambiente').

Trovare le cause delle malattie comporta dunque la capacità di districarsi entro le reti causali. Lo scopo della clinica e della sanità pubblica è spesso quello di semplificare le relazioni causali isolando singoli elementi su cui sia possibile intervenire (per es., l'assunzione di sale). Poiché questi elementi fanno parte della rete, ne conseguono alcune difficoltà: (a) il potere predittivo può essere modesto, se ciò che conta è soprattutto l''interazione' con altri componenti della rete; (b) un singolo elemento (per es., un'esposizione ambientale) può 'confondersi' all'interno della rete causale, ingannandoci sulla sua natura di fattore di rischio (è presente un'altra variabile sottostante che è la vera causa).

Studi sperimentali e non sperimentali

Se, come si è detto, le cause delle malattie non sono perlopiù singole ma multiple, all'interno di reti probabilistiche, studiare il ruolo svolto da singoli fattori può essere estremamente complesso. Ronald Fisher e Bradford Hill, inventando la sperimentazione randomizzata, proposero un modello di studio molto semplice ed efficace: assegnando un'esposizione (un farmaco) in modo 'casuale' (randomizzato) a un gruppo di soggetti e non a un altro, ottenevano infatti automaticamente una correzione per le possibili 'variabili sottostanti' o 'confondenti' cui si è accennato. La sperimentazione randomizzata presentava diversi altri vantaggi: (a) consentiva di evitare distorsioni legate a una selezione erronea dei gruppi; se per esempio un gruppo di pazienti affetti da sindrome di immunodeficienza acquisita (AIDS) da trattare con un nuovo farmaco viene scelto dallo sperimentatore in assenza di randomizzazione può verificarsi ogni genere di distorsione che poi influenzerà i risultati; per esempio l'assegnazione del nuovo farmaco a pazienti con una malattia meno grave può indurre un 'bias di selezione' che influenzerà pesantemente l'interpretazione dei risultati; (b) consentiva di condurre gli esperimenti in cieco, evitando che chi rilevava le variabili dell'effetto dei trattamenti fosse influenzato dalla conoscenza delle terapie in atto; (c) consentiva un'estrema semplificazione della relazione causale, differenziando i due gruppi sulla sola base del trattamento e rendendoli invece identici per tutte le altre variabili (fatte salve differenze legate alla variabilità del campionamento e dunque condizionate dalle dimensioni dei campioni).

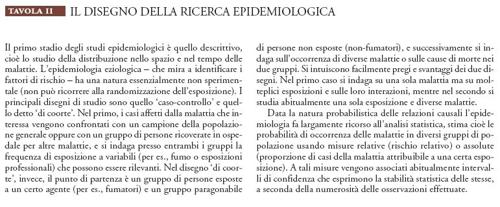

Naturalmente un tale approccio sperimentale (sperimentazione randomizzata) è proponibile solo per interventi preventivi e curativi, e sotto precise condizioni di eticità. Non è possibile invece applicarlo allo studio dei fattori di rischio. L'epidemiologia che studia le cause delle malattie ricorre a disegni non sperimentali di studio che sono descritti nella Tav. II.

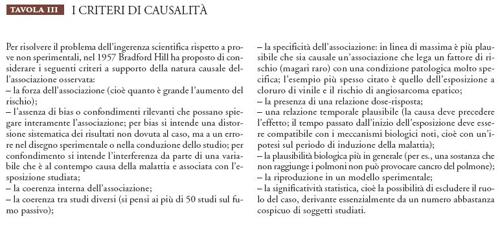

Per la natura non sperimentale delle prove, l'inferenza scientifica è più difficile in epidemiologia che in altre discipline scientifiche; è per questo motivo che Hill ha proposto i suoi criteri per il riconoscimento dei nessi causali entro studi osservazionali, cioè non sperimentali (Tav. III).

L'idea di fondo è di supplire alla mancanza di randomizzazione cercando di evitare quanto possibile bias di selezione, assicurandosi il controllo delle variabili confondenti e applicando alcuni dei classici criteri di causalità già elaborati da Bacone e John S. Mill: la riproducibilità delle osservazioni in contesti differenti, la coerenza interna delle osservazioni e la presenza di una proporzionalità tra la causa e l'effetto. A questo si aggiungeva la preoccupazione tipicamente statistica relativa alle dimensioni delle popolazioni studiate: l'inferenza scientifica è giustificata se basata su un numero sufficientemente ampio di osservazioni, cioè se l'intervallo di confidenza delle misure è abbastanza ristretto.

I criteri di Hill (che vanno intesi come 'linee-guida' generali per il riconoscimento delle relazioni causali) sono in parte derivati dai famosi 'postulati di Henle-Koch', di cui rappresentano l'estensione dalle malattie infettive all'emergere delle malattie croniche degenerative, che rispondono a un modello causale multifattoriale. I postulati di Henle-Koch affermavano che un microrganismo è causa della malattia in studio se: (a) è presente in tutti i malati; (b) è assente nei sani; (c) la relazione con la malattia è riproducibile negli animali da esperimento. Ora i primi due criteri non sono più applicabili nella loro formulazione originale, poiché fanno riferimento all'idea di cause necessarie e sufficienti (idea valevole per la meccanica classica, non più per quella quantistica e molto limitatamente per la biologia). Si ritrovano però là dove Hill fa riferimento alla forza dell'associazione tra esposizione e malattia e all'assenza di spiegazioni alternative.

Le prospettive: gli effetti della globalizzazione

Si è accennato nell'introduzione alla 'transizione epidemiologica' verificatasi a cavallo tra l'Ottocento e il Novecento nei paesi occidentali, e poi alla più recente diminuzione della mortalità per alcune delle principali malattie degenerative. Ma altre trasformazioni sono in atto, soprattutto legate ai profondi mutamenti produttivi ed economici cui si sta assistendo, e le cui implicazioni per la salute sono ancora incerte: (a) i mutamenti climatici portano alla diffusione di agenti infettivi e dei loro vettori, fenomeno cui concorrono notevolmente anche i trasporti internazionali; (b) le mutate caratteristiche del mercato del lavoro comportano spostamenti, anche su lunghe distanze, di ingenti masse di persone, con conseguenze psicofisiche non ancora interamente comprese; (c) le scelte dell'industria alimentare privilegiano spesso il profitto rispetto a raccomandazioni di tipo preventivo: si pensi agli ingenti investimenti nella produzione di cibi salati, nonostante le forti evidenze sulla relazione causale sale-ipertensione; (d) molte delle malattie emergenti nei paesi occidentali (l'anoressia, il morbo di Alzheimer, le artropatie, le malattie autoimmuni) hanno cause ignote o definite in termini ancora troppo generici, così come il ruolo della psiche nei gravi disturbi alimentari.

L'epidemiologia del Novecento ha adattato i suoi metodi alla necessità di studiare nessi causali probabilistici per malattie clinicamente ben definite e dotate di un chiaro substrato anatomico (il cancro, le malattie cardiovascolari). Molte nuove malattie emergenti cui si è accennato mancano di tale substrato, a volte rientrando chiaramente tra le malattie psichiche, altre sfuggendo invece ai tentativi di inquadramento dei meccanismi patogenetici. La sfida per l'epidemiologia consiste oggi nel pensare nuovi modelli interpretativi anche per questo mutato scenario.

Bibliografia

Bingham 2003: Bingham, Sheila A. e altri, Dietary fibre in food and protection against colorectal cancer in the European prospective investigation into cancer and nutrition (EPIC): an observational study, "The Lancet", 361, 2003, pp. 1496-1501.

McMichael 2001: McMichael, Anthony J., Human frontiers, environments and disease, Cambridge, Cambridge University Press, 2001.

Parodi 2002: Parodi, Alessandra, Storie della medicina, Torino, Edizioni di Comunità, 2002.

Schulte, Perera 1998: Schulte, Paul A. - Perera, Frederica, Molecular epidemiology, New York, Academic Press, 1998.

Vineis 1990: Vineis, Paolo, Modelli di rischio, Torino, Einaudi, 1990.

Vineis 1997: Vineis, Paolo, Proof in observational medicine, "Journal of epidemiology and community health", 51, 1997, pp. 9-13.