La grande scienza. Gravitazione

La grande scienza. Gravitazione

Gravitazione

La teoria della relatività generale (RG), elaborata da Albert Einstein (1879-1955) a partire dal 1907 ed enunciata definitivamente nel 1916 (Die Grundlage der allgemeinen Relativitätstheorie), costituisce tutt'oggi la più profonda teoria della gravitazione dopo quella di Isaac Newton (1642-1727). Tuttavia, nonostante il clamore inizialmente suscitato sia nella comunità scientifica sia nell'opinione pubblica, il suo pieno riconoscimento e i suoi più compiuti sviluppi sono relativamente recenti. Infatti, dopo aver influenzato la fisica negli anni immediatamente successivi alla sua formulazione (grazie anche ad alcune clamorose conferme sperimentali), la RG entra in un periodo di stasi che inizia alla metà degli anni Venti e si conclude soltanto verso la fine degli anni Cinquanta. In questo arco di tempo si diffonde nell'ambito della comunità scientifica la convinzione (ancora oggi largamente presente sia tra gli scienziati sia tra il pubblico generico) che la RG, pur rappresentando la più raffinata teoria della gravitazione mai concepita, abbia comunque a che fare più con la matematica che con la fisica: gli sviluppi nella comprensione del suo formalismo e nel padroneggiamento dei calcoli non trovano contatti, se non limitati, con le verifiche sperimentali.

La situazione cambia drasticamente a partire dagli anni Sessanta, quando nuove scoperte astronomiche (come quelle delle quasar, delle pulsar e della radiazione cosmica di fondo) e nuovi esperimenti, resi possibili dagli sviluppi della tecnologia, riaccendono l'interesse della comunità dei fisici e degli astronomi per la RG. Questa nuova fase può farsi iniziare nel 1960 con la prima conferma sperimentale dello spostamento gravitazionale della frequenza della luce (altrimenti noto come 'red shift gravitazionale') e può dirsi conclusa nel 1979 con l'osservazione della diminuzione del periodo orbitale di una pulsar binaria di una quantità coerente con la previsione della RG della perdita di energia per emissione di onde gravitazionali. Tutti i risultati di questo periodo confermano la validità della RG e permettono di attuare una selezione nell'insieme delle teorie alternative della gravitazione, il numero delle quali era andato crescendo di pari passo con l'accuratezza delle verifiche sperimentali e con i tentativi di una formulazione quantistica delle stesse.

A partire dal 1980 si è dovuto prendere atto che l'indagine sperimentale e teorica sulla gravitazione nell'ambito del Sistema solare (campi gravitazionali deboli) ha raggiunto i limiti di precisione consentiti dalle tecnologie disponibili: le predizioni della RG e delle teorie antagoniste che rimangono da indagare in questo ambito sono perlopiù estremamente piccole in termini quantitativi e quindi difficili da misurare. Proprio per questo negli ultimi venti anni l'investigazione sistematica delle previsioni della RG nell'ambito dei campi deboli è stata via via sostituita da una ricerca più opportunistica, che utilizza nuove, inaspettate, e spesso poco costose verifiche della gravitazione provenienti da nuove idee teoriche e moderne tecniche sperimentali. Basti pensare ai test accuratissimi della relatività ristretta che utilizzano atomi raffreddati con la tecnica del raffreddamento laser, alle proposte di una quinta forza che si risolvono in una verifica con precisione sempre maggiore del principio di equivalenza debole e, infine, al rinnovato interesse per le teorie che prevedono ulteriori dimensioni, aggiuntive alle quattro dello spaziotempo fisico, che sono alla base di recenti esperimenti per verificare l'andamento della forza di gravità a distanze minori di 100 micrometri.

Tuttavia, dal 1980 i maggiori sforzi si sono concentrati su esperimenti che riguardano effetti di campi gravitazionali intensi. Il parametro ε che permette di distinguere tra campi intensi e campi deboli è dell'ordine di GM/(Rc2), essendo G la costante gravitazionale di Newton, M la scala di massa caratteristica del fenomeno, R la scala di distanza caratteristica del sistema in esame e c la velocità della luce nel vuoto. Vicino all'orizzonte degli eventi di un buco nero (non rotante) ε vale circa 0,5 e per una stella a neutroni circa 0,2, entrambi valori tipici del regime di gravità forte, mentre nel Sistema solare è ε⟨10−5, valore tipico del regime di gravità debole. La ricerca mirante all'osservazione delle onde gravitazionali è diretta proprio a investigare regimi di gravità forte associati con la formazione e la dinamica di oggetti quali i buchi neri e le stelle di neutroni.

In quel che segue prenderemo le mosse dai fondamenti delle teorie della gravitazione che hanno dato luogo agli esperimenti classici della RG, soffermandoci sui successivi sviluppi teorici e sperimentali. Faremo quindi una breve rassegna di quanto è avvenuto dagli anni Ottanta a oggi nell'ambito dei fenomeni che coinvolgono campi gravitazionali intensi e concluderemo tratteggiando gli scenari futuri sul versante sia cosmologico sia delle moderne teorie di unificazione delle quattro forze della Natura oggi note.

I fondamenti delle teorie della gravitazione

Il principio di equivalenza è alla base sia della teoria della gravitazione universale di Newton sia della RG di Einstein. Eppure soltanto dopo gli anni Sessanta, grazie soprattutto ai contributi di Robert H. Dicke, si è arrivati a una comprensione più profonda di questo principio come fondamento non solamente della RG ma di una più ampia classe di teorie della gravitazione basate sull'idea di uno spaziotempo curvo. Consideriamo allora il principio di equivalenza nelle sue varie formulazioni, analizzandone le implicazioni teoriche e le prove sperimentali.

Il principio di equivalenza debole e le sue verifiche sperimentali

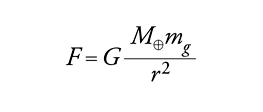

Il principio di equivalenza debole (PED) asserisce l'uguaglianza, a parte una costante di proporzionalità K, della massa inerziale mi e della massa gravitazionale mg di un qualunque corpo. La massa inerziale mi di un corpo si misura applicando a esso una forza nota F e stabilendo la sua accelerazione a dalla legge di Newton F=mia; quindi, mi misura l'inerzia del corpo, che si può anche interpretare come la riluttanza di un corpo a essere messo in movimento. D'altra parte, la massa gravitazionale mg è dedotta dalla legge di gravitazione di Newton. La forza di attrazione fra due corpi, per esempio, tra la Terra, di massa M⊕, e una pietra, di massa mg, vale:

dove G è nota come costante di gravitazione universale ed è uguale a 6,670×10−8 dine cm2 g−2 (ossia G/c2=7,421×10−29 cm/g, dove c è la velocità della luce nel vuoto) e r è la distanza fra i centri di massa dei due corpi.

Empiricamente, e con grande precisione, risulta mi=Kmg. Poiché K è una costante universale, possiamo ridefinire G in modo tale da avere K=1. Ne consegue che l'accelerazione di gravità g sulla Terra, espressa da GM⊕/R2⊕ con R⊕ raggio della Terra, supposta sferica, è indipendente dalla massa mg della pietra; pertanto, qualora si potesse trascurare la viscosità dell'aria, i gravi cadrebbero tutti con la stessa accelerazione. Questo fatto era già noto a Galileo Galilei (1564-1642) e quindi il principio di equivalenza debole è anche chiamato 'principio di equivalenza di Galilei'.

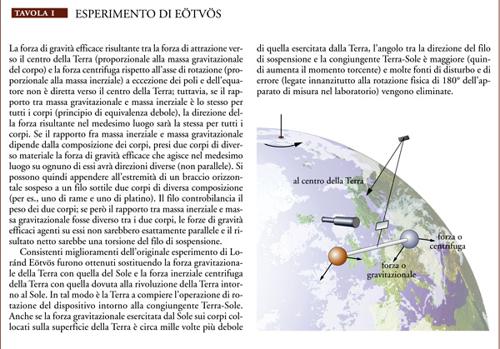

I primi esperimenti di verifica del principio di equivalenza debole furono condotti da Galilei, Christiaan Huygens (1629-1695) e Newton con l'utilizzazione di pendoli, raggiungendo una precisione che implica l'uguaglianza di mi e mg (cioè mi/mg=1) con un errore minore di un millesimo. Le prime misure moderne con l'uso di bilance di torsione furono eseguite dal barone ungherese Loránd Eötvös (1848-1919) (Tav. I).

Tra il 1889 e il 1919, Eötvös e i suoi collaboratori stabilirono che il rapporto mi/mg è uguale a 1 con un errore relativo dell'ordine di qualche parte su un miliardo (circa 5×10−9). Tra la metà degli anni Sessanta e i primi anni Settanta l'errore relativo scende a circa 10−12 grazie al lavoro del gruppo di Dicke a Princeton (1964) e di quello di Vladimir Borisovič Braginskij a Mosca (1972). A partire dalla metà degli anni Ottanta, numerosi esperimenti sono stati progettati e portati a termine con l'intento principale di verificare l'esistenza di una 'quinta forza', una proposta, questa, avanzata nel 1986 da alcuni fisici, tra i quali Ephraim Fischbach e Carrick Talmadge. L'eventuale esistenza di un'altra forza implicherebbe una violazione del principio di equivalenza debole a distanze inferiori ai duecento metri, ma il risultato nullo di questi esperimenti si è risolto in un'ulteriore conferma sperimentale del principio di equivalenza. Il più noto di tali esperimenti, soprannominato 'Eöt-Wash', è stato condotto a Washington a partire dal 1990 da Eric G. Adelberger e altri con l'uso di una bilancia di torsione e recentemente ha raggiunto la precisione di circa 4×10−13.

Il principio di equivalenza di Einstein: conseguenze teoriche e verifiche sperimentali

Einstein si rese conto che il principio di equivalenza debole è un fatto empirico di estrema importanza e lo estese introducendo un principio fondamentale della fisica, che condiziona ogni futura teoria della gravitazione. Il suo punto di partenza fu l'esperimento concettuale (Gedankenexperiment) dell''ascensore'.

Esso si basa, innanzitutto, sull'assoluta validità del principio di equivalenza debole. Inoltre, le conclusioni ricavate (l'equivalenza fra osservazioni nelle fasi A e C e osservazioni nelle fasi B e D) valgono solamente entro certe approssimazioni: precisamente, le dimensioni del laboratorio devono essere sufficientemente piccole e i moti dei corpi devono essere nel regime non relativistico, cioè in campi gravitazionali deboli, a basse velocità e accelerazioni, assumendo la validità della meccanica newtoniana. Il risultato rivela tuttavia una straordinaria equivalenza fra inerzia e gravità, anche se questa equivalenza è valida a livello puramente 'locale', non potendosi espandere indefinitamente le pareti del laboratorio.

Einstein trasformò questo risultato in un grande manifesto scientifico, postulandone la validità ben al di là delle assunzioni iniziali. Egli richiese, per un campo gravitazionale qualsiasi, che i sistemi di riferimento locali in caduta libera (fase C) fossero equivalenti ai sistemi di riferimento inerziali in regioni limitate dello spaziotempo (fase A). Entro questi sistemi, le leggi della fisica verificabili con misurazione che non implichino la gravitazione si presentano uguali a quelle della relatività ristretta. Per esempio, una misurazione della forza elettrica tra due corpi carichi è un esperimento locale non gravitazionale, mentre non lo è la misurazione della forza di attrazione gravitazionale tra due corpi.

Riassumendo, il principio di equivalenza di Einstein (PEE) è l'insieme di queste tre asserzioni: (1) vale il principio di equivalenza debole; (2) il risultato di qualunque esperimento non gravitazionale è indipendente dalla velocità del sistema di riferimento locale in caduta libera nel quale esso è eseguito (invarianza locale di Lorentz); (3) il risultato di qualunque esperimento non gravitazionale è indipendente da dove e da quando esso è eseguito nell'Universo (invarianza locale di posizione nello spaziotempo). Il principio di equivalenza di Einstein è spesso chiamato anche 'principio di equivalenza forte', ma in anni recenti, come vedremo, quest'ultima espressione ha assunto un significato diverso.

Negli ultimi quaranta anni gli sviluppi teorici e sperimentali relativi alla gravitazione hanno permesso di cogliere la centralità del principio di equivalenza di Einstein nell'ambito non soltanto della RG ma anche di molte teorie alternative della gravitazione. Se il principio di equivalenza di Einstein è valido, allora è possibile dedurne in modo convincente che la gravitazione è un fenomeno dello spaziotempo curvo o, in altri termini, che gli effetti della gravitazione sono dovuti alla curvatura dello spaziotempo. Questa conclusione è vera non soltanto per la RG ma anche per una classe di teorie, note come 'teorie metriche', delle quali la RG è solamente un caso particolare. Tra le teorie metriche alternative alla RG la più famosa è quella di Jordan-Fierz-Brans-Dicke, oggi comunemente nota come teoria di Brans-Dicke. Il nome 'teorie metriche' è stato originariamente introdotto da Markus Fierz nel 1956 in un articolo in cui discuteva alcuni risultati ottenuti nel 1955 da Pascual Jordan. Nel 1961 Carl H. Brans e Dicke svilupparono queste idee formulando congiuntamente la teoria metrica che oggi porta il loro nome. Le teorie metriche soddisfano i seguenti tre postulati: (1) lo spaziotempo è dotato di una metrica (simmetrica o, più precisamente, lo spaziotempo è una varietà di Lorentz); (2) le traiettorie dei corpi in caduta libera sono geodetiche di quella metrica (nei sistemi di riferimento locale in caduta libera, i corpi di prova appaiono non accelerati, si muovono cioè in linea retta; tuttavia tali traiettorie localmente rettilinee corrispondono alle geodetiche in uno spaziotempo curvo); (3) nei sistemi di riferimento locali in caduta libera, le leggi non gravitazionali della fisica sono quelle scritte nel linguaggio della relatività ristretta.

Aggiungiamo un commento al postulato (2). Il principio di equivalenza fissa in modo quasi inequivocabile il moto di particelle puntiformi all'interno di un campo gravitazionale, determinando il moto lungo linee, le 'geodetiche', che in uno spazio curvo generalizzano il concetto di linea retta. Una geodetica su una superficie è la linea più breve fra due punti ed è anche quella che più si avvicina a una retta; un esempio ci è dato dalle circonferenze massimali di una sfera. È quindi naturale richiedere che nello spaziotempo i corpi si muovano lungo una geodetica. Così facendo, vediamo che il moto geodetico è estremamente vicino a quello newtoniano: è necessario, quindi, applicarsi molto per trovarne la differenza. A volte si rimane sconcertati dalla considerazione che, dopotutto, nello spazio ordinario la strada più breve fra la posizione attuale della Terra e quella che occuperà fra sei mesi passi direttamente attraverso il Sole, e ci si domanda come mai invece la Terra segua una perfetta orbita ellittica. Tuttavia, l'ellisse è soltanto la proiezione sullo spazio ordinario di una curva dello spaziotempo, simile a un'elica molto allungata lungo la direzione del tempo; essendo una geodetica, essa è poi, per definizione, più diritta di qualsiasi altra linea. Quindi l'idea di 'geodetica' deve essere applicata a una rappresentazione quadridimensionale dello spaziotempo e non al solo spazio ordinario tridimensionale.

Torniamo ora alle teorie metriche. Per definizione, ogni teoria metrica della gravità ha la stessa struttura spaziotemporale (varietà lorentziana) e formalmente le stesse equazioni geodetiche, ossia le medesime equazioni di moto delle particelle di prova della RG. Si può così affermare che la geometria dello spaziotempo vincola la massa-energia a muoversi come previsto dalla teoria di Einstein; tuttavia, le equazioni di campo e la risultante metrica dello spaziotempo definite dalle altre teorie metriche sono diverse da quelle di Einstein; quindi, la massa-energia induce sulla geometria dello spaziotempo una curvatura in modo diverso da quanto formulato dalla RG.

Vale forse la pena di soffermarsi su quest'ultimo aspetto, cercando di capire in che cosa la RG differisca dalle altre teorie metriche. Le equazioni di campo di Einstein determinano la curvatura (ovvero la metrica dello spaziotempo) generata da una data distribuzione di massa-energia: una volta nota la metrica dello spaziotempo, il principio di equivalenza di Einstein ci suggerisce quale sia la risposta della massa-energia alla curvatura spaziotemporale. La curvatura è individuata da un campo metrico tensoriale che assegna a ogni punto dello spaziotempo dieci numeri (le componenti del tensore metrico). Nello spaziotempo esistono tuttavia altri tipi di campi oltre quello tensoriale della RG, tra i quali i vettoriali (che assegnano a ogni punto dello spaziotempo quattro componenti) e gli scalari (che assegnano a ogni punto dello spaziotempo una sola componente). Nel caso particolare delle teorie scalare-tensore, come la teoria di Brans-Dicke, al campo tensoriale metrico ne è aggiunto uno scalare: le equazioni di campo devono quindi determinare la quantità di campo scalare generata dalla materia-energia e specificare come cambia la curvatura in relazione alla materia-energia combinata con il campo scalare. Altre teorie metriche introducono vari tipi di campi addizionali a quello tensoriale metrico; tuttavia, per ognuna di esse, una volta determinata la metrica, il principio di equivalenza di Einstein vincola la risposta della massa-energia alla curvatura spaziotemporale. Quindi, ciò che distingue una teoria metrica dall'altra è il modo in cui la massa-energia e gli eventuali campi aggiuntivi generano la metrica.

Per analizzare i risultati sperimentali sulla gravitazione e paragonarli con le previsioni delle diverse teorie metriche, Kenneth Nordtvedt ha sviluppato negli anni Sessanta una tecnica, introdotta da Arthur S. Eddington negli anni Venti, che va sotto il nome di 'formalismo PPN' (parametrised post-Newtonian formalism). Alla base di questo approccio sta la constatazione che, nel limite di campo gravitazionale debole e di moti con velocità piccola rispetto a quella della luce, è relativamente semplice confrontare tra loro le diverse teorie metriche e mettere in relazione le loro previsioni con i risultati sperimentali. Entro questo limite, noto come 'limite post-newtoniano' perché prende in considerazione soltanto la prima correzione introdotta dalle nuove teorie a quella della gravitazione di Newton, l'approssimazione ottenuta ha una accuratezza sufficiente per la trattazione della maggioranza dei test sperimentali della gravitazione, sia terrestri sia spaziali, condotti nell'ambito del Sistema solare. Risulta inoltre che, entro lo stesso limite, la metrica dello spaziotempo delle diverse teorie della gravitazione ha una struttura generale basata sul valore di un comune insieme di parametri: diversi valori dell'insieme di parametri individuano differenti teorie metriche. I parametri rilevanti nel caso di teorie metriche che ammettano la conservazione dell'energia-impulso sono essenzialmente cinque: γ, che misura la curvatura prodotta dalla massa-energia in relazione alla curvatura della RG; β, che misura la non linearità rispetto alla RG; ξ, che misura la dipendenza degli effetti gravitazionali dalla posizione; α1 e α2, che misurano la dipendenza degli effetti gravitazionali dalla velocità. Per la RG si ha γ=1, β=1, ξ=α1=α2=0, mentre per la teoria di Brans-Dicke si ha γ=(1+ω)/(2+ω), β=1, ξ=α1=α2=0, dove la costante ω, il cui valore viene corretto in funzione dei dati sperimentali, misura la rilevanza del campo scalare nella determinazione della curvatura: più grande è il suo valore, minore è l'influenza del campo scalare, fino al limite di ω→∞ nel quale la teoria di Brans-Dicke diventa identica alla RG.

Non tutte le teorie della gravitazione elaborate negli ultimi decenni sono teorie metriche nel senso sopra esposto. Per esempio, le cosiddette 'teorie di superstringa', che ugualmente si basano su una metrica spaziotemporale anche se trattano oggetti che vivono in spazi di dimensione superiore a quella dello spaziotempo quadridimensionale, richiedono l'introduzione di campi addizionali (dilatoni, moduli) che si accoppiano alla materia-energia in modo tale da portare a una violazione del principio di equivalenza di Einstein (in particolare, del principio di equivalenza debole).

La proliferazione di teorie della gravitazione, metriche o non metriche, alternative alla RG è uno degli aspetti connotativi della fisica degli ultimi decenni, ed è stata sicuramente stimolata dalle nuove verifiche sperimentali della RG iniziate negli anni Sessanta. A sua volta, la disponibilità di più teorie alternative ha fornito ulteriori stimoli alla ricerca sperimentale sulla gravitazione, al fine di determinare quale sia la teoria della gravitazione più adeguata. Ecco perché assume particolare rilievo verificare la validità delle diverse asserzioni che compongono il principio di equivalenza di Einstein. Una sua violazione potrebbe risolversi in una, più o meno diretta, evidenza sperimentale a favore di teorie non metriche della gravitazione e in particolare a favore delle teorie di superstringa, da molti considerate la strada più promettente verso la formulazione della teoria quantistica della gravitazione, e successivamente di teoria unificata delle interazioni fondamentali oggi note (gravitazionale, elettromagnetica, debole e forte). D'altra parte, una verifica sempre più accurata del principio di equivalenza di Einstein può servire a delineare meglio la struttura delle teorie metriche: infatti, a eccezione della RG, che può di fatto essere considerata una teoria senza parametri aggiustabili, le varie teorie metriche introducono parametri (come la citata costante ω nella teoria di Brans-Dicke) il cui valore deve essere fissato sulla base di dati sperimentali.

Alla luce della centralità del principio di equivalenza di Einstein è opportuno passare in rassegna i progressi realizzati nella verifica sperimentale dei vari asserti in esso contenuti.

La prima delle tre asserzioni che esprimono il principio di equivalenza di Einstein riguarda la validità del principio di equivalenza debole, delle cui verifiche in campo sperimentale abbiamo già parlato.

La seconda asserzione, cioè l'invarianza locale di Lorentz, può considerarsi di fatto verificata in tutti gli esperimenti che confermino le previsioni della relatività ristretta, come avviene di frequente in quelli di fisica delle alte energie; non è però facile, anche a causa dei complicati effetti legati alla presenza delle interazioni forti e deboli, interpretarli quali prove dell'invarianza locale di Lorentz. L'esperimento che molti autori giudicano come la verifica diretta dell'invarianza locale di Lorentz riguarda una misura dell'anisotropia nella massa inerziale ed è stato condotto per la prima volta all'Università di Yale (Vernon Hughes e collaboratori, 1960) e all'Università di Glasgow (Ron Drever, 1961). Il principio dell'invarianza locale di Lorentz asserisce che le leggi non gravitazionali della fisica coincidono con le leggi della relatività ristretta in qualunque sistema locale di riferimento in caduta libera. In altre parole, in regioni sufficientemente piccole dello spaziotempo il principio di equivalenza è soddisfatto indipendentemente dalla velocità del sistema di riferimento in caduta libera.

Tuttavia, secondo alcune accezioni del principio di Mach, anche in un sistema di riferimento in caduta libera le proprietà inerziali di un corpo (in particolare la sua massa inerziale) potrebbero dipendere dalla distribuzione delle masse dell'Universo e dalla direzione dell'accelerazione. Si potrebbe, per esempio, pensare che la massa inerziale di un corpo che si muova in direzione del centro della nostra galassia (dove è concentrata una massa maggiore) sia diversa da quella dello stesso corpo che si muova in direzione perpendicolare alla precedente, come pure si potrebbe osservare una variazione della sua massa inerziale causata dal suo moto rispetto al sistema di riferimento assoluto dell'Universo, determinato dalla distribuzione media della massa-energia cosmica. L'esperimento di Hughes e Drever utilizza nuclei di Li7. Lo stato fondamentale del Li7 ha spin 3/2 e perciò in presenza di un campo magnetico esterno si scinde in quattro livelli energetici che, se esiste simmetria rotazionale, sono ugualmente spaziati; quindi, le transizioni tra questi livelli hanno la stessa energia e sono accompagnate da emissioni di fotoni della medesima, che generano un'unica linea spettrale ben definita. Tuttavia, se esiste una direzione privilegiata nello spazio, ossia se la simmetria per rotazioni è rotta, allora i quattro livelli energetici non sono più ugualmente spaziati: i fotoni emessi nelle transizioni hanno diversa energia e non si ha più una sola linea spettrale. Poiché la Terra ruota, l'orientamento dell'apparato sperimentale cambia direzione, relativamente alla distribuzione di massa dell'Universo, con un periodo di circa 24 ore. Si dovrebbero quindi osservare linee dello spettro con energia di separazione che varia nel tempo con un periodo di un giorno. Tuttavia una simile variazione non è stata osservata e l'esperimento, ulteriormente raffinato nel corso degli anni Ottanta, fissa oggi un limite all'anisotropia in relazione ai livelli di energia dei nuclei atomici di circa una parte su 1027.

La terza asserzione del principio di equivalenza di Einstein è l'invarianza locale di posizione, che può essere provata misurando lo spostamento verso il rosso (red shift) della luce che risale un campo gravitazionale. Einstein, già nel 1907, aveva concepito il red shift gravitazionale della luce come un esperimento a supporto della nuova teoria della gravitazione (formulata compiutamente solo nel 1916). Oggi il red shift è visto più in generale come un fenomeno a favore del principio di equivalenza di Einstein, che quindi non discrimina tra la RG e le altre teorie metriche. Sulla base del principio di equivalenza debole, del principio di conservazione dell'energia e di alcuni principî base di meccanica classica e quantistica, possiamo derivare un'espressione del red shift in approssimazione di campo debole utilizzando il seguente Gedankenexperiment. Si costruisca una macchina per il moto perpetuo, con un tubo piegato a formare un anello e posto verticalmente. Il tubo è pieno di un fluido di atomi aventi due stati, uno fondamentale e uno eccitato, separati da un'energia E=hν, con h costante di Planck e ν frequenza del fotone emesso dall'atomo nel passaggio dallo stato eccitato a quello fondamentale o assorbito nel passaggio inverso. La macchina è posta su un astro che ha accelerazione di gravità aG. Il fluido ascende lungo il ramo destro e discende lungo quello sinistro. Entrambi i rami hanno altezza l. Gli atomi in ascesa sono nello stato fondamentale e quelli in discesa nello stato eccitato. Una volta arrivati in basso, gli atomi eccitati emettono un fotone che viene spedito verso l'alto per essere quindi riassorbito dagli atomi dello stato fondamentale in ascesa. Poiché la massa di un atomo eccitato è maggiore di quella dell'atomo nello stato fondamentale, il fluido discendente è più pesante di quello ascendente e si ottiene un guadagno energetico di EaGl/c2. Sappiamo però che, per il principio di conservazione dell'energia, il moto perpetuo non è possibile. Tuttavia la macchina funziona solamente se il fotone emesso e quello assorbito hanno la stessa energia. Evitiamo quindi il paradosso se assumiamo che il fotone, in ascesa nel campo gravitazionale, perda esattamente l'energia che si spera di ottenere dall'atomo durante un ciclo. Questo implica che la frequenza ν del fotone emesso da un atomo debba diminuire, salendo dal ramo orizzontale basso a quello alto, della frazione ΔV/c2, dove ΔV=aGl è la variazione di potenziale gravitazionale nel passaggio dal primo al secondo ramo. Precisamente, si ha Δν=νaGl/c2, da cui hΔν=hνaGl/c2=EaGl/c2: la perdita di energia per fotone pareggia così il guadagno energetico della macchina, in accordo con il principio di conservazione dell'energia. Nel risalire un campo gravitazionale il fotone perde quindi energia, cioè la sua frequenza diminuisce (nello spettro del visibile si sposta verso la regione del rosso). Per converso, un fotone che scende lungo il campo gravitazionale aumenta la sua energia, e quindi la sua frequenza (che nello spettro del visibile si sposta verso la regione del blu). A entrambi i fenomeni, red shift e blue shift, si attribuisce comunque il nome di 'red shift gravitazionale'. La diminuzione della frequenza di un fotone che esce dalla Terra e viene osservato da distanza infinita, ossia fuori dal campo gravitazionale, è dell'ordine di GM⊕/(c2r⊕), che equivale a circa una parte su un miliardo.

Un tipico esperimento per osservare il red shift gravitazionale misura la differenza in frequenza tra due sistemi (orologi) che hanno in partenza la stessa identica frequenza (e quindi hanno identica scansione del tempo) e che sono collocati fermi a diverse altezze in un campo gravitazionale statico. Se la frequenza degli orologi atomici è la stessa quando viene misurata in un sistema di riferimento locale in caduta libera, indipendentemente dalla collocazione o dalla velocità del sistema di riferimento, allora il confronto tra le frequenze di due orologi fermi a due quote diverse si riduce al confronto tra le velocità di due sistemi locali in caduta libera, uno istantaneamente fermo rispetto a un orologio al momento dell'emissione del segnale e l'altro istantaneamente fermo rispetto all'altro orologio al momento della ricezione del segnale. In questo senso il red shift gravitazionale misura l'effetto Doppler tra i due sistemi di riferimento: se l'emettitore si trova più in basso del ricevitore (come nel caso del Gedankenexperiment) lo spostamento è verso il rosso poiché, nell'intervallo di tempo nel quale il fotone emesso raggiunge il ricevitore, il sistema di riferimento in caduta libera associato all'emettitore all'istante dell'emissione del fotone si allontana dal sistema di riferimento istantaneamente fermo rispetto al ricevitore al momento della ricezione; viceversa avviene se l'emettitore si trova più in alto del ricevitore.

Il red shift gravitazionale

Usando raggi gamma emessi dal Fe57, Robert V. Pound e Glen A. Rebka (1960) e Pound e Joseph L. Snider (1965) hanno misurato per la prima volta con grande precisione (errore relativo di circa l'1%) il red shift gravitazionale, trovandolo pari a Δν/ν≃−2,46×10−15 su una salita di soli 22,6 m, in perfetto accordo con le previsioni teoriche. Ulteriori esperimenti sono stati condotti in seguito; uno dei più accurati è stato realizzato alla fine degli anni Settanta con due orologi atomici, uno a terra e uno su un razzo lanciato a un'altezza di circa 10.000 km, confermando le previsioni teoriche con un errore dell'ordine di uno su diecimila.

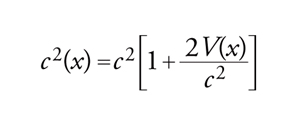

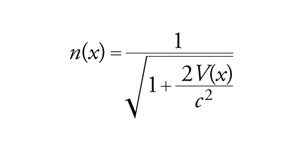

I vari aspetti collegati al red shift gravitazionale possono essere considerati da un altro punto di vista, in cui si sottolinea come il potenziale gravitazionale si comporti per molti versi quale un indice di rifrazione variabile. Si può quindi pensare a una velocità della luce variabile in funzione del potenziale gravitazionale V(x) (essendo x una generica coordinata spaziotemporale):

corrispondente all'indice di rifrazione:

Questo indice, come si vede, è maggiore nelle valli e minore sulla cima delle montagne. La luce viaggia più velocemente nello spazio esterno piuttosto che sulla Terra. L'indice di rifrazione è in generale uguale a (1−R0/r)−1/2, dove R0=2MG/c2 è il cosiddetto raggio di Schwarzschild della massa M; per la Terra R0 è uguale circa a 0,88 cm e n(x) varia solo di un miliardesimo rispetto all'unità, mentre per il Sole R0 è circa 3 km e n(x) varia di 2 milionesimi rispetto all'unità. Fisicamente, R0/r è il β2 di fuga (il β di fuga è il rapporto tra la velocità di fuga e la velocità della luce) dalla distanza r all'infinito. Se r→R0, cioè se β2→1, e quindi se la velocità di fuga tende a c, per l'indice di rifrazione si ha n→∞, per cui i raggi di luce tendono sempre di più a essere riflessi totalmente passando da una zona con alto indice di rifrazione a una con basso indice di rifrazione. Per questa ragione, se comprimiamo un corpo di massa M in modo da confinarlo entro il suo raggio di Schwarzschild R0, rendiamo effettivamente impossibile l'uscita della radiazione dalla superficie. Un corpo per il quale R0/r=1 è noto con il nome di 'buco nero'. All'interno di un corpo di queste dimensioni, la curvatura dello spaziotempo sarebbe dell'ordine di 1/r2=1/(R0)2, che implica deviazioni fortissime dalla geometria euclidea.

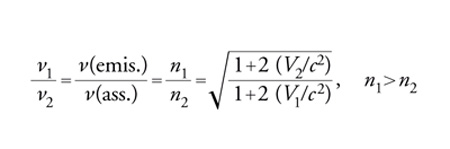

Usando il modello dell'indice di rifrazione, il rapporto tra frequenza emessa e assorbita nel Gedankenexperiment sopra descritto è:

dove i pedici 1, 2 indicano che le grandezze sono valutate rispettivamente nel ramo basso e nel ramo alto della macchina del moto perpetuo. Effettivamente, per Vc−2≪1 abbiamo:

ν1/ν2∼1+(V2−V1)c−2=1+Δxg/c2, in quanto V(x)=gx, con x misurato lungo la verticale e Δx=x2−x1=l.

Dunque, Δν=ν1−ν2=lgν/c2; la perdita di energia per fotone vale hΔν=Egl/c2 e si ha conservazione dell'energia. Inoltre i periodi T1 e T2 devono soddisfare le relazioni:

dove T0 è il periodo della radiazione vista da distanza infinita, ossia fuori del campo gravitazionale, misurato nella coordinata temporale valida per entrambi gli osservatori. Poiché T1⟨T2⟨T0, se ne deduce che la radiazione perde energia salendo nel campo, viene cioè spostata verso il rosso. Un qualunque osservatore esterno vede quindi un fotone arrivare con una frequenza spostata verso il rosso e ha l'impressione che tutti i fenomeni sulla superficie della Terra (o su quella di un qualsiasi corpo celeste) siano rallentati. Viceversa, gli osservatori sulla superficie del corpo hanno l'impressione che il tempo esterno scorra più velocemente. Un osservatore fuori del campo gravitazionale ha l'impressione che gli standard atomici di tempo sulla superficie siano rallentati del fattore n (indice di rifrazione), che sulla Terra, per quanto detto, è dell'ordine di 1+10−9. Tra la cima di una montagna e la pianura l'effetto è minore, dell'ordine di pochi nanosecondi al giorno. Sebbene molto piccolo, questo effetto può essere misurato come nell'esperimento di Rebka e Pound. I moderni dispositivi di rilevazione della posizione, usati per esempio per la navigazione, si basano sui segnali emessi da un certo numero di orologi atomici trasportati da satelliti orbitanti che inviano sulla Terra precisi segnali di tempo. La posizione di ogni stazione ricevente è quindi ricavata tenendo conto delle correzioni dovute agli effetti del red shift gravitazionale e della dilatazione dei tempi causata dalla velocità dei satelliti vettori, con un errore di pochi metri. Per esempio, il sistema GPS (global position system) fornisce un'accuratezza della posizione di circa 15 m (e ancora di più nell'ambito degli impieghi militari) in ogni punto della Terra, che corrisponde a un'accuratezza di circa 50 nanosecondi nella misura dei tempi in qualunque momento. Siccome le differenze nella scansione temporale tra orologi sui satelliti e orologi a Terra dovuti a effetti di relatività ristretta e generale ammontano a circa 39 microsecondi, senza correggere questi effetti l'accuratezza del GPS sarebbe assai minore. Ecco una delle più dirette e diffuse applicazioni odierne della RG.

Nel limite estremo, n→∞, in cui il corpo diventa un buco nero, lo scorrere del tempo sulla sua superficie s'arresta. Esistono buone ragioni per credere che in Natura buchi neri siano creati durante l'implosione di una supernova. Il nucleo della stella collassa sotto l'azione della propria forza gravitazionale, che in queste condizioni supera tutte le altre forze che resistono alla compressione. Il raggio del nucleo diminuisce e raggiunge molto velocemente (nel giro di pochi secondi) un valore R(t) vicino a quello del raggio di Schwarzschild, R0 (circa 10 km). Quando R(t) è ormai prossimo a R0 il collasso appare rallentato agli occhi di un osservatore esterno; alla fine, il processo sembra fermato all'ultimo fotogramma del film. Visto da osservatori esterni, il buco nero è quindi un oggetto statico o quasi statico. Una conclusione, questa, che vale solamente se si trascurano gli effetti quantistici di cui parleremo tra breve. Un osservatore seduto sulla superficie sarebbe invece testimone del collasso che sembrerebbe svolgersi in una frazione di secondo. Al termine di questo breve intervallo iniziale, egli vedrebbe l'evoluzione dell'Universo esterno enormemente accelerata per un fattore che tende all'infinito e assisterebbe alla fine dell'Universo; egli entrerebbe anche in una regione dello spaziotempo in cui sarebbe testimone effimero di strani fenomeni, sui quali non ci soffermiamo.

Questa storia molto interessante è modificata dall'idea di Stephen W. Hawking secondo la quale i buchi neri possono alla fine evaporare in un gas di fotoni e di altre particelle ad alta energia, attraverso un effetto tunnel quantistico. Nella meccanica quantistica ‒ più precisamente nella teoria quantistica dei campi ‒ il vuoto non è realmente tale, ma pieno di coppie di particelle-antiparticelle, che si creano e si annichilano continuamente. Infatti, dal principio di indeterminazione di Heisenberg per l'energia E e il tempo T, ΔEΔT>h, dove h è la costante di Planck, consegue che lo spazio vuoto e privo di energia è soggetto a scale di tempi molto piccole, dell'ordine di 10−44secondi o minori, ossia alle cosiddette 'fluttuazioni quantistiche del vuoto'. Nel corso di queste fluttuazioni le coppie particella-antiparticella appaiono per un tempuscolo ΔT dell'ordine di h/ΔE (con ΔE energia della coppia, per es., elettrone-positrone). Il vuoto è quindi popolato continuamente da processi di fluttuazione in cui coppie di particella-antiparticella vengono create e annichilate. Il processo di annichilazione è così rapido che le particelle non possono essere rilevate a nessuna scala di osservazione: da qui il nome di 'particelle virtuali' per queste coppie di particelle.

Secondo il processo di evaporazione proposto da Hawking, se una coppia si formasse vicino a un buco nero di massa M alla distanza pari al raggio del buco nero R0, una delle due particelle della coppia sarebbe attratta e inghiottita nel tempo R0/c. Se R0/c⟨h/ΔE, il processo è possibile e la produzione di particelle reali dal vuoto diventa anch'essa possibile; in modo simile, un nucleo di carica Z sufficientemente grande (Z>137∼1/α, con α costante di struttura fine) può estrarre un elettrone dal vuoto ed emettere un positrone. Ci aspettiamo quindi che un buco nero emetta particelle di energia media E=hc3/(2MG). I buchi neri dunque si comportano come corpi di temperatura Θ=E/k=hc3/(k2MG) (legge di Wien, dove k è la costante di Boltzmann, il cui valore è di circa 1,38×10−16 erg/K) e la potenza emessa a unità di superficie è, secondo la legge di Stefan-Boltzmann, σΘ4=costante/M4 (dove σ è una costante il cui valore è circa 5,67×10−5 erg cm−2 s−1 K−4), cioè è proporzionale al reciproco della quarta potenza della massa. Poiché la superficie totale del buco nero è dell'ordine di (R0)2=costante M2, la potenza totale W è espressa da W=costante M2. Ciò significa che i grandi buchi neri evaporano molto lentamente, i piccoli più velocemente e che la loro vita media è dell'ordine di M3. Un buco nero di massa pari a 1015 g dovrebbe durare circa dieci miliardi di anni, che corrisponde al valore attualmente stimato dell'età dell'Universo. Se durante il big bang fossero stati creati buchi neri di questa massa in gran quantità, dovremmo oggi assistere alla loro fine. Le fasi finali della vita di un buco nero sono caratterizzate da un'emissione intensa ad andamento esplosivo, ed è ragionevole pensare di poter osservare tali eventi, con un telescopio a raggi gamma o con qualche altro strumento, ma sino a ora questo non è accaduto. L'osservazione di questi eventi, oltre a offrire la prova diretta dell'esistenza dei buchi neri, permetterebbe di verificare la correttezza di alcune congetture interessanti. I primi oggetti proposti come buchi neri sono stelle, quali Cygnus X-1, che manifestano un'intensa emissione di raggi X. L'emissione di raggi X è in ottimo accordo con un meccanismo di accrezione: si tratterebbe di un sistema binario in cui la materia proveniente da una stella gigante blu cade nel campo di un buco nero e viene violentemente compressa e riscaldata a milioni di gradi, emettendo raggi X.

Torniamo ora al red shift gravitazionale. Lo spostamento verso il rosso gravitazionale è stato osservato in un certo numero di corpi celesti. Nel Sole, ammonta a due parti su un milione ed è difficile, ma non impossibile, vederlo a causa dell'allargamento termico delle linee dello spettro. L'effetto è molto più evidente per le nane bianche e dovrebbe avvicinarsi al 10% su una stella di neutroni. Il red shift gravitazionale, per quanto detto, potrebbe simulare l'effetto Doppler dovuto alla recessione della sorgente, e qualcuno l'ha anche proposto in alternativa all'effetto Doppler cosmologico (interpretato come espansione dell'Universo) per spiegare il red shift osservato nella luce emessa dalle galassie. Questa interpretazione non ha però avuto molto successo: un corpo il cui campo gravitazionale dovesse produrre un red shift di un fattore 2 o anche maggiore (come quelli osservati per le galassie) sarebbe infatti pericolosamente vicino al collasso gravitazionale e la sua configurazione sarebbe estremamente instabile.

Da quanto fin qui detto emerge che il principio di equivalenza di Einstein è stato provato con accuratezza crescente negli ultimi venti anni. Ma allora perché progettare nuovi esperimenti come lo STEP (satellite test of the equivalence principle), attuato da una collaborazione tra le agenzie spaziali statunitensi (NASA), europea (ESA) e francese (CNES), che ha l'obiettivo di verificare l'equivalenza tra massa inerziale e gravitazionale con un errore dell'ordine o minore di uno su 1017? Le ragioni di questo sforzo sperimentale sono legate agli attuali sviluppi della fisica teorica che sembrano prevedere una violazione del principio di equivalenza di Einstein a qualche livello, dovuta a effetti di gravità quantistica derivanti dalle teorie di stringa o a interazioni ancora non conosciute. La ricerca di verifiche sperimentali sempre più accurate del principio di equivalenza di Einstein è oggi vista come un ambito di indagine dal quale ci si aspettano non soltanto ulteriori informazioni sulla gravitazione, ma anche evidenze più o meno dirette della validità del Modello standard delle particelle elementari e della eventuale esistenza di nuove interazioni oltre il Modello standard. Si tratta di una branca di sviluppo della fisica che, senza far ricorso agli acceleratori di particelle, utilizza l'Universo come laboratorio di fisica delle particelle, alla ricerca delle tracce di effetti provocati da particelle ad alta energia nel contesto della gravità.

Teorie della gravitazione a confronto: gli esperimenti classici della relatività generale

Quando si parla di esperimenti classici della RG ci si riferisce solitamente alla precessione del perielio di Mercurio, alla deflessione della luce e al red shift gravitazionale, cioè ai tre effetti che per primi sono stati considerati negli scritti di Einstein. Tuttavia, come già osservato, il red shift gravitazionale non è più oggi considerato un test della RG, ma un test del principio di equivalenza di Einstein comune a tutte le teorie metriche.

Un confronto tra la RG e le altre teorie metriche può quindi essere realizzato facendo riferimento agli altri due esperimenti classici e alle loro conseguenze. Usando il formalismo PPN, i risultati di questi esperimenti nell'ambito del Sistema solare possono essere interpretati come misure per la stima dei valori dei vari parametri e la conseguente determinazione di quale sia la teoria più inerente alle osservazioni.

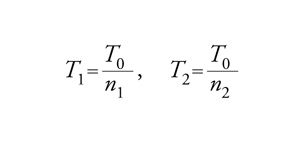

Iniziamo considerando la precessione del perielio di Mercurio (fig. 2). Il grande astronomo francese Urbain-Jean-Joseph Le Verrier (1811-1877) divenne famoso per avere predetto l'esistenza di un nuovo pianeta, Nettuno, dalle perturbazioni che provoca sul moto di Urano. Non appena le osservazioni rivelarono irregolarità nel moto di Mercurio, Le Verrier e altri astronomi ipotizzarono l'esistenza di un nuovo pianeta, Vulcano, il più interno del Sistema solare, causa di quelle perturbazioni. Le Verrier arrivò persino a descrivere sulla base di precedenti scarse informazioni (probabilmente soltanto le macchie solari) quella che sarebbe potuta essere l'effettiva orbita di Vulcano, annunciando anche che sarebbe passato davanti al Sole in una certa data. Non accadde nulla e gli astronomi rimasero delusi e preoccupati. Infatti, il perielio di Mercurio compie una precessione di circa 5600″ a secolo, tutti, salvo 43″, spiegati dalla perturbazione newtoniana dovuta agli altri pianeti. Calcolando esattamente il moto dei pianeti con le equazioni della RG, si dimostra che realmente si può dar conto dei 43″ addizionali e predire effetti simili per gli altri pianeti, anch'essi in accordo con le osservazioni. Questo accordo tra previsioni teoriche e dati sperimentali è molto importante, poiché dipende da caratteristiche proprie della RG che non hanno precedenti nella teoria newtoniana.

Sfortunatamente, l'interpretazione dell'avanzamento del perielio di Mercurio come chiara conferma della teoria della RG è complicata: errori sistematici di osservazione ed errori nella valutazione degli effetti planetari potrebbero invalidare l'accordo. Sull'avanzamento del perielio di Mercurio possono influire numerosi fattori. Tra questi, uno dei più indagati è quello relativo allo schiacciamento polare del Sole, che porterebbe all'introduzione di un contributo del termine di quadrupolo J2 nel potenziale gravitazionale. Se si assume che il Sole ruoti su sé stesso con una velocità angolare uniforme che produce lo schiacciamento polare, misurando la velocità di rotazione del Sole è possibile dedurre un valore sufficientemente piccolo, J2≈10−7, che giustifichi il pieno accordo tra la RG e la precessione del perielio di Mercurio. Una serie di misure ottenute nel 1966 da Dicke e H. Mark Goldenberg davano invece J2≈2,5×10−5, un valore che implica un disaccordo tra RG nella sua formulazione standard e dati osservati sulla precessione di Mercurio. Anche su questa base sono state approfondite le ricerche di teorie della gravità, competitive con la RG, tra le quali, in particolare, la teoria di Brans-Dicke. In questa gli effetti, come la precessione del perielio di Mercurio, sono spiegati in modo diverso che nella RG standard: sono messi in relazione allo schiacciamento polare del Sole e fatti dipendere dal campo scalare aggiuntivo introdotto nella teoria. Se il valore di J2 fosse dell'ordine di quello trovato da Dicke e Goldenberg esso contribuirebbe a spiegare 4″ dei 43″ dell'avanzamento del perielio di Mercurio, ponendo seri limiti all'accordo tra previsioni della RG e osservazioni, mentre la teoria di Brans-Dicke sarebbe in perfetto accordo fissando uguale a circa 5 la costante ω che compare nel parametro γ del formalismo PPN. Altre osservazioni sul Sistema solare, delle quali parleremo tra breve, forniscono invece valori di ω ben più alti. D'altra parte, a partire dal 1982, ulteriori misurazioni, anche se non ancora definitive, hanno portato a un valore del termine di quadrupolo tra 10−6 e 10−7, assai prossimo a quello richiesto per il pieno accordo tra precessione di Mercurio e teoria della RG nella sua formulazione standard, permettendo al contempo di elevare il valore di ω come richiesto da altre evidenze sperimentali. Si può comunque affermare che la precessione di Mercurio rimane uno dei capisaldi osservativi della teoria della RG, anche perché pone limiti stringenti su teorie competitive come quella di Brans-Dicke.

Accanto alla precessione del perielio di Mercurio sono state recentemente migliorate le misure relative alle precessioni di altri pianeti. Il perielio di Venere compie una precessione di circa 5069″ a secolo, dei quali solamente 8,6″ necessitano delle correzioni della RG; per la Terra si hanno 6189″, dei quali soltanto 4″ richiedono correzioni della RG; per Marte si hanno 6627″, dei quali soltanto 1,35″ necessitano delle correzioni della RG. A causa della minore entità degli effetti non spiegabili nell'ambito della teoria newtoniana, queste misurazioni risultano più difficili di quelle relative al perielio di Mercurio.

Parlando di precessioni delle orbite vale la pena di citare le pulsar binarie. La prima pulsar binaria, PSR 1913+16, è stata scoperta nel 1974 da Russel Hulse e Joseph Taylor; a questa, a partire dagli anni Novanta, si è via via aggiunta un'intera famiglia di pulsar binarie. Esse costituiscono un laboratorio naturale unico per verificare gli effetti relativistici. PSR 1913+16 è composta da due corpi collassati, probabilmente ambedue stelle a neutroni, con un raggio di circa 10 km, con un'orbita molto stretta ed eccentrica con semiasse maggiore di circa 700.000 km ‒ giusto per dare un'idea, l'orbita del sistema binario potrebbe essere contenuta all'interno del Sole ‒ e un periodo di rivoluzione di circa 8 ore. Uno soltanto dei due corpi emette pulsazioni con un periodo di 59 millisecondi; l'altro (detto stella compagna) potrebbe essere anche una nana bianca, una stella di elio o un buco nero. In queste condizioni la precessione del periastro è di 4,22° ad anno ed è abbastanza facile da osservare. Riparleremo delle pulsar binarie nell'ambito degli effetti legati ai campi gravitazionali intensi. Va ricordato comunque che ancora oggi la RG è la teoria che fornisce le migliori e più dirette previsioni per quanto concerne l'avanzamento del periastro nelle pulsar binarie.

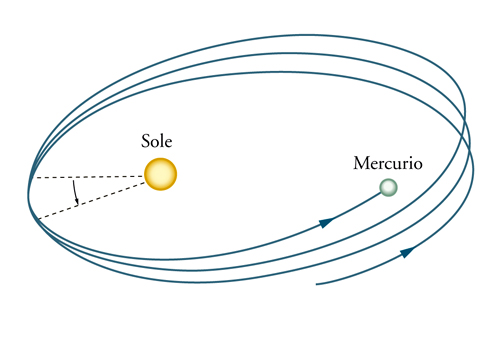

Il secondo test classico riguarda la deflessione della luce. Einstein divenne famoso nel mondo dopo la esatta predizione della deflessione Δφ (fig. 3) dei raggi di luce che passano radenti al bordo del Sole (cioè a una distanza pari al raggio R⊙ del Sole; per distanze d>R⊙ la deflessione diminuisce ed è uguale a circa 1,75″ R⊙/d). In una delle prime versioni della teoria (1911), Einstein predisse un valore (0,87″ di arco) che è in realtà solamente la metà di quello corretto (circa 1,75″ di arco, come comunicato dallo stesso Einstein nel novembre del 1915). Vari ostacoli, tra i quali l'inizio della Prima guerra mondiale, impedirono un esperimento prematuro che avrebbe screditato la teoria. Nel 1919, la spedizione di Eddington a Prince Island, nell'emisfero meridionale, riuscì finalmente a compiere osservazioni su un'eclissi totale di Sole che concordavano con il valore teorico corretto. Utilizzando il formalismo PPN, la deflessione per raggi radenti al Sole è espressa da [(1+γ)/2] 1,75″. Il coefficiente (1+γ)/2, che ha valore 1 nella RG, assume valori diversi nelle diverse teorie metriche a seconda del valore assunto da γ: il primo addendo, 1/2, può essere calcolato ricorrendo soltanto al principio di equivalenza, determinando la deflessione che si produce in una sequenza di osservatori in caduta libera lungo la traiettoria del fotone nel passaggio da un osservatore all'altro; il secondo addendo, γ/2, dipende dal fatto che a causa della curvatura dello spaziotempo le linee rette locali sono curvate proprio da questo fattore relativamente alle linee rette lontane (asintoticamente) dal Sole.

Se l'approssimazione delle prime misure di deflessione della luce condotte da Eddington era di circa il 30%, gli sviluppi della radioastronomia hanno notevolmente aumentato l'accuratezza delle misure, in buon accordo con la RG. Nelle eclissi la misurazione della deflessione della luce da parte del Sole è condotta in due fasi. Nella prima si aspetta un'eclissi totale di Sole in una regione opportuna e si fa una fotografia del campo di stelle intorno al Sole. Nella seconda fase questa fotografia è paragonata con un'altra dello stesso campo fatta sei mesi dopo, quando gli effetti del Sole sono divenuti minimi. I risultati delle osservazioni sono attualmente in accordo con il valore previsto entro il 10%. L'esperimento è stato ripetuto su vari gruppi di quasar che sono periodicamente nascoste dal Sole, utilizzando un radiotelescopio e senza più la necessità di essere in presenza di un'eclissi. I più recenti di questi esperimenti hanno errori relativi che vanno da qualche parte su mille, (1+γ)/2=0,9996±0,0017, a qualche parte su diecimila, (1+γ)/2=0,99992±0,00014, in buon accordo con le previsioni della RG.

La deflessione gravitazionale è presente ogni qualvolta ci siano masse interposte tra la sorgente e il ricevitore. Einstein, già nel 1936, aveva considerato alcune sorprendenti conseguenze astronomiche di questo effetto. Supponendo la presenza di un corpo di massa molto grande interposto tra la Terra e un oggetto astronomico distante (come una quasar), Einstein aveva previsto che la luce passando su bordi opposti del corpo fosse deviata verso l'esterno simulando due immagini dello stesso oggetto. Nel 1979 è stata osservata effettivamente per la prima volta una coppia di quasar, separate nel cielo di soli 6″, che mostravano identiche componenti dello spettro di emissione con spostamenti verso il rosso assolutamente uguali. Successivamente, tra il 1980 e il 1981, ricerche ottiche hanno evidenziato la presenza di una debole galassia ellittica collegata a un ammasso di galassie, a distanza di 1″ da una delle immagini. È la prima evidenza che una galassia o un ammasso di galassie, che si frappone tra noi e una quasar, si comporta come una gigantesca 'lente gravitazionale'. L'effetto finale è quello di simulare la presenza di due o più quasar con la stessa distribuzione spettrale e lo stesso red shift gravitazionale; inoltre, eventuali fluttuazioni di luminosità di un'immagine si ripresentano nell'altra, con un ritardo di alcuni mesi dovuti alla differenza di cammino ottico. Dal numero e dalle caratteristiche delle immagini prodotte da tali lenti gravitazionali si sono potute ricavare preziose informazioni sulle loro dimensioni e distanze. Per queste ragioni queste 'lenti galattiche' sono sfruttate per diminuire le incertezze sul valore della costante di Hubble, un dato di primaria importanza nello sviluppo dei modelli cosmologici.

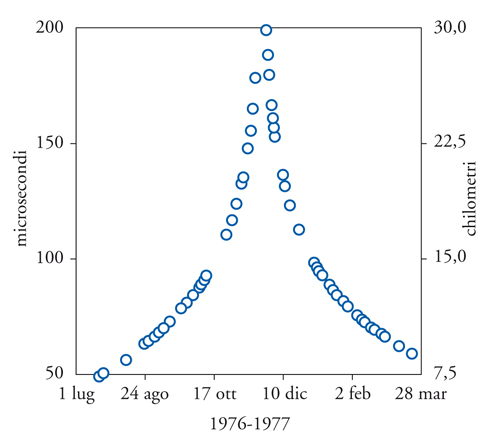

Strettamente legato alla deflessione della luce è un altro test di alta precisione sulla curvatura dello spaziotempo noto come 'ritardo temporale di Shapiro', dal nome dello scienziato Irwin Shapiro che lo propose nel 1964. Esso riguarda il ritardo dei segnali di luce che passano vicino al Sole ed è alla base di esperimenti assai accurati che utilizzano, in particolare, la propagazione di onde radio. Nel vuoto queste si propagano alla velocità costante della luce; quindi la misurazione del tempo di andata e ritorno di un segnale inviato dalla Terra su un pianeta permette di ricavare la distanza tra il pianeta e la Terra. Nel caso di Marte, la cui orbita è particolarmente eccentrica, questa distanza varia da un valore minimo di circa 80 milioni di km a un valore massimo di circa 380 milioni di km, tranne quando il cammino delle onde Terra-Marte passa vicino al bordo del Sole. In quella regione Marte sembra muoversi fuori dalla sua orbita, allontanandosi progressivamente fino a circa 30 km (equivalenti a un ritardo anomalo di circa 200 microsecondi) prima di tornare nuovamente al suo cammino normale: per circa due mesi e mezzo Marte appare spostato di più di 15 km dalla sua orbita (fig. 5). La spiegazione di tale fenomeno è che per effetto della massa solare la luce viaggia più lentamente nelle vicinanze del Sole.

I metodi per misurare i ritardi nell'eco di impulsi radar sono sostanzialmente due. Il primo utilizza la riflessione passiva di impulsi radar da parte dei pianeti, osservata per la prima volta nel 1959 con impulsi radar inviati su Venere. I limiti di precisione di questa tecnica sono essenzialmente dovuti alla conoscenza approssimativa della topografia dei pianeti e al loro basso potere riflettente: l'accuratezza delle misure è comunque notevole, arrivando a circa 5 microsecondi (corrispondente a 1,5 km). Il secondo metodo invece utilizza la riflessione attiva dei segnali per mezzo di transponder (apparati di ricezione, amplificazione e ritrasmissione di segnale) trasportati da satelliti artificiali (tra i più noti: Mariner 6 e Mariner 7, Mariner 9, Viking e Voyager 2) o collocati sulla superficie dei pianeti (Viking). Le misurazioni effettuate con questi sistemi sono notevolmente migliorate in quanto alla precisione, che arriva fino a 1/10 di microsecondo (corrispondente a 30 m).

Nell'espressione del ritardo temporale in condizioni di campo debole compare di nuovo il fattore (1+γ)/2, indicazione dello stretto legame tra questo fenomeno e la deflessione della luce. Gli attuali risultati, ottenuti da Shapiro per il ritardo temporale dal Viking e per la deflessione della luce con la tecnica VLBI (very-long-baseline radio interferometry), che riesce ad apprezzare differenze angolari dell'ordine di 100 microarcosecondi, danno (1+γ)/2=1, a meno, rispettivamente, di circa 1 parte su mille e di 2 parti su diecimila. Quest'ultimo risultato porta a fissare per le teorie metriche con scalare e tensore del tipo Brans-Dicke un valore ω>3500.

Il principio di equivalenza forte

Il principio di equivalenza di Einstein asserisce che l'invarianza locale di Lorentz e l'invarianza locale di posizione sono rispettate da tutte le leggi della fisica che non coinvolgano la gravitazione. Se si estende il principio di equivalenza di Einstein, localmente, a tutte le leggi della fisica compresa la gravitazione si ha il cosiddetto principio di equivalenza forte (PEF) secondo il quale non solamente i corpi di prova (quelli di dimensione degli usuali laboratori) ma anche i corpi celesti (pianeti e stelle) cadono tutti con la stessa accelerazione in un campo gravitazionale esterno. Inoltre, in analogia con la seconda e terza asserzione del principio di equivalenza di Einstein, in un sistema di riferimento locale in caduta libera abbastanza grande da contenere corpi come pianeti o stelle, tutte le leggi della fisica, comprese quelle della gravitazione, non dipendono né dalla velocità né dalla posizione spaziotemporale del sistema di riferimento in caduta libera.

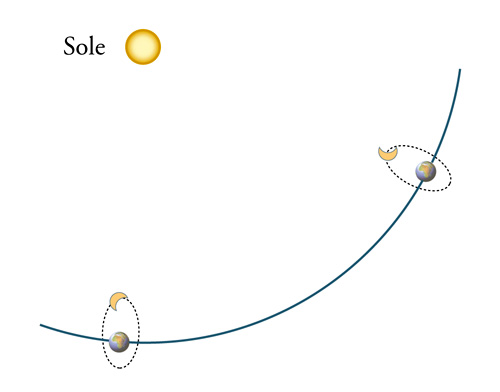

Il principio di equivalenza forte è un principio molto più vincolante di quello di equivalenza di Einstein e, a tutt'oggi, l'unica teoria metrica che non lo violi è la RG. Per questo, gli esperimenti di verifica del principio di equivalenza forte acquistano una particolare importanza tra gli esperimenti di conferma della RG. Una violazione del principio di equivalenza forte implicherebbe che l'energia di legame gravitazionale di un corpo contribuisca in modo diverso alla massa inerziale e alla massa gravitazionale del corpo stesso. Questo fatto, considerato per la prima volta da Nordtvedt nel 1968 e da allora noto come 'effetto Nordtvedt', può essere messo in evidenza da osservazioni sulle orbite di rivoluzione del sistema Terra-Luna in una sorta di esperimento planetario di tipo Eötvös. A causa, infatti, delle differenze tra massa inerziale e massa gravitazionale, la Terra e la Luna dovrebbero palesare differenti accelerazioni di caduta sul Sole, che si tradurrebbero in una elongazione dell'orbita lunare nella direzione Terra-Sole (fig. 6). A partire dalla missione Apollo del 1969 sono stati sistemati sulla Luna opportuni riflettori di raggi laser inviati dalla Terra. Il Lunar laser ranging experiment (LURE) utilizza proprio questo sistema di riflettori, misurando i tempi di andata e ritorno dei segnali luminosi e ricavando precise misure della distanza Terra-Luna. I dati accumulati in circa trent'anni di sistematiche osservazioni permettono oggi di conoscere la distanza Terra-Luna nelle varie fasi dell'orbita lunare con un'accuratezza che ha raggiunto il centimetro (equivalente a circa 50 picosecondi). La precisione raggiunta implica che l'identità tra massa inerziale e massa gravitazionale per la Terra e la Luna è verificata a meno di 5 parti su 1013. I risultati dell'esperimento, inoltre, implicano che nella teoria di Brans-Dicke la costante di accoppiamento ω debba essere maggiore di 1000.

Tra le conseguenze del principio di equivalenza forte ne va segnalata un'altra di grande interesse sia teorico sia sperimentale. L'invarianza locale di posizione spaziotemporale contenuta nel principio di equivalenza di Einstein, di cui abbiamo già detto, ha un'importante implicazione: tutte le costanti fisiche fondamentali (come la velocità della luce nel vuoto, la costante di Planck, la carica e la massa dell'elettrone, la massa del protone, ecc.) che compaiono nelle leggi fisiche non gravitazionali devono essere indipendenti dal tempo. Se il principio di equivalenza forte è valido, allora anche le costanti che compaiono nelle leggi di gravitazione, in particolare la costante G di gravitazione, devono essere indipendenti dal tempo.

Come già osservato, si possono però congetturare violazioni del principio di equivalenza forte. Gli esempi più noti di teorie che contemplano la variazione di G con il tempo sono la cosmologia ipotizzata da Paul Dirac tra il 1937 e il 1938 e le teorie metriche con scalare e tensore come la teoria di Brans-Dicke. Secondo l'idea di Ernest Mach, la massa inerziale mi e la massa gravitazionale mg di un corpo dipendono dalla distribuzione delle altre masse nell'Universo. Quello che di fatto possiamo misurare direttamente non è mg, ma Gmg. Si può allora ipotizzare che G vari al variare della distribuzione e del moto della massa-energia nell'Universo, per esempio a causa dell'espansione di quest'ultimo. Nella teoria di Brans-Dicke G effettivamente dipende da una funzione, determinata dalla distribuzione di massa-energia dell'Universo, identificata con il campo scalare aggiuntivo. La questione è uno dei punti più interessanti dell'attuale dibattito sulla gravitazione, anche alla luce di nuove evidenze sperimentali di cui parleremo nella sezione finale sulla cosmologia. Attualmente gli esperimenti più accurati per determinare la dipendenza di G dal tempo indicano un limite di variazione di G su scala di tempo cosmico inferiore a qualche parte su 1011 anni.

Campi gravitazionali intensi e onde gravitazionali

Nel Sistema solare il campo gravitazionale è sufficientemente debole da poter applicare il formalismo PPN, utilizzando soltanto il primo termine di correzione alla teoria newtoniana. La questione è più complessa nel caso di campi gravitazionali intensi, evidenziati da molte situazioni astronomiche. Quelle oggi maggiormente studiate sono relative alla formazione, struttura e dinamica delle stelle di neutroni e dei buchi neri. In alcuni casi è possibile tentare di calcolare correzioni di ordine superiore del formalismo PPN; in altri le tecniche di analisi da utilizzare sono diverse; tra esse si segnalano le ricerche di una soluzione generale delle equazioni di Einstein con metodi numerici, uno dei settori attualmente in espansione. D'altra parte, nell'ambito dei campi gravitazionali intensi le teorie della gravitazione e delle particelle elementari (in particolare la teoria quantistica dei campi, nota come Modello standard delle particelle, e le teorie di stringa) hanno una forte intersezione che complica ulteriormente il quadro.

Senza entrare nei dettagli, ci limiteremo a descrivere alcuni importanti risultati teorici e sperimentali recenti che coinvolgono campi gravitazionali intensi. Questi risultati riguardano le 'onde gravitazionali' e potrebbero preludere a una svolta nelle tecniche di osservazione astronomica.

Proprio come il campo di Maxwell possiede 'quanti' ('i fotoni') associati alla propagazione di onde, si suppone che anche il campo gravitazionale abbia 'quanti' ('i gravitoni') associati a moti ondulatori. Le equazioni di campo per la gravitazione sono non lineari e ciò rende difficile determinare soluzioni esatte per onde gravitazionali arbitrarie. Se ci limitiamo al caso più realistico delle onde deboli, è allora possibile risolvere l'equazione di campo della RG con il metodo della approssimazione lineare; questa è certamente adeguata per la maggior parte degli scopi. Le onde gravitazionali si propagano alla velocità della luce e, proprio come la luce, hanno due distinti stati di polarizzazione. I gravitoni sono particelle di spin 2 e il loro comportamento, se sottoposti a una rotazione, è abbastanza diverso da quello dei fotoni (particelle di spin 1). Infatti, se si ruota il campo lungo la linea di propagazione, il gravitone torna nella posizione originale dopo 180°; per i fotoni ciò accade dopo 360°, per gli elettroni (particelle di spin 1/2) dopo 720°: in generale, servono 360°/J, dove J è lo spin della particella. Ulteriori differenze si verificano anche nel meccanismo di emissione di radiazione e possono essere viste nel seguente modo. È noto che una particella carica accelerata perde energia per emissione di radiazione; in prima approssimazione, la potenza emessa è analoga a quella di un dipolo elettrico oscillante ed è direttamente proporzionale alla quarta potenza della frequenza ν della radiazione. La formula corrispondente per l'emissione gravitazionale da parte di una massa accelerata fornisce invece una potenza dell'ordine di ν6, perché nel caso gravitazionale si ha a che fare con un'emissione di quadrupolo. Non esiste infatti nessuna radiazione di dipolo per le onde gravitazionali (questo è vero nella RG ma non in altre teorie alternative della gravitazione) e, naturalmente, nessuna radiazione di monopolo, come avviene anche nel campo di Maxwell. Da ciò consegue che si producono onde gravitazionali solamente per particolari moti accelerati delle masse, del tipo di quelli nei quali la sorgente cambia forma, cioè nei casi in cui la dinamica non è uguale in tutte le direzioni (dinamica non sferica). Vibrazioni o collassi di stelle puramente sferici non producono radiazione gravitazionale.

Oltre a quelle appena ricordate, esiste un'altra fondamentale differenza tra onde elettromagnetiche e onde gravitazionali, che ha importanti conseguenze sul piano sperimentale: la potenza emessa da masse accelerate è sempre estremamente piccola, e quindi di difficile osservazione, a differenza di quella emessa da corpi carichi accelerati (che per questo è utilizzata in innumerevoli dispositivi di uso quotidiano, come, per es., le antenne di trasmissione e ricezione di segnali per le radiocomunicazioni).

La potenza emessa da masse accelerate diventa una frazione apprezzabile se la massa M vibra o compie moti di rivoluzione a velocità relativistiche ad altissima frequenza; la frequenza di riferimento è nota come 'frequenza di Schwarzschild' ed è pari a c3/(MG). Condizioni che, seppure lontanamente, richiamano questa situazione sono veramente rare. Alcuni dei fenomeni candidati per l'emissione di radiazione gravitazionale potenzialmente osservabile sono: il collasso di una supernova non isotropa (una stella che esplode e il cui nucleo collassa in modo disuguale nelle diverse direzioni); la collisione tra due stelle di neutroni; il moto a spirale di due buchi neri che cadono l'uno sull'altro fino a unirsi. Quanto lontane siano queste situazioni da quelle che si presentano nel Sistema solare è dimostrato dal calcolo applicato al caso del moto di rivoluzione della Terra, dal quale si ricava che la perdita di energia per emissione di onde gravitazionali ha il valore irrisorio di 200 W ca., ossia l'energia dissipata da una comune lampadina alogena. Ciò significa che un collasso gravitazionale dell'orbita terrestre avverrà fra circa 1024 anni. Altre cause, quali perturbazioni da parte dei pianeti, probabilmente agiranno molto prima, diciamo fra circa 1010 anni.

Nel caso della pulsar binaria PSR 1913+16, di cui abbiamo già parlato, il periodo di rivoluzione è di poche ore e il sistema dovrebbe decadere fra circa 109 anni. Questo fa sì che la perdita di energia per emissione di onde gravitazionali abbia un valore entro i limiti di osservazione: la perdita di energia si evidenzia nella diminuzione del periodo orbitale di 7,2×10−5 secondi all'anno circa. Si è potuto così concludere che l'effetto esiste in perfetto accordo con la teoria dell'approssimazione di quadrupolo.

Tuttavia, siamo di fronte in questo caso a evidenze indirette delle onde gravitazionali; vediamo le perdite di energia del sistema che le emette ma non siamo in grado di riceverle nel nostro laboratorio. Proprio per ottenere questo risultato, molti gruppi di ricercatori, sulla spinta del lavoro pionieristico di Joseph Weber (iniziato nei primi anni Sessanta nell'Università del Maryland a Baltimora), hanno cominciato a costruire ricevitori gravitazionali (antenne gravitazionali). Generalmente, questi dispositivi sono grandi cilindri di alluminio. Le onde in entrata (che ci si aspetta nella regione di 1 kHz) produrranno piccole oscillazioni nella forma del cilindro che, se tutto procede correttamente, potranno essere rilevate. La sensibilità degli apparati di misura di onde gravitazionali può essere espressa dal rapporto Δl/l tra l'ampiezza Δl dell'oscillazione prodotta nell'antenna e la lunghezza l dell'antenna. Nel caso dei primi strumenti utilizzati da Weber, questa sensibilità non era superiore a 10−15. Negli anni successivi, raffreddando il cilindro (per diminuire gli effetti dovuti all'agitazione termica) e utilizzando cavità con materiale superconduttore, questo tipo di strumenti ha raggiunto sensibilità dell'ordine di 10−18, che significa grosso modo riuscire ad apprezzare una vibrazione delle estremità della barra dell'ordine del centomilionesimo delle dimensioni di un atomo di idrogeno su una lunghezza di qualche metro. Solo con una grande dose di fortuna si può pensare di osservare un tale evento.

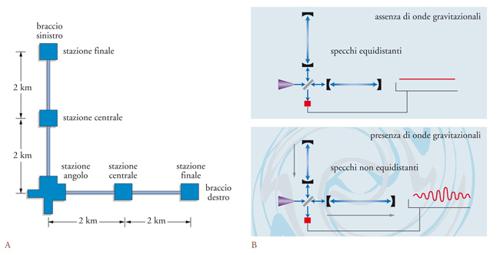

Sono stati anche progettati ricevitori gravitazionali basati su schemi interferometrici, la cui sensibilità sarebbe molto più elevata (10−22 e oltre). Essi sono costituiti da due gallerie lunghe alcuni chilometri che si intersecano ad angolo retto. Alle estremità delle gallerie e nel punto di intersezione sono sospese masse le cui distanze relative sono misurate accuratamente per mezzo di impulsi laser. In tal modo è possibile apprezzare cambiamenti della distanza tra le masse dell'ordine di un centomilionesimo del diametro di un atomo di idrogeno (su distanze di vari chilometri). I rivelatori LIGO (Laser interferometer gravitational-wave observatory, costruito negli Stati Uniti da una collaborazione tra Caltech e MIT) (fig. 7), e VIRGO, realizzato in Italia da una cooperazione tra enti di ricerca francesi e italiani, insieme a GEO600 (nato da una collaborazione tra Germania e Inghilterra) e TAMA300 (Giappone), sono già quasi tutti operativi. A questi si aggiungerà, intorno al 2012, LISA (Laser interferometer space antenna), nato da una cooperazione ESA-NASA, un interferometro laser orbitante costituito da tre navicelle spaziali separate da distanze di milioni di chilometri.

La rilevazione diretta di onde gravitazionali aprirebbe nuove strade all'astrofisica, permettendo di seguire in dettaglio i collassi gravitazionali di supernovae e molti altri fenomeni che coinvolgono stelle di neutroni e buchi neri. Non è escluso, inoltre, che si arrivi a rilevare onde gravitazionali provenienti da altre galassie. Si spera, così, di dare inizio all''astronomia gravitazionale'.

Gravitazione e cosmologia

Dal 'gran dibattito' al modello del big bang

Dopo i grandi modelli cosmologici dell'Antichità, la rinascita della cosmologia come scienza che studia la struttura e la dinamica dell'Universo è relativamente recente. Il primo grande allargamento degli orizzonti dell'Universo cominciò soltanto nella seconda metà del Settecento, quando l'inglese William Herschel (1738-1822) iniziò una sistematica osservazione e catalogazione delle stelle e delle numerose nebulose. Dai conteggi delle stesse e dalla congettura che stelle di luminosità minore fossero le più lontane, egli dedusse che il sistema di stelle chiamato 'Via Lattea' ha la forma appiattita di un disco. Poiché il numero di stelle sembrava crescere uniformemente con la distanza in tutte le direzioni, Herschel ne concludeva che il Sistema solare si trova al centro della Via Lattea. Tale teoria veniva avvalorata un secolo dopo da Jacob Cornelius Kapteyn (1851-1922), che pure utilizzava metodi più raffinati di stima delle distanze stellari. Soltanto Harlow Shapley, e siamo già intorno agli anni Venti del XX sec., stabilì che il Sole non si trova al centro della Via Lattea.

Tuttavia, ancora in quegli anni rimaneva aperta la questione se la Via Lattea si estendesse all'intero Universo o se fosse solamente uno degli innumerevoli ammassi di stelle che lo popolano, separati da enormi distanze. Il tema fu al centro di un famoso dibattito tra Heber D. Curtis, del Lick Observatory, e Shapley, del Mount Wilson Observatory, svoltosi negli anni Venti, sulla natura delle spirali. Shapley riteneva che esistesse solo un Universo-isola, la 'Via Lattea', e credeva che le spirali fossero in realtà oggetti posti all'interno di esso. Curtis (Kant aveva avuto quest'idea prima di lui) sosteneva invece che ogni spirale fosse un Universo-isola simile alla nostra Galassia. Un dibattito che appare quale ultimo capitolo della rivoluzione copernicana, l'estrema battaglia contro il geocentrismo camuffato da galassiocentrismo. La costruzione di grandi telescopi e il lavoro di Edwin P. Hubble avrebbero definitivamente risolto la questione una decina di anni dopo. Aveva ragione Curtis: le spirali sono in realtà altre galassie e l'Universo è pieno di 'polvere di galassie'. Queste, e non le stelle, sono i granelli fondamentali di materia che dobbiamo considerare quando pensiamo su grande scala. Esistono circa dieci miliardi di galassie potenzialmente osservabili. Sulla scala di 100 megaparsec (1 parsec è circa 3,26 anni-luce, ossia 3,09×1016 m, e un megaparsec è un milione di parsec) la loro distribuzione è approssimativamente uniforme e le loro distanze relative sono di alcuni milioni di anni-luce.

Tuttavia già nel 1917, prima che Hubble avesse gettato le basi osservative della moderna cosmologia, Einstein si era avventurato nella terra di nessuno dove la relatività comincia a rivelare qualcosa sull'Universo. Nell'articolo Kosmologische Betrachtungen zur allgemeinen Relativitätstheorie (Considerazioni cosmologiche sulla teoria della relatività generale), egli proponeva un modello basato sul fondamentale 'principio cosmologico', ancora oggi alla base del modello cosmologico standard, tuttavia non teneva conto dell'espansione dell'Universo, annunciata da Hubble soltanto nel 1929. L'idea, vecchia di millenni, da cui Einstein era partito era quella di un Universo statico. Risolvendo le sue equazioni per la RG, egli si era accorto che esse escludevano questo tipo di Universo: sotto l'azione della forza di gravità esercitata dalla materia in esso presente, l'Universo sarebbe collassato su sé stesso. Per evitare questo effetto, Einstein era stato portato a introdurre nelle sue equazioni un termine aggiuntivo Λ, chiamato 'costante cosmologica', interpretabile come una sorta di repulsione cosmica che deve compensare l'azione della gravità stabilizzando il sistema Universo.

Purtroppo, come avrebbe notato per primo Eddington, la struttura rimaneva in uno stato di equilibrio instabile e una qualsiasi perturbazione avrebbe destabilizzato in breve tempo anche questo Universo. Intanto però, già a partire dal 1917, si faceva avanti l'idea che l'Universo non fosse statico, ma in espansione. Il primo a proporre un modello di Universo in espansione (ancora con costante cosmologica) è stato l'olandese Willem De Sitter (1917). Tuttavia le basi generali del modello cosmologico standard sono state scoperte nel corso degli anni Venti, quando uscirono i lavori del russo Aleksandr Fridman (1922) e, indipendentemente, del belga Georges Lemaître (1927), che postulano un Universo in espansione con o senza costante cosmologica. L'ipotesi dell'Universo in espansione è stata confermata nel 1929 dalle osservazioni di Hubble e dall'annuncio della recessione cosmica. Il modello standard della cosmologia, noto come 'modello del big bang' con riferimento alla grande esplosione che avrebbe dato origine all'Universo in espansione, è tuttora contestato da una minoranza di cosmologi che propongono meccanismi alternativi, nell'ambito di modelli stazionari o quasi stazionari, per spiegare le diverse evidenze sperimentali da allora via via accumulate (Hermann Bondi, Thomas Gold e Fred Hoyle negli anni Quaranta e Halton C. Arp, Jayant V. Narlikar e altri negli anni Novanta).

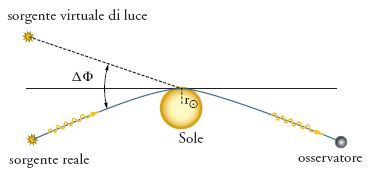

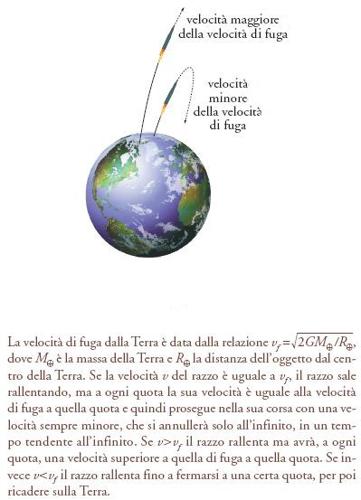

Il modello cosmologico standard proposto da Fridman poggia su due fondamentali requisiti: l'adozione della RG e il principio cosmologico. Per quanto riguarda la RG, Fridman dimostra che le equazioni di Einstein (senza costante cosmologica) ammettono tre soluzioni dipendenti dalla densità ϱ0 di materia-energia dell'Universo, collegata alla decelerazione di espansione dell'Universo: se la densità ϱ0 è uguale al valore critico ϱc l'Universo si espande indefinitamente con velocità via via decrescente; lo stesso succede se ϱ0⟨ϱc, tuttavia la decelerazione è minore rispetto al caso precedente; se ϱ0>ϱc l'Universo è chiuso e alla fase di espansione ne succede una di contrazione. È, mutatis mutandis, quanto accade a un razzo lanciato dalla Terra verso l'alto a seconda che la sua velocità di lancio sia uguale, maggiore o minore della velocità di fuga (fig. 8).

Il secondo requisito del modello cosmologico standard è il 'principio cosmologico'. Esso non segue dalla RG ma riassume solamente quanto si conosce al momento sulla struttura in grande scala dell'Universo visibile; come tale potrebbe essere invalidato da future scoperte osservative. Il principio postula l'esistenza di un tempo cosmologico t tale che, in media e su una scala spaziale abbastanza grande, l'Universo appaia lo stesso in qualunque punto lo si osservi. In particolare, la densità media della materia non dovrebbe dipendere dal punto in cui la si misura, ma soltanto dal tempo t; poiché la curvatura dello spazio dipende dalla distribuzione della materia, ne segue che anche la curvatura dovrebbe dipendere solamente dal tempo t. Un modo naturale di realizzare tale ipotesi è di assumere che a ogni istante t l'Universo abbia una forma simmetrica. Spazi di questo tipo si chiamano 'omogenei'.

Vediamo qualche esempio di spazi omogenei. Il primo esempio ovvio di spazio omogeneo a tre dimensioni è dato dallo spazio euclideo a noi familiare. Un esempio bidimensionale ben noto è dato da una superficie sferica, il luogo di tutti i punti dello spazio la cui distanza da un punto fisso è costante. Un altro spazio bidimensionale omogeneo è il piano, il quale può anche essere concepito come il limite di una sfera il cui raggio diviene molto grande. Esiste un'altra classe di spazi bidimensionali omogenei, ossia gli spazi iperbolici, scoperti dai padri fondatori della geometria non euclidea, Carl Friedrich Gauss (1777-1855), János Bólyai (1802-1860) e Nikolaj Ivanovič Lobačevskij (1793-1856). Non è possibile costruire, come accade per la sfera, l'intero piano iperbolico nel normale spazio tridimensionale; se ne possono costruire solo frammenti che localmente sono incurvati a forma di sella. Piano (curvatura nulla), sfera (curvatura positiva) e piano iperbolico (curvatura negativa) possono essere definiti in dimensioni maggiori di 2. Gli spazi a tre dimensioni servono come modelli per l'Universo. Gli spazi di curvatura positiva, detti ipersfere, sono di volume finito, così come è di estensione finita la sfera; quelli di curvatura nulla o negativa sono di estensione infinita. In tutti questi universi si può traslare o ruotare un oggetto geometrico mantenendone invariata la forma, come accade nello spazio ordinario.