La grande scienza. Imaging diagnostico computerizzato

La grande scienza. Imaging diagnostico computerizzato

Imaging diagnostico computerizzato

Attualmente vengono utilizzate diverse tecniche e svariati approcci fisici per ottenere immagini di strutture anatomiche degli esseri viventi per scopi diagnostici. La disciplina medica che riguarda l'applicazione di queste tecniche viene chiamata diagnostica per immagini o imaging diagnostico.

I computer hanno assunto in questo campo un ruolo fondamentale, al punto che la disciplina dipende ormai quasi completamente dalla tecnologia informatica per l'acquisizione e l'elaborazione dei dati, nonché per la gestione, l'archiviazione, il recupero e la trasmissione dei dati relativi ai pazienti. I computer possono fornire un aiuto importante anche nell'interpretazione delle immagini diagnostiche, che comunque si fonda ancora prevalentemente sull'osservazione da parte di esaminatori esperti.

La storia dell'imaging diagnostico ebbe inizio nel 1895, con la scoperta dei raggi X a opera dello scienziato tedesco Wilhelm Conrad Röntgen (1845-1923). La radiografia, vale a dire la tecnica di imaging diagnostico che utilizza i raggi X, ha rappresentato l'inizio di una serie di scoperte e invenzioni che negli anni Settanta del XX sec. raggiunge il culmine con l'introduzione della prima tecnica di ricostruzione di immagini diagnostiche realizzata con l'ausilio del computer. Questa tecnica, inventata da Godfrey N. Hounsfield è stata definita tomografia assiale computerizzata (TAC, in seguito TC, tomografia computerizzata). Attualmente sono ormai disponibili numerose tecniche di imaging medico, dalla radiografia convenzionale alla tomografia computerizzata, dall'imaging a risonanza magnetica (MRI, magnetic resonance imaging) e dall'ecografia alle tecniche di medicina nucleare, con la tomografia a emissione di positroni (PET, positron emission tomography) e la tomografia computerizzata a emissione di fotone singolo (SPECT, single photon emission computed tomography).

Il ruolo dei computer nell'imaging diagnostico inizia con l'uso delle funzioni dei dispositivi di imaging: attualmente anche i generatori di raggi X per la radiografia convenzionale vengono controllati da microprocessori, così pure l'acquisizione dei dati di medicina nucleare e la produzione e il rilevamento degli ultrasuoni. Le tecniche di imaging TC, MRI, PET e SPECT non sarebbero possibili senza i computer.

In pratica, non esiste un settore della medicina clinica in cui l'imaging diagnostico non fornisca informazioni utili. Le immagini diagnostiche sono utilizzate con due diversi scopi principali, ossia la diagnosi delle malattie e il monitoraggio della risposta al trattamento. Mentre le immagini diagnostiche sono state sempre utilizzate come supporto per la scelta della terapia, l'uso di quelle computerizzate trova applicazione nella scelta delle procedure di trattamento che includono interventi chirurgici e di radioterapia; inoltre costituiscono un valido strumento di apprendimento.

In situazioni particolari, le immagini diagnostiche vengono utilizzate per applicazioni di screening, in particolare per l'individuazione delle malattie prima delle manifestazioni cliniche, ossia prima dello sviluppo dei sintomi e dei segni.

L'evoluzione dalle immagini 'analogiche' convenzionali alle moderne immagini 'digitali' computerizzate costituisce il fondamento per una nuova serie di applicazioni basate sulla 'elaborazione delle immagini'. Le informazioni fornite dalle immagini diagnostiche possono essere potenziate tramite l'applicazione di procedure quali il miglioramento del contrasto, la ricostruzione tridimensionale, la navigazione virtuale, la segmentazione, la coregistrazione e la fusione. Recentemente si è cominciato a sperimentare procedure di elaborazione digitale dell'immagine per una valutazione automatizzata (diagnosi senza supervisione).

Le immagini digitali computerizzate memorizzate in supporti digitali (nastri e dischi) eliminano negli ospedali la necessità di utilizzare grandi archivi convenzionali di imaging diagnostico, con cartelle e pellicole. Inoltre, è possibile recuperare immagini digitali dagli archivi per scopi di consultazione, presentazione e valutazioni comparative per il follow up, da utilizzare sia in reti locali sia in siti remoti (teleradiologia).

Computer e immagini in medicina

La tecnologia informatica ha consentito sia lo sviluppo di nuove tecniche di imaging sia il miglioramento di quelle precedenti. Inoltre il computer è diventato uno strumento fondamentale per la gestione, la programmazione, la creazione di rapporti, l'archiviazione dei dati relativi al paziente e la pianificazione delle diverse attività di un reparto di imaging diagnostico.

Immagini analogiche e immagini digitali

Dal punto di vista fisico, un'immagine può essere definita come funzione bidimensionale dell'intensità della luce f(x,y), dove x e y definiscono le coordinate spaziali. Inoltre, mentre il valore di f in ogni punto di un'immagine in scala di grigi è proporzionale alla luminosità (livello di grigio) in quel punto, nelle immagini a colori esso dipende dal valore dei componenti cromatici in un determinato punto.

Il termine 'analogico' si riferisce a un segnale che varia con continuità, mentre il termine 'digitale' indica un'entità che varia solo mediante passi discreti (fig. 1). Per esempio, un orologio analogico utilizza lancette che si muovono uniformemente e indicano l'ora descrivendo una funzione sinusoidale. Al contrario, gli orologi digitali indicano l'ora con passi discreti (per es., i secondi). In un orologio digitale è possibile un numero limitato di letture sequenziali con passi discreti; non è invece possibile alcuna lettura nell'intervallo di tempo compreso tra due passi consecutivi.

I computer sono in grado di memorizzare e manipolare grandi serie di numeri, conservando tutte le informazioni in formato digitale, cioè numerico. L'imaging diagnostico computerizzato utilizza immagini digitali generalmente ottenute attraverso l'analisi di segnali analogici (di solito elettrici). Di conseguenza, tutte le informazioni analogiche devono essere convertite in formato digitale per poter essere memorizzate ed elaborate da un computer.

Le tecniche di imaging tramite computer sono state introdotte negli anni Settanta. L'impulso alla diffusione dei computer nell'imaging diagnostico è nato dalle esigenze della ricostruzione matematica necessaria per la tomografia computerizzata, l'ecografia e la medicina nucleare.

Un'immagine digitale è composta da elementi discreti, denominati pixel (picture element, elemento dell'immagine), disposti in una matrice bidimensionale. Il numero di pixel che descrive un'immagine digitale definisce le dimensioni della matrice; in genere, le immagini diagnostiche si basano su matrici quadrate di 128×128, 256×256, 512×512, 1024×1024, 2048×2048 pixel. Esiste un rapporto quadratico tra le dimensioni della matrice e il numero dei pixel. Raddoppiando il lato di una matrice, per esempio aumentando il numero dei pixel da 128 a 256, è possibile creare una matrice che contiene un numero di elementi quattro volte maggiore. Di conseguenza, l'aumento di dimensioni della matrice richiederà un incremento quadratico per la memorizzazione dei dati dell'immagine.

Per le immagini a colori è necessario uno spazio di memorizzazione maggiore rispetto a quelle in scala di grigi (cioè visualizzate con una scala di grigi che va dal nero al bianco attraverso una serie di livelli di grigio).

Nella matrice di un'immagine in scala di grigi, ogni pixel è identificato da tre numeri: due di questi definiscono la posizione del pixel all'interno della matrice (riga e colonna), mentre il terzo definisce il contenuto delle informazioni, cioè il 'valore' del pixel che verrà convertito nel livello di grigio corrispondente nell'immagine risultante (visualizzata su un monitor o stampata). Un'immagine digitale a colori richiede invece, per ciascun pixel, oltre alle coordinate spaziali, anche tre valori distinti, che codificano rispettivamente il livello di rosso, verde e blu, cioè i tre colori che possono essere miscelati per creare tutte le possibili combinazioni cromatiche su un monitor.

In un'immagine digitale, la risoluzione spaziale, cioè la capacità di distinguere due oggetti adiacenti come separati, dipende dalla matrice e dalle dimensioni dei pixel. In genere, più alto è il numero di pixel per un determinato campo visivo, maggiore sarà la massima risoluzione spaziale ottenibile. Tuttavia, una valutazione della risoluzione spaziale di un dispositivo di imaging, effettuata esclusivamente in termini di 'dimensioni dei pixel' o di 'dimensioni della matrice', potrebbe essere fuorviante in quanto esistono altri effetti fisici che possono limitare la risoluzione dell'immagine teoricamente ottenibile in base alle dimensioni dei pixel.

La risoluzione dell'immagine può essere anche descritta in termini di frequenze spaziali. Proprio allo stesso modo in cui le frequenze acustiche vengono definite dal numero di volte in cui un volume d'aria viene compresso o rarefatto per la durata di un secondo (ed espresse in unità di Hertz; 1Hz=1 oscillazione/secondo), le frequenze spaziali possono essere definite dal numero di oscillazioni dei livelli di grigio dal nero al bianco nella distanza di 1 mm. La frequenza è inversamente proporzionale alla lunghezza d'onda. Parti diverse dell'immagine avranno differenti frequenze spaziali: i margini che separano strutture diverse e che sono caratterizzati da rapide variazioni dei livelli di grigio conterranno nella maggior parte dei casi frequenze alte, mentre lo sfondo delle strutture corrisponderà a basse frequenze spaziali. Allo stesso modo, un oggetto di piccole dimensioni corrisponderà ad alte frequenze spaziali, mentre un oggetto grande corrisponderà a basse frequenze spaziali.

La riproduzione delle frequenze spaziali è quindi una definizione diversa per la risoluzione spaziale. La capacità di riprodurre fedelmente le frequenze spaziali dell'oggetto originale è definita in termini matematici dalla relativa funzione di trasferimento della modulazione (MTF, modulation transfer function), anziché dalla semplice considerazione del numero e delle dimensioni dei pixel prodotti.

L'MTF descrive la capacità di un sistema di imaging di riprodurre segnali originali su una gamma di frequenze spaziali. Dal punto di vista numerico l'MTF corrisponde alla frazione delle frequenze trasmesse. Di conseguenza, a una determinata frequenza spaziale, l'MTF ha un valore minimo di 0 e uno massimo di 1. Con un MTF uguale a 0 non viene riprodotta alcuna modulazione di segnale; con un MTF uguale a 1 avviene invece un perfetto trasferimento del segnale originale. In genere, la capacità di un sistema di imaging di rappresentare un segnale diminuisce con l'aumento della frequenza spaziale del segnale. L'MTF può essere utilizzata per valutare la risoluzione spaziale nei sistemi di imaging sia analogici (per es., basati su pellicole) sia digitali e in tutte le tecniche di imaging.

Visualizzazione dell'immagine

Il valore di pixel memorizzato (input) deve essere tradotto in un valore di immagine di uscita (output), utilizzando una serie di livelli di scala di grigi o di livelli cromatici per riportare l'immagine visualizzata come una distribuzione di valori di intensità su un monitor o su una stampa.

Nelle immagini mediche, l'identificazione degli elementi diagnostici rilevanti dipende non solo dalla risoluzione spaziale, ma anche dalla risoluzione di contrasto, cioè dai diversi livelli di colore o di grigio delle strutture contigue. Il numero di livelli di grigio è espresso in cifre binarie (o bit) di informazioni per pixel. Poiché a ogni pixel è assegnato un valore discreto (digitale) di intensità della scala di grigi, è possibile definire una profondità di bit o risoluzione in scala di grigi dell'immagine.

Nonostante l'incapacità di un normale occhio umano di distinguere tra più di 32 livelli di grigio (in genere da 16 a 20), più alto è il numero di livelli della scala di grigi, migliore sarà la risoluzione del contrasto. Una risoluzione a singolo bit presenterà i dati con due possibili livelli, ossia la scelta di 'nero' o 'bianco' per ciascun pixel. Aumentando il numero di bit della scala di grigi, crescerà in proporzione anche il numero di livelli di grigio disponibili. In un sistema a 4 bit ogni pixel può avere valori di scala di grigi pari a 24 (cioè 16). In un sistema a 8 bit ogni pixel può avere valori di scala di grigi pari a 28 (cioè 256), con una migliore qualità di visualizzazione delle immagini. La risoluzione della scala di grigi va progressivamente aumentando, al punto che un rilevatore digitale di immagini a raggi X a stato solido può già utilizzare livelli di grigio a 14 bit (o 16.000).

In conclusione, la capacità di estrarre informazioni diagnostiche da un'immagine dipende da una combinazione di risoluzione spaziale e di contrasto, nonché dalla possibilità di alterare l'immagine. Il modo più semplice per alterare un'immagine consiste nella modifica della presentazione dei livelli di grigio dei dati contenuti nell'immagine originale.

L'occhio umano è in grado di distinguere le combinazioni di colori con una capacità superiore rispetto a quella dei livelli di scala di grigi. L'utilizzazione dei colori è teoricamente vantaggiosa. Tuttavia, nella maggior parte delle modalità di imaging (radiografia, ecografia, TC) le immagini si basano sulla valutazione di un singolo parametro fisico, quale la densità dei tessuti, per cui una presentazione monocromatica (in scala di grigi) è sufficiente per visualizzare le informazioni necessarie.

I colori possono essere utili per visualizzare immagini in cui il segnale rilevato derivi dalla combinazione di diversi parametri fisici, come nelle immagini a risonanza magnetica, dove la presentazione del colore può essere utilizzata per la visualizzazione simultanea di più parametri. I colori possono essere utilizzati anche per visualizzazioni simultanee di immagini sovrapposte, ottenute mediante differenti modalità di imaging.

Attualmente la visualizzazione a colori trova largo impiego soprattutto in medicina nucleare e per immagini in cui viene presentata una combinazione di dati anatomici e funzionali, come si verifica nelle immagini ottenute con ecografia color Doppler, dove le informazioni anatomiche sono visualizzate in scala di grigi, mentre quelle funzionali sovrapposte (flusso sanguigno) sono riportate a colori.

Definizioni di immagini planari, tomografiche, morfologiche e funzionali

Nei precedenti paragrafi è stata fornita una definizione concettuale di 'immagini digitali', tuttavia, una terminologia più vasta è necessaria per poter comprendere la trattazione che segue sulle tecniche di imaging e sull'elaborazione dell'immagine. Le immagini diagnostiche in riferimento alla modalità 'anatomica' di presentazione possono essere distinte in due categorie: immagini planari e tomografiche (o di sezioni).

Le immagini planari forniscono una visualizzazione bidimensionale (planare) del contenuto di una parte del corpo: ne sono esempi gli studi a raggi X (radiografici) convenzionali e gli studi scintigrafici di medicina nucleare. In una radiografia del torace viene visualizzato l'intero contenuto del torace in un singolo piano; con le immagini planari, la distinzione delle strutture sovrapposte può essere difficile, per cui due immagini ottenute ad angoli diversi (viste, proiezioni) possono migliorare l'interpretazione diagnostica.

Le tecniche tomografiche quali l'ecografia, la tomografia computerizzata, la risonanza magnetica, la tomografia a emissione di positroni e di fotone singolo, forniscono immagini in cui le informazioni visualizzate corrispondono alle sezioni trasversali del corpo umano (il termine 'tomografia' deriva infatti dal greco τόμοϚ, 'sezione'). In un'immagine digitale tomografica, ogni elemento di immagine (pixel) presente nella matrice corrisponde a un elemento di volume (voxel) della sezione esaminata. I dati tomografici rappresentano la base per molte procedure di elaborazione delle immagini, quali la ricostruzione tridimensionale, la coregistrazione e l'imaging di fusione.

Le immagini diagnostiche, con riferimento al 'contenuto informativo', sono classificate in due categorie: immagini morfologiche (anatomiche) e funzionali.

Le tecniche quali la radiografia e la tomografia computerizzata effettuano un'analisi della densità dei tessuti per fornire informazioni morfologiche e strutturali sulle zone acquisite, di cui rappresentano minuziosamente i dettagli anatomici; pertanto la radiografia e la TC vengono considerate in primo luogo tecniche di imaging morfologico.

Altre tecniche, come la medicina nucleare, eseguono una valutazione dell'assorbimento di diversi tipi di molecole da parte dei tessuti, per creare immagini rappresentative della funzione dei tessuti anziché della struttura.

Ciononostante, una chiara distinzione tra le tecniche di imaging morfologico e funzionale può essere difficile; anche una tecnica di imaging morfologico quale la radiografia può fornire alcune informazioni funzionali. Per esempio, dall'imaging radiografico di un'articolazione della spalla in diverse posizioni si possono ottenere informazioni sulle funzioni dell'articolazione. Allo stesso modo, uno studio funzionale di medicina nucleare, quale una scintigrafia della tiroide, fornirà alcune informazioni anatomiche sulle dimensioni, la forma e la posizione della ghiandola.

Altre tecniche, come l'ecografia, possono fornire regolarmente dati morfologici e funzionali. La tecnica ecografica viene utilizzata principalmente per ottenere eccellenti informazioni anatomiche, ma anche per avere informazioni funzionali relative al flusso sanguigno nella struttura studiata. Similmente, l'imaging a risonanza magnetica fornisce ottime informazioni morfologiche sul sistema nervoso centrale, ma anche diversi tipi di informazioni funzionali correlate al flusso sanguigno, alla diffusione delle molecole di acqua e alla concentrazione di metaboliti nei tessuti.

Lo standard DICOM

Per rendere possibile la telecomunicazione e l'utilizzazione di immagini diagnostiche in postazioni remote, tutti i file con i dati delle immagini devono condividere una struttura di file e un protocollo di scambio comuni. Per molto tempo ciò non è stato possibile, in quanto molte apparecchiature di imaging continuavano a memorizzare e trasferire le immagini in formato proprietario. Attualmente, però, si presuppone che tutti i sistemi di postelaborazione per immagini mediche digitali realizzati dai principali produttori siano compatibili con lo standard DICOM (digital imaging and communications in medicine).

La storia dello standard DICOM nasce all'incirca negli anni Ottanta del XX secolo. Come riportato nel sito web ufficiale della NEMA (National electrical manufacturers association), l'introduzione dell'imaging medico digitale e l'uso dei computer per l'elaborazione delle immagini spinsero due istituzioni statunitensi, l'ACR (American college of radiology) e la stessa NEMA, a formare un comitato congiunto, "allo scopo di creare un metodo standard per la trasmissione delle immagini mediche e delle relative informazioni". Nel 1985 furono pubblicati gli standard ACR-NEMA, ma solo nel 1993, con la pubblicazione della versione 3.0, i principali produttori iniziarono ad adeguarsi pienamente a essi. Nella versione del 1993 delle raccomandazioni, introdotte dalla sigla DICOM, venivano annunciati diversi miglioramenti, i quali, come si affermava, non avevano solo lo scopo di "consentire il trasferimento delle immagini mediche in un ambiente con più fornitori, ma anche di facilitare lo sviluppo e l'espansione dei sistemi di archiviazione e comunicazione delle immagini (PACS, picture archiving and communication systems) e il collegamento con i sistemi di informazioni mediche".

Lo standard DICOM definisce il formato di file nel quale vengono codificate le immagini, consentendo la visualizzazione e la postelaborazione dei dati senza perdita di qualità. Un file DICOM si compone di due parti: (a) un'intestazione contenente una serie di elementi di dati (per es., il nome del paziente, il protocollo di acquisizione, la matrice dell'immagine, le dimensioni dei pixel) e quindi (b) i dati originali relativi ai pixel o ai voxel. Lo standard DICOM definisce anche l'impostazione della comunicazione, basata su un protocollo TCP/IP in cui l'unità che richiede il servizio (workstation) è il service class user, mentre l'unità che fornisce il servizio richiesto (il dispositivo di imaging) è il service class provider.

Quando una workstation di postelaborazione esegue un'operazione di 'interrogazione e recupero', viene richiesto in primo luogo un elenco di pazienti da cui ne viene selezionato uno, dopodiché viene recuperata la serie di immagini richiesta e avviata sulla rete una procedura di trasferimento delle stesse, in modo che esse siano memorizzate in una posizione diversa (in genere un disco rigido locale). Inizialmente, le operazioni DICOM erano limitate allo scambio dei dati tra workstation proprietarie. Attualmente, invece, le applicazioni conformi allo standard DICOM sono disponibili su personal computer che utilizzano sistemi operativi Windows, Macintosh e Linux. La disponibilità di software sia commerciale sia gratuito per la visualizzazione delle immagini DICOM consente a tutti i reparti di imaging di eseguire a basso costo svariate operazioni di postelaborazione, quali misurazione, ricostruzione 3D e archiviazione.

Tecniche di imaging diagnostico

Radiografia

La radiografia, storicamente la prima tecnica di imaging diagnostico, fu inventata, come già detto, da Röntgen. Sebbene l'imaging radiografico ancora utilizzi in buona parte la tecnica analogica convenzionale su pellicola, la radiografia attualmente sta andando incontro a un processo di 'digitalizzazione'.

L'8 novembre 1895, Röntgen, mentre svolgeva studi sui raggi catodici (elettroni) impiegando un tubo di vetro vuoto contenente due elettrodi collocato all'interno di una scatola sigillata di cartone nero e spesso, in una stanza buia, osservò un fenomeno inaspettato: una 'fluorescenza' (emissione di luce verde-blu) proveniente da una lastra di carta ricoperta di platinocianuro di bario che era posta a due metri dal tubo.

Durante gli esperimenti successivi, lo scienziato osservò che gli oggetti di diversi spessori interposti sul percorso dei raggi presentavano una trasparenza variabile quando ne veniva registrata l'immagine su una lastra fotografica. Röntgen ipotizzò allora che dal tubo fosse emesso un tipo di radiazione ancora sconosciuto, in grado di provocare effetti quali la fluorescenza e la trasformazione di materiali sensibili alla luce, utilizzati comunemente per scopi fotografici, e che poteva anche essere attenuata dai materiali interposti.

Röntgen definì questa radiazione 'sconosciuta' raggi X (in quanto in matematica 'X' indica una quantità sconosciuta). Quando lo scienziato interpose la mano della moglie tra il tubo e una lastra fotografica riuscì a ottenere la prima immagine della struttura interna della mano, nella quale risultavano evidenti l'ombra delle ossa e quella di un anello, circondate dall'ombra più tenue dei tessuti molli. Fu così realizzato il primo 'röntgenogramma' o 'radiografia' ed ebbe inizio la storia dell'imaging diagnostico. Per questa scoperta lo scienziato ricevette il premio Nobel per la fisica nel 1901. Max von Laue (1879-1960), anch'egli insignito del Nobel nel 1914 per i suoi studi sui raggi X, dimostrò che questi, ottenuti dalla trasformazione dell'energia cinetica degli elettroni (raggi catodici) che vengono costretti a colpire un bersaglio metallico all'interno di un tubo per raggi X, sono una radiazione elettromagnetica ad alta energia.

Un''immagine a raggi X' (detta anche 'radiogramma' o 'radiografia') è una rappresentazione bidimensionale, 'planare', di una struttura che è stata attraversata da tali raggi. Mentre attraversa il corpo, una parte del fascio viene fermata o deviata ('attenuata'). La parte rimanente ('non attenuata') del fascio attraversa il corpo e colpisce un bersaglio sensibile ai raggi X. Più densa e spessa è la struttura, più alta è la probabilità che la radiazione a raggi X venga attenuata.

In una radiografia 'analogica' convenzionale il bersaglio è uno speciale tipo di pellicola, collocata all'interno di una cassetta, che la protegge dall'esposizione a sorgenti di luce esterne e che contiene anche i cosiddetti 'schermi di rinforzo', vale a dire lastre di materiali fluorescenti in grado di potenziare l'effetto di esposizione ai raggi X. Tali materiali consentono infatti di ridurre il tempo di esposizione e la quantità di radiazioni utilizzate per l'imaging radiografico. Quando la pellicola viene sviluppata dopo l'esposizione ai raggi X, le strutture dense, quali le ossa, vengono visualizzate in bianco, mentre le strutture meno dense, come i polmoni, corrispondono alle zone scure. La parte della pellicola sensibile ai raggi X è un'emulsione fotografica, composta da granuli submicroscopici di cristalli di bromuro d'argento (AgBr) con impurità di iodio, che creano un supporto analogico per l'immagine, con la possibilità di continue variazioni dei livelli di esposizione. Un'altra tecnica radiologica, che può rappresentare un approccio alternativo o complementare alla registrazione su lastre, è la fluoroscopia o radioscopia, in cui si utilizza uno schermo fluorescente per una visualizzazione delle strutture in tempo reale utile per particolari applicazioni diagnostiche e terapeutiche.

Un'immagine ai raggi X può essere definita 'immagine di trasmissione', in quanto rappresenta l'anatomia delle strutture valutate, a seconda delle relative capacità di 'trasmettere' (ossia di attenuare) il fascio di raggi X.

L'intrinseca, 'naturale' capacità delle strutture corporee di trasmettere i raggi X può essere modificata mediante la somministrazione di materiale ad alta e/o bassa densità (mezzi di contrasto), allo scopo di consentire la visualizzazione di strutture che altrimenti sarebbero scarsamente visibili o completamente invisibili sui radiogrammi convenzionali. I mezzi di contrasto sono utilizzati largamente nello studio delle strutture vascolari e gastrointestinali e delle vie di escrezione urinaria.

In effetti, l'utilizzazione dei mezzi di contrasto per il miglioramento delle informazioni diagnostiche fa ora parte delle procedure di routine anche in altre tecniche di imaging diagnostico, quali la tomografia computerizzata e l'imaging con risonanza magnetica, e ricorre in modo sempre più frequente nell'ecografia, tecnica che utilizza gli ultrasuoni.

Negli ultimi anni si sono registrati notevoli progressi nella tecnologia digitale applicata all'imaging con i raggi X. Nelle moderne tecniche di radiografia digitale vengono impiegati diversi tipi di rilevatori di raggi X, come alternativa alla registrazione su pellicola (radiologia senza pellicola o filmless). Nella radiografia digitale sono utilizzati dati in formato digitale per l'acquisizione, l'elaborazione, la visualizzazione, l'archiviazione e la trasmissione delle immagini ai raggi X. Tuttavia, oggi non esistono procedure standard per l'acquisizione digitale delle immagini radiografiche e l'approccio varia a seconda dei produttori. Sebbene un'immagine radiografica convenzionale possa essere trasformata in immagine digitale utilizzando digitalizzatori di radiografie convenzionali (scanner), la procedura di digitalizzazione non è paragonabile all'acquisizione diretta di un'immagine digitale ai raggi X. Gli elementi fondamentali per la diffusione dei sistemi di radiografia digitale sono la risoluzione spaziale, i livelli della scala di grigi, la sensibilità ai raggi X, la disponibilità di diversi formati, la compatibilità con le apparecchiature ai raggi X utilizzate e i costi complessivi.

Attualmente la radiografia digitale può essere effettuata con svariati approcci tecnici (James et al. 2001), quali: (a) fluorografia digitale basata su intensificatore di immagini; (b) radiografia computerizzata con fosfori fotostimolabili; (c) tecnologia basata su rilevatori a selenio o silicio amorfi; (d) rilevatori a pannello piatto.

Tra le suddette tecniche, la radiografia computerizzata con fosfori fotostimolabili (PPCR, photo-stimulable phosphor computed radiography) ha conosciuto un'ampia diffusione, in quanto utilizza pannelli di fosfori contenuti in dispositivi di protezione simili alle cassette per pellicole radiografiche convenzionali, consentendo quindi l'utilizzazione delle apparecchiature radiografiche disponibili. I fosfori immagazzinano l'energia della radiazione a raggi X e possono essere successivamente analizzati quando sono esposti a una frequenza luminosa adeguata, con una matrice delle dimensioni massime di 1024×1024 pixel.

La radiografia digitale diretta (DDR, direct digital radiography), tecnica più costosa, utilizza pannelli piatti (composti di selenio o silicio amorfi), collocati in modo permanente sul tavolo radiografico e collegati a un dispositivo di lettura che consente la trasmissione immediata delle informazioni acquisite all'unità di visualizzazione e archiviazione. La DDR permette di acquisire e di visualizzare le immagini in modo più rapido rispetto alla PPCR.

Le grandi dimensioni della matrice di immagine, necessarie per ottenere una risoluzione spaziale paragonabile a quella dei radiogrammi convenzionali su pellicola, hanno in parte ritardato la diffusione delle tecniche radiografiche digitali. Attualmente, però, l'aumento della capacità di memorizzazione e la riduzione dei prezzi dei supporti digitali consentono l'utilizzazione della radiografia digitale a costi ragionevoli in tutti gli ospedali.

La diffusione di questa tecnica presenta vantaggi sia sul piano radiobiologico sia su quello ambientale, in quanto: (a) limita il numero di impostazioni non corrette dei raggi X, che richiedono una seconda esposizione con la radiografia convenzionale e, di conseguenza, diminuisce la dose di radiazioni per il paziente; (b) riduce l'utilizzazione delle procedure convenzionali di trattamento delle pellicole e quindi il conseguente accumulo di grandi quantità di rifiuti tossici.

La lettura delle immagini radiografiche digitali implica un approccio diverso rispetto alle pellicole convenzionali. La radiografia tradizionale su pellicola non consente il miglioramento dell'immagine. Come i radiogrammi convenzionali, quelli digitali possono essere stampati e osservati usando un diafanoscopio (cassetta con retroilluminatore). Tuttavia, per poter sfruttare i vantaggi dei dati computerizzati, le immagini digitali possono essere osservate su monitor di computer utilizzando, se necessario, software che elaborano l'immagine per migliorare la visualizzazione di determinati dettagli e per misurare e calcolare i dati morfometrici. La radiografia digitale consente infatti il miglioramento della qualità dell'immagine attraverso semplici modifiche dei livelli di scala di grigi (regolazione del contrasto e della luminosità) oppure mediante procedure più sofisticate di elaborazione dell'immagine che comprendono il filtraggio per il miglioramento dei margini (edge enhancement) e l'uniformazione (smoothing), nonché il calcolo delle distanze, degli angoli e delle aree.

Tomografia computerizzata

La tomografia computerizzata (TC) o tomografia assiale computerizzata (TAC) rappresenta, storicamente, la prima tecnica di imaging interamente digitale. Nei primi decenni del XX sec. erano stati effettuati diversi tentativi per ottenere immagini tomografiche, apportando modifiche alle apparecchiature radiografiche convenzionali; tuttavia, questi dispositivi avevano prodotto immagini di scarsa qualità, con una bassa risoluzione spaziale e un valore diagnostico limitato. Hounsfield riuscì a combinare e sfruttare pienamente gli sviluppi tecnologici delle apparecchiature radiografiche e dei computer che avevano caratterizzato gli anni Sessanta. Per l'invenzione della TC, egli ricevette il premio Nobel per la medicina o la fisiologia nel 1979, insieme ad Allan M. Cormack (1924-1998), che negli anni Sessanta postulò, indipendentemente da Hounsfield, le basi teoriche per la ricostruzione delle immagini tomografiche da più proiezioni.

Il primo tomografo TC era dotato di un tubo radiogeno, in grado di ruotare intorno al corpo e di emettere un sottile fascio di raggi X; in questo modo era possibile ottenere una serie di proiezioni di una sezione del corpo.

Come si verifica con la radiografia, nell'attraversare le strutture del corpo umano, una parte del fascio di raggi X viene 'attenuata' e la rimanente attraversa il corpo, colpendo un rilevatore sensibile a essi. Nella TC il bersaglio sensibile è rappresentato da una serie di rilevatori ad alta densità allo stato solido o gassoso. L'immagine tomografica viene ricostruita utilizzando algoritmi matematici che richiedono una lunghissima serie di operazioni che possono essere svolte solo da un computer e necessitano di un certo tempo. In pratica, la produzione di un'immagine TC è paragonabile alla risoluzione di una serie di equazioni con centinaia di migliaia di incognite, corrispondenti alle densità dei tessuti dei vari voxel presenti in una sezione. Maggiori sono le dimensioni della matrice, più alta sarà la risoluzione spaziale e più lungo sarà il tempo di ricostruzione dell'immagine.

Gli algoritmi di ricostruzione dell'immagine utilizzati per la tomografia computerizzata possono essere iterativi e analitici. Gli algoritmi iterativi calcolano le densità dei voxel attraverso più serie di ipotesi ed effettuano la verifica dei valori utilizzando i dati di proiezione ottenuti dai rilevatori: più alto è il numero di fasi in cui è suddivisa l'iterazione, maggiore sarà la precisione del calcolo. Essi sono stati impiegati per la ricostruzione dell'immagine nel primo tomografo TC. Successivamente, le procedure iterative sono state sostituite da metodi analitici basati sul filtraggio preliminare dei dati delle proiezioni, al quale fa seguito la retroproiezione nell'immagine finale (FBP, filtered back projection). I motivi di questa scelta erano dovuti principalmente al fatto che, a differenza degli approcci iterativi, le procedure di calcolo potevano iniziare prima del completamento della scansione.

L'approccio della TC è simile a quello della radiografia, in quanto entrambe le tecniche prevedono l'utilizzazione dei raggi X. Come la radiografia, la TC è in grado di realizzare 'immagini di trasmissione'. Tuttavia, a differenza della radiografia, la TC esegue misurazioni reali e accurate delle densità dei tessuti per ciascun elemento di volume delle sezioni studiate, nonché un alto contrasto dei tessuti. Le densità dei tessuti vengono espresse in modo convenzionale come HU (Hounsfield units, in onore dell'inventore della TC), cioè misure relative dell'attenuazione dei raggi X rispetto all'acqua. La forza della TC sta nella combinazione dei suddetti vantaggi con la visualizzazione tomografica e nell'assenza di interferenze delle strutture adiacenti.

Uno studio TC dell'encefalo effettuato con uno dei primi tomografi poteva impiegare ben più di un'ora. Attualmente, i progressi tecnici realizzati sia con le apparecchiature sia con l'elaborazione al computer hanno ridotto drasticamente il tempo di scansione con la TC. I tomografi TC sono stati potenziati grazie all'utilizzazione di tubi radiogeni più avanzati, inoltre, la struttura e le prestazioni dei rilevatori sono state migliorate progressivamente nelle generazioni successive. All'inizio degli anni Novanta fu realizzato un miglioramento significativo nella tecnologia TC grazie alla costruzione di tomografi con scansione a spirale (TC elicoidale), consentendo l'acquisizione ininterrotta dei dati durante una rotazione continua del tubo per raggi X, insieme a un movimento simultaneo del lettino porta-paziente. Oggi, con un tomografo TC spirale, una scansione completa dell'encefalo può durare meno di un minuto.

Il tempo di scansione è stato ulteriormente ridotto con l'introduzione di tomografi TC spirale multisezione (multistrato), che consentono di acquisire simultaneamente un massimo di 16 set di dati. I dati ottenuti con i tomografi TC spirale multisezione possono essere visualizzati tridimensionalmente e consentono eccezionali ricostruzioni multiplanari. Con le ricostruzioni 3D, le accurate misurazioni della densità dei tessuti ottenute con la TC possono essere utilizzate per distinguere diverse strutture anatomiche mediante una classificazione con pseudocolori e con una visualizzazione sequenziale di diverse strutture di tessuti, rimuovendo elettronicamente quelli sovrapposti. Un altro importante campo di utilizzazione di questi dati è la navigazione endoscopica virtuale.

Di particolare valore nella TC spirale multisezione è la straordinaria rappresentazione anatomica della vascolarizzazione del corpo umano, migliorata anche dall'impiego di mezzi di contrasto ad alta densità, che vengono iniettati contemporaneamente all'acquisizione dei dati TC. Attualmente la TC spirale multisezione consente un uso efficace di approcci terapeutici meno invasivi, quali il posizionamento endovascolare di stent e protesi per il trattamento di anomalie vascolari.

I set di dati 3D possono essere utilizzati per scopi diagnostici, ma sono utili specialmente per la pianificazione della terapia chirurgica e della radioterapia.

Medicina nucleare e imaging molecolare

La medicina nucleare è la disciplina medica che studia l'utilizzazione degli atomi radioattivi (radionuclidi) per scopi diagnostici e terapeutici. Le applicazioni diagnostiche comprendono studi di imaging funzionale e test di laboratorio. Sebbene le applicazioni diagnostiche della medicina nucleare siano state introdotte negli ultimi decenni del XX sec., le radici di questa branca risalgono alla scoperta della radioattività naturale a opera di Henri Becquerel nel 1896. Successivamente allo sviluppo del ciclotrone nel 1931, grazie a Ernest O. Lawrence, nel 1934 Frédéric Joliot e sua moglie Irene Curie (figlia di Pierre e Marie Curie) ottennero isotopi radioattivi artificiali. Nell'anno seguente furono scoperte oltre cento nuove forme di materiali radioattivi artificiali. L'evento più importante per la moderna medicina nucleare è stato la scoperta del tecnezio (Tc) da parte di Emilio Segré (1905-1989); il 99mTc è il radionuclide più utilizzato nelle attuali applicazioni di imaging in medicina nucleare.

I materiali radioattivi emettono radiazioni ad alta energia, che possono essere riconosciute e misurate da 'rilevatori di radiazioni'. Negli studi di imaging in medicina nucleare, i radionuclidi che emettono radiazioni elettromagnetiche ad alta energia (raggi γ) sono incorporati in molecole diverse, che creano 'radiofarmaci' somministrabili ai pazienti, in genere per via endovenosa. I raggi γ vengono rilevati utilizzando rilevatori a 'scintillazione' allo stato solido composti di NaI[Tl] (ioduro di sodio con impurità di tallio) o di altri materiali capaci di emettere una luce quando vengono colpiti dai raggi γ. Uno studio di imaging in medicina nucleare viene definito 'scintigrafia' in quanto vengono utilizzati rilevatori a scintillazione.

Mentre la radiografia e la TC sono modalità di imaging di 'trasmissione', in quanto i raggi X prodotti da una sorgente esterna attraversano il corpo umano, la medicina nucleare è una modalità di imaging di 'emissione', per la quale è lo stesso paziente a diventare emettitore del segnale, in seguito alla somministrazione di una piccola quantità di materiale radioattivo.

Un'immagine scintigrafica è una mappa funzionale della biodistribuzione di un materiale radiomarcato, che viene ottenuta con un dispositivo chiamato 'gamma camera'. È possibile utilizzare diversi 'radiofarmaci' per studiare differenti organi e funzioni. Per esempio, per ottenere un'immagine funzionale della tiroide, ghiandola specializzata nella produzione di ormoni iodati, è possibile somministrare iodio radioattivo o altri anioni radioattivi quali il 99mTcO4 (pertecnetato). Dopo che lo iodio, o il pertecnetato, viene assorbito dalle cellule della tiroide, una gamma camera posizionata davanti al collo del paziente è in grado di ottenere una 'scintigrafia della tiroide', evidenziando le zone nelle quali è concentrato il radionuclide e misurando la quantità di captazione.

Per valutare determinate funzioni dei tessuti, come avviene negli studi delle ghiandole salivari, vengono effettuati studi dinamici computerizzati. L'elaborazione al computer dei dati scintigrafici basati su una conoscenza a priori del meccanismo di biodistribuzione di una determinata molecola, vale a dire utilizzando un 'modello matematico di biodistribuzione', consente inoltre di ottenere valutazioni funzionali più sofisticate. Per esempio, la 'scintigrafia renale' permette di rappresentare e misurare le funzioni renali (velocità di filtrazione glomerulare, flusso plasmatico renale), l''angiocardioscintigrafia' di misurare la gittata cardiaca e la frazione di eiezione del ventricolo sinistro del cuore. Inoltre, lo studio del cervello consente di misurare il flusso ematico cerebrale, l'utilizzazione di glucosio, il consumo di ossigeno e, nella modalità di studio attualmente definita 'imaging molecolare', persino le densità e affinità dei recettori (Weissleder e Mahmood 2001).

Tali studi quantitativi richiedono in genere il monitoraggio della biodistribuzione del radiofarmaco nel corso del tempo (cioè l'acquisizione di serie di immagini) e una stima della funzione di ingresso (input) dei tessuti, per esempio, l'evoluzione temporale della loro esposizione ai radiofarmaci sommata a un modello matematico di biodistribuzione. L'insieme delle conoscenze che hanno costituito la base per questi studi quantitativi è chiamato 'teoria dei traccianti', mentre i radiofarmaci utilizzati per questo scopo vengono definiti 'traccianti' (delle funzioni corporee). Le basi per l'utilizzazione dei radionuclidi per il tracciamento delle funzioni corporee sono state gettate negli anni Trenta.

Le informazioni quantitative possono essere riportate in forma di dati (numeri), ma in alcuni casi possono anche assumere la forma di altre immagini, nelle quali viene utilizzata una scala di grigi o una scala di colori per visualizzare livelli specificamente diversi di una funzione o di un parametro. Queste immagini, che di solito sono il risultato di calcoli svolti da un computer su una serie di immagini ottenute in momenti successivi, vengono definite 'parametriche'. Un esempio di immagine parametrica è la 'mappa di fase' creata analizzando una serie di cicli cardiaci e di dati angiocardioscintigrafici di postelaborazione. Nella mappa di fase, tutte le pareti ventricolari che si contraggono in modo sincronico ('in fase') vengono visualizzate con lo stesso colore, mentre le zone discinetiche o acinetiche possono essere identificate da un diverso codice di colore.

Attualmente, gli studi più avanzati di medicina nucleare vengono svolti utilizzando apparecchiature in grado di fornire acquisizioni di dati e immagini di sezioni (tomografiche). Studi tomografici vengono realizzati mediante tomografia a emissione di positroni (PET) e tomografia computerizzata a emissione di fotone singolo (SPECT). Mentre la SPECT si serve degli stessi radionuclidi utilizzati per l'imaging planare (quale 99mTc), la PET utilizza quelli che decadono in seguito all'emissione di particelle con carica positiva (positroni), che vengono trasformati rapidamente in coppie di raggi γ.

La PET consente di effettuare misurazioni tomografiche della radioattività dei tessuti in modo più accurato, ma è più costosa, in quanto i radionuclidi che emettono positroni hanno un decadimento rapido e di solito vengono prodotti da ciclotroni collocati in prossimità dell'area in cui è situato l'apparecchio PET. Attualmente la principale applicazione della PET consiste nella stadiazione di un tumore e nel relativo follow up mediante il [18F]-fluorodeossiglucosio (FDG), un analogo del glucosio. Poiché le cellule dei tumori maligni sono caratterizzate da un maggiore consumo di glucosio rispetto alle cellule normali, gli studi PET-FDG del corpo intero possono contribuire notevolmente alla localizzazione e alla stadiazione di un tumore. L'elaborazione dei dati FDG al computer è in grado di fornire misurazioni quantitative dell'assorbimento che possono essere utilizzate per il monitoraggio degli effetti della terapia e dell'evoluzione della malattia nel corso del tempo.

Gli studi PET-FDG trovano impiego per misurare la quantità di glucosio utilizzata dall'encefalo, fornendo informazioni diagnostiche valide per la valutazione di malattie neurodegenerative e dell'epilessia. Il consumo di glucosio è solo una delle principali funzioni che possono essere valutate con la PET. Come indicato in precedenza, è possibile utilizzare altri radiofarmaci per misurare il metabolismo delle proteine e dei lipidi, l'uso di ossigeno, la sintesi di DNA e il flusso sanguigno, nonché per identificare determinati antigeni cellulari e per effettuare studi sui neurorecettori.

Recentemente sono state impiegate sonde radiomarcate per valutare la possibilità di utilizzazione degli approcci di terapia genica. Inoltre la PET viene impiegata anche nelle ricerche farmaceutiche, per valutare la biodistribuzione e gli effetti funzionali dei farmaci. Tra le applicazioni citate, lo studio dei neurorecettori sta suscitando il maggiore interesse, con lo sviluppo di radiofarmaci che consentono l'osservazione della sintesi del recettore e delle interazioni pre- e postsinaptiche. La PET rappresenta in effetti la tecnica più potente attualmente disponibile per l'imaging molecolare.

Imaging e spettroscopia a risonanza magnetica

La scoperta, nel 1944, del fenomeno fisico chiamato risonanza magnetica nucleare (NMR, nuclear magnetic resonance) a opera di Felix Bloch ed Edward Purcell (insigniti del premio Nobel per la fisica nel 1952) avvenne circa quarant'anni prima dell'introduzione della risonanza magnetica tra le apparecchiature di imaging diagnostico. Questo evento ha rappresentato uno dei più importanti progressi nel campo dell'imaging diagnostico dopo la scoperta dei raggi X.

L'imaging con risonanza magnetica (MRI, magnetic resonance imaging) utilizza un campo magnetico costante di intensità elevata, campi magnetici più deboli oscillanti a frequenze di onde radio e computer per esaminare le strutture anatomiche interne del paziente. L'MRI è considerato un esame non invasivo, in quanto il paziente non è esposto a radiazioni ionizzanti.

L'NMR è caratterizzata da piccole variazioni nei livelli di energia dei nuclei atomici esposti a un forte campo magnetico creato da magneti superconduttori o, meno frequentemente, permanenti. L'eccitazione nucleare (risonanza) viene quindi ottenuta con un campo magnetico debole, creato da un circuito elettrico (bobina), che oscilla alla frequenza di risonanza dei nuclei selezionati. Nuclei diversi hanno differenti frequenze di risonanza, come viene definito dall''equazione di Larmor': ω=γH0, dove ω è la frequenza di risonanza angolare, H0 è l'intensità del campo magnetico e γ è il rapporto giromagnetico, specifico di ciascun nucleo.

In seguito all'eccitazione, i nuclei rilasciano l'energia acquisita in un processo di rilassamento, che a sua volta crea segnali elettrici nelle bobine. Questi segnali rappresentano la base dell'esperimento NMR nel quale diversi parametri fisici influiscono sull'intensità del segnale e sul rilassamento degli spin nucleari. Nell'imaging medico, questa caratteristica del fenomeno NMR viene utilizzata per creare più serie di immagini 'pesate' su diversi parametri, quali il tempo di rilassamento T1 (spin-lattice), il tempo di rilassamento T2 (spin-spin), la densità dei protoni, la suscettibilità magnetica e la diffusione delle molecole di acqua.

Nelle applicazioni di MRI è necessario determinare in modo accurato l'origine spaziale del segnale NMR. Di conseguenza, durante l'acquisizione, il segnale viene codificato con gradienti di campo magnetico, che fanno variare gradualmente tale campo, consentendo un imaging accurato delle strutture del corpo umano.

Un'importante funzione dell'MRI è la possibilità di selezionare lo spessore e l'orientamento delle immagini tomografiche secondo diversi piani anatomici (sagittale, trasversale, coronale, obliquo) senza modificare la posizione del paziente, agendo semplicemente sui gradienti di campo magnetico. Dall'introduzione dei primi tomografi MRI commerciali negli anni Ottanta, le applicazioni dell'MRI sono aumentate continuamente. Grazie allo sviluppo tecnico dell'hardware (magneti con campi più elevati, circuiti migliorati, computer a più alta velocità) e del software (sequenze di impulsi, elaborazione dei dati) l'MRI è oggi in grado di fornire immagini ad alta risoluzione di tutte le strutture anatomiche, con un'eccellente visualizzazione dei tessuti molli e con risultati ineguagliati nella caratterizzazione morfostrutturale del sistema nervoso centrale e delle strutture muscolo-articolari. L'elaborazione delle immagini può essere utilizzata per la ricostruzione e l'analisi 3D, inoltre, l'alto contrasto e le caratteristiche multiparametriche dell'MRI possono essere impiegati per ottenere informazioni aggiuntive come avviene nella procedura di classificazione dei tessuti, nota come segmentazione, che costituisce la base per la misurazione volumetrica di strutture sia normali sia patologiche. Le applicazioni avanzate dell'MRI funzionale (fMRI) consentono, in più, la valutazione della perfusione dei tessuti e della diffusione delle molecole di acqua in molte potenziali applicazioni di ricerca, nonché un'utilizzazione diagnostica mirata nello studio del sistema nervoso centrale.

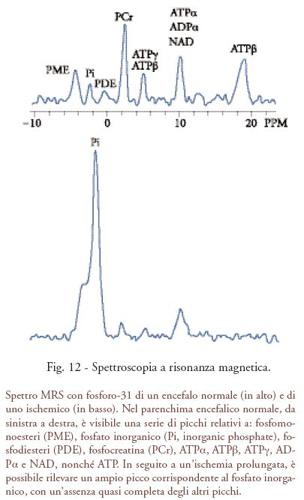

Prima di essere utilizzato nell'imaging medico, il fenomeno dell'NMR ha trovato un'applicazione pratica in chimica e in biochimica, con una tecnica chiamata spettroscopia a risonanza magnetica (MRS, magnetic resonance spectroscopy). Questa applicazione ha avuto inizio dall'osservazione che è possibile misurare per ogni nucleo una frequenza di risonanza leggermente diversa dalle altre, a seconda della molecola e della posizione molecolare del nucleo stesso. Elaborando al computer il segnale NMR è possibile estrarre le informazioni di frequenza e creare uno 'spettro' (fig. 12). Mentre la frequenza di risonanza dei due atomi di idrogeno dell'acqua è identica e nello spettro NMR è presente un singolo picco, in un'ampia serie di metaboliti il segnale dei nuclei di idrogeno può essere identificato, mediante magneti con campo di intensità elevata, creando un'impronta chimica (spettro) del campione studiato. L'MRS può essere applicata a molti nuclei stabili di interesse biologico (1H, 31P, 13C, 19F). Lo sviluppo di magneti con campo di intensità elevata da impiegare nell'MRI ha favorito l'interesse scientifico verso l'utilizzazione dell'MRS per la diagnosi in vivo di molte patologie, in particolare i tumori e le malattie del sistema nervoso centrale. Grazie ai molti potenziali sviluppi, l'MRS può essere considerata perfettamente complementare alle informazioni dinamiche sul metabolismo e sulle funzioni dell'organismo fornite dalle 'tecniche con traccianti' utilizzate dalla medicina nucleare, in quanto fornisce spettri e mappe della concentrazione dei tessuti di diversi metaboliti. Per questo motivo l'MRS continua a contribuire al progresso dell'imaging molecolare.

Ecografia

L'imaging a ultrasuoni, o ecografia, uno dei progressi più importanti della medicina moderna, è una tecnica ampiamente diffusa, le cui immagini sono il risultato della riflessione (eco) di un'onda ultrasonora da parte delle strutture del corpo umano. Le onde ultrasonore vengono ottenute mediante 'trasduttori' composti di materiali in grado di convertire gli impulsi elettrici in vibrazioni. L'effetto fisico che determina la formazione delle onde ultrasonore viene chiamato 'piezoelettricità'.

Le applicazioni degli ultrasuoni hanno origine dagli studi sulle caratteristiche e la propagazione delle onde sonore. Nel 1881, i fisici francesi Pierre e Jacques Curie scoprirono la piezoelettricità e postularono il principio che ha portato allo sviluppo dei trasduttori a ultrasuoni. La prima applicazione pratica di questo principio si ebbe in campo militare: gli ultrasuoni ad alta frequenza furono utilizzati per rilevare i sommergibili, grazie allo sviluppo del SONAR.

L'utilizzazione degli ultrasuoni come strumento diagnostico è iniziata negli anni Cinquanta. A quell'epoca, però, non era possibile realizzare immagini; gli oscilloscopi erano impiegati per visualizzare segnali che indicavano la profondità e l'intensità delle onde di ultrasuoni riflesse dalle strutture dell'organismo, in maniera molto simile a ciò che si verificava con il SONAR. Essi divennero uno strumento medico consolidato solamente negli anni Sessanta, con lo sviluppo di sistemi in grado di ottenere immagini delle strutture anatomiche. I primi rudimentali e ingombranti dispositivi a ultrasuoni si trasformarono progressivamente in sistemi di minori dimensioni per l'acquisizione di immagini ad alta risoluzione e in tempo reale.

Gli ultrasuoni sono onde meccaniche che si comportano come le onde acustiche a bassa frequenza. Le frequenze degli ultrasuoni utilizzate in campo diagnostico sono comprese nell'intervallo di 1-20 MHz, sebbene in determinate applicazioni sia possibile utilizzare frequenze più alte. Vengono prodotti da cristalli piezoelettrici contenuti in un trasduttore, che funziona sia come produttore di onde di ultrasuoni sia come rilevatore delle onde riflesse. Negli studi di imaging con ultrasuoni, i trasduttori sono posizionati a stretto contatto con la superficie corporea corrispondente all'area da esaminare. Gli ultrasuoni viaggiano attraverso le strutture del corpo umano a velocità che variano a seconda delle caratteristiche di attraversamento dei tessuti (impedenza); incontrando diversi tessuti con impedenze differenti, una parte degli ultrasuoni viene riflessa. Le onde riflesse (echi), che presentano ritardi diversi per le differenti profondità, possono essere rilevate e utilizzate per creare un'immagine delle strutture studiate. Gli echi acquisiti rappresentano, perciò, le interfacce dei tessuti.

Sebbene in origine l'imaging a ultrasuoni fosse una tecnica analogica, recentemente si è trasformato in una tecnica digitale, in cui i microprocessori controllano l'intero processo di imaging, dalla produzione e dal rilevamento degli ultrasuoni alla formazione e gestione delle immagini. Il progresso tecnologico nella realizzazione dei materiali di trasduzione e delle serie di cristalli ha consentito di migliorare notevolmente la risoluzione spaziale e di contrasto, mentre lo sviluppo dell'elaborazione digitale del segnale ha innovato le modalità di formazione dei fasci di ultrasuoni e di visualizzazione e memorizzazione delle immagini.

Gli studi ecografici forniscono informazioni morfostrutturali altamente dettagliate sulla struttura dei tessuti molli. Inoltre, grazie all''effetto Doppler', questi studi possono fornire anche informazioni funzionali relative al flusso sanguigno. Infatti, quando gli ultrasuoni colpiscono un oggetto in movimento, la frequenza dell'onda riflessa è più alta se l'oggetto si sposta verso il trasduttore ed è invece più bassa se se ne allontana. Ciò permette perciò di definire la direzione e la velocità del flusso sanguigno. La tecnica 'power Doppler' consente di utilizzare l'amplificazione del segnale per rilevare le caratteristiche del flusso sanguigno nei vasi all'interno di un organo, ottenendo informazioni estremamente utili per la caratterizzazione dei tessuti. Sono stati inoltre introdotti mezzi di contrasto con microbolle, che permettono di estendere le applicazioni di ricerca e l'utilizzazione clinica degli ultrasuoni nello studio della microcircolazione. Tra gli sviluppi più interessanti vanno ricordati l'imaging tridimensionale in tempo reale (definito imaging 4D), le applicazioni terapeutiche di ultrasuoni focalizzati e il rilascio di farmaci e geni con l'ausilio di microbolle (Wells e Specht 2000; Harvey et al. 2002).

Elaborazione e gestione delle immagini

Con la diffusione dei computer, l'elaborazione delle immagini mediche è diventata un settore indipendente della ricerca, sviluppando strumenti e applicazioni specifici. L'elaborazione delle immagini finalizzata al miglioramento delle informazioni diagnostiche e alla visualizzazione dei dati, nonché all'ottenimento di informazioni quantitative, richiede hardware e software appropriati.

Per scopi descrittivi, le procedure di elaborazione delle immagini possono essere raggruppate in quattro categorie.

1) Elaborazione per punti. Questa procedura, utilizzata per modificare il contrasto dell'immagine, include routine progettate per cambiare l'aspetto dei singoli pixel in modo indipendente. In seguito all'elaborazione per punti, il valore dell'immagine risultante viene modificato in base a una determinata regola applicata al valore di pixel corrispondente nell'immagine originaria. La mappatura dei livelli della scala di grigi e di quella dei colori sono tipici esempi di elaborazione dei punti per la modifica e il miglioramento del contrasto. Nelle routine di elaborazione per punti possono essere incluse anche la sottrazione temporale e di doppie energie, sebbene queste prevedano la valutazione di più set di dati anziché di una singola immagine.

Il miglioramento del contrasto è probabilmente la procedura di elaborazione delle immagini più utilizzata nell'attività quotidiana. La risoluzione di contrasto di un'immagine digitale consente di visualizzare in modo distinto due pixel adiacenti con diverse intensità di segnale. Poiché l'utilizzazione del colore nell'imaging diagnostico è ancora limitata, i ricercatori hanno concentrato la maggior parte degli sforzi sul miglioramento del contrasto nelle immagini in scala di grigi, in cui la distribuzione dei livelli di grigio (istogrammi) può essere impiegata per visualizzare il numero di pixel come funzione del livello di grigio. Per migliorare il contrasto dell'immagine, la distribuzione dei livelli di grigio nell'immagine risultante può essere modificata utilizzando una procedura basata su una tabella di corrispondenza (LUT, look up table). Tramite la mappatura dei livelli di grigio (definita anche tecnica windowing, ovvero di estensione dell'istogramma, histogram stretching), essi vengono riassegnati in base a una LUT definita dall'utente, vale a dire un grafico dei livelli di grigio risultanti come funzione dei livelli di grigio originari. Quando si utilizza l'approccio della LUT, mentre il set di dati originale viene lasciato invariato, l'intensità dei pixel visualizzati viene modificata.

In alternativa, è possibile apportare una modifica diretta dei limiti dell'istogramma originale e del valore centrale. Un'immagine scura presenta un istogramma pesato vicino allo 0, mentre una molto luminosa è caratterizzata da un istogramma pesato vicino al valore massimo (numericamente dipendente dai bit della scala di grigi). Nel caso di un'immagine a basso contrasto è presente un istogramma con distribuzione stretta, mentre un'immagine ad alto contrasto ne ha uno a distribuzione ampia. Nella maggior parte dei casi, le operazioni di mappatura del livello di grigio eseguite da un operatore tecnico corrispondono alle modifiche del valore centrale della scala di grigi e dell'intervallo di valori visualizzati (centratura e tecnica a finestre).

La modifica dell'istogramma può essere lineare (ampliamento, spostamento e compressione dell'istogramma) o non lineare (logaritmica, esponenziale, equalizzazione).

2) Elaborazione per zone. In questo tipo di procedura il valore di ciascun pixel nell'immagine risultante dipende dal valore dei pixel circostanti.

Le routine di elaborazione per zone includono il 'filtraggio delle frequenze spaziali', con i seguenti obiettivi: ridurre le frequenze alte, cioè uniformare (smoothing) le immagini (filtro passa-basso); potenziare le frequenze più alte, ovvero rendere le immagini più nitide (filtro passa-alto).

Il filtraggio è un'operazione matematica, e l'espressione 'filtraggio delle immagini' indica in genere l'insieme delle operazioni che modificano sistematicamente la distribuzione dei valori in una matrice; il filtraggio spaziale può essere eseguito sia nel dominio delle frequenze sia in quello dello spazio. Nel primo caso, per poter funzionare sul piano della frequenza, la trasformata di Fourier degli oggetti viene moltiplicata per la trasformata di Fourier del filtro. Nel filtraggio passa-basso, le frequenze spaziali dell'immagine vengono analizzate e le frequenze più alte di un valore limite (che può corrispondere alla risoluzione del dispositivo di imaging) vengono scartate. Le immagini vengono quindi ricostruite mantenendo le frequenze più basse, per cui sono eliminate le fluttuazioni statistiche casuali e i margini più contrastati. Al contrario, il filtraggio passa-alto può essere utilizzato per migliorare l'evidenza dei margini.

Nel secondo caso, il filtraggio spaziale viene eseguito utilizzando il grigio originale (o i livelli di colore) e una procedura matematica chiamata 'convoluzione'. Questa viene effettuata definendo una maschera (una matrice quadrata di numeri), le cui dimensioni dipendono dal tipo di procedura di filtraggio. Se viene utilizzata una maschera di 3×3 pixel, la procedura consisterà nel moltiplicare ogni valore presente nella maschera del filtro per il relativo valore di pixel dell'immagine, sommare i valori ottenendo la media e collocare il numero risultante al centro della maschera del filtro che verrà quindi spostata sulla posizione del pixel successivo e la procedura verrà ripetuta. La procedura descritta, in cui tutti i valori dei pixel vengono sostituiti dal valore medio circostante (smoothing a 9 punti) è la più comune di filtraggio passa-basso, in cui viene creata un'immagine riducendo il rumore. In uno smoothing a 9 punti è possibile utilizzare diversi fattori di peso (per es., i valori più alti per il pixel centrale e quelli più bassi per i pixel degli angoli).

Per migliorare la visibilità di determinati oggetti, è anche possibile utilizzare filtri speciali, che consentono di rendere più chiari i profili delle strutture acquisite (edge enhancement). L'edge enhancement, una delle routine di elaborazione per zone più utilizzate, si ottiene impiegando filtri passa-alto modificati, per evitare immagini dal contrasto eccessivo, incorporando rilevatori di gradiente che analizzano la prima e la seconda derivata dei valori dell'immagine lungo una serie di direzioni per individuare i bordi e i contorni. Le applicazioni del filtro edge enhancement possono favorire il rilevamento dei piccoli dettagli e di anomalie focali minime nei mammogrammi, nei radiogrammi del torace e nella visualizzazione delle strutture ossee con la TC. I filtri per l'edge enhancement possono essere integrati e attivati mediante una procedura di definizione della soglia, che consente di saturare tutti livelli di grigio superiori e inferiori ad alcuni valori definiti. In questo modo vengono realizzate immagini simili a disegni con linee bianche e nere o, più frequentemente, con profili più evidenti. Un'alternativa più semplice ai rilevatori di gradiente per l'individuazione dei margini potrebbe consistere in una routine di rilevamento dei margini con isoconteggio.

Il filtraggio high boost viene utilizzato per amplificare le frequenze spaziali alte, lasciando non attenuate le frequenze spaziali basse. Esso utilizzando pesi negativi con un valore centrale alto (unsharp masking), rende più nitidi i contorni, lasciando invariato il resto dell'immagine. Nell'elaborazione delle immagini diagnostiche vengono inoltre applicati differenti altri filtri. Le più efficaci procedure di miglioramento dei margini che agiscono in tutte le direzioni senza limitazioni si basano su diversi operatori derivati dall'operatore originale di Laplace. Con esso, il ricalcolo dei valori dei pixel si fonda sull'analisi dei gruppi di cinque pixel ed elimina le zone a intensità luminosa costante, conservando la visualizzazione delle aree a intensità variabile.

3) Elaborazione geometrica. Include procedure che vanno dai semplici movimenti dell'intera immagine (spostamenti di colonne e righe) a routine più complesse come rotazione, disposizione speculare (mirroring), ingrandimento e distorsione. Dopo l'elaborazione geometrica, l'immagine risultante potrebbe anche non conservare il numero originario di pixel. Con le operazioni di rotazione, spostamento e disposizione speculare, le coordinate dei pixel cambiano, tuttavia non si verifica alcun mutamento nell'intensità dei valori dei pixel e nel loro numero complessivo. Per quanto concerne le operazioni più complesse, compreso l'ingrandimento, la procedura di elaborazione include di solito una combinazione di passaggi e può richiedere regolazioni della scala di grigi/colori in base alle modifiche apportate alla distribuzione dei pixel (per es., interpolazione dei livelli di grigio e smoothing delle immagini ingrandite).

Tra le procedure di elaborazione geometrica, la traslazione (spostamento) di un'ampia serie di sezioni trasversali e di set di dati volumetrici per scopi di riallineamento ha acquisito un ruolo importante per le procedure finalizzate alla coregistrazione e, quindi, alla rielaborazione di immagini ottenute con la stessa tecnica in due momenti diversi o di immagini ottenute con tecniche differenti.

4) Elaborazione globale delle immagini. Include routine di elaborazione analitica che eseguono operazioni quantitative sui dati dell'immagine. Tra le routine di elaborazione globale, la segmentazione e la classificazione di diversi tessuti rappresentano i settori sui quali si concentra maggiormente la ricerca. "La segmentazione di un'immagine ne comporta la divisione o la separazione in regioni dalle caratteristiche o attributi simili" (Pratt 1991).

Le caratteristiche di base di un'immagine corrispondono alla luminescenza nelle immagini in scala di grigi e ai valori dei componenti di colore nelle immagini in scala di colori. La segmentazione ha come scopo l'identificazione di classi omogenee di tessuti e rappresenta, quindi, il passaggio preliminare necessario per eseguire le misurazioni volumetriche, ossia per ottenere misure di volumi di differenti componenti di tessuti normali e anormali in una struttura anatomica. Infatti, una volta segmentata correttamente un'immagine, è possibile misurare i volumi dei diversi compartimenti sommando i volumi dei voxel corrispondenti. La segmentazione delle strutture encefaliche, per esempio, identifica i pixel che appartengono alla sostanza grigia e bianca e al liquido cerebrospinale, nonché alle strutture extracerebrali, quali le ossa, il tessuto adiposo sottocutaneo e i muscoli. All'interno di questi componenti dei tessuti è possibile identificare i gruppi anomali di pixel in presenza di una malattia.

Tuttavia, con la risoluzione spaziale attualmente disponibile, neppure le tecniche di imaging più avanzate consentono ancora di identificare cluster distinti di pixel corrispondenti alle strutture microscopiche, come i microvasi. Ciononostante, la classificazione di strutture macroscopiche sta già fornendo importanti informazioni cliniche attraverso le svariate applicazioni sviluppate finora, in particolare nell'imaging dell'encefalo.

Rispetto al ruolo degli operatori al computer, le procedure di segmentazione possono essere classificate in due categorie: procedure con supervisione (completamente manuali o parzialmente manuali) e procedure prive di supervisione (completamente automatiche).

Le procedure manuali possono essere utilizzate per tracciare i profili di una lesione, come può essere un tumore, su diverse sezioni trasversali di uno studio tomografico. I volumi di un tumore nelle sezioni possono essere sommati per ottenere il volume totale della lesione. Mentre per una singola lesione/struttura è consigliabile una procedura manuale, le operazioni diventano notevolmente più lunghe e complesse quando si tratta di più tessuti e lesioni. Nel caso di disturbi multifocali del cervello, come per esempio la sclerosi multipla, la misurazione manuale del volume di decine e persino di centinaia di piccole lesioni può richiedere una quantità di tempo così grande da essere inaccettabile per le applicazioni cliniche di routine. Di conseguenza, se la segmentazione viene applicata come procedura di routine, è preferibile utilizzare metodi che non richiedano la supervisione o che prevedano una supervisione limitata.

Per la segmentazione non esistono vere e proprie procedure standard. Finora ne sono state suggerite diverse, che vanno dalla più semplice 'segmentazione di ampiezza' basata sull'impostazione manuale di una 'soglia' per l'immagine (definizione degli intervalli di valori di pixel che includono un determinato tessuto), fino a sofisticate procedure di elaborazione al computer basate sulla segmentazione delle regioni, dei profili, della struttura e sugli algoritmi ibridi.

Nei metodi basati sulla definizione della soglia, il valore di ciascun pixel viene confrontato con uno o più valori di soglia, mentre il pixel viene assegnato a una fra più serie di regioni, a seconda che la soglia sia stata superata o meno. Se l'istogramma dell'immagine presenta picchi ben distinti, sarà possibile impostare le soglie sui punti più bassi tra un picco e l'altro. Le procedure basate sulla definizione della soglia sono rapide ma caratterizzate da un alto livello di rumore e dipendono strettamente dall'accuratezza nella misurazione dell'intensità dei pixel; inoltre non assicurano una connettività spaziale tra i pixel.

A differenza delle procedure di definizione della soglia, i metodi di segmentazione delle regioni (ingrandimento, scomposizione, scomposizione e fusione) prevedono la valutazione dell'omogeneità e della connettività spaziale. Le procedure di ingrandimento delle regioni incominciano da un punto iniziale (seed point) per ciascuna regione e consentono di ampliarla, incorporando i pixel con proprietà simili. I metodi di scomposizione delle regioni permettono di suddividere ciascuna regione inizialmente considerata omogenea in diversi sottogruppi, fino a definire zone omogenee.

I metodi di segmentazione dei profili (rilevamento dei margini) definiscono contorni chiusi intorno a una regione omogenea, mediante l'analisi delle variazioni locali di intensità dell'immagine.

I metodi ibridi consentono di combinare diversi approcci operativi: è possibile associare una procedura di rilevamento dei profili a procedure di definizione della soglia, dove i valori soglia vengono definiti in modo più preciso dopo una segmentazione preliminare della regione.

Tra le diverse tecniche di imaging, l'MRI viene preferita nelle procedure di segmentazione e classificazione dei tessuti, in quanto presenta una natura multiparametrica. Ciò, infatti, consente agli algoritmi di segmentazione di considerare più parametri per la classificazione dei tessuti, migliorando la qualità del risultato. Sulla base dei dati MRI sono state sviluppate per gli studi dell'encefalo procedure di segmentazione multiparametrica (multispettrale) completamente prive di supervisione.

Attualmente è possibile utilizzare le misurazioni volumetriche ottenute con la segmentazione e la classificazione dei tessuti per identificare 'obiettivamente' condizioni anormali, come l'atrofia cerebrale. Si è in grado infatti di monitorare e di quantificare le variazioni che si verificano nel corso del tempo, come nelle malattie neurodegenerative, per esempio il morbo di Alzheimer, e nei disturbi de- e dismielinizzanti, quale la sclerosi multipla. In prospettiva, tali metodi si riveleranno molto utili nella valutazione dell'effetto di terapie finalizzate a rallentare e, auspicabilmente, a invertire il decorso di queste patologie. Inoltre, mediante le stime volumetriche si possono valutare e monitorare le dimensioni dei tumori nel corso della terapia.

Ricostruzione tridimensionale

Le applicazioni della ricostruzione 3D includono diverse procedure, attualmente disponibili nella maggior parte delle workstation per l'elaborazione di immagini mediche (Robb 1999).

1) Ricostruzione multiplanare (MPR, multiplanar reformation o multiplanar reconstruction). Questa procedura consente la visualizzazione di strutture su diversi piani che attraversano il volume dei dati mediante l'interpolazione e il ricampionamento, in modo da assegnare determinate intensità ai voxel 'interposti' tra i punti di dati effettivi. In pratica, l'MPR consente al radiologo di valutare un intero volume lungo l'orientamento assiale, coronale, sagittale od obliquo. Esiste inoltre la possibilità di effettuare la rigenerazione di un piano curvilineo, dove il piano da rappresentare in modo interattivo viene definito dal radiologo all'interno di una serie di piani ortogonali utilizzati come riferimento. Questa tecnica è particolarmente indicata per la visualizzazione di strutture dalla conformazione spaziale curva, quali i grandi vasi sanguigni. L'MPR viene utilizzata principalmente per i dati acquisiti con la TC spirale multisezione.

2) Proiezione di intensità massima (MIP, maximum intensity projection). È un algoritmo di post processing che consente di creare immagini di proiezione bidimensionali, in cui ciascun pixel viene assegnato al valore di intensità massima rilevato lungo il raggio corrispondente, proiettando raggi paralleli da ciascun pixel del piano dell'immagine di proiezione attraverso il volume studiato. In altre parole, i pixel risultanti nell'immagine MIP sono quelli che presentano il valore più alto ottenuto quando il volume acquisito viene attraversato da un raggio virtuale proveniente da un punto di vista esterno, proiettando le strutture interne attraverso una mappa densitometrica. Le immagini MIP vengono generalmente utilizzate per la valutazione dei dati dell'angiografia a risonanza magnetica e possono avere un aspetto molto simile agli angiogrammi convenzionali. Un limite di questa procedura è rappresentato dalla perdita delle informazioni sulla profondità (volume) nel processo di ricostruzione. Tuttavia, le informazioni volumetriche possono essere recuperate se l'intero set di dati viene visualizzato in una modalità 'cine' attraverso punti di vista in variazione continua. La MPR e la MIP non richiedono una classificazione preliminare dei tessuti

3) Rendering della superficie o del volume. Per questa procedura è necessario effettuare un'elaborazione dei dati e una classificazione dei tessuti per la ricostruzione e la visualizzazione 3D. Sono utilizzati diversi approcci di elaborazione, quali l'estrazione di isosuperfici, la classificazione binaria dei voxel e il rendering diretto del volume. L'estrazione delle isosuperfici prevede l'identificazione di isocontorni/profili che separano diverse strutture e viene svolta in modo più efficace nei set di dati 3D; la classificazione binaria implica il campionamento e la classificazione dei voxel in due gruppi, in base alla possibilità di appartenere a una o due categorie/strutture da visualizzare. Il rendering diretto del volume si basa su un modello semitrasparente 'tipo gel' del set di dati 3D. Con questa tecnica, ogni voxel è associato a una trasparenza e a un livello di colori; l'immagine finale viene ottenuta fondendo i diversi contributi e creando proiezioni che utilizzano una procedura di proiezione del raggio o di splatting.

Il rendering della superficie è una procedura di visualizzazione 3D (volumetrica), che prevede un'operazione di segmentazione preliminare per separare i diversi oggetti di cui si desidera visualizzare la superficie. Sebbene sia possibile utilizzare anche una segmentazione manuale (definizione della soglia), in particolare con i set di dati monoparametrici (TC), è comunque preferibile ricorrere alle procedure automatiche. Nel rendering della superficie sono visualizzati i voxel dei profili tra due strutture, per creare una superficie 3D. Viene chiamato anche visualizzazione della superficie ombreggiata (SSD, shaded surface display), in quanto in queste immagini l'intensità di ciascun pixel viene calcolata utilizzando l'orientamento locale della superficie rispetto a una sorgente di illuminazione virtuale.

Questa tecnica può essere utilizzata per diverse applicazioni, tra cui l'angiografia (in alternativa al MIP), la programmazione di interventi chirurgici, gli studi di attivazione cerebrale e l'endoscopia virtuale.

Con il rendering prospettivo del volume, l'intero set di dati volumetrici 3D viene visualizzato simultaneamente. Questa procedura utilizza le intensità dei voxel per creare rappresentazioni tridimensionali traslucide del set di dati con l'aiuto della visualizzazione dei colori. Nell'immagine finale, gli oggetti con alta e bassa intensità di segnale risultano rispettivamente opachi e trasparenti. Il rendering del volume è ora possibile grazie all'evoluzione delle funzionalità grafiche delle workstation e viene generalmente utilizzato per i set di dati TC e MRI, sebbene possa essere usato anche con la tecnica ecografica 3D.

Il rendering del volume consente di creare immagini 3D calcolando inizialmente il colore e l'opacità parziale per ciascun voxel e quindi fondendo i contributi forniti dalla proiezione dei voxel sullo stesso pixel nel piano dell'immagine (lungo una linea che dal punto di vista dell'osservatore passa attraverso il volume). Questa procedura permette la visualizzazione di strutture interne che normalmente sarebbero invisibili con altre elaborazioni, come il rendering della superficie. L'osservatore può modificare interattivamente i parametri di visualizzazione, quali il colore, la luminosità e l'opacità, per i voxel con diversa intensità dei tessuti.

4) Endoscopia virtuale. È una procedura interattiva basata su una grafica computerizzata estremamente rapida e su applicazioni di 'realtà virtuale'. Essa consente la visualizzazione delle superfici interne degli organi, quali l'intestino, la vescica, le vie respiratorie o le pareti interne dei vasi sanguigni. Il set originale di dati si compone di immagini TC o MRI che vengono elaborate mediante routine di rendering della superficie o del volume. Oltre alla TC e alla MRI, questa procedura consente di utilizzare anche altre fonti, quali l'ecografia 3D e l'angiografia rotazionale, tuttavia tali applicazioni sono ancora a livello sperimentale.