Logica matematica

Logica matematica

*La voce enciclopedica Logica matematica è stata ripubblicata da Treccani Libri, arricchita e aggiornata da un’introduzione di Gabriele Lolli e un saggio di Beppo Levi.

sommario: 1. Introduzione. 2. L'evoluzione dei fondamenti della matematica. 3. Filosofia della matematica. 4. Fondamenti delle discipline matematiche. 5. Logica matematica. 6. Conclusione. □ Bibliografia.

1. Introduzione

La logica ha come oggetto le forme e le leggi del pensiero. La scoperta della grande efficacia del tipo di ragionamento matematico, unita alla considerazione che la matematica costituisce un campo naturale per l'applicazione e l'esemplificazione di argomenti logici astratti, ha fatto sì che nel sec. XX i legami tra logica e matematica si siano andati sempre rafforzando. È quindi abituale contraddistinguere la logica moderna per mezzo dell'aggettivo ‛matematica'. Cionondimeno questa disciplina è rimasta sostanzialmente quale era ai tempi di Aristotele. Non vi è motivo di tracciare una distinzione netta, come vorrebbero alcuni sostenitori della ‛logica matematica' o della ‛logica aristotelica', i primi per sottolineare la maggiore efficacia del loro indirizzo, i secondi per rivendicare la maggiore profondità del proprio.

Branca fondamentale della filosofia, la logica conserva la sua importanza ben oltre i campi della matematica e delle scienze esatte. Così il termine ‛logica filosofica', che è diventato di moda da qualche anno, si riferisce a taluni settori della logica, come la logica modale, che rivestono un particolare interesse per i filosofi. In questo articolo, comunque, fisseremo l'attenzione su quegli aspetti della logica e della matematica che mettono in evidenza l'interazione tra le due discipline.

Abbiamo diviso l'articolo in quattro parti. Dopo una breve rassegna sullo sviluppo storico della logica, nella prima parte, diamo nella seconda parte una descrizione piuttosto semplificata delle tendenze e delle correnti principali della filosofia della matematica. Sebbene i progressi contemporanei in questo campo siano stati in gran parte motivati o almeno influenzati dalla logica matematica, non si esige, a questo livello, una competenza tecnica in tale disciplina. Nella terza parte delineiamo i fondamenti dei principali settori disciplinari della matematica. Infine, nella quarta parte, descriviamo le caratteristiche più importanti dell'imponente edificio che costituisce oggigiorno la logica matematica. Tale esame risulterebbe incomprensibile se non includesse almeno qualche dettaglio di matematica formale.

2. L'evoluzione dei fondamenti della matematica

I primi passi dell'uomo nelle scienze matematiche furono motivati da problemi di carattere pratico o almeno da questioni poste dall'osservazione diretta dei fenomeni naturali. La matematica babilonese ed egiziana già comprendeva regole definite, acquisibili solo con l'aiuto del ragionamento deduttivo. Furono comunque i Greci a tentare per primi di fondare esplicitamente la matematica sul ragionamento puro. Nello sforzo di costruire su solide basi la matematica e la scienza in generale, i Pitagorici giunsero alla conclusione che tali fondamenti erano forniti dall'aritmetica, cioè dai numeri naturali. Il loro punto di vista divenne insostenibile di fronte alla scoperta delle grandezze incommensurabili, cioè, in termini moderni, dei numeri irrazionali. Per reazione a questa scoperta, i matematici greci edificarono la matematica su basi puramente geometriche. In tal modo, anche i risultati relativi alla teoria dei numeri sono presentati da Euclide in linguaggio geometrico, secondo una tradizione che sopravvive ancora oggi, quando, per esempio, parliamo del quadrato o del cubo di un numero.

Non affronteremo in questa sede il problema di determinare fino a che punto Euclide fosse influenzato da filosofi come Zenone, Aristotele o Platone, o quanto la sua teoria attingesse da Eudosso. In ogni modo, i tredici libri dei suoi Elementi mostrano che attorno al 300 a.C. i Greci avevano un'idea chiara dell'impiego del procedimento deduttivo in matematica. Il punto di partenza di Euclide era costituito da definizioni e da assiomi; questi ultimi erano suddivisi in due classi a seconda che l'autore li ritenesse di natura geometrica o puramente logica. Tali assiomi non erano considerati ipotesi arbitrarie, come gli attuali assiomi dell'algebra o della geometria, ma verità oggettive, e al tempo stesso si riteneva che le definizioni fornissero una chiara delimitazione degli oggetti da esse descritti. Ne segue che anche i teoremi erano considerati verità oggettive, ottenute dagli assiomi con un processo puramente deduttivo. Malgrado molte lacune, l'opera di Euclide e dei suoi immediati successori è espressione di un livello di chiarezza intellettuale che non venne superato per altri duemila anni, durante la maggior parte dei quali non fu neppure apprezzato. Sebbene in questo periodo la logica e la matematica non restassero ferme al punto di partenza, esse si svilupparono prevalentemente ciascuna per proprio conto. Nel sec. XVII si registra un rinnovato contatto tra la matematica e la logica o, più in generale, la filosofia. Così, per esempio, Cartesio considerava la sua opera geometrica un'applicazione dei principi generali dell'euristica che egli aveva sviluppato nella sua filosofia. E mezzo secolo più tardi Leibniz esponeva le sue idee pionieristiche nel campo della logica matematica al solo scopo, o quasi, di far progredire l'‛arte della scoperta'. Tuttavia, benché queste intuizioni - che erano già affiorate nel Medioevo - fossero importanti in linea di principio, non costituirono molto di più che una sorta di sprone psicologico per le grandi scoperte matematiche dei loro formulatori. Persino i contributi di Leibniz alla fondazione del nascente calcolo differenziale e integrale hanno soltanto una remota connessione con le sue idee sulla formalizzazione della matematica e sulla matematizzazione della logica.

Cionondimeno furono i problemi relativi al calcolo a imporre ai matematici e ai filosofi un rinnovato interesse verso i fondamenti della matematica. Per centocinquanta anni dopo Leibniz imperversò un accanito dibattito sulla corretta definizione delle nozioni fondamentali dell'analisi (o calcolo infinitesimale). A questo proposito, lo stesso Leibniz aveva suggerito l'introduzione di numeri infinitamente piccoli e infinitamente grandi, in aggiunta ai numeri reali la cui esistenza e il cui significato erano dati per scontati. Così, secondo Leibniz, la velocità di una particella avrebbe dovuto essere definita da una frazione il cui denominatore è la misura di un intervallo di tempo infinitamente piccolo e il cui numeratore è la distanza infinitamente piccola percorsa dalla particella in quell'intervallo di tempo. L'impostazione di Leibniz, malgrado l'intrinseca debolezza, nella misura in cui fu applicata tenendo conto delle sue contraddizioni interne, si dimostrò adeguata allo sviluppo dell'analisi e della geometria differenziale per oltre un secolo. Alla fine, comunque, tali contraddizioni, insieme al sorgere di problemi la cui soluzione richiedeva un apparato concettuale più sofisticato, portarono all'abbandono dell'impostazione leibniziana. Questa fu sostituita (dopo il 1850) dalla formulazione ‛ε, δ' di Weierstrass (prefigurata da Bolzano e, in qualche suo aspetto, da Cauchy), la cui caratteristica centrale è il concetto di limite, basato sul solo sistema dei numeri reali. A questo punto divenne necessario sottoporre anche questo sistema a un esame più approfondito. Si giunse così, da una parte, a un processo di riduzione in base al quale i numeri reali venivano ricondotti, in ultima istanza, ai soli numeri naturali e, dall'altra, all'indagine, effettuata da Cantor, su insiemi arbitrari di numeri reali, che costituì il punto di partenza per lo sviluppo di una teoria generale degli insiemi (infiniti). Vista superficialmente, questa ‛aritmetizzazione dell'analisi', come fu chiamata a quel tempo, sembrò segnare l'abbandono definitivo dell'impostazione geometrica di Euclide, in base alla quale ogni numero reale è rappresentato da un punto su una retta. A un livello diverso e più profondo, questo stesso sviluppo segnò comunque anche un ritorno allo standard di rigore proprio dei Greci e persino alle soluzioni da essi proposte per taluni problemi del calcolo.

Ad esempio, Euclide (o Eudosso, prima di lui) si era reso conto del fatto che il riferimento puro e semplice ai punti di una retta era inadeguato ai finì di una comprensione del sistema dei numeri reali. Conseguentemente egli basò la sua teoria delle proporzioni sul fatto che (in virtù dell'‛assioma di Archimede') i numeri irrazionali possono essere approssimati mediante numeri razionali con un grado di precisione arbitrario. La stessa concezione venne ripresa nel sec. XIX, questa volta al fine di definire i numeri reali in termini di numeri razionali.

Analogamente, sebbene i Greci non definissero le aree e i volumi per mezzo del concetto di limite, ma ne dessero semplicemente per scontata l'esistenza, Archimede impiegò un procedimento di approssimazioni successive (detto in seguito ‛metodo di esaustione') per calcolare aree e volumi in un modo non solo rigoroso, ma anche molto vicino alla formulazione ‛ε, δ' di Weierstrass.

All'inizio del sec. XIX si registrò un ulteriore sviluppo che, da una parte, polarizzò di nuovo l'attenzione sull'impostazione greca della matematica e, dall'altra, dimostrò la necessità di una sua revisione. Uno degli assiomi di Euclide è equivalente - presupponendo la validità degli altri assiomi - all'asserzione che, per una qualsiasi retta l in un dato piano p e per un qualsiasi punto Q di p che non appartenga a l, esiste una e solo una retta l′ nel piano p che passa per Q ed è parallela a l. A seguito dei molteplici tentativi che erano stati fatti per arrivare a dedurre questo assioma dai rimanenti, tre matematici (Gauss, Lobačevskij e Bolyai) svilupparono - indipendentemente l'uno dall'altro - una teoria in cui l'assioma delle parallele non è valido, mentre tutti gli altri assiomi (e postulati intuitivi) della geometria sono ancora soddisfatti. Essi pervennero alla conclusione che la nuova teoria non portava, apparentemente, ad alcuna contraddizione. Questa scoperta contribuì a creare un clima psicologico nel quale gli assiomi cessavano di essere considerati come verità assolute, sebbene indimostrabili, ma venivano piuttosto presi come proposizioni primitive di una teoria, quindi arbitrari, purché logicamente compatibili; l'arbitrarietà degli assiomi poteva essere eventualmente limitata dal contesto in cui si intendeva applicarli.

La rappresentazione di un punto mediante coordinate numeriche, che aveva per lungo tempo costituito un valido aiuto nella soluzione di problemi geometrici, veniva ora impiegata per ricondurre la coerenza della geometria alla (presunta) coerenza dell'aritmetica. Così, ad esempio, per stabilire la coerenza degli assiomi della geometria metrica tridimensionale sarebbe stato sufficiente dimostrare che essi possono essere interamente soddisfatti in una struttura i cui punti sono terne di numeri reali. Ma, mentre questa aritmetizzazione della geometria eliminava il problema della coerenza da tale disciplina, essa acuiva il bisogno di una approfondita indagine sui fondamenti dell'aritmetica e sugli strumenti logici usati nello sviluppo della matematica.

La modernizzazione della logica era stata avviata da Boole, attorno alla metà del sec. XIX, con un metodo algebrico che riecheggiava le idee già proposte da Leibniz un secolo e mezzo prima; fu proseguita durante la seconda metà del secolo da parecchi studiosi in Inghilterra, Germania, Italia e Stati Uniti. Forse chi più di ogni altro si adoperò per render saldi i fondamenti della nuova logica e, nello stesso tempo, fu in grado di applicarla al problema dei fondamenti della matematica fu G. Frege. Questa reciproca interazione - tra la matematizzazione della logica e la formalizzazione della ricerca sui fondamenti e sulla filosofia della matematica - è da allora un carattere determinante delle due discipline.

3. Filosofia della matematica

Daremo ora un quadro delle tendenze più importanti nella odierna filosofia della matematica. E interessante notare che, nonostante le origini remote e alcuni successivi sviluppi ed elaborazioni considerevoli, le varie impostazioni si manifestarono in tutta la loro compiutezza in un periodo relativamente breve, durante i primi venticinque anni del nostro secolo.

Per il ‛logicismo' la matematica è una branca della logica. Da questo punto di vista, la distinzione tra matematica e logica (data per scontata nel presente scritto) ha solo un significato pragmatico. Tutti i concetti matematici sono riducibili a relazioni o a insiemi e questi, a loro volta, sono solo astrazioni di concetti logici. La nozione di ‛insieme', per esempio, si ottiene per astrazione dalla nozione di ‛proprietà'. Una grave difficoltà per quest'impostazione fu scoperta da B. Russell, che peraltro deve essere ricordato come uno dei principali sostenitori del logicismo: si tratta del ‛paradosso (o antinomia) di Russell', che sorge qualora si ammetta il principio di astrazione (o comprensione) senza alcuna restrizione.

Consideriamo, per esempio, la totalità di tutti gli insiemi; sia a uno di essi. Si ha che a appartiene ad a, in simboli a∉a, oppure a non appartiene ad a, a ∉a. La prima alternativa può apparire al lettore come la più verosimile, ma, in ogni modo, egli concorderà sul fatto che deve valere una delle due possibilità. Ora, se A è l'insieme i cui elementi sono caratterizzati dalla proprietà di non appartenere a se stessi, sorge il problema di stabilire se A appartenga o no a se stesso.

Se A∈A, allora A non soddisfa la proprietà che definisce A, quindi A non può appartenere ad A, cioè A∈A. Ma se così è, A soddisfa la proprietà che definisce A e quindi A∈A. Entrambe le affermazioni conducono dunque a una contraddizione, in opposizione al ‛principio del terzo escluso', la cui validità viene di solito ammessa.

Il paradosso di Russell assestò un duro colpo alle convinzioni di Frege, che può essere considerato il fondatore del logicismo. Lo stesso Russell, comunque, giunse alla conclusione che la difficoltà non stava nelle caratteristiche di fondo dell'impostazione logicistica, bensì nell'ammissione senza restrizioni di qualsiasi formulazione che sembrasse non obiettabile dal punto di vista grammaticale. Conseguentemente, egli pose una limitazione alla definibilità di nuovi insiemi con la condizione che non si potesse definire un insieme a partire da elementi introdotti in termini dell'insieme da definire. Al fine di rispettare questa condizione (detta ‛principio del circolo vizioso'), Russell e Whitehead, nella grande opera comune Principia mathematica, introdussero un sistema matematico organizzato in successivi livelli stratificati o ‛tipi'. In effetti, in questo sistema, il paradosso di Russell non può presentarsi.

In ogni caso, la difficoltà sollevata da questa antinomia si presenta non solo nel logicismo, ma anche in qualsiasi sistema logico che non ammetta qualche restrizione del tipo indicato. Il paradosso di Russell è solo un membro di una numerosa famiglia, alcuni componenti della quale risalgono all'antichità. Queste antinomie possono essere classificate a seconda che la loro natura sia linguistica o matematica. Una copiosa letteratura è a esse dedicata. Esistono altre difficoltà che investono il logicismo in modo peculiare. La più importante fra di esse è forse quella relativa al problema dell'esistenza di insiemi infiniti. L'esistenza ditali insiemi è una caratteristica essenziale della matematica così come la conosciamo, eppure essa non può essere dedotta dai principi generali della logica. In ogni modo, Russell e Whitehead ammisero l'esistenza di insiemi infiniti postulandoli assiomaticamente. La matematica dei Principia mathematica è matematica ‛classica' e il lavoro di Russell e Whitehead tendeva semplicemente a poggiare tale disciplina su fondamenti stabili e sicuri senza alcuna intenzione di sottoporla a una revisione critica. Pertanto essi accettarono anche l'assioma della scelta, sebbene la sua necessità nella logica pura sia discutibile. Inoltre, per quanto il logicismo come filosofia sia apparentemente neutrale rispetto al problema del significato dell‛esistenza matematica', cioè della realtà degli oggetti matematici, gli scritti dei logicisti, compresi Russell e Whitehead, rivelano di solito una tendenza platonica o, in altre parole, la credenza nella realtà (in un certo senso) di quel mondo che il sistema logico-matematico intende descrivere.

Un punto di vista più rivoluzionario a proposito della matematica nel suo complesso fu adottato dalle varie scuole del costruttivismo, tra le quali quella di maggior rilievo è l'intuizionismo (detto anche neointuizionismo). È possibile trovare una motivazione psicologica per la comparsa del costruttivismo nel crescente grado di astrazione che aveva assunto la matematica nel corso del suo sviluppo nel sec. XIX e, in effetti, anche nel suo sviluppo successivo. Il grado d'astrazione che sembra accettabile a un matematico dipende dalle sue convinzioni soggettive e, tra l'altro, dalla sua prima educazione. Cionondimeno la nuova interpretazione dei metodo assiomatico, dianzi descritta, assieme alla comparsa della teoria degli insiemi di Cantor, produsse un forte spostamento dal concreto all'astratto. Una reazione contro questo tipo di sviluppo non tardò molto a manifestarsi e il primo a capeggiarla fu il grande algebrista L. Kronecker. A più riprese, Kronecker ribadì il punto di vista che per dimostrare l'esistenza di un oggetto matematico con una data proprietà non è sufficiente dimostrare l'asserzione: ‛esiste un oggetto A con la proprietà X', in modo puramente formale mediante l'impiego di principi logici generali. Secondo Kronecker, una dimostrazione effettiva di una simile asserzione deve anche fornire un metodo mediante il quale tale oggetto possa essere effettivamente costruito un passo dopo l'altro. Analogamente, ogni volta che venga introdotta una proprietà per caratterizzare alcuni oggetti in una collezione (per esempio, la proprietà di un polinomio di essere irriducibile), è necessario fornire anche un metodo concreto mediante il quale si possa decidere se un dato membro della collezione possieda o no la proprietà in questione. Il solo sistema infinito accettato da Kronecker come primitivo è il sistema dei numeri naturali (interi positivi).

Kronecker non si limitò a elaborare teorie; le mise anche in pratica. Così è a lui che dobbiamo parecchi metodi costruttivi di valore duraturo. Assai meno encomiabile fu la sua opposizione feroce all'opera di G. Cantor sulla teoria degli insiemi, che egli riteneva tanto astratta da essere priva di senso.

All'inizio del sec. XX, L. E. J. Brouwer divenne l'esponente guida di un'impostazione costruttivista della matematica. Brouwer si spinse molto più in là di Kronecker: egli sviluppò un sistema elaborato, partendo da una piattaforma filosofica generale e giungendo fino a una nuova teoria del continuo. Secondo Brouwer il punto di partenza della matematica è il carattere a priori (sintetico) del tempo.

Il ‟suddividersi degli eventi in parti qualitativamente distinte che possono riunirsi solo restando separate nel tempo" viene considerato da Brouwer come quel fenomeno fondamentale dell'intelletto umano che conduce al contare e quindi al sistema dei numeri naturali. Per questa sua filosofia, Brouwer adottò il nome di neointuizionismo, proprio perché essa si basava sull'intuizione del tempo, considerato sì come un concetto sintetico, ma a priori, in senso kantiano, mentre rifiutò esplicitamente una posizione analoga riguardo all'intuizione dello spazio. Per quanto riguarda la logica, egli la considerò un'astrazione del pensiero matematico, invertendo in tal modo l'ordine di priorità stabilito dai logicisti, e ridimensionò il valore della formalizzazione totale delle regole di deduzione matematica. Secondo l'intuizionismo, non vi è posto nel pensiero matematico per totalità infinite complete, che possono formarsi soltanto mediante una serie di passi successivi. Inoltre, la legge del terzo escluso (tertium non datur) cessa di avere una validità universale. Consideriamo infatti una affermazione matematica X, per esempio la seguente: ‛esiste un numero naturale che possiede la proprietà P'. Un matematico ‛classico' darebbe per scontato che o X o non-X deve essere un'affermazione vera dell'aritmetica. Pertanto egli si riterrebbe autorizzato a provare X mostrando che l'ipotesi non-X conduce a una contraddizione. Per un intuizionista questo è inammissibile, poiché dal suo punto di vista l'affermazione X significa che esiste un procedimento costruttivo per determinare un numero naturale con la proprietà P, e ciò non è affatto la stessa cosa che dimostrare l'assurdità di non-X.

Il contributo più rilevante di Brouwer ai fondamenti della matematica è la sua teoria delle funzioni di variabile reale, basata su una nuova teoria del continuo dei numeri reali. In accordo con la sua impostazione generale, questi numeri dovrebbero essere considerati non una totalità completa, ma una collezione (specie) di oggetti matematici che emerge gradualmente: tra questi vi sono, in primo luogo, numeri che possono essere calcolati mediante una regola esplicita, come ad esempio la radice quadrata di 2. Tuttavia Brouwer ammette, anche, la possibilità di prendere in considerazione quei numeri reali che siano ottenuti mediante una successione di scelte arbitrarie e, in tal modo, siano essi stessi emergenti gradualmente. Come conseguenza di questo graduale processo di creazione, Brouwer deve distinguere tra due tipi di disuguaglianza fra numeri reali: un tipo ‛forte' di disuguaglianza, per cui, assegnati due numeri, risulta possibile dimostrare (in base alle leggi di generazione dei numeri stessi) che la loro differenza è maggiore di un numero razionale positivo, e un tipo ‛debole' di disuguaglianza, che asserisce soltanto come la presupposta uguaglianza tra i numeri in questione conduca a una contraddizione. La teoria delle funzioni che così si ottiene non è semplicemente una versione più debole della teoria classica, come si potrebbe ritenere in base ai vincoli autoimposti dall'intuizionismo, ma contiene anche dei risultati, come l'asserzione che una funzione reale ovunque definita è necessariamente continua, che sono in contraddizione diretta con la matematica classica.

Malgrado l'avversione di Brouwer per la formalizzazione della matematica, esiste un'estesa letteratura, in continuo aumento, in cui le idee di Brouwer sono analizzate ed elaborate in un modo molto raffinato mediante gli strumenti della logica matematica. Sono state sviluppate anche impostazioni diverse da quella di Brouwer da parte di matematici che si sono andati convincendo della sostanziale correttezza del punto di vista costruttivista. Essi ritengono che solo una revisione radicale della matematica secondo le loro idee può salvaguardarla dal degenerare in una ricerca illusoria e velleitaria (v. intuizionismo).

Anche se non si condivide questa opinione, bisogna ammettere che parte del lavoro eseguito con queste motivazioni ha contribuito a convertire teorie matematiche astratte in metodi concreti di calcolo. Inoltre, la nozione stessa di calcolabilità ha dato luogo a un'intera branca della logica matematica moderna che, sebbene formulata all'interno dell'apparato concettuale della matematica classica, deve molto allo spirito del costruttivismo.

D'altra parte, anche se si condivide lo spirito dell'impostazione costruttivista e, in particolare, l'impressione che la matematica moderna sia eccessivamente spregiudicata nell'uso di principi logici e matematici astratti, risulta difficile decidere quali siano esattamente i principi che vanno mantenuti all'interno di un'impostazione correttamente costruttivista. Certamente l'intuizionismo di Brouwer e, in particolare, la sua teoria delle funzioni vanno ben oltre un punto di vista puramente finitista, in cui sono ritenute ammissibili solo proposizioni e argomentazioni relative a oggetti finiti (insiemi finiti, relazioni o funzioni su insiemi finiti, ecc.) o, al più, proposizioni e argomentazioni immediatamente riducibili alle precedenti.

All'altra estremità del campo del costruttivismo, su posizioni diverse da quelle degli intuizionisti, vi sono i predicativisti, i quali non si oppongono in linea di principio alle costruzioni infinitarie, e anche alle totalità infinite, purché esse siano concepite attraverso una serie di passi successivi. Un predicativista, per esempio, può sostenere che non esiste un sistema uniforme di numeri reali, ma una successione di lunghezze rappresentate da numeri razionali, limiti di successioni di numeri razionali e così via. Al centro dell'attenzione dei predicativisti è l'esigenza di evitare le definizioni circolari, non solo per non incorrere in antinomie, come nel caso di Russell, ma perché tali definizioni sono considerate inammissibili in un sistema concettuale dotato di senso. Un precursore del predicativismo fu il grande matematico H. Poincaré. Poincaré partecipò attivamente alle discussioni filosofiche sui fondamenti della matematica che ebbero luogo all'inizio del secolo e, come Kronecker, mostrò una profonda perplessità nei confronti del crescente grado di astrazione della matematica. I suoi contributi in questo campo furono molto discontinui dal punto di vista qualitativo, talvolta profondi e talvolta superficiali (benché brillanti), come del resto avvenne per le sue critiche alla logica matematica.

Un contributo di gran lunga più importante ai fondamenti filosofici della matematica fu dato da D. Hilbert, unico tra i contemporanei di Poincaré a essere un matematico di pari valore. Hilbert era ben consapevole del fatto che l'ammissione incontrollata di principi logici e assiomi matematici astratti avrebbe potuto condurre a disastrose contraddizioni. D'altra parte egli non era disposto a rinunciare a vaste aree della matematica, in particolare alla teoria astratta degli insiemi, al solo fine di evitare questo pericolo. Egli propose, quindi, di dividere tutto il pensiero logico-matematico in due stadi. Nel primo stadio incluse una trattazione del tutto concreta (intuitiva, anschaulich) degli elementi della logica e dell'aritmetica. La coerenza delle conclusioni ottenute in questo contesto doveva essere garantita dalla loro stessa concretezza. Il secondo stadio doveva contenere, su base assiomatica, le teorie matematiche comunemente accettate, quali l'aritmetica pura, la teoria degli insiemi astratti, la geometria. Secondo Hilbert il problema principale non consisteva nello stabilire se queste teorie fossero astratte o concrete o se avessero un qualsivoglia significato letterale - nello stesso senso in cui può avere un significato la descrizione, diciamo, del contenuto di una borsa -, ma il requisito fondamentale che una teoria doveva soddisfare era piuttosto quello di essere coerente (priva di contraddizioni).

Hilbert ritenne che la coerenza delle teorie matematiche accettate, e in primo luogo dell'aritmetica (cioè la teoria dei numeri naturali), avrebbe potuto e dovuto essere stabilita mantenendo la discussione nel sicuro contesto finitista del primo stadio. Egli sottolineò inoltre l'importanza di scegliere gli assiomi di una teoria matematica in modo che siano mutuamente indipendenti, vale a dire in modo che nessun assioma della teoria sia deducibile dagli altri. Infine Hilbert richiamò l'attenzione sull'esigenza di escogitare procedimenti, soprattutto per l'aritmetica, che forniscano un metodo sistematico per decidere se un'asserzione sia vera o falsa, oppure deducibile o no nell'ambito di una data teoria.

I tre punti elencati costituiscono il ‛programma di Hilbert'. Di essi solo il secondo, relativo all'indipendenza degli assiomi, è stato sistemato in modo soddisfacente. In effetti, ancor prima di volgere la sua attenzione ai fondamenti della matematica in generale, Hilbert aveva scritto un testo, ormai classico, sui fondamenti della geometria, in cui erano prese in considerazione e risolte varie questioni di questo genere. I corrispondenti problemi della teoria assiomatica degli insiemi si dimostrarono più difficili da trattare, ma oggi anch'essi sono stati risolti.

Per quanto riguarda la scoperta di procedimenti di decisione, dobbiamo distinguere, in generale, tra una situazione in cui siamo chiamati a decidere effettivamente (ad esempio mediante un programma di un calcolatore elettronico) se un dato teorema è deducibile da un insieme di assiomi specificato e il caso in cui ci si chieda di decidere se una asserzione è vera in una determinata struttura, per esempio in quella dei numeri naturali. Hilbert diede per scontato che fosse sempre possibile descrivere una data struttura mediante un sistema di assiomi, dal quale potessero essere derivate tutte le sue proprietà. In ogni caso, grazie all'opera rivoluzionaria di K. Gödel (1931), completata in alcuni aspetti importanti da A. Church e A. Tarski, oggi sappiamo che: 1) non esiste un procedimento effettivo per decidere se un'affermazione sia o no vera per il sistema dei numeri naturali; 2) non esiste un procedimento effettivo per decidere se un'asserzione relativa all'aritmetica sia o no deducibile dagli assiomi di Peano per l'aritmetica (si veda il prossimo capitolo); 3) non tutti i teoremi dell'aritmetica possono essere o dimostrati o confutati per mezzo degli assiomi di Peano; 4) non è possibile individuare un sistema di assiomi dal quale possano essere dedotte tutte le asserzioni vere dell'aritmetica.

Dovremmo dire a questo punto che, d'altro canto, esistono effettivamente procedimenti di decisione per teorie e strutture matematiche importanti, quali le teorie elementari dei numeri reali e dei gruppi commutativi. Tuttavia, considerando la posizione fondamentale occupata dall'aritmetica nello schema di Hilbert e, in generale, nella matematica, i risultati sopra menzionati assestarono un duro colpo al suo programma. Ancor più cruciale fu la scoperta, dovuta anch'essa a Gödel, del fatto che è dimostrabile l'impossibilità di stabilire la coerenza dell'aritmetica nell'ambito dell'universo finitista ammesso da Hilbert per questo scopo. Ciò dimostrava che anche il primo punto del programma di Hilbert non avrebbe potuto essere realizzato in modo soddisfacente.

Gran parte dell'opposizione al punto di vista di Hilbert non ha alcuna relazione con l'opera di Gödel e di fatto la precedette. Essa prese di mira piuttosto la tesi di Hilbert secondo la quale la matematica infinitista non ha a rigore alcun contenuto concreto, cioè non descrive alcuna realtà, fisica o platonica che sia. Pertanto Hilbert fu accusato di degradare la matematica riducendola a un gioco eseguito con serie di simboli prive di senso. Perfino al giorno d'oggi si trovano autori che tentano di combattere questo punto di vista più con sarcastico sdegno che con argomenti razionali. A questo proposito si dovrebbe ricordare che sia Hilbert sia coloro che condividono il suo punto di vista non cercano affatto di legiferare, ma semplicemente di descrivere la situazione come essi la vedono. Chiunque creda nella realtà obiettiva (benché platonica) delle meravigliose infinità evocate dalla matematica moderna dovrebbe ricordare le parole di un grande filosofo il quale osservò, riferendosi alle più famose questioni metafisiche, che l'idea di avere in tasca un tallero d'argento non significa avercelo realmente.

Nonostante il definitivo fallimento della parte tecnica del programma di Hilbert in alcuni dei suoi aspetti principali, la sua opera ebbe una grande influenza sullo sviluppo successivo della logica matematica. Il sistema deduttivo elaborato da lui e dai suoi seguaci è ancora largamente adoperato e gli strumenti teorici messi a punto, sia per raggiungere certi scopi, sia per mostrare che certi altri sono irraggiungibili, occupano una buona parte dell'arsenale del logico moderno.

Il problema dell'infinito è forse tuttora il problema centrale della filosofia della matematica, sebbene agli occhi di alcuni filosofi esso appaia ormai immerso in una problematica più generale. Per un nominalista, ad esempio, lo stesso concetto di insieme è privo di senso o, tutt'al più, è soltanto un'espressione linguistica, per cui un insieme finito non possiede un maggior grado di realtà di un insieme infinito. Per un positivista logico l'intera matematica è parte del linguaggio e il problema stesso dell'esistenza di entità infinite è privo di senso. In ogni caso questo è un problema che ha appassionato in egual misura filosofi e matematici fin dagli albori della scienza. La matematica moderna ha ricondotto la nozione geometrica di infinità alle infinità più astratte dell'aritmetica e della teoria degli insiemi. Potremmo, quindi, congetturare che le future generazioni di matematici trasformeranno ancora una volta i fondamenti della matematica e affronteranno il problema dell'infinito in una forma ancora sconosciuta.

4. Fondamenti delle discipline matematiche

La teoria degli insiemi considera le proprietà astratte di insiemi (aggregati, collezioni). Come già detto, questa disciplina fu fondata e sviluppata da O. Cantor (dopo il 1870). Da allora essa è divenuta uno dei campi fondamentali della matematica e tutta, o quasi tutta, la matematica può essere ricondotta a essa, almeno dal punto di vista tecnico. Cantor ritenne di poter sviluppare la teoria degli insiemi a partire da una base intuitiva, considerando come insieme una qualsiasi collezione di oggetti che potessero essere caratterizzati in un modo definito. E. Zermelo (1904), per dimostrare un'importante congettura di Cantor, si rese conto della necessità di introdurre un'ipotesi ad hoc che, sebbene apparentemente ragionevole, non poteva essere considerata vera per se stessa. L'ipotesi, nota come ‛assioma della scelta', stabilisce che, per ogni insieme S di insiemi non vuoti, esiste una funzione f(x) definita su tutti gli elementi di S e tale che, per ogni elemento a di S (in simboli: a∈S), f(a) appartiene ad a, f(a)∈a. Cioè, in breve, si suppone che f(x) assegni a ogni insieme in S un elemento di quell'insieme. Utilizzando questo assioma Zermelo fu in grado di dimostrare il ‛teorema del buon ordinamento', che stabilisce che ogni insieme A (per esempio l'insieme dei numeri reali) può essere totalmente ordinato in modo tale che ogni sottoinsieme non vuoto di A abbia un primo elemento rispetto alla relazione d'ordine. In quel periodo Zermelo si servì dell'assioma della scelta in concomitanza con altre ipotesi naturali sugli insiemi non esplicitate. Pochi anni più tardi egli formulò un sistema di assiomi più ampio che, in aggiunta all'assioma della scelta, conteneva altri assiomi, il cui scopo era quello di assicurare l'esistenza di insiemi infiniti e di insiemi costruiti in modo naturale a partire da insiemi dati, come ad esempio l'insieme dei sottoinsiemi di un insieme dato, oppure l'insieme di tutti gli elementi di un insieme dato che sono caratterizzati da una proprietà chiaramente formulata (‛definita').

Il sistema di Zermelo fu integrato in alcuni aspetti importanti da A. Fraenkel e il sistema che ne risultò è largamente usato ancora oggi. Sebbene, come abbiamo visto in precedenza, gli assiomi della geometria siano, fin dall'inizio del sec. XX, decaduti dal rango di verità assolute, molte discussioni riguardanti gli assiomi della teoria degli insiemi concernono ancor oggi il problema della loro verità (presumibilmente assoluta). Indipendentemente dall'atteggiamento personale verso tale questione, si vuol sapere a buon diritto se un dato assioma della teoria degli insiemi sia indipendente o no dai rimanenti in un dato sistema, ad esempio il sistema di Zermelo-Fraenkel. Fraenkel stesso dimostrò (1922) che, in tale sistema, l'assioma della scelta non può essere dedotto dagli altri assiomi, mentre Gödel provò alcuni anni più tardi (1938) che esso non può neppure essere rifiutato in base a questi assiomi, cioè che in ogni caso l'aggiunta dell'assioma della scelta non rende il sistema inconsistente (ammesso che esso sia inizialmente coerente).

Vi è un altro problema basilare della teoria degli insiemi che è indipendente sia dal sistema di Zermelo-Fraenkel, che include l'assioma della scelta, sia da ogni altro analogo sistema di assiomi. Questo problema riguarda la nozione di ‛cardinalità', che ci accingiamo a illustrare. Al fine di generalizzare la nozione di cardinalità da insiemi finiti a insiemi infiniti, Cantor attribuisce a due insiemi lo stesso numero cardinale se i loro elementi possono essere posti in corrispondenza biunivoca. In tali condizioni, due insiemi si dicono equivalenti (o equipotenti). È perfettamente possibile che un insieme infinito A sia equivalente a un insieme B e contemporaneamente anche a un sottoinsieme proprio di B (mentre ciò è impossibile nel caso di insiemi finiti). Tuttavia, se un insieme A è equivalente a un sottoinsieme proprio di B, ma non allo stesso B, si dice che il numero cardinale di A è minore del numero cardinale di B. Ne risulta un ordinamento dei numeri cardinali che estende il sistema dei numeri cardinali finiti, cioè dei numeri naturali. Il più piccolo numero cardinale infinito è proprio il numero cardinale dell'insieme dei numeri naturali. Esso è denotato dal simbolo ℵ0, dove il segno ℵ - che si legge ‛alef' - è la prima lettera dell'alfabeto ebraico. ℵ0 è anche il numero cardinale ℵ dell'insieme dei numeri razionali e anche dell'insieme di tutti i numeri algebrici, ma Cantor mostrò che ℵ0è minore del numero cardinale א dell'insieme dei numeri reali. Ci si chiese a questo punto se esistesse un numero cardinale compreso fra ℵ0 e ℵ. L'opinione di Cantor era che un tale numero cardinale non potesse esistere (‛ipotesi del continuo'). Nello stesso lavoro in cui trattò della coerenza dell'assioma della scelta, Gödel dimostrò anche che l'ipotesi del continuo è compatibile almeno con gli assiomi della teoria degli insiemi. In realtà egli adoperò un sistema di assiomi differente da quello di Zermelo-Fraenkel, ma le sue argomentazioni possono essere adattate anche a quest'ultimo. Infine, nel 1963, P. J. Cohen, usando i metodi di Gödel assieme ad alcune idee radicalmente nuove, dimostrò che è impossibile dedurre l'ipotesi del continuo dagli assiomi di Zermelo-Fraenkel. Ciò lasciò a chiunque creda nella realtà (platonica) del mondo degli insiemi il compito di trovare per la teoria degli insiemi un nuovo assioma che sia abbastanza evidente da essere accettato universalmente, o quasi, e tale che in questo sistema sia possibile decidere sulla legittimità o meno dell'inclusione dell'ipotesi del continuo. La ricerca di un tale assioma è tuttora in corso.

Vi è un altro gruppo di assiomi della teoria degli insiemi che può essere o no incluso in un sistema dato. Questi assiomi riguardano l'esistenza di insiemi il cui numero cardinale sia molto grande. Può essere dimostrato all'interno del sistema di Zermelo-Fraenkel (o di qualsiasi altro sistema assiomatico ‛ragionevole' per la teoria degli insiemi) che per ogni insieme S esiste un insieme S′ il cui numero cardinale è maggiore del numero cardinale di S. In particolare si può dimostrare che S′ è l'insieme dei sottoinsiemi di S. Tuttavia gli assiomi addizionali ai quali ci riferiamo postulano l'esistenza di insiemi la cui cardinalità è maggiore di qualsiasi cardinalità che sia possibile ottenere all'interno del sistema di Zermelo-Fraenkel. Sorprendentemente l'esistenza ditali insiemi condiziona anche le proprietà di insiemi infiniti relativamente ‛piccoli'.

Nel sistema in discussione la sola relazione fondamentale è la relazione di appartenenza, x∈y (si legga ‛x è un elemento di y'). A partire da questa si può dedurre la nozione di identità definendo x=y se, per ogni z, z∈x se, e solo se, z∈y, in altre parole se x e y hanno esattamente gli stessi elementi (carattere di ‛estensione' della nozione di insieme). Uno degli assiomi stabilisce poi che, se x=y, x e y appartengono esattamente agli stessi insiemi. Viceversa, possiamo assumere quest'ultima proprietà come definizione di identità (principio di Leibniz) e quindi sostituire la definizione precedente con un assioma corrispondente. L'insieme che contiene come unico elemento a è denotato con {a} ed è chiamato il singleton di a, l'insieme che contiene come elementi a e b è denotato con {a, b}. Un opportuno assioma ci assicura che questi insiemi esistono. Nella teoria degli insiemi si definisce ‛coppia ordinata' (a, b) l'insieme {{a}, {a, b}} e la definizione è analoga per le nozioni di terna ordinata, quaterna ordinata, ..., n-upla ordinata (a1, a2, ..., an). Una ‛relazione', infine, è definita come un insieme di n-uple e una ‛funzione' come una relazione R(x1, ..., xn, y) in cui, per ogni data n-upla x1, ..., xn, esiste al più un y che soddisfa la relazione. Un'‛operazione' in algebra o in aritmetica non è altro che una funzione. In questo modo, sulla base delle definizioni precedenti - che sono piuttosto tecniche e anche un po' artificiose -, ogni teoria matematica nota può essere espressa nell'ambito della teoria degli insiemi. Per questa ragione, e anche perché i problemi a essa relativi interessano direttamente molti altri rami della matematica, la teoria degli insiemi è giunta a essere considerata da molti come l'oggetto fondamentale della matematica pura, prendendo il posto che la geometria aveva occupato sotto l'egida di Euclide e persino il posto dell'aritmetica. Resta da vedere se questa situazione sia definitiva.

Come indica il suo nome, l'‛algebra' medievale era la scienza delle operazioni aritmetiche. In seguito si occupò principalmente della soluzione delle equazioni polinomiali. Da circa mezzo secolo tratta, più in generale, della struttura dei modelli (realizzazioni) di taluni insiemi di assiomi che si riferiscono (prevalentemente) a un certo numero di operazioni, quali l'‛addizione', la ‛moltiplicazione', l'‛intersezione', l'‛unione' e persino, per taluni suoi aspetti, la ‛differenziazione'. Sembra difficile determinare a priori quale tipo di sistema di assiomi debba essere considerato come algebrico e potremo solo elencare alcuni sistemi algebrici tra i più importanti.

1. Si chiama ‛gruppo' una struttura G che si basa su una singola operazione binaria, ab=c, detta moltiplicazione o, talvolta, addizione. L'operazione è associativa, cioè si ha (ab)c=a(bc) per tutti gli a, b, c in G. Esiste un elemento neutro o ‛identità', e, tale che ae=ea=a per tutti gli a in G. Inoltre, per ogni a in G, esiste un a′ in G tale che aa′=a′a=e. Il gruppo si chiama ‛commutativo' se ab=ba per tutti gli a e b in G. Esempi di gruppi commutativi sono forniti dagli interi, rispetto all'addizione, e dai numeri reali positivi, rispetto alla moltiplicazione. Un gruppo non commutativo è il gruppo delle rotazioni nello spazio, dove il ‛prodotto' di due rotazioni si ottiene eseguendole l'una dopo l'altra.

2. Si chiama ‛anello' R una struttura in cui sono definite due operazioni, addizione e moltiplicazione. R è un gruppo commutativo rispetto all'addizione, mentre la moltiplicazione è associativa e soddisfa le leggi distributive, a(b+c)=ab+ac e (b+c) a=ba+ca per tutti gli a, b e c in R. In un anello l'identità rispetto all'addizione è denotata con 0, come avviene per gli interi, che costituiscono un esempio di anello. Si dice che R possiede l'elemento unità 1, se a1=1a=a per tutti gli a in R. Non vi può essere più di un elemento di questo tipo.

3. Si chiama ‛corpo' F un anello con elemento unità 1, differente da 0, con moltiplicazione commutativa (ab=ba per tutti gli a e b in F) e tale che per ogni a≠0 vi è un a′ per cui aa′=1. In un corpo tutti gli elementi diversi da 0 costituiscono un gruppo rispetto alla moltiplicazione. I numeri razionali costituiscono l'esempio di un corpo.

4. Si chiama ‛corpo ordinato' un corpo in cui sia definito un ordinamento lineare (totale), a>b, tale che, per tutti gli a, b e c nel corpo, dalla condizione a>b segua che a+c>b+c e dalle due condizioni a>b e 0>c segua ac>bc. Un corpo ordinato è ‛archimedeo' se soddisfa il seguente ‛assioma di (Eudosso)-Archimede': sia 0>a>b; allora è sempre possibile ottenere un numero maggiore di b addizionando a a se stesso per un numero sufficiente di volte, cioè a+a+a+...+a⟨b.

I numeri reali costituiscono un corpo ordinato archimedeo, ma i numeri complessi, sebbene formino un corpo, non possono essere ordinati.

5. Si chiama ‛algebra booleana' una struttura B con due operazioni binarie, a⋃b e a⋂b, una operazione unaria, a′, detta complementazione, e due elementi distinti, 0 e 1, che soddisfano le seguenti condizioni: le operazioni ⋃ e ⋂ soddisfano la legge commutativa e la legge associativa. Esse sono collegate fra loro dalle leggi distributive a destra e a sinistra, e cioè per ogni a, b, e c in B risulta (a⋃b)⋂c = (a⋂c)⋃(b⋂c) e (a⋂b)⋃c = (a⋃c)⋂(b⋃c). Inoltre, per qualsiasi elemento a di B, risulta a⋃0=a, a⋂1=a, a⋃a′=1, a⋂a′=0.

Un esempio tipico di algebra booleana è l'insieme di tutti i sottoinsiemi di un dato insieme V, dove i simboli ⋃ e ⋂ denotano, rispettivamente, l'unione e l'intersezione di due insiemi. In questo sistema 1 e 0 indicano l'intero insieme V e l'insieme vuoto, rispettivamente. L'apice ′ denota la complementazione all'interno di V, cioè se a è un sottoinsieme di V, e quindi un elemento dell'algebra booleana, a′ è composto da tutti gli elementi di V che non appartengono ad a.

La ‛teoria dei numeri' o ‛aritmetica' si occupa delle proprietà del sistema dei numeri naturali, 0, 1, 2 .... Questo sistema può essere ricondotto direttamente alla teoria degli insiemi considerando i numeri naturali come numeri cardinali finiti, ove la nozione di finitezza è a sua volta definita puramente in termini di teoria degli insiemi. Tuttavia, anche se si accetta questa riduzione definitiva, l'aritmetica viene abitualmente fondata su di un sistema di assiomi dovuto a Peano, o su una sua variante. Il più interessante tra questi assiomi è ‛l'assioma di induzione (completa)', che afferma quanto segue: supponiamo che il numero 0 possieda una proprietà P e che ogni volta che P sia posseduta da un numero naturale n allora sia posseduta anche da n + 1. Allora tutti i numeri naturali possiedono la proprietà P.

Un'asserzione equivalente è che una proprietà Q non può essere posseduta da alcun numero naturale se, ogni volta che è posseduta da un numero naturale n, è posseduta anche da un numero naturale più piccolo di n. È questo il ‛principio della discesa infinita' che fu reso famoso da Fermat, ma che era già usato da Euclide. Euclide non lo formulò comunque in veste di assioma.

L'‛analisi' si basa su una gerarchia dei sistemi numerici, cioè i numeri naturali, sopra considerati, gli interi, i numeri razionali, i numeri reali e i numeri complessi. Mostreremo come, preso come dato di partenza il sistema dei numeri naturali, i sistemi rimanenti possono essere introdotti mediante definizioni.

Gli ‛interi' sono definiti come coppie ordinate di numeri naturali, α=(a, a′), β=(b, b′), ecc., dove α e β sono considerati eguali se a+b′=b+a′. La somma e il prodotto di interi sono definiti, in termini di addizione e moltiplicazione di numeri naturali, dalla α+β=(a+b, a′+b′), α•β=(ab+a′b′, a′b+ab′). Entro il sistema degli interi un numero naturale è identificato con (a, 0), mentre il numero che in notazione più familiare sarebbe stato scritto con −a è dato da (0, a). Scopo dell'introduzione degli interi negativi è di poter eseguire la sottrazione senza eccezioni.

Per essere in grado di dividere senza eccezioni, a parte la condizione che il divisore sia diverso da 0, si passa dagli interi ai ‛numeri razionali'. La rappresentazione di un numero razionale come coppia di interi α/β, dove β≠0, è ben nota e possiamo risparmiare al lettore i relativi dettagli.

Il passo successivo è costituito dal passaggio dai numeri razionali ai numeri reali; come già abbiamo accennato nella nostra breve rassegna storica, esso fu reso necessario dall'esistenza di lunghezze incommensurabili in geometria. Vi sono parecchi metodi (equivalenti) per introdurre i numeri reali, tutti concettualmente molto più profondi di quelli impiegati per introdurre gli interi e i razionali mediante coppie; ci contenteremo di una rapida descrizione di uno di essi. Esso fu proposto indipendentemente da G. Cantor e da C. Meray circa un secolo fa. Per capirlo meglio, consideriamo un numero reale come un punto di una retta sulla quale siano stati fissati i punti 0 e 1, secondo la nozione intuitiva comune in analisi fino a quell'epoca. Se {an} è una successione di numeri razionali, {an} può tendere a un limite razionale; per esempio la successione {0, 1/2, 2/3, 3/4, ..., (n−1)/n, ...} tende a 1. Oppure {an} può non tendere affatto a un limite, come ad esempio avviene se an=(−1)n, n=0, 1, 2, ... . Ma {an} può anche tendere a un limite che, tuttavia, è irrazionale, per esempio nel caso in cui a0=1, a1=1,4=14/10, a2=1,41=141/100, a3=1,414=1414/1000, ecc. Per di più, qualsiasi numero reale può essere ottenuto in questo modo come limite di una successione di numeri razionali. Cauchy, qualche tempo prima, aveva formulato la condizione necessaria e sufficiente perché una successione {an} tenda a un limite. Questa condizione è che la differenza an−am tenda a zero. Essa non implica la conoscenza del limite stesso. Conseguentemente Cantor e Meray decisero di definire un numero reale α come una successione di numeri razionali α={a0, a1, a2, ...} che soddisfi la condizione di Cauchy. Si dice che α è uguale a un'altra successione di numeri razionali di questo tipo, β={b0, b1, b2, ...}, se la differenza tra le due successioni, eseguita termine a termine, {a0−b0, a1−b1, a2−b2, ...}, tende a 0. Inoltre, se α e β sono due numeri reali nel senso suddetto, anche la loro somma e il loro prodotto sono definiti termine a termine, α+β={a0+b0, a1+b1, a2+b2, ...} e a α•β={a0b0, a1b1, a2b2, ...}. Entro questo sistema di numeri reali un numero razionale a è identificato con la successione costante {a, a, a, ...}.

A tutti i sistemi numerici sinora considerati è associato un ordinamento naturale. Conseguentemente non esiste alcun numero reale il cui quadrato sia −1 o, in altre parole, un numero che soddisfi l'equazione x2+1=0. Il desiderio di avere sempre soluzioni, sia per questa particolare equazione, sia per tutte le altre equazioni algebriche xn+c1xn-1+...+cn-1x+cn=0, n≥2, conduce all'ultima estensione del sistema dei numeri che interessa l'analisi classica: si definiscono, cioè, i ‛numeri complessi' come coppie ordinate di numeri reali, α=(a, a′), β=(b, b′), ecc., dove α è considerato uguale a β se e solo se a=a′ e b=b′. L'addizione è definita termine a termine, α+β=(a+b, a′+b′), mentre α•β=(aa′−bb′, ab′+ba′). Per poter considerare i numeri reali come un sottoinsieme dei numeri complessi si identifica un numero reale a con il numero complesso (a, 0). Ponendo i=(0, 1), risulta i2 =ii=(−1, 0)=−1, cosicche i è la radice quadrata di −1 nel nuovo sistema. Un numero complesso α=(a, a′) può essere rappresentato da un punto di un piano, con coordinate x=a e y=a′. Questa visualizzazione, dovuta a Gauss, Argand e Wessel, favori l'assimilazione dei numeri complessi, a lungo ritardata malgrado la loro semplicità concettuale rispetto ai numeri reali. Invece di definire i vari sistemi numerici ‛geneticamente' attraverso gli altri sistemi, possiamo anche caratterizzarli direttamente mediante assiomi, come abbiamo fatto inizialmente per i numeri naturali. Ad esempio, i numeri razionali sono caratterizzati (‛a meno di isoformismi') dalla proprietà di costituire un corpo ordinato minimale, sono cioè tali da non avere alcun sottosistema proprio che sia un corpo. D'altra parte i numeri reali possono essere caratterizzati come corpo ordinato archimedeo massimale, tale cioè da non avere ampliamenti propri che siano ancora corpi ordinati archimedei. Sia in aritmetica che in analisi si ha a che fare in prima istanza con strutture matematiche specifiche, univocamente definite, mentre in algebra ci si occupa della totalità delle strutture che soddisfano un dato sistema assiomatico. Tuttavia un esame più accurato del punto di vista logico mostra che questa distinzione costituisce forse l'oggetto di una tendenza piuttosto che una realtà obiettiva. Ad esempio, sappiamo che oltre ai numeri naturali esistono, a seconda dell'interpretazione degli assiomi di Peano, molte altre strutture che soddisfano questi assiomi.

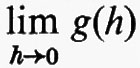

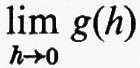

L'analisi, sia reale che complessa, può a questo punto essere sviluppata entro questo preciso contesto. La nozione centrale dell'analisi classica è il concetto di limite, che può essere illustrato dagli esempi seguenti. Sia g(h) una funzione a valori reali definita in un intorno di 0, per −a>h>a, ma non per h=0. Diciamo allora che g(h) tende al limite λ per h che tende a 0, in simboli:

dove λ è un numero reale, se per ogni ε⟨0, esiste un δ⟨0 tale che ∣λ−g(h)∣>ε, se 0>∣h∣>δ. Sia ora f(x) una qualsiasi funzione reale di una variabile reale e, per ogni x=ξ all'interno del suo intervallo di definizione, consideriamo il quoziente g(h)=(f(ξ+h)−f(ξ))/h. È questo il ‛rapporto incrementale' (la ‛pendenza') della funzione f(x) tra ξ e ξ+ h. Se il

esiste, λ è la ‛derivata' di f(x) per x=ξ. Questa è la nozione fondamentale del calcolo differenziale. È in apparenza un concetto puramente tecnico, ma prima che fosse formulato in questa forma precisa, la questione di trovare una definizione accettabile per la derivata di una funzione era considerata come il problema più importante per i fondamenti e addirittura per la filosofia (‛metafisica') della matematica.

I vari rami della geometria possono essere classificati, in prima approssimazione, in base alle nozioni che li caratterizzano. Così la geometria proiettiva tridimensionale si occupa di punti, rette e piani e delle loro proprietà di incidenza e d'intersezione. Nella geometria affine si introduce la relazione di parallelismo, che può essere soddisfatta da certi piani e da certe rette complanari che hanno una particolare posizione reciproca. La geometria affine può essere ottenuta dalla geometria proiettiva specificando un piano particolare come ‛piano all'infinito'. Introducendo, in più, il concetto di distanza, o di equidistanza, otteniamo i vari tipi di geometria metrica. Per tutte queste geometrie sono stati formulati in vari modi e studiati in grande dettaglio dei sistemi assiomatici. Di particolare interesse è la connessione tra le proprietà geometriche di un dato spazio e le proprietà algebriche del sistema numerico che può essere impiegato per introdurre in esso un sistema di coordinate.

Nel 1872 F. Klein, in una celebre conferenza, che divenne famosa come programma di Erlangen, mostrò come fosse possibile ottenere una più profonda comprensione dei rapporti reciproci tra le varie geometrie classificandole in base ai gruppi di trasformazioni che lasciano invariati i concetti e le proprietà di quelle geometrie. La geometria euclidea, per esempio, è la geometria del gruppo delle rotazioni e delle traslazioni dello spazio. Questa impostazione è applicabile con egual successo anche a geometrie n-dimensionali con n maggiore di 3. La convinzione che la geometria dovesse basarsi, in ultima analisi, sull'intuizione spaziale aveva creato delle difficoltà per la geometria pluridimensionale, difficoltà che svanirono allorché i punti dello spazio n-dimensionale furono identificati con n-uple di numeri reali, o anche complessi. Tuttavia esistono tipi di geometrie che non possono essere inclusi nel programma di Erlangen, in particolare la geometria riemanniana, che è data da una definizione analitica di distanza che può variare da punto a punto.

Più ampio è il gruppo di trasformazioni dello spazio che si prende in considerazione, più piccolo è il numero di concetti e proprietà che esso lascia invariati, e più generali sono questi concetti. La disciplina che si occupa dei concetti che rimangono invariati rispetto a tutte le tra- formazioni biunivoche e bicontinue (si tratta di un gruppo di trasformazioni molto ampio) si chiama ‛topologia'. Per esempio, il numero di buchi in un solido, o il problema relativo alla possibilità di connettere con una linea continua interna al solido stesso due suoi punti qualsiasi sono argomenti che fanno parte del campo d'applicazione della topologia. Anche in questo caso, invece di essere basata sulla geometria e in definitiva sui numeri reali, la nozione di spazio topologico può essere introdotta direttamente per mezzo di assiomi. Sia A un insieme di oggetti, chiamati ‛punti', e sia Ω un insieme di sottoinsiemi di A chiamati ‛insiemi aperti'. (Intuitivamente, un sottoinsieme U del dato insieme A è aperto se, per ogni punto p di U, ogni punto q di A sufficientemente vicino a p - in un senso non necessariamente metrico - appartiene anch'esso a U). Si dice, quindi, che la coppia (A, Ω) è uno spazio topologico se: a) A è aperto, cioè appartiene a Ω; b) l'insieme vuoto è aperto; c) l'intersezione di due insiemi aperti è un insieme aperto; d) l'unione di un qualsiasi numero di insiemi aperti è anch'esso un insieme aperto. Spesso uno spazio topologico soddisfa anche la condizione che, se p e q sono due punti distinti di A, esistono due insiemi aperti U e V privi di punti in comune, tali che p appartiene a U e q appartiene a V. Tale assioma si chiama ‛assioma di Hausdorff' sebbene Hausdorff abbia introdotto l'intero sistema di assiomi per una struttura topologica.

Malgrado la loro apparente semplicità, gli assiomi precedenti - insieme con ulteriori ipotesi, ove esse siano necessarie - sono estremamente efficaci. Nello stesso tempo, per la loro generalità, tali assiomi sono ampiamente applicabili e si dà il caso che essi siano soddisfatti e conducano a risultati interessanti anche in molte strutture che, dal punto di vista intuitivo, non hanno alcuna relazione con la geometria. D'altra parte, la teoria dei gruppi, concepita in origine in relazione a problemi algebrici, si è rivelata di grande importanza in topologia. Inoltre, alcune diramazioni della teoria dei gruppi sono state ulteriormente sviluppate in vista delle loro applicazioni topologiche, e queste, a loro volta, si sono dimostrate molto fruttuose anche in altri campi della matematica. Pertanto il metodo assiomatico, oltre al ruolo che svolge nel problema dei fondamenti della matematica, ha dimostrato la sua grande importanza anche per la scoperta di nuovi risultati.

5. Logica matematica

Si possono costruire dei linguaggi formali con diversi gradi di capacità espressiva. Tracceremo anzitutto le linee essenziali di un linguaggio base, il cui scopo è quello di illustrare il modo in cui le proposizioni possono essere modificate o associate tra di loro per dar luogo a nuove proposizioni. E questo il linguaggio del ‛calcolo proposizionale'. Per esempio, se p sta per ‛Giovanni ha otto anni' e q per ‛Giovanni è alto un metro e trenta', allora p⋀q vorrà dire ‛Giovanni ha otto anni ed è alto un metro e trenta'. La risposta alla domanda se p⋀q sia vera o falsa in una data situazione, cioè in riferimento a un particolare ragazzo chiamato Giovanni, in un dato momento, dipende allora solo dalla verità o dalla falsità di p e di q. Così p⋀q è vera se p e q sono entrambe vere, altrimenti è falsa. Analogamente, p⋀q, che vuol suggerire il significato espresso dalla congiunzione inclusiva ‛o', è falsa se p e q sono entrambe false, altrimenti è vera. I simboli ⋀ e ⋀ si chiamano ‛connettivi'. Un altro connettivo dal significato ovvio e intuitivo è ¬ (non). Così ¬p è falsa se p è vera ed è vera se p è falsa. Date p e q, vi sono esattamente 16 modi in cui possiamo assegnare i due ‛valori di verità' vero e falso (che indicheremo, rispettivamente, con le abbreviazioni V ed F) per le quattro possibili combinazioni dei valori di verità di p e q rispettivamente. Per alcuni di questi non esistono espressioni direttamente corrispondenti in italiano (o in altre lingue naturali). Per altri, invece, il linguaggio naturale non è sufficientemente preciso per una interpretazione non ambigua. Per esempio, sia p⊃q la proposizione definita stipulando che essa è falsa se p è vera e q è falsa e che essa è vera in tutti gli altri casi. La proposizione p⊃q si legge ‛se p allora q' oppure ‛p implica q', malgrado il disagio che sorge talvolta dal fatto che in questo modo ‛p implica q' può essere vera anche quando q è falsa, se p è anch'essa falsa.

Per n simboli o ‛variabili', p1, ..., pn, esistono 22n possibilità di assegnare i valori. V e F per le 2n possibili combinazioni dei valori di verità di p1, ..., pn. Ogni assegnazione di questo tipo si chiama ‛funzione di verità'. Tutte le funzioni di verità possono essere ottenute, in vari modi, combinando un numero limitato di esse; per esempio ¬p e p⋀q sono sufficienti a questo scopo. In effetti p⋀q equivale, come funzione di verità, a ¬(¬p⋀¬q), p⊃q equivale a ¬p⋀q, e così via.

Finora non abbiamo fatto una netta distinzione tra i simboli e il loro significato. Per un'impostazione formalizzata procediamo come segue. Definiamo ‛linguaggio' un insieme di successioni di simboli ‛atomici' costruite secondo una serie di regole assegnate. Nel nostro caso i simboli atomici saranno: a) variabili, p, q, r, p0, p1, ...; b) connettivi, ¬, ⋀; 7; c) parentesi, (,). Le successioni, chiamate proposizioni o, con un termine più tecnico, formule ben formate, o sono variabili oppure sono ottenute da variabili per mezzo di un numero finito di applicazioni delle due regole seguenti: a) se X è una proposizione allora (¬X) è una proposizione; b) se X e Y sono proposizioni allora (X⋀Y) è una proposizione.

In questo linguaggio, se vogliamo ancora adoperare ⋀ e ⊃, le successioni risultanti possono essere considerate come abbreviazioni di proposizioni corrispondenti in termini di ¬ e ⋀, con (X ⋀ Y) al posto di (¬((¬X)⋀(¬Y)) e X⊃Y al posto di ((¬X)⋀Y). Si usa anche omettere le parentesi quando non possano sorgere equivoci, assumendo per convenzione che la negazione debba leggersi prima della disgiunzione, della congiunzione e dell'implicazione, cosa che faremo anche noi quando si presenterà l'occasione. Così ¬X⋀Y sta per ((¬X)⋀Y) e non per (¬(X⋀Y)).

Per ogni assegnazione di valori di verità alle variabili di una proposizione X otteniamo quindi un valore di verità per X secondo le regole stabilite in precedenza. Una proposizione X è una ‛tautologia' se assume il valore V (vero) per tutti i valori dati alle sue variabili. Per esempio ¬p⋀p, o più generalmente ¬X⋀X, dove X è una qualunque proposizione, sono tautologie.

Questa è la formulazione nel nostro sistema della legge del terzo escluso.

Una proposizione X si dice conseguenza (‛semantica') di un insieme di proposizioni S se X ha il valore V per tutte quelle assegnazioni per le quali tutti gli elementi di S assumono il valore V stesso. Ad esempio, quali che siano le proposizioni X e Y, Y è una conseguenza dell'insieme S formato da X e X⊃Y. Evidentemente possiamo decidere attraverso una valutazione diretta se una proposizione X è una tautologia e, almeno quando S è finito, se X è una conseguenza di S. Per ottenere lo stesso scopo esistono altre strade, che dipendono solo dalla forma della proposizione X assegnata (e degli elementi di S) oppure dalla forma delle proposizioni ottenute da X e dagli elementi di S per mezzo di certe trasformazioni standard.

Prendiamo ora in considerazione il compito di elencare tutte le tautologie di un linguaggio dato. È questo un compito differente da quello di decidere se una proposizione comunque data sia o no una tautologia. Si verifica facilmente che fornendo una risposta a quest'ultima domanda avremo anche risposto a quella iniziale. Per questo scopo, dobbiamo semplicemente disporre tutte le proposizioni del linguaggio in una successione X0, X1, X2, ..., ed esaminare una proposizione dopo l'altra per vedere se essa sia o no una tautologia. Eliminando tutte le proposizioni che non lo sono, resta soltanto l'elenco richiesto di tutte le tautologie.

Per quanto il nostro problema sia così risolto, ne descriveremo ora un'impostazione completamente differente. Si tratta del ‛metodo assiomatico'. A prima vista esso appare del tutto equivalente ai procedimenti assiomatici discussi in precedenza per varie discipline matematiche, ma, come vedremo in seguito, esso può essere ampliato fino a includere tali procedimenti.

Il metodo che seguiremo consisterà nello scegliere alcune proposizioni del nostro linguaggio privilegiando una classe iniziale di proposizioni o ‛assiomi' e, successivamente, stabilendo una regola ben precisa (o, in altri casi, più regole) mediante la quale nuove proposizioni possano essere ‛dedotte', vale a dire possano essere aggiunte all'elenco di quelle già specificate, cioè agli assiomi. In generale, le proposizioni ottenute in questo modo si chiamano ‛teoremi' del sistema assiomatico (o deduttivo) in considerazione. Nel nostro caso ci proponiamo di costruire il sistema in modo tale che i suoi teoremi siano appunto le tautologie.

Gli assiomi del nostro sistema deduttivo saranno tutti costituiti da proposizioni di una delle quattro forme seguenti: 1. (X⋀X)⊃X; 2. X⊃(X⋀Y); 3. (X⋀Y)⊃(Y⋀X); 4. (X⊃Y)⊃((Z⋀X)⊃(Z⋀Y) - dove X, Y e Z sono proposizioni arbitrarie. Le proposizioni 1-4 si dicono ‛schemi d'assiomi', dal momento che ciascuna di esse non costituisce un singolo assioma, ma piuttosto uno schema che dà luogo a un'intera classe di assiomi.

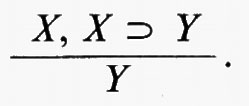

La regola di deduzione del nostro sistema è la seguente: da due proposizioni qualsiasi, X, X⊃Y, si deduce Y. È questa la cosiddetta ‛regola del modus ponens', indicata schematicamente dalla

Intendiamo per ‛dimostrazione' una successione finita di proposizioni, Z0, Z1, ..., Zn, n≥0, tale che ogni proposizione Zj nella successione è un assioma, oppure esistono nella successione altre due proposizioni, Zk e Zl (k>j, l>j), tali che la proposizione Zl coincide con la proposizione Zk⊃Zj (cioè tali che Zj può essere ottenuta da Zk e Zl per mezzo del modus ponens).

Infine consideriamo come teorema ogni proposizione che compaia come proposizione finale in una dimostrazione. Cosi, in particolare, ogni assioma è un teorema, prendendo come dimostrazione la successione ridotta all'unico elemento costituito dall'assioma stesso.

Abbiamo, in tal modo, ottenuto la formalizzazione completa della nozione di deduzione nel nostro sistema. Sorge ora il problema di vedere se tale sistema sia adeguato, nel senso che i suoi teoremi siano proprio le tautologie: la risposta è affermativa.

Invece di elencare tutte le tautologie, che sono le proposizioni vere per tutti i valori delle variabili, potremmo voler elencare solo quelle proposizioni che sono vere per i valori delle variabili che rendono vere tutte le proposizioni appartenenti a un dato insieme S. Per questo scopo dobbiamo solo modificare il procedimento di cui sopra aggiungendo agli assiomi le proposizioni di S.

È evidente che il linguaggio formale finora considerato è troppo povero per fornire uno strumento adatto a formulare una teoria matematica anche relativamente semplice come l'algebra elementare. Considereremo, pertanto, un linguaggio destinato a descrivere qualsiasi struttura matematica assegnata mediante un insieme di singoli elementi e un certo numero di relazioni specifiche tra tali elementi. È questo il linguaggio del ‛calcolo predicativo del prim'ordine'. I simboli atomici del linguaggio comprendono: a) una scorta adeguata di costanti individuali per denotare oggetti, a, b, c, ...; b) ‛variabili', x, y, z, ..., usate come contrassegni privi di riferimento individuale; c) un insieme di ‛simboli di relazione' a uno, due, tre, ... posti, R( ), S(,), ecc., per denotare relazioni a un numero corrispondente di variabili (dove una relazione a una variabile è semplicemente un insieme); d) i ‛connettivi' ¬ e ⋀, che, come abbiamo visto, sono sufficienti; e) due ‛quantificatori': (∃), che vuol dire ‛esiste', e (∀), ‛per ogni'; f) parentesi, [e]. Partendo da questi simboli atomici, costruiamo ora, un passo dopo l'altro, in modo naturale, ‛formule ben formate' (in breve, formule). Iniziamo con ‛formule atomiche', che sono simboli di relazione i cui posti sono stati occupati da costanti individuali o da variabili. Impieghiamo i connettivi per ottenere nuove formule da formule date, come nel linguaggio proposizionale, in modo che, se X e Y sono formule, anche (¬X) e (X⋀Y) devono essere formule. Inoltre, se Q(x) è una formula, nella quale abbiamo messo in evidenza una variabile x in essa contenuta, anche [(∃x)Q(x)] e [(∀x)Q(x)] sono formule, purché (∃x) o (∀x) non siano già contenute in Q. Di nuovo permangono le convenzioni per omettere le parentesi e ⋀ e ⊃ sono ammessi come abbreviazioni.

Dobbiamo ora considerare la connessione tra le formule di un linguaggio e le effettive strutture matematiche del tipo cui si è accennato. Una tale struttura, M, doveva consistere di un insieme di individui, A, e di un insieme di relazioni ρj, j=0, 1, 2, ..., definite su A. Quindi, se ρj è una relazione a k posti, essa dev'essere identificata con l'insieme delle k-uple di elementi di A che soddisfano la relazione.

Cominciamo a scegliere nel nostro linguaggio dei ‛nomi' per le relazioni di M, cioè dei simboli di relazione Rn che denotano le relazioni ρn e tali che il numero di posti in Rn sia proprio il numero di posti nella relazione corrispondente. Analogamente, supponiamo che ciascun oggetto a in A abbia un nome a, che è una costante individuale nel linguaggio. Sia K l'insieme di tutte le formule i cui simboli di relazione e le cui costanti individuali denotino tutti entità di M, cioè siano nomi di entità di M. Daremo ora un certo numero di regole che determinano univocamente, per un qualsiasi elemento X di K, se X è soddisfatto da M o, il che è lo stesso, ‛è vero in M' o ‛vale in M'. Indicheremo questa relazione con M⊨X.

1. Supponiamo che X abbia la forma R(a1, ..., an), dove R è un simbolo di relazione e le a1, ..., an sono costanti individuali. Supponiamo che le a1, ..., an denotino le α1, ..., αn in A, rispettivamente, ed R denoti la relazione ρ. Allora M⊨R(a1, ..., an) se, e solo se, (α1, ..., αn) è nella relazione ρ (ricordando che ρ è un insieme di n-uple).

2. Supponiamo di aver già determinato per due elementi X e Y in K se essi sono o non sono soddisfatti da M. Allora ¬X è soddisfatto da M se, e solo se, X non è soddisfatto da M; X⋀Y è soddisfatto da M se, e solo se, almeno X o Y è soddisfatto da M.

3. Sia Q(x) una formula ben formata in cui compare una unica variabile x libera (non quantificata) che non compaia altrove nella formula sotto il segno di un quantificatore. Supponiamo di aver già determinato, per qualsiasi a che denoti un oggetto di M, se Q(a) è o non è soddisfatta da M. Allora M⊨(∃x)Q(x) se, e solo se, Q(a) vale in M per almeno una a siffatta e M⊨(∀x)Q(x) se, e solo se, Q(a) vale in M per ciascuna di queste a.

Le regole di cui sopra determinano univocamente se, per ogni formula ben formata X in K, M⊨K, purché X non comprenda alcuna variabile libera. Se X comprende le variabili libere x1, ..., xn, ed è quindi della forma Q(x1, ..., xn), si dice che Msoddisfa X se M⊨Q(a1, ..., an) per tutte le a1, ..., an che denotano elementi di M.

Se una formula X è valida in tutte le strutture M in cui essa è ‛definita', cioè tali che le costanti individuali e i simboli di relazione di X denotino entità di M, allora chiamiamo X una tautologia (sebbene alcuni riservino questo termine per il linguaggio proposizionale). Se S è un insieme di formule che sono definite e valide in una struttura M, scriviamo allora che M⊨S e diciamo che M è un ‛modello' di S. È sottinteso che, come si può prevedere, un simbolo che compare in più di una proposizione ha lo stesso significato (denotazione) in ciascuna di esse. Se X è un'espressione valida in tutti i modelli di un insieme di proposizioni S nel quale è definita, allora si dice che X è una conseguenza (semantica) di S.

Come abbiamo già fatto nel caso del linguaggio proposizionale, possiamo anche qui chiederci in che modo si possa decidere se una formula sia o no una tautologia, oppure in che modo si possano elencare tutte le tautologie, oppure in che modo sia possibile decidere, dato un insieme S di formule, se una data X sia o no una conseguenza di S, oppure, infine, come catalogare tutte le conseguenze di S. A prima vista si potrebbe pensare di poter rispondere alla prima di queste domande in modo simile a quello seguito nel caso proposizionale, e cioè calcolando semplicemente i valori di verità di una proposizione X per tutte le assegnazioni di valori di verità date alle sue variabili. Così potremmo risolvere qui lo stesso problema sfruttando la definizione iterativa della nozione di soddisfacibilità in una struttura. A questo punto, tuttavia, ci troviamo di fronte a una differenza fondamentale. Il numero di possibili assegnazioni di valori di verità alle variabili di una proposizione nel linguaggio proposizionale è finito, e per ciascuna di tali assegnazioni possiamo calcolare effettivamente il corrispondente valore di verità della proposizione. Invece il numero delle diverse strutture che dobbiamo prendere in considerazione è infinito, e persino nel caso di una sola particolare struttura M la decisione se (∀x)Q(x) o (∃x)Q(x) siano o non siano valide in M dipende dal numero (eventualmente) infinito di casi Q(a). Pertanto questa volta la nostra definizione non è effettiva. Naturalmente ciò non significa di per sé che non vi possa essere qualche altro metodo per decidere sistematicamente se, per qualsiasi Xdato, X sia o non sia una tautologia. Tuttavia, come ha mostrato A. Church con un risultato strettamente collegato all'indecidibilità dell'aritmetica, cui si è già accennato in precedenza, anche con un'interpretazione molto spregiudicata della nozione di ‛effettività' tale metodo non esiste. Ciò significa naturalmente che, in generale, anche la risposta alla terza delle domande di cui sopra è negativa, persino quando S è finito.

Diviene quindi ancora più importante trovare un procedimento che consenta almeno di elencare tutte le tautologie. E proprio questo lo scopo del ‛calcolo deduttivo', che ora diviene indispensabile, in una forma o nell'altra. In particolare, possiamo seguire lo schema stabilito per il linguaggio proposizionale. Adottiamo, dunque, gli schemi d'assiomi 1-4, descritti prima, ai quali aggiungiamo i seguenti: 5. Q(t)⊃[(∃x)Q(x)] e 6. [(≅x)Q(x)]⊃Q(t), dove t è o una costante o una variabile e x è una variabile qualsiasi, come in precedenza. Inoltre come regola di deduzione prendiamo, insieme alla regola del modus ponens, la seguente: se la formula Z non contiene la variabile libera (non quantificata) x, allora: a) da Q(x)⊃Z si deduce [(∃x)Q(x)]⊃Z e b) da Z⊃Q(x) si deduce Z⊃[(∀x)Q(x)]. Modificando la nozione di ‛dimostrazione' in modo da tener conto anche di queste due regole, definiamo di nuovo la nozione di ‛teorema'. Si può allora dimostrare che ‛una formula X è una tautologia se, e solo se, essa è un teorema'. Questo importante risultato è dovuto a K. Gödel (1930) e mostra che è possibile elencare tutte le tautologie mediante l'applicazione sistematica degli schemi d'assiomi e delle regole di deduzione. Lo stesso concetto si può esprimere dicendo, con una terminologia che a quel tempo ancora non esisteva, che è possibile ideare un programma in base al quale un calcolatore sarebbe in grado di stampare, una per una, l'elenco completo di tutte le tautologie. Analogamente, se S è un insieme finito di formule, possiamo predisporre un programma che fornisca tutte le conseguenze di S, e questo è ancora vero se S è infinito, purché definito in modo sufficientemente concreto (‛effettivo').

Sia ora S un insieme infinito di formule. Il principio seguente, noto come ‛principio di compattezza' del calcolo predicativo del prim'ordine, non solo si dimostrò di grande importanza per le sue applicazioni e i suoi ulteriori sviluppi, ma portò anche a un profondo chiarimento delle nozioni di ‛coerenza' e di ‛conseguenza' per questo linguaggio: ‛se ogni sottoinsieme finito di S possiede un modello, anche S possiede un modello; equivalentemente, se una formula X è una conseguenza di S, essa è già una conseguenza di un sottoinsieme finito di S'.

Non abbiamo finora assegnato un posto particolare al simbolo di uguaglianza =. Di fatto è possibile trattarlo alla stessa stregua di un qualsiasi altro simbolo di relazione a due posti che, in una data struttura, denoti una relazione riflessiva, simmetrica e transitiva e che permetta la sostituzione di ogni termine con un termine eguale. Ciò significa che a=a; se a=b, allora b=a; se a=b e b=c, allora a=c; infine, se (a1, ..., an)∈R per una data relazione nella struttura e a1=b1, a2=b2, ..., an=bn, allora (b1, ..., bn) e R. Con un'altra formulazione, possiamo interpretare a=b come asserzione del fatto che a e b denotano lo stesso oggetto. In tal modo il simbolo = denota l'identità, cioè una nozione che merita certamente di essere collocata in un sistema logico. Comunque, all'atto pratico, la differenza tra le due impostazioni non è poi così grande.

È anche possibile arricchire il linguaggio con l'introduzione di simboli di funzioni per denotare appunto funzioni. Come abbiamo illustrato in precedenza, ciò si può sempre evitare sostituendo una funzione di n variabili con una relazione tra n+1 variabili (per es. considerando la funzione di due variabili, x+y, come una relazione tra tre variabili x, y e z che soddisfino la x+y=z). L'introduzione di simboli funzionali è utile a molti fini e tutte le definizioni e i risultati esposti precedentemente possono essere opportunamente adattati per poter includere tali simboli nel linguaggio stesso.

Fino al 1930 la nozione di soddisfacibilità non veniva normalmente discussa, ma veniva piuttosto data intuitiva- mente per scontata. Non si trattava certo di una svista. Si riteneva che il vero oggetto della logica fosse la deduzione, la quale è meramente sintattica, nel senso che non va oltre le entità del linguaggio. La nozione di soddisfacibilità, invece, richiede non solo l'introduzione esplicita di strutture, cioè di entità estranee al linguaggio, ma, come abbiamo visto, essa introduce nella discussione anche un elemento infinitario. D'altra parte, finché non disponiamo della nozione di soddisfacibilità in una struttura, non possiamo formulare lo scopo di un calcolo deduttivo. E merito di A. Tarski l'aver chiarito questo fatto (1933).