Meteorologia

Meteorologia

di Giorgio Fea e Maurizio Fea

Meteorologia

sommario: 1. Introduzione. 2. Nubi e idrometeore. a) Il vapor d'acqua nell'atmosfera. b) I nuclei di condensazione. c) L'accrescimento delle gocce. d) I nuclei glaciogeni. e) L'accrescimento dei cristalli di ghiaccio. f) Le idrometeore. g) Il dissolvimento delle nubi. 3. Meteorologia operativa. a) I rilevamenti tradizionali. b) Il telerilevamento nelle funzioni operative. c) Strumentazioni sperimentali di interesse applicativo. 4. La meteorologia come scienza ambientale. a) L'atmosfera superiore e l'ozono. b) Lo strato di confine planetario. c) L'inquinamento atmosferico. d) Il clima. e) Aspetti idrologici e agrometeorologici. f) L'intervento sulle nubi e il controllo delle precipitazioni. g) Metodi di analisi e di previsione del tempo. □ Bibliografia.

1. Introduzione

Grazie alla perseveranza degli studiosi, alla collaborazione internazionale sempre più intensa e ai mezzi d'indagine assai perfezionati che il progresso tecnologico rende disponibili, la diffidenza con la quale la meteorologia viene da molti considerata sta lasciando il posto alla presa di coscienza del reale valore che questa scienza riveste per il benessere attuale e soprattutto futuro della popolazione mondiale. Numerose indagini statistiche e approfondite valutazioni nazionali e internazionali hanno ormai mostrato in modo chiaro che il rapporto tra i benefici pratici (già raggiunti o raggiungibili in breve) e i costi derivanti dallo sviluppo della meteorologia è senz'altro a favore dei primi, quanto più l'assistenza meteorologica si specializza a seconda dei diversi settori di attività dell'uomo. Quest'ultimo aspetto rispecchia il moderno orientamento di ‛analizzare' le ricerche verso i campi di applicazione pratica, onde averne un ritorno economico e sociale il più rapido ed elevato possibile, a causa soprattutto dell'urgenza e dell'indifferibilità di molti problemi, quali la difesa dell'ambiente e la fame nel mondo, per citarne due fra gli essenziali. Questi studi si svolgono parallelamente alle iniziative di cooperazione scientifica internazionale; tra le più importanti va ricordato il progetto GARP (Global Atmospheric Research Programme): questo ambizioso programma vede impegnate le forze di moltissimi paesi nell'intento di comprendere le basi fisiche del clima e di migliorare i metodi di previsione a medio termine, e viene realizzato sotto l'egida dell'OMM (Organizzazione Meteorologica Mondiale) e dell'ICSU (International Council of Scientific Unions).

È in questa visione della scienza al servizio dell'utente che verranno trattati qui alcuni tra i problemi che la meteorologia è chiamata a risolvere, per collaborare, tra l'altro, allo sforzo comune volto a preservare l'integrità della biosfera.

Invece, per gli aspetti scientifici dei problemi relativi ai sistemi di circolazione dell'atmosfera, alla sua fenomenologia e ai suoi bilanci termoradiativo, idrico ed energetico in generale, si rimanda all'articolo atmosfera che peraltro verrà ancora, ove opportuno, richiamato.

Le ragioni per le quali la meteorologia ha ricevuto il crisma ufficiale di scienza solo in questo secolo, nonostante che le vicissitudini del tempo abbiano da sempre interessato direttamente lo svolgersi della vita umana, sono da ricercarsi nell'estrema complessità della fenomenologia degli eventi atmosferici e dei suoi legami fisici con molte altre scienze. Infatti, per lo stretto legame della meteorologia con le scienze fisiche, chimiche e matematiche e con la tecnologia, il risveglio euristico si ebbe soltanto nel XVII secolo; ma il continuo progresso nel colmare il divario tra la pratica e la teoria è stato determinato, come per le altre scienze, dall'invenzione di strumenti e dal progresso tecnologico, dalla formulazione delle leggi fisiche fondamentali e, condizione indispensabile, dallo sviluppo di metodi matematici adeguati a descrivere queste ultime. Si è dovuto, cioè, attendere che la fisica e soprattutto la termodinamica fossero in grado di spiegare in modo accettabile le molteplici esperienze e osservazioni collezionate nelle prime raccolte climatologiche; soltanto verso la fine del XIX secolo insigni matematici e fisici posero le basi della meteorologia come scienza fisica. Alcuni nomi sono particolarmente significativi per i meteorologi: M. Margules, conosciuto soprattutto per la formula che esprime le condizioni di equilibrio dinamico di una superficie frontale; W. H. Dines, che enunciò il ‛principio di compensazione' in base al quale nella troposfera superiore deve esistere ‛divergenza' al di sopra dei cicloni in via di sviluppo, in corrispondenza dei quali nella troposfera inferiore si ha ‛convergenza' (da queste considerazioni nel 1947 R. C. Sutcliffe trasse una spiegazione quantitativa della genesi di un ciclone in termini di ‛vorticità' e di ‛venti termici'; v. atmosfera); V. Bjerknes che, nel 1897, partendo dalle ricerche di Helmoltz e di lord Kelvin, enunciò la forma generale del teorema della circolazione, sintesi dell'idrodinamica e della termodinamica applicabile ai moti su grande scala nell'atmosfera e negli oceani, e il figlio Jacob, che nel 1919 formulò la teoria secondo la quale i cicloni hanno origine dalle onde che si generano sulla superficie inclinata che separa masse d'aria diverse; T. Bergeron, al quale si debbono le basi della climatologia dinamica; C. O. Rossby, che introdusse i concetti di ‛vorticità' e di ‛onde planetarie' nella circolazione atmosferica delle medie latitudini e che nel 1939 dimostrò la possibilità di utilizzare le equazioni della dinamica apportandovi drastiche approssimazioni senza che esse perdessero di significato fisico (a lui si attribuisce anche l'identificazione delle correnti a getto e la formulazione di una teoria sulla loro esistenza); L. F. Richardson, che effettuò il primo tentativo di previsione numerica del tempo risolvendo le equazioni simulanti un modello di atmosfera e che nel 1922 pubblicò Weather prediction by numerical process, il trattato classico sui metodi numerici di previsione, nel quale mostrò come le equazioni differenziali governanti i moti atmosferici potessero essere approssimate con un sistema di equazioni alle differenze finite; N. Ekholm, che intorno al 1900 osservò per primo che le formazioni isallobanche (nuclei individuabili sulle carte meteorologiche come zone caratterizzate da un'uguale variazione di pressione in un determinato intervallo di tempo) presentano nei loro spostamenti una regolarità maggiore che non le stesse formazioni banche, e che quindi a esse si possono applicare con maggior successo procedimenti di estrapolazione di tipo cinematico piuttosto semplici (da qui si sviluppò per es. il ‛metodo delle variazioni', cui diedero notevole contributo gli italiani F. Vercelli e R. Bilancini, e che consiste nel considerare il campo banco reale come risultante della sovrapposizione di un campo stabile, le cui configurazioni sono chiamate centri d'azione, e di un campo di perturbazione); L. V. Keller e A. A. von Friedmann, che nel 1924 introdussero metodi statistici nello studio dei processi atmosferici, proponendo una teoria statistica della turbolenza che si è rivelata di basilare importanza.

Gli studi di questi e di altri numerosi scienziati non sarebbero progrediti nè avrebbero avuto la possibilità di una verifica sperimentale se, contemporaneamente, non si fossero sviluppate le telecomunicazioni internazionali, le reti di stazioni a terra e le osservazioni in quota con palloni e aeromobili. È però dopo la seconda guerra mondiale che la tecnologia ha fornito alla scienza meteorologica nuovi e potentissimi strumenti d'indagine: i radar e i satelliti artificiali quali mezzi di osservazione a distanza, e gli elaboratori elettronici come mezzi di calcolo rapido. Con questi ultimi si ebbe finalmente la possibilità di sperimentare l'applicazione delle equazioni teoriche della dinamica e della termodinamica ai dati rilevati a terra e in quota in numerose stazioni distribuite su vaste aree; nel 1948 J. G. Charney mostrò che le equazioni del moto potevano essere semplificate introducendo sistematicamente le approssimazioni idrostatica (cioè validità, anche in caso di moto, dell'equazione verticale della statica) e geostrofica (cioè considerando il vento quale si avrebbe in assenza di accelerazioni e di attrito); in tal modo è possibile filtrare le oscillazioni atmosferiche di natura sonora e gravitazionale, cioè le onde veloci che, seppure di piccola ampiezza all'origine, possono essere amplificate dal modello di calcolo in modo tale da divenire vere e proprie perturbazioni fittizie non meteorologiche. Nacque il modello ‛quasi geostrofico', il cui caso particolare chiamato ‛equivalente barotropico' servì al gruppo di J. von Neumann e di Charney per eseguire nel 1950 la prima vera previsione con metodi numerici, con la quale si ottennero dall'elaboratore elettronico i venti previsti alla quota isobarica di 500 mbar (circa 5.500 metri).

È difficile esaminare sinteticamente gli enormi progressi compiuti negli ultimi decenni, anche per il numero sempre crescente di studiosi che si sono dedicati alla fisica dell'atmosfera; vale la pena di focalizzare l'attenzione su alcuni campi fondamentali d'indagine meteorologica dai quali emergono problemi di largo interesse applicativo, piuttosto che soffermarsi su settori di speculazione squisitamente teorica, nonostante questi ultimi possano essere forieri di enormi benefici per le ricerche finalizzate.

Per evidenziare la complessità dei fenomeni che la meteorologia deve spiegare e le difficoltà che essa va incontrando nel trasformarsi in scienza esatta, R. C. Sutcliffe ha scritto: ‟La previsione del tempo richiede la soluzione di un problema di meccanica dei fluidi, con un fluido che è compressibile e in moto turbolento sulla superficie di una sfera ‛gravitante'. La superficie della sfera non è uniforme, in parte è costituita da acqua, in parte da terreno rugoso, e c'è attrito tra aria e superficie. Il moto è termodinamicamente attivo con scambio di energia attraverso i due contorni, inferiore la terra e superiore lo spazio, mentre trasformazioni di energia interna sono continue e di vario genere. Il fluido non è di composizione costante ma acquista continuamente vapor d'acqua per evaporazione e ne perde per precipitazione, e questo processo è, per inciso, una sorgente dominante di energia per il sistema" (v. Sutcliffe, 1966, p. 121). Infatti, lo stato dell'atmosfera e il suo evolversi nel tempo sono conseguenze del combinarsi di un'infinità di processi su tutte le scale sia spaziali che temporali; è proprio dalla coesistenza e dall'interazione di processi su scale assai diverse, cioè da quella molecolare, tipica per esempio dei processi diffusivi, a quella planetaria, caratteristica della grande circolazione emisferica, che scaturiscono le difficoltà d'indagine ‛sul campo' e di simulazione in laboratorio. Perciò, è giocoforza ricorrere a schematizzazioni più o meno rudimentali che diano, a seconda del fenomeno in studio o della scala d'indagine, la possibilità di capire lo svolgersi dei processi dominanti su quella scala, anche se può rimanere sempre l'incertezza dell'influenza su questi processi di fattori propri di una o più scale, più grandi e più piccole. Per comprendere come nella meteorologia siano coinvolti fenomeni dalle dimensioni spazio-temporali assolutamente diverse, basta pensare da un lato ai processi microfisici che danno luogo alla formazione delle goccioline di una nube (dimensioni caratteristiche dell'ordine dei millesimi di millimetro), dall'altro alla fenomenologia di un ciclone tropicale (dimensioni orizzontali dell'ordine dei 500 km).

2. Nubi e idrometeore

a) Il vapor d'acqua nell'atmosfera

Fase aeriforme del composto chimico acqua, il vapor acqueo costituisce in media una piccola percentuale sia del totale di acqua presente sulla Terra nelle varie fasi che di tutta l'atmosfera, ed è concentrato in massima parte nella troposfera inferiore, dove può raggiungere e oltrepassare anche il 5% in volume, come sulla zona delle foreste tropicali.

Malgrado la sua piccola percentuale, il vapor d'acqua è, tra i costituenti gassosi dell'aria presenti in percentuale variabile, senza dubbio il più importante nel determinare i fenomeni del tempo meteorologico; ciò non soltanto dal punto di vista delle idrometeore, giacché le sue fasi condensate (acqua liquida e ghiaccio) sono costituenti essenziali delle nubi e delle precipitazioni, ma anche sotto l'aspetto energetico; infatti, a causa dell'elevato calore latente di trasformazione, mediante l'evaporazione (che avviene lentamente e in modo quasi inavvertibile su superfici vastissime) il vapor acqueo consente all'aria di accumulare ingenti quantità di energia che può essere trasportata anche assai lontano dal luogo di provenienza ed esser poi liberata in modo concentrato negli spazi limitati nei quali si manifestano i fenomeni di condensazione, cioè le nubi e le precipitazioni associate alle perturbazioni. Dato l'andamento esponenziale della pressione di vapore saturo in funzione della temperatura, l'energia sviluppata nelle idrometeore può esser tanto maggiore (e così la violenza di queste) quanto più alta è la temperatura dell'aria alla quale esse si manifestano: si pensi al confronto fra gli uragani, caratteristici delle zone calde tropicali, e i fenomeni alle alte latitudini.

Il vapor d'acqua si comporta praticamente come un gas perfetto fino ai limiti della saturazione, con una costante caratteristica Rv=461,5 J/kg °K (mentre quella dell'aria secca è RA=287 J/kg °K); in presenza di una sua fase condensata e in condizioni di equilibrio termodinamico, il vapore tende ad assumere, anche nel miscuglio chiamato aria, una pressione parziale massima detta pressione di saturazione, che dipende, come già si è osservato, soltanto dalla temperatura; sotto lo 0 °C questa pressione, a parità di temperatura, dipende dal tipo di fase condensata presente ed è minore rispetto al ghiaccio che non rispetto all'acqua (che, se liquida sotto lo 0 °C, si trova in quello stato instabile detto ‛sopraffuso'). La relazione generale è del tipo ben approssimabile con la formula empirica di Magnus:

E(t)=E0•10at/(b+t),

ove E(t) ed E0=6,11 mbar rappresentano rispettivamente le pressioni di vapore saturo alla temperatura t e a quella di 0 °C, e a e b sono due costanti che sono leggermente diverse se calcolate per il vapore saturo rispetto all'acqua (eventualmente sopraffusa) in superficie piana, o rispetto al ghiaccio in superficie piana.

Tuttavia nell'intorno dello 0 si può scrivere approssimativamente:

Ew(t)≃E0 eKwt ed Ei(t)≃E0 eKit,

dove Ew(t) e Ei(t) sono rispettivamente le pressioni di vapore saturo rispetto all'acqua e rispetto al ghiaccio e:

sono due ‛quasi' costanti, nelle quali Le ed Ls sono i calori latenti di evaporazione (Le≃600 kcal/kg) e di sublimazione (Ls≃680 kcal/kg). La differenza delle due pressioni di vapore saturo ΔE=Ew−Ei è approssimativamente ΔE≃E0 (eKwt−eKit): calcolata rispetto a una superficie limite piana, essa raggiunge alla temperatura di −11,8 °C il suo valore massimo, pari a 0,27 mbar, valore che, pur essendo molto piccolo, giuoca un ruolo determinante nell'accrescimento dei cristalli di ghiaccio a spese delle goccioline sopraffuse e quindi nella produzione delle precipitazioni.

È molto importante, inoltre, tener conto del fatto che nell'atmosfera le superfici di elementi condensati rispetto alle quali occorre valutare la pressione di saturazione sono in realtà generalmente convesse, e molto spesso con dimensioni lineari molto piccole (goccioline, cristalli di ghiaccio, particelle igroscopiche); cosicché i valori che la pressione di vapore deve raggiungere per arrivare a quelli di saturazione sono più elevati di quelli calcolabili rispetto a superfici piane; e tanto più ciò è vero quanto più piccole sono le dimensioni.

Se i processi spontanei di cambiamento di stato del vapor d'acqua avvenissero in un atmosfera pura e su superfici libere delle fasi condensate anch'esse pure, potrebbero aversi in natura soprassaturazioni che, come in laboratorio, dovrebbero far avvicinare l'umidità relativa al 1.000%; in realtà i valori più alti misurati nella troposfera generalmente superano di assai poco il 100% (scendendo invece spesso al di sotto dell'80%), mentre d'altra parte nell'atmosfera i fenomeni di passaggio di stato del vapor acqueo sono frequentissimi. Questo fatto dipende da molti fattori, quali il grado di purezza dell'aria, lo stato, la forma e le dimensioni delle superfici degli elementi condensati presenti (che con l'aria formano sospensioni chiamate ‛aerosol'), fenomeni di origine elettrica e, soprattutto, l'azione di particolari particelle igroscopiche che hanno la capacità di abbassare notevolmente i valori della pressione di saturazione del vapore: si tratta dei nuclei di condensazione e dei nuclei glaciogeni.

b) I nuclei di condensazione

M. Coulier nel 1875 e J. Aitken nel 1880 dimostrarono per primi l'importanza di particelle fungenti da nuclei nei processi di condensazione; oggi questi nuclei vengono generalmente classificati, in base alle loro dimensioni (v. Battan, 1964), come: 1) nuclei di Aitken (di raggio r〈0,4 μm), molto numerosi, in media alcune migliaia per cm3, specie sugli insediamenti urbani, ma dei quali solo i più grossi sembrano utili ai fini della condensazione; 2) grandi nuclei (0,4〈r〈1,0 μm), generalmente composti di solfati provenienti da combustioni, in concentrazioni medie di poche centinaia per cm3; 3) nuclei giganti (1〈r〈???52???10 μm), nella stragrande maggioranza particelle di salmarino, in concentrazioni che di rado giungono all'unità per cm3, ma che sono tra i più efficaci nell'innescare i processi di condensazione.

L'azione e l'efficacia di molti tipi di nuclei di condensazione non sono sempre chiaramente determinabili; spesso dipendono dal grado di affinità con l'acqua delle sostanze che li compongono: è un fatto che le loro proprietà igroscopiche sono in grado di permettere la condensazione del vapor d'acqua su di essi a umidità relativa dell'ambiente molto spesso assai inferiore al 100%. È opportuno sottolineare poi che, nelle condizioni normali dell'atmosfera, l'effetto dovuto a eventuali cariche elettriche possedute dai nuclei può favorire i fenomeni di condensazione, seppure in modo non determinante.

c) L'accrescimento delle gocce

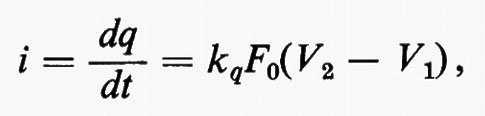

In condizioni di equilibrio, per una gocciolina d'acqua appena formata assumono particolare importanza tre fattori: la tensione superficiale della goccia, la concentrazione della sostanza disciolta in essa (che originariamente costituiva il nucleo di condensazione) e la carica elettrica da essa portata. L'effetto della tensione superficiale è infatti quello di tendere a far aumentare la pressione di equilibrio del vapore, mentre le sostanze disciolte e le cariche elettriche tendono a farla diminuire (in modo più efficace le prime, assai meno le seconde): normalmente l'equilibrio tra l'effetto dovuto alla tensione superficiale e quello dovuto alla concentrazione della soluzione si ha per raggi delle gocce dell'ordine del micron, mentre l'equilibrio fra effetto dovuto alla tensione superficiale e quello dovuto alle cariche elettriche superficiali si manifesta per raggi assai più piccoli, dell'ordine dei decimillesimi di micron. Questi fenomeni determinano perciò l'esistenza di un certo valore critico del raggio delle goccioline, che per ogni tipo di nucleo risulta funzione delle dimensioni del nucleo stesso sul quale si è formata la goccia ed è relativo a uno stato di equilibrio instabile; se nell'ambiente vi è vapore disponibile, i raggi delle goccioline tendono a superare il valore critico e a crescere sempre di più, oppure, se l'ambiente è relativamente secco o lo diventa, le dimensioni delle goccioline scendono al di sotto di tale valore ed esse tendono a evaporare. In ambedue i casi, a causa del gradiente di pressione di vapore stabilitosi tra gocciolina e ambiente si ha un trasporto di vapore per diffusione attraverso l'aria; se avviene la condensazione, si libera il relativo calore latente, del quale si deve tener conto nel calcolo del flusso di calore per conduzione termica diffusiva tra gocciolina e ambiente. L'insieme di questi fenomeni si può trattare in modo analogo a quanto si fa nello studio del trasporto di cariche in mezzi conduttori per la presenza di campi elettrici; come è ben noto, sotto particolari condizioni quasi stazionarie si può infatti scrivere che l'intensità di corrente i che fluisce nell'unità di tempo da un elettrodo 1 a un elettrodo 2, rispettivamente a potenziale V1 e V2, in un mezzo a conducibilità elettrica specifica kq è data approssimativamente da:

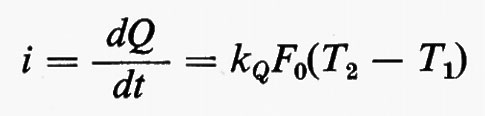

dove F0=C0/ε0 (che ha le dimensioni di una lunghezza) si può considerare un ‛fattore di forma', dipendente cioè dalla geometria del sistema, pari al rapporto tra la capacità elettrica del sistema nel vuoto e la costante dielettrica del vuoto. In analogia, nel caso della propagazione del calore, l'intensità del flusso termico si può scrivere:

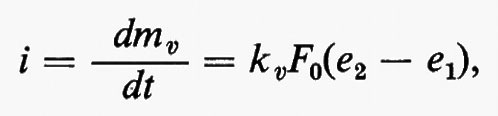

e, per la diffusione del vapore, l'intensità del flusso di vapore:

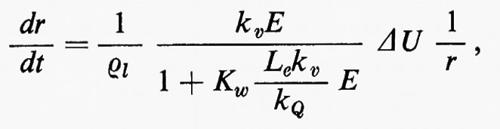

dove T1 e T2, e1 ed e2 sono rispettivamente le temperature e le pressioni di vapore in corrispondenza della gocciolina e dell'ambiente lontano da questa, e kQ e kv sono la conducibilità termica specifica e la conducibilità specifica del vapore per diffusione. Si ottiene allora che la velocità di accrescimento o di evaporazione di una goccia per diffusione è data da:

dove r è il raggio della gocciolina, ΔU è la differenza tra l'umidità relativa dell'ambiente e quella di saturazione della gocciolina, ρl è la densità della gocciolina e Kw il coefficiente già visto che controlla l'andamento della pressione di vapor saturo E rispetto all'acqua in funzione della temperatura. Ne consegue che le velocità di accrescimento di gocce molto piccole risultano, con il solo processo diffusi- vo, già molto elevate per un eccesso relativo di umidità di qualche unità per mille, quale si verifica spesso, appunto, nella realtà; da sottolineare che la soprassaturazione è intesa come quella che presenta il vapore in equilibrio con la goccia rispetto al vapore in equilibrio con acqua pura in superficie piana.

Questo processo è quello di primo accrescimento rapido delle goccioline nelle prime fasi di sviluppo delle nubi, con tempi di accrescimento che però, pur inversamente proporzionali ai valori di soprassaturazione, crescono assai rapidamente al crescere dei raggi delle gocce (proporzionalmente al quadrato dei raggi stessi): l'accrescimento determina anche il rapido diluirsi della soluzione nella goccia, sì che questa viene rapidamente a esser costituita da acqua praticamente pura, il che contribuisce all'aumento dei tempi.

Alla fase di accrescimento per diffusione subentra presto, per poi prevalere, l'importantissimo fenomeno della crescita per coalescenza, cioè per cattura di alcune gocce da parte di altre più grosse (c'è già infatti una varietà iniziale di dimensioni dovuta soprattutto alle diverse dimensioni dei nuclei attorno ai quali le goccioline si sono formate), che si ingrandiscono a spese delle prime; il fenomeno è possibile per le diverse velocità da cui sono reciprocamente animate gocce di differenti dimensioni sia nel moto di caduta che, soprattutto, nel moto turbolento che accompagna le correnti verticali che dan luogo alle nubi: la cattura si manifesta con un'efficienza più elevata per le gocce grosse che per le piccole, e tanto maggiore quanto maggiori sono le dimensioni delle gocce ‛piccole' catturate dalle gocce più grandi.

Un altro processo di accrescimento iniziale, che può dar luogo poi a gocce grosse, sarà esaminato più avanti come conseguenza della formazione e della crescita dei cristalli di ghiaccio.

d) I nuclei glaciogeni

Svariate esperienze hanno mostrato che le goccioline d'acqua possono mantenersi sopraffuse, cioè liquide, anche a temperature notevolmente inferiori allo 0 °C, e ciò accade tanto più facilmente quanto minore è il loro raggio; limite inferiore sembra essere la temperatura intorno a −40 °C, alla quale anche le più piccole gocce sopraffuse congelano istantaneamente. A temperature inferiori allo O, particolari particelle, chiamate ‛germi di ghiacciamento', possono però essere in grado di rendere l'aria soprassatura rispetto al ghiaccio, cosicché, anche se l'ambiente non è saturo rispetto all'acqua, si deposita su queste particelle un sottilissimo velo d'acqua che solidifica subito, dando origine al cristallino di ghiaccio (processo di Bergeron). Per quanto le fonti principali dei germi di ghiacciamento siano a tutt'oggi incerte, sembra molto probabile che questi siano costituiti in gran parte da particelle di certi tipi di terreno (deserti e alcuni tipi di argille), da polvere cosmica di origine meteorica e vi sono prove che possano esserlo anche aggruppamenti molecolari organici; è comunque assodato che l'efficacia delle particelle come germi di ghiacciamento attivi aumenti con il diminuire della temperatura.

Germi di ghiacciamento efficaci sono anche i microcristallini di ghiaccio che si generano quando il vapor d'acqua passa direttamente allo stato solido, ciò che in natura avviene però di rado e in particolari condizioni (come nel caso delle scie di condensazione), oppure quando vapor acqueo saturo rispetto al ghiaccio e non saturo rispetto all'acqua viene a contatto con alcuni tipi di particelle molto piccole, chiamate ‛nuclei di sublimazione' (anche se sarebbe più corretto chiamarle ‛nuclei di deposizione' o di ‛brinamento'); questi processi in realtà non sono molto frequenti a causa della scarsezza di tali particelle nell'aria troposferica superiore, ove si raggiungono le basse temperature richieste per questo tipo di fenomeni.

A causa del valore del rapporto tra calore specifico dell'acqua liquida e calore latente di fusione, pari a 1/80, una goccia d'acqua sopraffusa nel venire a contatto con un germe di ghiacciamento ghiaccia con un processo temporale tale da avere ghiacciati pressoché istantaneamente tanti 80-esimi del suo volume quanti sono i gradi centigradi al di sotto dello 0; il rimanente della goccia ghiaccia in un tempo molto piccolo Δt dipendente dal raggio della goccia e dal numero di gradi ΔT sotto lo 0 °C.

Risulta che per gocce di piccole dimensioni, cioè con r〈10 μm e con temperature intorno ai −10 °C, i tempi Δt di ghiacciamento completo della goccia sono ancora inferiori al secondo; salgono rapidamente, invece, per le gocce di pioggia: una goccia con raggio di 1 mm a −10 °C impiega tempi dell'ordine della decina di minuti.

e) L'accrescimento dei cristalli di ghiaccio

In un ambiente costituito da goccioline d'acqua sopraffusa, il cristallino di ghiaccio appena formato agisce a sua volta da nucleo di ghiacciamento, crescendo a spese delle altre gocce ancora liquide: queste goccioline sopraffuse sono infatti costrette a evaporare per ristabilire l'equilibrio nell'aria impoverita di vapore, e poi sotto forma di vapore si depositano sul cristallo (processo generalmente chiamato di Bergeron-Findeisen). Qui, a temperature inferiori a 0 °C, tutto dipende dal diverso andamento della pressione di vapor saturo rispetto al ghiaccio e all'acqua; introducendo considerazioni sul flusso di vapore analoghe a quelle fatte per le gocce d'acqua, l'accrescimento del cristallo comporta tempi direttamente proporzionali al quadrato delle dimensioni e, ciò che è più importante, per la prima decina di gradi sotto lo 0, inversamente al numero dei gradi centigradi sotto lo 0 a cui si trova l'ambiente. La crescita dei cristalli di ghiaccio avviene perciò in funzione del valore sotto lo 0 °C a cui è la temperatura (poiché da questo dipende la soprassaturazione rispetto al ghiaccio del vapore saturo) contrariamente a quanto accade per le goccioline, che si accrescono soltanto per effetto di una piccola soprassaturazione raggiunta previamente; ne risulta che la velocità di accrescimento dei cristalli per temperature poco sotto lo 0 (caso assai frequente nella troposfera inferiore) è assai più elevata, a parità di dimensioni, della velocità di crescita delle goccioline per soprassaturazioni notevoli (pur sempre però entro i limiti effettivamente osservabili).

f) Le idrometeore

La forma primitiva del minuscolo cristallo è di aghetto o di lamina esagonale, forme nelle quali esso raggiunge il terreno in alta montagna dopo una breve caduta a bassa temperatura; in generale, i cristalli di ghiaccio crescono sia per impatto con goccioline sopraffuse che per aggregazione con altri cristalli, sviluppandosi in infinite combinazioni e variazioni della forma esagonale originaria, e dando luogo ai fiocchi di neve, con un processo tanto più efficace quanto più l'aria che attraversano nello scendere è umida e con temperatura prossima (anche se sempre inferiore) allo 0 °C. È ora possibile comprendere in modo abbastanza completo la formazione di gocce grosse, cioè della pioggia: in effetti questa proviene, nelle nubi ‛calde' (vale a dire nubi a temperature superiori allo 0 °C, che sono caratteristiche delle zone tropicali), da una progressiva crescita. delle gocce per coalescenza su grosse goccioline iniziali prodotte da nuclei giganti, come già visto; per le nubi ‛fredde' (predominanti alle medie e alte latitudini), a causa della grande velocità di accrescimento dei cristalli di ghiaccio, la pioggia deriva assai spesso dalla fusione dei fiocchi di neve che precipitano verso la superficie, se tra questa e la nube vi è uno strato di aria calda sufficientemente spesso. Mentre i processi fisici che danno luogo alla formazione delle nubi vengono ricordati nella tab. I, si vuole qui sottolineare il fatto che le foschie, le nebbie e le nubi sono costituite da goccioline d'acqua o da cristallini di ghiaccio, o da ambedue i tipi di particelle. Foschia e nebbia sono sospensioni di queste particelle negli strati d'aria prossimi al suolo e la differenza tra le due meteore è dovuta alla concentrazione dell'aerosol che determina una maggiore o minore visibilità: per convenzione internazionale si parla di nebbia quando la visibilità è inferiore a 1.000 m, altrimenti la sospensione è chiamata foschia; in ambedue i casi le particelle sono molto piccole, con dimensioni dell'ordine del centesimo di millimetro. Una nube si forma, invece, quando nell'atmosfera si producono moti ascendenti più o meno turbolenti che provocano la condensazione (sotto forma di miriadi di goccioline) di parte del vapor acqueo contenuto nell'aria coinvolta nell'ascesa; la nube evolve poi espandendosi alla sommità, ove una gran percentuale delle goccioline nuovamente evapora, mentre alla base è continuamente alimentata dall'aria umida ascendente in progressivo arrivo. Lo studio del numero e della grandezza delle gocce che costituiscono una nube è complesso sia a causa delle difficoltà d'indagine diretta, sia per l'impostazione e la soluzione di modelli teorici fisico-matematici; le indagini svolte hanno però permesso di stabilire (v. Battan, 1964; v. Mason, 1957; v. Sutcliffe, 1966) che la concentrazione in media oscilla intorno a qualche centinaio di goccioline per centimetro cubo d'aria, mentre si può, con buona approssimazione, definire il valore medio dei raggi delle gocce intorno al centesimo di millimetro; nelle grosse nubi cumuliformi, invece, la situazione è meno definita: le forti correnti ascensionali turbolente, che caratterizzano queste nubi a grande sviluppo verticale, provocano frequenti urti tra le gocce, molti dei quali favoriscono l'ulteriore accrescimento delle più grosse a scapito delle più piccole; si osservano così, specie nelle nubi temporalesche, valori intorno al decimo di millimetro.

In realtà quest'ultimo valore viene convenzionalmente considerato come il limite inferiore delle dimensioni di gocce di precipitazione, in particolare della pioviggine, costituita di gocce piccole e in caduta molto lenta, con velocità dell'ordine dei dm/s; la pioggia è considerata invece come precipitazione di gocce di diametro pari o superiore al millimetro, con velocità medie di caduta dell'ordine di alcuni m/s e con limite superiore di circa 8-9 m/s, al di sopra del quale le gocce si frantumano. La percentuale d'acqua che, rispetto a quella condensata nella nube, riesce a precipitare è in media soltanto di un 10%: ciò perché di tutte le goccioline cadono soltanto quelle poche che riescono a crescere fino ad acquistare un peso in grado di vincere la spinta verso l'alto dovuta alle correnti ascendenti; inoltre, anche perché gran parte di queste evaporano nell'ambiente sottostante (così come fondono molti dei cristalli di ghiaccio che precipitano fuori della nube) a causa del gradiente di pressione di vapore che si viene a stabilire verso l'ambiente man mano che nella discesa le gocce incontrano strati d'aria a temperature sempre maggiori. Analoghe considerazioni valgono per i cristallini di ghiaccio e le precipitazioni nevose.

La rugiada e la brina sono invece dovute a condensazione e deposizione del vapore direttamente sulla vegetazione, sugli oggetti al suolo e sul terreno: la prima in forma liquida e la seconda direttamente in forma solida (brinamento) o come ghiacciamento della prima.

Un cenno particolare merita la formazione della grandine, prodotto frequente delle violente e turbolente correnti ascendenti che si manifestano nelle nubi temporalesche (cumulonembi) particolarmente sviluppate verticalmente. Nell'ascesa turbolenta dagli strati atmosferici prossimi al suolo, la massa d'aria molto umida coinvolta nel processo si raffredda per espansione adiabatica (v. atmosfera) facendo condensare parte del vapor d'acqua che essa contiene: tuttavia questa condensazione, anche a temperature notevolmente al di sotto dello 0 °C, non avviene subito in forma solida, bensì in forma liquida instabile di goccioline sopraffuse che le correnti ascendenti trascinano verso le parti più alte e fredde della nube; qui una modesta percentuale delle goccioline ghiaccia intorno a piccolissimi cristalli di ghiaccio o altri germi di ghiacciamento, e si ingrossa poi perché su ciascuna di esse viene a depositarsi, in forma di ghiaccio cristallino brinoso, il vapore che satura l'ambiente. Appesantiti da questo primo ingrossamento, i granuli bianchi opachi cadono attraverso la nube composta di goccioline sopraffuse che essi urtano e conglobano, ingrossandosi ulteriormente; al di sopra del granulo opaco, se il numero di goccioline inglobate è grande, si forma un primo strato che è di ghiaccio trasparente e duro; i chicchi così formati possono cadere a terra o essere ripresi dalle intense correnti ascendenti della nube e venir riportati ai livelli ai quali ingrossano di nuovo con la formazione di un secondo strato opaco; il ghiaccio opaco è dovuto alla cattura di uno scarso numero di goccioline molto minute, che gelano quasi istantaneamente intrappolando bollicine d'aria (crescita secca, che si ha con difetto di materiale catturato); il ghiaccio trasparente, invece, è dovuto a cattura di numerose gocce più grosse che ghiacciano lentamente, dopo essersi espanse come una pellicola intorno al chicco di grandine (crescita bagnata, che si ha con eccesso di materiale catturato). Il fenomeno di ascesa e discesa può ripetersi più volte e può portare un certo numero di chicchi ad avere molti strati brinosi e trasparenti e raggiungere nello stesso tempo dimensioni di alcuni centimetri. Molti sono i modelli di nube temporalesca grandinigena escogitati per giustificare questa serie di fenomeni; tra essi il più soddisfacente è quello di F. Ludlam (v. Battan, 1964, p. 88).

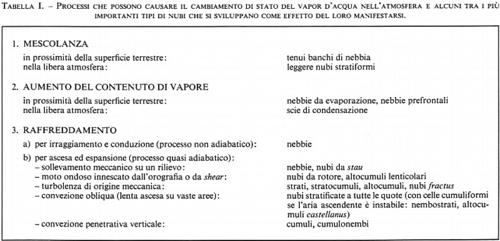

Si può in conclusione dire che le cause determinanti i processi di cambiamento di stato del vapor d'acqua contenuto nell'atmosfera (quindi la genesi e la crescita delle goccioline d'acqua e dei cristalli di ghiaccio e dei loro stati aggregati, cioè nubi e precipitazioni) sono in sostanza due, e possono agire separatamente o insieme: un abbassamento della temperatura dell'ambiente, tale da far scendere il valore della pressione di saturazione almeno sino a quello della pressione effettiva di vapore, oppure un'umidificazione dell'ambiente, per la quale la pressione effettiva di vapore tende ad aumentare sino a raggiungere il valore della pressione di saturazione. Il raffreddamento e l'arricchimento di vapore sono cause tanto più efficaci quanto più attive sono le particelle igroscopiche spurie che favoriscono tali processi (v. tab. I).

È opportuno ricordare che si può manifestare anche un processo di ‛autosemina' dei sistemi nuvolosi; questo fenomeno si può verificare, per esempio, quando sotto a uno strato di cirri venga a trovarsi una distesa di altostrati o altocumuli oppure addirittura di strati o di stratocumuli: può allora accadere che dai cirri precipitino dei cristallini di ghiaccio, i quali, penetrando negli strati nuvolosi sottostanti, agiscano come nuclei di condensazione e inneschino la precipitazione da queste nubi più basse.

La specie e la varietà delle nubi vengono poi modificate molto spesso da processi aggiuntivi, quali precipitazioni, subsidenza, instabilità verso il basso e nubi accessorie; esempio caratteristico è rappresentato dalla particolarità supplementare chiamata virga nel caso del cirrocumulo: assai spesso la nube visibile è in realtà la precipitazione di cristalli di ghiaccio proveniente dalla nube generatrice (cirrocumulo), la quale invece si è praticamente esaurita per ghiacciamento e precipitazione. Infine, un tipo di nube può originarsi per trasformazione di un'altra nube, in fase di dissolvimento di quest'ultima o per variazioni dinamiche dello stato dell'atmosfera. Ciò accade sovente con i cumuli imponenti e i cumulonembi: se nello sviluppo ascendente queste nubi si avvicinano a uno strato d'inversione in quota, questo si marca sotto la spinta dinamica e nella cresta si sviluppa il pileus o ‛cappuccio', dal quale si originano stratocumuli, mammotocumuli o altocumuli cumulogeniti; se lo strato viene perforato, il pileus diventa una ‛cintura' per la nube cumuliforme; allo stesso modo, dal dissolvimento dei cumulonembi completamente sviluppati restano, oltre a cellule altocumuliformi, le frange dell'‛incudine' sotto forma di nubi cirriformi (falsi cirri).

In natura i processi genetici delle nubi non si manifestano isolati, ma accade per lo più che la struttura termoigrometrica e dinamica dell'atmosfera favorisca la formazione di sistemi nuvolosi più o meno complessi risultanti da combinazioni di questi processi. Dal punto di vista dinamico, i sistemi nuvolosi sono generalmente presenti sulle aree dove si sviluppano correnti verticali e dove vi è convergenza nei bassi strati e divergenza in quota: esempio tipico, la posizione dei sistemi frontali rispetto ai massimi delle correnti a getto spiegata da R. Scherhag nel 1934 (v. atmosfera, cap. 6).

Giova infine ricordare che le nubi stratificate, indice di correnti ascendenti estese ma di debole o moderata intensità (‛convezione obliqua' per scivolamento ascendente), sono accompagnate in genere da pioviggine e da piogge (o rispettivamente da nevischio e neve) prevalentemente persistenti, mentre alle nubi cumuliformi, sede di forti ma localizzate correnti verticali (‛convezione verticale penetrativa'), sono associate precipitazioni più intense, spesso a carattere di rovescio (di pioggia, di neve o di grandine).

Naturalmente infinite sono le varietà dei sistemi nuvolosi associati alle molteplici configurazioni che la circolazione atmosferica può assumere in ciascuna stagione e a ogni latitudine. È da sottolineare anche l'importanza fondamentale che hanno, nello sviluppo delle nubi, l'influenza della superficie e lo stato dello strato atmosferico di confine, cioè delle prime centinaia di metri di spessore della troposfera, che risentono particolarmente dell'andamento diurno. La superficie, sia marina che terrestre, costituisce infatti il contorno inferiore del fluido ‛atmosfera' e ne influenza gli strati troposferici in vari modi: dal punto di vista dinamico, per l'azione che le rugosità (ivi comprese le grandi catene montuose) della superficie stessa hanno sullo scorrimento dell'aria e quindi sullo scambio di quantità di moto tra Terra e atmosfera e nella produzione di vorticità ciclonica o anticiclonica; sotto il profilo termico, come sorgente o pozzo di energia termica in dipendenza soprattutto dalla natura e dallo stato della superficie e dalla latitudine; infine, sotto l'aspetto igrometrico, come fonte di vapore acqueo, anche in relazione alla vegetazione, allo stato di imbibizione del terreno o alle condizioni della superficie del mare e così via.

Aspetti ed evoluzione delle nubi e dei loro sistemi sono quindi caratteristici dello stato fisico dinamico e termodinamico dell'atmosfera. Mentre oggi si lavora per studiare e comprendere le correlazioni fra dinamica da una parte e nubi e precipitazioni dall'altra, è interessante ricordare che un tempo si operava in modo opposto: in assenza di dati in quota, si cercava di dedurre questi e studiare poi la dinamica dell'atmosfera proprio con l'ausilio delle osservazioni sulle nubi (aerologia indiretta).

g) Il dissolvimento delle nubi

Vale la pena di accennare brevemente alle cause naturali di dissolvimento delle nubi e dei sistemi nuvolosi (per l'intervento artificiale sulle nubi e sulle precipitazioni v. sotto, cap. 4).

Generalmente si affievolisce o termina il processo che ha determinato le condizioni favorevoli allo sviluppo delle nubi, sia per il mutare della situazione meteorologica che per l'esaurirsi dell'energia disponibile: per esempio su piccola scala può cessare l'effetto instabilizzante dovuto al riscaldamento solare che ha dato luogo a nubi cumuliformi, oppure su grande scala può avvenire che gli uragani, penetrando nell'entroterra, perdano il rifornimento di calore latente dovuto alla condensazione delle ingenti quantità di vapor acqueo acquistato sulle zone oceaniche, e tendano a dissolversi.

Si possono inoltre manifestare processi che portano all'evaporazione delle goccioline o alla sublimazione dei cristalli di ghiaccio costituenti la nube. Di questi processi il più frequente è forse il riscaldamento adiabatico, che avviene quando la massa d'aria nella quale si è sviluppata la nube viene sottoposta a moti discendenti (per es. orografici, come nel caso del föhn): effetto di tale subsidenza è il riscaldamento della massa per compressione adiabatica e quindi l'allontanamento dalle condizioni di saturazione. Il mescolamento con aria ambiente non satura è spesso tale da provocare processi di evaporazione e sublimazione in grado di erodere e addirittura far dissolvere la nube, come accade ad esempio nella base dei cumuli di bel tempo. Anche l'insolazione può portare all'assottigliamento e spesso al dissolvimento di nebbie oppure di nubi formate per turbolenza sulla superficie terrestre, innalzando e distruggendo lo strato d'inversione talchè l'aumento di temperatura e la diminuzione del contenuto di vapore per diffusione turbolenta verso l'alto rendono l'aria non più satura. Infine, anche la precipitazione delle gocce o dei cristalli di ghiaccio può provocare il dissolvimento della nube generatrice per esaurimento delle particelle costitutive, come nel già citato caso delle virga dei cirrocumuli.

3. Meteorologia operativa

La fenomenologia atmosferica è estremamente complessa, poiché è il risultato, istante per istante, di una grande molteplicità di processi contemporanei che si svolgono su scale spazio-temporali le più diverse (v. sopra, cap. 1); per l'analisi accurata e completa dello stato dell'atmosfera sarebbe perciò necessaria una rete mondiale d'osservazione e di misurazione dei vari parametri meteorologici quanto più possibile densa di stazioni, nelle quali si eseguissero con frequenza assai elevata i rilevamenti sia in superficie che a tutte le quote. Naturalmente la realizzazione di una rete globale con tali caratteristiche è pura utopia, sotto l'aspetto sia tecnico che finanziario; a ciò si aggiunga il fatto che è solo da poco tempo che in molti potenziali utenti è andata maturando una mentalità opportuna di interesse e di stimolo, cosicché per lungo tempo, a parte le richieste di assistenza aeronautica, lo studio della meteorologia è stato confinato al di fuori degli interessi della comunità.

Prima di illustrare alcuni dei settori di ricerca applicata verso i quali si è maggiormente rivolta l'attività degli studiosi, specie da quando è stata riconosciuta una stretta interdipendenza fra meteorologia ed ecologia, è opportuno dare uno sguardo alla situazione reale delle capacità di sorveglianza dello stato dell'atmosfera, cioè ai sistemi di osservazione attualmente operativi, ai mezzi di collegamento per l'indispensabile scambio delle informazioni e ai prodotti elaborati dai meteorologi per l'analisi e la prognosi del tempo. Ovviamente il discorso diverrebbe interminabile se non ci si limitasse, come verrà fatto in questo capitolo, ad alcuni cenni essenziali sulla rete meteorologica internazionale e alla presentazione di alcune strumentazioni ‛speciali' le quali, pur non avendo ancora un uso operativo, si rivelano assai promettenti come mezzi di sorveglianza continua dell'atmosfera.

a) I rilevamenti tradizionali

Le osservazioni e le misurazioni tradizionali per il rilevamento di dati vengono eseguite nelle stazioni meteorologiche da personale specializzato sulla base di criteri e modalità internazionalmente convenuti e codificati (per merito soprattutto dell'OMM) affinché i dati siano affida- bili, utilizzabili da meteorologi di qualunque paese e le loro serie temporali confrontabili fra loro; il problema non è da sottovalutare, perché ancor oggi, nonostante il progresso tecnologico, alcuni parametri meteorologici possono essere soltanto ‛osservati a vista' e non sono ancora misurabili con apparecchiature, almeno in modo pratico ed economico: esempio ne sia la valutazione della nuvolosità, soprattutto in funzione dell'importanza che le caratteristiche presentate dalle nubi assumono per l'analista e il previsore in quanto effetti di processi fisici in atto nell'atmosfera (v. tab. I).

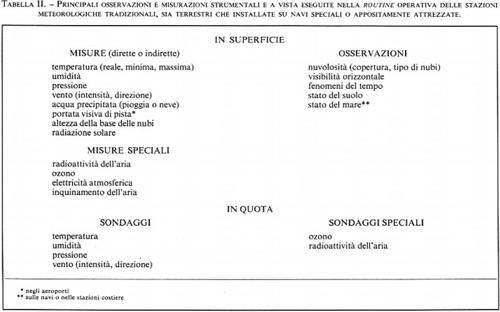

Nella tab. Il sono illustrati i principali rilevamenti effettuati dalle stazioni meteorologiche tradizionali, sia terrestri che imbarcate su navi speciali.

Data l'importanza di avere misurazioni a densità spaziale quanto più elevata possibile, o per sopperire alla mancanza o alla chiusura di stazioni con personale, oggi sono divenuti numerosi gli esemplari di stazioni automatiche, sia terrestri che montate su boe galleggianti; in esse, i parametri meteorologici misurabili sono rilevati da sensori in modo automatico, sia autonomo che per comando a distanza, e i dati vengono trasmessi a una stazione di accentramento via filo o via radio, sia direttamente che tramite satellite (v. sotto).

Le osservazioni eseguite in ogni stazione sono trasformate in messaggi secondo codici internazionali fissati dall'OMM e inviate sulla rete di telecomunicazioni meteorologiche al centro meteorologico nazionale; da qui i messaggi delle stazioni più rappresentative di ogni paese sono poi inseriti nel circuito di telecomunicazioni internazionali della Vigilanza Meteorologica Mondiale (WWW, World Weather Watch.). A ore prefissate, quindi, si può fare un'analisi ‛sinottica', cioè avere una visione d'insieme dello stato dell'atmosfera su aree vastissime, al limite anche su tutto il globo.

È opportuno sottolineare che il progresso dei mezzi di diffusione delle informazioni costituisce una premessa indispensabile al progresso della meteorologia moderna. Dopo l'accentramento a livello nazionafe dei messaggi il collegamento internazionale avviene su linee di trasmissione ad alta velocità tra elaboratori elettronici che controllano e gestiscono le telecomunicazioni per poi operare la ridistribuzione nazionale e capillare dei dati; questa parte della Vigilanza Meteorologica Mondiale, denominata GTS (Global Telecommunication System), ha anche il vantaggio di permettere un miglioramento delle prestazioni ogni volta che il progresso tecnologico mette a disposizione degli utenti macchine più potenti e veloci, oppure sistemi più efficienti di trasferimento dei dati.

b) Il telerilevamento nelle funzioni operative

Le tecniche di misura a distanza di parametri atmosferici, le uniche che permettono la sorveglianza su vaste aree o addirittura su tutto il globo, hanno già trovato applicazioni operative in due sistemi di osservazione: il radar e il satellite artificiale.

Il radar meteorologico (RADAR, RAdio Detection And Ranging) si è rivelato strumento impareggiabile nella sorveglianza delle nubi e delle precipitazioni, particolarmente di quelle che possono arrecare danno alle attività umane; le lunghezze d'onda usate rientrano nelle onde centimetriche, in genere intorno ai 3 cm (banda X), 5 cm (banda C) o 10 cm (banda S).

Numerosissimi studi vengono fatti sulle relazioni che legano il fattore di riflettività radar Z e l'intensità di precipitazione R misurata al suolo, le quali peraltro possono sintetizzarsi nella forma Z=aRb, dove i coefficienti a e b variano soprattutto in funzione del tipo di precipitazione. Le ricerche tendono a trasformare l'informazione da puramente qualitativa, quale appare la presentazione sullo schermo radar degli echi meteorologici frammisti a echi spuri, in un dato quantitativo: per esempio l'intensità di precipitazione in un punto dello spazio sorvegliato dal radar. Il campo di osservazione dello strumento è notevole, potendosi rilevare echi fino a distanze dell'ordine dei 400 km, e la possibilità di seguire l'evoluzione spazio-temporale degli echi stessi è eccellente, con un intero giro d'orizzonte ogni pochi secondi; è perciò ovvio l'interesse di estrarre dall'informazione radar grezza soltanto il dato di interesse meteorologico e di trasmetterlo in tempi brevi a un unico centro di elaborazione meteorologica: qui, con l'integrazione dei segnali di tutti i radar di un vasto territorio si può effettuare una sorveglianza continua del territorio stesso. In questa direzione si sono orientate ultimamente le applicazioni della radarmeteorologia, soprattutto per scopi aeronautici, idrologici e agricoli, con l'intento di giungere sia ai sistemi di controllo e di allarme di fenomeni pericolosi per le attività umane e per l'agricoltura sia alla gestione delle risorse idriche di interi bacini: i risultati che sono stati già ottenuti in alcuni paesi confortano questa speranza (v. sotto, cap. 4).

L'unico mezzo in grado di assicurare la sorveglianza globale dell'atmosfera è invece a tutt'oggi un sistema di satelliti meteorologici: questi sono in realtà delle stazioni automatiche di telerilevamento immesse in orbite praticamente circolari attorno alla Terra.

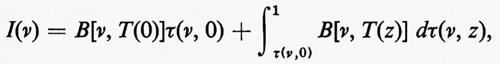

La tecnica di telerilevamento sulla quale si basano tutte le strumentazioni montate a bordo dei satelliti meteorologici è quella della misurazione, in uno o più intervalli di lunghezze d'onda, della radiazione che dal basso giunge al satellite. La fisica di tale metodo è riassunta dall'equazione del trasporto radiativo, che in una forma semplificata si può scrivere:

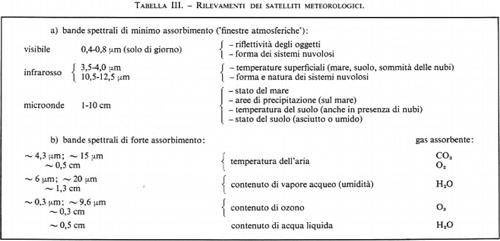

dove I(ν) è l'intensità della radiazione di frequenza ν che giunge al satellite, B[ν, T(z)] è la sua funzione di Planck relativa alla frequenza ν e alla temperatura T che si ha alla quota z, τ(ν, z) è la trasmissività dello strato atmosferico compreso tra la quota z e quella del satellite (per z=0 i parametri si intendono riferiti alla superficie); in sostanza l'intensità di energia radiante emessa dai corpi sottostanti viene rilevata dal satellite attenuata dal valore di trasparenza dell'atmosfera interposta: il secondo termine a secondo membro dell'equazione rappresenta infatti il contributo radiativo dei vari strati atmosferici, mentre il primo termine esprime quello della superficie del suolo o del mare oppure della cima delle nubi. Gli strumenti operanti a bordo dei satelliti sono perciò dei radiometri, con filtri e sensori tali da selezionare particolari frequenze d'interesse meteorologico, in particolare nei campi del visibile, dell'infrarosso e delle microonde (v. tab. III); ciò permette di utilizzare due metodi d'indagine: effettuare misure in intervalli spettrali nei quali l'atmosfera si presenta molto trasparente, chiamate misure in ‛finestra atmosferica', le quali sono relative alla radiazione proveniente dalla superficie superiore dei corpi condensati più vicini al satellite (nel secondo membro dell'equazione il valore dell'integrale è in tal caso praticamente trascurabile); oppure misure in bande spettrali di assorbimento dei diversi gas costituenti l'atmosfera, nel qual caso il primo termine a secondo membro può rendersi quasi nullo, in modo da ottenere informazioni sullo stato della colonna atmosferica sottostante il satellite, cioè una sorta di stratigrafia dell'atmosfera specie per quanto concerne l'andamento verticale di grandezze come la temperatura dell'aria o il contenuto di vapor d'acqua.

Da menzionare altre due funzioni operative fondamentali dei satelliti meteorologici: l'interrogazione di stazioni automatiche e la trasmissione di carte meteorologiche, soprattutto la diffusione delle immagini del globo o di sue parti, già ottenute dai satelliti, con i contorni geografici e con le caratteristiche dei sistemi nuvolosi opportunamente esaltate ed elaborate (‛nefoanalisi'). Con la prima il satellite, previo comando da terra o su temporizzazioni programmate, interroga le stazioni automatiche predisposte per il collegamento, ne riceve i dati e li rinvia a terra alla stazione centrale, fungendo perciò da ‛collettore' per varie centinaia di stazioni automatiche marine o terrestri. Con la seconda funzione (WEFAX), il satellite opera da ‛trasponditore' fra la stazione centrale a terra e gli utenti per una più capillare e assai più ampia diffusione delle carte meteorologiche.

c) Strumentazioni sperimentali di interesse applicativo

Come già accennato, l'interesse dei meteorologi è volto ormai all'acquisizione di apparecchiature di rilevamento a distanza dei dati, sia per la sorveglianza continua locale dell'atmosfera che per l'analisi dello stato di essa su scala globale. Per questo motivo si ritiene opportuno illustrare brevemente alcune moderne tecniche sperimentali di tele- rilevamento o altre strumentazioni speciali, le quali sembrano avere un promettente futuro per un uso operativo.

Sondaggi acustici. - In generale, la trasmittanza acustica dell'atmosfera dipende in gran parte dal contenuto di vapore nell'aria e dalle perdite per diffusione dovute alla turbolenza dinamica e alla struttura termica su piccola scala: queste infatti fanno variare la velocità di propagazione delle onde acustiche, nei riguardi delle quali si comportano come veri e propri diffusori. Il favore con il quale i ricercatori hanno accolto le sonde acustiche è dovuto anche alla relativa semplicità e maneggevolezza dell'apparecchiatura, giacché lo stesso apparato trasmittente (un altoparlante o traduttore elettromeccanico accoppiato a una piccola antenna parabolica) può operare anche da sistema ricevente.

Con le sonde acustiche, chiamate frequentemente SODAR (SOund Detection And Ranging, in analogia con RADAR), si studiano bene con continuità nel loro evolversi temporale la struttura fine e le fluttuazioni delle inversioni termiche e della turbolenza termica associate al passaggio di perturbazioni frontali, le onde interne atmosferiche e la diffusione dei pennacchi di fumi inquinanti, nonché le condizioni di shear del vento nei bassi strati atmosferici, di grande interesse aeronautico (v. sotto, cap. 4).

Sondaggi ottici. - Anche il telerilevamento effettuato con tecniche ottiche si è rivelato un prezioso metodo d'indagine atmosferica; infatti l'intensità del segnale è funzione soprattutto della concentrazione di particelle diffondenti nel volume d'aria illuminato, mentre a sua volta la distribuzione spazio-temporale della concentrazione di queste dipende dallo stato termoigrometrico e dinamico dell'aria stessa. Questo metodo d'indagine si è rivelato assai efficace nello studio delle inversioni, in quanto è in grado di rilevare la variazione nell'andamento verticale della distribuzione di particelle diffondenti (funzione per esempio della stabilità dell'aria, cioè del gradiente termico verticale) non appena essa comincia a manifestarsi: promettenti appaiono perciò, con tali tecniche ottiche, gli studi sulla formazione e la dispersione delle nebbie e quindi sui processi di cambiamento di stato del vapor d'acqua che si manifestano nell'atmosfera, con la possibilità di predisporre strumentazioni operative che integrino validamente, specie nella frequenza temporale, i tradizionali radiosondaggi.

Utilizzando poi tecniche laser, c'è la possibilità di studiare anche gli strati medi e alti dell'atmosfera, con limiti dovuti soltanto alla potenza del laser adoperato; queste strumentazioni vengono chiamate LIDAR (LIght Detection And Ranging), e si sono rivelate efficaci nelle indagini relative al trasporto a distanza di inquinanti.

Altre apparecchiature di rilevamento vanno tenute presenti, anche se è impossibile presentarne una rassegna esauriente. Da citare i razzi attrezzati per scopi meteorologici, i quali sono soprattutto adibiti da un lato a misurare l'andamento verticale della temperatura fino a quote molto elevate onde integrare le radiosonde e i satelliti, dall'altro a sganciare all'apogeo particolari sonde, traccianti o reagenti per lo studio dei venti e della composizione dell'aria a grandi altezze; queste apparecchiature, peraltro preziosissima fonte d'informazioni altrimenti non ottenibili, purtroppo sono assai costose, cosicché il loro uso è assai limitato. Per gli stessi motivi sono pochi i lanci di palloni a quota banca costante, liberi di seguire le correnti atmosferiche alla quota di galleggiamento prefissata: il loro inseguimento da terra o da satellite ha già portato notevoli informazioni sulla circolazione in alta quota, specie sull'emisfero australe là dove la scarsità di terre emerse impedisce la costituzione di una fitta rete di radiosondaggi.

Un breve cenno merita il fatto che uno studio continuo degli strati atmosferici compresi fra i 70 e i 120 km circa (ai limiti dell'atmosfera omogenea e alla base della termosfera) viene compiuto con speciali stazioni radar che, a mezzo del comportamento delle micrometeore e delle loro scie, sondano temperatura, densità e venti.

4. La meteorologia come scienza ambientale

a) L'atmosfera superiore e l'ozono

Giacché le tradizionali radiosonde giungono in media soltanto a quote intorno ai 30 km, le ricerche sull'atmosfera superiore vengono attualmente svolte con altri metodi di misurazione sia diretti, quali i razzi meteorologici, sia indiretti, quali i rilevamenti a distanza. Questi ultimi vengono effettuati tramite satelliti artificiali opportunamente attrezzati, oppure da terra con tecniche radioelettriche (radar) oppure ottiche (laser), sfruttando per lo studio dell'atmosfera l'osservazione di altri fenomeni che vi si producono, quali, come si è già accennato, le tracce di materiale micrometeorico. L'interesse degli studiosi è rivolto soprattutto a due aspetti principali: l'acquisizione di maggiori conoscenze sulla struttura termica e dinamica dell'alta atmosfera e lo studio delle reazioni fotochimiche che avvengono ad alta quota, sia per tentare di capire se questi fenomeni influiscano sulla variabilità stagionale del tempo, sia per poter dedurre e prevedere gli effetti che alcune attività umane potranno avere sul clima del pianeta.

Da tempo si sono superate infatti vecchie teorie che consideravano la stratosfera come una zona tranquilla, inerte e termostatata; in realtà si è visto che la circolazione stratosferica è molto attiva; non solo, ma grande attenzione viene rivolta; al fenomeno degli improvvisi riscaldamenti invernali che si manifestano in essa: nel volgere di 24 ore si possono avere incrementi di temperatura persino di 30 o più gradi centigradi, ai quali seguono ampie modificazioni di tutta la struttura delle correnti in quota. Il fenomeno, osservato e messo in evidenza per la prima volta nel 1962 presso l'Istituto Meteorologico della Libera Università di Berlino, è a scala emisferica e ha come effetto la formazione di una cellula anticiclonica, animata da moto retrogrado, che può arrivare a spezzare il vortice ciclonico polare stratosferico: questo evento può verificarsi diverse volte nel corso di un inverno, e in genere l'ultima coincide con il momento di cambiamento stagionale. Il riscaldamento si manifesta intorno ai 40-50 km e interessa un notevole spessore di atmosfera, potendo giungere da un lato alla bassa mesosfera, e dall'altro, nei giorni successivi all'apparizione, spingersi talvolta fino alla tropopausa; in concomitanza, nelle zone più interessate dal fenomeno si generano intensi moti verticali accompagnati da sensibile turbolenza, così come sembra essere associata all'evento la presenza di particolari configurazioni delle correnti troposferiche. Gli effetti determinati sull'ambiente atmosferico dal rapido riscaldamento e dalla genesi di moti turbolenti possono influire sulla sicurezza dei voli commerciali a velocità supersonica che si vanno diffondendo nella stratosfera: è stato calcolato che, nel passaggio dalla fase subsonica a quella supersonica del volo, un aumento di 5 °C nella temperatura reale rispetto a quella prevista comporta una riduzione del 25% nell'accelerazione del velivolo, per ovviare alla quale il pilota è costretto ad aumentare la spinta dei motori e a consumare più carburante del previsto; l'importanza attribuita all'evento è tale che, quando viene rilevato un improvviso riscaldamento stratosferico, si diffonde sul circuito di telecomunicazioni della Vigilanza Meteorologica Mondiale uno speciale messaggio chiamato in codice STRATALERT. Dallo studio di questi fenomeni si cercherà tra l'altro di capire meglio con quali processi e in quale percentuale le quote superiori influenzino lo stato e l'evoluzione della troposfera, o se questa induce su quelle delle alterazioni ancora non scoperte.

Per quanto concerne l'ozono, il problema è ormai di pubblico dominio. Mentre fino agli anni sessanta si riteneva che gli agenti dissocianti fossero soltanto i radicali derivati dal vapor acqueo, efficaci distruttori d'ozono si sono dimostrati anche i radicali degli ossidi di azoto e dei dorofluorocarburi e il cloro atomico. Il meccanismo naturale di produzione dell'ozono nell'atmosfera superiore (v. Verniani, 1976) è la fotodissociazione dell'ossigeno molecolare, provocata da radiazione di lunghezza d'onda inferiore ai 2.400 Å, seguita da processi di collisione tra ossigeno molecolare e atomico in presenza di altre particelle catalizzatrici; nella troposfera l'ozono si forma, in quantità assai inferiore, durante le scariche elettriche, nelle esplosioni nucleari e nella distruzione del biossido d'azoto. La distruzione dell'ozono avviene invece attraverso vari processi: la fotodissociazione in ossigeno atomico e molecolàre per l'assorbimento di radiazione a λ〈11.500 Å, la combinazione diretta con ossigeno atomico o con il cloro atomico, le reazioni catalitiche con ossidi d'azoto, le interazioni con i radicali del vapor d'acqua, la decomposizione su particelle di origine meteorica e infine il contatto con il suolo dovuto al trasporto legato a moti atmosferici discendenti, o a trasporto per diffusione turbolenta.

Oggi il problema può formularsi nei seguenti termini: in quale misura il rilascio nell'atmosfera di ossidi di azoto, immessi in quota dagli scarichi dei motori dei velivoli supersonici e dalle esplosioni nucleari, e di clorofluorocarburi, usati come propellenti nebulizzanti nelle bombolette spray oggi diffusissime per gli usi più vari, può portare alla distruzione di apprezzabili quantità di ozono? E quali altri agenti distruttori di questo gas sono rilasciati nell'aria a opera dell'uomo oltre a quelli prodotti dalla natura? La presenza di ozono nell'atmosfera mostra d'altronde ampie fluttuazioni naturali diurne, stagionali e biennali, che rendono problematiche la conoscenza e la sorveglianza delle alterazioni indotte nell'ozonosfera dalle attività umane.

La percentuale di ozono, rispetto agli altri gas costituenti l'aria, è piccolissima, dell'ordine di un milionesimo del totale (corrispondente, se tutto il gas venisse portato a livello del suolo e in condizioni standard, a uno spessore di pochi millimetri); ciò nonostante, la sua importanza è determinante nell'equilibrio radiativo del sistema Terra-atmosfera e nella sopravvivenza della biosfera; le reazioni fotochimiche che interessano l'ozono determinano il mantenimento di temperature relativamente elevate nella stratosfera e nella mesosfera inferiore, con un massimo prossimo a 0 °C al livello della stratopausa; inoltre, questo gas assorbe quasi tutta la radiazione ultravioletta proveniente dallo spazio con una funzione filtrante che è di vitale importanza per impedire gli effetti biologici negativi che queste radiazioni altrimenti provocherebbero, specie per quanto riguarda i processi rigeneratori delle cellule animali e vegetali. Il problema delle conseguenze indotte da una riduzione della quantità di ozono atmosferico è vastissimo e molto complesso, perché ancora assai poco si conosce sulla molteplicità dei processi nei quali questo gas è coinvolto e soprattutto perché, se da una parte sono difficili e delicate le osservazioni sperimentali, dall'altra non è ancora possibile simulare in laboratorio altro che aspetti parziali e incompleti della fenomenologia relativa all'ozono stesso. Anche per questi motivi, l'impatto che una riduzione della fascia di ozono stratosferico avrebbe sul clima costituisce un problema controverso, come pure molto discusso è l'effetto che avrebbero i clorofluorocarburi (più noti come gas ‛freon') nella rimozione dell'ozono; per contro, è assodato che gli ossidi d'azoto sono agenti efficacissimi nella distruzione di questo gas, il loro contributo depletivo essendo stato valutato dell'ordine del 70% del totale di ozono rimosso: appare allora giustificato l'allarme degli studiosi per il preoccupante elevato indice d'incremento annuo dell'uso di componenti azotati adoperati come fertilizzanti; a ciò si aggiungano i lunghi tempi di residenza nell'atmosfera di questi agenti distruttivi, che possono perciò far sentire i loro effetti anche molti anni dopo che si sia operato un severo controllo nel loro uso. Purtroppo, se è vero che il pericolo esiste, è altrettanto vero che la richiesta di cibo e perciò di concimi a livello mondiale è sempre più pressante: per questo, alla rete internazionale di stazioni terrestri e di ozonosondaggi in quota integrata da misure eseguite con i satelliti meteorologici per controllare la concentrazione di questo prezioso gas nell'atmosfera, si comincia ad affiancare un analogo controllo sugli agenti che intervengono nelle reazioni interessanti l'ozono.

b) Lo strato di confine planetario

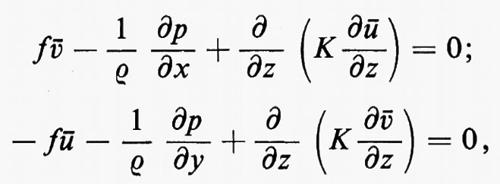

Dal punto di vista dinamico, le forze in gioco su una particella di fluido atmosferico per unità di massa sono: la forza di gravità relativa (nella quale è compresa l'azione della forza centrifuga), la forza di pressione, la forza deviante di Coriolis e le forze d'attrito interno ed esterno legate soprattutto agli effetti dello scambio turbolento. Si considera quindi libera atmosfera la parte di fluido che si trova al di sopra della quota alla quale le forze dovute allo scambio diventano assolutamente trascurabili rispetto alle altre forze agenti, mentre si dà il nome di strato di confine planetario, o strato limite, alla fascia atmosferica compresa tra quella quota e la superficie terrestre. Il livello di transizione varia molto, in funzione sia delle caratteristiche della superficie (in particolare della sua rugosità) che dei parametri meteorologici (quali vento e temperatura) nella loro distribuzione orizzontale e soprattutto verticale; generalmente si assume perciò come limite superiore dello strato la quota alla quale il vento può considerarsi geostrofico, il che equivale a dire là ove le forze viscose, dovute alla diffusione verso l'alto dei moti turbolenti di origine termica e/o dinamica innescati dalla superficie, tendono ad annullarsi; questa quota si aggira in media intorno ai 500-1.000 m, ma in presenza di situazioni con inversione si suppone coincida con l'altezza della cima dello strato d'inversione, a causa della funzione di blocco che queste situazioni esercitano sul rimescolamento verticale turbolento. Lo strato di confine planetario è dominato dalla dinamica dei moti turbolenti, e in esso le forze di scambio assumono un ruolo pari o superiore a quello delle forze di pressione e di Coriolis; al suo interno, specie nella parte inferiore, il mescolamento turbolento può produrre intensi trasferimenti di massa e di energia tra i suoi diversi strati, mentre la sua parte superiore è in genere stratificata in modo stabile. Per queste sue caratteristiche, lo strato limite può essere suddiviso in uno strato d'attrito, o ‛di Prandtl', a diretto contatto con la superficie e con spessore dell'ordine di decine di metri, caratterizzato da rapide variazioni con la quota dei valori medi del vento, della temperatura e dell'umidità specifica, e nel quale prevalgono la diffusione di energia cinetica turbolenta e la dissipazione in calore di energia turbolenta, e in uno strato superiore, chiamato ‛strato di Ekman', nel quale con l'aumentare della quota l'effetto del contorno inferiore tende a smorzarsi, talché il vettore vento, secondo il più semplice dei modelli schematici, col crescere della quota ruota e aumenta di grandezza seguendo con l'estremo libero una spirale (quella di Ekman) fino a coincidere praticamente col vento geostrofico alla sommità dello strato limite. La descrizione del flusso turbolento e del rimescolamento da esso operato, per la grande variabilità spazio-temporale del fenomeno anche per piccoli intervalli di tempo e su aree ridotte, può essere fatta con teorie di tipo statistico, basandosi sull'assunto che sia possibile esprimere il trasporto di quantità di moto, operato dai moti turbolenti nello strato di confine planetario, tramite i parametri propri della circolazione media su scala maggiore, quale la scala sinottica. Con questo tipo di impostazione del problema, applicando le equazioni del moto a un flusso stazionario orizzontale nello strato prossimo al suolo, si ottengono le equazioni di equilibrio dinamico tra le forze dovute alla circolazione (di Coriolis e forze di pressione) e quelle dovute alla viscosità (v. Gifford, 1968):

dove f=2Ω sen ϕ è il parametro di Coriolis (Ω è la velocità angolare di rotazione della Terra e ϕ è la latitudine), ρ la densità dell'aria, p la pressione atmosferica, ù e ã le componenti orizzontali del vento medio nello strato nelle direzioni x e y, e K è il coefficiente di viscosità turbolenta o diffusività. Nell'ipotesi che nello strato la diffusività, la densità e il gradiente banco siano costanti si giunge a un andamento con la quota del vento che schematicamente, in rappresentazione vettoriale, segue appunto la già citata spirale di Ekman. Si noti che al limite superiore dello strato di confine planetario, quota alla quale le forze viscose praticamente si annullano (terzo termine delle equazioni su indicate), il vento medio tende a identificarsi con il vento geostrofico. Per valutare l'importanza della diffusione turbolenta verticale, si tenga presente che il valore del relativo coefficiente diffusivo, alla scala dei fenomeni locali e dello strato limite, è di cinque o sei ordini di grandezza superiore al valore del coefficiente di diffusione molecolare.

Un indice molto espressivo delle condizioni di stabilità di uno strato è il ‛numero di Richardson' Ri, usualmente espresso da:

dove g è l'accelerazione di gravità, θ la temperatura potenziale (cioè la temperatura che assumerebbe la particella d'aria se fosse portata con un processo adiabatico secco alla pressione di 1.000 mbar), ∂v/∂z lo shear verticale del vento, cioè la variazione del vento orizzontale con la quota; il numero di Richardson offre la possibilità di valutare in quale misura campo termico e campo dinamico, pesati da un fattore di galleggiamento, interagiscono nell'innescare fluttuazioni turbolente. Un altro parametro ricorrente negli studi sullo strato di confine planetario è la cosiddetta ‛lunghezza di Monin-Obukhov'; correlato con Ri tramite la quota, esso assume il significato di lunghezza caratteristica della scala del fenomeno turbolento ed è un indice molto significativo nella ‛teoria della similarità' di Monin e Obukhov, teoria che si presta a interpretare abbastanza bene i dati sperimentali di questo complesso campo d'indagine.

Tra le applicazioni degli studi sullo strato di confine planetario, tre settori di ricerca sono di grande interesse: shear del vento, diffusione di inquinanti e micrometeorologia urbana; questi ultimi due argomenti sono trattati nel successivo paragrafo sull'inquinamento. Lo shear verticale del vento costituisce oggi uno dei più complessi e delicati problemi di meteorologia aeronautica, a causa della grande inerzia presentata dai moderni aeromobili da trasporto nel rispondere alle correzioni del pilota per brusche variazioni di vento; queste ultime, infatti, a parte la turbolenza meccanica vera e propria, hanno effetto soprattutto sulla velocità dell'aereo relativa all'aria e quindi sulla portanza, con conseguenze tanto più vistose quanto maggiore è la massa dell'aeromobile. La situazione si rivela spesso critica in fase di decollo e di atterraggio, quando il velivolo è particolarmente vulnerabile a ogni variazione di velocità rispetto all'aria: in decollo, fintanto che non si è raggiunto un tranquillizzante margine nella velocità rispetto all'aria nei confronti della velocità di stallo; in avvicinamento e in atterraggio, perché se lo shear inizia appena sopra il suolo si ha un difetto di potenza e la tendenza ad atterrare ‛corto', mentre se esso inizia in quota e cessa appena sopra il suolo c'è un eccesso di potenza e la probabilità di un atterraggio ‛lungo': non sempre purtroppo c'è il tempo di eseguire le correzioni di spinta necessarie a evitare l'impatto fuori zona o a ‛riattaccare' per ritentare nuovamente la manovra. Promosse dall'OMM e dall'ICAO (International Civil Aviation Organization), ricerche sul problema dello shear del vento sono in corso in numerosi paesi; la peculiarità dell'approccio moderno a questo tipo d'indagini sta nell'usare contemporaneamente diversi tipi di strumentazioni (convenzionali, radar, rivelatori ottici e acustici, microbarografi, ecc.) in modo da osservare il fenomeno nel modo più completo possibile, sia per capirne i meccanismi, che, soprattutto in una prima fase, per escogitare un sistema di allarme per il pilota, da usarsi allorché il meteorologo venga a riscontrare condizioni atmosferiche favorevoli allo sviluppo di shear intensi o quando riesca a rivelare la reale presenza di questi.

Va infine sottolineata l'importanza assunta dagli studi sull'interazione atmosfera-oceano, sia come progresso delle conoscenze sullo strato di confine planetario, che nell'aspetto più generale dello scambio di proprietà termiche e dinamiche e di materia (si pensi all'evaporazione sugli oceani, che in media raggiunge i 2 m all'anno sui mari tropicali; v. acqua) all'interno del sistema Terra-atmosfera: ricerche meteorologiche e oceanografiche si fondono nel tentativo di individuare gli effetti dell'influenza reciproca su piccola e grande scala, sia sul tempo osservato che sul clima.

c) L'inquinamento atmosferico

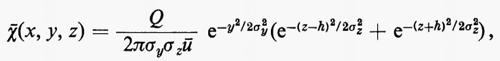

Lo studio delle proprietà dispersive dell'atmosfera si è fatto pressante in questi ultimi anni, in concomitanza con il rapidissimo progresso tecnologico e con l'espandersi della popolazione mondiale. Le caratteristiche termiche e dinamiche dello strato di confine planetario sono elementi di primo piano nella valutazione delle proprietà diffusive dei bassi strati atmosferici nei riguardi degli elementi inquinanti che in essi vengono rilasciati come conseguenza delle attività umane sulla superficie terrestre. Le teorie e i risultati sperimentali delle ricerche sullo strato di confine planetario vengono perciò estese al problema della concentrazione di inquinanti su una certa area in funzione delle sorgenti di emissione degli stessi; per ovvi motivi d'interesse economico e sociale, l'attenzione degli studiosi è particolarmente rivolta alla distribuzione degli inquinanti sulle aree urbane, talché si parla di ‛micrometeorologia urbana' come settore di meteorologia applicata. La complessità della fenomenologia relativa all'inquinamento artificiale in superficie ha indotto gli scienziati a impostare dei modelli numerici simulanti le proprietà dell'atmosfera nello strato di confine, per introdurvi poi, con opportune tecniche matematiche, le sorgenti inquinanti, valutarne le capacità contaminanti e studiare la dispersione dell'atmosfera. Nella variabilità e complessità delle situazioni naturali e artificiali di terreno e di ambiente, è chiaro che la soluzione matematica semplice e universale non può esistere, nè le applicazioni reali la pretendono. Peraltro, con le necessarie approssimazioni grossolane, si sono dimostrati molto utili in pratica i modelli di tipo gaussiano basati sulla teoria statistica applicata a condizioni omogenee e isotrope: si fa cioè l'ipotesi che sottovento a una sorgente puntiforme la concentrazione media del pennacchio di fumo su un piano trasversale alla direzione del vento abbia una distribuzione simile a quella gaussiana normale; ciò impone condizioni molto restrittive per l'atmosfera: presenza continua di ventilazione e costanza nel tempo e nello spazio della turbolenza e del vento. L'equazione classica dei modelli gaussiani per una sorgente puntiforme continua è del tipo (v. Gifford, 1968):

dove χ-(x, y, z) è la concentrazione media d'inquinante nel punto di coordinate x, y, z, Q l'intensità della sorgente supposta continua, ù l'intensità media orizzontale del vento, h l'altezza della sorgente rispetto al suolo, σy e σz, le deviazioni standard nella distribuzione della concentrazione rispettivamente nella direzione traversa al vento e in quella verticale. La stabilità dell'atmosfera entra nei modelli gaussiani soltanto attraverso i coefficienti σy e σz, i quali sono calcolati in funzione delle diverse categorie di stabilità verticale proposte da Pasquill nel 1951, le quali sono, a loro volta, connesse con la turbolenza del vento in superficie, il gradiente termico verticale, l'intensità della radiazione solare e la copertura nuvolosa; è evidente, comunque, la scarsa flessibilità dei modelli gaussiani nel rappresentare le reali condizioni di un'atmosfera urbana.

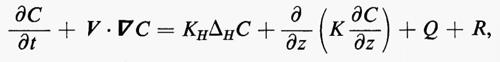

Per tenere in maggior conto il fatto che la turbolenza atmosferica e lo stato della superficie sottostante sono i fattori che più caratterizzano i processi di diffusione, si stanno mettendo a punto sofisticati modelli numerici che descrivono le concentrazioni degli effluenti nello spazio e nel tempo t in funzione dei parametri caratteristici dello strato di confine planetario. L'equazione che governa la concentrazione è basata sulle leggi di conservazione ed è del tipo seguente (v. Shir e Shiem, 1974):