Morbosita

Morbosità

Definizione e valutazione della morbosità

La morbosità esprime il rapporto fra il numero di ammalati e la popolazione. Questo rapporto viene studiato come uno degli indicatori dello stato di salute, e viene utilizzato come una guida per l'azione sanitaria. Solitamente la morbosità viene valutata per singole malattie (per esempio influenza, diabete, malaria, ecc.), oppure per gruppi di malattie che abbiano cause simili (per esempio malattie infettive, malattie tumorali, ecc.), oppure secondo i quadri clinici (per esempio broncopolmoniti, gastroenteriti, ecc.).

Da qualche tempo si usa distinguere, per esprimere meglio l'andamento temporale delle malattie, la morbosità incidente, che comprende i nuovi casi accertati nella popolazione, dalla morbosità prevalente, che si riferisce al numero totale dei casi, nuovi e vecchi, esistenti in un determinato periodo.L'indice di morbosità, che in molti casi è utile per definire l'andamento delle malattie e per orientare la prevenzione e le terapie, costituisce però una misura piuttosto grezza. I motivi sono diversi:

a) molte malattie, comprese quelle di carattere infettivo che sono soggette a denunzia obbligatoria, sfuggono alla rilevazione statistica e sono quindi sottostimate;

b) le conoscenze e i criteri diagnostici mutano nel tempo, e risulta pertanto difficile comparare la morbosità per malattie (come per esempio i tumori degli organi interni) che prima sfuggivano agli accertamenti, oppure per quadri clinici (molte malattie mentali, per esempio) suscettibili di classificazioni diverse;

c) il criterio seguito è solitamente quello del 'tutto o nulla' - la malattia c'è o non c'è -, che esclude una valutazione sia della gravità, sia del decorso e dei possibili esiti del processo morboso;

d) la constatazione della malattia è quasi sempre basata sull'oggettivazione dei sintomi da parte dei medici, prescindendo dal modo in cui il soggetto la vive e l'interpreta nel suo corpo, col suo comportamento e attraverso la sua cultura.

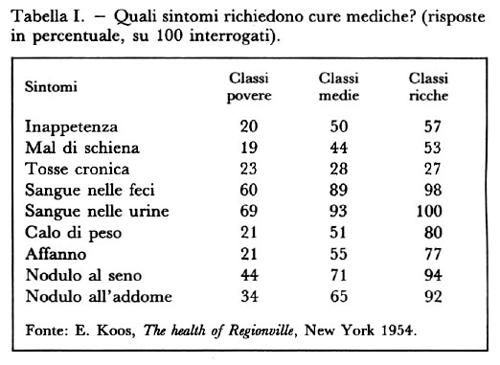

La differenza fra morbosità oggettiva e soggettiva balza in evidenza, per esempio, nella rilevazione delle assenze dal lavoro per causa di malattia. Gli indici di assenza sono estremamente variabili in rapporto non solo alle patologie lavorative ed extralavorative, ma anche allo stato delle relazioni industriali, alla percezione del rischio della disoccupazione, alle esigenze di guadagno, al livello e alla frequenza dei controlli. Si parla di assenteismo quando la certificazione di malattia è eccessiva rispetto alla morbosità reale, ma si potrebbe anche parlare di 'presenteismo' quando vi sono lavoratori che si recano al lavoro pur se sofferenti, per necessità o per timore.La differenza fra oggettività e soggettività emerge anche quando si rivolge a diversi gruppi di persone la domanda: quali disturbi ritenete che siano da considerare vere e proprie malattie, per le quali bisogna ricorrere alle cure mediche? Come risulta evidente dalla tab. I, le risposte sono fortemente influenzate da fattori sociali e culturali come il grado delle conoscenze, la capacità di percezione del proprio corpo, l'abitudine e la possibilità di consultare i medici.

Indicatori di salute e di rischio

Malgrado questi limiti, la valutazione della morbosità è utilissima per svelare la presenza e l'andamento delle singole malattie - siano esse sporadiche, endemiche o epidemiche - come pure per attuare tempestivamente misure di prevenzione e per organizzare in modo razionale i servizi sanitari in funzione del quadro nosologico della popolazione. Come indicatore delle condizioni sanitarie e sociali di una comunità, invece, la misura della morbosità deve essere integrata con altri dati. Una delle ragioni deriva proprio dai progressi compiuti dalla medicina nel corso di questo secolo. Oggi le cure consentono una lunga sopravvivenza a molte persone affette da malattie croniche, anche gravi. Diminuisce pertanto la mortalità, ma cresce per accumulo nel tempo la morbosità prevalente per tali malattie, senza che ciò possa essere interpretato come un fenomeno che ha una connotazione soltanto negativa.Ma la ragione principale per cui si ricorre anche ad altri indicatori è che la salute non è più considerata soltanto in negativo, come assenza di malattia. Nell'ultimo quarto di secolo, "con l'ampliarsi e il precisarsi del concetto di salute, come condizione dipendente dall'interagire di numerosissimi fattori e variabili di natura eterogenea, e come determinazione del benessere degli individui e delle popolazioni" (v. Vanini e Calamo Specchia, 1990), si sono moltiplicati i tentativi di misurare gli indicatori positivi della salute, e non solo quelli negativi come la presenza delle malattie.

Tali indicatori, che possono essere basati su criteri molto diversi, valutano soprattutto:

a) il raggiungimento o meno di quegli standard di normalità dei vari organi e apparati che siano considerati fisiologici per gli individui appartenenti a una popolazione omogenea e ben definita;

b) le capacità di espletare attività, compiti e funzioni, in modo tale da poter far fronte in maniera autonoma sia alle esigenze della vita quotidiana, sia all'assolvimento degli incarichi che vengono personalmente scelti o attribuiti da altri;

c) la percezione soggettiva di una condizione di benessere (cenestesi positiva) anziché di malessere (cenestesi negativa).

Questa valutazione può comprendere l'autopercezione della salute, l'atteggiamento verso le proprie condizioni passate, presenti e future, e anche la suscettibilità, l'accettazione, l'ansietà collegate alle malattie.Per molte di queste valutazioni sono stati proposti metodi di misurazione basati su indagini soggettive. Cito, a solo titolo di esempio, l'indice SIP (Sick Impact Profile, profilo di impatto morboso) di Bergner, che è basato sulle risposte scelte dagli intervistati tra 235 opzioni possibili, raggruppate per i seguenti ambiti di attività e di preferenze: locomozione, sonno, nutrizione, igiene personale, attività domestica, movimenti del corpo, mobilità, funzioni mentali, piaceri, emozioni, vita familiare, comunicazioni, attività sociali. In altri casi si è fatto ricorso, per iniziativa dell'Organizzazione Mondiale della Sanità (v. WHO, 1979 e 1987), a metodi di valutazione dello stato di salute degli individui che, oltre a fotografare la situazione, potessero servire da guida per la programmazione dei servizi. Molti sociologi, tuttavia, hanno sottolineato che la salute di una popolazione non è soltanto la somma delle condizioni individuali, e che la definizione stessa di salute è fortemente influenzata da fattori di natura sociale (v. Lerner, 1973).Ancora più discussa, anche dal punto di vista etico, è la tendenza a valutare sul piano quantitativo la 'qualità della vita'. Essa può essere legittimamente oggetto di misure, anche se sono difficilmente comparabili fra un paese e un altro i valori che vengono assunti come indici di partenza.

Da qualche tempo però si cerca di sostituire al calcolo della life expectancy (anni che costituiscono la speranza di vita alla nascita), che è uno dei pochi indicatori certi del benessere, una valutazione basata sui QALY (Quality Adjusted Life Years, anni di vita ponderati secondo la loro qualità). Questa valutazione è legittima e spetta in primo luogo a ogni singola persona, che può esprimerla a suo modo, come fece Denis Diderot, ormai anziano, in una lettera a Sophie Volland, nella quale prevedeva di avere all'incirca dieci anni da vivere, dei quali però "le flussioni, i reumatismi e il resto di questa scomoda famiglia ne prenderanno due o tre". Bisogna però evitare che sulla base del calcolo dei QALY si arrivi a concludere che, per esempio, un anno di vita in piena salute vale più di due o tre anni vissuti in condizioni di malattia o di inabilità, e che perciò è preferibile riservare le scarse risorse disponibili per le cure alle persone in piena efficienza e trascurare i deboli; si correrebbe in tal modo il rischio, non solo teorico, di introdurre nell'assistenza e nella convivenza civile criteri arbitrari e discriminatori.Un campo di grande interesse, che si sta sviluppando a integrazione dello studio della morbosità e degli indicatori di salute, è la ricerca volta alla previsione della morbosità futura. Questa comprende ovviamente le analisi demografiche, perché la struttura e i movimenti della popolazione influenzano notevolmente i quozienti di morbosità.

Si deve però ricordare che un grande demografo, Alfred Sauvy, sosteneva ironicamente che le previsioni a lungo termine sulla popolazione hanno di certo una sola cosa: quanto ne rideranno i posteri nel leggerle. Malgrado questo scetticismo, le previsioni a breve e medio termine sono ormai non solo possibili, ma abbastanza realistiche, e perciò meritevoli di attenzione. Questa non c'è stata, per esempio, per la prevista crescita esponenziale della popolazione anziana, che presenta indici e fattori di morbosità differenti da quelli di altre età. In molti paesi, compresa l'Italia, si è continuato irresponsabilmente a costruire ospedali pediatrici e a trascurare non solo i ricoveri geriatrici, ma l'assistenza domiciliare alle persone anziane, ben più efficace e umana.Un altro dato previsionale, utile per adottare le necessarie misure di prevenzione, è l'analisi delle 'malattie evitabili'. La Comunità Europea ha pubblicato un Atlante delle morti evitabili (v. EEC, 1991²), nei cui cartogrammi ha raffigurato i vari paesi, a partire da quelli che avevano, per ciascuna malattia, gli indici di morbosità più bassi fino a quelli che li avevano più alti, allo scopo di sollecitare misure efficaci di riduzione delle malattie considerate in eccedenza. Un altro sistema rivolto alla conoscenza delle 'malattie evitabili', certamente più scientifico del precedente, consiste nell'individuazione degli 'eventi sentinella'. Vengono così definiti quei casi di malattia, inabilità o morte precoce che non avrebbero dovuto verificarsi se l'insieme delle conoscenze, delle attrezzature e dei servizi già oggi disponibili avesse funzionato a dovere.

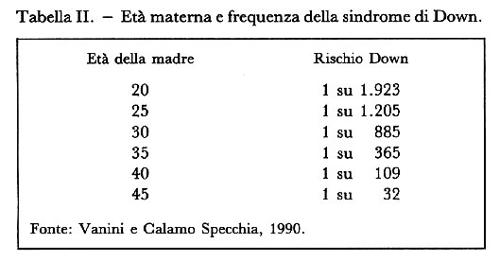

Si può citare come esempio la circoscritta e breve epidemia di colera che nel 1973 colpì Napoli, Bari e Cagliari. L'arrivo del vibrione nel nostro paese dal Medioriente era previsto, ma le autorità sanitarie intervennero tardivamente. Quando la malattia si manifestò, il colera fu considerato l'evento sentinella che segnalava le pessime condizioni delle fognature e dell'approvvigionamento idrico nelle tre città, cioè proprio quelle condizioni che favoriscono la diffusione di molte malattie - come le gastroenteriti e l'epatite A - trasmesse per via oro-fecale, che erano (e sono ancora) endemiche in quelle aree.Sempre nel campo previsionale siamo ora in grado di valutare, per moltissime malattie, i rischi personali e collettivi che si corrono a causa di determinate situazioni o comportamenti. L'esempio più semplice, relativo al rischio personale, è quello della probabilità di generare figli affetti dalla sindrome di Down, che è statisticamente collegata all'età della madre (v. tab. II).

Altri esempi si possono trarre dall'analisi del rapporto più o meno diretto esistente fra i tumori polmonari e l'abitudine al fumo, oppure fra l'infarto del miocardio e il colesterolo ematico (v. Figà Talamanca, 1981). Ma i rischi individuali sono spesso collegati a situazioni specifiche di una determinata comunità lavorativa o residenziale, o anche di ambiti territoriali più vasti, che accrescono la morbosità collettiva. Nell'attività industriale, per esempio, i fattori di rischio sono collegati al microclima, alle sostanze presenti nel ciclo produttivo, alle condizioni ergonomiche, organizzative e psicosociali del lavoro. Nell'ambiente di vita possono esservi agenti biologici di malattia (virus, microbi e parassiti), come pure fonti di inquinamento dell'aria, delle acque e del suolo. È stata constatata ad esempio una correlazione fra la morbosità per bronchiti croniche e la presenza di contaminanti atmosferici nelle città.

Interpretazioni della malattia

Una delle difficoltà nello studio e nell'interpretazione dei dati sulla morbosità, come già accennato, è di carattere concettuale. Le singole malattie, con i loro nomi ormai consolidati nella dottrina, sembrano corrispondere oggi a fattori causali, segni e sintomi, decorso ed esiti molto ben definiti. Ma le denominazioni e le classificazioni delle malattie evolvono nel tempo, in rapporto alle scoperte scientifiche. Una vera rivoluzione delle parole e dei concetti della medicina si produsse a cavallo fra il XIX e il XX secolo, quando la conoscenza del mondo microbico rese desueti molti nomi generici di malattie, come per esempio le innumerevoli febbri di incerta natura. Chi consulta un vecchio dizionario medico (v. ad esempio Buonsanti e Pini, 1875) può facilmente constatare che solo le febbri il cui nome iniziava con la lettera A comprendevano, insieme a pochi quadri clinici precisi (come la febbre aftosa), le fumose categorie di febbre adinamica, adinamico-atassica, agripnode (quella che priva del sonno i pazienti), algida, amfimerina, anomala, ardente, asode (provocante disgusto e nausea), astenica, atassica e atasso-dinamica. Un'altra rivoluzione delle parole, dei concetti e della classificazione delle malattie, solo per ora meno sconvolgente, è cominciata da pochi decenni in seguito alle scoperte della biologia molecolare.

Ma soprattutto è la malattia in quanto tale, è quel continuum che esiste quasi sempre fra salute e malattia a essere oggetto di molte interpretazioni. Limiteremo gli esempi, per illustrare questa constatazione, a quelli tratti da illustri enciclopedie. Si deve partire naturalmente dalla Encyclopédie di Diderot e d'Alembert, antesignana di tutte le enciclopedie, la quale definisce la malattia come "la condizione dell'animale vivente che non gode di salute; è la vita fisica in uno stato di imperfezione". Ma poi riconosce che bisognerebbe allora definire la salute e la perfezione, e conclude, basandosi sul buon senso, che tutto sommato la parola malattia è ben compresa da tutti. Si può continuare con la Encyclopaedia Britannica, che considera la malattia come "l'allontanamento dalla normale condizione fisiologica di un organismo vivente, sufficiente a produrre percepibili segni o sintomi": essa collega cioè la malattia alla fluttuante idea di normalità, e alla visibilità che possono averne sia il soggetto, sia il medico. La Bolsciaja Sovetskaja Enciklopedija parla della malattia come di un processo prodotto da fattori dell'ambiente esterno o interno, i quali suscitano una conseguente reazione dell'organismo; ma introduce anche l'idea produttivistica (e non sempre esatta) che essa comporta "la riduzione della capacità di lavoro". La Encyclopedia Americana, infine, definisce la malattia come "difetto o assenza di agio, condizione di disagio o dolore", con un'interpretazione che è tutta soggettiva, e col rischio di trasformare ogni difficoltà in motivo o pretesto di intervento medico.Nella letteratura scientifico-sociologica il concetto di malattia e il processo dinamico salute-malattia sono stati oggetto di molte analisi (v. Canguilhem, 1966; v. Ongaro Basaglia, 1982; v. Berlinguer, 1984; v. Gourevitch, 1992). Dal punto di vista delle scienze sociali, piuttosto che ricorrere a interpretazioni ontologiche può essere preferibile osservare come la malattia viene compresa e vissuta, e quali indicazioni operative derivano dai suoi vari significati, raggruppabili intorno a cinque parole chiave: sofferenza, diversità, pericolo, segnale, stimolo.

1. Sofferenza. La malattia è quasi sempre una sofferenza personale. Anche quando non comporta dolore, la perdita di salute diviene spesso perdita di efficienza, di dignità e di potere, soprattutto nelle società in cui è più rilevante il ruolo giocato dalla competizione. All'idea che il malato sia innanzitutto da considerare come un sofferente da assistere si oppone però un'altra concezione: che egli sia colpevole della malattia, che meriti quella sorte, e che perciò sia piuttosto da punire o da segregare. L'idea di colpa associata alla malattia è radicata nella storia, e riemerge ogni volta che nuove patologie risvegliano antiche paure. Anche la comparsa dell'AIDS, almeno all'inizio, è stata dominata dal victim blaming (biasimo delle vittime).

2. Diversità. La malattia viene spesso interpretata come diversità, deviazione rispetto a una norma. Ma che tipo di norma? Norma biologica? In questo caso però il campo di variazioni è un continuum, e può prevalere la tendenza a medicalizzare piccoli scostamenti dalla normalità. Norma sociale? Questa però può essere arbitraria, come la tendenza a selezionare la manodopera da assumere in base al sesso o a caratteristiche psicologiche o genetiche che non abbiano attinenza con l'idoneità lavorativa. Sul piano operativo c'è in questo campo una triplice esigenza: riconoscere come un fatto, anzi come un valore, l'esistenza delle diversità; ridimensionare le diagnosi di anormalità fisica e di devianza mentale, evitando che le opinioni e i pregiudizi prevalgano sui dati obiettivi; ampliare invece gli accertamenti e gli interventi correttivi, ma soltanto nei casi in cui lo scostamento dalla zona di equilibrio possa divenire chiaramente patologico.

3. Pericolo. L'idea che la malattia sia un pericolo, non solo per chi ne è affetto, ma per la società dei sani, ha un riscontro nella realtà almeno in due casi: le malattie infettive e le droghe. Nel primo, la storia insegna che al fine di prevenire il contagio si sono rivelati efficaci obblighi collettivi come le vaccinazioni, o anche limitazioni della libertà dei singoli, come la contumacia e le quarantene. Ma spesso queste misure hanno travalicato lo scopo. Un esempio tipico è la costruzione dei lebbrosari, e la loro successiva trasformazione quando la lebbra divenne meno frequente: prima molti di essi divennero sifilocomi, e poi ricoveri per i malati di mente. Nel caso delle droghe, è vero che i tossicodipendenti possono spingere altri al consumo, sia perché vendono essi stessi la merce, sia perché inducono l'imitazione. Ma l'esperienza ha dimostrato che nei loro confronti la solidarietà è più efficace della repressione, anche al fine di prevenire la diffusione del consumo.

4. Segnale. Le malattie possono costituire un segnale d'allarme e una sollecitazione alla collettività, in particolare quando il processo morboso di un individuo si ripete in altri soggetti che lavorano o vivono in ambienti simili, o che hanno comportamenti personali analoghi. Quando la malattia ha un'origine biologica e minaccia tutta la popolazione, questo segnale è facilmente percepito e diffuso. Ma quando la malattia ha un'origine antropogena, per esempio è conseguenza di fattori lavorativi e colpisce gruppi ristretti e subalterni della popolazione, spesso il segnale è ignorato, soffocato o distorto, anche perché la rimozione delle cause morbigene implicherebbe non solo atti medici, ma trasformazioni sociali e produttive ben più impegnative. Lo studio della morbosità tende appunto a captare, amplificare, trasmettere questi segnali, perché le malattie di massa, come diceva Rudolf Virchow, costituiscono "grandi segnali di avvertimento, dai quali il vero uomo di Stato può capire che l'evoluzione della sua nazione è stata disturbata, fino a un punto che neppure la politica più miope può ignorarlo".5. Stimolo. L'idea che la malattia possa anche essere uno stimolo è la più difficile da accettare, perché spesso essa si presenta e viene interpretata come antitesi globale della vita, mentre dovrebbe essere considerata una componente (in negativo) dei processi vitali. Nella storia della scienza, però, lo studio dei fenomeni patologici ha preceduto e stimolato in molti casi la conoscenza del corpo e della psiche dell'uomo 'normale'. E nella storia della solidarietà umana è proprio partendo dall'azione a favore dei malati che si sono affermate importanti correnti religiose e politiche. È stato sostenuto, per esempio (v. McNeill, 1976), che il cristianesimo si affermò sul paganesimo anche perché, nei secoli in cui il mondo era sconvolto dalle epidemie, esso si presentò come riferimento morale e assistenziale alle popolazioni incerte e disperate; lo stesso movimento operaio nacque in molti paesi come filiazione delle società di mutuo soccorso, e fra le ragioni che determinarono la sua affermazione vi fu la volontà di sollecitare il diritto all'assistenza per tutti.

La transizione epidemiologica

Lo studio dell'andamento della morbosità nel tempo, come quello della mortalità per cause, mostra chiaramente la storicità delle malattie. Anche se è raro che compaiano nuovi quadri clinici, i processi morbosi che si manifestano come fenomeni collettivi variano molto secondo le epoche, secondo le aree del mondo, secondo i gruppi sociali che ne sono colpiti. Le malattie, che nella nostra specie non si presentano mai come fenomeni puramente biologici, costituiscono perciò uno degli specchi più fedeli del modo in cui gli esseri umani entrano in rapporto con la natura (di cui sono parte) attraverso il lavoro, la tecnica e la cultura. La storicità è dimostrata dal fatto che nel tempo alcune malattie diventano meno frequenti, e possono perfino scomparire. Così è accaduto per il vaiolo, il cui virus è ora conservato soltanto in pochissimi laboratori per esclusive finalità scientifiche, non essendo più stati registrati casi nel mondo, fin dal 1977, grazie all'efficacia delle vaccinazioni. Così è accaduto per il saturnismo (intossicazione da piombo), che un tempo era la più frequente patologia professionale dei tipografi, e che è quasi scomparso in seguito alle nuove tecnologie di composizione e di stampa; ma ora, soprattutto a causa dell'inquinamento atmosferico dovuto ai gas di scarico delle automobili, l'intossicazione da piombo ha assunto carattere ambientale.

Malattie che scompaiono, altre che sopravvengono. A volte ciò accade a causa delle mutazioni dei virus e dei microbi; ma più spesso a causa di cambiamenti che avvengono nelle condizioni umane: lavoro, abitazione, nutrizione, comportamenti, migrazioni, avvenimenti politici, guerre e invasioni, conquiste scientifiche e progressi sociali. La comparsa dell'AIDS, dopo un lungo periodo nel quale si erano manifestate ben poche malattie nuove, ha ribadito che anche in questo campo non siamo alla fine della storia. Essa ha attirato l'attenzione sul fenomeno delle malattie emergenti.

Sotto questa dizione si raggruppano non soltanto le malattie dovute a germi che non avevano mai prodotto manifestazioni patologiche, ma anche altre malattie: quelle che i medici non avevano saputo interpretare come entità nosologiche autonome; quelle dovute a germi che hanno subito nel tempo una particolare virulentazione; quelle che si sono trasmesse per la prima volta dagli animali all'uomo; quelle che si sono trasferite da una parte all'altra del mondo. Ciò è accaduto su scala amplissima dopo il 1492, quando dall'Eurasia all'America furono portati il vaiolo e il morbillo, dall'Africa all'America la febbre gialla, e dall'America pervenne quasi sicuramente nel Vecchio Mondo la sifilide.

Dopo quell'evento, che nel campo della morbosità può essere considerato come l'unificazione microbica del mondo, bisogna giungere al nostro secolo per trovare un altro mutamento radicale nella distribuzione delle malattie. Esso viene definito transizione epidemiologica, e consiste fondamentalmente nel passaggio dalla prevalenza delle malattie infettive, che avevano sempre dominato sia la patologia umana, sia la patologia degli altri viventi, alla prevalenza, nella specie umana, delle malattie che vengono definite cronico-degenerative. Questo fenomeno è comparso già alla fine del XIX secolo, ha avuto un'accelerazione dopo la seconda guerra mondiale, ed è tuttora in corso in tutti i continenti, con intensità maggiore o minore secondo i paesi.

Il declino della mortalità (e in misura minore della morbosità) per malattie infettive è dovuto alla scoperta dei loro agenti eziologici, all'introduzione di misure profilattiche come le vaccinazioni, e ai risultati terapeutici ottenuti prima coi sulfamidici, e poi, in maggior misura, con gli antibiotici. Ma in molti casi questo declino ha preceduto nel tempo il progresso medico. L'esempio più tipico è l'andamento della tubercolosi negli ultimi due secoli. Il microbo che causa la malattia ha accompagnato l'uomo da sempre, o almeno da quando l'addomesticamento degli animali favorì il suo passaggio dai bovini alla nostra specie. Ma solo nel XIX secolo la tubercolosi divenne la malattia sociale per eccellenza, perché l'avvio della rivoluzione industriale tolse i lavoratori dalle campagne, li portò a vivere in abitazioni affollate e buie, spinse i fanciulli denutriti a lavorare anche di notte sottraendoli all'aria aperta e al riposo. La malattia cominciò a declinare quando queste condizioni mutarono, molto prima della scoperta dell'agente eziologico e di efficaci terapie. Nell'ultimo decennio, purtroppo, la morbosità per tubercolosi ha mostrato nuovamente una tendenza all'aumento: sia per l'accentuazione dei fenomeni di marginalità e di povertà urbana, sia perché il microbo si moltiplica facilmente nei soggetti immunodepressi per AIDS, sia infine per la comparsa di ceppi microbici resistenti alle terapie antibiotiche.

La riduzione nel numero e nella letalità delle malattie infettive rappresenta comunque uno dei progressi maggiori compiuti dall'umanità nel corso del XX secolo, anche se la sua portata è purtroppo limitata, come vedremo, dalla persistenza e in qualche caso dall'aumento di queste malattie nei paesi sottosviluppati.

L'aspetto per molti versi negativo della transizione epidemiologica è il consistente aumento delle malattie che vengono definite (con un termine alquanto impreciso) cronico-degenerative o, meglio, non infettive (v. Checcacci e altri, 1992). Esse comprendono fondamentalmente le cardiopatie ischemiche (infarto), le ischemie cerebrali (ictus), il diabete e altre malattie del metabolismo, i tumori e le broncopneumopatie croniche di tipo ostruttivo. Questo aumento è in parte apparente, in parte reale. L'aumento apparente è dovuto al fatto che la riduzione delle nascite e più ancora il prolungamento della speranza media di vita, che all'inizio del secolo era in Italia di 45 anni e ora di quasi 80, hanno posto in primo piano le malattie tipiche dell'età avanzata e dell'età senile. Queste erano sempre state presenti nelle società umane, ma la loro evidenza era rimasta mascherata sia dalla prevalenza delle età infantili e giovanili nella popolazione, sia dall'elevata mortalità per malattie infettive. Gran parte della popolazione non viveva abbastanza a lungo, in altre parole, per avere la possibilità di morire, una volta giunta all'età adulta o anziana, a causa di un infarto o di un tumore.Ma esiste anche un aumento reale. Ne sono testimonianza, per esempio, la frequenza dell'infarto in età ancora giovane e l'abbassamento dell'età in cui compaiono i tumori polmonari. L'aliquota di aumento reale è dovuta sia a fattori nocivi presenti negli ambienti di vita e di lavoro, sia a fattori comportamentali, come la malnutrizione, il fumo di tabacco, l'abuso degli alcolici, la sedentarietà, il sovraconsumo di tutto, gli stress di una vita sempre più competitiva. Queste malattie, a differenza di quelle infettive, raramente sono guaribili; spesso anzi sono invalidanti. Rappresentano perciò un carico di sofferenze, di costi umani e di spese che potrebbe essere notevolmente attenuato, in molti casi, attraverso misure preventive. Già ora si è dimostrata possibile la riduzione di alcuni tumori, come quelli della sfera genitale femminile, e dell'infarto del miocardio, in quest'ultimo caso principalmente con l'adozione di comportamenti più sani.

Il quadro nosologico

La transizione epidemiologica ha implicato un mutamento sostanziale sia del tipo, sia della distribuzione geografica delle malattie prevalenti. Nel passato hanno dominato la scena le malattie fisiogene, derivanti da cause prevalentemente naturali: malattie infettive, climatiche, carenziali, che vedevano l'uomo come oggetto passivo o come agente secondario rispetto ai fattori presenti nell'ambiente esterno. Nel presente gran parte delle malattie sono invece antropogene (v. Berlinguer, 1973), derivano cioè in modo prevalente, anche se non esclusivo, dai mutamenti indotti dall'azione umana. Se è vero che le malattie esprimono la rottura di un equilibrio, il mutamento di cui siamo partecipi consiste nel fatto che, mentre nel passato esse hanno segnalato uno squilibrio fra l'uomo e l'ambiente esterno naturale, oggi segnalano soprattutto uno squilibrio nei rapporti fra uomo e uomo, cioè nelle relazioni sociali.Ma oltre alla causalità generale, muta anche il modello delle patologie prevalenti.

Le malattie infettive hanno solitamente queste caratteristiche:

a) sono acute, in quanto insorgono per lo più improvvisamente;

b) sono monocausali, derivano cioè ciascuna da un germe specifico, anche se ovviamente la sua azione può essere facilitata oppure ostacolata da condizioni ambientali; c) sono reversibili, perché quando guariscono lasciano l'organismo sostanzialmente integro.

Le malattie cronico-degenerative invece:

a) sono appunto croniche, hanno cioè una evoluzione lenta;

b) sono multicausali, perché sulla loro insorgenza influiscono fattori genetici, fisici, chimici e comportamentali, nessuno dei quali è solitamente sufficiente a indurre di per sé la malattia;

c) sono irreversibili, perché raramente è possibile la completa guarigione, e le cure valgono soltanto a rallentare il decorso e a mitigare i danni.

Anche se espresse in modo schematico, e anche se le caratteristiche enunciate presentano molte eccezioni (fra le malattie infettive l'AIDS, per esempio, insorge in modo lento; nell'ambito delle malattie cronico-degenerative esistono oggi tumori reversibili e guaribili), queste differenze hanno profonde implicazioni operative. Esse impongono "una scelta da fare in relazione alla strategia più opportuna per arginare la patologia oggi prevalente, e aumentare la durata e soprattutto la qualità della vita umana. Per attuare opere di prevenzione è necessario intervenire non con misure terapeutiche su fenomeni prettamente biologici, ma fornire conoscenze e strumenti tecnici che interagiscono con l'organizzazione complessiva della società" (v. Buiatti e altri, 1993).

L'altro aspetto che muta è la distribuzione geografica delle malattie. Un tempo le differenze erano determinate principalmente dal clima, dall'ambiente naturale, dalle abitudini alimentari. Alcune malattie erano tipiche di poche zone del mondo; è questo il caso, ad esempio, del colera - presente in India - e di un tipo di verminosi, la schistosomiasi da Schistosoma haematobium, un'infezione caratteristica dell'Africa e della valle del Nilo. Noto per inciso che un ramo recente e promettente della medicina e dell'antropologia, la paleopatologia, mira ora a riconoscere le malattie presenti nella storia della specie umana fin dalle sue origini. Nei resti ossei degli Ominidi, per esempio, si trovano segni patognomonici di tumori e di infezioni dell'epoca, e nelle antiche mummie egiziane sono state trovate le uova delle stesse specie di schistosomi che esistono oggi.

Altre malattie, come la malaria, si trovavano a tutte le latitudini, dalle zone temperate a quelle equatoriali e tropicali, purché nella zona vi fossero acque stagnanti e zanzare Anopheles atte a trasmettere il plasmodio; le gastroenteriti batteriche e parassitarie dell'infanzia erano quasi ubiquitarie.La distribuzione delle malattie continua ora a essere influenzata dai fattori naturali; ma essa è stata soprattutto modificata dalla storia, che ha prodotto una diversificazione profonda del quadro nosologico dei vari paesi in base al loro reddito, al livello di istruzione, alle condizioni di lavoro, all'efficacia dei servizi sanitari. L'esempio più tipico è quello della malaria, che negli anni successivi alla seconda guerra mondiale è stata non solo circoscritta, ma eradicata da tutti i paesi sviluppati; essa è quasi scomparsa anche in Cina ed è stata ridotta in altre nazioni dell'Asia, mentre è ora più diffusa di prima in Africa, dove causa ogni anno due milioni di morti (v. Clyde, 1987). Come l'eradicazione del vaiolo rappresenta il maggior successo dell'azione internazionale in favore della salute e dell'iniziativa dell'OMS, così la lotta antimalarica ne rappresenta il maggiore fallimento. La ragione sta nel fatto che per il vaiolo, una malattia che si trasmetteva soltanto da uomo a uomo, era disponibile un''arma assoluta', il vaccino, che fu adoperata ovunque in un clima di universale solidarietà; invece per la malaria, come per altre malattie infettive che hanno un ciclo più complesso e che sono ampiamente influenzate dalle condizioni ambientali e sociali, l'esperienza fu diversa: l'arma assoluta, che negli anni sessanta fu identificata nel DDT, si rivelò inefficace, le necessarie trasformazioni sociali e culturali furono ostacolate, la solidarietà internazionale si attenuò, e fallì per questo non solo la prevista eradicazione, ma anche il controllo della malattia.

Si è venuto così delineando un quadro nosologico molto differenziato. La transizione epidemiologica, che si è compiuta nei paesi sviluppati, è ancora lenta a procedere in quelli in via di sviluppo: nelle aree più povere del mondo dominano ancora le malattie infettive, verso le quali esistono oggi efficaci mezzi di prevenzione e di cura che in gran parte però non sono utilizzati.

Morbosità, equità, eticità

L'aggiornamento dei dati nosologici (v. World Bank, 1993) mostra che persiste un forte divario nella distribuzione delle malattie nel mondo. Anche se vi sono stati quasi ovunque un aumento della speranza di vita e una riduzione della mortalità infantile, quest'ultima è quasi dieci volte maggiore nei paesi poveri rispetto a quelli ricchi, prevalentemente a causa delle malattie enteriche e respiratorie, aggravate dalla denutrizione; inoltre la mortalità materna, dovuta a complicanze della gravidanza e del parto, è trenta volte più alta. Ma anche all'interno dei paesi sviluppati persistono notevoli differenze basate su fattori culturali e sociali. Una ricerca comparativa sulla mortalità negli Stati Uniti, compiuta nel 1960 e ripetuta con gli stessi criteri nel 1986 (v. Pappas e altri, 1993), ha mostrato che, pur essendo gli indicatori di salute globalmente migliorati, le differenze secondo la razza, il reddito e il grado di istruzione sono sensibilmente cresciute. Quelle correlate al titolo di studio sono cresciute, sia tra i bianchi che tra i neri, del 20 per cento per le femmine e del 100 per cento per i maschi. Nel nostro continente l'Ufficio europeo dell'OMS propose nel 1975 come primo obiettivo a tutti i paesi, nel quadro della campagna mondiale Salute per tutti nell'anno duemila, la riduzione, almeno del 25 per cento, delle differenze nel livello della salute dovute a squilibri sociali. Ma queste si sono invece accentuate, soprattutto a partire dalla seconda metà degli anni ottanta.

Oggi viene considerato probabile che, per molti indicatori di salute, nell'anno duemila vi possa essere il 25 per cento di aumento, anziché di riduzione, delle differenze.Sul piano individuale le differenze possono anche essere dovute alla variabilità naturale, oppure a comportamenti dannosi alla salute, che sono condizionati oppure scelti liberamente. Ma spesso esse sono collegate ai livelli di reddito e di istruzione, all'essere costretti o stimolati a comportamenti insalubri, alla maggiore esposizione a condizioni di lavoro e di vita stressanti, all'accesso inadeguato ai servizi sanitari essenziali. In tutti questi casi esiste una situazione di 'arbitrarietà morale' che priva i soggetti di un diritto fondamentale: mi riferisco non soltanto al diritto all'assistenza, che appartiene alla sfera dei diritti sociali, ma soprattutto al diritto alla salute, che rientra nel quadro dei diritti umani basilari. Esso è ormai uno dei 'diritti dei moderni', e si è imposto non solo come risultato di una generale maturazione delle coscienze, ma anche per la consapevolezza che vi sono concrete possibilità di tradurlo in realtà. Tali possibilità sono divenute reali soltanto recentemente, quando sono state acquisite le conoscenze e creati gli strumenti atti a ridurre la morbosità per moltissime delle malattie esistenti. Il fatto che l'umanità abbia le risorse per raggiungere tale obiettivo, e non riesca a realizzarlo, costituisce una delle principali sfide morali e pratiche che la nostra epoca deve affrontare. (V. anche Malattie; Sanità).

Bibliografia

Berlinguer, G., Medicina e politica, Bari 1973.

Berlinguer, G., La malattia, Roma 1984.

Buiatti, E., Carnevale, F., Geddes, M., Macciocco, G., Manuale di sanità pubblica, Firenze 1993.

Buonsanti, N.L., Pini, G., Dizionario delle scienze mediche e veterinarie, Milano 1875.

Canguilhem, G., Le normal et le pathologique, Paris 1966 (tr. it.: Il normale e il patologico. Norme e comportamenti patologici nella storia della medicina, Rimini 1975).

Checcacci, L., Meloni, C., Pelissero, G., Igiene, Milano 1992.

Clyde, D.F., Recent trends in the epidemiology and control of malaria, in "Epidemiological reviews", 1987, IX, pp. 219-243.

EEC (European Economic Community), European atlas of 'avoidable deaths', Oxford 1991².

Figà Talamanca, I., Elementi di epidemiologia, Roma 1981.

Gourevitch, M. (a cura di), Maladie et maladies. Histoire et conceptualisation, Genève 1992.

Lerner, M., Conceptualization of health and social well being, in Health status indexes (a cura di R.L. Berg), Chicago 1973.

McNeill, W.H., Plagues and peoples, New York 1976 (tr. it.: La peste nella storia. Epidemie, morbi e contagio dall'antichità all'età contemporanea, Torino 1981).

Ongaro Basaglia, F., Salute/Malattia. Le parole della medicina, Torino 1982.

Pappas, G., Queen, S., Hadden, W., Fisher, G., The increasing disparity in mortality between socioeconomic groups in the United States, 1960 and 1986, in "New England journal of medicine", 1993, CCCXXIX, 2.

Vanini, G., Calamo Specchia, F., Igiene e metodologia epidemiologica, Torino 1990.WHO (World Health Organization), Regional Office for Europe, Measurement of the levels of health, Copenhagen 1979.

WHO (World Health Organization), Regional Office for Europe, Measurement in health promotion and protection, Copenhagen 1987.

World Bank, World development report 1993: investing in health, Oxford 1993.