Natura e cultura nel linguaggio

Natura e cultura nel linguaggio

In questo saggio vengono discussi la struttura, le origini, lo sviluppo e le basi neuronali del linguaggio umano con una particolare attenzione all'antico dilemma natura-cultura. Il linguaggio umano si basa su capacità innate che non sono però specifiche solo del linguaggio e non sono localizzate in una singola zona del cervello; in particolare, si basa sui meccanismi dell'attenzione, della memoria e del relazionarsi sociale che, anche se in maniera meno sviluppata, erano presenti in altri primati prima che il linguaggio si evolvesse. Poiché il linguaggio si fonda su un'ampia serie di abilità, esso è localizzato in varie aree del cervello, non tutte però della stessa importanza. Quando alcune di esse vengono danneggiate nelle prime fasi di vita, possono emergere modalità alternative di organizzazione cerebrale. Particolare enfasi è posta sulle varietà del linguaggio: varietà strutturali testimoniate dalla quantità di lingue diffuse nel mondo, dalla velocità e dalla consequenzialità del loro sviluppo nei bambini, e, infine, dagli studi di visualizzazione dell'attività funzionale del cervello in vivo.

Introduzione

Il linguaggio è il coronamento delle conquiste della specie umana ed è una facoltà che normalmente tutti gli esseri umani possiedono. L'uomo medio non è né Shakespeare né Caravaggio, ma è comunque capace di produzione linguistica fluente, anche se non sa poetare o dipingere. Infatti, il parlante medio produce approssimativamente 150 parole al minuto che sceglie tra circa 20.000÷40.000 diverse alternative, con percentuali d'errore inferiori allo 0,1 %. Il bambino, in media, si avvicina considerevolmente a tale livello di produzione intorno ai 5 anni di età: in questo periodo il suo vocabolario conta più di 6000 parole e controlla quasi tutti gli aspetti del parlato e la grammatica della propria lingua.

Data la portata di tali risultati e la velocità con la quale li conseguiamo, alcuni teorici hanno sostenuto che la facoltà del linguaggio deve risiedere direttamente nel cervello umano ed è in grado di svilupparsi come un braccio o un rene. Secondo altri, invece, l'uomo è dotato di linguaggio perché ha un cervello potente capace di apprendere molte cose e perché è un animale straordinariamente sociale per il quale comunicare è più importante di qualsiasi altra cosa.

Il linguaggio è innato? Lo si apprende? Oppure, il linguaggio rinasce in ogni generazione in quanto rappresenta la migliore soluzione per i nostri problemi più importanti, problemi che soltanto gli esseri umani possono risolvere? Questi sono gli interrogativi su cui per secoli si sono confrontate le scienze che studiano il linguaggio. Essi rappresentano anche le varianti di un dibattito più generale sulla natura della mente e sul processo attraverso cui essa si costruisce nei bambini.

L'approccio innatista è basato sull'assunzione che la conoscenza nasce dalla natura umana. Questo concetto risale a Platone e Kant, tuttavia ne II 'età moderna viene generalmente associato al linguista N. Chomsky. Egli assume una posizione molto decisa al riguardo frn dal suo primo libro nel 1957, e la mantiene coerentemente nei successivi 40 anni. Egli spiega il rapporto tra la sua concezione dell'innatismo del linguaggio e la posizione originaria di Platone sulla natura della mente in questo modo:

"Come possiamo interpretare la proposta di Platone in termini moderni? Una variante moderna potrebbe essere che certi aspetti della nostra conoscenza e della nostra comprensione sono innati, sono parte del nostro corredo biologico, geneticamente determinato, al pari degli elementi della nostra natura comune che fanno crescere gambe e braccia anziché ali. Penso che questa versione della dottrina classica sia essenzialmente corretta" (Chomsky, 1988).

Chomsky ha dedicato la sua vita scientifica allo sviluppo di una fondamentale teoria della grammatica che descriva le proprietà universali sotto stanti alle grammatiche di tutte le lingue del mondo. Poiché questa grammatica universale è del tutto astratta, lo studioso ritiene che non possa essere appresa e afferma che "la teoria linguistica, la teoria della Grammatica Universale [ ... ] è una proprietà innata della mente umana [e] lo sviluppo del linguaggio [è] analogo allo sviluppo di un organo".

Naturalmente Chomsky riconosce che i bambini francesi imparano parole francesi, i bambini cinesi parole cinesi e così via. Tuttavia, egli ritiene che i principi astratti sotto stanti alla lingua non vengano affatto appresi e sostiene che "una teoria generale dell' apprendimento [ ... ] sembra discutibile, non dibattuta, e priva di supporto empirico".

Poiché questa teoria ha influenzato notevolmente la linguistica e la psicolinguistica moderne, è importante chiarire che cosa significhi precisamente innato per Chomsky. Tutti siamo d'accordo nel ritenere che il cervello umano possieda qualcosa di unico che rende possibile il linguaggio. Tuttavia, in assenza di prove che dimostrino il contrario, questo qualcosa potrebbe non essere altro che il fatto che il nostro cervello è un gigantesco elaboratore multifunzionale, con migliaia di miliardi di elementi preposti all'elaborazione. La versione di Chomsky della teoria dell'innatismo è molto più forte di quella del 'grande cervello' e si basa su due assunti logicamente ed empiricamente distinti: il linguaggio è innato e i nostri cervelli contengono un dispositivo di apprendimento dedicato, specializzato, che si è sviluppato esclusivamente per il linguaggio. Il secondo assunto, che è il più controverso, fa parte di una dottrina conosciuta con diversi nomi: dottrina della specificità del dominio, dottrina dell'autonomia, dottrina della modularità.

Una posizione differente è quella sostenuta dall' empirismo: la conoscenza proviene dall'ambiente e arriva all'individuo attraverso i sensi. Anche questo approccio, chiamato anche comportamentismo o associazionismo è antico e risale (almeno) ad Aristotele, ma in epoca moderna viene associato allo psicologo B.F. Skinner. Secondo Skinner, non esistono limiti a ciò che l'essere umano può diventare, se ne ha il tempo e l'opportunità, applicando le leggi generali dell'apprendimento. Gli esseri umani hanno la facoltà di linguaggio perché hanno il tempo, l'opportunità e (forse) la capacità di elaborazione necessaria ad apprendere 50.000 parole e le associazioni che legano tali parole. A partire dagli anni Cinquanta, gran parte della ricerca linguistica, psicolinguistica e neurolinguistica ha cercato di dimostrare che Skinner aveva torto, sottolineando che i bambini e gli adulti vanno oltre l'input che ricevono, creando frasi nuove e (nel caso di bambini normali e di adulti cerebrolesi) producendo errori particolari, mai sentiti prima. Chomsky stesso criticava severamente l'approccio comportamentista e accusava coloro che credevano che illinguaggio potesse essere appreso di essere "grottescamente in torto" (Gelman, 1986).

Nel criticare duramente l'approccio comportamentista, gli innatisti a volte confondono la forma di empirismo di Skinner con un approccio molto diverso, chiamato interazionismo o costruttivismo o approccio epigenetico. L'idea è molto più complessa dell'innatismo o dell'empirismo e le sue radici storiche sono meno chiare. Nel 20° secolo l'approccio interazionista o costruttivista è stato associato allo psicologo J. Piaget. Più recentemente, tale concezione è riapparsa in un nuovo approccio all'apprendimento e allo sviluppo del cervello e di elaboratori simili al cervello, chiamato connessionismo, elaborazione parallela distribuita oppure teoria delle reti neurali (Rumelhart e McClelland, 1986; Elman et al., 1996), e nella relativa teoria dello sviluppo ispirata dai sistemi dinamici non lineari della fisica moderna (Thelen e Smith, 1994). Per comprendere questa difficile ma importante concezione, bisogna distinguere due diversi tipi di interazionismo: quello delle interazioni semplici (il nero e il bianco fanno il grigio) e quello delle forme emergenti (il nero e il bianco si uniscono e accade qualcosa di totalmente nuovo). In una teoria delle forme emergenti, la soluzione di un problema assume un determinato profilo per ragioni che non sono né ovvie né prevedibili a partire da uno qualsiasi degli input iniziali al problema stesso. Per esempio, le bolle di sapone sono tonde perché la forma sferica rappresenta l'unica possibile soluzione per raggiungere il volume massimo con una superficie minima: la forma non viene spiegata in relazione al sapone, all'acqua o al bambino che fa le bolle soffiando; il nido d'ape in un alveare assume la forma esagonale perché ('principio del riempimento') essa rappresenta la soluzione al problema di dover pressare insieme dei cerchi (fig. 4): l'esagono non è prevedibile in base alla cera, al miele che contiene e al comportamento della singola ape nell'atto di comprimere. Piaget sosteneva che la logica e la conoscenza emergono esattamente in questo stesso modo, da interazioni successive tra attività sensomotoria e mondo strutturato. Un'argomentazione simile è stata presentata per spiegare la nascita delle grammatiche, che rappresentano la classe di soluzioni possibili al problema di dover far corrispondere un ricco insieme di significati a un limitato canale linguistico, pesantemente costretto dai limiti della memoria, della percezione e della programmazione motoria. La logica e la grammatica non sono date nel mondo, ma non si trovano nemmeno nei geni. Gli esseri umani scoprono i principi che includono la logica e la grammatica perché tali principi rappresentavano la migliore soluzione possibile ai problemi specifici di cui le altre specie non si curavano e che, comunque, non avrebbero potuto risolvere. I sostenitori dell' approccio epigenetico riconoscono che nel cervello umano c'è qualcosa di innato che rende possibile il linguaggio, ma questo qualcosa non può essere un dispositivo specializzato e dominio-specifico che si è evoluto esclusivamente per il linguaggio. Può essere, invece, un qualcosa che realizziamo grazie a un cervello grande e sofisticato che si è sviluppato per conseguire i complessi obiettivi della società e della cultura umane (Tomasello e CalI, 1997). In altre parole, il linguaggio è una nuova macchina costruita con parti vecchie e ricostruita, a partire da quelle componenti, da ogni bambino.

Così oggi il dibattito al centro della ricerca sul linguaggio non riguarda la contrapposizione natura versus cultura, ma la 'natura della natura', cioè se la lingua sia qualcosa che realizziamo grazie a un imIato dispositivo del linguaggio o se sia il prodotto di abilità (imIate) che non sono specifiche del linguaggio. Nelle pagine seguenti, analizzeremo le conoscenze attuali sulla psicologia, la neurologia e lo sviluppo del linguaggio da questo punto di vista. Affronteremo questo problema ai diversi livelli del sistema, dai suoni del parlato alle più ampie strutture comunicative della produzione linguistica complessa. Cominceremo dalla definizione dei diversi livelli del sistema linguistico e descriveremo successivamente in che modo ognuno di questi livelli viene elaborato dagli adulti normali, acquisito dai bambini e rappresentato nel cervello.

Componenti del linguaggio

Linguaggio come suono: fonetica e fonologia

Lo studio dei suoni linguistici può essere diviso in due campi: fonetica e fonologia.

La fonetica è lo studio dei suoni del parlato intesi come eventi fisici e psicologici. Essa comprende un vasto campo di ricerche sulle proprietà acustiche del linguaggio e il rapporto tra tali caratteristiche acustiche e il modo in cui l' essere umano percepisce e ha esperienza del linguaggio stesso. Comprende, inoltre, lo studio approfondito dellinguaggio come sistema motorio che pone l'accento sull'anatomia e la fisiologia della produzione orale. Nell'ambito della fonetica i linguisti lavorano insieme a tecnici del suono, psicologi sperimentali, informatici e ricercatori biomedici. La fonologia è una disciplina molto diversa che studia le rappresentazioni astratte sotto stanti al linguaggio, sia nella percezione che nella produzione, all'interno delle lingue umane e tra le lingue stesse. Per esempio, un fonologo può concentrarsi sulle regole che governano il contrasto sonoro/sordo nella grammatica inglese, come l'opposizione tra la -s sorda in cats e la -s sonora in dogs. Questo contrasto nella formazione del plurale assomiglia al contrasto sordo/ sonoro nella formazione del passato in inglese, quale, per esempio, quello tra -ed sordo di walked e -ed sonoro di wagged. I fonologi ricercano un insieme di regole o principi che possano spiegare analogie di questo tipo e tentano di estenderli a nuovi casi di formazione delle parole in una particolare lingua. Pertanto la fonologia è una sorta di interfaccia tra la fonetica e le altre regolarità che costituiscono la lingua umana, posta a una certa distanza dal suono inteso come evento fisico.

Alcuni teorici sostengono che la fonologia non dovrebbe esistere come disciplina a sé stante e che le generalizzazioni scoperte dai fonologi debbano essere spiegate esclusivamente in termini fisici e psicofisici. Questo è essenzialmente l'approccio epigenetico. Altri ritengono che la fonologia costituisca un livello di analisi completamente indipendente, le cui leggi non possono essere ricondotte a nessuna combinazione di eventi fisici. Non sorprende che questo sia l'approccio adottato dagli innatisti, soprattutto da coloro i quali ritengono che il linguaggio abbia una sua propria macchina neuronale dedicata. Indipendentemente dalla specifica posizione assunta in questo dibattito, è chiaro che fonetica e fonologia non sono la stessa cosa. Se si analizzano i suoni del parlato da un punto di vista fonetico, basato su tutti i diversi suoni che possono essere prodotti dall'apparato fonatorio umano, otteniamo circa 600 possibili contrasti sonori che possono essere utilizzati dalle lingue (e anche di più, se utilizziamo un sistema estremamente raffrnato per categorizzare i suoni). Tuttavia, nella maggior parte delle lingue umane non vengono usate più di 40 contrasti per costruire le parole.

Per spiegare questo punto, consideriamo la seguente differenza tra inglese e francese. In inglese, il suono aspirato indicato dalla lettera (h) viene usato fonologicamente, per esempio per indicare la differenza tra at e hat. l parlanti francesi sono perfettamente capaci di emettere questi suoni, ma il contrasto creato dalla presenza o dall'assenza di aspirazione non viene utilizzato per contrassegnare una differenza sistematica tra parole. Allo stesso modo, la lingua inglese ha un contrasto binario tra i suoni indicati da (d) e (t) che viene utilizzato per indicare contrasti sistematici come tune e dune. La lingua thai ha entrambi i contrasti e ha inoltre un terzo confine tra la (t) e la (d) inglese. l parlanti inglesi sono capaci di produrre questo terzo contrasto che, infatti, rappresenta il modo normale di pronunciare la consonante intermedia in una parola come buttero La differenza risiede nel fatto che la lingua thai usa questo terzo contrasto fonologicamente (per formare nuove parole), mentre l'inglese lo usa solo foneticamente, in quanto permette di pronunciare fonemi bersaglio passando rapidamente da una parola all'altra (in questo caso si parla anche di variazione allofonica). Nella nostra panoramica sugli studi che si occupano dell'elaborazione, dello sviluppo e delle basi neuronali dei suoni del parlato sarà utile distinguere tra approccio fonetico e approccio fonologico o fonemico.

Linguaggio e significato: semantica e lessico

Lo studio del significato linguistico rappresenta l'ambito di studio di un campo della linguistica chiamato semantica. La semantica è anche una branca della filosofia che pone l'enfasi sulla relazione tra significato e logica formale. La semantica viene suddivisa tradizionalmente in due aree: la semantica lessicale, che si occupa dei significati associati ai singoli elementi lessicali (cioè, le parole), e la semantica proposizionale o relazionale, che si occupa dei significati relazionali che generalmente esprimiamo con un'intera frase.

La semantica lessicale è stata studiata da linguisti di diverse scuole e abbraccia una vasta gamma di indagini, dal lavoro minutamente descrittivo dei lessicografi (cioè gli 'scrittori di dizionari') alla ricerca teorica sul significato lessicale e sulla forma lessicale di scuole molto diverse della linguistica formale e della grammatica generativa (McCawley, 1993). Alcuni teorici sottolineano lo stretto rapporto tra semantica e grammatica, utilizzando una combinazione di semantica lessicale e proposizionale per spiegare i vari significati codificati nella grammatica. Questa è la posizione degli studiosi che hanno adottato un approccio epigenetico al linguaggio: essa è sostenuta da alcune scuole specifiche quali quelle della grammatica cognitiva, della semantica generativa e del funzionalismo linguistico. Altri teorici, invece, sostengono l'indipendenza strutturale di semantica e grammatica, posizione, questa, associata a coloro che adottano un approccio innatista della lingua.

La semantica proposizionale è stata principalmente dominio di filosofi del linguaggio interessati al rapporto tra la logica sotto stante la lingua naturale e la gamma dei possibili sistemi logici che sono stati scoperti negli ultimi due secoli dalla ricerca sul ragionamento formale. Una proposizione viene definita come un'asserzione che può essere giudicata vera o falsa. La struttura interna di una proposizione comprende un predicato e uno o più argomenti di quel predicato. Un argomento è un'entità o una cosa di cui vogliamo parlare. Un predicato a un argomento è uno stato, attività o identità che attribuiamo a un'unica entità (per esempio, attribuiamo la bellezza a Maria nella frase "Maria è bella" oppure attribuiamo 'l'ingegnerità' a un particolare individuo nella frase "Giovanni è un ingegnere"). Un predicato polivalente è una relazione che attribuiamo a una o più entità o cose. Per esempio, il verbo baciare è un predicato bivalente che crea la relazione asimmetrica baciare tra due entità nella frase "Giovanni bacia Maria". Il verbo dare è un predicato trivalente che mette in relazione tre entità nella proposizione espressa dalla frase "Giovanni dà un libro a Maria". l filosofi tendono a preoccuparsi di come stabilire la verità o la falsità delle proposizioni e di come trasmettere (o nascondere) la verità nella lingua naturale o nelle lingue artificiali. l linguisti tendono a preoccuparsi delle forme proposizionali utilizzate nelle lingue naturali. Gli psicologi, invece, tendono a preoccuparsi della forma e della natura delle rappresentazioni mentali che codificano le conoscenze proposizionali; in particolare, gli psicologi dell'età evolutiva si occupano del processo attraverso cui i bambini raggiungono la capacità di esprimere tali conoscenze proposizionali. In tutti i campi, coloro che adottano un approccio innati sta alla natura del linguaggio umano tendono a evidenziare l'indipendenza del significato proposizionale e combinatorio dalle regole per la combinazione delle parole nella grammatica. Per contro, le varie scuole che adottano un approccio epigenetico tendono a evidenziare sia le somiglianze strutturali che la relazione causale tra i significati proposizionali e la struttura grammaticale, suggerendo che gli uni derivano dall' altra.

Come si incontrano suoni e significati: la grammatica

Il settore della linguistica che studia il modo in cui le singole parole e altri suoni si combinano per esprimere un significato si chiama grammatica. Lo studio della grammatica tradizionalmente si divide in due parti: morfologia e sintassi. La morfologia studia i principi che governano la costruzione di parole e di sintagmi complessi per scopi lessicali o grammaticali. Questo campo è ulteriormente suddiviso in due sottodiscipline: la morfologia derivazionale e la morfologia flessiva.

La morfologia derivazionale si occupa della costruzione di parole complesse partendo da componenti semplici: per esempio, la parola governatore deriva dal verbo governare e dal morfema derivazionale -tore. Alcuni studiosi sostengono che la morfologia derivazionale effettivamente appartenga alla semantica lessicale e non dovrebbe essere inclusa nella grammatica. Tuttavia, il raggruppamento della morfologia derivazionale nella semantica descrive meglio una lingua come l'inglese piuttosto che lingue altamente flessive come l'eschimese della Groenlandia in cui un'intera frase può essere espressa da un'unica parola con diversi morfemi derivazionali e flessivi. La morfologia flessiva studia le modulazioni della struttura della parola che hanno conseguenze grammaticali. Tali modulazioni si realizzano per flessione, per es. aggiungendo in inglese -ed al verbo per formare il passato come in walked, o per sostituzione, per es. sostituendo il passato irregolare went al presente go. Alcuni linguisti includono nella morfologia flessiva anche lo studio di come funtori liberi, quali per esempio verbi ausiliari (avere/essere), preposizioni (per esempio, da/per) o articoli vengono aggiunti a verbi e nomi per costituire sintagmi nominali o verbali complessi. Ciò avviene, per esempio, nel processo che espande un verbo, come "ha corso/aveva corso", oppure nel processo che espande un nome, come "cane", in un sintagma nominale del tipo "il cane" o in un sintagma preposizionale del tipo "dal cane".

La sintassi viene definita come l'insieme dei principi che governano il modo in cui le parole e altri morfemi sono ordinati per formare una frase possibile in una data lingua. Per esempio, la sintassi dell'inglese contiene principi che spiegano perché la frase "Mary kissed John" ("Maria ha baciato Giovanni") è una frase possibile, mentre "Mary John kissed" ("Maria ha Giovanni baciato") suona come una frase strana. Va notato, comunque, che entrambe le frasi sarebbero accettabili in tedesco; quindi, in qualche misura, queste regole e questi vincoli sono arbitrari. La sintassi può anche contenere principi che descrivono la relazione tra diverse forme della stessa frase (per esempio, la frase attiva "Gianni ha picchiato Luigi" e la forma passiva "Luigi è stato picchiato da Gianni") e i modi per inserire una frase in un'altra (per esempio "Il ragazzo che è stato picchiato da Gianni ha picchiato Luigi").

Le lingue variano moltissimo a seconda di quanto facciano affidamento sulla sintassi o sulla morfologia per esprimere i significati proposizionali di base. Un esempio particolarmente chiaro è la differenza che esiste tra le varie lingue nei mezzi per esprimere una relazione proposizionale chiamata transitività (che corrisponde a 'chi ha fatto cosa a chi'). L'inglese usa l'ordine delle parole come indizio regolare e affidabile del significato di una frase: per esempio, nella frase "John kissed a girl" sappiamo immediatamente che "John" è l'attore e "girl" è il paziente. Allo stesso tempo, l'inglese usa pochissimo la morfologia flessiva per indicare la transitività, o qualsiasi altro importante aspetto del significato della frase. Così, non ci sono marche sulle parole "John" e "girl" a indicare chi ha baciato chi, né esistono indicatori di transitività sul verbo "kissed". In ungherese, invece, accade il contrario, in quanto questa lingua possiede un sistema morfologico molto ricco, ma ha un elevato grado di variabilità nell'ordine delle parole. In ungherese, frasi come "John kissed a girl" possono essere espresse praticamente con qualsiasi ordine delle parole, senza perdita di significato.

Alcuni linguisti hanno sostenuto che questo tipo di variazione dell'ordine delle parole sia possibile solo in lingue ricche di marche morfologiche. Per esempio, la lingua ungherese prevede dei suffissi di caso su ogni nome, che indicano in maniera non ambigua 'chi ha fatto cosa a chi', e delle marche speciali sul verbo che concordano con l'oggetto in defrnitezza. Quindi, la traduzione in ungherese dell'esempio inglese equivarrebbe a "John-agente indefinito-girl-paziente-kissed-indefinito". Tuttavia, il cinese pone un problema a questo proposito: esso non ha marche flessive di alcun genere (per esempio, non ha marche di caso né forme di accordo) e tuttavia permette una considerevole variazione dell'ordine delle parole a scopo stilistico. Quindi, gli ascoltatori cinesi devono esclusivamente affidarsi a indizi probabilistici per capire 'chi ha fatto cosa a chi', comprese alcune combinazioni di ordini di parole (cioè, alcuni ordini sono più probabili di altri, sebbene ne siano possibili molti) e il contenuto semantico della frase (è più probabile che dei ragazzi mangino delle mele che non viceversa). In breve, appare ormai chiaro come le lingue umane abbiano trovato diverse soluzioni al problema della mappatura.

Chomsky e i suoi seguaci hanno definito la grammatica universale come l'insieme delle possibili forme che la grammatica di una lingua naturale può assumere. Questi caratteri universali possono essere visti in due modi: come l'intersezione di tutte le grammatiche umane, cioè l'insieme di strutture che ogni lingua deve avere, oppure come l'unione di tutte le grammatiche umane, cioè l'insieme di possibili strutture tra le quali ogni lingua umana deve scegliere. Chomsky ha sempre sostenuto che la grammatica universale è innata, in una forma peculiare propria del linguaggio. In altre parole, la grammatica non assomiglia né si comporta come nessun altro sistema cognitivo esistente. Tuttavia, lo studioso ha modificato le sue idee nel corso degli anni circa il modo in cui queste conoscenze innate si realizzano in lingue specifiche come il cinese o il francese. Agli albori della grammatica generativa la ricerca dei caratteri universali si sviluppava intorno al concetto di un'intersezione universale.

Quando le enormi differenze tra le lingue cominciarono a diventare più evidenti, e l'intersezione tra di esse si riduceva sempre di più, Chomsky cominciò a spostare la sua attenzione dall' intersezione all'unione delle possibili grammatiche. In sostanza, oggi egli ritiene che i bambini nascano con un insieme di opzioni innate che definisce il modo in cui gli oggetti linguistici come i nomi e i verbi possono essere messi insieme. Il bambino non impara realmente la grammatica (nel modo in cui il bambino potrebbe imparare a giocare a scacchi), ma l'ambiente linguistico funge da innesco per la scelta di alcune opzioni e fa sì che altre vengano meno. Questo processo viene chiamato fissazione dei parametri. La fissazione dei parametri assomiglia all'apprendimento, in quanto permette di spiegare perché le lingue appaiono così diverse e come i bambini si muovono secondo gli obiettivi della propria lingua. Tuttavia, Chomskye i suoi seguaci sono convinti che la fissazione dei parametri (la scelta tra una grande riserva di possibili opzioni) sia diversa dall'apprendimento (l'acquisizione di strutture che non era presente prima che l'apprendimento avesse luogo) e che l'apprendimento, così definito, svolga un ruolo limitato, e forse addirittura marginale, nello sviluppo della grammatica.

Molti teorici non condividono questo approccio alla grammatica sulla base delle motivazioni precedentemente illustrate. Gli empiristi potrebbero sostenere che la fissazione dei parametri è un vero e proprio apprendimento (cioè, i bambini ricevono nuove cose anche dall'ambiente e non scelgono semplicemente tra le opzioni innate). I sostenitori dell'approccio epigenetico adottano un'impostazione ancora diversa che si colloca tra la fissazione dei parametri e l'apprendimento. Più precisamente, un sostenitore dell'approccio epigenetico potrebbe dire che alcune combinazioni di caratteristiche grammaticali sono più convenienti da elaborare rispetto ad altre. Queste osservazioni sull' elaborazione pongono dei limiti alla classe di possibili grammatiche: alcune combinazioni funzionano, altre no. Per fare un'analogia, perché un passero può volare mentre un emù non può? Forse l'emù non possiede 'conoscenze innate sul volo' oppure non possiede il rapporto tra peso e apertura alare, fondamentale per il volo? Si può applicare lo stesso ragionamento alla grammatica. Per esempio, nessuna lingua possiede una regola grammaticale che prevede di trasformare un'asserzione in una domanda presentando la frase al contrario, come nel caso seguente: "Gianni colpisce il pallone" "Pallone il colpisce Gianni?".

Chomsky sosterrebbe che tale regola non esiste perché non è contenuta nella grammatica universale. Potrebbe esistere, ma di fatto non esiste. I sostenitori dell' approccio epigenetico direbbero che tale regola non esiste perché sarebbe molto difficile produrre o comprendere frasi in tempo reale secondo un principio di ricostruzione del tipo avantiindietro. Potrebbe funzionare con frasi composte da tre o quattro parole, ma la nostra memoria verrebbe meno se fossero più lunghe, come nel caso: "il bambino che ha dato un calcio alla bambina ha colpito la palla che Peter ha portato" "portato ha Peter che palla la colpito ha bambina alla calcio un dato ha che bambino il?"

In altre parole, la regola di ricostruzione all'indietro per la formazione delle domande non esiste perché sarebbe incompatibile con il tipo di memoria con cui dobbiamo lavorare. Entrambi gli approcci suppongono che le grammatiche sono come sono per il modo in cui il cervello umano funziona. La differenza non risiede nell'opposizione natura versus cultura quanto nella 'natura della natura', cioè nella domanda se tale capacità venga costruita da materiali specifici della lingua o da ingredienti cognitivi più generali.

Il linguaggio nel contesto sociale: pragmatica e discorso

Le varie sottodiscipline che abbiamo finora illustrato riflettono uno o più aspetti della forma linguistica, dai suoni alle parole, alla grammatica. La pragmatica è definita lo studio del linguaggio nel contesto: è una branca della linguistica e della filosofia che si concentra, invece, sul linguaggio come forma di comunicazione, uno strumento che utilizziamo per raggiungere certi fini sociali (Bates, 1976). La pragmatica è una disciplina non definita chiaramente e infatti qualcuno l'ha definita il 'cestino della spazzatura' della teoria linguistica. Essa comprende lo studio degli atti linguistici (una tassonomia degli atti della comunicazione socialmente riconosciuti che compiamo quando dichiariamo, ordiniamo, dubitiamo, battezziamo, imprechiamo, promettiamo, sposiamo, ecc.), delle presupposizioni (le informazioni di base necessarie perché un determinato atto del discorso funzioni, per esempio il significato sotteso a una domanda insidiosa come "Hai smesso di picchiare tua moglie?") e i postulati conversazionali (principi che governano la conversazione come attività sociale, per esempio l'insieme dei segnali che regolano l'alternanza dei turni e la tacita consapevolezza di aver detto troppo o troppo poco per sostenere una certa posizione).

La pragmatica include anche lo studio del discorso che, a sua volta, comprende lo studio dei tipi di discorso (per esempio, come costruire un paragrafo, una storia, oppure una barzelletta) e lo studio della coesione testuale, cioè il modo in cui utilizziamo i singoli dispositivi linguistici quali congiunzioni (e, quindi), pronomi (egli, lei, quello), articoli definiti (il/lo/la rispetto a un/uno/una) e addirittura intere frasi o proposizioni ("L'uomo di cui ti ho parlato") per legare insieme frasi, distinguere tra informazioni vecchie e nuove e mantenere l'identità di singoli elementi citati in parti diverse di un testo (cioè, le relazioni di coreferenza).

Dovrebbe essere chiaro che la pragmatica è un campo eterogeneo, privo di confini ben definiti. Tra le altre cose, il perfetto dominio degli aspetti pragmatici del linguaggio implica moltissime informazioni socioculturali: informazioni sui sentimenti e gli stati interni, la conoscenza di come appare il discorso dal punto di vista di chi ascolta, e la considerazione del rapporto di potere e intimità tra i parlanti che entra in gioco quando occorra calcolare quanto bisogna essere cortesi o espliciti per far valere un'opinione nel corso della conversazione. Immaginiamo un marziano che arrivi sulla Terra sapendo tutto di fisica e matematica, armato di elaboratori che potrebbero accedere a qualsiasi codice. Nonostante questi potenti strumenti, sarebbe impossibile per il marziano capire perché usiamo la lingua come la usiamo, a meno che egli non abbia una vasta conoscenza della società e delle emozioni umane. Per la stessa ragione, questo è un settore del linguaggio in cui i disturbi socioemotivi potrebbero avere effetti devastanti sullo sviluppo (per esempio, i bambini autistici hanno risultati particolarmente negativi nei compiti pragmatici). Ciononostante, alcuni linguisti hanno cercato di organizzare alcuni aspetti della pragmatica in uno o più moduli indipendenti, ognuno con le sue proprietà innate (Sperber e Wilson, 1986). Come vedremo più avanti, nell'ambito della neurolinguistica recentemente si è tentato di identificare un locus neuronale specifico per l'aspetto pragmatico della conoscenza linguistica.

Ora che abbiamo una mappa delle componenti della lingua, esploriamone brevemente ognuna, illustrando le attuali conoscenze su come, a ogni livello, le informazioni vengono elaborate dagli adulti, acquisite dai bambini e mediate nel cervello umano.

I suoni linguistici

L'elaborazione del linguaggio negli adulti normali

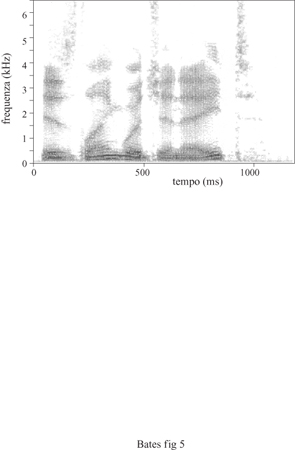

Lo studio dell' elaborazione linguistica a partire da una prospettiva psicologica ebbe inizio dopo la Seconda guerra mondiale, quando cominciarono a essere disponibili gli strumenti che permettevano un'analisi dettagliata del linguaggio come evento fisico. Il più importante di questi strumenti era lo spettro grafo acustico che, diversamente dal più conosciuto oscilloscopio che visualizza le frequenze acustiche nel tempo, visualizza i cambiamenti nel tempo dell'energia contenuta all'interno delle diverse bande di frequenza. In figura (fig. 5) è illustrato uno spettrogramma del suono per la frase "/s language innate?" ("Il linguaggio è innato?"), una delle domande fondamentali di questo campo.

Questo tipo di visualizzazione si è dimostrato utile non solo in quanto permette l'analisi visiva dei suoni del linguaggio, ma anche perché permette di 'raffigurare' suoni linguistici artificiali e farli riascoltare per determiname gli effetti sulla percezione da parte di un essere umano. Inizialmente gli scienziati speravano che questo dispositivo potesse costituire la base per mettere a punto 'lettori' di linguaggio parlato per le persone sorde: l'unica cosa da fare era (o sembrava essere) individuare 'l'alfabeto', cioè la configurazione visiva corrispondente a ognuno dei principali fonemi linguistici. Allo stesso modo dovrebbe essere possibile creare dei sistemi artificiali che comprendano il linguaggio: così potremmo avvicinarci a un bancomat e dirgli il nostro codice segreto, l'ammontare desiderato e così via. Sfortunatamente le cose non sono così semplici. Infatti, non esiste una chiara relazione isomorfica tra i suoni linguistici che i parlanti nativi sentono e il tracciato visivo prodotto da tali suoni. Più precisamente, la relazione tra i segnali linguistici e la percezione del linguaggio è priva di due importanti proprietà: la linearità e l'invarianza.

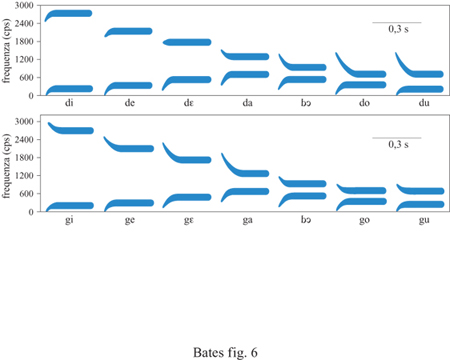

La linearità si riferisce al modo in cui il linguaggio si manifesta nel tempo. Se il segnale linguistico avesse linearità, allora nello spettrogramma del suono esisterebbe un rapporto isomorfico da sinistra a destra tra il linguaggio come segnale e il linguaggio come esperienza. Per esempio, consideriamo la sillaba da visualizzata nello spettrogramma artificiale in figura (fig. 6). Se il segnale linguistico fosse lineare, la prima parte di questo suono (la componente d) dovrebbe corrispondere alla prima parte dello spettrogramma e la seconda parte (la componente a) dovrebbe corrispondere alla seconda parte dello stesso spettrogramma. Tuttavia, se facessimo ascoltare queste due componenti separatamente a un parlante nativo, esse non assomiglierebbero affatto alle due metà di da. Il suono vocalico effettivamente suona come la vocale a, ma la componente d presentata separatamente (senza contesto vocalico) non sembra affatto un suono linguistico. Sembrerebbe che la nostra esperienza del linguaggio implichi la riorganizzazione e l'integrazione del segnale fisico in entrata per creare l'esperienza percettiva unificata che tutti conosciamo.

L'invarianza si riferisce al rapporto tra il segnale e la percezione del segnale stesso in diversi contesti. Anche se il segnale è privo di linearità, gli scienziati una volta speravano che la stessa porzione dello spettrogramma che dà origine all'esperienza d nel contesto di corrispondesse anche all'esperienza della d nel contesto du. Ma, ahimè, le cose non stavano così. Come indica la figura 6, la componente responsabile della d appare completamente diversa a seconda della vocale che la segue. Per di più, la componente d della sillaba du assomiglia alla componente g della sillaba ga. Infatti, la forma del pattem visivo che corrisponde a un suono consonantico può addirittura variare con il tono della voce del parlante, cosicché la sillaba da prodotta da un bambino presenta un pattem completamente diverso dalla sillaba da prodotta da un adulto di sesso maschile.

Questi problemi possono essere osservati negli stimoli linguistici artificiali e isolati. Nel linguaggio fluente i problemi sono addirittura peggiori (v. oltre). Sembra che i parlanti nativi usino diverse parti del contesto per scoprire i confini tra una parola e l'altra. Nessun tipo di sistema semplice di regole dall' alto in basso è sufficiente per eseguire questo compito. Questo è il motivo per cui ancora non esistono lettori del linguaggio parlato per le persone sorde o elaboratori capaci di percepire la produzione linguistica fluente di diversi parlanti, sebbene questo tipo di macchine esista da decenni nella fantascienza. Il problema della percezione del linguaggio diventò "curioser and curioser" ("sempre più singolare"), come direbbe Lewis Carroll, al punto da portare negli anni Sessanta un gruppo di scienziati del linguaggio a ipotizzare che gli esseri umani realizzino la percezione linguistica per mezzo di un dispositivo particolare di cui è dotato esclusivamente il cervello umano. Per ragioni che vedremo tra breve, questi scienziati erano anche convinti che questo dispositivo per la percezione del linguaggio fosse innato, perfettamente funzionante nel neonato umano fin dalla nascita. Ritenevano, inoltre, che gli esseri umani elaborassero questi suoni linguistici non come eventi acustici, ma testando l'input linguistico rispetto a eventuali modelli motori (cioè, versioni dello stesso suono linguistico che l'ascoltatore può produrre per se stesso, una sorta di analisi per sintesi). Questo concetto, chiamato teoria motoria della percezione del linguaggio, venne presentato per spiegare per quale motivo l'elaborazione linguistica è non lineare e invariante da un punto di vista acustico e perché solamente gli esseri umani (almeno così si riteneva) sono in grado di percepire il linguaggio.

Per diverse ragioni (alcune delle quali saranno discusse oltre) questa ipotesi ha conosciuto momenti difficili. Oggi moltissimi studiosi sono nuovamente favorevoli all'idea che il linguaggio sia dopo tutto un evento acustico, sebbene molto complesso e difficile da comprendere esaminando gli spettro grammi del linguaggio come quelli delle figure 5 e 6. In primo luogo, i ricercatori che utilizzano il particolare tipo di dispositivo computazionale chiamato rete neurale hanno dimostrato che, dopo tutto, le unità linguistiche di base possono essere apprese anche da una macchina piuttosto stupida con accesso esclusivamente a dati linguistici sonori grezzi (cioè, senza alcun modello motorio da far corrispondere a un segnale). Così la capacità di percepire queste unità non deve essere innata, ma potrebbe essere appresa. Questa osservazione ci porta al punto successivo: come si sviluppa il linguaggio.

Lo sviluppo dei suoni linguistici nei bambini

Percezione del linguaggio. - È stata sviluppata una serie di tecniche raffinate per determinare l'insieme di contrasti fonetici/fonemici percepiti dai bambini in età preverbale. Tali tecniche includono la misurazione della frequenza della suzione, che si basa sul fatto che quando i bambini percepiscono uno stimolo nuovo e interessante tendono a succhiare vigorosamente, la tecnica della abituazione e disabituazione, che fa affidamento sulla tendenza dei bambini a 'orientarsi' o attivare nuovamente l'attenzione quando percepiscono un cambiamento interessante nell'input visivo o uditivo, e quella della rotazione condizionata della testa, che consiste nel condizionare un lattante a girare il capo verso i suoni appartenenti a una categoria sonora ma non a un'altra, tecnica che permette al ricercatore di ridi segnare i confini tra le categorie dal punto di vista del bambino (Aslin et al., 1998). Sebbene le tecniche siano rimaste invariate per più di 20 anni, le nostre conoscenze del repertorio iniziale del bambino e del modo in cui esso cambia nel tempo sono state sostanzialmente modificate.

Nel 1971, P. Eimas e collaboratori pubblicarono un importante articolo in cui si dimostrava che i bambini sono in grado di percepire i contrasti tra i suoni linguistici pa e ba (Eimas et al., 1971). Cosa ancora più importante, essi furono in grado di dimostrare che i bambini sentono questi suoni in modo categoriale. Per illustrare questo punto, si provi a mettere una mano sulla gola e l'altra (con il dito indice sollevato) davanti alla bocca. Alternando i suoni pa e ba si noterà che la bocca si apre prima che le corde vocali vibrino per emettere il suono pa, mentre il tempo tra la vibrazione delle corde vocali e l'apertura delle labbra è molto più breve quando si emette il suono ba. Tale variabile, chiamata VOT (Voice Onset Time, tempo di inizio della vocalizzazione), è una dimensione continua in fisica, ma discontinua nella percezione umana. In altre parole, gli ascoltatori umani sentono una demarcazione netta e discontinua intorno a 20 ms tra l'apertura della bocca e l'attacco della sonorità; prima di quel limite le repliche ba sembrano molto simili e dopo tale punto è difficile distinguere le repliche pa, ma in corrispondenza di quella linea di demarcazione si può sentire un chiaro cambiamento. Per scoprire se i bambini possiedono tale capacità di discriminazione, Eimas e collaboratori utilizzarono la procedura di misurazione della frequenza della suzione, ossia gli autori annoiarono i bambini con una serie di stimoli appartenenti alla medesima categoria (per es., ba), per poi presentare loro delle nuove versioni in cui il VOT veniva spostato gradualmente verso la linea di demarcazione dell'adulto. I bambini ricominciavano a succhiare vigorosamente (il che corrisponde all'esclamazione "Ehi! questo è nuovo!"): un brusco cambiamento proprio in corrispondenza della stessa linea di demarcazione dove gli adulti umani percepiscono un contrasto consonantico.

Ciò significa che la capacità di sentire le distinzioni categoriali della lingua è innata? Sì, probabilmente lo è. Ma significa anche che tale capacità è basata su un processore innato che si è sviluppato esclusivamente per il linguaggio? Eimas e i suoi collaboratori pensavano di sì, ma la storia ha dimostrato che avevano torto. P.K. Kuhl e J.D. Miller (1975) fecero una scoperta devastante per l'approccio innati sta: anche i cincillà riescono a sentire il confine tra le consonanti e lo sentono in modo categoriale, circa nella stessa posizione di quello percepito dagli esseri umani. Tale risultato è stato replicato in varie specie, con diversi metodi, esaminando molti aspetti diversi del segnale linguistico. In altre parole, la percezione categoriale del linguaggio non è dominio-specifica e non si sviluppa al servizio del linguaggio. L'orecchio non si è sviluppato per soddisfare la bocca umana: piuttosto il linguaggio umano si è sviluppato per trarre vantaggio dalle distinzioni già presenti nel sistema uditivo dei mammiferi. Questa è una illustrazione particolarmente chiara della differenza tra innatismo e specificità di dominio accennata nell'introduzione.

Dalla scoperta che la percezione categoriale e i fenomeni linguistici non sono specifici del linguaggio, la ricerca sulla percezione linguistica infantile si è allontanata dall'interesse per lo stato iniziale per concentrarsi sul processo con il quale i bambini mettono a punto la loro percezione per adattarla alle peculiarità della lingua madre. Oggi sappiamo che i neonati possono sentire virtualmente tutti i contrasti fonetici utilizzati dalle lingue umane. Infatti, possono sentire cose che non sono più percepibili dall'adulto. Per esempio, gli ascoltatori giapponesi hanno difficoltà a sentire il contrasto tra ra e la, ma i bambini giapponesi non hanno alcun problema con questa distinzione. Quando perdono (o sopprimono) la capacità di sentire suoni che non fanno parte della loro lingua? l dati attuali indicano che la soppressione dei suoni linguistici non nativi comincia intorno agli 8÷10 mesi di età, momento in cui la maggior parte dei bambini comincia a dare prova di comprendere sistematicamente delle parole. Sembra che nulla venga regalato: per potersi sintonizzare sui suoni specifici della lingua e poterne estrapolare il significato, il bambino deve 'escludere' quelle variazioni fonetiche che non sono usate nella lingua.

Ciò non significa, tuttavia, che i bambini prima dei 10 mesi di età siano 'neutrali' rispetto alla lingua. Gli studi condotti hanno dimostrato che frn da quando sono nel ventre materno i bambini apprendono qualcosa sui suoni della propria lingua madre! l bambini francesi si girano per ascoltare preferibilmente il francese nelle prime ore o nei primi giorni di vita, preferenza che non viene manifestata da neonati che nell'ultimo trimestre di gravidanza sono stati immersi in una lingua diversa. Indipendentemente da ciò che i francesi pensano del fascino universale della loro lingua, questa non è preferita universalmente alla nascita. Qualcosa dei pattern sonori della lingua madre penetra il ventre materno e la capacità di imparare qualcosa di questi pattern è presente nell 'ultimo mese di gravidanza. Tuttavia questo qualcosa è probabilmente vago e impreciso. Kuhl e collaboratori hanno dimostrato che un più preciso apprendimento specifico della lingua si verifica tra la nascita e i sei mesi di età, sotto forma di preferenza per prototipi di suoni vocalici nella lingua di quel particolare bambino. Inoltre, entro i sei mesi di età il numero di vocali 'preferite' viene perfezionato seguendo le caratteristiche specifiche della lingua. Sembra che le informazioni specifiche della lingua sulle consonanti facciano la loro apparizione più tardi e probabilmente coincidono con la soppressione dei contrasti non nativi e con la capacità di comprendere parole.

Per riassumere, i bambini inizialmente possiedono la capacità universale di sentire tutti i suoni linguistici usati in qualsiasi lingua naturale. Tale capacità è innata, ma apparentemente non è specifica del linguaggio (né specifica degli esseri umani). L'apprendimento dei segnali linguistici comincia quando il sistema uditivo è in funzione (più o meno nell'ultimo trimestre di gravidanza) e si sviluppa progressivamente nel corso del primo anno di vita, finché i bambini sono alla fine capaci di eliminare suoni irrilevanti e di sintonizzarsi con le demarcazioni fonologiche specifiche della loro lingua madre. A questo punto, la semplice produzione linguistica si trasforma in lingua reale, cioè la capacità di trasformare i suoni in significato.

Produzione linguistica. - Questa visione dello sviluppo della percezione linguistica è corroborata dalle scoperte sullo sviluppo della produzione linguistica (Menn e Stoel-Gammon, 1995). Nei primi due mesi, i suoni prodotti dai bambini sono riflessivi, suoni 'vegetativi' legati a specifici stati interiori (per esempio, il pianto). Tra i due e i sei mesi, i bambini cominciano a produrre suoni vocalici (vocalizzazione e giochi vocalici). La cosiddetta lallazione canonica o reduplicata comincia intorno ai 6÷8 mesi nella maggior parte dei bambini: la lallazione in brevi segmenti o in stringhe più lunghe ora interrotte da consonanti (per esempio, "dadada"). Nel periodo tra i 6 e i 12 mesi, la lallazione si sposta verso i pattern sonori tipici della lingua materna dei bambini (cosicché ascoltatori adulti possono distinguere la lallazione di bambini cinesi, francesi e arabi). Tuttavia, ancora non sappiamo quali caratteristiche della lallazione dei bambini portino a questa discriminazione, cioè, se essa si basa sulle consonanti, sulla struttura sillabica o sulle caratteristiche dell'intonazione dei suoni linguistici. Infatti, alcuni ricercatori sostengono che la produzione di consonanti può essere relativamente immune agli effetti specifici della lingua fino al secondo anno di vita. Intorno ai 10 mesi di età alcuni bambini cominciano a produrre suoni simili a parole, utilizzati in maniera relativamente consistente in particolari contesti: per esempio "nana", suono prodotto nelle richieste; "bam", pronunciato in giochi in cui fanno cadere i giocattoli. Da questo momento in poi (se non prima) lo sviluppo fonologico infantile è fortemente influenzato da altri aspetti dell'apprendimento linguistico (cioè, grammatica e lessico). Si registra una considerevole variabilità tra i bambini per quanto riguarda i particolari suoni linguistici che preferiscono. Tuttavia, esiste una chiara continuità nei suoni preferiti da ogni bambino dalla lallazione prelinguistica alle prime parole. Questo risultato contraddice una famosa previsione del linguista R. Jakobson, il quale credeva che la lallazione prelinguistica e la produzione linguistica dotata di significato fossero discontinue. Lo sviluppo fonologico esercita una forte influenza sulle prime parole che i bambini cercano di produrre: essi, cioè, evitano l'uso di parole che non sanno pronunciare e fanno proprie nuove parole quando sviluppano un appropriato modello fonologico per quelle parole. Inoltre, lo sviluppo lessicale influenza fortemente i suoni che un bambino produce; più precisamente, i fonemi preferiti del bambino tendono a derivare dai suoni presenti nelle sue prime parole preferite. Infatti, sembra che i bambini trattino questi prototipi lessicalilfonologici come una sorta di campo base da cui partire per esplorare il mondo dei suoni prendendo varie direzioni, ma senza perdere mai di vista la propria casa.

Lo sviluppo fonologico interagisce con lo sviluppo lessicale e grammaticale per almeno 3 anni. Così, sembra che i bambini che hanno difficoltà con un particolare suono (per esempio, la s sibilante) posticipino l'uso produttivo delle flessioni grammaticali che contengono tali suoni (nel caso della s sibilante, il plurale in inglese). Un'altra diversa interazione lessicale/fonologica è illustrata dai molti casi in cui lo stesso suono linguistico viene prodotto correttamente nel contesto di una parola, ma erroneamente in un altro; per esempio, il bambino può dire "cacco" invece di "tacco" e non avere alcuna difficoltà nel pronunciare la t di "tetto". Pensiamo che ciò sia dovuto a fattori articolatori: è difficile spostare l'apparato fonatorio (della lingua) in avanti e indietro tra la posizione dentale (in t) e la posizione occlusiva velare (nella parte cc di "tacco"), così il bambino raggiunge un compromesso utilizzando solo una posizione ("cacco"). Cioè, il bambino può essere capace di produrre tutti i suoni rilevanti isolatamente, ma avere difficoltà a produrli nelle combinazioni richieste da certe parole bersaglio.

Dopo il terzo anno di vita, quando lo sviluppo grammaticale e lessicale si è assestato, anche la fonologia diventa più stabile e sistematica: per molti anni il bambino non produce più errori ovvi, oppure può persistere negli stessi errori fonologici (per esempio, la difficoltà nel pronunciare r e l) indipendentemente dal contesto lessicale. Quello che avviene dopo i tre anni di vita fino all'età adulta, per quanto concerne lo sviluppo lessicale, può essere genericamente sintetizzato in un aumento della fluenza che comprende un fenomeno chiamato coarticolazione per il quale i suoni che verranno pronunciati successivamente in una frase vengono anticipati preparando la posizione della bocca fm da un suono linguistico precedente (per cui la s di "sole" è qualitativamente diversa dalla s di "scopa").

Per riassumere, lo sviluppo del linguaggio come sistema di suoni comincia alla nascita o forse prima (nella percezione linguistica) e continua fino all'età adulta (con un incremento costante della fluenza e della coarticolazione per i primi 20 anni di vita). Tuttavia, c'è un momento nello sviluppo fonetico e fonologico che può essere considerato una sorta di spartiacque: gli 8÷10 mesi di età, caratterizzati da cambiamenti nella percezione (per esempio, l'inibizione di suoni linguistici che non appartengono alla madrelingua) e i cambiamenti nella produzione (per esempio, l'inizio della lallazione canonica e della deriva fonologica). Questi momenti chiave nell'apprendimento del linguaggio possono essere correlati ad alcuni importanti avvenimenti dello sviluppo cerebrale umano che si verifica circa nello stesso periodo, tra cui l' apparizione della sinaptogenesi (un'esplosione nella crescita sinaptica che inizia intorno agli 8 mesi e raggiunge l'apice tra i 2 e i 3 anni di età), insieme all'evidenza di cambiamenti nell'attività metabolica all'interno dei lobi frontali, e un incremento del controllo frontale su altre funzioni corticali e subcorticali (Elman et al., 1996). Questa interessante correlazione tra cervello e sviluppo comportamentale non è limitata ai cambiamenti del linguaggio: infatti, il periodo degli 8÷10 mesi è caratterizzato da cambiamenti fondamentali in molte aree cognitive e sociali, compresi gli sviluppi relativi all'uso di strumenti, alla categorizzazione e alla memorizzazione di oggetti, all'imitazione e alla comunicazione intenzionale per mezzo di gesti. In altre parole, i momenti più sensazionali dello sviluppo linguistico sembrano essere legati a cambiamenti esterni ai confmi del linguaggio, ulteriore prova che la nostra capacità di linguaggio dipende da fattori non linguistici. Questo ci porta al punto successivo, cioè a una breve panoramica sui substrati neuronali del linguaggio.

Basi neuronali di produzione e percezione linguistica

In questa sezione e in quelle successive riguardanti le basi neuronali del linguaggio, la trattazione verrà suddivisa in modo da rispecchiare i dati raccolti dalle due principali metodologie della neurolinguistica e delle neuroscienze cognitive. Saranno presi in esame dati ottenuti dallo studio di pazienti con lesioni monolaterali (metodo molto vecchio) e quelli ottenuti attraverso l'applicazione di tecniche di neurovisualizzazione nel monitoraggio dell'elaborazione linguistica in persone normali (metodo molto più recente).

Sebbene si speri che questi due ordini di prove convergano, fornendo una visione unificata dell'organizzazione cerebrale del linguaggio, non dovremmo sorprenderci di scoprire che spesso le due metodologie portano a risultati diversi. Gli studi che si occupano degli effetti delle lesioni focali sul comportamento linguistico potrebbero indicarci quali regioni cerebrali sono necessarie per un normale uso della lingua. Gli studi che impiegano tecniche di neurovisualizzazione in soggetti normali possono dirci quali regioni cerebrali partecipano all'uso normale della lingua. Ma questi due risultati non sono necessariamente la stessa cosa.

Cosa ancora più importante per i nostri scopi, gli studi sulle lesioni e sulle tecniche di neurovisualizzazione non possono dirci dove risiede il linguaggio o qualsiasi altra funzione cognitiva superiore, cioè dove vive il 'sapere', che è indipendente da uno specifico compito. La presa elettrica sul muro dietro al televisore è necessaria per il normale funzionamento del televisore stesso (provate a togliere la spina e vi renderete conto di quanto questa sia importante). Possiamo anche dire che la spina partecipi attivamente al processo con il quale vengono visualizzate le immagini. Ciò non significa che le immagini si trovino nella spina, e non vuole nemmeno dire che le immagini passano attraverso la spina per arrivare allo schermo! Gli studi sulla localizzazione sono controversi e meritano di esserlo. La figura (fig.7) mostra una versione della mappa frenologica di F.I. Gall e le. Spurzheim proposta nel 18° secolo, ancora oggi la versione più nota e maggiormente ridicolizzata dell'idea che le facoltà superiori siano ubicate all'interno di aree discrete del cervello. Esistono tutt'oggi varianti moderne della dottrina frenologica, tra cui, per esempio, le teorie che propongono che la libera volontà risieda nella corteccia frontale, la percezione delle facce nel lobo temporale e il linguaggio in due aree dell'emisfero sinistro, una anteriore (l'area di Broca) e un'altra posteriore (l'area di Wernicke). Come vedremo in questa breve panoramica, non esiste una visione freno logica del linguaggio che possa spiegare le prove attuali ottenute mediante gli studi sulle lesioni o mediante le tecniche di neurovisualizzazione applicate all'attività cerebrale. Il linguaggio, piuttosto, sembra un evento che riguarda diverse aree del cervello, un processo complesso che non risiede in un unico luogo. Nonostante sia opportuno notare che alcune aree sono più importanti di altre, queste non devono essere considerate 'la scatola del linguaggio'. Le molteplici abilità di una ballerina non risiedono nei suoi piedi, anche se questi sono certamente più importanti di altre parti del corpo. Lo stesso vale per alcune aree del cervello che certamente sono particolarmente rilevanti per l'uso normale del linguaggio, anche se non va, tuttavia, automaticamente concluso che il linguaggio risieda in tali aree. Tenendo ben presenti questi avvertimenti, diamo un rapido sguardo alla letteratura sulle basi cerebrali della percezione e della produzione linguistica.

Studi sul linguaggio in pazienti con lesioni cerebrali. - È noto da tempo che i traumi cranici possono danneggiare le capacità di comprendere e produrre il linguaggio. Di fatto questa osservazione, pubblicata per la prima volta nel Surgical Papyrus di E. Smith, è stata attribuita all'egiziano Imhotep. Da allora fino al 19° secolo non si è andati molto oltre questa semplice osservazione. Nel 1861 P.-P. Broca osservò un paziente chiamato Tan che sembrava in grado di capire ciò che le persone gli dicevano, ma era assolutamente incapace di comunicare verbalmente con loro; la sua produzione linguistica era, di fatto, ridotta al monosillabo 'tan' da cui derivava il suo soprannome. Il paziente morì e gli venne praticata un'autopsia pochi giorni dopo essere stato sottoposto a un test da parte di Broca. Un'immagine del suo cervello (conservato per i posteri) è riportata in figura (fig. 8). Una semplice osservazione della figura consente di individuare una cavità massiccia presso la terza circonvoluzione del lobo frontale sinistro, una regione oggi nota come area di Broca. Broca e i suoi colleghi sostennero che la capacità di produrre il linguaggio risiede in questa regione del cervello.

Nel corso dei decenni successivi, i ricercatori europei si dedicarono all'individuazione di ulteriori sedi delle facoltà del linguaggio. Si distinse tra questi C. Wernicke, che descrisse una lesione diversa, ritenuta la causa di deficit di comprensione in pazienti con produzione linguistica fluente. Anche questa regione (oggi nota come area di Wernicke) si trova nell'emisfero sinistro, lungo il giro temporale superiore in prossimità della giunzione dei lobi temporale, parietale e occipitale. È stata avanzata l'ipotesi che sia questa la sede della percezione del linguaggio e che sia annessa all'area di Broca sulla parte anteriore del cervello per mezzo di un gruppo di fibre detto fascicolo arcuato. I pazienti con lesioni circoscritte a tale fascio di fibre dovrebbero essere incapaci di ripetere le parole udite, benché capaci di produzione linguistica spontanea e di comprensione di gran parte dei discorsi ascoltati. Questa sindrome (detta afasia di conduzione) venne teorizzata sulla base della teoria di Wernicke, e negli anni che seguirono alcuni ricercatori sostennero di poterne dimostrare l'esistenza. Sulla base di questo modello di organizzazione cerebrale per il linguaggio, sono state individuate ulteriori aree responsabili della lettura (e quindi dell' alessia) e della scrittura (e quindi dell'agrafia), e sono stati aperti dibattiti circa la relativa possibilità di scindere o dissociare le nuove sindromi afasiche (cioè, l' alessia può manifestarsi senza l'agrafia?).

Tale interpretazione neofrenologica è stata oggetto di critiche in diversi momenti della storia dell'afasiologia, tra cui la famosa opera di S. Freud Sull'afasia, che ridicolizza il modello Wernicke-Lichtheim (Freud, 1953), e l'arguta quanto influente critica di H. Head sulle localizzazioni, i cui sostenitori vennero chiamati da Head 'costruttori di diagrammi' (Head, 1926). Le teorie dei fautori delle localizzazioni caddero davanti alle prime difficoltà sorte tra il 1930 e il 1960, l'era della psicologia comportamentista, quando l'attenzione si spostò sul ruolo dell'apprendimento e sulla plasticità del cervello. Queste teorie tornarono nuovamente in auge negli anni Sessanta grazie agli scritti influenti di N. Geschwind e al forte approccio innatista al linguaggio e alla mente proposto da Chomsky e dai suoi seguaci.

Le opinioni dei localizzazionisti continuano a riscuotere successo, ma al giorno d'oggi sembrano giunte a una fase di stallo, dovuta (paradossahnente) alla elevata precisione delle immagini ottenute con la tecnica (NMR, Nuclear Magnetic Resonance, risonanza magnetica nucleare) e con altri metodi che consentono di determinare l'esatta localizzazione delle lesioni associate alle sindromi afasiche. La teoria classica della corrispondenza lesione-sindrome sta perdendo terreno. Per esempio, N.F. Dronkers (1996) ha dimostrato che le lesioni dell'area di Broca non sono né necessarie né sufficienti a giustificare le difficoltà di produzione dellinguaggio alla base dell'afasia di Broca. Infatti, l'unica regione cerebrale che appare saldamente legata ai deficit nella produzione del linguaggio è un'area detta insula, nascosta nelle pieghe tra i lobi frontale e temporale. Quest'area ha un'importanza cruciale, ma il suo apporto può essere presente in misura relativamente ridotta, come mediatore del feedback (retro azione ) cinestesico dal volto e dalla bocca.

Lo stesso si può dire della percezione del linguaggio. È certo che nell'adulto la comprensione può essere danneggiata da lesioni al lobo temporale. Tuttavia la natura e la sede del danno non sono ancora noti. Tra i sintomi che colpiscono la percezione del linguaggio, il più grave è la sindrome detta sordità verbale pura. Gli individui affetti da questo disturbo sono assolutamente incapaci di riconoscere le parole pronunciate, benché reagiscano ai suoni e siano in grado (in molti casi) di classificare correttamente suoni ambientali significativi (cioè, associare il suono del latrato di un cane con l'immagine del cane). Non si tratta di un deficit della semantica lessicale, dal momento che alcuni individui affetti da questi disturbi sono in grado di comprendere le stesse parole in forma scritta. Poiché tali individui non sono sordi, è facile supporre che la sordità verbale pura rappresenti la perdita di una struttura cerebrale localizzata che esiste solo nel linguaggio. Tuttavia, ci sono due motivi per essere cauti prima di accettare tale conclusione. In primo luogo, i danni che determinano la sordità verbale sono bilaterali (cioè, una vasta porzione di corteccia uditiva danneggiata su entrambi i lati), e perciò non seguono la consueta asimmetria sinistra/destra osservata nelle sindromi relative al linguaggio. In secondo luogo, da un punto di vista logico, è difficile operare una distinzione tra un contrasto linguaggio/non linguaggio (distinzione dominio-specifica) e un contrasto complesso/semplice (distinzione dominio-generale). Come precedentemente rilevato, il linguaggio è un fenomeno uditivo fin troppo complesso. Non ci sono altri suoni ambientali rilevanti in grado di raggiungere tali livelli di complessità (latrato dei cani, suono di campanelli, ecc.). È dunque probabile che i danni responsabili della sordità verbale producano i loro effetti dando origine a un deterioramento globale, non specifico, del processo uditivo sufficientemente grave da inibire il linguaggio, ma non abbastanza per impedire il riconoscimento di altri fenomeni uditivi più elementari.

Tali considerazioni ci portano a prendere in esame un fenomeno diverso, ma correlato. Esiste una sindrome dello sviluppo detta disfasia congenita o disturbo specifico del linguaggio, una menomazione che determina nei bambini un forte ritardo nello sviluppo del linguaggio in assenza di qualsiasi altra sindrome responsabile del ritardo, cioè senza alcun segnale di ritardo mentale, sordità, menomazioni neurologiche evidenti come la paralisi cerebrale, né deficit socioemotivi come quelli responsabili dell'autismo. Alcuni teorici sostengono che si tratti di una sindrome dominiospecifica che prova l'indipendenza del linguaggio dalle funzioni cognitive (v. oltre). Tuttavia altri teorici hanno ipotizzato che questa forma di ritardo del linguaggio sia il sottoprodotto di impercettibili deficit del processo uditivo non specifici del linguaggio, ma che lo danneggiano più di qualsiasi altro aspetto del comportamento. Tale affermazione è ancora piuttosto controversa, ma le prove si stanno disponendo a suo favore (Bishop, 1997; Leonard, 1998). Se queste argomentazioni sono esatte, allora dobbiamo riformulare la distinzione netta tra le componenti fin qui esaminate, a favore di una teoria in cui i deficit uditivi portano a deficit nella percezione del linguaggio, che a sua volta determinano deficit nell'apprendimento del linguaggio.

Studi funzionali del linguaggio attraverso le tecniche di neurovisualizzazione. - Con la scoperta di nuovi strumenti come la tomografia a emissione di positroni (PET, Positron Emission Tomography) e la risonanza magnetica nucleare funzionale (fMRI, functional Magnetic Resonance Imaging), siamo in grado di osservare il funzionamento del cervello normale. Se l'approccio frenologico dell'organizzazione del cervello relativamente al linguaggio fosse corretto, allora riuscire a localizzare le aree relative a ogni singola componente del linguaggio diventerebbe solo una questione di tempo. Tuttavia, i risultati finora conseguiti sono molto scoraggianti per la dottrina frenologica.

Partendo dalla percezione del linguaggio, D. Poeppel (1996) ha rivisitato sei studi pionieristici sull'elaborazione fonologica che hanno utilizzato la PET. Poiché la fonologia è molto più vicina alla fisica del linguaggio rispetto ad altre discipline più astratte come la semantica e la grammatica, potremmo aspettarci da questo settore i primi risultati sulla corrispondenza cervello-linguaggio. Poeppel fa notare, tuttavia, che virtualmente non esistono punti comuni tra questi sei studi sulle regioni che sembrano essere più attive durante l'elaborazione dei suoni linguistici! Nonostante sia gli studi di lesioni sia quelli di neurovisualizzazione atte stino un interessamento dei lobi frontale e temporale, in particolare delle aree adiacenti la scissura silviana (corteccia perisilviana), incluse le aree di Broca e Wernicke, anche altre aree sembrano coinvolte in questo processo, aree che variano notevolmente da uno studio all'altro. Comunque ciò che più importa ai fini della nostra analisi è che non vi è prova in tutti questi studi di un unico 'centro di elaborazione fonologica' attivato da tutti i compiti che comportano un'elaborazione fonologica.

Prove ulteriori in questa direzione provengono da alcuni studi sulla produzione linguistica (compreso il linguaggio silenzioso, in assenza di veri e propri movimenti della bocca). Anche in questo caso l'attivazione dell'emisfero sinistro è immancabilmente superiore rispetto a quella del destro (Toga et al., 1996). È interessante notare che l'insula sinistra è la regione che emerge con maggiore frequenza dagli esami con tMRI e PET sulla produzione del linguaggio, un complemento alle scoperte di Dronkers sui deficit nella produzione linguistica dei pazienti afasici. Benché il ruolo dell'insula non sia stato compreso appieno, essa risulta particolarmente importante nella mediazione del feedback cinestetico dai diversi articolatori (le parti del corpo che si muovono), e l'area interessata dai deficit nella produzione linguistica sembra essere quella che svolge un ruolo nella mediazione del feedback dal volto e dalla bocca. A parte questo fattore relativamente poco rilevante, nessuna regione può essere considerata il centro della produzione del linguaggio.

Uno studio particolarmente interessante sul tema concentra l'attenzione sulle diverse sottoregioni che formano l'area di Broca e la corteccia adiacente (Erhard et al., 1996). L'analisi mediante tMRI è stata utilizzata per mettere a confronto l'attivazione all'interno e attraverso il complesso di Broca, in soggetti ai quali era stato richiesto di produrre i movimenti di linguaggio silenzioso, movimenti non linguistici semplici e complessi della bocca, nonché movimenti del dito a livelli di difficoltà variabili. Benché molte delle componenti del complesso di Broca siano attive per il linguaggio, tutte queste componenti sono ugualmente coinvolte in almeno uno dei compiti non linguistici. Vale a dire, non esistono aree della regione frontale che si attivano solo per il linguaggio.

Queste scoperte sul linguaggio mettono in risalto una tematica di rilievo nell'ambito delle tecniche di neurovisualizzazione, che riguarda la specificità del compito, piuttosto che la specificità dell'area. Vale a dire, i modelli di localizzazione o di attivazione sembrano variare secondo fattori quali la quantità e il tipo di memoria richiesta da un compito specifico, il suo relativo grado di difficoltà e di familiarità per il soggetto, l'attenzione richiesta, la presenza o l'assenza della necessità di sopprimere una risposta conflittuale, la richiesta o meno di una attività motoria silenziosa e così via. Tali fattori dominio-generici, ma specifici rispetto al compito, emergono in tutti gli studi condotti, con materiale linguistico e non. Per esempio, l'attivazione di un'area della corteccia frontale chiamata giro cingolato anteriore appare in tutti gli studi in cui è coinvolto un compito del tutto nuovo, e molto difficoltoso. Ciò significa che i compiti dominio-specifici 'si spostano' da un'area all'altra? Forse, ma è più probabile che 'spostamento' e 'residenza' siano metafore errate. Potremmo dover rivedere le nostre teorie sull' organizzazione del cervello per il linguaggio e altre funzioni su basi assolutamente diverse. La mia mano assume configurazioni decisamente diverse a seconda del tipo di compito che mi appresto a svolgere: prendere una spilla, sollevare un libro pesante oppure spingere una scatola pesante contro il muro. Uno studio sull'attivazione dei muscoli della mano per ogni tipo di compito evidenzierebbe una distribuzione delle attività fortemente differenziata per ognuno di questi compiti. Tuttavia esso non fornisce al dibattito contributi sostanziali per poter definire la prima configurazione 'processore spilla', la seconda 'processore libro', e così via. Analogamente, potremmo utilizzare le risorse sparse del nostro cervello in modi completamente diversi in base al tipo di compito che ci apprestiamo a svolgere. Alcune componenti secondarie di basso livello sono saldamente ancorate alla struttura fisica del linguaggio e indipendenti dal compito: le aree della corteccia alimentate direttamente dal nervo uditivo, oppure quella porzione dell'insula che gestisce il feedback cinestetico dalla bocca e dal volto. Se ci spostiamo a un livello superiore, tuttavia, possiamo aspettarci di trovare modelli di attività fortemente variabili e un'ampia distribuzione in abbinamento ai compiti linguistici. Torneremo sull'argomento in un secondo momento, quando prenderemo in esame le basi cerebrali di altri livelli del linguaggio.

Parole e grammatica

Modalità di elaborazione di parole e frasi da parte di adulti normali

La questione di fondo negli studi sull'elaborazione di parole e frasi è simile a quella che divide i linguisti. Da una parte si collocano i ricercatori che interpretano l' elaborazione grammaticale e l'elaborazione lessicale come attività mentali indipendenti, gestite da meccanismi mentali/neuronali differenti (Fodor, 1983). Affinché ciò avvenga, questi due moduli devono essere integrati a un dato momento dell'elaborazione, ma la loro interazione può avvenire esclusivamente dopo che ogni modulo ha completato il proprio lavoro. Dall'altra parte, troviamo i ricercatori che intendono il riconoscimento delle parole e l'analisi grammaticale come due aspetti di un unico complesso processo: il riconoscimento della parola è 'impregnato' dell'informazione relativa al livello di frase (Elman e McClelland, 1986), e l'elaborazione delle frasi è profondamente influenzata dalla natura delle parole contenute all'interno di ogni frase (MacDonald et al., 1994). Questa scissione degli psicolinguisti in modularisti e interazionisti rispecchia la divisione dei teorici dellinguaggio tra i sostenitori dell'autonomia sintattica (Chomsky, 1957) e i teorici che mettono in risalto la natura semantica e concettuale della grammatica (Langacker, 1987).

Negli anni Sessanta e Settanta, quando prevalse la teoria dell'autonomia, vennero fatti vari tentativi di sviluppare modelli di elaborazione in tempo reale di produzione e comprensione linguistica (cioè, modelli della prestazione che implementassero la stessa struttura modulare proposta sotto diverse formulazioni dalla grammatica generativa di Chomsky, cioè modelli della competenza; Fodor et al., 1974). Le varianti della comprensione presentavano una struttura tipo catena di montaggio, con input linguistici trasmessi in forma seriale da un modulo all'altro (fonetico fonologico grammaticale semantico). l modelli di produzione apparivano molto simili, con le frecce rivolte in direzione opposta (semantico grammaticale fonologico fonetico). Secondo questo approccio, ognuno di questi processi appare unidirezionale. Pertanto non è possibile che una informazione di livello più elevato, contenuta nella frase, influenzi il processo per mezzo del quale riconosciamo parole singole durante il processo di comprensione, e le informazioni relative ai suoni nella frase non possono influenzare il processo per mezzo del quale scegliamo parole singole durante la produzione.

La teoria dell 'unidirezionalità fu oggetto di numerose controversie intorno alla fine degli anni Settanta fino agli inizi degli anni Ottanta, specie per quanto concerne lo studio della comprensione. Una voluminosa serie di studi ha dimostrato gli effetti 'dall'alto in basso' prodotti dal contesto sui primi stadi del riconoscimento delle parole, sollevando seri dubbi relativamente a questa architettura strettamente seriale. Per esempio, A.G. Samuel (1981) presentò per via uditiva ad alcuni soggetti delle frasi che contenevano parole bersaglio, quali "meal" (pasto) o "wheel" (ruota). In questo studio, il fonema iniziale che differenziava due parole bersaglio venne sostituito da un rumore di breve durata (un veloce colpo di tosse), per esempio le parole "meal" e "wheel" vennero sostituite da "(rumore)-eel". In tali circostanze, i soggetti percepivano eel come "meal" nel contesto cena e "wheel" nel contesto trasporti, spesso senza neanche rilevare la presenza del colpo di tosse.

In risposta alle dimostrazioni degli effetti prodotti dal contesto, i sostenitori della teoria modulare hanno fatto riferimento a studi che mettono in evidenza limitazioni temporali nell 'uso di informazioni dall'alto in basso durante il processo di riconoscimento della parola (Onifer e Swinney, 1981), proponendo che il processo è effettivamente modulare e unidirezionale, ma solo per un lasso di tempo molto breve. Un esempio eloquente ci è fornito da esperimenti in cui parole semanticamente ambigue, come "cimice", sono uditivamente all'interno di una frase contesto che favorisce uno solo dei due significati della parola.

Per esempio: nel contesto insetto (cimice = insetto): "Avendo trovato una serie di scarafaggi e ragni nella stanza, contattarono degli esperti per individuare le cimici nella stanza"; invece nel contesto spionaggio (cimice = microfono nascosto): "Preoccupati del sistema di sorveglianza elettronico, chiamarono gli esperti per individuare le cimici nella stanza".

Poco dopo la presentazione della parola ambigua (il prime, cioè la parola responsabile della preattivazione), viene proiettata su uno schermo di un elaboratore una parola reale oppure una non parola (ovvero il bersaglio), e il compito dei soggetti è di decidere il più velocemente possibile se la parola bersaglio esiste realmente (cioè, si dà loro un compito di decisione lessicale). Le parole reali comprendevano sia parole correlate al prime o al significato contestualmente pertinente di "cimice" (per esempio, "spia" in un contesto di spionaggio), sia parole correlate all'accezione incongruente di "cimice" (per esempio, "formica" in un contesto di spionaggio), sia parole di controllo non in relazione con nessuna delle due accezioni (per esempio, "bicchiere" in un contesto di spionaggio). Se i soggetti reagiscono più velocemente a una parola correlata a "cimice" piuttosto che a una parola di controllo non correlata si parla di attivazione semantica o priming. Se l'accesso al lessico è un processo modulare, e non influenzato da un livello superiore del contesto, allora ci dovrebbe essere un periodo di tempo ridotto in cui "spia" e "formica" sono entrambe più veloci di "bicchiere". D'altro canto, se l'accesso al lessico è influenzato dal contesto nelle fasi iniziali, allora "spia" dovrebbe essere più veloce di "formica", e "formica" non dovrebbe essere più veloce della parola "bicchiere" non correlata. Il primo insieme di risultati ottenuti con questa tecnica sembrava supportare una visione modulare. Se il bersaglio e il prime sono distanziati di almeno 750 ms, il priming si ha solo nel caso di un significato contestualmente adeguato (accesso selettivo); tuttavia, se il prime e il bersaglio sono molto ravvicinati (250 ms o meno), si ha un effetto del prime per entrambi i significati della parola ambigua (accesso esaustivo).

Tali risultati vennero interpretati come riprova del modello a due fasi per il riconoscimento di parole: una fase ascendente (bottom up) che non subisce l'influenza del contesto, e una successiva fase discendente (top down) nella quale si applicano restrizioni contestuali.

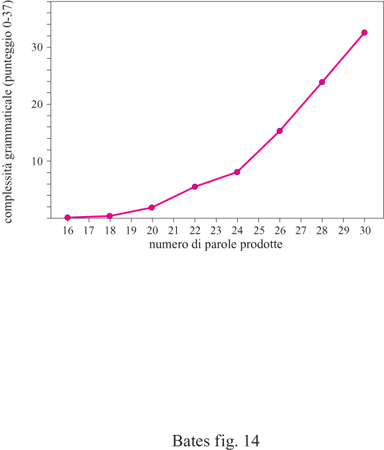

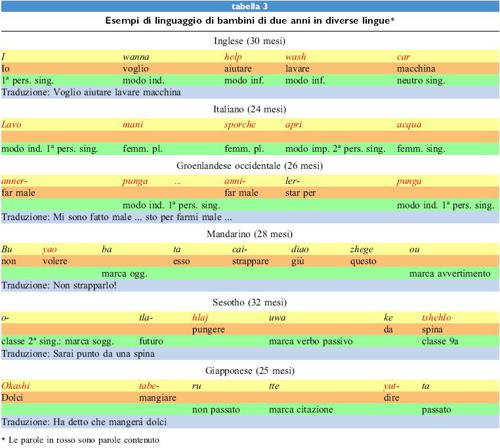

Benché la scoperta dell'accesso esaustivo sia stata riprodotta in molti laboratori diversi, la sua interpretazione rimane controversa. Per esempio, alcuni ricercatori hanno dimostrato che l'accesso selettivo non si verifica quando una parola ambigua viene presentata una seconda volta o quando contesti molto restrittivi favoriscono il significato predominante della parola.