Risonanza magnetica nucleare:applicazioni biochimiche e biologiche

Risonanza magnetica nucleare: applicazioni biochimiche e biologiche

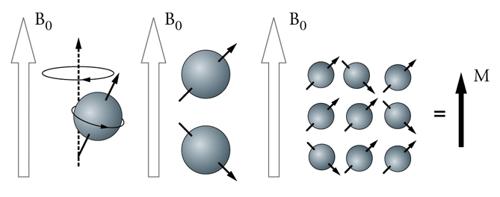

Subito dopo la sua scoperta negli anni Quaranta del Novecento, il fenomeno della risonanza magnetica nucleare (RMN), cominciò immediatamente a essere utilizzato come strumento di analisi spettroscopica in chimica. Le prime immagini RMN, ottenute tramite l’uso di gradienti di campo magnetico, furono pubblicate nel 1973 da Paul Lauterbur, che denominò la tecnica zeugmatography (dal greco zeũgma: legame, unione). Tale pubblicazione è riconosciuta come la nascita della risonanza magnetica per immagini (Magnetic resonance imaging, MRI), e fruttò al suo autore nel 2003 il premio Nobel per la medicina in condivisione con Peter Mansfield (che ne introdusse il formalismo matematico). Le prime apparecchiature commerciali per l’acquisizione di immagini RMN apparvero negli ospedali nella prima metà degli anni Ottanta del secolo scorso, e da allora l’uso della RMN si è rapidamente diffuso, grazie alla possibilità di produrre immagini dei tessuti molli in maniera non invasiva e senza radiazioni ionizzanti.

Una delle caratteristiche della RMN è la possibilità di manipolare i parametri di acquisizione per ottenere uno spettro quasi infinito di diversi contrasti d’immagine, che riflettono caratteristiche fisiche e chimiche del tessuto in esame. Proprio grazie a questa proprietà, oltre alle applicazioni più squisitamente diagnostiche, la RMN è usata oggi anche come strumento di ricerca nello studio della fisiologia e della fisiopatologia di svariate condizioni cliniche. Tramite tecniche RMN è cioè possibile misurare la concentrazione di acqua e di altre molecole di interesse biologico, le caratteristiche di diffusione dei tessuti, la permeabilità delle membrane, il flusso sanguigno, e altri parametri rilevanti. Alterazioni di queste grandezze possono accompagnarsi ad alterazioni biologiche causate da uno stato patologico, e per questo la RMN è uno strumento di indagine fisiopatologica dal potenziale enorme. Spesso si utilizza l’espressione RMN quantitativa per distinguere tali applicazioni avanzate, per la maggior parte ancora confinate alla ricerca clinica, dalla diagnostica per immagini, dove la RMN viene usata per produrre immagini qualitative, ovvero ‘fotografie’ dettagliate degli organi in esame, che richiedono l’interpretazione da parte di un radiologo. Tipicamente, la RMN quantitativa si basa sullo sviluppo di un modello che spieghi la dipendenza del segnale RMN da un processo fisico. Tale modello può quindi essere usato per estrarre delle grandezze fisiche da una serie di misure ottenute variando i parametri di acquisizione. Le tecniche quantitative non sono completamente validate come strumenti clinici, e di conseguenza la loro utilità nel singolo soggetto è limitata. Ciononostante, l’informazione da esse fornita è di grande portata nello studio dei tessuti biologici, e quindi nella comprensione dei meccanismi fisiopatologici delle diverse malattie.

Le tecniche quantitative o avanzate di RMN vengono frequentemente classificate come ‘strutturali’ e ‘funzionali’, a seconda che mirino a misurare proprietà dei tessuti (queste possono essere specifiche al fenomeno di risonanza magnetica, come i tempi di rilassamento, o indipendenti da esso, come il coefficiente di diffusione), oppure proprietà fisiologiche (tipicamente proprietà emodinamiche e attività funzionali del sistema nervoso centrale).

Applicazioni strutturali

Tempo di rilassamento longitudinale: T1

Si indica con il termine relaxometry la quantificazione dei tempi di rilassamento (T1, T2). I tempi di rilassamento caratterizzano il tempo richiesto dagli spin in un particolare tessuto per ritornare all’equilibrio dopo una perturbazione del campo magnetico e dipendono dalle caratteristiche microscopiche del tessuto in esame. Il rilassamento longitudinale (cessione dell’energia accumulata dagli spin nucleari durante l’irradiazione a radiofrequenza) è principalmente causato dai campi magnetici generati dalle molecole attorno a ogni spin. Quindi, T1 riflette indirettamente la mobilità e l’interazione delle molecole d’acqua e altre molecole presenti nel tessuto.

È opportuno chiarire la differenza fra le immagini pesate in T1 (o in T2) e le ‘mappe’ quantitative dei tempi di rilassamento. In un’immagine pesata in T1, il segnale e il contrasto sono influenzati dalla costante di rilassamento T1, ma dipendono anche da altri fattori come la densità protonica e il rilassamento T2. Il contributo relativo di ogni fattore è controllato dai parametri di acquisizione, scelti dall’operatore: di conseguenza l’intensità di ogni pixel non è una misura riproducibile e quantitativa di una proprietà intrinseca del tessuto, ma semplicemente un numero che rappresenta l’intensità di segnale in un scala arbitraria. Al contrario, con il termine mappa si intende un’immagine ottenuta come il risultato di un’elaborazione di più immagini di partenza, in cui ogni pixel rappresenta una grandezza con un preciso significato fisico o biologico, espressa in un’uni-tà di misura definita (nel caso delle mappe T1, in ms). Il valore della constante T1 è influenzato dalla concentrazione di macromolecole e dal contenuto d’acqua nei tessuti. Per questa ragione la sua misura è utile per la caratterizzazione di alcuni stati patologici. Esistono diversi metodi per misurare questa grandezza: i più diffusi si basano su sequenze inversion recovery o gradient echo. In presenza di alterazioni patologiche tissutali, sono osservabili variazioni dei tempi di rilassamento longitudinali. Tra gli esempi più noti, vi sono diverse patologie di interesse neurologico, dove un allungamento del tempo di rilassamento longitudinale può riflettere fenomeni di demielinizzazione, sofferenza ischemica, presenza di tessuto neoplastico. Al contrario, riduzioni di T1 sono osservabili in relazione a deposizione tissutale di ferro e ferritina, che caratterizzano altre malattie neurologiche.

Tempo di rilassamento trasversale: T2

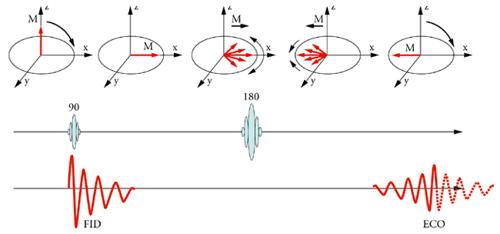

Il concetto di rilassamento trasversale è meno intuitivo del concetto di rilassamento longitudinale. Entrambi costituiscono meccanismi di dispersione dell’energia accumulata dagli spin. Mentre il rilassamento longitudinale è esclusivamente legato alla ridistribuzione energetica verso il lattice molecolare, cioè la riserva energetica costituita dagli stati energetici associati con le vibrazioni e rotazioni molecolari, al rilassamento trasversale contribuisce anche la cessione di energia degli altri momenti magnetici elettronici e nucleari. L’interazione con questi dipoli magnetici tende a distruggere la coerenza di fase fra spin, causa cioè l’accumulo di ritardi casuali nel moto di precessione che risultano nell’annullamento della componente trasversale della magnetizzazione M. La costante T2 governa questo processo, ed è più breve di T1. Oltre ai momenti magnetici microscopici, il decadimento della componente trasversale della magnetizzazione è accelerato dalla presenza di disomogeneità e perturbazioni del campo magnetico statico B0, facendo sì che gli spin perdano coerenza di fase con una costante di tempo T2*, più breve di T2. La seconda componente è tuttavia reversibile, grazie all’utilizzo della sequenza spin echo, illustrata in fig 2. Immediatamente dopo l’avvento di un impulso a 90°, tutti gli spin si trovano in fase, e la componente trasversale della magnetizzazione è massima. Poiché la velocità di precessione di ogni spin è proporzionale al campo magnetico da esso avvertito, le piccole disomogeneità di campo causano un progressivo sfasamento, che può essere recuperato con l’introduzione di un impulso di inversione (a 180°). L’effetto di questo impulso è quello di invertire la fase dei singoli spin, facendo sì che quelli in ‘anticipo’, perché caratterizzati da frequenza angolare superiore agli altri, si trovino in posizione arretrata, mentre quelli in ‘ritardo’ si trovino in posizione avanzata. Grazie a questo accorgimento, dopo un intervallo di tempo identico a quello intercorso tra l’impulso a 90° e quello a 180°, gli spin si trovano nuovamente in fase e si assiste alla produzione di una ‘eco’, cioè alla formazione di una nuova componente di magnetizzazione trasversale (fig. 3). La magnetizzazione trasversale può essere riformata più volte tramite una successione di impulsi a 180° ripetuti a intervalli regolari. L’ampiezza degli echi che si susseguono diminuisce nel tempo con andamento esponenziale e costante di tempo T2, che può quindi essere quantificata tramite tecniche di fitting.

La costante di rilassamento trasversale riflette principalmente il contenuto di acqua nei tessuti. Le applicazioni cliniche più note, nuovamente in campo neurologico, includono patologie caratterizzate da processi ischemici acuti e cronici e patologie demielinizzanti. Un’ulteriore applicazione riguarda il monitoraggio dello sviluppo cerebrale (processi di mielinizzazione delle fibre cerebrali) durante l’età evolutiva. Nei i primi sei mesi di vita, infatti, si assiste a un progressivo decremento dell’acqua contenuta nei tessuti cerebrali, cui corrisponde una riduzione di T2.

In tessuti complessi come quelli biologici, il de-cadimento della magnetizzazione trasversale ha spesso un andamento più complesso rispetto al modello monoesponenziale tradizionalemte adottato: è frequente osservare infatti un andamento di tipo biesponenziale, caratterizzato cioè dalla sovrapposizione di almeno due componenti che decadono con velocità diverse. La componente più breve è ritenuta essere associata all’acqua intrappolata in proteine come la mielina (la guaina che riveste i fasci di sostanza bianca, permettendo una trasmissione veloce dei segnali neuronali). La separazione delle diverse componenti è possibile, anche se richiede tempi di acquisizione lunghi per garantire sufficiente qualità dei dati.

Diffusione

Le molecole d’acqua, come ogni particella contenuta in un fluido, sono sottoposte a un moto browniano, in virtù dell’energia termica molecolare di cui sono dotate. A ogni urto, la singola particella cambia in modo accidentale la propria direzione di spostamento, cosicché nel tempo compie una traiettoria casuale. Il moto casuale dei protoni si manifesta come un’attenuazione del segnale RMN misurato in presenza di forti gradienti di campo magnetico. Questo fenomeno può essere sfruttato per rilevare spostamenti molecolari che avvengono nella scala temporale dell’ordine dei millisecondi. Poiché la mobilità molecolare è influenzata dalla struttura e dalle proprietà dei tessuti, come la presenza di strutture subcellulari, la misura della diffusione fornisce indici circa la configurazione tissutale a livello microscopico. Il succes-so della tecnica dell’RMN pesata in diffusione fu inizialmente dovuto all’osservazione (effettuata prima in modelli animali, e poi in vivo) che il coefficiente didiffusione decresce rapidamente nel tessuto cerebraleinteressato da un evento ischemico. Questo permettel’identificazione dell’evento in fase preclinica, quando è ancora possibile un intervento di riperfusione con salvataggio di parte del tessuto colpito da ischemia. L’interpretazione di questo fenomeno, generalmente accettata anche se non completamente verificata, è legata all’interruzione della respirazione cellulare (processo metabolico che produce la maggior parte dell’energia per il fabbisogno cellulare) e al conseguente blocco della pompa membranale che estromette dallo spazio intracellulare molecole di sodio per intromettere quelle di potassio. A ciò segue l’ingresso passivo di molecole di sodio all’interno della cellula, a cui si associa (per meccanismo osmotico) l’ingresso di molecole d’acqua, e quindi un rigonfiamento cellulare.

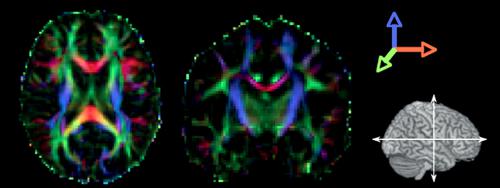

In seguito si osservò che il fenomeno della diffusione è anisotropo (varia con la direzione di misura) in molti tessuti, come per esempio la sostanza bianca cerebrale e il muscolo. Questo aspetto, che inizialmente costituì un ostacolo e un fattore di complicazione nella misura della diffusione tramite tecniche RMN, divenne poi uno degli aspetti più interessanti della metodica. In analogia con altri fenomeni anisotropi, la diffusione può essere descritta matematicamente da un tensore di ordine 2 (matrice 3×3), i cui elementi diagonali rappresentano i coefficienti di diffusione lungo le 3 direzioni principali del sistema di riferimento. Gli elementi fuori diagonale rappresentano il livello di correlazione fra lo spostamento medio delle molecole in due direzioni ortogonali. L’introduzione del tensore permette non solo di derivare quantità scalari invarianti per rotazione (cioè indipendenti dal sistema di riferimento), ma anche di estrarre informazioni addizionali, come la quantificazione dell’anisotropia, e la determinazione della direzione principale della diffusione (fig. 4). Questo ha portato allo sviluppo delle tecniche di trattografia, principalmente applicate allo studio della sostanza bianca cerebrale. Infatti, in virtù della sua peculiare struttura anatomica, il sistema nervoso centrale è costituito da neuroni, i cui assoni sono organizzati in fasci relativamente ben orientati, lungo il cui asse maggiore gli ostacoli alla diffusione dell’acqua sono estremamente inferiori rispetto a quelli (citoscheletro, mielina) dell’asse ortogonale. Fino a ora l’applicazione clinica più promettente della trattografia è risultata essere la pianificazione neurochirurgica, al fine di valutare se l’asportazione di una massa tumorale rischia di compromettere importanti fasci di sostanza bianca. È infatti possibile individuare i rapporti anatomici tra lesione tumorale e tessuto sano e caratterizzare i diversi tipi di tumore in maggiormente infiltranti o comprimenti, cui si associano elementi prognostici differenti.

Tutte le grandezze derivate dal tensore di diffusione misurano qualche proprietà microscopica dei tessuti, legata alla cellularità, all’organizzazione e all’integrità tissutale, e sono pertanto utili a caratterizzare il tessuto sano e patologico. Oltre all’ischemia cerebrale, le tecniche di diffusione sono ampiamente usate nello studio di diverse patologie neurologiche (sclerosi multipla, epilessia, tumore, demenza) e psichiatriche (schizofrenia, disturbo bipolare). Al di fuori del sistema nervoso centrale, la tecnica viene principalmente utilizzata per lo studio dei tumori della prostata, dove incrementa la confidenza diagnostica nel differenziare l’adenoma prostatico (lesione tumorale benigna) dal carcinoma (lesione maligna).

Trasferimento di magnetizzazione

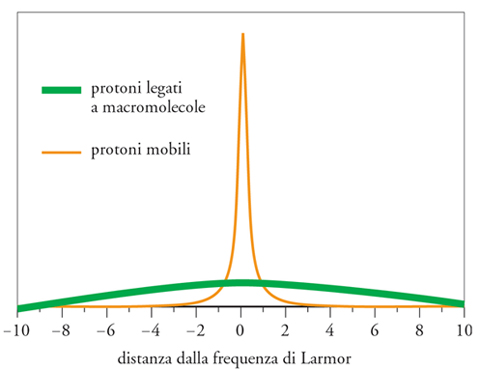

Il fenomeno del trasferimento di magnetizzazione (MT) fu scoperto in seguito alle osservazioni sperimentali di Wolff e Balaban. Si notò un’attenuazione del segnale RMN qualora la misura fosse preceduta o associata con irradiazione a frequenze diverse dalla frequenza di Larmor (saturazione off resonance). Il fenomeno, osservabile solo in alcuni tessuti, fu interpretato come un effetto dell’interazione fra i protoni contenuti nelle molecole d’acqua e quelli legati a macromolecole lipidiche e proteiche. Questi ultimi, infatti, a causa della rigida struttura molecolare in cui sono inseriti, hanno tempi di rilassamento T2 troppo brevi per essere misurabili mediante un acquisizione RMN convenzionale, ma sono anche caratterizzati da uno spettro di assorbimento di radiazione elettromagnetica molto più ampio delle molecole d’acqua (fig. 5). Questa interpretazione del fenomeno MT è supportata dal fatto che la riduzione di segnale è proporzionale alla quantità di macromolecole presenti nel tessuto in esame. Per questa ragione, l’effetto è pressoché nullo nel liquido cefalo-rachidiano, che è costituito per la quasi totalità da molecole d’acqua. Il fenomeno del trasferimento di magnetizzazione può essere quantificato tramite il cosiddetto magnetization transfer ratio (rapporto del trasferimento di magnetizzazione), o MTR, quantificato come la differenza percentuale fra il segnale RMN misurato in presenza e in assenza di saturazione off resonance. Nei tessuti biologici, l’MTR è sensibile principalmente alla presenza di lipidi e proteine, quindi è un indice indiretto della densità di tali molecole. Nell’encefalo, queste sono costituite in gran parte da mielina (la guaina che riveste i fasci di sostanza bianca, permettendo una veloce trasmissione dei segnali neuronali), la cui misura riveste interesse in numerosissime patologie, tra cui la sclerosi multipla. La tecnica è stata inoltre applicata allo studio di muscoli e cartilagini, della mammella e nella differenziazione di alcuni tipi di tumore.

Perfusione

L’obiettivo della perfusione è la misura locale del flusso sanguigno a livello del microcircolo. Tale flusso è associato al metabolismo energetico ed è dunque di interesse nella fisiopatologia. La perfusione si differenzia dall’angiografia RMN, che consente la visualizzazione dei principali rami venosi e arteriosi, con lo scopo di rilevarne eventuali anomalie. La misura della perfusione richiede l’utilizzo di un tracciante, che può essere esogeno, cioè un mezzo di contrasto paramagnetico che viene iniettato al paziente (dynamic contrast enhancement perfusion), o endogeno, come avviene nella tecnica chiamata arterial spin labelling (ASL). La prima soluzione è chiaramente più invasiva rispetto ad altre tecniche quantitative RMN, e il mezzo di contrasto più diffuso è il gadolinio, comunemente usato per la routine clinica. La tecnica consiste nella misura ripetuta a intervalli di circa 1 secondo del segnale RMN (pesato in T2*) durante il passaggio del mezzo di contrasto trasportato dal sangue. L’agente paramagnetico ha l’effetto di distorcere localmente il campo magnetico avvertito dai protoni di idrogeno. A causa di questa distorsione, la precessione dei diversi protoni avviene a frequenze leggermente diverse, causando uno sfasamento del segnale RMN che quindi risulta ridotto (questo corrisponde a una riduzione dei tempi di rilassamento T2 e T2*). Si assiste infatti a una brusca riduzione di segnale causata dall’aumento di suscettività magnetica e a un successivo ritorno all’equilibrio. Assumendo che la funzione di immissione arteriosa (arterial input function) sia nota, tramite un’operazione di deconvoluzione è possibile misurare il flusso sanguigno (Cerebral blood flow, CBF), il volume sanguigno locale (Cerebral blood volume, CBV), e il tempo medio di transito (Mean transit time, MTT). Questa tecnica è sensibile ad alterazioni del microcircolo, ed è per questo particolarmente utile nello studio delle malattie cerebrovascolari. L’applicazione principale rimane l’ischemia cerebrale acuta, grazie alla capacità di questa tecnica di identificare l’area di tessuto ipoperfuso entro pochi secondi dall’occlusione del vaso interessato. I parametri misurati, specialmente CBF e MTT, correlano inoltre con l’outcome clinico, e con il volume finale dell’infarto. Ulteriore informazione può essere dedotta dall’uso combinato di perfusione e diffusione: l’area identificata come anormale dalla perfusione è in genere più ampia di quella identificata dalla diffusione. L’interpretazione è che le anomalie misurate dalla diffusione rappresentino il tessuto che ha subito danno irreversibile, mentre le aree in cui solo la perfusione risulta alterata siano potenzialmente salvabili tramite terapia trombolitica. Questo ha quindi portato a identificare l’area di mismatch con la penombra ischemica. Sulla quantificazione del mismatch tra tessuto irreversibilmente danneggiato e sofferente, sono stati sviluppati protocolli terapeutici di riperfusione arteriosa fondati sulla trombolisi enzimatica dell’occlusione. Tali interventi non sono esenti da rischi aggiuntivi (complicanza emorragica). L’opportunità di adottarli viene, tra l’altro, quantificata in termini di rischio-beneficio sulla base della quantità di tessuto potenzialmente salvabile.

Nell’ASL, il tracciante è costituito dagli spin associati al sangue arterioso. Grazie all’applicazione di impulsi a radio frequenza (concomitanti a gradienti di campo) all’altezza delle carotidi interne, tali spin subiscono un’inversione di magnetizzazione durante il passaggio dal piano stesso, detto appunto labelling plane. Dopo un breve intervallo, il segnale RMN viene misurato nell’encefalo, e risulta ridotto rispetto al normale a causa del transito dei protoni etichettati (labelled). Un’applicazione molto promettente di questa tecnica è lo studio dell’attività funzionale, come alternativa al contrasto BOLD.

Anche la perfusione cardiaca può essere misurata tramite sequenze RMN: il metodo più diffuso (dynamic first pass imaging) sfrutta sequenze pesate in T1, acquisite in seguito alla somministrazione intravenosa di tracciante paramagnetico. Alcuni ricercatori hanno suggerito in alternativa all’iniezione di un mezzo di contrasto esogeno l’uso del contrasto BOLD (normalmente utilizzato per registrare l’attività cerebrale) come meccanismo endogeno.

Spettroscopia

La spettroscopia in vivo si è sviluppata in parallelo all’imaging, in maniera indipendente da esso. Ciò è soprattutto dovuto al fatto che la spettroscopia (Magnetic resonance spectroscopy, MRS) è nata come strumento per studiare il metabolismo cellulare, mentre la risonanza per immagini (Magnetic resonance imaging, MRI) era in principio indirizzata esclusivamente all’indagine morfologica. La spettroscopia misura la concentrazione di metaboliti, cioè di composti coinvolti in processi chimici che avvengono negli organismi viventi. Nel caso più frequente, i metaboliti studiati sono quelli che contengono idrogeno (e quindi sono sensibili al fenomeno di risonanza magnetica). Altri nuclei possono essere studiati con la spettroscopia in vivo, come il fosforo 31, il carbonio 13, il sodio, e il fluoro. Questi ultimi sono meno usati soprattutto a causa del loro intrinseco basso rapporto segnale-rumore rispetto all’idrogeno. Il fenomeno alla base della spettroscopia è il chemical shift (traslazione chimica). Lo shift a cui l’espressione si riferisce è quello della frequenza di risonanza del nucleo investigato a seconda della diversa struttura della molecola che lo contiene. Nella spettroscopia del fosforo, per esempio, le molecole dell’adenosin trifosfato (ATP), della fosfocreatina (PCr) nonché quella del fosforo inorganico (tutti elementi contenenti atomi di fosforo e presenti nei tessuti biologici) risuonano a frequenze lievemente differenti tra loro. Tale effetto è causato dalla composizione chimica molecolare, e in particolare dal campo magnetico generato dalla nube elettronica che circonda la molecola in esame, che si oppone al campo B0. Questa differenza di frequenza viene misurata in parti per milione (ppm).

Lo spettro è un grafico che mostra i picchi corrispondenti alla frequenza di risonanza dei diversi composti contenenti il nucleo di interesse. Lo spettro è ottenuto tramite la trasformata di Fourier dell’evoluzione temporale del segnale RMN sviluppatosi dopo un impulso di eccitazione. La concentrazione dei diversi metaboliti viene stimata misurando l’aerea dei diversi picchi, relativamente all’area di un picco di riferimento. La misura può essere ristretta a un volume di interesse (single voxel spectroscopy), o ottenuta da una regione più ampia, con risoluzione spaziale dell’ordine dei centimetri (Chemical shift imaging, CSI). La spettroscopia del protone è ampiamente utilizzata nello studio del sistema nervoso centrale, con riferimento principalmente alla concentrazione di N-acetil aspartato (NAA). Questo composto è presente esclusivamente nei neuroni, ed è quindi un eccellente indice di densità neuronale. È infatti molto comune trovarlo ridotto in patologie qua-li tumori cerebrali costituiti da cellule non neuronali,ictus, trauma, e altro. Sempre nell’ambito della spettroscopia protonica del sistema nervoso centrale, altri metaboliti di interesse biologico sono: (a) la creatina (Cr), una molecola coinvolta nei processi di accumulazione di energia, la cui concentrazione è relativamente stabile e, per questo viene tradizionalmente usata come riferimento interno per la quantificazione di altri composti; (b) la colina (Cho), un indice di permeabilità delle membrane cellulari; (c) il mio-inositolo (mI), considerato un marker delle cellule gliali; (d) il lattato (Lac), il cui picco, normalmente invisibile, si accentua, per esempio, in presenza di blocco della respirazione cellulare (per es., ischemia), in presenza di reazioni infiammatorie o di tessuti neoplastici (cellule con metabolismo prevalentemente glicolitico), in presenza di patologie con difetto della catena respiratoria (per es., malattie mitocondriali). Infine, il gruppo glutammato-glutammina (Glx) è di grande interesse in quanto coinvolto nei processi eccitatori-inibitori dei neuro-trasmettitori. La difficoltà di separazione dei due picchi ne ha però finora limitato l’applicabilità a 1,5T. Grazie all’aumentato potere risolutivo ad alto campo (3T, 4,7T, 7T), parte di questi problemi potrebbero essere presto superati. Al di fuori del sistema nervoso centrale, un’applicazione molto promettente della spettroscopia è la valutazione metabolica cellulare prostatica. In presenza di un tumore si osserva una riduzione della concentrazione di citrato (prodotto dalle cellule epiteliali) e un aumento della colina. Il metodo più efficace per distinguere il tessuto tumorale da quello sano è quindi basato sulla quantificazione del rapporto tra la somma delle concentrazioni di colina e creatina e la concentrazione di citrato.

Relativamente alla spettroscopia del fosforo, è stata utilizzata nello studio di patologie sia muscolari sia cerebrali caratterizzate da difetto energetico, come le malattie mitocondriali. Dallo spettro del fosforo, è infatti possibile quantificare in vivo la concentrazione delle principali molecole energetiche (ATP, fosfo-creatina), nonché valutare il pH intracellulare.

Applicazioni funzionali

Design sperimentale

Il temine risonanza magnetica funzionale (functional MRI, fMRI) si riferisce a tutte le tecniche RMN usate per misurare l’attività funzionale cerebrale durante lo svolgimento di compiti o la somministrazione di stimoli sensoriali. Il termine compito può indicare un semplice atto motorio, come il movimento di una mano, oppure lo svolgimento di attività cognitive complesse (linguistiche, mnestiche, attentive ecc.). Gli stimoli sensoriali possono essere visivi (presentazione di un’immagine), uditivi, tattili e così via. Un tipico esperimento fMRI consiste nell’acquisizione di un grande numero di immagini ottenute manipolando gli stimoli presentati o i compiti richiesti al soggetto in esame. Nel caso più semplice lo stesso numero di immagini viene collezionato in due o più condizioni, e un’analisi statistica rivela le aree in cui il segnale RMN differisce nelle diverse condizioni. L’approccio statistico è richiesto dalla piccola entità dell’effetto.

Contrasto dipendente dal livello di ossigenazione sanguigna (BOLD)

Il metodo di gran lunga più diffuso è il contrasto BOLD, soprattutto in virtù della maggiore sensibilità rispetto ad altre tecniche. Durante l’attivazione neuronale, l’energia richiesta dai processi metabolici a livello sinaptico è fornita sotto forma di adenosin trifosfato (ATP), prodotta dal metabolismo cellulare, prevalentemente aerobio. A una maggiore richiesta energetica consegue una maggiore richiesta di ossigeno e glucosio, e quindi di apporto sanguigno. Grazie alle diverse proprietà magnetiche dell’emoglobina ossigenata (ossiemoglobina) e deossigenata (deossiemoglobina), è possibile misurare l’attività cerebrale regionale tramite risonanza magnetica. In particolare, l’ossiemoglobina è paramagnetica, mentrela deossiemoglobina non lo è. I capillari e le vene contenenti deossiemoglobina producono quindi una distorsione locale del campo magnetico, con relativa riduzione del segnale RMN. Questo fenomeno fu ori-ginariamente dimostrato in studi su animali ipossici.

Il meccanismo su cui si basa il blood oxygenation level dependent (BOLD) contrast non è stato ancora completamente chiarito, ma sembra essere legato al fatto che l’attività neuronale induce vasodilatazione e quindi un aumento sia del flusso sia del volume sanguigno. L’aumento del flusso supera l’aumento del volume, facendo sì che l’apporto superi rapidamente la domanda. L’effetto macroscopico è l’aumento del rapporto tra ossi- e deossiemoglobina nel sangue venoso, e quindi un aumento del segnale RMN.

Arterial spin labelling (ASL)

La tecnica di perfusione ASL consente la quantificazione del flusso sanguigno, e di conseguenza, se accompagnato alla fMRI (acquisizione di immagini durante la presenza o assenza di stimoli) è in grado di identificare le aree in cui il flusso sanguigno aumenta durante una condizione (per es., attivazione) rispetto a un’altra (per es., riposo). Come descritto nella sezione dedicata alla perfusione, questa tecnica sfrutta un tracciante endogeno per caratterizzare il sistema vascolare microscopico. Il vantaggio principale rispetto al BOLD è il fatto che l’ASL misura una quantità fisiologica ben identificata, mentre le origini del contrasto BOLD sono meno ovvie. Inoltre, la localizzazione ottenuta con l’ASL appare più precisa e ristretta ai capillari, mentre, nonostante la maggiore sensibilità, la variabilità tra soggetti è molto superiore quando si utilizza il contrasto BOLD. La minore diffusione dell’ASL rispetto al BOLD è legata soprattutto al suo inerentemente scarso rapporto segnale-rumore. La diffusione di scanner RMN ad alto campo e lo sviluppo di nuove tecniche per ridurre gli artefatti potrebbero contribuire a una maggiore applicabilità dell’ASL agli studi funzionali.

Bibliografia

Basser 1994: Basser, Peter J. - Mattiello, James - LeBihan,Denis, MR diffusion tensor spectroscopy and imaging,“Biophysical journal”, 66, 1994, pp. 259-267.

Bloch 1946: Bloch, Felix - Hansen, William W. - Packard, Martin, The nuclear induction experiment, “Physical review”, 70, 1946, pp. 474-485.

Gadian 1995: Gadian, David, Nuclear magnetic resonance and its application to living system, 2. ed., Oxford, Oxford University Press, 1995.

Lauterbur 1973: Lauterbur, Paul C., Image formation by induced local interactions: examples employing nuclear magnetic resonance, “Nature”, 242, 1973, pp. 190-191.

Ogawa 1990: Ogawa, Seiji e altri, Oxygenation-sensitive contrast in magnetic resonance image of rodent brain at highmagnetic fields, “Magnetic resonance in medicine”, 14,1990, pp. 68-78.

Purcell 1946: Purcell, Edward M. - Torrey, Henry C. - Pound, Robert V., Resonance absorption by nuclear magnetic moments in solids, “Physical review”, 69, 1946, pp. 37-38.

Tofts 2003: Quantitative MRI of the human brain, edited by Paul Tofts, Chichester, Wiley, 2003.

Wolff, Balaban 1989: Wolff, Steven D. - Balaban, Robert S., Magnetization transfer contrast (MTC) and tissue water proton relaxation in vivo, “Magnetic resonance in medicine”, 10, 1989, pp. 135-144.