Quanti, teoria dei

Quanti, teoria dei

Meccanica quantistica, di Gian Carlo Wick

Elettrodinamica quantistica, di Gian Carlo Wick

Meccanica quantistica

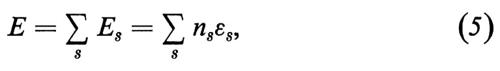

SOMMARIO: 1. Introduzione: a) il quanto d'azione; b) origini della teoria dei quanti; c) gli stati stazionari di Bohr; d) diffusione elastica e anelastica degli elettroni; e) il princioio di corrispondenza e lo spettro dell'atomo di idrogeno; f) regole di quantizzazione di Bohr-Sommerfeld. □ 2. Onde e particelle, esperienze cruciali: a) il dilemma; b) onde di de Broglie; c) interpretazione statistica delle ampiezze d'onda; d) effetto Compton, metodo delle coincidenze. □ 3. Meccanica quantistica: a) scoperta della teoria; b) problemi agli autovalori; c) l'equazione d'onda di Schrödinger; d) interpretazione statistica della funzione d'onda; e) equazione e funzioni d'onda per un sistema di n corpi; f) momento angolare intrinseco (spin) dell'elettrone, principio di esclusione. □ 4. Principi generali della meccanica quantistica: a) vettori di stato, operatori hermitiani; b) algebra degli operatori, commutatori; c) teoria delle trasformazioni; d) rappresentazione di Heisenberg. □ 5. Simmetrie o principi di invarianza nella meccanica quantistica: a) gruppi di trasformazioni delle coordinate; b) trasformazioni unitarie della funzione d'onda, leggi di conservazione; c) rappresentazioni, algebra di Lie; d) parità; e) formule di intensità, regole di selezione. □ 6. Formulazione relativistica: a) operatori di simmetria del gruppo di Lorentz inomogeneo; b) l'equazione di Dirac; c) problemi della meccanica quantistica relativistica. □ Bibliografia.

1. Introduzione.

a) Il quanto d'azione.

La ‛teoria dei quanti' esprime i concetti fondamentali e le leggi dinamiche della fisica in una forma compatibile con l'esistenza del ‛quanto d'azione' o costante di Planck h, una costante fisica universale che ha dimensioni [energia × tempo]. L'abbreviazione ℏ = ℏ/2π è oggi frequente; in unità c.g.s. h ha il valore:

ℏ = 1,0546 × 10-27 erg 5 (≃ 10-34 J s).

Una revisione delle idee della dinamica e dell'elettrodinamica classiche si era già iniziata al principio del secolo, quando la velocità della luce c nel vuoto era stata riconosciuta come limite superiore fondamentale alla velocità di propagazione di qualsiasi interazione (v. relatività). Eppure la revisione connessa con la costante h è ancora più radicale; sotto uno dei suoi aspetti la costante h è un quantum, nel senso di unità indivisibile, laddove la descrizione classica fa uso di variabili continue (esempi di grandezze che diventano ‛quantizzate' sono le componenti della quantità di moto angolare e l'integrale di ‛azione' su un'orbita periodica). Sotto un altro aspetto, anche più sorprendente, la costante h appare come l'anello di congiunzione fra interpretazioni della realtà fisica reciprocamente incompatibili dal punto di vista classico. Esempi tipici di questo aspetto sono le relazioni di Planck-Einstein e quelle di de Broglie tra gli aspetti corpuscolare e ondulatorio delle radiazioni (v. eqq. 9 e 10). Uno dei principali meriti del formalismo della meccanica quantistica è di esser riuscito a conciliare in un singolo schema coerente questi aspetti ‛complementari' della realtà.

b) Origini della teoria dei quanti.

D'ora in poi chiameremo ‛teoria classica' il quadro dei fenomeni ottici costruito verso la fine del secolo scorso, mediante una fusione della teoria elettromagnetica di Maxwell con la dinamica newtoniana delle particelle. Si ammetteva che la luce, o più generalmente la radiazione (infrarossa, visibile o ultravioletta), consistesse di onde elettromagnetiche di varia frequenza, le quali interagissero con la materia soprattutto grazie alla presenza, entro ogni atomo o molecola, di particelle cariche di massa piccolissima (elettroni). In base alla ben nota stabilità di atomi e molecole, era naturale supporre che questi elettroni fossero legati a posizioni di equilibrio. Consideriamo brevemente le conseguenze di queste ipotesi. Quando un elettrone oscilla intorno a una posizione di equilibrio con una certa frequenza, esso agisce come un dipolo di Hertz, emettendo un'onda sferica elettromagnetica della stessa frequenza; in questo modo, può venir trasferita energia dalla materia al campo elettromagnetico (emissione). Se la forza che lega ogni elettrone alla sua posizione di equilibrio è esattamente proporzionale allo spostamento, le oscillazioni saranno strettamente armoniche e la radiazione emessa dagli atomi consisterà di componenti monocromatiche (linee spettrali), come si osserva sperimentalmente. D'altra parte il campo elettrico di un'onda incidente, di frequenza v, può mettere in moto gli elettroni trasferendo energia nel senso opposto al precedente (assorbimento). L'effetto è assai più forte quando ν coincide con la frequenza di oscillazione spontanea di qualche elettrone ('assorbimento di risonanza'). L'elaborazione di queste idee, dovuta in buona parte a H. A. Lorentz (teoria degli elettroni), dà inoltre un quadro particolareggiato di molti altri fenomeni ottici (diffusione, rifrazione, ecc.).

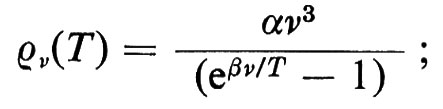

Le prime forti deviazioni dalla teoria classica vennero osservate verso la fine del secolo scorso nell'emissione di luce da parte di sostanze ad alta temperatura. Il problema teorico centrale consisteva nell'interpretazione della distribuzione spettrale della radiazione in equilibrio termico alla temperatura assoluta T (ossia della funzione ρν(T) definita come la densità di energia radiativa di frequenza v, per unità di volume e di intervallo di frequenza). La distribuzione prevista classicamente (la cosiddetta formula di Rayleigh-Jeans) è in accordo con l'esperienza alle basse frequenze, ma è errata alle alte frequenze. L'esperienza conferma invece una formula proposta da Planck nel 1899, che dà la distribuzione spettrale ρν(T) della cosiddetta ‛radiazione di corpo nero'.

in questa celebre formula le costanti α e β sono connesse alle costanti universali c, h e k : α = 8πhc-3, β = hk-1 (k è la costante di Boltzmann = 1,38 × 10-16 erg/0K). Le misure di Rubens nell'infrarosso diedero la prima verifica accurata della formula di Planck. Da allora la sua validità non è mai stata messa seriamente in questione.

In breve tempo Planck riconobbe l'origine delle difficoltà teoriche nel fallimento della formula statistica classica, = kT, per l'energia media Ä di un oscillatore armonico unidimensionale a temperatura T. Il passo decisivo (dicembre 1900) viene compiuto con un'audace innovazione nel calcolo di Ä; invece della tradizionale distribuzione continua (di Boltzmann) nello spazio delle fasi, Planck suppone che l'energia di eccitazione di un oscillatore di frequenza ν non possa essere altro che un multiplo di un certo ‛quanto di energia' ε proporzionale alla frequenza,

ε = hv, (1)

e ottiene così per Ä una formula che conduce alla sua legge della radiazione.

È chiaro che una relazione come la (1) è del tutto estranea alla fisica classica; ma il suo pieno significato si rivela solo nelle formulazioni successive di Einstein (1905) e di Bohr (v., 1913). Secondo Einstein la ‛quantizzazione' del moto oscillatorio armonico deve essere un fatto di importanza generale; si deve applicare, per esempio, al moto oscillatorio di atomi o molecole legati elasticamente entro un cristallo; il che conduce a una comprensione profonda delle proprietà termodinamiche dei solidi a bassa temperatura (calori specifici anomali, principio di Nernst, ecc.). Ancor più importante è la ‛concezione euristica' dei fenomeni di emissione ε assorbimento della luce proposta da Einstein, concezione che precisa notevolmente l'ipotesi originale di Planck. Quando un ‛oscillatore' entro un atomo emette un quanto ε di radiazione, non possiamo descrivere il processo mediante l'immagine classica di un'onda sferica emessa. Ciò condurrebbe a gravi paradossi; per esempio: l'energia totale e dell'onda è distribuita in tutte le direzioni; se l'onda si espande radialmente, diventando sempre più debole, come può l'intero quanto di energia raccogliersi di nuovo in un punto lontano quando avviene l'assorbimento? Da questa e da altre argomentazioni, fondate sulla teoria delle fluttuazioni di energia, Einstein deduce che i quanti della radiazione devon venir concepiti come corpuscoli, detti anche ‛fotoni', che si muovono alla velocità della luce. Poiché secondo le leggi della meccanica relativistica tali corpuscoli debbono possedere una quantità di moto p = ε/C e poiché l'emissione è unidirezionale, l'atomo emittente deve ricevere un impulso ε/C nella direzione opposta.

L'esistenza di questo impulso fu verificata direttamente assai più tardi (nel 1933), mediante la tecnica dei raggi molecolari, da R. Frisch. Quando propose la ‛concezione euristica', Einstein poteva solo citare a suo sostegno alcuni risultati qualitativi di P. Lenard sull'emissione fotoelettrica da parte di superfici metalliche. Questi mostravano che la luce di bassa frequenza v non è in grado di estrarre elettroni, indipendentemente dalla sua intensità. Dal punto di vista classico questo comportamento è incomprensibile. Viceversa, se si ammette che l'emissione di un elettrone sia dovuta all'assorbimento di un singolo quanto hv, viene spontaneo pensare che i quanti di bassa frequenza non posseggano sufficiente energia per estrarre un elettrone. Perseguendo quest'idea fino in fondo Einstein predisse: a) l'esistenza di una netta ‛soglia' ν0 dell'effetto fotoelettrico, dove hv0, il lavoro di estrazione, misura per ogni metallo il valore minimo dell'energia di legame di un elettrone; b) l'esistenza di un limite superiore h(ν − ν0) per lo spettro di energia cinetica degli elettroni estratti da luce di frequenza ν. Queste previsioni furono brillantemente verificate da Millikan nel 1916; si ebbe così anche la prima misura di precisione della costante di Planck.

c) Gli stati stazionari di Bohr.

Con il lavoro di N. Bohr (v., 1913) si compie un altro passo in avanti. Egli parte dalla necessità di riconciliare le proprietà più elementari degli atomi, come la loro caratteristica stabilità, con il modello nucleare di Rutherford (v. atomo), secondo il quale ogni atomo consiste di un nucleo pesante, carico positivamente, circondato da un sistema di elettroni tenuti insieme dall'attrazione coulombiana del nucleo. Grazie all'analogia tra la legge di Coulomb e la gravitazione newtoniana, un tale sistema presenta una notevole somiglianza con il sistema planetario.

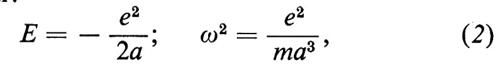

Le principali difficoltà cui va incontro questo modello sono sufficientemente illustrate dal più semplice sistema di questo genere, l'atomo di idrogeno, consistente di un singolo elettrone di carica −e e massa m (e = 4,803 × 10-10 u.e.s., m = 0,911 × 10-27 g) circolante intorno a un protone di carica + e e di massa mp = 1.836 m. Se trascuriamo per il momento la forza reattiva dovuta all'emissione di radiazione e altre piccole correzioni, possiamo mostrare che l'elettrone si muove su un'orbita periodica ‛kepleriana'; l'asse maggiore 2a, l'energia totale (potenziale + cinetica) E e il periodo di rivoluzione T relativi a tale orbita sono legati dalle relazioni:

dove ω = 2π/T è la velocità angolare media, che in base alla seconda equazione vana proporzionalmente ad a-3/2. Si noti che T ∝ a3/2 è la terza legge di Keplero. Si noti anche, per il seguito, la relazione: ω ∝ ∣ e ∣3/2.

Orbene, un fatto notevole è che, se in queste formule si pone 2a uguale al diametro osservato dell'atomo di idrogeno (2a ≃ 1 Å = 10-8 cm), se ne deducono per ∣ E ∣ e ω valori grosso modo corretti per l'energia ‛di ionizzazione' e per la frequenza dell'assorbimento di risonanza dell'idrogeno. D'altra parte si può vedere che, per ragioni puramente dimensionali, il modello stesso non possiede una lunghezza caratteristica; senza fare uso di dati sperimentali, le dimensioni dell'orbita rimangono completamente arbitrarie. Un'obiezione ancor più seria nasce, come Bohr fa notare, quando si considerano gli effetti radiativi; infatti la forza di reazione radiativa, benché molto piccola, a lungo andare fa sì che il sistema sia completamente instabile. Questa difficoltà è dovuta sostanzialmente al fatto che l'eq. (2) non pone alcun limite inferiore all'energia E (attribuendo un raggio finito al protone, si può introdurre nel problema una lunghezza ‛fondamentale' e con essa anche un limite inferiore all'energia E della (2); esperimenti sulla diffusione delle particelle, e anche di elettroni, indicano tuttavia che tale raggio finito è così piccolo da non essere pertinente in questa discussione). Ne segue che l'emissione di radiazione è sempre possibile, con una graduale contrazione dell'orbita. Poiché dipende da a, lo spettro emesso sarebbe ‛continuo' e ciò comporterebbe un'altra difficoltà.

Invece di attribuire queste difficoltà al modello di Rutherford, Bohr ne scorge la radice nei difetti delle leggi dell'elettrodinamica classica già rivelati dall'analisi di Planck e Einstein. Il rimedio deve dunque consistere nella ‛quantizzazione' del moto dell'elettrone. In primo luogo si introduce così nel problema una nuova costante, cioè ℏ, che insieme a e ed m definisce una lunghezza, il cosiddetto raggio di Bohr

aB = ℏ2/me2 = 0,529 × 10-8 cm, (3)

il quale, cosa assai notevole, è dell'ordine di grandezza delle dimensioni atomiche osservate. Dobbiamo inoltre aspettarci che le ‛regole di quantizzazione', quali che siano, permettano, tra tutte le possibili orbite classiche, una particolare successione di orbite; trovare le corrette regole di quantizzazione rappresenta naturalmente una non semplice estensione della prescrizione originale di Planck (che vale solo per un moto armonico). Il modo in cui Bohr affronta questo problema, sebbene di notevole interesse storico, non può venir qui riassunto adeguatamente. Tra le numerose idee nuove che Bohr utilizza, vi sono: a) due postulati fondamentali, che hanno superato indenni la totale revisione della teoria effettuata negli anni 1925-1926; b) l'altrettanto fondamentale ‛principio di corrispondenza'; c) vari principi particolari, che, essendo poi stati notetevolmente estesi e perfezionati da A. Sommerfeld, sono ora noti come ‛regole di quantizzazione di Bohr-Sommerfeld'.

I due postulati di Bohr sono i seguenti.

A. Ogni atomo possiede una successione discreta di valori possibili dell'energia o ‛livelli energetici':

E1, E2, E3, . (4)

(in ordine crescente; il livello più basso, E1, è chiamato stato fondamentale).

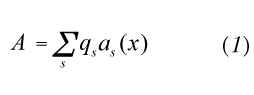

B. L'atomo può compiere ‛transizioni' da un livello energetico a un altro; la differenza di energia viene emessa o assorbita sotto forma di un quanto di luce di frequenza ν. La conservazione dell'energia nell'atto elementare di emissione o di assorbimento viene espressa dalla condizione di Bohr

hν = En − Em, (5)

dove En ed Em sono rispettivamente il livello superiore e il livello inferiore tra cui avviene la transizione (v. fig. 1).

Anche dopo che l'applicazione della meccanica quantistica è stata estesa dal campo atomico a quello dei fenomeni nucleari i due postulati hanno conservato la loro validità. Dovunque nel seguito si parli di livelli atomici, righe spettrali ecc., si può anche intendere: livelli nucleari, righe dello spettro γ, ecc.

Il postulato A non fa altro che affermare più esplicitamente l'idea che in un sistema legato son possibili soltanto certi movimenti ‛quantizzati', mentre il postulato B spinge alle estreme conseguenze le idee di Planck e di Einstein sull'emissione e sull'assorbimento della luce. (Bohr ammette, in via provvisoria, che le stesse orbite, sia pure quantizzate, siano descritte dalla dinamica classica; il postulato B rappresenta pertanto una deviazione più radicale dalla dinamica classica che non il postulato A, ma è solo con la meccanica quantistica del 1925-1926 che si arriva a un distacco completo dalla nozione classica di orbita).

La (5) implica naturalmente che gli spettri atomici sono spettri di righe (non ‛continui'); per di più essa riassume in modo estremamente compatto una quantità sorprendente di fatti sperimentali (alcuni dei quali verranno discussi più avanti: v. cap. 1, ÈÈ d ed e).

In particolare essa fornisce un'interpretazione tanto semplice quanto profonda di certe regolarità ben note già da lungo tempo agli spettroscopisti e riassunte nel ‛principio di combinazione' (v. atomo). Tale principio afferma che l'inverso della lunghezza d'onda, o ‛numero d'onda' ν/c di ogni riga spettrale può venire espresso come differenza tra due ‛termini' di un sistema (di termini) caratteristico dell'atomo emittente. La (5) dice infatti proprio questo, fornendo inoltre l'informazione preziosa che i ‛termini', a meno del fattore hc, sono null'altro che i livelli energetici dell'atomo.

d) Diffusione elastica e anelastica degli elettroni.

Una conferma diretta dell'esistenza di questi livelli energetici discreti fu raggiunta nello stesso anno 1913 con gli esperimenti di J. Franck e G. Hertz; tecniche elettroniche più progredite permisero in seguito non solo di mostrare con grande chiarezza l'esistenza dei livelli, ma anche di misurarli accuratamente (si noti che vi sono analoghe esperienze, a energie assai più alte, in cui si usano elettroni, protoni, ecc. come particelle incidenti, per dimostrare l'esistenza dei livelli energetici del nucleo).

In un tipico esperimento un fascio parallelo di elettroni, di energia cinetica W0 ben definita, incide su un gas di atomi di una data specie. Rispetto alle velocità elevate degli elettroni, gli atomi si possono considerare praticamente fermi. Si suppone inoltre che essi siano ‛freddi', cioe tutti nello stato fondamentale. Si osserva che gli elettroni diffusi secondo una direzione che forma un angolo ϑ col fascio incidente si suddividono in generale in vari gruppi discreti monoenergetici. Partendo dai principi di conservazione dell'energia e della quantità di moto nell'urto di un elettrone con un atomo e applicando il postulato A di Bohr, si prevede che, a prescindere da una piccolissima correzione dipendente da ϑ e dovuta all'impulso che l'atomo riceve nel suo insieme, il gruppo più energetico di elettroni diffusi abbia la stessa energia W0 degli elettroni incidenti (diffusione ‛elastica'); analogamente, le differenze W0 - W1, W0 − W2 ... tra W0 e le energie W1, W2 ... dei gruppi di elettroni diffusi anelasticamente dovrebbero coincidere con le ammissibili energie di eccitazione dell'atomo, E2 - E1, E3 − E1, ..., dedotte dallo spettro ottico. È esattamente quello che si trova; inoltre la presenza di gruppi diffusi anelasticamente è accompagnata (come prevede la teoria) dall'emissione di righe spettrali corrispondenti a transizioni dell'atomo eccitato a livelli più bassi.

e) Il principio di corrispondenza e lo spettro dell'atomo di idrogeno.

L'esempio più semplice e più famoso del principio di combinazione fu scoperto nel 1885 da Balmer, il quale mostrò che le quattro righe dell'idrogeno allora note potevano essere rappresentate assai accuratamente da una semplice formula aritmetica; essa prevede in realtà, con grande esattezza, centinaia di altre righe scoperte più tardi. La formula si può ottenere dalla (5), se a questa si aggiunge l'informazione che i livelli energetici dell'idrogeno sono dati da:

dove

R = 109.678 cm-1 (7)

è una costante ed n = 1, 2, 3,... è un intero, detto anche ‛numero quantico principale'. R è la ‛costante di Rydberg' per l'idrogeno e dovrebbe venir designata più esattamente con RH. Vi sono costanti analoghe per altri sistemi ‛idrogenoidi' (gli ioni He+, Li++, ecc.). Le lievi differenze tra queste costanti sono elegantemente spiegate dalla teoria di Bohr come effetti del moto relativo, il che tra l'altro fornisce un'impressionante conferma della teoria.

Per il momento considereremo la (6) come ottenuta dallo spettro di righe osservato mediante la (5). Una conferma diretta di questi livelli si potrebbe anche avere dalle citate esperienze di urto anelastico. Ammettendo dunque la (6) come un fatto sperimentale, vedremo ora che il valore della costante R si può dedurre a priori dal principio di corrispondenza, il quale afferma che le frequenze di Bohr date dall'eq. (5) devono coincidere asintoticamente (cioè nel caso limite di grandi numeri quantici) con le frequenze previste dall'elettrodinamica classica.

Per capire cosa ciò significhi, immaginiamo che l'elettrone si muova attorno al protone in un'orbita kepleriana con un'energia E = En, corrispondente a un grande valore del numero quantico' n. Nota l'energia E, possiamo calcolare mediante la (2) l'asse maggiore 2a e il periodo T = 2π/ω dell'orbita; si noti che a varia come n2: a valori elevati di n corrispondono quindi orbite di grandi dimensioni (v. atomo).

Secondo la teoria classica, un tale elettrone dovrebbe irraggiare in primo luogo come un dipolo hertziano oscillante con la frequenza fondamentale ν = 1 /T. Questa sarebbe l'unica frequenza emessa se l'orbita fosse circolare; ma, essendo l'orbita ellittica, lo sviluppo in serie di Fourier del momento di dipolo in funzione del tempo contiene anche le ‛armoniche superiori', 2ν, 3ν,..., ecc. Lo spettro'classico' contiene dunque tutte queste frequenze.

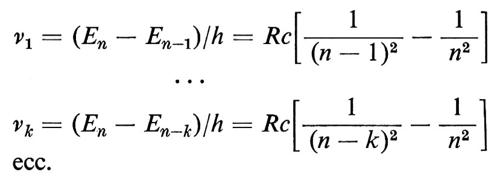

Confrontiamo questo spettro con la formula di Bohr (5). Nelle transizioni dallo stato En a stati più bassi, En-1, En-2, ..., ecc., le frequenze emesse sono:

A prima vista questo non ha nulla a che vedere con lo spettro classico, ma quando n è assai grande vi sono due sorprese. Per k = 1, 2, 3,... (piccolo rispetto a n) si ha approssimativamente:

νk ≃ (2R/n3)k ≃ kν1,

e cioè ν2, ν3, ... sono effettivamente (quasi esattamente) le armoniche superiori di ν1; per di più, ν1 ~ n-3 ∝ ∣ E ∣3/2, oc E 13/2, il che è proprio la relazione classica, notata precedentemente, tra frequenza ed energia dell'orbita. È dunque possibile scegliere il valore di R in modo tale che i due spettri coincidano riga per riga nel limite n → ∞. Si calcola facilmente che il valore in questione si ottiene da:

Rhc = me4/(2 ℏ2); (8)

più esattamente, date le approssimazioni fatte nella (2), la (8) dà il valore R∞ della costante di Rydberg ‛per un nucleo infinitamente pesante'.

Un esame critico della validità sperimentale di questa formula, entro i limiti oggi permessi dall'elevatissima precisione delle misure, va oltre i confini di questo articolo. Basti dire che la formula è stata e rimane uno dei trionfi della teoria di Bohr.

f) Regole di quantizzazione di Bohr-Sommerfeld.

Omettendo altre importanti applicazioni del principio di corrispondenza (intensità delle righe spettrali, regole di selezione), passiamo alla deduzione completa dell'eq. (6), compresa la dipendenza dal numero n. Molti eminenti fisici oltre Bohr, fra i quali in modo particolare A. Sommerfeld, presero parte alla soluzione del difficile problema di trovare ‛regole di quantizzazione' soddisfacenti. A tale scopo furono fatte varie considerazioni, tra cui forse la più stringente era quella fondata sul ‛principio adiabatico', introdotto da P. Ehrenfest per motivi termodinamici, in base al quale le regole di quantizzazione devono esser tali da restare invariate dopo una trasformazione adiabatica, cioè dopo una variazione infinitamente lenta di qualche parametro esterno, come, ad esempio, un campo elettrostatico o magnetostatico in cui il sistema sia immerso. La regola assai semplice usata da Bohr afferma che il momento angolare dell'elettrone nella sua orbita, 2πmab/T (dove b è l'asse minore dell'ellisse), dev'essere un multiplo intero di h/2π. Per un'orbita circolare (a = b) questa condizione determina i livelli energetici in accordo con l'eq. (6), in cui il valore della costante R è fornito dalla (8). In questo caso (ma solo in questo) n coincide nella teoria di Bohr con l'intero che misura il momento angolare. Quando a ≠ b la regola di cui sopra, pur rimanendo vera, non basta a fissare il valore dell'energia. La condizione necessaria, nella sua forma più semplice, si riconnette al ‛principio di minima azione' di Leibniz e Maupertuis. Essa afferma che l'integrale d'azione, ossia l'integrale di linea della quantità di moto, esteso all'intera orbita chiusa, è un multiplo intero della costante di Planck:

§ mv ds = nh; (9)

nella (9) v è la velocità dell'elettrone e ds è l'elemento di linea. Si hanno così due numeri quantici, uno dei quali determina l'energia e l'altro il momento angolare. Insieme essi determinano l'eccentricità dell'orbita. L'orientamento spaziale del piano dell'orbita rimarrebbe così ancora interamente arbitrario. Esso viene definito da un'ulteriore condizione, usata da Sommerfeld e da altri nella discussione di effetti dovuti a campi esterni, come l'effetto Zeeman (v. atomo). Il successo di questa cosiddetta ‛quantizzazione spaziale' nello studio di questi effetti e la sua verifica diretta nella famosa esperienza di Stern e Gerlach sono pietre miliari nella storia della teoria dei quanti.

2. Onde e particelle, esperienze cruciali.

a) Il dilemma.

Una questione, più di ogni altra, fu oggetto di dibattito nei primi due decenni di sviluppo della teoria dei quanti: come si poteva eliminare una contraddizione così netta come quella tra i diversi aspetti della luce? Come si è detto, le prove in favore di un'interpretazione strettamente corpuscolare dei fenomeni di emissione e assorbimento sono schiaccianti; ma le ben note difficoltà che questa interpretazione incontra nelle classiche esperienze di interferenza e diffrazione sono molto gravi: il passo dall'osservazione di questi fenomeni a un'interpretazione mediante onde che si sovrappongono linearmente è troppo diretto e naturale perché se ne possa fare a meno. Questo dilemma divenne noto come ‛dualismo onda-particella'.

Di particolare interesse a questo riguardo è il fatto sperimentale che le frange chiare e scure, osservate su uno schermo (o meglio su una lastra fotografica) in uno dei tanti dispositivi interferenziali, rimangono essenzialmente invariate al variare dell'intensità luminosa, anche quando essa è talmente bassa che gli arrivi dei singoli quanti sulla lastra sono nettamente separati nel tempo. L'energia di un singolo quanto, beninteso, non è distribuita in modo continuo sullo schermo come quella di un'onda classica; essa appare invece di colpo tutta in un punto. Tuttavia le frange devono avere una relazione ben definita con il comportamento dei singoli quanti, nel senso statistico seguente: il punto d'arrivo varia a caso da un quanto all'altro, ma con una distribuzione di probabilità tale che, dopo un'esposizione sufficientemente lunga (cioè dopo che moltissimi quanti hanno colpito lo schermo), la distribuzione media risultante riproduce esattamente il risultato noto.

Fu della massima importanza per il successivo sviluppo della teoria il fatto che questa contraddizione tra comportamento corpuscolare e ondulatorio si riscontrasse non solo in quelle radiazioni che, come l'ultravioletto e i raggi X, possono considerarsi un'estensione dello spettro visibile ad altre lunghezze d'onda, ma anche, come ora vedremo, in radiazioni di natura del tutto diversa, come i raggi catodici (cioè fasci di elettroni), i raggi atomici o molecolari, i fasci di protoni, neutroni, ecc.: tutte radiazioni a lungo considerate chiaramente e strettamente corpuscolari.

b) Onde di de Broglie.

L'indizio di una possibile natura ondulatoria dell'elettrone fu intravisto nel 1924 da L. de Broglie nella forma della regola di quantizzazione data dall'eq. (9) per un'orbita. Si ammetta per un momento che un fascio parallelo di elettroni, aventi ognuno la stessa energia cinetica w e quantità di moto p, possegga allo stesso tempo, e in un senso che apparirà poi più chiaramente, le proprieta ‛duali' di un'onda piana di frequenza circolare ω = 2πν e lunghezza d'onda λ; dovrà allora esservi, come nel caso dei fotoni, una relazione tra i due aspetti duali della radiazione, relazione che deve valere indipendentemente dal sistema inerziale di riferimento rispetto al quale ν, w, ecc. sono definite (‛invarianza relativistica'). Nel caso dei fotoni questa relazione assume la forma già nota:

ε = hν; ℏω, p = ℏk, (10)

dove la seconda equazione esprime la relazione di Einstein per un fotone p = ε/c = hν/c, sotto forma vettoriale (il ‛vettore d'onda' k, di modulo k = 2π/λ = ω/c, è normale alla superficie di un'onda piana). De Broglie ammise, per analogia, che le stesse relazioni valessero per gli elettroni e le ‛onde' corrispondenti. L'invarianza relativistica delle relazioni viene salvaguardata, ove si ponga ε = w + m0c2, includendo cioè nell'energia e della particella l'energia di riposo m0c2 (nel caso dei fotoni la massa di riposo m0 è nulla). La lunghezza d'onda di queste ‛onde di de Broglie' è data perciò dalla:

λ = h/p. (11)

Per elettroni non relativistici (v ≪ c) si può inoltre porre p = m0v.

L'indizio', di cui sopra, è l'analogia, indotta dalla (11), tra la regola quantica (9) per un'orbita chiusa, ossia

§ ds/λ = n, (12)

e la nota condizione 2l/λ = n per le oscillazioni spontanee (onde stazionarie) di una corda vibrante di lunghezza l. L'eq. (12) dice infatti che un'onda di de Broglie che percorre un cammino ricurvo lungo l'orbita si ritrova al punto di partenza con la fase iniziale e può quindi generare un sistema di onde stazionarie. Nasce così la possibilità, sfruttata più tardi da Schrödinger, di interpretare le regole di quantizzazione in un modo del tutto nuovo.

Questa straordinaria intuizione di de Broglie doveva venir ben presto verificata dallo storico esperimento di C. Davisson e L. H. Germer nel 1927. L'eq. (11) mostra che elettroni aventi, per esempio, un'energia cinetica dell'ordine di 100 eV hanno una lunghezza d'onda λ dell'ordine di 108 cm, adatta cioè per esperienze di diffrazione nei cristalli, simili a quelle coi raggi X. Su questo si basa l'esperienza suddetta, come anche la precisa conferma dell'eq. (11) da parte di G. P. Thomson nel 1928. Si ritiene ora, in parte per ragioni teoriche, in parte per via di numerose esperienze sui raggi molecolari (v. Estermann e Stern, 1930), sui neutroni lenti (E. Fermi e altri) ecc., che proprietà ondulatorie rette dalla (11) possano attribuirsi a particelle di qualsiasi genere. Non occorre insistere sul fatto che le proprietà ondulatorie di particelle di dimensioni macroscopiche non sono praticamente osservabili (λ è troppo piccola).

c) Interpretazione statistica delle ampiezze d'onda.

In tutte le esperienze summenzionate la figura di interferenza o di diffrazione osservata è descritta correttamente da un campo d'onde, ma, come si è già osservato, il comportamento individuale delle particelle può venire descritto soltanto in termini statistici: si dirà, per esempio, che la probabilità che un fotone produca una reazione chimica in un certo punto di una lastra fotografica è proporzionale all'intensità del campo in quel punto. Questo punto di vista permette evidentemente di riconciliare l'emissione unidirezionale dei quanti di Einstein con l'onda sferica di dipolo, ammettendo che la distribuzione d'intensità dell'onda nelle varie possibili direzioni determini puramente la probabilità di emissione direzionale del fotone o, se si vuole, che l'intensità dell'onda, là dove si trova un qualche atomo capace di assorbire il fotone, determini la probabilità di assorbimento.

È però tutt'altro che facile vedere come questa interpretazione probabilistica possa conciliarsi con la connessione causale che deve esistere tra la direzione del quanto di luce e il rinculo dell'atomo emittente, come richiede la legge di conservazione della quantità di moto, nell'ipotesi che tale legge sia strettamente valida negli atti individuali di emissione. La difficoltà appare nel modo più chiaro se si suppone che gli atomi siano situati a grande distanza dal punto di emissione; l'atto di assorbimento, che in ultima analisi definisce la direzione del quanto emesso, avviene molto tempo dopo l'atto di emissione. Ora, se esso è determinato solo probabilisticamente, com'è possibile descrivere una sua correlazione esatta con il rinculo dell'atomo, che è già avvenuto assai prima, all'atto dell'emissione?

Vedremo, tuttavia, che le ‛ampiezze di probabilità' generalizzate della meccanica quantistica, per esempio le funzioni d'onda multidimensionali di Schrödinger, possono effettivamente descrivere benissimo correlazioni siffatte; il prezzo di questo progresso è però una rinuncia quasi totale all'ordinaria immagine spazio-temporale dello svolgersi dei fenomeni naturali. Esaminiamo perciò i fatti che rendono inevitabile questo sacrificio.

d) Effetto Compton, metodo delle coincidenze.

Oltre al già citato esperimento di Frisch, prove anche più stringenti della validità delle leggi di conservazione negli atti individuali sono date dallo studio delle ‛coincidenze', per esempio nella diffusione dei raggi X o γ.

Studiando la diffusione di raggi X monocromatici da parte di varie sostanze, H. A. Compton scoprì nel 1923 che i raggi X diffusi sono più ‛molli' della radiazione primaria (hanno cioè lunghezza d'onda maggiore). Per varie ragioni, che omettiamo, la diffusione viene attribuita a elettroni presenti negli atomi del diffusore ed essenzialmente liberi. L'effetto osservato da Compton si interpreta facilmente se si descrive l'atto di diffusione come un urto tra un elettrone allo stato di riposo e un fotone X. Se in seguito all'urto il fotone cambia direzione, le leggi di conservazione richiedono che una certa quantità di moto e quindi anche una certa energia vengano trasmesse all'elettrone. Ne segue che l'energia ε = hν del fotone deve a sua volta diminuire, ossia λ = c/ν deve aumentare. Questa è la spiegazione qualitativa dell'effetto. Un semplice calcolo mostra che la lunghezza d'onda λ′ della radiazione diffusa è data da:

λ′ = λ + (h/m0c)(1 − cos ϑ), (13)

dove ϑ è l'angolo di diffusione ed m0 è la massa di riposo dell'elettrone. Questa formula è in perfetto accordo con le misure.

L'importanza cruciale dell'effetto Compton sta anche nella verifica più accurata delle leggi di conservazione fornita da ulteriori studi. L'interpretazione ora data dell'effetto richiede che, ogniqualvolta un quanto X viene diffuso in una certa direzione, un elettrone venga contemporaneamente proiettato in una ben definita direzione, legata alla prima, con una certa velocità. In una ben nota esperienza, Bothe e Geiger mostrarono infatti che un contatore di fotoni e un contatore di elettroni situati in posizione opportuna l'uno rispetto all'altro rivelano l'arrivo simultaneo (in ‛coincidenza') di un elettrone e di un fotone con la frequenza media prevista; in altre posizioni i conteggi dei due contatori non sono correlati nel tempo, si hanno cioè solo coincidenze casuali. L'esistenza delle correlazioni richieste dalle leggi di conservazione dell'energia e dell'impulso è anche confermata da un'esperienza effettuata da Compton e Simon con un diverso apparato; le tecniche elettroniche moderne hanno permesso una conferma dei risultati di Bothe e Geiger in condizioni assai più probanti. Come vedremo questi risultati hanno una parte importante nell'interpretazione del formalismo ondulatorio nella meccanica quantistica.

3. Meccanica quantistica.

a) Scoperta della teoria.

Le enormi difficoltà incontrate nel tentativo di estendere le regole di quantizzazione di Bohr-Sommerfeld a sistemi più complicati (atomi con più elettroni) fornirono in parte la spinta alla scoperta, nel 1925-1926, della meccanica quantistica. Il carattere provvisorio delle regole era stato del resto riconosciuto da alcuni sin dal principio; la ricerca di uno schema più coerente era quindi inevitabile.

La nuova struttura fu scoperta seguendo due vie assai diverse e in due forme distinte: meccanica delle matrici e meccanica ondulatoria, che vennero poi riconosciute come diversi aspetti di un'unica struttura. Lungo una di queste vie il passo decisivo fu compiuto da W. Heisenberg nell'estate del 1925. (Per la parte avuta da altri fisici, in particolare M. Born, P. Jordan, P. A. M. Dirac e W. Pauli, ai quali si devono contributi essenziali, v. van der Waerden 1967).

Il formalismo di Heisenberg si presenta come un analogo dello sviluppo in serie di Fourier per un'orbita periodica. In tale sviluppo il moto di una particella appare come una sovrapposizione di moti armonici di frequenza ν, 2ν, 3ν, ... La frequenza ‛fondamentale' ν dipende in generale, com'è ovvio, dall'orbita (cioè dai numeri quantici che definiscono lo stato stazionario). Le ampiezze dei moti armonici componenti sono i classici coefficienti di Fourier. Si noti che l'intera impalcatura del metodo di Bohr-Sommerfeld (e cioè le equazioni classiche del moto e le regole quantiche) si può mettere sotto la forma di una serie di relazioni tra i coefficienti di Fourier e le relative frequenze. L'idea di Heisenberg fu di sostituire, in queste relazioni, le componenti armoniche classiche con un insieme ‛corrispondente' di componenti, le cui frequenze sono quelle fisicamente osservabili date dalla relazione di Bohr e le cui ampiezze, come le relative frequenze, sono assegnate ognuna a una determinata transizione tra due stati stazionari. Il modo naturale di assegnare indici a queste ampiezze è perciò di disporle in una matrice, le cui righe (e le cui colonne) sono numerate in corrispondenza con i livelli energetici E1, E2, E3, ... Le componenti armoniche, per esempio, della coordinata x di un elettrone diventano così elementi di matrice, la cui dipendenza dal tempo è data dalla:

xnm(t) = xnm(0)eiωnmt, (14)

dove ωmn è 2π volte la frequenza ν dell'eq. (5), cioè ωnm = (En − Em)/ℏ. In particolare gli elementi ‛diagonali' non dipendono dal tempo (poiché ωnn = 0), ma rappresentano valori medi, rispetto al tempo, negli stati corrispondenti. Questa nuova assegnazione di indici alle componenti armoniche ci costringe a modificare le equazioni in certi modi che sono dettati da requisiti di compatibilità. L'audacia di questo procedimento appare chiaramente, ove si osservi che, poiché i moti armonici componenti sono ora assegnati non a uno stato stazionario ben definito, ma a transizioni, essi non si possono più ricomporre in un moto classico ben definito, sicché la nozione di ‛orbita' viene a perdere il suo senso preciso; infatti, per piccoli numeri quantici, tale nozione è del tutto priva di significato.

L'altra via di approccio al formalismo quantistico, partendo dalle idee di de Broglie, conduce alla meccanica ondulatoria di E. Schrödinger (1926). In breve l'idea chiave è che la dinamica classica non è una teoria esatta, ma presuppone grosso modo lo stesso tipo di approssimazioni che presenta l'ottica geometrica rispetto all'ottica ondulatoria. Nello studio dei movimenti elettronici entro l'atomo queste approssimazioni diventano troppo grossolane e la dinamica classica deve venir sostituita con una teoria di tipo ondulatorio. È chiaro che l'ipotesi di de Broglie è il primo passo in questa direzione; è solo un primo passo, perché l'idea si deve esprimere in una forma precisa mediante un'equazione delle onde' e ancor più perché, come si vedrà più avanti, la concezione generale di una meccanica ondulatoria implica un'estensione del problema degli n corpi tutt'altro che banale. Esaminiamo dapprima il caso di un solo elettrone, ossia, in pratica, il problema dell'idrogeno.

b) Problemi agli autovalori.

La prima pubblicazione di Schrödinger è intitolata La quantizzazione come problema agli autovalori; essa contiene la formulazione matematica precisa dell'analogia di de Broglie tra la (9) e una condizione per la formazione di onde stazionarie.

È ben noto che nella fisica matematica classica problemi del genere assumono la forma seguente. Il campo d'onda è descritto da una funzione d'onda ψ(x, y, z, t) che obbedisce a un'equazione lineare omogenea alle derivate parziali, a coefficienti costanti. Il carattere lineare omogeneo dell'equazione dà luogo al ‛principio di sovrapposizione': due o più soluzioni si possono combinare linearmente, ottenendo così ancora una soluzione. Ciò è fondamentale per i fenomeni di interferenza. Nel caso delle onde stazionarie, ψ è una funzione sinusoidale del tempo, il che si può scrivere, mediante note convenzioni, nella forma ψ = u(x, y, z) e-iωt; la funzione u soddisfa allora un'equazione indipendente dal tempo (o ‛stazionaria'), in cui la frequenza ν = ω/2π appare come parametro. Si studiano di solito onde stazionarie in una cavità racchiusa da pareti riflettenti; la funzione d'onda deve soddisfare, sulle pareti, ‛condizioni al contorno' omogenee, che assicurano la riflessione totale delle onde. Si trova allora che l'equazione d'onda, insieme alle condizioni al contorno, possiede soluzioni non nulle solo per una serie discreta di valori del parametro frequenza. La ricerca di questi ‛autovalori' e delle corrispondenti soluzioni dell'equazione, le ‛autofunzioni', costituisce il problema agli autovalori.

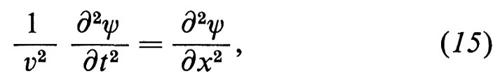

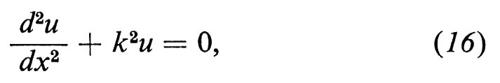

Il caso più noto e più semplice è quello, unidimensionale, della corda vibrante, che conduce all'equazione di

D'Alembert:

in cui ν è una costante che rappresenta anche la velocità di propagazione delle onde. Per un'onda stazionaria, ψ = e-iωtu(x), l'equazione diventa:

ove k = ω/v è il parametro di cui si cercano gli autovalori. Con le condizioni al contorno corrispondenti a una corda di lunghezza l tenuta fissa agli estremi si ritrovano facilmente gli autovalori

k = kn = (π/l)n (n = 1, 2, 3, ...), (17)

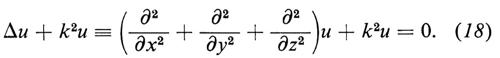

ossia, poiché k = kn = 2π/λ la condizione 2l = nλ già citata. Anche più interessante per noi è l'analogo tridimensionale della (15), in cui la derivata seconda rispetto a x è sostituita dal laplaciano; la (16) diventa allora

Notiamo infine il caso in cui la v è una funzione della posizione (mezzo a indice di rifrazione variabile da punto a punto). In questo caso, per una data aω, si ha nella (18) k = ω/v = k0n(x, y, z), ove k0 è una costante.

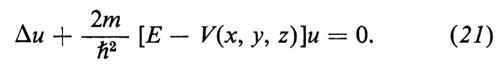

Possiamo aspettarci che le onde stazionarie di de Broglie siano descritte da un'equazione in cui l'energia appare come parametro, dato che nella teoria dei quanti ‛energia' è sinonimo di ‛frequenza'; i livelli energetici sono gli autovalori di questo parametro, secondo l'intuizione di de Broglie. Questo è un modo di ‛quantizzare' assai più naturale, dal punto di vista matematico, di quanto non sia l'arbitraria imposizione di regole quantiche alle orbite classiche voluta dalla teoria di Bohr-Sommerfeld. Nell'atomo di idrogeno non vi sono, beninteso, pareti riflettenti che racchiudano le onde in una regione finita, ma, come vedremo, una ‛condizione al contorno all'infinito' svolge un ruolo equivalente, cosicché si trova effettivamente uno spettro discreto di autovalori negativi del parametro energia e precisamente i livelli che già conosciamo. L'equazione possiede inoltre uno spettro continuo di autovalori positivi, che corrispondono alle orbite iperboliche della teoria classica. Le autofunzioni corrispondenti a questi valori positivi dell'energia sono indispensabili nella teoria dell'urto di elettroni (o analogamente di altre particelle cariche) contro un nucleo. Su di esse si basa, per esempio, la deduzione ondulatoria sia della formula di Rutherford, sia di certe deviazioni interessanti nel caso dell'urto tra particelle identiche.

c) L'equazione d'onda di Schrödinger.

Le onde di de Broglie seguono una ‛legge di dispersione', cioè una relazione tra frequenza e lunghezza d'onda che le distingue da altri casi. La legge segue dalla (10) e dalla relazione tra energia 8 e quantità di moto p per una particeila:

ε ≡ m0c2 + E = c(m02c2 + p2)1/2 (19)

(E è l'energia cinetica). Si vede subito che ω non è proporzionale al numero d'onda k, di modo che l'equazione d'onda per le onde di de Broglie dev'essere diversa dalla versione tridimensionale della (15). È opportuno notare che, quando la ‛velocità di fase' ω/k non è una costante (cioè dipende dalla frequenza), essa deve venir distinta dalla ‛velocità di gruppo' dω/dk, la quale, com'è ben noto dall'ottica, è quella che si misura nei metodi detti di ‛durata del volo'; infine la velocità di gruppo coincide, per le onde di de Broglie, con la velocità delle particelle corrispondenti dE/dp = c2p/ε. Vogliamo inoltre un'equazione che sia valida in presenza di un campo elettrostatico. Per semplicità rivolgiamoci subito al caso non relativistico: elettroni di velocità v ≪ c, dunque p ≪ m0c. Lasciamo cadere la distinzione tra massa m e massa di riposo m0 e scriviamo p = mv e

E = (p2/2m) + V(x, y, z), (20)

dove, per esempio, nel caso di un elettrone nel campo coulombiano di un nucleo di carica Ze Sito nell'origine, si ha V = − Ze2/r; dunque E è ora l'energia totale (cinetica + potenziale). L'ipotesi più semplice che possiamo fare è che l'equazione d'onda sia del tipo della (18) quando k varia con la posizione nel modo indicato dalle equazioni (10) (11) e (20), ossia

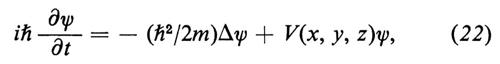

Questa è la famosa equazione di Schrödinger indipendente dal tempo. Supponiamo che la corrispondente funzione d'onda completa sia ψ = e-iωtu(x, y, z), dove ω = E/ℏ, che si ottiene dalla (10) e dalla (19) trascurando il termine costante ω0 = m0c2/ℏ, il che non ha importanti conseguenze. Allora ῼψ/ῼt = − iωψ = −i(E/ℏ)ψ e la (21) diventa:

che è l'equazione che contiene il tempo; questa è più generale della (21), in quanto si applica non solo a onde di frequenza (o energia E) arbitraria, ma anche a sovrapposizioni di onde di varie frequenze.

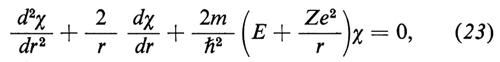

Si hanno soluzioni esatte dell'eq. (21) per vari tipi di potenziale; se, per esempio,si suppone che sia V = ½k(x2 + y2 + z2), ossia il potenziale di un oscillatore armonico, si trova una serie di livelli equidistanti, intervallati di ℏω0, con ω0 = (k/m)1/2, in accordo con l'ipotesi di Planck. Nel caso del potenziale coulombiano già detto, V = − Ze2/r, si ritrova la formula di Balmer e così via. Diamo qualche particolare sul caso coulombiano, per via della sua importanza.

Poiché in questo caso V dipende solo da r = (x2 + y2 + + z2)1/2, è naturale cercare soluzioni della (21) anch'esse della forma u = χ(r). Si vede subito che la funzione χ deve soddisfare l'equazione

la quale, per E = − Z2Rhc (che per Z = 1 corrisponde allo stato fondamentale dell'idrogeno, v. eqq. 6 e 8), possiede la soluzione:

χ = e-ξ (ξ = Zr/aB), (24)

dove aB è il raggio di Bohr, eq. (3). Anche per Z = 2, 3, ... il livello ora trovato coincide esattamente con la teoria di Bohr. Soltanto, mentre in questa teoria lo ‛stato' è un'orbita circolare di raggio aBZ-1, nella meccanica ondulatoria esso è un'onda stazionaria che si estende a tutto lo spazio; siccome però la u decresce esponenzialmente al crescere di r e diventa trascurabile quando r ≫ aBZ-1, in pratica il campo d'onda si estende a una regione di dimensioni paragonabili a quelle dell'orbita di Bohr. Si verifica similmente che la (23) ha un'altra soluzione,

χ = e-ξ/2(1 − ½ξ), (24a)

per un valore E = E2 = −¹-4Z2Rhc corrispondente al livello n = 2 dell'eq. (6). Un grafico di queste due soluzioni in funzione della distanza r è dato nella fig. 2. Se si calcolano soluzioni della (23) per un qualsiasi valore di E intermedio tra i due ora considerati (richiedendo inoltre che la soluzione sia finita nell'origine, r = 0), si trova invariabilmente che esse ‛esplodono' esponenzialmente all'infinito (r → ∞): si vedano le linee tratteggiate nella fig. 2. La ‛condizione al contorno all'infinito' ci impone di scartare queste soluzioni come fisicamente prive di significato. Per la stessa ragione si scartano le soluzioni corrispondenti a valori di E al disotto dello stato fondamentale E1; anche per E al disopra di E2 le soluzioni esplodono all'infinito, fino a che E non raggiunge il valore E3, per il quale si trova di nuovo una soluzione accettabile e così via. Così avviene che la condizione al contorno restringa i valori di E a una serie discreta di autovalori.

Un tipo più generale di soluzione si ottiene mediante la ‛separazione delle variabili' in coordinate polari r, ϑ, ϕ, ossia ponendo u = χ(r)Y(ϑ, ϕ). Si trova allora che la Y è necessariamente una ‛funzione sferica' Y1 , con l = 1, 2, 3, ... (il caso l = 0 è quello trattato precedentemente, poiché Y0 = cost.). Non si trova, però, in questo modo, alcun nuovo livello. Si trovano soltanto nuove autofunzioni per i livelli n = 2, 3,... già noti (analogamente nella teoria di Bohr-Sommerfeld a un livello possono corrispondere diverse orbite). Più precisamente si trova che al livello En corrispondono n2 soluzioni linearmente indipendenti. Si dice che questi livelli sono degeneri: solo lo stato fondamentale (n = 1) è non degenere; si noti, tuttavia, che non è qui inclusa un'ulteriore degenerazione, dovuta allo spin dell'elettrone.

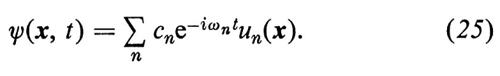

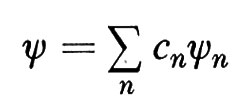

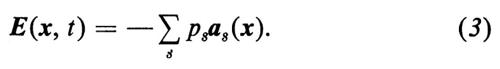

Teoremi generali permettono di affermare che gli autovalori En e le corrispondenti autofunzioni un formano un sistema ‛completo', nel senso che la soluzione generale della (22) si può sviluppare in una serie:

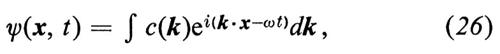

Quando esiste uno spettro continuo di autovalori (per esempio quando è E > 0, per l'atomo di idrogeno) la somma diventa un integrale. Un esempio del genere si ha nel caso di particelle libere (V = 0), quando le autofunzioni della (21) sono semplici esponenziali eik x. La funzione d'onda è allora una sovrapposizione di onde piane (integrale di Fourier tridimensionale):

dove ω ≡ ω(k) = ℏk2/2m e dk = dkxdkydkz è l'elemento di volume nello ‛spazio dei momenti'. Sovrapponendo onde piane, si possono costruire in questo modo ‛pacchetti di onda' di dimensioni finite, che in assenza di forze esterne si muovono in linea retta e in presenza di un potenziale V si muovono lungo il cammino ricurvo che la particella percorrerebbe nel caso classico corrispondente. Un teorema di Ehrenfest permette di precisare ulteriormente questa analogia. Un altro modo di mettere in luce la corrispondenza tra meccanica ondulatoria e dinamica classica verrà descritto più avanti.

d) Interpretazione statistica della funzione d'onda.

La funzione ψ è necessariamente complessa, per la presenza dell'immaginario nell'eq. (22). La parte reale e quella immaginaria della ψ potrebbero considerarsi come grandezze fisiche reali o ‛componenti' di un campo nel senso classico. Scbrödinger ha anche mostrato che, mediante questi campi, è possibile costruire una densità di carica ρ e di corrente j, che soddisfino la consueta equazione di continuità: ρ̇ + div j = 0. La densità ρ, per esempio, va posta proporzionale al quadrato del valore assoluto della ψ: ρ ∝ ∣ ψ ∣2. Dall'equazione di continuità si deduce che la carica totale è indipendente dal tempo:

∫ ∣ ψ(x, t)∣2 dτ = cost (27)

(dτ = dx dy dz). Il ‛campo ψ' può dunque trasportare una carica, il cui segno e valore totale per un pacchetto d'onde sono ancora a nostra scelta. Un pacchetto di carica totale −e (la carica dell'elettrone) potrebbe quindi considerarsi come un interessante modello dell'elettrone. Quest'idea però non regge a un esame critico. Un pacchetto d'onde non possiede la stabilità necessaria a rappresentare l'indivisibilità della carica di un elettrone; urtando contro un ostacolo, esso si sbriciola in tutte le direzioni e, del resto, anche senza urti, a lungo andare un pacchetto d'onde di de Broglie non sta insieme. Sostanzialmente le difficoltà sono poi le stesse già incontrate nel tentativo di descrivere i fotoni come pacchetti d'onde del campo maxwelliano interpretato in senso classico.

D'altra parte l'interpretazione ‛statistica' della funzione ψ, proposta da Born, come ‛ampiezza di probabilità' ci dà una descrizione logicamente coerente del comportamento di un elettrone, anche, per esempio, nei fenomeni d'urto. Basta ammettere che la probabilità al tempo t di trovare l'elettrone entro un elemento di volume dτ intorno al punto x sia uguale a ∣ ψ(x, t) ∣2 dτ. L'equazione (27) esprime allora la legge di conservazione della probabilità totale. Questa può venir posta uguale all'unità (secondo le ordinarie convenzioni del calcolo delle probabilità) moltiplicando la ψ, ove ciò sia necessario, per una costante di proporzionalità. Si dice allora che la funzione ψ è ‛normalizzata'; si noti che le ψ precedentemente scartate in base alla condizione al contorno all'infinito non sono così normalizzabili, perché l'integrale è divergente; l'interpretazione statistica fornisce così una giustificazione ulteriore del procedimento seguito.

Il fatto che la ψ, e con essa la probabilità, sia diversa da zero simultaneamente in diversi punti dello spazio, significa che la posizione dell'elettrone a un dato istante non è ben definita; quando si dice, per esempio, che un pacchetto d'onde percorre una certa traiettoria, s'intende che questa è definita solo sino a un certo punto è che lo è tanto meglio quanto più il pacchetto può considerarsi piccolo rispetto ad altre dimensioni caratteristiche, come il diametro di un'orbita chiusa, il raggio di curvatura, ecc.

Naturalmente, nota la distribuzione di probabilità di una coordinata x, si può poi definire esattamente sia il valore probabile medio 〈x> a un dato istante, sia i ‛momenti superiori', cioe i valori medi 〈x2>, 〈x3>, ecc. Se ne deduce, per esempio, la deviazione quadratica media Δx, che misura l'incertezza statistica della posizione. Dopo di ciò è logico interpretare la funzione c(k) nell'eq. (26) come un'ampiezza di probabilità per l'impulso. Difatti, già in base alla concezione originaria di de Broglie, una singola onda piana deve rappresentare elettroni aventi un determinato impulso p = ℏk; una sovrapposizione di diverse onde piane può soltanto rappresentare uno stato di impulso mal definito; per di più si può mostrare che, se l'impulso viene misurato, la probabilità di trovare un certo valore di k = p/ℏ entro un elemento di volume (dk) deve esser proporzionale a ∣ c(k) ∣2(dk). L'eq. (26), valida per particelle libere, si può generalizzare, insieme alle considerazioni precedenti, al caso di una particella soggetta a un potenziale; le ampiezze c(k) dipendono allora anche dal tempo, com'è naturale quando l'impulso non è una ‛costante del moto'.

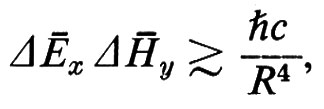

È un fatto elementare della teoria di Fourier, ben noto dall'ottica, che la larghezza spettrale Δν di un treno d'onde è inversamente proporzionale alla sua lunghezza; l'applicazione di questo principio alla (26) ci fa concludere che un pacchetto d'onde con una x molto ben definita (cioè una Δx molto piccola) deve avere una componente dell'impulso px molto poco definita. Più precisamente si prova la ‛relazione d'indeterminazione di Heisenberg':

Δx • Δpx ≥ ½ℏ. (28)

In questa e in analoghe relazioni si può vedere l'origine della natura probabilistica delle previsioni della meccanica quantistica.

Alcuni autori ritengono che la descrizione della realtà fisica data dalla meccanica quantistica sia incompleta; vi sarebbero cioè ‛variabili nascoste' di cui la teoria non tiene conto; se queste potessero venir misurate, sarebbero nuovamente possibili previsioni di natura strettamente causale secondo il modello classico. È interessante osservare (v. Bell, 1964; v. anche Wigner, 1970) che la differenza fra quest'ipotesi e la meccanica quantistica è direttamente verificabile mediante opportune esperienze. Secondo la tesi svolta da Heisenberg e più ampiamente da Bohr, e oggi generalmente accettata, le relazioni d'indeterminazione rappresentano una limitazione intrinseca alla possibilità di misurare simultaneamente la posizione e la velocità di una particella; questa limitazione è una conseguenza diretta dell'esistenza del quanto d'azione, che determina il carattere individuale degli atti di interazione elementari su cui si basa in ultima analisi ogni misura.

e) Equazione e funzioni d'onda per un sistema di n corpi.

La concezione più vasta, di una meccanica ondulatoria applicabile a un sistema con un numero qualsiasi di gradi di libertà, fu suggerita a Schrödinger dall'antica analogia, di Hamilton, tra la meccanica e l'ottica geometrica. Nel caso più semplice questa non è altro che l'analogia tra il principio di Fermat dell'ottica geometrica per un mezzo a indice di rifrazione n(x, y, z) variabile in modo continuo e il principio di Maupertuis della minima azione per una particella in moto sotto l'azione di un potenziale conservativo V(x, y, z). Abbiamo già notato che secondo le leggi dell'ottica il numero d'onda k = 2π/λ varia da punto a punto proporzionalmente all'indice di rifrazione - purché, beninteso, la frequenza rimanga costante. Nel caso limite delle piccole lunghezze d'onda (quando gli effetti di diffrazione sono trascurabili) l'equazione d'onda dà risultati equivalenti a quelli dell'ottica geometrica, che costruisce le superfici d'onda come superfici ortogonali ai ‛raggi' di luce, che obbediscono al principio del minimo cammino ottico di Fermat. Per l'equazione d'onda (21), tenendo presente la legge n ∝ k, il cammino ottico è:

∫ n(x, y, z) ds ∝ ∫ {2m[E − V(x, y, z]}1/2ds (29)

e coincide quindi con l'integrale d'azione della dinamica, che compare anche nella regola di quantizzazione (9). I ‛raggi' coincidono dunque con le traiettorie delle particelle. Questa è l'analogia di Hamilton nel caso più semplice, che si può estendere anche, per esempio, alla dinamica di un elettrone in campi elettrici e magnetici combinati. L'equazione di Schrödinger per questo caso è una generalizzazione della (22). Si può così mostrare che le classiche esperienze sui raggi catodici (misura di e/m, ecc.), presentate spesso come prove della natura corpuscolare di questi raggi, si possono interpretare altrettanto facilmente mediante l'equazione d'onda.

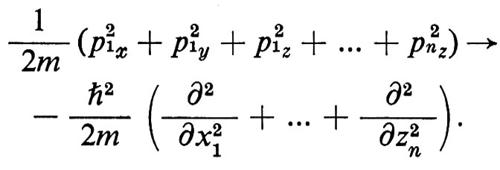

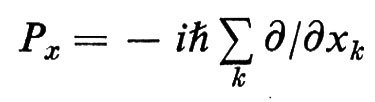

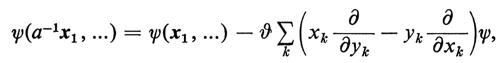

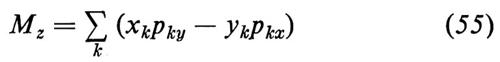

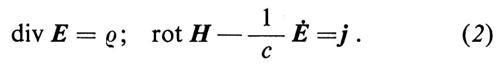

Hamilton stesso aveva esteso la sua analogia a un sistema conservativo con un numero qualsiasi f di gradi di libertà, con coordinate lagrangiane di posizione q1, q2, ..., qf e momenti coniugati p1, p2, ..., pf. L'analogo ottico è un'astratta ottica geometrica nello spazi o a f dimensioni. Questo indusse Schrödinger a formulare una corrispondente equazione d'onda nello stesso spazio, che si ottiene come segue. Sia H(q1, ..., qf; pf; p1, ... pf) la funzione di Hamilton, che abbreviamo H(q; p). Nella dinamica classica questa funzione è una costante del moto e precisamente l'energia del sistema; da essa si deducono le equazioni del moto nel modo solito. Per ottenere l'equazione d'onda si consideri H(q; p) come un operatore differenziale, detto operatore hamiltoniano ottenuto con la sostituzione simbolica:

ps → iℏ ῼ/ῼqs (s = 1, 2, ... f), (30)

che agisce sulla funzione d'onda ψ(q1, q2, ..., qf), abbreviata ψ(q).

L'equazione d'onda indipendente dal tempo, per esempio, è allora:

H(q; p)ψ(q) = Eψ(q). (31)

n elettroni (o più in generale n particelle) avranno f = 3n coordinate di posizione x1, y1, z1, x2, ..., xn, zn. Gli impulsi corrispondenti diventano gli operatori −iℏ ῼ/ῼx1, ..., −iℏ ῼ/ῼzn. Il termine che rappresenta l'energia cinetica in H(q; p) diventa allora:

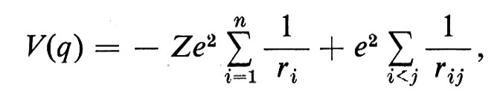

Se vi è nell'origine un nucleo di carica Ze il termine ‛energia potenziale' è:

dove

ri = (x2i + y2i + z2i)1/2, rij = [(xi − xj)2 + ...]1/2.

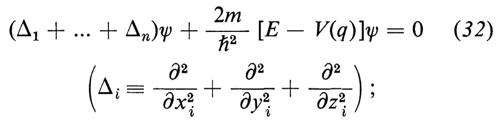

L'equazione (31) si può ora scrivere in modo conciso:

la (32) per n = 1 si riduce alla (21).

Il calcolo degli autovalori della (32) per n = 2, 3, ... è assai meno semplice che per l'atomo di idrogeno. Non esistono soluzioni esplicite; vi sono ciononostante approssimazioni estremamente accurate delle soluzioni, il cui accordo con le misure non lascia alcun dubbio sulla validità dell'equazione per i sistemi di più elettroni. Si tratta, beninteso, di validità entro il limite dell'approssimazione non relativistica. Le correzioni relativistiche, di cui si dirà più avanti, sono del resto estremamente piccole per gli elementi leggeri. L'eq. (32) si può facilmente generalizzare, com'è ovvio, in modo da includere particelle di massa diversa, per esempio il nucleo dell'atomo o i nuclei di una molecola. Si ha così una dinamica completa di questi sistemi, che permette di analizzare con grande ricchezza di risultati la struttura di rotazione e oscillazione dei livelli di una molecola e simili problemi. Ricordiamo infine che anche per i sistemi di più particelle la teoria descritta è completamente equivalente allo schema delle matrici di Born, Jordan e Heisenberg.

Anche concettualmente la (32) è assai importante. Essa ci fornisce uno dei migliori argomenti contro l'interpretazione della ψ come un campo classico. Non vi è nulla di classico in un'onda in uno spazio astratto a 3n dimensioni; viceversa l'interpretazione della ψ come un'ampiezza di probabilità si estende al caso degli n corpi senza alcuna difficoltà. Basta considerare l'espressione ∣ ψ(x1, ..., xn) ∣2 dτ1 dτ2 ... dτn come la probabilità di trovare la prima particella entro l'elemento di volume dτ1 intorno al punto x1 e allo stesso tempo la seconda particella entro l'elemento dτ2 intorno a x2 e così via. La ψ può descrivere anche complicate correlazioni tra le posizioni di varie particelle e, in modo del tutto simile, correlazioni tra le velocità di diverse particelle, o tra le loro energie, ecc. Come ciò avvenga si può vedere dall'esempio seguente.

Funzioni d'onda per più elettroni nella forma di semplici prodotti di funzioni delle coordinate dei singoli elettroni possono essere considerate come soluzioni approssimate della (32) se si trascurano le interazioni a due a due tra gli elettroni (ma non quella col campo centrale). Per due elettroni si ponga, per esempio:

ψ(x1, x2) = ua(x1)ub(x2), (33)

dove ua (rispettivamente ub) è un'autofunzione per un singolo elettrone nel campo centrale, con energia Ea (rispettivamente Eb). L'autovalore dell'energia totale, in questa approssimazione, è Ea + Eb. Diremo che ψ rappresenta uno stato tale che l'elettrone i si trova nel livello Ea e il 2 nel livello Eb. Evidentemente possiamo scambiare i ruoli dei due elettroni senza alterare l'energia totale; è anche lecito combinare linearmente le due diverse autofunzioni così ottenute, per esempio:

ψ = ua(x1)ub(x2) − ua(x2)ub(x1). (34)

Si noti che questa è un'autofunzione (approssimata) dell'operatore energia totale, ma non dell'energia del primo (o del secondo) elettrone; ciò è possibile grazie alla correlazione esistente in questo stato tra le energie dei due elettroni. La possibilità di queste correlazioni nel formalismo ondulatorio generalizzato elimina interamente le contraddizioni incontrate inizialmente (v. cap. 2, È c) tra l'interpretazione statistica delle onde e le leggi di conservazione dell'energia e dell'impulso.

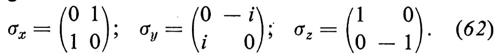

f) Momento angolare intrinseco (spin) dell'elettrone, principio di esclusione.

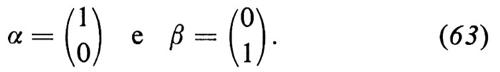

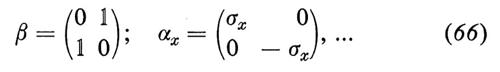

La funzione d'onda può anche venir generalizzata per tener conto dello spin dell'elettrone e del momento magnetico a esso associato, momento la cui esistenza fu dapprima intuita da Goudsmit e Uhlenbeck in base ai risultati delle ricerche sulla struttura fine delle righe spettrali e sull'effetto Zeeman anomalo. Il momento angolare intrinseco ha il più piccolo valore consentito dalla teoria e cioè ½ℏ (v. cap. 5, È c). Il grado di libertà corrispondente possiede così soltanto due stati linearmente indipendenti α e β (oppure spin all'insù e all'ingiù): esso si può descrivere mediante un'autofunzione (detta di Pauli) a due componenti. Nel caso di n elettroni, l'autofunzio nella 2n componenti, poiché ogni elettrone può avere indipendentemente due diversi stati dello spin.

La meccanica quantistica ci offre a questo punto una piacevole sorpresa, nella facilità con cui essa può assimimilare il principio di esclusione, formulato anteriormente da Pauli su basi strettamente sperimentali. Nella sua forma originaria, il principio afferma che due elettroni non possono avere esattamente gli stessi numeri quantici (bisogna tener conto anche del numero quantico dello spin, che può assumere due valori). Nell'antica teoria quantica questo principio, che ha basi sperimentali assai solide, è difficile da comprendere. La forma esatta del principio nella meccanica ondulatoria è la seguente: una funzione d'onda per n elettroni deve essere totalmente antisimmetrica, ossia deve cambiar segno se si scambiano le coordinate cartesiane e di spin di una qualsiasi coppia di elettroni. Questa è una condizione di simmetria la quale (v. cap. 5, È b) commuta con l'operatore di Hamilton ed è quindi perfettamente compatibile con l'equazione di Schrödinger. Omettendo lo spin, abbiamo nella (34) l'esempio più semplice di una funzione antisimmetrica (la stessa formula con un segno + ci darebbe una funzione simmetrica). Notiamo subito che, se nella (34) si pone a = b, la funzione si annulla identicamente: nello stato anti simmetrico i due elettroni non possono avere gli stessi numeri quantici. Proseguendo per questa via si può mostrare che la forma esatta del principio contiene in sé, oltre a nuove importanti conseguenze, anche tutte quelle della forma più antica, come la nozione di anelli elettronici chiusi (importantissima nell'interpretazione del sistema periodico degli elementi; v. atomo), la validità della statistica di Fermi per il gas di elettroni liberi in un metallo e così via. Il principio di esclusione, nella sua forma esatta, si estende ad altri sistemi di particelle identiche (per esempio sistemi di protoni, di neutroni, ecc.).

Con lo spin e col principio di esclusione abbiamo completato in sostanza il quadro della meccanica quantistica non relativistica, la quale ci fornisce secondo l'opinione corrente - un insieme di leggi fondamentali sufficienti (a parte le difficoltà matematiche che si possono presentare nel caso di sistemi molto complicati) per una discussione quantitativa del comportamento della materia in condizioni ordinarie. Questa opinione si basa sul fatto che la teoria suddetta è stata applicata con grande successo non solo allo studio delle proprietà individuali di atomi o molecole, ma anche a sistemi più complicati, come i cristalli o i liquidi. Per lo studio di certi particolari degli spettri degli atomi e delle molecole, come la struttura fine dello spettro ottico o dei raggi X, o la struttura iperfine, occorre tener conto, nell'operatore hamiltoniano, di certi termini, come l'interazione ‛spin-orbita', che a dire il vero rappresentano correzioni relativistiche, ma a causa della loro estrema piccolezza possono in genere venir calcolati come piccole perturbazioni a partire dalle funzioni d'onda non relativistiche.

Nel caso delle molecole la meccanica quantistica ci ha dato un'idea qualitativa assai più chiara, e in certi casi un calcolo quantitativo, del legame chimico nelle molecole e della valenza, grazie agli studi avviati dal classico lavoro di Heitler e London sul legame omopolare nella molecola di idrogeno. L'applicazione della meccanica quantistica alla teoria dei metalli a partire dal 1928 (Bloch) ha portato a un completo rinnovamento della teoria della conduzione e del ferromagnetismo (Heisenberg). Il paramagnetismo alle basse temperature, la semiconduzione e, più recentemente, la superfluidità e la superconduzione sono altri fenomeni alla cui comprensione la meccanica quantistica ha contribuito in modo essenziale.

4. Principi generali della meccanica quantistica.

a) Vettori di stato, operatori hermitiani

Si possono individuare nel formalismo di Schrödinger alcuni principi che costituiscono lo scheletro di una teoria più generale. Si capisce così perché siano possibili diverse forme della teoria (teoria delle trasformazioni).

Le funzioni d'onda che descrivono gli stati di un sistema possono venir concepite come ‛vettori' (cioè come elementi di uno ‛spazio vettoriale') in senso astratto. Questo è naturale, poiché le regole fondamentali di uno spazio vettoriale sono le regole di sovrapposizione (o combinazione) lineare, regole identiche a quelle su cui si fonda l'interpretazione ondulatorio-probabilistica dei fenomeni di interferenza e diffrazione. Più precisamente, abbiamo a che fare con uno spazio vettoriale a coefficienti complessi. Tutto ciò sarà riassunto più avanti nel postulato generale A.

Esaminando la (27) ed espressioni analoghe in altri casi si giunge alla conclusione che la ‛probabilità totale' è data in generale da una forma quadratica, definita positiva, nel ‛vettore di stato' (funzione d'onda) ψ, forma che indicheremo con il ∥ψ∥2 Spazi vettoriali dotati di una siffatta forma quadratica (che per definizione è invariante rispetto ai cambiamenti di coordinate) si chiamano spazi di Hilbert. Questo requisito verrà dunque aggiunto espressamente. Dalla forma quadratica si deduce con semplici operazioni il concetto derivato di ‛prodotto scalare hermitiano' di due vettori ψ1 e ψ2 designato con (ψ1, ψ2), che ha un ruolo importante nel calcolo delle probabilità (v. sotto il postulato C). Nel caso specifico della (27), per esempio, il prodotto scalare è.

(ψ1, ψ2) = ∫ ψ1*(x, t)ψ2(x, t) dτ. (35)

Si può mostrare che, come la (27), anche questa espressione è indipendente dal tempo t, purché ψ1 e ψ2 siano soluzioni della (22). In modo del tutto generale il prodotto scalare (ψ1, ψ2) è lineare in ψ2 e antilineare in ψ1 (cioè, se in luogo di ψ1 compare cψ1, allora il prodotto scalare si moltiplica per la costante complessa coniugata c*); se si pone ψ1 = ψ2 = ψ, il prodotto scalare diventa la forma quadratica di partenza ∥ ψ ∥2.

Gli operatori di impulso dell'eq. (30) e l'operatore di Hamilton H(q; p) dell'eq. (31) sono esempi di ‛operatori lineari hermitiani' che agiscono sui vettori ψ dando altri vettori dello spazio di Hilbert. L'affermazione ‟Ω è un operatore lineare" significa: Ω(ψ1 + ψ2) = Ωψ1 + Ωψ2 e inoltre Ω(cψ) = cΩψ, se c è una qualsiasi costante complessa. L'aggettivo ‛hermitiano' significa che il prodotto scalare (ψ, Ωψ) è sempre reale. Un autovalore dell'operatore Ω è una costante λ tale che l'equazione

Ωψ = λψ (36)

possegga una o più soluzioni ψ non nulle ('autovettori'); si tratta di ovvie generalizzazioni dell'idea di autofunzione. Il postulato B, che diamo più avanti, è una generalizzazione naturale della condizione di Schrödinger per i livelli energetici e di altri esempi, che qui non citiamo. Si dimostra che gli autovalori di un operatore hermitiano sono necessariamente reali; donde l'importanza di questi operatori per la rappresentazione delle grandezze fisiche.

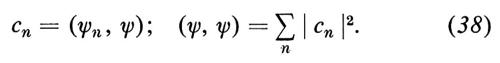

Altre importanti proprietà di un operatore hermitiano sono il teorema di ortogonalità, che asserisce che due autovettori ψ1, ψ2, corrispondenti ad autovalori distinti (λ1 ≠ λ2), sono tra loro ortogonali, cioè che risulta (ψ1, ψ2) = 0, e un teorema di sviluppo che viene usato per giustificare formule come la (25). Quest'ultimo teorema, che vale per ampie classi di operatori Ω e, sia pure in forma lievemente diversa, anche nel caso di uno spettro continuo di autovalori, afferma che Ω possiede una ‛base' di autovettori ψ1, ψ2, ..., ossia un insieme di autovettori tale che qualsiasi vettore si può sviluppare, in uno e in un solo modo, in una serie del tipo Σ cnψn; tale base si può inoltre supporre ‛ortonormale', cioè consistente di vettori normalizzati a due a due ortogonali. Poiché sarebbe ovviamente assurdo, in generale, interpretare lo stato descritto dalla (25) come uno stato di energia ben determinata, dobbiamo supporre che l'interpretazione statistica della ψ si estenda anche alle misure di energia; è allora naturale considerare la cn nella (25) come un'ampiezza di probabilità per il livello energetico En; la corrispondente probabilità deve essere proporzionale a ∣ cn ∣2. Come conseguenza del postulato B, queste considerazioni vengono estese ad altre grandezze fisiche nel postulato C, che ora enunceremo insieme agli altri due.

A. Gli stati di un sistema sono rappresentati da vettori in uno spazio di Hilbert. Lo stato non cambia se il vettore ψ viene cambiato in cψ, dove c è una costante complessa. Un dettaglio tecnico, non secondario, è il seguente: una funzione d'onda è elemento di uno spazio di Hilbert solo se l'integrale che definisce la probabilità totale è finito; in tal caso essa può ovviamente venir nomalizzata, se ciò è necessario, moltiplicandola per una costante finita c, tale che ∥ ψ ∥2 diventi eguale all'unità (ciò che corrisponde all'usuale convenzione nel calcolo delle probabilità).

B. Le grandezze fisiche reali sono rappresentate da operatori lineari (hermitiani) nello spazio di Hilbert. I valori numerici possibili di una grandezza fisica sono gli autovalori λ1, λ2, ... del corrispondente operatore. Gli autovettori associati ψ1, ψ2, ... (preferibilmente normalizzati) rappresentano stati in cui la grandezza detta è ben definita. Una notazione un po' diversa è necessaria (v. Dirac, 1930) nel caso di uno spettro continuo di autovalori, che richiede anche condizioni di normalizzazione diverse su cui non ci dilunghiamo; la notazione usata presuppone inoltre, per semplicità, che gli autovalori λn non siano degeneri.

C. Se lo stato del sistema è rappresentato dal vettore normalizzato

(dove le ψn sono normalizzate), i possibili risultati λ1, ..., λn, ... di una misura della grandezza Ω hanno le probabilità p1, ..., pn, ..., date da

pn = ∣ cn ∣2 = ∣ (ψn, ψ) ∣2. (37)

Quest'ultima affermazione si fonda sulle seguenti identità (di facile dimostrazione):

Tutte le probabilità pn rimangono invariate se la ψ si moltiplica per un fattore di fase c = eiα (α reale), il che si accorda con quanto si è in A

b) Algebra degli operatori, commutatori.

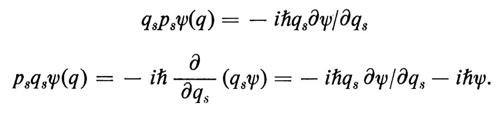

Gli operatori in uno spazio di Hilbert sono elementi di un'algebra: possono essere moltiplicati per una costante arbitraria e possono essere sommati o moltiplicati fra di loro. Le regole di quest'algebra si possono anche ricavare in modo quasi automatico dalla convenzione di scrivere un'operatore Ω sempre dalla stessa parte (per esempio a sinistra) del vettore su cui l'operatore agisce: Ωψ. Quest'algebra ha un ‛elemento unità': l'operatore ‛identità' 1, definito dalla 1 ψ = ψ. Gli operatori che rappresentano le coordinate qs e gli impulsi ps (v. la 130) agiscono sulla ψ(q) nel modo che segue: qs[ψ(q)] = qsψ(q)] = − ihῼψ/ῼqs. Il prodotto AB di due operatori è definito dalla: (AB)ψ = A(Bψ). A parole: dapprima B agisce sulla ψ, poi A agisce sul risultato. In generale AB ≠ BA (non commutatività del prodotto di due operatori). L'esempio classico è:

D'altra parte qs e ps, (dove s ≠ s′) commutano. Tutto ciò è riassunto dall'equazione tra operatori

qsps′ − ps′qs = iℏ δss′1, (39)

dove δss′ è il simbolo di Kronecker (=1, se s = s′, = 0 altrimenti). Questa celeberrima equazione compare anche nella meccanica di Heisenberg come relazione fra matrici. Come ha mostrato Dirac, il commutatore [A, B] di due operatori, definito dalla

[A, B] = AB − BA, (40)

diviso per iℏ, rappresenta l'analogo quantistico delle parentesi di Poisson, di modo che le (39) corrispondono a relazioni ben note nella dinamica classica. D'altra parte esse sono connesse direttamente con il principio di indeterminazione di Heisenberg. Qualitativamente la connessione è la seguente: uno stato in cui le due grandezze sono entrambe ben definite deve corrispondere a una ψ, che è simultaneamente un autovettore sia di A che di B, con autovalori, diciamo, a e b. Ne segue facilmente che ABψ = A(bψ) = bAψ = baψ = ... = BAψ,. Ma la (39) ci dice precisamente che per A = qs, B = ps (con lo stesso indice) un siffatto vettore non può esistere. Più in generale, se [A, B] ≠ 0, devono esistere dei vettori sui quali AB e BA agiscono in modo diverso. Ciò rappresenta necessariamente una restrizione della possibilità di determinare le due grandezze simultaneamente.

c) Teoria delle trasformazioni.

Un vettore dello spazio di Hilbert può venire definito semplicemente come una serie di coefficienti:

(c1 , c2, c3, ..., cn, ...). (41)

S'intende che le cn sono le componenti dello sviluppo ψ = Σncnψn del vettore ψ relativamente a una base ortonormale di vettori. Spesso la (41) viene scritta come una matrice (infinita) a una colonna, anziché a una riga. La (38) serve allora da definizione della norma del vettore. Un operatore A può venire similmente definito mediante una doppia successione di coefficienti Aij, gli ‛elementi di matrice'. Infatti, essendo A lineare, la sua azione su un qualsiasi vettore, A(Σjcjψj) = ΣjcjAψj, sarà nota, ove Aψj sia noto per j = 1, 2, ... Ma, poiché ψ1, ψ2, ... e una base, si deve avere Aψj = ΣjAijψi, dove le Aij sono coefficienti numerici, che definiscono dunque l'operatore. Si verifica facilmente che la matrice che rappresenta il prodotto AR si ottiene con la regola del prodotto di matrici: (AB)ij = ΣnAinBnj. Così prùcedendo, e mediante la (39), si dimostra facilmente l'equivalenza dello schema ondulatorio con la meccanica delle matrici.

La teoria delle trasformazioni nasce dal fatto che nello spazio dei vettori di stato è possibile, e spesso desiderabile, passare a un nuovo insieme base di vettori ψ1′, ψ2′, ... Poiché ψj′ si può esprimere come una combinazione lineare

dei vettori di base originari (e viceversa), si può scrivere simbolicamente

ψj′ = Uψj; ψj = U-1ψj′, (43)

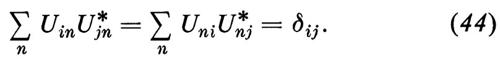

dove U e U-1 sono operatori tali che UU-1 = U-1U = 1. Se entrambe le basi sono ortonormali, si provano facilmente le relazioni

Si dice allora che l'operatore U è ‛unitario'.

In pratica è importante, nelle applicazioni fisiche, il fatto che i vettori base siano di solito definiti non già come autovettori di un singolo operatore (come H, per es.) bensì come autovettori simultanei di un insieme di operatori che commutano tra di loro. Così nel problema dell'idrogeno le autofunzioni hanno come indici tre numeri quantici, che identificano gli autovalori rispettivamente dell'energia, del momento angolare totale e di una componente dello stesso lungo una qualche direzione fissa. Questi autovalori simultanei sono possibili perché gli operatori corrispondenti commutano.

La teoria delle trasformazioni è utile, perché ci permette di scegliere gli stati base nel modo più adatto alla questione prescelta. Altri utili insiemi base sono, per esempio, gli autovettori di posizione o, rispettivamente, di impulso; in ambo i casi abbiamo a che fare con indici variabili in modo continuo, argomento a cui abbiamo appena accennato. Ma le componenti del vettore ψ rispetto a queste basi non sono altro che la funzione ψ(q) e, rispettivamente, la sua trasformata di Fourier c(k) dell'eq. (26). Quest'ul tima è, beninteso, un caso speciale (per una singola particella libera). Una particolare scelta della base viene anche chiamata ‛rappresentazione' (per esempio ‛rappresentazione degli impulsi', ecc.).

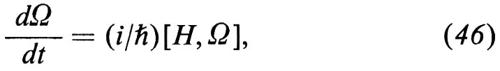

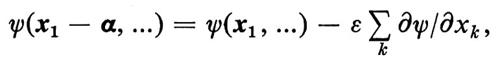

d) Rappresentazione di Heisenberg.