Terremoto

Terremoto

(XXXIII, p. 639; App. II, ii, p. 981)

Un panorama sulla sismologia, la parte della geofisica che studia i t. come fenomeno fisico, è presentato nell'omonima voce di G.B. Alfano, contenuta nell'Enciclopedia Italiana (XXXI, p. 916), e nei successivi aggiornamenti redatti da P. Caloi per il periodo dal 1938 al 1978 (App. II, ii, p. 841; III, ii, p. 755; IV, iii, p. 343), riguardanti specialmente la fisica della propagazione delle onde sismiche e le informazioni da queste deducibili sulla struttura dell'interno della Terra, e da G. Panza per il periodo dal 1979 al 1992 (App. V, iv, p. 787). Quest'ultima voce è particolarmente importante per la trattazione analitica delle oscillazioni libere della Terra e per l'introduzione della nozione di sismogramma sintetico. All'importantissima sismologia strumentale sono dedicate le voci sismografo, di G.B. Alfano (XXXI, p. 914) e sismometria, di R. Console (App. V, iv, p. 792), che si può considerare un aggiornamento della precedente. Per la 'antropizzazione della geofisica' è utile rifarsi al sottolemma Geofisica e difesa dell'ambiente della voce di aggiornamento geofisica (App. IV, ii, p. 28). *

Considerazioni generali sul fenomeno terremoto

Un t. ha luogo a seguito del subitaneo dislocamento di masse nella litosfera terrestre con il raggiungimento di una nuova condizione di equilibrio instabile, caratterizzata da una minore energia potenziale elastica. Dall'ipocentro (o fuoco del t.) si originano onde elastiche sia di volume (longitudinali e trasversali) sia di superficie.

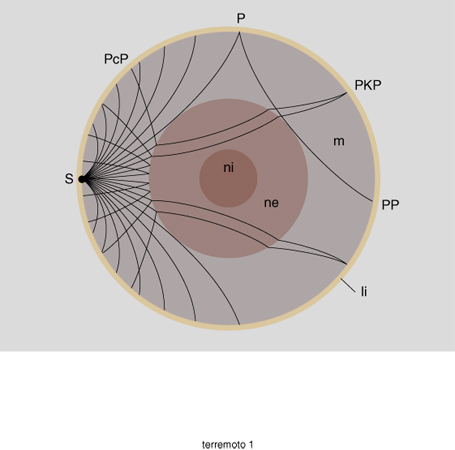

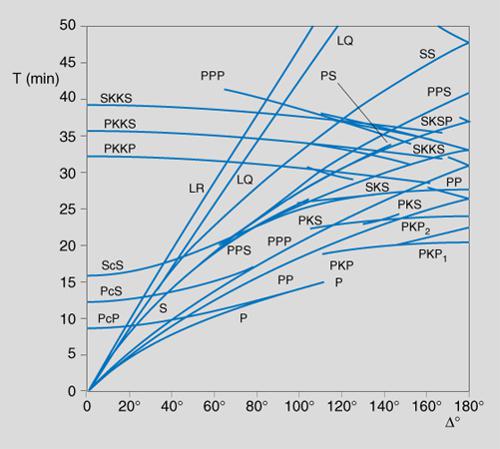

Le onde longitudinali sono più veloci delle altre e quindi sono le prime ad arrivare: di qui la denominazione per queste di onde P (lat. primae) e di onde S (lat. secundae) per quelle trasversali. La propagazione delle onde può avvenire nella crosta terrestre, e allora si parla di onde crostali, sia longitudinali, Pg, che trasversali, Sg, le quali sono in grado di raggiungere punti distanti dall'ipocentro non oltre un migliaio di km. Altre onde, denominate Pn (longitudinali) e Sn (trasversali), seguono il confine crosta-mantello. Poiché la litosfera presenta una struttura a strati con natura geologica e proprietà elastiche differenti, per giungere in un determinato punto della superficie le onde subiscono fenomeni di rifrazione e di riflessione, seguendo cammini diversi (raggi sismici); una ancora più ampia possibilità di cammini diversi si ha per punti a grande distanza, allorché la propagazione delle onde interessa anche le parti più interne della Terra, il mantello e il nucleo (fig. 1). Di fondamentale importanza per lo studio dei t. sono le dromocrone, cioè l'insieme dei singoli diagrammi (o talora delle equivalenti tabelle) che danno, per ognuno dei possibili tragitti dei vari tipi di onde sismiche, la relazione fra il tempo di percorso T (travel time), dall'ipocentro al luogo di interesse (tipicamente, una stazione di rilevamento sismico), e la distanza epicentrale Δ° di un t., vale a dire l'ampiezza, espressa in gradi geografici (1°≈111,18 km), dell'arco di cerchio massimo terrestre dal luogo di osservazione all'epicentro del t., che è la zona della superficie terrestre situata sulla verticale dell'ipocentro (fig. 2). Nell'uso, le dromocrone sono spesso chiamate travel time. In conseguenza della differenza nelle velocità di propagazione dei tipi di onde sismiche e della molteplicità dei possibili cammini di propagazione, in un dato punto della superficie terrestre l'impulso vibratorio iniziale nell'ipocentro si traduce in una successione di treni di oscillazioni del terreno, dette scosse sismiche, che si presentano con caratteri differenti secondo la natura delle onde cui sono dovute: si parla di scosse sussultorie e scosse ondulatorie secondo che le vibrazioni del suolo avvengano in direzione verticale oppure orizzontale; per es., sono sussultorie le scosse dovute a onde P in siti non molto distanti dall'epicentro (la zona della superficie nella quale, tra l'altro, si hanno le scosse più ampie). Va però osservato che raramente questi caratteri sono ben distinti tra loro.

Il termine terremoto indica il complesso delle scosse attribuibili a un unico fenomeno di instabilità dinamica nella litosfera e ai fenomeni concomitanti e conseguenti a esso; tra questi ultimi, particolare rilevanza hanno altri insiemi di scosse che si verificano a distanza di tempo più o meno breve, dette repliche (o, anche, impropriamente, scosse di assestamento) e dovute a successivi movimenti impulsivi delle masse inizialmente dislocatesi verso condizioni di equilibrio progressivamente meno instabile. La tradizionale distinzione fra la trattazione propriamente descrittiva del fenomeno t. e la sismologia intesa come fisica matematica dei t. s'è andata facendo meno netta e consistente nel corso del Novecento, specialmente nell'ultimo ventennio.

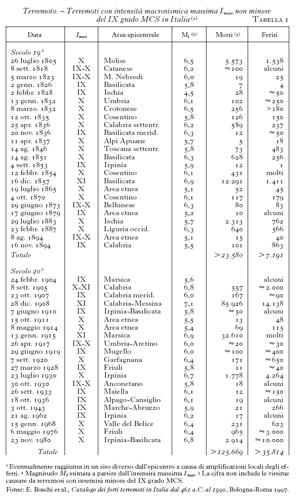

Questa tendenza unificatrice delle discipline attinenti ai t. è in gran parte dovuta a una significativa, e positiva, evoluzione verificatasi nei tardi anni Settanta nella geofisica in generale. Ci si riferisce al riconoscimento - in verità stranamente tardivo - del fatto che questa scienza si occupa di fenomeni fisici che hanno una rilevanza diretta e in genere molto importante per le attività, le condizioni di vita e la vita stessa dell'uomo. Questa rilevanza è decisamente di natura fondamentale per i fenomeni classificati come catastrofi naturali, quali sono gli intensi t. che colpiscono ripetutamente certe zone della superficie terrestre, denominate a forte rischio sismico, espressione che fa riferimento alla possibilità di gravi alterazioni e distruzioni di strutture naturali e di manufatti necessari per le attività umane, nonché di gravi perdite di vite umane. Per l'Italia si stima che il 40% del territorio nazionale sia a forte rischio sismico e va tenuto presente che, come mostra la tab. 1, nel 20° secolo il nostro paese ha sofferto a seguito di t. la perdita di oltre 125.000 vite umane. È ben giustificata, quindi, l'attenzione verso la difesa dai terremoti, con ciò ovviamente intendendosi non l'intervento diretto sul fenomeno, la cui scala di energia è assolutamente al di fuori del controllo umano, ma la 'difesa dalle conseguenze dei t.', vale a dire l'identificazione e la messa in opera di tutti gli accorgimenti (normativi, tecnici, di comportamento) volti a prevenire o quanto meno limitare i danni nelle zone la cui 'storia sismica' faccia apparire probabile l'evento sismico distruttivo.

La sismologia ha carattere spiccatamente fenomenologico. In essa è infatti quasi impossibile parlare di esperimenti nel senso in cui vengono intesi in fisica, organizzabili in laboratorio sotto condizioni variabili stabilite dal ricercatore; in sismologia, eccettuate alcune branche collaterali a essa collegate, l'operatore si limita a disporre i suoi strumenti di osservazione in attesa di raccogliere dati provenienti da t., naturali o artificiali. Egli non può fare nulla per variare le condizioni del mezzo attraversato dalle onde sismiche, di cui deve anzi riconoscere, con i dati raccolti e per via indiretta e interpretativa, i parametri fisici costitutivi (quali densità e costanti elastiche) e strutturali (come stratificazione e natura geologica degli strati); lo stesso vale per la sorgente del t. (parametri dell'ipocentro e meccanismo focale).

Tipologia dei terremoti

Escludendo i t. da impatto con meteoriti, la cui entità può superare quella dei t. di origine interna al sistema terrestre, possiamo distinguere i t. naturali nei seguenti tipi, in ordine decrescente dell'energia dispiegata: a) terremoti tettonici, prodotti per effetto di sforzi di carattere regionale inquadrati in un più generale sistema di sforzi globali; questi sono assunti da un modello cinematico-geodinamico globale, e gli sforzi che dai t. vengono dedotti devono essere spiegati mettendoli in relazione al reciproco influenzarsi delle strutture tettoniche, in modo che si trovi accordo tra il globale e il regionale; in questo tipo di t. si hanno i maggiori rilasci di energia e quindi i maggiori danni; b) terremoti vulcanici, dovuti all'impetuoso spostamento interno o all'eruzione all'esterno di masse magmatiche e gassose in un apparato vulcanico; c) terremoti lenti, caratterizzati da movimenti di strutture della crosta terrestre con velocità intermedia tra le due estreme del bradisismo e del t.; d) terremoti da collasso, di modesta entità, per la maggior parte dovuti a movimenti franosi dalla cui registrazione sismografica si riescono a interpretare i vari momenti della caduta (come nel caso della terribile frana dal Monte Zandila, in Valtellina, nel luglio 1987); possono accadere anche per crollo di volte di cavità naturali; e) microsismi meteorologici, di piccolissima entità, dovuti a fulmini, tuoni, ondate marine e quant'altro contribuisca all'aumento naturale del rumore di fondo registrato dai sismografi.

Accanto ai t. naturali vanno considerati anche i terremoti artificiali, prodotti dall'attività umana, quali quelli dovuti a esplosioni di varia potenza (le maggiori sono quelle di bombe nucleari), a grandi e rapide variazioni di carico e pressione idraulica, indotte in strutture artificiali o naturali (rottura di una grande diga, variazione brusca del regime di un grande invaso d'acqua, importante iniezione o sottrazione di fluidi nel sottosuolo, e simili) o, infine, alla semplice percossa del suolo (per es. a seguito della caduta di un oggetto di grande massa), accidentale o voluta che sia (quest'ultimo è il caso di tecniche di prospezione sismica a piccolissimo raggio).

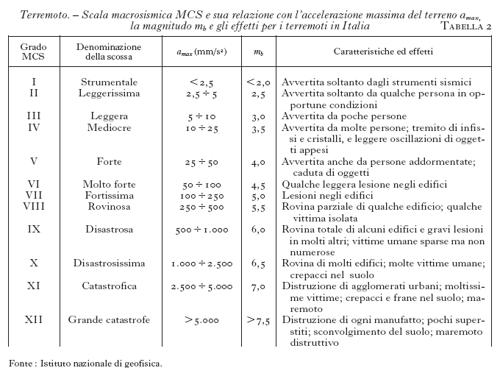

Evoluzione della nozione di 'entità' di un terremoto: dall'intensità macrosismica alla magnitudo e al momento sismico

Sebbene sia improprio misurare l'entità di un t. con l'intensità macrosismica, che assume valori differenti in località diverse intorno all'epicentro, le scale macrosismiche furono usate a questo scopo ai primordi della sismologia. A partire dalla scala in quattro gradi di D. Pignataro, usata in Calabria a fine Settecento, un primo raffinamento fu, nell'Ottocento, la scala in dieci gradi di M.S. De Rossi e F. Forel. Si affermò poi quella a dodici gradi di G. Mercalli del 1902, perfezionata prima da A. Cancani e A. Sieberg, poi da H. Wood e F. Neumann negli anni Trenta, e infine da V. Medvedev, W. Sponheuer, V. Karnik nel 1964. La scala oggi in uso internazionale, che è stata correlata con l'accelerazione massima del suolo, è la Mercalli-Cancani-Sieberg (MCS) ed è riportata nella tab. 2.

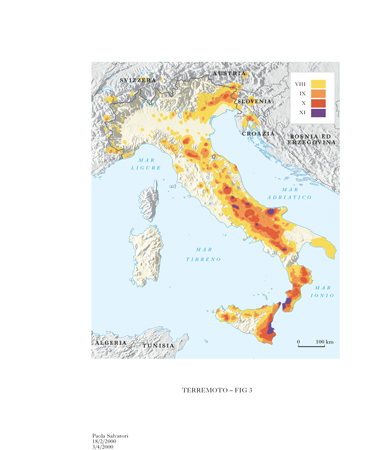

Per sua natura, una scala sismica di questo tipo ha un notevole significato ai fini di quella che all'inizio è stata chiamata difesa dai danni dei terremoti, e può essere quindi considerata positivamente nell'ambito dei provvedimenti di 'difesa civile' (v. oltre: Aspetti sociali e di protezione civile), a patto di correlare bene, in ambito locale, i gradi della scala non soltanto con la tipologia corrente dei manufatti, ma anche con la natura del suolo; peraltro, ciò che da essa si deduce (a parte una stima dell'accelerazione massima del terreno) è privo di significato univoco dal punto di vista della fisica del t. nel suo fuoco: per es., due t., uno di grande energia e a media profondità e l'altro di modesta energia ma a piccola profondità, e quindi intrinsecamente ben diversificati, apparirebbero simili se producessero effetti simili nei loro epicentri. Per interessi sia protezionistici sia scientifici è molto utile cartografare l'andamento sul territorio della massima intensità MCS risentita (fig. 3): tale mappa da un lato fornisce una prima visione d'insieme di tutte le aree da considerare a rischio, pur senza indicare le priorità, dall'altro, come si vedrà nel seguito, può essere correlata a strutture geologiche e mappe di quantità fisiche misurabili per trarne conclusioni utili all'individuazione della causa dei terremoti.

Non appena la sismologia ha potuto contare su una reale sismometria quantitativa, i sismologi hanno avuto gli elementi per quantificare fisicamente la 'entità' di un t. introducendo la magnitudo: una grandezza dedotta da particolarità del segnale fornito dai sismografi o sismometri e che consente una stima dell'energia liberatasi nell'ipocentro del terremoto. Dalla prima definizione di magnitudo di un t., introdotta intorno al 1935 dal sismologo statunitense Ch. Richter, basata su un particolare tipo di sismometro e valida solo per t. locali, molte altre sono state le definizioni che di questa quantità si sono date; esse si differenziano tra loro sia per la natura del dato dedotto dal sismogramma (ampiezza della traccia, durata del segnale utile ecc.: va comunque tenuto conto della 'funzione di risposta' o 'funzione di amplificazione' dello strumento), sia per il tipo di onde sismiche o di altre quantità cui si riferiscono. Esistono almeno sette 'famiglie' di magnitudo, indicate con le sigle: ml, mS, mb, mB, MD, Mi, Mw. Ricordiamo, a titolo di esempio, le definizioni delle seguenti, che sono fra le più usate: a) magnitudo locale di Richter, ml=log₁₀A-log₁₀A₀, dove A è l'ampiezza massima registrata da un sismometro a torsione Wood-Anderson a una distanza fissata, A₀ l'ampiezza prodotta da una scossa di magnitudo zero alla stessa distanza; b) magnitudo da onde di volume, mb=log₁₀(A/T)+Q(Δ°, h), con A ampiezza massima (in μm) della componente verticale del moto del terreno nel primo gruppo di onde P (deducibile dalla funzione di risposta di un sismometro verticale), T il periodo (in secondi) di questa fase massima, e Q(Δ°, h) una funzione empirica correttiva per la distanza Δ° (in gradi geografici) della stazione di osservazione dall'epicentro del t. e per la profondità h (in km) dell'ipocentro del t. in questione; c) magnitudo da onde superficiali, mS=log₁₀(A/T)+1,66 log ₁₀Δ°+3,3, con A ampiezza massima (in μm) del moto del terreno nel gruppo di onde superficiali, T periodo (in secondi) di questa fase massima e Δ° distanza epicentrale (in gradi geografici).

Si nota immediatamente il carattere assai diverso delle definizioni empiriche di magnitudo: la definizione di Richter non contiene il periodo di vibrazione della fase massima, mentre nelle altre due se ne tiene conto, e solo nella mb si tiene conto della profondità dell'ipocentro. Inoltre, le istituzioni che nelle varie parti del mondo curano il servizio di rilevamento sismico usano per la determinazione di questa grandezza formule e procedure specifiche. Dal momento che dai mezzi di informazione l'entità dei t. è espressa talora in gradi della scala macrosismica MCS (in Italia detti correntemente gradi Mercalli) all'epicentro, talaltra in magnitudo (spesso e impropriamente espressa in gradi Richter), molte di queste istituzioni si preoccupano di valutare e diffondere la correlazione approssimativa tra questi due diversi parametri, che naturalmente ha carattere regionale, se non addirittura locale. Per quanto riguarda l'Italia, tale correlazione indicativa, elaborata dall'Istituto nazionale di geofisica, è riportata nella tab. 2 riguardante la scala MCS. Un problema rimasto ancora oggi aperto è quello della semplificazione e unificazione dei linguaggi. Non sempre infatti e non in tutti gli intervalli di valori (ma specie per quelli alti) le varie magnitudo calcolate con metodi empirici da diverse istituzioni per un dato t. assumono valori vicini, e questo in dipendenza di limitazioni specifiche di ogni metodo. Il problema non è di secondaria importanza e genera grandi difficoltà per la costituzione di un catalogo sismico globale omogeneo nei valori di magnitudo e sufficientemente esteso nel passato. Il conseguimento di tale omogeneità è importantissimo ai fini scientifici per chi si occupa della previsione statistica dei terremoti.

Relativamente all'opportuna unificazione dei 'linguaggi' sismologici, un miglioramento della situazione potrebbe provenire dall'introduzione generalizzata della nozione di momento sismico dei t., definito (in 10⁻⁵ N∙m) dalla relazione: M₀=μsA, essendo A l'area della superficie di frattura (in m²), s lo spostamento medio tra le labbra di faglia (in m) e μ la rigidità del mezzo a sforzo di taglio (in 10⁻⁵ N/m²). È possibile da M₀ definire una magnitudo momento (moment magnitude) Mw attraverso la relazione Mw=(2/3)log₁₀M₀−10,7.

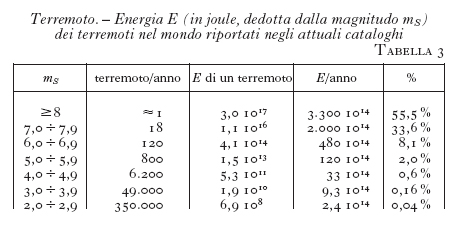

Il momento sismico è, come la magnitudo, in relazione all'energia sismica totale irradiata dalla sorgente; per es., tale energia, E (in joule), può essere dedotta dalla magnitudo mS mediante la relazione: E=10⁵,²⁴∙10¹,⁴⁴mS. La tab. 3 riporta la distribuzione dell'energia associata ai t. riportati negli attuali cataloghi, calcolata appunto a partire dalla relazione data.

L'energia può essere ricavata da una rete sismica mondiale, insieme al meccanismo focale (v. oltre): come dire che per tale via sono determinabili i parametri che compaiono nella definizione del momento medesimo; di questo si dà, oltre alla definizione scalare appena riportata, anche una definizione tensoriale, in relazione ai campi di sforzo. L'internazionalizzazione del procedimento stesso di determinazione dei valori garantisce che per il momento sismico sia più difficile, ma non del tutto evitabile, cadere in una situazione di estrema proliferazione delle definizioni simile a quella che nel tempo si è venuta a creare per la magnitudo. I risultati della raccolta ed elaborazione internazionale di dati formano il catalogo del Centroid Moment Tensor (CMT): in questo, a partire dal 1977 sono conservate tutte le informazioni utili a rappresentare tridimensionalmente il movimento dei materiali, la caduta di sforzo, il momento sismico (scalare e tensoriale) e la magnitudo a esso associata Mw. Il meccanismo focale fornito in questo catalogo è più affidabile di quello ricavato dai soli versi del movimento del terreno dei primi arrivi delle onde P, in quanto è ricavato dal confronto ripetuto tra i sismogrammi reali con i sismogrammi sintetici calcolati mediante diversi tentativi di orientazione dei piani del meccanismo focale, cui accenneremo più avanti.

Cause dei terremoti: distribuzione geografica, modello cinematico-dinamico, meccanismi di sorgente

Molto fu scritto in passato sulle cause dei t.; ma null'altro che ipotesi si tramandarono fino all'Ottocento, secolo che vide gli albori della metrologia sismica (sismometria), quando A. von Humboldt pensava che il t. fosse dovuto alla pressione di fluidi che non riuscivano a trovare sbocco verso la superficie. Solo nella seconda metà dell'Ottocento, a seguito di accurate campagne di rilevamento geologico condotte in Austria e in Italia, E. Suess collegò il t. al rapido scivolamento reciproco di due blocchi di crosta lungo un piano di faglia, compiendo il primo importantissimo passo nella conoscenza della catena causale che produce il terremoto.

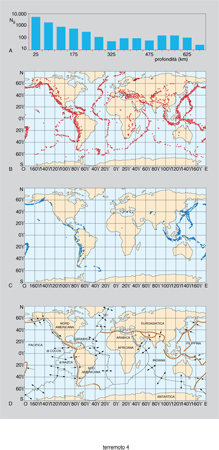

Tradizionalmente i t. sono suddivisi in superficiali, intermedi e profondi a seconda che la loro profondità ipocentrale sia, rispettivamente, minore di 70 km, compresa tra 70 e 300 km, maggiore di 300 km. È stato osservato che gli ipocentri dei t. sono situati fino a una profondità massima di circa 700 km, che, secondo le nuove concezioni mobiliste, rappresenterebbe il limite della subduzione delle placche oceaniche sotto quelle continentali. Esaminando la distribuzione in profondità dei t. (fig. 4A) si può constatare che per circa il 70% degli eventi la profondità ipocentrale è minore di 100 km.

La distribuzione globale dei t. risulta caratterizzata, come mostra la fig. 4B per i t. superficiali e la fig. 4C per quelli profondi, da grande disuniformità, con addensamenti in ben definite zone a sviluppo lineare.

Per spiegare questo la sismologia fa oggi ricorso a un modello cinematico-dinamico generale di stampo mobilista, che è il perfezionamento, dopo le conferme provenienti dalle campagne oceanografiche degli anni Cinquanta e Sessanta, del modello della 'deriva dei continenti' proposto negli anni Venti da A. Wegener. Tale modello mette in evidenza che (confrontando la fig. 4D con le due precedenti) le ristrette zone di massima evenienza dei t. coincidono con i confini delle placche (o zolle) litosferiche in moto reciproco, sede di convergenza, divergenza o trascorrenza (oppure combinazioni di esse) tra le placche stesse; il numero di t. che si originano all'interno delle zolle, dove in genere la crosta terrestre è piuttosto stabile, è relativamente piccolo. Le fasce di attività sismica lungo i confini delle placche litosferiche sono piuttosto strette: soltanto dell'ordine di 100 km in corrispondenza delle linee di separazione rappresentate dalle dorsali oceaniche. Ogni anno si verificano alcune migliaia di t. con magnitudo superiore a 4 (tab. 3), cioè distintamente avvertibili dall'uomo. L'attività sismica differisce considerevolmente per frequenza e intensità tra le varie zone considerate. Oltre la metà dell'energia sismica rilasciata dai t. superficiali è concentrata sulla 'cintura circumpacifica', che segue la linea delle coste e degli archi insulari del Pacifico; un altro 20% è prodotto nella 'cintura alpina', che si estende dall'area mediterranea fino all'Asia centrale attraverso il Vicino e il Medio Oriente. I t. intermedi e profondi sono usualmente associati con placche litosferiche in fase di sprofondamento, e la loro distribuzione ricalca infatti quella delle zone che la geologia interpreta oggi come zone di subduzione (figg. 4B e 4C). In particolare, i t. profondi si verificano soltanto in regioni particolari, come il Mar del Giappone, le isole Figi, il Mar di Banda, il Mar Tirreno e il Mar Egeo. I t. intermedi, invece, si possono trovare anche dove due placche continentali interagiscono, come nell'Asia centrale.

Dopo l'epoca della sismologia puramente osservativa, si è avuto un notevole progresso in seguito alle prime indagini condotte con gli strumenti teorici della fisica sui processi che danno luogo al t. nel suo ipocentro, processi conosciuti come meccanismi di sorgente.

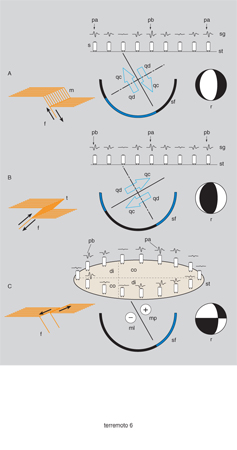

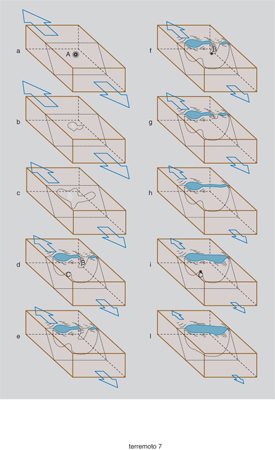

Il modello meccanico oggi comunemente accettato per i t. che avvengono nella crosta terrestre è quello del 'rimbalzo elastico' (elastic rebound) dello statunitense H.F. Reid (1906). Esso postula una progressiva deformazione elastica dei materiali sottoposti a uno sforzo tettonico (compressivo, tensile, di taglio, o combinazioni di questi) in progressiva crescita, finché nel punto e nel momento in cui viene superata la resistenza dei materiali si produce una frattura, che si propaga tutt'intorno con tipiche velocità subsoniche e con velocità di scorrimento tra le due labbra della faglia di qualche m/s. Al termine della propagazione della frattura, la cui elongazione massima può coprire tutto lo spettro di valori, dal microscopico a molte decine di km, la dislocazione tra le due labbra di faglia si arresta anch'essa, raggiungendo, per i t. più intensi, valori a volte superiori alla decina di metri. Nella fig. 5 sono rappresentate le diverse fasi previste dal modello di Reid: il mezzo è inizialmente a riposo e indeformato (A); successivamente lo sforzo tettonico deforma il mezzo, finché, quando lo sforzo supera il limite di resistenza a frattura dei materiali sollecitati, in un punto di esso si produce un cedimento (B). Da quel momento inizia a propagarsi una frattura lungo la quale i due blocchi di materiale scorrono in direzioni opposte generando l'irradiarsi di onde sismiche (C): alla fine del processo di frattura e di scorrimento, i due blocchi sono ritornati a riposo ma dislocati reciprocamente (D). L'energia potenziale elastica accumulata prima della frattura viene dissipata in deformazione permanente del suolo, in onde sismiche, in calore d'attrito e in processi chimici e fisici causati dall'attrito di scorrimento e dal calore a esso associato. Il processo di 'ricarica' dell'energia potenziale elastica riprende quindi lentamente con l'azione delle forze tettoniche fino a ricostituire le condizioni favorevoli a una nuova frattura e a un nuovo rilascio di energia. Secondo la direzione del movimento reciproco delle labbra di frattura e l'orientazione nello spazio del piano di scorrimento, i t. produrranno o riattiveranno faglie che, riconoscibili o no sulla superficie terrestre, saranno classificate secondo le definizioni geologiche in faglie dirette, inverse, trascorrenti. Lo slittamento delle due labbra di faglia genera una particolare distribuzione a quadranti del primo impulso, compressivo o dilatativo delle onde prime P. Questa distribuzione può essere rilevata in superficie dalle registrazioni sismografiche del primo arrivo, verso l'alto o verso il basso, dalle quali è possibile ricostruire il meccanismo focale del t., che si usa proiettare sulla semisfera inferiore rispetto al centro di frattura. Nella fig. 6 sono rappresentati i meccanismi focali derivati da tre tipi di faglia, e la loro distribuzione superficiale di primi arrivi così come sarebbe registrata da un insieme di sismografi verticali. Bisogna ricordare che il meccanismo focale ricavato dai primi arrivi, così come quello ricavato dal confronto dei sismogrammi reali e sintetici, non consente di distinguere tra il piano di scorrimento (quello rappresentato a tratto continuo tra le due frecce grandi) e quello coniugato (perpendicolare al primo, a tratto e punto). Il modello di Reid ha il vantaggio di essere applicabile ai campi di sforzo provenienti da qualsiasi modello geodinamico globale. Non solo: esso è applicabile anche a una eventuale causa con più definito carattere regionale o locale dei campi di sforzo e dei t., che, come vedremo, non può ancora ragionevolmente essere esclusa. Invece è assai semplicistica la trattazione della frattura come piano di scorrimento: nulla vieta che durante il rilascio di energia la frattura segua zone di minor resistenza, non perfettamente piane, e che si creino diverse ramificazioni durante la sua propagazione. Nel corso di quest'ultima, la frattura può incontrare zone con maggiore resistenza, dove può rallentare o momentaneamente arrestarsi, per riprendere il suo corso frazioni di secondo più tardi o anche minuti od ore, dando luogo in questi casi a vere e proprie scosse di replica. Nella fig. 7 è rappresentata la dislocazione di una faglia seguita nelle sue varie fasi. Il processo di frattura intracrostale inizia (a) quando lo sforzo tettonico (frecce larghe orizzontali) supera la resistenza dei materiali in un punto A e due labbra della frattura iniziano a scorrere l'una rispetto all'altra (b, c): è rappresentata (d) una frattura che si propaga secondo una faglia normale e che raggiunge la superficie terrestre producendo dei muri di faglia visibili e incontrando zone di disomogeneità dei materiali, come in B e C, dove non riesce a propagarsi. La frattura può temporaneamente fermarsi come in (e), dove lo sforzo tettonico è già diminuito. Il fenomeno riprende (f) con il cedimento dell'asperità B e un nuovo scorrimento (g, h) che riattiva il muro superficiale, il quale si innalza ulteriormente (i, l) in seguito al cedimento della seconda asperità C. Da studi dettagliati della sorgente sismica dei maggiori t., confrontando le tracce delle registrazioni sismografiche reali con le tracce teoriche (sismogrammi sintetici), derivate dal modello di Reid opportunamente rielaborato, si è verificato che l'evolversi della frattura nei pochi secondi iniziali di un t. è effettivamente un processo complesso. Per es., si è accertato che il t. dell'Irpinia del 1980 si è svolto con il susseguirsi di tre episodi di frattura, l'iniziale e due subeventi, a distanza di 20 secondi l'uno dall'altro.

I mezzi di osservazione e le reti sismiche

Il generale successo delle reti sismiche è stato reso possibile, a partire dagli anni Sessanta, dalla disponibilità, per il trattamento dei segnali generati dai sensori sismici, di dispositivi elettronici a stato solido, assai affidabili, pochissimo ingombranti e relativamente assai poco esigenti in termini di alimentazione elettrica. L'esigenza di sviluppare moderne reti sismiche si deve invece all'intrecciarsi e sostenersi a vicenda di diversi motivi. Forse il principale è stato la necessità di localizzare con sempre maggiore accuratezza l'ipocentro dei t. per poterne cartografare con grande attendibilità la distribuzione sul territorio, a fini sia scientifici sia sociali.

Dato che la determinazione dell'ipocentro di un t. è basata sulla differenza fra gli istanti di arrivo di un dato tipo di onde sismiche in luoghi diversi dalle coordinate geografiche note, l'accuratezza della localizzazione dell'ipocentro viene a dipendere da un'analoga precisione dei riferimenti temporali nei siti di rilevamento. In passato la struttura di rilevamento tramite osservatori, ognuno dei quali era provvisto di un orologio per identificare l'istante di arrivo dei vari tipi di onde sismiche, a causa degli scarti praticamente inevitabili tra orologio e orologio forniva coordinate ipocentrali con errori da qualche km a qualche decina di km; oggi il riferimento dei dati di tutti i sensori di una rete a un solo orologio, quello centralizzato della rete (conosciuta come rete sismica centralizzata), insieme al maggior numero di dati di stazione su cui operare il calcolo, ha determinato la diminuizione di un ordine di grandezza dell'errore associato alle coordinate geografiche del fuoco, ridotto ora a solo pochissimi km al massimo. Un'accuratezza ancora maggiore la si può ottenere con il metodo delle 'determinazioni congiunte' (joint determination), che consiste nello scegliere gruppi di eventi sismici vicini, assumendo costanti le correzioni dei tempi di stazione per la propagazione di un dato raggio sismico dalla sorgente alla stazione. In altre parole, per quel gruppo di eventi (in genere repliche di una scossa principale o successive riprese di una sequenza sismica) si suppone che le anomalie delle travel time di stazione siano sempre le stesse, considerato che lo stretto raggruppamento spaziale degli eventi consente di ipotizzare come molto simili i tragitti dei raggi sismici e le caratteristiche del mezzo attraversato. Altrettanto efficace è il metodo del master event, ovvero dell'evento di riferimento. Esso consiste: nello scegliere un t., nel gruppo in esame, per la cui rilevanza (delineata dal grande numero di dati usati nel calcolo e dall'eventuale conoscenza della posizione della faglia sorgente) si è sicuri del risultato del calcolo ipocentrale; nell'usare i tempi di arrivo di questo evento come riferimento per calcolare le coordinate ipocentrali di tutti gli altri, tenendo conto delle lievi differenze tra i tempi di arrivo di questi ultimi e quelli dell'evento di riferimento.

I risultati dei due metodi sono a volte sorprendentemente buoni: distribuzioni molto confuse di ipocentri calcolati indipendentemente si raggruppano in modo più regolare, rendendo riconoscibili allineamenti e superfici riconducibili a discontinuità delle strutture geologiche. Per il secondo metodo rimane l'unica riserva che l'inevitabile, ma in genere piccolo, errore nella localizzazione dell'evento di riferimento si riflette in uno slittamento complessivo delle determinazioni ipocentrali degli altri. Rimedio a quest'ultima fonte di incertezza può essere il brillamento di una forte carica di esplosivo che faccia da evento di riferimento senza incertezza di localizzazione nello spazio e nel tempo, almeno per quel gruppo di stazioni a distanza sufficiente per registrare il t. artificiale così prodotto.

Un altro importante motivo per lo sviluppo di moderne reti sismiche è sicuramente stato il constatare che una distribuzione fitta di stazioni permetteva di abbassare con maggiore uniformità su tutto il territorio coperto dalla rete la soglia di minima magnitudo registrabile, cosa una volta possibile solo in un raggio ristretto intorno all'osservatorio.

Per es., se una piccola scossa di magnitudo 2,5 è registrabile da buone stazioni sismiche a distanza massima di circa 40 km, una rete di stazioni con maglia massima di 40 km consente di registrare tutti i t. con magnitudo superiore a 2,5 in tutto il territorio coperto dalla rete. L'infittirsi delle maglie risponde alla duplice convinzione che il rilevamento di t. di piccolissima entità (microsismi) possa servire come segnale premonitore di eventi di maggiore entità e che strutture generatrici di forti t. possano essere seguite e meglio delimitate anche dai loro movimenti minori espressi come piccoli terremoti.

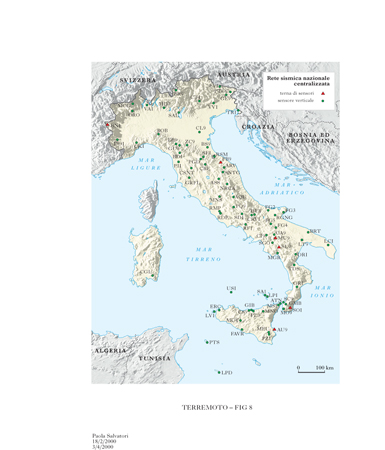

Lo sviluppo di sismografi portatili, facilmente alloggiabili anche in locali non espressamente progettati per rilevamenti sismici, ha permesso una graduale ed elastica espansione delle reti sismiche con stazioni ospitate da enti e municipalità e con infittimenti e miglioramenti successivi, localizzate in dipendenza delle opportunità createsi all'accadere dei maggiori eventi sismici. In particolare, il disastroso terremoto dell'Irpinia del 1980 ha dato l'impulso decisivo al mondo politico e scientifico italiano perché si procedesse all'attuazione di una moderna Rete sismica nazionale centralizzata (RSNC) gestita dall'Istituto nazionale di geofisica, che, in quanto statutariamente incaricato della "sorveglianza sismica del territorio nazionale", stava già muovendosi da qualche tempo in quella direzione superando la sua precedente struttura a osservatori sismici.

La Rete sismica nazionale centralizzata dell'Istituto nazionale di geofisica (circa 90 stazioni automatiche di rilevamento nel 1999: fig. 8) si avvale anche, dal 1989, di una Rete mobile le cui apparecchiature, in caso di t. rilevante, sono trasportabili nel luogo più opportuno; a essa si aggiunge la Rete accelerometrica nazionale gestita congiuntamente dall'ENEL e dal Servizio sismico nazionale, il quale afferisce al Dipartimento dei servizi tecnici nazionali della Presidenza del consiglio dei ministri; si aggiungono inoltre alcune Reti sismiche regionali e alcuni osservatori locali. Tutte queste attività di rilevamento sismico sono coordinate, ai fini della sorveglianza sismica del territorio nazionale, dal Servizio sismico nazionale e, ai fini della prevenzione dei danni, dal Sottosegretariato della protezione civile del Ministero dell'Interno. Per i t. interessanti i paesi circostanti il bacino del Mediterraneo l'ente coordinatore dei risultati delle osservazioni è il Centre sismologique euro-méditerranéen (CSEM), con sede a Strasburgo; su scala mondiale si hanno lo statunitense National Earthquake Information Service (NEIS) e il britannico International Seismological Centre (ISC) per le attività osservative e la International Association of Seismology and Physics of the Earth's Interior (IASPEI) di Denver per le attività propriamente scientifiche.

Mediante tali mezzi osservativi è oggi possibile rappresentare tridimensionalmente la distribuzione delle repliche dei grandi t., anche quelle di piccola magnitudo, e definire con minore incertezza posizione e, per i t. superficiali (che sono di gran lunga i più frequenti anche in Italia), orientamento del piano di faglia. Seguire in questo modo nel tempo il 'fenomeno t.' è di interesse estremo, specie nei casi frequenti dell'evenienza di numerose repliche e t. susseguenti (riprese), questi ultimi, a volte, di magnitudo non minore di quella della scossa di apertura (come si è avuto, per es., nella lunga sequenza sismica umbro-marchigiana del 1997). Queste informazioni sono integrabili con quelle provenienti dai primi movimenti del terreno (fig. 6), che forniscono il cosiddetto meccanismo focale del t. e anzi costituiscono oggi le condizioni necessarie per una metodologia del meccanismo focale, che è sempre bisognosa, a causa della molteplicità delle soluzioni possibili, di ulteriori indizi per operare una scelta corretta tra esse.

Si intuisce facilmente come i meccanismi focali dei t. della prima metà del secolo, o comunque avvenuti prima dell'installazione della Rete sismica nazionale centralizzata, siano mal determinati e statisticamente poco significativi: dei principali eventi sismici della nostra storia recente, come quelli di Messina del 1908 e di Avezzano del 1915, esistono diverse versioni discordanti tra loro e fra le quali quella in accordo con il più probabile piano di faglia non è la più significativa statisticamente. Se, per es., i meccanismi focali dei maggiori t. italiani dal 1977 al 1992 vengono riportati insieme su una mappa (fig. 9), appare comunque un andamento coerente e caratterizzato da un Appennino in generale distensione. Questo elemento è confortato dagli attuali cataloghi di dati di stress misurati in situ, valutando la deformazione dei pozzi di prospezione per idrocarburi sparsi fittamente sulla penisola. Al di là del fronte appenninico, in Adriatico e sulle Dinaridi i meccanismi mostrano invece uno sforzo dominante compressivo. Sull'arco calabro-siciliano e sul Tirreno la distribuzione regionale degli sforzi è di più difficile interpretazione.

Una moderna rete sismica, con le sue eventuali integrazioni temporanee, consente di usare il fascio dei raggi delle onde sismiche prodotte dai t. per una caratterizzazione dello spessore crostale (cioè della profondità della discontinuità di Mohorovičić tra crosta e mantello) e della stratificazione della crosta.

Si usa per questo l'analisi delle registrazioni dei t. lontani (distanza epicentrale dell'ordine di 2500 km o più), per i quali si è sicuri che le onde sismiche attraversano quasi verticalmente la litosfera. Le onde che arrivano dal mantello vengono riflesse dalla superficie libera terrestre verso il basso e, arrivate alla discontinuità crosta-mantello, vengono nuovamente riflesse verso la superficie e registrate come onde riverberate; la differenza di tempo tra il primo arrivo e il riverbero risulta tanto maggiore quanto più spessa è la crosta attraversata. Con questo principio, e altri analoghi (quale quello della valutazione, quando possibile, della differenza di arrivo dell'onda P e dell'onda S orizzontale originatasi dalla stessa P al suo passaggio alla discontinuità di Mohorovičić), i t. lontani vengono oggi sfruttati per studi dettagliati di lunghe sezioni di crosta. Per es., sono state recentemente organizzate delle vere e proprie campagne che, con il mantenimento in funzione per qualche mese di stazioni sismiche portatili lungo stendimenti lineari, dalle coste adriatiche a quelle tirreniche, hanno permesso di definire con una risoluzione mai raggiunta prima la struttura crostale dell'Appennino.

Utilizzazioni geologiche di dati sismologici: la tomografia sismica

Da quanto è stato detto si comprende come la svolta decisiva dell'osservazione del 'fenomeno t.' mediante reti sismometriche abbia significato un aumento per il sismologo delle possibilità risolutive nello studio delle strutture geologiche. All'inizio del 20° secolo la principale ragione dell'installazione dei sismografi negli osservatori e dello scambio internazionale dei dati era quella di costruire le dromocrone (fig. 2) dei terremoti.

La costruzione di questi diagrammi (o tabelle), che negli anni precedenti all'avvento degli elaboratori elettronici ha costituito un assai laborioso impegno per generazioni di sismologi, rispondeva al problema principe della sismologia dell'epoca: determinare l'architettura interna generale della Terra mediante l'individuazione e la definizione della profondità delle grandi superfici di separazione (crosta-mantello, mantello-nucleo, nucleo esterno-nucleo interno): per es., se la discontinuità mantello-nucleo si fosse trovata 500 km più in alto o più in basso avrebbe avuto come effetto un corrispondente cambiamento di forma e posizione del tratto di dromocrona relativo, per es., alle onde longitudinali PcP riflesse su quella discontinuità (fig. 1). Molto importante fu il constatare che le dromocrone mediate su tutti i percorsi su cui era possibile misurarle avevano una piccola deviazione dalla media, un fatto che testimoniava in modo sicuro la simmetria sferica dell'architettura globale terrestre: per es., se una dromocrona di un'onda P riflessasi sul nucleo non era significativamente diversa se misurata in due opposti emisferi, o in ogni altra parte del globo, il confine mantello-nucleo doveva essere in prima approssimazione sferico.

Con l'infittirsi delle stazioni sismiche, fino alle moderne reti sismometriche nazionali e internazionali, è stato invece possibile gestire le dromocrone come oggetti da mediare non più globalmente ma solo regionalmente, o non mediare affatto, e tenere conto così, a parità di distanza percorsa, di tutte le lievi differenze tra i tempi di tragitto come indizi di propagazione attraverso mezzi caratterizzati da diverse qualità meccaniche, diversa densità o composizione. Con l'accumularsi di un'enorme massa di dati, si sono via via affinate queste tecniche di individuazione delle zone più o meno profonde ed estese cui attribuire i lievi anticipi o ritardi nei tempi di tragitto: è nata così la tomografia sismica, che ha lo scopo di cartografare tridimensionalmente le cosiddette anomalie del mantello e del nucleo, nonché la struttura regionale e locale della crosta e della litosfera.

Questa tecnica, molto promettente, consente di ottenere immagini, sfocate ma indicative, di strutture a tutte le scale, dall'apparato vulcanico, alle strutture di fossa-arco-retroarco, all'intero pianeta. Al di là dei pur giustificati entusiasmi, la tomografia sismica globale soffre però di diverse limitazioni, la principale tra le quali è di non poter utilizzare sorgenti artificiali coerenti e direzionabili, né reti di sensori regolarmente distribuiti (come accade, per es., nella tomografia medica, e come a volte è possibile fare per tomografie sismiche a piccola scala). Una seconda limitazione è la dicotomia tra i continenti ricoperti da reti sismiche, seppur con grandi disomogeneità (come, per es., tra Nord e Sud), e i bacini oceanici (più del 70% della superficie terrestre, e tra essi il Pacifico ricopre quasi un emisfero), quasi del tutto privi di stazioni sismiche. Questa netta disomogeneità globale raccomanda ancora molta cautela nel giudicare i risultati delle tomografie sismiche a grande scala. Ne segue che il traguardo da raggiungere per la sismologia del nuovo millennio è quello di sviluppare affidabili tecniche sottomarine, capaci di allestire e mantenere nel tempo, con una efficace trasmissione dei dati in superficie, un gran numero di stazioni sismiche a grande profondità; impresa difficile a causa della pratica impossibilità di trasmettere in acqua segnali radio con sufficiente capacità di informazione e degli alti costi di posa dei cavi sottomarini per le telecomunicazioni. Già si pensa alla riutilizzazione di vecchi cavi transoceanici dismessi.

La tomografia sismica attende dunque nei prossimi decenni un sostanziale aiuto dall'oceanografia, ma attende anche di lavorare di concerto con la fisica delle particelle elementari in quella che già si chiama tomografia neutrinica della Terra.

I neutrini, evanescenti particelle di massa prossima a zero, attraversano la Terra con un lievissimo assorbimento ma senza le riflessioni e rifrazioni tipiche delle onde sismiche. Con opportuni allestimenti di reticoli di rivelatori immersi negli oceani a grande profondità si confronterà il flusso di radiazione Čerenkov innescata dai rari urti dei neutrini che piovono dall'alto in una determinata direzione, con quelli che hanno attraversato, nella stessa direzione, ma in senso contrario, l'interno della Terra. Il calcolo dell'assorbimento al variare della direzione di attraversamento fornirà una nuova mappa indipendente dell'architettura terrestre, da integrare con quella tradizionale ottenuta dalla 'luce del t.', le onde sismiche.

Ma non solo la tomografia sismica deve essere considerata simile a una foto, in cui non è presente la dimensione tempo. Un'importante avvisaglia del suo potersi trasformare in una tecnica capace di indagare anche i movimenti si è avuta con il recente risultato della scoperta della super-rotazione del nucleo interno terrestre. Indagando sull'andamento nel tempo delle dromocrone di onde sismiche che attraversano il nucleo interno a confronto con quelli di onde che lo sfiorano solo esternamente, si è notata una differenza periodica, indizio di una rotazione, dell'ordine di 1 sino a 3 gradi all'anno, del nucleo interno rispetto al mantello.

Terremoti profondi: ipotesi di meccanismi focali

Se il modello del 'rimbalzo elastico' di Reid ha avuto un grande successo per la spiegazione del 'fenomeno t.', non bisogna mai dimenticare che esso è applicabile solo alla parte fragile della Terra: al di sotto della litosfera si avrebbero difficoltà enormi ad applicare un modello di frattura a un mezzo che dovrebbe qualificarsi come viscoso. D'altronde i t. avvengono frequentemente a profondità molto grandi, fino a un massimo di 700 km, e di questo limite ancora non si conosce definitivamente il significato. Potrebbe trattarsi di una reale impossibilità, alle temperature, pressioni e composizione dei materiali più profondi (quelli a perovskite del mantello inferiore), di accumulare tensioni o sviluppare processi che diano come risultato il t.; così come eventuali t. più profondi di quello che oggi a noi appare un limite potrebbero essere solo talmente rari da non essere compresi ancora nei nostri cataloghi. Potrebbe infine trattarsi solo di un abbassamento, a causa delle mutate caratteristiche dei materiali, della magnitudo massima esprimibile da quel mezzo viscoelastico sottoposto a deformazione, e quindi della banale impossibilità per un sisma, per es. di magnitudo 2,5, di essere registrato da una stazione in superficie a 700 km di distanza. Risulta infatti difficile immaginare che gli allineamenti tipici dei t. profondi lungo superfici a cucchiaio, orientate in media a 45° verso l'interno terrestre (superfici di Benioff, impropriamente dette piani di Benioff), indizio di un movimento reciproco dei materiali separati da queste superfici, non indichino pure un prolungamento di questo moto verso la base del mantello. Quanto all'origine, a differenza dei t. superficiali, che sono prodotti da processi di fratturazione fragile e di scivolamento con attrito lungo superfici di faglia, quelli intermedi e profondi sembrano avere una genesi più complessa.

La spiegazione meccanica dei t. profondi impegna da decenni i sismologi e richiede la convergenza di varie discipline, dalla reologia alla geochimica, alla fisica delle alte pressioni e delle alte temperature. Fra i diversi modelli proposti spicca quello basato sull'ipotesi di uno scorrimento lungo un improprio 'piano di faglia', o 'zona schiacciata'; tale scorrimento è ipotizzabile dalla determinazione dei piani del meccanismo focale, ma sarebbe innescato non dal propagarsi di una frattura quanto da repentini cambiamenti di fase in un mezzo divenuto metastabile, che si verificano in profondità nel mantello terrestre a causa del lentissimo transito dei materiali su livelli di profondità diversa e della conseguente variazione di pressione. Il risultato finale sarebbe l'improvvisa riorganizzazione dei reticoli cristallini in strutture con una viscosità minore di quella di partenza, che consentirebbe lo scorrimento rapido da cui originano le onde sismiche.

Sebbene la nuova tettonica globale delle placche abbia incontrato il favore generale, la spiegazione che nel suo ambito si dà della causa delle 'superfici di Benioff', sulle quali, come detto precedentemente, si addensano gli ipocentri dei t., appare prestare ancora il fianco a numerose obiezioni.

Le superfici di Benioff, per la maggior parte distribuite sui margini del bacino del Pacifico, sarebbero dovute alla necessità di rispettare un bilancio in pareggio tra la nuova crosta, creata per fasce parallele alle dorsali oceaniche, e altrettanta crosta oceanica antica che deve essere riassorbita ritornando nel mantello lungo le suddette superfici. Numerose contraddizioni (tra le quali la difficile compatibilità della proposta dinamica dei moti convettivi, motori delle placche, con le tracce dei sottili pennacchi, plumes, di materiale caldo proveniente dal mantello; oppure l'esistenza di conoidi detritici fluviali a ridosso dell'arco delle Aleutine, in posizioni non in facile accordo con la cinematica globale delle placche; la stranezza della grande attività tettonica del lato continentale rispetto alle apparenze indisturbate del lato oceanico delle strutture fossa-arco-retroarco) fanno sì che alla distribuzione regolare dei t. al di sotto delle strutture fossa-arco-retroarco circumpacifiche non sia ancora possibile assegnare con certezza il ruolo, a essi attribuito dalla tettonica delle placche, di traccia del ritorno di una grande quantità di antica crosta oceanica nel mantello, per un ammontare che dal Giurassico a oggi sarebbe pari a più di mezzo emisfero. Si può solo essere certi che si tratta di una superficie di separazione fra due zone in lenta interazione su cui è ancora utile indagare senza modelli precostituiti.

Ulteriori studi sono necessari e non è escluso che maggiore luce possa venire da indagini regionali sulla sismicità e sismotettonica degli archi del Mediterraneo.

Non va infatti dimenticato che l'Italia e la Grecia costituiscono strutture geologiche del tutto simili a quelle della cintura circumpacifica. Il Mar Egeo non è altro che il bacino di retroarco di un arco insulare ellenico dalla curvatura assai accentuata rispetto a quella prevista da una teoria che attribuisce la curvatura degli archi al piegamento del bordo di una calotta sferica verso l'interno. Stessa cosa dicasi per il Tirreno e l'arco calabro-siciliano, e per il disaccordo tra le direzioni dei due piani di Benioff, tirrenico ed egeo, che rende difficoltoso l'accordo tra la cinematica prevista nello schema della tettonica delle placche dello scontro in atto tra Africa ed Eurasia e i dati a nostra disposizione. I chiarimenti che forniranno nei prossimi anni gli studi volti ad appurare la reale origine dei t. mediterranei dovranno pure dare risposta al legame mai ben esplicitato tra fenomeni sismici e vulcanici, in base alla quale i t. lenti potrebbero trovare un loro inquadramento.

Sismicità e vulcanesimo

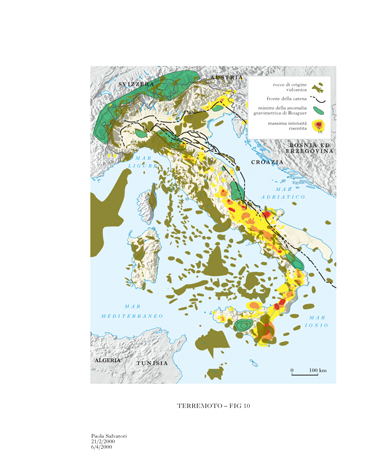

Molti sismologi in passato pensavano che un processo unico fosse alla base dei t. e delle eruzioni vulcaniche. Qualche decennio fa P. Caloi rilevò sul territorio italiano una correlazione tra fascia vulcanica e fascia dei t. più distruttivi, nel senso che sulla fascia vulcanica si aveva una sismicità relativamente modesta. Si può oggi precisare meglio questa relazione spaziale utilizzando la cartografia più aggiornata proveniente da diverse istituzioni scientifiche.

Se si sovrappongono su una mappa, indipendentemente dalla loro età, tutte le formazioni geologiche di origine vulcanica, sia quelle esposte in superficie, sia quelle sepolte in profondità nella crosta e rilevate con campagne aeromagnetiche, e si confronta poi questa distribuzione di rocce con quella di quantità che sono in relazione al flusso di energia sismica ricavata dai dati dei cataloghi sismici, si vede che effettivamente i flussi più intensi di energia sismica, quelli relativi alle zone in cui si manifestano intensità macrosismiche maggiori del ix grado MCS, sono generalmente al di fuori della fascia vulcanica ma generalmente compresi tra fasce di vulcaniti: anzi, in più punti l'attività sismica sembra avere dislocato, a volte per decine di chilometri, formazioni di rocce vulcaniche che una volta erano accostate. L'impressione che se ne trae è una visione d'insieme dell'azione di trasporto che i t. esercitano sulle formazioni tettoniche nel corso di intervalli temporali dell'ordine di decine di milioni d'anni, mantenendosi un fenomeno stazionario per tali scale di tempi e nello spazio. Ma riemerge anche l'ipotesi di un legame tra i fenomeni magmatici, l'impostazione dei corpi ignei intracrostali e i t., che, per quanto detto prima, appaiono come poli opposti di un medesimo processo di spostamento di masse in fase fluida e solida rispettivamente. La fig. 10 evidenzia, oltre che alte emissioni di energia sismica fra vulcaniti, come a nord-est del Cilento, nell'Appennino bolognese, nel Mugello, anche il fatto che il fronte della catena è un ulteriore confine. Un altro fattore rispetto al quale la sismicità è inibita è la presenza di minimi relativi delle anomalie gravimetriche di Bouguer: queste ultime sono da mettere in relazione a ispessimenti locali della crosta o a cambiamenti delle sue caratteristiche.

Aspetti sociali e di protezione civile: previsione degli eventi e prevenzione dei danni

Tutte le scale di intensità macrosismica, compresa la scala MCS attualmente più usata, hanno avuto come preoccupazione prioritaria quella di descrivere gli effetti dei t. sui manufatti e, per i t. assai intensi, anche sulle strutture naturali, con ovvio riferimento alla geomorfologia del luogo e alle diverse tipologie costruttive, sia di tipo tradizionale (caratteristica dei vari paesi), sia di tipo nuovo, come quelle in cemento armato. Né si vede oggi la fine dell'evoluzione delle scale macrosismiche, che dovranno anzi affrontare auspicabilmente una sempre più consapevole e capillare applicazione delle norme di costruzione antisismica, fino ad affrontare la forse utopica possibilità di una 'città ideale', nella quale nessuna abitazione possa essere danneggiata se non superficialmente da un sisma. La scala macrosismica del futuro dovrà poter assegnare un valore di intensità anche per questa città, e commissioni di studio sono già al lavoro sul problema di come stabilirlo.

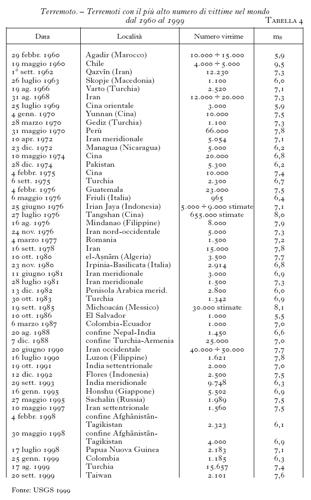

Ma 'città ideali antisismiche' purtroppo non esistono ancora, e i risvolti sociali dei t. a seguito dei loro effetti distruttivi sono noti quel tanto che basta per poter affermare che i t. di grande magnitudo sono anche ad alto grado macrosismico (fanno eccezione i t. in distretti oceanici e, almeno in parte, i t. in ampie zone prive di importanti insediamenti umani) e appartengono spesso, per non dire sempre, alla categoria di quelle che tradizionalmente si chiamano catastrofi naturali, come tali causa irreversibile della perdita di beni e persone. Indicativa a tale riguardo per l'Italia è la tab. 1, che riporta i dati dei maggiori t. occorsi in Italia negli ultimi due secoli, con l'indicazione del numero delle vittime. Analoga, ma relativa anche alle altre regioni della Terra, è la tab. 4, che riporta i dati dei t. compresi nell'arco di tempo 1960-99 e contraddistinti dal più alto numero di vittime. Soltanto in tempi piuttosto recenti la comunità scientifica ha preso piena coscienza del fatto di avere ormai la capacità di valutare oggettivamente la pericolosità dei t. e di attuare provvedimenti per poter ridurre l'entità dei danni da essi prodotti.

Esistono diversi approcci al problema della prevenzione dei danni da terremoto, e negli ultimi decenni, come base di giudizio per i successivi concreti interventi, si è imposto il concetto di rischio sismico in una data zona, quantificato mediante il suo valore numerico R (espresso in unità di valuta monetaria) dato dalla relazione: R5F(Im)?P?V, essendo Im l'intensità macrosismica in gradi MCS, F(Im) la frequenza di accadimento di intensità maggiori o uguali di quella intensità in quella zona (in t. all'anno), V il valore dei beni in quella zona, P la percentuale di danneggiamento per terremoto.

La determinazione del parametro V risulta subito di grande difficoltà, a causa di soggettività e fluttuazioni dei prezzi di mercato, della non estimabilità della vita umana e di altri beni di natura culturale e artistica (a tale riguardo va sottolineata per l'Italia la cospicua presenza, anche in zone fortemente sismiche, di preziosi beni culturali). Ma va anche notato che la quantità stessa R, una volta che a essa sia stato assegnato un determinato valore per una data zona, deve essere poi affidata a un giudizio sulla sua minore o maggiore rilevanza, che è ampiamente discrezionale e 'politico'.

Le competenze necessarie alla valutazione pratica di R sono da una parte sismologiche e ingegneristiche (relative al prodotto F(Im)?P) e dall'altra di natura economica (V). Questo ha fatto sì che si creasse una divisione del lavoro e che i sismologi si occupassero della definizione della pericolosità sismica, essenzialmente di F(Im) o del tempo di ritorno medio (in anni) del t. nella zona di interesse, T51/F(Im). Per es., studi effettuati per la zona complessiva Irpinia e Sannio-Matese hanno dato come risultato che t. di intensità pari o maggiore del IX grado MCS hanno un tempo di ritorno medio T di 20612 anni.

I problemi pratici di questo obiettivo parziale, compito della sismologia, derivano da due difficoltà principali: l'assegnazione di un valore quanto più vicino al vero per l'intensità macrosismica degli eventi sismici antichi (di cui esistono cronache non scientifiche) e la determinazione dell'anno a partire dal quale ragionevolmente si può essere sicuri che il catalogo sismico della regione di interesse e delle zone limitrofe sia completo per una determinata intensità epicentrale, cioè l'intervallo su cui si può calcolare, fiduciosi di non sbagliare per difetto, la frequenza F. I due problemi sono interconnessi in quanto assegnare un'intensità più bassa o più alta a un evento sismico significa alterare la statistica su cui si fonda la valutazione della frequenza (ammesso che, data la natura particolare dei dati, si possa parlare di statistica nel significato corretto del termine). Ma forte influenza ha anche la delimitazione della zona entro la quale considerare gli epicentri su cui effettuare la valutazione, l'ampliamento o la riduzione della quale, con l'inclusione o meno di determinati eventi, è a volte un fattore critico risolvibile solo con approfonditi studi sismotettonici e con la rivalutazione delle coordinate epicentrali, impresa a volte assai ardua per eventi antichi. Le laboriose revisioni successive dei cataloghi sismici, che pur tanto hanno contribuito, con paziente lavoro di ricerca archivistica, al completamento dei cataloghi e al perfezionamento della documentazione su cui basare il giudizio di intensità e di posizione epicentrale, avranno purtroppo sempre una ineliminabile componente soggettiva dipendente dall'interpretazione del gruppo di ricercatori che vi ha lavorato. Meritevoli sono quei tentativi di eliminare, con programmi di giudizio codificati e informatizzati, almeno il fattore di variabilità umana nell'elaborazione dei dati. Pur non potendo cancellare la soggettività dei criteri scelti per l'automatizzazione, questi metodi riducono la dispersione dei valori di intensità e possono paragonarsi come vantaggi, nel campo della macrosismica, al metodo delle determinazioni congiunte di cui si è già detto a proposito delle localizzazioni ipocentrali.

Una volta individuate le zone a forte rischio sismico e pericolosità, resta il problema di fondo dell'indirizzamento delle risorse disponibili (che in genere sono sempre insufficienti per poter essere distribuite preventivamente in tutte le dette zone), nel luogo e al momento appropriati, per la prevenzione dei danni, avendo a che fare con un fenomeno che, almeno finora, appare non prevedibile, anche se più o meno frequente secondo le zone. Proprio sulla frequenza di ricorrenza sono basati gli studi condotti, a base regionale, sui tempi di ritorno medi, che possono essere considerati studi sulla previsione statistica dei terremoti.

Se si ragiona dal punto di vista della significatività scientifica della previsione, sembra piuttosto discutibile l'applicabilità dei concetti e dei metodi della statistica a fenomeni che, anche se occorrenti frequentemente (secondo la scala dei tempi geologici) in una certa zona, appaiono essere per loro natura ben lungi dal costituire un universo di dati omogenei, come dire equiprobabili, come la statistica medesima pretenderebbe. A questo aggiungasi l'intrinseca scarsità dei dati oggettivi relativi a t. non recenti. Per ridurre quest'ultima difficoltà, si potrebbe supplire con stime dei parametri significativi dedotte da indagini archeosismologiche e paleosismologiche che cerchino di completare il catalogo degli eventi sismici rispettivamente nel vicino passato (ancora tempi storici) o in quello più lontano (preistoria e tempi geologici prossimi); è peraltro evidente che, salvo casi eccezionali, questa via appare difficile da percorrere e incapace di dare l'attesa massa di dati.

Un'ulteriore difficoltà di utilizzazione a fini previsionistici dei dati disponibili dai cataloghi, o deducibili da altre fonti storiche, consiste nel fatto che la 'storia sismica' di certe regioni mostra l'esistenza di situazioni singolari, apparentemente 'indecidibili' per il futuro.

Un esempio di 'indecidibilità sismica' si ha per la zona della Piana di Sibari, ai piedi del M. Pollino, nella quale negli ultimi secoli non si sono avuti t. di intensità superiore al vii grado MCS: una situazione strana, visto che nelle zone a nord e a sud si sono avuti t. piuttosto intensi, tra il ix e il x grado MCS. Questo caso di assenza di forti t. in tempi passati nella Calabria settentrionale è da alcuni interpretato come una condizione di quiete instabile che potrebbe essere interrotta da un forte t. in un futuro non precisabile. Se, da un lato, le indagini paleosismologiche poco sopra ricordate trovano indicazioni di eventi in questa zona ora relativamente quieta, altri fattori geofisici testimoniano una peculiarità che sembra essere comune ad altre zone quiete, cioè la presenza di un minimo relativo delle anomalie di Bouguer del campo di gravità che, come in altre aree geografiche quali la Sicilia centrale o le Marche a sud di Ancona, sono associate a inibizioni nell'emissione di energia sismica (fig.10). A complicare il quadro esiste la possibilità che la situazione dello stress tettonico e le condizioni geologiche siano mutate nel tempo e che l''orologio' di questi cambiamenti abbia un ritmo vicino alla durata della finestra coperta in totale dal catalogo storico, archeosismico e paleosismico. In casi di questo genere i responsabili per i provvedimenti di protezione civile non hanno la possibilità di prendere, allo stato attuale delle conoscenze, misure certe di intervento preventivo.

Più affidabile, in quanto basata soltanto sulla fisica dei fenomeni sismici o, per dir meglio, dei processi di preparazione e di svolgimento di essi, appare essere, in linea di principio, la previsione deterministica dei terremoti, vale a dire la preventiva individuazione, con determinati margini di errore, delle coordinate spazio-temporali e dell'entità di t. futuri in una data zona. Si tratta di una metodica essenzialmente osservativa, basata com'è sulla registrazione continua dell'andamento dei precursori sismici, vale a dire fenomeni di svariata natura (geologica, meccanica, elettrica, elettromagnetica) le cui caratteristiche appaiono essere in relazione con l'evolversi dello stato di tensione delle rocce che porterà all'evento sismico. Intense ricerche di carattere fisico su questo argomento sono state attivate da tempo in vari paesi soggetti a forte rischio sismico (i principali gruppi di ricerca operano in Giappone, California, Cina, Russia, repubbliche ex sovietiche dell'Asia centrale, Italia e Grecia). I risultati già ottenuti con varie tecniche, spesso combinate fra loro, sono incoraggianti per la prosecuzione degli studi, ma non costituiscono ancora previsioni concretamente utilizzabili ai fini delle misure di prevenzione dei danni e di difesa della popolazione. Nella prospettiva, quindi, di non poter disporre ancora per lungo tempo di attendibili previsioni sismiche, ai responsabili degli organismi preposti al coordinamento delle misure volte alla prevenzione dei danni da t. resta a disposizione soltanto la stima del verificarsi di un t., capace di provocare danni in una data zona, calcolata sulla base dei tempi di ritorno medi di t. simili già avvenuti in passato in quella zona.

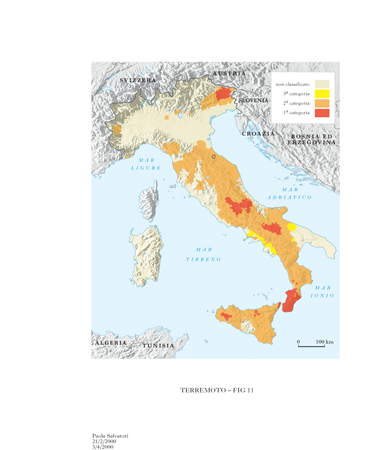

In Italia la funzione di coordinare le misure di prevenzione è attualmente attribuita al Sottosegretariato della protezione civile del Ministero dell'Interno, che consulta il Gruppo nazionale per la difesa dai terremoti, di cui fanno parte rappresentanti di diversi istituti scientifici (Istituto nazionale di geofisica, Consiglio nazionale delle ricerche, alcuni organismi universitari ecc.) e il Servizio sismico nazionale della Presidenza del Consiglio dei ministri, al quale spetta anche di occuparsi del Servizio informativo sul rischio sismico. La valutazione di questo rischio è effettuata ripartendo il territorio nazionale in zone di rischio simile (zonazione, o zonizzazione, sismica; se effettuata alla scala locale, per es. sul territorio di un comune, si parla di microzonazione sismica); sulla base di ciò sono emanate norme di classificazione sismica, come tale intendendosi la ripartizione delle zone del territorio in tre categorie (fig. 11), di rischio decrescente dalla 1ª alla 3ª. Per le costruzioni civili in queste zone valgono speciali norme, che fino al 1981 erano emanate dal Ministero dei Lavori pubblici (l. 2 febbr. 1974 nr. 64) e attualmente sono di competenza delle varie Regioni (l. 10 dic. 1981 nr. 741). Il Ministero dei Lavori pubblici ha emanato il d.m. 16 genn. 1996, riguardante le norme da seguire per la costruzione in zona sismica, e ha dettato con successiva circolare del 10 apr. 1997 le istruzioni per la sua applicazione.

Peraltro, occorre tenere presente che il t. non si basa su eventi casuali, ma è un evento concreto 'irripetibile', che provoca danni irreversibili (non si potrà mai recuperare la perdita di vite umane o di opere d'arte inestimabili): appare azzardato quindi, per la sua prevenzione, fondarsi soltanto su considerazioni di frequenza degli eventi, dal momento che non si conoscono deterministicamente i tempi di ritorno dei t. nelle differenti zone sismiche.

Per migliorare questa situazione - che numerosi indizi fanno sperare essere di natura provvisoria - si può ricorrere alle cosiddette mappe (o carte) di scenario, con le quali si può ottenere una rozza, ma tuttavia significativa, stima degli effetti dei t. in una data zona indipendentemente dalla loro frequenza.

Il tracciamento di tali mappe tenta di rispondere alle domande sugli effetti che ci si potrebbe aspettare se ritornasse un t. con l'intensità massima già registrata in una data regione; oppure su quali sarebbero le zone da intervento prioritario. Una semplice integrazione della mappa della massima intensità risentita (fig. 3) con quelle della densità di popolazione, cioè mediante il cosiddetto filtraggio, fornisce indicazioni utilissime. Per es., il filtraggio della mappa della massima intensità con quella della densità della popolazione per la Campania (fig. 12) mette in evidenza come le aree esposte a un forte impatto socioambientale da t. siano non solo quelle incluse nel poligono di massima intensità MCS dell'Irpinia-Sannio-Matese, ma anche quelle zone della Campania comprese tra l'Irpinia e il Golfo di Napoli che sono a più elevata densità di popolazione, fittamente industrializzate e attraversate da importanti infrastrutture lineari (come il gasdotto transmediterraneo). Ciò induce a riflessioni sulle relazioni più generali e poco note tra storia (politica, economica, sociale ecc.) e calamità naturali. Analogamente, se si dovesse decidere sulla priorità di intervento da assegnare tra la zona del Belice e quella di Palermo, si vedrebbe che, mentre per la mappa della massima intensità risentita avrebbe priorità la zona del Belice, il filtraggio con la densità di popolazione indicherebbe un'alta priorità per il territorio di Palermo, dove una maggiore densità di popolazione presuppone intrecci di cultura, commerci, industrie, trasporti e servizi di gran lunga più importanti.

Nel concreto, l'azione dei responsabili della protezione civile può spingersi anche a dettagli conoscitivi maggiori, con l'individuazione, nel territorio dei Comuni, delle aree la cui risposta alle sollecitazioni delle onde sismiche è maggiore, ricorrendo cioè alla microzonazione sismica; è infatti noto da tempo che nelle zone più esposte i fabbricati possono subire guasti che variano grandemente per aree lontane anche solo poche decine di metri.

Il problema più generale della non uniforme generazione, trasmissione e ricezione dell'energia sismica va considerato a diversi livelli. Già in partenza, a causa del meccanismo focale, le onde P e S si allontanano dalla sorgente con intensità maggiori lungo determinate direzioni. Non ci si deve quindi attendere una distribuzione dei danni uniforme entro corone circolari concentriche intorno all'epicentro: al contrario, è da attendersi una distribuzione assai irregolare. A questo va aggiunta la possibile riverberazione delle onde sismiche su eventuali discontinuità geologiche, che può produrre interferenza costruttiva o risonanze nel terreno e nei manufatti. Infine, la qualità del terreno e gli effetti topografici divengono determinanti all'arrivo in superficie delle onde sismiche, dove differenze grandissime sono osservabili, in caso di eventi catastrofici, fra parti di centri urbani fondati su roccia compatta, dove si hanno danni non rilevanti, e parti costruite su terreni alluvionali o su forti pendenze, circostanze che possono favorire l'innescarsi di frane, con conseguenti grandi distruzioni. Per es., effetti combinati di riverberazioni e di cattiva qualità dei terreni sono stati osservati a Roma su antichi monumenti: gli esempi più vistosi sono costituiti dalla rovina di parte della cinta esterna del Colosseo, provocata dal t. centro-meridionale del 1349, e dai danni molto differenti causati da antichi t. alle colonne gemelle Traiana e di Marco Aurelio giacenti su situazioni geologiche diverse, rispettivamente all'esterno e all'interno dell'antico alveo del Tevere. Tutto il territorio della capitale è stato con vari metodi e in diverse occasioni sottoposto a indagini di microzonazione, per individuare le zone con maggiore propensione al danneggiamento, in relazione alla salvaguardia del suo immenso patrimonio architettonico e culturale.

Prospettive future

La sismologia potrà guardare con ragionevole soddisfazione al 20° secolo per i progressi avutisi nel campo della comprensione fisica delle sorgenti sismiche e dell'uso che di questa conoscenza si è fatto per creare nuove metodologie di rappresentazione e catalogazione dei dati sismici, quali i meccanismi focali e il momento sismico. È dal completamento e ampliamento nel tempo di queste collezioni di meccanismi focali e di magnitudo omogenee che verranno significativi progressi nell'interpretazione sismotettonica delle aree geografiche di maggiore interesse per la geodinamica regionale e globale. Dare uniformità e affidabilità ai dati sismici mondiali è inteso come obiettivo prioritario della sismologia del nuovo millennio, dove la 'materia prima' fornita dai t. dovrà essere resa disponibile per ricerche di più ampio respiro a stretto contatto con la fisica fondamentale. Questi progressi richiederanno una più completa distribuzione dei siti di osservazione sismica sull'intera superficie terrestre; e dato che questa è coperta per oltre il 70% da oceani e mari, potranno essere ottenuti in tempi relativamente brevi solo con la deposizione sui fondali oceanici e marini di affidabili reti sismiche, paragonabili a quelle terrestri.

La scarsità di risultati raggiunti nel 20° secolo nel campo della mitigazione dei danni e delle perdite umane richiede che tutte le conoscenze storiche, statistiche, tecniche, teoriche nel campo (per le quali una grande accelerazione si è avuta nei due scorsi decenni) siano congiuntamente applicate al conseguimento di sicure metodologie di prevenzione. Forse un ritorno alla filosofia sperimentale, questa volta applicata su lunghi periodi di tempo, potrebbe essere di aiuto. Il sorgere, in questo paese che ha vissuto il Rinascimento, di una città ideale edificata con la collaborazione interdisciplinare di ingegneria, architettura, scienze della Terra, ambientali e sociali, secondo le più avanzate tecniche antisismiche, nella quale l'espansione urbanistica avvenga ogni volta con tecnologie non codificate ma rinnovate e migliorate dall'esperienza, in una zona con alta frequenza di sismi distruttivi, potrebbe essere un progetto la cui realizzazione costituirebbe un riferimento mondiale per la lotta contro i disastri naturali.

bibliografia

M. Caputo, Terremoto, previsione del, in Enciclopedia delle scienze fisiche, Istituto della Enciclopedia Italiana, Roma 1992-96, 6° vol., ad vocem.

R. Console, Terremoto, in Enciclopedia delle scienze fisiche, Istituto della Enciclopedia Italiana, Roma 1992-96, 6° vol., ad vocem.

G.F. Panza, R. Funiciello, M. Sarasso, Terra, in Enciclopedia delle scienze fisiche, Istituto della Enciclopedia Italiana, Roma 1992-96, 6° vol., ad vocem.

B.A. Bolt, Earthquakes, New York 1993.

The practice of earthquake hazard assessment., ed. R.K. McGuire, International Association of Seismology and Physics of the Earth's Interior, Denver 1993.

Th. Lay, T.C. Wallace, Modern global seismology, San Diego (Calif.) 1995.

Istituto nazionale di geofisica (ING), Gruppo nazionale per la difesa dai terremoti (GNDT), Storia geofisica ambiente (SGA), Servizio sismico nazionale (SSN), Catalogo parametrico dei terremoti italiani, Bologna 1999.