Acceleratore

Acceleratore

«Io non cerco, trovo» (Pablo Picasso)

LHC. Il grande anello di collisioni adroniche

di

10 settembre Il CERN, l’Organizzazione europea per la ricerca nucleare di Ginevra, mette in funzione l’LHC (Large Hadron Collider), il più grande e complesso acceleratore di particelle al mondo. Installato in un tunnel circolare lungo 27 km, a 100 metri di profondità, contribuirà a far luce su aspetti fondamentali della formazione e dell’evoluzione del cosmo

Perché il Large Hadron Collider

L’inaugurazione di LHC marca l’inizio di un’avventura che segnerà lo sviluppo della fisica nei primi decenni del 21° secolo. Il nuovo grande anello di collisione tra protoni, oppure nuclei pesanti, è la risposta del mondo di oggi alla sfida millenaria dell’uomo di scoprire i costituenti fondamentali della materia e le leggi alla base del loro comportamento.

La teoria che costituisce la sintesi delle attuali conoscenze si è affermata da circa 30 anni con il nome di Modello Standard. Da allora ha conosciuto una serie sorprendente di successi, permettendo d’interpretare con accuratezza crescente tutti i fenomeni elementari osservati. La materia che è intorno a noi e che popola l’Universo sin dalle origini è fatta di leptoni e quark, organizzati simmetricamente in gruppi e famiglie. Gli atomi della materia ordinaria, per esempio, sono costituiti da elettroni – che sono leptoni – orbitanti attorno a un nucleo fatto di protoni e neutroni, che a loro volta sono composti di quark. Le forze che agiscono fra i costituenti materiali si manifestano anch’esse come particelle: i fotoni, i bosoni W e Z, i gluoni, che rispettivamente governano l’elettromagnetismo, la radioattività, il nucleo atomico. Una proprietà singolare distingue i quark: nessuno li ha mai osservati isolati; essi appaiono sempre almeno in coppie, legati da gluoni, costituendo composti che si chiamano adroni. L’attuale teoria richiede ancora l’osservazione diretta di un ingrediente essenziale: un campo – il campo di Higgs, con associata l’omonima particella – che pervaderebbe tutto lo spazio e che avrebbe la fondamentale proprietà di conferire la massa alle particelle dell’Universo. Scoprire la particella di Higgs – e spiegare così l’origine della massa delle cose – è in cima agli obiettivi di LHC.

A dire il vero, i successi del Modello Standard sono, a poco a poco, diventati frustranti, perché è evidente che esso non può in nessun modo abbracciare tutta la realtà: mentre da una parte descrive con successo le tre interazioni dominanti a livello subatomico più su richiamate, dall’altra non riesce a includere nella sua trattazione la quarta interazione fondamentale, vale a dire la forza di gravità, proprio quella della quale siamo maggiormente consci. Assieme al completamento dell’attuale teoria si punta quindi al suo superamento. In pratica si spera, benché ciò possa apparire paradossale, che essa incappi in un insuccesso, il più clamoroso possibile, per meglio capire in quale direzione modificarla o estenderla.

Molte delle conquiste del Modello Standard resteranno, in ogni caso, per sempre; per esempio la sua intima struttura matematica, basata su simmetrie astratte, studiate da tempo nella teoria matematica dei gruppi. I segni che tali principi organizzativi sono presenti in natura sono semplici e inequivocabili: nella descrizione delle particelle elementari e delle loro interazioni, appaiono numeri interi, certi numeri e non altri, caratteristici di certe simmetrie. In linea con tali idee, è stata ipotizzata l’esistenza di un’altra simmetria, chiamata supersimmetria. Tutte le particelle microscopiche conosciute hanno la natura quantistica di fermioni o bosoni, una dicotomia rispettivamente corrispondente a quella, familiare, tra materia e campi di forza. La supersimmetria risolve tale dicotomia, prevedendo l’esistenza di un nuovo bosone in corrispondenza di ogni fermione noto e viceversa: il partner dell’elettrone sarebbe il selettrone, quello del fotone il fotino, e così via, con nomi anche più buffi. C’è grande aspettativa che le particelle supersimmetriche siano scoperte grazie a LHC e il successo in tal caso sarebbe duplice, visto che la loro esistenza risolverebbe, almeno in parte, il mistero della materia oscura dell’Universo.

A livello dei processi elementari, la natura appare organizzata in conformità a simmetrie che, secondo il Modello Standard, furono presenti in forma esatta nell’Universo primordiale, determinando stati iniziali alquanto omogenei. L’infinita varietà del mondo che conosciamo è innanzitutto frutto della progressiva spontanea rottura di quelle simmetrie, a mano a mano che l’Universo si è raffreddato. Con LHC sarà studiata la violazione della simmetria materia-antimateria, un processo necessario per spiegare che l’Universo che conosciamo, pur essendo succeduto a uno stato materia-antimateria perfettamente bilanciato, è fatto di sola materia. Oltre ai protoni, grazie a LHC saranno fatti collidere tra loro anche nuclei di piombo. Nel caso di urti centrali piombo contro piombo – 82 protoni e 125 neutroni per parte – si creerà una densità di energia ben superiore alla massima sinora raggiunta in esperimenti simili, cui corrisponderà una temperatura oltre 100.000 volte superiore a quella del cuore del sole. C’è la convinzione che queste saranno finalmente le condizioni adatte alla formazione di un nuovo stato della materia, il plasma di quark e gluoni, uno stato della materia assente nell’Universo conosciuto ma dallo stesso assunto, per un attimo, un milionesimo di secondo dopo la sua nascita.

Il CERN, l’INFN e l’LHC

Fu poco più di 50 anni fa che un gruppo di governi europei, con l’Italia in prima linea, fondò il CERN, il Consiglio europeo per la ricerca nucleare: una casa comune dedicata alla scienza fondamentale, aperta alla più ampia partecipazione. Oggi, con LHC, è definitivamente attuata la visione originale, che mirava a ristabilire la leadership europea nella fisica fondamentale.

La stretta collaborazione tra il centro di avanguardia, da una parte, e gli istituti scientifici e le università dei paesi membri, dall’altra, ha facilitato lo sviluppo di una comunità che va ben oltre i confini del laboratorio di Ginevra. Il caso dell’Italia è esemplare per la presenza dell’INFN, l’Istituto nazionale di fisica nucleare, che essendo fatto di sezioni universitarie e laboratori nazionali, costituisce l’intera comunità italiana di fisica delle particelle.

La partecipazione alle attività del CERN si è gradualmente estesa al di là dei confini dei paesi europei membri dell’organizzazione, e oggi, con LHC, il laboratorio è in pratica diventato mondiale.

Il grande anello di LHC è stato installato nel tunnel scavato per accogliere negli anni 1980 LEP (Large Electron-Positron collider). Il capostipite di questo tipo di acceleratore fu AdA, il primo anello di accumulazione di elettroni e positroni, ideato e costruito nei laboratori di Frascati dell’INFN, quasi 50 anni fa. AdA rappresenta l’idea più elegante di acceleratore: collidendo fra loro, un elettrone e un positrone, vale a dire un elettrone e la sua corrispondente particella di antimateria, possono annichilirsi, trasformandosi in uno stato di pura energia; questo a sua volta, in un attimo, può dar luogo a una qualunque altra coppia particella-antiparticella, purché l’energia disponibile sia sufficiente per crearne la massa, mimando così, su scala microscopica, la nascita della materia e dell’antimateria nell’Universo primordiale. Nel giro di pochi decenni, tutta una serie di discendenti di AdA segnò il progresso della fisica fondamentale, passando dai suoi pochi metri di circonferenza ai 27 km di LEP, la cui energia di annichilazione equivaleva a una massa circa 100 volte maggiore di quella di un protone.

Come mai, in un’epoca in cui tutto è sempre più piccolo, non si riescono a raggiungere energie elevate con anelli, in qualche modo, compatti? La ragione è che quando una particella elettricamente carica è costretta – per esempio da un campo magnetico – a curvare, essa perde energia emettendo luce: tanta di più, quanto più è grande la sua energia, o piccola la sua massa, o stretta la curva (quella luce, peraltro, è un prezioso strumento d’indagine). Nel caso di LHC, possono circolare, nello stesso tunnel, protoni con energia 70 volte maggiore di quella degli elettroni di LEP, con irraggiamento del tutto trascurabile, dato che la massa del protone è quasi 2000 volte quella dell’elettrone. La fortuna di LHC deriva, in effetti, proprio dal tunnel di LEP, anche per il motivo seguente. Negli Stati Uniti negli anni 1980 fu lanciato il progetto SSC (Superconducting Super Collider) per collisioni protone-protone a energie tanto elevate da richiedere un tunnel di ben 80 km di circonferenza, che fu effettivamente scavato nel Texas. Il progetto però naufragò dopo il lancio di LHC, concepito per essere installato nell’esistente tunnel di LEP, con energia di collisione certamente inferiore a quella di SSC, ma con luminosità – il parametro che dà una misura della frequenza degli urti – tanto più elevata da garantire analogo potenziale di scoperta.

Le collisioni tra protoni o nuclei di piombo

Per produrre i fasci di protoni di LHC si parte da atomi d’idrogeno, ciascuno dei quali è costituito da un protone e un elettrone. Strappando gli elettroni, rimangono i protoni, che sono gradualmente accelerati fino a un’energia adatta all’iniezione nel grande collider. È tradizione dei laboratori di acceleratori usare le proprie vecchie macchine, rimesse a nuovo, per realizzare il complesso d’iniezione dell’ultimo arrivato. Così per alimentare LHC, dopo una fase di accelerazione preliminare, c’è il protosincrotrone, il primo acceleratore costruito al CERN, seguito dal suo successore, il superprotosincrotrone.

I due fasci di protoni di LHC, una volta accumulati nella sua doppia ciambella sotto vuoto, sono accelerati all’energia massima e, finalmente, sono portati a collidere, cosa che continuano a fare per ore e ore con buona luminosità; poi si ricomincia tutto daccapo (da notare che nel tempo libero tra un’iniezione e l’altra, il fascio di protoni dal superprotosincrotrone è deviato in direzione del Gran Sasso, per trarne uno di neutrini che, dopo un volo sotterraneo di 700 km, investe i rivelatori del laboratorio abruzzese). Il funzionamento di LHC è governato da un’infinità di dispositivi, d’impressionante complessità. Sono oltre 8000 i magneti necessari per definire la traiettoria e controllare la geometria dei fasci; questi, per esempio, nelle zone di collisione dove sono installati i rivelatori, sono compressi fin quasi a un centesimo di millimetro e portati a collidere con microscopica precisione. I campi elettrici oscillanti all’interno di 16 cavità superconduttrici restituiscono invece ai protoni l’energia che essi perdono continuamente per irraggiamento a ogni curva o per altre cause.

Al vertice dell’impresa tecnologica spicca l’imponente complesso dei magneti curvanti: oltre 1200, ognuno lungo 15 m, così che insieme arrivano a coprire ben 18 km dei 27 dell’anello. Essi sono realizzati in tecnologia superconduttrice; la corrente che li alimenta scorre, infatti, in un cavo conduttore di una speciale lega di niobio-titanio che, alla bassissima temperatura stabilita da un bagno in elio liquido, solo un paio di gradi kelvin sopra lo zero assoluto, non offre resistenza alcuna al passaggio di corrente. Non costa perciò nulla far fluire, in ciascun magnete, per un tempo indefinito, la corrente di 12.000 ampere che genera il campo di oltre 8 tesla, necessario a tenere i protoni sulla traiettoria circolare. Per fare di LHC un collider a nuclei di piombo, si parte da vapori del metallo, sottoponendo i suoi atomi alla graduale completa sottrazione dei rispettivi 82 elettroni, così che alla fine rimangono solo i nuclei, che contengono altrettanti protoni, ciascuno dei quali subisce l’azione dei campi acceleranti. L’energia totale raggiunta in una collisione piombo-piombo è, in pratica, 82 volte quella del caso protone-protone; questa è a sua volta pari a 14.000 miliardi di elettronvolt, equivalente alla massa di circa 14.000 protoni. Naturalmente, sulla scala della nostra comune esperienza, tali energie sono del tutto trascurabili. Non è affatto trascurabile, invece, l’energia complessiva di un fascio, specialmente quello di protoni, costituito da ben 300.000 miliardi di protoni: la sua energia è pari a quella di un Eurostar lanciato a piena velocità. A evitare i guai che possono combinare i protoni di un fascio in caso di uscita dal binario magnetico, lungo tutto l’anello ci sono sensori pronti, al primo segno d’instabilità, a dirottarli contro un imponente blocco di materiale capace di assorbirne senza danno l’energia, il tutto in una frazione di millesimo di secondo.

Una quantità di energia ancora più sorprendente è nascosta nel campo dei freddissimi magneti curvanti: restando nell’analogia ferroviaria, gli Eurostar a piena velocità stavolta sono 30. Si nota innanzitutto che tale energia va spesa solo all’atto dell’attivazione della corrente nei magneti. Inoltre non si può escludere che lo stato superconduttore s’interrompa accidentalmente; per tale eventualità, ciascun magnete ha accanto a sé un circuito passivo di normale conduttore, sul quale la corrente è facilmente dirottata se necessario, per dissiparne l’energia in calore.

Lo sviluppo del cavo superconduttore e la costruzione dei magneti curvanti di LHC hanno costituito un’impresa tecnologica di straordinario valore, durata quasi 20 anni, cui hanno partecipato l’INFN e numerose industrie italiane. In particolare, l’Ansaldo di Genova ha costruito circa un terzo dei magneti.

Le immagini delle collisioni

Nel caso più semplice, un rivelatore di particelle ne segnala il passaggio in un certo luogo a un certo istante: si pensi al ticchettio di un contatore Geiger. In generale, un rivelatore può essere complesso e strutturato fino a fornire un’immagine accurata della traiettoria di più particelle, a identificarne i tipi e a misurarne le quantità di moto.

Una particella carica, attraversando un rivelatore, lascia una scia di elettroni, strappati qua e là agli atomi del suo materiale sensibile. A essere rivelata è proprio tale sottile traccia di elettroni, che ricalca fedelmente la traiettoria della particella. I rivelatori moderni funzionano secondo processi elettronici, i cui segnali sono variamente elaborati e infine registrati mediante calcolatore, con estrema rapidità. Non sorprende che il rivelatore più preciso, veloce e compatto sia fatto di silicio, vale a dire della stessa materia e tecnologia della microelettronica oggi tanto diffusa.

I quattro rivelatori di LHC sono apparati impressionanti: grossi come palazzi e, allo stesso tempo, capaci di rendere visibile la miriade di tracce che si sprigionano dalle collisioni con precisione incredibile, di centesimi di millimetro.

Due rivelatori, Atlas e CMS, hanno il compito di osservare e studiare tutto quanto è prodotto a LHC, innanzitutto per cercare il bosone di Higgs. I due apparati abbracciano ciascuno la propria zona dove i protoni collidono al ritmo di quasi un miliardo di volte ogni secondo, irraggiando ogni volta fino a un centinaio di particelle in tutte le direzioni. Tra queste, ogni tanto – si prevede solo una volta ogni 10 miliardi di collisioni – potrebbe nascondersi un Higgs, che in realtà è per sua natura instabile e si disintegra immediatamente in altre particelle. L’impresa è allora districare la figura di frammentazione dell’Higgs dal groviglio di tracce create nella stessa collisione. E questo spiega perché i due apparati devono essere capaci di registrare a un ritmo vertiginoso le immagini complete e accurate dei prodotti di collisione. Le due rispettive squadre di ricercatori e tecnici hanno ciascuna sviluppato tecniche ingegnose, diverse fra loro, in un’atmosfera di stimolante competizione, che in pratica è la migliore garanzia di successo del progetto LHC.

Atlas e CMS impiegano entrambi rivelatori al silicio nel dispositivo tracciante centrale, che si spinge fino a qualche centimetro dalla linea di collisione, per il buon motivo che solo quelli al silicio hanno, oltre alla precisione e alla rapidità, anche la resistenza per fronteggiare l’infernale flusso di particelle a ridosso degli urti protone-protone.

L’immaginazione dei fisici ha potuto maggiormente sbizzarrirsi nell’ideare i rivelatori dei gusci più esterni: il calorimetro elettromagnetico, il calorimetro adronico e, infine, il tracciatore di muoni, le particelle cariche più penetranti. Per esempio, il calorimetro elettromagnetico di Atlas rivela gli elettroni di ionizzazione prodotti da sciami elettromagnetici nell’argon liquido che riempie una struttura a fogli di piombo; in CMS, invece, il calorimetro è costituito da 80.000 pesantissimi cristalli di tungstato di piombo, nei quali la ionizzazione è accompagnata da un debole bagliore di luce, segnalato a sua volta da sensori al silicio. Entrambi gli apparati impiegano magneti per curvare la traiettoria delle particelle cariche, fornendo così una chiave per la loro identificazione; e proprio la scelta dei rispettivi magneti caratterizza i due esperimenti.

Il Compact Muon Solenoid, vale a dire CMS, impiega un solenoide, che però è compatto per modo di dire, essendo lungo 12 m e largo 6 m. La corrente dell’avvolgimento superconduttore genera un campo magnetico di 4 tesla; stavolta, per dare un’idea dell’intensità del campo, diciamo che la pressione che esso esercita sull’avvolgimento cilindrico è 600 tonnellate al metro quadro. A Toroidal Lhc Apparatus, in altre parole Atlas, usa invece un magnete di forma toroidale, a ciambella: 8 spire superconduttrici, con le dimensioni di un palazzo di sette piani, piene di rivelatori che tracciano le traiettorie curve dei muoni con accuratezze di centesimi di millimetro. Lo studio della violazione della simmetria materia-antimateria è affidato all’apparato LHCb (Large Hadron Collider beauty). La luminosità di LHC, imposta dalla caccia all’Higgs, è talmente elevata che solo un suo centesimo basterà per registrare una straordinaria collezione di decadimenti di mesoni b – particelle fatte di un quark e un antiquark, di cui uno di tipo beauty – che violano la simmetria detta. Il ricco campione di eventi e le raffinate tecniche di misura dell’esperimento promettono uno studio di precisione del fenomeno, che metterà a dura prova le previsioni del Modello Standard.

L’apparato dedicato allo studio delle collisioni piombo-piombo è Alice (A Large Ion Collider Experiment). Dal miscuglio di quark e gluoni che si viene a formare in uno scontro frontale, di energia totale equivalente alla massa di oltre un milione di protoni, si sprigionano decine di migliaia di particelle, di tutti i tipi, che danno luogo a spettacolari immagini di fuochi d’artificio. La sfida in questo caso è non solo disegnare la miriade di traiettorie, ma anche identificare tutte o quasi le particelle che le tracciano, impiegando le tecniche più raffinate, per giungere a cogliere le proprietà del microscopico campione di plasma di quark e gluoni. Sono circa 6000 i ricercatori complessivamente impegnati nei quattro esperimenti. I gruppi italiani dell’INFN costituiscono una presenza tra le più nutrite e i loro contributi emergono ben visibili, frutto anche dell’impegno dell’industria italiana.

Dopo il web, la Grid

LHC produrrà una tale massa di dati da riempire 100.000 DVD l’anno, a disposizione dei suoi ricercatori, sparsi in tutto il mondo. Oggi è fin troppo facile con il web scambiare testi, immagini e musica in rete. Fu proprio al CERN, ai tempi del LEP, meno di 20 anni fa, che il www cominciò a essere battuto su una tastiera. Dopo la sua inaspettata e folgorante diffusione a livello planetario, a più d’uno, al CERN, venne il dubbio che fosse stato un errore non brevettarlo. In realtà, se qualcuno avesse tentato di farlo, il web non sarebbe nato, perché esso fu il frutto della visione di una comunità di ricerca, quella del LEP, che operò in una situazione di trasparente competizione. Il giusto rammarico è, se mai, di non aver lasciato traccia della paternità nel nome, nemmeno un quark o un leptone.

L’imponente mole di dati in arrivo da LHC ha stimolato un nuovo passo avanti da parte della sua comunità informatica, pronta a bissare il successo del web con la Grid. La nuova idea, nata negli Stati Uniti quasi dieci anni fa, ha finalmente trovato in LHC l’ambiente adatto per svilupparsi e in pochi anni si è concretizzata e diffusa in Europa. La Grid punta a rendere disponibili in rete nuovi servizi software, che permettano l’utilizzo facile e sicuro delle enormi potenze di centinaia di centri di calcolo dislocati in tutto il mondo, per l’elaborazione delle imponenti quantità di dati prodotti da LHC. Non c’è voluto molto per pensare al coinvolgimento di altri settori scientifici e oggi sono numerose le comunità già attratte dalla Grid. Niente brevetti, certo, ma questa volta gli Europei vogliono avere la sicurezza di essere in prima linea, non solo nello sviluppo ma anche nello sfruttamento di questa tecnologia. È così nato EGEE, il programma Enabling Grid for E-sciencE, una serie di progetti finanziati dalla Commissione Europea, che si avvale di ricercatori e ingegneri da centinaia di istituzioni e industrie di 50 paesi.

Oggi EGEE mette a disposizione 50.000 unità di calcolo, 24 ore al giorno, 7 giorni alla settimana – oltre a 15 milioni di gigabyte di capacità di archiviazione dati, ed è così in grado di soddisfare simultaneamente migliaia di utenti, appartenenti alle più svariate discipline, dalla biologia alla chimica computazionale, dall’astrofisica allo spazio. Sotto l’impulso di EGEE, decine di progetti europei e nazionali stanno diffondendo l’uso della Grid, sia verso nuovi paesi sia verso nuove comunità scientifiche. La Grid sta cambiando il modo di fare ricerca e sta prefigurando nuovi metodi di collaborazione, per la società intera, su scala planetaria. La comunità dei ricercatori italiani dell’INFN, con al centro il CNAF (Centro nazionale di tecnologie informatiche e telematiche) di Bologna, è tra i suoi maggiori artefici.

Il grande momento degli acceleratori

Sotto lo stimolo degli sviluppi della fisica subatomica, le applicazioni degli acceleratori ad altri campi di ricerca stanno oggi vivendo una vera e propria età dell’oro. Sta per entrare in funzione a Pavia il CNAO (Centro nazionale di adroterapia oncologica), che impiegherà per la cura dei tumori un acceleratore di nuclei di carbonio. Un fascio di particelle può essere un’arma particolarmente efficace contro i tumori profondi, difficilmente operabili. Per le diverse modalità di perdita di energia nella materia attraversata, il fascio di nuclei di carbonio, rispetto ad altri tipi di radiazione, ha il vantaggio di concentrare meglio sul tumore il danno, a vantaggio del tessuto sano circostante. L’efficacia della terapia è stata dimostrata da migliaia di trattamenti, in oltre dieci anni di attività, all’Heavy Ion Medical Accelerator di Chiba in Giappone. Su scala ridotta, da molti anni a Catania, nei Laboratori del Sud dell’INFN, il fascio di protoni del ciclotrone superconduttore è impiegato per la cura di tumori dell’occhio.

Altro campo d’impiego degli acceleratori, di elettroni in questo caso, riguarda la produzione di luce. Le sorgenti di luce ad anello di elettroni, variamente curvati da magneti, sono ormai giunte alla terza generazione. La luce così irraggiata è molto intensa, a largo spettro e polarizzata. L’elettrosincrotrone di Frascati è stata la prima sorgente italiana del genere, negli anni 1960.

Lo sviluppo in anni recenti dei collider elettrone-positrone lineari, dunque senza curve, ha portato in ogni caso allo sviluppo di un nuovo tipo di sorgente di luce: un laser a elettroni liberi, caratterizzato non solo da elevatissima intensità nella regione dei raggi X, ma soprattutto da una straordinaria definizione temporale, fino a un milionesimo di miliardesimo di secondo. La prospettiva è, in breve, quella di realizzare un microscopio a raggi X, capace di offrire immagini istantanee di nanostrutture.

Il progetto europeo X-FEL è in costruzione ad Amburgo, mentre l’analogo dispositivo SparX è in fase di sviluppo a Roma, all’Università di Tor Vergata, per opera dell’INFN e altri enti.

Conclusioni

La costruzione di LHC ha richiesto uno sforzo intenso, durato 20 anni. Ora si è finalmente aperta la fase di esplorazione del suo immenso territorio di scoperta, che durerà almeno altrettanti anni o forse più, se si pensa alle possibilità di potenziamento della macchina e dei rivelatori. La prima modifica, già in agenda, riguarda l’innalzamento della luminosità. Più ambiziosa e impegnativa è invece l’idea di aumentare l’energia, che significa sviluppare magneti curvanti a campo doppio, per esempio, di quello attuale, che già è stato il frutto di una grande impresa. È, d’altra parte, da tempo opinione diffusa a livello internazionale che il successore di LHC debba essere un collider elettrone-positrone, di energia ben superiore a quella del LEP, rettilineo dunque non circolare, a evitare un insostenibile irraggiamento. Una vasta comunità internazionale è da anni impegnata nella ricerca e sviluppo dell’ILC (International Linear Collider). Decisive, per capire quale direzione intraprendere, saranno le scoperte di LHC. I quattro esperimenti – Atlas, CMS, LHCb e Alice – sono stati pensati e costruiti per scoprire la particella di Higgs oppure la supersimmetria o il plasma di quark e gluoni. La speranza è però che essi scoprano qualcosa mai concepita o sognata. In tal senso, la scienza è un po’ come l’arte; Picasso, per esempio, ebbe a dire: «Io non cerco, trovo».

Repertorio

Gli acceleratori di particelle

di Roberto Sagnotti

Un acceleratore di particelle è un dispositivo che imprime elevate energie cinetiche a particelle subatomiche cariche (ioni, elettroni, protoni ecc.). Le particelle vengono accelerate facendo uso di campi elettrici e magnetici: i campi elettrici forniscono l’energia necessaria all’accelerazione, mentre i campi magnetici curvano le traiettorie. Convenienti accorgimenti permettono di collimare i fasci. Le particelle così accelerate sono generalmente inviate contro un opportuno bersaglio, o vengono fatte collidere tra loro, per produrre nuove particelle al fine di esplorare la struttura della materia e dei suoi costituenti. Questo tipo di indagini fu inizialmente condotto utilizzando particelle veloci naturali, come quelle emesse da sostanze radioattive o quelle costituenti la radiazione cosmica; a partire dagli anni 1930 si è fatto sempre più ricorso agli acceleratori per ottenere fasci intensi ben collimati, sensibilmente monocromatici, di elevatissima energia, variabile con continuità.

L’evoluzione degli acceleratori

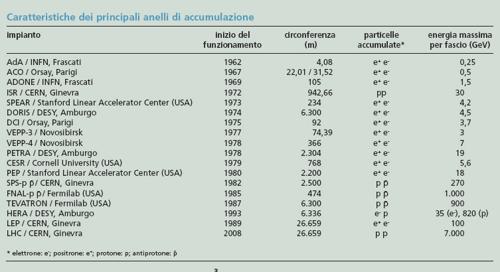

I primi acceleratori sono stati gli acceleratori elettrostatici (o a caduta di potenziale), che usavano campi elettrici statici per accelerare ioni tra differenze di potenziale comprese tra 10 e 20 MV (milioni di volt). Nel 1931 Robert Jemison Van de Graaff, dopo numerosi esperimenti iniziati nel 1929 presso la Princeton University, perfezionò il primo acceleratore di questo tipo (generatore di Van de Graaff), capace di produrre una differenza di potenziale di 1.000.000 di volt. Nel 1932 John D. Cockcroft ed Ernest T.S. Walton realizzarono il modello che fu utilizzato per i primi studi sulla fissione nucleare in laboratorio (disintegrazione nucleare mediante protoni che, accelerati artificialmente, colpivano nuclei di litio e boro). Gli acceleratori lineari (LINAC, Linear Accelerators), che utilizzavano campi elettrici alternati, consentirono di raggiungere energie molto maggiori. Fu Rolf Wideröe, nel 1928, a darne il primo esempio nella sua tesi di laurea. Il passo successivo fu la realizzazione del ciclotrone, nel quale le particelle erano vincolate su traiettorie curve, circolari: il primo fu ideato (1930) e realizzato (1931) da Ernest Orlando Lawrence e forniva protoni di 80 keV. I ciclotroni, progettati inizialmente per accelerare ioni e protoni, risultarono meno efficaci per l’accelerazione di elettroni a causa delle loro perdite radiative. Una nuova macchina, detta betatrone, dal nome originario degli elettroni, ‘raggi beta’, fu per la prima volta realizzata da Donald W. Kerst nei laboratori della General Electric Company a New York, che la chiamò dapprima reotrone. Il betatrone utilizza, per l’accelerazione degli elettroni, campi magnetici variabili nel tempo, in grado di produrre campi elettrici per induzione elettromagnetica. Una macchina costruttivamente simile al ciclotrone, ma in grado di accelerare le particelle cariche pesanti (protoni, deutoni, particelle a) a energie ancora più elevate, sino a qualche centinaio di MeV, fu il sincrociclotrone, il cui principio di funzionamento fu enunciato nel 1945 dal sovietico Vladimir I. Veksler e dallo statunitense Edwin M. McMillan. Dopo la Seconda guerra mondiale, le energie raggiungibili dagli acceleratori furono notevolmente incrementate grazie ad apparati sperimentali sofisticati che consentirono ricerche sempre più proficue. Ciò portò, negli anni 1950, a perfezionare un nuovo tipo di macchina, il sincrotrone, che era stata ideata dagli stessi Veksler e McMillan sempre nel 1945. Il sincrotrone è ancora alla base dei moderni acceleratori circolari e degli anelli di accumulazione, strumento imprescindibile per la ricerca nella fisica delle alte energie e la sincronizzazione dei campi variabili nel tempo con il passaggio dei fasci di particelle. Nel corso degli anni 1970 si realizzarono sincrotroni con energie sempre più elevate, perché si comprese che bombardando con le particelle accelerate particelle ferme si ottengono informazioni, sempre più dettagliate al crescere dell’energia, sulla struttura sia delle particelle che costituiscono il bersaglio sia di quelle usate come proiettili; inoltre, al valore dell’energia è legata la possibilità di produrre particelle e stati risonanti con masse via via maggiori. La limitazione di principio nella sperimentazione con i sincrotroni era legata al fatto che nell’urto di particelle relativistiche contro particelle bersaglio ferme il rapporto tra l’energia totale disponibile per la creazione di nuove particelle (corrispondente a quella nel sistema di riferimento del centro di massa) e l’energia della particella proiettile decresce come l’inverso della radice quadrata di questa. Tale limitazione è stata superata grazie alla realizzazione degli anelli di accumulazione, macchine strutturalmente simili ai sincrotroni, nelle quali si realizza la collisione ‘frontale’ di due fasci di particelle. Dal 1980 la ricerca sperimentale svolta nei diversi laboratori ha consentito di costruire anelli di accumulazione con un notevole incremento di energia.

Lo studio di nuove tecniche di accelerazione è continuato, stimolato soprattutto dalle esigenze della ricerca fondamentale avanzata (in termini di energie massime, intensità e qualità dei fasci) e dalla necessità di ridurre i costi a parità di prestazioni. I risultati hanno riguardato l’aumento dei valori dei campi elettrici acceleranti e magnetici di guida (nelle macchine circolari), per ridurre le dimensioni dell’acceleratore, così come il miglioramento dell’efficienza globale di trasferimento di energia dalla macchina al fascio (nelle macchine lineari), al fine di ridurre i costi legati alla lunghezza e al consumo energetico dell’acceleratore.

Tipi di acceleratore

Acceleratori lineari (LINAC). In essi le particelle vengono accelerate lungo traiettorie rettilinee da campi elettrici variabili nel tempo. Gli elettrodi acceleratori hanno forma di cilindretti cavi, disposti uno di seguito all’altro tra la sorgente e il bersaglio; un generatore di tensione alternata mantiene una differenza di potenziale tra due elettrodi consecutivi. I vari elettrodi hanno lunghezza progressivamente crescente andando dalla sorgente verso il bersaglio, in modo che il moto delle particelle, accelerato nell’intervallo tra un elettrodo e l’altro, risulti in fase costante con le oscillazioni della tensione acceleratrice. Negli acceleratori lineari per elettroni il tubo a vuoto è dotato di setti forati equidistanti e costituisce una guida d’onda, nella quale viene prodotta un’onda elettromagnetica che ha una componente del campo elettrico nella direzione di propagazione; gli elettroni che vengono iniettati nel tubo acceleratore con la giusta fase e con velocità prossima a quella dell’onda sono catturati dall’onda e accelerati fino al termine del tubo. Un acceleratore lineare lungo 70 m, in grado di accelerare elettroni e positroni fino a circa 400 MeV, è installato presso i Laboratori nazionali di Frascati (Roma). A Stanford, in California, si trova il più grande LINAC oggi esistente: è lungo 3,2 km ed è in grado di accelerare elettroni fino a un’energia di 50 GeV: è stato progettato per far collidere due fasci di particelle, dopo che questi sono stati mantenuti per un certo tempo in anelli di accumulazione.

Ciclotrone. È un acceleratore di particelle cariche pesanti (protoni, particelle a ecc.). Il ciclotrone consiste di due scatole metalliche semicircolari a forma di D, contenute in un recipiente chiuso, nel quale si pratica il vuoto, tra i poli di un potente elettromagnete; al centro dell’intercapedine tra le due scatole si trova la sorgente di particelle. Un oscillatore mantiene tra i bordi affacciati delle scatole un campo elettrico oscillante ad alta frequenza (qualche MHz). Il protone emesso dalla sorgente si muove con velocità costante su una traiettoria circolare il cui raggio è proporzionale, a parità di altre condizioni, alla velocità del protone. Se la frequenza del campo elettrico è tale che il campo s’inverte nel tempo (indipendente dal raggio) che il protone impiega a descrivere una semicirconferenza all’interno di ciascuna scatola, esso, uscendo da una di esse, viene nuovamente accelerato dal campo, che ora è diretto verso l’altra. Continuando questo processo, la traiettoria risulta una ‘spirale’ di raggio crescente. Quando essa si è allargata tanto da giungere sulla periferia delle scatole, un campo elettrico prodotto da un elettrodo deflettore attrae il protone che, attraversata la parete della scatola, prosegue in linea retta con l’energia posseduta al momento dell’uscita dal ciclotrone. Tale energia risulta tanto maggiore – a parità di altri parametri - quanto più è grande l’elettromagnete. In realtà, un limite all’energia ottenibile è posto dall’aumento relativistico della massa con la velocità che determina uno sfasamento tra l’oscillazione del campo elettrico e il moto della particella. Lo sfasamento può essere corretto con due sistemi: o variando nel tempo la frequenza del campo acceleratore o dando al campo magnetico valori crescenti in senso radiale. Il primo metodo permette di raggiungere energie molto elevate, ma ha l’inconveniente che l’intensità del fascio delle particelle accelerate è bassa. Con il secondo metodo, in cui la frequenza del campo acceleratore viene mantenuta fissa, la variazione del campo magnetico in senso radiale produce una defocalizzazione degli ioni, che viene però compensata con una opportuna modulazione del campo magnetico stesso in senso azimutale, cioè nella direzione della velocità delle particelle; i ciclotroni di questo tipo richiedono particolari cure per la costruzione dei magneti, ma hanno il vantaggio di fornire intensi fasci di particelle a elevata energia e hanno una grande flessibilità di impiego per la possibilità di variare facilmente il valore dell’energia finale. Le energie massime ottenibili con i moderni ciclotroni per protoni vanno da qualche decina a qualche centinaio di MeV.

Betatrone. È una macchina acceleratrice in grado di portare gli elettroni a energie dell’ordine di quella delle particelle b‚ naturalmente emesse dalle sostanze radioattive. Il principio di funzionamento è il seguente: gli elettroni vengono fatti muovere lungo una traiettoria circolare concatenata con un campo magnetico variabile; a ogni giro ciascun elettrone subisce un incremento di energia pari al prodotto della sua carica per la forza elettromotrice che, in conseguenza della variazione del flusso di induzione magnetica, viene indotta nella spira costituita dall’orbita. Dato il grandissimo numero di giri che gli elettroni possono compiere in breve tempo, l’aumento di energia che ne consegue è notevole. Il campo magnetico generato dall’elettromagnete è variabile nel tempo e ha il duplice compito di creare nella parte centrale il flusso variabile necessario per accelerare gli elettroni e, nella parte periferica, di mantenerli su orbite circolari (ciò che si ottiene dando forma opportuna alle espansioni polari). Gli elettroni vengono iniettati nell’interno del tubo a vuoto mediante un cannone elettronico: l’iniezione avviene nell’istante in cui ha inizio la variazione di flusso nel campo magnetico. Gli elettroni, compiendo un grandissimo numero di giri, acquistano una velocità molto vicina a quella della luce. Sotto l’azione di una piccola perturbazione supplementare possono essere mandati a urtare una lamina metallica (bersaglio), che diviene sorgente di raggi X molto penetranti o di raggi c.

Sincrociclotrone. Nel sincrociclotrone, come nel ciclotrone, il campo magnetico è costante e il campo elettrico è periodico, però con frequenza variabile; ogni particella descrive una traiettoria a spirale: se la massa della particella rimanesse costante, anche il suo periodo di rivoluzione resterebbe costante ed è precisamente quanto si verifica finché la velocità della particella è abbastanza lontana dalla velocità della luce. Quando si raggiungono velocità non trascurabili rispetto a quella della luce, si comincia ad avere un sensibile aumento della massa e conseguentemente un aumento del periodo di rivoluzione: ne risulta uno sfasamento tra il moto di rivoluzione della particella e le oscillazioni del campo elettrico acceleratore. Ovvia a questo inconveniente un dispositivo regolatore inserito nell’oscillatore, che fa decrescere la frequenza della tensione acceleratrice in sincronia con l’aumento di massa della particella, cosicché man mano che il tempo di rivoluzione cresce, la frequenza decresce e non si manifesta lo sfasamento suddetto. Il flusso di particelle accelerate non può essere continuo nel tempo, come nel ciclotrone, in quanto un gruppo di esse deve essere accompagnato sincronicamente, dalla sorgente all’uscita della macchina, dalla quale poi è estratto, come nel ciclotrone, dal campo elettrico di un elettrodo deflettore; a questo punto la frequenza della tensione acceleratrice torna al valore iniziale e si inizia l’accelerazione di un altro gruppo di particelle. La durata tipica del processo è 1/50 di secondo: si hanno pertanto 50 gruppi di particelle accelerate ogni secondo. Tra i sincrociclotroni più potenti, vi sono quelli, per protoni, del CERN a Ginevra (600 MeV), di Dubna in Russia (680 MeV), dell’Università della California (720 MeV).

Sincrotrone. Sfrutta contemporaneamente il principio del sincrociclotrone, cioè della modulazione del campo elettrico accelerante, e del betatrone, cioè di una modulazione del campo magnetico curvante le traiettorie, per cui il funzionamento generale è impulsivo come nel sincrociclotrone, ma la traiettoria media delle particelle iniettate è sensibilmente circolare di raggio fisso. L’introduzione di un campo magnetico variabile in sincronismo con il moto delle particelle consente di mantenere le particelle sempre sulla stessa orbita circolare; poiché, a causa dell’accelerazione subita dalle particelle, questa orbita circolare viene descritta con velocità sempre più elevata, per mantenere il sincronismo tra il moto di rivoluzione delle particelle e le oscillazioni della tensione acceleratrice si rende necessario l’aumento progressivo della frequenza della tensione acceleratrice. In un sincrotrone la camera da vuoto, nella quale si muovono le particelle accelerate, si riduce a un anello cavo (ciambella) immerso nel campo magnetico generato da elettromagneti opportunamente disposti intorno all’anello, assai meno ingombranti e costosi di quelli che, a parità di raggio, sarebbero richiesti per un ciclotrone, un sincrociclotrone o un betatrone. Il sincrotrone può essere usato per l’accelerazione di elettroni (elettrosincrotrone), di protoni (protosincrotrone) e di particelle pesanti (sincrotrone per ioni), che vengono in esso iniettati dopo essere stati preventivamente accelerati da un acceleratore ausiliario (iniettore) e che sono poi ulteriormente accelerati da una o più cavità risonanti disposte lungo l’anello. Il ciclo di accelerazione di un sincrotrone ha durata che varia da alcuni millesimi di secondo nei piccoli elettrosincrotroni ad alcuni secondi nei grandi protosincrotroni. L’energia ottenuta con i sincrotroni è dell’ordine di 7,5 GeV per elettroni (DESY, Amburgo) e di 1000 GeV (1 TeV) per protoni (Tevatron, Fermi National Accelerator Laboratory di Batavia, presso Chicago). Gli elettrosincrotroni oggi sono quasi esclusivamente impiegati come iniettori per altri acceleratori, mentre i protosincrotroni, molto spesso modificati per accelerare anche ioni pesanti, sono utilizzati, oltre che come iniettori, per esperimenti su bersaglio fisso ovvero per produrre fasci primari (di protoni, di ioni pesanti) o secondari (di mesoni, di neutrini ecc.) intensi che vengono fatti interagire con bersagli fissi esterni alla macchina. Sincrotroni capaci di accelerare protoni sino a conferire loro energie particolarmente alte, dell’ordine delle centinaia di GeV, sono i superprotosincrotroni.

Collisori ad anello di accumulazione. Gli acceleratori fin qui presi in considerazione funzionano a bersaglio fisso e, di conseguenza, solo una parte dell’energia del fascio è effettivamente disponibile per la creazione di nuove particelle. La ricerca per far sì che tutta l’energia prodotta dall’acceleratore fosse disponibile ha portato alla realizzazione del collisore (o collider), che è la combinazione di uno o più anelli di accumulazione con un acceleratore circolare, nel quale due fasci di particelle vengono accelerati in senso opposto e fatti urtare frontalmente. Il risultato è che per particelle simili tutta l’energia viene a essere disponibile per gli urti e cresce quindi proporzionalmente all’energia dei fasci. I sistemi a bersaglio fisso sono invece assai meno efficienti, con un’energia effettivamente disponibile che cresce solamente come la radice quadrata dell’energia del fascio. D’altra parte, i collisori richiedono una molto maggiore precisione nella collimazione dei fasci per dar luogo a numeri elevati di collisioni, rispetto ai sistemi con bersaglio fisso. Fu Bruno Touschek, intorno al 1960, a ideare gli anelli di collisione per particelle con carica elettrica opposta (per es. elettroni-positroni o protoni-antiprotoni), strutturalmente simili a un sincrotrone, ma diversi per il fatto che in essi vengono accelerati contemporaneamente i due fasci di particelle circolanti in verso opposto. Il primo anello di accumulazione (AdA) fu realizzato nei laboratori dell’INFN di Frascati. Gli anelli di accumulazione a fasci collidenti costituiscono dunque una macchina acceleratrice dove, nell’interazione tra particelle, l’energia massima disponibile per creare nuove particelle è l’energia totale nel sistema di riferimento del centro di massa. Con il passare degli anni, a causa dei grandi risultati ottenuti nella sperimentazione con gli acceleratori (studio delle particelle J/U e Y, della struttura a jet, scoperta del leptone t e di numerose nuove particelle ecc.), sono stati realizzati anelli di collisione con energie sempre più elevate (tab.). In particolare, presso i laboratori del CERN intorno al 1980 è stato risolto il problema di accumulare un numero convenientemente elevato di antiprotoni, impiegando il superprotosincrotrone come anello di collisione per protoni e antiprotoni; con questo sono stati scoperti i bosoni vettoriali intermedi, mediatori delle interazioni deboli. Sempre presso i laboratori del CERN, nel 1989 è entrato in funzione il LEP (Large Electron-Positron collider), grande anello di collisione per elettroni e positroni, in grado di raggiungere l’energia di 100 GeV per fascio mediante l’impiego di un sistema di accelerazione superconduttivo (costituito da cavità risonanti): con questo acceleratore è stata misurata con grande precisione la ‘larghezza’ della particella Z e si è conseguentemente accertato che vi sono tre famiglie di particelle elementari. Il programma sperimentale del LEP si è concluso nel novembre 2000, quando nel tunnel lungo 27 km in cui era alloggiato è iniziato il montaggio del nuovo anello di collisione per protoni LHC. Una nuova classe di anelli per elettroni è costituita dalle cosiddette fabbriche di mesoni (meson factories). Si tratta di anelli di energia opportunamente scelta per la produzione, con elevatissimo tasso e in condizioni di basso fondo, di particolari coppie mesone-antimesone. In Italia è stata realizzata la fabbrica DAFNE di mesoni z (e quindi di coppie di mesoni K e anti-K) presso i Laboratori nazionali di Frascati dell’INFN, consistente di due distinti anelli da 0,5 GeV ciascuno, uno per e+ e uno per e-, che si intersecano in due punti nei quali avvengono le collisioni.

Applicazioni

Per quanto riguarda i principali campi di applicazione degli acceleratori, questi hanno un notevole potenziale nell’ambito delle tecniche di produzione dell’energia: in particolare, fasci di protoni e di ioni pesanti (dallo xeno al piombo) derivati da acceleratori di particelle pesanti (sincrotroni e acceleratori lineari), per le loro potenze medie e di picco, per efficienza, affidabilità, durata e perfetta controllabilità, sono naturali candidati per pilotare reattori a fissione sottocritici e quindi intrinsecamente sicuri o a fusione con confinamento inerziale.

In area medica, la medicina nucleare e l’oncologia sono campi applicativi di notevole interesse: ciclotroni e sincrotroni si sono dimostrati molto efficaci per produrre fasci di adroni (più specificamente protoni o ioni di atomi leggeri, quali il carbonio), utilizzati nell’adroterapia – proposta da Robert Wilson nel 1946 e sperimentata negli anni 1990 – per la cura dei tumori. I protoni e gli ioni hanno una ben definita distanza di penetrazione nei tessuti, che è funzione della loro energia, accompagnata da un marcato incremento della ionizzazione specifica (e quindi dell’efficacia antitumorale) in prossimità del punto di arresto. Ciò permette di raggiungere e colpire la massa tumorale, lasciando relativamente indenni i tessuti circostanti. Anche i betatroni vengono utilizzati in campo medico grazie ai raggi X ultrapenetranti che sono in grado di generare (betatronoterapia) e che sono indicati nella cura di tumori maligni profondi.

La radiologia e la strumentazione chirurgica (laser a elettroni liberi) sono campi di ulteriori applicazioni legate agli acceleratori, con significativi progressi nel campo delle tecniche angiografiche e radiografiche che utilizzano la radiazione di sincrotrone.

In area industriale, le applicazioni più comuni sono la saldatura, la sterilizzazione di cibi, di materiali medici e di fanghi, la modificazione delle proprietà chimico-fisiche di materie plastiche, l’impiantazione ionica.

Luce di sincrotrone

La luce o radiazione di sincrotrone è l’emissione di radiazione elettromagnetica da parte di una particella carica accelerata all’interno del sincrotrone, enormemente maggiore nel caso degli elettroni a causa della loro piccola massa. Dagli anni 1960 si sono rapidamente moltiplicate in tutto il mondo le iniziative per l’utilizzazione in fisica e in biologia degli intensi flussi di fotoni dovuti a tale radiazione. L’impatto della luce di sincrotrone sulla ricerca nei campi della fisica, chimica, biologia e sulla scienza dei materiali è così divenuto considerevole: l’interazione di questa radiazione con la materia presenta aspetti molteplici legati alla grande varietà di sistemi che si possono studiare a causa dell’ampio intervallo spettrale coperto dalla sorgente. Dall’uso ‘parassitico’ di elettrosincrotroni e anelli di accumulazione costruiti per lo studio delle particelle elementari, si è passati, negli anni 1980, allo sviluppo di anelli di accumulazione per elettroni dedicati alla luce di sincrotrone, dotati di dispositivi che permettono di variare le caratteristiche del fascio fotonico emesso. Da allora il numero di anelli di accumulazione per elettroni dedicati alla produzione di radiazione di sincrotrone ha registrato una continua crescita in tutto il mondo. Si realizzano sia anelli per ricerca con prestazioni sempre più elevate in termini di intensità, brillanza e struttura temporale, sia macchine dalle caratteristiche studiate appositamente per determinate applicazioni, per lo più di tipo industriale (caratterizzazione di prodotti, micromeccanica ecc.). I campi di ricerca sono molto vari e vanno dalla struttura della materia alla chimica e alle scienze biologiche. Il parametro di qualità più importante, anche se non l’unico, per gli esperimenti scientifici di punta è la brillanza che caratterizza globalmente la qualità del fascio di fotoni. La massima brillanza teoricamente ottenibile è limitata dalla diffrazione e cresce quindi al diminuire della lunghezza d’onda utilizzata. Le sorgenti a più alta brillanza non si realizzano con i magneti curvanti della macchina acceleratrice, ma con elementi magnetici speciali (ondulatori) disposti in appositi tratti rettilinei posti lungo l’anello. La massima efficienza di un anello di accumulazione per la produzione di luce di sincrotrone si ottiene quando l’energia di funzionamento dell’anello stesso è fissa e l’iniezione degli elettroni avviene già a questa energia. L’energia di lavoro della macchina dipende, d’altronde, dall’intervallo di energie fotoniche nel quale si desiderano ottimizzare le prestazioni, cosicché occorrono macchine con energie di lavoro diverse per coprire con la massima efficienza l’intervallo di lunghezze d’onda di interesse, fra il visibile e i raggi X duri. Fra le macchine in funzione in Europa si può menzionare quella da 6 GeV dell’ESRF (European Synchrotron Radiation Facility), a Grenoble, nel laboratorio finanziato e gestito da un’associazione di tutti i paesi dell’Unione Europea. L’anello è ottimizzato per la produzione di radiazione X dura (lunghezze d’onda comprese tra circa 10-1 e 10-2 nm); può ospitare più di 100 stazioni sperimentali e produce fasci da ondulatore a elevatissima brillanza. In Italia è in funzione a Trieste ELETTRA, anello da 2 GeV, ottimizzato per l’intervallo tra circa 1 e 10-1 nm, che può ospitare oltre 40 stazioni sperimentali. Brillanze ancora più elevate si possono ottenere con laser a elettroni liberi sempre più spesso realizzati accanto agli anelli per elettroni o come parte di essi. I laser a elettroni liberi, essendo accordabili e potenzialmente in grado di coprire ampi intervalli di lunghezze d’onda con brillanze elevatissime, si sono rapidamente diffusi come sorgenti di radiazione di sincrotrone. Nell’intervallo spettrale che va dalle onde millimetriche al visibile sono operanti diverse installazioni per la ricerca fondamentale e applicata, tra cui, in Europa, quelle di Amsterdam, Orsay e Frascati; a Trieste è installato anche un laser a elettroni liberi che opera nell’ultravioletto con lunghezze d’onda fino a 190 nm. È stata inoltre avviata un’intensa attività su impianti di tipo applicativo destinati all’industria (principalmente per il trattamento dei materiali) e alla medicina (soprattutto per la chirurgia). Poiché le prestazioni di un laser a elettroni liberi dipendono essenzialmente dalla potenza e dalla qualità del fascio elettronico primario (che deve essere tanto migliore quanto minore è la lunghezza d’onda desiderata), si è avviato lo studio di vari metodi per ottenere fasci elettronici con caratteristiche adeguate. La grande maggioranza dei laser a elettroni liberi in funzione è pilotata da acceleratori lineari elettrodinamici o anche elettrostatici; i candidati naturali alla produzione di fasci elettronici per laser a elettroni liberi con lunghezza d’onda ultracorta sono gli acceleratori lineari superconduttivi, che permettono di raggiungere la qualità di fascio e la potenza desiderate.