Energia

Energia

L’energia si identifica con la capacità di compiere il lavoro richiesto per modificare lo stato di un sistema fisico. Esistono diverse forme di energia che traggono origine da particolari campi di forza, quali il campo gravitazionale, quello elettromagnetico e i campi relativi alle forze che si manifestano nelle interazioni tra le particelle elementari e intervengono quindi negli eventi nucleari e cosmici. Ciascun campo di forze possiede due forme di energia, chiamate rispettivamente cinetica, associata al moto, e potenziale, associata alla posizione delle entità interagenti. Un’importante forma di energia cinetica è quella termica derivante dai moti caotici delle molecole. L’energia chimica, che tiene uniti gli atomi nelle molecole, costituisce una manifestazione delle forze elettromagnetiche ed è quella che interviene in maggior misura nelle attività umane, pur essendo presente in modo trascurabile nell’Universo.

Le diverse forme di energia sono reciprocamente intercambiabili in accordo a un principio fondamentale di conservazione. Ciascuna di esse è caratterizzata da un indice di qualità associato al valore della funzione termodinamica entropia, che a sua volta misura il grado di disordine di un sistema. La forma qualitativamente più pregiata di energia è quella a entropia più bassa e al primo posto si pone l’energia gravitazionale, seguita rispettivamente da quella nucleare, da quella elettromagnetica e quindi dalla termica. Nelle trasformazioni naturali l’energia fluisce spontaneamente nella direzione in cui ha luogo un aumento di entropia, con un continuo degrado della sua qualità.

L’energia interviene in quasi tutte le attività umane; dalla sua disponibilità dipende la possibilità di fronteggiare diverse situazioni critiche riguardanti lo sviluppo economico, l’approvvigionamento di acqua, l’alimentazione e la tutela dell’ambiente. Esiste pertanto una diffusa consapevolezza che la soluzione dei problemi concernenti l’approvvigionamento di energia giocherà un ruolo determinante sul futuro del nostro pianeta.

Tra le diverse sorgenti di energia attualmente impiegate nel mondo quelle fossili sono predominanti (gas naturale, petrolio, carbone), poiché il loro basso costo ha limitato il decollo delle altre fonti. Le moderne economie industriali sono basate sul carbonio e il principale processo di produzione dell’energia è la combustione delle sostanze fossili contenenti carbonio, con formazione di acqua e anidride carbonica, il cui studio ha contribuito a migliorare in modo significativo l’efficienza e la conduzione delle corrispondenti tecnologie. In realtà gli idrocarburi costituiscono anche la materia prima per la preparazione di diversi prodotti di ampio impiego, primi fra tutti i materiali polimerici, per cui circa il 4% del petrolio viene utilizzato per tali finalità. Poiché ogni anno vengono estratti 30 miliardi di barili di petrolio risulta legittimo chiedersi se ne esista una quantità sufficiente per soddisfare le richieste mondiali e se i recenti aumenti del suo costo siano un indizio dell’esaurimento delle riserve. Considerando che l’aumento della popolazione mondiale comporta parallelamente la crescita dei consumi energetici, ragionevoli previsioni indicano che i consumi energetici richiederanno nella seconda metà del XXI sec. una potenza energetica all’incirca doppia dell’attuale.

Sorgenti energetiche ed egemoniadei combustibili fossili

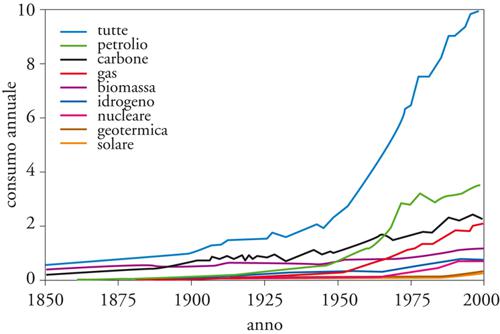

Il consumo energetico mondiale attuale si aggira attorno a 13,8 TW-anno (1 TW=1terawatt=1012 watt). La distribuzione dei consumi fra le diversi sorgenti è riportata nella fig. 2. Si può osservare che quelle fossili quali il petrolio, il carbone e il gas naturale – di natura chimica in quanto l’energia viene ottenuta attraverso le reazioni di combustione – occupano una posizione egemone poiché il loro impiego globale supera l’80%. L’Italia, Paese importatore di combustibili e di energia, si trova in una posizione atipica rispetto agli altri Paesi occidentali, per avere bandito il nucleare, limitato il carbone e privilegiato il gas naturale.

Il petrolio è una miscela di idrocarburi gassosi, liquidi e solidi con prevalenza di quelli saturi, seguiti in minore misura dalle olefine insature per la presenza di doppi legami e dagli aromatici, nei quali sono presenti anelli benzenici. I petroli greggi hanno composizione variabile e contengono in piccola quantità composti dello zolfo e dell’azoto e tracce di metalli, in particolare il vanadio.

La distribuzione geografica delle riserve di petrolio non riflette i luoghi di consumo dell’energia; al primo posto fra le aree produttrici troviamo infatti il Medio Oriente, che supera di gran lunga, nell’ordine, l’America Settentrionale, l’Asia, l’Africa, l’America latina e l’Europa.

Secondo un modello proposto dal geofisico M. King Hubbert la produzione di petrolio nel tempo dovrebbe seguire una curva a campana con il massimo in corrispondenza del 50% della quantità totale di riserve e risorse petrolifere presenti nel sottosuolo (Ultimate resource and reserves, URR). Purtroppo non esistono criteri sicuri per determinare in quale anno cada il picco: secondo stime pessimistiche dovrebbe verificarsi prima del 2010 mentre secondo valutazioni ottimistiche non prima del 2021. Da tali previsioni si arguisce che ci si dovrebbe comunque preparare alla fine dell’epoca del petrolio abbondante e a buon mercato alla quale le nazioni industrializzate sono abituate. In realtà, in base alle indagini in corso, il valore dell’URR è un obiettivo mobile verso l’alto come si desume dai dati dell’United States Geological Survey (USGS) che dalla fine degli anni Settanta del Novecento al 2000 ha visto quasi triplicare il suo valore, che attualmente supera 3∙1012 tonnellate.

Attualmente vengono estratti 3∙1010 barili di petrolio all’anno e con questo ritmo di consumi, tenendo conto che una quantità di quasi 1012 tonnellate è già stata utilizzata, si stima che sia disponibile petrolio per circa cinquanta anni. Il gas naturale dovrebbe soddisfare i bisogni energetici per due secoli e il carbone per tempi ancora più lunghi.

In realtà le menzionate previsioni si riferiscono ad analisi statistiche che non tengono adeguato conto dei fattori fisici e chimici che caratterizzano la struttura e la storia del sottosuolo, sul quale purtroppo le nostre conoscenze sono ancora modeste. Secondo la teoria più accreditata, il petrolio proviene da materia organica depositata sul fondo del mare che, grazie all’assenza di ossigeno, avrebbe subito nel corso di alcuni milioni di anni – con il concorso di batteri anaerobici e di catalizzatori inorganici – il processo di trasformazione in idrocarburi. La scoperta di nuovi giacimenti profondi ha però rinverdito l’ipotesi, avanzata nell’Ottocento dal gran-de chimico russo Dmitrij Ivanovič Mendeleev, che il petrolio possa avere avuto origine da precursori minerali. Questa possibilità, confermata da recenti esperienze condotte in laboratorio, aprirebbe nuove interessanti prospettive sulla disponibilità delle riserve petrolifere.

In generale si ritiene comunque che le future disponibilità di petrolio dipendano dall’estensione dell’area esplorativa e dal miglioramento delle tecnologie estrattive, di perforazione e di prospezione sismica tridimensionale del sottosuolo. Inoltre, la capacità di estendere le perforazioni off-shore a profondità sempre maggiori sta spingendo la frontiera verso lo sfruttamento degli alti fondali, a profondità superiori a 1000 metri, rendendo disponibili giacimenti di petrolio che in passato erano considerati inaccessibili.

Uno dei vantaggi che si riscontrano nell’impiego dei combustibili fossili è la loro versatilità. Il petrolio greggio viene trasformato nelle operazioni di raffineria che contemplano la purificazione da componenti inquinanti e una serie di trasformazioni chimiche, in particolare il cracking catalitico, in virtù delle quali le molecole idrocarburiche vengono trasformate, riducendone le dimensioni e agevolando le reazioni di isomerizzazione dello scheletro molecolare. È così possibile produrre molecole idrocarburiche che presentano migliori prestazioni come combustibili. Attraverso processi di distillazione frazionata si separano gruppi di idrocarburi aventi le caratteristiche adeguate per applicazioni specifiche. Si ottengono così benzina, gasolio e cherosene che costituiscono comodi vettori energetici e trovano quindi ampia applicazione nel settore del trasporto. Lo stesso petrolio e il gas naturale trovano impiego nel settore residenziale e in quello commerciale. Il carbone, infine, viene prevalentemente utilizzato per produrre elettricità.

Il problema delle emissioni di composti inquinanti nei centri urbani dove è presente un’elevata densità di autoveicoli ha fatto affiorare la proposta di avvicendarli con l’idrogeno, che presenta minori effetti di inquinamento. L’idrogeno non esiste libero in natura e il modo più economico per ottenerlo è far reagire metano con acqua a elevata temperatura in presenza di opportuni catalizzatori. Poiché nel processo si forma anche anidride carbonica, il procedimento non presenta particolari vantaggi riguardo al riscaldamento globale. I vantaggi si riscontrerebbero a livello locale per l’assenza degli inquinanti della benzina (in particolare lo zolfo, che però attualmente viene quasi del tutto rimosso nelle operazioni di raffineria), delle polveri sottili di carbone che si formano durante la combustione e delle tracce di idrocarburi volatili incombusti che, reagendo con l’ozono, portano alla formazione di prodotti nocivi. Purtroppo l’impiego dell’idrogeno fa nascere una serie di problemi connessi con il suo immagazzinamento e trasporto, soprattutto perché esso può essere liquefatto solo a temperature minori di 33°K(−240 °C) e pressioni superiori a 13 bar.

Viceversa il gas naturale, in virtù della sua purezza e abbondanza, sta acquisendo una posizione di crescente rilevanza. È principalmente costituito dal più semplice degli idrocarburi, il metano CH4, la cui molecola ha la forma di un tetraedro avente al centro l’atomo di carbonio e ai vertici i quattro atomi di idrogeno. Alcune analisi stimano che nel mondo vi sia una quantità di gas naturale, facilmente estraibile, sufficiente per produrre 500 miliardi di barili di greggio sintetico. Un’ulteriore fonte di metano sono i cosiddetti gas idrati, costituiti da masse solide biancastre formate da metano e da altri idrocarburi di basso peso molecolare, intrappolati in una particolare struttura cristallina del ghiaccio. Le molecole di acqua formano un reticolo rigido nel quale sono presenti cavità aventi un diametro di circa 8 Å, in grado di ospitare le molecole di metano; a piena saturazione è presente una molecola di metano ogni sei molecole di acqua. Queste specie sono stabili a bassa temperatura ed elevata pressione; portate in condizioni ordinarie, si decompongono rapidamente liberando il gas. I gas idrati sono molto abbondanti nei sedimenti marini e nelle aree continentali ricoperte da permafrost, quali la Siberia e l’Alaska.

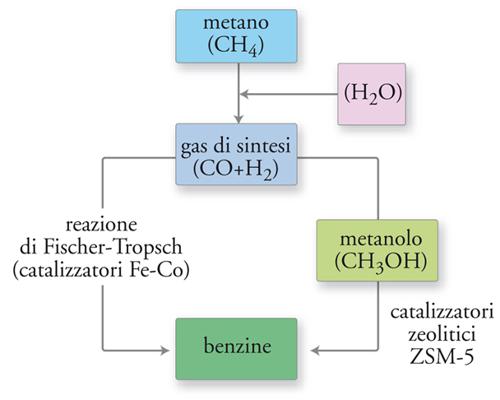

Il metano può essere convertito in una miscela di idrogeno e ossido di carbonio, chiamata gas di sintesi (syngas), facendolo reagire con acqua a circa 600 °C in presenza di catalizzatori a base di nichel, secondo una reazione detta di steam reforming, ampiamente impiegata nella chimica industriale e nella petrolchimica. Se si assoggetta il gas di sintesi a una reazione, detta di Fischer-Tropsch, nella quale esso viene fatto fluire su un catalizzatore a base di cobalto, nichel o ferro (fig. 3), si ottiene una miscela di idrocarburi liquidi saturi e insaturi con un’ampia distribuzione di pesi molecolari, la cui composizione può essere modulata variando la temperatura.

Risvolti ambientali

L’esteso impiego delle sorgenti fossili ha fatto emergere problemi d’inquinamento atmosferico che si manifestano su due scale: quella locale, connessa con l’elevata concentrazione delle emissioni nei centri urbani, e quella globale, che coinvolge tutto il pianeta. In quest’ultimo caso le inquietudini sono dovute principalmente alle emissioni di anidride carbonica, un gas che contribuisce ad aumentare la temperatura del pianeta per effetto serra. Anche se gli studi sull’evoluzione dell’atmosfera non sono pervenuti a conclusioni univoche è indiscutibile che negli ultimi 150 anni abbia avuto luogo un aumento della concentrazione di anidride carbonica che nella seconda metà del secolo scorso ha subito un’impennata passando da circa 280 a 370 parti per milione. Ciò ha avuto un’indiscutibile influenza sulla temperatura atmosferica che è aumentata di circa 0,7 °C.

Le previsioni sull’evoluzione dell’atmosfera sono condotte mediante modelli matematici chiamati General circulation models (GCM) che includono i processi dinamici atmosferici e le trasformazioni cui sono soggetti idiversi componenti chimici. Le incertezze nella loroapplicazione sono dovute ai dati in essi inseriti che riguardano il grado di dettaglio geografico di cui si tiene conto, la presenza delle nubi e le emissioni vulcaniche.

Un’informazione importante sull’analisi del comportamento del clima sul pianeta riguarda l’aumento di temperatura che ha luogo in corrispondenza di un raddoppio della quantità di anidride carbonica (climate sensitivity). Recentemente è stato effettuato un confronto fra i risultati dei diversi modelli riscontrando che tale aumento si aggira intorno ai 3 °C.

Numerose iniziative hanno tentato di portare l’attenzione generale sul problema delle emissioni di anidride carbonica, cercando di trovare consenso internazionale su quantità di emissioni accettabili. Ne sono emerse alcune direttive, formalizzate nel 1997 nel protocollo di Kyoto, che fissano i criteri e i limiti delle emissioni che ciascun Paese dovrebbe osservare per evitare un eccessivo accumulo dei gas serra nell’atmosfera.

Fissione nucleare

L’energia ottenuta dalla fissione nucleare differisce da quella fossile, poiché trae le sue origini dalle forze che agiscono fra le particelle presenti nei nuclei atomici, vale a dire i neutroni e i protoni. La quantità di energia coinvolta nella reazione di combustione di un idrocarburo ammonta a qualche decina di elettronvolt mentre nella reazione di fissione dell’uranio – nella quale il nucleo di un atomo U-235, reagendo con un neutrone, subisce una scissione in due o più frammenti di massa intermedia – ammonta a 200 milioni di elettronvolt. Parte di tale energia è trattenuta dai neutroni, emessi in numero tale (mediamente 2,5) da poter scindere altri nuclei di uranio e innescare una reazione a catena che si autoalimenta. Nei reattori è presente un sistema di rallentamento di tali neutroni che viene realizzato immergendo i blocchetti di uranio in un opportuno materiale, detto moderatore. In questo modo risulta possibile controllare la velocità della reazione, mantenendola ai livelli compatibili con una buona gestione del processo. Nei suoi elementi essenziali la teoria dei reattori nucleari ha una storia scientifica di tutto rispetto, poiché è stata tenuta a battesimo da Enrico Fermi ed Eugene Wigner, che hanno posto le basi per gli studi successivi.

Attualmente sono in funzione 444 (aprile 2008) impianti nucleari, che forniscono circa il 6,5% dell’energia mondiale sotto forma di energia elettrica (16% di quella globalmente impiegata). Il reattore è il centro vitale di una centrale e la zona in cui il materiale fissile genera energia termica, chiamata core, viene percorsa da un fluido che trasferisce il calore a un gruppo turbine-alternatore per la produzione di energia elettrica. Nell’evoluzione della tipologia dei reattori sono stati considerati diversi liquidi di raffreddamento, tra i quali l’acqua, l’acqua pesante, alcuni composti organici, i metalli e i sali fusi, sino a privilegiare l’impiego dell’acqua, a pressione elevata o in ebollizione. In questo quadro si stanno però sperimentando nuove tecnologie con l’obiettivo di semplificare gli impianti mediante configurazioni più compatte costituite da piccoli moduli suscettibili di una disposizione più flessibile ed economica.

Un’ulteriore linea di sviluppo riguarda l’impiego di gas quali l’elio o l’anidride carbonica per il raffreddamento. Un progetto tecnologicamente interessante è quello di disperdere il combustibile sotto forma di piccole particelle di ossido di uranio in sfere aventi la dimensione delle palle da biliardo. L’impiego congiunto di questi letti di sfere e di un raffreddamento a gas permetterebbe di semplificare gli attuali impianti, rendendoli più gestibili e sicuri.

Secondo la World Nuclear Association, se si vuole impedire il declino dell’energia nucleare sarà necessario poter disporre entro la metà di questo secolo di almeno 2500 reattori, rinnovando buona parte degli attuali, destinati a chiudere il loro ciclo vitale. A tale scopo è stato istituito il GIF (Generation IV International Forum) orientato allo sviluppo di sistemi nucleari da realizzare a livello di prototipo entro il 2035. Tutto ciò con l’intento di diminuire i costi, privilegiare il ciclo chiuso del combustibile, ridurre il volume delle scorie, individuare le caratteristiche di protezione da attacchi terroristici e dalla proliferazione di ordigni bellici.

Si deve comunque tenere conto che 1 TWh richiede 22 tonnellate di U-235, le cui riserve ammontano a 2,3∙106 tonnellate (0,7% dell’uranio naturale). Ne segue che con le desiderate velocità di produzione di energia l’approvvigionamento di uranio risulterebbe sufficiente per qualche decina di anni circa. Tuttavia solo se si opera con un ciclo del combustibile nucleare chiuso l’uranio bruciato deve essere sequestrato in un deposito geologico. Il plutonio presente nel combustibile spento può essere estratto per via chimica e impiegato nuovamente per alimentare un altro reattore. Questa tecnologia, in realtà complessa, viene impiegata in alcuni paesi con un aggravio dei costi.

Una via d’uscita comporta l’impiego dei reattori veloci, che non contengono o contengono poco materiale moderatore per cui la velocità del processo di fissione si mantiene elevata. In questa situazione si produce un numero di nuclidi fissili maggiore di quanti se ne distruggono, aprendo così la prospettiva di poter disporre di quantità praticamente illimitate di combustibile. Purtroppo questa strada comporta un aumento delle difficoltà tecniche, poiché si deve operare a temperatura molto elevata, e quindi con maggiori difficoltà di controllo, usando un fluido di raffreddamento più efficiente dell’acqua, quale il sodio.

Le fonti rinnovabili

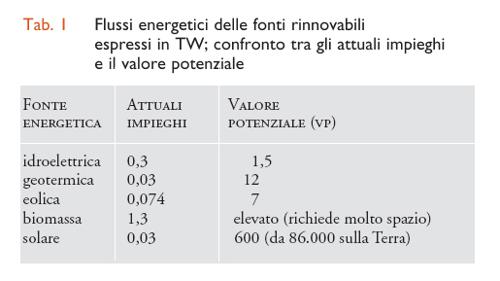

Accurate analisi hanno permesso di evidenziare quale sia il valore potenziale (vp), espresso in TW, dei flussi energetici delle diverse fonti rinnovabili, tenendo conto degli aspetti sia tecnici sia economici connessi con il loro sfruttamento. Questi valori sono riportati nella tab. 1, confrontati con quelli relativi al loro attuale impiego.

Si può osservare che l’energia solare, anche se viene impiegata in misura molto limitata, è in realtà nettamente superiore alle altre. La superficie del pianeta viene colpita da un flusso di energia pari a 178.000 TW, di cui 86.000 sul terreno, sotto forma di radiazioni elettromagnetiche, o fotoni, con un intervallo di frequenze compreso fra l’infrarosso e il violetto. Circa il 30% di questa energia viene direttamente riflesso nello spazio, mentre il 50% circa viene assorbito e trasformato in calore. Il restante 20% viene impiegato per dare luogo ai flussi ciclici dell’acqua e soltanto lo 0,06% viene catturato dagli organismi vegetali attraverso i processi fotosintetici dai quali derivano tutte le forme di vita e tutte le energie rinnovabili. Pertanto, tra le diverse forme di energia alternative la solare è quella sulla quale vengono poste le maggiori aspettative, anche perché offre diversi spunti verso applicazioni innovative. In tale quadro risulta importante l’efficienza delle trasformazioni che subisce, o può subire, la radiazione incidente, cioè la frazione di quest’ultima che viene convertita in una forma di energia direttamente impiegabile per usi diversificati. Considerando un valore ragionevole dell’efficienza del 10% si dimostra che per soddisfare l’attuale fabbisogno energetico mondiale viene richiesta una superficie pari a quella di un quadrato di 800 km di lato, corrispondente a circa lo 0,2% della superficie terrestre. Pertanto un eventuale ricorso estensivo all’energia solare non risulterebbe limitato da difficoltà territoriali.

Impiego delle biomasse

L’uso delle biomasse si basa sullo sfruttamento della radiazione solare per la sintesi di composti chimici con elevato contenuto di energia libera, e pertanto adeguati alla produzione di combustibili. È il procedimento adottato dalla natura nella fotosintesi, attraverso l’interazione della luce con biomolecole massive di struttura proteica. Il cuore del fotosistema è la molecola della clorofilla α, che assorbe le radiazioni rosse e blu riflettendo quelle verdi, che conferiscono così il tipico colore agli organismi vegetali. In seguito all’assorbimento della luce, la clorofilla passa in uno stato energetico eccitato che la rende in grado di trasferire un elettrone in un’altra parte del complesso molecolare, fornendo così l’energia richiesta per l’insieme delle reazioni chimiche che conducono alla sintesi dei carboidrati, i principali costituenti degli organismi vegetali. Tutta l’energia necessaria alla totalità delle forme di vita sulla terra corrisponde a un flusso di circa 90 TW.

Tuttavia, dal punto di vista energetico la fotosintesi è un processo poco efficiente perché ha un rendimento globale di circa 0,3%. Pertanto, per produrre 13 TW sarebbe necessario impiegare 2,6∙1013 m2, che corrispondono a circa il 20% delle terre emerse.

Dalle fonti vegetali si possono ottenere carburanti liquidi che possono surrogare quelli provenienti dal petrolio. Per esempio, si produce un biodiesel tramite una reazione relativamente semplice di transesterificazione degli oli vegetali, nella quale ha luogo la conversione di un trigliceride (olio vegetale) nel carburante per reazione con il metanolo. I biocarburanti hanno il vantaggio di poter essere direttamente impiegati nei trasporti, senza modifiche essenziali dei motori endotermici a ciclo Diesel. Pertanto, l’Unione Europea ha adottato un piano per incentivarne l’impiego, anche se la produzione resta limitata poiché i costi industriali di produzione non li rendono competitivi con i derivati del petrolio. La loro adozione è pertanto condizionata dall’esistenza di un regime fiscale agevolato. Le materie prime sono disparate, poiché possono essere impiegati tutti gli oli vegetali disponibili, ma le nuove tendenze prevedono il ricorso a oli vegetali ricavati da alghe marine o lacustri, così da non dover utilizzare terreni destinati a prodotti alimentari per la coltivazione dei semi oleosi impiegati nella produzione di biocarburanti.

Solare termodinamico

Si tratta di un processo nel quale l’energia della radiazione viene direttamente convertita in calore, successivamente impiegato per azionare un convertitore termomeccanico per produrre elettricità. Il cuore dei corrispondenti impianti è un collettore avente, per esempio, la forma di un disco o di un incavo a struttura parabolica, per concentrare la radiazione su un punto o su una linea. Le ulteriori unità sono un dispositivo per l’immagazzinamento dell’energia termica e quindi il convertitore per trasformarla in elettricità. Con questi impianti si può arrivare a un rendimento complessivo del 40%. Si tratta dunque di dispositivi efficienti, anche se permangono incertezze sulla loro durata e affidabilità. Infatti il collettore deve essere attraversato da un fluido in grado di raggiungere temperature dell’ordine dei 500 °C e con elevata capacità termica così da poter immagazzinare il calore a esso ceduto per un tempo relativamente lungo (dell’ordine delle 24 ore); a questo scopo si impiegano sali alcalini fusi (quali miscele di nitriti e nitrati di sodio e potassio) che però sono caratterizzati da un comportamento fortemente corrosivo.

Solare fotovoltaico

La cattura della radiazione solare si attua sulla superficie di opportune celle di un materiale semiconduttore in cui è presente una giunzione p-n ottenuta per drogaggio. La prima cella fotovoltaica fu realizzata all’inizio degli anni Cinquanta del secolo scorso presso i laboratori della Bell Telephon, sfruttando un effetto scoperto da Alexandre-Edmond Becquerel nel 1839 e rimasto a lungo una pura curiosità scientifica. Le prime applicazioni riguardarono il settore spaziale, nel quale il costo dell’energia aveva un’incidenza molto modesta. Con la crisi energetica del 1973 iniziarono le prime applicazioni terrestri, con lo sviluppo di programmi di ricerca intesi a diminuirne il costo di produzione con l’obiettivo di renderla competitiva con quella dei combustibili fossili. Il materiale più impiegato nella costruzione delle celle è il silicio, per cui la loro fabbricazione si avvale largamente della tecnologia dell’industria elettronica. Il recente incremento del costo del silicio puro, dovuto al suo impiego nel settore solare, ha stimolato la ricerca di sistemi basati sull’impiego di film sottili. Attualmente si tende a usare il silicio policristallino con purezza molto elevata, anche se si sta diffondendo l’utilizzo di celle con film sottili di silicio amorfo.

In alternativa all’impiego del silicio l’attenzione è volta alla preparazione di materiali semiconduttori a base di composti policristallini, che sembrano offrire una valida opzione per ridurre i costi perché possono essere ottenuti con processi relativamente semplici. In questo quadro i materiali interessanti sono il seleniuro di indio e rame (CIS), il tellururo di cadmio (CdTe). L’arseniuro di gallio (GaAs) che permette di realizzare celle stabili con efficienza elevata, ma costose sia per i materiali impiegati sia per il metodo di preparazione a larga scala.

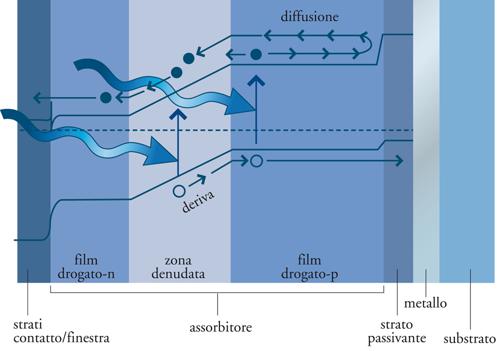

Se Δεg è la variazione di energia (gap) del semiconduttore richiesta per promuovere elettroni dalla banda di valenza a quella di conduzione, ciascun fotone incidente con frequenza νg=Δεg/h, essendo h la costante di Planck, eccita un elettrone alla banda di conduzione lasciando una lacuna elettronica, come illustrato nella fig. 5. La coppia si separa in corrispondenza della giunzione per effetto del campo elettrico che guida gli elettroni nella regione n e le lacune nella regione p, attraverso un movimento (drift o deriva) cui si contrappone la diffusione che tende a ripristinare la situazione iniziale. L’efficienza delle celle fotovoltaiche è determinata dall’abilità degli elettroni di sfuggire dalla regione p prima di ricombinarsi con le lacune. In sostanza, l’energia della radiazione viene convertita in energia elettrica alla giunzione e l’intensità della corrente che fluisce nel circuito elettrico risulta espressa dalla differenza fra la velocità di formazione delle coppie elettrone-lacuna e quella della loro ricombinazione attraverso processi non radiativi e radiativi, i quali dipendono, entrambi, dalla differenza di potenziale che si istituisce fra i terminali connessi con le regioni p e n.

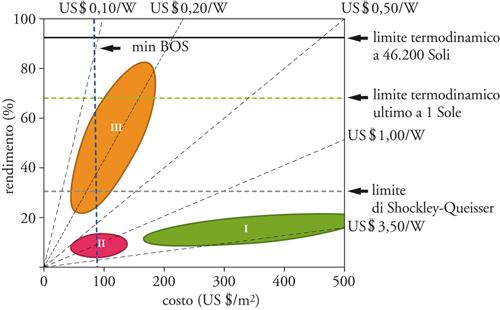

Per poter valutare i limiti di efficienza di un dispositivo fotovoltaico convenzionale è opportuno ricondursi a uno studio condotto nel 1961 da William Shockley e Hans J. Queisser. Il modello considerato contempla la presenza di una giunzione p-n alla temperatura ordinaria, soggetta alla radiazione solare cui vengono attribuite le tipiche caratteristiche della radiazione del corpo nero alla temperatura di 6000 °C. Le ipotesi che stanno alla base dell’analisi condotta sono le seguenti: (a) esiste una sola giunzione; (b) ogni fotone incidente eccita una sola coppia elettrone-lacuna; (c) l’energia in eccesso rispetto a quella richiesta per creare la coppia viene dissipata per rilassamento termico; (d) l’illuminazione viene condotta senza concentrazione dell’energia solare.

Il limite massimo dell’efficienza della cella è espresso dal rapporto fra quella parte dell’energia della radiazione incidente per unità di tempo sulla superficie della cella che viene catturata perché include le frequenze ν≥Δεg/h, e l’energia totale della radiazione che incide sulla superficie stessa. Se si tiene opportunamente conto delle caratteristiche geometriche dell’apparato e della rilevanza dei processi di ricombinazione delle coppie attraverso transizioni radiative e termiche, si dimostra che il valore massimo dell’efficienza ammonta a 0,31. Questo risultato teorico è confermato dai dati sperimentali per celle a singola giunzione realizzate con diversi semiconduttori quali il silicio monocristallino, policristallino e amorfo o l’arseniuro, i cui valori sono, rispettivamente 25%, 10%, 7% e 25%.

L’analisi di Shockley-Queisser evidenzia che se si vuole superare il menzionato limite massimo di efficienza si devono violare le ipotesi che stanno alla base del modello adottato per l’analisi teorica. Si intravedono così diversi approcci innovativi, primo fra i quali l’impiego di celle solari a giunzioni multiple con materiali meno trasparenti del silicio e quindi in grado di assorbire una quantità maggiore di energia, e con gap energetico calibrato sulle zone più intense dello spettro solare. I materiali candidati per la fabbricazione di tali celle sono semiconduttori composti da elementi dei gruppi III (gallio, indio) e V (arsenico, azoto, fosforo) del sistema periodico, di cui sono noti processi di fabbricazione in grado di produrre materiali di ottima qualità con alti coefficienti di assorbimento e con gap energetici capaci di coprire l’intero intervallo spettrale. Le celle vengono costruite formando strutture a strati ai cui contatti si formano le giunzioni n-p. Per esempio dispositivi con contatti del tipo GaInP/GaAs/Ge hanno raggiunto rendimenti che sfiorano il 40% e stanno pertanto risvegliando l’interesse di diversi operatori.

Un ulteriore accorgimento per migliorare le rese consiste nell’impiego di specchi che permettono di concentrare la radiazione che arriva sulla cella posta al centro dello specchio. Per evitare che l’energia assorbita diversa da Δεg venga dissipata in calore, è stato anche proposto di utilizzare materiali semiconduttori con una struttura a bande altamente quantizzata per la presenza di punti quantici (quantum dots) e di buche quantiche (quantum wells). I calcoli teorici dimostrano che con questo approccio si possono raggiungere efficienze dell’ordine del 60%. Le indagini sperimentali hanno confermato la presenza di tali effetti in particolari materiali contenenti quantum dots di PbSe, PbS, PbTe e CdSe, nei quali hanno luogo eccitazioni multiple comprese tra 3 e 7, aprendo così una linea di indagine di notevole interesse.

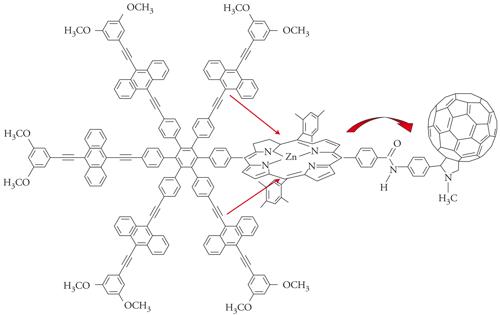

I crescenti sviluppi nell’impiego di materiali organici per la fabbricazione di dispositivi elettroottici quali i diodi emettitori di luce (LED), hanno suggerito la loro applicazione anche per la costruzione di celle solari. La prospettiva è allettante poiché tali materiali posseggono elevati coefficienti di assorbimento ottico e inoltre possono risultare meno costosi dei corrispondenti materiali inorganici. Un requisito indispensabile per poterli applicare con profitto è ovviamente la loro stabilità. La loro fabbricazione può fruire della larga esperienza maturata nel settore della chimica organica sintetica, grazie alla quale si possono produrre molecole con proprietà elettroniche opportunamente progettate. Esse dipendono dalla presenza di sistemi coniugati di elettroni, detti π, in grado di assorbire l’energia delle radiazioni luminose (fig. 6) e dalle interazioni che si manifestano fra le diverse molecole. In realtà il meccanismo di eccitazione dei semiconduttori organici è diverso da quello presente nei semiconduttori inorganici. Infatti, nei primi l’assorbimento della luce non porta direttamente alla formazione della coppia elettrone-lacuna. Inizialmente si forma uno stato eccitato mobile, chiamato eccitone, che migra sino a raggiungere la superficie di separazione fra i due materiali dove ha luogo la separazione dell’elettrone dalla lacuna. Per questa ragione le celle sono chiamate XSC (Excitonic solar cell).

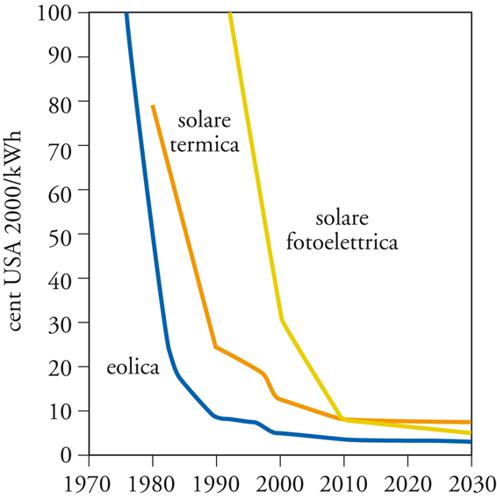

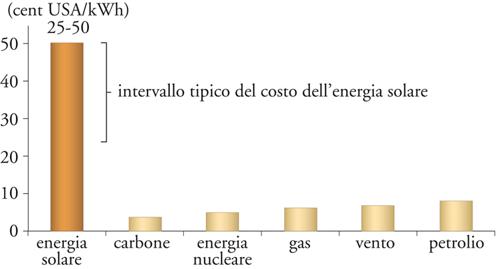

In conclusione il panorama che si presenta nel settore fotovoltaico appare variegato e promettente. Il motivo che ostacola attualmente l’applicazione estesa di tale tecnologia è il costo dell’energia prodotta (ca. 0,25 $/kW-ora), ancora nettamente superiore a quello delle altre sorgenti (ca. 0,05÷0,07 $/kW-ora). Come appare però dalla fig. 7, tale costo è in sensibile diminuzione. Questo fatto riflette l’esperienza acquisita e il graduale passaggio verso un’economia di scala grazie alla quale il costo di un manufatto diminuisce all’aumentare della sua produzione.

Fonte eolica

La fonte eolica, che sfrutta l’energia dei venti mediante i tipici aerogeneratori o mulini a vento, sta riscuotendo notevole interesse, soprattutto grazie alla disponibilità a basso costo di materiali resistenti e leggeri per fabbricarne le pale, che hanno ormai raggiunto le ragguardevoli dimensioni di 15 metri. Il flusso energetico specifico estraibile (espresso in W/m2) dipende dal cubo della velocità del vento. Si calcola che un tipico mulino assoggettato a un vento intermittente di 10 m/s è in grado di erogare un flusso di circa 40 W/m2. In realtà, per evitare mutue interferenze i mulini debbono essere localizzati ad almeno 150 m di distanza fra di loro nella direzione del vento. Risulta allora che il flusso specifico realmente disponibile si aggira fra 0,2 e 0,9 W/m2. Se lo stesso impianto eolico si trovasse in una zona con venti di entità doppia, grazie alla menzionata dipendenza della potenza gene-rata dal cubo della velocità, il flusso risulterebbe ottovolte superiore. Questi fatti evidenziano che tali installazioni sono redditizie solo in zone caratterizzate da un’adeguata ventosità, fermo restando l’inconveniente dell’intermittenza della fornitura elettrica dovuta ai salti di vento. Per contro, il sistema da installare è relativamente semplice e quindi i costi unitari dell’energia prodotta sono solitamente competitivi con quella ottenuta dalle fonti fossili, aggirandosi intorno a 0,05÷0,09 $/kWh.

Conclusioni e scenari futuri

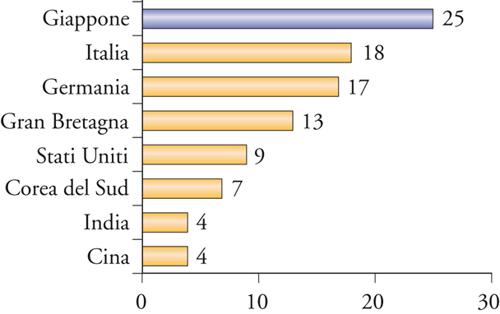

Nella fig. 9 vengono confrontati i valori dei costi di produzione dell’energia elettrica ottenuta dalle diverse fonti, mentre nella fig. 10 vengono riportati i prezzi alla vendita in diversi Paesi. Tali dati evidenziano che questi ultimi dipendono non tanto da fattori tecnologici o dal costo delle fonti fossili. Essi sono soprattutto condizionati da fattori economici strutturali e politici, di natura complessa poiché coinvolgono molti parametri connessi fra di loro in modo non lineare. Infatti solo nei Paesi in via di sviluppo quali la Cina e l’India il costo di vendita dell’energia è prossimo a quello di produzione.

Ragionevoli previsioni indicano che l’aumento della popolazione mondiale, che verosimilmente nel 2050 raggiungerà i 10 miliardi, e lo sviluppo in corso in diversi Paesi del Terzo mondo, trascineranno in modo significativo la crescita dei consumi energetici. In linea generale, anche se le attività di produzione dell’energia subiranno cambiamenti guidati dalle limitazioni ambientali e condizionati dai modi di fruizione dell’energia stessa attraverso un’applicazione sempre più massiccia delle metodologie di risparmio, si può prevedere che fra quaranta anni si dovrà produrre un flusso di energia di almeno 15 TW in più di quello attuale.

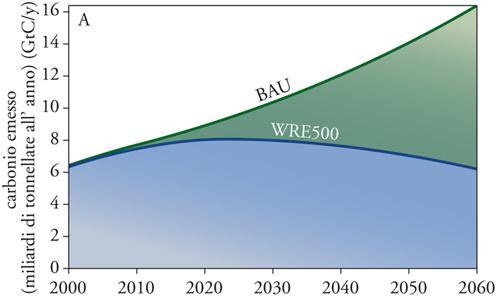

Per poter valutare l’incidenza dovuta alla produzione di energia da fonti fossili sul livello di CO2 sono stati costruiti diversi scenari concernenti il loro impiego nel tempo, ciascuno compatibile con una ben definita quantità di anidride carbonica presente nell’atmosfera. Quello corrispondente all’attuale schema di produzione dell’energia viene indicato come Business as usual (BUA) e il suo andamento è illustrato nella fig. 11 dove viene riportata la corrispondente quantità di carbonio che si riversa nell’atmosfera in funzione del tempo. Unitamente a essa è tracciata la curva (indicata come WRE, dal nome dei ricercatori Tom Wigley, Richard Richels e Jae Edmonds) corrispondente a una stabilizzazione dell’anidride carbonica a 500 ppm. Le due curve, che partono dallo stesso valore in corrispondenza dell’anno 2000, si divaricano a forbice; quella inferiore indica il limite di impiego dei combustibili fossili affinché l’anidride carbonica si mantenga stabile al valore fissato.

L’analisi precedente evidenzia la necessità di individuare sin da ora gli approcci in grado di produrre l’energia carbon-free che possa integrare in futuro quella ottenuta da fonti fossili. Il modo più diretto è quello di sequestrare la CO2 prodotta per combustione operando in impianti di grosse dimensioni. La separazione della CO2 dai gas di combustione può essere condotta mediante lavaggio con soluzioni basiche, per esempio in presenza di etanolammine, dalle quali successivamente la CO2 viene liberata per riscaldamento e quindi sequestrata in depositi geologici. Esistono nel mondo diversi progetti pilota intesi a valutare la fattibilità tecnologica, e sopratutto economica, di questo approccio.

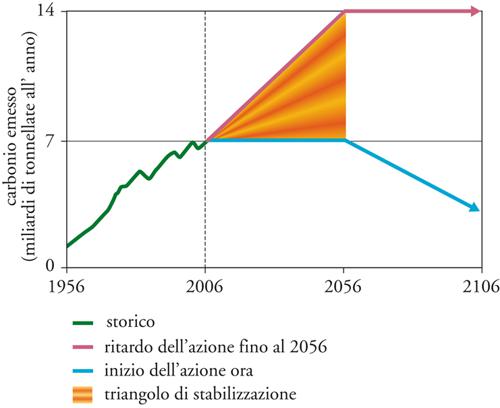

Dalle analisi prospettiche che sono state sviluppate sul controllo delle emissioni attraverso la combinazione, o mixing (fig. 12), di diverse tecnologie, quali il miglioramento dell’efficienza e le sorgenti alternative, si ipotizza che l’energia nucleare dovrebbe essere presente con un numero di reattori almeno cinque volte superiore a quelli esistenti. Sui programmi nucleari grava pertanto il problema del reperimento dei fondi necessari per fronteggiare elevati costi di investimento con un ritorno ritardato, poiché la costruzione di un impianto nucleare richiede una decina di anni. A questo si aggiunge lo spinoso problema dello smaltimento delle scorie che, operando su scale più elevate delle attuali, può presentare delle incognite. Pertanto, anche se esistono i presupposti per un rilancio dell’energia nucleare per far fronte ai rischi geopolitici connessi con l’approvvigionamento di petrolio e gas e all’incombere dell’effetto serra, permangono delle incertezze sulla sua programmazione. Infine, non si può ignorare che fra le diverse sorgenti quella nucleare è la più controversa, poiché la sua evoluzione futura dipenderà dalla capacità di offrire una soluzione politica ai problemi dell’eliminazione delle scorie e della sicurezza degli impianti.

Per quanto concerne le energie rinnovabili si può osservare che in questi ultimi anni hanno avuto un sostanziale incremento in termini tecnologici, di costi e di affidabilità. Tale sviluppo è stato guidato dall’eolico e dal fotovoltaico (fig. 13), che rappresentano le fonti con il più alto tasso di crescita di tutto il comparto energetico, anche se riferito a un valore iniziale estremamente basso. È comunque indiscutibile che alle energie rinnovabili si debba attribuire la concreta prospettiva di stabilizzare il mercato dell’energia riducendo l’impatto delle fluttuazioni indotte dalle tensioni sulle fonti petrolifere, e di favorire nel contempo uno sviluppo associato a sicuri benefici ambientali.

Bibliografia

Carrà 2008: Le fonti energetiche, a cura di Sergio Carrà, Bologna, Il Mulino, 2008.

Chauvel 1998: Chauvel, Alain, Fossil resources: current situ-ation and hydrocarbons issues for 2020, in: Energia e ambiente. Combustibili fossili, Roma, Accademia Nazionale dei Lincei, 1998, pp. 11-25.

Clery 2005: Clery, Daniel, Nuclear industry dares to dream of a new dawn, “Science”, 309, 2005, pp.1172-1175.

Kennett 2002: Methane hydrates in quaternary climate change. The clathrate gun hypothesis, edited by James P. Kennett e altri, Washington D.C., American Geophysical Union, 2002.

Kerr 2004: Kerr, Richard, Three degrees of consensus, “Science”, 305, 2004, pp. 932-934.

Lake 2002: Lake, James A. - Bennett, Ralph G. - Kotek, John F., Next-generation nuclear power, “Scientific American”, 286, 2002, pp. 72-81.

Lewis 2007: Lewis, Nathan S., Powering the Planet, “Material Research Society bulletin”, 32, 2007, pp. 808-820.

Marshall 2005: Marshall, Eliot, Is the friendly atom poised for a comeback?, “Science”, 309, 2005, pp. 1168-1169.

Masi 2007, Masi, Maurizio - Carrà, Sergio, Il ruolo del solare nel futuro panorama energetico, “Energia”, 4, 2007, pp.74-84.

Maugeri 2007: Maugeri, Leonardo, L’era del petrolio, Milano, Feltrinelli, 2007.

Service 2005: Service, Robert F., Is it time to shoot for the Sun?, “Science”, 309, 2005, pp. 548-551.

Shah 1999: Shah, Arvind e altri, Photovoltaic technology:the case for thin-film solar cells, “Science”, 285, 1999,pp. 692-698.

Smalley 2004: Smalley, Richard, Future global energy prosperity: the terawatt challenge, “Material Research Societybulletin”, 30, 2005, pp. 412-417.

Turner 1999: Turner, John A., A realizable renewable energy future, “Science”, 285, 1999, pp. 687-689.