Informatica

Informatica

di Luigi Dadda, Peter J. Denning

INFORMATICA

Informatica ed elettronica dei calcolatori

di Luigi Dadda

sommario: 1. Introduzione. 2. Evoluzione storica degli elaboratori: a) Fno a circa il 1940. b) Dal 1940 al 1950. c) Dal 1950. 3. Concetti introduttivi all'informatica. 4. L'elaboratore come automa per la memorizzazione e la sostituzione di simboli: a) Gli elaboratori elettronici e i programmi. b) Gli algoritmi e le macchine di Turing. 5. Elaboratori e linguaggi. 6. Classificazione dell'informazione: a) Informazione numerica o algebrica. b) Informazione fisica. c) Informazione strutturata o modulare. d) Testi in linguaggio naturale. e) Testi in linguaggi artificiali. 7. La codificazione dell'informazione: a) L'elaborazione dell'informazione codificata. b) Rappresentazione dei numeri in forma ‛normalizzata' (floating-point). 8. I principî della teoria delle reti logiche o binarie o di commutazione. 9. L'evoluzione della tecnologia dei circuiti elettronici binari. 10. L'evoluzione della tecnologia delle memorie. 11. L'evoluzione dell'architettura delle memorie. 12. L'evoluzione dell'architettura degli elaboratori. a) L'architettura dei sottosistemi. b) L'architettura dei sistemi di elaborazione: il collegamento dei sottosistemi. c) I microprocessori. 13. Le reti di calcolatori. □ Bibliografia.

1. Introduzione

I calcolatori elettronici sono nati come branca distinta dell'elettronica intorno all'anno 1950, dando origine sia a una nuova disciplina, l'informatica, sia a un nuovo importante settore industriale e influendo anche su molte altre discipline (scientifiche e umanistiche) nonché su molti aspetti della vita associativa. Tali influssi sono tuttora in continuo aumento e una valutazione della loro linea di sviluppo verrà tratteggiata in questo articolo.

I calcolatori elettronici sono noti essenzialmente come macchine da calcolo che sollevano l'uomo dall'arido compito di eseguire le lunghe sequenze di operazioni aritmetiche richieste dai calcoli scientifici e tecnici. Ci si è resi però presto conto che tali macchine costituivano uno strumento più generale di quello che inizialmente era stato concepito, in quanto erano capaci di compiere le più svariate elaborazioni su ‛stringhe' di simboli, non necessariamente limitati alle cifre numeriche. Ciò allargava enormemente la portata della macchina calcolatrice (giustamente denominata ‛elaboratore di informazione' nella nostra lingua), estendendone il campo di applicazione dall'informazione puramente numerica a quella codificata in stringhe di simboli, per esempio alfabetici. Mentre però l'informazione numerica era già da tempo fondata sull'importante costruzione matematica sviluppata precedentemente al calcolatore elettronico, l'elaborazione di una stringa di simboli qualsiasi pose nuovi problemi di carattere sintattico e semantico, che coinvolgevano le teorie dei linguaggi artificiali e naturali. È per tale motivo che l'informatica si è incontrata con le scienze umanistiche, come già accennato. Tale incontro si è sviluppato, peraltro, anche per altre vie, quali quelle percorse dagli studi sull'‛intelligenza artificiale' e sul riconoscimento automatico delle forme o configurazioni, studi diretti a sondare le possibilità degli elaboratori nello svolgimento di compiti che vanno al di là della pura e semplice elaborazione dell'informazione codificata; si tratta, infatti, di indagini rivolte a simulare e indagare il meccanismo delle più importanti funzioni del cervello umano.

Le applicazioni degli elaboratori ai problemi di carattere scientifico e tecnico si sono sviluppate a tal punto che essi sono ormai considerati strumenti insostituibili. Le applicazioni in settori amministrativi e organizzativi, iniziate con lo svolgimento di compiti elementari, sono state sviluppate al punto da rendere significativo il paragone tra ‛sistema informativo' di un'azienda e sistema nervoso di un organismo. Il superamento di alcune limitazioni tecnologiche ancora oggi presenti permetterà la realizzazione di sistemi informativi capaci di gestire i grandi servizi pubblici (sanità, territorio, trasporti, anagrafi di vario tipo). L'influenza di tali sistemi sulla vita associata sarà tale da porre anche problemi di grave momento, come quello della protezione legislativa delle libertà individuali che sarebbero minacciate da una diffusione non controllata e da un accesso indiscriminato alle ‛banche di dati' contenenti le informazioni sui vari aspetti della vita degli individui.

In questo articolo verranno esaminati, nell'ordine, l'evoluzione storica degli elaboratori, i vari aspetti che essi presentano al momento attuale e le prospettive di sviluppo.

2. Evoluzione storica degli elaboratori

a) Fino a circa il 1940

I dispositivi che possono considerarsi predecessori degli odierni elaboratori sono quelli che sono stati usati o proposti nel corso dei secoli come ausili alle operazioni del contare e aritmetiche.

L'arte del contare e del computare è stata sviluppata indipendentemente in culture indipendenti. L'applicazione di tale arte alle osservazioni degli astri le ha conferito un carattere divino e i numeri hanno acquisito per tale motivo un carattere mistico. Ma la stessa arte è stata coltivata anche per motivi pratici, specialmente nel commercio, come testimoniano tavolette sumeriche di cinquemila anni fa e il fatto che molti dei libri che Gutenberg stampò furono testi di aritmetica commerciale. Lo strumento tipico dell'antica arte del computare fu l'abaco (ancora oggi largamente usato nei paesi asiatici e dell'Europa orientale).

L'arte del computare fu sempre considerata molto difficile e tediosa e il suo sviluppo cominciò a verificarsi solo con l'adozione dell'attuale sistema di numerazione decimale, fondato sul concetto di ‛base' e utilizzante i simboli originati in India, diffuso per opera di Muḥammad ibn Mūsā al-Khuwārizmī (quest'ultimo è il nome di un villaggio dell'attuale Uzbekistan sovietico; da esso deriva la parola ‛algoritmo'). La diffusione del sistema decimale fece gradualmente scomparire l'uso dell'abaco in Europa, per la maggiore potenza e praticità delle regole di calcolo con numeri decimali (ancora nel XVI secolo, l'università di Altdorf attraeva gli studenti con la promessa che avrebbero imparato perfino la divisione). L'introduzione dei logaritmi da parte di J. Napier e H. Briggs rivoluzionò l'arte del computare, in particolare per i calcoli ‛tecnici' come quelli necessari per la navigazione su grandi distanze. La pubblicazione delle tavole dei logaritmi e delle funzioni circolari caratterizza tale epoca, ed è importante sottolineare il ruolo assunto da tali tavole come strumento per tutti i calcoli tecnici e scientifici (si può dire che soltanto oggi, con l'avvento degli elaboratori elettronici, la loro importanza è definitivamente declinata). I logaritmi sono peraltro la base dei ‛regoli calcolatori' (ove i numeri sono rappresentati appunto da segmenti la cui lunghezza è proporzionale al loro logaritmo e che perciò si prestano bene per le operazioni di divisione e di moltiplicazione).

La notazione decimale è la base dei primi veri e propri meccanismi di calcolo, il più significativo dei quali fu quello costruito nel 1642 da Pascal (all'età di 19 anni) per offrire un ausilio al padre intendente di finanza a Rouen. Successivamente Leibniz costruì (1673) una sua macchina che fu esposta alla Royal Society di Londra (è interessante citare quanto Leibniz scrisse nel 1671: ‟non è conveniente che uomini eccellenti perdano, come schiavi, ore di lavoro per calcoli che potrebbero essere affidati a chiunque altro se si utilizzassero delle macchine").

Nel 1878 lo svedese Odhner inventò un nuovo dispositivo per l'addizione e i suoi brevetti furono utilizzati in Germania per la costruzione delle note macchine da tavolo Brunsviga.

Tutte le macchine da tavolo, pur costituendo un importante strumento, richiedono l'intervento dell'operatore per ogni operazione aritmetica. Molti dei calcoli, in particolare quelli di tipo tecnico-scientifico, richiedono una lunga successione di tali operazioni e perciò si presenta ancora, sia pure a un livello superiore, l'inconveniente della laboriosita che aveva indotto alla costruzione dei primi meccanismi. Era pertanto ragionevole pensare di compiere un ulteriore passo nell'automazione dei calcoli, rendendo possibile l'esecuzione automatica successiva delle operazioni necessarie per compiere un calcolo complesso.

Tale pensiero venne per la prima volta coltivato dal matematico inglese Ch. Babbage (1792-1871), che propose una macchina (the difference engine) capace di calcolare tavole numeriche, basata sul ‛calcolo delle differenze'. Dopo la presentazione di un piccolo modello funzionante, realizzato con l'appoggio della Royal Society e del governo inglese, il Babbage iniziò la costruzione di un modello più grande (con numeri di 20 cifre e capace di calcolare fino alle seste differenze) concepito per calcoli effettivi, la cui costruzione però venne sospesa. Successivamente un esemplare venne completato e utilizzato nel 1863 per il calcolo delle tavole di vita usate poi per molti anni dalle compagnie assicuratrici. Nel frattempo il Babbage aveva concepito l'analytical engine, cioè una macchina capace di qualsiasi tipo di calcolo e basata sugli stessi concetti che sono alla base dei moderni elaboratori elettronici. Essa infatti comprendeva una ‛memoria' per dati e programmi, un'unità di calcolo e una per il controllo della sequenza delle operazioni. L'elemento fondamentale era il programma di calcolo, costituito dall'indicazione delle successive operazioni. Erano previste, in particolare, operazioni che permettevano alla macchina la scelta tra due successive diverse sequenze di istruzioni.

L'analytical engine non venne mai completato. È interessante notare che il Babbage pensò di risolvere il problema di controllare la successione delle numerose operazioni necessarie per un calcolo completo adottando un dispositivo inventato da Jacquard per il controllo dei telai di tessitura e basato sull'uso di schede perforate per ottenere la ripetizione di disegni e trame nei tessuti.

Vent'anni dopo la morte di Babbage, il responsabile dell'American Bureau of the Census, Hollerith, di fronte al problema di elaborare i dati di un censimento, ricorse al metodo di registrare tali dati tramite perforazioni su schede di carta e inventò una serie di macchine per ordinare le schede e per analizzare i dati su esse registrati. Le idee di Hollerith furono sviluppate dalla International Business Machines Corporation (IBM) in America e dalla British Tabulating Machine Company in Inghilterra, mentre le Società Powers-Samas e Remington Rand svilupparono le idee di Powers, assistente di Hollerith. In Francia, successivamente, la Compagnie de Machine Bull si basava per gli stessi scopi sui brevetti del norvegese Bulì. Le suddette società hanno contribuito, fino all'avvento degli elaboratori elettronici, a diffondere l'impiego delle macchine a schede perforate soprattutto per la soluzione dei problemi amministrativi; si può ritenere che la rapida affermazione degli elaboratori nelle applicazioni amministrative e organizzative sia in gran parte dovuta alla preparazione raggiunta nell'epoca precedente con l'uso delle macchine a schede perforate che, seppure grandemente inferiori agli elaboratori elettronici, hanno contribuito a sviluppare una mentalità che ha reso relativamente facile l'accettazione del nuovo più potente strumento. Inoltre le macchine a schede perforate costituiscono uno dei più noti strumenti per l'ingresso dei dati negli stessi elaboratori. Sebbene le macchine a schede fossero particolarmente concepite per le elaborazioni amministrative, si ebbero anche significative applicazioni a calcoli scientifici e ciò valse probabilmente di stimolo a concepire macchine più adatte allo scopo.

b) Dal 1940 al 1950

L'idea di una macchina calcolatrice universale secondo la concezione di Babbage rivisse negli Stati Uniti e successivamente in Inghilterra (oltre che in Germania) a cominciare dal 1938, anno nel quale il prof. Aiken dell'Università di Harvard, con la collaborazione della IBM, iniziò il progetto del calcolatore Mark I (completato nel 1944). Esso era costituito da organi elettromeccanici (relè e selettori rotanti) ed eseguiva, su numeri decimali di 23 cifre, operazioni la cui successione era controllata da un nastro di carta perforata al ritmo di 200 operazioni al minuto. La programmazione fu tuttavia limitata, rispetto a quella concepita da Babbage, dal fatto che vi erano soltanto due alternative possibili: continuare con l'operazione successiva o fermarsi. Mark I venne intensamente usato per il calcolo di ogni genere di tabelle numeriche.

Nel 1946 presso la Moore School of Electrical Engineering dell'Università di Pennsylvania, J. W. Mauchly e J. P. Eckert completarono la prima macchina interamente elettronica, chiamata E.N.I.A., C. (Electronic Numerical Integrator and Calculator). Essa comprendeva 18.000 tubi elettronici e 1.500 relè e la sua struttura poteva considerarsi come un analogo elettrico del Mark I, rispetto al quale risultava molte centinaia di volte più veloce.

Nel 1945 il prof. J. von Neumann, della stessa Moore School, pubblicava un rapporto sul progetto logico dei calcolatori elettronici, in cui i concetti precedentemente noti venivano completati ed estesi alla luce delle possibilità offerte dalla tecnologia elettronica (in particolare veniva proposto l'uso del sistema binario già preconizzato da Leibniz e si illustrava la necessità di disporre di memorie elettroniche di grandi capacità), in modo da ottenere macchine molto più potenti di quelle fin allora concepite e con un minor numero di componenti elettronici. È importante osservare che la struttura delle macchine attuali può considerarsi come derivata per evoluzione da quella suggerita da von Neumann.

Nel 1948 la IBM completava una macchina denominata Selective Electronic Calculator, composta da 23.000 relè e 13.000 tubi elettronici. Tale macchina è stata forse la prima a permettere la biforcazione condizionata di un programma, secondo le concezioni di Babbage. Essa fu intensamente utilizzata, in particolare dalla Atomic Energy Commission.

Nel 1950 presso il National Bureau of Standard entrava in funzione la macchina SEAC (Standard Eastern Automatic Computer), caratterizzata da memorie a linee di ritardo in mercurio e da organi di entrata e uscita a filo magnetico.

Un'intensa attività di ricerca si svolgeva contemporaneamente in Gran Bretagna all'Università di Manchester, a quella di Cambridge, al National Physical Laboratory, ad Harwell, al Telecommunication Research Establishment, all'Empirial College, al Royal Aircraft Establishment.

In particolare a Manchester veniva sviluppata una macchina con una memoria basata sull'uso di tubi a raggi catodici, sulla cui superficie veniva controllato il deposito di una matrice di cariche elettriche assunte a rappresentare cifre binarie. La nuova memoria caratterizzava fino a circa il 1955 molte altre macchine, costruite anche in serie, e fu in seguito soppiantata dalla memoria a nuclei magnetici.

A Cambridge, nel 1949, veniva completata l'EDSAC (Electronic Delay Storage Automatic Calculator), ispirata dal citato rapporto di von Neumann, con la quale si fecero importanti esperienze di programmazione, con l'uso sistematico di sottoprogrammi. La macchina usava memorie a linee di ritardo in mercurio.

Anche in Germania e Svizzera, a opera di Zuse, si svolgeva un'interessante attività nel campo delle calcolatrici automatiche.

c) Dal 1950

A cominciare da tale data, si assiste da una parte al moltiplicarsi di iniziative nei laboratori di ricerca, dall'altra al sorgere di iniziative industriali che si sono oggi sviluppate al punto tale da fare dell'industria degli elaboratori una delle massime dal punto di vista del valore della produzione. Tali iniziative industriali traevano stimolo dall'applicazione delle nuove macchine nel campo delle elaborazioni amministrative, dapprima come semplici complementi ed estensioni delle preesistenti macchine a schede perforate, in seguito come macchine espressamente concepite per tali elaborazioni, che rivoluzionavano le stesse tecniche amministrative e organizzative.

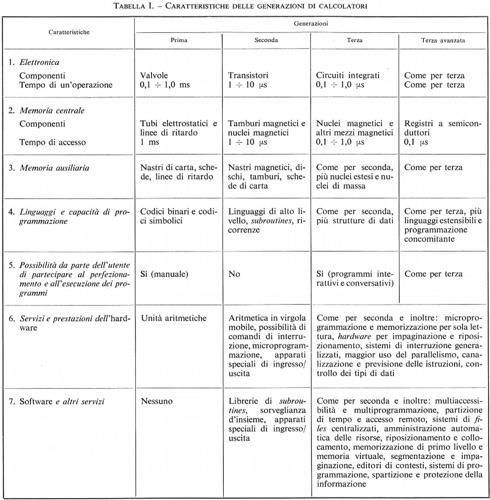

Lo sviluppo degli elaboratori è caratterizzato dall'av- vento di nuove tecnologie e nuovi concetti, convenzionalmente inquadrati in successive ‛generazioni' di macchine.

La ‛prima generazione' (fino a circa il 1955) era caratterizzata dall'uso dei tubi elettronici e di memorie a tubi catodici, elementi che limitavano grandemente l'affidabilità delle macchine. Le tecniche di programmazione erano ancora nella prima fase di sviluppo, con i primi tentativi verso i linguaggi di programmazione.

La ‛seconda generazione' era caratterizzata dall'avvento del transistore, che permetteva di ridurre notevolmente il tasso dei guasti. Come conseguenza, la potenza di calcolo delle macchine subiva un forte incremento, anche grazie all'introduzione delle memorie a nuclei magnetici. Contemporaneamente, la programmazione compiva, soprattutto nel campo dei linguaggi, importanti progressi che permettevano di ridurre considerevolmente le difficoltà della programmazione. L'elaboratore veniva concepito non più come una singola, indivisibile macchina, ma come un sistema formato di moduli variamente componibili per meglio adattarli alle esigenze di ogni applicazione.

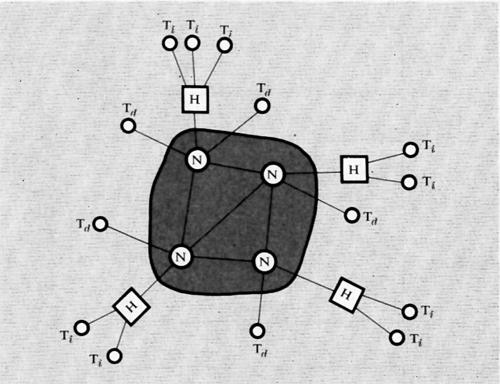

La ‛terza generazione' può caratterizzarsi con l'avvento dei circuiti integrati, coi quali le caratteristiche delle macchine sono state ulteriormente migliorate, con riduzione dei costi. Dal punto di vista della programmazione, le tecniche di ‛multiprogrammazione', di time sharing, di ‛elaborazione in tempo reale' estendono ulteriormente gli impieghi, permettendo sia l'uso simultaneo di una stessa macchina da parte di più utenti, sia la possibilità di usare l'elaboratore in modo più strettamente collegato con l'organizzazione che lo adotta. La trasmissione a distanza dei dati permette inoltre di estendere le capacità di elaborazione su aree geografiche molto estese, consentendo anche il collegamento tra elaboratori.

Nel seguito si cercherà di illustrare, i concetti e le tecnologie di base degli elaboratori, descrivendone l'evoluzione e formulando i problemi che si presentano oggi nell'ulteriore sviluppo di quest'applicazione tecnologica.

3. Concetti introduttivi all'informatica

I concetti che oggi sono riconosciuti come fondamentali per gli elaboratori si sono sviluppati e precisati gradualmente, a cominciare da quelli primitivi di Babbage e di von Neumann. Tali concetti primitivi si riferivano all'elaboratore concepito essenzialmente come macchina da calcolo, ma lo sviluppo delle applicazioni ha messo presto in evidenza come la nuova macchina fosse, più in generale, un elaboratore automatico dell'informazione espressa sotto forma di stringhe di simboli. I risvolti concettuali più importanti di tale modo di vedere l'elaboratore verranno sviluppati nel seguito. Ci si vuole qui invece soffermare a introdurre alcune considerazioni preliminari e generali sull'elaboratore.

Analizziamo il flusso delle informazioni in due casi tipici, il primo relativo a due interlocutori umani che comunicano indirettamente tramite un elaboratore (può essere il caso di due interlocutori ‛diretti' che parlano lingue diverse e in cui l'elaboratore compie la traduzione, oppure di due interlocutori ‛indiretti' che comunicano con lo stesso elaboratore programmato per gestire un'azienda, per es. una banca), il secondo relativo invece a un osservatore che si serve dell'elaboratore per indagare il mondo esterno (per es., un ricercatore fisico che si serve dell'elaboratore per lo studio di fenomeni). I due casi si prestano alle seguenti osservazioni.

1. Il mondo reale viene sempre osservato attraverso un modello (anche quando non lo si definisce esplicitamente) che può evolvere in funzione delle stesse osservazioni. Analogamente due interlocutori assumono sempre reciprocamente un modello, oppure si tratta del modello dell'azienda in cui operano.

2. L'informazione viene sempre rappresentata con ‛dati'. Nel caso dell'osservazione del mondo esterno si tratta per esempio di misure, nel caso di due interlocutori può trattarsi di stringhe di simboli, cioè di linguaggi. Anche quando i due interlocutori sono per esempio due operatori di terminali di elaboratori aziendali, essi usano speciali linguaggi. È importante notare che i dati vengono qui considerati dipendenti dal modello stesso: per esempio, uno strumento di misura non viene mai messo in un impianto a caso, ma come il modello suggerisce.

È ancora importante notare che qui si suppone che i due interlocutori comunichino solo attraverso l'elaboratore, cioè esclusivamente tramite linguaggi. Le comunicazioni tra interlocutori umani avvengono, fortunatamente, anche in forma diretta e, anche se si supponesse il linguaggio naturale trattabile dalle macchine (ciò che non è, come verrà meglio detto in seguito), sarebbe difficile pensare di trattare automaticamente gli innumerevoli altri modi di comunicazione umana, come i gesti, le occhiate, ecc.

3. I dati vengono successivamente consegnati ai ‛pro-grammi' per mezzo dei quali vengono elaborati e occorre tener presente che tali programmi consistono nella descrizione dell'elaborazione voluta, descrizione eseguita tramite uno dei ‛linguaggi' di programmazione che la macchina data è capace d'interpretare. Inoltre la gestione dei programmi, dei traduttori di linguaggio e in generale di tutte le risorse della macchina è compiuta tramite un ‛programma base' o ‛sistema operativo', non accessibile all'utente. Per quanto ora detto, l'informazione fornita coi dati viene elaborata in vari stadi dal complesso di tutti i programmi della macchina costituenti il cosiddetto software.

4. Sotto il controllo del programma base le informazioni, rappresentate finalmente nella forma interna alla macchina, cioè con atomi di informazione detti bits, vengono elaborate dai circuiti della macchina, cioè da ciò che è chiamato l'hardware della macchina stessa.

I risultati dell'elaborazione ottenuti nell'hardware sotto forma di bits devono poi ripercorrere a ritroso tutta la catena precedentemente illustrata, per essere infine presentati all'osservatore.

L'illustrazione fatta fornisce, pur nella sua sommarietà, un'indicazione delle numerose trasformazioni che l'informazione subisce quando viene elaborata con macchine. Il più importante problema che emerge dall'illustrazione suddetta è quello delle condizioni che devono verificarsi affinché l'elaborazione automatica delle informazioni sia di qualche utilità, e sembra di poter affermare che la condizione più importante è la ‛conservazione del significato' dell'informazione attraverso tutta la catena delle trasformazioni.

La conservazione del significato dell'informazione assume aspetti diversi nei diversi stadi dell'elaborazione. Al livello più basso, dell'hardware, essa richiede innanzitutto che la sequenza di bits esprimente in un dato codice un dato simbolo venga riconosciuta sempre allo stesso modo nelle varie parti della macchina. Ma ai livelli superiori ciò non è sufficiente, perché lo stesso simbolo in relazioni diverse rispetto ad altri può assumere significati diversi. Si incontrano pertanto i problemi tipici della teoria dei linguaggi, sui quali si tornerà successivamente.

Può essere interessante confrontare la condizione di conservazione del significato con la condizione di conservazione della quantità di informazione di un segnale studiata nella teoria dell'informazione (v. elettronica). Mentre quest'ultima condizione dipende dall'effetto del rumore nei canali di trasmissione del segnale, la conservazione del significato è di carattere linguistico e prescinde dalla precedente condizione, che si presume, anzi, sempre verificata.

4. L'elaboratore come automa per la memorizzazione e la sostituzione di simboli

Come già detto, l'elaboratore moderno, concepito inizialmente come macchina per l'esecuzione di calcoli numerici, si è rivelato ben presto di natura molto più generale: esso è cioè una macchina per la memorizzazione e la sostituzione di simboli.

È importante notare come molte delle operazioni del cervello umano non siano di natura creativa, ma si riducano a un'automatica sostituzione di simboli. Quando, per esempio, eseguiamo una moltiplicazione, ricorriamo sistematicamente alla tavola pitagorica memorizzata durante l'infanzia e operiamo una pura e semplice sostituzione di simboli. Così pure, quando eseguiamo elaborazioni algebriche o differenziazioni o integrazioni di funzioni, operiamo prevalentemente con sostituzioni di simboli, o stringhe di simboli, memorizzati o reperibili in tabelle e manuali. Un altro esempio simile ai precedenti è costituito dall'elaborazione di equazioni di equilibrio chimico.

Gli esempi precedenti sono tratti da campi nei quali la formalizzazione dei rispettivi ‛linguaggi' (cioè delle regole per costituire stringhe significative di simboli per comunicare le informazioni relative al campo considerato) era stata perfezionata anteriormente all'avvento degli elaboratori. Tutte le volte che è stato affrontato il problema di applicare l'elaboratore in settori nei quali tale formalizzazione non era stata ancora perfezionata, ci si è imbattuti in gravi difficoltà, che non possono essere superate se non con una precisa formalizzazione che permetta di sfruttare l'unica vera importante proprietà dell'elaboratore e cioè quella di essere una macchina per la sostituzione e per la memorizzazione di simboli. Tale formalizzazione è stata relativamente facile nel settore delle elaborazioni amministrative e gestionali, ma trova gravissime difficoltà, per esempio, nella soluzione di un problema che è tipicamente un problema di pura sostituzione di simboli e che gli esseri umani sanno compiere con relativa facilità, e cioè la traduzione di testi espressi con linguaggi naturali.

Due sono i più importanti aspetti dell'elaboratore che verranno qui di seguito illustrati, quello del ruolo dell'elaboratore come trasformatore di stringhe di simboli e quello del significato della stessa stringa di simboli.

Infatti l'elaboratore non può essere visto dall'esterno se non come una macchina che accetta stringhe di simboli e che fornisce come risultato stringhe di simboli. Poiché una stringa di simboli può essere considerata come un testo in un certo linguaggio, lo studio dei linguaggi risulta d'importanza rilevante per la comprensione degli elaboratori.

Dal punto di vista interno ci interessa invece il meccanismo di sostituzione di simboli che avviene per effetto di un programma (anch'esso composto di stringhe di simboli), propriamente un ‛algoritmo': è pertanto quest'ultimo l'altro concetto rilevante per la comprensione degli elaboratori. Essi verranno illustrati più avanti.

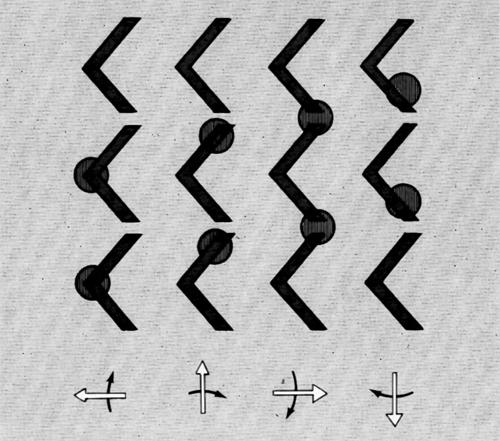

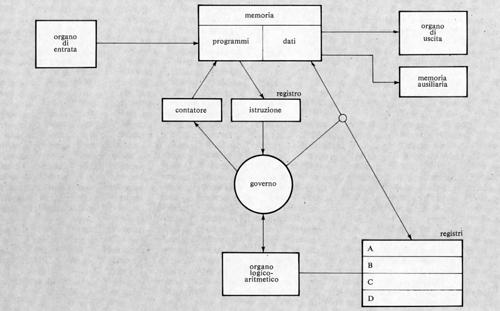

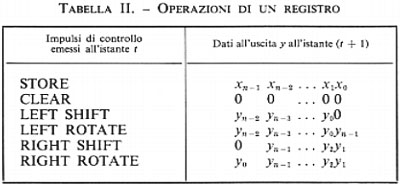

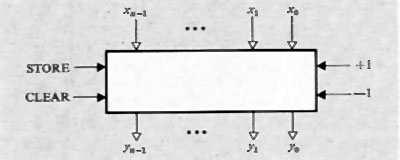

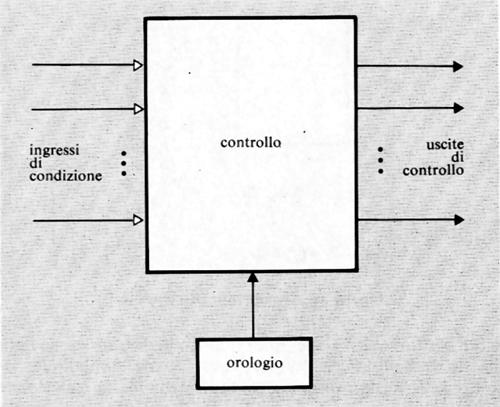

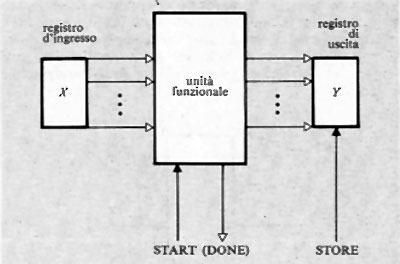

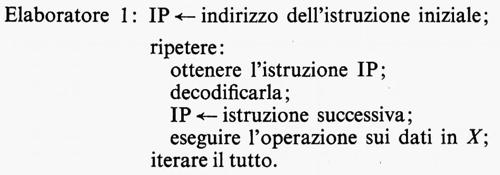

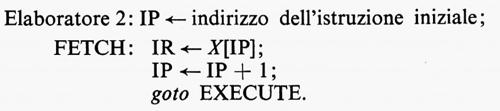

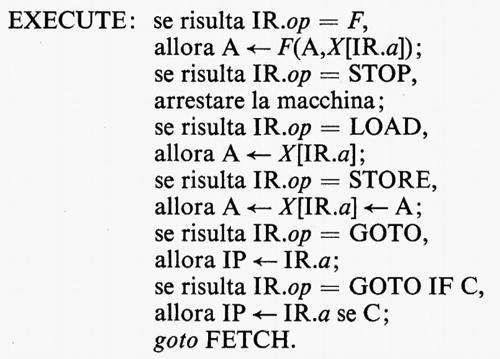

a) Gli elaboratori elettronici e i programmi

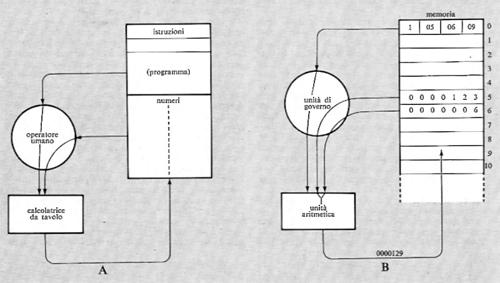

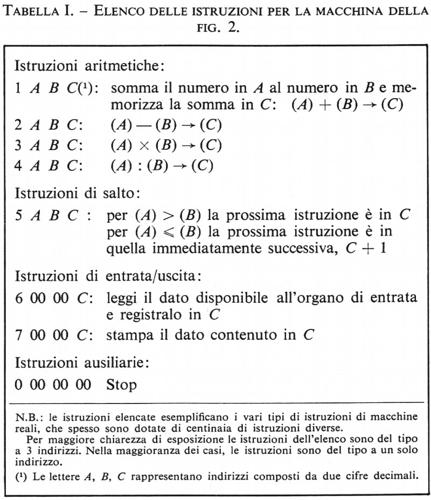

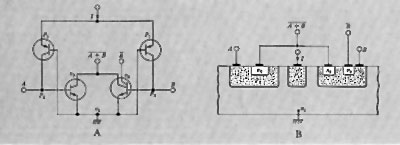

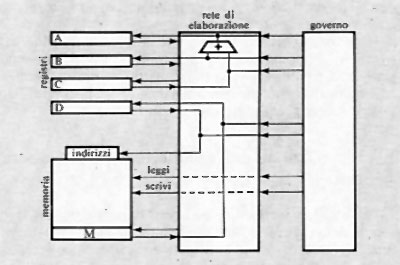

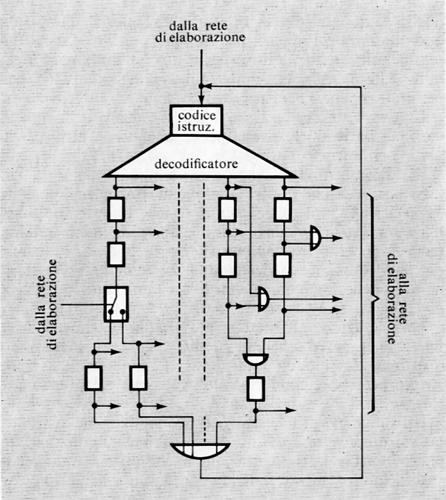

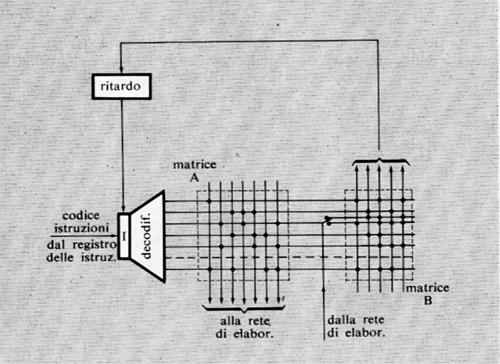

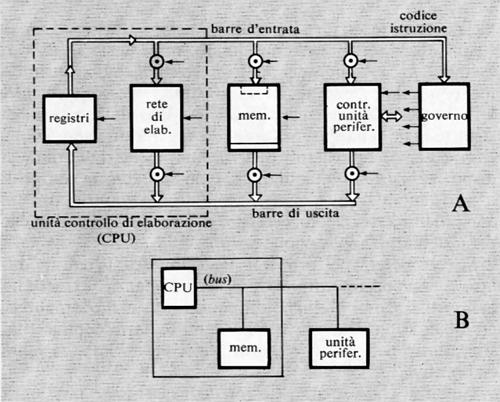

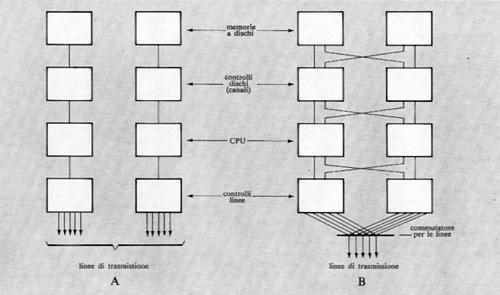

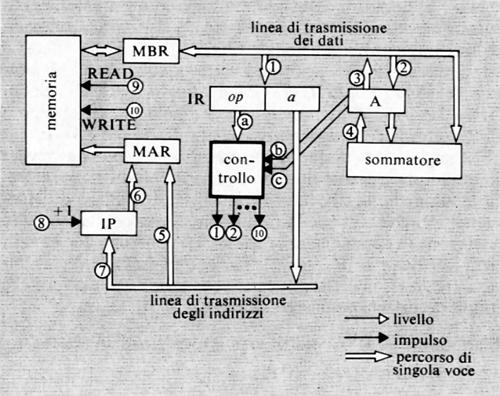

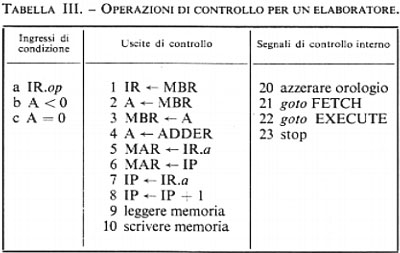

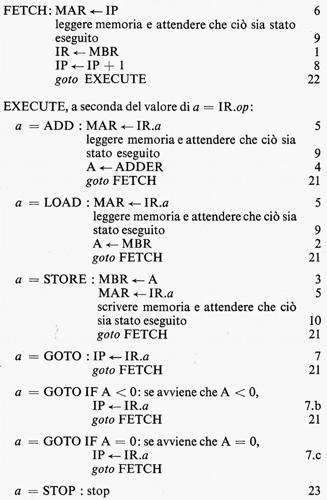

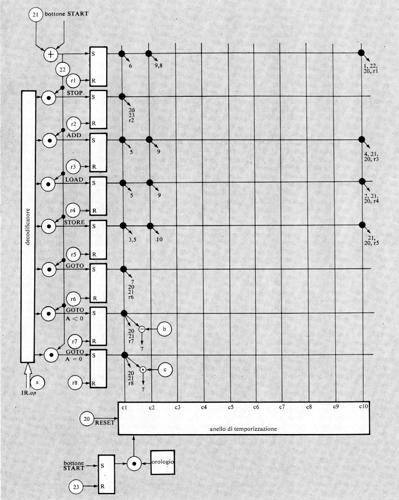

Come è stato ricordato nella precedente esposizione storica, la concezione che Babbage aveva di un calcolatore universale derivava dalla constatazione che calcolazioni comunque complicate potevano essere compiute da persone anche ignare del problema, una volta che la sequenza delle operazioni fosse stata accuratamente e preventivamente descritta. Tale sequenza di operazioni forma l'algoritmo per una certa classe di problemi. La similitudine tra la calcolazione tramite operatori umani e quella tramite una macchina è mostrata nella fig. 2. Nella fig. 2A l'operatore umano deve solo interpretare fedelmente le istruzioni costituenti il programma e saper eseguire (magari con l'ausilio di una calcolatrice da tavolo) le operazioni richieste; non deve assolutamente prendere alcuna iniziativa autonoma. Nella fig. 2B l'operatore umano è sostituito da una parte della macchina (l'unità ‛di governo' o ‛di controllo'), capace d'interpretare le istruzioni del programma. Queste sono registrate in un organo detto di governo o di controllo, corrispondente al foglio di carta della fig. 2A e contenente anche i dati numerici su cui operare. Le istruzioni del programma sono rappresentate in forma codificata con 7 cifre decimali di cui: la prima rappresenta il tipo di operazione (l'elenco delle operazioni eseguibili dalla macchina è rappresentato nella tab. I); le due successive coppie di cifre rappresentano ‛l'indirizzo' dei due ‛operandi', nell'esempio i due addendi; l'ultima coppia rappresenta l'indirizzo di memoria ove s'intende che venga riposto il risultato (nelle usuali memorie, quando si registra una nuova informazione in una certa cella, il contenuto precedente viene perduto e sostituito dal nuovo. Per contro, quando l'organo di controllo preleva l'informazione, per esempio un operando, da una cella, l'informazione stessa rimane registrata nella stessa cella).

Oltre alle istruzioni di tipo ‛aritmetico', un elaboratore è capace di eseguire molti altri tipi di istruzioni. Di particolare rilevanza sono quelle dette di ‛salto' o ‛biforcazione'. È importante osservare che di regola (cioè con qualsiasi altro tipo di istruzione) l'unità di governo provvede a eseguire le istruzioni nell'ordine in cui esse sono registrate nelle celle della memoria. Un'istruzione di salto permette invece di interrompere l'esecuzione per indirizzi sequenziali, obbligando l'elaboratore a compiere un salto a un qualsiasi altro indirizzo (v. l'istruzione di salto della tab. I), iniziandovi una nuova successione di istruzioni. Tale salto è, peraltro, condizionato dal risultato di un confronto (come per l'istruzione di salto della tab. I) oppure dal segno di un numero o da qualsiasi altra condizione (anche esterna all'elaboratore stesso), come avviene in pratica nelle macchine che sono munite di numerose istruzioni di salto.

L'istruzione di salto è di fondamentale importanza per la strutturazione di programmi complessi. Essa è infatti indispensabile per realizzare due dei più importanti concetti nella programmazione, e cioè i ‛cicli' e i ‛sottoprogrammi', utili sia per facilitare la scrittura dei programmi, sia per ridurre il numero di istruzioni componenti un programma.

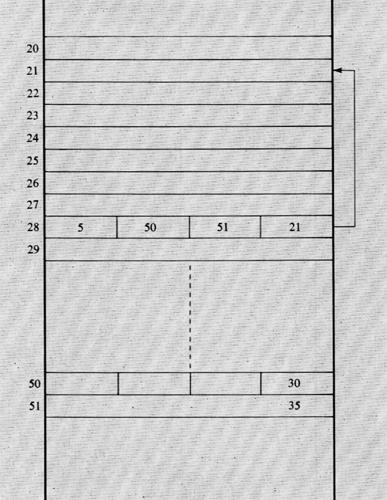

Un ciclo viene ottenuto in un programma mediante un'istruzione di salto che rinvia a un'istruzione precedente quella del salto stesso, in modo tale da poter ripetere la parte di programma compresa tra essa e quella di salto (v. fig. 3, ove l'istruzione di salto 28 rimanda all'istruzione 21 tutte le volte che il contenuto della cella 50 risulti maggiore di quello della cella 51).

L'esecuzione di un ciclo può essere utile in due casi principali. Il primo è quello in cui il ciclo rappresenti un programma di calcolo di tipo ‛iterativo', come si richiede nell'applicazione di procedimenti di calcolo detti ‛per approssimazioni successive'. Tali procedimenti sono basati su schemi di calcolo che permettono di ottenere un certo risultato soltanto in forma approssimata e insieme permettono anche di determinare di quanto la soluzione ottenuta si discosti da quella cercata (cioè l'errore della soluzione). L'istruzione di salto permette allora di ripetere il calcolo fintanto che non sia stata raggiunta l'approssimazione desiderata. Il secondo caso in cui un ciclo si rivela utile è quello in cui si desidera ripetere un prefissato numero di volte un certo programma, applicato a dati diversi. Ciò può essere ottenuto se, ogni volta che il ciclo viene ripetuto, vengono anche modificati gli indirizzi nelle istruzioni che si riferiscono a tali dati.

È infatti importante notare che i numeri esprimenti gli indirizzi in un'istruzione possono essere trattati come qualsiasi altro numero, in particolare possono essere modificati con opportune istruzioni, nelle quali gli operandi sono delle istruzioni essi stessi. La possibilità di modificazione delle istruzioni tramite altre istruzioni si rivela come uno dei più potenti strumenti per la programmazione.

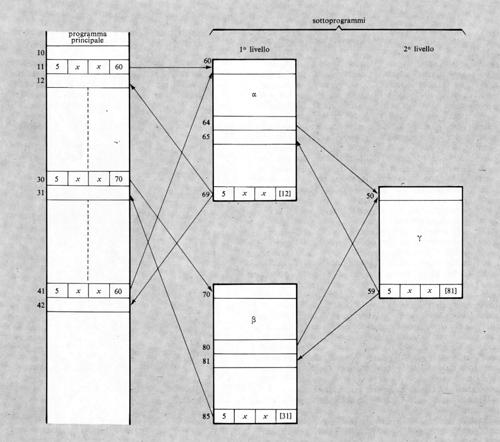

L'altro importante uso dell'istruzione di salto si ha nei cosiddetti ‛sottoprogrammi' o subroutines (v. fig. 4). Si supponga che in un programma vi siano delle elaborazioni (per es. il calcolo di una particolare funzione) che vengono richieste più volte nel corso del programma stesso e in posizioni diverse. Anziché ripetere le relative istruzioni nel programma ogni volta che tale elaborazione viene richiesta, esse vengono scritte una volta sola. Ogniqualvolta nel programma considerato (programma principale) si richiede l'esecuzione di tale gruppo di istruzioni o sottoprogramma, si predispone un'istruzione di salto alla prima istruzione del sottoprogramma (si consideri, nell'esempio, l'istruzione 11 che salta all'istruzione 60, la prima del sottoprogramma α). Una volta eseguito il sottoprogramma, l'ultima istruzione di questo dovrà rinviare di regola all'istruzione successiva a quella che ha provocato il salto.

Poiché un certo sottoprogramma (per es. α nella fig. 4) può essere richiesto in più punti del programma principale, l'ultima istruzione di salto del sottoprogramma (detta anche istruzione di ritorno) dovrà rinviare a un indirizzo di volta in volta diverso (ciò è stato espresso nella fig. 4 segnando tra parentesi quadra tale indirizzo). Con vari metodi, che qui per brevità non si illustreranno, tale indirizzo di ritorno può essere automaticamente determinato sia da opportune istruzioni sia con dispositivi circuitali all'uopo predisposti. Si noti anche che un sottoprogramma può richiedere a sua volta un altro sottoprogramma, come mostra la fig. 4 ove i sottoprogrammi α e β richiedono il γ. I vari sottoprogrammi possono classificarsi in vari ‛livelli' (v. la fig. 4 che mostra sottoprogrammi di 1° e di 2° livello). Il numero di livelli può essere qualsiasi.

Un concetto collegato a quello di sottoprogramma è quello di ‛recursività'. Si ha un calcolo recursivo quando il relativo programma richiama se stesso come sottoprogramma, e ciò avviene per un numero indefinito di livelli.

Quelli precedentemente illustrati sono i concetti più elementari della programmazione degli elaboratori elettronici, che risultano, per quanto detto, macchine capaci di eseguire qualsiasi calcolo che sia stato espresso con una successione di istruzioni, cioè un algoritmo espresso tramite un programma. Il concetto di algoritmo è pertanto fondamentale per la comprensione della natura degli elaboratori.

b) Gli algoritmi e le macchine di Turing

In base a quanto illustrato al precedente punto sui programmi per elaboratori, si può dare dell'algoritmo la seguente definizione: ‟un insieme di istruzioni che definiscono una sequenza di operazioni mediante le quali si risolvono tutti i problemi di una determinata classe".

Qualunque elaborazione che possa essere eseguita da una macchina può definirsi e descriversi come un algoritmo. Diversamente, si può anche dire che tutti gli algoritmi che, allo stato attuale delle nostre conoscenze, possono essere definiti, possono in linea di principio essere eseguiti da una macchina.

Quest'ultima affermazione richiede tuttavia qualche precisazione. Come è noto, le memorie degli elaboratori hanno necessariamente una capacità che, anche se in taluni casi è molto grande (fino a 1012 bits), è comunque sempre finita. Può allora darsi che un algoritmo, benché perfettamente noto e definito, risulti concretamente non realizzabile per la limitazione della memoria. Si dice allora che l'algoritmo è ‛realizzabile potenzialmente' se il risultato viene raggiunto in un numero finito di passi, per quanto grande sia. Lo stesso algoritmo sarebbe cioè realizzabile in una macchina con capacità di memoria illimitata.

Nel 1937 il matematico inglese A. M. Turing dava una definizione del concetto di algoritmo basata su una macchina ideale, che può essere considerata come la semplificazione al massimo grado di un elaboratore elettronico dotato di memoria illimitata. La cosiddetta ‛macchina di Turing' è uno strumento tramite il quale la nozione di algoritmo può essere rigorosamente definita e indagata. È interessante notare come ricercatori diversi abbiano fornito della nozione di algoritmo definizioni diverse, per essere partiti da altri punti di vista; tuttavia le varie definizioni risultarono tra loro equivalenti, nel senso che esse definivano lo stesso concetto. Ciò dimostra il carattere di grande generalità della nozione di algoritmo e di macchina di Turing.

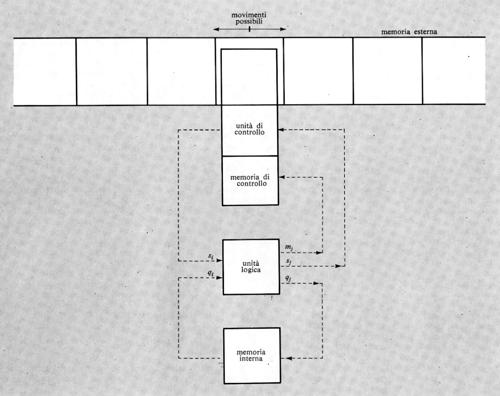

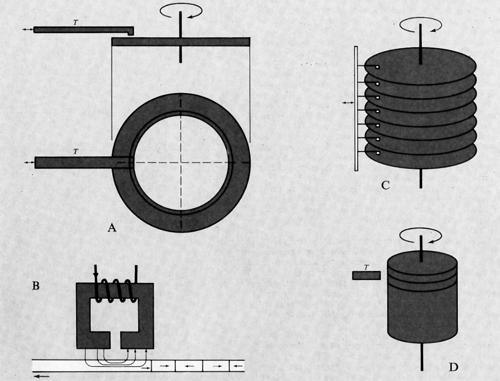

Una macchina di Turing è costituita nel modo seguente (v. fig. 5).

1. Un'unità di memoria, detta ‛memoria esterna', costituita da un nastro illimitato nei due sensi, suddiviso in celle, ciascuna delle quali può contenere uno dei k + 1 simboli s0, s1, ... sk costituenti l'alfabeto ‛esterno'. Per motivi di generalità è conveniente supporre che tra i simboli ve ne sia uno, s0, che sta a indicare ‛cella vuota' e che si suppone registrato in tutte le celle che non contengono altri simboli.

Ogni cella può contenere al massimo un simbolo e l'informazione iniziale nella memoria esterna è costituita da una stringa finita di simboli, non comprendente s0, registrati in celle consecutive del nastro.

2. Un'unità di memoria ‛interna', capace di immagazzinare uno dei simboli q0, q1, ..., qm costituenti l'alfabeto interno'. Tali simboli rappresentano gli stati possibili della macchina (simboli di stato) e uno di essi, q0, sta a indicare lo stato di arresto della macchina.

3. Un'unità di ‛controllo', in grado di leggere il carattere nella cella in esame, di registrare un nuovo simbolo nella stessa cella e di comandare lo spostamento del nastro di una cella in uno dei due versi.

L'unità di controllo è munita allo scopo di una memoria ‛di controllo' nella quale viene immagazzinato uno dei simboli S, D, F detti ‛simboli di movimento', indicanti rispettivamente gli ordini di esame della cella adiacente a sinistra, oppure a destra, oppure della stessa cella.

4. Un'unità ‛logica' avente due ingressi e tre uscite. I due ingressi sono costituiti dal simbolo dell'alfabeto esterno, si contenuto nella cella in esame e letto dall'unità di controllo, e dal simbolo qi contenuto nella memoria interna. Per ogni coppia di valori di ingresso l'unità logica produce una terna di valori in uscita consistenti: 1) nel simbolo sj che deve essere registrato nella cella in esame; 2) nel simbolo qj che deve essere registrato nella memoria interna; 3) nel simbolo di movimento mj per la memoria di controllo.

Il legame stabilito dall'unità logica tra la terna (sj, qj, mj) e la coppia (si, qi) è rappresentabile con una tavola composta da k + 1 righe ed m colonne contenenti agli incroci le terne (sj, qj, mj). Tale tavola è chiamata ‛matrice funzionale' e rappresenta completamente il funzionamento della macchina di Turing.

Tale funzionamento avviene infatti come segue. Innanzitutto la macchina si trovi in una ‛configurazione iniziale'. L'unità di controllo, in base ai valori (si, qi), produce la terna (sj, qj, mj) che porta la macchina in una nuova configurazione, dalla quale essa evolve con lo stesso meccanismo nella successiva e così via.

Se dopo un numero finito di passi la macchina si ferma (avendo trovato il simbolo q0), si dice che la macchina è applicabile' all'informazione contenuta inizialmente sul nastro, che è stata trasformata nell'informazione che si trova sul nastro all'atto dell'arresto.

Se invece la macchina non trova mai l'ordine di arresto q0 e quindi non si ferma mai, si dice che la macchina non è applicabile all'informazione contenuta inizialmente sul nastro.

Diremo anche che una macchina può risolvere una data classe di problemi se essa risulta applicabile all'informazione rappresentante (con una data codificazione) un qualunque problema della classe e se trasforma tale informazione in quella rappresentante la soluzione (nello stesso codice).

Malgrado l'estrema (o voluta) semplicità della macchina di Turing, essa risulta capace (con adatto assegnamento della matrice funzionale) di risolvere problemi di grande complessità, ma la sua importanza non sta ovviamente in tale capacità (per la quale sono molto più convenienti gli elaboratori reali), ma nell'essere uno strumento concettuale che permette di definire rigorosamente gli algoritmi e di ottenere risultati di grande generalità.

Le ricerche finora condotte fanno pensare che qualsiasi algoritmo possa essere realizzato mediante una macchina di Turing. Tale ipotesi viene detta ‛ipotesi fondamentale della teoria degli algoritmi' e l'accettarla significa che si considera la teoria degli algoritmi coincidente con la teoria della macchina di Turing. Pertanto il problema relativo all'esistenza di un algoritmo per risolvere una certa classe di problemi può ridursi alla ricerca o alla dimostrazione dell'esistenza di una macchina di Turing.

Si è già detto come siano state date altre definizioni equivalenti della nozione di algoritmo.

Il concetto di macchina di Turing può essere esteso a quello di macchina di Turing universale, capace di simulare il funzionamento di una macchina di Turing dotata di una matrice funzionale qualsiasi. Ciò viene ottenuto registrando in forma codificata la matrice funzionale data sul nastro della macchina universale definita da una matrice funzionale in grado d'interpretare qualsiasi matrice funzionale registrata nella sua memoria. La sua importanza è dovuta al fatto che essa è paragonabile a un elaboratore capace di interpretare un qualsiasi programma. Ne discende anche che un programma qualsiasi può essere pensato come una macchina per risolvere una data classe di problemi.

Tra i risultati concettualmente importanti della teoria della macchina di Turing si citerà qui quello relativo all'esistenza di problemi non risolubili per via algoritmica, per il quale si rimanda alla letteratura.

5. Elaboratori e linguaggi

Si è già fatto notare come la nozione di linguaggio, insieme a quella di algoritmo, sia di carattere fondamentale per la comprensione degli elaboratori.

Come risulta dall'esposizione storica, i linguaggi per elaboratori (o linguaggi artificiali) furono inizialmente introdotti per ragioni di ordine pratico, e furono le stesse ragioni che indussero a porre il problema della definizione dei linguaggi e della costruzione dei relativi traduttori su basi teoriche sicure, proprio allo scopo di evitare gli inconvenienti, pratici oltre che concettuali, delle primitive impostazioni.

L'importanza del linguaggio, in generale, deriva dal fatto che con esso noi comunichiamo ai nostri simili l'informazione e, in definitiva, il nostro pensiero. Per tale motivo, a cominciare dal secolo scorso, i linguaggi divennero oggetto di indagini filosofiche. Pertanto, così come la teoria degli algoritmi collega il tema degli elaboratori alla logica e alla matematica moderna, la teoria dei linguaggi stabilisce un collegamento con le scienze filosofiche e umane.

Nella teoria dei linguaggi non vi è limite inferiore alla complessità di un linguaggio: un insieme molto semplice di segni e regole di combinazione può pertanto legittimamente chiamarsi linguaggio.

La teoria dei linguaggi o semiotica (teoria dei segni), si compone di tre principali capitoli, che rappresentano diversi livelli d'indagine: 1) la sintassi; 2) la semantica; 3) la pragmatica.

1. La sintassi riguarda le regole per la costruzione di stringhe di simboli rispondenti a regole assegnate, senza riguardo al loro significato e alle motivazioni del linguaggio. Le regole di combinazione dei simboli (in parole, frasi e testi) nel caso ideale sono perfettamente note e prive di eccezioni: pertanto la verifica di correttezza formale sintattica di un testo può essere effettuata tramite un algoritmo, cioè automaticamente.

2. La semantica attiene al significato dei simboli e delle loro costruzioni. La verifica di correttezza semantica costituisce un problema di grande difficoltà. Si tratta infatti di verificare se le relazioni espresse dalle espressioni del linguaggio considerato siano conformi alle relazioni che si volevano descrivere tra gli oggetti cui il linguaggio è applicato. Un insieme di regole valide per la determinazione del significato di un testo può essere stabilito solo per linguaggi artificiali; su tale punto si ritornerà.

3. La pragmatica considera gli scopi per cui il linguaggio è concepito. Nel campo dei linguaggi naturali l'indagine inizia col considerare come un linguaggio viene usato e successivamente ne studia la sintassi. Nel caso dei linguaggi artificiali per elaboratori si è spesso portati a iniziare dalla definizione formale della sintassi, ma in realtà è proprio dalla pragmatica che si deve cominciare affinché siano preventivamente definiti gli scopi per cui un linguaggio viene costruito.

Come esempio di quanto detto, nel linguaggio dell'algebra, un'espressione corretta sintatticamente è la seguente: a − (bc + d), mentre un'espressione non corretta sarebbe per esempio: a) bc + (d. Due espressioni sintatticamente corrette sono pure le seguenti: A = a2 e A = a5; una sola, la prima, è semanticamente corretta se l'espressione vuole esprimere l'area di un quadrato.

Una peculiare difficoltà che emerge nello studio dei linguaggi è data dal fatto che nel discorrere di un linguaggio si adopera un linguaggio: quest'ultimo viene chiamato ‛metalinguaggio' e le sue espressioni devono essere chiaramente distinte da quelle del linguaggio per cui viene usato. Per rendere chiara tale distinzione potrebbe essere conveniente usare un altro alfabeto oppure, più praticamente, ricorrere a qualche segno speciale (sottolineature, virgolette) per individuare le espressioni del linguaggio di cui si parla.

Per parlare del metalinguaggio si richiederebbe un metametalinguaggio, o un metalinguaggio di secondo livello, e così via.

Per porre un limite al livello dei metalinguaggi occorrerebbe un metalinguaggio che potesse definire se stesso senza ambiguità. La questione è tuttora aperta ed è inevitabile oggi adottare il linguaggio naturale come metalinguaggio finale.

È opportuno ora commentare brevemente il concetto di informazione e la sua classificazione.

6. Classificazione dell'informazione

Al livello sintattico la rappresentazione dei simboli di un alfabeto in un elaboratore è risolta tramite la codificazione, di cui si dirà successivamente, e tale problema non presenta difficoltà concettuali notevoli.

Il problema della semantica dell'informazione codificata è invece notevolmente più complesso e a tale riguardo è opportuno distinguere tra i seguenti tipi d'informazione.

a) Informazione numerica o algebrica

Una stringa di cifre estratte dall'alfabeto corrispondente a una data base (2, 8, 10, 12, 16, ecc.) costituisce una parola numerica la cui interpretazione è legata alla posizione di ciascuna cifra rispetto alla virgola. Così pure si può costruire una stringa di caratteri alfabetici e di simboli di operazioni in modo non ambiguo, nel linguaggio dell'algebra o della logica, come: (a + b) : c; (x > y) ⋀ (z = 1) ecc.

Espressioni numeriche, algebriche e logiche sono ben note come mezzo per la descrizione di algoritmi e il procedimento di formalizzazione della semantica in relazione a tale descrizione è basato su convenzioni oramai universalmente accettate e pertanto non ambigue. Si può addirittura affermare che, nel caso dell'informazione qui considerata, il problema semantico è ridotto alle regole elementari dell'aritmetica e della logica e che tutta la semantica della matematica può ridursi alla stessa sintassi.

b) Informazione fisica

È noto come ogni grandezza fisica si possa rappresentare come il prodotto di un valore numerico e di una dimensione o corrispondente unità. L'indicazione di tali dimensioni risolve completamente il problema semantico dell'informazione fisica, nel senso che, una volta scelto un sistema di unità di misura (per es. quello internazionale), l'elaborazione dell'informazione fisica si riduce a elaborazioni di grandezze numeriche o algebriche.

Quanto sopra spiega come l'applicazione degli elabora- tori ai problemi matematici e fisici sia avvenuta senza sostanziali difficoltà interpretative.

c) Informazione strutturata o modulare

Indichiamo così quell'informazione la cui interpretazione è determinata dalla posizione dell'informazione stessa rispetto ad altre informazioni a essa associate.

Come esempio, in un'istruzione di macchina come quella della tab. I, la prima cifra denota l'operazione, la seconda coppia di cifre l'indirizzo di un operando, ecc. È importante notare che l'informazione utilizzata nelle applicazioni amministrative può considerarsi di tipo strutturato: infatti i vari libri o registri sono costruiti come moduli, ove ogni campo stabilisce anche il significato dell'informazione che vi verrà registrata. Il problema semantico delle informazioni amministrative può dunque considerarsi preventivamente risolto dalle convenzioni adottate nei moduli in uso per le varie applicazioni.

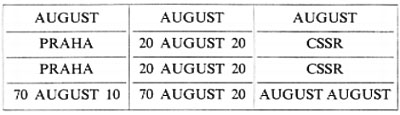

La conoscenza delle definizioni semantiche dei vari campi di un modulo è indispensabile, per quanto detto, per l'assegnamento del significato dell'informazione registrata e senza tale conoscenza possono sorgere problemi praticamente insolubili, come mostra il seguente esempio (v. Zemanek, 1973):

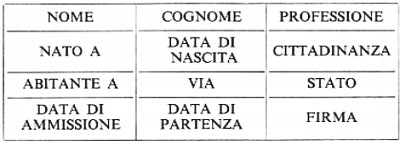

L'informazione contenuta nel quadro sarebbe difficilmente comprensibile se non si sapesse che essa è relativa a un modulo di polizia di frontiera, modulo che specifica la semantica dei vari campi come segue:

(e se non si sapesse che in lingua ceca august significa clown).

Un altro esempio è dato dai moduli di censimento ove sono spesso contenuti, a chiarimento del significato dei vari campi (per es. domicilio, professione ecc.), dettagliate delucidazioni intese a risolvere completamente (nella speranza dell'estensore) il problema semantico.

Il problema semantico dell'informazione strutturata può considerarsi risolto in quei casi in cui una lunga consuetudine ha condotto alle necessarie convenzioni interpretative, ma in campi ove tali convenzioni non si siano stabilizzate il problema rimane irrisolto. Si consideri l'esempio di informazioni di tipo statistico per l'importazione e l'esportazione e il vantaggio di utilizzare una stessa informazione per vari tipi d'indagine statistica, non tutti però prevedibili al momento della formulazione dei moduli. Si verifica facilmente il caso d'impossibilità di attribuire significati corretti per l'indagine statistica voluta. Si consideri il caso del vitello. È a tutti noto che un vitello è una mucca giovane. Sembrerebbe dunque che, una volta convenuta una certa età, il problema delle statistiche sui vitelli sia risolto. Ma in realtà così non è. Infatti con vitello noi indichiamo anche un tipo di carne, che però non è semplicemente la carne di un vitello, ma di un vitello che sia stato nutrito con latte e non con erba. Risulta così insufficiente il parametro età e il problema si complicherebbe ulteriormente se si volesse discutere sulle parti dell'animale che sono propriamente da considerarsi vitello, nel senso di carne di vitello.

Si vede dunque come l'elaborazione dell'informazione non puramente numerica o fisica incontri gravi difficoltà, non appena si voglia affrontare il problema dell'uso dell'informazione al di fuori di campi ben definiti e per i quali la semantica è stata accuratamente predisposta.

La pratica costituzione di banche di dati (quelle di tipo statistico sono un esempio notevole), nelle quali una certa informazione può venire associata ad altre in modo arbitrario e imprevedibile, è condizionata a un'attenta valutazione e accurata soluzione del problema semantico dell'informazione strutturata.

d) Testi in linguaggio naturale

Le informazioni espresse in linguaggio naturale presentano il massimo delle difficoltà. Lo dimostra il sostanziale fallimento dei diversi tentativi fatti per realizzare la traduzione automatica delle lingue. Fiumi di inchiostro sono stati versati sull'argomento, per la sua importanza concettuale e pratica, ma si deve oggi riconoscere che una traduzione soddisfacente non può essere ottenuta dalle macchine per l'enorme e imprevedibile massa di relazioni che nel linguaggio naturale si stabilisce non solo tra le parole, ma anche con l'ambiente in cui il discorso è fatto.

Si racconta che V. Hugo, dopo aver affidato a un editore un suo romanzo, ansioso di conoscerne l'accoglienza da parte dei lettori, scrisse all'editore una lettera composta di un solo simbolo: un punto interrogativo. La risposta consisté in una lettera contenente anch'essa un solo simbolo: un punto esclamativo, e fornì allo scrittore tutta l'informazione che attendeva. È chiaro che nessuna macchina potrebbe tradurre tali lettere, la cui semantica è determinata da una situazione esterna che supera di gran lunga la simbologia e che semmai dimostra le straordinarie capacità di associazione della mente umana. Tutte le esperienze raccolte nello studio del linguaggio naturale mostrano che la sua semantica è ben al di là di un insieme di regole meccanizzabili: essa, come mezzo principe per l'espressione di una cultura, non è trasferibile a una macchina.

e) Testi in linguaggi artificiali

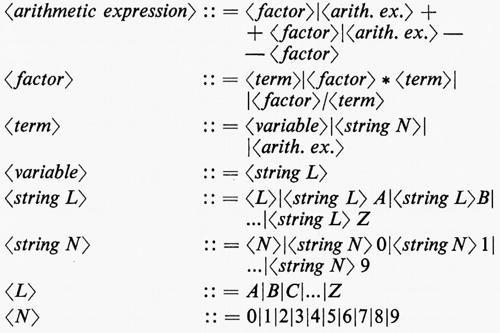

Sono quelli costruiti coi linguaggi di programmazione. La loro definizione sintattica rappresenta il problema più facile. Il metodo più usuale (proposto dal matematico americano J. Backus e utilizzato sistematicamente per la prima volta nella definizione del linguaggio ALGOL) consiste nel fornire un insieme di regole per la costruzione di frasi ‛ben strutturate'. Un sistema completo di tali regole è chiamato ‛grammatica generativa' (Backus normal form). Vedasi per esempio:

La suddetta ‛grammatica' definisce (:: =) in modo del tutto generale una <espressione aritmetica> come: un <fattore>, oppure (∣) una <espressione aritmetica> seguita dal segno + seguito da un <fattore>, oppure una <espressione aritmetica> seguita dal segno − seguito da un − <fattore>. La definizione 〈fattore> successiva esprime un − <fattore>, e così via fino ai caratteri terminali, alfabetici (L) e numerici (N).

La definizione formale della semantica presenta invece gravi difficoltà. Un metodo di notevole interesse, applicato alla verifica semantica del linguaggio PL/I, consiste nella definizione e nell'uso di una macchina astratta, che elabora testi nel linguaggio considerato e che, partendo da uno stato iniziale, evolve attraverso una serie di stati fino a raggiungere lo stato finale. L'osservazione della sequenza di stati causata da un dato testo permette all'osservatore umano di constatare il significato del testo e di compiere tutte le verifiche necessarie per l'analisi semantica.

Lo sviluppo dell'elaboratore come macchina universale dipende, per quanto detto, in larga misura dai progressi della teoria dei linguaggi, in particolare per quel che riguarda la loro definizione formale. Potremo probabilmente risolvere soddisfacentemente i problemi dell'informazione strutturata, in modo da rendere possibile un sicuro uso di banche di dati generalizzate, ma sarà forse impossibile definire formalmente la sintassi e la semantica del linguaggio naturale: molti argomenti inducono a pensare che non vi possa essere algoritmo di verifica semantica.

L'elaboratore, per contro, è un sistema non naturale, ma costruito, cui si applicano bene linguaggi artificiali. Il vero problema sarà quello della comunicazione tra mondo naturale, uomo e sistemi artificiali, la cui efficacia come strumenti di elaborazione è strettamente legata al rigore delle definizioni formali. L'elaboratore non potrà rimpiazzare l'uomo, che è meno sistematico ma è molto di più di un automa e può controllare e decidere sul significato di ciò che vuole o fa. In definitiva, il problema dello sviluppo dell'informatica sarà principalmente quello di determinare la più adatta combinazione di strutture di elaborazione artificiali con la capacità umana.

7. La codificazione dell'informazione

Come detto, un elaboratore elettronico può considerarsi come una macchina per la manipolazione (sostituzione) di simboli, tramite i quali si intende rappresentare l'informazione.

Per ragioni di carattere tecnologico, d'altronde, è conveniente che i circuiti destinati a elaborare l'informazione siano semplificati al massimo grado e la massima semplificazione si ottiene costituendoli in modo che essi elaborino due soli simboli, rappresentati da due valori di una qualsiasi grandezza (tensione o corrente elettrica, flusso magnetico ecc.). Tali simboli (detti bits) possono rappresentarsi con H (per high) e L (low), oppure con 0 e 1. Dato che i simboli degli alfabeti usati per la rappresentazione esterna sono più di due, si deve preliminarmente risolvere il problema della rappresentazione dei simboli dell'alfabeto esterno con i due soli dell'alfabeto interno, il che si ottiene con un'operazione di ‛codificazione', che fa corrispondere una disposizione di bits a ciascun simbolo esterno. Poiché con n bits si possono avere 2n disposizioni, altrettanti saranno i simboli esterni codificabili con n bits. In altre parole, se N è il numero di simboli esterni, n dovrà essere maggiore del log2 N.

Poiché, inoltre, la corrispondenza tra disposizioni e simboli è arbitraria, si potranno definire numerose diverse codificazioni con lo stesso numero di bits.

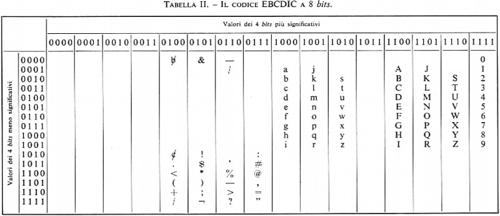

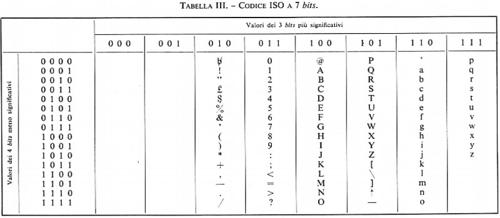

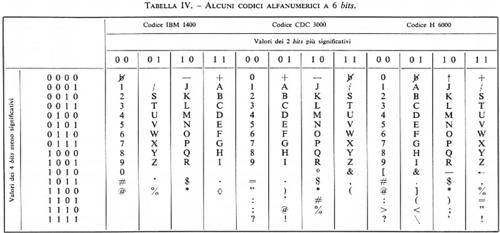

Le tabelle II, III e IV mostrano codici a 8, 7 e 6 bits rispettivamente, per caratteri alfabetici, numerici e speciali.

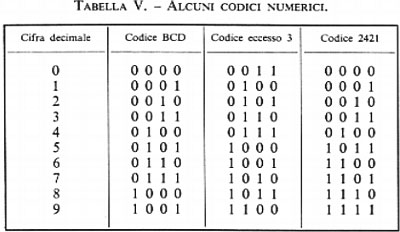

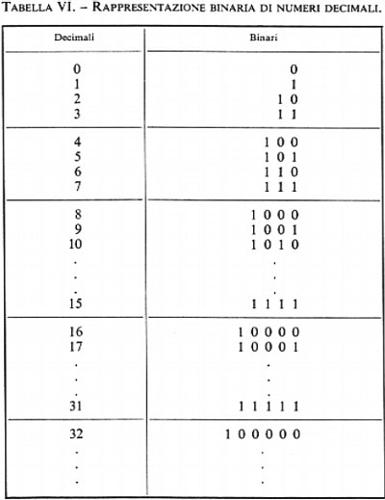

Nel caso che l'informazione da codificare sia puramente numerica, si possono seguire due strade distinte. Con la prima si codificano i 10 caratteri numerici (e i segni +,−) e per tale scopo occorre un minimo di 4 bits: la tab. V mostra alcuni codici numerici. La seconda strada consiste nell'adottare la numerazione binaria per la rappresentazione del numero dato (espresso in forma decimale): in tal caso non vi è più corrispondenza tra ciascuna cifra decimale e gruppi di bits, ma è il numero nel suo complesso che viene codificato dal gruppo di bits costituenti il numero binario equivalente a quello dato. La tab. VI rappresenta la corrispondenza tra i primi numeri della serie naturale espressi in decimale e in binario.

È importante notare che nella codificazione di simboli alfanumerici si usa spesso un numero di bits maggiore di quello strettamente necessario, come mostrano le tabb. II e III: in questo caso molte delle 2n disposizioni possibili con n bits non corrispondono a nessun simbolo. Tale ridondanza è spesso voluta allo scopo di conferire al codice proprietà di rivelazione o di autocorrezione di errori nella trasmissione: la teoria dell'informazione fornisce gli strumenti concettuali per tale problema, e a essa si rimanda il lettore.

a) L'elaborazione dell'informazione codificata

Per quanto detto, tutta l'informazione di un elaboratore è rappresentata in forma codificata binaria. Per la comprensione dei circuiti destinati a questa elaborazione è pertanto importante illustrare i tipi di elaborazione che su tale informazione si possono eseguire.

Informazione numerica. - Le elaborazioni che su tale in- formazione possono eseguirsi sono tutte quelle necessarie per l'esecuzione di calcoli. Le più semplici elaborazioni risultano essere quelle aritmetiche e tra queste le più elementari sono l'addizione e la sottrazione. La moltiplicazione e la divisione sono le operazioni di complessità immediatamente superiore ed è noto come esse possano ottenersi con un'opportuna successione di addizioni e sottrazioni, rispettivamente. Si osservi anzi come l'usuale metodo per l'esecuzione della divisione richieda anche un'operazione di confronto tra due numeri, per determinarne l'uguaglianza o la disuguaglianza (e, in tal caso, quale dei due sia il maggiore).

È ben noto dal calcolo numerico come qualsiasi calcolo, in particolare la determinazione di qualsiasi funzione, possa ottenersi con una successione di operazioni aritmetiche e di confronto (cioè un ‛programma'). Il calcolo di ‛funzioni' può per esempio essere ottenuto sia tramite consultazione di tabelle (per cui è fondamentale l'operazione del confronto), sia tramite espressioni razionali che approssimano la funzione voluta con errori noti e che possono calcolarsi con operazioni aritmetiche.

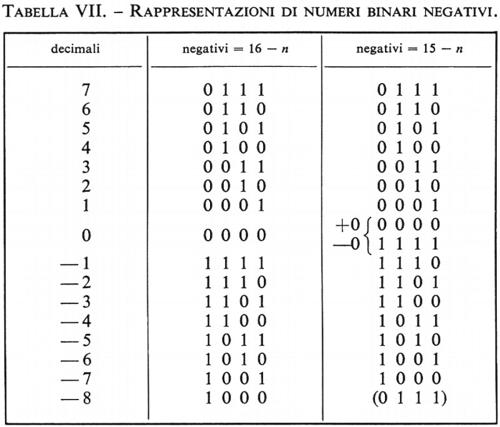

Per tali motivi, le operazioni elementari di addizione e di sottrazione nonché quella di confronto sono alla base di qualsiasi calcolo e sono pertanto presenti in qualsiasi cal- colatore. Un'ulteriore semplificazione è possibile osservando che è molto importante che le operazioni di somma e differenza eseguite da un calcolatore risultino di tipo algebrico: in tal caso la differenza può ridursi alla somma dopo aver cambiato il segno al sottraendo. Inoltre, con opportuna scelta del modo di rappresentazione dei numeri negativi, le operazioni di addizione e sottrazione possono ridursi alla sola operazione di addizione. Ciò può essere ottenuto rappresentando i numeri col metodo dei ‛complementi'. Si considerino numeri di n bits e si convenga di rappresentare il negativo negA di un intero positivo A, supposto inferiore a 2n-1, col suo complemento a 2n oppure a 2n−1. Si ha allora:

negA → 2n − A (complemento a 2n)

negA → (2n−1) − A (complemento a 2n−1).

La tab. VII mostra tali rappresentazioni per n = 4. Si noti che il primo bit può sempre considerarsi come rappresentante il segno del numero.

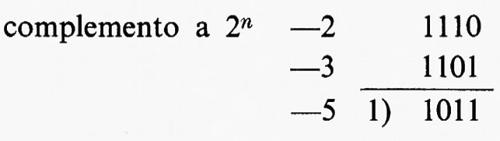

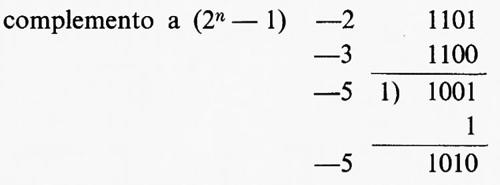

Si può mostrare che, con tali rappresentazioni, la somma algebrica si riduce sempre a una sola operazione di somma binaria dei due addendi, interpretando il bit di segno come una cifra binaria, con le seguenti regole: 1) nel caso del complemento a 2n si trascura il riporto eventualmente generato nella somma dei bits di segno; 2) nel caso del complemento a (2n − 1) tale riporto viene addizionato ‛in coda', come mostrano i seguenti esempi:

Le operazioni di divisione e di moltiplicazione possono essere ottenute coi metodi noti, con ripetute addizioni e sottrazioni rispettivamente. In tal modo, la durata di queste operazioni risulta notevolmente maggiore di quella delle addizioni. Si può ridurre tale durata con metodi vari, alcuni dei quali tendono a ridurre il numero delle addizioni necessarie, altri ottengono invece il risultato con una sola operazione che può essere realizzata circuitalmente in modo da ottenere l'esecuzione del prodotto in un tempo di poco superiore a quello della somma.

b) Rappresentazione dei numeri in forma ‛normalizzata' (floating-point)

Nell'esecuzione manuale di calcoli numerici si ha l'abitudine di tenere conto della posizione delle virgole adottando come fattori potenze di dieci, che equivalgono al numero di spostamenti della virgola stessa necessari a ottenere un numero che non sia né troppo più piccolo né troppo più grande dell'unità. Se non si facesse ciò, s'incorrerebbe in inconvenienti pratici quando, per esempio, si richiedesse un eccessivo numero di zeri dopo la virgola prima delle prime cifre significative.

Se non si adottasse la stessa soluzione nelle rappresentazioni numeriche degli elaboratori, considerando cioè le virgole in posizione predeterminata e fissa, si incorrerebbe in inconvenienti anche peggiori poiché, dato che il numero di bits assegnati a ogni numero non può essere troppo grande, si finirebbe col perdere in precisione dovendo trascurare qualcuna o addirittura tutte le cifre significative.

A tali inconvenienti si può rimediare con una rappresentazione simile a quella prima illustrata, come mostrano i seguenti esempi:

+3.277,53 = +0,327753 × 104 che si scrive:

+327753 + 4

−0,000085234 = −0,85234 × 104 che si scrive:

−85234 − 4.

Tale rappresentazione è oggi comunemente utilizzata anche in alcuni calcolatori elettronici ‛tascabili' per uso scientifico.

Informazione alfabetica. - Nel caso di informazione alfabetica codificata, non hanno ovviamente significato le operazioni aritmetiche, mentre assume grande importanza quella di confronto. Si ricordi infatti come in questo caso l'elaboratore debba essere pensato essenzialmente come una macchina per il riconoscimento, la sostituzione e la memorizzazione di simboli. Per l'esecuzione di tali funzioni generali si rivela essenziale l'operazione del riconoscimento di uguaglianza di due simboli.

Risulta inoltre di grande utilità pratica la possibilità del confronto tra due simboli per determinare, oltre che l'uguaglianza, le relative posizioni nell'alfabeto considerato ove essi sono convenzionalmente ordinati (si pensi all'operazione del mettere in ordine alfabetico dei nomi di persona, come frequentemente può essere richiesto nelle applicazioni amministrative). Tale operazione di ordinamento può essere eseguita o con il confronto di ogni simbolo dato con la tabella ordinata dell'alfabeto (con l'uso ripetuto della determinazione dell'uguaglianza) oppure con il confronto dei due simboli come se fossero numeri binari (ciò richiede che il codice sia come quello delle tabb. II, III e IV), in modo che il loro ordinamento come numeri binari coincida con l'ordinamento alfabetico corrente.

8. I principî della teoria delle reti logiche o binarie o di commutazione

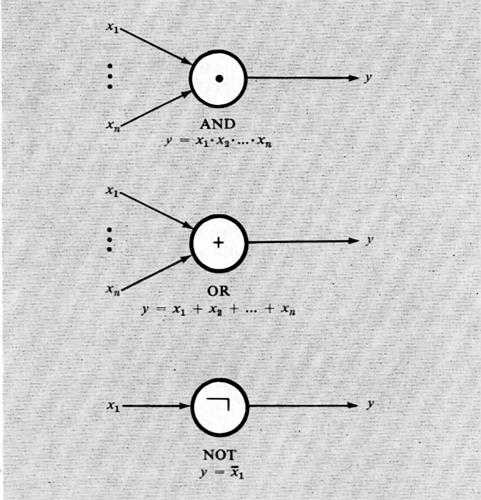

È stato illustrato come convenga che le informazioni in un elaboratore elettronico siano in forma binaria e si è anche discusso su alcuni principî relativi alla loro elaborazione. Allo scopo di disporre di uno strumento concettuale che sia di ausilio nella progettazione delle reti elettriche che ottengono le elaborazioni volute, è opportuno prescindere per il momento dall'effettiva realizzazione elettrica (che verrà studiata in seguito) definendo in modo astratto degli enti capaci di elaborare informazioni binarie, cioè le reti logiche o binarie.

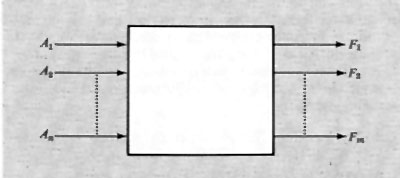

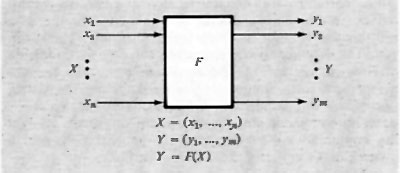

Una prima considerazione generale sulle reti binarie (dette anche ‛di commutazione') può essere fatta con riferimento alla dipendenza che una certa rete stabilisce tra variabili binarie d'ingresso e variabili d'uscita (prodotte cioè dalla rete; v. fig. 6). Tale dipendenza può esprimersi come funzione, scrivendo:

F1=F1(A1, A2, ...An).

Esiste una fondamentale distinzione tra due tipi di rete, in relazione a tale dipendenza. La rete può infatti essere tale che la F1 dipenda dal valore assunto in un certo istante dalle variabili d'ingresso e sia indipendente dai valori che esse possono aver assunto precedentemente, oppure può anche dipendere da questi ultimi valori.

Nel primo caso si dice che la rete è di tipo ‛combinatorio', nel secondo che è di tipo ‛sequenziale'. Si può dire, con altre parole, che le reti sequenziali, contrariamente alle reti combinatorie, conservano memoria dell'evoluzione delle variabili d'ingresso.

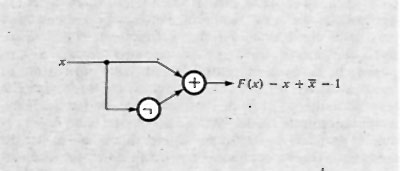

Considerando ora le reti combinatorie, si è portati a indagare sulle proprietà delle funzioni che le descrivono. La più semplice funzione è quella di una sola variabile, A, che fa corrispondere 0 a 1 e viceversa, ed è nota come ‛negazione' o funzione NOT. Essa si scrive:

F = Ā

Tra le funzioni di due o più variabili alcune assumono significati particolari, anche perché sono realizzabili facilmente in forma circuitale.

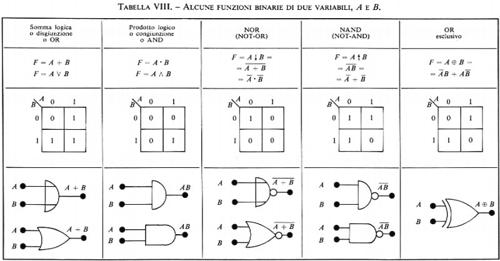

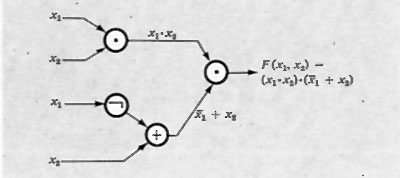

Le più importanti funzioni di più variabili sono rappresentate nella tab. VIII, insieme ai simboli grafici e alle loro espressioni.

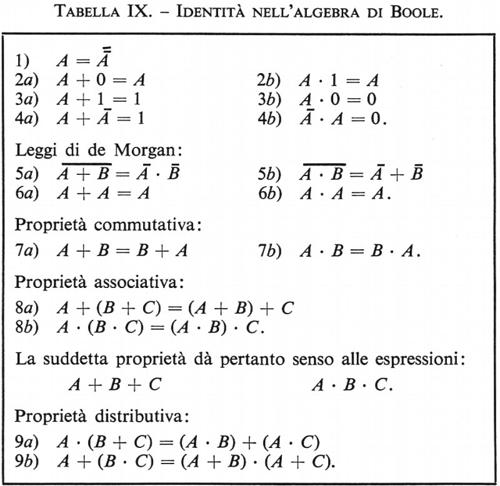

La manipolazione di tali espressioni si effettua in base alla cosiddetta ‛algebra di Boole', della quale sono fornite nella tab. IX le identità fondamentali.

Il problema fondamentale nella teoria delle funzioni ‛combinatorie' può definirsi come segue: assunta una o più funzioni da considerare come funzioni elementari e assegnata una funzione arbitraria (per es. per mezzo di una tabella), esprimere tale funzione con l'uso esclusivo delle funzioni elementari.

Si può mostrare che ‛insiemi minimi' di funzioni elementari sono costituiti da: negazione e disgiunzione; negazione e congiunzione; NOR; NAND. Naturalmente gli insiemi di funzioni elementari possono comprendere altre funzioni; per esempio, la negazione e la congiunzione possono essere usati in luogo della disgiunzione.

Il problema illustrato è fondamentale per il progetto delle ‛reti combinatorie' che realizzano un'assegnata funzione, e la scelta delle funzioni elementari è allora suggerita dalla loro realizzabilità con circuiti elettronici. Più avanti si illustreranno le più importanti realizzazioni delle funzioni elementari con vari tipi di circuito.

Si può mostrare che un'assegnata funzione può essere espressa in varie forme con l'impiego di date funzioni elementari. Assume allora grande importanza il problema di scegliere quella forma che, realizzata con un determinato tipo di circuito, presenti il costo totale minimo.

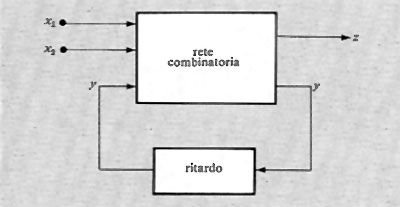

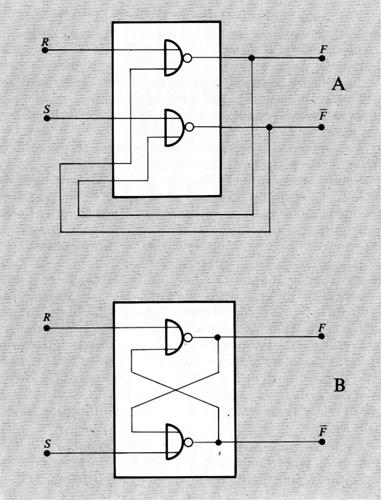

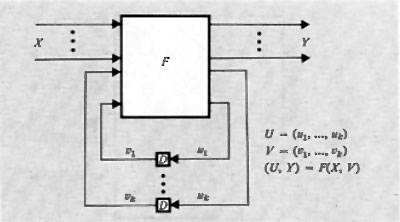

Le ‛reti sequenziali' possono essere schematizzate in relazione a varie modalità di funzionamento. Lo schema concettualmente più interessante è quello corrispondente a una rete funzionante nel ‛modo fondamentale' (v. fig. 7). Questo schema mette in evidenza come una rete sequenziale possa essere schematizzata con una rete combinatoria nella quale un certo numero di ingressi è collegato con altrettante uscite. Tali collegamenti rendono conto delle capacità di memoria proprie delle reti sequenziali. I ritardi segnati in figura rappresentano anche i ritardi eventualmente presenti nelle stesse reti combinatorie, di modo che la rete sequenziale risulta funzionare, nello schema, in modo ideale, cioè senza ritardi propri.

Per la teoria delle reti sequenziali si rimanda alla letteratura. Qui basterà dire che il numero degli stati interni possibili in una rete sequenziale (numero che misura la sua capacità di memorizzazione) è determinato dal numero delle variabili y, dette variabili secondarie o interne.

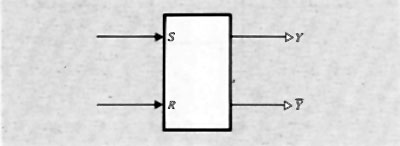

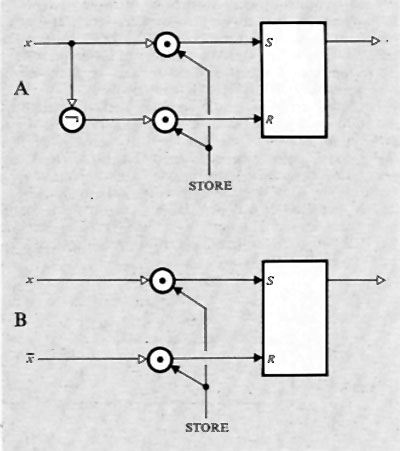

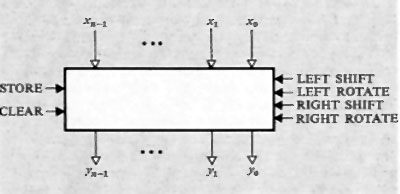

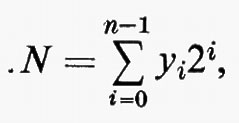

Nella fig. 8 è rappresentato lo schema della più elementare rete sequenziale usata negli elaboratori e cioè il ‛bistabile' o flip-flop capace di memorizzare un bit, il cui valore può essere modificato agendo con segnali opportuni alle entrate.

Gli strumenti della teoria della comunicazione permettono lo studio dal punto di vista logico (ma non elettrico) di tutte le reti usate negli elaboratori, in particolare permettono il progetto di reti che compiano operazioni assegnate in vista delle elaborazioni volute.

9. L'evoluzione della tecnologia dei circuiti elettronici binari

Si è già detto come l'adozione della codificazione binaria negli elaboratori elettronici sia dovuta alla necessità di utilizzare circuiti elettronici di massima semplicità, allo scopo di poter costruire sistemi di grandissima complessità ma con funzionamento sufficientemente sicuro. Ciò viene ottenuto con circuiti in cui per esempio un transistore funziona semplicemente come interruttore, interrompendo o permettendo la circolazione della corrente in un circuito e facendo corrispondere ai due stati di funzionamento lo 0 e l'1 della codificazione binaria.

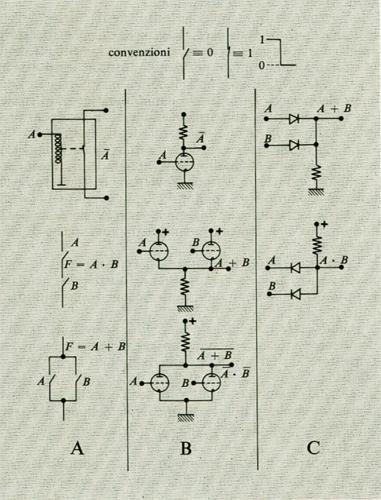

Le operazioni logiche elementari, con le quali si costruiscono i sistemi di calcolo, possono essere ottenute con varie tecnologie. Il primo dispositivo usato, di tipo elettrico, è stato, com'è noto, il relè, nel quale la chiusura e l'apertura di contatti viene ottenuta con un elettromagnete: la sua modesta velocità (i ritardi introdotti da un relè possono essere al minimo di circa 1 ms) ne ha giustificato la sostituzione con i tubi elettronici a vuoto (che possono ottenere risultati equivalenti in tempi di pochi microsecondi) per la costruzione di elaboratori più veloci e più sicuri (per l'assenza di parti in movimento). I tubi a vuoto in unione con diodi (a vuoto inizialmente, a semiconduttore dopo il 1953) sono stati gli elementi di base per la prima generazione di elaboratori.

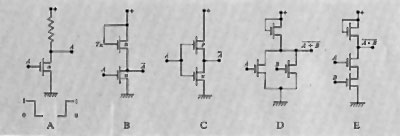

La flg. 9 mostra gli schemi di alcuni circuiti logici elementari del tipo finora considerato.

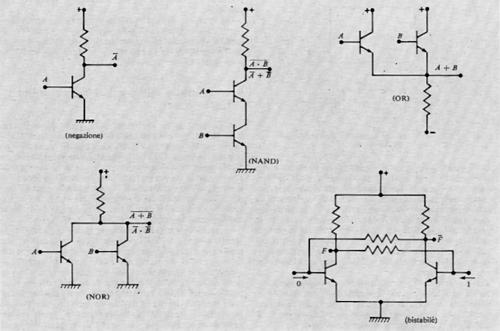

L'avvento dei transistori ha fatto presto intravedere in essi un elemento ideale per la costruzione degli elaboratori. Infatti il transistore si presta a essere usato in circuiti simili ai circuiti a tubi, è molto più piccolo, consuma meno energia e ha una vita utile e un'affidabilità molto maggiori del tubo elettronico. I transistori hanno caratterizzato, insieme alle memorie a nuclei magnetici e ai linguaggi di programmazione, la seconda generazione di elaboratori.

La fig. 10 mostra gli schemi di alcuni circuiti logici elementari. Sono stati molto usati circuiti logici misti, per esempio a diodi e transistori. L'evoluzione della tecnologia dei semiconduttori ha condotto (1963 circa) ai circuiti integrati che caratterizzano la terza generazione di elaboratori insieme alla tecnica di multiprogrammazione e di time sharing.

Le tecniche dei semiconduttori e dei circuiti integrati sono illustrate nell'articolo elettronica al quale si rimanda il lettore. Qui si illustrano le caratteristiche dei circuiti logici ottenuti con tali tecniche.

È noto come le tecniche dei circuiti integrati permettano di ottenere non più soltanto un singolo componente (un transistore, un diodo) ma un intero circuito logico su una piastrina di semiconduttore (silicio). I circuiti integrati hanno pertanto esaltato le caratteristiche di piccole dimensioni, di basso consumo e di grande affidabilità dei precedenti circuiti, permettendo la costruzione di sistemi sempre più complessi.

La tendenza a integrare su un solo dispositivo circuiti sempre più grandi (fino a migliaia di componenti elementari come i transistori) è tuttora in atto, e a essa si dà il nome di Large Scale Integration (LSI) o ‛integrazione in grande'. Prima di discutere le tendenze di tale evoluzione e le prevedibili conseguenze, si illustreranno brevemente i tipi principali di circuiti logici integrati.

Nei primi dispositivi integrati si è cercato di riprodurre i tipi di circuiti logici già noti, dando origine alle famiglie di circuiti come la Resistor Transistor Logic (RTL) e la Diode Transistor Logic (DTL).

La prima è basata sui circuiti del tipo di quelli illustrati nella fig. 10, mentre la seconda utilizza circuiti e diodi per l'operazione di prodotto o somma logici e il transistore per l'operazione di negazione.

La famiglia RTL è stata abbandonata per prima e la stessa sorte è più tardi toccata alla famiglia DTL.

Sono state infatti nel frattempo individuate strutture circuitali che meglio si adattano alle tecniche di integrazione, permettendo di ottenere circuiti che occupano minori aree sulle piastrine di silicio e offrono perciò i vantaggi di un minor costo e di più elevate velocità di funzionamento.

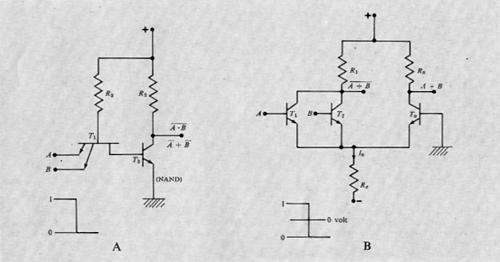

Appartiene a tale categoria di circuiti la famiglia nota come Transistor Transistor Logic (TTL), il cui schema fondamentale è rappresentatò nella fig. . La caratteristica principale è data dal transistore T1 dotato di più emettitori, che è molto facile da costruire con la tecnica ‛planare' (v. elettronica). Allorquando uno dei due morsetti d'ingresso (A, B) è a potenziale basso (0), il transistore T1 è portato in saturazione e di conseguenza il transistore T2 viene bloccato, ottenendo cosi al collettore di T2 un potenziale alto (1). Ciò può essere descritto con una funzione logica A NAND B, cioè A̅ • B̅, come segnato in figura.

Una seconda famiglia di nuovi circuiti integrati, caratterizzata da una velocità di funzionamento superiore a quella delle precedenti, è nota come Emitter Coupled Logic (ECL) e anche Current Mode Logic (CML); il suo schema fondamentale è rappresentato nella fig. 11B. In tale circuito la base del transistore T0 è sempre a potenziale nullo e nel resistore Re si suppone circolante una corrente costante. Tale corrente circolerà tutta in T0 se T1 e T2 saranno bloccati (A = B = 0), mentre ‛verrà deviata in R1 se saranno in conduzione (A = 1 o B = 1). Ciò produce ai collettori di T1, T2 e T0 le funzioni A̅ + B e A + B rispettivamente.

I circuiti ECL risultano di funzionamento molto veloce (ritardi dell'ordine del nanosecondo), ma sono più costosi dei circuiti TTL: essi sono pertanto usati in quelle parti degli elaboratori dove si richieda una velocità molto alta, come nelle unità aritmetiche.

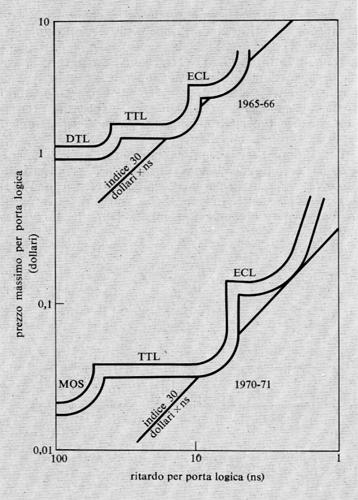

La fig. 12 mostra un diagramma che mette in relazione il costo per circuito elementare (‛porta logica') con il ritardo dello stesso, per le diverse famiglie e in due epoche diverse. Si noti come in una certa epoca il prezzo specifico per una certa famiglia cresca rapidamente, al di sotto di un certo ritardo, e come dunque convenga adottare un'altra famiglia (se questa è disponibile, s'intende). Si veda anche come i ritardi critici per una certa famiglia diminuiscano col tempo, grazie ai perfezionamenti tecnologici.

Al momento, la famiglia ECL è quella che fornisce i ritardi minimi.

Un'importante famiglia di circuiti logici è la MOS (Metal Oxide Semiconductors) che, malgrado presenti ritardi maggiori di altre, è di grande interesse per il suo costo che è invece il minimo di quelli oggi ottenibili. Infatti i transistori di tipo MOS occupano nei circuiti integrati aree di gran lunga minori dei transistori bipolari, permettendo così la costituzione di circuiti sempre più complessi su una stessa piastrina di silicio e inoltre richiedono un procedimento costruttivo più semplice. Per tali motivi, i circuiti integrati MOS rendono possibile la costruzione di dispositivi ‛a grande integrazione' (LSI), in particolare memorie e anche intere unità di calcolo (CPU) su un'unica piastrina.

I principali circuiti logici di tipo MOS sono illustrati nella fig. 13, nella quale si osserva in B l'impiego di un transistore TR in sostituzione del resistore del circuito A; risulta infatti che ciò è conveniente, dato quanto si è già detto e dato che i resistori sono gli elementi che occupano aree di piastrina molto grandi rispetto ai transistori MOS. Nel circuito C si ha un negatore del tipo ‛complementare' (CMOS), in quanto si utilizzano due transistori MOS, di cui uno a ‛canale n' e l'altro a ‛canale p' (v. elettronica). Con esso si consegue il grande vantaggio di un ridottissimo consumo di energia, in quanto uno dei due transistori è sempre bloccato (salvo nelle transizioni della variabile di entrata). I circuiti D ed E mostrano infine come si possano realizzare le funzioni logiche NOR e NAND. Altre più complesse funzioni logiche sono facilmente realizzabili con i circuiti di tipo MOS.

È stata recentemente scoperta un'ulteriore famiglia di circuiti logici, la IIL (Integrated Injection Logic), il cui circuito base è rappresentato nella fig. 14 insieme alla sua realizzazione in forma integrata. Quest'ultima risulta molto semplice e compatta, permettendo così di raggiungere alte densità di integrazione. Il suo sviluppo è ancora in corso, soprattutto per quanto riguarda il miglioramento della velocità. Lo studio e l'applicazione dei circuiti logici di tipo MOS si stanno sempre più diffondendo, con l'intento di migliorarne la velocità di funzionamento ed estenderne l'impiego ai casi in cui non si richieda una velocità estremamente alta. Parallelamente anche le dimensioni dei circuiti bipolari (in particolare IIL) tendono ad aumentare (LSI): sono già oggi disponibili circuiti con migliaia di componenti elementari. Una particolare attenzione merita la tecnologia C-MOS realizzata su supporti di zaffiro, che è potenzialmente capace di raggiungere la velocità di funzionamento dei circuiti TTL, ma a minor costo e soprattutto con consumi di energia ridottissimi.

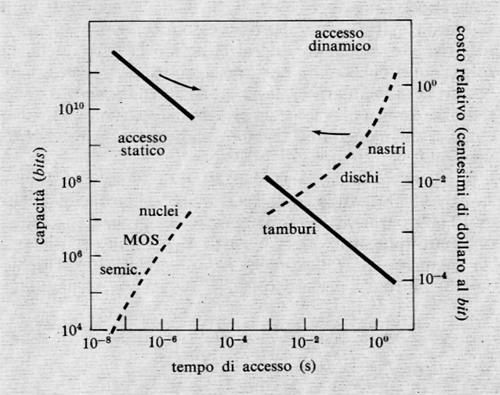

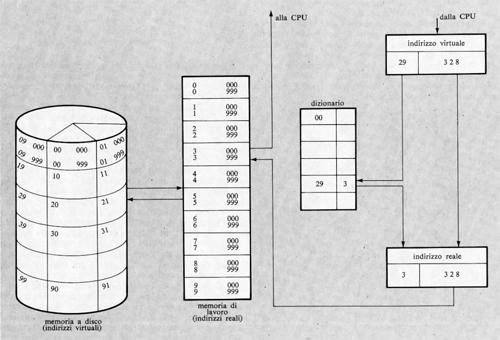

È presumibile che per parecchi anni la tecnologia dominante per i circuiti logici rimarrà quella dei semiconduttori, che offre ancora larghi margini di miglioramento.