Modellistica matematica

Modellistica matematica

Caratteristiche e origini

di Giorgio Israel

Un modello matematico è uno schema espresso in linguaggio matematico e volto a rappresentare un fenomeno o un insieme di fenomeni. Lo schema può essere costruito mediante uno dei tanti concetti o teorie della matematica (o una loro combinazione): strutture algebriche o geometriche, equazioni algebriche, differenziali (ordinarie o alle derivate parziali), alle differenze finite, stocastiche, teoria delle probabilità, teoria dei giochi, teoria dei sistemi ecc. Nei confronti dei fenomeni cui si riferisce, il modello matematico può avere una funzione descrittiva ovvero ambire a una descrizione quanto più soddisfacente, al fine di consentire una previsione circa il loro andamento futuro. Tale previsione può limitarsi a delineare questo andamento soltanto in termini qualitativi, oppure determinarlo in termini quantitativi esatti (eventualmente attraverso il calcolo numerico assistito dall'elaboratore elettronico). Tuttavia, nei confronti di certe classi di fenomeni, il modello matematico può (o deve) assolvere una funzione prescrittiva o di controllo, ovvero indicare in che modo il fenomeno deve svolgersi al fine di rispondere nel modo più efficace a determinati fini. Per es., un modello dei fenomeni meteorologici è di carattere descrittivo (in quanto ambisce a prevedere l'andamento del tempo con la massima accuratezza possibile). Invece, un modello del traffico automobilistico o un modello di allocazione di risorse scarse fra consumatori sono modelli prescrittivi o di controllo. Difatti, qui l'interesse non consiste nella descrizione, bensì nella determinazione delle procedure attraverso cui può essere conseguito un fine predefinito: nel nostro caso, realizzare uno scorrimento fluido e veloce del traffico e una distribuzione delle risorse 'ottimale' dal punto di vista dell'equità o di criteri di efficienza. Tuttavia questi due punti di vista possono coesistere. Per es., il moto di un aeromobile fa intervenire aspetti meramente descrittivi e aspetti di controllo legati all'intervento umano sulla traiettoria. È altresì evidente che l'influsso sempre più sensibile delle attività umane sui fenomeni meteorologici induce ad abbandonare il classico approccio puramente descrittivo, per tener conto degli effetti di tale influsso esterno e studiarli, al fine di correggerne gli aspetti negativi.

Dal punto di vista concettuale e metodologico, una delle caratteristiche più importanti del modello matematico è che esso non aspira a essere l'unica rappresentazione possibile di un fenomeno o di una classe di fenomeni. Il modello non è specchio della realtà e non esiste alcuna corrispondenza biunivoca fra modelli e fenomeni. Il medesimo fenomeno può essere rappresentato mediante più modelli fra i quali si può scegliere in base a criteri di efficacia, ma che non sono necessariamente in competizione, potendo offrire prospettive diverse e compatibili fra di loro. Viceversa, uno stesso modello (o, per meglio dire, un singolo schema matematico) può servire a rappresentare fenomeni diversi, fra i quali istituisce una sorta di 'omologia' strutturale. Questo aspetto rappresenta un approccio caratteristico della m. m., e cioè il metodo dell'analogia matematica. Esso consiste nell'identificare aspetti comuni tra fenomeni eventualmente anche molto diversi fra loro e scoprire così collegamenti non di rado inattesi. Se uno di questi fenomeni è suscettibile di una descrizione matematica efficace e semplice, essa può essere considerata come un modello matematico di tutti gli altri fenomeni analoghi (od 'omologhi'). Per es., nella moderna dinamica non lineare si è pervenuti a una trattazione unificata in molti differenti campi d'indagine, quali i fenomeni di turbolenza idrodinamica, la cinetica chimica, il comportamento di certi circuiti elettronici caratteristici della radiotecnica ecc.: il modello matematico più soddisfacente è ricavato dalla descrizione di certi processi oscillatori che trovano la loro manifestazione più evidente e già nota nei suddetti circuiti elettronici.

In definitiva, un modello matematico può essere considerato come un frammento di matematica applicato alla rappresentazione (descrittiva o prescrittiva) di un fenomeno, senza che questa rappresentazione abbia caratteristiche di unicità e potendo anche accadere che lo stesso frammento di matematica sia atto a rappresentare più fenomeni completamente indipendenti. La m. m. esclude ogni pretesa di rappresentazione univoca o 'vera' della realtà, ogni ambizione esplicativa, ermeneutica o interpretativa dei fatti, bensì insiste soltanto su un criterio di efficacia pratica. Si tratta di una caratteristica esplicitamente riconosciuta nell'eccellente caratterizzazione della prassi modellistica data da uno dei massimi scienziati del nostro secolo, J. von Neumann (1961-63, 6° vol., p. 492): "[…] le scienze non cercano di spiegare, a malapena tentano di interpretare, ma fanno soprattutto dei modelli. Per modello si intende un costrutto matematico che, con l'aggiunta di certe interpretazioni verbali, descrive dei fenomeni osservati. La giustificazione di un siffatto costrutto matematico è soltanto e precisamente che ci si aspetta che funzioni, cioè descriva i fenomeni in un'area ragionevolmente ampia. Inoltre, esso deve soddisfare certi criteri estetici, cioè, in relazione con la quantità di descrizione che fornisce, deve essere piuttosto semplice".

La scienza dei secoli passati era profondamente convinta che la matematica fosse capace di rappresentare l'autentica struttura dei fenomeni e che questa si riflettesse univocamente in un numero limitato di equazioni fondamentali. Tali sono l'equazione della meccanica di Newton, l'equazione del potenziale di Laplace, l'equazione delle vibrazioni, l'equazione del calore, le equazioni del campo elettromagnetico di Maxwell. Il grande fisico matematico ottocentesco J. Fourier (creatore della teoria matematica del calore) esprimeva tale credenza affermando che la natura e l'analisi matematica sono equiestese. Questa convinzione ha le sue radici nell'idea di Galileo secondo cui il grande libro della natura è stato scritto da Dio in caratteri matematici, e percorre tutta la storia della scienza moderna fino ad A. Einstein, il quale affermava che "abbiamo il diritto di essere convinti che la natura è la realizzazione di ciò che può essere immaginato di più semplice dal punto di vista matematico" (Penser les mathématiques 1982, p. 196). Se la natura è strutturata matematicamente, la matematica non è un mero strumento descrittivo ma permette di cogliere l'intima essenza dei fenomeni.

La m. m. rappresenta quindi una prassi scientifica nuova, che emerge nella scienza del Novecento e anzi la caratterizza. È spontaneo tentare di identificare con maggior precisione quando si sia affermata una prassi siffatta e a seguito di quali processi. La storiografia della scienza diverge nell'identificare gli inizi della m. m.: alcuni storici li collocano negli anni Venti, altri negli anni Quaranta, attorno alla fine della Seconda guerra mondiale. Questa divergenza è riconducibile a una diversa valutazione dei fattori determinanti nell'emergere della m. m.: difatti, ove si attribuisca un peso predominante ai fattori di carattere applicativo e tecnologico, appare evidente che, nel periodo della Seconda guerra mondiale, a seguito di molteplici esigenze belliche ed economico-industriali, la matematica assume una funzione pratica di dimensioni senza precedenti nella storia. Le forme in cui si manifesta tale intervento pratico sono proprio quelle della modellistica e vedono lo svincolamento della matematica dal legame esclusivo che essa aveva intrattenuto con la fisica per circa tre secoli. D'altra parte, se consideriamo le cose da un punto di vista concettuale e ricerchiamo le prime manifestazioni di questo svincolamento e del costituirsi dell'approccio modellistico, siamo ricondotti a qualche decennio prima. I primi segni di dissoluzione del rapporto esclusivo fra fisica e matematica si esprimono agli inizi del Novecento nella crisi del paradigma riduzionistico classico legata allo sviluppo della teoria della relatività e della teoria dei quanti, che mettono in discussione la rappresentazione newtoniana del tempo e dello spazio e, soprattutto, la rappresentazione dei fenomeni mediante uno schema continuo espresso in termini di equazioni differenziali. Inoltre, la fisica abbandona sempre più il realismo, sempre meno chiedendosi cosa siano gli oggetti di cui si occupa, bastandole fornirne una rappresentazione formale coerente ed efficace: si diffonde in questo contesto il termine modello, soprattutto in riferimento ai vari 'modelli dell'atomo' che mirano a rappresentarne le proprietà e il comportamento senza pretendere di rifletterne la struttura reale.

L'affermarsi dell'approccio modellistico ha quindi le sue radici nella crisi dell'approccio realista e oggettivista nella fisica classica, che prende forma fin dagli inizi del 20° secolo e, in modo netto, a partire dagli anni Venti. D'altra parte, un siffatto approccio in termini di storia delle idee, a ben vedere, non confligge con quello che privilegia i fattori applicativi e tecnologici. Difatti, la natura stessa dell'approccio modellistico contiene le premesse per un uso più ampio e non restrittivo dello strumento matematico in ogni settore in cui esso possa rivelarsi utile ed efficace. L'affermarsi dell'approccio modellistico si accompagna al costituirsi di un rapporto sempre più stretto della matematica con le applicazioni, e quindi alla diffusione crescente della tecnologia (ovvero della tecnica fondata sulla scienza). Appare chiaro che, se l'esplosione di una tecnologia basata sistematicamente sull'approccio matematico (v. modelli, teoria dei, App. III e App. IV) si situa negli anni Quaranta e Cinquanta, le sue premesse sono facilmente rintracciabili nei primi decenni del secolo: pertanto, lo sviluppo concettuale e metodologico e la svolta sul piano tecnologico sono collegati da un filo coerente.

A ciò va aggiunto un altro aspetto, legato alle caratteristiche dell'approccio modellistico e al menzionato svincolamento della matematica dal rapporto esclusivo con la fisica: si tratta dell'applicazione sempre più diffusa della matematica a tematiche di carattere non fisico, in particolare nel campo della biologia e delle scienze sociali ed economiche.

Fin dai primi decenni del Novecento, gruppi sempre più consistenti di studiosi appaiono interessati a una vasta gamma di questioni che sembrano sfuggire al quadro tradizionale della fisica matematica classica. Tali sono i problemi legati ai fenomeni fisici a regime turbolento, oltre a quelli suggeriti dai nuovi sviluppi della tecnica: per es., la diffusione delle onde radio, il comportamento di circuiti elettrici non convenzionali e di apparecchi in cui intervengono servomeccanismi, le questioni ingegneristiche legate al volo aereo. I modelli matematici elaborati per trattare questi temi - e che spesso riprendono approcci prima marginali nella fisica matematica classica, come lo studio delle equazioni differenziali non lineari - suggeriscono nuove applicazioni e connessioni impensate: dal problema dei cicli economici a quello degli innumerevoli fenomeni ciclici che si presentano in biologia, dallo studio dell'equilibrio economico a quello degli equilibri di popolazioni animali in competizione nell'ambito di un ecosistema, alle linee di tendenza dello sviluppo di un'epidemia.

Una simile varietà ed eterogeneità di argomenti non rende facile l'inserimento di nuovi sviluppi della m. m. nella struttura alquanto rigida della scienza classica. Il loro studio è quindi svolto da gruppi di studiosi che si collocano spesso ai margini della comunità scientifica ufficiale, benché comprendenti (o sostenuti da) alcune figure di grande prestigio. Un esempio di ricercatore tanto ricco di idee fertili quanto eclettico nell'approccio e isolato dalla comunità scientifica ufficiale è dato da A.J. Lotka, funzionario di una compagnia di assicurazioni di New York, che scrisse negli anni Venti un volume misconosciuto all'epoca e che ebbe poi un grande influsso sulla formazione di un grande 'matematico applicato' come N. Wiener (Lotka 1925). Un esempio di scienziato di prim'ordine che si impegnò in questo nuovo fronte non convenzionale della matematica applicata e della m. m. è dato dall'ingegnere ungherese Th. von Kármán (attivo in Germania e poi emigrato negli Stati Uniti, dove svolse un importante ruolo nell'ambito del California Institute of Technology). L'illustre fisico matematico italiano T. Levi-Civita può essere considerato come uno dei principali simpatizzanti e fautori del nuovo corso. Questi sviluppi si accompagnano a una vera e propria esplosione di ricerche matematiche nel campo della dinamica delle popolazioni, dell'epidemiologia, della fisiologia e della patologia delle funzioni del corpo umano, nonché della teoria dell'equilibrio economico generale.

Innumerevoli problemi di carattere applicato stimolano l'espansione della m. m. a partire dagli anni della Seconda guerra mondiale: problemi della meteorologia, problemi di allocazione ottimale delle risorse (dai problemi di logistica militare a quelli legati all'organizzazione del Piano Marshall, ai problemi di pianificazione e programmazione economica e di gestione industriale), problemi di aereodinamica e di balistica (dall'ottimizzazione del tiro contraereo ai modelli della bomba atomica e termonucleare, alla missilistica), questioni di tecnologia industriale (dai problemi di estrazione del petrolio ai metodi di organizzazione della produzione). Le applicazioni della matematica sono ormai tanto numerose che il diffondersi, fra i matematici degli anni Cinquanta, di un approccio tendente all'astrazione e alla visione pura e disinteressata della ricerca - promosso dal collettivo di matematici francesi raccolti sotto lo pseudonimo di N. Bourbaki - rappresenta una breve parentesi, per quanto influente, cui segue un'espansione inarrestabile della matematica applicata (v. matematica, in questa Appendice). La modellistica non si limita tuttavia agli aspetti tecnologici e industriali cui abbiamo ora accennato: essa riprende i temi che erano stati centrali nella modellistica biologica ed economico-sociale degli anni Venti. Dopo una pausa di qualche decennio, infatti, la dinamica delle popolazioni e l'epidemiologia ritornano al centro degli interessi e conoscono, negli anni Settanta, uno sviluppo impressionante, mentre a partire dagli anni Cinquanta l'economia matematica si concentra di nuovo sullo studio della teoria dell'equilibrio economico e riprende vigore l'interesse per la teoria dei giochi, i cui fondamenti erano stati posti in un celebre libro di von Neumann e O. Morgenstern (1944). In anni più recenti, lo studio matematico dei problemi meteorologici ha condotto alla scoperta di un fenomeno - il cosidetto caos deterministico - da taluni considerato come una rivoluzione concettuale di grande portata. Lo studio dei fenomeni 'caotici', così come quello dei fenomeni 'complessi', si ricollega direttamente all'interesse per i processi turbolenti e ha indotto un radicale mutamento nella visione matematica dei fenomeni: all'antica convinzione di un mondo strutturato in forme semplici e ordinate, che si rifletterebbero nelle strutture chiare e armoniose della matematica, si sostituisce l'idea di un'irriducibile complessità, di un intreccio straordinariamente complicato di relazioni che può essere rappresentato soltanto nell'ambito della 'nuova' matematica del caos o delle strutture frattali, o descritto mediante gli strumenti più sofisticati della teoria delle probabilità.

Un fattore di importanza cruciale nello sviluppo della m. m. è rappresentato dall'elaboratore elettronico e dal suo uso sempre più diffuso e sistematico nella ricerca scientifica. A partire dalle prime applicazioni importanti all'implementazione di modelli matematici, dovute a von Neumann, la costruzione di macchine sempre più potenti, veloci e maneggevoli conduce a un'esplosione del calcolo numerico (v. computazionali, metodi, in questa Appendice). Inoltre, l'introduzione della grafica su calcolatore, e quindi la sostituzione della rappresentazione numerica con la rappresentazione geometrica delle soluzioni dei sistemi studiati, permette una valutazione qualitativa diretta del comportamento delle soluzioni stesse. Ciò mette capo a un radicale mutamento nella prassi della ricerca. L'analisi numerica non è più un supporto per lo studio delle soluzioni laddove esse non sono direttamente esplicitabili con gli strumenti dell'analisi ordinaria, ma diviene uno strumento di simulazione del comportamento dei sistemi matematici studiati e, di riflesso, dei sistemi reali che essi pretendono di rappresentare. Mediante il calcolatore diviene quindi possibile simulare il comportamento di un sistema reale, nella speranza, almeno in certi casi, di sostituire questo approccio con la verifica empirica diretta (v. simulazione, in questa Appendice).

In conclusione, gli sviluppi della m. m. si estendono in un arco temporale di circa ottant'anni, durante i quali il panorama della matematica nei suoi rapporti con le altre scienze cambia in modo radicale. Tentiamo ora di descrivere in maggior dettaglio questo cambiamento.

Non linearità e complessità

di Giorgio Israel

La prassi modellistica implica il progressivo abbandono di un principio fondamentale della scienza classica: l'idea della semplicità della natura. Esso ha radici lontane, ma è nell'opera di G. Galilei che si connette con l'idea che il mondo ha una struttura matematica: quindi, una struttura matematica semplice. Il fascino che questo principio ha esercitato sulle menti degli scienziati è testimoniato dalla sua persistenza fino al Novecento.

Il principio della semplicità della natura ebbe una traduzione matematica esplicita tra la fine del Settecento e gli inizi dell'Ottocento, principalmente a opera di J.L. Lagrange. L'introduzione del calcolo infinitesimale aveva condotto alla rappresentazione dell'evoluzione dei fenomeni fisici nel tempo mediante equazioni differenziali. Consideriamo, per semplicità, il caso di un'equazione differenziale ordinaria

dove x è un vettore che rappresenta le variabili caratteristiche del processo in esame, f una funzione vettoriale di x, e al primo membro compare la derivata di x rispetto al tempo t. L'equazione della dinamica di Newton che stabilisce la proporzionalità fra accelerazione e forza impressa nel moto (f=ma, dove m è la massa del corpo) rientra in un'equazione siffatta. Se f è una funzione lineare (ovvero un polinomio di primo grado nella x), l'equazione suddetta è particolarmente semplice e la sua risoluzione è relativamente facile. Le cose vanno diversamente se f non è lineare: in tal caso, l'equazione non è quasi mai risolubile in modo esplicito. Si può pensare di sostituire alla f(x) il suo sviluppo in serie attorno a un punto: se x è uno scalare ciò equivale a considerare la somma infinita delle derivate dei vari ordini, con certi coefficienti; se x è un vettore, la situazione è più complicata formalmente ma concettualmente analoga: al posto della derivata prima comparirà la matrice jacobiana di f(x) e così via. Si sostituisce così all'equazione considerata un'equazione del tipo:

dove Df(x) è lo jacobiano calcolato nel punto (oppure la derivata nel caso scalare) ed R(x) rappresenta il contributo di tutte le derivate di ordine superiore.

Il passo fondamentale consiste ora nell'ammettere che il contributo della parte lineare sia quello fondamentale nella struttura delle soluzioni, ovvero quello che esprime gli aspetti caratterizzanti la dinamica del processo fisico in esame. Se le cose stanno così, si può pensare di trascurare R(x). Esso rappresenta certamente una serie di aspetti del processo, ma si tratta di 'perturbazioni' del processo fondamentale: la loro omissione fornisce una descrizione lievemente alterata, ma che non modifica le caratteristiche fondamentali di quella 'vera'. Linearizzare l'equazione differenziale (e quindi il processo) significa ricorrere a una descrizione più semplice, in cui certamente perdiamo qualcosa, ma soltanto aspetti marginali del processo. In cambio, guadagniamo in semplicità, perché potremo trattare matematicamente il processo in modo agevole. Insomma, la linearizzazione rappresenta il procedimento matematico con cui si attinge all'essenza fondamentale di un processo fisico e si svelano le intime strutture semplici che lo governano. È quasi superfluo dire che questo approccio ha senso se e soltanto se è vera l'ipotesi che la soppressione dei termini non lineari dell'equazione equivale a trascurare perturbazioni inessenziali o comunque secondarie. Questa è un'ipotesi che nessuno ha mai dimostrato e che, al contrario, si è rivelata falsa, almeno in linea di principio. Tuttavia, la scienza fisico-matematica l'ha considerata come un'evidenza per almeno un secolo, fornendo così un'ottima dimostrazione del fatto che la scienza è governata da ipotesi metafisiche nelle sue scelte concettuali e metodiche.

Il metodo della linearizzazione è la traduzione matematica del principio secondo cui la natura è semplice, anzi quanto di più semplice può essere immaginato dal punto di vista matematico. È quindi la credenza nella semplicità della natura che fonda la validità del procedimento consistente nello scartare la componente non lineare dei processi in quanto inessenziale. Agli inizi del Novecento ci si è resi conto che il metodo della linearizzazione poteva condurre a gravi errori e non possedeva alcun fondamento oggettivo generale. In moltissimi casi importanti proprio nei termini non lineari dell'equazione era contenuta la componente significativa dal punto di vista della descrizione del processo fisico, ovvero quella che ne caratterizza l'essenza intima. Può ben dirsi che lo sviluppo della m. m. sia legato all'affermarsi di un paradigma della non linearità in opposizione al paradigma tradizionale della linearità, e che questa contrapposizione corrisponda all'affermarsi dell'idea che i processi naturali non sono in generale semplici, bensì complessi: la semplicità (e quindi la linearità) diventa l'eccezione e la complessità (ovvero la non linearità) è la regola.

Il ruolo della m. m. nell'affermarsi del paradigma della non linearità e della complessità può essere inteso se si tiene conto del fatto che la fisica classica e anche quella più recente erano dominate dal dogma della centralità dell'analisi lineare. Anzi, la meccanica quantistica è tutta strutturata attorno allo schema dell'oscillatore lineare (ovvero lo schema matematico che rappresenta il comportamento di oscillatori come il pendolo semplice) e rappresenta l'apoteosi del paradigma lineare, per l'uso sistematico che in essa si fa della teoria degli operatori lineari in uno spazio di Hilbert. È facile quindi intendere come proprio in questo contesto si incontrassero le maggiori resistenze all'adozione di un punto di vista diverso. L'attenzione per la non linearità (e la corrispondente attenzione per il carattere complesso di moltissimi fenomeni) emerge quindi entro ambiti applicativi della fisica e nella tecnologia (teoria delle oscillazioni nella meccanica applicata, problemi di turbolenza, radiotecnica, processi di autoregolazione, fenomeni di biforcazione), oltre che nelle applicazioni della matematica alle scienze biologiche ed economico-sociali. Per quanto riguarda gli ambienti in cui si svilupparono questi interessi, va sottolineato il ruolo del tutto speciale assunto dalla scienza russa nel costituirsi del paradigma della non linearità, fin dagli inizi del 20° sec., sotto l'impulso di un'importante tradizione nel campo dell'ingegneria, delle scienze applicate e della meccanica.

Per illustrare meglio questi temi conviene riferirsi all'evoluzione del concetto di oscillazione, che prende forma nei primi decenni del Novecento. Innumerevoli fenomeni oscillatori e periodici si riscontrano in natura e nei processi artificiali, dalle vibrazioni meccaniche ai cicli economici, dall'acustica alla dinamica delle popolazioni, dalla contrazione del cuore ai cicli di riproduzione delle piante. La generalità e centralità della nozione di oscillazione nella descrizione scientifica (e matematica) dei fenomeni si può meglio intendere ove si tenga conto che uno strumento fondamentale della matematica, la trasformata di Fourier, permette di decomporre ogni evoluzione nella somma di contributi periodici. La struttura matematica più semplice ed efficace per la descrizione di un fenomeno oscillatorio è data dall'oscillatore armonico lineare: di qui il ruolo quasi universale che esso ha assunto nella fisica matematica (v. oscillazioni e vibrazioni, XXV). Tuttavia, molti processi oscillatori periodici non sono facilmente riconducibili a questo modello. Per es., esso si rivela inadeguato a descrivere un meccanismo antico come l'orologio, in quanto non riesce a rendere conto della capacità dell'orologio di stabilire in modo 'automatico' un bilancio fra immissione e dissipazione di energia: l'orologio - come innumerevoli altri dispositivi o processi naturali - 'autoregola' le sue oscillazioni mediante un meccanismo di retroazione (o feedback). A questo tipo di oscillazioni si addice piuttosto la denominazione di 'autooscillazioni' e la loro descrizione più appropriata è data da un modello matematico non lineare che costituisce una variante di una celebre equazione introdotta dal fisico olandese B.L. Van der Pol nel 1926.

Van der Pol introdusse la sua equazione per rappresentare il comportamento di circuiti elettrici in cui sono inseriti triodi o tubi a neon e la applicò con successo alla descrizione di fenomeni assai diversi, come il battito cardiaco, mettendo così in opera quel procedimento che abbiamo chiamato di analogia matematica. L'equazione di Van der Pol è essenzialmente non lineare e apre la strada a uno studio originale di un gran numero di processi autooscillatori governati dalla retroazione (v. oscillatore elettrico, App. III).

Questi problemi, studiati dapprima in modo episodico in Occidente, furono esaminati in modo più sistematico in Russia sotto l'impulso dell'opera del fisico L.I. Mandel´štam, il quale fu il capostipite di una scuola che annoverò matematici e fisici matematici di gran rilievo come A.A. Andronov, A.A. Vitt, S.E. Chajkin, L.S. Pontryagin. Mentre la fisica occidentale focalizzava i suoi interessi attorno alla meccanica quantistica, la scuola di Mosca di Mandel´štam e la scuola di Gor´kij guidata da Andronov sviluppavano sistematicamente la teoria delle autooscillazioni, mostrandone le numerose applicazioni nel campo della tecnologia del controllo automatico. Il volume sulla teoria delle vibrazioni di Andronov, Vitt e Chajkin (1937) può essere considerato un caposaldo in questo nuovo campo di ricerche (il nome di Vitt compare nell'edizione del 1959, ed è omesso in quella del 1937, in quanto egli era stato vittima delle purghe staliniane). Vanno inoltre ricordati i fondamentali studi sui metodi asintotici sviluppati dalla scuola di Kiev (i cui massimi esponenti sono N.M. Krylov, N.N. Bogoljubov e V.A. Mitropol´skij). Questo complesso di attività sfocia nell'imponente opera di A.N. Kolmogorov e della sua scuola, che salda lo studio dei sistemi dinamici non lineari con i metodi del calcolo delle probabilità, cui lo stesso Kolmogorov conferì l'assetto dominante nel 20° secolo.

Questi studi si sviluppano tra gli anni Venti e gli anni Sessanta, quando entrano a far parte del patrimonio della scienza occidentale e il paradigma non lineare diventa un tema centrale nel dibattito scientifico internazionale. Negli ultimi decenni del Novecento si è aperto un filone di ricerche ancora in pieno sviluppo che si identifica in modo sempre più esplicito sotto l'etichetta della complessità e che conferisce alla matematica un ruolo sempre più esteso entro la cornice modellistica. Di particolare importanza, in questo ambito, è la tematica del caos deterministico, già sviluppata nell'ambito della scienza sovietica e che risale a una formulazione dovuta ai matematici H. Poincaré e J. Hadamard sin dalla fine dell'Ottocento, e ripresa da E.N. Lorenz nello studio dei sistemi dinamici associati all'evoluzione dei processi meteorologici. Trattasi di sistemi dinamici in cui una perturbazione anche minima dello stato iniziale conduce a evoluzioni asintotiche radicalmente divergenti e che quindi, in ragione dell'inevitabile approssimazione nella determinazione dei dati numerici, mette in discussione la possibilità di una previsione esatta sul lungo e anche sul medio periodo. Lo studio dei sistemi caotici ha inaugurato una branca nuova della matematica - che, per certi versi, richiama l'impatto che ebbe la scoperta delle funzioni patologiche dell'analisi nel 19° secolo - il cui significato applicativo e la cui portata effettiva sono lungi dall'essere chiariti (v. caos e complessità, e anche sistemi disordinati, App. V; complessità: Sistemi complessi, in questa Appendice). Accanto a questi temi va menzionato l'apporto di teorie come quella delle catastrofi (sviluppata negli anni Settanta da R. Thom) e quella dei frattali (dovuta in anni più recenti a B. Mandelbrot), le quali nascono dall'esigenza di studiare i fenomeni di discontinuità e generalizzano alcuni risultati matematici entro una visione dei fenomeni che aspira a essere globale e onnicomprensiva (v. catastrofi, teorema delle e frattali, App. V).

I settori della ricerca modellistica

di Giorgio Israel

Modellistica, tecnologia e ingegneria

Quanto precede vale a illustrare il profondo mutamento che ha subito il rapporto fra matematica e tecnologia nel Novecento. La considerazione del più semplice sistema in cui siano presenti relazioni di tipo non lineare mostra l'emergere di comportamenti non riconducibili alla somma del comportamento delle singole parti. Così, in un sistema a due sole componenti, se esiste una relazione di retroazione della prima componente sulla seconda, è impossibile descrivere il comportamento dell'insieme come risultato del comportamento delle due componenti (in termini matematici, gli autovalori della soluzione del sistema non si ricavano attraverso una semplice combinazione degli autovalori delle due componenti). Ciò testimonia già di un legame preciso fra complessità, non linearità e determinati processi tecnologici non tradizionali, come i processi di retroazione, i quali sono legati all'introduzione di dispositivi di autoregolazione nelle macchine.

Quanto precede conduce a un discorso più ampio. La concezione classica delle macchine è fondata su un principio di tipo riduzionistico che può essere espresso nell'aforisma: "il tutto è la somma delle parti". Una macchina le cui componenti sono connesse da una concatenazione causale lineare, in cui ogni elemento agisce sul successivo secondo uno schema privo di diramazioni o di retroazioni, può essere ricondotta a questo principio. Quest'ultimo, d'altra parte, rappresenta bene il paradigma fondamentale della fisica classica, in base al quale ogni sistema deve essere considerato come l'aggregato di parti elementari e la descrizione dell'evoluzione dell'insieme si ottiene come risultante della descrizione dell'evoluzione delle componenti elementari. Questo schema meccanicista basato sulla concatenazione causale di componenti isolate o isolabili si è rivelato inadeguato di fronte allo sviluppo di nuove concezioni tecnologiche. La tematica che per prima (anche temporalmente) entra in contraddizione con questo paradigma (che ancora una volta si basa sull'idea della semplicità e della linearità) è certamente quella della retroazione e dei servomeccanismi. Basti pensare alla fondamentale sintesi con cui Wiener (1948), partendo dagli sviluppi della tecnologia degli elaboratori, della teoria dell'informazione e delle macchine automatiche, propose i concetti di retroazione e di informazione come centrali anche in contesti molto più vasti di quello strettamente tecnologico. Non minore importanza ebbero, nel progressivo abbandono della rigida concezione del riduzionismo meccanico, la teoria dell'informazione di C. Shannon e la teoria dei giochi di von Neumann (v. cibernetica e informazione, teoria della, App. III; giochi, teoria dei, App. IV). Tuttavia, l'insufficienza del riduzionismo meccanicistico si manifesta a un livello più profondo e vasto. La tecnologia moderna pone problemi molto più complessi della descrizione di un dispositivo isolato o di una macchina individuale: ci si trova sempre più di fronte a sistemi, in cui intervengono livelli assai diversi fra loro e che spesso non sono neppure riducibili a fattori puramente fisici. Non si tratta soltanto dei problemi posti da tecnologie come quella aerospaziale, in cui intervengono questioni di natura meccanica, elettronica, chimica e persino biologica, ma anche di problemi di tipo gestionale, come nel caso della regolazione del traffico o delle file d'attesa, per non parlare della trattazione scientifica dei problemi economici, produttivi, finanziari, sociali (v. organizzative, tecnologie, App. V; gestionale, ingegneria, in questa Appendice). Qui interviene una molteplicità di livelli che richiedono l'interazione di competenze di specialisti che nel passato sono stati considerati come appartenenti a sfere rigorosamente separate: il biologo, lo psicologo, l'economista, il programmatore ecc. Inoltre, la modellizzazione matematica di processi siffatti non richiede un approccio meramente descrittivo, anzi talvolta deve esplicitamente negarlo per determinare le condizioni sotto le quali il processo può assumere un comportamento ottimale (v. operativa, ricerca, App. V; ottimizzazione, in questa Appendice). Il vasto dominio dei modelli di controllo rappresenta un campo in cui la descrizione scientifico-matematica è chiamata a un ruolo sconosciuto nel passato (v. controlli automatici, App. III, IV e V; automatica e sistemi, App. IV e V; automazione, in questa Appendice). In definitiva, la tecnologia del Novecento, già nelle sue prime forme embrionali agli inizi del secolo e in modo nettissimo ai nostri giorni, determina l'abbandono definitivo del rapporto tradizionale ed esclusivo fra matematica e fisica, e del nucleo costitutivo di tale rapporto, il riduzionismo meccanicistico. Resta aperto il problema se la matematica - per tanti aspetti profondamente plasmata da quel rapporto - abbia subito un'evoluzione tale da fondare un nuovo rapporto costitutivo con le scienze non fisiche, libero da ogni residuo del meccanicismo causale lineare, e quindi davvero adeguato a riflettere la specificità dei problemi biologici, sociali o economici. Difatti, come ha osservato L. von Bertalanffy, molti approcci modellistici o sistemistici appaiono più come estensioni che come sostituzioni della visione meccanicista e quindi, mentre offrono un potenziamento indiscutibilmente efficace dell'analisi matematica dei fenomeni fisici, non sempre può dirsi la stessa cosa in contesti in cui si richiede una visione concettuale originale.

Biologia matematica

Le considerazioni precedenti appaiono particolarmente pertinenti nell'ambito delle applicazioni della matematica alla biologia. La ricerca recente gravita attorno agli stessi problemi che ne avevano stimolato lo sviluppo fin dagli anni Venti e spesso ricorrono al medesimo contesto concettuale che si ispira a un'imitazione di concetti e metodi della meccanica. I campi in cui si è sviluppata la biologia matematica possono essere sommariamente ridotti a quattro: la dinamica delle popolazioni, la biologia evolutiva, la teoria dello sviluppo e della diffusione delle epidemie, la biologia degli organismi (includendo in questo campo le ricerche sulla fisiologia e la patologia delle funzioni e degli organi del corpo umano). Negli anni 1920-40 questi settori conobbero un imponente sviluppo, che suggerì per questo periodo la denominazione di età d'oro della biologia matematica.

La dinamica delle popolazioni ha ricevuto un impulso massiccio dalle ricerche del matematico V. Volterra e da Lotka. Entrambi partirono dalla considerazione di un semplice modello non lineare che descriveva l'interazione fra una popolazione animale di prede e una popolazione di predatori, mostrando che il numero delle due specie doveva seguire un andamento oscillatorio periodico attorno a uno stato di equilibrio. Volterra estese questa trattazione al caso di un numero qualsiasi di prede e predatori e, pur non sviluppando la trattazione matematica in modo esauriente (data la sua difficoltà), tracciò un quadro di grande vastità che tendeva a rappresentare gli ecosistemi come insiemi di particelle governati da un comportamento simile a quello di un sistema meccanico: i predatori divorano le prede quando avviene un 'incontro', come nell'urto fra due molecole di gas. In coerenza con questa impostazione egli tentò di fornire una formulazione variazionale della rappresentazione matematica dell'ecosistema. Inoltre, per l'importanza che egli attribuiva al problema della verifica empirica, si adoperò intensamente alla ricerca di conferme sperimentali ed empiriche delle sue teorie. Il mondo dei biologi mostrò un grande interesse per questi sviluppi, cui seguì un crescente scetticismo dovuto alla scoperta delle numerose divergenze fra il modello e i fatti biologici.

È interessante notare che il modello meccanicistico di Volterra - ovvero la considerazione dell'ecosistema come un sistema di particelle meccaniche, adoperando come strumento matematico le equazioni differenziali - si ritrova con poche varianti negli sviluppi della teoria matematica delle epidemie, dovuta soprattutto al contributo degli statistici statunitensi W.O. Kermack e A.G. McKendrick: anche qui la diffusione dell'epidemia in una popolazione umana avviene secondo il principio degli incontri. Questo filone di ricerche è stato forse quello più convincente e produttivo della biomatematica e ha reso possibile la descrizione della diffusione di molte malattie infettive, come le malattie esantematiche, le grandi epidemie (come la peste o il colera) e la malaria. Un'impostazione di tipo meccanico può anche riscontrarsi nelle ricerche di genetica delle popolazioni sviluppate da R.A. Fisher, S. Wright e J.B.S. Haldane: le loro elaborazioni matematiche, sebbene elementari, contribuirono in modo significativo alla formazione della teoria sintetica dell'evoluzione, ovvero alla sintesi fra darwinismo e mendelismo che è alla base degli sviluppi più recenti della biologia molecolare e della genetica. Il loro uso degli strumenti della statistica segna l'inizio della moderna biometria (v. App. IV e V).

Dopo un periodo di stasi durato fino agli anni Settanta, negli ultimi decenni si è verificata un'espansione straordinaria della modellistica biomatematica. I problemi classici sono stati ripresi nel contesto degli sviluppi più recenti della biologia, risentendo così delle nuove visioni introdotte dalla biologia molecolare e cellulare. Ai campi di ricerca sviluppati nel periodo della 'età d'oro' occorre quindi aggiungere le applicazioni della matematica alla biologia molecolare, allo studio dei comportamenti delle cellule e alla genetica. Tuttavia, l'approccio matematico rimane un fattore relativamente marginale rispetto alla corrente principale degli studi biologici (v. biologia, in questa Appendice).

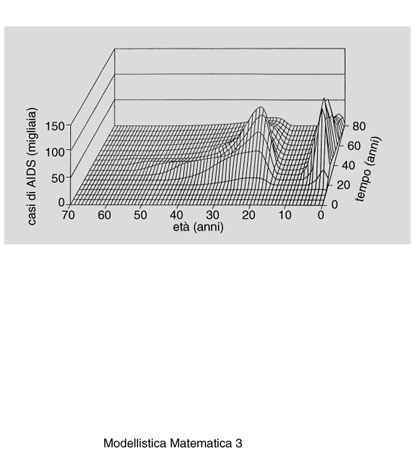

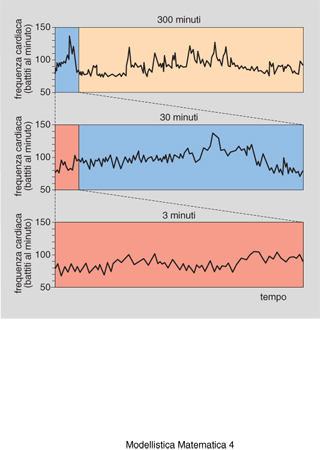

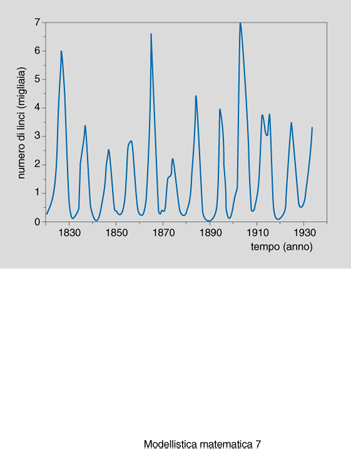

La dinamica delle popolazioni ha ripreso in modo abbastanza fedele le tematiche originarie di Volterra, ma inserendole nel contesto matematico più recente e cioè attribuendo un'importanza speciale alla trattazione in termini di sistemi dinamici e alla manifestazione di fenomeni caotici nei processi studiati (v. oltre: Teoria matematica della dinamica delle popolazioni). Di particolare rilievo sono le ricerche condotte da R.M. May (1973), volte a esaminare la relazione fra stabilità e complessità negli ecosistemi. Il problema che si è posto May è il seguente: può dirsi che, nei modelli matematici di Volterra e nelle loro generalizzazioni, un incremento di complessità del sistema (ovvero un incremento del numero delle specie e delle loro interazioni) conduca a un aumento di stabilità dell'ecosistema (nel senso che la sua struttura resiste alle perturbazioni esterne)? Gli ecologi sono orientati a dare una risposta affermativa per quanto riguarda i fenomeni reali noti e studiati. Le ricerche di May hanno invece condotto a una risposta opposta nel caso dei modelli matematici. Ciò ha aperto un difficile problema di coerenza fra modelli e osservazioni empiriche, il quale è tuttora irrisolto. Anche la teoria matematica delle epidemie ha ripreso l'impostazione e i modelli originari, naturalmente nel quadro dell'evoluzione delle tecniche matematiche e in relazione alle nuove problematiche empiriche contemporanee. Da questo punto di vista, una menzione speciale va fatta dei numerosissimi tentativi di fornire una modellizzazione matematica dell'AIDS, ai fini di prevedere le forme di sviluppo e le tendenze nella diffusione della malattia (fig. 3). Qui la m. m. si è dovuta misurare con una questione davvero 'complessa', dovuta alla difficoltà di formalizzare le modalità di trasmissione della malattia e alle forme assai varie della sua incubazione e del suo sviluppo. Si tratta di un campo in cui è in corso una discussione assai accesa che investe il problema della verifica empirica dei modelli, le modalità di uso dei dati empirici e numerici per la loro implementazione a fini predittivi e persino l'utilità stessa dello strumento matematico. Infine, il campo delle modellizzazioni matematiche dei processi fisiologici e patologici dell'organismo si presenta così vasto e soprattutto così disperso da rendere difficile ogni tentativo di sintesi. Si spazia dai modelli del battito del cuore o delle disfunzioni di questo organo (fig. 4), ai modelli dei processi del ricambio e delle loro patologie, allo studio del fenomeno della morte improvvisa (che si prestano a trattazioni sia stocastiche sia caotiche) o della dinamica di sviluppo dei tumori.

Economia matematica

Le applicazioni della matematica all'economia hanno conosciuto un importante sviluppo verso la fine dell'Ottocento, soprattutto a opera di L. Walras e V. Pareto, nel quadro della teoria dell'equilibrio economico generale. In questa prima fase, i risultati concreti sono modesti: l'aspetto più importante di questi contributi risiede nella formulazione dei problemi principali della teoria (l'esistenza dell'equilibrio economico, ovvero di uno stato di compatibilità delle azioni degli agenti economici in un'economia di mercato, la sua unicità e la sua stabilità globale), nonché nell'affermazione di principio della centralità del metodo matematico per la costruzione dell'economia teorica. Occorrerà attendere il periodo che va dal 1929 al 1936 per vedere le prime dimostrazioni dei problemi sopradetti a opera di A. Wald e di von Neumann. Tuttavia, mentre Wald si muoveva nel quadro concettuale della teoria walrasiana del mercato concorrenziale, von Neumann mirava alla dimostrazione di teoremi più generali nel quadro della teoria dei giochi, ovvero a provare l'esistenza di una soluzione minimax per un gioco competitivo fra n agenti. Questa soluzione corrisponde a una strategia 'prudente' dei giocatori, consistente nello scegliere fra tutti i migliori esiti (vincite) della partita quello peggiore; o, viceversa, a mirare alla perdita meno grave fra quelle che possono essergli inflitte da tutte le possibili strategie dei suoi avversari. Il problema economico rientrava come caso particolare in questa teoria molto generale, volta a descrivere ogni sorta di conflitto o confronto sociale, economico o politico, incluso il confronto strategico-militare.

La teoria dei giochi, formulata da von Neumann e Morgenstern negli anni Quaranta, non riscosse molto successo fra gli economisti. La maggioranza di costoro, consapevole delle nuove prospettive che la teoria dei giochi offriva sul piano matematico, si adoperò per recepirne i risultati, riscrivendoli però nel linguaggio classico della teoria walrasiana. Si trattava, insomma, di ottenere i teoremi relativi all'equilibrio economico, facendo ricorso alle tecniche di punto fisso e di minimax introdotte da von Neumann, ma liberandole del linguaggio della teoria dei giochi. L'esito di questi tentativi fu dato dalla dimostrazione di un teorema assai generale di esistenza dell'equilibrio economico a opera di K.J. Arrow e G. Debreu nel 1954. Seguirono molte altre generalizzazioni e perfezionamenti di questo risultato, mentre le cose non andarono altrettanto bene per la dimostrazione dell'unicità e della stabilità globale dell'equilibrio (quest'ultima equivale a postulare, in termini economici, che il mercato possieda una capacità automatica, od omeostatica, di porsi da solo in equilibrio). I risultati matematici concernenti i temi dell'unicità e della stabilità conseguiti nel periodo 1958-82 (i quali hanno visto il contributo di numerosi studiosi di primo piano, fra cui quello del matematico S. Smale) si sono rivelati completamente deludenti e, di fatto, quest'ultima branca della teoria è stata abbandonata. In particolare, la teoria economico-matematica ha, per ora, messo da parte il problema della dinamica, in quanto troppo complesso, se non inabbordabile, sostituendolo con formulazioni in cui si studiano forme molto riduttive di dinamica, le quali si svolgono tutte nello stato di equilibrio. Al contempo, si è constatato che buona parte delle difficoltà della teoria provengono dall'insufficiente caratterizzazione del comportamento dell'agente economico (che conduce al fatto che le funzioni di utilità di tale agente siano praticamente arbitrarie). Di qui lo sviluppo di importanti e recenti teorie, come quella delle aspettative razionali, e i tentativi di raffinare la teoria introducendo rappresentazioni di carattere stocastico o costruendo modelli di informazione incompleta degli agenti. Un altro tentativo di costruire una teoria dinamica più soddisfacente di quella classica è dato dalla cosiddetta teoria degli equilibri temporanei, elaborata a partire dagli anni Settanta.

L'economia matematica non può certamente essere ridotta al modello dell'equilibrio economico generale. È tuttavia indubbio che questo modello - e, in particolare, la sua idea centrale di rappresentare il processo economico come la risultante del comportamento di n agenti indipendenti, la cosiddetta ipotesi dell'individualismo metodologico - resta al centro di tutte le elaborazioni sviluppate in questo campo. Per dirla con l'efficace espressione del premio Nobel per l'economia P. Samuelson, la teoria dell'equilibrio economico generale è la "cassetta degli strumenti" di ogni economista. L'ipotesi dell'individualismo metodologico è presente anche nella vasta pleiade dei modelli dell'econometria che mettono in opera strumenti probabilistici e statistici per l'analisi anche numerica di contesti empirici o di situazioni simulate (v. econometria, App. III, IV e V). Parzialmente autonomi da questo contesto sono invece i modelli matematici finanziari che hanno conosciuto un grande sviluppo in tempi recenti e che fanno ricorso sistematico all'analisi stocastica (v. stocastici, processi: Processi stocastici in finanza matematica, in questa Appendice). Secondo alcuni autori il successo predittivo di questi modelli pone il problema dell'influsso che può avere l'analisi matematica sulla dinamica stessa dei capitali finanziari, anche se il carattere caotico di questa dinamica non configura questo influsso in termini di controllo.

Modellistica e panmatematismo

di Giorgio Israel

Al volgere del secolo, la matematica appare come uno strumento pervasivo che sembra proporsi sempre più come la via obbligata per ogni analisi dei fenomeni che ambisca a definirsi scientifica. Le applicazioni della matematica non si limitano ai pochi campi che abbiamo esaminato. La sociologia, dopo lo sviluppo degli studi di sociometria (App. IV; v. anche statistica, App. V), si trova di fronte al problema se instradarsi decisamente oppure no nella via del formalismo matematico. Numerosi studiosi nel campo della psicologia o della psicoanalisi tentano di ricorrere alla matematica per una presentazione rigorosa delle loro teorie (v. psicometria, XXVIII e App. II e IV). Persino nel campo storiografico si discute circa l'utilità dei modelli matematici, e se in antropologia la simpatia di C. Lévi-Strauss per un approccio di tipo matematico-formale non ha conquistato molti adepti, i modelli matematici hanno fatto il loro ingresso in discipline come l'archeologia.

La scienza appare quindi sempre più pervasa da un ideale di tipo 'panmatematico' che sembra riproporre l'antica idea galileiana secondo cui la natura è scritta in caratteri matematici. Naturalmente, le cose non stanno negli stessi termini, e questo per due motivi principali. In primo luogo perché l'approccio modellistico non ha ambizioni di realismo e, come si è visto, si giustifica in termini di efficacia più che in termini di aderenza alla realtà dei fenomeni. In secondo luogo perché, soprattutto nell'ambito delle scienze umane, l'efficacia del metodo matematico è lungi dall'essere acquisita. Mentre le rappresentazioni matematiche della complessità sembrano rispondere abbastanza bene alla complessità dei fenomeni fisici, i livelli di complessità che si presentano nei fenomeni biologici, e ancor più, in quelli economici, sociali e psicologici, rappresentano una sfida straordinariamente ardua per l'analisi scientifica formale.

bibliografia

J.B.S. Haldane, A mathematical theory of natural and artificial selection, in Transactions and proceedings of the Cambridge philosophical society, 1924, 23, pp. 1924-32.

A.J. Lotka, Elements of physical biology, Baltimore 1925 (nuova ed. Elements of mathematical biology, New York 1956).

W.O. Kermack, A.G. McKendrick, Contributions to the mathematical theory of epidemics, in Proceedings of the Royal statistical society, 1927, 115, pp. 700-21.

R.A. Fisher, The genetical theory of natural selection, Oxford 1930.

V. Volterra, U. D'Ancona, Les associations biologiques étudiées au point de vue mathématique, Paris 1935 (trad. it. Roma 1995).

A.A. Andronov, A.A. Vitt, S.E. Chajkin, Teorija kolebanij (La teoria delle vibrazioni), Moskva 1937, 1959².

J. von Neumann, O. Morgenstern, Theory of games and economic behavior, Princeton 1944, 1947².

N. Wiener, Cybernetics. Or, control and communication in the animal and the machine, Cambridge (Mass.) 1948, New Tork 1961².

C. Shannon, W. Weaver, The mathematical theory of communication, Urbana (Ill.) 1949.

R.D. Luce, H. Raiffa, Games and decisions. Introduction and critical survey, New York 1957, 1985².

J. von Neumann, Collected works, ed. A.H. Taub, 6 voll., New York 1961-63.

E.N. Lorenz, Deterministic non-periodic flow, in Journal of atmospheric science, 1963, 20, pp. 130-41.

L. von Bertalanffy, General system theory, New York 1968.

A. Koyré, Études newtoniennes, Paris 1968.

K.J. Arrow, F.H. Hahn, General competitive analysis, San Francisco 1971.

W.B. Provine, The origins of theoretical population genetics, Chicago 1971.

R.M. May, Stability and complexity in model ecosystems, Princeton (N.J.) 1973.

Penser les mathématiques. Séminaire de philosophie et mathématiques, Paris 1982.

J. Guckenheimer, P. Holmes, Nonlinear oscillations, dynamical systems, and bifurcation of vector fields, New York-Berlin 1983.

P. Bergé, Y. Pomeau, Ch. Vidal, L'ordre dans le chaos. Vers une approche déterministe de la turbulence, Paris 1984.

L. Glass, M.C. Mackey, From clocks to chaos. The rythms of life, Princeton (N.J.) 1988.

B. Ingrao, G. Israel, Equilibrio economico, in Enciclopedia delle scienze sociali, 3° vol., Istituto della Enciclopedia Italiana, Roma 1993, ad vocem.

Frontiers in mathematical biology, ed. S.A. Levin, Berlin-Heidelberg 1994.

G. Israel, A. Millán Gasca, Il mondo come gioco matematico. John von Neumann, scienziato del Novecento, Roma 1995.

G. Israel, La visione matematica della realtà. Introduzione ai temi e alla storia della modellistica matematica, Roma-Bari 1996.

Teoria matematica della dinamica delle popolazioni

di Mimmo Iannelli

Gli ecosistemi naturali presentano una complessità che rende difficile la loro descrizione dettagliata (v. ecologia, App. III, IV e V; complessità: Complessità biologica, in questa Appendice); tuttavia i modelli matematici possono gettar luce sui meccanismi fondamentali che regolano le interazioni tra le specie all'interno di un ecosistema. Nel seguito vengono descritti i modelli che costituiscono i prototipi di base per l'indagine dei fenomeni di popolazione, a partire dai quali, negli ultimi trent'anni, la ricerca si è sviluppata in varie direzioni. L'indagine scientifica si avvale di tali modelli sia per acquisire indicazioni teoriche sui meccanismi che regolano i fenomeni, sia per poter elaborare descrizioni più complesse da simulare al calcolatore per ottenere previsioni realistiche. Modelli più sofisticati, sempre basati su sistemi di equazioni differenziali ordinarie, cercano di analizzare la struttura di ecosistemi complessi, permettendo di discutere la natura e il ruolo delle interazioni che coinvolgono più specie. Dal punto di vista dei metodi matematici applicati, l'analisi qualitativa delle equazioni differenziali ordinarie (o più in generale la teoria dei sistemi dinamici finito-dimensionali) svolge un ruolo centrale, ma la ricerca e l'analisi delle equazioni procede anche per via empirica tramite simulazioni al calcolatore, rese possibili dal grande sviluppo dei mezzi informatici.

La crescita di una singola specie

La situazione idealizzata di una singola specie, isolata e internamente omogenea (gli individui che la compongono possono essere considerati identici, trascurando differenze di struttura quali l'età, la dimensione, il sesso, differenze di collocazione geografica ecc.), viene descritta da una singola equazione differenziale ordinaria, cui si dà in genere la forma specifica seguente (modello di Verhulst), dove N è il numero degli individui, variabile dipendente dal tempo t, e N₀ è la popolazione iniziale:

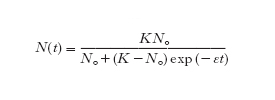

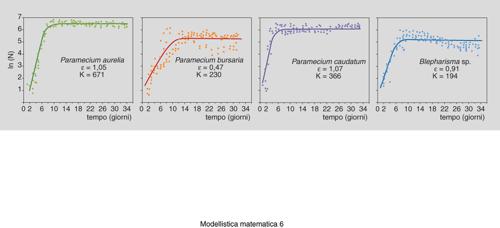

In questo modello, il tasso specifico di crescita ε(1−N/K), che risulta dal bilancio tra la natalità e la mortalità specifiche, dipende dai due parametri ε>0 e K>0, chiamati rispettivamente potenziale biologico intrinseco della popolazione e capacità portante dell'ambiente. Inoltre, il tasso dipende in modo decrescente dal numero di individui presenti, allo scopo di modellizzare il cosiddetto effetto logistico secondo cui, in presenza di alte densità di individui, a causa di numerosi fattori (tra cui la limitatezza delle risorse, le sostanze di rifiuto che la popolazione emette nell'ambiente, le energie spese per la socializzazione, l'aumento della predazione), un aumento della popolazione produce una diminuzione della natalità e un aumento della mortalità. La soluzione del modello

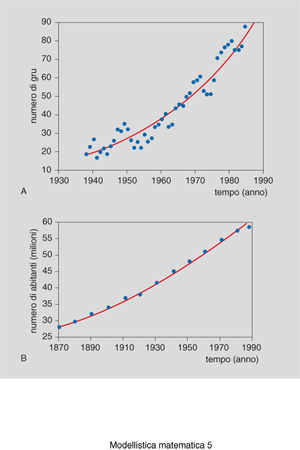

tende asintoticamente al valore K, qualunque sia il dato iniziale N₀∙0. La popolazione, quindi, tende ad attestarsi sul valore della capacità portante. Nel caso di N₀〈K/2, la soluzione assume la forma della 'sigmoide logistica', che si osserva sperimentalmente in molte situazioni. Quando la capacità K è molto grande rispetto alla densità di popolazione N, il tasso ε(1−N/K) è approssimabile con ε e di conseguenza si ha una crescita (illimitata) di tipo esponenziale N(t)=N₀exp (εt), ossia una crescita malthusiana (figg. 5 e 6).

Due specie in competizione

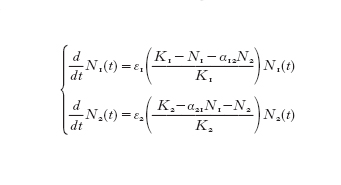

Il modello relativo alla competizione riprende il principio logistico esposto nel modello di Verhulst, applicandolo al caso di due specie biologiche che vivono in uno stesso ambiente e interagiscono in quanto competono per le stesse risorse. In termini biologici, le due specie hanno in comune parte della nicchia ecologica, intendendo con questo termine il complesso di abitudini, cibo, spazio ecc. propri di ciascuna specie. Indichiamo con N₁(t) ed N₂(t) il numero di individui delle due specie e (supponendo che ognuna di esse, in assenza dell'altra, si evolverebbe secondo un modello logistico) siano ε₁, ε₂ i rispettivi potenziali biologici e K₁, K₂ le rispettive capacità. In questo caso occorre tener conto del fatto che il potenziale biologico di ciascuna specie diminuisce anche al crescere della densità del competitore; ciò porta al sistema di equazioni differenziali ordinarie

con le condizioni iniziali N₁(0)=N₀₁, N₂(0)=N₀₂, dove il parametro αij rappresenta il grado di occupazione della nicchia della specie i da parte di un individuo della specie j, misurando quanti individui di tipo i equivalgono a un individuo di tipo j. Le conclusioni che si traggono da questo modello, in funzione dei valori dei parametri, forniscono indicazioni sul meccanismo della competizione tra le due specie. In particolare si ottengono indicazioni sulle condizioni che permettono la coesistenza stabile (α₁₂K₂〈K₁ e α₂₁K₁〈K₂) o su quelle che invece portano all'esclusione di una delle specie.

Il modello preda-predatore

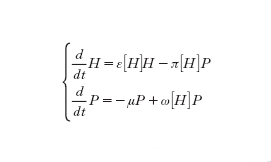

Una fenomenologia diversa da quella di competizione caratterizza il meccanismo della predazione. In questo caso, indicando con H(t) e con P(t) rispettivamente la preda e il predatore al tempo t, un tipico modello che permette di discutere l'interazione tra le due specie in modo esauriente è dato dal seguente sistema:

Ogni funzione presente nelle equazioni ha un suo specifico significato biologico: ε[H] rappresenta il tasso intrinseco di crescita della preda, che spesso si assume nella forma specifica ε[H]=ε₀(1−H/K), tipica del modello di Verhulst; −μ è il tasso intrinseco di crescita del predatore, che si assume costante e negativo, supponendo così che, in assenza di preda, il predatore si estinguerebbe esponenzialmente con vita media 1/μ; π[H] è la risposta funzionale del predatore, che corrisponde al numero di prede consumate nell'unità di tempo da un singolo individuo; ω[H] rappresenta infine la risposta numerica alla predazione e corrisponde al numero di nuovi individui prodotti da ciascun predatore nell'unità di tempo. Per es., tra le forme che possono prendere le suddette funzioni è realistica e significativa l'espressione

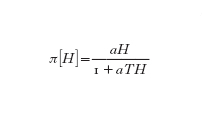

(proposta da C.S. Holling sulla base di considerazioni empiriche riguardanti il meccanismo della predazione), dove a>0 è detto coefficiente di attacco, mentre T>0 corrisponde al tempo necessario a consumare la preda; per ciò che riguarda la risposta numerica, si suppone spesso che sia proporzionale alla risposta funzionale, ponendo ω[H]=ω₀ π[H]. L'analisi qualitativa del comportamento delle soluzioni mostra che il modello è in grado di render conto delle tipiche oscillazioni (fig. 7) che si rilevano in natura, e permette di discutere le condizioni che producono oscillazioni stabili (soluzioni periodiche).

Modelli epidemiologici

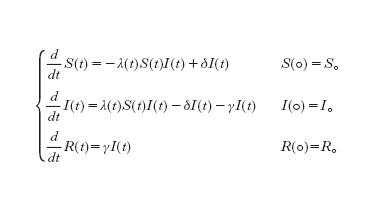

La descrizione delle epidemie tramite modelli matematici (fig. 8) si basa essenzialmente sulla definizione di tre classi di individui in cui viene divisa la popolazione: suscettibili (S, individui che non sono malati e possono essere contagiati), infettivi (I, individui che hanno contratto la malattia e possono contagiare i suscettibili) e rimossi (R, individui che sono stati infettati e che non intervengono nel meccanismo dell'infezione in quanto immuni, isolati o morti). L'interazione tra queste classi di individui è descritta complessivamente dal sistema:

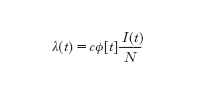

I parametri δ e γ sono rispettivamente il tasso di guarigione e il tasso di rimozione, mentre il tasso λ(t) (forza di infezione) si assume della forma

dove c è il tasso di contagio, ϕ la probabilità di infezione ed N la popolazione totale, che in questo modello risulta costante perché si trascurano nascite e morti. Casi particolari del modello si ottengono con speciali scelte dei parametri in corrispondenza di due fondamentali classi di malattie. La prima classe comprende le malattie che non inducono immunità e non sono letali (tipo S-I-S, corrispondente a γ=0), la seconda quelle che producono la completa 'rimozione' del malato a conclusione del periodo di infettività (tipo S-I-R, corrispondente a δ=0). Un tipico risultato fornito da questi modelli è l'esistenza di una condizione di soglia (cϕ/γ>1 per il modello S-I-S, cϕS₀/γN>1 per il modello S-I-R) che fornisce il legame che deve intercorrere tra i parametri affinché l'epidemia si sviluppi. La modellizzazione delle malattie infettive si è sviluppata nella direzione di una descrizione più serrata di specifiche epidemie, elaborando particolari meccanismi di contagio che permettono di analizzare fenomeni quali l'esplosione periodica di particolari infezioni, l'influenza delle epidemie sullo sviluppo demografico e anche il loro ruolo nel controllo delle specie naturali.

Oltre i prototipi: modelli strutturati e modelli discreti

Mentre i modelli già descritti si fondano su uno schema di base secondo cui il sistema è articolato in un numero finito di classi di popolazione, ciascuna delle quali internamente omogenea, i modelli più strutturati, che tengono conto di alcune variabili fondamentali che differenziano gli individui (età, dimensione, sesso, posizione nello spazio, stadio di sviluppo), conducono allo studio di equazioni alle derivate parziali o a equazioni integro-differenziali.

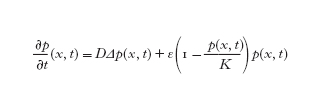

Lo studio della struttura spaziale della popolazione e dei relativi processi di dispersione, che comprendono sia la diffusione casuale sia la migrazione e la chemotassi, conduce all'analisi di equazioni di reazione e diffusione analoghe a quelle che nascono dalla modellizzazione di fenomeni fisico-chimici. Un tipico modello per la descrizione della dispersione di una singola specie consiste infatti nel seguente problema sulla variabile p(x, t) che rappresenta la distribuzione spaziale della popolazione stessa al tempo t:

In questa equazione il primo termine del secondo membro definisce il meccanismo della diffusione, mentre il secondo termine definisce il processo di crescita della popolazione, che nel caso specifico è di tipo logistico. Il termine DΔp(x,t) interviene sulla base di ipotesi costitutive che modellizzano un processo di diffusione casuale.

I modelli più elaborati che descrivono fenomeni di migrazione e di chemotassi portano invece allo studio di equazioni non lineari parabolico-degeneri del tutto analoghe a quelle che descrivono la diffusione nei mezzi porosi.

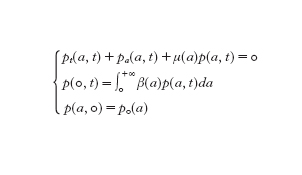

Una differente classe di problemi alle derivate parziali interviene quando si considera la struttura di età. In questo caso la popolazione è descritta dalla distribuzione in età p(a,t), la cui dinamica è, nel caso più semplice, regolata dal seguente sistema lineare:

dove β(a) e μ(a) rappresentano rispettivamente natalità e mortalità della popolazione e sono entrambi dipendenti dall'età a degli individui. Questo sistema che si presenta di tipo iperbolico a causa della condizione integrale al bordo, mostra una struttura simile alle equazioni integrali di Volterra e, insieme ai modelli non lineari che ne costituiscono lo sviluppo, interviene nello studio di problemi di demografia, di ecologia e di crescita cellulare.

Nella modellizzazione delle epidemie intervengono equazioni analoghe per descrivere quelle malattie il cui meccanismo di infezione dipende strettamente dall'età; tipici esempi sono le malattie infantili, per le quali il tasso di contagio coinvolge essenzialmente l'età scolare, e le malattie veneree, che invece riguardano individui di età matura. Sempre nel contesto delle epidemie, altri modelli prendono in considerazione quella che viene chiamata età di malattia, che corrisponde al tempo trascorso dal momento in cui un individuo è stato infettato. Questo tipo di modelli, il cui studio coinvolge metodi analoghi a quelli già considerati, viene utilizzato nei casi in cui l'infettività degli individui varia in funzione di tale parametro. Il caso della recente epidemia HIV/AIDS, con il lungo periodo di incubazione che la caratterizza, richiede che siano prese contemporaneamente in considerazione sia l'età degli individui sia l'età di malattia.

I modelli discussi finora, tutti basati su una variabile di tempo continuo, si avvalgono degli strumenti dell'analisi infinitesimale seguendo l'impostazione tradizionale propria della fisica matematica. Negli ultimi anni, però, una crescente attenzione è stata dedicata alla formulazione e all'analisi di modelli a tempo discreto, che si fondano su equazioni alle differenze la cui analisi rientra nella teoria dei sistemi dinamici discreti. Tali modelli, ampiamente utilizzati nell'interpretazione dei dati sperimentali, sembrano infatti rispondere maggiormente alle esigenze del biologo, perché la scansione a tempo discreto appare suggerita in modo naturale dalla stessa natura dei fenomeni; inoltre sono più direttamente simulabili al calcolatore, anche introducendo elementi di stocasticità che possono contribuire a rendere il modello più adeguato. Di fatto, i risultati che si ottengono attraverso modelli discreti non sono del tutto coerenti con quelli ottenuti modellizzando lo stesso fenomeno con un modello a tempo continuo. A questo proposito è esemplare il comportamento del modello logistico discreto, che può essere ricondotto all'equazione xn₊₁=m(1−xn)xn, la cui soluzione ha un comportamento asintotico non paragonabile al corrispondente modello continuo già visto in precedenza. Infatti, al crescere del valore del parametro m, la successione xn ha come limite asintotico una soluzione periodica di periodo crescente, fino a mostrare un comportamento caotico.

La m. m. dei fenomeni biologici, di cui abbiamo seguito le linee portanti nel settore della dinamica delle popolazioni, si estende a numerosi altri problemi e campi di interesse attuale. Oltre agli esempi considerati è necessario menzionare i settori della genetica, dell'immunologia e della crescita cellulare, che pur rientrando nel campo della dinamica delle popolazioni pongono problemi peculiari a vari livelli e suggeriscono l'uso di metodi propri di differenti ambiti della matematica: i modelli di tipo stocastico, o di tipo misto stocastico-deterministico, spesso risultano più adeguati alla complessità dei fenomeni in studio e anche alla natura intrinseca di alcuni processi. Anche il tema della dinamica evoluzionistica, di grande interesse attuale, si avvale di tutto il complesso di idee e metodi che costituiscono il corpus della modellistica tradizionale e suggerisce nuove direzione di indagine, mentre il settore della fisiologia, tradizionalmente legato alla fisica per il carattere dei fenomeni che coinvolge, ha conosciuto un notevole sviluppo, incentrato sulla modellizzazione del singolo neurone tramite le equazioni di Hodgkin e Huxley: in questo campo la ricerca ha raggiunto un notevole grado di maturità, che permette di fornire risposte significative a problemi medici di elevata incidenza.

bibliografia

H.I. Freedman, Deterministic mathematical models in population ecology, New York 1980.

A. Okubo, Diffusion and ecological problems. Mathematical models, Berlin-New York 1980.

J.A.J. Metz, O. Dickmann, The dynamics of physiologically structured populations, Berlin-New York 1986.

J. Hofbauer, K. Sigmund, The theory of evolution and dynamical systems. Mathematical aspects of selection, Cambridge-New York 1988.

Applied mathematical ecology, ed. S.A. Levin, T.G. Hallam, L.J. Gross, Berlin-New York 1989.

Mathematical and statistical approaches to AIDS epidemiology, ed. C. Castillo-Chavez, Berlin-New York 1989.

J.D. Murray, Mathematical biology, Berlin-New York 1989.

H.W. Hethcote, J.W. Van Ark, Modeling HIV transmission and AIDS in the United States, Berlin-New York 1992.

S.N. Busenberg, K. Cooke, Vertically transmitted diseases, models and dynamics, Berlin-New York 1993.

Frontiers in mathematical biology, ed. S.A. Levin, Berlin-New York 1994.

H.L. Smith, P. Waltman, The theory of the chemostat. Dynamics of microbial competition, Cambridge-New York 1995.

J.M. Cushing, An introduction to structured population dynamics, Philadelphia 1998.