Probabilità

Probabilità

Apartire dalla fine degli anni Venti del Novecento incominciò a diffondersi l'uso di una definizione generale di probabilità, in sostituzione di precedenti impostazioni parziali. Tra queste le principali sono il punto di vista classico (basato sulla nozione di casi ugualmente probabili e sulla conseguente valutazione della probabilità come rapporto tra numero dei casi favorevoli e numero dei casi possibili); il punto di vista empirico (basato sulla nozione di eventi ripetibili la cui frequenza su grandi numeri di prove, in virtù della cosiddetta legge empirica del caso, darebbe una buona stima della probabilità); la concezione asintotica, che modifica la precedente considerando successioni infinite di prove e definisce la probabilità come valore limite della frequenza lungo tali successioni.

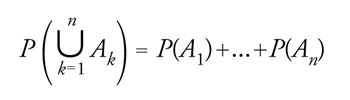

Alla base della definizione generale qui adottata, vi sono i concetti primitivi di caso elementare (evento indivisibile) e di insieme, o spazio, dei casi elementari Ω. Si considera evento ogni sottoinsieme di Ω, e le ordinarie operazioni su insiemi diventano operazioni sugli eventi. L'evento corrispondente a Ω si dice certo, mentre l'evento corrispondente all'insieme vuoto si dice impossibile. Il complementare rispetto a Ω di un sottoinsieme di Ω è considerato come evento contrario dell'evento corrispondente a esso. La definizione generale di probabilità ammette una formulazione semplice quando si prenda come dominio della probabilità un'algebra A di eventi (sottoinsiemi di Ω). Tale algebra è caratterizzata dalle seguenti proprietà: Ω è un elemento di A; se A appartiene ad A, anche il complementare di A (in simboli, Ac) è contenuto in A; l'unione di un qualunque numero finito di elementi di A continua a essere un elemento di A. Allora, una qualunque funzione P definita sull'algebra A e a valori nell'intervallo [0,1] si dice probabilità se P(Ω)=1 e per ogni classe finita A1,...,An di elementi di A a due a due incompatibili si ha

formula.

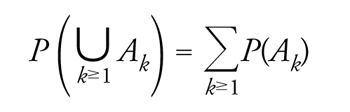

A questa caratterizzazione della probabilità si perviene se si fonda la teoria sul celebre principio di coerenza della concezione soggettivistica di Bruno de Finetti, che permette di definire la probabilità su classi arbitrarie di eventi. Vi si perviene anche, come fa Andreij N. Kolmogorov, prendendo come riferimento le proprietà formali della frequenza secondo la concezione empirica. Con qualche forma di idealizzazione suggerita da comprensibili ragioni di convenienza matematica, Kolmogorov restringe la classe delle probabilità ammissibili alle misure di probabilità, ossia alle probabilità che sono additive per tutte le famiglie numerabili (quindi, anche numerabilmente infinite) di elementi di A a due a due incompatibili: se A1,A2,...,An,... sono elementi di A a due a due incompatibili la cui unione fa parte di A, allora

[2] formula.

La convenzione suggerita da Kolmogorov, che conducea identificare la probabilità con la misura finita astratta nel senso di Lebesgue-Fréchet, si è rapidamente imposta su tutte le altre. Anche in questa presentazione, il termine probabilità verrà usato per designare una misura di probabilità.

Una semplice ma importante conseguenza dell'additività è la seguente: se l'evento A implica l'evento B (il verificarsi di A implica quello di B, ovvero A⊂B), allora

[3] P(A) ≤ P(B).

(monotonia della probabilità).

Vi è un tratto caratteristico della probabilità, rispetto all'ordinaria teoria della misura, che conviene porre subito in evidenza. Si tratta della presenza di eventi condizionati o subordinati. Presi due eventi H ed E in A con H diverso dall'evento impossibile, si può scommettere su E e subordinare la validità della scommessa al verificarsi di H: se H non si verifica, la scommessa viene annullata; se H si verifica, la scommessa è vinta o persa a seconda che, rispettivamente, E si verifichi o non si verifichi. Sulla base del già citato principio di coerenza, oppure ricorrendo ad un'analogia formale fra probabilità e frequenza, si stabilisce che la probabilità P(E |H) dell'evento subordinato E |H deve soddisfare la relazione

[4] P(E ∩H) = P(E |H)P(H).

nota come principio delle probabilità composte.

Calcolo stocastico

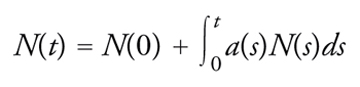

La teoria dei processi stocastici si ricollega altresì al calcolo stocastico. Si consideri il semplice modello di crescita di una popolazione dato da

[54] dN = a(t)N(t)dt N(0) = costante assegnata

o equivalentemente, in forma integrale,

[55] formula

dove N(t) denota la consistenza della popolazione all'istante t. Non è difficile immaginare situazioni concrete in cui a(∙) non è interamente nota e sarà quindi più appropriatamente rappresentabile come somma di due componenti, l'una determinata e l'altra descritta da un processo aleatorio. Ma come risolvere una tale equazione? Si può dare una risposta ricorrendo al concetto d'integrale secondo Ito e alla versione stocastica della regola di derivazione di funzioni composte nota come formula di Ito, dal nome del matematico giapponese Kiyosi Ito che negli anni Quaranta sviluppò le linee fondamentali del calcolo stocastico.

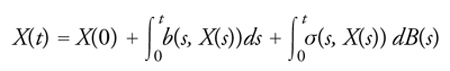

Cerchiamo, comunque, di spiegare la peculiarità del problema rispetto alla situazione ordinaria in cui il disturbo è estromesso dal modello. Tipicamente si ricorre a un processo browniano per rappresentare il disturbo e si studia l'equazione

[56] dX(t) = b(t, X(t)) + σ(t, X(t))dB(t)

dove B(∙) denota il moto browniano. Se si scrive quest'ultima in forma integrale, ovvero

[57] formula

ci si rende conto che il secondo integrale deve essere definito fuori dalle regole del calcolo ordinario. Infatti, essendo le traiettorie di B(∙) ovunque non differenziabili, cade la condizione di limitatezza della variazione ordinariamente richiesta a una funzione per essere integratrice. L'integrale in questione sarà allora da intendersi come integrale secondo Ito.

Una volta precisato il significato di [56] e [57] si trova che il processo X, soluzione di

[58] dX(t) = b(t, X(t))dt + σ(X(T))dB(t) t ≥ s ≥ 0 X(s) = x

con b e σ che soddisfano

[59] |b(x)−b(y)| + |σ(x)−σ(y)| ≤ D|x−y|

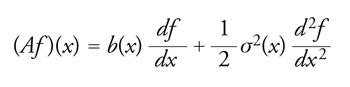

per ogni x,y in ℝ e per una costante opportuna D, è un processo morkoviano comunemente detto diffusione di Ito. Il suo generatore infinitesimale, definito su una classe opportuna di funzioni f reali di variabile reale, è dato da

[60] formula.

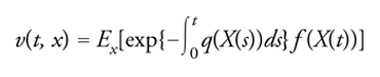

Esso si riduce ovviamente a [51] se b≡0 e σ2=1 e infatti in tal caso l'equazione [58] diviene dX(t)=dB(t). Il teorema dell'equazione all'indietro di Kolmogorov continua a valere con A definito da [60] e inoltre

[61] formula

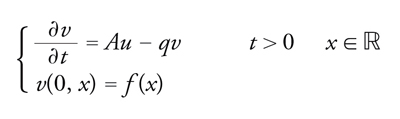

è l'unica soluzione del problema

[62] formula

purché le funzioni reali di variabile reale f e q soddisfino alcune condizioni di regolarità. La [61] è una versione della celebre formula di Feynman-Kac, dai nomi di Richard Feynman e Mark Kac che con intenti e metodi diversi per primi la ottennero verso la fine degli anni Quaranta.

Come applicazione particolarmente significativa e di indubbio successo dei risultati citati sopra si segnala la formula di Black-Scholes per la valutazione dell'opzione europea: si tratta di un titolo che dà all'acquirente la facoltà di acquistare, all'istante T ma a un prezzo K fissato oggi (istante 0), un certificato azionario o altro titolo avente alla scadenza T valore aleatorio ST. Ovviamente, perché l'acquirente abbia interesse all'esercizio dell'opzione alla scadenza T, dovrà risultare ST maggiore di K; in caso opposto, l'acquirente rinuncerà. Quindi è possibile caratterizzare l'opzione col guadagno dell'acquirente, ovvero max{ST−K,0}≡(ST−K)+. Il problema particolarmente importante data la diffusione delle opzioni europee e di altri derivati è allora quello di determinare il prezzo equo che l'acquirente sarebbe tenuto a pagare all'istante 0. Fu risolto da Fischer Black e Myron Scholes nel 1973; Robert Merton approfondì, perfezionò e risolse nello stesso anno alcuni rilevanti problemi collegati a quello della valutazione. Nel 1997 a Scholes e Merton fu assegnato per tali contributi il premio Nobel dell'economia (Black era deceduto nel 1995).

Teoremi come quello di Kolmogorov (sull'equazione all'indietro) e di Feyenman-Kac rivestono grande importanza concettuale rispetto al disvelamento di profondi, e talvolta inattesi, legami tra aspetti significativi dello studio di certi processi aleatori e questioni classiche dell'analisi matematica. Da un punto di vista pratico, non è da escludere che tali risultati possano talvolta facilitare il calcolo esatto di soluzioni di equazioni differenziali (quando, come nell'esempio del problema di Black-Scholes, il calcolo diretto del valore atteso di Ex[f (X(t))] o più in generale di [61] risulti pressoché immediato) per mezzo del calcolo delle probabilità o, inversamente, possano risultare determinanti per ottenere l'espressione esatta di certi valori attesi grazie all'interpretazione che ne evidenzia la natura di soluzioni di ben definiti problemi differenziali.

Oltre al calcolo esatto, i collegamenti che abbiamo visto fra probabilità e analisi si rivelano particolarmente utili per il calcolo numerico approssimato di soluzioni di problemi differenziali. I metodi che si usano a questofine sono detti di simulazione o, più pittorescamente, metodi Monte Carlo e l'idea che li ispira può essere riassunta nei termini seguenti. Con riferimento per esempio al problema della ricerca della soluzione di [62], si eseguono numerosi esperimenti (simulazioni) organizzati con l'aiuto di tecniche di calcolo automatico in modo che i relativi risultati siano concepibili come realizzazioni x(∙) di un processo markoviano caratterizzato dal generatore [60] e avente valore x nell'origine (distribuzione iniziale 0 concentrata in {x}). Allora, la media dei valori f (x(t)) in corrispondenza delle traiettorie ottenute per mezzo della simulazione costituisce una stima statistica diEx[f (X(t))] e, per il tramite del teorema di Kolmogorov, una valutazione approssimata del valore della soluzione u di [62] nel punto (t,x).

Infine, in virtù di un celebre teorema di Shizuo Kakutani del 1944 e di successivi sviluppi si hanno risultati analoghi a quelli di Kolmogorov e Feynman-Kac anche in relazione ai problemi di Dirichlet e Poisson, consentendone la risoluzione approssimata per mezzo di metodi Monte Carlo.

bibliografia

Bachelier 1900: Bachelier, Louis, Théorie de la spéculation, "Annales de l'École Normale Supérieure", s. 3, 17, 1900, pp. 21-86.

Billingsley 1999: Billingsley, Patrick, Convergence of probability measures, 2. ed., New York-Chichester, Wiley, 1999.

Dallacherie, Meyer 1976-1987: Dallacherie, Claude - Meyer, Paul-André, Probabilités et potentiel, I-IV, Paris, Hermann, 1976-1987.

De Finetti 2005: De Finetti, Bruno, Teoria delle probabilità, Milano, Giuffré, 2005.

De Finetti 2006: De Finetti, Bruno, Opere scelte, I, Bologna, Cremonese, 2006.

Doob 1953: Doob, Joseph L., Stochastic processes, New York, Wiley, 1953.

Gnedenko, Kolmogorov 1954: Gnedenko, Boris V. - Kolmogorov, Andrej N., Limit distributions for sums of independent random variables, Reading, Addison-Wesley, 1954.

Kallenberg 2001: Kallenberg, Olav, Foundations of modern probability, New York, Springer, 2001.

Karatzas, Shreve 1991: Karatzas, Ioannis - Shreve, Steven E., Brownian motion and stochastic Calculus, New York, Springer, 1991.

Kolmogorov 1933: Kolmogorov, Andrej N., Grundbegriffe der Wahrscheinlichkeitsrechnung, Berlin, Springer, 1933.

Kolmogorov 1992: Kolmogorov, Andrej N., Selected works, II, edited by Albert N. Shiryayev, Dordrecht, Kluwer Academic, 1992.

Lamperti 1977: Lamperti, John, Stochastic processes, New York, Springer, 1977.

Letta 1993: Letta, Giorgio, Probabilità elementare, Bologna, Zanichelli, 1993.

Lévy 1934: Lévy, Paul, Sur les intégrales dont les éléments sont des variables aléatoires indépendantes, "Annali della Scuola Normale Superiore di Pisa", 3, 1934, pp. 337-366.

Oksendal 2003: Oksendal, Bernt, Stochastic differential equations, 6 ed., Berlin-London, Springer, 2003.

Protter 2005: Protter, Philip E., Stochastic integration and differential equations, Berlin, Springer, 2005.

Regazzini 2005-2006: Regazzini, Eugenio, Leggi dei grandi numeri e dintorni, "Bollettino dell'Unione Matematica Italiana", 8-A, 2005, pp. 1-22 (I parte); 9-A, 2006, pp.89-130 (II parte).

Sato 1999: Sato, Ken-ichi, Lévy processes and infinitely divisible distributions, Cambridge, Cambridge University Press, 1999.

Wiener 1923: Wiener, Norbert, Differential space, "Journal of mathematics and physics", 2, 1923, pp. 131-174.