Informazione, scienza della

INFORMAZIONE, SCIENZA DELLA

Tecnologie della comunicazione di Roman Tirler

Sommario: 1. Introduzione. 2. Tecniche di comunicazione dati: a) trasmissione dei dati; b) codifica dei dati e modulazione; c) tecniche di comunicazione di dati digitali; d) controllo del collegamento dati (DLC, Data Link Control); e) allocazione e multiplazione del canale; accesso al canale. 3. Reti per la comunicazione dati: a) commutazione di circuito; b) commutazione di messaggio; c) commutazione di pacchetto; d) reti locali (LAN); e) reti di area metropolitana (MAN); f) reti di area ampia (WAN); g) reti ad alta velocità. 4. Architettura di una rete d'informazioni: a) protocolli; b) il modello di riferimento ISO OSI; c) l'insieme di protocolli TCP/IP; d) protocolli proprietari; e) internetworking. 5. Applicazioni e servizi: a) applicazioni tradizionali; b) ricerca di informazioni; localizzatori di risorse; c) applicazioni avanzate; d) reti per l'informazione e multimedialità. 6. Le prospettive future. □ Bibliografia.

1. Introduzione

Il termine ‛comunicazione', oltre a indicare lo scambio di informazioni, designa un intero settore industriale che comprende la telefonia e l'elaborazione dei dati. La comunicazione - che si articola in un'ampia gamma di discipline che va dalle radiodiffusioni al giornalismo, dalla televisione all'informatica - è divenuta il tratto distintivo dell'epoca contemporanea, che cambierà per sempre il modo di vivere, lavorare e giocare; il nome stesso evoca l'immagine di un sistema di strade o sentieri, attraverso i quali l'informazione viaggia da un gruppo di persone a un altro. In una rete per la comunicazione dei dati, tali percorsi possono collegare dispositivi locali - come un computer e alcuni terminali in uno stesso edificio - o disseminati in un'area più vasta. Oggi l'informazione, la sua trasmissione ed elaborazione, le telecomunicazioni e i collegamenti in rete rappresentano una forza trainante nell'evoluzione della nostra società. Nei paesi economicamente avanzati, il settore della comunicazione è, e lo sarà sempre di più, un comparto dominante dell'economia; per l'anno 2000 si stima che questo settore rappresenterà più del 10% del Prodotto Interno Lordo in Europa, un incremento stimolato non solo da una domanda crescente da parte degli utenti, ma anche da uno straordinario progresso tecnologico.

Alcuni assimilano l'impatto delle reti di calcolatori sullo sviluppo della società a quello dei sistemi meccanici che hanno accompagnato la rivoluzione industriale, altri lo paragonano a quello delle grandi ferrovie del XIX secolo. Tuttavia, questi eventi del passato certamente non hanno avuto sulla civiltà umana un'influenza paragonabile a quella esercitata congiuntamente dall'ingegneria delle telecomunicazioni e dei calcolatori. Nessun'altra invenzione ha avuto uno sviluppo altrettanto rapido e di così ampia portata come il calcolatore e nessuna tecnologia ha raggiunto mete paragonabili alla diffusione capillare del moderno sistema di telecomunicazioni.

Nel corso degli ultimi venti anni il cambiamento è stato radicale: si è passati dalla comunicazione vocale alle reti per la comunicazione dati, e da queste alle reti per l'informazione. La comunicazione dati, che influisce su molti aspetti della vita quotidiana - come le transazioni del mercato azionario, la ricerca medica, la posta elettronica, gli sportelli bancari automatici (il ‛bancomat') e, da ultimo, Internet, coi suoi aspetti rivoluzionari -, è una realtà complessa in rapido movimento, poiché gli standard cambiano di continuo, ogni giorno sono introdotti nuovi prodotti, l'hardware si evolve costantemente. La comunicazione e la condivisibilità dei dati sono gli aspetti più ovvi che rendono le proprietà dell'informazione diverse da quelle dei beni materiali; vi sono tuttavia molte altre caratteristiche che, seppure collaterali, sono degne di nota. Oltre a poter essere comunicata e condivisa, l'informazione può essere diffusa, via etere o via cavo, o essere messa in rete. Gli uomini stessi vivono da sempre in una rete di rapporti, ma il grado di interconnessione è aumentato negli ultimi decenni in una misura assolutamente imprevedibile. L'infrastruttura di supporto per l'informazione comprende una serie di elementi: l'ampiezza di banda di trasmissione, i media e i dispositivi di rete, nonché uno spettro, pressoché illimitato, di nuove applicazioni.

Si stima che l'inizio della comunicazione umana orale (analogica) risalga a più di 50.000 anni fa. In alcune caverne sono stati ritrovati graffiti che hanno più di 20.000 anni. Si sono rinvenute tracce di messaggi scritti di oltre 5.000 anni. La comunicazione ottica digitale a lunga distanza iniziò prima della nascita di Cristo, presso gli antichi Greci, i quali costruirono una rete di stazioni ripetitrici su torri da cui trasmettevano segnalazioni con torce. Nel Seicento e nel Settecento la telegrafia ottica era largamente usata in Europa. La telegrafia elettrica, inventata da Samuel Morse nel 1846, segnò l'inizio delle moderne comunicazioni digitali elettromagnetiche. La radiotelegrafia fu inventata da Guglielmo Marconi nel 1896. Fra la fine del XIX e i primi anni del XX secolo fece la sua comparsa la trasmissione via radio di segnali audio in forma analogica, una tecnologia che fu applicata nello stesso periodo alla comunicazione vocale analogica. La trasmissione di segnali televisivi divenne una realtà commerciale nei tardi anni quaranta, e successivamente, negli anni cinquanta, cominciò nelle grandi aree metropolitane la conversione dei segnali vocali analogici in segnali digitali. In seguito, come ricaduta della ricerca dedicata alla costruzione di reti per comunicazioni militari sicure, fu sviluppata la tecnica della commutazione di pacchetto, che permise di utilizzare in modo più efficiente i cavi telefonici installati. Il successivo, decisivo passo in avanti fu la creazione, a opera del Dipartimento della Difesa degli Stati Uniti, della prima rete a commutazione di pacchetto, ARPAnet, realizzata nel 1971 dall'Advanced Research Projects Agency e rimasta operante fino al 1990. Molti dei progressi nelle comunicazioni fra calcolatori, compreso l'istradamento (routing) e il collegamento in rete (networking), sono derivati dall'esperienza fatta su Internet. Le reti locali (LAN; v. cap. 3, § d) sono state il successivo, fondamentale passo in avanti per le comunicazioni fra calcolatori, con l'introduzione di Ethernet da parte della Xerox nel 1974. L'avvento delle architetture client/server e dell'elaborazione distribuita segna l'inizio della comunicazione dati moderna. Le trasmissioni su fibra ottica e il concetto di trasmissione digitale sincrona sono stati introdotti nei primi anni ottanta. Lo sviluppo della tecnologia ATM ha rinnovato l'interesse della tecnologia per le comunicazioni digitali asincrone. Il prossimo balzo in avanti sarà probabilmente la multiplazione a divisione di frequenza (WDM), che è analogica e asincrona (v. cap. 3, § g). La velocità delle comunicazioni digitali è cresciuta in progressione geometrica attraverso ciascuna di queste fasi della tecnologia

2. Tecniche di comunicazione dati

Il successo della trasmissione dei dati dipende principalmente da due fattori: la qualità del segnale trasmesso e le caratteristiche del mezzo di trasmissione.

a) Trasmissione dei dati

La trasmissione dei dati avviene fra un trasmittente e un ricevente attraverso un mezzo di trasmissione. I mezzi di trasmissione possono essere guidati o non guidati: in entrambi i casi la comunicazione avviene sotto forma di onde elettromagnetiche. Con i mezzi guidati, le onde sono convogliate in un canale fisico, come ad esempio il doppino telefonico, il cavo coassiale e la fibra ottica. I mezzi non guidati forniscono invece un modo per trasmettere onde elettromagnetiche senza determinarne il percorso, come avviene nella propagazione attraverso l'aria, il vuoto o l'acqua del mare. In una configurazione multipunto, più di due dispositivi condividono lo stesso mezzo. Una trasmissione può avvenire in simplex, half-duplex o full-duplex. In una trasmissione in simplex, i segnali sono trasmessi in una sola direzione: una stazione funge da trasmittente e l'altra da ricevente; nel funzionamento in half-duplex, entrambe le stazioni possono trasmettere, ma solo una alla volta; nel funzionamento in full-duplex entrambe le stazioni possono trasmettere simultaneamente (v. sotto, § d).

Un segnale può essere rappresentato come funzione del tempo oppure come funzione della frequenza. Lo studio nel dominio delle frequenze è molto più utile per la comprensione della comunicazione dei dati. La larghezza di banda assoluta di un segnale è l'intervallo di frequenze entro il quale è contenuta la maggior parte della sua energia. Da un punto di vista pratico, ogni mezzo usato è in grado di trasmettere solo in una banda ristretta di frequenze, e ciò limita la quantità di dati che possono essere trasportati nell'unità di tempo dal mezzo di trasmissione: più grande è l'intervallo di frequenze entro il quale un mezzo può trasmettere, maggiore è la sua capacità di trasportare informazione. Nella comunicazione dei dati, la larghezza di banda è normalmente espressa in bit al secondo (b/s). Un dispositivo che ha una larghezza di banda di 2 Mbit/s può sopportare una velocità di trasmissione di 2 milioni di bit al secondo. Inoltre, quando un segnale si propaga nel mezzo di trasmissione la sua intensità diminuisce. Per compensare questo effetto possono essere inseriti in vari punti del mezzo degli amplificatori che accrescono l'intensità del segnale.

Trasmissione analogica e digitale. - I termini ‛analogico' e ‛digitale' corrispondono, in prima approssimazione, rispettivamente a ‛continuo' e ‛discreto', e sono usati frequentemente nella comunicazione dati in riferimento ai dati stessi, ai segnali e alla trasmissione. I dati analogici assumono valori continui in un determinato intervallo: per esempio, la voce e le immagini video presentano distribuzioni di intensità che variano in maniera continua. I dati digitali assumono valori discreti; un esempio familiare è dato dal testo scritto, che è costituito da sequenze di caratteri. I dati testuali, i più naturali per gli esseri umani, non possono essere memorizzati o trasmessi facilmente sotto forma di caratteri dai sistemi di elaborazione dati o di comunicazione, che sono progettati per trattare dati binari. Sono stati quindi sviluppati vari codici attraverso i quali i caratteri sono rappresentati da sequenze di bit. Forse il primo esempio di codice ad ampia diffusione è stato il codice Morse. Attualmente il codice più comunemente usato è il codice ASCII (American Standard Code for Information Interchange), stabilito dall'ANSI (American National Standards Institute), l'ente che negli Stati Uniti fissa gli standard.

In un sistema di comunicazione i dati si propagano da un punto a un altro sotto forma di segnali elettrici. Un segnale analogico è un'onda elettromagnetica che varia con continuità e che può essere trasmessa su vari mezzi a seconda del suo spettro. Un segnale digitale è una sequenza di impulsi di tensione corrispondenti a cifre binarie, che può essere trasmessa lungo un cavo elettrico. I dati digitali possono essere trasmessi anche in forma di segnali analogici attraverso l'uso di un modem (modulatore/demodulatore); tale dispositivo converte una successione di impulsi binari di tensione in un segnale analogico, codificando i dati digitali, generalmente nello spettro vocale, su una frequenza portante e trasmettendoli lungo le ordinarie linee telefoniche; all'altro capo della linea, il modem demodula il segnale recuperando i dati originari. I dati analogici possono anche essere convertiti in segnali digitali. Il dispositivo che svolge questo compito per dati vocali è il codec (codificatore/decodificatore): sostanzialmente un codec riceve un segnale analogico costituito dai dati vocali e lo approssima con una sequenza di bit; il codec ricevente usa la sequenza di bit per ricostruire i dati analogici.

La trasmissione analogica è un modo per trasmettere un segnale analogico indipendentemente dal suo contenuto; il segnale può infatti rappresentare dati sia analogici (voce, immagini video) sia digitali (dati binari che passano attraverso un modem). In entrambi i casi, poiché il segnale analogico diventa più debole dopo una certa distanza, il sistema di trasmissione deve servirsi di amplificatori che immettono energia nel segnale, permettendogli di giungere a distanze maggiori. Sfortunatamente gli amplificatori rafforzano anche le componenti dovute a rumore.

La trasmissione digitale, al contrario, riguarda direttamente il contenuto del segnale, che può essere trasmesso solo a una distanza limitata per evitare che l'attenuazione danneggi l'integrità dei dati. Per distanze maggiori si usano i ripetitori, che ricevono il segnale digitale, dal quale traggono la sequenza binaria, e ritrasmettono un nuovo segnale, aggirando il problema dell'attenuazione. La stessa tecnica può essere usata con un segnale analogico, se è noto che il segnale trasporta dati digitali; in questo caso, invece di amplificatori il sistema di trasmissione utilizza dei ripetitori, collocati in punti opportunamente distanziati, che recuperano i dati digitali dal segnale analogico e generano un nuovo segnale analogico. Ciò consente che gli effetti del rumore non si accumulino.

Ci si può chiedere quale sia il metodo di trasmissione preferibile: la risposta che viene dall'industria delle telecomunicazioni e dai suoi utenti è che è preferibile la trasmissione digitale, nonostante il fatto che vi sia stato un enorme investimento in infrastrutture per le comunicazioni analogiche. L'abbattimento dei costi della tecnologia digitale (VLSI, Very Large Scale Integration), la possibilità di collegamenti con ampia larghezza di banda (fibra di vetro), un alto grado di multiplazione e l'integrazione fra voce, segnali video e dati sono tra le principali ragioni della scelta. La trasmissione digitale è inoltre preferibile perché il tasso di errori è potenzialmente molto basso e anche perché la velocità di trasmissione dei dati è molto maggiore anche con le linee esistenti.

Disturbi nella trasmissione. - Quale che sia il sistema di trasmissione, è necessario tener presente che il segnale ricevuto è diverso dal segnale trasmesso a causa dei vari disturbi nella trasmissione. Nei segnali analogici questi disturbi introducono modificazioni casuali che degradano la qualità del segnale; nei segnali digitali, invece, possono essere introdotti errori nei bit, quali ad esempio la trasformazione di un 1 binario in uno 0 binario e viceversa.

I disturbi più significativi sono l'attenuazione e la conseguente distorsione, la distorsione dovuta a ritardo (instabilità) e il rumore. Per i mezzi guidati, la riduzione dell'intensità del segnale, o attenuazione, è in genere logaritmica ed è quindi tipicamente espressa come un numero costante di decibel per unità di distanza. Per i mezzi non guidati, l'attenuazione è una funzione più complessa della distanza e delle condizioni atmosferiche. Oltre una certa distanza, l'attenuazione diventa eccessivamente grande e pertanto si usano amplificatori o ripetitori per rafforzare il segnale. Un'ulteriore complicazione sta nel fatto che l'attenuazione è una funzione crescente col quadrato della frequenza. Per i segnali digitali il problema è meno rilevante.

La distorsione dovuta a ritardo è un fenomeno peculiare dei mezzi guidati. Essa è causata dal fatto che la velocità di propagazione di un segnale attraverso un mezzo guidato varia con la frequenza, e pertanto risulta particolarmente critica per i dati digitali. Per ridurre tale distorsione si possono adottare tecniche di equalizzazione.

Il rumore è il principale fattore che limita l'efficienza dei sistemi di comunicazione. Esso può essere classificato in quattro categorie in base alla sua origine: rumore termico, rumore di intermodulazione, interferenza e rumore impulsivo. Il rumore termico è causato dall'agitazione termica degli elettroni in un conduttore: esso - che è presente in tutti i dispositivi elettronici e in tutti i mezzi di trasmissione ed è funzione della frequenza (v. telecomunicazioni, vol. VII) - non può essere eliminato e pone un limite superiore alle prestazioni di un sistema di comunicazione. Quando segnali con differenti frequenze condividono il mezzo di trasmissione si può avere rumore da intermodulazione. L'interferenza è l'accoppiamento indesiderato di due segnali che si propagano lungo cammini diversi. Tutti i tipi di rumore fin qui descritti, che hanno intensità ragionevolmente prevedibile e ragionevolmente costante, consentono di progettare un sistema di trasmissione efficiente. Il rumore impulsivo, invece, essendo discontinuo (consiste di picchi irregolari di breve durata e di ampiezza relativamente grande), è una delle principali cause di errore nella comunicazione di dati digitali, mentre non rappresenta un grande problema nel caso dei dati analogici.

Capacità del canale. - La velocità con cui i dati possono essere trasmessi lungo un dato percorso, o canale, in date condizioni è detta ‛capacità del canale'. La qualità di un canale dipende da alcune grandezze fra loro correlate, cioè la velocità di trasmissione, la larghezza di banda, il rumore e il tasso di errore. La velocità di trasmissione è la velocità, in bit al secondo, con cui i dati possono essere comunicati; la larghezza di banda è quella del segnale trasmesso, limitata dal trasmettitore e dalla natura del mezzo di trasmissione, ed è espressa in cicli al secondo, o hertz; il rumore è il livello medio del rumore sul canale di comunicazione; il tasso di errore, infine, è la percentuale dei casi di ricezione di un 1 quando è stato trasmesso uno 0 o viceversa.

Gli impianti per la comunicazione hanno, in generale, un costo proporzionale alla larghezza di banda. Comunque, tutti i canali di trasmissione di un qualche interesse pratico hanno una larghezza di banda limitata. Le limitazioni dipendono dalle proprietà fisiche del mezzo di trasmissione o sono deliberatamente imposte al trasmettitore per evitare l'interferenza con altre sorgenti.

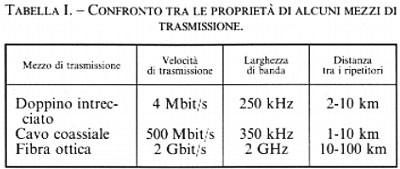

Mezzi di trasmissione. - Il mezzo di trasmissione è l'ambiente fisico tra trasmittente e ricevente in un sistema di trasmissione dei dati. Le caratteristiche e la qualità della trasmissione sono determinate sia dalla natura del segnale sia dalla natura del mezzo; nel caso dei mezzi guidati le limitazioni per la trasmissione dipendono prevalentemente dal mezzo stesso. Un confronto fra alcuni mezzi di trasmissione è riportato nella tab. I. Come abbiamo già detto, più alta è la frequenza centrale di un segnale, maggiore è la larghezza di banda potenziale e conseguentemente la velocità di trasmissione. Una proprietà dei segnali trasmessi da un'antenna è la direzionalità. In generale i segnali a bassa frequenza si propagano in tutte le direzioni, mentre a frequenze più elevate è possibile focalizzare il segnale in un fascio direzionale. Descriveremo brevemente le caratteristiche dei principali mezzi di trasmissione.

1) Il doppino intrecciato è stato uno dei primi mezzi di trasmissione usati nelle comunicazioni telefoniche ed è attualmente il mezzo più diffuso anche per le trasmissioni dati locali. I due fili, solitamente di rame, sono intrecciati insieme per minimizzare l'interferenza, nota con il nome di diafonia (crosstalk), che si ha quando doppini adiacenti sono combinati in cavi multifilo. Il doppino è, al momento, il mezzo di trasmissione meno costoso e di solito è usato per connettere attrezzature a bassa velocità, come terminali non intelligenti e modem. Può essere impiegato per trasmettere segnali sia analogici, sia digitali: per i segnali analogici sono necessari amplificatori ogni 5-6 km, mentre per quelli digitali si usano ripetitori ogni 2-3 km. Rispetto ad altri mezzi di trasmissione, il doppino è limitato dal punto di vista della distanza, della larghezza di banda e della velocità. Questo mezzo è anche altamente sensibile alle interferenze e al rumore, perché può facilmente accoppiarsi con le onde elettromagnetiche. Varie precauzioni possono essere prese per diminuire i disturbi: per ridurre le interferenze, ad esempio, si può schermare il filo con una treccia o una guaina metallica.

2) Il cavo coassiale offre una grande larghezza di banda e può sostenere grandi velocità di trasmissione con una bassa incidenza di errori e un'elevata immunità da interferenze elettromagnetiche. È formato da un filo centrale portante (carrier) circondato da un sottile rivestimento di rame, in genere tessuto a calza, e/o da un foglio di alluminio estruso. Materiali plastici (come teflon o PVC) sono usati per posizionare e isolare il filo portante. Il cavo coassiale è largamente usato nella rete telefonica per trasmettere più conversazioni su un unico cavo, soprattutto per le chiamate interurbane, e anche dall'industria della TV via cavo, per la sua capacità di trasportare contemporaneamente molti canali televisivi; inoltre è frequentemente impiegato come mezzo di trasmissione nelle reti locali per trasmettere dati sia analogici che digitali. Grazie alla sua schermatura concentrica è meno soggetto alle interferenze e alla diafonia del doppino telefonico; i principali fattori che ne limitano le prestazioni sono l'attenuazione, il rumore termico e il rumore dovuto a intermodulazione.

3) La fibra ottica è un mezzo flessibile e sottile (2-125 µm) capace di trasmettere un raggio di luce. Le fibre ottiche sono realizzate con plastica o vetro e costituiscono un mezzo di trasmissione capace di elevatissime prestazioni in alcune applicazioni. Nelle comunicazioni su fibra ottica, i segnali elettrici sono convertiti in impulsi di luce da un modulatore, trasmessi sulla fibra da una sorgente luminosa (un LED - Light Emitting Diode - oppure un diodo laser), rivelati e riconvertiti in segnali elettrici da diodi fotoelettrici. Un cavo di fibra ottica ha, in genere, una forma cilindrica e consta di tre sezioni: il nucleo, il rivestimento e la guaina esterna. Il fascio di luce, su cui è codificato il segnale, si propaga lungo la fibra per riflessione totale. Le caratteristiche che distinguono la fibra ottica dal doppino e dal cavo coassiale sono: maggiore larghezza di banda, dimensioni e peso ridotti, inferiore attenuazione, isolamento elettromagnetico e maggiore distanza fra i ripetitori. La trasmissione a lunga distanza su fibra sta diventando sempre più comune nelle reti telefoniche. I vantaggi della fibra ottica rispetto al doppino telefonico e al cavo coassiale divengono sempre più evidenti via via che cresce la domanda di un unico mezzo capace di trasmettere tutti i tipi di informazione (voce, video, immagini e dati). Per la fine del secolo la fibra ottica sarà divenuta il mezzo di trasmissione dominante, soppiantando il doppino telefonico e il cavo coassiale anche in ambito locale. Il campo dell'ottica su fibra ha avuto un'espansione eccezionale negli ultimi 25 anni, da quando per la prima volta i ricercatori cominciarono a esaminare la possibilità di utilizzare segnali luminosi attraverso fibre per ottenere trasmissioni quasi esenti da perdite.

4) Il più comune tipo di antenna per microonde è l'antenna parabolica. In genere essa è fissa ed emette un fascio sottile focalizzato per ottenere una trasmissione in linea ottica verso l'antenna ricevente. I sistemi a microonde terrestri sono usati principalmente per i servizi di telecomunicazione a lunga distanza, come alternativa al cavo coassiale per la trasmissione televisiva e vocale. L'infrastruttura basata sulle microonde necessita di un numero minore di amplificatori o di ripetitori, a parità di distanza, rispetto al cavo coassiale, ma richiede una trasmissione in linea ottica. La trasmissione a microonde si può utilizzare per la trasmissione di dati digitali su piccole aree, di raggio inferiore ai 10 km. Le frequenze comunemente usate sono fra i 2 e i 40 GHz. Come per ogni sistema di trasmissione, una sorgente importante di perdita di segnale è l'attenuazione; un'altra fonte di disturbi è l'interferenza. I segnali a microonde per comunicazioni terrestri possono risentire del fading, un fenomeno dovuto al fatto che strati di differente densità nell'atmosfera possono produrre effetti di rifrazione per cui segnali provenienti da una stessa sorgente arrivano da due diverse direzioni lungo cammini di lunghezza lievemente diversa, risultando così fuori fase e interferendo l'uno con l'altro.

5) Un satellite per telecomunicazioni è una stazione di collegamento a microonde che serve a collegare due o più trasmettitori/ricevitori a microonde al suolo. Il satellite riceve una trasmissione su una banda di frequenza ascendente, amplifica il segnale (nel caso di trasmissioni analogiche) o lo ripete (nel caso di trasmissioni digitali) e lo ritrasmette su un'altra frequenza discendente. Un singolo satellite opera su varie bande di frequenza, chiamate canali di transponder o semplicemente transponders. Perché un satellite per telecomunicazioni funzioni efficacemente si richiede in genere che la sua posizione sopra la Terra rimanga stazionaria, quindi che abbia un'orbita con un periodo uguale a quello di rotazione della Terra; i due periodi coincidono per un satellite in orbita all'altezza di 35.784 km. A causa della distanza, c'è un ritardo di propagazione di 240-300 ms fra la trasmissione da una stazione a terra e la ricezione da parte di un'altra stazione a terra. Le comunicazioni via satellite hanno prodotto una rivoluzione tecnologica paragonabile a quella delle fibre ottiche. Fra le applicazioni importanti dei satelliti citiamo come esempi la trasmissione di programmi televisivi, le comunicazioni telefoniche a lunga distanza, le reti commerciali private. Sviluppi recenti sono il sistema VSAT (v. cap. 3, § f), che fornisce un'alternativa a basso costo per alcune applicazioni commerciali, e l'uso del satellite per le comunicazioni mobili GSM (Global System for Mobile communications). A questo scopo sono usati dispositivi ricetrasmittenti piccoli e di basso costo, e la trasmissione avviene in full-duplex direttamente fra l'utente e il satellite.

6) Un uso ben noto delle trasmissioni radio per la comunicazione digitale dei dati è la packet radio, un sistema che impiega antenne a terra per collegare più siti in un'unica rete di trasmissione dati. Il limite è dato dal fatto che la trasmissione deve avvenire in linea ottica. Le velocità sono nell'ordine del kilobit al secondo.

b) Codifica dei dati e modulazione

La modulazione e la codifica sono elementi essenziali di quasi tutte le comunicazioni, in quanto rendono possibile la trasmissione di molti messaggi indipendenti su un doppino o su una fibra ottica.

Codifica. - La codifica dei dati è il processo che trasforma i segnali o i dati in ingresso in segnali che possono essere trasmessi. La tecnica di codifica è adattata al metodo di trasmissione dei dati in modo da ottimizzarne le prestazioni. La maggior parte dei dati testuali è codificata usando il codice ASCII, che usa 7 bit per rappresentare le varie lettere maiuscole e minuscole, i numeri e altri simboli speciali. Altri codici di uso comune sono il codice Baudot e il codice EBCDIC (Extended Binary-Coded Decimal Interchange Code). Il codice Baudot, dal nome di J.-M.-. Baudot che lo introdusse nel 1874, è un codice a 5 bit usato su telescriventi di buona qualità, come quelle della Telex. Il codice EBCDIC, impiegato sui dispositivi sincroni dell'IBM, consiste di caratteri codificati su 8 bit. Un dispositivo che opera con uno di questi codici non può ricevere dati direttamente da un dispositivo che usa un codice diverso senza un convertitore che traduca il codice di un dispositivo in quello dell'altro.

Modulazione. - Vi sono fondamentalmente due modi per trasmettere i segnali analogici lungo un canale: mantenendo la loro frequenza originale come un segnale in banda base, oppure associandolo a un altro segnale, detto ‛portante', opportunamente modulato e quindi trasmettendolo a una frequenza diversa, in genere maggiore. Le frequenze dei segnali portanti sono scelte in modo da essere compatibili col mezzo di trasmissione usato.

Tutte le tecniche di modulazione coinvolgono operazioni su uno o più dei tre parametri fondamentali delle frequenze, cioè ampiezza, frequenza e fase. Nella modulazione di frequenza l'ampiezza del segnale portante è mantenuta costante, mentre la sua frequenza è alterata per conformarsi al segnale messaggio. La modulazione di ampiezza altera l'ampiezza del segnale portante per adattarlo al segnale messaggio, mentre la sua frequenza rimane immutata. Nella modulazione di fase è questa proprietà del segnale portante a essere alterata, il che modifica anche la frequenza, mentre l'ampiezza rimane costante. Infine nella modulazione a impulsi (PCM, Pulse Code Modulation) la forma d'onda del segnale è codificata come una sequenza di cifre binarie che sono trasmesse come impulsi. La regola matematica che sta alla base della PCM è quella espressa dal teorema del campionamento, secondo il quale si può trasmettere l'intero messaggio contenente l'informazione inviando solo le ampiezze del segnale in istanti ben precisi, detti ‛tempi di campionamento'. Se un segnale in banda base ha componenti le cui frequenze sono tutte comprese entro una larghezza di banda B, allora esso può essere rappresentato accuratamente dalle sue ampiezze rilevate in 2B punti al secondo. Consideriamo un segnale telefonico fatto di componenti sinusoidali con frequenze nella banda da 0 a 4.000 Hz: se misuriamo questo segnale variabile, cioè la forma d'onda, 8.000 volte al secondo, le ampiezze misurate danno l'informazione necessaria e sufficiente sul segnale originario; possiamo quindi ricostruire la forma d'onda dalla successione delle ampiezze misurate. Una buona riproduzione della voce con la PCM può essere ottenuta con 128 livelli di quantizzazione, ovvero con una codifica a 7 bit (27 = 128). Un segnale vocale occupa una larghezza di banda di 4 kHz, e pertanto, in base al teorema del campionamento, la frequenza con la quale debbono essere presi i campioni è di 8.000 volte al secondo. Ciò porta a una velocità di trasmissione di 8.000 × 7 = 56 kbit/s per i dati codificati con la PCM.

c) Tecniche di comunicazione di dati digitali

Di regola i dati sono trasmessi un bit alla volta sul mezzo di trasmissione. La temporizzazione (velocità, durata, intervallo temporale) di questi bit deve essere la stessa per trasmittente e ricevente. Normalmente i dispositivi per il trattamento dei dati digitali non sono connessi direttamente a un mezzo di trasmissione e quindi non inviano direttamente segnali nel mezzo; il processo è mediato da un'interfaccia standardizzata.

Metodi di trasmissione. - La sincronizzazione è uno dei compiti fondamentali della comunicazione dati. Un trasmittente invia a un ricevente un messaggio, un bit alla volta, attraverso un mezzo di trasmissione. Il ricevente deve riconoscere l'inizio e la fine dei blocchi di bit nonché la loro durata, in modo da poter campionare la linea con la temporizzazione opportuna per leggere ciascun bit. Varie sono le modalità impiegate per ottenere la sincronizzazione richiesta.

Nella trasmissione asincrona i dati sono trasmessi un carattere alla volta (ogni carattere ha una lunghezza da 5 a 8 bit). La sincronizzazione si ottiene solo per ogni singolo carattere e il ricevente può risincronizzarsi all'inizio di ognuno di essi. I segnali che hanno origine da circuiti di temporizzazione (clocks) indipendenti non hanno in generale nessuna relazione l'uno con l'altro e hanno differenti frequenze e fase. La trasmissione asincrona è semplice e poco costosa ma richiede la trasmissione di 2 o 3 bit supplementari per ogni carattere.

La trasmissione sincrona è il metodo di comunicazione più efficiente: i blocchi di caratteri sono trasmessi senza codice di inizio e fine messaggio e può esser calcolato con esattezza il tempo di partenza e di arrivo di ogni bit. Per evitare la deriva fra la temporizzazione del trasmittente e quella del ricevente, i loro clocks devono essere sincronizzati. I segnali devono essere originati dallo stesso riferimento temporale: a tale scopo è possibile o stabilire una linea di clock separata fra trasmittente e ricevente, oppure l'informazione di clock deve essere incorporata nel segnale dati tramite una codifica bifase, se i segnali sono di tipo digitale; per i segnali analogici possono essere utilizzate diverse tecniche. Per blocchi di dati di dimensioni abbastanza grandi la trasmissione sincrona è più efficiente di quella asincrona.

La trasmissione isocrona è usata per segnali che dipendono da una temporizzazione uniforme o che trasportano l'informazione di temporizzazione come parte del segnale, come ad esempio la voce e i segnali televisivi.

Tecniche di rilevamento degli errori. - Indipendentemente dalla struttura del sistema di trasmissione, non è possibile evitare del tutto gli errori. Mentre l'incidenza di errori dovuti al rumore termico può essere ridotta fino a divenire trascurabile, il rumore impulsivo può ancora dar luogo a errori considerevoli. Le tecniche per il rilevamento degli errori si basano sul seguente principio: a un dato blocco di bit sono aggiunti dal trasmittente alcuni bit addizionali che costituiscono un codice di controllo; tale codice è calcolato come funzione degli altri bit trasmessi. Il ricevente esegue lo stesso calcolo. Si rileva un errore se e solo se non c'è corrispondenza fra i bit di controllo ricevuti e quelli calcolati. Per correggere l'errore si può usare una tecnica di rilevamento che dia al ricevente informazioni sufficienti a correggerlo. Le tecniche più comuni sono il controllo del bit di parità, il controllo della ridondanza longitudinale e il controllo della ridondanza ciclica (CRC, Cyclic Redundance Control). Più semplicemente, il ricevente può avvertire il trasmittente che è stato rilevato un errore e chiedere la ritrasmissione dei dati.

Interfacciamento. - I dispositivi per il trattamento di dati digitali hanno per la maggior parte limitate capacità di trasmissione, e anche la distanza alla quale possono trasmettere è limitata. Di conseguenza è raro che tali dispositivi - che comprendono computers e terminali e sono indicati collettivamente come apparati terminali dati (DTE, Data Terminal Equipment) - siano collegati direttamente a un mezzo di trasmissione. Un DTE fa uso del mezzo di trasmissione attraverso la mediazione di un apparato terminale di circuito (DCE, Data Circuit-terminating Equipment), per esempio un modem. Il DCE è responsabile della trasmissione e della ricezione dei bit, uno alla volta, su un mezzo di trasmissione, e inoltre deve interagire con il DTE: ciò richiede che siano scambiati sia dati sia informazione di controllo, e tale scambio avviene su un insieme di fili chiamati ‛circuiti di interscambio'. Affinché questo schema funzioni è necessario un alto grado di cooperazione. Ogni coppia DTE-DCE deve essere progettata in modo da avere interfacce complementari. L'esatta natura dell'interfaccia fra il DTE e il DCE è specificata in base a standard, noti come protocolli dello strato fisico del modello di riferimento OSI (v. cap. 4, § a). L'interfaccia ha quattro caratteristiche importanti: meccanica, elettrica, funzionale e procedurale. L'interfaccia standard di gran lunga più diffusa è la RS-232, che però è limitata a distanze brevi e a velocità di trasmissione non molto elevate; sono state pertanto messe a punto le interfacce RS-422 e RS-423, le cui prestazioni sono migliori.

d) Controllo del collegamento dati (DLC, Data Link Control)

Uno scambio di dati digitali fra due dispositivi per essere davvero cooperativo richiede la presenza di una qualche forma di controllo del collegamento, realizzata fondamentalmente tramite le seguenti tecniche.

Discipline di linea. - Le varie configurazioni per il collegamento dati si distinguono in base alla topologia, alla duplexity e alla disciplina di linea. Per topologia si intende la disposizione delle stazioni su un collegamento: se vi sono solo due stazioni, il collegamento è punto-punto; se vi sono più stazioni, si ha una topologia multipunto. La duplexity, in un collegamento, si riferisce alla direzione e alla temporizzazione del flusso dei segnali. Nelle trasmissioni simplex il flusso è in una sola direzione: per esempio, un sensore remoto può essere connesso a un host in modo da poter solamente trasmettere; oppure, un dispositivo di output come una stampante può essere configurato per poter ricevere senza trasmettere. Un collegamento half-duplex può ricevere e trasmettere, ma non simultaneamente; invece, su un collegamento full-duplex due stazioni possono contemporaneamente trasmettere e ricevere. Usando segnali digitali, la trasmissione full-duplex di solito richiede due canali di trasmissione separati (ad esempio, due doppini), mentre quella half-duplex ne richiede solo uno. Per i segnali analogici, tutto dipende dalla frequenza, a prescindere dal fatto che il mezzo usato sia guidato o non guidato. Una stazione che trasmette su una frequenza e riceve su un'altra può funzionare in modo full-duplex. Nell'uso di un collegamento è necessaria una qualche disciplina di linea: su una linea half-duplex, solo una stazione alla volta deve trasmettere; tanto su una linea half-duplex quanto su una full-duplex una stazione deve trasmettere solo se sa che il destinatario è pronto a ricevere. Vi sono tre distinte fasi nella procedura di controllo della comunicazione: 1) avvio della connessione, che determina quale stazione deve trasmettere e quale ricevere e indica che il ricevente è pronto a ricevere; 2) trasferimento dati, che avviene in uno o più blocchi di cui è notificata la ricezione; 3) terminazione, che chiude la connessione logica. Queste tre fasi fanno parte di tutte le discipline di linea, sia per i collegamenti punto-punto sia per quelli multipunto. La scelta della disciplina di linea per collegamenti multipunto dipende principalmente dal fatto che vi sia o meno una stazione designata come primaria. Le discipline più comunemente usate sono tutte varianti di uno schema noto come poll and select (sonda e scegli): la stazione primaria interroga ciclicamente una stazione secondaria per accertare se richiede dati (poll); la stazione primaria ha dati da inviare e informa una secondaria che questi stanno per arrivare (select).

Un altro tipo di disciplina di linea è la ‛contesa': in questo caso non c'è nessuna stazione primaria ma piuttosto un insieme di stazioni di pari rango. Una stazione può trasmettere se la linea è libera, altrimenti deve aspettare. Questa tecnica ha largo impiego nelle reti locali e nei sistemi satellitari. Una caratteristica comune a tutte le discipline di linea per collegamenti multipunto è la necessità di un indirizzamento.

Controllo di flusso. - Il controllo di flusso è una tecnica che consente di evitare che una stazione trasmittente sommerga di dati una stazione ricevente. Il ricevente stabilisce una dimensione massima di memoria per contenere i dati; dopo la loro ricezione, è necessario che i dati siano elaborati prima che la memoria sia disponibile a riceverne di nuovi. Il controllo di flusso evita che siano persi i dati che arrivano mentre è ancora in corso l'elaborazione di quelli precedenti. Il tipo più semplice di controllo di flusso, noto come stop and wait flow (fermati e aspetta), funziona nel seguente modo: l'entità sorgente trasmette un blocco di dati (frame); dopo la ricezione, l'entità destinataria invia un avviso di disponibilità ad accettare un nuovo blocco di dati, e solo a questo punto la sorgente può inviare il blocco successivo. Il destinatario può quindi arrestare il flusso dei dati semplicemente non fornendo l'avviso. Questa procedura funziona bene se il messaggio è inviato in grossi blocchi, ma può risultare inadeguata se si usano più frames per un singolo messaggio. In questo caso è preferibile una procedura più elaborata, come un protocollo a finestra scorrevole (sliding window). Il problema è che solo un frame per volta può essere in transito, e pertanto quando la lunghezza in bit del collegamento è maggiore della lunghezza del frame si può andare incontro a gravi inefficienze. La soluzione è ovviamente quella di consentire il transito di più frames contemporaneamente.

Controllo degli errori. - Le tecniche più comuni per il controllo degli errori che avvengono nella trasmissione dei frames sono basate sui seguenti passi: 1) rilevamento degli errori, per il quale viene normalmente usato il CRC; 2) avviso di ricezione positivo: è la conferma da parte del destinatario di aver ricevuto i frames senza errori; 3) ritrasmissione, dopo un time-out, del frame per il quale la sorgente non ha avuto un avviso di ricezione positivo entro un intervallo di tempo prestabilito; 4) avviso di ricezione negativo e ritrasmissione: se il destinatario informa di aver rilevato la presenza di errori in alcuni frames, la sorgente ritrasmette tali frames. Questi meccanismi di richiesta automatica di ritrasmissione sono definiti ARQ.

HDLC (High level Data Link Control). - Per questo tipo di controllo, sviluppato dalla International Standards Organization (ISO3309, ISO4335), viene impiegata una trasmissione sincrona. Tutte le trasmissioni avvengono in frames, di cui l'HDLC prevede tre tipi, ognuno con un diverso formato del campo di controllo. I frames contenenti informazione (I-frames) trasportano i dati che devono essere trasmessi, detti ‛dati utente'. I dati per il controllo del flusso e degli errori, che usano un meccanismo ARQ, possono essere trasportati su frames di supervisione (S-frames), oppure, con un'opportuna codifica addizionale, su I-frames. Frames non numerati (U-frames) forniscono funzioni supplementari per il controllo del collegamento. La fondamentale operazione dell'HDLC riguarda lo scambio di frames di informazione contenenti dati utente. Ogni I-frame contiene il numero di sequenza del frame trasmesso e anche un avviso di ricezione positivo, che è il numero di sequenza del prossimo frame atteso.

e) Allocazione e multiplazione del canale; accesso al canale

Quando molti nodi si contendono l'uso della rete, la capacità o larghezza di banda del canale deve essere divisa o allocata in modo da consentirne l'uso più efficiente. Il termine generico con cui viene indicato il metodo per dividere in più canali un singolo canale, in modo da poter trasmettere più segnali indipendenti, è ‛multiplazione' (multiplexing). Le tecniche di multiplazione sono state sviluppate in risposta a una domanda crescente e a una limitata capacità di canale, in un primo tempo per le trasmissioni telefoniche e in seguito per la comunicazione dei dati. Inviando molti segnali su un canale attraverso la multiplazione, si utilizza una percentuale molto maggiore del mezzo di trasmissione e si possono servire più utenti. Si può avere multiplazione a divisione di spazio, di frequenza o di tempo.

Multiplazione a divisione di spazio. - Si parla di multiplazione a divisione di spazio (space division multiplexing) quando si crea un singolo canale raggruppando insieme molti canali fisici. L'esempio più comune è rappresentato dai cavi telefonici: ognuno dei grandi cavi telefonici che vediamo ovunque è formato da centinaia o migliaia di doppini telefonici che giungono in ogni casa. Ogni telefono ha un cavo telefonico dedicato, cioè uno spazio fisico nel canale. La divisione di spazio è in genere un modo inefficiente per sfruttare il canale, dato che ogni nodo usa solo una frazione della capacità del cavo a cui è connesso; ad esempio, i segnali vocali a 4.000 Hz utilizzano solo una piccola parte della capacità disponibile su ogni doppino.

Multiplazione a divisione di frequenza. - La multiplazione a divisione di frequenza (FDM, Frequency-Division Multiplexing) è possibile quando la larghezza di banda utilizzabile del mezzo è maggiore di quella necessaria a trasmettere i segnali. La larghezza di banda di un singolo mezzo fisico è divisa in vari canali con bande di frequenza più piccole e indipendenti. Assegnando a ogni sottocanale un intervallo di frequenza proporzionato alla larghezza di banda del segnale che deve trasportare, si riesce a utilizzarne pressoché totalmente la capacità. Le reti telefoniche e radiotelevisive rappresentano gli esempi più noti dell'impiego della FDM. Per poter usare tale tecnica, è necessario che i segnali siano in forma analogica e pertanto quelli in forma digitale devono essere convertiti: questo è ciò che avviene nel caso della trasmissione dei segnali digitali di un calcolatore su una rete analogica per comunicazioni telefoniche a lunga distanza. La FDM è spesso usata insieme a tecniche di accesso e di commutazione.

Multiplazione a divisione di tempo sincrona. - Se la densità di dati che può essere trasmessa sul mezzo supera quella dei dati nei segnali digitali da trasmettere è possibile utilizzare la multiplazione a divisione di tempo sincrona (TDM, Time-Division Multiplexing). È infatti possibile trasportare segnali multipli su un singolo cammino di trasmissione alternando nel tempo porzioni di ciascun segnale. La TDM è un altro metodo per utilizzare la capacità del canale in modo efficiente. A ogni nodo è assegnato, a turno, un piccolo intervallo di tempo (time slot), durante il quale esso può trasmettere un messaggio o una sua porzione (data packet). Con la TDM ciascuna porzione di ogni messaggio occupa completamente la capacità del canale per il tempo assegnatole. Questa tecnica risolve sia il problema dell'accesso, stabilendo l'ordine in cui i nodi possono trasmettere, sia quello dell'allocazione, specificando l'intervallo di tempo durante il quale un nodo può trasmettere. Essa può essere usata per multiplare segnali digitali o analogici, ed è detta ‛sincrona' non perché la trasmissione sia effettivamente sincrona, ma perché i time slots sono preassegnati alle sorgenti in maniera stabile e la trasmissione ha luogo indipendentemente dal fatto che la sorgente abbia dati da trasmettere.

La TDM è usata anche in diversi punti della rete telefonica per trasmettere in multiplazione le comunicazioni telefoniche. Le compagnie telefoniche hanno sviluppato gerarchie di TDM, chiamate PDH (Plesiochronous Digital Hierarchy) e SDH (Synchronous Digital Hierarchy) o SOnet (Synchronized Optical network), tra le quali la più diffusa è la PDH, in cui il prefisso ‛plesio' (quasi) indica il fatto che la trasmissione non è né completamente sincrona né completamente asincrona. La rete di telecomunicazioni attualmente è quasi interamente basata sulla PDH e si evolverà in direzione di una rete mista SDH/PDH.

La SDH (standard CCITT) è attualmente in fase di installazione; essa utilizza un nuovo meccanismo per compensare gli sfasamenti nella temporizzazione di segmenti sincroni adiacenti. I dispositivi della rete SDH sono controllati tramite software, mentre quelli della rete PDH, controllati dall'hardware, risultano relativamente ‛torpidi'. La rete SOnet è stata sviluppata negli Stati Uniti ed è simile alla SDH.

Multiplazione a divisione statistica di tempo. - In un multiplatore a divisione di tempo sincrono accade in genere che molti dei time slots disponibili vadano sprecati. Un'applicazione tipica di una TDM sincrona è il collegamento di molti terminali a un unico insieme di elaboratori centrali: anche se tutti i terminali sono attivi, per la maggior parte del tempo non si ha trasferimento di dati da o verso un particolare terminale. La TDM statistica, nota anche come TDM asincrona o intelligente, rappresenta un'alternativa alla TDM sincrona, con la quale condivide la caratteristica di allocare dinamicamente i time slots su richiesta per trasmettere i dati. Il multiplatore statistico ha un certo numero di linee di I/O (input/output), a ciascuna delle quali è associato un buffer da un lato e una linea multiplata ad alta velocità dall'altro; vi sono n linee di I/O, ma solo k (k 〈 n) time slots disponibili sul frame TDM. Per quanto riguarda l'input, la funzione del multiplatore è di analizzare i buffers di ingresso, raccogliendo i dati fino a riempire un frame e inviarlo. Per quanto riguarda l'output il multiplatore riceve un frame e distribuisce gli slots di dati ai buffers di outputs appropriati. Dato che la TDM statistica sfrutta il fatto che i dispositivi a essa collegati non trasmettono continuamente, la velocità della linea multiplata è inferiore alla somma delle velocità dei dispositivi collegati e pertanto può sostenere lo stesso numero di terminali di un multiplatore sincrono. A differenza di quest'ultimo, infatti, il multiplatore statistico non invia slots vuoti. Poiché i dati arrivano alle linee di I/O e sono da queste distribuiti in maniera imprevedibile, per poter essere consegnati devono contenere anche l'indirizzo del destinatario. Vi è quindi un maggior sovraccarico per ogni slot, dato che esso deve contenere anche un indirizzo. La struttura del frame in una TDM statistica influisce sulle prestazioni. In genere, i sistemi con TDM statistica usano un protocollo sincrono come l'HDLC.

Accesso al canale. - Le tecniche di accesso, cioè le modalità con cui i nodi ottengono di accedere alla rete, sono usate per mediare fra i nodi che si contendono l'uso di un canale e sono in genere suddivise in tecniche di interrogazione ciclica (polling) e di contesa (contention).

Le tecniche di polling determinano l'ordine di accesso alla rete dei nodi, in modo da evitare conflitti diretti (cioè, collisione nell'accesso) fra i nodi. La TDM può essere considerata come una forma di polling predeterminato, in cui l'allocazione è basata sul tempo. Il controllo dell'accesso alla rete può essere effettuato da forme di polling centralizzate o distribuite. Un polling con controllo centralizzato può essere attuato in ogni topologia di rete.

Le forme più frequentemente usate di polling distribuito sono il token passing e gli slotted rings. Il token passing - che nella maggior parte dei casi è associato a una topologia ad anello, sebbene recentemente sia stato applicato anche a reti a bus - è un meccanismo in base al quale ogni dispositivo, a turno e in modo predeterminato, riceve e passa il diritto all'uso del canale. I tokens sono speciali configurazioni o pacchetti di bit, usualmente lunghi parecchi bit, che circolano lungo l'anello da nodo a nodo quando non c'è traffico di messaggi. Il possesso del token dà a un nodo l'accesso esclusivo alla rete per trasmettere il proprio messaggio, evitando quindi il conflitto con altri nodi che vogliono trasmettere. Se un nodo vuole trasmettere un messaggio, esso ‛tratterrà' il token e invierà il suo messaggio, specificando l'indirizzo di destinazione. I nodi sull'anello controllano il messaggio mentre passa. Essi identificano e ricevono i messaggi a loro indirizzati, mentre ripetono e passano i messaggi destinati ad altri nodi. Gli slotted rings impiegano una variante del controllo di accesso via token passing sulle reti ad anello. Usualmente lungo l'anello circola un certo numero di slots (pacchetti di dimensione fissa), ognuno contenente dei bit che specificano gli indirizzi della sorgente e della destinazione, l'informazione di controllo e di parità, nonché i dati. Se un nodo decide di trasmettere, aspetta uno slot libero o non usato, inserisce i dati nei campi opportuni, imposta un bit che indica che lo slot è pieno e specifica l'indirizzo della sorgente e quello del destinatario. Come nel token passing, i nodi lungo il cammino controllano se lo slot è indirizzato a loro. Il nodo di destinazione copia i dati nei suoi buffers e marca lo slot in modo da indicare che è vuoto e può essere usato dai nodi successivi.

Le tecniche di contesa prevedono l'esistenza di conflitti o collisioni e ne fanno uso per allocare il canale comune. L'accesso multiplo del CSMA/CD (Carrier Sense Multiple Access with Collision Detect) consente a ogni nodo che ha trovato il canale libero da traffico di spedire immediatamente un messaggio, eliminando così gran parte dell'attesa caratteristica delle tecniche senza contesa; ad esempio, nel polling un nodo pronto per trasmettere un messaggio deve attendere che sia completato il polling di tutti i nodi presenti, indipendentemente dal fatto che questi vogliano trasmettere o no. La ‛rilevazione di portante' (carrier sense) è la capacità di ogni nodo di rilevare il traffico sul canale (chiamata listen-before-talking). I nodi aspettano a trasmettere se sentono che c'è traffico sul canale. Però, a causa del tempo che un segnale impiega per attraversare la rete (detto ‛ritardo di propagazione'), due nodi possono individuare un canale libero esattamente nello stesso momento o quasi, dato che nessuno dei due ha ancora rilevato il segnale dell'altro, e in tal caso si avrà una collisione fra i due messaggi. Quando è rilevata una collisione, ogni nodo coinvolto smette di trasmettere e aspetta per un breve intervallo prima di tentare nuovamente. Per garantire che tutti i nodi, compreso quello che sta trasmettendo, avvertano una collisione sul canale, è necessario che i pacchetti abbiano una certa dimensione minima.

3. Reti per la comunicazione dati

Dato che un collegamento fornisce la capacità di comunicare solo fra due punti, sorge il problema di come estendere tale capacità a un gran numero di siti geograficamente distribuiti, ognuno dei quali ha la necessità di comunicare con gli altri. Per risolvere questo problema è necessario introdurre le nozioni di collegamento in rete (networking) e di commutazione (switching).

L'espressione ‛collegamento in rete' si riferisce alla configurazione delle infrastrutture di trasmissione connesse in una rete che può servire molti utenti geograficamente distribuiti; il termine ‛commutazione' si riferisce invece ai metodi con cui allocare le limitate risorse di trasmissione agli utenti; la combinazione dei due sistemi è ciò che fornisce la possibilità di connettere gli utenti in maniera economica ed efficiente. La risorsa più scarsa e più cara è sempre stata la larghezza di banda, e pertanto le tecniche usate per il collegamento in rete sono state scelte in modo da ottimizzarne l'uso. Queste tecniche sono diverse a seconda del tipo di informazione trasportata (voce, dati, video, immagini) e dell'ambito servito (area locale, area metropolitana e area ampia o geografica). Nonostante la grande varietà di reti progettate per soddisfare le diverse necessità, esse sono tutte basate su tre principali tecniche di commutazione, dette di circuito, di messaggio e di pacchetto

a) Commutazione di circuito

La commutazione di circuito, il metodo prevalente nelle comunicazioni telefoniche, è alla base della rete telefonica mondiale odierna. La comunicazione via commutazione di circuito implica la creazione di un cammino dedicato, cioè di una sequenza connessa di collegamenti fra nodi della rete, fra due stazioni che intendono comunicare. Essa è costituita da tre fasi: 1) prima che qualunque segnale possa essere trasmesso, deve essere stabilito un circuito che colleghi le due stazioni; ciò avviene sulla base delle informazioni di instradamento, della disponibilità dei vari collegamenti intermedi e magari anche del costo; 2) l'informazione può allora essere trasmessa attraverso la rete; i dati possono essere digitali o analogici, secondo la natura della rete; 3) dopo un certo periodo di trasferimento dati, la connessione è interrotta, di solito da una delle due stazioni.

Fra ogni coppia di nodi deve essere riservata la capacità del canale e ogni nodo deve essere in grado di effettuare la commutazione in modo autonomo per stabilire la connessione richiesta. Ogni commutatore deve avere la capacità di effettuare questa allocazione e di individuare un percorso attraverso la rete.

La commutazione di circuito può essere piuttosto inefficiente. La capacità del canale è riservata per tutta la durata della connessione anche se non vi sono dati da trasferire. In una rete a commutazione di circuito, sono i segnali di controllo a gestire la rete e a stabilire, mantenere e terminare le chiamate. A tal fine è necessario vi siano scambi di informazione fra l'abbonato e la centrale di commutazione, fra le varie centrali e fra la centrale e il centro di gestione della rete. Lo schema di segnalazioni di controllo necessario a una grande rete pubblica di telecomunicazioni è piuttosto complesso. L'uso della commutazione di circuito nella comunicazione dei dati è iniziato più di cinquant'anni fa con modem progettati per sistemi di trasmissione analogici. I circuiti di commutazione attualmente in uso sono le linee dedicate e l'ISDN (Integrated Services Digital Network).

Linee dedicate. - L'operatore di rete assegna all'utente un collegamento dati fisso, permanentemente disponibile per il trasporto dei dati, fornendo una certa larghezza di banda di trasmissione. In origine le linee dedicate erano usate solo per connessioni punto-punto; attualmente, invece, sistemi di accoppiamento intelligenti, come i routers, possono effettuare una gestione dinamica della larghezza di banda fra vari utenti attraverso un'unica linea dedicata. Il principale difetto rimane la limitata possibilità di commutazione. Se una rete è costituita da un certo numero di linee dedicate, l'allocazione dinamica della larghezza di banda fra differenti linee può essere ottenuta solo attraverso multiplatori flessibili, ma per riconfigurare sistemi di questo tipo può essere necessario un tempo variabile da qualche minuto a ore.

ISDN. - Questa rete estende anche al doppino telefonico attualmente in uso la capacità di trasmissione digitale e fornisce all'utente due canali commutati da 64 kbit/s e un canale a commutazione di pacchetto da 16 kbit/s. L'ISDN è una rete pubblica di telecomunicazioni digitali end-to-end e pertanto fornisce le capacità di comunicazione di base per un ampio spettro di applicazioni. L'ISDN renderà la comunicazione dei dati per qualsiasi scopo semplice quanto una telefonata; essa è stata progettata per avere estensione mondiale e per soddisfare una grande varietà di richieste dell'utente. Attualmente l'ISDN offre molteplici servizi, tra i quali l'interconnessione di reti locali, il lavoro a distanza, l'istruzione tramite computer, la compilazione e revisione di rapporti finanziari, la videoconferenza, l'accesso a basi di dati remote, la trasmissione di immagini (still video).

b) Commutazione di messaggio

Nella comunicazione di dati, gli scambi di informazione fra gli utenti avvengono sotto forma di scambi di blocchi di dati, detti ‛messaggi'. Per adattarsi meglio alle caratteristiche e alle esigenze di tali scambi è stata introdotta la commutazione di messaggio. Ai fini della trasmissione, un messaggio è composto dai dati che l'utente deve trasmettere, dall'intestazione (header) che contiene informazioni di controllo e dalla ‛somma di controllo' (check-sum) che serve per il controllo degli errori. I commutatori sono calcolatori capaci di elaborazione e memorizzazione. Per prima cosa il messaggio è trasmesso dal dispositivo dell'utente al commutatore di messaggio al quale è collegato; dopo la sua completa ricezione, il commutatore ne esamina l'intestazione e seleziona di conseguenza il successivo canale di comunicazione sul quale inoltrarlo; lo stesso processo è poi iterato da un commutatore al successivo finché il messaggio arriva al destinatario. Questa tecnica di trasmissione viene anche appropriatamente definita tecnica store-and-forward (memorizza e spedisci).

La commutazione di messaggio ha inaugurato l'odierna era della comunicazione dati nel 1847, con l'invenzione del telegrafo da parte di Morse e col sistema dei ripetitori; si è quindi evoluta producendo il ripetitore telescrivente a nastro di carta e il moderno telex, usato per operazioni finanziarie e per accedere a locazioni remote.

c) Commutazione di pacchetto

Con questa tecnica, i blocchi di dati che possono essere trasmessi sulla rete, indicati come ‛pacchetti', non possono superare una lunghezza massima assegnata. I messaggi che superano questa lunghezza sono suddivisi in più pacchetti, trasmessi indipendentemente con modalità store-and-forward. La commutazione di pacchetto, oltre a offrire i vantaggi della commutazione di messaggio, permette una allocazione dinamica ed equa della larghezza di banda anche quando i messaggi variano molto in lunghezza. In tal modo il ritardo nella trasmissione di un messaggio da trasmittente a ricevente è inferiore che nella commutazione di messaggio, in quanto molti pacchetti di uno stesso messaggio possono essere simultaneamente in trasmissione su segmenti successivi di un cammino fra sorgente e destinazione.

L'utilizzazione efficiente degli impianti di trasmissione, insieme al continuo progresso della tecnologia di elaborazione digitale (che ha finora tenuto il passo con la larghezza di banda disponibile sulle infrastrutture di trasmissione), ha reso la commutazione di pacchetto il metodo di commutazione più economico, e quindi preferito, per la comunicazione dei dati fin dalla sua comparsa, verso la fine degli anni sessanta. Ma come riesce la rete a gestire questo flusso di pacchetti, a guidarli lungo la rete e a farli pervenire al destinatario? Due sono attualmente gli approcci: il datagramma e il circuito virtuale.

Secondo l'approccio basato sui datagrammi (senza connessione), ogni pacchetto è trattato indipendentemente, senza tener alcun conto dei pacchetti già trasmessi. I datagrammi possono prescindere da procedure per il controllo delle chiamate e possono essere inviati senza curarsi del fatto che giungano effettivamente a destinazione, oppure richiedere un'esplicita notifica di ricezione. Sono meccanismi solidi e flessibili: se qualche nodo o qualche collegamento della rete non è disponibile, possono essere instradati in modo da evitare l'area malfunzionante e inoltre sono in grado di reagire più rapidamente alla congestione della rete decidendo la strada di ogni singolo pacchetto.

Nell'approccio basato sul circuito virtuale (orientato alla connessione), prima che un pacchetto possa essere inviato deve esserne prestabilito il percorso. I circuiti virtuali assicurano l'integrità della sequenza nella trasmissione dei dati utente. Dal momento che il percorso è fisso per tutta la durata della connessione logica, esso è in qualche modo simile a un circuito in una rete a commutazione di circuito e viene perciò definito circuito virtuale. Ogni pacchetto in questo caso contiene, oltre ai dati, anche un identificatore del circuito virtuale. Ogni nodo lungo il percorso sa dove inviare questi pacchetti e non ci sono da prendere decisioni al riguardo. In qualunque istante, ogni stazione può avere più di un circuito virtuale verso qualunque altra stazione e verso più stazioni. Quindi la caratteristica principale della tecnica è che il percorso fra le stazioni è fissato prima del trasferimento dei dati. Si noti che questo non significa che si tratta di un cammino dedicato, come nella commutazione di circuito; il pacchetto è ancora memorizzato in ogni nodo e messo in coda per l'output su una linea, ma il nodo decide il percorso dei pacchetti una volta per tutte.

Poiché la commutazione di pacchetto basata sui datagrammi non richiede sovraccarico per stabilire una connessione, per messaggi brevi essa risulta più veloce della commutazione basata sul circuito virtuale e forse della commutazione di circuito. Però, dato che ogni singolo datagramma è instradato indipendentemente, l'elaborazione di ciascuno di essi in ogni nodo può essere più lunga che per i pacchetti a circuito virtuale. Di conseguenza, per messaggi lunghi la tecnica a circuito virtuale può risultare superiore.

Le reti a commutazione di pacchetto sono andate evolvendosi per oltre 25 anni, passando dai sistemi X.25 e IP - progettati per funzionare su reti con scarsa capacità di trasmissione - a protocolli più semplici, come HDLC; esse formano oggi la base delle reti di comunicazione dati più avanzate. La commutazione di pacchetto ha avuto larga applicazione, specialmente in Europa, dove è utilizzata per la maggior parte dei servizi di trasmissione dati, sia pubblici che privati. Uno degli esempi meglio documentati di rete a commutazione di pacchetto è la già citata ARPAnet.

I due problemi tecnici principali delle reti a commutazione di pacchetto sono l'instradamento e il controllo del traffico.

Instradamento (routing). - La funzione primaria di una rete a commutazione di pacchetto è di accettare pacchetti da una stazione sorgente e consegnarli alla stazione di destinazione. Per svolgere questo compito, deve essere scelto almeno un cammino (route) attraverso la rete. Le proprietà che una funzione di instradamento dovrebbe avere sono la correttezza, la semplicità, la solidità, la stabilità, l'imparzialità, l'ottimalità e naturalmente l'efficienza. Le esigenze di solidità - che consistono nel far sì che la rete riesca a consegnare i pacchetti attraverso un cammino anche in presenza di guasti e sovraccarichi localizzati - possono essere in contrasto con quelle di stabilità. L'ideale sarebbe che la rete reagisse alle emergenze senza perdita di pacchetti e senza interruzione dei circuiti virtuali. Purtroppo le tecniche che reagiscono al mutare delle condizioni hanno tempi di reazione lunghi, oppure possono dar luogo a oscillazioni instabili da un estremo all'altro; per esempio, la rete può reagire alla congestione di un'area spostando la maggior parte del carico su un'altra area. A questo punto, anche questa diviene sovraccarica - mentre la prima è sottoutilizzata - e si rende necessario un altro spostamento. Durante questa serie di spostamenti, i pacchetti possono viaggiare nella rete in cammini chiusi ad anello (loops). Anche fra imparzialità e ottimalità bisogna trovare un compromesso. Alcuni criteri di efficienza possono favorire, per esempio, lo scambio di pacchetti fra stazioni vicine e scoraggiare quello fra stazioni distanti, ma questa politica può apparire ingiusta a una stazione la cui necessità primaria è quella di comunicare con stazioni lontane. Infine, ogni tecnica di instradamento comporta qualche sovraccarico di elaborazione in ogni nodo e spesso anche un sovraccarico nella trasmissione.

Controllo del traffico. - Il controllo del traffico in una rete a commutazione di pacchetto - cioè il controllo del numero dei pacchetti che entrano nella rete e che la usano, evitando che la rete diventi un collo di bottiglia e garantendo che l'uso della rete sia efficiente - è complesso e a questo riguardo è stata proposta una grande varietà di approcci. I meccanismi impiegati a tal fine sono di tre tipi, ognuno con differenti obiettivi: controllo del flusso, controllo della congestione e prevenzione delle situazioni di stallo (deadlocks).

d) Reti locali (LAN)

Un tipo di rete di comunicazione a pacchetto che ha fatto la sua comparsa nei primi anni settanta è il tipo a mezzo condiviso (shared medium), detto anche trasmissione circolare multiaccesso (multiaccess broadcast). L'intera rete in questo caso consiste di un unico mezzo di trasmissione condiviso da tutte le stazioni, le quali vi accedono in base a un protocollo di controllo (MAC, Media Access Control), e ogni accesso è limitato alla durata di un singolo pacchetto (o messaggio). In queste reti, la trasmissione di un qualunque utente è ascoltata da tutti gli altri utenti (da cui l'attributo ‛circolare'), cioè il messaggio trasmesso raggiunge tutte le stazioni, il che consente una connettività completa a un costo molto basso: ogni utente è collegato al canale comune attraverso un'interfaccia che ascolta tutte le trasmissioni e accetta i pacchetti che gli sono destinati. In sostanza, la condivisione di un mezzo secondo un protocollo multiaccesso (eseguito in modo distribuito da tutte le stazioni connesse al mezzo condiviso) costituisce la funzione di commutazione. Due sono i fattori principali che hanno contribuito alla diffusione di tali sistemi: la necessità di sfruttare in modo efficiente una risorsa di comunicazione costosa (ad esempio, un canale satellitare o un ponte radio), facendola condividere da molti utenti ‛a raffica', e la necessità di fornire un grado elevato di connettività per la comunicazione fra un gran numero di utenti ‛a raffica' (per esempio in un ambiente di rete locale, come un edificio o un campus universitario). Tali sistemi sono ora largamente usati sia in area locale sia in area metropolitana; sono quindi indicati come reti locali (LAN, Local Area Network) o reti metropolitane (MAN, Metropolitan Area Network). Si può definire una LAN come un sistema di comunicazione dati, di proprietà privata, che di solito copre un territorio abbastanza limitato, cioè una ‛area locale'.

Topologia. - Vi sono due strutture prevalenti per tali reti: la prima è quella dei cosiddetti sistemi a bus di trasmissione (broadcast bus systems), in cui tutti gli utenti sono collegati a un unico cavo attraverso semplici connettori passivi - sistemi che sono ideali per ambienti composti da un gran numero, spesso variabile, di dispositivi poco costosi che necessitano di interconnessione; la seconda è quella delle cosiddette reti ad anello (ring networks), in cui l'interfaccia di ogni dispositivo è connessa solo ai due vicini con collegamenti punto-punto unidirezionali, in modo da formare un circuito chiuso. L'interfaccia verso un anello è un componente attivo in grado sia di esaminare il flusso di dati che l'attraversa allo scopo di accedere alla rete, sia di rigenerare il segnale per ritrasmetterlo sul collegamento successivo. I messaggi (o pacchetti) si possono propagare lungo tutto l'anello, acquisendo così caratteristiche di ‛diffusione'. Le velocità complessive di trasferimento dati ottenibili su queste reti a bus e ad anello variano da 1 a 100 Mbit/s. Ciò che è importante notare qui è che la capacità di elaborazione ottenuta da tutti gli utenti non può superare la larghezza di banda del mezzo condiviso e che - data la natura distribuita della tecnica di commutazione usata e del sovraccarico a essa associato - tale capacità tende a scendere al di sotto di quanto sarebbe consentito dalla larghezza di banda fisicamente disponibile. Inoltre, anche se la massima densità di dati richiesta da un utente può essere solo una frazione della larghezza di banda del mezzo, l'interfaccia utente verso la rete deve operare alla stessa velocità del mezzo.

Cablaggio strutturato. - È opportuno sottolineare l'importanza delle infrastrutture di cablaggio, che possono essere di tipo diverso. Fisicamente una rete consiste di dispositivi attivi e passivi e del cavo che li connette. Il cablaggio strutturato definisce tanto il sistema di cavi quanto le componenti a esso connesse. Un'infrastruttura universale di cablaggio strutturato consente l'accesso a qualunque tecnologia informativa ed è indipendente dalle apparecchiature che serve; essa consente ai gestori e ai progettisti di modificare l'organizzazione della rete facilmente e con poche interruzioni del servizio. Il cablaggio strutturato per le comunicazioni si sta rapidamente affermando come un'infrastruttura per i servizi di LAN e di telecomunicazione presente in ogni edificio.

Un rilevante successo tecnologico ottenuto dall'industria delle LAN è la capacità di fornire Ethernet (10 Mbit/s), Token Ring (4 e 16 Mbit/s), FDDI/CDDI (100 Mbit/s) e perfino ATM (100/155 Mbit/s) su doppino telefonico non schermato (cablato con una distanza fra i nodi che può arrivare fino a 100 m). Per costruire collegamenti in rete basati su questi schemi strutturati di cablaggio si utilizzano in genere pannelli di connessione definiti ‛intelligenti', che forniscono un gran numero di connessioni in rete locale per tutti i tipi di cablaggio.

Ethernet. - È di gran lunga la tecnologia LAN più diffusa, tanto che si stima che nel 1994 vi fossero circa 40 milioni di nodi Ethernet installati nel mondo. La sua notorietà assicura un vasto mercato, che aiuta a mantenere competitivi i prezzi. Dai tempi del primo standard Ethernet (IEEE 802.3) le specifiche e il diritto di costruire tecnologia Ethernet sono diventati facilmente disponibili e perciò essa è ampiamente usata nell'industria dei calcolatori. Ethernet è una tecnologia LAN che permette di connettere qualsiasi tipo di calcolatore, consentendo una velocità di trasmissione compresa tra 10 e 100 Mbit/s. I supporti di trasmissione usati sono il doppino telefonico, il cavo coassiale e la fibra ottica. Il sistema Ethernet consiste di tre elementi principali: il mezzo fisico per trasportare i segnali da un computer all'altro, un insieme condiviso di regole per il controllo dell'accesso al canale Ethernet e un pacchetto, o frame, Ethernet, che consiste in un insieme standardizzato di bit per trasportare i dati nel sistema. I computers connessi a una rete Ethernet inviano dati usando pacchetti basati su protocolli di alto livello, come il protocollo TCP/IP usato su Internet.

Tecnologia token ring. - Il metodo di accesso standard IEEE 802.5 è basato su una tecnologia ‛ad anello con gettone' (token ring). L'anello inizia da un sistema principale (master) che genera anche i tokens, il cui possesso conferisce il diritto di trasmettere per un periodo di tempo definito da regole; il token circola lungo l'anello nell'intervallo fra due trasmissioni. Quando una stazione vuole trasmettere esegue le seguenti funzioni: si impadronisce del token; cambia un bit all'interno del token per marcarlo come occupato (convertendolo così in una sequenza di inizio di frame); trasmette un frame. Le altre stazioni a turno ripetono i bit del frame, passandoli alla propria vicina a valle. Una o più stazioni possono scegliere di ricevere il frame facendone una copia mentre passa attraverso di essa nel suo percorso lungo l'anello. Quando la stazione trasmittente vede ritornare il proprio frame lo toglie dall'anello e, dopo che l'ultimo dei frames trasmessi è stato rimosso dalla rete, mette in circolazione un nuovo token. Il supporto fisico per la rete Token ring può essere il doppino telefonico, il doppino schermato, il cavo coassiale o la fibra ottica. Lo standard IEEE 802.5, che è stato approvato per la prima volta nel dicembre 1984, dà le specifiche per una rete Token ring a 4 Mbit/s. Nel novembre 1988 l'IBM ha annunciato un prodotto con architettura token ring a 16 Mbit/s di seconda generazione, che usa una tecnica detta ‛rilascio precoce del gettone' (early token release) in grado di aumentare la capacità di trattamento della rete. Gli standard per questa tecnologia sono però ancora largamente incompleti.

FDDI (Fiber Distributed Data Interface). - L'FDDI è una rete locale Token ring ad alte prestazioni su fibra ottica che funziona a 100 Mbit/s su distanze fino a 200 km e che collega fino a 1.000 stazioni; data la sua grande larghezza di banda può anche essere usata come dorsale (backbone) per reti locali con supporto fisico di rame. Essa adotta una tecnologia a passaggio di token che utilizza un protocollo temporizzato il quale, ogni volta che si inserisce una nuova stazione, garantisce l'accesso all'anello entro un periodo di tempo contrattato tra le stazioni.

Il cablaggio FDDI è formato da due anelli di fibra ottica, uno che trasmette in senso orario e l'altro in senso antiorario: se uno dei due si interrompe, si può utilizzare l'altro come riserva. I due anelli sono indipendenti finché non c'è un guasto (come la rottura di un cavo), nel qual caso essi vengono congiunti o avvolti insieme per ripristinare le condizioni operative.

Un anello FDDI può operare in due modi: in modo sincrono, che garantisce ai nodi una determinata larghezza di banda e un determinato tempo di risposta; in modo asincrono, che fornisce condivisione dinamica della larghezza di banda. La larghezza di banda sincrona è allocata come percentuale del tempo di rotazione del token fino al bersaglio (TTRT, Target Token Rotation Time): se ogni nodo cattura il token e invia dati, tale percentuale è equivalente alla larghezza di banda totale sull'anello. La trasmissione asincrona prevede un'allocazione a due livelli della larghezza di banda: il modo non ristretto offre una spartizione di tempo fra tutti i nodi che vogliono inviare dati; il modo ristretto è dedicato a un singolo dialogo prolungato. Il funzionamento normale è quello non ristretto.

Reti locali ad alta velocità. - Le migliori prestazioni dei moderni calcolatori hanno indotto sempre ulteriori sviluppi nel campo delle applicazioni di rete a grande intensità di dati - come la visualizzazione scientifica e multimediale - e imposto l'aumento della velocità delle reti locali, che ha raggiunto l'ordine del gigabit al secondo. Tra le reti locali ad alta velocità ricordiamo l'‛interfaccia parallela a elevate prestazioni' (HiPPI, High Performance Parallel Interface) e l'FCS (Fibre Channel Standard).

L'HiPPI (standard ANSI X3T9) ha le sue origini nei supercomputers Cray, che usano canali a 100 Mbyte/s per comunicare con le periferiche, ed è un collegamento punto-punto per trasferimento dati ad alta velocità la cui interfaccia è ben diversa da quella delle reti locali ad accesso multiplo: difatti l'HiPPI è un sistema a circuito orientato. Il supporto fisico è costituito da 50 coppie di doppini telefonici che ne limitano il raggio d'azione a circa 25 m, ma ne rendono meno costosa la realizzazione. L'HiPPI è usata per il trasferimento ad alta velocità di grandi volumi di dati.

L'FCS definisce invece un'interfaccia per il trasferimento dei dati ad alta velocità che può essere utilizzata per collegare stazioni di lavoro, sistemi centrali, supercomputers, unità di memorizzazione e dispositivi di visualizzazione. Lo standard soddisfa la richiesta di trasferimenti molto veloci di grandi volumi di informazioni e potrebbe sollevare i produttori di sistemi dall'onere di occuparsi della gran varietà di canali e di reti attualmente installate, dato che fornisce un unico standard per la connessione in rete, per la memoria e per il trasferimento dati. L'FCS è un collegamento seriale veloce in grado di soddisfare anche le esigenze di protocolli di più alto livello, come l'FDDI, l'SCSI (Small Computer System Interface), l'HiPPI e l'IP. Questa tecnologia veloce (fino a 1 GBit/s) può essere convertita per l'uso nelle reti locali aggiungendo un commutatore, che gestisce l'indirizzamento multipunto e pertanto è possibile che in futuro essa potrà essere utilizzata sia come tecnologia di I/O, sia come tecnologia di rete locale. Si cominciano a installare sia collegamenti FC (Fibre Channel) in dispositivi di memoria di massa, sia collegamenti di più sistemi a cluster, che raggiungono velocità da 266 a 1.062 Mbit/s e tempi di latenza dell'ordine dei decimi di microsecondo e consentono di ottenere benefici economici che cominciano a divenire evidenti.