Sistemi dinamici. Origini e sviluppo

Sistemi dinamici. Origini e sviluppo

La teoria dei sistemi dinamici è un settore della matematica pura e applicata che si è sviluppato intensamente a partire dagli anni Sessanta del secolo scorso. Essa si occupa dell'analisi delle soluzioni di equazioni che descrivono l'evoluzione di sistemi fisici, chimici, biologici, ecc. Nello studio teorico di qualsiasi sistema fisico reale è inevitabile un processo di maggiore o minore idealizzazione del sistema stesso. Dobbiamo decidere quali sono gli aspetti fondamentali che ci interessano e ignorare tutti quei particolari che ci sembrano non essenziali alla descrizione del fenomeno in studio. Occorre "difalcare gli impedimenti", per riprendere una celebre espressione di Galileo Galilei.

Poiché in una operazione del genere è insita una grande arbitrarietà, il nostro procedimento conoscitivo avrà un senso solo se la nostra descrizione rimarrà sostanzialmente invariata includendo qualcuno degli effetti inizialmente trascurati: in altre parole la nostra descrizione del sistema dovrà possedere delle buone proprietà di stabilità. Per essere concreti prendiamo in considerazione il moto libero di un pendolo nell'aria, dapprima in un breve intervallo di tempo e successivamente per un tempo molto lungo (rispetto al periodo di oscillazione). Nel primo caso non commettiamo un sensibile errore sia includendo, sia tralasciando la forza di attrito; le proprietà qualitative del moto saranno quelle di un sistema conservativo. Nel secondo caso la dissipazione di energia fa sì che le proprietà del moto siano completamente diverse se includiamo l'attrito: il moto, anziché persistere, termina dopo un certo lasso di tempo.

Questo esempio del tutto elementare ci suggerisce una prima possibilità di classificazione qualitativa dei moti, e quindi dei sistemi dinamici, in conservativi e dissipativi. La nostra scelta della idealizzazione da applicare dovrà innanzi tutto tener conto di questa importantissima distinzione. Meno importante sarà invece includere o trascurare gli effetti che non cambino la categoria scelta per il sistema. Ovviamente, la classificazione può procedere per raffinamenti successivi all'interno di ciascuna categoria, dando luogo a sottoclassi di sistemi con proprietà simili che potremo chiamare classi di stabilità.

Il tentativo di arrivare a una classificazione completa dei moti ha costituito la motivazione principale nello sviluppo della cosidetta teoria qualitativa o geometrica dei sistemi dinamici. Tuttavia, nella considerazione dei sistemi dinamici, si può adottare un altro punto di vista, particolarmente interessante quando si segue il moto per un tempo molto lungo e alcune sue caratteristiche sembrano stabilizzarsi: si è cioè in presenza di stati stazionari. Anche in questo caso ricorriamo a un esempio classico.

Consideriamo il sistema costituito dalle molecole di un gas in un recipiente con pareti elastiche. A un certo istante il gas viene fatto espandere in un volume più grande e dopo qualche tempo raggiunge uno stato in cui le molecole appaiono comportarsi in modo omogeneo sia rispetto allo spazio che al trascorrere del tempo.

Quando parliamo di comportamento delle molecole non ci riferiamo a una sola di esse ma al comportamento medio di gruppi sufficientemente numerosi. Più precisamente, per omogeneità o stazionarietà rispetto al tempo intendiamo che le nostre osservazioni, che rappresentano sempre delle medie su intervalli di tempo abbastanza lunghi se confrontati con quelli microscopici e su regioni spaziali abbastanza grandi rispetto alle dimensioni molecolari, non variano sensibilmente se effettuate in istanti diversi e in regioni diverse dello spazio. In altri termini certe proprietà statistiche del moto si stabilizzano. Da ciò discende quindi l'idea che si possa avanzare una possibile classificazione dei moti rispetto alle loro proprietà statistiche.

Lo sforzo di classificazione delle proprietà statistiche dei moti ha dato luogo a quella che viene chiamata teoria ergodica dei sistemi dinamici. Essa è nata nell'ambito dei sistemi conservativi ed è stata successivamente applicata allo studio dei sistemi dissipativi.

In questo capitolo cercheremo di illustrare alcune idee fondamentali della teoria seguendo la suddivisione in proprietà qualitative e proprietà statistiche che abbiamo introdotto. Cominceremo con alcuni richiami storici che mostrano come i due punti di vista si sono intrecciati in molti modi con mutuo vantaggio.

Alle origini

Supponiamo di aver individuato una equazione per descrivere approssimativamente l'evoluzione di un fenomeno fisico.

Tale descrizione risulterà utile solo se l'aspetto geometrico delle traiettorie non muta qualitativamente per piccole variazioni dell'equazione stessa. Questa proprietà verrà chiamata in epoca moderna stabilità strutturale.

Dal punto di vista matematico l'idea di stabilità strutturale nasce da un concetto di tipicità o genericità di largo uso in matematica e in particolare in topologia. La prima formulazione rigorosa di questa idea fu data nel 1937 in un noto lavoro di Alexandr A. Andronov e Lev S. Pontryagin, l'uno ingegnere e l'altro matematico, e rifletteva un'esigenza sentita in modo acuto nelle applicazioni tecniche della fisica.

Tuttavia alcune idee fondamentali della teoria qualitativa delle equazioni differenziali sono emerse nell'Ottocento nel campo della meccanica celeste, dove non si poneva alcun problema di stabilità della descrizione in quanto le equazioni del moto erano quelle della dinamica newtoniana con interazioni gravitazionali la cui validità nessuno avrebbe osato mettere in dubbio.

Metodi qualitativi vennero sviluppati da Henri Poincaré con la scoperta delle cosidette orbite omocline nel problema ristretto dei tre corpi. Le orbite omocline sono traiettorie che tendono allo stesso punto quando il tempo tende all'infinito passato e all'infinito futuro. Sotto condizioni molto generali che descriveremo nel seguito, l'evoluzione di un sistema nei pressi di un'orbita omoclina è estremamente complessa (si tratta tipicamente di traiettorie che verranno poi chiamate caotiche) e a questa complessità è associata una perdita di validità dei metodi perturbativi. Le ricerche di Poincaré vennero sviluppate negli anni Trenta da George D. Birkhoff, il quale mostrò l'esistenza di insiemi molto complicati di orbite periodiche di periodo molto lungo nelle vicinanze di un'orbita omoclina.

Si trattava di ricerche di carattere generale e quindi piuttosto astratte. Nuove idee vennero dallo studio di equazioni particolari: per costruire modelli del funzionamento delle valvole termoioniche Balthasar van der Pol introdusse nel 1920 una classe di equazioni, che oggi portano il suo nome, adatte alla descrizione di oscillatori non lineari con o senza termine forzante. Negli anni Quaranta Mary L. Cartwright, John E. Littlewood e Norman Levinson scoprirono che questa classe di equazioni possedeva soluzioni più complicate di qualsiasi soluzione di equazione differenziale nota fino a quel momento. Le ragioni di questa complessità furono chiarite da Steven Smale negli anni Sessanta, circa settant'anni dopo i lavori di Poincaré.

Dal canto suo la teoria ergodica, che cerca di analizzare i sistemi dinamici rispetto alle loro proprietà statistiche. Per lungo tempo è stata identificata dai fisici con l'analisi della tendenza dei corpi macroscopici (considerati come sistemi meccanici con un grandissimo numero di gradi di libertà) a evolvere verso uno stato stazionario di equilibrio. A questo problema è legato in particolare il nome di Ludwig Boltzmann, che introdusse anche il termine 'ergodico'.

La teoria ergodica rigorosa si è tuttavia sviluppata inizialmente nell'ambito dei sistemi con pochi gradi di libertà. Per comprenderne le ragioni occorre tornare a Poincaré e alle sue scoperte in meccanica celeste: infatti i metodi qualitativi di analisi delle traiettorie da lui sviluppati e applicati al problema dei tre corpi avevano mostrato la possibilità di evoluzioni molto complesse (caotiche) in sistemi con pochi gradi di libertà e vi è un legame stretto tra le proprietà statistiche di un sistema dinamico e il fatto che le sue traiettorie siano, appunto, caotiche.

I fondamenti della teoria ergodica furono elaborati da Birkhoff, Aleksandr Ya. Khinchin e John von Neumann negli anni Trenta. Le loro ricerche furono tuttavia di carattere generale e non affrontarono lo studio delle proprietà statistiche di sistemi meccanici particolari.

Il primo risultato concreto di grande portata è dovuto a Yakov G. Sinai, che negli anni sessanta studiò le proprietà statistiche di un biliardo con ostacoli: la dimostrazione completa, un lavoro monumentale, fu pubblicata nel 1970. Da allora il progresso è stato molto lento e a tutt'oggi non esiste una trattazione adeguata delle proprietà statistiche dei sistemi oggetto di studio della termodinamica, anche nel caso di un gas di molecole interagenti.

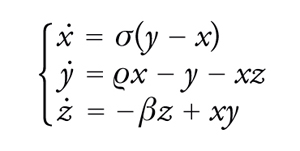

Nello stesso periodo, nel 1963, veniva pubblicato un lavoro del meteorologo Edward Lorenz dove veniva mostrato numericamente il comportamento caotico di un sistema dinamico a tre gradi di libertà. Si trattava di un sistema ottenuto attraverso un processo di riduzione da una equazione idrodinamica largamente usata nelle previsioni meteorologiche e il risultato di Lorenz indicava chiaramente le ragioni dell'impossibilità di predizioni a lungo termine. Con questo lavoro il caos deterministico oltrepassava la cerchia degli specialisti ed entrava nella cultura scientifica generale.

Verso la metà degli anni Cinquanta nasceva infine un nuovo capitolo della teoria dei sistemi dinamici, la cosiddetta teoria KAM, dalle iniziali dei suoi fondatori Andreij N. Kolmogorov, Vladimir I. Arnold e Jürgen Moser. Questa teoria ha costituito una vera e propria svolta concettuale: infatti, tra le idee prevalenti tra i fisici vi era quella che per un sistema valesse solo l'alternativa moti regolari (periodici o quasi periodici) o moti ergodici con forti proprietà statistiche. La teoria KAM ha mostrato che esistono situazioni intermedie in cui sono presenti gli uni e gli altri in proporzioni arbitrarie.

Teoria qualitativa dei sistemi non lineari: l'emergere del comportamento caotico

Il pendolo

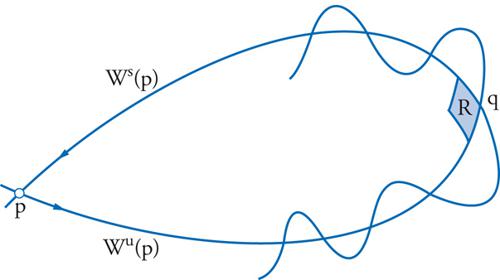

Introduciamo alcune idee partendo dal semplice esempio del pendolo, che rappresenta un caso paradigmatico. Esso è descritto dall'equazione del secondo ordine θ¨=−senθ, dove θ misura la deviazione angolare del pendolo dalla verticale. Si sono scelte unità in cui tutte le costanti fisiche sono uguali a 1. Possiamo riscrivere questa equazione come sistema del primo ordine:

[1] formula.

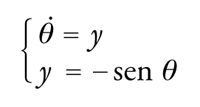

Nell'analisi delle equazioni differenziali è opportuno passare a una descrizione ridotta in cui le soluzioni vengono considerate a istanti di tempo discreti, per esempio multipli di un dato tempo T. Definiamo allora la trasformazione φ(θ,y)=(θ~,y~) quando la soluzione del nostro sistema è tale che (θ(0),y(0))=(θ,y) e (θ(T),y(T))=(θ~,y~). La φ possiede due punti fissi in corrispondenza delle posizioni di equilibrio del pendolo (θ=0,y=0) e (θ=π,y=0). La prima è una posizione di equilibrio stabile, mentre la seconda è instabile. Concentriamoci sulla seconda e definiamo le corrispondenti varietà stabile e instabile. In generale, dato un punto fisso p di una trasformazione, a esso possono essere associate una varietà stabile Ws(p)={x: ϕi(x)→p, i→+∞} e una varietà instabile Wu(p)={x: ϕi(x)→p, i→−∞}, dove i indica il numero di iterazioni della trasformazione. Nel nostro caso x rappresenta la coppia (θ,y) e la conservazione dell'energia ci dice che entrambe le varietà sono descritte dall'equazione −cosθ+1/2y2=1: esse sono perciò coincidenti. La traiettoria che inizia e termina nella posizione di equilibrio instabile è un'orbita omoclina. Se ora perturbiamo leggermente l'equazione del pendolo in modo tale da rimuovere la degenerazione tra le varietà stabile e instabile, queste si incontreranno almeno in un punto q, detto punto omoclino. Iterando allora la trasformazione del punto omoclino ci rendiamo conto che, per la loro stessa definizione, le due varietà dovranno intersecarsi infinite volte (fig. 1).

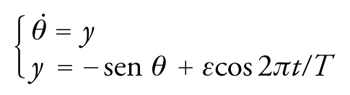

È questo un meccanismo fondamentale di generazione del comportamento caotico. Infatti, le infinite intersezioni costringono le varietà stabile e instabile ad avere una struttura geometrica molto complessa che si trasmette alle orbite vicine. La conseguenza è che, iterando la trasformazione, due punti vicini tra loro nei pressi di un punto omoclino tenderanno ad avere storie molto diverse e a perdere memoria uno dell'altro. Questo fenomeno nella letteratura moderna viene chiamato dipendenza sensibile dalle condizioni iniziali e lo illustreremo in dettaglio più avanti. La natura caotica del moto può essere rivelata registrando per esempio i tempi di passaggio del pendolo nella posizione più bassa: si può mostrare che essi formano una sequenza di numeri non distinguibile da una sequenza casuale (preciseremo questo punto nella successiva discussione relativa al problema dei tre corpi). Per ottenere un punto omoclino basta aggiungere alle equazioni del pendolo una piccola perturbazione periodica, per esempio modificando le equazioni come segue:

[2] formula.

La trasformazione discreta naturale da considerare è quella che corrisponde a un intervallo di tempo uguale al periodo della perturbazione esterna. Naturalmente, non tutte le condizioni iniziali danno luogo a moti caotici, e l'analisi delle diverse regioni dello spazio delle fasi rispetto ai tipi di moto possibili è molto complessa.

Il problema ristretto dei tre corpi

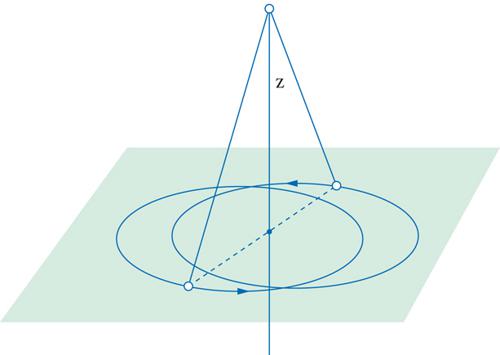

Prima di descrivere un po' più in dettaglio il meccanismo che genera il caos, citiamo un altro esempio che, come accennato nella sezione 1, ha avuto un ruolo storico di grande importanza: il problema ristretto dei tre corpi. Si considerino due corpi puntiformi di massa uguale e soggetti all'attrazione newtoniana. Essi descriveranno orbite ellittiche in un piano e il loro baricentro sarà in quiete (fig. 2). Si consideri poi una terza massa, trascurabile rispetto alle prime due, che si muove perpendicolarmente al piano precedente lungo una retta che passa per il baricentro delle prime due. Il problema consiste nello studiare il moto del terzo corpo, in particolare gli istanti di attraversamento del piano. Se indichiamo con z la quota di questo corpo, la legge di gravitazione di Newton fornisce l'equazione z¨=−z/(z2+r2(t))3/2. La r(t) è una funzione periodica che rappresenta la distanza di una delle due masse grandi dal baricentro e può essere scritta nella forma r(t)=1/2(1−εcos t)+O(ε2) dove ε è l'eccentricità, supposta piccola. Si dimostra l'esistenza di orbite che compiono infinite oscillazioni e che i tempi di attraversamento del piano z=0 costituiscono una successione non distinguibile da una successione casuale. Più precisamente il risultato è il seguente: si consideri una soluzione dell'equazione precedente che attraversi infinite volte il piano z=0 negli istanti tk, con k=0,±1,±2,... ordinati secondo valori crescenti. Si introducano gli interi sk=[(tk+1−tk)/2π], che misurano il numero di rivoluzioni complete delle masse grandi tra uno zero e l'altro di z(t) ([a] rappresenta la parte intera di a). Allora per eccentricità ε sufficientemente piccole esiste un numero m(ε) tale che qualsiasi successione di interi sk≥m corrisponde a una soluzione dell'equazione differenziale. È chiaro l'interesse di simili risultati per l'astronomia. Lo studio dei moti caotici del Sistema solare ha avuto notevolissimi sviluppi negli ultimi anni, con risultati sorprendenti.

Il modello di Smale del ferro di cavallo

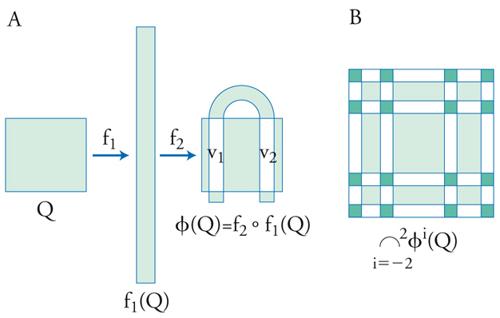

Il meccanismo geometrico fondamentale che produce un comportamento caotico in presenza di intersezioni omocline è stato chiarito da Smale negli anni Sessanta attraverso la costruzione di un modello a cui è possibile ricondursi sotto condizioni molto generali. Tale modello viene chiamato ferro di cavallo e lo illustreremo brevemente. Si consideri nel piano un quadrato Q che assoggettiamo a una trasformazione ϕ=f2∘f1 ottenuta dall'applicazione in successione di due operazioni più semplici f1 e f2: la prima operazione consiste nel contrarre linearmente il quadrato nella direzione orizzontale e dilatarlo in quella verticale; la seconda nel ripiegare a ferro di cavallo il rettangolo ottenuto dalla prima operazione come indicato nella fig. 3A. Indichiamo con V1 e V2 le intersezioni di ϕ(Q) con Q. Le iterazioni successive si costruiscono nel modo seguente: l'iterazione al passo n+1 agisce sull'intersezione con il quadrato di partenza dell'insieme ottenuto al passo n. Smale considera allora l'insieme Λ dei punti che non escono mai da Q quando si applica ϕ. Per definizione Λ= ∩∞n=−∞ϕn(Q). È facile rendersi conto che Λ= ∩Νn=−Nϕn(Q) è costituito dalle intersezioni di strisce verticali e orizzontali, queste ultime corrispondenti ai valori negativi di n, di larghezza decrescente (fig. 3B): si dimostra che il limite per N che tende all'infinito è un insieme di Cantor.

A ogni punto p di Λ si può ora associare una sequenza infinita di simboli {sk}, dove sk può assumere i valori 1 o 2 in base alla regola ϕk(p)∈Vsk. A ogni punto si fa quindi corrispondere la storia delle sue visite nelle strisce verticali V1 e V2 sotto l'azione della trasformazione. Si dimostra che questa corrispondenza è biunivoca e bicontinua, cioè che si tratta di un omeomorfismo. Si può ora comprendere facilmente il comportamento caotico della dinamica sull'insieme Λ. Data una sequenza di lunghezza finita {sk} con ∣k∣≤N, essa corrisponde a un sottoinsieme infinito (non numerabile) di punti di Λ, cioè tutti i punti che hanno questa sequenza come segmento iniziale; le storie successive di tali punti, tuttavia, sono indipendenti, poiché per k maggiore di N i simboli corrispondenti possono essere scelti arbitrariamente.

Torniamo allora ai punti omoclini. Con riferimento alla fig. 1, si immagini di costruire un piccolo parallelogramma R che contenga il punto q. Per esempio, si possono prendere per lati due segmenti giacenti l'uno sulla varietà instabile Wu(p), l'altro su quella stabile Ws(p) e intersecantisi in q. Gli altri due lati saranno segmenti paralleli ai precedenti e uscenti dalle estremità opposte a q. Si può allora dimostrare che una opportuna potenza ϕl della trasformazione che definisce la dinamica possiede un insieme invariante Λ⊂R su cui le traiettorie sono caotiche in modo del tutto analogo a quelle del ferro di cavallo di Smale. Questo risultato è noto con il nome di teorema di Birkhoff-Smale.

I moti caotici nel Sistema solare

Il caos è presente un po' ovunque nel Sistema solare. Si osserva nel moto dei corpi minori come gli asteroidi, le comete e i piccoli satelliti, per esempio il satellite di Saturno chiamato Iperione. Ma anche i pianeti maggiori hanno probabilmente avuto periodi di moto caotico nella loro storia, specialmente per quanto riguarda l'evoluzione della loro obliquità, vale a dire l'inclinazione del piano equatoriale del pianeta rispetto al piano dell'orbita. È stato dimostrato che l'obliquità della Terra è attualmente stabile a causa della presenza della Luna, a cui dobbiamo quindi la possibilità stessa della vita. L'inclinazione di Marte subisce invece grandi variazioni caotiche tra 0° e 60°. Su periodi dell'ordine del miliardo di anni anche le orbite dei pianeti presentano importanti variazioni caotiche, che potrebbero portare a una fuga di Mercurio dal Sistema solare o a una sua collisione con Venere.

L'interesse che riveste lo studio dei moti caotici nella storia del Sistema solare è legato alla possibilità o meno di ottenere informazioni sulla formazione di quest'ultimo a partire dai dati alla situazione attuale. Per esempio, se le obliquità dei pianeti osservate potessero identificarsi con quelle primordiali avremmo un vincolo nell'interpretazione del processo di formazione. Purtroppo questo non è il caso. I grandi progressi recenti nella simulazione della dinamica planetaria permettono di ricostruire in modo attendibile la storia del sistema per molti milioni di anni, e mostrano che moti caotici sono intervenuti nell'evoluzione dell'obliquità di tutti i pianeti per effetto delle loro interazioni reciproche. È interessante notare che lo studio di questo problema si riduce all'analisi di perturbazioni quasi periodiche di un oscillatore, il cui prototipo è l'esempio del pendolo perturbato da noi considerato nel capitolo precedente.

La teoria KAM

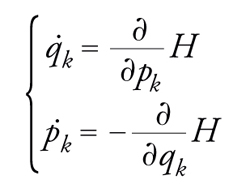

Ci si può chiedere a questo punto come siano possibili i moti regolari che appaiono dominanti nel Sistema solare e a cui dobbiamo una situazione sufficientemente tranquilla da garantire la nostra esistenza. Una risposta qualitativa a questa domanda viene dalla teoria di Kolmogorov-Arnold-Moser, o teoria KAM, che trae la sua origine dal seguente problema di stabilità. Consideriamo le equazioni di un sistema meccanico in forma hamiltoniana. Esso è descritto da coordinate e momenti (q1,...,qn,p1,...,pn) che soddisfano le equazioni

[3] formula.

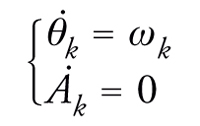

Supponiamo che esista una trasformazione canonica che permetta di passare a nuove variabili Ak,θk tali che le equazioni del moto prendano la forma

[4] formula.

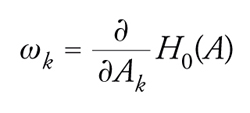

Le Ak sono quindi costanti del moto, mentre le θk effettuano un moto periodico o quasi periodico se le frequenze ωk sono tra loro razionalmente indipendenti. In tale situazione si dice che il sistema è integrabile. Ci chiediamo cosa accade se perturbiamo debolmente un sistema integrabile. Sia H0(A1,…, An) la funzione hamiltoniana non perturbata e supponiamo che il sistema perturbato sia descritto dalla hamiltoniana

[5] H(A1, …, An, θ1, …, θn, μ)=

=H0(A1, …, An)+ μH1(A1, …, An, θ1, …, θn)+ …

dove μ è un parametro piccolo e H è una funzione analitica reale di 2n+1 variabili; H1 è periodica nelle θk. Ci chiediamo in particolare cosa accade dei moti quasi periodici descritti da H0 quando si accende la perturbazione. Consideriamo quelle frequenze

[6] formula

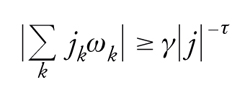

che, oltre a essere razionalmente indipendenti, soddisfano la condizione

[7] formula

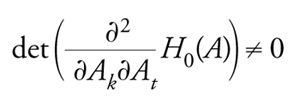

per tutti gli interi jk tali che ∣j∣=∑k∣jk∣≥1, con γ e τ costanti positive. Il teorema KAM afferma che sotto la condizione aggiuntiva

[8] formula

per piccoli valori di ∣μ∣si possono trovare nuove coordinate θ′ tali che θ∙′k=ωk. È importante sottolineare che le frequenze ωk vengono mantenute fisse quando si accende la perturbazione. Ciò è reso possibile dalla condizione supplementare [8].

Per molto tempo si è ritenuto che le perturbazioni dei sistemi integrabili distruggessero tutti i moti quasi periodici dando luogo a un comportamento caotico. Il teorema KAM, nella forma in cui l'abbiamo enunciato, può dare l'impressione che sia vero esattamente l'opposto, cioè che essenzialmente tutti i moti quasi periodici vengano conservati poiché il complemento dell'insieme delle frequenze che soddisfano alla relazione [7] per qualche valore di γ e τ ha misura nulla. In realtà, la condizione che il parametro μ sia sufficientemente piccolo dipende dal valore di γ e ciò implica che non tutti i moti quasi periodici sopravvivono alla perturbazione. Il teorema KAM stabilisce quindi che una parte di essi viene preservata dalla perturbazione. Questa affermazione significa che le condizioni iniziali nello spazio delle fasi cui corrispondono moti quasi periodici costituiscono un insieme di volume positivo. Ciò fu empiricamente scoperto in un celebre esperimento numerico di Enrico Fermi, John R. Pasta e Stanislaw Ulam ‒ di poco precedente il primo lavoro di Kolmogorov sull'argomento ‒ consistente nello studio dell'equipartizione dell'energia tra i gradi di libertà di una catena di oscillatori non lineari interagenti debolmente. Il sorprendente risultato dell'esperimento fu che non si osservava alcuna equipartizione.

Teoria statistica dei sistemi dinamici

Sistemi conservativi

In una visione gerarchica e newtoniana del mondo naturale, i sistemi considerati sono conservativi. Infatti, dalla scala planetaria a quella atomica e subatomica le forze che agiscono tra elementi di materia sono conservative e la grande maggioranza dei fisici ritiene che se esiste una teoria ultima del mondo ‒ una teoria del tutto, come si usa dire attualmente ‒ questa debba essere basata su un modello conservativo. È quindi naturale esaminare i sistemi conservativi per primi, anche perché a essi si riferisce il problema della tendenza all'equilibrio dei sistemi termodinamici posto da Boltzmann nel secolo scorso. Occorre dire subito che questo problema a tutt'oggi non ha avuto una soluzione soddisfacente: la sua formulazione matematica è tutt'altro che ovvia e alla fine di questo paragrafo discuteremo alcune impostazioni possibili. Molte difficoltà sono legate alla necessità di considerare un numero di gradi di libertà che tende all'infinito.

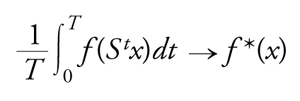

I sistemi conservativi classici posseggono misure invarianti naturali. L'esistenza di misure invarianti è un'ipotesi fondamentale della teoria ergodica. Cominciamo con l'introdurre alcuni concetti della teoria ergodica che sono indipendenti dal numero di gradi di libertà del si-stema. Sia M un insieme sulla cui natura non facciamo ipotesi particolari e supponiamo che sui sottoinsiemidi M sia assegnata una misura di probabilità μ. Per fis-sare le idee, M può essere l'insieme delle posizioni e delle velocità accessibili a un sistema dinamico, cioè lo spazio delle fasi (di solito una varietà differenziabile), mapuò anche essere costituito da elementi discreti. Definiamo la dinamica come un gruppo di trasformazioni di M che dipendono da un parametro t e conservano la misura. Se indichiamo con St tali trasformazioni, avremo μ(A)=μ(StA)=μ(S−tA), dove A⊂M. La terna (M,St,μ) viene chiamata sistema dinamico astratto e costituisce l'ambiente naturale per lo sviluppo della teoria ergodica. Il primo teorema ergodico, dimostrato da John von Neumann nel 1929, afferma che al tendere di T all'infinito si ha

[9] formula

dove f è una funzione a quadrato integrabile definita su M. La funzione f* ha le seguenti proprietà: (a) è invariante, vale a dire f*(Stx)=f*(x); (b) ∫Mfdμ=∫Mf*dμ. La convergenza è quella della media quadratica.

Il teorema fu poco dopo raffinato da Birkhoff e Khinchin che, indipendentemente, mostrarono la convergenza per quasi tutti i punti iniziali x (questa locuzione significa per tutti i punti x eccetto un insieme di misura o probabilità zero).

Il contenuto di questi teoremi implica che la media temporale, per la classe delle funzioni considerate, tende a stabilizzarsi al crescere del tempo e dipende solo dall'orbita passante per x. Un risultato così generale è un buon punto di partenza, poiché la misura di una qualunque grandezza fisica relativa a un sistema termodinamico richiede tempi lunghi rispetto a quelli della dinamica microscopica (tempi di collisione tra le molecole) e deve quindi intendersi come una media temporale della grandezza in questione. Tuttavia, la nostra intuizione vorrebbe che non ci fosse neppure la dipendenza dall'orbita considerata. Infatti, quando studiamo per esempio un gas, noi fissiamo solo alcune grandezze macroscopiche come energia totale, pressione o temperatura e non abbiamo alcuna idea di quale sia lo stato dinamico delle molecole. Una tale proprietà di indipendenza delle medie temporali dall'orbita considerata in generale non è vera. Chiameremo ergodici solo quei sistemi per cui le medie temporali sono delle costanti. In tal caso

[10] f*(x)=∫Mf(x)dμ

per quasi tutti i punti x, cioè per tutti gli x meno un insieme di μ-misura 0. Sistemi ergodici sono, per esempio, i sistemi integrabili della meccanica classica quando le frequenze sono razionalmente indipendenti: si tratta, cioè, dei sistemi di equazioni lineari

[11] θ∙k = ωk

dove k=1,2,...,n, le θk sono variabili angolari su di un toro a n dimensioni e gli ωk numeri reali razionalmente indipendenti. Quest'ultima ipotesi fa sì che le orbite del sistema siano dense sul toro. La misura invariante è data dall'elemento di volume. Si comprende quindi facilmente come la densità delle orbite permetta l'uguaglianza delle medie temporali con quelle spaziali.

L'importanza dell'ergodicità sta nel fatto che essa permette di sostituire lo studio della dinamica, praticamente impossibile quando il numero dei gradi di libertà è elevato, con il calcolo di medie effettuate con la misura invariante μ, che chiameremo anche misura di equilibrio. In particolare, un'importante conseguenza dell'ergodicità è che, se nel teorema precedente scegliamo una funzione f che valga 1 su una data regione dello spazio delle fasi e 0 altrove, troviamo che la percentuale di tempo spesa dal sistema dentro quella regione è pari alla probabilità di trovarvi il sistema stesso. Questa considerazione ha avuto un ruolo rilevante nel pensiero di Boltzmann.

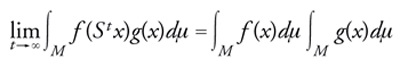

Tuttavia l'ergodicità non è sufficiente per lo scopo dei fisici: occorre rendersi conto che mentre assicura la sostituibilità delle medie temporali con medie fornite da una distribuzione di probabilità invariante nel tempo, non garantisce che essa venga raggiunta a partire da una diversa distribuzione iniziale. Perché questo avvenga è necessaria una proprietà più forte, definibile nella forma seguente: il sistema dinamico (M,St, μ) è mescolante (mixing) se la dinamica rende i sottoinsiemi di M statisticamente indipendenti. Ciò si può esprimere matematicamente come segue:

[12] formula

dove f e g sono funzioni a quadrato integrabile. Mostriamo allora che se il nostro sistema è mescolante e inizialmente descritto da una distribuzione di probabilità μ0, questa evolverà tendendo asintoticamente alla distribuzione di equilibrio μ. L'evoluzione è definita dall'equazione μt(A)=μ0(S−tA), dove A è un sottoinsieme di M; sotto un'ipotesi aggiuntiva che commenteremo in seguito, μt(A) tende a μ(A). Tale ipotesi è che μ0(A)=∫Ap(x)dμ, cioè μ0 possiede una densità rispetto alla misura di equilibrio μ. Infatti in tal caso

[13] μt(A)=∫MχA(Stx)p(x)dμ →

→ ∫MχA(x)dμ∫Mp(x)dμ=μ(A)

dove χA è la funzione indicatrice dell'insieme A. L'argomento è identico se sostituiamo χA con qualsiasi funzione a quadrato integrabile. Ne risulta che i valori medi sulla distribuzione iniziale di una grandezza fisica tendono ai valori medi calcolati con la distribuzione di equilibrio e quindi coincidono con le medie temporali.

Cerchiamo di capire meglio il risultato ottenuto. L'ipotesi che μ0 possieda una densità rispetto alla misura di equilibrio μ esclude il caso in cui il sistema parte da uno stato iniziale determinato x0. In tal caso infatti la misura iniziale si ridurrebbe a una δ di Dirac. In altre parole, riusciamo a dimostrare che il sistema evolve verso l'equilibrio se il suo stato iniziale è noto solo approssimativamente e ci accontentiamo di una descrizione incompleta, cioè probabilistica. È tuttavia molto interessante il fatto che esistano sistemi a un numero finito di gradi di libertà ergodici e mescolanti. Tra questi ricordiamo il moto geodetico su una superficie a curvatura negativa studiato da Jacques Hadamard nel 1898. Molti sistemi della meccanica classica possono ridursi a questo caso.

Dobbiamo peraltro sottolineare la differenza tra i sistemi a numero finito di gradi di libertà e i sistemi termodinamici. Nel primo caso, infatti, anche se i valori medi delle grandezze fisiche rappresentate dalle diverse funzioni f tendono ai corrispondenti valori di equilibrio, le grandezze stesse avranno in generale fluttuazioni rispetto ai valori medi, sia durante l'evoluzione che una volta raggiunto l'equilibrio. I sistemi macroscopici, invece, tendono all'equilibrio in modo deterministico. Infatti, l'evoluzione delle grandezze fisiche è spesso retta da equazioni alle derivate parziali come quelle dell'idrodinamica. Questo comportamento deterministico è dovuto al fatto che le variabili macroscopiche rappresentano medie su un grandissimo numero (al limite infinito) di gradi di libertà e quindi sono stabilizzate dalle leggi dei grandi numeri.

La teoria ergodica ha dato finora pochi risultati quando i gradi di libertà del sistema sono infiniti (limite termodinamico). In questo caso interviene un nuovo meccanismo che porta all'ergodicità e al mescolamento e che può essere descritto come la possibilità di trasformare il caos spaziale in caos temporale. A causa dell'estensione infinita del sistema, una configurazione (per es., di un gas) spazialmente caotica apparirà caotica nella sua evoluzione temporale se osservata su una regione spaziale finita, poiché la dinamica fa passare sotto gli occhi dell'osservatore le configurazioni esistenti in altre regioni. Si tratta evidentemente di un meccanismo che può agire anche in sistemi non interagenti come un gas perfetto. In effetti, ergodicità e mescolamento sono stati rigorosamente dimostrati per il gas perfetto, per il cristallo armonico e per sistemi riconducibili a questi, mentre per modelli di un gas di particelle interagenti sono stati ottenuti risultati analoghi solo introducendo ipotesi ad hoc, come una sorgente di stocasticità esterna al sistema e limitazioni non naturali sulla forma dell'energia cinetica.

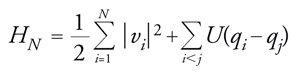

Vogliamo descrivere brevemente lo stato attuale dell'arte in relazione al problema della tendenza all'equilibrio. Dalla discussione precedente emerge che il grande numero di gradi di libertà deve avere un ruolo cruciale, come del resto è avvenuto nella spiegazione delle transizioni di fase da parte della meccanica statistica dell'equilibrio. Indicheremo alcune delle difficoltà matematiche principali. Occorre dimostrare che la dinamica di un gas di molecole interagenti ha un senso anche quando il numero delle molecole cresce indefinitamente e diventa infinito nel limite termodinamico. Non si tratta di un problema banale, poiché particolari configurazioni del gas, come la concentrazione di infinite particelle in una regione finita, possono dare luogo a evoluzioni catastrofiche. Si procede allora nel seguente modo: si parte da una funzione hamiltoniana relativa a N particelle (molecole) del tipo

[14] formula,

dove vi sono le velocità delle particelle e U è un potenziale di interazione tra le coppie di esse. Poiché per qualunque configurazione iniziale l'evoluzione data dalle corrispondenti equazioni del moto non è ben definita quando N→∞, si cerca di dimostrare che essa esiste almeno per un insieme di configurazioni iniziali che ha probabilità 1 rispetto a una misura invariante di riferimento. Si ritiene che le misure di riferimento rilevanti siano le misure di equilibrio di Gibbs, per esempio la misura canonica μN=exp(−βHN)/ZN, il cui limite per N→∞ esiste per una vasta scelta di potenziali di interazione. ZN è il fattore di normalizzazione (funzione di partizione).

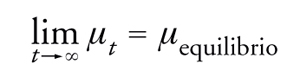

Quando questo programma ha successo si dice che esiste la dinamica dell'equilibrio. Per arrivare a dimostrare che l'evoluzione tende all'equilibrio occorrono proprietà ben più forti. Per esempio, sarebbe molto soddisfacente mostrare che per una vasta classe di distribuzioni iniziali non necessariamente dotate di una densità rispetto alla distribuzione di equilibrio vale la relazione

[15] formula,

dove μt designa l'evoluzione temporale della distribuzione iniziale μ0. La convergenza è quella debole per le misure di probabilità, cioè la convergenza dei momenti delle distribuzioni. Tipicamente le distribuzioni iniziali che hanno una densità diversa rispetto a quella di equilibrio comportano alterazioni di quest'ultima solo in regioni limitate dello spazio delle fasi del sistema, e quindi coinvolgono solo un numero finito di gradi di libertà. Una situazione del tutto ovvia dal punto di vista fisico come quella di un gas in cui la densità iniziale differisca da quella di equilibrio per una modulazione periodica non rientra tra queste e risultati del tipo indicato non sono noti per alcun modello deterministico di particelle interagenti. La dimostrazione di proprietà di mescolamento per grandezze fisiche che dipendono da un numero finito di variabili non è sufficiente per stabilire l'equazione [15].

In conclusione, i problemi posti da Boltzmann oltre un secolo fa costituiscono ancora oggi una grande sfida per la teoria dei sistemi dinamici.

Sistemi dissipativi

L'ipotesi dell'esistenza di misure invarianti non è verificata nei sistemi dinamici che descrivono fenomeni dissipativi. I fenomeni dissipativi che ci interessano maggiormente sono quelli in cui il sistema, nella sua evoluzione, dopo una fase transiente raggiunge uno stato stazionario nel quale è mantenuto dall'azione costante di una sorgente di energia: un esempio di grande interesse è rappresentato dagli stati turbolenti di un fluido. Uno sviluppo molto importante della teoria moderna dei sistemi dinamici ha permesso di estendere la teoria ergodica a tali situazioni. Per comprendere come ciò sia possibile è necessario introdurre alcuni nuovi concetti.

Un concetto basilare è quello di attrattore: in termini semplici è un insieme compatto, nello spazio delle variabili che descrivono un sistema, verso cui tendono tutte le traiettorie che iniziano nelle sue vicinanze. Un caso molto elementare si ottiene riprendendo in considerazione l'esempio del pendolo, ma questa volta introducendo una forza di attrito. In tal caso al crescere del tempo tutte le traiettorie tendono verso la posizione di equilibrio θ=0, y=0. Un caso più interessante, che si incontra nella teoria degli oscillatori di van der Pol, è il ciclo limite, cioè un'orbita periodica che al crescere del tempo attrae tutte le traiettorie vicine. La teoria moderna dei sistemi dissipativi ha messo in luce l'esistenza e l'importanza nelle applicazioni di attrattori più complessi (attrattori strani) sui quali il moto è caotico.

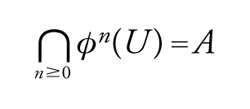

Per dare una definizione formale di attrattore consideriamo ancora, per fissare le idee, una dinamica con tempo discretizzato. Diremo che un insieme compatto A invariante sotto la trasformazione ϕ, cioè ϕ(A)=A, è un attrattore se esiste un suo intorno U tale che

[16] formula.

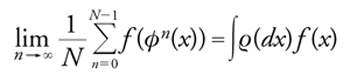

Un attrattore si dice strano se contiene un'orbita omoclina con autointersezioni trasversali, cioè punti omoclini. Per le trasformazioni ϕ differenziabili almeno due volte insieme alle loro inverse (diffeomorfismi di classe Cr con r≥2) e che soddisfano delle ipotesi che vengono usualmente indicate con il nome di assioma A, si può di-mostrare che: (a) ϕn(x) tende verso un attrattore quando n→ per quasi ogni x rispetto alla usuale misura di volume; (b) per ogni funzione continua f(x)

[17] formula,

dove ϱ è una misura definita sull'attrattore in modo univoco. La proprietà (b) è una proprietà ergodica e mostra che una volta raggiunto l'attrattore il sistema si comporta in modo simile ai sistemi conservativi.

I sistemi che soddisfano l'assioma A di Smale sono caratterizzati nel modo seguente. Sia M una varietà compatta di classe C∞, ϕ un diffeomorfismo di classe Cr che agisce su M. Diremo che un sottoinsieme X di M è iperbolico se l'iperpiano tangente a M in ogni punto x∈X può decomporsi nella somma di due sottospazi Eu,Es sui quali l'azione di Dϕ, differenziale di ϕ nel punto x, è rispettivamente dilatante e contraente. Ciò significa che gli autovalori della matrice Dϕ(x) sono maggiori di 1 nel sottospazio Eu e minori di 1 nel sottospazio Es. Un punto x di M si dice vagante se esiste un suo intorno U tale che U∩ϕn(U)=0/ per ogni n positivo. Sia Ω l'insieme dei punti non vaganti; diremo che il sistema dinamico descritto dal diffeomorfismo ϕ verifica l'assioma A se sono soddisfatte le seguenti due ipotesi: (a) l'insieme Ω è iperbolico; (b) i punti periodici di ϕ, cioè i punti x tali che esiste un intero m per cui ϕm(x)=x, sono densi in Ω.

Dimostrare rigorosamente che un dato sistema dinamico possiede un attrattore strano non è semplice. Tra i sistemi di interesse fisico che si ritengono rientrare in tale categoria vi è quello di Lorenz in precedenza menzionato. Esso è definito dalle tre equazioni seguenti:

[18] formula

con σ,ϱ,β costanti positive.

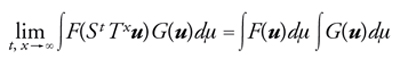

Anche nel caso dissipativo sono stati studiati sistemi a infiniti gradi di libertà. Per i sistemi infiniti, conservativi o dissipativi, è stata introdotta una nozione di caos spazio-temporale corrispondente a una proprietà di mescolamento simultanea rispetto alla dinamica e alle traslazioni spaziali. Si consideri, per esempio, il reticolo dei punti a coordinate intere in uno spazio a d dimensioni. Data una funzione in generale vettoriale u(x) definita sul reticolo, l'operatore di traslazione agisce nel modo seguente: Tzu(x)=u(x−z), dove z è un vettore del reticolo. Supponiamo ora che in ciascun punto del reticolo vi sia una copia di un sistema caotico a un numero finito di gradi di libertà. Indichiamo con u(x) la posizione nel proprio spazio delle fasi del sistema che si trova in x. Supponiamo inoltre che ciascun sistema interagisca con i propri vicini che si trovano a una distanza minore di R. La configurazione dell'intero sistema sarà evidentemente specificata dall'assegnazione di una funzione u(x). Sia Stl'operatore che descrive l'evoluzione dell'intero sistema e consideriamo l'azione simultanea della dinamica e delle traslazioni. Diremo che il sistema presenta caos spazio-temporale se, data una misura μ invariante sotto tale azione, si verifica che

[19] formula

con F e G funzionali limitati di u. È stato dimostrato che i sistemi descritti sopra, sotto opportune ipotesi, presentano caos spazio-temporale. Si tratta di risultati interessanti poiché forniscono un modello ancora qualitativo ma rigoroso di fenomeni spazialmente caotici come i flussi turbolenti. Inoltre, questi sistemi possono dar luogo a situazioni analoghe alle transizioni di fase e per questa via si ritiene possibile spiegare la comparsa di strutture spaziali (strutture coerenti) che si osserva in esperimenti sia reali che numerici di meccanica dei fluidi.

Entropia e complessità

In quest'ultimo paragrafo vogliamo brevemente discutere come si può caratterizzare quantitativamente il comportamento caotico dei sistemi dinamici. Ci riferiamo a sistemi dinamici che posseggono una misura invariante, quindi a sistemi conservativi o sistemi dissipativi il cui moto sia ristretto agli attrattori.

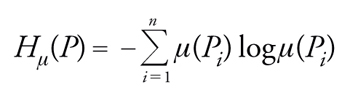

Il concetto di entropia è fondamentale. L'entropia di un sistema dinamico, chiamata anche entropia di Kolmogorov-Sinai, si definisce nel modo seguente. Sia P=(P1,...,Pn) una partizione dell'insieme M su cui è definita la misura μ. Definiamo la quantità

[20] formula

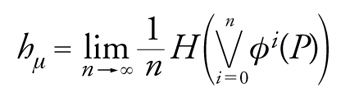

entropia della partizione. L'entropia della trasformazione ϕ rispetto alla partizione P è data da

[21] formula

Date n partizioni Pi, la partizione ∨iPi è costituita da tutte le possibili intersezioni della forma π1∩π2∩...∩πn, con πi∈Pi. L'entropia di Kolmogorov-Sinai si ottiene prendendo l'estremo superiore rispetto a tutte le possibili partizioni. Sinai ha mostrato che non è necessario effettuare questa difficile operazione, poiché esistono partizioni dette generanti che dànno direttamente il risultato desiderato.

Un sistema viene considerato fortemente caotico se ha entropia positiva; essa fornisce una misura della diversificazione delle traiettorie sotto l'azione della dinamica. È facile rendersi conto, per esempio, che se i moti sono periodici il numero di elementi della partizione n∨i=0ϕi(P) rimane finito al crescere di n e l'entropia in questo caso è 0. L'entropia è una quantità che riguarda il comportamento statistico dell'insieme di tutte le traiettorie.

Un interessante teorema di A. Brudno del 1978 consente di mettere in relazione la caoticità delle singole traiettorie con l'entropia. La caoticità di una singola traiettoria può essere caratterizzata mediante la complessità di Kolmogorov, definita nel modo seguente: sia A un calcolatore e p un programma costituito, per esempio, da una sequenza finita di simboli 0 o 1. Il numero dei simboli è la lunghezza del programma. Quando p viene inserito in A si ottiene il risultato x rappresentato da una sequenza finita di simboli di un qualunque alfabeto. La lunghezza del più corto tra tutti i programmi che dànno il risultato x viene chiamata complessità di x relativa ad A, e la indichiamo con KA(x). Kolmogorov ha dimostrato che esiste un calcolatore universale per cui tale quantità ha un minimo K(x) che chiameremo complessità di x.

Per definire la complessità di una traiettoria si considera una partizione di M e la sequenza ottenuta registrando gli elementi della partizione da essa visitati in successione (dinamica simbolica). Si calcola la complessità di Kolmogorov dei segmenti di lunghezza n della sequenza, si divide per n, si passa al limite per n→∞ e si prende l'estremo superiore rispetto alle partizioni. Brudno ha dimostrato che sotto condizioni molto generali la quantità che così si ottiene è uguale all'entropia per quasi tutte le traiettorie. In tal modo si stabilisce un legame tra la caoticità geometrica delle singole traiettorie e le proprietà statistiche del sistema.

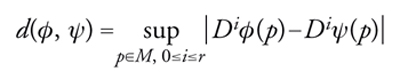

Stabilità strutturale

Vogliamo dare una definizione più precisa del concetto di stabilità strutturale discusso in modo informale nell'introduzione. Consideriamo sistemi dissipativi come quelli descritti in precedenza. Diremo che il diffeomorfismo ϕ è strutturalmente stabile se esiste un suo intorno U tale che considerato un elemento ψ∈U è possibile stabilire una corrispondenza biunivoca tra le orbite di ϕ e quelle di ψ; tale corrispondenza deve essere data da un omeomorfismo (trasformazione continua insieme alla sua inversa) prossimo all'identità. Affinché questa definizione abbia senso occorre precisare il significato di intorno, cioè una topologia nello spazio dei diffeomorfismi. Una definizione naturale è la seguente: due diffeomorfismi di classe Cr sono vicini se essi sono vicini con le loro derivate fino all'ordine r per la topologia della convergenza uniforme, cioè per la distanza

[22] formula

Un importante teorema afferma che i sistemi che soddisfano l'assioma A sono strutturalmente stabili sotto alcune ipotesi aggiuntive di carattere tecnico.

La stabilità strutturale è stata un tema dominante nelle ricerche degli anni Sessanta. Recentemente si è affermato un diverso punto di vista, che ritiene la stabilità strutturale un concetto troppo vasto per essere utile in uno studio dettagliato di sistemi interessanti nelle applicazioni. Anziché lavorare nella classe di tutti i diffeomorfismi che posseggono un certo numero di derivate, l'attenzione viene concentrata su famiglie di diffeomorfismi che dipendono da alcuni parametri. In questo ambito è possibile porsi, per esempio, il problema di come muta la struttura delle orbite al variare dei parametri, cioè il problema delle biforcazioni. In particolare sono stati studiati il meccanismo della transizione a un comportamento caotico attraverso le biforcazioni omocline e il carattere tipico di certi attrattori. In questo approccio, per proprietà tipica si intende una proprietà vera per un insieme di misura (di Lebesgue) positiva nello spazio dei parametri. Tra i risultati significativi vi è il seguente: sia ϕμ una famiglia di diffeomorfismi C∞ dipendenti dalparametro μ e agenti su una superficie. Supponiamo che ϕ0 abbia un punto di tangenza omoclina, cioè un punto in cui la varietà stabile e la varietà instabile di un punto fisso sono tangenti; allora esiste un insieme E di misura positiva tale che, se μ∈E, ϕμ ha un attrattore strano.

Bibliografia

Alekseev, Jakobson 1981: Alekseev, Vladimir M. - Jakobson, Michael V., Symbolic dynamics and hyperbolic dynamic systems, ‟Physics reports", 75, 1981, pp. 287-325.

Andronov 1966: Andronov, Aleksandr A. - Vitt, Aleksandr A. - Khaikin, Semen E., Theory of oscillators, Oxford, Pergamon, 1966.

Birkhoff 1927: Birkhoff, George D., Dynamical systems, New York, American Mathematical Society, 1927.

Boldrighini 1996: Boldrighini, Carlo, Macroscopic limits of microscopic systems, ‟Rendiconti di matematica e delle sue appplicazioni", 16, 1996, pp. 1-107.

Collet, Eckmann 2006: Collet, Pierre - Eckmann, Jean-Pierre, Concepts and results in chaotic dynamics, Berlin, Springer, 2006.

Cornfeld 1982: Cornfeld, Isaak P. - Fomin, Sergej V. - Sinai, Yakov G., Ergodic theory, New York, Springer, 1982.

Dobrushin 1989: Dobrushin, Roland L. - Sinai, Yakov G., Sukhov, Yu. M., Dynamical systems of statistical mechanics, in: Ergodic theory with applications to dynamical systems and statistical mechanics, edited by Yakov G. Sinai, Berlin-New York, Springer, 1989, pp. 208-254.

Dobrushin 1997: Dobrushin, Roland L., A mathematical approach to foundations of statistical mechanics, in: Boltzmann's legacy. 150 years after his birth, Roma, Accademia Nazionale dei Lincei, 1997, pp. 227-243.

Gallavotti 2004: Gallavotti, Giovanni - Bonetto, Federico - Gentile, Guido, Aspects of ergodic, qualitative, and statistical theory of motion, Berlin-New York, Springer, 2004.

Guckenheimer, Holmes 1983: Guckenheimer, John - Holmes, Philip, Nonlinear oscillations, dynamical systems and bifurcations of vector fields, New York-London, Springer, 1983.

Laskar 1995: Laskar, Joy, Large scale chaos and marginal stability in the solar system, in: XI International congress of mathematical physics. Paris 18-21 July 1994, edited by Daniel Iagolnitzer, Boston, International Press, 1995, pp. 75-120.

Moser 1973: Moser, Jürgen, Stable and random motions in dynamical systems: with special emphasis on celestial mechanics, Princeton (N.J.), Princeton University Press, 1973.

Nitecki 1971: Nitecki, Zbigniew, Differentiable dynamics: an introduction to the orbit structure of diffeomorphisms, Cambridge (Mass.)-London, MIT Press, 1971.

Palis, Takens 1993: Palis, Jacob - Takens, Floris, Hyperbolicity and sensitive chaotic dynamics at homoclinic bifurcations, Cambridge, Cambridge University Press, 1993.

Pesin 1989: Pesin, Yakov B., General theory of hyperbolic dynamical systems, in: Ergodic theory with applications to dynamical systems and statistical mechanics, edited by Yakov G. Sinai, Berlin-New York, Springer, 1989, pp. 108-151.

Poincaré 1892-1899: Poincaré, Henri, Les méthodes nouvelles de la mécanique céleste, Paris, Gauthier-Villars, 1892-1899, 3 v.

Ruelle 1975: Ruelle, David, Formalisme thermodynamique, in: Lecture notes in mathematics, edited by Albrecht Dold, Beno Eckmann, Berlin, Springer, 1975, pp. 154-166.

Ruelle 1991: Ruelle, David, Hasard et chaos, Paris, O. Jacob, 1991.

Shub 1978: Shub, Michael, Stabilité globale des systèmes dynamiques, ‟Astérisque", 56, 1978 (numero monografico).