Epistemologia

Epistemologia

(App. IV, i, p. 7o8).

Esauritosi il programma di ricerca neopositivistico, la riflessione filosofica sulla conoscenza scientifica e sulla sua metodologia appare suddivisa, nel ventennio compreso tra i primi anni Sessanta e la fine degli anni Settanta, nelle due grandi correnti del razionalismo critico popperiano e del cosiddetto postpositivismo, denominazione corrente dell'e. di orientamento storico il cui maggior rappresentante è stato Th.S. Kuhn. Benché siano entrambe fortemente caratterizzate dall'opposizione all'immagine della conoscenza scientifica elaborata dal neopositivismo, la seconda presenta, come caratteristica addizionale, la messa in discussione dei temi centrali della stessa e. popperiana, spesso accusata di essere ancora compromessa con una visione astorica e logicista della metodologia scientifica non dissimile da quella neopositivistica. Una ricostruzione storicamente adeguata del dibattito epistemologico della seconda metà del 20° secolo non può trascurare inoltre il ruolo centrale che, negli anni Cinquanta, hanno rivestito le critiche interne di C.G. Hempel e, soprattutto, di W.V.O. Quine nella dissoluzione del neopositivismo. A quest'ultimo, per formazione e convinzioni vicino tanto al neopositivismo quanto al pragmatismo, si devono probabilmente alcune delle obiezioni più radicali al programma riduzionistico del neopositivismo attraverso la ripresa di problematiche tipiche del convenzionalismo di P. Duhem, le quali hanno costituito uno dei principali ostacoli anche per il falsificazionismo popperiano. La problematizzazione del rapporto teoria-esperienza, che costituisce, seppur in forme diverse, un tratto comune a Quine, Hempel e Popper, appare poi radicalizzata nell'orientamento dei filosofi-storici (S. Toulmin, N.R. Hanson, Th.S. Kuhn, P.K. Feyerabend) che, tra la fine degli anni Cinquanta e gli anni Sessanta, hanno delineato un'immagine della conoscenza scientifica alternativa a quella positivistica non meno che a quella falsificazionista, un'immagine fortemente debitrice nei confronti della storia della scienza e che avrebbe riproposto in una nuova veste i vecchi e tradizionali problemi della razionalità scientifica e della capacità della conoscenza scientifica di fornire descrizioni vere della realtà.

In questa sede verranno innanzitutto delineati i principali contributi epistemologici di Quine e Popper, in particolare in relazione ai problemi sollevati da alcune note tesi di Duhem riproposte da Quine. Si presenteranno quindi le principali tesi dei filosofi postpositivisti, antipositivistiche e (con l'eccezione, forse, di quelle di I. Lakatos) antipopperiane, a partire dalle quali si cercherà di evidenziare il ventaglio di problemi da esse sollevato. Si fornirà quindi un quadro del dibattito più recente, suscitato in parte dall'e. postpositivistica, sul problema del realismo scientifico e si accennerà infine agli orientamenti epistemologici naturalistici e cognitivi.

Teoria e osservazione tra crisi del neopositivismo e falsificazionismo

La 'ricostruzione razionale' delle procedure scientifiche operata dal positivismo logico tra la fine degli anni Venti e la prima metà degli anni Sessanta, che aveva trovato in E. Nagel (1961) il suo più autorevole sistematizzatore, aveva lasciato irrisolto il rapporto fra teorie scientifiche e osservazione empirica. La lunga e tormentata storia del requisito neopositivistico di significanza empirica - il cosiddetto principio di verificazione - aveva ampiamente ridimensionato gli originari obiettivi radicalmente empiristici del neopositivismo: dalla verificazione completa alla conferma solo probabilistica delle ipotesi scientifiche, dalla pretesa di una riduzione completa a una riduzione solo parziale del linguaggio teorico al linguaggio osservativo, la storia di continue modifiche e 'liberalizzazioni' dei principi neopositivistici aveva quanto meno dimostrato l'impossibilità di una netta separazione tra il vocabolario teorico e quello osservativo nelle teorie scientifiche (distinzione cui ancora si atteneva il Carnap degli anni Sessanta). C.G. Hempel, in un lucido e influente lavoro dedicato alla storia dei mutamenti del criterio empiristico di significato (1950), indicava chiaramente l'inseparabilità dei due tipi di vocabolario, sottolineando come la deduzione e il controllo empirico delle conseguenze osservative (predizioni) di una data ipotesi (secondo quanto previsto dal metodo ipotetico-deduttivo) siano possibili soltanto in congiunzione con ulteriori ipotesi ausiliarie, spesso di tipo teorico (si pensi ai controlli sperimentali, implicanti ipotesi ausiliarie di tipo teorico relative agli strumenti utilizzati). La constatazione che ogni enunciato o ipotesi scientifica intrattiene delle relazioni logiche con un insieme più o meno vasto di altri enunciati, molti dei quali di tipo non osservativo, rappresentava naturalmente una seria difficoltà per i restrittivi criteri empiristici di significato elaborati dal neopositivismo originario. Hempel parlava di un'"eccedenza di significato" degli enunciati scientifici che oltrepassa ciò che può essere espresso in termini (di enunciati) osservativi.

In forma ancor più radicale e conseguente, negli stessi anni osservazioni analoghe venivano compiute da Quine. Nel contesto dell'intersezione tra filosofia del linguaggio e filosofia della scienza tipica del neopositivismo, Quine avanzava, in Two dogmas of empiricism (1951), le sue ormai celebri obiezioni alla distinzione neopositivistica tra asserzioni analitiche e asserzioni sintetiche, su cui era basata la tripartizione linguistico-epistemologica in asserzioni vere o false in base al solo significato linguistico (analitiche o contraddittorie), in base alla sola esperienza (sintetiche) e prive di significato conoscitivo in quanto non rientranti in nessuna delle due precedenti classi (tipiche, tra queste, le asserzioni metafisiche). Quine metteva in evidenza l'implausibilità del progetto di selezionare una classe di asserzioni sintetiche, puramente empiriche, cui ridurre le teorie scientifiche, contestando il "dogma" empiristico secondo il quale ciascun enunciato, singolarmente considerato, possiede un importo empirico specificabile tramite la sua riduzione a esperienze confermanti o confutanti (e, insieme, l'ulteriore "dogma" di asserzioni analiticamente vere, cioè con importo empirico nullo). Nel modello quineano è il sistema nel suo complesso (la teoria o un insieme di teorie) a essere provvisto di contenuto empirico e non il singolo enunciato: l'unità minima di significato è, olisticamente, il sistema cui l'enunciato appartiene, ogni enunciato essendo connesso, attraverso relazioni logiche e teoriche, a un più vasto insieme di asserzioni connesso all'esperienza in modo indiretto e inferenziale. Conseguenza di ciò era la ridefinizione del rapporto fra teoria ed esperienza secondo un modello che vede le procedure sperimentali non più come l'incontestabile banco di prova puramente empirico delle ipotesi scientifiche, ma, in modo più complesso e articolato, come un metodo di controllo che, nel presupporre una quantità più o meno ampia di assunzioni e ipotesi teoriche, è vincolato da considerazioni pragmatiche di semplicità, economia e coerenza globale. A tali conclusioni Quine perveniva riprendendo le tesi di Duhem (1906) sulla natura dei controlli sperimentali delle ipotesi fisiche e sull'impossibilità dei cosiddetti esperimenti cruciali. Per sottoporre al controllo empirico una certa ipotesi, notava Duhem, il fisico deduce dall'ipotesi alcune predizioni osservative da verificare sperimentalmente; tuttavia, per operare le predizioni, approntare l'esperimento e interpretarne i risultati il fisico "non si limita a fare uso della proposizione in discussione. Egli usa ancora tutto un insieme di teorie accettate senza riserve" (Duhem 1906; trad. it. 1978, p. 208). Duhem ne traeva la conseguenza che, in caso di conflitto tra la previsione e il risultato sperimentale, ciò che quest'ultimo mette in discussione non è la sola ipotesi che si intendeva sottoporre a controllo, ma tutto l'insieme di teorie (cioè l'ipotesi di partenza insieme ad altre ipotesi ausiliarie) utilizzate dal fisico, sicché il risultato sperimentale non può essere interpretato come confutazione non ambigua della sola ipotesi sottoposta a controllo, o lo è solo a condizione di ammettere implicitamente la correttezza di tutte le altre ipotesi coinvolte. Accentuando il carattere sistematicamente ambiguo dei risultati negativi dei controlli sperimentali, messo in evidenza da Duhem, Quine si spingeva ad asserire che esiste sempre un ampio margine di scelta nel processo di revisione, che va dal considerare erroneo il risultato sperimentale fino alla salvaguardia dell'ipotesi e dello stesso sistema minacciati dal responso sperimentale mediante l'opportuna introduzione di ipotesi addizionali (ipotesi ad hoc) in un punto o nell'altro dell'intero sistema di conoscenze (logica e matematica incluse), in modo da consentire la deduzione del risultato sperimentale inatteso e ripristinare così l'accordo fra teoria ed esperienza. Accordo che, nel modello quineano inteso a descrivere l'effettiva pratica scientifica, è solitamente ottenuto sulla base di un atteggiamento conservatore ispirato a una "massima della minima mutilazione", consistente nell'eliminare il minor numero possibile di ipotesi dalla teoria in oggetto e dal più ampio sistema conoscitivo di cui la teoria fa parte.

La congiunzione degli argomenti di Duhem e Quine è nota come tesi Duhem-Quine ed è stata al centro del dibattito epistemologico degli anni Sessanta e Settanta. Dubbi sulla sua validità sono stati avanzati da A. Grünbaum (1960, 1963), ma l'interesse da essa suscitato è stato determinato soprattutto dalle sue ripercussioni sul falsificazionismo di Popper. Com'è noto, sin dagli anni Trenta Popper aveva ravvisato nell'e. neopositivistica una deformazione di quella che considerava l'autentica metodologia scientifica basata su procedure esclusivamente deduttive, ben lontane dall'"induttivismo" e dall'"osservativismo" che contestava ai positivisti. Nel sostenere il primato del momento congetturale nell'impresa scientifica, Popper (1935) aveva interpretato il metodo scientifico in chiave ipotetico-deduttiva, individuando nel requisito della falsificabilità empirica (in contrasto con quello neopositivistico di verificabilità) un criterio di "demarcazione" tra asserzioni scientifiche e asserzioni metafisiche, e nella falsificazione il momento propulsivo per l'acquisizione e la crescita del sapere scientifico. La plausibilità di un'ipotesi o di una teoria scientifica viene valutata, secondo Popper, non, come nel modello neopositivistico, sulla base delle conferme empiriche che ricevono le loro conseguenze osservative, ma sulla base della loro capacità di "resistere" ai più severi tentativi di falsificazione miranti a mettere alla prova la correttezza dell'ipotesi o della teoria attraverso il controllo sperimentale delle loro conseguenze (o predizioni) osservative più arrischiate e improbabili. Caratteristica centrale dei controlli sperimentali delle asserzioni universali nel metodo ipotetico-deduttivo è infatti per Popper la cosiddetta asimmetria tra procedure di verificazione e procedure di falsificazione, per la quale un numero per quanto elevato di conferme empiriche di enunciati osservativi dedotti da un'ipotesi (asserzione di forma universale) non può garantire conclusivamente la verità dell'ipotesi, mentre una sola confutazione da parte dell'esperienza sarebbe viceversa sufficiente - per il tramite del procedimento inferenziale noto come modus tollens - a revocarla in dubbio. Di qui la caratterizzazione dell'impresa scientifica come sistema autocorrettivo che si accresce indefinitamente mediante reiterati tentativi di falsificazione (esperimenti) volti a eliminare ipotesi e teorie false e a sostituirle con nuove "congetture" da sottoporre a controllo. Il modello epistemologico popperiano può ricordare la tradizionale induzione per eliminazione, con l'avvertenza, tuttavia, che nessuna delle ipotesi "sopravvissute" ai tentativi di falsificazione - secondo la terminologia evoluzionistica già utilizzata nella Logik der Forschung e che preludeva alla più compiuta interpretazione darwinista elaborata da Popper negli anni Sessanta - può essere considerata vera o immune da confutazione. Le novità introdotte da Popper rispetto all'e. empirista otto-novecentesca dovevano comunque fare i conti con il convenzionalismo. I maggiori problemi per l'e. popperiana (e per l'immagine della dinamica del mutamento scientifico che essa implicava) derivavano infatti dalle osservazioni di Duhem e dall'interpretazione che, sulla loro base, avrebbe fornito Quine della metodologia scientifica. Era proprio l'asimmetria tra verificazione e falsificazione che aveva messo in discussione Duhem, argomentando per la non conclusività, analogamente agli esperimenti verificanti, degli stessi esperimenti confutanti. La stessa insistenza di Popper sulla presenza di elementi teorici nella "base empirica" che dovrebbe "corroborare" o "falsificare" un'ipotesi - "la teoria domina il lavoro sperimentale, dalla sua pianificazione iniziale ai tocchi finali che esso riceve in laboratorio" (Popper 1935; trad. it. 1970, p. 103) - e sul carattere "convenzionale" dell'accettazione delle "asserzioni-base" da utilizzare quali premesse di argomentazioni falsificanti lo conduceva del resto a confrontarsi con Duhem. Nelle "obiezioni convenzionaliste" di Duhem, Popper si era imbattutto sin dalla sua prima opera, cercando di limitarne la portata distruttiva nei confronti del falsificazionismo attraverso l'elencazione di un insieme di regole metodologiche contro gli "stratagemmi convenzionalisti". Pur riconoscendo l'ambiguità dei risultati sperimentali falsificanti, Popper stabiliva, come fondamentale regola metodologica anticonvenzionalista, quella di non cercare di "salvare" una teoria dalla falsificazione mediante l'introduzione di ipotesi che ne diminuiscano il grado di falsificabilità (ossia di contenuto empirico) ma che, al contrario, lo accrescano. Naturalmente, si trattava di una regola correttiva difficile da precisare, data la labilità della distinzione tra mere ipotesi ad hoc e ipotesi ausiliarie accrescitive di contenuto empirico e controllabili indipendentemente dalle teorie sotto controllo, come l'ultimo Popper (1974) avrebbe finito per riconoscere. Riconoscendo inoltre che una teoria non viene falsificata se non a condizione che ve ne sia un'altra disponibile, e concedendo "uno spazio legittimo, ancorché molto limitato, per il dogmatismo" (Popper 1974, 2° vol., p. 984), cioè per un conservatorismo scientifico al quale l'originario falsificazionismo intendeva contrapporsi, Popper sembra infine essere pervenuto a indebolire le sue precedenti posizioni. Accanto a queste aperture Popper (1963, 1974) aveva comunque anche cercato - nonostante la sempre più determinata affermazione dell'inseparabilità di osservazione e teoria - di ridimensionare del tutto le difficoltà sollevate dalla "concezione olistica dei controlli empirici" per il suo falsificazionismo, ricorrendo tuttavia a un argomento non del tutto chiaro: nei controlli sperimentali, riconosceva Popper, si ammette di solito come non problematica una porzione più o meno vasta della "conoscenza di sfondo" (background knowledge), e a tale condizione è possibile operare delle falsificazioni; Popper ammetteva inoltre che non si dà mai la certezza che si stia falsificando "l'elemento giusto", ma ciò sarebbe irrilevante dato il carattere congetturale e sempre revocabile sia delle falsificazioni sia (di porzioni) della conoscenza di sfondo. Ci si potrebbe chiedere (come è stato più volte osservato: si veda per es. Parrini 1980) se questa sia un'obiezione alla tesi Duhem-Quine o non piuttosto una sua riaffermazione.

La svolta storicistica

Mentre il falsificazionismo popperiano ha avuto una diffusione e una circolazione soprattutto europee, negli Stati Uniti la filosofia della scienza continuava a essere largamente influenzata dall'empirismo logico e dal pragmatismo. Se è difficile sopravvalutare l'influenza che filosofi vicini al neoempirismo e al pragmatismo come Quine, W. Sellars e N. Goodman (autore, negli anni Quaranta, di alcune esemplari analisi dei concetti di induzione e di legge naturale) hanno avuto sull'e. statunitense, non va trascurata tuttavia l'influenza esercitata dall'ultimo Wittgenstein. Nel gruppo di filosofi che avrebbero radicalmente messo in discussione l'e. neopositivistica - Toulmin, Hanson, Kuhn - possono essere infatti rintracciate le nozioni wittgensteiniane di "gioco linguistico" e "forma di vita", oltre che una generale prospettiva basata sull'idea della dipendenza, risalente anch'essa al Wittgenstein delle Philosophische Untersuchungen, del significato e delle stesse esperienze percettive dalle convenzioni presenti nelle comunità linguistiche, culturali e sociali in cui si viene educati. In Toulmin (1953, 1961), Hanson (1958) e Kuhn (1962) si precisava inoltre quell'approccio all'e. basato su indagini di storia della scienza (case histories) finalizzate non all'elaborazione di modelli logico-formali delle teorie scientifiche (tipici del neopositivismo) né a cercare conferme a un modello epistemologico generale in difficile equilibrio tra pretese normative e descrittive (come nel caso del falsificazionismo popperiano), ma all'individuazione delle effettive pratiche di acquisizione scientifica operanti nel corso dell'evoluzione storica. Ciò che veniva particolarmente messo in discussione da approcci di questo tipo era la distinzione, risalente a H. Reichenbach, tra "contesto della scoperta" e "contesto della giustificazione", sulla cui base i neopositivisti e lo stesso Popper avevano escluso dall'ambito dell'e. ogni considerazione storica, psicologica e sociologica relativa alla 'scoperta', cioè alla genesi della conoscenza scientifica, a favore di un'analisi formale e atemporale dei suoi procedimenti di giustificazione logica. Nella nuova prospettiva storica si indagavano invece soprattutto gli aspetti storici, culturali, metafisici, psicologici e sociali dai quali appaiono condizionate la ricerca e la conoscenza scientifiche.

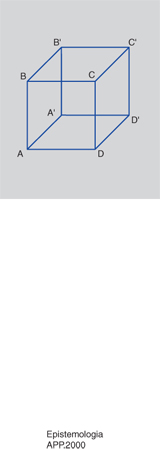

Insieme con il ricorso sistematico a episodi desunti dalla storia della scienza, uno dei più noti e discussi nuclei tematici della 'nuova filosofia della scienza' è stata la problematizzazione del concetto eccessivamente semplicistico di osservazione attribuito al neopositivismo. Innestando temi duhemiani in una cornice wittgensteiniana, Hanson (1958) prendeva le mosse dalla dicotomia neopositivistica tra 'linguaggio teorico' e 'linguaggio osservativo' per contestare la pretesa 'neutralità' di quest'ultimo sulla base della constatazione che ogni osservazione è sempre "carica di teoria" (theory-laden), nel senso molto esteso di 'teoria' come insieme di informazioni, aspettative e schemi organizzativi che condizionano l'attività percettiva. Esattamente come soltanto chi già possieda i 'concetti' pertinenti è in grado di vedere in una certa configurazione di linee un poligono o un solido, così soltanto chi sia provvisto di una pertinente informazione teorica sui fenomeni microfisici è in grado di 'vedere' la traiettoria di una particella subatomica nelle macchie rivelate da una fotografia di quanto accade nella camera a bolle, mentre l'osservazione puramente fenomenologica della medesima fotografia da parte di un profano non rivelerebbe altro che macchie prive di un determinato significato. Di rilievo e altamente influenti, in questa prospettiva, sono state le osservazioni di Hanson volte a porre in evidenza il condizionamento teorico-concettuale della percezione visiva attraverso il ricorso ai noti esperimenti di tipo gestaltico basati su figure ambigue e reversibili (quali il cubo di Necker e la celebre figura che può essere percepita alternativamente come un'anatra o una lepre: v. .), ai quali si era peraltro già richiamato Wittgenstein. Hanson esemplificava la sua tesi cognitiva con l'esperimento mentale relativo alla 'base osservativa' di Tycho Brahe e Keplero, i quali, in presenza del Sole sorgente, non interpretano in modi diversi un medesimo e 'neutrale' insieme di osservazioni percettive - l'esperienza visiva di un disco luminoso bianco-giallo -, ma vedono letteralmente cose diverse: il primo un corpo celeste in movimento rispetto all'orizzonte della Terra, l'altro un corpo celeste stazionario. Benché il concetto neopositivistico di osservazione fosse probabilmente meno semplicistico di quanto tali argomenti intendessero riconoscere, come si evince da alcuni classici del tardo neopositivismo quali il già citato Hempel e lo stesso Nagel (ben consapevoli dei problemi sollevati da Duhem), ciò che essi intendevano contestare era il ruolo generale dell'osservazione nell'indagine scientifica, la concezione ipotetico-deduttiva del 'metodo' - basata sul confronto fra ipotesi teoriche e dati osservativi o 'fatti' in grado di verificarle o falsificarle - e l'interpretazione (neopositivistica) delle teorie come strutture di tipo assiomatico da cui inferire leggi sperimentali invarianti rispetto alle teorie. C'era, nella nuova prospettiva, qualcosa di più e di diverso rispetto alla semplice riaffermazione delle difficoltà, sottolineate da Duhem e Quine, interne all'interpretazione ipotetico-deduttiva del metodo scientifico; c'era un modo di guardare alla conoscenza scientifica nei termini di teorie intese come modelli organizzativi - vere e proprie concezioni del mondo - che rendono possibile osservare i fenomeni inserendoli in categorie o quadri concettuali che ne forniscono così spiegazioni. Lungi dal confermare o confutare le teorie, le osservazioni sarebbero piuttosto da quelle orientate sin dal principio.

Nel contesto di quelle che F. Suppe (The structure of scientific theories, 1974) ha chiamato Weltanschauungen analyses un posto di rilievo occupa il già citato Toulmin (1961), con il quale facevano la comparsa i concetti di "presupposizione" e "paradigma", intesi come idee-guida, "modelli dell'ordine naturale", cui un certo ambito della ricerca scientifica di una data epoca (per es. la dinamica aristotelica o quella newtoniana) cerca di ricondurre i fenomeni. All'indagine storica l'attività dello scienziato risulta volta a inquadrare i fenomeni in tali modelli e a incrementare o modificare questi ultimi con ulteriori principi o leggi quel tanto da offrire spiegazioni plausibili di quei fenomeni (i 'fenomeni' propriamente detti) che appaiono deviare dall'ordine regolare della natura presupposto. Dalla considerazione che ciascuna fase di tale procedura sia "governata e diretta dalle idee che stanno a fondamento della teoria" (in modo non dissimile da quanto aveva sostenuto Hanson) Toulmin traeva due importanti conseguenze: da un lato sottolineava come comunità scientifiche che sottoscrivono diversi modelli o paradigmi non hanno "alcun termine teorico comune", il che precluderebbe ogni possibilità di comunicazione tra esse, considerando l'una del tutto naturale ciò che invece l'altra considererebbe problematico; dall'altro negava che i paradigmi esplicativi siano valutabili in termini di verità o falsità, essendo soltanto più o meno 'fruttuosi' nell'organizzazione e nella previsione dell'esperienza. Se con quest'ultima tesi Toulmin avallava un'interpretazione strumentalista delle teorie scientifiche (per certi versi affine a quella già difesa da E. Mach e Duhem e contrapposta al realismo che invece caratterizzava l'e. popperiana), con la prima segnalava il carattere discontinuo dell'evoluzione della conoscenza scientifica con un argomento che, diretta conseguenza della theory-ladenness dell'osservazione, sarebbe stato più esplicitamente difeso da Kuhn e Feyerabend.

L'approccio di Toulmin presentava del resto molti punti di contatto - sin dalla terminologia - con quello decisamente più influente e articolato di Kuhn, dalla cui formazione di storico della scienza estraneo alle interpretazioni filosofiche della conoscenza scientifica dipende in larga misura l'autorevolezza del suo lavoro più fortunato, The structure of scientific revolutions (1962). Oltre all'influenza di storici della scienza e delle idee (tra cui Kuhn citava A. Koiré, E. Meyerson, A. Mayer insieme al Lovejoy di The great chain of being), sull'interpretazione kuhniana dell'indagine e della dinamica scientifiche agivano, come Kuhn stesso riconosceva, la Gestaltpsychologie (mediata da Wittgenstein), il relativismo linguistico di B.L. Whorf, le tesi olistiche di Quine e l'opera pionieristica del microbiologo e storico della medicina L. Fleck, Enstehung und Entwicklung einer wissenschaftlichen Tatsache, pubblicata nel 1935. Se Kuhn dava per scontata l'implausibilità dell'impostazione epistemologica neopositivistica, è certo che il modello falsificazionista di Popper - tra i primi filosofi ad appellarsi alla storia della scienza per avallare le sue intuizioni - ne costituiva un bersaglio non secondario. Nozione centrale di Kuhn era quella di "paradigma", inteso come insieme di assunti o modelli che orientano la ricerca scientifica in una data epoca all'interno di una o più discipline; caratteristica dei paradigmi - tra i quali Kuhn elencava l'astronomia tolemaica, la dinamica aristotelica, la concezione corpuscolare dell'universo - è quella di fornire una visione del mondo che influenza la proposta di teorie, determina la gamma dei problemi pertinenti e le spiegazioni ammissibili, condizionando l'osservazione e le stesse tecniche sperimentali. Gran parte della ricerca scientifica svolta sotto l'influenza di un paradigma (la "scienza normale") consiste così nel "forzare la natura entro le caselle prefabbricate e relativamente rigide fornite dal paradigma", applicando il paradigma a settori sempre più ampi della realtà e spesso (secondo criteri non dissimili da quelli delineati da Quine) ignorando ciò che non si adatta ai suoi presupposti o introducendo ipotesi ad hoc tese a salvaguardarne i principi in presenza di fatti 'recalcitranti'. La scienza normale veniva caratterizzata da Kuhn come un'attività di "soluzioni di rompicapo" nei termini delle regole codificate dal paradigma. Sulla base di questa interpretazione dell'attività delle comunità scientifiche Kuhn vedeva l'evoluzione della conoscenza come transizione da un paradigma a un altro (per es., dall'astronomia tolemaica a quella copernicana, dalla chimica del flogisto a quella di Lavoisier), una transizione determinata dall'insuperabilità delle "anomalie" (cioè di fenomeni inattesi rispetto alle aspettative indotte dal paradigma) che, a lungo andare, finiscono per gravare su un paradigma dominante. Il passaggio a un nuovo paradigma - solitamente preceduto dalla messa in discussione del vecchio e dalla proliferazione di nuove teorie che caratterizzano la fase di "scienza straordinaria" - non comporterebbe tuttavia nulla di simile allo "stereotipo metodologico della invalidazione di una teoria mediante un suo confronto diretto con la natura" (Kuhn 1962; trad. it. 1978, p. 103), precisazione antipopperiana con cui Kuhn contestava un "falsificazionismo dogmatico", come lo avrebbe etichettato Lakatos (1970), che, per la verità, forse non era presente neanche nella Logik der Forschung. Le ragioni del passaggio da un paradigma all'altro sono molteplici e spesso diverse da quelle riconducibili alle regole di una pura razionalità scientifica, essendo connesse a fattori extralogici quali tecniche di persuasione, motivazioni e idiosincrasie personali degli scienziati o presupposti metafisici. Spesso un nuovo paradigma viene accettato solo per le sue "promesse" di risoluzione delle vecchie anomalie, e in ciò può non esservi null'altro che una scelta di fede o un processo di conversione: le rivoluzioni scientifiche non sono in questo diverse da quelle politiche, basate sul consenso delle comunità interessate.

Un aspetto molto discusso delle tesi kuhniane è il rapporto tra paradigmi diversi: Kuhn parlava dei paradigmi come di "strutture concettuali" che, condizionando il modo in cui gli scienziati guardano al mondo, sarebbero tra loro "incommensurabili", cioè non confrontabili in quanto prive di un comune dominio di problemi, soluzioni, entità ammesse, 'fatti', osservazioni e tecniche sperimentali. Con argomenti analoghi a quelli di Hanson, Kuhn paragonava il passaggio da un paradigma all'altro al "riorientamento gestaltico" (Gestalt switch) sperimentabile nella percezione visiva di figure ambigue (v. .): come qualcuno vede un'anatra dove altri vedono un coniglio, così lo scienziato che abbraccia un nuovo paradigma vede e riorganizza in modo completamente diverso il medesimo insieme di fatti e osservazioni: A.-L. Lavoisier, per es., vedeva ossigeno laddove J. Priestley aveva visto aria deflogistizzata.

La tesi di incommensurabilità è in larga misura alla base della messa in discussione da parte di Kuhn della tradizionale concezione lineare e cumulativa del progresso scientifico (secondo cui la successione delle teorie è un processo di costante accumulazione di nuove conoscenze) a favore di un'interpretazione radicalmente discontinuista per la quale ogni acquisizione scientifica risulta strettamente connessa a quadri concettuali destinati a essere soppiantati da altri del tutto privi di relazione con quelli delle epoche precedenti e successive. Su un piano filosofico più generale, nell'interpretazione del mutamento scientifico come giustapposizione di Weltanschauungen incommensurabili è stata inoltre spesso vista l'adesione a una forma di storicismo relativistico che, mentre da un lato mina la legittimità di ogni discorso epistemologico sulla razionalità scientifica, lasciando agli storici e ai sociologi della scienza il compito di studiare il fenomeno della conoscenza scientifica nel contesto storico-sociale entro cui sorge e si sviluppa, dall'altro pone radicalmente in dubbio la credenza tradizionale (il 'realismo scientifico') che le teorie scientifiche siano in grado di descrivere l'autentica struttura della realtà. Kuhn avrebbe successivamente respinto le accuse di relativismo, mentre avrebbe invece affermato un punto di vista strumentalista, per il quale le teorie scientifiche non sono descrizioni di una realtà indipendente, e quindi valutabili in termini di verità e falsità, ma piuttosto tecniche più o meno efficaci per organizzare l'esperienza all'interno dei presupposti paradigmatici.

In un celebre convegno tenutosi a Londra nel 1965, i cui atti - pubblicati con il titolo Criticism and the growth of knowledge (1970) - sarebbero stati al centro del dibattito epistemologico degli anni Settanta e oltre, si scontravano i due modelli epistemologici di Kuhn e Popper. Nel medesimo contesto si segnalava soprattutto il tentativo di Lakatos, allievo e seguace di Popper, di conciliare il falsificazionismo popperiano con alcune delle istanze più plausibili emerse dalla concezione di Kuhn (oltre che con la tesi Duhem-Quine), evitandone comunque gli esiti più 'irrazionalistici'. Lakatos delineava un "falsificazionismo sofisticato", di cui naturalmente la storia della scienza avrebbe offerto numerose testimonianze, per il quale un'"anomalia" o "fatto recalcitrante" rispetto a una teoria T₁ appare come una falsificazione della stessa solo alla luce di un'ulteriore teoria T₂ per la quale costituisce una conferma. Su tali basi Lakatos riconduceva la dinamica operante nella ricerca scientifica non a un semplicistico rapporto di falsificazione da osservazioni a singole teorie, ma a un più complesso e articolato rapporto fra teorie successive all'interno di "programmi di ricerca scientifici" - quali l'astronomia tolemaica o la teoria meccanicistica dell'universo di origine cartesiana - basati su un "nucleo" (hard core) metafisico considerato inconfutabile. Ciascuna teoria in cui si sviluppa il programma di ricerca è volta a correggere le anomalie o le difficoltà teoriche della precedente ed è ottenuta tramite l'introduzione di ipotesi ausiliarie in grado di salvaguardare l'accordo del nucleo inconfutabile del programma con l'osservazione (o meglio, con le 'teorie osservative' accettate). I programmi di ricerca, per molti versi simili ai paradigmi di Kuhn, possono essere progressivi (progressive) o regressivi (degenerating), a seconda che le teorie escogitate al loro interno conducano di volta in volta alla predizione di nuovi fatti o meno. Essi vengono abbandonati quando diventano irrimediabilmente regressivi (per es., quando le teorie al loro interno possono essere sostenute solo in congiunzione con un coacervo di ipotesi ad hoc) in confronto a un "programma rivale" progressivo.

Restava problematico, nell'articolata e complessa ricostruzione storicistica di Lakatos, stabilire in base a quali criteri 'razionali' la comunità scientifica può decidere di attenersi a un vecchio programma di ricerca o aderire a uno nuovo: in altri termini, la questione della razionalità del mutamento scientifico. Come spesso è stato notato, e come Lakatos finiva per riconoscere, la progressività o la regressività di un programma di ricerca sono individuabili solo dopo un lungo lasso di tempo, lasciando così irrisolto il problema dei criteri metodologici operanti nella ricerca scientifica: come ha osservato I. Hacking (1983; trad. it. 1987, p. 133), la teoria della razionalità scientifica di Lakatos "non fornisce il minimo aiuto per decidere che cosa sia razionale credere o fare. Essa è completamente retrospettiva. Ci può dire quali decisioni nella scienza del passato siano state razionali, ma non ci è di aiuto per il futuro". Obiezioni di questo tipo aveva del resto avanzato Feyerabend (1975) contro la proposta di Lakatos, difendendo un 'anarchismo' epistemologico sulla base della constatazione che la storia della scienza mostrerebbe l'inesistenza di regole e procedure epistemologiche simili a quelle elaborate da Popper, Lakatos e dallo stesso Kuhn. La storia della scienza appare costellata, per Feyerabend, da decisioni e ipotesi "irrazionali" rispetto al contesto storico in cui sorsero: non c'è alcun metodo tipicamente scientifico che produca conoscenza, e spesso il progresso (come Feyerabend ha cercato di dimostrare nel caso di Galileo) è conseguenza della deliberata violazione delle norme elaborate dai filosofi.

Strumentalismo, costruttivismo e realismo scientifico

Le indagini epistemologiche basate sulla storia della scienza hanno talvolta finito per confondere piuttosto che chiarire i problemi da cui avevano preso l'avvio. Anche senza attribuirvi eccessivo credito, le tesi di Feyerabend - provocatoriamente riassunte dall'ormai celebre anything goes - costituiscono una sorta di involontaria reductio ad absurdum di una certa filosofia della scienza: esse segnalano quanto meno la difficoltà di far emergere una descrizione univoca della metodologia scientifica dall'analisi di 'casi storici' rilevanti. L'orientamento storico, in ogni caso, mentre da un lato ridimensionava i progetti neopositivistici e quelli del razionalismo critico, dall'altro suscitava una gamma di temi e problemi che sarebbero stati variamente discussi nella filosofia della scienza degli anni Settanta e Ottanta: il ruolo della metafisica nella conoscenza scientifica, cui avevano originariamente dedicato attenzione, nel quadro falsificazionista, lo stesso Popper e la sua scuola (J. Agassi, J. Watkins) e che era stato al centro delle prospettive di Kuhn e Lakatos; il problema della razionalità e quello del progresso scientifico, discussi soprattutto da L. Laudan (1977) sviluppando in senso strumentalistico indicazioni lakatosiane; la varietà dei procedimenti euristici ed esplicativi operanti nella scienza (di rilievo a questo proposito le indagini di M.B. Hesse sul ruolo della metafora, dell'analogia e dei modelli nella scienza); il problema delle influenze del contesto sociale sulla scienza, particolarmente sviluppato, su basi kuhniane, dalla cosiddetta scuola di Edimburgo (B. Barnes, D. Bloor); il problema degli "schemi concettuali" e del relativismo, al quale ha fornito un influente e tuttora molto discusso contributo D. Davidson (1974); il problema dello status epistemico delle teorie scientifiche, cioè del rapporto fra le teorie e la realtà.

Quest'ultimo problema, in particolare, ha suscitato un notevole interesse nell'ultimo ventennio, dando vita a un autonomo ambito d'indagine epistemologica e riportando al centro dell'attenzione la tradizionale questione del realismo. Benché ogni pretesa di considerare le teorie scientifiche come descrizioni vere delle autentiche strutture ontologiche della realtà fosse stata messa in discussione dallo strumentalismo di Mach e Duhem e benché il problema del realismo fosse stato liquidato dal neopositivismo come pseudo-problema, la questione del rapporto fra teorie e realtà era risorta all'interno dello stesso neopositivismo in relazione allo status ontologico delle entità inosservabili designate dai "termini teorici" (atomi, elettroni, campi ecc.), la cui esistenza è solo inferita sulla base dei dati osservativi risultanti da procedure operazionali, ma non è in alcun modo riducibile a un insieme finito, completo e specificabile di criteri operazionali che possa del tutto 'eliminare' i termini teorici e, con questi, ogni riferimento alle entità inosservabili (v. epistemologia, App. IV). Su tale base i neopositivisti propendevano verso un moderato strumentalismo piuttosto che verso il realismo.

Un'interpretazione realista delle entità teoriche sembrava del resto messa in discussione dai noti risultati della meccanica quantistica, mentre, su un più generale piano epistemologico, essa appariva inconciliabile con i potenti argomenti di Duhem contro gli esperimenti cruciali e con la conseguenza che ne avrebbe tratto Quine, la tesi della cosiddetta "sottodeterminazione" (underdetermination) empirica delle teorie, secondo cui, non essendo le teorie completamente determinate dai dati osservativi, teorie fra loro logicamente incompatibili e basate su assunti ontologici diversi possono spiegare il medesimo insieme di fenomeni e avere lo stesso importo predittivo (conseguenze osservative). In questa prospettiva, evidentemente, la possibilità di concepire le teorie come descrizioni della struttura ultima della realtà sembra assottigliarsi man mano che aumenta la plausibilità della tesi di sottodeterminazione - plausibilità che per Quine è una diretta conseguenza dell'empirical slack delle teorie, con le quali "gli scienziati inventano ipotesi che parlano di cose che vanno ben oltre l'osservazione" (Quine 1975; trad. it. 1982, p. 127). Ciò nondimeno, lo stesso Quine (1960, 1963, 1975), che è stato uno dei più autorevoli sostenitori della tesi, non le ha attribuito gli esiti distruttivi per il realismo scientifico che sulle prime essa sembra comportare. Se da un lato, infatti, la postulazione delle entità teoriche va per Quine valutata, pragmaticamente, in base ai vantaggi e al successo che essa comporta sul piano del potere esplicativo e predittivo, della semplicità, dell'unificazione e della fecondità delle teorie - le tipiche caratteristiche sottolineate da chi difende un'interpretazione antirealista e strumentalista di queste ultime -, dall'altro sono esattamente tali vantaggi e tale successo a costituire la migliore evidenza per l'accettazione, almeno provvisoria, delle ontologie scientifiche. Ne segue che fra teorie rivali la migliore dai punti di vista elencati è anche quella che meglio descrive la realtà, non essendovi del resto, per il naturalismo quineano, alcun criterio di realtà esterno o superiore alla scienza e al metodo scientifico.

Una forma di realismo più forte, ma anche esposta a maggiori obiezioni, è stata sostenuta da Popper (1963), che, in accordo con l'interpretazione falsificazionista del progresso scientifico e in polemica con lo strumentalismo - che sottovaluterebbe il fatto che l'indagine scientifica è in larga misura tesa alla ricerca di prove a favore o contro le teorie, eliminando quelle erronee, cioè non corrispondenti alla realtà - ha considerato la successione storica delle teorie scientifiche come un asintotico avvicinamento alla verità e le teorie come descrizioni della realtà sempre più verosimili. Nell'aderire alla tradizionale dottrina della verità come corrispondenza con i fatti, Popper - che riteneva tale teoria essere stata sufficientemente chiarita dalla definizione semantica del predicato 'vero' da parte di A. Tarski - considerava la verità come un principio regolativo, sostenendo una concezione non epistemica del realismo e della stessa nozione di verità: una teoria può essere vera - cioè corrispondere ai fatti - senza che si sia in grado di accertarlo; al massimo, è possibile accertarne la falsità o, nella successione storica, il grado di verosimiglianza tramite comparazioni interteoriche relative al "contenuto di verità" (l'insieme delle conseguenze logiche vere) e al "contenuto di falsità" (l'insieme delle conseguenze logiche false) delle teorie. Il realismo di Popper è stato variamente criticato, in particolare per le difficoltà logiche della sua definizione di grado di verosimiglianza. Esso inoltre piegava a un uso quanto meno discutibile la definizione semantica di verità formulata da Tarski, che non fornisce alcuna indicazione relativa all'esistenza di 'fatti' cui corrisponderebbero gli enunciati di un linguaggio o una teoria, ma si limita a fissare condizioni formali necessarie e sufficienti (tramite la nozione logico-semantica di "soddisfacimento") per la loro verità. Il problema se la definizione tarskiana di verità sia in generale utile nel chiarimento della concezione realista e se renda effettivamente conto della tradizionale idea di corrispondenza attraversa del resto gran parte della filosofia analitica - da Quine a Putnam, da Davidson a Dummett - e gli esiti del dibattito sembrano alquanto negativi (v. verità, in questa Appendice).

Il maggiore ridimensionamento dell'interpretazione realista, non soltanto popperiana, della conoscenza scientifica veniva dalla tesi di incommensurabilità di cui si è detto, la quale finiva per dare un'immagine 'costruttivistica' della scienza le cui conseguenze sul piano della tesi del realismo sono abbastanza ovvie: se ogni teoria (o quadro concettuale) implica un diverso modo di vedere, percepire e strutturare ontologicamente (in breve, di 'costruire') la realtà, la tesi che una teoria possa descrivere le strutture ontologiche e causali di una realtà indipendente dall'attività epistemica perde ogni significato e, con essa, anche la tesi che la successione storica delle teorie fornisca un resoconto sempre più adeguato (vero o verosimile) della realtà. La versione decisamente più drastica della tesi, sostenuta da Feyerabend ma suggerita già da Hanson e Kuhn, è quella semantica. Riprendendo probabilmente tesi wittgensteiniane e quineane (ma sviluppandone in modo originale e conseguente alcune delle implicazioni più radicali attraverso il ricorso a dettagliate e provocatorie analisi di casi tratti dalla storia della scienza), Feyerabend (1965) sosteneva - nell'ambito di un'analisi della possibilità della riduzione interteorica come era stata teorizzata da Nagel - che "il significato di ogni termine che usiamo dipende dal contesto teorico in cui esso occorre", traendone la conseguenza che un medesimo termine, sia esso osservativo o teorico, possiede significati differenti in teorie differenti (tesi della meaning variance): così, nel celebre esempio di Feyerabend, il termine 'massa' ha un significato diverso nella meccanica classica e nella teoria della relatività, con la conseguenza, ancora una volta, che le due teorie, parlando letteralmente di cose diverse, sono inconfrontabili e, pertanto, non riducibili l'una all'altra (come invece ritiene il 'cumulativista'). L'incommensurabilità semantica è quasi certamente la tesi che più di ogni altra ha determinato una rinascita del dibattito sul realismo nell'e. dell'ultimo ventennio, stimolando, per reazione, sofisticate argomentazioni volte a dimostrarne l'implausibilità sia sul piano storico sia su quello teorico. D. Shapere (1969), per es., è stato tra i primi a contrapporvi una concezione realistica delle cosiddette entità teoriche, sottolineando come l'indagine storica testimonia in molti casi la presenza di una certa continuità nel significato di varie nozioni teoriche, per esempio di quella di elettrone, cui andrebbe riconosciuto lo status di nozione trans-teorica, indipendente dalle teorie: esistono infatti varie teorie su un tipo di entità chiamate 'elettroni', e ciò non sarebbe possibile se ciascuna teoria creasse la propria ontologia. Sul piano teorico l'argomento di Shapere è stato ripreso da H. Putnam (1973, 1975, 1978), che lo ha sviluppato all'interno della cosiddetta teoria causale del riferimento (su cui v. significato: Teorie filosofiche del significato, App. V). Putnam ha sottolineato come la meaning variance che conduce all'incommensurabilità sia la conseguenza di una fuorviante concezione semantica che associa un termine a un insieme di espressioni descrittive - i "sensi" di Frege e, nel caso dei termini teorici, le definizioni che ne danno le teorie - che ne determinerebbero univocamente il referente, cioè l'entità designata. Ne seguirebbe che, mutando teoria - cioè le descrizioni intrateoriche che definiscono il significato di un termine -, muterebbe anche il riferimento. Nella più articolata teoria semantica di Putnam, che scinde la componente descrittiva ed epistemica da quella referenziale del significato, ciò che varia da una teoria all'altra è la componente epistemica e descrittiva (oltre che operazionale) dei termini teorici - ossia l'insieme delle proprietà che le teorie attribuiscono ai referenti putativi (le entità postulate) -; immutata rimarrebbe invece quella referenziale, la quale è indipendente dalle teorie e identificata, nelle diverse teorie, con il tipo di entità o di sostanze fisiche ritenute responsabili di certi effetti macroscopici, quale che sia la loro reale natura (l'essenza), che è compito della ricerca scientifica caratterizzare in modo sempre più adeguato.

Questa difesa del realismo attraverso la stabilità referenziale dei termini teorici presenta implicazioni 'essenzialistiche' che sono state spesso ritenute discutibili (non è raro trovare, nella letteratura epistemologica realista, riferimenti alla distinzione lockiana tra "essenza nominale" ed "essenza reale"). Inoltre, essa è stata obbligata a fornire una plausibile spiegazione di una caratteristica che non comporta alcuna difficoltà per le interpretazioni costruttiviste della scienza, e cioè il fatto che la storia della scienza è costellata di esempi di termini teorici che, dal punto di vista di teorie successive, si sono rivelati privi di riferimento (per es. 'flogisto', 'calorico', 'etere'). Di solito, la difficoltà è stata ritenuta superabile restringendo la tesi realista della stabilità referenziale alle "scienze mature". Così, secondo i maggiori sostenitori del realismo scientifico - tra cui R.N. Boyd (1973, 1984, 1990), W. Newton-Smith (1981) e lo stesso Putnam, almeno negli anni Settanta - la tesi del realismo sarà equivalente alle seguenti sottotesi: a) i termini teorici delle scienze mature sono provvisti di un autentico riferimento, quindi le entità da essi designate esistono realmente e quei termini non sono meri strumenti o comode finzioni per rappresentare, organizzare e inferire i fenomeni sperimentali; b) la successione delle teorie di una scienza matura in un certo ambito costituisce una sempre maggiore approssimazione alla verità sia relativamente ai fenomeni osservabili sia relativamente a quelli inosservabili. Inoltre, le teorie più recenti conservano i referenti e le leggi di quelle che le hanno precedute, fornendone spiegazioni più ampie, accurate e sempre più vere. La novità di questa versione del realismo - noto come realismo convergente per l'accento che pone sulla caratteristica delle teorie di convergere tutte, nella progressione storica, verso un'unica teoria 'completa' sulla realtà - sta soprattutto nel fatto che i suoi sostenitori la formulano non come una tesi metafisica, ma, secondo un generale approccio ispirato dal naturalismo di Quine e dagli argomenti a favore del realismo avanzati da W. Sellars (1963), come un'ipotesi empirica e scientifica sulla pratica scientifica. Secondo un celebre argomento di Putnam, quella del realismo è l'unica ipotesi esplicativa che non fa del successo della scienza un miracolo: il successo esplicativo e predittivo delle teorie, ha notato Putnam, può essere plausibilmente spiegato solo con l'ipotesi che esse siano vere, cioè descrizioni corrette della struttura ontologica e causale della realtà. L'argomento è stato articolato nel modo più conseguente da Boyd a partire dalla constatazione incontestabile che la metodologia scientifica - osservazione, sperimentazione e conferma - è altamente influenzata dalle teorie e dagli sviluppi teorici; se questo è vero, continua l'argomento, l'attendibilità strumentale dei metodi scientifici - il fatto cioè che essi conducano a spiegazioni e predizioni di successo - può essere considerata in larga misura una conseguenza del fatto che le teorie su cui essi si basano sono, almeno approssimativamente, vere e provviste di riferimento. Questa difesa del realismo fa uso di un argomento noto come abduzione o inferenza alla migliore spiegazione, la cui capacità di condurre a spiegazioni vere è stata più volte contestata da parte di antirealisti, soprattutto per il suo dare per dimostrata l'inattendibilità della tesi di sottodeterminazione (e si tratterebbe, nel caso dell'ipotesi realista, di una sottodeterminazione 'di secondo livello', riguardante cioè, oltre che le ipotesi interne alla scienza, anche una 'metaipotesi' sulle teorie scientifiche in generale, che potrebbe ben essere sottodeterminata rispetto ai dati storici pertinenti). Di là dalle difficoltà logiche ed epistemologiche dell'argomento, tuttavia, l'obiezione maggiore all'inferenza dal successo delle teorie alla loro verità deriva da chi, come Laudan (1981), ponendosi sullo stesso piano storico-empirico del realista, mette in evidenza come molte teorie un tempo di successo si siano rivelate, per quanto ne sappiamo oggi, prive di importo referenziale e completamente false (per es., la teoria medica degli umori, le teorie dell'etere, le teorie della forza vitale, la teoria della generazione spontanea). La restrizione dell'ipotesi alle "scienze mature" può forse limitare la forza di questo controargomento, ma resta nondimeno il sospetto che si tratti di una restrizione ad hoc che, mentre finisce per privilegiare la scienza (e in particolare la fisica) del 20° sec., indebolisce comunque l'implicazione successo-verità in modo alquanto immotivato e 'ideologico', per così dire (si può davvero escludere, come auspicava Putnam, che le teorie scientifiche di oggi si riveleranno in futuro prive di importi referenziali, come è accaduto per la teoria chimica del flogisto?). Un'altra obiezione al realismo convergente è che esso, come è stato più volte notato, si basi sull'accettazione acritica di nozioni vaghe come 'verità' e 'approssimazione alla verità' senza fornirne un'adeguata caratterizzazione. Come si è già notato a proposito di Popper, il realista si appella implicitamente a una presunta corrispondenza tra enunciati e teorie da un lato e porzioni di realtà dall'altro, corrispondenza della cui intelligibilità è legittimo dubitare sia a causa della problematizzazione contemporanea (dello stesso Popper oltre che dei filosofi post-positivisti) della nozione di fatto, per la quale ciò che si considera un fatto non è indipendente da un insieme di presupposti teorici, linguistici e concettuali, sia, soprattutto, in seguito alla diffusione delle cosiddette teorie deflazionistiche della verità degli ultimi trent'anni (v. verità, in questa Appendice).

Anche per via delle difficoltà legate ai concetti di verità e corrispondenza, le proposte epistemologiche sul realismo sembrano aver imboccato percorsi alquanto problematici. Lo stesso Putnam (1981) ha finito del resto per abbandonare questo tipo di realismo, che considera "metafisico", a favore di una prospettiva pragmatista che, liberandosi del tutto di presupposti tipicamente prekantiani, tende a definire la verità non in termini di corrispondenza, ma di "asseribilità in condizioni epistemiche ideali" sulla base dei migliori criteri intersoggettivi disponibili in una comunità scientifica. È abbastanza agevole rilevare come le ultime proposte di Putnam (1981, 1987), benché intendano difendere una prospettiva realista moderata (il "realismo interno"), siano in realtà meglio caratterizzabili come un originale tentativo di conciliare il pragmatismo con il convenzionalismo dei linguistic frameworks del tardo Carnap (1950) e il pluralismo delle world versions di Goodman (1978), un tentativo che, ridimensionando ampiamente le pretese del realismo così come questo era stato inizialmente concepito, si pone l'obiettivo più debole di salvaguardare l'oggettività del discorso scientifico. Tali esiti testimoniano come le teorie del realismo nell'e. contemporanea appaiano quanto meno irrisolte; non è chiaro d'altronde fino a che punto esse siano state in grado di contrastare il relativismo e il costruttivismo di Kuhn e Feyerabend, anche in considerazione del fatto che la pratica scientifica e la storia della scienza sembrano aver fornito evidenze a entrambe le opposte fazioni. Non mancano d'altra parte sofisticati argomenti antirealisti come quelli avanzati da B.C. Van Fraassen (1980), il cui "empirismo costruttivo", identificando l'attività scientifica con "un'attività di costruzione piuttosto che di scoperta", ripropone alcuni fondamentali principi positivistici evitandone tuttavia gli aspetti più implausibili (quali il verificazionismo e la distinzione teorico-osservativo). Mettendo in discussione la correttezza dell'argomentazione che inferisce la verità delle teorie dal loro successo e seguendo in modo personale l'approccio formalistico tipico del neopositivismo, Van Fraassen ha considerato le teorie come strutture matematiche provviste di almeno un modello (in senso logico-matematico) empirico, ossia strumenti volti a rappresentare correttamente ("salvare") i fenomeni osservabili, senza che ciò comporti la credenza nelle entità inosservabili postulate.

Un tentativo diverso dai precedenti di difendere il realismo eludendo il tradizionale problema della verità è stato compiuto da N. Cartwright (1983) e I. Hacking (1983), i quali hanno distinto un "realismo sulle entità" da un "realismo sulle teorie". Ora, è soltanto quest'ultimo a dover fare i conti con i concetti di verità e corrispondenza, e sotto questo aspetto le leggi formulate da una teoria, hanno sottolineato sia la Cartwright sia Hacking, potrebbero anche essere false, dato che non esistono in natura regolarità ineccepibili come quelle formulate dalle teorie. Il primo tipo di realismo si limita invece a riconoscere la possibilità di attribuire autentica realtà alle entità postulate dalle teorie senza con questo dover presumere una qualche corrispondenza tra descrizioni teoriche e (porzioni di) realtà. Come ha notato Hacking, questo punto di vista deve molto all'intuizione di Putnam circa l'indipendenza dei referenti dei termini teorici dalle descrizioni che ne possono dare le diverse teorie. Ma esso non implica semplicemente una tesi semantica. L'esistenza delle entità postulate dalle teorie è piuttosto una conseguenza che si trae dai molteplici aspetti dell'attività sperimentale: la realtà degli elettroni e di altre entità inosservabili verrebbe infatti dimostrata dai poteri causali da essi posseduti, in particolare da quelli utilizzati nei laboratori sperimentali per produrre nuovi fenomeni o interferire con altri fenomeni. Molte ingenuità e difficoltà del realismo difeso nella filosofia della scienza contemporanea deriverebbero, per Hacking, dall'aver in larga misura trascurato l'attività sperimentale a favore di quella teorica.

Dall'"epistemologia naturalizzata" all'"epistemologia cognitiva"

Nel concludere la presente ricostruzione del dibattito epistemologico della seconda metà del sec. 20° sarà opportuno fare almeno un rapido cenno al progetto di Quine della cosiddetta e. naturalizzata e agli attuali orientamenti di tipo "cognitivo".

In un celebre articolo del 1969 Quine sosteneva, in una forma che sarebbe diventata paradigmatica del suo approccio all'e., che ogni sensato discorso sulla conoscenza, dai più elementari livelli percettivi fino all'elaborazione di sofisticate teorie scientifiche, non può che essere basato sulle risorse, gli strumenti e i risultati delle scienze stesse. L'e. - sia nel senso ristretto (tipicamente anglosassone) di "teoria della conoscenza", sia in quello più vasto di filosofia o metodologia della scienza - non può, riteneva Quine, essere considerata parte di un discorso specificamente filosofico sulla scienza: abbandonati il punto di vista di una "filosofia prima" e i progetti fondazionali che ancora caratterizzavano l'approccio neopositivistico alla scienza, lo studio dell'attività conoscitiva e della metodologia scientifica sopravviverebbe esclusivamente come "capitolo" della scienza naturale. L'obiettivo di questo approccio naturalistico all'e. - che in Quine è strettamente legato al suo olismo e alla sua opzione fisicalistica - sarebbe il conseguimento di plausibili teorie scientifiche riguardanti il modo in cui, a partire dalle stimolazioni delle terminazioni nervose di un soggetto fisico qual è l'uomo, si possono elaborare, da parte di quel soggetto fisico, le teorie scientifiche sulla realtà. Il programma di Quine - al quale per certi aspetti può essere avvicinato quello di Popper e D.T. Campbell dell'"e. evoluzionistica" - prevedeva naturalmente una fervida cooperazione tra le più varie scienze naturali, dalla psicologia comportamentistica (di tipo skinneriano) alla neurofisiologia, dalla biologia evoluzionistica alle scienze del linguaggio. Nel suo più recente lavoro, From stimulus to science (1995), Quine ha ribadito le tesi principali del suo progetto, chiarendo ulteriormente le ragioni della definitiva scomparsa di una disciplina specificamente filosofica che si occupi della conoscenza in generale e del sapere scientifico in particolare.

Per quanto si siano liberati dei restrittivi vincoli comportamentistici posti da Quine allo studio empirico-psicologico dell'attività scientifica, i sempre più numerosi tentativi di coniugare le indagini sulla metodologia scientifica con le ricerche svolte nell'ambito della cosiddetta scienza cognitiva (v. in questa Appendice) possono essere in qualche modo considerati un originale sviluppo del programma di ricerca naturalistico difeso da Quine, il cui nome viene spesso citato da molti autorevoli esponenti del nuovo orientamento. Le recenti prospettive mettono innanzitutto in discussione l'identificazione, tipica della vecchia e. (e già contestata dal postpositivismo), fra attività cognitiva scientifica e organizzazione logico-formale di strutture linguistiche, mirando a fornire analisi empiriche e descrittive del ragionamento scientifico (più che canoni normativi di una razionalità scientifica astrattamente considerata) con l'ausilio delle risorse e dei risultati della psicologia cognitiva, delle neuroscienze e dell'intelligenza artificiale. Temi privilegiati dell'"epistemologia cognitiva" o, secondo una recente definizione di A.I. Goldman (1993), "scienza cognitiva della scienza", sono l'elaborazione di modelli computazionali dell'accettazione di ipotesi, l'analisi delle strategie euristiche e delle procedure inferenziali tipiche dei ricercatori scientifici, lo studio dei meccanismi cerebrali che presiedono alla scoperta e alla teorizzazione scientifiche. Da segnalare, in questo ambito di ricerca, sono almeno i contributi di H. Simon, P. Thagard, R. Giere, oltre, naturalmente, a quelli di P. Churchland, tra i più strenui difensori del cosiddetto materialismo eliminativo (v. mente, App. V) e di un approccio "neurocomputazionale" all'epistemologia. Churchland, lamentando la totale mancanza di relazione dell'e. tradizionale con una "qualsiasi teoria che riguardi la struttura biologica del cervello" (Churchland 1989; trad. it. 1992, p. 119) ha coerentemente proposto un'analisi dei meccanismi di rappresentazione e di inferenza basata su modelli connessionistici, pervenendo su questa base a originali caratterizzazioni sia della nozione di teoria sia di quella di spiegazione. Da questo punto di vista gran parte dell'e. tradizionale appare quanto meno inquinata da una sopravvalutazione di aspetti puramente proposizionali, logici e normativi che non trovano un adeguato corrispettivo sul piano psicologico-cognitivo e neurocerebrale. E, benché sia prematura ogni valutazione di questo nuovo orientamento, appare sempre più esiguo, per la riflessione futura, lo spazio per un'e. intesa come filosofia della scienza.

bibliografia

P. Duhem, La théorie physique: son object et sa structure, Paris 1906 (trad. it. Bologna 1978).

K.R. Popper, Logik der Forschung, Wien 1935 (ed. ingl. col titolo Logic of scientific discovery, London 1959.

R. Carnap, Empiricism, semantics, and ontology, in Revue internationale de philosophie, 1950, pp. 20-40 (trad. it. in Semantica e filosofia del linguaggio, a cura di L. Linsky, Milano 1969, pp. 261-82).

C.G. Hempel, Problems and changes in the empiricist criterion of meaning, in Revue internationale de philosophie, 1950, pp. 41-63 (trad. it. in Semantica e filosofia del linguaggio, a cura di L. Linsky, Milano 1969, pp. 209-32).

W.V.O. Quine, Two dogmas of empiricism, in Philosophical review, 1951, pp. 20-43 (rist. in W.V.O. Quine, From a logical point of view, Cambridge (Mass.) 1953, 1980³, pp. 20-46; trad. it. dalla 2a ed. Il problema del significato, Roma 1966, pp. 20-44).

S.E. Toulmin, The philosophy of science. An introduction, London-New York 1953 (trad. it. Che cosa è la filosofia della scienza?, Milano 1973).

L. Wittgenstein, Philosophische Untersuchungen, hrsg. G.E.M. Anscombe, R. Rhees, Oxford 1953 (trad. it. a cura di M. Trinchero, Torino 1967).

N. Goodman, Fact, fiction, and forecast, Cambridge (Mass.) 1954, 1983⁴ (trad. it. Roma-Bari 1985).

N.R. Hanson, Patterns of scientific discovery, Cambridge 1958 (trad. it. Milano 1978).

A. Grünbaum, The Duhemian argument, in Philosophy of science, 1960, pp. 75-87 (rist. in Can theories be refuted?, ed. S.G. Harding, Dordrecht-Boston 1976, pp. 116-31).

W.V.O. Quine, Posits and reality, in Basis of the contemporary philosophy, ed. S. Uyeda, 5° vol., Tokyo 1960, pp. 391-400 (rist. in W.V.O. Quine, The ways of paradox and other essays, New York 1966; trad. it. Milano 1975).

W.V.O. Quine, Word and object, Cambridge (Mass.) 1960 (trad. it. Milano 1970).

E. Nagel, The structure of science, New York 1961 (trad. it. Milano 1968).

S.E. Toulmin, Foresight and understanding. An enquiry into the aims of science, Bloomington (Ind.) 1961 (trad. it. Roma 1982).

Th.S. Kuhn, The structure of scientific revolutions, Chicago 1962, 1970² (trad. it. Torino 1978).

A. Grünbaum, The falsifiability of theories: total or partial? A contemporary analysis of the Duhem-Quine thesis, in Proceedings of the Boston Colloquium for the philosophy of science 1961-1962, ed. M.W. Wartofsky, Dordrecht 1963, pp. 178-95.

M.B. Hesse, Models and analogies in science, London-New York 1963, 1970² (trad. it. Milano 1980).

K.R. Popper, Conjectures and refutations, London 1963 (trad. it. Bologna 1972).

W.V.O. Quine, On simple theories of a complex world, in Synthese, 1963, pp. 107-11 (rist. in W.V.O. Quine, The ways of paradox and other essays, New York 1966).

W. Sellars, Science, perception and reality, London-New York 1963.

P.K. Feyerabend, Problems of empiricism, in Beyond the edge of certainty, ed. R.G. Colodny, Englewood Cliffs (N.J.) 1965, pp. 145-269 (trad. it. Milano 1971).

I. Scheffler, Science and subjectivity, Indianapolis (Ind.) 1967 (trad. it. Roma 1983).

W.V.O. Quine, Epistemology naturalized, in W.V.O. Quine, Ontological relativity and other essays, New York 1969, pp. 69-90 (trad. it. Roma 1986).

D. Shapere, Towards a post-positivistic interpretation of science, in The legacy of logical positivism, ed. P. Achinstein, S.F. Barker, Baltimore 1969, pp. 115-60.

Criticism and the growth of knowledge, ed. I. Lakatos, A. Musgrave, Cambridge 1970 (trad. it. Milano 1976).

I. Lakatos, Falsification and the methodology of scientific research programmes, in Criticism and the growth of knowledge, ed. I. Lakatos, A. Musgrave, Cambridge 1970, pp. 91-196 (trad. it. Milano 1976, pp. 164-276).

K.R. Popper, Objective knowledge. An evolutionary approach, Oxford 1972 (trad. it. Roma 1975).

R.N. Boyd, Realism, underdetermination and a causal theory of evidence, in Noûs, 1973, pp. 1-12.

H. Putnam, Explanation and reference, in Conceptual change, ed. G. Pearce, P. Maynard, Dordrecht-Boston 1973, pp. 199-221.

B. Barnes, Scientific knowledge and sociological theory, London-Boston 1974.

D. Davidson, On the very idea of a conceptual scheme, in Proceedings and addresses of the American philosophical association, 1974, pp. 5-20 (rist. in D. Davidson, Inquiries into truth and interpretation, Oxford-New York 1984, pp. 183-98; trad. it. Bologna 1994).

K.R. Popper, Replies to my critics, in The philosophy of Karl Popper, ed. P.A. Schilpp, 2 voll., La Salle (Ill.) 1974, 2° vol., pp. 961-1197.

The structure of scientific theories, ed. F. Suppe, Urbana (Ill.) 1974, 1977²

P.K. Feyerabend, Against method. Outline of an anarchich theory of knowledge, London 1975 (trad. it. Milano 1979).

H. Putnam, The meaning of "meaning", in H. Putnam, Mind, language and reality, Cambridge-New York 1975, pp. 215-71 (trad. it. Milano 1987, pp. 238-97).

W.V.O. Quine, On empirically equivalent system of the world, in Erkenntnis, 1975, pp. 313-28 (trad. it. in W.V.O. Quine, Saggi filosofici 1970-1981, Roma 1982, pp. 127-43).

D. Bloor, Knowledge and social imagery, London-Boston 1976.

Can theories be refuted? Essays on the Duhem-Quine thesis, ed. S.G. Harding, Dordrecht-Boston 1976.

G. Giorello, Filosofia della scienza e storia della scienza nella cultura di lingua inglese, in L. Geymonat, Storia del pensiero filosofico e scientifico, 7° vol., Milano 1976, pp. 654-762.

H.I. Brown, Perception, theory and commitment. The new philosophy of science, Chicago 1977 (trad. it. La nuova filosofia della scienza, Roma-Bari 1984).

L. Laudan, Progress and its problems, Berkeley 1977 (trad. it. Il progresso scientifico, Roma 1979).

N. Goodman, Ways of worldmaking, Indianapolis (Ind.) 1978 (trad. it. Vedere e costruire il mondo, Roma-Bari 1988).

H. Putnam, Meaning and the moral science, London-Boston 1978 (trad. it. Verità e etica, Milano 1982).

B.C. Van Fraassen, The scientific image, Oxford-New York 1980 (trad. it. Bologna 1985).

P. Parrini, La struttura logica del controllo empirico e il falsificazionismo di K.R. Popper, in P. Parrini, Una filosofia senza dogmi, Bologna 1980, pp. 93-162.

L. Laudan, A confutation of convergent realism, in Philosophy of science, 1981, pp. 19-48.

W. Newton-Smith, The rationality of science, Boston 1981; H. Putnam, Reason, truth and history, Cambridge-New York 1981 (trad. it. Milano 1985).

Scientific revolutions, ed. I. Hacking, Oxford-New York 1981 (trad. it. Roma-Bari 1984).

S. Amsterdamski, Mięzdy historia a metoda, Warszawa 1983 (trad. it. Tra la storia e il metodo, Roma-Napoli 1986).

N. Cartwright, How the laws of physics lie, Oxford-New York 1983.

I. Hacking, Representing and intervening, Cambridge-New York 1983 (trad. it. Conoscere e sperimentare, Roma-Bari 1987).

R.N. Boyd, The current status of scientific realism, in Scientific realism, ed. J. Leplin, Berkeley 1984, pp. 41-82.

Scientific realism, ed. J. Leplin, Berkeley 1984.

D. Oldroyd, The arch of knowledge. An introductory study of the history of the philosophy and methodology of science, New York 1986 (trad. it. Storia della filosofia della scienza, Milano 1989).

P. Langley, H. Simon, G. Bradshaw, J. Zytkov, Scientific discovery, Cambridge (Mass.) 1987.

H. Putnam, The many faces of realism, La Salle (Ill.) 1987 (trad. it. La sfida del realismo, Milano 1991).

R.N. Giere, Explaining science. A cognitive approach, Chicago 1988 (trad. it. Bologna 1996).

P.M. Churchland, A neurocomputational perspective. The nature of mind and the structure of science, Cambridge (Mass.) 1989 (trad. it. parz. Bologna 1992).

R.N. Boyd, Realism, approximate truth, and philosophical method, in Scientific theories, ed. C.W. Savage, Minneapolis (Minn.) 1990, pp. 355-91.

R.N. Boyd, Realism, conventionality, and "realism about", in Meaning and method. Essays in honor of H. Putnam, ed. G. Boolos, Cambridge-New York 1990, pp. 171-95.

W.V.O. Quine, Pursuit of truth, Cambridge (Mass.) 1990, 1992².

P. Thagard, Conceptual revolutions, Princeton 1992 (trad. it. Milano 1994).

D. Gillies, G. Giorello, Philosophy of science in the twentieth century, Oxford-Cambridge (Mass.) 1993 (trad. it. Roma-Bari 1995).

A.I. Goldman, Philosophical applications of cognitive science, Boulder (Colo.) 1993 (trad. it. Bologna 1996).

W.V.O. Quine, From stimulus to science, Cambridge (Mass.) 1995.

G. Boniolo, Filosofia della scienza: la chiusura di un ciclo?, in L. Geymonat, Storia del pensiero filosofico e scientifico, a cura di E. Bellone, C. Mangione, 8° vol., Milano 1996, pp. 3-78.

D. Papineau, The philosophy of science, New York 1996.

G. Lolli, Beffe, scienziati e stregoni, Bologna 1998.