Informatica

Informatica

(App. IV, ii, p. 189; V, ii, p. 704)

Mentre negli anni 1937-38 venivano pubblicati l'ultimo volume della Enciclopedia Italiana e l'App. I, alcuni ricercatori (K. Zuse in Germania, G. Stibitz e H.H. Aiken negli Stati Uniti) lavoravano intensamente alla progettazione di macchine calcolatrici elettromeccaniche, in grado di soddisfare la crescente esigenza di potenza di calcolo e di elaborazione automatica dell'informazione numerica, che era registrata nei volumi dell'Enciclopedia (v. calcolatrici, macchine, VIII, p. 352 e App. I, p. 339; statistica: Macchine per contabilità e statistica, App. I, p. 1018). Nel periodo intorno alla Seconda guerra mondiale furono sviluppate le prime macchine calcolatrici elettroniche, nelle quali venivano applicate le tecnologie in uso in radiotecnica e in telefonia: il moderno sviluppo tecnologico veniva così incontro ad aspirazioni molto più antiche relative all'automatizzazione e alla creazione di esseri artificiali in grado di riprodurre le capacità umane, incluso il pensiero (v. automa, V, p. 554). Un ampio ventaglio di ricerche nell'ambito della logica matematica (dall'algebra di G. Boole al concetto teorico di algoritmo di A. Turing, alle idee sull'architettura delle macchine calcolatrici di J. von Neumann) e nel campo delle tecniche di trasmissione dei messaggi (i cui principi di base furono stabiliti da Cl. Shannon) costituiscono il substrato teorico che rese possibile il perfezionamento dei calcolatori elettronici. Questo periodo pionieristico è ben considerato nelle App. II e III, nelle voci calcolatrici, macchine (App. II, i, p. 482; III, i, p. 281), elettronica (App. III, i, p. 532) e informazione, teoria della (App. III, i, p. 874), oltre che nella voce cibernetica (App. III, i, p. 368), che riprende le riflessioni generali e interdisciplinari sul confronto fra i processi di comunicazione o trasmissione dell'informazione nell'animale e nella macchina, sollecitate dai recenti sviluppi tecnologici (v. nell'App. III: automazione, i, p. 178, controlli automatici, i, p. 430 e servosistema, ii, p. 705). Negli anni Quaranta e Cinquanta vengono quindi sviluppate le prime macchine dotate di programmi registrati, in grado di eseguire in modo automatico sequenze prefissate di istruzioni. Queste macchine sono dette elaboratori elettronici (in francese il nuovo termine è ordinateur; ma internazionalmente si preferisce usare il termine inglese per 'calcolatore', computer). Dalle prime applicazioni militari si passa, negli anni successivi, alle applicazioni industriali su vasta scala, con la creazione dei grandi sistemi informativi; e si assiste a un'esplosione dei perfezionamenti tecnici. Si sviluppa di conseguenza un nuovo settore di ricerche per il quale Ph. Dreyfus ha coniato nel 1962 un nuovo termine, informatique (composto di information e automatique), il quale, rispetto alla locuzione inglese computer science, sposta l'accento dallo strumento, l'elaboratore elettronico, all'oggetto immateriale da esso trattato, l'informazione; l'i., nella sua accezione più ampia concerne, oltre le discipline che forniscono la base scientifica e formale (scienze dell'informazione), anche aspetti tecnologici, sistemistici e applicativi. Questa fase di espansione dell'i. è trattata nelle Appendici tra gli anni Settanta e l'inizio dei Novanta, oltre che sotto il lemma informatica, anche nelle voci elettronica (App. IV, i, p. 669 e V, ii, p. 73), elaboratori elettronici (App. IV, i, p. 650 e V, ii, p. 44) oltre che circuito logico (App. IV, i, p. 454), linguaggi programmativi (App. V, iii, p. 215), logica e informatica (App. V, iii, p. 238), intelligenza artificiale (App. V, ii, p. 735). Gli aspetti industriali legati a questo nuovo settore di attività sono descritti nell'App. V nelle voci elettronica, industria (ii, p. 80) e informatica, industria (ii, p. 707).

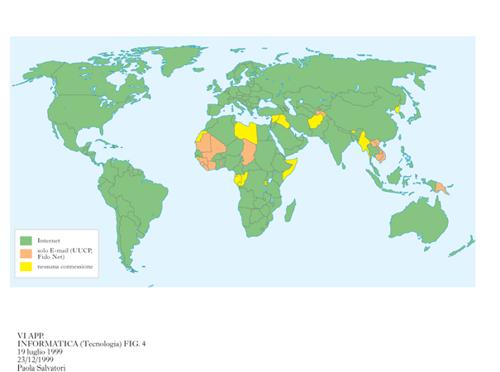

L'i. ha assunto nel panorama scientifico della fine del 20° sec. una notevole rilevanza, legata alla diffusione dei sistemi di elaborazione nei più svariati ambiti dell'attività umana, dal mondo scientifico, militare, industriale e finanziario, sino al commercio, alla casa, al tempo libero, grazie allo sviluppo della tecnologia digitale dei circuiti integrati (v. microelettronica in questa Appendice), che ha determinato la definitiva affermazione dei computer nella vita quotidiana. Negli ultimi anni sono emerse nuove possibilità di supporto degli strumenti informatici in campo scientifico (v. computazionali, metodi; fisica: Calcolatori nella fisica teorica, e simulazione, in questa Appendice) e umanistico (v. beni culturali: Beni culturali e informatica, e informatica umanistica, in questa Appendice); in particolare hanno avuto notevole sviluppo alcuni settori di i. applicata alla ricerca scientifica (v. informatica medica, App. V, ii, p. 709, ripresa sotto il lemma ingegneria biomedica, e informatica musicale, in questa Appendice; per l'i. giuridica, v. oltre Informatica e diritto). Continuano a estendersi le applicazioni all'ingegneria e all'architettura, anche attraverso lo sviluppo di metodi di rappresentazione numerica dell'informazione applicabili a qualsiasi tipo di segnale. Inoltre, il trattamento di immagini e suoni, anche in forma integrata, ha portato allo sviluppo dell'idea di multimedialità (v. multimedialità; produzione; progettazione; robotica, in questa Appendice). Insieme alla diffusione delle telecomunicazioni, l'onnipresenza degli elaboratori e delle loro applicazioni ha determinato una svolta epocale nei sistemi socioeconomici dei paesi tecnologicamente avanzati, con il passaggio da una società basata sulla produzione industriale e sul consumo di energia a una basata sulla produzione di beni immateriali e di servizi, che viene suggestivamente definita 'società dell'informazione'. In questa voce vengono considerate le sfide teoriche che sono di fronte alle scienze dell'informazione, che forniscono i principi di base dello sviluppo dell'i., oltre che le prospettive del complesso delle tecnologie dell'informazione (v. anche elaboratori elettronici, in questa Appendice). La pervasività dei sistemi informatici ha importanti implicazioni giuridico-sociali, che sono illustrate in conclusione della voce attraverso il rapporto fra i. e diritto. Notevoli sono inoltre le implicazioni socio-culturali della simbiosi fra i. e telecomunicazioni, che ha portato alla nascita delle reti di informazioni e della rete globale Internet (v. rete, in questa Appendice; e nell'App. V le voci telematica, v, p. 417 e spazio informatico, v, p. 94). *

Scienze dell'informazione

di Giorgio Ausiello

Con la locuzione scienze dell'informazione (coniata intorno al 1970 in occasione dell'istituzione presso l'università di Pisa del primo corso di laurea italiano in i.) ci si riferisce a un complesso di discipline scientifiche aventi per oggetto lo studio formale degli strumenti, dei metodi e dei processi per la rappresentazione dell'informazione e per la sua elaborazione. Favorendo la comprensione dei diversi aspetti e delle diverse fasi dell'elaborazione elettronica, le scienze dell'informazione creano le basi concettuali e culturali dello sviluppo tecnologico e contribuiscono a migliorare l'affidabilità, l'efficienza e la facilità d'uso dei sistemi.

Tuttavia, anche se le scienze dell'informazione si occupano prevalentemente di elaborazione dell'informazione realizzata mediante calcolatore elettronico, e si sono sviluppate in relazione all'evoluzione dei calcolatori stessi, va sottolineato che molte problematiche da esse studiate sono indipendenti dallo strumento utilizzato per l'elaborazione. Da un lato queste discipline riguardano temi oggetto di studio anche prima dell'avvento degli elaboratori elettronici (per es., il concetto di algoritmo); dall'altro esse devono affrontare anche aspetti di elaborazione dell'informazione realizzata con tecnologie diverse da quella elettronica (per es., l'elaborazione realizzabile con materiale genetico o con una struttura neuronale). È dunque riduttivo considerare le scienze dell'informazione come le discipline scientifiche alla base dello studio dell'elaboratore elettronico. Esse investono un più vasto ambito culturale; fanno proprie metodologie della fisica (nell'analisi e nella misura dei fenomeni computazionali), della matematica (nella creazione di sistemi formali, modelli, teorie per rappresentare le diverse realtà che si vogliono automatizzare), della psicologia (nella ricerca sui processi cognitivi e sulla loro simulazione).

Due aspetti mettono in evidenza, in particolare, il legame tra le scienze dell'informazione, la matematica e la logica. Per analizzare e affrontare in modo scientifico i problemi relativi all'elaborazione dell'informazione nei vari campi applicativi, è necessario seguire procedimenti di astrazione e di formalizzazione concettualmente non dissimili da quelli seguiti dai matematici ma basati su nuove strutture formali, diverse da quelle utilizzate nei campi classici della matematica. Così, per es., per descrivere e ottimizzare i sistemi di produzione industriale è stata utilizzata la teoria delle reti di Petri, per il controllo di sistemi in condizioni di incertezza sono stati introdotti gli insiemi sfumati (fuzzy sets), per garantire la sicurezza delle transazioni elettroniche è stata sviluppata la teoria dei protocolli crittografici ecc. In questo senso, dunque, le scienze dell'informazione costituiscono un'estensione della matematica per modellare la realtà delle tecnologie informatiche e delle loro applicazioni. Inoltre, si deve tenere presente che le scienze dell'informazione hanno come oggetto di studio anche, o soprattutto, attività caratteristiche della sfera intellettuale dell'uomo: il calcolo, l'analisi di strutture linguistiche, la rappresentazione simbolica della realtà, il ragionamento ecc. Lo studio dei principi logico-matematici che regolano tali attività è dunque un obiettivo non secondario delle scienze dell'informazione, di grande interesse culturale ed epistemologico. Esso costituisce di fatto una prosecuzione e un arricchimento dell'opera dei logici che negli anni Trenta hanno affrontato e risolto i primi importanti interrogativi riguardanti la completezza e la consistenza delle teorie logiche e il potere computazionale dei sistemi formali di calcolo, a partire dalla definizione formale di A.M. Turing del concetto di algoritmo mediante un modello di calcolo astratto (v. informatica, App. IV; logica e informatica, App. V).

In prosecuzione di questa linea di studi a carattere metateorico, lo sviluppo dell'i. ha determinato ulteriori approfondimenti dei concetti e delle proprietà del calcolo, delle macchine, dei linguaggi ecc. Esempi di problematiche affrontate nell'ambito delle scienze dell'informazione e poste su questo piano fondazionale sono: la definizione del concetto di trattabilità computazionale (come raffinamento del concetto di calcolabilità), l'analisi del potere computazionale di nuovi modelli di calcolo (non deterministici, probabilistici, quantistici), la caratterizzazione dei problemi risolvibili vantaggiosamente con calcolatori paralleli, l'analisi delle relazioni esistenti tra costi di elaborazione e costi di comunicazione nel calcolo distribuito ecc.

Aree metodologiche

In relazione ai diversi obiettivi di studio e alle diverse problematiche citate, si sono sviluppate, nell'ambito delle scienze dell'informazione, varie discipline. Lo Handbook of theoretical computer science, opera enciclopedica che al volgere degli anni Novanta ha inteso fornire un quadro aggiornato delle scienze dell'informazione, cita, in proposito, le seguenti aree fondamentali: complessità di calcolo, complessità di descrizione, algoritmi e strutture di dati, geometria computazionale, crittografia, teoria delle reti di comunicazione, teoria dei circuiti ad alta integrazione, architetture e algoritmi paralleli, teoria degli automi e dei linguaggi formali, automi su strutture infinite, sistemi di riscrittura, λ-calcolo e programmazione funzionale, programmazione logica, teorie logiche della programmazione, correttezza dei programmi, logiche modali e temporali, teoria delle basi di dati, teoria dei sistemi distribuiti, teoria dei processi concorrenti. Si tratta, come si vede, di una pluralità estremamente ampia (e peraltro non esaustiva) di tematiche, nell'ambito di ciascuna delle quali si sono sviluppate delle vere e proprie teorie scientifiche, dotate di complessi apparati concettuali, di tecniche di analisi, di strumenti deduttivi logico-formali, di risultati fondamentali, di applicazioni. Nell'impossibilità di fornire, in questa sede, un quadro così ampio, ci limitiamo a presentare alcune delle più importanti tra le suddette tematiche, raccogliendole in due filoni culturali, uno riguardante gli aspetti relativi alla complessità dei problemi e alla progettazione di algoritmi efficienti, l'altro riguardante gli aspetti relativi al comportamento dei programmi e dei processi, che possiamo denominare, rispettivamente, teoria degli algoritmi e della complessità di calcolo e teoria dei programmi e dei processi di calcolo.

Un filone importante nell'ambito delle scienze dell'informazione (già trattato in App. IV: v. informatica: Informatica matematica, teoria dei linguaggi) è costituito dalla teoria degli automi e dei linguaggi formali, che si occupa delle proprietà sintattiche dei linguaggi, intesi come insiemi di sequenze di simboli definite su un dato alfabeto (chiamate stringhe o parole), dei sistemi formali per la loro caratterizzazione e generazione (grammatiche), della struttura e del potere computazionale di modelli elementari di macchine (automi) che consentono di decidere se una stringa appartiene a un dato linguaggio, cioè se essa rispetta determinate proprietà sintattiche. Tale teoria è alla base degli studi relativi alla sintassi dei linguaggi di programmazione, in particolare dei linguaggi detti ad alto livello, cioè dotati di un repertorio concettuale più composito, e ai metodi di verifica della correttezza sintattica dei programmi e di traduzione di essi in sequenze di istruzioni più semplici direttamente eseguibili dal calcolatore.

Teoria degli algoritmi e della complessità di calcolo

In molte applicazioni dell'i. (controllo di impianti, applicazioni aerospaziali, gestione di reti di telecomunicazione, sistemi di grafica interattiva e di realtà virtuale) la tempestività della risposta del sistema di elaborazione è una condizione vincolante per il funzionamento dell'applicazione stessa. Peraltro, anche nei casi in cui non si richiedono tempi di risposta particolarmente stringenti, come per es. nei sistemi di previsione finanziaria o meteorologica, l'efficienza dei programmi è resa necessaria dalla grande mole di dati che devono essere elaborati in breve tempo.

Per accelerare la soluzione di un problema è sempre possibile accrescere la potenza dei mezzi di calcolo utilizzati. L'evoluzione tecnologica ha determinato, nella seconda metà del Novecento, un costante raddoppio della velocità degli elaboratori ogni diciotto mesi, e ciò consente di gestire in tempi più rapidi applicazioni notevolmente più complesse di quelle affrontate in passato. Inoltre, molte applicazioni si possono giovare dell'utilizzazione di calcolatori paralleli in cui il compito elaborativo è suddiviso tra più unità di elaborazione interconnesse in modo più o meno stretto e operanti simultaneamente (v. elaboratori elettronici, in questa Appendice). D'altra parte queste evoluzioni non riducono l'importanza dell'efficienza degli algoritmi, poiché la complessità e la dimensione delle applicazioni richieste è anch'essa aumentata negli ultimi decenni del secolo, accrescendo vieppiù, anziché ridurla, la forbice tra prestazioni offerte dai sistemi e prestazioni desiderate dagli utenti. Infine, come vedremo oltre, problemi di elevata complessità possono trarre poco vantaggio da aumenti anche cospicui della potenza degli elaboratori.

La necessità di garantire, nelle applicazioni informatiche, la maggiore efficienza possibile, compatibilmente con l'intrinseca complessità delle applicazioni, ha portato allo sviluppo di una serie di metodologie volte a studiare tecniche per il progetto di algoritmi efficienti e per l'analisi delle loro prestazioni (anche con riferimento a elaboratori di diversa tecnologia, come i calcolatori paralleli), nonché a individuare la complessità intrinseca dei problemi e a classificare questi ultimi in relazione al costo (quantità di tempo di calcolo o quantità di memoria) necessario per la loro risoluzione.

Analisi del costo di esecuzione di algoritmi

Per analizzare il costo di esecuzione di un algoritmo e la complessità dei problemi è necessario fare riferimento a modelli di calcolatori astratti, semplificati, che consentano di prescindere dalle caratteristiche tecnologiche dei calcolatori utilizzati in pratica e dai dettagli realizzativi con cui l'algoritmo può essere scritto in un reale linguaggio di programmazione.

Il modello astratto utilizzato più frequentemente a questo scopo è la macchina a registri (chiamata anche RAM, Random Access Machine, cioè macchina con memoria ad accesso casuale). Tale modello (direttamente ispirato al modello strutturale dei normali calcolatori, detto anche modello di von Neumann) è dotato di un nastro di ingresso, di un nastro di uscita, di una memoria costituita da un numero potenzialmente illimitato di celle (chiamate registri), ciascuna delle quali capace di contenere numeri interi arbitrariamente grandi, e di un'unità di elaborazione capace di eseguire semplici istruzioni logico-aritmetiche sugli interi contenuti nei registri (non molto dissimili da quelle previste dai calcolatori reali: trasferimento di dati, somma, sottrazione, prodotto, verifica di uguaglianza a zero ecc.).

Per studiare il costo di esecuzione di un algoritmo si può redigere un programma che lo realizza utilizzando le istruzioni elementari previste dalla RAM e valutare poi il costo di esecuzione di tale programma da parte della macchina, contando le istruzioni che vengono eseguite in funzione dei dati in ingresso. Attribuendo opportunamente i costi alle singole istruzioni (in particolare assumendo che il costo di ogni istruzione sia linearmente proporzionale al numero di cifre degli operandi) si può fare in modo che il costo complessivo di esecuzione dell'algoritmo da parte della RAM corrisponda, a meno di costanti moltiplicative, al tempo di esecuzione dell'algoritmo su una macchina reale.

Un altro modello astratto frequentemente utilizzato negli studi di complessità computazionale è la macchina di Turing. Tale macchina dispone di una memoria interna con un numero finito di stati e di un nastro (memoria esterna) suddiviso in celle, e potenzialmente illimitato, su cui la macchina può leggere e scrivere caratteri mediante un'apposita testina di lettura e scrittura. Un passo elementare di calcolo consiste nella lettura di un carattere sul nastro e, in base al carattere letto e allo stato interno in cui la macchina si trova, nell'effettuazione delle seguenti ulteriori operazioni (transizioni di stato): scrittura di un nuovo carattere, passaggio a un altro stato interno e spostamento a destra o a sinistra della testina. Nonostante questo modello sia alquanto lontano dai reali elaboratori, esso è stato ed è tuttora molto utilizzato, sia nella teoria degli automi e dei linguaggi formali, sia nella teoria degli algoritmi per la sua grande semplicità formale e perché, rispetto alla RAM, si presta, in modo più naturale, all'analisi di algoritmi per linguaggi formali.

Lo scopo dell'analisi di algoritmi è di valutare come evolve il costo di esecuzione di un algoritmo per la soluzione di un problema dato, al crescere della quantità e della dimensione dei dati in ingresso (numero di cifre che costituiscono, in notazione decimale o binaria, i dati in ingresso o altre grandezze analoghe: numero di elementi di un vettore, lunghezza di una stringa di caratteri ecc.), e per confrontarne le prestazioni con quelle di altri algoritmi. In casi particolarmente semplici essa può essere effettuata anche esaminando un programma scritto in linguaggio ad alto livello e limitandosi a contare le istruzioni più significative che vengono eseguite durante il calcolo, sempre in funzione della dimensione dei dati in ingresso. L'analisi può fare riferimento sia al comportamento dell'algoritmo in corrispondenza di quei dati per cui l'esecuzione è più laboriosa (analisi del caso peggiore), sia alla media dei costi di elaborazione, assumendo opportune ipotesi di distribuzione dei dati (analisi del caso medio). Per esprimere il comportamento asintotico del costo di esecuzione si utilizza la seguente notazione matematica: si dice che il costo nel caso peggiore (o nel caso medio) è O(f(n)) se esistono due costanti c e n' tali che per ogni n>n', per ogni dato (o, rispettivamente, in media sui dati) di dimensione n, l'algoritmo ha un costo limitato da c f(n).

Per effettuare l'analisi degli algoritmi, in particolare per l'analisi del caso medio, è necessario affrontare, a volte, problemi di natura matematica e combinatoria alquanto complessi (risoluzione di relazioni di ricorrenza mediante funzioni generatrici, espansione delle soluzioni in serie formali, determinazione di approssimazioni asintotiche mediante metodi di analisi complessa ecc.). Tra i ricercatori che hanno maggiormente contribuito a questo campo segnaliamo D.E. Knuth (cui si devono i primi studi e la nozione stessa di analisi di algoritmi), P. Flajolet, R. Sedgewick.

Esempio. Consideriamo il problema dell'ordinamento di un vettore di n interi (per es. in modo crescente). Un metodo banale, chiamato ordinamento mediante selezione, consistente nel cercare via via il minimo tra gli elementi non ancora ordinati e disporlo progressivamente nel vettore, richiede in ogni caso O(n²) confronti tra elementi. Un metodo decisamente preferibile (almeno da un punto di vista asintotico) è quello chiamato ordinamento mediante fusione che consiste nel suddividere il vettore in due parti uguali, nell'ordinare separatamente con lo stesso metodo le due metà e nel fondere i vettori ordinati così ottenuti. Il costo C(n) di questo metodo è O(n logn), dove logn indica il logaritmo in base 2 di n, e si ottiene risolvendo la semplice relazione di ricorrenza C(n)=2 C(n/2)+n, direttamente ricavabile dalla struttura ricorsiva dell'algoritmo. Un altro metodo ricorsivo, che però ha prestazioni diverse nel caso peggiore e nel caso medio, è il metodo chiamato ordinamento rapido. Esso consiste nello scegliere un elemento, individuare la posizione h che gli compete nell'ordinamento finale, e procedere a ordinare con lo stesso metodo i due sottovettori costituiti da elementi in posizione minore e maggiore di h. Questo metodo ha un costo O(n²) nel caso peggiore e O(n logn) nel caso medio. L'analisi del costo nel caso medio per questo algoritmo porta alla relazione di ricorrenza C(n)=n+1+2/n Σj≤nC(j−1), molto più complessa della precedente, e la cui soluzione si basa su un'approssimazione dei numeri armonici.

Tecniche di progetto di algoritmi efficienti. - La necessità di risolvere problemi con metodi efficienti non è emersa solo nell'ambito delle scienze dell'informazione. Da quando hanno cominciato a essere utilizzati i primi calcolatori, tecniche algoritmiche di grande rilevanza sono state sviluppate nell'ambito del calcolo numerico (per la risoluzione di sistemi di equazioni differenziali e integrali) e della ricerca operativa (per la risoluzione di problemi di ottimizzazione). Tuttavia, nell'ambito delle scienze dell'informazione sono state sviluppate, negli ultimi decenni del 20° sec., tecniche di progetto di algoritmi che hanno permesso di migliorare notevolmente le prestazioni degli algoritmi utilizzati in tutti i campi applicativi. In questa sede ci limiteremo a citare alcuni esempi legati a tre importanti tecniche di progetto.

1) Divide et impera. Con questo sintagma è nota la tecnica di risoluzione di problemi basata sulla decomposizione in sottoproblemi. Un elementare esempio di applicazione di questo metodo di progetto è costituito dall'algoritmo di ordinamento mediante fusione, visto precedentemente. L'uso della tecnica divide et impera ha consentito in molti casi di realizzare algoritmi assai efficienti. Ciò si verifica in particolare quando il numero di sottoproblemi in cui il problema viene decomposto è piccolo e quando la ricomposizione delle loro soluzioni per ricostruire la soluzione del problema originario è semplice (per es., di costo lineare). Inoltre il metodo ha il pregio di facilitare l'analisi delle prestazioni poiché (come abbiamo visto nel caso dell'ordinamento mediante fusione) si può esprimere il costo di esecuzione mediante una relazione di ricorrenza che riflette la struttura ricorsiva dell'algoritmo. Esempi storicamente importanti in cui il metodo divide et impera ha consentito di realizzare algoritmi più efficienti di quelli usati in precedenza sono: l'algoritmo di J.M. Cooley e J.W. Tukey (1965) per la trasformata rapida di Fourier, che può essere realizzata in tempo O(n logn) (v. computazionali, metodi: Applicazioni dell'analisi armonica, in questa Appendice); e l'algoritmo per il prodotto di matrici, dovuto a V. Strassen (1969), che ha permesso per la prima volta di battere il classico algoritmo con tempo di esecuzione O(n³) e di effettuare il prodotto di matrici in tempo O(n²,⁸¹), aprendo così la strada a una serie di miglioramenti che hanno portato D. Coppersmith e S. Winograd (1987) alla realizzazione di algoritmi con tempo di esecuzione O(n²,³⁷⁶). Pur non essendo utilizzabile in pratica, l'algoritmo di Coppersmith e Winograd è asintoticamente il miglior algoritmo noto per il prodotto di matrici e non si sa se possa essere ulteriormente migliorato.

2) Bilanciamento. In molte applicazioni in cui si richiede l'accesso rapido a un'ingente quantità di dati immagazzinati nella memoria principale o nella memoria secondaria è necessario organizzare le informazioni in strutture basate sul concetto di albero bilanciato. Se, per es., associamo opportunamente ai nodi di un albero binario n numeri interi (per es., numeri di matricola di impiegati, collegati alle rispettive informazioni anagrafiche) e se tale albero è bilanciato, cioè il sottoalbero destro e il sottoalbero sinistro hanno 'quasi' lo stesso numero di nodi, è possibile reperire le informazioni riguardanti un impiegato in tempo O(log₂ n). Nel caso che si faccia uso di alberi m-ari (cioè tali che ogni nodo interno abbia m figli) si possono ottenere prestazioni ancora migliori perché l'accesso diviene proporzionale al logm n. Nel 1972 è stata proposta da R. Bayer ed E. McCreight una struttura organizzativa delle informazioni basata su alberi m-ari (B-alberi), che consente di effettuare efficientemente la gestione di grandi archivi su memoria secondaria e di ricercare (ed eventualmente inserire o eliminare) un'informazione con un numero molto esiguo di accessi a disco. I B-alberi sono stati utilizzati per realizzare i primi sistemi di basi di dati relazionali e a essi è in gran parte dovuto il successo di tali sistemi. Più recentemente sono state proposte altre strutture di dati, efficienti per la gestione di dati su memoria secondaria, nelle quali il bilanciamento viene garantito realizzando una redistribuzione casuale delle informazioni sulle varie foglie dell'albero (hashing dinamico, hashing lineare ecc.; to hash significa letteralmente 'triturare' e intende suggerire il fatto che un'informazione viene codificata mediante una stringa calcolata da una funzione che tritura e rimescola i caratteri dell'informazione originaria), in modo da eliminare eventuali squilibri esistenti intrinsecamente nell'insieme delle informazioni trattate. Il concetto di bilanciamento si può estendere dal caso della ricerca su archivi a molti altri problemi. In particolare, il bilanciamento tra sottoproblemi è una condizione necessaria per garantire che la decomposizione attuata dal metodo divide et impera dia risultati efficienti.

3) Dinamizzazione. Un numero crescente di applicazioni informatiche richiede la gestione di informazioni con una rapida evoluzione temporale e quindi soggette ad aggiornamenti molto frequenti. Ciò si verifica, per es., nelle reti di telecomunicazioni, nella visione di scene in movimento, nella grafica interattiva ecc. In questi casi, le usuali strutture di organizzazione dei dati nell'elaboratore non offrono le prestazioni richieste. Per tale motivo sono state introdotte strutture di dati dinamiche che possono essere facilmente aggiornate e che garantiscono un buon comportamento, se non a ogni operazione, almeno su un'intera sequenza di operazioni di aggiornamento. Il maggior contributo in questa direzione è stato dato da R.E. Tarjan che, nel corso degli anni Ottanta, ha introdotto varie strutture di dati chiamate autoadattative (in particolare gli 'alberi sghembi', splay trees) che permettono di eseguire efficientemente sequenze di operazioni di interrogazione e di aggiornamento (inserimenti, cancellazioni, fusioni, scomposizioni ecc.). In questi casi si deve utilizzare un metodo di analisi che tenga conto della ripartizione del costo sulle operazioni di una sequenza (analisi ammortizzata). Oltre a rivelarsi un utile paradigma nella gestione di problemi a elevata dinamicità, l'uso di strutture autoadattative ha anche consentito il miglioramento della soluzione di alcuni problemi di ottimizzazione, come per es. il problema della massimizzazione del flusso in una rete, per il quale A.V. Goldberg e lo stesso Tarjan (1986) hanno proposto una soluzione di costo O(nm log(n²/m)) per grafi con n nodi e m archi, trent'anni dopo il classico (ma inefficiente) algoritmo proposto da L.R. Ford e D.R. Fulkerson (1956).

I risultati riguardanti la realizzazione di algoritmi efficienti, ottenuti a seguito dell'intenso sviluppo della ricerca nell'ambito della teoria degli algoritmi e che sarebbero degni di nota per la loro rilevanza pratica, sono innumerevoli. Tra i campi in cui sono stati fatti progressi significativi possiamo ancora citare: la programmazione lineare (un'importante classe di problemi di ottimizzazione, fino a pochi anni fa ritenuta di costo intrinsecamente esponenziale, per la quale sono stati individuati invece algoritmi polinomiali; v. ottimizzazione, in questa Appendice), la gestione ottimale di reti (importante in quest'area è, per es., la realizzazione di un algoritmo lineare per il minimo albero ricoprente di un grafo), la geometria computazionale (per la quale sono stati definiti algoritmi efficienti di localizzazione di punti in regioni dello spazio e di triangolazione di superfici) ecc.

Caratterizzazione della complessità intrinseca dei problemi. - Il concetto di complessità si presenta in varia forma nell'ambito delle diverse discipline scientifiche. In vari contesti, per es., esso viene correlato alle strutture matematiche (equazioni algebriche, differenziali ecc.) necessarie per descrivere sistemi naturali o artificiali. Nel campo delle scienze dell'informazione, con il termine complessità ci si riferisce, usualmente, alla complessità computazionale, cioè al costo computazionale (quantità di tempo o di memoria) necessario e sufficiente per risolvere un problema con un determinato modello di calcolo (per es. RAM o macchina di Turing).

Per determinare esattamente la complessità computazionale di un problema si deve poter asserire che, fatto riferimento a un particolare modello di calcolo (per es., la RAM), esiste un algoritmo che risolve il problema dato con un certo costo, e che nessun algoritmo può risolvere il problema stesso con un costo asintoticamente minore. La conoscenza di un algoritmo risolutivo per un dato problema non è dunque sufficiente per determinare la complessità del problema stesso. Il costo di esecuzione dell'algoritmo, infatti, fornisce una delimitazione superiore della complessità del problema, ma non ci dice nulla sulle intrinseche caratteristiche che rendono più o meno difficile la soluzione del problema stesso e che derivano dalla sua natura combinatoria. È lo studio di queste proprietà che permette di individuare il costo necessario per risolvere il problema, di individuare, cioè, una delimitazione inferiore della sua complessità. Quando tali delimitazioni coincidono vuol dire che abbiamo caratterizzato esattamente la complessità del problema e che, quindi, l'algoritmo risolutivo che possediamo ha, da un punto di vista asintotico, prestazioni ottime. Formalmente, diciamo che la complessità di un problema è:

- O(f(n)) se esiste un algoritmo che lo risolve con un costo O(f(n)),

- Ω(f(n)) se ogni algoritmo comporta almeno un costo dell'ordine di f(n),

- Θ(f(n)) se essa è sia O(f(n)) sia Ω(f(n)).

Esempio. Consideriamo ancora il problema dell'ordinamento. Possiamo mostrare che la sua complessità è Θ(n logn). Infatti essa è Ω(n logn) poiché il numero di possibili ordinamenti di un vettore di n elementi è n! e il numero minimo di confronti necessari per individuare l'ordinamento corretto è log(n!) ≈̳ n logn (ogni confronto può al più suddividere in due semispazi di uguale cardinalità lo spazio degli ordinamenti possibili). D'altra parte, come abbiamo visto, l'algoritmo di ordinamento mediante fusione è in grado di operare con un costo O(n logn). Possiamo dunque concludere che la complessità del problema dell'ordinamento è Θ(n logn) e che l'algoritmo suddetto è ottimo.

In base alla loro complessità, i problemi vengono raggruppati in classi. Per es., i problemi che hanno complessità O(nk) per qualche valore di k costituiscono la classe dei problemi risolubili in tempo polinomiale, denominata classe P. Tipici esempi di problemi appartenenti a P sono l'ordinamento di vettori, la moltiplicazione di matrici, la determinazione di cammini minimi in grafi e reti, la programmazione lineare ecc. Si noti che, poiché RAM e macchine di Turing possono simularsi reciprocamente in tempo polinomiale, se un problema appartiene alla classe P non dobbiamo specificare a quale modello di calcolo facciamo riferimento.

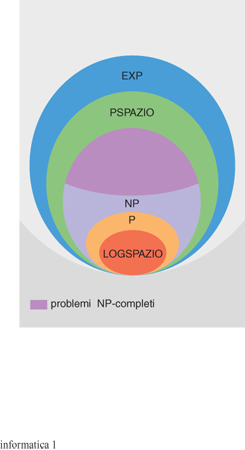

Altre classi significative (fra le molte che sono state studiate) sono le classi di problemi risolubili in tempo esponenziale (EXP), e quelle dei problemi che richiedono una quantità di spazio (memoria) logaritmica (LOGSPAZIO) o polinomiale (PSPAZIO).

Le classi di complessità temporale e spaziale sono parzialmente ordinate rispetto all'inclusione, e lo studio della struttura di tale ordinamento (chiamato complessità strutturale) costituisce uno dei capitoli più importanti delle scienze dell'informazione.

Al centro dell'interesse della complessità strutturale si trova il concetto di trattabilità computazionale. Tale concetto costituisce un rafforzamento del concetto di calcolabilità: un problema si dice trattabile se non solo è possibile risolverlo in modo algoritmico (cioè esso è calcolabile) ma la sua soluzione è realizzabile con un algoritmo che ha un costo di esecuzione polinomiale ed è quindi possibile risolverlo efficientemente in pratica. I problemi la cui soluzione richiede tempo crescente in modo non limitato da un polinomio (per es., in modo esponenziale) vengono considerati intrattabili poiché per essi la crescita asintotica del costo di elaborazione rende proibitiva la risoluzione non appena i dati in ingresso raggiungono una dimensione ragguardevole.

La scelta di identificare la trattabilità computazionale con la complessità polinomiale può apparire arbitraria. Per comprendere tale scelta si può osservare che i benefici derivanti dal potenziamento dei mezzi di elaborazione incidono soprattutto nel caso di problemi risolubili in tempo polinomiale, ma arrecano poco giovamento nella risoluzione di problemi che comportano tempi di risoluzione esponenziali. Infatti, l'utilizzazione di p elaboratori in parallelo (o l'aumento della potenza di un singolo elaboratore di un fattore p) nella migliore delle ipotesi non può che ridurre dello stesso fattore p il tempo di elaborazione complessivo. Sia, per es., p=1024. Supponiamo che in una certa quantità di tempo (diciamo un secondo) sappiamo risolvere un caso di un problema di dimensione k. Ebbene, se il costo della soluzione del problema cresce come n², un calcolatore parallelo con p unità potrà permetterci di affrontare, nella stessa quantità di tempo, un caso di dimensione 32k, ma se il problema richiede tempo dell'ordine di 2n, il calcolatore con p unità permetterà al più di risolvere, sempre nell'intervallo di un secondo, casi di dimensione n+10 e il vantaggio conseguito sarà quindi marginale.

Iniziatori della teoria della complessità computazionale, a metà degli anni Sessanta, si possono considerare J. Hartmanis, H. Stearns e H.R. Lewis, i quali hanno mostrato le condizioni che permettono di provare l'inclusione stretta tra le classi temporali e tra le classi spaziali (teoremi di gerarchia). A tali studi hanno fatto seguito quelli di M. Blum e A. Meyer, aventi per oggetto le proprietà astratte (indipendenti da specifici modelli di calcolo) del concetto di misura di complessità e di classe di complessità, e successivamente, negli anni Settanta, le ricerche di W.J. Savitch, S. Cook, R. Karp, D. Johnson, L. Levin e altri, volte a caratterizzare (anche mediante modelli di calcolo non deterministici, in cui cioè le computazioni non sono costituite da una sequenza univoca di passi ma si diramano con una struttura ad albero) la complessità di problemi di rilevante interesse applicativo e a studiarne la trattabilità. Nonostante i molti risultati conseguiti nell'ambito della teoria della complessità, vari aspetti irrisolti, di interesse sia strutturale che applicativo, pongono all'inizio del nuovo secolo importanti interrogativi agli studiosi. Tali interrogativi investono la natura stessa del calcolo, come, per es., quello riguardante la relazione esistente tra le principali risorse di calcolo, in particolare spazio e tempo: nonostante il primo (a differenza del secondo) sia riusabile, allo stadio attuale non è provato che PSPAZIO contenga funzioni non in P. Anche la relazione tra LOGSPAZIO e P costituisce un interessante problema aperto, poiché non è noto se il contenimento di LOGSPAZIO in P sia stretto o meno.

Una questione di particolare rilevanza riguarda la trattabilità o intrattabilità di un'ampia classe di problemi per i quali si conoscono solo algoritmi di costo temporale esponenziale ma, al tempo stesso, si conoscono solo delimitazioni inferiori di complessità polinomiali. Alcuni esempi di problemi di tale tipo sono la risolubilità di un sistema di equazioni lineari a variabili intere, la soddisfattibilità di un'espressione booleana, la possibilità di sequenziare un insieme di lavori su più macchine in modo da rispettare una data scadenza, la possibilità di stabilire se esiste un percorso che consenta a un commesso viaggiatore di visitare un dato numero di città entro un dato limite di tempo ecc.

Una particolarità comune a tutti questi problemi è che in ogni caso l'insieme delle soluzioni possibili (per es., l'insieme di tutte le possibili assegnazioni di valori di verità alle variabili della formula booleana o l'insieme di tutti i percorsi diversi che possono essere seguiti dal commesso viaggiatore) è esponenziale, mentre la verifica del fatto che una data soluzione soddisfi la proprietà richiesta (cioè che una data assegnazione di valori di verità soddisfi la formula o che il commesso viaggiatore completi il suo viaggio nel tempo richiesto) può essere effettuata in tempo polinomiale. La classe dei problemi che hanno questa natura è chiamata NP (poiché essa coincide con la classe di problemi risolubili in tempo polinomiale con una macchina non deterministica). Chiaramente la classe NP contiene la classe P, ma allo stadio attuale non è noto se qualche problema in NP sia effettivamente di complessità non polinomiale (e quindi sia P≠NP) o se non sia possibile trovare, per tutti i problemi in NP, algoritmi di costo polinomiale (e quindi sia P=NP).

In particolare, tra i problemi appartenenti alla classe NP si trovano i problemi detti NP-completi, la cui struttura combinatoria è sufficientemente ricca da permettere che ogni altro problema in NP sia Karp-riducibile a essi, in tempo polinomiale. Un problema A è Karp-riducibile in tempo polinomiale a un problema B se per risolvere un caso del problema A è sufficiente effettuare un'unica chiamata alla procedura che risolve un caso del problema B costruito in tempo polinomiale. In base a tale proprietà (dimostrata da S. Cook nel 1971 per il problema della soddisfattibilità di formule booleane e successivamente dimostrata da R.M. Karp per numerosi altri problemi combinatori), se anche per un solo problema NP-completo si individuasse un algoritmo di costo polinomiale, tutti i problemi in NP sarebbero risolubili in tempo polinomiale e risulterebbe P=NP. La gran maggioranza dei problemi noti in NP sono in effetti NP-completi; per es., sono NP-completi tutti i problemi che sono stati citati precedentemente, e nuovi problemi NP-completi si incontrano quotidianamente in ogni campo dell'i., della matematica e di altri settori scientifici (inclusa la biologia: recentemente è stato mostrato, per es., che alcuni problemi relativi alla struttura delle proteine sono NP-completi). La grande rilevanza applicativa dei problemi che risultano NP-completi, oltre alla loro abbondanza, rende il tentativo di scoprire se sia possibile risolvere tali problemi in tempo polinomiale o, al contrario, di dimostrare che la loro complessità è intrinsecamente esponenziale, una delle principali questioni aperte delle scienze dell'informazione. In fig. 1 presentiamo la struttura gerarchica delle principali classi di complessità.

Metodi di calcolo approssimato. - L'elevata complessità di molti problemi di rilevante importanza, e quindi l'impossibilità di disporre di algoritmi efficienti per la loro soluzione, implica che, quando è necessario affrontare in pratica la soluzione di tali problemi, si debba ricorrere a metodi di soluzione approssimati. Ciò, in particolare, si verifica nel caso dei problemi di ottimizzazione combinatoria in cui alle diverse soluzioni di un problema è associato un valore (mediante una corrispondenza chiamata, in genere, funzione obiettivo) e la finalità dell'elaborazione consiste nel determinare, nello spazio finito ma estremamente ampio delle soluzioni possibili, una soluzione (non necessariamente unica) che massimizzi o minimizzi tale valore. Problemi di tale natura vengono detti NP-ardui (o NP-difficili) se per essi può esistere un algoritmo risolutivo polinomiale solo se risulta P=NP. Se un problema di ottimizzazione è NP-arduo, a fronte di un algoritmo che fornisce una soluzione ottima ma richiede tempo esponenziale, è in molti casi possibile realizzare un algoritmo che determina in tempo polinomiale una soluzione non ottima ma il cui valore può essere prossimo al valore della soluzione ottima.

La risoluzione esatta e approssimata dei problemi di ottimizzazione è uno dei temi più importanti, sia dal punto di vista teorico sia da quello applicativo, nell'ambito della teoria degli algoritmi e della complessità computazionale. Chiamiamo algoritmo di approssimazione a qualità garantita un algoritmo eseguibile in tempo polinomiale che risolve in modo approssimato un problema di ottimizzazione NP-arduo, fornendo sempre una soluzione il cui valore può presentare, rispetto all'ottimo, un errore di entità limitata.

Esempio. Si consideri il seguente problema: data una rete stradale con m strade, si deve determinare il minimo numero di vigili urbani da disporre agli incroci in modo che ogni strada abbia un vigile ad almeno una delle due estremità. Sfruttando le tecniche di riduzione viste precedentemente si può dimostrare che questo problema è risolubile in modo ottimo in tempo polinomiale se e solo se risulta P=NP. Ebbene, è possibile mostrare che, se ci si accontenta di una soluzione approssimata che fa uso di un numero di vigili (al più) doppio rispetto al minimo possibile, si può determinare una soluzione in tempo O(m). A tal fine si può procedere nel seguente modo: si seleziona una strada qualsiasi e si assegnano due vigili agli incroci che sono alle sue estremità. Poi si cancellano dalla rete tutte le strade che portano a tali due incroci e si seleziona un'altra strada. Si procede in tal modo finché tutte le strade sono servite. Non è difficile convincersi che il numero di vigili utilizzati non sarà mai più del doppio del numero minimo necessario; infatti, in qualunque soluzione ottima, ognuna delle strade via via prese in considerazione, a cui sono stati assegnati due vigili, dovrà avere comunque un vigile ad almeno una delle estremità.

Vari problemi di ottimizzazione NP-ardui ammettono, come quello visto nell'esempio, soluzioni approssimate di qualità garantita. Tra di essi sono particolarmente interessanti il problema di massimizzare il numero di clausole soddisfattibili in un'espressione booleana in forma normale congiuntiva (approssimabile a 1/8 dall'ottimo), quello di determinare il massimo taglio in un grafo (approssimabile a poco più del 10% dall'ottimo) e infine quello del commesso viaggiatore, nel caso in cui i costi di percorrenza delle strade che collegano le varie città soddisfino la disuguaglianza triangolare (in tal caso si possono ottenere soluzioni che non eccedono mai più del 50% il costo minimo).

Per alcuni problemi di ottimizzazione le condizioni di approssimabilità sono ancora più forti: per essi, qualunque sia il grado di approssimazione che vogliamo raggiungere, esiste un algoritmo di approssimazione che garantisce tale comportamento. È il caso, per es., del problema (noto come problema della bipartizione) consistente nel dividere un'eredità, costituita di tanti oggetti di valore, ciascuno dei quali non scomponibile, tra due fratelli, in modo da minimizzare la differenza di valore ottenuto da essi. Un altro esempio è il problema (noto come problema della bisaccia) consistente, intuitivamente, nel massimizzare il valore degli oggetti che possono essere inseriti in una bisaccia senza eccedere la capacità della bisaccia stessa.

Sfortunatamente non tutti i problemi di ottimizzazione NP-ardui ammettono algoritmi di approssimazione a qualità garantita poiché, per molti problemi, la ricerca di una soluzione di qualità garantita è altrettanto complessa della ricerca di una soluzione ottima. Ciò accade, per es., per il problema della colorazione ottima di grafi (consistente nella ricerca del minimo numero di colori applicabili ai nodi di un grafo con il vincolo che a nodi adiacenti, cioè collegati da un arco, vengano assegnati colori diversi), per il problema della ricerca della massima cricca in un grafo (cioè la ricerca del massimo numero di nodi di un grafo mutuamente congiunti da un arco) e anche per il problema, già citato, della ricerca del percorso ottimo per il commesso viaggiatore, nel caso in cui non ci siano restrizioni sui costi di percorrenza delle strade.

I motivi che rendono alcuni problemi di ottimizzazione NP-ardui approssimabili e altri no sono solo parzialmente compresi, e la ricerca in questo campo delle scienze dell'informazione, avviata dai lavori di D.S. Johnson negli anni Settanta, è molto stimolante. In particolare, solo agli inizi degli anni Novanta, dopo un ventennio di inutili tentativi, alcuni studiosi (soprattutto S. Arora, S. Safra, M. Sudan) sono riusciti a dimostrare i limiti di approssimabilità o l'eventuale non approssimabilità di alcuni problemi. Le tecniche sviluppate per dimostrare la non approssimabilità si basano su una singolare proprietà degli insiemi NP-completi (teorema delle dimostrazioni verificabili in modo probabilistico). Questa proprietà stabilisce che per ogni insieme NP-completo S, se un elemento e appartiene a S, esiste una dimostrazione di questo fatto (codificata in una sequenza binaria) che può essere verificata, in tempo polinomiale, da un algoritmo che ne esamina solo un numero prefissato di bit, scelti a caso.

L'introduzione di elementi di casualità nella realizzazione di algoritmi è un altro importante strumento che consente, in alcuni casi, di ottenere efficientemente la soluzione di un problema complesso a patto di accettare un limitato rischio di errore. Intuitivamente, un algoritmo che sfrutta la casualità (algoritmo probabilistico, o anche, con termine di derivazione anglosassone, algoritmo randomizzato) può essere realizzato prevedendo che, in occasione di particolari scelte, anziché procedere deterministicamente ci si affidi al lancio di una moneta e si proceda opportunamente a seconda che il risultato sia 'testa' o 'croce'. In realtà, per effettuare scelte casuali in un algoritmo probabilistico si ricorre a un generatore di valori casuali (un singolo bit zero o uno, o un valore in un certo intervallo). Uno dei primi algoritmi probabilistici volti alla soluzione di un problema complesso è l'algoritmo proposto da M.O. Rabin nel 1980 per decidere se un dato numero è un numero composto o è un numero primo (test di primalità), un problema per il quale non è, ancora oggi, noto alcun algoritmo polinomiale.

Definiamo certificato di non primalità di un intero n un altro intero m, con 1〈m〈n, dotato di proprietà tali da garantire che n non è un numero primo. Ovviamente un divisore di n è un certificato di non primalità di n ma molti altri numeri minori di n, oltre ai suoi divisori, possono essere certificati di non primalità. Per es., si può dimostrare che se mn⁻¹ - 1 non è un multiplo di n, allora n è composto. La teoria dei numeri consente di dimostrare che esistono opportune definizioni di certificato di non primalità tali che se un numero non è primo allora il numero di certificati della sua non primalità è maggiore di n/2. Consideriamo ora un algoritmo probabilistico che, dato n, genera a caso m (1〈m〈n) e verifica se esso è un certificato della non primalità di n. Una risposta positiva si verifica solo se n è composto; una risposta negativa si può verificare se n è primo oppure se n non è primo, ma noi abbiamo generato un numero che non è un suo certificato. Poiché ciò avviene con probabilità minore di 1/2, se l'algoritmo, in caso di risposta negativa, dichiara comunque che n è primo, la risposta è corretta con probabilità maggiore di 1/2. Ripetendo la verifica con k successivi valori m₁, ..., mk, si può ottenere una probabilità di errore minore di 1/2k. La probabilità di errore può essere dunque resa arbitrariamente piccola, per es. minore di 1/2¹⁰⁰, un risultato che, a tutti i fini pratici, è equivalente alla certezza.

Per analogia con la terminologia adottata per indicare un metodo di integrazione numerica basato su un approccio probabilistico, un algoritmo di questa natura viene chiamato algoritmo Monte Carlo. Un algoritmo di tale tipo può dare una risposta errata, ma con una probabilità di errore limitata; per es., l'algoritmo per il test di primalità può, con un margine di errore che può essere reso piccolo a piacere, dichiarare che un intero è un numero primo anche se non lo è. In questo caso l'errore si può verificare solo se la risposta è affermativa, mentre se la risposta è negativa (il numero non è primo) essa è sicuramente corretta (errore unilaterale). Esistono peraltro algoritmi Monte Carlo che possono errare sia nel caso di risposte affermative sia nel caso di risposte negative (errore bilaterale). Altri problemi per i quali sono stati realizzati algoritmi probabilistici sono i problemi di ricerca di occorrenze di stringhe in un testo, i problemi di conteggio, di taglio minimo su grafi ecc.

L'utilizzazione di algoritmi probabilistici, tuttavia, non è limitata a questo tipo di applicazioni. L'uso della casualità può risultare utile anche per velocizzare algoritmi. In molti casi, infatti, una redistribuzione casuale delle informazioni in ingresso può rendere con elevata probabilità la soluzione più efficiente. Solo occasionalmente l'algoritmo continuerà ad avere un costo di esecuzione elevato. Per questo tipo di algoritmo è stato adottato il nome di algoritmo Las Vegas. Un esempio di algoritmo Las Vegas è la versione probabilistica dell'algoritmo di ordinamento rapido, già citato precedentemente, nella quale la casualità consente di ottenere un bilanciamento dei sottoproblemi che non è invece garantito dalla versione deterministica dell'algoritmo.

Il potere computazionale degli algoritmi probabilistici di vario tipo è tuttora oggetto di studio. Chiaramente gli algoritmi probabilistici non sono più potenti delle macchine di Turing (è sempre possibile simulare un qualunque tipo di algoritmo probabilistico con una macchina di Turing). Ciò che non è stato caratterizzato, e rappresenta una delle grandi sfide intellettuali che impegneranno la ricerca nel campo delle scienze dell'informazione all'inizio del 21° sec., è il potere degli algoritmi probabilistici operanti in tempo polinomiale. Se chiamiamo RP la classe dei problemi di decisione risolubili in tempo polinomiale con un algoritmo probabilistico che può errare (ma con probabilità inferiore a 1/2) solo quando dovrebbe rispondere positivamente, si può facilmente osservare che P⊆RP⊆NP. Finora però non esiste alcuna dimostrazione che il primo contenimento sia stretto, che, cioè, esista qualche problema intrattabile che può essere risolto in tempo polinomiale ammettendo una limitata possibilità di errore. In altre parole non si sa se la casualità possa realmente aiutare nella risoluzione di problemi complessi. Si osservi che, in base a questa definizione e all'algoritmo discusso precedentemente, il problema di verificare se un numero è composto o è primo appartiene a RP.

In pratica, gli algoritmi probabilistici hanno consentito importanti progressi in moltissimi campi dell'i., in particolare nel campo dei protocolli crittografici che, a loro volta, hanno influenzato settori applicativi importanti come il commercio elettronico, l'accesso elettronico ai servizi bancari, l'utilizzazione di servizi a pagamento su rete come la televisione a richiesta (video-on-demand).

Uno dei più interessanti e promettenti casi di applicazione di algoritmi probabilistici in quest'area riguarda i protocolli interattivi, e in particolare le cosiddette dimostrazioni a conoscenza nulla. In questo tipo di protocolli si ipotizza un dialogo tra un dimostratore P (avente a disposizione illimitate risorse computazionali) e un verificatore V (che può effettuare una qualunque elaborazione probabilistica in tempo polinomiale) in merito a una determinata asserzione. Se l'asserzione è vera, P riesce a convincere V di ciò, senza peraltro trasmettergli alcuna conoscenza relativa al metodo di prova; se l'asserzione è falsa, anche barando, P non riuscirebbe a convincere V della correttezza dell'asserzione con probabilità maggiore di 1/2. La nozione di dimostrazioni a conoscenza nulla è stata introdotta da S. Goldwasser, S. Micali e C. Rackoff, intorno alla metà degli anni Ottanta; indipendentemente, nello stesso periodo, L. Babai ha introdotto un analogo tipo di protocolli chiamati giochi tra Artù e Merlino.

Esempio. Consideriamo il problema del non isomorfismo di grafi. Dati due grafi G₁ e G₂ ci si chiede se non esista una permutazione π dei nodi tale che se (e solo se) in Gi esiste un arco (ni, nj), in G₂ esiste un arco (nπ(i), nπ(j)). Il protocollo funziona nel seguente modo:

V sceglie a caso i in {1,2} e una permutazione π;

calcola H=π(Gi);

fornisce H a P e chiede a P un indice j in {1,2} tale che H sia isomorfo a Gj;

P restituisce un indice j;

V accetta che G₁ e G₂ sono non isomorfi se j=i, rifiuta altrimenti.

Vediamo, in modo informale, perché l'algoritmo opera correttamente. Supponiamo che V scelga i=1. Supponiamo poi che i grafi non siano isomorfi. Allora P non può che rispondere con j=1 e quindi V deve necessariamente accettare, nel 100% dei casi. Supponiamo, invece, che i grafi siano isomorfi. In tal caso non c'è alcuna possibilità che P risponda 1 con probabilità maggiore del 50%. Ripetendo eventualmente il protocollo si può ottenere che il margine di errore scenda dal 50% a un valore arbitrariamente piccolo.

I protocolli interattivi e gli algoritmi probabilistici che ne sono alla base hanno avuto un ruolo molto importante nell'ambito delle scienze dell'informazione per quanto attiene il problema teorico della caratterizzazione di classi di complessità: per es., abbiamo già visto che la classe NP può essere caratterizzata mediante un tipo particolarmente semplice di protocollo interattivo, le dimostrazioni verificabili in modo probabilistico, e un risultato analogo, con un opportuno protocollo, vale per la classe PSPAZIO. Inoltre essi sono stati decisivi anche da un punto di vista pratico nello sviluppo delle moderne tecniche crittografiche.

Teoria dei programmi e dei processi di calcolo

La soluzione di problemi mediante elaboratore richiede come prima condizione che i programmi utilizzati effettuino correttamente le operazioni per le quali sono stati progettati. Nonostante siano trascorsi più di quarant'anni dall'invenzione dei primi linguaggi di programmazione ad alto livello (v. linguaggi programmativi, App. V), e nonostante i grandi progressi compiuti con la diffusione di metodologie di progetto e sviluppo di programmi, il problema della correttezza funzionale del software rimane un problema aperto. Mentre gli elaboratori si diffondono in tutti i settori, e in particolare in ambito industriale e commerciale, nella generalità dei casi la rilevazione di errori avviene ancora con metodi di verifica empirici, consistenti nel provare il comportamento del programma su particolari sequenze di dati di ingresso; a volte, gli errori presenti vengono individuati solo a seguito dei malfunzionamenti da essi determinati. Ciò, in parte, è dovuto a limitazioni intrinseche evidenziate dalla teoria delle calcolabilità e consistenti nella indecidibilità di molti problemi di verifica delle proprietà di programmi (per es., la terminazione). Tuttavia, questa situazione è anche dovuta al fatto che non sono stati ancora adottati su larga scala i metodi formali di verifica applicabili ai casi decidibili. Infatti, mentre dal punto di vista sintattico i linguaggi di programmazione sono accompagnati, in genere, da una definizione formale che ne consente un uso corretto, dal punto di vista semantico, cioè del significato delle istruzioni, essi sono accompagnati da una descrizione informale, incompleta, a volte inconsistente e, spesso, dipendente dal compilatore utilizzato.

Il problema di definire una precisa semantica di un linguaggio e di garantire la correttezza di funzionamento del software è divenuto ancora più complesso da quando si è affermato l'uso di applicazioni distribuite, da quando cioè, anziché risiedere su un unico elaboratore, le applicazioni hanno cominciato a essere localizzate su più elaboratori, dislocati nei vari reparti di un'azienda o di un ufficio e collegati in 'rete locale'. Più recentemente, per alcune applicazioni in ambito Internet, si è addirittura rinunciato alla località dei programmi a favore dell'uso di codice mobile tra elaboratori dislocati a centinaia o migliaia di chilometri l'uno dall'altro e collegati in reti globali. Uno scenario applicativo che sarà sempre più diffuso nei futuri anni vedrà la realizzazione di compiti (telelavoro, teledidattica, commercio elettronico) da parte di programmi mobili (agenti) che potranno interagire in vario modo con altri agenti mossi da intenti cooperativi od ostili (v. oltre: Le tecnologie per i sistemi distribuiti).

Nell'area che abbiamo denominato teoria della programmazione e dei processi di calcolo esistono vari approcci allo studio del comportamento dei programmi e delle loro possibili interazioni. Tali approcci sono basati sulla definizione formale del comportamento dei programmi mediante modelli astratti e hanno diverse finalità: dotare i linguaggi di programmazione di vario tipo (sequenziali, paralleli, concorrenti) di una semantica formale definita in modo altrettanto rigoroso di quanto è definita la sintassi; consentire prove formali di correttezza dei programmi rispetto alla specifica fornita dall'utente; definire e studiare nuovi concetti e paradigmi di programmazione che agevolino la produzione di software corretto e affidabile. Per questi ultimi aspetti, gli studi nel campo della teoria della programmazione hanno un ruolo significativo nei confronti delle aree più applicative dei linguaggi, delle metodologie e degli ambienti di programmazione che formano la cosiddetta ingegneria del software.

Semantica operazionale. - Un primo approccio allo studio del comportamento di un programma consiste nella definizione di un modello di calcolo astratto (macchina astratta) e nella rappresentazione dei passi di calcolo del programma in tale modello (semantica operazionale). In tal modo è possibile prescindere da quegli aspetti di comportamento che dipendono dalle caratteristiche tecnologiche della macchina utilizzata e concentrarsi, in prima istanza, sugli aspetti del comportamento legati al linguaggio di programmazione. Gli aspetti tecnologici (per es., lunghezza massima delle costanti numeriche prevista dalla dimensione della memoria) potranno poi essere reintrodotti come parametri della semantica formale.

In un approccio molto utilizzato, basato su un punto di vista sintattico, il modello è costituito da tutte le espressioni (termini) costruibili con i simboli di funzione e i simboli di variabile disponibili nel linguaggio. In logica, l'insieme dei termini viene chiamato universo di Herbrand. Formalmente ogni simbolo di variabile x₁,...,xn è un termine e, per ogni simbolo di funzione fi , con mi argomenti, se t₁,...,tmi sono termini, anche l'espressione fi (t₁,..., tmi) è un termine. In particolare, i simboli di funzione con zero argomenti sono chiamati costanti. Per es., se f è una funzione unaria, x è una variabile e O una costante, avremo che i possibili termini sono la costante O, la variabile x e la funzione f applicata a un termine. In tal caso l'universo di Herbrand è costituito dall'insieme: {O, x, f(O), f(x), f(f(O)), f(f(x)),...}. I passi di calcolo corrispondenti alle varie istruzioni del linguaggio sono descritti mediante regole di sostituzione (riscrittura) di termini con altri termini. Per es., le seguenti due regole di riscrittura definiscono il comportamento del costrutto if-then-else:

if true then T₁ else T₂→T₁

if false then T₁ else T₂→T₂

La loro applicazione determina la sostituzione del termine al lato sinistro della freccia con quello al lato destro, indipendentemente dai termini T₁ e T₂. L'esecuzione delle istruzioni di un programma (computazione) corrisponde a una serie di passi di riscrittura che si conclude quando si giunge a un termine che non ammette più sostituzioni (interpretabile come un valore costante nel dominio dei dati: un intero, un valore booleano ecc.), o può non concludersi, se si entra in una serie ciclica di sostituzioni.

Una classica applicazione di questo approccio è volta allo studio dei meccanismi di chiamata di funzione e di esecuzione della ricursione nei linguaggi di programmazione. A seconda delle regole adottate per gestire la valutazione di funzioni (per es., regole di sostituzione che partono dall'interno di un termine o regole di sostituzione che partono dall'esterno) si possono avere, infatti, risultati diversi. Per determinati argomenti, una funzione può essere definita se valutata secondo alcune regole, e non definita se valutata secondo altre.

Semantica denotazionale. - Un inconveniente delle semantiche operazionali è il fatto che esse dipendono dal modello di macchina astratta utilizzato. Un approccio che si prefigge di caratterizzare il comportamento di un programma definendo invece direttamente in termini matematici la funzione che esso calcola nel dominio dei dati, a partire dalla struttura sintattica del programma stesso, è l'approccio chiamato semantica denotazionale (inizialmente chiamato semantica matematica), introdotto da D. Scott e C. Strachey nel 1971.

Nella semantica denotazionale ogni struttura sintattica composta di un programma viene associata a un oggetto matematico, chiamato denotazione (per es., la funzione che quella particolare struttura definisce), che deriva esclusivamente dalle denotazioni delle sottostrutture componenti (proprietà di composizionalità). A strutture elementari corrispondono oggetti matematici primitivi (funzioni base). La funzione definita da un programma viene così individuata con un meccanismo di induzione strutturale. Una delle caratteristiche dell'approccio denotazionale è l'uso del concetto di punto fisso. Come domini dei dati si assumono, anziché insiemi, insiemi parzialmente ordinati completi e, potendosi interpretare i programmi di un linguaggio di programmazione come funzionali continui su tali insiemi, è possibile garantire l'applicabilità del teorema del punto fisso di Knaster-Tarski e individuare le funzioni calcolate da programmi ricorsivi come i punti fissi associati a tali programmi.

L'approccio denotazionale ha il pregio di una notevole eleganza formale ed è particolarmente interessante la sua equivalenza con alcuni degli approcci percezionali citati precedentemente. Inoltre, esso è uno strumento didattico fondamentale nello studio della semantica dei linguaggi di programmazione. Tra coloro che hanno maggiormente contribuito allo sviluppo di questo approccio, nelle sue varie forme, citiamo J. de Bakker, D. Bjœrner, B. Courcelle, M. Gordon, P.D. Mosses, G.D. Plotkin. Esso è stato utilizzato per definire la semantica di importanti linguaggi imperativi (Pascal), funzionali (ML) e concorrenti (Ada).

Semantica algebrica. - Un approccio alla semantica particolarmente adatto a esprimere le proprietà formali dei dati, e che ha avuto un notevole ruolo nell'evoluzione delle metodologie e dei linguaggi di programmazione, è quello denominato semantica algebrica. Esso è sostanzialmente basato sul concetto di tipo astratto di dato. I dati, anziché essere insiemi (come nei linguaggi di programmazione usuali) o insiemi parzialmente ordinati (come nella semantica denotazionale), sono strutture algebriche, cioè insiemi di oggetti dotati di operazioni; in generale si tratta di algebre a più sorti.

Si definisce segnatura Σ una coppia Σ=〈S,F> dove S è un insieme di nomi di insiemi s₁,…,sn (detti sorti di Σ) e F è un insieme di simboli di funzione f₁,…,fm (detti operazioni di Σ) dotati di tipo (corrispondenza tra i simboli in F e l'insieme di stringhe S*→S). Un simbolo di funzione per cui vale tipo(f)=ε→s è detto costante di tipo s. Data una segnatura S, una Σ-algebra è un'interpretazione della segnatura, consiste cioè di una famiglia di insiemi non vuoti As₁,…,Asn (in corrispondenza delle sorti s₁,…,sn di Σ) e una famiglia di funzioni (in corrispondenza delle operazioni f₁,…,fm di Σ).

Esempio. Sia data la segnatura ΣNAT le cui sorti sono: {nat,bool}, le operazioni sono {zero,succ,eq} e il loro tipo è:

zero:→nat; succ:nat→nat; eq:nat,nat→bool.

Associando a nat l'insieme dei naturali e a bool l'insieme {vero, falso} e interpretando le operazioni zero (come la costante 0), succ (come il successore di un naturale), ed eq (come la relazione di uguaglianza tra due interi), si vede che i numeri naturali sono una ΣNAT-algebra.

Il fatto di considerare i dati non come semplici insiemi di valori ma come strutture algebriche ha rappresentato un'importante innovazione nelle teorie e nelle metodologie della programmazione. L'idea, ispirata dal concetto di classe introdotto nel 1970 da O.J. Dahl e K. Nygaard nel linguaggio di programmazione SIMULA (e ripreso in seguito nell'ambito dei linguaggi a oggetti), è stata sviluppata e formalizzata a metà degli anni Settanta per opera di J.V. Guttag, B. Liskov, S.N. Zilles e del gruppo di ricercatori costituito da J.A. Goguen, J.W. Thatcher, E.G. Wagner, J.B. Wright (denominato gruppo ADJ). Essa ha dato luogo, da un lato, allo sviluppo dell'approccio algebrico alla semantica, dall'altro alle metodologie di specifica algebrica del software, basate sul concetto di tipo astratto di dato.

Per definire un tipo astratto di dato è necessario individuare le sorti e le operazioni che lo caratterizzano (cioè la segnatura), nonché le proprietà delle operazioni. Tali proprietà, generalmente espresse in forma di equazioni, caratterizzano la struttura in modo astratto, cioè indipendente dall'implementazione. Perché la struttura sia realizzata correttamente sarà sufficiente che le proprietà fornite nella specifica siano garantite.

Tornando a considerare l'esempio precedente, la specifica dovrà prevedere che l'operazione eq soddisfi le seguenti proprietà:

eq(zero,zero)=vero; eq(x,y)=eq(y,x); eq(zero,succ(x))=

=falso; eq(succ(x),succ(y))=eq(x,y).

Una specifica algebrica consiste in un insieme di tipi astratti di dati, la cui gestione può avvenire solo tramite le operazioni previste nella specifica, in modo che tutti gli aspetti realizzativi siano schermati all'esterno: una concezione modulare non dissimile da quella che caratterizza i moderni linguaggi a oggetti (la cui definizione è stata, in effetti, ampiamente influenzata dalle metodologie di specifica algebrica del software).

La semantica formale dei tipi astratti di dati è formulata mediante il concetto di classe di omomorfismi tra le Σ-algebre che soddisfano le proprietà delle operazioni.

Formalmente, se X è un insieme di nomi di variabili e Σ=〈S,F> è una segnatura, definiamo T(Σ,X) l'insieme dei termini costruiti con le variabili in X e le funzioni in F. Si noti che 〈T(S,X),F> è una Σ-algebra. T(Σ)=T(Σ,∅) è chiamata algebra dei termini di base. Consideriamo l'insieme E di equazioni del tipo t=t′ dove t e t′ sono termini in T(Σ,X). Sia Alg(Σ,E) la famiglia delle Σ-algebre che soddisfano le equazioni in E. Se ≡E è la relazione di equivalenza tra termini indotta dalle equazioni di E e T(Σ)/≡E la partizione in classi indotta su T(Σ) dalla relazione ≡E, definiamo tipo astratto di dato la famiglia di tutte le Σ-algebre isomorfe con T(Σ)/≡E. Si noti che anche 〈T(Σ)/≡E,F> è una Σ-algebra; essa è tale che per ogni algebra A in Alg(Σ,E) esiste un unico omomorfismo 〈T(Σ)/≡E,F> in A. Poiché un'algebra siffatta viene detta iniziale, la semantica dei tipi astratti di dati che abbiamo testé definito viene detta semantica iniziale.

La semantica algebrica e i metodi di specifica algebrica del software hanno avuto negli ultimi anni un notevole sviluppo che ha riguardato vari aspetti (tuttora oggetto di studio) necessari per rendere l'approccio più potente (per es., prevedendo che la specifica utilizzi formule più generali delle equazioni), in grado di esprimere aspetti di programmazione più generali (come la concorrenza), adatto alla specifica formale di sistemi informatici di grandi dimensioni (introducendo meccanismi di specifica gerarchica) e in grado di esprimere la riusabilità del software (mediante il concetto di specifica parametrica). Dal punto di vista dell'evoluzione dei linguaggi di programmazione, oltre al già citato ruolo che il concetto di tipo astratto di dato e altri aspetti di semantica algebrica (polimorfismo, overloading degli operatori ecc.) hanno avuto sullo sviluppo dei linguaggi orientati a oggetti, va segnalato l'impatto dell'approccio algebrico sui linguaggi di specifica. Vari linguaggi di specifica sono stati definiti utilizzando concetti e strutture sviluppati nell'ambito degli studi sulla specifica algebrica del software (CLEAR, OBJ, ACT ONE, ACT TWO, ASL ecc.), e in altri linguaggi, come ML, sono stati aggiunti meccanismi di tipo algebrico per la specifica di tipi di dati e programmi.

Logiche della programmazione e dimostrazione di correttezza. - L'approccio logico allo studio del comportamento dei programmi (v. logica e informatica, App. V) è basato sul principio che un programma sequenziale contenga tutte le informazioni necessarie per determinare il suo comportamento e, pertanto, è possibile definire un sistema deduttivo che consenta di derivare in modo formale, partendo dalla struttura del programma, asserzioni riguardanti le sue proprietà (per es., la terminazione) nonché le proprietà del suo comportamento rispetto allo stato (valore di un insieme di variabili) che esso modifica durante l'esecuzione.

L'esigenza di dimostrare formalmente la correttezza di un programma non era sfuggita a due precursori delle scienze dell'informazione come A.M. Turing e J. von Neumann; tuttavia, solo nella seconda metà degli anni Sessanta sono state proposte adeguate metodologie per opera di R.W. Floyd, P. Naur e, in particolare, di C.A.R. Hoare, che hanno contribuito a porre le basi teoriche dell'i. e a determinare importanti evoluzioni dei linguaggi di programmazione (programmazione strutturata). Nel sistema formale proposto da Hoare (logica di Hoare o semantica assiomatica) viene data particolare enfasi all'analisi della correttezza di un programma rispetto alla specifica delle proprietà che le variabili devono verificare prima e dopo l'esecuzione del programma stesso. Tale logica può essere quindi utilizzata sia come sistema per la verifica a posteriori della correttezza di un programma, sia come metodo di specifica e sviluppo di un programma corretto. Una classica asserzione di correttezza parziale della logica di Hoare si presenta nel seguente modo:

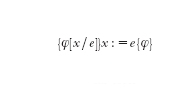

(se prima dell'esecuzione del programma p le variabili soddisfano la proprietà φ, dopo l'esecuzione, se essa termina, esse soddisfano la proprietà ψ). I predicati φ e ψ si chiamano precondizione e postcondizione. Gli assiomi della teoria definiscono il comportamento delle istruzioni elementari di un programma. Per es., l'assioma:

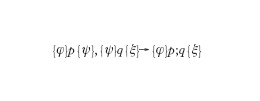

afferma che se prima dell'esecuzione dell'assegnazione vale la proprietà φ in cui ogni occorrenza di x è sostituita dal termine e, dopo l'assegnazione vale la proprietà φ. Nel corso di una dimostrazione di correttezza si propagano le precondizioni e le postcondizioni lungo il programma, sfruttando le regole di inferenza che specificano il comportamento dei costrutti del linguaggio (per es., la regola:

specifica che se per le istruzioni p e q valgono le condizioni φ, ψ, e, rispettivamente, ψ, ξ, per la composizione sequenziale delle due istruzioni valgono le condizioni φ e ξ). In conclusione, se la dimostrazione ha successo, si verificherà che le condizioni sono soddisfatte dall'intero programma.

L'approccio assiomatico alla semantica dei programmi ha portato allo sviluppo di una serie di sistemi formali (logiche della programmazione), per lo più estensioni modali di logiche del prim'ordine. Esempi di tali logiche sono la logica dinamica (Pratt 1976), la logica algoritmica (Salwicki 1977), il calcolo situazionale (Z. Manna, R. Waldinger, 1981), il μ-calcolo (Kozen 1982).

In questi sistemi il linguaggio del prim'ordine viene arricchito introducendo istruzioni e costrutti di un linguaggio di programmazione (per es., composizione sequenziale, iterazione, alternativa in base al valore di verità di un predicato) e uno o più operatori modali che esprimono relazioni tra asserzioni sullo stato del sistema ed esecuzione di programmi. La necessità di utilizzare operatori modali è legata al fatto che mentre nella logica classica si formulano asserzioni in merito a una realtà statica, nel caso delle logiche della programmazione si studia una realtà che evolve dinamicamente durante l'esecuzione di un programma. Una tipica formula modale di questa natura è la seguente:

che appartiene alla logica dinamica ed esprime il fatto che se l'esecuzione del programma p termina, ci si trova in uno stato che soddisfa la proprietà φ. Gli assiomi e le regole di inferenza delle teorie logiche della programmazione contengono, oltre agli assiomi e alle regole di inferenza logiche del prim'ordine, assiomi e regole che stabiliscono relazioni tra programmi e proprietà dello stato. Un tipico esempio, in tal senso, è l'assioma che descrive le proprietà della composizione sequenziale (anch'esso appartenente alla logica dinamica)

Dopo i risultati teorici sviluppati negli anni Settanta e Ottanta, gli anni Novanta hanno visto le prime concrete applicazioni dei metodi formali, basati sugli studi di semantica e logica della programmazione, a casi reali di dimensioni medio-grandi (per es., verifiche di correttezza di microprogrammi per operazioni aritmetiche in processori commerciali). Ciò è avvenuto grazie alla realizzazione di strumenti in grado di effettuare in modo automatico (o semiautomatico) verifiche di correttezza e all'utilizzazione di metodi ibridi capaci di sfruttare le caratteristiche migliori dei diversi sistemi formali.

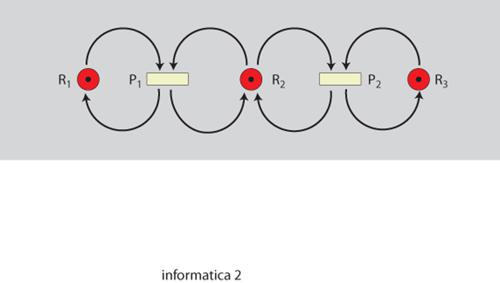

Semantica di processi concorrenti. - In un reale sistema informatico, l'elaborazione delle informazioni non dà necessariamente luogo a una computazione sequenziale come nei modelli teorici (macchina di Turing, RAM ecc.); al contrario, per vari motivi, nel sistema sono generalmente attive più computazioni (processi). Ciò avviene in diverse circostanze: nei sistemi paralleli o distribuiti, basati cioè su una pluralità di unità di elaborazione (processori) più o meno strettamente interconnesse, che cooperano, comunicando mediante messaggi o mediante unità di memoria condivise, nella risoluzione di un particolare problema o nei sistemi transazionali (casse automatiche, sistemi di prenotazione, sistemi archiviali ecc.), in cui una pluralità di utenti, collegati in rete, accede a una base informativa interrogandola ed eseguendo operazioni che ne modificano il contenuto. Anche nei sistemi monoprocessore e monoutente, la semplice presenza del sistema operativo che interagisce con l'utente per gestire le risorse del sistema dà luogo all'attività simultanea di più processi. Sistemi nei quali siano contemporaneamente presenti più processi vengono detti sistemi concorrenti.

In un sistema concorrente i processi possono interagire tra di loro in modo cooperativo, per il raggiungimento di un obiettivo comune, ma possono anche interagire in modo competitivo contendendosi l'uso delle risorse del sistema e determinando, in caso di errato coordinamento, un'evoluzione scorretta delle singole attività.

Alcuni classici esempi di concorrenza, legati alla necessità di far accedere più processi a risorse condivise, si sono presentati fin dal momento della progettazione dei primi sistemi operativi multiutente. Essi sono stati formulati e analizzati da E. Dijkstra alla fine degli anni Sessanta e pongono tuttora problemi di interesse basilare:

1) aggiornamento del valore di una variabile. Se più processi accedono a una variabile condivisa (si pensi, per es., al saldo di un conto corrente bancario) per leggerne il valore ed eventualmente modificarlo, per garantire la correttezza del sistema è necessario che ogni processo mantenga il controllo della variabile fino a che non ha ultimato l'aggiornamento; è necessario, cioè, che si realizzi la cosiddetta mutua esclusione;

2) condivisione di risorse. Quando più processi necessitano di varie risorse (per es., diverse unità periferiche) per completare il loro compito, si possono verificare situazioni di stallo (nessuno dei processi è in condizione di evolvere perché essi sono reciprocamente in attesa del rilascio di risorse da parte degli altri processi) o di privazione (alcuni processi evolvono ma altri sono permanentemente impossibilitati a procedere), e si devono quindi instaurare opportune politiche di gestione delle risorse stesse che evitino tali inconvenienti;