Chimica

Chimica

La chimica nella società contemporanea,

di Luciano Caglioti

SOMMARIO: 1 Introduzione. 2. Un po' di storia. 3. La chimica come punto di forza dell'economia: qualche cifra. 4. La chimica e l'alimentazione: a) l'uso di fertilizzanti e pesticidi in agricoltura; b) trasformazione, conservazione e trasporto dei cibi. 5. La chimica e la salute dell'uomo. 6. I nuovi materiali. 7. Chimica, energia e ambiente: a) chimica ed energia; b) chimica e ambiente. 8. L'informazione. 9. La ricerca. □ Bibliografia.

1. Introduzione

La scienza costituisce il naturale prolungamento dell'evoluzione culturale dell'uomo. Essa è alla base dello sviluppo economico-sociale, e al tempo stesso della cultura nel suo senso più lato. Nella scienza la chimica assume un ruolo centrale, essendo, come essa è, trasversale alle altre discipline, ed essendo, al tempo stesso, il canale di trasmissione attraverso il quale il progresso scientifico-tecnologico arriva all'uomo: chimica, infatti, sono gli alimenti, i medicamenti, i mezzi di trasporto, i delicatissimi chips dei sempre più sofisticati calcolatori, chimica sono le fotografie, i detersivi che usiamo, le fibre che indossiamo, le colle, le vernici, le lampade, le gomme.

Fondamentale è anche il ruolo che la chimica ha per la cultura dell'uomo. Chiunque, oggi, si ponga la stessa domanda - chi siamo noi - che si poneva Plotino, non può prescindere dalla conoscenza dei dati essenziali della chimica e della biochimica. Elementi fondamentali sono a nostra disposizione. È ormai saldamente acquisito il concetto della sostanziale unità del mondo biologico, in un contesto di molecole e di meccanismi ben inquadrabili nel quadro generale intuito da Darwin, e ora completo, a volte fin nei dettagli.

La teoria dell'evoluzione, contestatissima dal mondo religioso e da una parte del mondo scientifico, poggia adesso su inoppugnabili verifiche biochimiche. La teoria dell'informazione, unita alla termodinamica dei sistemi aperti, ci dà conto di come, in zone limitate, l'ordine possa scaturire dal caos, di come cioè la vita possa essere intesa come un fenomeno pienamente in accordo con le leggi fisiche: non vi è più bisogno di invocare la vis vitalis per spiegare il chimismo degli organismi, come coraggiosamente - per il suo tempo - intuì F. Wöhler. La sinergetica e la sociobiologia agitano inquietanti problematiche sul comportamento animale e umano, mentre le conoscenze via via più approfondite sul ruolo delle endorfine pongono interrogativi affascinanti e supremi sull'effettiva indipendenza del nostro atteggiamento da droghe esogene ed endogene.

Scrive infatti Sicuteri (v., 1983): ‟Il senso del benessere, di leggerezza del proprio corpo, lo spunto conciliante, la tolleranza verso l'ambiente, in sintesi l'atteggiamento psichico ottimistico e di benessere, sono gli effetti osservati nell'uomo dopo la somministrazione parenterale o intraspinale o intracerebroventricolare degli oppioidi endogeni". Stante il fatto che le endorfine sono sostanze normalmente presenti nel nostro organismo, il nostro ‛atteggiamento psichico' potrebbe, in parte più o meno grande, dipendere da contingenti fattori biochimici.

Se, pertanto, l'apporto della chimica alla cultura è ampio, importante e insostituibile, altrettanto dobbiamo dire per l'influenza che la chimica esercita, attraverso le tecnologie a essa legate, sulla società.

Può valere la pena di ricostruire in chiave storica alcune tappe dello sviluppo dell'uomo, per poterci meglio rendere conto dei motivi di fondo che sono alla base dell'attuale stato delle cose, e quindi per meglio comprendere quanto, di ciò che la chimica mette a nostra disposizione sia necessario e quanto invece superfluo, quanto dobbiamo a essa e a quali rischi essa ci espone, quali misure infine possiamo prendere per aumentare il rapporto fra i benefici e le controindicazioni.

2. Un po' di storia

Nei due grafici qui riportati Ricossa (v., 1984) ci fornisce informazioni fondamentali per comprendere la storia dell'umanità. Il primo grafico (v. fig. 1) riguarda la crescita della popolazione mondiale. E un po' il ‛senso' della storia dell'uomo. La popolazione oscilla, per qualche decina di millenni, fra due e dieci milioni. Alla fine del Neolitico ha inizio la rivoluzione agricola, e con essa si verifica un primo salto quantitativo: si passa da dieci a cento milioni, segno che la relativa abbondanza di alimenti ‛prodotti' (e non più faticosamente reperiti attraverso caccia, pesca e raccolta di vegetali) permetteva la sopravvivenza di una popolazione maggiore.

L'aumento della popolazione continuava con qualche oscillazione (in corrispondenza delle grandi epidemie, ad esempio, si registra un lieve regresso) fino alla rivoluzione industriale. In corrispondenza di questo punto, situato subito dopo il 1750, si verifica un salto drammatico che in circa due secoli ha portato la popolazione ai livelli attuali. In altre parole, tutto quel complesso di fenomeni e di avvenimenti che hanno caratterizzato, sul piano dell'industrializzazione, l'era moderna si è risolto in un'enorme facilitazione della vita umana, in termini di maggiore salute, aumento della vita media, minore mortalità infantile, ecc.

Il secondo grafico (v. fig. 2) ci informa di un altro fenomeno. Non solo la popolazione, in corrispondenza della rivoluzione industriale, è aumentata, ma si è anche ‛spostata', si è trasferita in città. La percentuale della popolazione urbana è infatti passata dal 18% del 1790 all'80% degli anni immediatamente precedenti il 2000. È questo il punto chiave che dobbiamo tenere ben presente nella nostra riflessione sull'importanza della tecnologia in genere, e della chimica in particolare, nello sviluppo della società moderna.

Una sola considerazione, fra tutte. Se l'uomo abbandona, in una percentuale che arriva all'80%, le campagne, ciò significa che meno persone coltivano i campi, o meglio che un numero basso di persone deve produrre il cibo per un numero alto di consumatori (se stessi e coloro che stanno in città). Ciò significa, ancora, che rispetto all'agricoltura patriarcale (nella quale il 95% della popolazione coltiva i campi) l'agricoltura moderna deve ‛produrre di più' per unità di coltivatore. Il caso limite è costituito dagli Stati Uniti, nei quali il 4-5% di lavoratori agricoli sopperisce ai bisogni dell'altro 95% e di un'altissima percentuale dell'esportazione mondiale di cereali, soia, ecc. Ciò significa, infine, che l'agricoltura moderna deve industrializzarsi, cioè usare fertilizzanti, pesticidi, ecc.

L'urbanizzazione dell'uomo è un fatto di dimensioni bibliche, certamente irreversibile. Piaccia o non piaccia, è così, malgrado gli sforzi di tutti i propagandisti della vita agreste che, in genere saldamente arroccati nel ceto medio urbano, non coincidono con coloro (gli altri) che dovrebbero vivere in campagna per trovarsi alle quattro del mattino dietro due buoi, anche con un tempo cattivo, ad arare un campo per guadagnarsi l'incerto reddito dell'agricoltura patriarcale.

È cambiato tutto: il modo di vivere, di vestirsi, di curarsi, di mangiare, i materiali che usiamo. Non vi è molto di concettualmente nuovo in questo: da sempre l'uomo ha usato materiali artificiali. Se si eccettuano la pietra, il legno, il cotone, la lana, qualche medicamento naturale, ciò che l'uomo usa da sempre è qualcosa di chimico, ottenuto attraverso procedimenti chimici. Il ferro, il bronzo, vocaboli che ci riportano ai primordi della nostra storia, provengono dalla chimica, così come oggi ne provengono i polimeri, le fibre sintetiche, le colle, l'infinita gamma di possibilità delle quali, quasi senza rendercene conto, usufruiamo.

Tutto questo si ottiene attraverso cultura tecnologica e materie prime. La rivoluzione industriale significò, all'inizio, carbone, macchine termiche, cotone. Dopo di allora il problema è stato, più che mai, quello di procurarsi materie prime, al miglior mercato possibile. Se le prime conquiste coloniali dell'Europa in espansione significarono spezie e oro, dopo il 1800 si verificò una caccia ai materiali più vari: il fosfato del Marocco, i metalli pregiati del Congo e del Sudafrica, lo zucchero, il cotone, via via fino all'attuale dopoguerra fatto di petrolio. In tutto questo la chimica ha avuto un ruolo di primissimo piano, nel bene e talvolta - nel male.

3. La chimica come punto di forza dell'economia: qualche cifra

Un paese moderno vive di tecnologia, di forza lavoro e di materie prime. I paesi più fortunati posseggono tutte e tre queste variabili: gli Stati Uniti, ad esempio, sono autosufficienti per molte delle materie prime più importanti, hanno costruito un'infrastruttura culturale potentissima e possono contare su una forza lavoro interna e di immigrazione. Non altrettanto può dirsi per l'Italia, che non possiede materie prime e ha una cultura tecnologica di medio livello.

L'industria chimica è una tipica industria di trasformazione, in cui le materie prime vengono trasformate in prodotti finiti di valore maggiore. Per ottenere questo risultato occorre ‛sapere': il ‛valore aggiunto' è un preciso derivato della cultura, tanto che si può formulare lo slogan ‟materie prime + cervello = guadagno". Nel linguaggio tecnico ricorrono due espressioni, riferite all'industria chimica: ‛chimica di base' e ‛chimica fine'. Come per tutte le definizioni, anche qui ci troviamo di fronte a un margine di incertezza: non sempre la divisione fra chimica di base e chimica fine è così netta. In generale per ‛chimica di base' si intende quel tipo di produzione rivolta a prodotti che sono alla base di altre produzioni, per esempio l'ammoniaca (che è alla base della produzione dei fertilizzanti), l'acido solforico (anch'esso usato nella produzione dei fertilizzanti e in numerosissimi altri processi), la soda, il cloro, l'etilene (alla base della chimica dei polimeri).

Per ‛chimica fine' si intende, invece, quel complesso di prodotti - e di produzioni - la cui caratteristica principale e ‛l'uso' che se ne può fare: un adesivo che resiste a condizioni estreme (quali, per esempio, quelle dei voli spaziali), una vernice anticorrosiva, un tecnopolimero adatto a essere inserito in una vena, un colorante, un principio attivo per cosmesi, un farmaco. L'esempio più idoneo a rappresentare concretamente quello che si intende per chimica fine, valore aggiunto, cultura tecnologica è la fotografia ad autosviluppo tipo Polaroid. Si scatta, e in una trentina di secondi si vedono comparire le immagini che vanno pian piano fissandosi per poi restare stabili. L'abitudine a queste cose - veri e propri miracoli della tecnologia - non deve farci dimenticare l'immane sforzo culturale che deve essere compiuto per risultati di questo genere.

L'industria chimica statunitense ha realizzato nel 1982 un fatturato di 170 miliardi di dollari, con un utile di 12 miliardi. Si tratta del 9% dell'intera industria manifatturiera statunitense, ed è importante rilevare che nel 1972 la chimica rappresentava il 7,5%. L'industria chimica impiega il 5% del personale dell'industria manifatturiera e l'11% degli addetti alla ricerca e allo sviluppo.

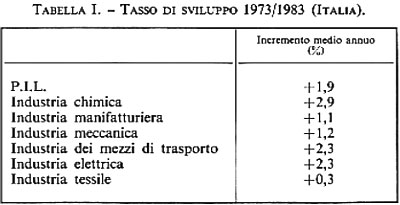

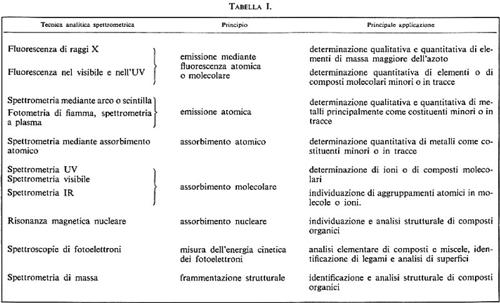

Anche in Italia il tasso di crescita dell'industria chimica è superiore a quello delle altre industrie: fra il 1973 e il 1983 esso è stato del 2,9% annuo, indice medio superiore a quelli dell'industria manifatturiera, meccanica, ecc. (v. tab. I). Se poi vogliamo renderci conto di quanto la chimica contribuisca alla ricchezza che si crea nel nostro paese attraverso il valore aggiunto, la fig. 3 ci rende edotti del fatto che il valore aggiunto dovuto alla chimica, in Italia, è il 7,2% dell'intera industria manifatturiera.

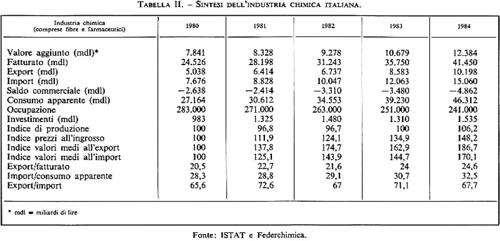

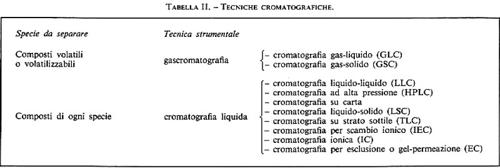

La fig. 3 ci dà inoltre la ripartizione della cifra d'affari nei singoli settori, mentre la tab. II ci dà la sintesi dei principali parametri che hanno caratterizzato la chimica italiana negli ultimi anni. Saltano subito all'occhio alcuni punti importanti: le dimensioni del fatturato, dell'occupazione, e anche il saldo negativo. Occorre dire che il saldo negativo nella chimica è una caratteristica della nostra industria. Per altri paesi (Germania, Francia, Gran Bretagna, Stati Uniti, Svizzera) con i quali siamo in continuo contatto commerciale l'industria chimica presenta da sempre un forte saldo attivo e costituisce pertanto un punto di forza dell'economia. Questa situazione anomala del nostro paese è legata a una serie di vicende aziendali, di scelte sbagliate culminate nella ‛guerra chimica' che i grossi gruppi industriali impegnarono fra loro verso la fine degli anni sessanta - e anche a una scarsa fiducia e uno scarso Impegno nella ricerca. Occorre però dire che a partire dal 1984 si sta verificando una svolta manageriale e imprenditoriale che potrebbe consentire una ripresa positiva.

4. La chimica e l'alimentazione.

La vita dell'uomo urbanizzato è caratterizzata dai grandi consumi. Egli riceve cibi freschi e trasformati dai luoghi di produzione, distanti talvolta migliaia di chilometri; si veste con grande varietà di stoffe e di colori, largamente al di là dello stretto necessario, si cura con numerosi medicinali, usa cosmetici in misura sempre maggiore, viaggia sempre più velocemente, usa automobili personali, mezzi di comunicazione pubblici, costruisce dimore sempre più comode. Potremmo proseguire - calcolatori, macchine fotografiche, elettrodomestici - ma il concetto è chiaro. Dopo l'età della pietra, del ferro, del bronzo, è venuta l'età dei polimeri, dei materiali speciali, dei cibi precotti. Benefici, e anche rischi. È chiaro che una tecnologia così invadente può creare perplessità, diffidenze, timori: non a caso la chimica è stata il principale bersaglio del movimento ecologico in tutto il mondo. Spesso, occorre dire, si è posta maggiore enfasi sui lati negativi che sugli aspetti positivi, ma con il calare delle emozioni e il prevalere dell'approccio razionale il problema del rapporto rischi/benefici si sta inquadrando in un'ottica più rispondente allo stato dei fatti. Qui di seguito riferiremo dettagliatamente sul ruolo di grande rilievo svolto dalla chimica per andare incontro alle esigenze alimentari dell'uomo.

a) L'uso di fertilizzanti e pesticidi in agricoltura

La fame è una vecchia compagna di viaggio dell'uomo, e non è stata certamente debellata. Anzi, la situazione appare drammatica, soprattutto per quei paesi che l'aumento del costo dell'energia ha messo sostanzialmente fuori causa per quanto riguarda la possibilità di sopperire con la produzione interna alle esigenze alimentari di popolazioni sempre crescenti.

L'agricoltura moderna si basa sull'impiego sempre maggiore di fertilizzanti, pesticidi, macchine agricole, energia. In tutti i paesi del mondo la tendenza è quella di industrializzare al massimo l'agricoltura e diminuire il numero degli addetti. Non fa eccezione la Repubblica Popolare Cinese, che pure fino al 1970-1975 costituiva un esempio di modello di sviluppo completamente diverso da quelli occidentale e sovietico. Negli Stati Uniti (ci riferiamo a quanto detto in apertura a proposito della crescente urbanizzazione della popolazione mondiale) gli addetti all'agricoltura e all'allevamento del bestiame sono (1982) il 4% della popolazione, mentre in paesi come l'India e il Pakistan si arriva al 70% circa. In Italia detta percentuale era, nel 1982, del 12,4%.

Si calcola che circa il 30-40% dell'aumento della produttività degli Stati Uniti sia da attribuire all'uso dei fertilizzanti. Tale aumento arriva al 50% per le nazioni in via di sviluppo. Riferendoci ancora al modello di agricoltura statunitense, al quale si ispirano i modelli agricoli europei, ricordiamo che un secolo fa i contadini americani adoperavano 320.000 t/anno di fertilizzanti, 50 anni orsono 7,2 milioni, oggi superano largamente i 40 milioni. Analogo andamento si è avuto in Italia, dove nel 1982 il consumo ha raggiunto i 4,4 milioni di t/anno. Tale consumo è comunque, a parità di superficie coltivata, inferiore a quello degli Stati Uniti e dei paesi della CEE. La fig. 4 riporta l'aumento di resa, in kg/ha, dei cereali e delle leguminose negli anni 1950-1972. La resa dei cereali è aumentata di molto (in seguito alla somministrazione di fertilizzanti azotati), mentre non altrettanto si è verificato per le leguminose. Ciò perché le leguminose provvedono naturalmente al loro fabbisogno di composti azotati mediante il processo di fissazione dell'azoto atmosferico (cioè la trasformazione dell'azoto gassoso in composti utilizzabili dalla pianta) operato da particolari microrganismi che vivono in simbiosi sulle loro radici.

Oltre all'azoto, i vegetali richiedono fosforo, potassio e altri elementi. I fertilizzanti devono essere forniti sotto forma di composti assimilabili, alcuni dei quali sono presenti in natura, mentre altri si ottengono per trasformazioni operate dall'industria chimica. Si trovano in natura i fosfati e i sali di potassio. Le rocce fosfatiche si trovano in quantità tale da assicurare il fabbisogno agricolo per secoli; la loro distribuzione terrestre non è tuttavia omogenea: si trovano nell'Africa nordoccidentale (soprattutto in Marocco, che ne possiede il 50% del totale), negli Stati Uniti e nell'Unione Sovietica, ma anche in Sudafrica, in Sudamerica, in Australia, nel Medio Oriente e in varie isole dell'Oceano Pacifico e dell'Oceano Indiano; scarseggiano nel continente asiatico, la cui sovrappopolazione richiederebbe invece una più abbondante produzione agricola. Anche per i sali di potassio non ci sono timori di esaurimento delle riserve naturali, almeno in tempi medio-brevi. Per l'azoto, invece, essendo assai scarsi i relativi composti naturali utilizzabili dalle piante, è necessaria una massiccia produzione di sintesi a partire dall'azoto atmosferico, che viene trasformato in ammoniaca, nitrati, urea, calciocianammide, ecc. La materia prima azoto è inesauribile, ma l'idrogeno che serve per trasformarla in ammoniaca è praticamente assente in natura e viene fornito dalla petrolchimica (gas naturale e nafta) e dal carbone (attraverso il ‛gas d'acqua'), e il petrolio e il carbone non sono inesauribili.

Bisogna inoltre considerare che le sintesi chimiche richiedono spesso grossi quantitativi di energia e quindi il prossimo esaurirsi di certe fonti energetiche pone problemi anche da questo punto di vista. Già l'aumento del costo del greggio, provocato dalla crisi del petrolio (1973), ha fatto diminuire la produzione agricola; l'effetto si è fatto sentire soprattutto nei paesi - quali l'India e il Bangladesh - in cui erano state introdotte, come strumenti contro la fame, varietà ad alta produttività ottenute dalle pazienti ricerche di N. A. Borlaug, che richiedono però quantità particolarmente elevate di concimi chimici. I paesi a più alto reddito, invece, possono acquistare fertilizzanti in abbondanza e ne utilizzano oggi l'86% della produzione mondiale, mentre la loro popolazione è solo il 39% di quella mondiale; dispongono perciò di una produzione eccedentaria di derrate alimentari di origine vegetale, che destinano in gran parte all'alimentazione del bestiame da carne. È questo un grosso, tragico problema sociale di oggi, che tuttavia non rientra nel campo della chimica. Per quanto riguarda, invece, l'impiego dei concimi chimici, che molti ecologisti vorrebbero eliminare a favore dei concimi naturali (letame), occorre dire che il letame non viene prodotto in quantità sufficiente e inoltre non permette di utilizzare, per ogni tipo di coltura, un concime mirato, cioè contenente il rapporto più adatto fra i principali elementi necessari: azoto, fosforo, potassio. D'altra parte, se non si desse al terreno un congruo apporto dei minerali utilizzati dalle piante, si avrebbe uno sfruttamento eccessivo del terreno stesso, con conseguente drastico abbassamento della fertilità. Non si può negare che i fertilizzanti presentino anche effetti negativi: uno è l'eutrofizzazione delle acque che ricevono, per dilavamento, l'eccesso dei fertilizzanti; l'altro, meno appariscente ma da non trascurare, è l'arricchimento in certi metalli pesanti, presenti come impurezze nei concimi chimici ma estranei ai processi biologici. Gli effetti negativi possono essere minimizzati facendo dei fertilizzanti un uso accorto, il che corrisponde anche a un principio di economia.

Un altro gruppo di composti chimici che ha arrecato enormi vantaggi all'agricoltura ma che presenta, più dei fertilizzanti, problemi di tipo ecologico, con riflessi diretti sulla salute dell'uomo, è quello dei pesticidi. Sotto questo nome (v. pesticidi) si suole indicare un insieme di composti impiegati per la lotta agli organismi, generalmente parassiti, che danneggiano la produzione agricola e zootecnica: prima di tutto insetti, e poi acari, molluschi, vermi, roditori, erbe, ecc. e vari tipi di microrganismi (batteri, virus, muffe).

Tali organismi nocivi (pests) appartengono a numerosissime specie (solo di insetti ne sono state classificate oltre 10.000) e agiscono sulla vegetazione agricola in tutte le fasi del suo sviluppo, sugli animali d'allevamento, sulle derrate alimentari. Il problema è sempre esistito; per la lotta agli insetti - la categoria maggiore di parassiti - si usavano un tempo gli estratti di piretro e di tabacco, poi si sono trovati più efficaci prodotti chimici di sintesi. Il loro capostipite è il DDT (diclorodifeniltricloroetano), le cui proprietà insetticide furono scoperte dal chimico svizzero P. H. Müller nel 1939. Il DDT, usato massicciamente nel dopoguerra soprattutto per la lotta alle zanzare, ha permesso l'eradicazione della malaria in molti paesi (fra cui l'Italia) e una drastica riduzione in molti paesi del Terzo Mondo in cui la malaria era endemica.

Al DDT sono seguiti altri insetticidi dello stesso gruppo chimico (organoclorurati): l'esaclorobenzene (lindano o gammaesano), il clordano, l'aldrin, il dieldrin, l'eptacloro e altri. Oltre a essere molto efficaci, questi composti sono assai stabili: permangono nell'ambiente per mesi o addirittura per anni, in quanto la loro degradazione è molto lenta. Se questo è un vantaggio per la loro azione insetticida, è invece uno svantaggio per l'ambiente, che ne viene contaminato per molto tempo; per di più molti organismi hanno la tendenza ad accumularli e quindi la loro concentrazione cresce man mano che si sale nella catena alimentare, fino all'uomo. I danni a lungo termine riscontrati in alcuni animali da laboratorio, insieme con alcuni ritrovamenti che colpirono l'opinione pubblica (per esempio il suo rinvenimento negli orsi polari e nel latte di donna), provocarono una campagna contro il DDT e contro gli insetticidi in genere. Antesignana di questa campagna fu Rachel Carson, autrice nel 1962 di un libro cui arrise un grande successo: Silent spring. Negli anni settanta l'impiego agricolo del DDT è stato vietato in diversi paesi, fra i quali l'Italia, pur fra opinioni discordi; in effetti il provvedimento fu preso senza considerare molto quali possibili alternative venissero offerte agli agricoltori.

Il bando del DDT coinvolse anche molti altri insetticidi che furono vietati o sottoposti a limitazioni, alcuni perché molto stabili (come gli organoclorurati), altri perché molto tossici, anche se degradati abbastanza rapidamente dall'ambiente: tali sono gli organofosforici (parathion, malathion, ecc.) e i carbammati (carbaryl o Sevin, ecc.).

Accanto ai danni ecologici gli insetticidi sintetici presentano anche l'inconveniente di potere dar luogo a varietà di insetti resistenti: l'azione dell'antiparassitario, infatti, può selezionare quegli insetti che per qualche motivo siano insensibili a esso. I chimici hanno cercato di ovviare all'inconveniente sintetizzando nuovi composti, ma la selezione di individui resistenti, se continuata con più insetticidi e per più anni, può portare a vaste popolazioni di insetti resistenti agli insetticidi chimici: ci troveremmo, in tal caso, davanti a un più grave problema.

Per diverse considerazioni, quindi, a partire dagli anni sessanta venne a formarsi un generale movimento di rifiuto dei prodotti chimici e innanzitutto degli insetticidi; tale movimento, sorto all'interno della ‛società del benessere' e condotto pertanto in un'atmosfera privilegiata, fece rapidamente grossi passi avanti pur in mezzo ad alcune perplessità e anche a opinioni contrarie. La tesi prevalente vedeva questi prodotti chimici soprattutto sotto il profilo del rischio, ma vi era anche chi ne apprezzava i benefici. Fra questi Norman A. Borlaug, premio Nobel per la pace per la sua azione nell'ambito della ‛rivoluzione verde', che in una conferenza tenuta nel 1971, parlando della campagna di stampa contro i pesticidi, diceva: ‟Se l'agricoltura dovesse fare a meno dei mezzi chimici (fertilizzanti e pesticidi) a causa di una legislazione aberrante, auspicata da un potente gruppo di pressione nel quale militano certi maniaci dell'ambiente che terrorizzano il mondo predicendo che morirà avvelenato, allora sì che il mondo perirà, ma di fame". Riferendosi poi al libro della Carson, Borlaug affermava: ‟La campagna odiosa e isterica condotta attualmente da ambientalisti seminatori di panico e irresponsabili contro i prodotti agrochimici trae le sue origini da un bestseller [...]. L'autrice non menziona il DDT come uno dei mezzi per difendere le derrate, o per salvare l'umanità dal paludismo". E inoltre: ‟L'innocuità del DDT si é rivelata veramente rimarchevole. Nel periodo di produzione massima ne sono state utilizzate in agricoltura 400.000 t/anno. Benché centinaia di milioni di uomini siano stati in contatto col prodotto in modo prolungato, e molti per motivi professionali siano stati esposti a esso, i soli casi di danni alla salute dell'uomo sono stati il risultato di incidenti o di ingestione per suicidio. Non esiste alcuna prova che il DDT provochi il cancro o modificazioni genetiche nell'uomo [...]. Quando la campagna di disinfestazione con DDT cominciò a Ceylon, nel 1950, vi erano 2 milioni di casi di malaria. Nel 1962 essi erano scesi a 31, nel 1963 a 17. A quella data, per motivi economici, si sospese la campagna. Nel 1967 vi erano 3.000 casi, nel 1968 16.000. Alla fine del 1969 2.000.000 di casi".

La necessità di conciliare la lotta ai parassiti con la salvaguardia dell'ambiente, e in particolare della salute umana, ha stimolato gli studi chimici e biologici, nonché di tecnica agronomica.

I primi hanno sostanzialmente due obiettivi:

1) preparare altri pesticidi di tipo tradizionale, aventi efficacia possibilmente elevata, ma con controindicazioni più limitate;

2) studiare pesticidi di concezione completamente nuova.

Per quanto concerne il secondo punto, si é cercato di riconoscere e produrre per sintesi alcune sostanze che si comportano come ‛ormoni' degli insetti e presiedono ai fenomeni della crescita, della muta e dell'impupamento delle larve. La somministrazione di queste sostanze in quantità anomala per l'organismo provoca la morte degli insetti. Sempre sul piano delle sostanze chimiche, possono essere sintetizzati e adoperati nella lotta agli insetti alcuni prodotti che agiscono come richiamo sessuale. Si tratta di sostanze relativamente semplici, che gli organismi di un sesso emettono per attrarre gli organismi di sesso opposto. Per mezzo di esse possono essere attivate delle vere e proprie trappole, convogliando in uno spazio limitato gli insetti, attirati dal richiamo dell'altro sesso, per ucciderli con un insetticida convenzionale (v. lotta biologica).

Gli studi biologici seguono le vie della selezione genetica e dell'ingegneria genetica. Si stanno selezionando piante resistenti agli insetti o ad agenti patogeni sia attraverso normali pratiche di ibridazione, sia avvalendosi di tecnologie di ingegneria genetica, ossia immettendo in piante ‛normali' materiale genetico di altre piante che conferisce loro la resistenza a un insetto o a una malattia. Si tratta di ricerche assai promettenti, anche se di non semplice attuabilità su scala generalizzata, che avranno certamente notevole importanza pratica in tempi medi.

Queste nuove vie per la lotta agli insetti e ai microrganismi patogeni presentano il vantaggio di poter agire selettivamente su di essi senza fare uso di sostanze dotate di una nocività generalizzata, con notevoli vantaggi sia sul piano dell'efficacia che sul piano strettamente ecologico.

Accanto ai predetti studi vanno ricordati quelli più propriamente tecnologici riguardanti le modalità di somministrazione: bisogna scegliere accortamente il pesticida (o la miscela) da usare in relazione all'obiettivo specifico che si vuole raggiungere; attenersi alla dose minima efficace e scegliere i tempi più adatti (tali da assicurare una protezione ottimale, senza inquinare il raccolto); talvolta può essere utile ricorrere a tecniche nuove di somministrazione, per esempio l'incapsulamento del pesticida in una membrana porosa che ne regola un lento rilascio, e va invece evitata la somministrazione mediante veicoli aerei, che provoca un'indiscriminata diffusione. È molto importante che siano adeguatamente istruiti gli utilizzatori, non solo per quanto riguarda un corretto impiego, ma anche per quel che concerne le precauzioni da prendere durante la manipolazione, onde salvaguardare la salute dell'operatore stesso.

La legislazione italiana, in continuo aggiornamento parallelamente a quella della CEE, detta norme per la manipolazione e l'impiego dei vari pesticidi e fissa per ognuno di essi le quantità massime che possono essere presenti nelle varie derrate alimentari.

Fra i pesticidi bisogna ricordare anche gli erbicidi. Difendere i raccolti dalle erbe parassite è un problema di sempre, per il contadino. ‟Non seminare zizzania" è una raccomandazione evangelica che deriva, con diverso significato, da una diffusa problematica del momento.

L'impiego degli erbicidi (iniziato nel 1945) ha indubbiamente segnato una svolta in agricoltura e anche nella gestione di pascoli, boschi e parchi. Accanto agli evidenti vantaggi non si possono tuttavia ignorare alcuni svantaggi. Uno riguarda il terreno che, se eccessivamente liberato dall'erba, è più soggetto all'erosione causata dalle acque piovane. L'altro riguarda gli animali e l'uomo, nei confronti dei quali gli erbicidi hanno una certa nocività come tali, soprattutto in seguito a fenomeni di accumulo, ma possono anche essere letali se accompagnati da qualche impurezza molto tossica: quest'ultimo fatto è stato drammaticamente messo in evidenza dalla tragedia di Seveso (10 luglio 1976) determinata dalla cosiddetta diossina (tetraclorodibenzoparadiossina, TCDD), che può essere presente come impurezza in alcuni erbicidi del gruppo dell'acido fenossiacetico.

Roditori e funghi patogeni costituiscono un altro inquietante problema. I topi sono un vero e proprio flagello, e rispondono con sorprendente furbizia ai rimedi che l'uomo riesce a escogitare. Una volta somministrato un veleno, c'è da attendersi che i topi ‛imparino' a evitarlo. Per questo motivo i rimedi più efficaci sono veleni che agiscono molto tempo dopo la somministrazione: ciò rende più difficile per gli animali il collegamento fra la causa e l'effetto. Si adoperano anticoagulanti, derivati della scilla, fluoroacetammide, derivati della stricnina, derivati del tallio, ecc. In ambienti chiusi si adoperano gas tossici come ossido di carbonio, diossido di zolfo, cianuro di idrogeno, ecc. Per quanto concerne i funghi, essi vengono combattuti con agenti tradizionali come la miscela bordolese (a base di solfato di rame e idrossido di calcio) e lo zolfo, o con agenti di più recente ritrovamento, come i derivati dell'acido ditiocarbammico (Zineb, Ziram, ecc.). Altri composti usati sono taluni antibiotici (ad esempio la streptomicina contro la peronospora del tabacco), derivati guanidinici, ecc.

b) Trasformazione, conservazione e trasporto dei cibi

L'uomo urbanizzato riceve gli alimenti necessari al suo sostentamento dai luoghi di produzione lontani chilometri (talvolta migliaia di chilometri). Si tratta di cibi prodotti altrove, che quindi devono essere trasportati e idoneamente conservati. A ciò aggiungasi che l'industria alimentare ha creato prodotti di nuova concezione, adatti alla diminuzione dei tempi disponibili per la cucina e per i servizi domestici e alla necessità di mangiare in intervalli di tempo ristretti.

Cibi in scatola, liofilizzati, surgelati, precotti, avvolti in fogli di plastica sono all'ordine del giorno: è innegabile che l'industria alimentare ha saputo rispondere alle esigenze - belle o brutte che siano - dei tempi moderni. La chimica ha un suo preciso ruolo in questo contesto, sia che si tratti di produrre membrane idonee per l'ultrafiltrazione dei succhi di arancia e di pomodoro o per l'industria lattiero-casearia, sia che si tratti di composti chimici che inibiscono la fermentazione, l'ossidazione, la degradazione in genere dei cibi, o ne ripristinano le caratteristiche organolettiche originali, andate perdute o deteriorate durante la lavorazione. Queste sostanze vanno sotto il nome di ‛additivi alimentari', con cui si indicano secondo la legge italiana (decreto ministeriale del 31.3.1965) ‟quelle sostanze, prive di potere nutritivo o impiegate a scopo non nutritivo, che si aggiungono, in qualsiasi fase della lavorazione, alla massa o alla superficie degli alimenti per conservare nel tempo le caratteristiche chimiche, chimico-fisiche, fisiche, per evitare l'alterazione spontanea, o per impartire a essi, o per esaltare favorevolmente, particolari caratteristiche di aspetto, di sapore, di odore, di consistenza".

A differenza dagli inquinanti, gli additivi sono quindi sostanze chimiche introdotte intenzionalmente negli alimenti per svolgere una precisa funzione.

A seconda di questa, possiamo distinguere tre categorie principali di additivi:

a) conservanti;

b) emulsionanti;

c) addensanti e gelificanti.

Assimilabili agli additivi, anche se regolamentati diversamente, sono i coloranti, gli aromatizzanti e gli edulcoranti.

I conservanti (antimicrobici, antiossidanti, ecc.) preservano gli alimenti dall'azione dei microrganismi e degli agenti ossidanti, che sono le più importanti cause del loro deterioramento. In assenza di sostanze protettive, naturali o sintetiche, si formano nella maggior parte degli alimenti, più o meno rapidamente, sostanze con sapore e odore sgradevoli, talvolta dotate di maggiore o minore tossicità. L'ossidazione è provocata dall'aria ed è spesso catalizzata dalla luce, da tracce di certi metalli (ferro, rame), da enzimi presenti in microrganismi. Essa avviene soprattutto a carico delle sostanze grasse (oli, burro, margarine, ecc.), di cui provoca l'irrancidimento. Esistono antiossidanti e antimicrobici naturali e sintetici (questi ultimi generalmente più efficaci dei primi) che, avendo la proprietà di rallentare o inibire l'alterazione degli alimenti, sono di estrema importanza tecnologica ed economica nell'industria alimentare.

Per quanto riguarda gli emulsionanti, si tratta di sostanze tensioattive che hanno la proprietà di stabilizzare le emulsioni, cioè le fini dispersioni di un olio nell'acqua o dell'acqua in un olio. Possono essere naturali (per esempio le lecitine) o semisintetici (per esempio i sucresteri).

Gli addensanti e gelificanti hanno la proprietà di rigonfiarsi con l'acqua, conferendo all'alimento cui vengono aggiunti una particolare consistenza; sono ampiamente usati per succhi di frutta, creme, budini, marmellate, gelati, formaggi fusi. Possono essere naturali (gomme, pectine, gelatine, ecc.) o semisintetici (carbossimetilcellulosa, polifosfati, ecc.).

Per migliorare il colore o il sapore di certi alimenti si usano numerose sostanze, naturali o sintetiche: abbiamo così i coloranti, gli aromatizzanti, gli edulcoranti. Questi ultimi vengono impiegati per sostituire lo zucchero in alimenti che potrebbero dar luogo a fermentazioni indesiderate o in alimenti dietetici destinati a un'alimentazione particolare, ipocalorica; in questo caso si tratta di sostanze, generalmente sintetiche (per esempio la saccarina), che hanno un forte sapore dolce ma praticamente non forniscono calorie all'organismo.

Sono note le violente polemiche spesso sorte sugli additivi alimentari. Non sempre, soprattutto fino agli anni settanta, si è prestata la necessaria attenzione alle possibili controindicazioni che l'uso degli additivi presentava, per cui talvolta ci si è resi conto dopo anni di impiego della nocività di alcuni prodotti. Da una ventina di anni, tuttavia, le agenzie internazionali e le autorità sanitarie dei vari paesi preposte alla tutela della salute hanno decisamente rivolto la loro attenzione verso questo tipo di problemi, inasprendo le normative da rispettare prima di mettere in commercio prodotti destinati all'alimentazione.

5. La chimica e la salute dell'uomo

L'avanzamento della conoscenza dei meccanismi fondamentali della biologia e della fisiologia e lo sviluppo della chimica analitica e sintetica hanno determinato un grande progresso nella medicina. Malattie che una volta erano molto temute sono state debellate, sono stati identificati i principi attivi come le vitamine e gli ormoni, sono stati chiariti i motivi di alcune malattie da carenza: si può dire che uno dei benefici di cui gode l'uomo moderno è la possibilità di usare determinate medicine.

I punti più qualificanti della produzione farmaceutica sono i sulfamidici, gli antibiotici, l'isoniazide (che ha debellato la tubercolosi), gli ormoni corticosurrenali, alcuni psicofarmaci, gli antistaminici, gli antidiabetici, gli anestetici, i materiali per protesi, i contraccettivi, i vaccini.

Possiamo ricordare brevemente alcuni punti salienti dello sviluppo dei farmaci. Fino al 1920 i medicinali erano soprattutto di origine naturale: estratti di chinino per la malaria, estratti di coca per le anestesie, decotti di erbe. Fra il 1920 e il 1930 si è cominciato a ricorrere alla sintesi e nel 1935 si ebbero i sulfamidici. Fu la prima grande svolta nella cura delle malattie infettive. La seconda fu determinata, all'inizio degli anni quaranta, dalla penicillina, capostipite degli antibiotici prodotti per fermentazione. Nel campo dei principi naturali, il ritrovamento di vitamine (v. vitamine) e ormoni (v. ormoni nei vertebrati) ha costituito un compito arduo per i chimici, sotto il profilo sia delle analisi che della sintesi. La ‛pillola' costituisce il primo approccio razionale al controllo delle nascite. Un salto qualitativo immenso è atteso, per la medicina, dagli sviluppi dell'ingegneria genetica (v. genetica: Applicazioni della genetica; v. biotecnologie, suppl.). Fattori di crescita, fattori del sangue, fattori immunitari, vaccini sintetici: sono questi i principali progressi che si attendono.

Se si considera come un indice di successo l'allungamento della vita media e la diminuzione della mortalità connessa con la malattia, la medicina può vantare la forte diminuzione dei casi di morte per malattie infettive nei paesi tecnologicamente avanzati. Negli Stati Uniti, dove nel 1900 morivano per malattie infettive circa 500 persone l'anno su 100.000, questo numero si è ora abbassato a 50. Anche in Italia la mortalità per malattie infettive è drasticamente diminuita negli ultimi decenni. È stata debellata la sifilide; è stata sconfitta la tubercolosi; la difterite non terrorizza più come un tempo; le infezioni gastrointestinali sono fortemente diminuite e sono in genere curabili (v. morbilità, suppl.).

L'uso delle medicine, dunque, se fatto in modo razionale, può portare all'uomo enormi vantaggi. L'abuso delle medicine è invece una malattia sociale molto seria. La ‛iatrogenesi' (termine con cui si intende l'insorgenza di disturbi a causa dell'uso improprio di medicamenti) provoca negli Stati Uniti dal 3 al 5% dei casi di ricovero. Il 18% dei ricoverati, a sua volta, ha una reazione patologica a un medicamento. Può accadere inoltre che talvolta, malgrado le precauzioni, qualche farmaco venga introdotto in terapia senza che ne siano state accertate fino in fondo le eventuali controindicazioni. Un esempio fra tutti è costituito dal talidomide, un tranquillante che, assunto dalle gestanti provocava gravi anomalie nel feto.

La salute dell'uomo dipende anche dall'igiene: nei paesi sviluppati una delle voci che sono in continua espansione nei bilanci individuali è quella della cosmesi: ogni abitante di un paese minimamente civilizzato usa ogni giorno per la sua pulizia personale uno o due prodotti e molti arrivano a usarne una dozzina. Le condizioni igieniche sono straordinariamente migliorate rispetto al cosiddetto ‛buon tempo antico' e ciò ha portato un contributo non indifferente all'aumento della vita media e del benessere in generale.

6. I nuovi materiali

Un terzo settore nel quale la chimica ha un ruolo fondamentale, oltre quello dell'alimentazione e quello della salute, riguarda i nuovi materiali di sintesi (v. materiali, suppl.) Non vi è forse nulla, come l'avvento delle materie plastiche, che abbia inciso in modo così profondo sulla vita dell'uomo contemporaneo. Non vi è oggetto che noi tocchiamo, si può dire, che non sia in qualche modo legato agli alti polimeri (v. polimeri) e sono ora accessibili a buon mercato oggetti di uso comune che una volta erano a disposizione di pochi. Ciò ha un importante significato sociale, di fronte al quale hanno ben poco valore i rimpianti per il crescente abbandono di certi materiali tradizionali come la lana, la seta, i metalli, il legno. La sostituzione di quest'ultimo con materie plastiche è anche vantaggiosa dal punto di vista ecologico: è evidente, infatti, che per ottenere il legno necessario a fabbricare tutti gli oggetti che oggi si realizzano con le materie plastiche si dovrebbe attingere massicciamente al patrimonio forestale mondiale.

Le materie plastiche prendono origine dalla petrolchimica; i principali prodotti base sono l'etilene (20 milioni di tonnellate l'anno), lo stirene, il propilene, i derivati acrilici. Il fatturato annuo delle materie plastiche negli Stati Uniti supera i cinque miliardi di dollari. Telefoni, maniglie, interruttori, pezzi di automobili, posaterie, vernici protettive, adesivi, isolanti: sono tutti oggetti della nostra vita quotidiana realizzati con materiali plastici.

Una vera e propria rivoluzione industriale si è avuta anche nel campo dei tessuti con lo sviluppo delle fibre tessili artificiali. Se ci riferiamo al mondo occidentale, a partire dalla fine degli anni sessanta le fibre tessili artificiali hanno sorpassato in quantità il cotone e la lana, e soprattutto la seta. L'ampia disponibilità di fibre artificiali (nailon, poliacrilico, poliestere, raion) ha cambiato le abitudini individuali per quanto riguarda il vestiario: il guardaroba si è arricchito, vi sono molti abiti estivi e invernali, il vestiario viene cambiato per motivi legati alla moda più che per un vero e proprio consumo, sono sempre più disponibili tendaggi e tappeti, il materiale è più facile da trattare e più resistente, la varietà di colori è maggiore.

Stando alle statistiche, l'individuo occidentale può ottenere, spendendo il 9% del suo reddito, una disponibilità di tessuti migliore, in qualità e quantità, di quella che otteneva trent'anni orsono spendendo il 12% del reddito. Nel Terzo Mondo coprirsi non è più un privilegio di pochi.

Ausiliari chimici dell'industria tessile permettono inoltre di confezionare tessuti no iron, resistenti all'infiammabilità e all'infeltrimento e impermeabilizzati, tutte cose che stanno divenendo ovvie nei nostri consumi.

Di profondo significato per il benessere dell'uomo sono le applicazioni delle materie plastiche alla medicina, che riguardano soprattutto due settori: le protesi e le tecnologie di somministrazione. Per quanto riguarda le protesi, le materie plastiche forniscono i materiali più adatti per la fabbricazione di pezzi di tessuto, di vene, di organi o di strutture artificiali. Sono stati risolti, anche con contributo italiano, i problemi legati alla trombogenicità dei materiali estranei una volta entrati in contatto col sangue, e si prevede per questo settore uno sviluppo importante. Vi è poi tutta la problematica del lento rilascio dei medicamenti: sono state studiate, dapprima negli Stati Uniti e quindi negli altri paesi tecnologicamente avanzati, delle formulazioni che vedono l'inglobamento di medicinali in materiali polimerici che li rilasciano lentamente una volta in circolo. Questo approccio è importantissimo ai fini di evitare i sovradosaggi o la discontinuità nei dosaggi, ed è particolarmente adatto in tutti quei casi in cui occorre somministrare quantità piccole, ma costanti, di un medicamento (ad esempio sostanze ad azione contraccettiva o taluni medicamenti indicati per malattie cardiache).

Come per gli argomenti trattati precedentemente, anche nel caso delle materie plastiche dobbiamo considerare le controindicazioni. Queste sono dirette e indirette. Sono dirette le controindicazioni dovute allo smaltimento dei rifiuti di materie plastiche, che sono difficilmente degradabili, si trovano dappertutto e infestano laghi, fiumi, mari, boschi, città. Lo smaltimento di questi rifiuti pone seri problemi, in quanto non si è ancora giunti alla convenienza delle tecniche di riciclo, e il loro incenerimento può provocare, come nel caso del polivinildoruro, la formazione di sostanze tossiche. Le controindicazioni indirette sono di tipo sanitario: recenti studi hanno accertato la pericolosità di molti dei monomeri con i quali si producono le materie plastiche più importanti: vinildoruro, acrilonitrile, stirene, benzene (precursore, quest'ultimo, dello stirene).

Sempre collegata con la petrolchimica è la produzione di detersivi. Questo settore ha completamente rivoluzionato le nostre abitudini per quanto riguarda il lavaggio della biancheria, alcuni procedimenti industriali, la cura della persona, e anche, indirettamente, l'industria degli elettrodomestici. I saponi di una volta, inadatti alle lavatrici automatiche, sono stati obbligatoriamente sostituiti dai detersivi, che non danno sali insolubili con acque ricche di calcio e magnesio, e sono additivati di fosfati che impediscono l'intasamento dei tubi delle lavatrici. Anche in questo caso le controindicazioni sono svariate. Riguarda direttamente noi italiani il potere eutrofizzante dei fosfati: si pensa che una causa non trascurabile dell'inquinamento da alghe dell'Adriatico sia proprio la presenza di fosfati nei detersivi.

L'industria della carta, l'industria dei metalli, i materiali fotografici e per fotocopie, i materiali per i transistor e per le celle solari, i nuovi materiali compositi per costruzione: infinite sono le vie attraverso cui la chimica influisce sullo sviluppo e sull'economia della moderna società.

7. Chimica, energia e ambiente

La chimica ha dovuto affrontare in questi ultimi anni due diverse crisi - la crisi energetica e la crisi ambientale - in quanto le nazioni industrializzate si trovano a fronteggiare il passaggio da un'economia basata su risorse illimitate e sul libero sfruttamento dell'ambiente a un'economia basata su risorse limitate e sul rispetto dell'ambiente.

a) Chimica ed energia

L'energia costituisce il cardine dell'intera problematica delle risorse. Essa entra dappertutto: non vi è processo chimico che non preveda un dispendio più o meno grande di energia.

Nel campo dell'industria chimica organica l'aumento del prezzo del petrolio ha creato un doppio problema: infatti il greggio petrolifero è per l'industria chimica organica fonte di energia e fonte di materie prime. Si calcola che il 90% della chimica industriale organica utilizzi come materia prima derivati del petrolio.

L'agricoltura moderna è anch'essa basata su un larghissimo impiego di energia. La resa per ettaro di molte coltivazioni è aumentata, la qualità del cibo è migliorata, la fatica dell'uomo è diminuita, il numero di addetti è calato contemporaneamente all'aumento della produzione, ma ogni caloria di cibo che arriva sulle nostre tavole costa 7-8 calorie di energia termica, il che equivale a dire che coi nostri sistemi alimentari ognuno di noi consuma per alimentarsi 0,8 tonnellate di greggio all'anno. L'energia serve come combustibile, per i macchinari, per i fertilizzanti, per i pesticidi, per cuocere, trasportare, conservare. La fatica dell'uomo nell'agricoltura moderna è il 5% dell'energia impiegata, mentre nei sistemi patriarcali arriva al 95%.

L'aumento del prezzo del petrolio verificatosi dopo il 1973 ha colpito l'agricoltura dei paesi del Terzo Mondo - e del Quarto - togliendo loro la possibilità di acquistare i fertilizzanti necessari per portare avanti la produzione agricola.

Nel settore dei metalli il consumo di energia è direttamente proporzionale alla diminuzione in percentuale dei metalli presenti nei minerali. Man mano che vengono ad esaurirsi i minerali più ricchi, si deve ricorrere a minerali sempre più poveri, la cui purificazione richiede lavoro ed energia in quantità enormi.

L'energia consumata pro capite, d'altronde, è un indice del livello di vita ed è strettamente legata al reddito: Stati Uniti, Svezia, Canada, Belgio presentano al tempo stesso un elevatissimo reddito individuale e un altissimo consumo pro capite di energia, mentre paesi come India, Brasile, Turchia uniscono al basso reddito individuale un altrettanto basso consumo di energia. L'oscillazione dei prezzi e l'instabilità politica di alcune zone (Medio Oriente, Sudamerica) fanno dell'energia una variabile assai importante per la chimica mondiale.

b) Chimica e ambiente

La crisi ambientale ha colpito la chimica in maniera intensa. Alla fine degli anni sessanta ci si è cominciati a rendere conto degli effetti che la diffusione incontrollata di prodotti chimici esercitava sull'ambiente e sugli esseri viventi. La resipiscenza, benché tardiva e disordinata, è stata importante. Si può affermare che il 60-80% del cancro ha origine ambientale. Prima causa il fumo, poi le radiazioni naturali, quindi l'esposizione a composti chimici, sia naturali che sintetici. Il cancro è passato fra il 1900 e il 1970 dall'ottavo posto, come causa di morte, al secondo. I più esposti sono ovviamente i lavoratori dell'industria chimica, poi i loro familiari e i consumatori di prodotti contaminati da certi composti chimici. Molte sostanze inoltre (mercurio, piomho, metalli pesanti in genere, asbesto, benzene, ecc.) hanno una specifica attività nociva.

Se vogliamo riesaminare l'evoluzione della mentalità generale a proposito delle complesse relazioni che intercorrono fra la produzione chimica e l'ambiente, dobbiamo osservare che vi è stata una prima fase nella quale le iniziative ufficiali, gli studi, i provvedimenti delle agenzie internazionali erano la conseguenza diretta o indiretta di un avvenimento grave, e pertanto erano soggetti a una generalizzata tensione emotiva. Dopo il famoso episodio di Minamata - ci riferiamo all'intossicazione da mercurio cui andarono incontro alla fine degli anni cinquanta gli abitanti della baia giapponese di Minamata a causa degli scanchi di mercurio di una ditta produttrice di acetaldeide - tutte le grandi organizzazioni si sono occupate del mercurio. Allo stesso modo, dopo analoghi episodi, si occuparono del cadmio, dei PCB (policlorobifenili), ecc. Si procedeva in modo casuale, episodico, con spreco di forze, studi sovrapposti e non coordinati, al di fuori di una reale scala di priorità. A questa fase è seguita, da qualche anno, una serie di iniziative e di provvedimenti di largo respiro, volti a riparare i danni provocati dall'immissione sul mercato - e pertanto nell'ambiente - di prodotti non sufficientemente controllati sotto il profilo della nocività, e a evitare, per il futuro, che tale immissione possa avvenire.

Sono state emesse normative alle quali dovrà attenersi chiunque voglia distribuire sul mercato un composto nuovo: si prevedono saggi sulla nocività, sulla persistenza, sulla cancerogenicità, sulle caratteristiche chimico-fisiche, sul comportamento nell'ambiente dei prodotti, anche in relazione al loro impiego. All'idea del beneficio che la società o l'individuo si attendono da un nuovo prodotto si è aggiunta quella del rischio che l'uso del prodotto comporta.

Ciò è avvenuto, lo ricordiamo, per alcuni insetticidi, per alcuni medicamenti, per alcuni additivi alimentari, per diserbanti, coloranti, adesivi. Dopo polemiche, campagne di stampa, movimenti ecologici, si è pervenuti alla presa di coscienza dell'impossibilità di ottenere composti chimici a rischio zero. L'opinione pubblica, nella fase meno emotiva e più razionale, ha preso atto di un fatto incontrovertibile: ogni azione umana è soggetta a un margine - più o meno ampio - di rischio. Occorre quindi abbandonare utopistiche speranze di avere solo vantaggi dallo sviluppo tecnologico, e agire per far sì che il rapporto fra benefici e rischi sia ottimale. Si è verificata quindi un'evoluzione positiva della questione ambientale, che ha visto l'opinione pubblica più cauta nelle reazioni ad avvenimenti dolorosi, le agenzie internazionali molto attive nei controlli e nelle prescrizioni, e gli imprenditori più accorti (in molti casi potremmo dire meno disinvolti) nel determinare, con le loro decisioni e le loro valutazioni di bilancio, il margine di rischio delle loro produzioni. Come è avvenuto per il fattore energetico, anche per il problema ambientale si è arrivati a creare le premesse per un generale miglioramento: l'energia è divenuta così un parametro di cui tenere ben conto e i problemi legati alla sicurezza del lavoro e dell'ambiente fanno parte delle considerazioni che sono alla base di una produzione nuova o di una iniziativa commerciale. Se nel settore dei farmaci le precauzioni sono - tradizionalmente - in continuo affinamento per renderli idonei alle situazioni e agli scopi (ciò nonostante ogni tanto qualche prodotto viene ritirato dal mercato a seguito dei controlli e degli studi epidemiologici), analoghe precauzioni vengono prese per gli insetticidi, i cosmetici e i prodotti chimici in genere. Oltre a ciò, una sempre maggiore attenzione viene posta, sia dalle autorità che dagli imprenditori, al problema costituito da rifiuti nocivi, per impedire il ripetersi di inquietanti episodi di intossicazione o di inquinamento di falde acquifere a seguito di una malaccorta - se non incosciente - gestione dei rifiuti pericolosi.

Queste misure e queste cautele comportano costi aggiuntivi, talvolta rilevanti, ma è tuttavia importante che si stabiliscano e/o si rafforzino i collegamenti fra il mondo che produce tecnologie e il mondo che le utilizza, perché la scienza possa assolvere ancor meglio il compito di sempre, che è quello di generare cultura, tecnologia, soluzioni ai problemi dell'uomo.

8. L'informazione

La sempre maggiore partecipazione del largo pubblico alle decisioni politiche e tecniche è un indice di democrazia. Perché questa partecipazione sia - tuttavia - elemento di progresso e non di confusione è necessario che tutti coloro che partecipano siano correttamente e sufficientemente informati. Ciò vale anche - vorremmo dire soprattutto - per le scelte tecnologiche, che implicano la conoscenza di concetti non ovvii e la capacità di apprezzare anche sul piano quantitativo le dimensioni dei fenomeni.

È molto importante che gli operatori politici e sindacali, o quelli preposti ai mezzi di informazione, siano al corrente del fatto - per fare qualche esempio - che l'energia è essenziale per la fabbricazione dei fertilizzanti e per lo sviluppo dell'agricoltura e, quindi, per la soluzione del problema della fame, così come è importante che si sappia che il 40-5o% dei raccolti, se non si interviene con i pesticidi, viene distrutto dagli insetti o dai roditori. È essenziale che ognuno sappia che buona parte di ciò che indossa è costituito da materiali sintetici, che quando gira in macchina utilizza materiali metallici e plastici e contribuisce col suo scappamento all'inquinamento dell'aria, che l'enorme produzione chimica serve a soddisfare la somma delle esigenze individuali. In genere, ora come ora, tutti sono d'accordo nell'individuare i beni ai quali ‛gli altri' devono rinunciare. E invece la responsabilità dell'inquinamento, della degradazione ambientale, è la somma di responsabilità singole, alle quali ognuno di noi è tutt'altro che estraneo.

È anche essenziale che si conoscano a fondo i dati quantitativi che riguardano il problema energetico: tutti ritengono ovvio avvalersi dei benefici che la disponibilità di energia consente, ma pochi (in senso relativo) si rendono conto della necessità di impiantare nuove centrali.

L'informazione è necessaria anche per evitare l'incongruenza. E le incongruenze sono sotto gli occhi di tutti. Consideriamo, ad esempio, il fumo. Esso è considerato come la causa di gran lunga maggiore dell'insorgenza dei tumori polmonari, e tuttavia chiunque può acquistare sigari e sigarette, salvo qualche restrizione recente che regolamenta la possibilità di fumare nei locali pubblici. Attenzione molto superiore è stata data dalle autorità sanitarie a qualche sostanza certamente meno pericolosa, ad esempio ciclammati e saccarina, utilissima ai diabetici, il cui uso è stato limitato o proibito a seguito di controverse e discusse risultanze. Qualcosa del genere accade per gli alcolici.

Vi è poi un'altra incongruenza, dalle dimensioni planetarie, costituita dalla grande attività - e dalle grandi spese - nel settore delle armi. Le polemiche o le considerazioni sui rischi e sui benefici del progresso tecnologico riguardano in genere la scienza e la tecnologia promosse dalle università e dalle industrie, che concernono l'agricoltura, la salute, i materiali, l'energia; poca attenzione si pone invece al continuo sviluppo delle armi in genere, e anche delle armi chimiche. Mentre noi discutiamo e rallentiamo, per giusta cautela, le ricerche su qualche insetticida o farmaco sotto il largo controllo dell'opinione pubblica, nel segreto d'acciaio dei laboratori militari vengono concepite armi tremende. Valga per tutti l'esempio dell'energia atomica: è stato più facile riempire l'Est e l'Ovest di missili a testata atomica che costruire utilissime centrali nucleari.

In altri termini, di ogni branca della scienza noi abbiamo, di sicuro, le applicazioni volte al male, anzi in genere le scoperte più importanti sono possibili proprio perché già sviluppate nell'ambito militare. Su questo non possiamo dire nulla, ma quando si tratta di applicare per la qualità della vita queste scoperte, allora sorgono polemiche e discussioni. Il male è certo, il bene è solo possibile.

9. La ricerca

La chimica è stata, e sarà ancora, un punto di forza essenziale per lo sviluppo della società. La ricerca è a sua volta la base dello sviluppo della chimica. Le nuove frontiere della biologia e della scienza dei materiali stanno aprendo prospettive immense. La chimica ha permesso di identificare principi attivi presenti nel nostro organismo, di sintetizzarli, di mutare il patrimonio genetico di microrganismi, creando le premesse per una nuova medicina basata su sostanze regolatrici che fanno già parte dei normali cicli biologici. Per contro, nuovi materiali speciali, spesso creati su misura per una precisa esigenza, stanno rivoluzionando gli usi e aprendo la via a mutamenti radicali. Tutto questo è dovuto alla ricerca, che assume sempre più quel carattere di interdisciplinarità che è essenziale per un effettivo progresso. Né va dimenticato che il possesso di nuove tecnologie significa anche nuovi mestieri, prospettive importanti per il lavoro di coloro che oggi sono giovani.

Bibliografia

American Chemical Society, Chemistry and economy, Washington 1973.

Bosschère, G. de, Les deux versants de l'histoire. Perspectives de la décolonisation, Paris 1969 (tr. it.: I due versanti della storia. Storia della decolonizzazione, Milano 1973).

Boyd, E. M., Toxicity of pure foods, Cleveland 1973.

Caglioti, L., I due volti della chimica, Milano 1979.

Carson, R., Silent spring, Boston 1962 (tr. it.: Primavera silenziosa, Milano 1963).

Green, M. E., Turk, A., Safety in working with chemicals, New York 1978.

Marei, S., Risorse, popolazione, produzione agricola, in ‟Scienza e tecnica", 1976, LXXVI.

Ricossa, C., L'economia in 100 grafici, Milano 1984.

Selleri, R., Botré, C., Orzaleri, G., Chimica e tecnologia dei prodotti cosmetici, Roma 1977.

Sicuteri, F., Gli oppioidi endogeni come modulatori della omeostasi, Milano 1983.

Travaglia, S., Maledetta industria, Milano 1986.

Elettrochimica,

di Roger Parsons

SOMMARIO: 1. Origini. 2. Conduttanza e reazioni agli elettrodi. 3. Celle elettrochimiche. 4. Cinetica delle reazioni elettrodiche. 5. Struttura della regione interfacciale. 6. Elettroanalisi. 7. Fonti di energia elettrochimica: a) celle primarie; b) celle secondarie; c) celle a combustibile. 8. Fotoelettrochimica. 9. Elettrolisi industriale. 10. Finitura e lavorazione dei metalli. 11. Corrosione. 12. Bioelettrochimica. □ Bibliografia.

1. Origini

L'elettrochimica, quale importante branca della scienza, nacque alla fine del XVIII secolo: la sua nascita può essere datata quasi esattamente con la lettera di Volta alla Royal Society di Londra nel 1800 (v. Volta, 1800), dove egli descriveva la generazione di elettricità da parte di quella che è conosciuta come la ‛pila di Volta'. Questa consisteva in una pila di coppie di dischi di zinco e di rame (o di zinco e di argento), intramezzate da dischi di cartone imbevuto di soluzione salma. Solo pochi mesi dopo Nicholson e Carlisle (v., 1800) usarono tale pila per generare elettricità, con la quale decomposero l'acqua nei suoi elementi: idrogeno e ossigeno. È questo processo a due vie, la produzione di elettricità da una reazione chimica e la produzione di modificazioni chimiche mediante il passaggio di corrente elettrica, ciò di cui si occupa sostanzialmente l'elettrochimica, sebbene le sue ramificazioni nella scienza moderna siano molto ampie.

La Scoperta di Volta fu il culmine di alcuni decenni di ricerche sull'‛elettricità animale'. La capacità di certe specie marine, come la torpedine e l'anguilla elettrica, di produrre scosse elettriche suscitava grande interesse, ma fu l'osservazione di Galvani, pubblicata nel 1791 (v. Galvani, 1791), dell'eccitazione elettrica di zampe di rana isolate dal corpo, che spinse Volta alla ricerca che portò alla pila. In breve, Galvani sosteneva che l'‛elettricità animale' era un fenomeno puramente biologico, mentre Volta affermava che essa era essenzialmente identica all'elettricità statica (da strofinio) e dimostrò che poteva essere generata senza la partecipazione di sistemi viventi. Le ricerche successive hanno confermato la conclusione di Volta, ma hanno anche confermato l'importante ruolo dei processi elettrochimici nei sistemi biologici.

È possibile che processi elettrochimici fossero usati empiricamente nell'antichità. Scavi effettuati vicino a Baghdad, nel 1930 (v. Waterman, 1931), hanno portato alla luce vasi di argilla contenenti bacchette di ferro, che sono stati ritenuti batterie primitive (v. Gray, 1963). Essi risalgono al Il secolo a. C. Si è immaginato che tali batterie potessero essere utilizzate per la doratura elettrolitica. Simili processi potrebbero essere stati usati anche dagli antichi Egizi.

Il termine ‛elettrochimica' fu introdotto da sir Humphry Davy nel 1807 (v. Hartley, 1966), verso la fine di uno straordinario periodo di attività presso la appena creata Royal Institution a Londra, durante il quale egli dette solide basi alla nuova scienza. In particolare egli utilizzò metodi elettrochimici per scoprire una serie di nuovi elementi: potassio, sodio, calcio, stronzio, bario, berillio e alluminio. Il suo assistente e successore, Michael Faraday (v. Williams, 1965), dimostrò l'identità di tutte le forme di elettricità e trovò la relazione quantitativa fra la quantità di elettricità passata attraverso una cella elettrolitica e la quantità di sostanza modificata chimicamente (leggi di Faraday). Oltre a queste eleganti ricerche sperimentali, Faraday propose la nomenclatura elettrochimica usata ancora oggi: ‛elettrodo', ‛elettrolita', ‛catodo', ‛anodo', ‛anione', ‛catione', ecc. (v. Ross, 1961).

2. Conduttanza e reazioni agli elettrodi

Le modificazioni chimiche che sono causate dal flusso di corrente elettrica, o lo causano, avvengono nella zona di contatto tra due materiali differenti - spesso un metallo e una soluzione - che devono entrambi condurre l'elettricità. Per capire il processo elettrochimico è prima necessario capire come avvenga il passaggio di elettricità attraverso tali differenti materiali. La comprensione di questo fenomeno si approfondì nel corso del XIX secolo e raggiunse una forma soddisfacente verso la fine dello stesso secolo, con la teoria ionica della conduzione elettrolitica, proposta da S. Arrhenius nel 1887, e la scoperta dell'elettrone da parte di J. J. Thomson nel 1897.

La corrente elettrica è sempre dovuta a un flusso di particelle elementari aventi carica di −1,602 × 10-19 C e massa di 1,661 × 10-24 g. Gli ioni sono atomi o gruppi di atomi (molecole) che hanno acquistato o ceduto elettroni. Essi hanno una carica, negativa nel primo caso e positiva nel secondo, che in genere è un multiplo piccolo della carica dell'elettrone. La loro massa è oltre 103 volte quella dell'elettrone; infatti lo ione più leggero, il protone (H+), ha una massa 1.840 volte quella dell'elettrone.

L'importante differenza tra i due tipi di conduzione è che nei conduttori elettronici non c'è trasferimento di materia, mentre nei conduttori ionici il movimento degli ioni implica trasferimento di materia. I metalli e i semiconduttori sono i principali conduttori elettronici, mentre i sali fusi (materiali fusi ionici) e le soluzioni di acidi, sali o basi, in solventi come l'acqua, sono i principali conduttori ionici; essi sono chiamati elettroliti.

Nei plasmi, o gas ionizzati, sono presenti sia ioni sia elettroni, ma gli elettroni, essendo leggeri, tendono a prevalere nella conduzione, a causa della loro elevata mobilità. La conduzione mista può avvenire anche in alcuni solidi.

Per buona parte del XIX secolo si pensò che il processo di conduzione fosse un tipo di processo ‛a relè', secondo un meccanismo proposto da Grotthuss (v., 1806), ma a partire dal lavoro di Arrhenius è stata ben accertata la stabilità degli ioni. Questa stabilità deriva soprattutto dalle loro interazioni elettrostatiche con le molecole di solvente, sebbene molte sostanze che formano cristalli ionici (come gli alogenuri alcalini) si presentino ionizzate anche allo stato fuso. Il meccanismo ‛a relè' è responsabile solo di pochi processi di conduzione, fra i quali è importante la conduzione di acidi e basi in soluzione acquosa. Il protone è stabile in tali soluzioni solo a causa della forte interazione con il solvente, tuttavia dimostra una mobilità molto maggiore di quella che ci si aspetterebbe se la specie in movimento fosse un protone solvatato: ciò perché il protone salta da una molecola di solvente all'altra. Questo è particolarmente importante nelle soluzioni acquose, data la natura anfotera dell'acqua. L'acqua, in altre parole, può agire come un acido, donando un protone,

H2O → H+ + OH-, (1)

o come una base, accettando un protone,

H2O + H+ → H3O+. (2)

Le reazioni elettrochimiche avvengono alla superficie di separazione, all'interfaccia, tra un conduttore elettronico e un conduttore ionico, e sono perciò il risultato di questo cambiamento nel modo di conduzione. Un tipico esempio è un pezzo di rame (Cu) in contatto con una soluzione acquosa di solfato di rame (CuSO4), che contiene ioni rameici solvatati e ioni solfato solvatati (SO42- (aq)).

All'interfaccia tra questi due conduttori la modificazione del meccanismo di conduzione avviene mediante la reazione all'elettrodo

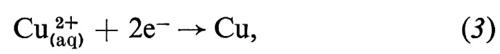

in cui gli ioni rameici sono neutralizzati dagli elettroni provenienti dal metallo per formare atomi di rame che si depositano sul metallo stesso. Su questo tipo di reazione è basato il processo di placcatura elettrolitica. Esso avviene quando la corrente di elettricità positiva fluisce dalla soluzione al metallo. L'elettrodo è allora un ‛catodo' e i ‛cationi' (Cu2+) si muovono verso l'interfaccia: la corrente è detta ‛catodica'. Se la corrente viene invertita, avviene il processo inverso: il rame passa in soluzione per formare ioni rameici e gli elettroni fluiscono dall'interfaccia verso il metallo. L'elettrodo è ora un ‛anodo' e la corrente è detta ‛anodica'. Il processo di addizione di elettroni a una specie è un processo di riduzione, mentre il processo inverso è un'ossidazione. Quindi una riduzione avviene sempre a un catodo e un'ossidazione sempre a un anodo. La comprensione di un processo elettrochimico elementare in termini di una reazione come la (3) lascia immediatamente capire la relazione quantitativa espressa dalle ‛leggi di Faraday dell'elettrolisi', in quanto due elettroni devono fluire attraverso il circuito esterno per formare un atomo di rame. Quindi ci dev'essere sempre una esatta relazione tra la quantità di elettricità passata attraverso il circuito e la quantità di sostanza modificata chimicamente. Bisogna notare che non è necessario che la corrente nell'elettrolita sia portata totalmente (o anche parzialmente) dalla specie che reagisce all'interfaccia. Nell'esempio visto sopra solo una frazione della corrente è portata dal catione, mentre il resto è portato dagli anioni solfato.

3. Celle elettrochimiche

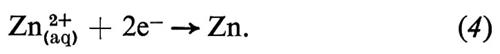

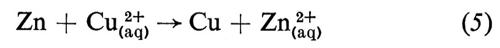

La pila di Volta era un insieme di unità, ognuna delle quali consisteva in due dischi di metalli diversi, separate da un disco di cartone imbevuto di soluzione salma. Questo è un esempio di cella elettrochimica, che ha sempre due elettrodi. Un esempio semplice di cella potrebbe essere l'elettrodo di rame sopra descritto, combinato con un elettrodo di zinco (v. fig. 1); la reazione a questo secondo elettrodo sarebbe

È la diversa reattività dei due metalli, Cu e Zn, con l'elettrolita a fornire la differenza di potenziale che fa passare la corrente elettrica attraverso la cella. La combinazione delle reazioni (3) e (4) nella forma

dà la reazione globale nella cella, che produce elettricità, poichè questa reazione è spontanea. Se però viene applicata alla cella una differenza di potenziale esterna (ΔE) sufficientemente grande, la reazione può essere invertita; cioè la reazione chimica procederà in direzione opposta a quella spontanea mostrata nella reazione (5), come risultato del passaggio forzato della corrente elettrica. Ciò può essere rappresentato mediante un diagramma del flusso di corrente in funzione del potenziale applicato esternamente (v. fig. 2). Per un particolare valore di ΔE, in corrispondenza del quale la corrente è zero, la reazione nella cella è bilanciata dalla differenza di potenziale esterna. Questa ΔE è una grandezza caratteristica della cella, nota come f.e.m. ('forza elettromotrice'), termine che ha perso il suo significato originario, sebbene la grandezza in sé sia di grande importanza.

H. von Helmholtz (v., 1881) e J. W. Gibbs (v., 1875) hanno dimostrato che la f.e.m. (E) di una cella in equilibrio è correlata all'energia libera di Gibbs (ΔG) della reazione che avviene nella cella mediante la relazione

E = − ΔG/nF, (6)

dove n è il numero di elettroni che attraversano il circuito esterno per ogni ione che reagisce all'elettrodo (nell'esempio visto sopra n = 2, come risulta dalle reazioni parziali (3) e (4)) e F è la costante di Faraday (96.484 C mol-1), che equivale alla carica di una ‛mole' di elettroni. La (6) è un'equazione chiave, poiché costituisce il ponte fra la termodinamica e le proprietà delle celle elettrochimiche in equilibrio. Queste proprietà possono ora essere interpretate in termini di reattività chimica.

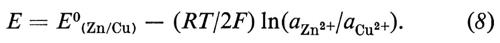

Uno dei numerosi risultati dell'applicazione dell'equazione (6) è la deduzione di come la f.e.m. di una cella dipenda dalla concentrazione dei reagenti nella cella. L'energia libera di Gibbs, e di conseguenza la f.e.m., dipendono logaritmicamente dalle attività delle specie chimiche che partecipano a una reazione, secondo la seguente equazione:

E = E0 − (RT/nF) Σi νi ln ai, (7)

dove R è la costante dei gas (8,31441 JK-1 mol-1), T è la temperatura termodinamica, ai è l'attività della specie i e νi è il suo coefficiente stechiometrico nella reazione che avviene nella cella (i prodotti di reazione hanno valori positivi di νi e i reagenti valori negativi); E0 è la f.e.m. quando tutti i reagenti hanno attività unitaria (tutte le specie nel loro stato standard).

Nel caso particolare della reazione (5), n = 2, νCu2+ = − 1, νZn2+ = 1, e aZn = aCu = 1, perché i metalli puri sono nel loro stato standard; sicché si ha:

L'equazione (7) fu ricavata da W. Nernst (v., 1889) ed è nota come ‛equazione di Nernst'.

Poiché le energie di Gibbs sono proprietà additive delle reazioni, anche la f.e.m. standard è una proprietà additiva. Perciò è possibile compilare una tabella delle f.e.m. standard delle celle in cui ogni elettrodo è collegato con un elettrodo standard; quindi si possono calcolare le f.e.m. di tutte le altre combinazioni.

Per celle con elettroliti acquosi (e altri elettroliti in cui il protone solvatato è stabile) l'elettrodo standard è l'elettrodo a idrogeno, che consiste in un metallo cataliticamente attivo (generalmente platino), sul quale si fa gorgogliare idrogeno, immerso in una soluzione acida avente attività degli ioni idrogeno unitaria (v. Latimer, 1938; v. Bard e altri, 1985). L'elenco dei potenziali standard dei metalli in ordine progressivo è spesso chiamato ‛serie delle forze elettromotrici'; esso dà un'indicazione sulla reattività relativa dei metalli in un dato solvente.

Per buona parte del XIX secolo e durante i primi anni del XX l'origine della f.e.m. in una cella elettrochimica fu oggetto di controversie. I sostenitori della teoria ‛chimica' affermavano, in base all'equazione (6), che l'origine della f.e.m. stesse nelle reazioni chimiche all'interfaccia metallo/elettrolita. Invece i sostenitori della teoria ‛fisica' affermavano che la f.e.m. della cella dipendesse dal contatto fra i diversi metalli dei due elettrodi (la cella completa della fig. 1, per esempio, implica un contatto metallo/metallo fra il terminale di rame e l'elettrodo di zinco); si sapeva che in corrispondenza di queste giunzioni metallo/metallo si determina una differenza di potenziale di contatto della stessa entità della f.e.m. della cella. Un'analisi completa basata sui concetti introdotti da A. N. Frumkin (v., 1917) e da E. Lange (v. Lange e Koenig, 1933) concilia queste due vedute estreme e mostra che, in effetti, le differenze di potenziale a ognuna delle giunzioni danno un contributo alla f.e.m. totale, che è anche, naturalmente, correlata quantitativamente all'energia di Gibbs della reazione che avviene nella cella.

4. Cinetica delle reazioni elettrodiche

Il fatto che la corrente che passa attraverso la cella non diventi infinita, quando il potenziale applicato esternamente differisce dalla f.e.m. di equilibrio, indica l'esistenza di processi lenti implicati nel passaggio di questa corrente. Nel metallo e nell'elettrolita questi processi sono espressi dalla resistenza elettrica dei materiali, dovuta al fatto che gli ioni possono muoversi solo spingendo ‛da parte' altre particelle, mentre il movimento di elettroni è impedito dal moto termico del reticolo metallico, nonché dai difetti presenti in questo. Comunque queste caratteristiche di resistenza non spiegano il comportamento di una cella elettrochimica al passaggio della corrente: essa mostra una resistenza maggiore, che è non lineare, nel senso che la corrente non è una funzione lineare del potenziale applicato, come sarebbe se gli unici effetti presenti fossero quelli della resistenza di massa. Effetti addizionali sono dovuti alla lentezza della stessa reazione elettrodica e al fatto che essa è una reazione eterogenea, nel senso che lo scambio dei portatori di carica avviene solo all'interfaccia.

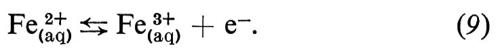

Formalmente, il tipo più semplice di reazione elettrodica è quello in cui il reagente e il prodotto sono due diversi stati di ossidazione di uno stesso ione, entrambi presenti nell'elettrolita, e la reazione consiste nello scambio di un elettrone con l'elettrodo metallico. Un esempio di questo tipo di reazione potrebbe essere quello tra ione ferroso e ione ferrico:

La cinetica di questa reazione segue le leggi della normale cinetica chimica. La (9) è del primo ordine in entrambe le direzioni: verso destra (anodica) e verso sinistra (catodica); cioè la velocità di reazione (v) proporzionale alla prima potenza della concentrazione del reagente:

υ→ = k→[Fe2+], (10)

υÁ = kÁ[Fe2+], (11)

dove [Fe2+] e [Fe3+] sono le concentrazioni ‛locali' rispettivamente di Fe(aq)2+ e Fe(aq)3+ nel luogo della reazione. La caratteristica delle equazioni di velocità delle reazioni elettrodiche è che le costanti di velocità k→ e kÁ dipendono dal potenziale dell'elettrodo: nel caso più semplice l'energia di attivazione è una funzione lineare del potenziale dell'elettrodo. Questo conduce a una dipendenza esponenziale delle costanti di velocità dal potenziale:

k→ = k0 exp[(1 − α)nEF/RT], (12)

kÁ = k0 exp[αnEF/RT]. (13)

La costante di proporzionalità α è detta ‛coefficiente di trasferimento' e il suo valore è normalmente compreso fra zero e uno. (Segue dal principio di reversibilità microscopica che la somma degli argomenti dei due esponenziali in (12) e (13) dev'essere nEF/RT; perciò è richiesto un solo coefficiente di trasferimento). Questa caratteristica unica delle reazioni elettrodiche significa che c'è un modo semplice per controllare la loro velocità e che, a causa della forma esponenziale, questo controllo può essere esercitato entro un intervallo molto ampio di velocità.

La velocità netta della reazione, υ→ − υÁ, può essere espressa in termini di una corrente, poiché per ogni gradino elementare n elettroni sono trasferiti al (o dal) metallo (n = 1 nel caso della reazione 9). Questa è un'espressione delle leggi di Faraday.

Poiché la reazione avviene all'interfaccia tra due fasi, la grandezza che interessa è la densità di corrente j e le velocità υ→ e υÁ sono espresse anche come velocità per unità di superficie dell'interfaccia. Si ha

j = nF(υ→ − υÁ). (14)