Clima

Clima

Sommario: 1. Introduzione. 2. Paleoclimatologia. 3. Le datazioni con radioisotopi. 4. Gli oceani. 5. L'effetto serra. 6. Le previsioni. 7. Strategie per mitigare l'effetto serra. 8. Questioni che richiedono una regolamentazione internazionale. Bibliografia.

1. Introduzione

Lo studio del clima è cosa ben diversa dalle analisi finalizzate alle previsioni del tempo. La distinzione - lungi dall'avere carattere accademico - è di fondamentale importanza; infatti, per prevedere il tempo atmosferico - un fenomeno limitato nello spazio e nel tempo - si studiano le variazioni della temperatura, della pressione e dell'umidità, i venti, la nuvolosità e le precipitazioni, ossia tutti quei fattori che sono influenzati soprattutto da fenomeni atmosferici; il clima si riferisce invece a grandi estensioni spaziali e a lunghi periodi di tempo (come regola, si considera che abbiano interesse climatologico dati come, ad esempio, la media delle precipitazioni su un periodo di 30 anni). Inoltre, alla determinazione del clima contribuiscono altri quattro fattori, oltre all'atmosfera: gli oceani, le masse ghiacciate, la biosfera e la radiazione solare; dunque, tre componenti terrestri e una extraterrestre. Detto in modo succinto, l'atmosfera assorbe e diffonde parte della radiazione solare incidente, mentre frena l'uscita della radiazione infrarossa emessa dalla Terra, provocando in tal modo un ‛effetto cuscinetto' molto delicato se si pensa che uno degli agenti della trappola infrarossa - l'anidride carbonica - è in continuo aumento a causa delle attività umane (il cosiddetto ‛effetto serra'; v. cap. 5).

Gli oceani sono la sorgente primaria di vapore acqueo, e quindi di nuvolosità, nonché importanti distributori di calore fra le regioni che ne sono povere e quelle che ne sono ricche (rispettivamente, quelle alle alte latitudini e quelle equatoriali) dell'intero globo. Tali scambi avvengono tramite gigantesche correnti che si snodano instancabilmente attraverso gli oceani. Le regioni coperte di ghiaccio assorbono meno calore rispetto alle regioni più scure (un corpo nero è un perfetto assorbitore di calore, un corpo bianco l'opposto) e influenzano così l'albedo, o riflettività del pianeta. Per esempio, l'albedo di una foresta (assai scura) è molto bassa (0,08), mentre quella della neve fresca è dieci volte maggiore (0,8); più grandi sono le estensioni ghiacciate, maggiore è la radiazione che esse riflettono (quando c'è neve fresca, fa infatti più freddo). Infine, la biosfera - forse la componente più difficile da quantificare in tutto lo scenario climatologico - può agire in modi svariati, per esempio sottraendo anidride carbonica all'atmosfera attraverso la vegetazione, o aumentando l'azione fotosintetica del fitoplancton marino che, riducendo la carica di diossido di carbonio (o anidride carbonica, CO2) dell'atmosfera, influenza l'effetto serra e quindi il clima.

Non sappiamo quando sia nato l'interesse dell'umanità per i fattori climatici, ma non sembra azzardato suggerire che sia sempre esistito e che si sia sviluppato parallelamente a quello per le previsioni del tempo. La frase di Giobbe ‟buon tempo vien dal nord", è forse più importante di quel che sembra, poiché ci rivela che già allora si era intuito che le perturbazioni atmosferiche e il clima ‛vengono' da qualche parte, sono cioè fenomeni dinamici. Gli abitanti della Mesopotamia sembrano essere stati i primi a documentare le loro osservazioni climatiche. Il mondo greco fu costellato di scienziati affascinati dai fenomeni naturali, per esempio dalle inondazioni del Nilo e dai famosi venti dell'Egeo. Se Talete fu il primo a predire un'eclisse solare, Ippocrate - padre della medicina - descrisse gli effetti del tempo sulla salute e Aristotele scrisse un trattato sulla meteorologia. La civiltà romana dimostrò un pressoché totale disinteresse per tali fenomeni; solo quando il baricentro della cultura mediterranea si spostò ad Alessandria furono ripresi gli studi di questo tipo. Poiché è nota la passione degli Inglesi per il tempo quale soggetto di conversazione, è forse bene ricordare che uno dei primi a scrivere in modo dettagliato sull'argomento fu il Venerabile Beda di Durham. Altri interessanti notizie relative al clima si possono ricavare dalla lettura dei rapporti degli ispettori delle tasse inglesi che parlano del ‛tempo' come di uno dei fattori addotti per giustificare mancati pagamenti; oppure da un documento del 1342, custodito nel castello di Knightsbridge, nel quale si legge che il ferro per gli aratri e per gli zoccoli dei cavalli sarebbe costato 30 scellini in più a causa della siccità di quell'anno. Un altro inglese quasi contemporaneo di Dante, R. Bacone, sostenne il concetto della supremazia dell'esperimento sulla teoria, un concetto che prevalse per lungo tempo, ma fu solo grazie a due italiani, Galileo Galilei ed Evangelista Torricelli, che si ebbero i primi due strumenti di lavoro, il termometro e il barometro (al riguardo esistono alcune divertenti note storiche, come il tentativo di Torricelli di usare miele prima di adottare il mercurio). Pochi anni dopo, l'impiego del barometro di Torricelli permise a B. Pascal in Francia e a R. Boyle in Inghilterra di effettuare importanti scoperte scientifiche. Leonardo inventò la banderuola del vento nonché un indicatore di umidità, ma fu il tedesco J. H. Lambert a ideare l'igrometro per misurare la concentrazione del vapor d'acqua. Impulsi a migliorare le conoscenze del clima vennero, come è comprensibile, dai mercanti, che avevano bisogno di affidabili previsioni dei venti.

Due grandi scienziati inglesi possono a buon diritto essere considerati i padri della climatologia dinamica: E. Halley - che scoprì la relazione fra la circolazione generale dei venti e la distribuzione della radiazione solare, e trovò la spiegazione dei monsoni e dei venti alisei - e G. Hadley - il quale estese la teoria di Halley includendovi la rotazione dalla Terra e quindi l'accelerazione di Coriolis. Ma le mappe climatiche a cui tutti siamo ormai abituati, anche se l'interesse con cui vengono guardate varia grandemente, non esistettero sino al secolo scorso, quando Napoleone III affermò che se il grande astronomo francese U. Leverrier era stato in grado di prevedere l'esistenza del pianeta Urano, sarebbe stato certamente capace di prevedere anche le condizioni climatiche in Crimea, dove i Francesi erano impegnati militarmente; affermazione evidentemente infondata, dato che nel 1856 la flotta francese subì nel Mar Nero un'umiliante sconfitta.

In questo secolo due grandi avvenimenti hanno dato alla climatologia un nuovo impulso: l'avvento dei computers, che possono effettuare un miliardo di operazioni al secondo, e quello dei satelliti, che forniscono dati su nuvolosità, temperatura, vapor acqueo, precipitazioni, concentrazione di ozono (O3) e CO2 relativamente a vaste aree e per lunghi periodi di tempo. Allo stesso tempo, l'umanità si è resa conto che il consumo di combustibili fossili (carbone, petrolio, gas naturale) - iniziato con la rivoluzione industriale - innesca reazioni chimiche con l'ossigeno dell'atmosfera generando una notevole quantità di CO2 che si aggiunge al ‛carico' naturale (tanto che esso è passato da un valore di 0,029% nel 1900 a quello attuale di circa 0,035%) potenziando così l'effetto serra naturale e determinando una serie di conseguenze, nessuna delle quali sembra essere particolarmente attraente. È importante sottolineare che nessuno, nella storia documentata dell'umanità, sembra aver suggerito che l'uomo avrebbe potuto diventare una forza capace di influenzare il clima, il quale - come detto all'inizio - implica scale di tempo molto lunghe e quindi generazioni passate e future. Soltanto ai nostri giorni l'umanità ha per la prima volta acquisito la consapevolezza di essere diventata un fattore potenzialmente importante per il clima del nostro pianeta; un fenomeno tanto più serio se si pensa che è irreversibile. Gli studi climatologici - e in particolare la previsione del clima sotto l'azione antropogenica di una popolazione di circa sei miliardi di esseri umani, gran parte dei quali in cerca di un miglioramento delle proprie condizioni di vita e quindi di una quantità sempre maggiore di energia - hanno assunto importanza prioritaria e sono divenuti un obbligo sociale per coloro che hanno gli strumenti e le conoscenze per realizzarli. Ma anche qualora riuscissimo a costruire il modello climatologico più attendibile dal punto di vista dei parametri fisici che abbiamo usato, come possiamo convalidarlo? Aspettare che le previsioni si avverino non è una proposta scientificamente seria né una strategia consigliabile. Non avendo molte scelte, ci si è diretti verso un orizzonte ricco di dati e di grande estensione temporale: la paleoclimatologia.

2. Paleoclimatologia

Cominciamo con una data recente, in senso geologico: 20.000 anni fa. Enormi ghiacciai coprivano tutto il Canada, gran parte degli Stati Uniti, molte regioni dell'Europa, tutta la Svizzera, parte dell'Italia settentrionale e della Germania, nonché parte dell'Argentina e della Nuova Zelanda. Tutto quel ghiaccio si era formato a spese degli oceani, il cui livello era di circa 120 metri più basso di quello attuale. Un totale di circa 28 milioni di km2 di terra era sotto ghiaccio. Da allora, il livello del mare ha continuato a crescere, ma non in modo lineare. Ci sono stati due grandi ‛singhiozzi': circa 14.000 anni fa il livello del mare crebbe a un tasso di 3,7 metri al secolo, e circa 11.000 anni fa esso si alzò a un tasso di 2,5 metri al secolo. Negli altri periodi, la crescita fu di circa mezzo metro al secolo. Se consideriamo il primo ‛singhiozzo' come sintomatico del primo serio scioglimento dei ghiacciai, possiamo concludere che il lungo inverno durò circa 7.000 anni; quando terminò, i ghiacciai ripresero il lento cammino verso il loro habitat naturale, le regioni polari. In questo viaggio lasciarono però dietro di sé cicatrici geologiche ancora visibili: per esempio, le regioni dei grandi laghi negli Stati Uniti. Là dove attualmente fioriscono i ‛granai' americani, gli Stati dello Iowa e del Dakota, c'erano ghiacciai dello spessore di 2 km. La capacità di questi enormi ghiacciai di trascinare grandi macigni rocciosi non fu mai tenuta nel debito conto, e solo nel secolo scorso si cominciò a dubitare che il trasporto di tali massi rocciosi potesse essere attribuito alle alluvioni di cui parla la Bibbia, come voleva la tradizione. Da questa osservazione scaturì una grande rivoluzione scientifica, la ‛teoria delle ere glaciali', la cui data di nascita viene comunemente fatta risalire al 24 luglio 1837, a Neuchâtel in Svizzera, dove si teneva la riunione annuale della Società delle Scienze Naturali. Il presidente di turno, il giovane geologo svizzero Louis Agassiz, sorprese gli scienziati avanzando l'ipotesi che i grandi massi rocciosi del vicino Giura, che apparivano striati, quasi graffiati, da lame finissime e che si trovavano in luoghi assai lontani da dove erano i ghiacciai, fossero una preziosa indicazione del cammino che questi avevano percorso durante una deglaciazione. Si coniò, forse per la prima volta, l'espressione ‛ere glaciali'. Il ‛discorso di Neuchâtel' - così passò alla storia la presentazione di Agassiz - scosse il mondo dei geologi. Il parallelo concettuale con la teoria copernicana, che ‛detronizzò' il geocentrismo e diede inizio all'astronomia moderna, è evidente. Il ribaltamento di semplicistiche spiegazioni bibliche (non prive comunque di una certa plausibilità scientifica) - dall'astronomia di Copernico alla geologia di Agassiz e alla assai più dibattuta teoria di Darwin che sarebbe balzata sulla scena pochi decenni dopo - rappresentano tre casi in cui il sofferto abbandono di spiegazioni diagnostiche, cioè puramente descrittive, aprì il cammino a nuove visioni ricche di potere predittivo, ossia alle teorie prognostiche. Poiché una teoria è scientifica solo se è falsificabile, come ci ha insegnato il filosofo Karl Popper, una teoria puramente descrittiva e senza potere predittivo è, per definizione, non falsificabile e quindi non costituisce una teoria scientifica. Copernico, Agassiz e Darwin hanno invece elaborato teorie veramente scientifiche.

Ma i critici non mancano mai, e la teoria delle glaciazioni fu attaccata dal grande geologo inglese Charles Lyell, il quale nel famoso testo Principî di geologia (1833) sostenne che i grandi macigni rocciosi fossero un tempo congelati in icebergs che poi li trascinarono là dove oggi li ritroviamo nella post-glaciazione. Questa ipotesi - poi chiamata ‛teoria degli spostamenti' - non contraddiceva l'idea di un diluvio universale e risultava assai più accettabile per molti. Lo stesso Darwin, nel diario del 1839 in cui descriveva il suo viaggio a bordo della Beagle, osservò che nei mari del sud esistevano icebergs che contenevano macigni petrosi. Ma fu W. Buckland - uno dei geologi inglesi più rispettati, professore di mineralogia a Oxford e maestro di Lyell - a riconoscere che la teoria di Lyell incontrava difficoltà quanto mai serie, poiché richiedeva, fra le altre cose, un innalzamento del livello del mare di circa un chilometro onde creare l'alluvione necessaria; o forse, ipotizzò qualcun altro, fu l'impatto di una cometa con la Terra e il suo scioglimento a produrre l'allagamento necessario.

A questo sfondo intellettualmente piuttosto conservatore si aggiungeva la difficoltà di immaginare l'esistenza di ghiacciai delle dimensioni richieste dalla teoria di Agassiz. Fu infatti solo nel 1852 che si scoprì che l'intera Groenlandia non è che un grande ghiacciaio. Le spedizioni organizzate da molti paesi, ma soprattutto dagli Stati Uniti e dalla Gran Bretagna (grazie anche al notevole benessere economico creatosi in seguito alla rivoluzione industriale), condussero a una migliore comprensione di quello che è realmente un ghiacciaio. In particolare, si capì che quando un ammasso di neve raggiunge i 100 metri di altezza, il semplice peso trasforma lo strato più basso in ghiaccio, il quale, così compatto, comincia a scivolare, per quanto lentamente, trascinando con sé i detriti incontrati nel suo cammino.

Quarant'anni dopo il discorso di Neuchâtel, il concetto delle ere glaciali era ormai universalmente accettato; rimanevano tuttavia ignote le cause di tale fenomeno, nonché il modo in cui esso era terminato, e il problema del se e quando avrebbe potuto verificarsi di nuovo. Cominciamo con le solite congetture: il Sole è la sorgente dell'energia che fa funzionare il sistema clima; basterebbe quindi postulare che ci sia stata una diminuzione della radiazione solare (a sua volta generata dalle reazioni nucleari che avvengono al centro della stella) di quel tanto che basterebbe per far precipitare la Terra in una glaciazione. Non solo questa ipotesi non sarebbe scienza, ma non avrebbe alcuna base astrofisica, teorica od osservazionale. Basti ricordare che i dati dei satelliti Nimbus 7 e Solar Maximum hanno confermato che la variazione della costante solare (termine che indica l'energia solare ricevuta) è stata solo dello 0,1%. Consideriamo ora il CO2, il gas che attraverso l'effetto serra influenza il clima; anche in questo caso bisognerebbe postulare fluttuazioni del CO2 totalmente ad hoc. C'è poi l'ipotesi che chiama in causa le esplosioni vulcaniche: com'è noto, fu B. Franklin il primo che, in una pubblicazione del 1784 (quando era ambasciatore americano in Francia) suggerì la connessione clima-vulcani; quando un vulcano esplode, il fine pulviscolo emesso nell'atmosfera blocca la radiazione solare, causando così un raffreddamento. Nell'aprile del 1815 ci fu l'eruzione del vulcano Tambora in Indonesia, che emise ben 50 km3 di magma e 100 megatonnellate di polvere solforosa; nella regione la temperatura si abbassò di 1 °C e l'anno 1816 passò alla storia come ‛l'anno senza estate'. Se si postula che la frequenza di tali eruzioni sia stata maggiore nel passato, le risultanti polveri vulcaniche dovrebbero essere rinvenute nei ghiacciai, nel fango dei fondi lagunari e nei sedimenti oceanici; gli studi di sedimentologia dovrebbero insomma essere in grado di darci una risposta, ma finora questo non è avvenuto.

Nel 1842, lo scienziato francese A. J. Adhemar fu il primo a suggerire che la causa delle glaciazioni fosse da ricercarsi nelle variazioni del moto della Terra attorno al Sole: non si trattava quindi di un fenomeno postulato ad hoc, ma, se provato, era una conseguenza necessaria. Keplero aveva precedentemente dimostrato che la traiettoria della Terra attorno al Sole non ha la forma di un cerchio (la figura prediletta dai filosofi greci), ma quella assai meno poetica di un'ellisse, il cui grado di eccentricità varia nel tempo, fluttuando dal massimo al minimo in circa 100.000 anni. Al variare dell'eccentricità, varia la distanza media dal Sole e quindi anche l'intensità della radiazione solare ricevuta. Inoltre, la Terra ruota su se stessa e l'asse di tale rotazione è oggi inclinato di circa 23° rispetto alla perpendicolare al piano dell'orbita; ciò causa le stagioni. Oggi, nell'emisfero nord è inverno nel periodo di perielio (punto dell'orbita più vicino al Sole), ma con un'inclinazione in verso opposto al Sole; è invece estate quando la Terra è all'afelio (punto dell'orbita di massima distanza dal Sole), ma con l'inclinazione verso il Sole. All'afelio, la distanza Terra-Sole è di circa 5 milioni di km maggiore che al perielio. Ma già gli astronomi dell'antichità, specialmente Ipparco (120 a. C.), avevano concluso che l'asse di rotazione della Terra non è fisso: oggi punta verso la stella polare (nella costellazione dell'Orsa Minore), ma nel 2000 a. C. era orientato in direzione di un punto intermedio fra l'Orsa Minore e l'Orsa Maggiore, mentre nel 4000 a. C. puntava direttamente verso l'Orsa Maggiore. La Terra è una trottola che oscilla con un periodo di 23.000 anni (il cosiddetto ‛fenomeno della nutazione') e pertanto 11.500 anni fa, al perielio, la Terra non solo era vicina al Sole, ma il suo asse era rivolto verso di esso (un'estate ‛maggiorata'), mentre all'afelio essa si trovava sia lontana dal Sole sia con l'asse inclinato lontano da esso (quindi un inverno più rigido). Occorre in ultimo considerare che tale inclinazione di 23° non è costante: varia da 21,8° a 24,4°, con un periodo di 41.000 anni. Ci sono quindi tre ‛battiti orbitali', vale a dire precessione degli equinozi (23.000 anni), obliquità (41.000 anni) ed eccentricità (100.000 anni). Il matematico serbo M. Milankovič elaborò il primo modello quantitativo della teoria astronomica delle glaciazioni. Il suo eroico programma di lavoro (‟sotto l'incantesimo dell'infinito e con la prospettiva di un problema cosmico", come ebbe a dire) si articolava in quattro punti, relativi il primo alla variazione temporale dei tre ‛battiti orbitali' nell'ultimo milione di anni (per sua fortuna, tale calcolo era già stato fatto dal matematico tedesco L. Pilgrim). Il secondo punto riguardava la variazione della radiazione solare incidente sul pianeta nello stesso periodo di tempo; poiché detta variazione dipende da due fattori geometrici, la distanza dal Sole e l'angolo di incidenza della radiazione, si doveva scegliere una latitudine appropriata. Seguendo i suggerimenti del meteorologo tedesco W. Kopper e dopo ‟cento giorni di calcoli dall'alba al tramonto", nel 1924 Milankovič presentò in un grafico la variazione nel tempo della radiazione solare per tre latitudini, 55°, 60° e 65° N. Il grafico indicava nove minimi che erano eccellenti candidati per l'esistenza di glaciazioni; in effetti, l'accordo fra le previsioni e i dati noti a quel tempo risultò essere più che soddisfacente. Una nota storica: nel settembre del 1924 fu A. Wegener, il padre della teoria della deriva dei continenti, a presentare in una conferenza tenutasi a Innsbruck - si racconta con notevole entusiasmo - i risultati della nuova teoria di Milankovič, il quale quella notte ‟dormì in un letto di allori e su soffici cuscini", mentre nei giorni che seguirono ‟visitò tutti i pubs di Innsbruck" con un compagno di scuola. Era passato meno di un secolo dal discorso di Neuchâtel. Rimanevano ancora due dei quattro temi da esplorare: come variano i tre ‛battiti orbitali' in funzione della latitudine e come rispondono i ghiacciai ai cambi di radiazione solare. Per risolvere il terzo compito, Milankovič calcolò la variazione dell'intensità solare a 15°, 45° e 75° di latitudine N, ottenendo risultati molto interessanti: la precessione degli equinozi è più importante all'equatore che ai poli, mentre succede l'opposto per il ciclo di 41.000 anni. L'ultimo tema venne risolto con la formulazione di una relazione matematica che connette l'aumento della superficie nevosa con la variazione della radiazione solare estiva. Il suo testamento scientifico, Canone dell'insolazione e problema delle glaciazioni, era sul punto di essere pubblicato quando, il 6 aprile del 1941, la Germania invase la Iugoslavia. Altre due memorie apparvero nel 1952 e nel 1957, l'anno prima della morte di Milankovič.

Fino al 1950 circa, la teoria di Milankovič venne accettata dalla grande maggioranza dei geologi, i quali conclusero che durante il Quaternario (gli ultimi due milioni di anni, divisi in Pleistocene e Olocene, ove quest'ultimo rappresenta gli ultimi 100.000 anni) erano avvenute quattro, forse cinque, glaciazioni, in accordo qualitativo con le previsioni della nuova teoria la quale prevedeva nove minimi: gli ultimi tre apparivano come un ‛tripletto', mentre i sei rimanenti erano divisi in tre ‛doppietti'. Stava però avvenendo qualcosa di nuovo.

3. Le datazioni con radioisotopi

Agli inizi degli anni cinquanta, l'americano W. L. Libby scoprì un nuovo metodo di datazione basato sul radiocarbonio 14C, un isotopo radioattivo del carbonio, che viene prodotto in quantità minime nella collisione dei raggi cosmici con le molecole di azoto dell'atmosfera. L'1% del carbonio nella vegetazione è 14C; questo, che ha una vita media di 5.730 anni, decade producendo in media 15 disintegrazioni per grammo di C al minuto. Quando la vegetazione muore, cessa l'assorbimento di CO2 dall'atmosfera e quindi anche del 14C. Libby suggerì che tale fenomeno potesse offrire un eccellente orologio naturale per datare l'origine di un fossile: bastava misurare la proporzione del 14C ancora presente nel fossile; l'unica limitazione consisteva nel fatto che non si possono datare fossili con un'età superiore ai 40.000 anni. Il metodo venne rapidamente applicato a una grande varietà di fossili con risultati molto interessanti: risultò che l'ultima glaciazione aveva raggiunto il suo massimo 18.000 anni fa ed era terminata quasi completamente 10.000 anni fa. I nuovi dati indicavano anche che 72.000 anni fa i ghiacciai erano troppo a nord (Quebec) perché si fosse verificata una glaciazione, prevista invece dalla teoria di Milankovič; inoltre, si concluse - anche in questo caso diversamente da quanto ipotizzato da Milankovič - che altre glaciazioni erano avvenute 40.000 e 60.000 anni fa, quando i ghiacciai erano arrivati a coprire gli Stati dell'Indiana e dell'Ohio. Verso il 1965, l'interesse nella teoria astronomica raggiunse il suo minimo storico.

Iniziava così un nuovo periodo di ricerca. Invece di usare fossili di superficie, si analizzarono fossili ricavati dai fondi marini. Tutto iniziò con la spedizione inglese della nave H. M. S. Challenger, che solcò gli oceani dal 1872 al 1875 riportando in patria una quantità tale di materiale da analizzare che il resoconto finale richiese ben 50 volumi. Di speciale interesse per la climatologia fu la scoperta che una certa specie di Foraminiferi vive solo in acque calde, mentre un'altra specie vive esclusivamente in acque fredde: una separazione così netta e naturale poteva venir immediatamente utilizzata per studiare fenomeni climatici basandosi sull'analisi di sequenze di sedimenti marini. I Foraminiferi sono organismi marini unicellulari che abitano in gusci fatti di carbonato di calcio, CaCO3; quando muoiono, si depositano sul fondo del mare diventando sedimenti marini e il CaCO3 dei loro gusci mantiene le caratteristiche dell'acqua in cui abitarono. Dopo il 1947, in seguito alla scoperta dello svedese B. Kullenberg di un nuovo pistone che permetteva di effettuare carotaggi di lunghezza fino a 10-15 metri, si aprì una nuova era di studi. Si scoprì, per esempio, che nell'Oceano Pacifico il tasso di sedimentazione non è superiore a l mm al secolo, il che permette di studiare l'intero Pleistocene con carotaggi relativamente corti, mentre nell'Oceano Atlantico il tasso è di 3 mm al secolo. I primi risultati vennero annunciati nel 1953 da F. B. Phleger, F. L. Parker e J. F. Peirson della Scripps Institution of Oceanography (California): usando 39 carotaggi di Kullenberg, si concluse che nel Pleistocene c'erano state nove glaciazioni. Studi dello stesso tipo, condotti presso la Columbia University a New York da D. B. Ericson, W. S. Broeker, J. L. Kulp e G. Wollin, portarono alla conclusione che l'ultima glaciazione ebbe termine 11.000 anni fa, in ottimo accordo con i dati ottenuti con il metodo del radiocarbonio. Nello stesso periodo, all'Università di Chicago (dove si trovava anche Libby), uno scienziato italiano, Cesare Emiliani (v., 1955), applicava alla paleoclimatologia un nuovo metodo di datazione basato sulla composizione isotopica dell'acqua del mare; tale metodo era stato originariamente suggerito da H. C. Urey, lo scienziato che aveva scoperto l'idrogeno pesante (deuterio). L'acqua degli oceani, e così anche i gusci in cui vivono certi organismi marini, contiene due isotopi dell'ossigeno, 18O e 16O; l'isotopo 18O è leggermente più pesante del 16O (due neutroni in più nel suo nucleo) che è di gran lunga il più abbondante, e per tale differenza di peso, l'acqua con più alta percentuale di 18O precipita più facilmente di quella ricca di 16O; analogamente, acqua ricca di 16O evapora più facilmente di quella ricca di 18O. L'acqua che evapora tende poi a formare neve e ghiaccio; più ghiaccio si forma, più 16O viene sottratto agli oceani e immagazzinato in ghiaccio. Durante un'era glaciale gli oceani hanno quindi una più alta concentrazione di 18O, cioè un alto rapporto 18O/16O, e così pure i fossili marini; pertanto, un alto rapporto 18O/16O in tali fossili implica basse temperature e quindi glaciazioni. I risultati più salienti di Emiliani, pubblicati nel 1955, si possono riassumere in tre punti: negli ultimi 300.000 anni ci sono state sette glaciazioni complete, durante le quali la temperatura nei Caraibi era di 6 °C più bassa di quella attuale e tali dati risultano in accordo qualitativo con la teoria astronomica. Tali conclusioni non erano però in accordo con i risultati ottenuti da D. B. Ericson sulla base dei Foraminiferi. I due metodi vengono spesso chiamati ‛termometro menardii' (dal nome Globorotalia menardii del foraminifero usato nell'analisi) e ‛termometro isotopico'. Dov'era l'errore? La diatriba fra Emiliani ed Ericson durò a lungo e destò grande interesse nel campo della paleoclimatologia. I risultati ottenuti dall'americano J. Imbrie nel 1969 dimostrarono che ambedue le metodologie avevano trascurato importanti fattori, tipo la salinità dell'acqua e la situazione ambientale, e che le necessarie correzioni portavano a concludere che le temperature si erano abbassate di soli 2 °C invece dei 6 °C previsti da Emiliani; ma il risultato più importante fu che il metodo di Emiliani, invece di misurare variazioni di temperatura (troppo piccole per essere rilevate in modo attendibile), permetteva in realtà di misurare la variazioni temporali del volume dei ghiacciai ed era quindi di grande valore per gli studi paleoclimatici.

Era forse necessario un altro orologio capace di risalire maggiormente nel tempo, al di là dei 40.000 anni del 14C? Nel 1965, Broecker iniziò ad applicare alla paleoclimatologia un nuovo metodo di datazione, suggerito nel 1956 da J. W. Barnes dei laboratori di Los Alamos, basato sul decadimento del torio. Usando fossili estratti dalle Bahamas e in Florida, il gruppo di Broecker dedusse che 120.000 anni fa il livello del mare era di 6 m più alto di oggi e che 80.000 anni fa si era verificata una situazione analoga. Il punto più importante era che estendendo le ricerche più indietro nel tempo si erano ottenuti risultati in ragionevole accordo con la teoria astronomica.

Rinasceva Milankovič? I risultati indicavano che negli ultimi 400.000 anni si erano verificate sei glaciazioni con una periodicità di circa 100.000 anni, ma che non c'era simmetria fra prima e dopo: periodi di espansione glaciale della durata di circa 100.000 anni terminavano in modo assai brusco. Il geologo cecoslovacco G. Kukla era arrivato indipendentemente allo stesso risultato: le glaciazioni avvengono lentamente ma spariscono rapidamente. Per coordinare gli sforzi che si stavano facendo in vari laboratori, il 1° maggio del 1971 si creò il CLIMAP, un progetto il cui obiettivo primario era quello di ricostruire quella che era stata la storia degli Oceani Atlantico e Pacifico negli ultimi 700.000 anni, un intervallo di tempo chiamato periodo Brunhes in onore del geofisico francese che nel 1906 aveva scoperto l'inversione di polarità del campo magnetico terrestre. Al progetto CLIMAP parteciparono, oltre agli Stati Uniti, sette paesi europei, con più di cento scienziati. Data la predominanza del ‛pulso climatico' di 100.000 anni, sarebbe stato possibile rivelare gli altri due ‛battiti' di 23.000 e 41.000 anni, o questi sarebbero stati schermati dal rumore di fondo? Si dovette applicare una tecnica di analisi nota come analisi spettrale (impiegata per esempio nello studio delle note che emette una corda di violino) e i risultati furono quanto mai soddisfacenti. In un lavoro apparso nella rivista americana ‟Science" nel dicembre del 1976, J. D. Hays, J. Imbrie e N. J. Shackleton confermarono i tre famosi battiti della teoria di Milankovič. La conclusione degli autori fu: ‟I cambi nella geometria dell'orbita della Terra sono le cause fondamentali delle ere glaciali che si sono succedute nel Quaternario". Il titolo di questa famosa pubblicazione, Variazioni nell'orbita della Terra, pacemaker delle glaciazioni, è assai indicativo. Erano passati 130 anni dal suggerimento di Adhemar.

4. Gli oceani

Ma come succede spesso nella scienza, c'era qualcosa che non quadrava ancora. Perché mai il ‛battito' di 100.000 anni risultava essere il modo fondamentale di funzionamento quando in realtà il suo effetto sulla insolazione stagionale era inferiore a quello degli altri due battiti? Inoltre, i cicli astronomici iniziano e decadono in modo continuo, mentre le glaciazioni non sono affatto simmetriche. E neppure si può pensare che l'emisfero nord determini in modo causale le glaciazioni nell'emisfero sud, poiché è stato ampiamente documentato che durante una glaciazione i ghiacciai si formano e scompaiono in modo sincrono nel nord e nel sud. Ma come può allora un cambio stagionale, per esempio in Islanda, aver causato una glaciazione in Nuova Zelanda o nell'Antartide? Quale possibile meccanismo lega due eventi tanto separati spazialmente? Si incominciò a far luce su tali questioni quando gli scienziati C. Lorius e H. Oeschger con una serie di carotaggi misurarono l'ammontare di CO2 dell'Antartico, ossia in un ghiaccio antico che contiene nei suoi interstizi aria antica. Ne risultò che durante l'ultima glaciazione il CO2 era assai basso: i conti ci dicono che ammontava a 2/3 di quello attuale. Se andiamo più indietro nel tempo, si può notare un singolare sincronismo fra il comportamento della temperatura e quello del CO2. Poiché le variazioni del CO2 sono assai cospicue e poiché gli oceani contengono una quantità di CO2 60 volte superiore a quella dell'atmosfera (approssimativamente, 700 miliardi di tonnellate nell'atmosfera e 40.000 negli oceani), tali dati indicavano in modo inequivocabile che qualcosa mancava ancora nello scenario generale: gli oceani. Per capire il ruolo di questi ultimi, ricordiamo anzitutto che c'è una considerevole disparità fra l'energia assorbita e quella emessa all'equatore e nelle regioni nordiche: nel primo caso, l'energia assorbita è maggiore di quella emessa, mentre nel secondo avviene il contrario. A prima vista, questo sembrerebbe implicare un continuo riscaldamento delle regioni equatoriali e un continuo raffreddamento di quelle polari, il che chiaramente non succede. Ciò si deve al fatto che gli oceani (e l'atmosfera) trasportano calore dall'equatore ai poli, aiutando così a equilibrare la disparità termica delle due regioni. La corrente oceanica, che si forma nelle regioni equatoriali, sale fino all'Islanda dove si imbatte nei venti gelidi provenienti dal Canada. Qui, accadono due fatti: primo, tale incontro tempera l'effetto deleterio che tali venti gelidi avrebbero sul Nordeuropa; secondo, l'acqua, nel cedere parte del suo contenuto termico all'aria, si raffredda e perciò si raddensa e tende ad affondare, dando luogo a una corrente sotterranea fredda. Il calore così rilasciato corrisponde a circa il 30% del calore ricevuto dal Sole in quelle regioni, e proprio questo ‛calore extra' è la ragione per cui il Nordeuropa gode di un clima mite, mentre alla stessa latitudine di Londra in Canada si aggirano le renne. Il fenomeno che avviene in Islanda è accompagnato da evaporazione, il che significa che l'acqua rimanente è più salata e quindi più densa, e ciò contribuisce ulteriormente al suo affondamento. Bisogna notare che la salinità è di gran lunga più efficace nel ‛raddensare' l'acqua del raffreddamento: un aumento dello 0,1% della salinità porta a un aumento della densità dell'acqua pari a un abbassamento di 7 °C. Ci troviamo quindi di fronte a una sorta di grande ‛trasportatore a nastro', una corrente fredda e salata che, nata nei mari del nord, si snoda negli oceani visitandoli tutti, compiendo un viaggio della durata di circa 1.000 anni. La portata di tale corrente è equivalente a più di 20 volte la portata di tutti i fiumi del mondo: nel Nordatlantico, si tratta di circa 15 milioni di metri cubi al secondo, che equivale alla portata che avrebbero circa 100 Rio delle Amazzoni. Questo trasportatore non è stato però sempre attivo, e ciò rappresenta un punto chiave. Come conosciamo il suo passato? Si è scoperto che negli oceani la distribuzione dell'elemento cadmio è, per ragioni ancora sconosciute, simile a quella dei fosfati e dei nitrati, che sono nutrienti marini; poiché uno ione cadmio ha carica e dimensioni uguali a quelle di uno ione calcio, è probabile che il cadmio abbia sostituito il calcio nella formazione di carbonato di calcio che, come abbiamo visto, forma i gusci dei Foraminiferi. Nello snodarsi attraverso gli oceani, il nastro trascina con sé i fosfati e i nitrati che stanno precipitando verso gli abissi marini, creando così un gradiente nella distribuzione verticale di tali elementi. Misurando il contenuto di cadmio, l'americano E. A. Boyle scoprì con sua grande sorpresa che durante l'ultima glaciazione tali gradienti erano molto ridotti, il che indica che il nastro rimescolatore non era in funzione, era ‛morto'. Quando, 12.000 anni fa, uscimmo dalla glaciazione, il nastro ritornò a circolare negli oceani, il che ci spiega in modo assai naturale il sincronismo di cui abbiamo parlato in precedenza. Durante le glaciazioni, il nastro era inattivo e quindi non portava alla superficie il CO2 che si trova sul fondo dei mari: il fitoplancton, che assorbe CO2 attraverso la fotosintesi, operava quindi indisturbato. Ne consegue che quando la temperatura è bassa, lo è anche il CO2. Quando il nastro è attivo, l'efficienza del fitoplancton nel ridurre il CO2 è assai ridotta, poiché per quanto CO2 assorba, ce n'è sempre di nuovo riportato in superficie dai fondi marini. Ecco quindi come si ritiene si intreccino gli eventi: l'atmosfera, che è certamente influenzata dai cambi stagionali di insolazione, a sua volta influenza gli oceani; il ponte fra i due, è il sale. I venti nelle regioni nordiche trasportano l'acqua evaporata dagli oceani da una parte all'altra, dove poi precipita come pioggia, cioè acqua dolce. Tale trasporto ha come effetto quello di arricchire la salinità della regione di partenza e di impoverire la regione di arrivo, il che influenza la portata del nastro oceanico. Quindi, un cambio graduale della circolazione atmosferica produce un cambio nella salinità, il che a sua volta altera il comportamento del nastro.

Gli esperti di polline ci dicono altresì che in seguito alla ‛resurrezione' del nastro oceanico dopo l'ultima glaciazione, nel giro di 100 anni avvenne un fatto singolare: il nastro si spense di nuovo, precipitando la Terra in una subitanea era glaciale. Infatti, quelle regioni nordiche che avevano cominciato a popolarsi di foreste tornarono a essere coperte soltanto da praterie e arbusti, il più conosciuto dei quali è un fiore noto come Dryas, che ha poi finito col dare il nome a questo fenomeno. L'abbassamento della temperatura fu di ben 6 °C. Questo improvviso inverno durò circa 1.000 anni, ma nel giro di 30 anni finì, come ci hanno dimostrato gli studi dello scienziato danese W. Dansgaard. Chi ferì a morte il nastro? Fu probabilmente un massiccio influsso di acqua dolce originatosi dallo scioglimento dei ghiacciai del Nordamerica, che cominciò 14.000 anni fa e che durò circa 7.000 anni. Tale flusso, paragonabile a quello del Rio delle Amazzoni, era inizialmente diretto al golfo del Messico per il tramite del fiume Mississippi. Durante questo periodo, infatti le misurazioni del contenuto di 18O delle acque del golfo hanno dato valori di gran lunga inferiori a quello di 16O, indicazione chiara della presenza di acqua dolce ricca di 16O. Bruscamente, 11.000 anni fa successe qualcosa, perché il livello di 18O crebbe indicando che era finito l'afflusso di acqua dolce; tale flusso cambiò rotta e invece di dirigersi al sud, si incanalò nel fiume San Lorenzo che lo portò all'Oceano Atlantico dove, abbassando la salinità, finì con lo spegnere il nastro.

Abbiamo descritto un intreccio di fenomeni, di indizi sospetti, di impronte digitali, una tela di ragno con causazioni che agiscono in tutte le direzioni. I climatologi moderni sono archeologi e futuristi al tempo stesso: dalla lettura del polline di 10.000 anni fa, a quella dei sedimenti marini, a quella dell'aria di 160 mila anni fa, cercano di tessere un quadro coerente onde identificare le cause e quantificare gli effetti. Impresa ardua da cui può dipendere la futura gestione del nostro pianeta. Gli oceani, termostato del nostro clima, dimostrano una personalità assai più irta e capricciosa di quanto pensassimo; sollecitati da forze esterne, essi non reagiscono in modo docile, e quindi non possiamo cullarci nell'illusione che il clima futuro sia solo gradualmente diverso da quello di ieri. Tutto ciò appartiene alla mistica screditata del gradualismo. Oggi ci sono forti indizi che quando le sollecitazioni esterne raggiungono una certa soglia, il sistema scatta in modo brusco da uno stato a un altro, come un elettrone quantizzato in un atomo: un fenomeno che abbiamo accettato su scala microscopica ma che inconsciamente respingiamo su scala globale, e tale reticenza è forse il problema più grande. Chi sosteneva che natura non facit saltus, non conosceva il grande salto che occorse 11.000 anni fa.

5. L'effetto serra

Contrariamente a quanto si pensa, l'effetto serra non è una scoperta recente; già nel 1827, infatti, il matematico J. B. Fourier scriveva: ‟Il problema delle temperature globali, uno dei più importanti e difficili di tutta la filosofia naturale, si compone di elementi alquanto diversi che dovrebbero essere considerati da un unico punto di vista generale". Se allo stesso Fourier è stata attribuita la paternità dell'espressione ‛effetto serra' (effet de serre), tuttavia per le prime stime concrete di tale fenomeno si dovette attendere il 1896, anno in cui il chimico svedese S. Arrhenius calcolò che se fosse raddoppiato il tenore in CO2 dell'atmosfera si sarebbe avuto un aumento globale della temperatura media di 5 °C - risultato abbastanza vicino a quello odierno. È interessante osservare che nel suo libro World in the making, pubblicato nel 1906, Arrhenius perveniva a una conclusione ottimistica, affermando che questo aumento della temperatura avrebbe comportato un miglioramento del clima e raccolti più abbondanti. Se l'ipotesi dello studioso svedese si sarebbe rivelata esatta per le regioni del mondo alle alte latitudini, egli tuttavia non poteva immaginare che lo stesso fenomeno avrebbe avuto un impatto negativo sulle aree più povere della Terra, peggiorando le loro già precarie condizioni di vita. Del problema si occuparono anche altri autori, in particolare T. C. Chamberlain nel 1899 e S. G. Calander nel 1938, nel 1940 e infine nel 1949, anno in cui pubblicò il saggio intitolato Può il CO2 influenzare il clima? Tutte queste analisi non prendevano tuttavia in considerazione due elementi importanti: il fatto che gli oceani assorbono circa la metà di tutte le emissioni di CO2, e il ruolo dei meccanismi di feedback (sia positivo che negativo), i quali rendono il problema assai più arduo da quantificare. L'idea che l'effetto serra potesse non avere effetti benefici per tutti faticò comunque ad affermarsi. Ancora nel 1957, in quello che viene considerato a buon diritto un saggio fondamentale in questo campo di studi, R. Revelle e H. E. Suess, della Scripps Institution, osservarono che il genere umano va conducendo un esperimento geofisico senza precedenti ‟che non avrebbe potuto essere realizzato in passato né potrà essere riprodotto in futuro. Nel giro di pochi secoli stiamo restituendo all'atmosfera e agli oceani il carbonio organico immagazzinato nelle rocce sedimentarie nel corso di centinaia di milioni di anni" (v. Revelle e Suess, 1957). L'esperimento in questione, ovviamente, è quello iniziato con la rivoluzione industriale, ossia con l'uso di combustibile fossile per produrre energia, un processo che comporta un aumento della concentrazione di CO2 nell'atmosfera. Come si sa, tanto gli oceani quanto la vegetazione scambiano enormi quantità di carbonio (l'unità di misura è la gigatonnellata, Gt, equivalente a un miliardo di tonnellate) attraverso la fotosintesi e l'evapo-traspirazione. Il carbonio depositatosi nel corso di milioni di anni nei siti geologici sotto forma di carbone, petrolio e gas naturale è estratto dall'uomo, ma il ciclo non è chiuso: i 5-6 miliardi di t di C all'anno costituiscono una delle principali fonti di preoccupazione per un effetto serra di origine antropica. Un'importante conclusione del saggio di Revelle e Suess era che il ciclo di vita di una molecola di CO2 tra l'atmosfera e gli oceani è di circa dieci anni - un periodo molto breve. Ciò significa che la maggior parte della quantità di CO2 immessa nell'atmosfera dalla metà dell'Ottocento (ossia dall'inizio della rivoluzione industriale), è già stata assorbita dagli oceani, cosa altamente positiva.

I processi fisici che sono alla base dell'effetto serra sono abbastanza semplici e hanno ben poco in comune con quelli che si verificano nelle serre vere e proprie, la cui principale funzione è quella di evitare la dispersione del calore da parte del vento. La radiazione solare che raggiunge la Terra (di cui il 30% viene riflesso nello spazio; è il fenomeno della cosiddetta riflessività o albedo) non viene arrestata dall'atmosfera. Raffreddandosi, la Terra emette radiazione (raggi infrarossi) di lunghezza d'onda assai superiore a quella della radiazione incidente; poiché alcuni dei gas che compongono l'atmosfera terrestre, H2O (vapore acqueo), O3 (ozono), CO2, N2O (protossido di azoto) e CH4 (metano) possiedono stati rotazionali e vibrazionali esattamente a quelle frequenze, la radiazione viene in tal modo trattenuta e quando viene riemessa solo una frazione si perde nello spazio, mentre il resto viene rinviato verso la Terra. Ciò forma una coltre naturale che mantiene più alta la temperatura.

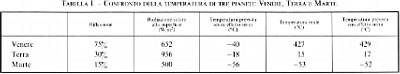

L'effetto serra naturale ha permesso al nostro pianeta di avere una temperatura media sui 18 °C, mentre su Venere, per es., essa è di 430 °C (una temperatura alla quale si fonde il piombo). Per capire l'importanza di tale effetto, nella tab. I riportiamo i dati relativi alla Terra, a Venere e a Marte. Senza l'effetto serra naturale, le temperature previste si aggirerebbero sui -40 °C, -18 °C e -56 °C, rispettivamente; ma salta subito agli occhi l'estrema somiglianza delle ultime due colonne, a conferma dell'importanza dell'effetto serra naturale senza il quale non ci sarebbe vita sulla Terra, poiché a una temperatura permanentemente di -18 °C non è concepibile alcuno sviluppo biologico. Sul nostro pianeta, l'effetto serra è quindi responsabile di un incremento della temperatura superiore ai 30 °C. La discrepanza è ancora maggiore nel caso di Venere, più vicino al Sole, dove senza effetto serra si avrebbero -40 °C, mentre in realtà si misurano 427 °C. Come si spiega questa enorme differenza, se in effetti la diversa radiazione solare ricevuta su Venere non è tale da causare una temperatura così diversa da quella della Terra? La ragione è che mentre sulla Terra il CO2 ammonta solo allo 0,035%, su Venere è quasi il 98%, determinando quindi un incontrollabile effetto serra. È chiaro dunque che i processi di origine antropica responsabili dell'aumento di CO2 nell'atmosfera potrebbero determinare nel nostro pianeta una situazione analoga a quella di Venere. I due gas che hanno il ruolo più importante nell'effetto di riscaldamento sono il vapore acqueo e il CO2. Tutto il calore trattenuto (misurato in watt per metro quadro) è ascrivibile per 2/3 al vapore acqueo, e solo per 1/3 al CO2. Abbiamo già accennato al fatto che il CO2 rappresenta solo lo 0,035% (350 ppm, parti per milione), l'ossigeno il 21% e l'azoto il 78% (in volume), il che vuol dire che insieme rappresentano già il 99%, mentre l'argo costituisce il restante 1% dell'atmosfera.

Dal 1958 C. D. Keeling ha installato due stazioni di misurazione, una nelle Hawaii, sul Mauna Loa (4.170 m sopra il livello del mare) e l'altra al Polo Sud, ponendo in tal modo le basi per lo studio delle perturbazioni del clima terrestre di origine antropica. La cosiddetta ‛curva di Keeling' mostra un aumento costante del CO2 nell'atmosfera: dall'epoca preindustriale, la concentrazione di CO2 è aumentata del 25%, passando da 280 ppm a 350 ppm, e il 50% di tale incremento si è registrato negli ultimi trent'anni; attualmente, il tasso di incremento è di 0,5% all'anno. È stato calcolato che circa 5-6 Gt per anno di C sono prodotte dai combustibili fossili, ossia carbone, petrolio e gas naturale; a ciò va aggiunto quello prodotto dalla deforestazione e dagli incendi delle foreste tropicali, che ammonta a 2 Gt all'anno, per un valore complessivo di 7 Gt annui. Il contributo della deforestazione è peraltro piuttosto incerto: le stime indicano valori compresi tra un massimo di 2 e un minimo di 0,6 Gt per anno. L'ammontare equivalente di CO2 si ottiene moltiplicando per 44/12.

Prima di esaminare alcune previsioni su un possibile effetto serra di origine antropica, occorre sottolineare il fatto che il CO2 non è l'unico gas a trattenere il calore che altrimenti si disperderebbe nello spazio; esistono altri gas responsabili dell'effetto serra. In effetti, sulla base di un confronto diretto tra molecole di diversi gas, il CO2 risulta essere il gas con effetto più debole; quello del CH4 è 30 volte più forte, quello di N2O 200 volte più forte e i ben noti CFC, i clorofluorocarburi, hanno effetto circa 20.000 volte più forte. Il motivo per cui ciascuno di questi gas preso separatamente ha un'incidenza minore rispetto al CO2 è dato dalla loro concentrazione assai più bassa. Le principali fonti di CH4 sono i terreni paludosi (25-170 Tg annui; 1 Tg o teragrammo = 1012 grammi), le risaie (40-170 Tg), la fermentazione del concime organico (40-110 Tg), la combustione della biomassa (30-110 Tg), la produzione e la distribuzione di gas naturale (20-50 Tg), l'estrazione del carbone (10-40 Tg) e le termiti (5-45 Tg), per un totale complessivo di 0,2-0,8 Gt annue, e un incremento dello 0,6% annuo. Quanto agli ossidi d'azoto, l'emissione totale è stimata sui 7,8-25,3 Tg annui. Consideriamo, infine, i CFC: si tratta di composti artificiali - le cui emissioni sono stimate intorno ai 0,33 Tg annui - che vennero scoperti nel 1928 dall'americano T. Midgley Jr., un chimico impiegato alla General Motors. È una storia triste e interessante al tempo stesso. Nel 1922 egli scoprì il piombo tetraetile, usato come additivo per carburanti, che si rivelò decisivo per il boom dell'industria automobilistica. Molti anni più tardi risultò peraltro che queste sostanze hanno effetti nocivi, e per questo motivo si è passati alla benzina senza piombo. I clorofluorocarburi scoperti da Midgley erano di fatto sostanze chimiche ‛miracolose' per i processi di refrigerazione, e per molti anni furono comprensibilmente considerati un grande successo industriale. Nel 1974 due chimici, S. Rowland e M. Molina, in un articolo pubblicato su ‟Nature" dimostrarono che il cloro dei clorofluorocarburi può agire da catalizzatore in una serie di reazione chimiche e fotochimiche, O3 + Cl → ClO + O2, O3 hν→ O2 + O, O + ClO → O2 + Cl. Il risultato è che due molecole di ozono vengono distrutte: 2O3 → 3O2. Inoltre, ogni atomo di cloro può distruggere sino a 1.000-10.000 molecole di O3 prima di diventare inattivo (v. Molina e Rowland, 1974). La previsione teorica dei due autori - per la quale sono stati insigniti del premio Nobel per la chimica nel 1995 - dovette aspettare parecchi anni prima di trovare una conferma sperimentale peraltro clamorosa.

Nel 1985 tre scienziati britannici, J. C. Farman, B. G. Gardiner e J. D. Shankin, annunciarono in un articolo pubblicato su ‟Nature" la scoperta di un ‛buco nell'ozono' nella regione antartica (v. Farman e altri, 1985). I tre studiosi avevano misurato per molti anni i livelli di ozono come parte del progetto British Antartic Survey, constatando già nel 1981 una sua diminuzione sull'Antartide (base di Halley Bay); essi pensarono tuttavia che si trattasse di un errore dovuto all'usura dello strumento di rilevazione, e decisero di non divulgare questi dati. Ma dalle rilevazioni ottenute con un nuovo spettrofotometro risultò una diminuzione del 50% nel contenuto di ozono, dato che costituiva una significativa conferma empirica dell'ipotesi teorica formulata undici anni prima da Rowland e Molina; l'effetto, inoltre, era di proporzioni di gran lunga maggiori di quelle previste dai modelli puramente chimici, in quanto le particolari condizioni climatiche della regione antartica potenziano notevolmente l'efficienza dei processi chimici alla base del fenomeno. Questa scoperta destò un comprensibile allarme, in quanto le molecole di ozono proteggono la Terra dalla radiazione ultravioletta che può creare gravi danni alla salute, come tumori della pelle, cataratte, immunodeficienze, ecc. Midgley si suicidò nel 1944 dopo che gli era stata diagnosticata una poliomielite, ma gli fu perlomeno risparmiata l'amara consapevolezza che la sua scoperta più brillante - che aveva reso l'aria condizionata e la refrigerazione beni di largo consumo e aveva creato un giro d'affari di miliardi di dollari - aveva un effetto così nocivo sull'ambiente.

I clorofluorocarburi si sono rivelati dunque doppiamente dannosi: non solo sono tra i gas responsabili dell'effetto serra, ma impoveriscono lo strato d'ozono. Per questo motivo sono stati oggetto di particolare attenzione da parte dei legislatori di diversi paesi, i quali nel Protocollo di Montreal (firmato nel settembre del 1987 e ratificato nel gennaio dell'anno successivo) si sono impegnati a ridurre gradualmente la produzione e il consumo di tali sostanze sino al loro dimezzamento entro il 1999. Nel 1989, con la Dichiarazione di Helsinki, 80 Stati firmatari hanno concordato il ritiro completo dei CFC entro il 2000. Nel 1985 clorofluorocarburi, N2O e CH4 contribuivano al surriscaldamento del clima nella stessa misura del CO2; ciò significa che la loro minore incidenza quantitativa è ampiamente compensata dalla loro elevata efficienza.

Sebbene non si possa affermare con assoluta certezza che l'uso di questi gas abbia aumentato l'effetto serra naturale, tuttavia una serie di circostanze sembra confermare l'ipotesi che un loro incremento abbia già provocato effetti tangibili. In primo luogo, durante l'ultimo secolo la temperatura della superficie terrestre è aumentata di circa 0,5 °C. I dati osservativi dimostrano un aumento complessivo, che tuttavia non è lineare: a un incremento costante dal 1880 al 1949 ha fatto seguito una fase di diminuzione che è durata circa un trentennio (sino al 1980), dopo la quale la temperatura ha ripreso ad aumentare. In secondo luogo, il livello del mare si è innalzato di circa 1 mm all'anno nel corso dell'ultimo secolo. In terzo luogo, va considerato il caso dell'Antartide. Sotto certi aspetti, l'ultima glaciazione è ancora in atto, poiché l'Antartide è un ghiacciaio non ancora disciolto. La catena montuosa transantartica divide il continente in due regioni, l'Antartide orientale e l'Antartide occidentale. Quest'ultima poggia su un arcipelago sommerso grande all'incirca quanto le Filippine, mentre l'Antartide orientale poggia su un continente sommerso, e contiene circa 30 milioni di km3 di ghiaccio, che rappresentano il 91% del volume totale dei ghiacciai esistenti sulla Terra. Attualmente, l'Antartide occidentale si estende su un'area che rappresenta solo il 10% di quella dell'Antartide orientale, ma durante l'ultima glaciazione essa costituiva un terzo dell'intero continente. Sebbene i due terzi della regione si siano inabissati, resta ancora una quantità di ghiaccio tale che, se dovesse sciogliersi, farebbe innalzare il livello del mare di circa 6 m. Se tale fenomeno si verificasse nell'Antartide orientale, d'altro canto, il corrispondente innalzamento del livello del mare sarebbe di 60 metri. Alcune parti dell'Antartide occidentale sono franate in anni recenti: tra il 1974 e il 1979 è collassato il ghiacciaio di barriera Wordie, un'area di 250 km2 e con un volume di 37,5 km3 di ghiaccio; nel 1986 è stata la volta del tavolato di ghiaccio di Larsen e del promontorio di Filchner, e della lingua di ghiaccio Thwaites, per un totale di 23.525 km2 e un volume di 5.460 km3 di ghiaccio; nel 1987 è sprofondato il ghiacciaio di barriera Ross (5.508 km2 e un volume di 1.650 km3 di ghiaccio). La frana più recente si è verificata nel 1995 e ha riguardato la penisola di Larsen (2.849 km2, la stessa estensione del Lussemburgo, per un volume di ghiaccio pari a 521 km3). Il glaciologo americano T. J. Hughes ha paragonato l'Antartide occidentale al tappo di una bottiglia rappresentata dall'Antartide orientale, il cui collo è formato dalla regione tra il Mare di Weddel e il Mare di Ross. La frana dei ghiacciai dell'Antartide occidentale è fonte di gravi preoccupazioni, non solo perché determinerebbe un innalzamento di 6 m del livello del mare, ma anche perché lascerebbe priva di sostegno l'Antartide orientale, rendendola instabile e soggetta a sua volte a frane. Se ciò si verificasse, come abbiamo già accennato, l'innalzamento del livello del mare assumerebbe proporzioni da catastrofe biblica. Ricordiamo che se si sciogliessero i ghiacciai della Groenlandia il livello del mare salirebbe di 5 m, mentre uno scioglimento dei ghiacciai montani provocherebbe un aumento di 30-50 cm. Alcune circostanze suffragano l'ipotesi che quanto accade nell'Antartide sia da porre in relazione con il riscaldamento della Terra. È stato infatti rilevato che nel corso degli ultimi 50 anni la temperatura locale è aumentata di 2,5 °C, che la temperatura media è salita attualmente a -3 °C e che la vita vegetale rifiorisce, come dimostra il fatto che la flora è aumentata di 25 volte.

6. Le previsioni

La branca della scienza che si serve di questi dati climatici per formulare previsioni sul clima futuro fu creata da un brillante scienziato inglese, Lewis Fry Richardson, il quale sin da giovane era affascinato dalla possibilità di prevedere il tempo risolvendo equazioni matematiche anziché usando metodi empirici di dubbia attendibilità. Il suo sogno era quello di arrivare a prevedere il tempo con la stessa esattezza con cui, ad esempio, si prevedono le eclissi. La prima guerra mondiale segnò una battuta d'arresto nelle sue ricerche; ciò nonostante, Richardson riuscì a portare a termine i calcoli necessari per formulare la sua prima previsione meteorologica, che risultò peraltro ampiamente errata. Senza lasciarsi scoraggiare da questo primo insuccesso, Richardson continuò le sue ricerche e infine, nel 1922, pubblicò quello che può essere considerato il primo trattato moderno di meteorologia dinamica, Weather prediction by numerical process. Nasceva così una nuova disciplina, anche se la prima previsione realistica non fu effettuata che alla fine degli anni quaranta, presso l'Institute for Advanced Studies di Princeton, sotto la guida di J. von Neumann. Richardson fu un visionario che anticipò i tempi. I suoi contributi nel campo della fluidodinamica (ricordiamo il noto ‛numero di Richardson') gli hanno assicurato una importante e ben meritata posizione nella storia della scienza. Il tempo e il clima, come abbiamo visto, sono materie che comprendono due ordini di fenomeni ben diversi, la cui descrizione richiede metodi matematici differenti. In termini matematici, il tempo costituisce un problema ‛ai valori iniziali', mentre il clima rappresenta un problema ‛di condizioni al contorno', o, per usare le colorite immagini di Richardson, un ‛problema in marcia' e un ‛problema di giuria'. Difatti, da qui a un secolo il clima sarà fortemente influenzato dalle condizioni limite che prevarranno allora - situazione demografica, livello di consumo energetico, emissioni di gas responsabili dell'effetto serra, grado di deforestazione, ecc. - ossia da condizionamenti esterni (la ‛giuria' di cui parla Richardson). Negli ultimi venti anni vari gruppi di scienziati di tutto il mondo - soprattutto statunitensi, canadesi, australiani ed europei - hanno sviluppato i cosiddetti GCM (General Circulation Models, modelli di circolazione generale), per i quali vengono utilizzati i più veloci computers attualmente disponibili. Questi modelli sono di norma codificati da 50.000 righe di istruzioni, e dividono la superficie terrestre in reticoli di 4,5° di latitudine e 7,5° di longitudine, corrispondenti a riquadri di 450×750 km ciascuno, con intervalli temporali di 30 minuti. Verticalmente l'atmosfera viene divisa dal suolo sino a 30 km di quota in una decina di strati. Dieci ore di calcoli effettuati da un singolo CARY Y-MP corrispondono a un anno di clima. I codici in questione descrivono il clima in termini di variabili fisiche quali la temperatura, la velocità del vento, il tasso di precipitazioni e di umidità, ecc., risolvendo un insieme di equazioni deterministiche sotto l'influenza di parametri esterni variabili. I risultati sono formulati spesso in termini di ‛sensibilità climatica', espressione che indica il cambiamento climatico atteso in conseguenza di un determinato cambiamento nei parametri esterni (ad esempio un raddoppiamento del tenore di CO2). Il sistema di equazioni viene elaborato al computer sinché non viene raggiunto uno stato di equilibrio. Per stabilire l'entità del cambiamento climatico, uno degli indicatori cui si fa riferimento più di frequente è il mutamento di temperatura, ma le precipitazioni e il tasso di umidità costituiscono indicatori altrettanto validi. I risultati delle ricerche effettuate dagli scienziati di tutto il mondo sono sintetizzati nell'ormai classico rapporto dell'IPCC (Intergovernmental Panel for Climate Change), pubblicato dal 1990 a cura di J. T. Houghton, G. J. Jenkins e J. J. Ephraums. Il lavoro è coordinato dalle Nazioni Unite e da due sue organizzazioni specializzate, la WMO (World Meteorological Organization) e l'UNEP (United Nations Environment Programme). Non va dimenticato, tuttavia, che la modellistica climatologica è una scienza ancora imperfetta e che non tutti gli studiosi sono disposti a sottoscrivere il rapporto dell'IPCC.

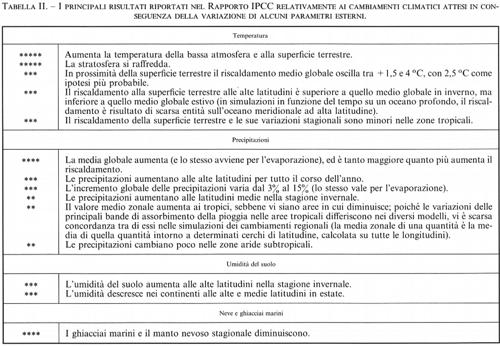

Consideriamo ora le principali caratteristiche di tale rapporto, sintetizzate nella tab. II, nella quale i cinque asterischi indicano che il fenomeno ha una probabilità di verificarsi vicina alla certezza; due asterischi, per contro, classificano un evento come scarsamente probabile. Tutti i GCM prevedono un aumento globale della temperatura di 2,5 °C; tuttavia questo effetto di riscaldamento non è uniforme: è massimo alle latitudini polari (sino a 10-12 °C), minimo nelle regioni equatoriali (1-2 °C). È importante capire la ragione di questa mancanza di uniformità. Alle alte latitudini il riscaldamento globale fa sciogliere il ghiaccio e modifica di conseguenza l'albedo, in quanto i terreni aridi, più scuri del ghiaccio, riflettono meno e assorbono maggior calore. Si tratta del fenomeno noto come ‛amplificazione polare' o ‛feedback dell'albedo di superficie ghiacciata'. Il fatto che tale fenomeno sia riprodotto da tutti i GCM aumenta la fiducia nella loro attendibilità. D'altro canto, l'effetto di riscaldamento non è altrettanto sensibile nell'emisfero meridionale, perché qui la quantità di terra coperta di ghiaccio è notevolmente inferiore e perché il ghiaccio dell'Antartide è troppo spesso per potersi sciogliere.

Possiamo menzionare un altro meccanismo analogo, che peraltro è assai più arduo da quantificare. La quantità di metano, CH4, attualmente congelato nella tundra è conosciuta solo per ordini di grandezza, ma è probabile che all'aumentare della temperatura globale si scioglieranno maggiori quantità di CH4, che raggiungendo l'atmosfera incrementeranno l'effetto serra, con la conseguenza di far sciogliere altro metano, e così via. Non sono che due esempi dei meccanismi di feedback ai quali devono essere ascritte le discrepanze tra i diversi modelli; l'esatta descrizione di tali meccanismi - senza i quali il problema sarebbe abbastanza semplice e non controverso: l'aumento della temperatura si aggirerebbe intorno a 1 °C - costituisce per molti versi il problema più arduo nella climatologia basata sui modelli matematici.

Per quanto riguarda l'umidità del suolo, i risultati possono essere sintetizzati nel modo seguente. In presenza di umidità, parte dell'energia termica è impiegata nell'evaporazione dell'acqua e quindi, contrariamente a quanto avviene nei climi aridi, non tutta riscalda il suolo. Di conseguenza, le previsioni climatiche per l'Africa Centrale dipendono in misura notevole dal tasso di umidità del suolo, e ciò spiega le discrepanze tra i diversi modelli, alcuni dei quali prevedono un aumento della temperatura di 4-6 °C, altri di 0-2 °C. Tuttavia, la maggiore incertezza deriva dal comportamento delle nubi, in quanto esse possono determinare meccanismi di feedback sia negativi che positivi. Attualmente, l'albedo è di circa il 30%, di cui il 20% dovuto alle nubi e il restante 10% alle radiazioni diffuse dalla superficie terrestre (ad esempio, dal ghiaccio e dalla neve). Solo sulla base di questi elementi si potrebbe concludere che le nubi hanno un effetto di raffreddamento sulla Terra. Tuttavia, il problema è assai più complesso, in quanto le nubi assorbono anche una certa quantità del calore emanato dalla Terra. Parte di questo calore viene diffuso verso l'esterno, parte ritorna verso la superficie terrestre; quest'ultimo contribuisce all'effetto serra e all'aumento della temperatura (è quindi un feedback positivo), mentre la quota di calore che si disperde all'esterno contribuisce a raffreddare il pianeta (si tratta quindi di un feedback negativo). Sulla base del clima attuale siamo in grado di stabilire se a prevalere è l'effetto di riscaldamento o quello di raffreddamento. Quest'ultimo corrisponde a -45 W/m2 (watt al metro quadro), mentre il riscaldamento è pari a + 30 W/m2: in complesso, dunque, le nubi raffreddano la Terra. Per quanto riguarda il clima futuro, le differenze nelle previsioni sul riscaldamento globale della superficie terrestre che si riscontrano tra i modelli - differenze che arrivano a un fattore 3 - dipendono in larga misura dal modo in cui sono considerate le nubi. I GCM prevedono che in un mondo con una concentrazione raddoppiata di CO2, vi saranno più nubi alte che nubi basse: le prime sono più fredde (la temperatura diminuisce con l'altezza a un ritmo di 6,5 °C per km) e irradiano meno; il loro valore di albedo è basso e quindi l'atmosfera trattiene maggior calore - un feedback positivo che porta a un aumento della temperatura. Inoltre, le nubi più basse, che in generale sono più brillanti e più bianche, hanno un'albedo superiore e quindi un effetto di raffreddamento; poiché sono in quantità inferiore, anche la loro incidenza globale è ridotta. In conclusione, gli attuali GCM prevedono un'albedo delle nubi ridotta, e poiché quella terrestre è determinata in larga misura dalle nubi, il loro effetto risulta dominante, sicché oggi si prevede che le nubi determineranno un feedback positivo (aumento della temperatura), assai simile a quello dell'albedo di superfici ghiacciate considerato in precedenza. Per queste ragioni, si afferma spesso che i risultati dei GCM debbono essere presi sul serio ma non alla lettera: sul serio, perché sono in grado di cogliere con sufficiente precisione le caratteristiche generali, ma non alla lettera in ragione delle difficoltà cui abbiamo accennato.

Se la precipitazione aumenta alle latitudini alte, quale sarà il suo effetto sul nastro oceanico? Detto in altri termini, quanta acqua dolce sarà necessaria per ‛indebolirlo'? Una possibile risposta è stata offerta nel 1995 dall'oceanografo tedesco S. Rahmstrof, che impiegò una tecnica molto nota negli studi sul caos, consistente nel registrare il comportamento (la risposta) di un sistema dinamico (il nastro) in funzione di un parametro di controllo (in questo caso, l'ammontare di acqua dolce). Ecco i risultati più salienti conseguiti in tal modo: 1) un flusso pari a 1/6 di quello del Rio delle Amazzoni spegnerebbe la corrente del Labrador, ma questo evento verrebbe preceduto da quello che nella teoria del caos è noto come ‛biforcazione di Hopf'. Il nastro oceanico comincia a oscillare con un periodo di 22 anni; la variazione nella sua portata è di 1-3 milioni di metri cubi al secondo e la corrispondente variazione della temperatura è di 0,2 °C. Va sottolineato che tutto ciò accade con un flusso di acqua dolce pari a 1/6 di quello del Rio delle Amazzoni, una perturbazione a prima vista minima su un sistema che ha una portata media pari a 100 volte il flusso considerato; 2) se si torna indietro sottraendo acqua dolce, il nastro oceanico non ritorna al suo stato iniziale, ma si stabilizza su un nuovo stato di equilibrio avente una portata pari solo al 75% di quella precedente; 3) qualora si aumentasse l'afflusso di acqua dolce e si arrivasse a un valore pari a 1/4 della portata del Rio delle Amazzoni, verrebbe raggiunto un punto senza ritorno. Di lì in poi il sistema precipiterebbe; quindi un ulteriore aumento, per quanto piccolo, lo spegnerebbe del tutto. Il nastro oceanico sembra pertanto possedere due stati di equilibrio (75 e 100) e soffrire di ‛fibrillazioni' aventi un periodo di 22 anni: il tutto avverrebbe con perturbazioni assai minute rispetto alla sua maestosa portata. Un vero Golia abbattuto da un astuto David che colpisce nel punto più delicato, il livello di salinità. Da dove può venire tale perturbazione? Oltre che da icebergs, potrebbe essere causata da un aumento globale della temperatura dovuto all'effetto serra? La risposta sembra essere negativa. Il volume di acqua artica è di circa 20-30 milioni di milioni di metri cubi. Per ottenere il flusso di cui sopra, lo scioglimento dovrebbe avvenire in 10-15 anni. Ma anche se ciò potesse accadere, il nastro oceanico non si spegnerebbe, perché esso impiega centinaia e non decine di anni a reagire. Un recente studio degli oceanografi italiani V. Artale e N. Pinardi, in collaborazione con M. W. Hecht e W. R. Holland, dimostra che, qualora il Mediterraneo dovesse staccarsi dall'Atlantico, il nastro si spegnerebbe in meno di 200 anni. La cosa più sorprendente è che anche in questo caso il mare nostrum, contro tutte le apparenze, risulti in grado di infliggere danni significativi. Il Mediterraneo è infatti un mare che, a causa della grande evaporazione, ha un alto tasso di salinità, e quindi all'uscita da Gibilterra offre alle acque atlantiche un ‛densificatore' quanto mai efficiente, proprio quel sale senza il quale il nastro oceanico avrebbe difficoltà a sopravvivere.

7. Strategie per mitigare l'effetto serra

Purtroppo per i responsabili delle scelte politiche e per tutti noi, i GCM attualmente a disposizione non sono in grado di quantificare in modo preciso i mutamenti nella temperatura e/o nelle precipitazioni, né l'effetto di variazioni quali l'innalzamento del mare a livello regionale. Ciò per una serie di ragioni, tra cui la potenza ancora limitata dei computers, la qualità e la quantità dei dati misurati, e infine la quantificazione ancora insoddisfacente degli effetti degli oceani e delle nubi. Nonostante queste incertezze, le previsioni e gli scenari che emergono dai GCM sono abbastanza preoccupanti da aver suscitato un interesse mondiale circa la possibilità di un effetto serra di origine antropica. A meno di non liquidare l'intero problema nella speranza che, una volta eliminate le incertezze scientifiche tuttora esistenti, risulti che non esiste il previsto aumento della temperatura e con esso gli effetti che ne conseguirebbero, l'unico atteggiamento responsabile consiste nel cercare di ridurre le emissioni di CO2 e di altri gas che provocano l'effetto serra.

Il problema tuttavia è tutt'altro che semplice. In primo luogo, quasi tutto il mondo ha tratto beneficio dall'impiego dei combustibili fossili; molte generazioni hanno contribuito a creare il problema e la responsabilità non può essere imputata a una singola nazione o industria: tutti abbiamo dato il nostro contributo, sebbene in misura notevolmente diversa. Poiché l'ipotesi di una drastica riduzione dell'impiego di combustibili fossili è assolutamente utopica e, se attuata, probabilmente creerebbe il caos economico, e poiché i paesi meno sviluppati hanno tutto il diritto di intraprendere l'industrializzazione, le speranze sono riposte nella scoperta di nuove fonti di energia. Un metodo ad interim suggerito da molti è il rimboschimento, in quanto durante il periodo della crescita le piante, prima di raggiungere uno stato di equilibrio, assorbono con la fotosintesi più CO2 di quanto ne emettano con la respirazione. Naturalmente occorre anche porre fine alla deforestazione e agli incendi delle foreste tropicali. Secondo un calcolo ampiamente citato, al fine di eliminare le cinque Gt di C annue originate dal combustibile fossile si dovrebbe procedere al rimboschimento di una regione grande come l'Australia.

E se si riuscisse a indurre gli oceani ad assorbire una quantità leggermente superiore ai 100 e più miliardi di tonnellate di C che già scambiano oggi con l'atmosfera? Nel 1996, scienziati americani, inglesi e messicani annunciarono risultati sorprendentemente positivi sulla possibilità di fertilizzare gli oceani. In oceanografia esiste da anni un enigma: ci sono almeno tre regioni in cui persiste una biomassa dotata di clorofilla incomprensibilmente bassa, sebbene vi siano abbondanti nutrienti, fosfati e nitrati. L'esperimento, chiamato IronExII (c'era stato un IronExI, ma di durata troppo breve per permettere conclusioni statisticamente valide), si svolse a 3,5° di latitudine S e 104° di longitudine W e iniziò il 29 maggio 1995. Il primo giorno si fertilizzò il mare con 225 kg di ferro (solfato di ferro) mescolato con un tracciante passivo (esafluoruro di zolfo, SF6) sparso su un rettangolo di 72 km2. I solchi erano distanti 400 metri, ma dopo appena un giorno si constatò che la turbolenza oceanica aveva causato una distribuzione uniforme nei 25 metri di profondità dello strato limite dell'oceano (questo venne verificato con l'aiuto dei traccianti). Altri 112 kg di ferro vennero immessi nel terzo e nel settimo giorno della spedizione. Ogni giorno veniva effettuata una serie di misurazioni delle variabili di interesse: temperatura, salinità, contenuto di ferro, SF6, CO2, DMS (dimetilsolfati), fitoplancton, ecc. La risposta biologica fu rapida e uniforme: una fioritura di biomassa clorofillica corrispondente a un aumento del 3.000% e una diminuzione della fugacità di CO2 del 60%. Questo importante risultato ha fatto passare dallo stadio di ipotesi a quello di realtà la tanto discussa fertilizzazione degli oceani quale possibile agente anti-effetto serra. Non si è risolto il problema, non illudiamoci, ma si è aperta una nuova possibilità.

Poiché il gas naturale genera, per unità di energia prodotta, una quantità minore di CO2 rispetto al petrolio e soprattutto al carbone, una strada possibile per arginare l'aumento di CO2 potrebbe essere quella di passare dal carbone al petrolio e quindi al metano. Ricordiamo che in unità di kWh per libbra di CO2, il carbone ha un potenziale di 0,56, il petrolio di 0,70 e il metano di 1,01. È interessante anche osservare l'andamento delle emissioni di CO2 nel tempo. Nel 1950, il 44,1% delle emissioni di CO2 era imputabile al Nordamerica, il 23,4% all'Europa occidentale, il 18% ai paesi del blocco sovietico e il 5,7% ai paesi in via di sviluppo. Nel 1980, l'apporto del Nordamerica è sceso al 26,6%, quello dell'Europa al 16,5%, mentre quello dei paesi ex socialisti è aumentato passando al 24,7%, e lo stesso vale per i paesi in via di sviluppo, passati al 12,2%. Nel 1950, le emissioni complessive di CO2 ammontavano a 1,62 Gt, mentre nel 1980 raggiungevano le 5,7 Gt, con un incremento del 300% (per quanto riguarda gli Stati Uniti, la ripartizione per settore delle emissioni di CO2 è la seguente: trasporti 31,8%, servizi elettrici 33,4%, industria e commercio 27,5%, usi domestici 7,4%). Queste cifre mettono in luce la prima difficoltà: la produzione di CO2 da combustibile fossile si è spostata e si prevede si sposterà ulteriormente dai paesi industrializzati alle nazioni in via di sviluppo, che perseguono una aggressiva strategia di sviluppo economico. Se si considera inoltre che le risorse di combustibile fossile recuperabile sono ancora consistenti, che esiste una infrastruttura internazionale per il suo sfruttamento e che mancano fonti di energia alternative che possano entrare in competizione con esso, è realistico prevedere che la dipendenza dai combustibili fossili non è destinata a diminuire nel prossimo futuro. Questa fonte di energia fornisce il 62% dell'elettricità mondiale, mentre l'energia idroelettrica ne fornisce il 19% e quella nucleare il 17%. Si calcola che le risorse mondiali di metano e petrolio dureranno 40-50 anni e quelle di carbone 200 anni. Più del 90% delle risorse carbonifere è concentrato in appena sette paesi: Stati Uniti (28,5%), ex Unione Sovietica (26,4%), Cina (10,7%), Australia (7,1%), Germania occidentale (6,4%), Sudafrica (6,5%) e Polonia (4,6%). È interessante notare inoltre che negli Stati Uniti nel 1966 il carbone era responsabile del 30,3% delle emissioni di CO2, nel 1976 del 25,5% e nel 1986 del 33,7%; nei decenni considerati, le emissioni di CO2 dovute al petrolio rappresentavano rispettivamente il 45,5%, il 52,7% e il 47,6%, mentre per quanto riguarda il metano le percentuali erano rispettivamente del 24,2%, del 21,6% e del 18,7%. In altre parole, è aumentato l'uso del carbone.

8. Questioni che richiedono una regolamentazione internazionale