INFORMATICA UMANISTICA

Informatica umanistica

Parte introduttiva

di Giovanni Adamo

L'espressione informatica umanistica è stata coniata all'inizio degli anni Novanta sul modello di locuzioni già lessicalizzate in altre lingue, in analogia con i settori applicativi dell'informatica giuridica e dell'informatica medica (v. informatica: Informatica e diritto; ingegneria biomedica: Bioingegneria, in questa Appendice). Essa si riferisce ai metodi e alle tecniche di applicazione dell'informatica nelle diverse discipline umanistiche, in considerazione di un retroterra culturale comune e di alcuni punti di contatto sostanziali, individuabili soprattutto nelle caratteristiche unitarie che presentano sia i dati che devono essere identificati e descritti per divenire oggetto di elaborazione automatica, sia i metodi di indagine e le conseguenti ipotesi di lavoro (modelli) che devono essere resi espliciti e formalizzabili. L'esperienza pluridecennale di applicazione dell'informatica alle discipline umanistiche ha dimostrato come le tecniche e i metodi applicativi impiegati in un particolare settore di studio tendano ad avere influssi e ripercussioni anche in altri più o meno contigui, o a ispirarne di nuovi improntati a una visione interdisciplinare. Si consideri, poi, l'esistenza di settori ampiamente condivisi, che costituiscono un crocevia per molte applicazioni umanistiche, come l'analisi testuale (v. oltre: Informatica e analisi testuale), l'organizzazione delle basi di dati e il trattamento computerizzato delle immagini. Accanto a questi, vi sono campi che assumono grande rilievo per tutta la ricerca umanistica: la gestione dei documenti d'archivio e l'automazione delle biblioteche e delle risorse bibliografiche (v. beni culturali e ambientali: Beni culturali e informatica; biblioteca, in questa Appendice).

L'introduzione dell'informatica o, più precisamente, di macchine per il calcolo automatico negli studi umanistici si può far risalire alla fine degli anni Quaranta, anche se già negli ultimi anni della Seconda guerra mondiale erano stati compiuti tentativi di automazione nel trattamento di dati linguistici per la composizione crittografica di messaggi e la traduzione assistita dai primi rudimentali calcolatori. Per poter parlare propriamente di informatica, occorre attendere gli anni Sessanta, quando il termine - coniato in Francia e rapidamente diffusosi in ambito internazionale - venne assunto per designare non più soltanto le innovazioni tecnologiche che hanno permesso di costruire i calcolatori elettronici digitali destinati all'impiego in ogni settore di attività e di ricerca, ma anche e soprattutto il complesso di conoscenze teoriche che costituiscono le premesse per il funzionamento delle macchine e assicurano lo sviluppo di metodologie applicative coerenti. Un ruolo fondamentale nella genesi dell'informatica è stato svolto dalla matematica, dalla logica, dalle scienze della comunicazione e dell'informazione e, in particolare, dalla linguistica. È interessante, a tal proposito, considerare gli effetti indotti dall'incontro di due domini apparentemente distanti tra loro come l'informatica e le discipline umanistiche. L'informatica, considerata nel suo ruolo di 'macchina argomentativa' più che dal punto di vista della tecnologia degli elaboratori, trae occasione per rivisitare le proprie radici logico-filosofiche e ottiene contributi determinanti per l'elaborazione di una teoria dei linguaggi; le materie umanistiche, giovandosi di strumenti logici e tecnologici potenti e precisi, ricevono stimolo e impulso per rendere coerenti e formali i loro metodi di indagine e di analisi. Da questa interazione si producono strumenti nuovi per la ricerca, che a loro volta sono in grado di determinare nuove conoscenze e risultati originali, così da elaborare ricadute autonome e, al tempo stesso, contributi destinati a rifluire nei due distinti domini d'origine. Si pensi, per es., alla formalizzazione delle regole (algoritmi) per l'analisi del vocabolario, del contenuto, della sintassi e dello stile di un testo, o per la traduzione automatica; essa costituisce il requisito indispensabile per la realizzazione di sistemi esperti in vari settori degli studi umanistici, di sistemi per la traduzione assistita o la sintesi automatica dei suoni e del parlato. La linguistica computazionale rappresenta il punto di convergenza delle competenze originarie dei due domini, ma fenomeni analoghi si osservano anche in settori come la didattica, la storia e l'archeologia, che forse più direttamente si prestano a cogliere le nuove potenzialità multimediali, manifestando già i tratti distintivi di un'evoluzione originale.

Sul finire degli anni Quaranta, ancora con l'aiuto di macchine elettrocontabili operanti su schede perforate, R. Busa condusse i primi esperimenti, sottoponendo a trattamento il terzo canto dell'Inferno dantesco e gli inni liturgici composti da Tommaso d'Aquino per l'Officium de festo Corporis Christi, per poi dare inizio alla trentennale impresa di spoglio dell'opera integrale dell'Aquinate e di altri autori a lui collegati, la cui prima fase si è conclusa nel 1980 con la pubblicazione dell'ultimo volume dell'Index thomisticus, che oggi è disponibile anche in CD-ROM (v. busa, roberto, in questa Appendice).

Tra il 1945 e il 1950, J. von Neumann e H.H. Goldstine avevano progettato la costruzione di un sistema di calcolo ad alta velocità, l'Electronic computer project, da realizzare presso l'Institute for Advanced Study dell'università di Princeton: il nuovo calcolatore fu inaugurato nel giugno 1952. Anche a seguito delle ricerche sulla ricorsività e sulla macchina ideale condotte da A.M. Turing, von Neumann aveva maturato la convinzione che quel computer dovesse essere considerato non solo come 'macchina da calcolo', ma piuttosto come l'automa che avrebbe indotto un ripensamento nei metodi di indagine e nelle attività di ricerca in ogni settore della scienza, anche nelle scienze umane e sociali. Nel 1955, su proposta di O. Neugebauer, specialista di storia della matematica e dell'astronomia dell'antichità, il computer venne utilizzato per la compilazione automatica di effemeridi relative al Sole, alla Luna e ai pianeti osservabili a occhio nudo. Queste tavole numeriche, recanti le coordinate degli astri a intervalli prefissati e uguali fra loro, avrebbero potuto essere utilizzate per la datazione di registrazioni astronomiche, e quindi di avvenimenti storici, dal 600 a.C. all'1 d.C. Le tavole, pubblicate nel 1962 (Tuckerman 1962) e ancora oggi patrimonio degli studi sull'astronomia antica, rappresentano il prodotto di una delle prime applicazioni umanistiche del calcolo automatico, probabilmente la prima nell'ambito degli studi storici. È interessante notare come, considerando l'aspetto originale e inconsueto dell'applicazione, i collaboratori di von Neumann avvertissero la necessità di giustificare ai finanziatori dell'Electronic computer project, che costituiva una vera e propria joint venture, i criteri che avevano motivato la scelta di tale applicazione: la quantità di operazioni di calcolo, assolutamente impraticabile senza computer; l'interesse per la sperimentazione di calcoli di alta precisione; la natura non commerciale dei risultati e il valore scientifico permanente che essi avrebbero rappresentato (Aspray 1990, pp. 167-69).

Grazie ai nuovi strumenti di calcolo, l'impiego di metodi quantitativi e statistici cominciò a diffondersi sistematicamente anche in vari settori degli studi umanistici, come la storia, l'archeologia e la linguistica, modulando tecniche e metodi applicativi da discipline affini (sociologia, psicologia, economia).

Nell'ambito della storiografia, a partire dalla seconda metà degli anni Cinquanta, la "propensione per lo studio dei fenomeni a carattere ripetitivo (e quindi per l'individuazione di entità misurabili e per la ricerca di adeguati modelli analitici e descrittivi) veniva a marcare polemicamente l'allineamento degli storici quantitativi sugli standard delle scienze fisiche e sociali" (Itzcovich 1993, p. 79). E in un articolo apparso sul Nouvel observateur dell'8 maggio 1968 E. Le Roy Ladurie, riferendosi alla "rivoluzione quantitativa", arrivava a sostenere: "Lo storico di domani dovrà essere un programmatore, o non sarà affatto" (Le Roy Ladurie 1973; trad. it 1976, p. 7). In Francia, sotto l'influsso della scuola delle Annales e della storia sociale di E. Labrousse, si andavano elaborando nuove impostazioni metodologiche: la storia quantitativa (J. Marczewski) e la storia seriale (P. Chaunu). Negli Stati Uniti nasceva la cliometria o new economic history (R.W. Fogel, S.L. Engerman, P. Temin).

L'adozione di metodi matematico-statistici ha caratterizzato altresì i movimenti culturali della new archaeology (L.R. Binford, Stati Uniti), piuttosto orientata agli studi antropologici, e della social archaeology (C. Renfrew, Inghilterra). Anche questi movimenti, che rivendicavano l'originalità e l'autonomia dei loro studi e si richiamavano ai metodi impiegati dalle scienze esatte, consideravano il calcolatore come strumento indispensabile della ricerca. Il passaggio dall'analisi qualitativa e descrittiva dei dati a quella quantitativa, in vista di una loro classificazione automatica, richiedeva un'attenta riflessione sui criteri di scelta e di rappresentazione (codifica) delle informazioni da sottoporre a elaborazione. I settori della ricerca archeologica maggiormente coinvolti nell'applicazione della statistica erano soprattutto quelli dell'analisi di manufatti litici, metallici e ceramici di epoca preistorica e storica, che venivano a trovarsi al centro dell'interesse di nuovi campi di ricerca, quali l'archeologia quantitativa, l'archeometria e l'archeologia spaziale. Nei decenni successivi sono stati sperimentati con successo anche metodi di analisi statistica multivariata: di classificazione automatica (in particolare la cluster analysis), di analisi fattoriale (dei componenti principali e delle corrispondenze) e di analisi discriminante, volta a enucleare gli elementi che più significativamente contribuiscono a caratterizzare ciascun gruppo di manufatti (Moscati 1987, pp. 55-108).

L'applicazione di calcoli statistici automatici alla linguistica e all'analisi testuale e stilistica ha avuto come punti di riferimento gli studi di L. Brandwood (1956), P. Guiraud (1960), G. Herdan (1964) e Ch. Muller (1977). Il calcolatore elettronico permetteva di considerare e di elaborare quantità di dati che sarebbe stato impensabile dominare con gli strumenti di calcolo tradizionali e consentiva di sviluppare intuizioni e metodi già sperimentati dalla fine del 19° secolo. Anche in quest'ambito si sono formati nuovi settori di studio - linguistica quantitativa, statistica linguistica, linguistica matematica, stilometria e lessicometria - con il compito di elaborare e compendiare dati numerici e verbali (statistica descrittiva) ma anche di comprovare l'attendibilità di modelli teorici, soprattutto nello studio di quei fenomeni linguistici che, non potendo essere dimostrati sulla base di un'elaborazione esaustiva dei dati, presuppongono l'impiego di campionature esemplificative (statistica inferenziale).

Tuttavia, l'accoglienza riservata dagli studiosi alle pubblicazioni che illustravano i risultati di ricerche compiute con metodi matematici e statistici non sempre è stata favorevole. Talvolta, anzi, sono emersi toni diffidenti e persino polemici, dettati dall'eccessiva presenza di formule e tabelle e dalla scarsa considerazione per una prassi che prevede un "immoderato e sventato ricorso alla quantificazione come risposta a tutti i problemi", fino a un punto in cui "lo strumento diviene fine a se stesso" (Stone 1977, pp. 29-30; trad. it. 1987, p. 34). Eppure, queste critiche hanno contribuito, nei fatti, a promuovere un lento e progressivo superamento della contrapposizione tra istanze qualitative e quantitative.

Dalla seconda metà degli anni Cinquanta, a seguito degli esperimenti compiuti da R. Busa, si diffondeva anche la compilazione automatica di indici e concordanze testuali. Si tratta di repertori che, come i vocabolari per le varie lingue, raccolgono e documentano l'impiego di vocaboli e locuzioni all'interno di un'opera. Le concordanze, in particolare, elencando le parole presenti in un testo, situate ciascuna all'interno di un breve contesto e accompagnate dal riferimento alla pagina e alla riga in cui compaiono, consentono una lettura sintetica o sinottica di quel testo, perché presentano simultaneamente al lettore tutti i brani in cui una determinata parola ricorre. Le prime concordanze automatiche furono pubblicate nel 1957 e, come già era accaduto per le Concordantiae compilate manualmente intorno alla metà del 13° secolo dai domenicani francesi coordinati da Ugo di Saint-Cher, si riferivano al testo per eccellenza, la Bibbia (nel testo latino della Vulgata), questa volta sul testo inglese della Revised standard version del 1952 (Ellison 1957).

Negli anni Sessanta e Settanta si sono affinate le procedure per la compilazione automatica di indici e concordanze e, con il perfezionamento tecnologico delle unità di output, si è arrivati a impaginare automaticamente i dati per la stampa in fotocomposizione (Accademia della Crusca 1968; Concordance du théâtre, 1968; Packard 1968), poi anche su microfiche e, solo più recentemente, su CD-ROM. Si risolveva così, almeno in parte, la polemica suscitata negli anni precedenti sull'utilità, sui costi e le modalità di pubblicazione di indici e concordanze; queste ultime infatti, per loro stessa natura, decuplicano mediamente il volume dell'opera a partire dalla quale sono compilate. Occorre poi ricordare che il trattamento di quantitativi ingenti di dati poneva allora notevoli problemi relativi ai costi di calcolo (che costringevano spesso a compiere elaborazioni notturne e di tipo batch, escludendo il dialogo tra l'utente e l'elaboratore), e al recupero puntuale dell'informazione. Per ovviare a tali inconvenienti, causati principalmente dalla tecnologia delle memorie di massa allora disponibili (schede e nastri perforati e, successivamente, nastri magnetici), si dovettero attendere memorie di massa più capaci e soprattutto più interattive, come le pile di dischi magnetici. Con le nuove memorie sarebbe stato possibile progettare soluzioni innovative che avrebbero consentito una maggiore dinamicità dei programmi di elaborazione, integrando funzioni che fino a quel momento potevano essere svolte solo in una sequenza di fasi successive. Si avviava la fase caratterizzata dallo sviluppo dei programmi di gestione di banche e basi di dati, destinati ad assumere un ruolo di primo piano nell'ambito delle applicazioni umanistiche e dell'elaborazione dell'informazione.

Lo sviluppo dei programmi di gestione delle basi di dati è molto legato a due grandi mutamenti che si sono registrati tra la fine degli anni Settanta e l'inizio del decennio successivo: la nascita dell'informatica distribuita e la realizzazione del personal computer. Anche se talvolta vengono ritenuti coincidenti per le conseguenze che hanno prodotto, i due fenomeni si sono verificati in tempi successivi, e solo indirettamente possono essere considerati interdipendenti. L'affermarsi dell'informatica distribuita dava riscontro all'esigenza sempre crescente di disporre di risorse di calcolo in ambito scientifico, amministrativo e commerciale, e consisteva nella realizzazione di reti locali di varia natura e portata, capaci di collegare un determinato numero di unità terminali, dislocate nei luoghi di lavoro dei singoli utenti, a un grande elaboratore. Solo in un secondo tempo le singole unità terminali sono state dotate di risorse di calcolo autonome via via più consistenti, dando luogo dapprima ai cosiddetti terminali intelligenti e poi a veri e propri elaboratori dedicati all'uso individuale. Come sempre è accaduto nella storia dell'informatica, all'innovazione tecnologica dell'hardware ha fatto seguito lo sviluppo o il potenziamento del software di gestione o applicativo, nella spirale di un processo evolutivo che, ingenerando sempre nuove esigenze, ha alimentato un mercato in continuo cambiamento.

Si può dire che i problemi metodologici relativi alla costituzione delle basi di dati siano fondamentalmente comuni a tutto l'ambiente umanistico, pur nella diversità dei dati che costituiscono l'oggetto di studio delle differenti discipline. Se si considera una base di dati come la trasposizione informatica del tradizionale archivio nel quale ogni studioso di archeologia, storia dell'arte, filologia, letteratura, storia, filosofia, musicologia o linguistica ha consuetudine di annotare le fonti o le informazioni relative alle proprie ricerche, è agevole comprendere come gli aspetti più importanti nella costituzione di una base di dati consistano nell'organizzare in modo omogeneo e coerente le proprie schede (record o documenti) e nel prevedere le soluzioni più concrete e immediate per ritrovare le informazioni archiviate. Nel corso degli anni, i sistemi informatici per la gestione delle basi di dati si sono molto evoluti, sia per quanto riguarda il modello complessivo di architettura che li caratterizza (con l'affermazione del modello relazionale su quello gerarchico e reticolare), sia per le opportunità di dialogo concesse all'utente. Oggi essi dispongono abitualmente di un linguaggio che consente all'utente stesso di disegnare gli schemi sulla base dei quali registrare i propri dati e consultare l'archivio informatico costituito.

Un argomento sul quale si è spesso richiamata l'attenzione è quello della diversificazione tra basi di dati testuali o linguistici (più utilizzate nell'ambito degli studi linguistico-letterari o filologici) e basi di dati fattuali (maggiormente impiegate per il trattamento di dati storici, archeologici o storico-artistici). Questa distinzione tende a mettere in evidenza la peculiarità del trattamento di dati più dichiaratamente linguistici rispetto ad altri che presuppongono un intervento descrittivo mediato dall'espressione linguistica: si tratta, in quest'ultimo caso, di acquisire dati relativi a oggetti (monumenti, sculture, dipinti, epigrafi, monete, o altro) o a personaggi, gruppi e classi sociali, avvenimenti storici. I problemi posti in passato dalla digitalizzazione delle immagini riproducenti gli oggetti originali sono ormai facilmente superabili grazie alle nuove tecniche di elaborazione grafica, come avviene anche per il trattamento di dati vocali e musicali, all'interno dei più evoluti sistemi informativi multimediali (v. multimedialità, in questa Appendice). Ma è interessante osservare come, nel corso degli ultimi decenni, si sia sviluppato un vivace dibattito sul tipo di linguaggio da utilizzare per la descrizione dei dati fattuali: alle varie fasi di tale dibattito hanno fatto seguito soluzioni operative che si sono diversificate nel tempo. Dalla costituzione di codici per la descrizione delle differenti categorie di oggetti si è passati alla compilazione di vocabolari controllati e, successivamente, alla strutturazione di thesauri informatici che, grazie a una complessa rete di relazioni sinonimiche, iponimiche e iperonimiche, consente all'utente di ottenere risposte soddisfacenti anche quando oggetti affini risultino descritti, all'interno della base di dati, con termini diversi. Negli ultimi anni si è registrato un notevole incremento delle ricerche orientate all'identificazione di strutture ontologiche, in vista di una più robusta categorizzazione dei dati, anche multilingui (Formal ontology, 1998).

D'altra parte, il problema della rappresentazione si è posto con tutta evidenza anche nel trattamento di dati linguistici e testuali (manoscritti e a stampa), soprattutto al fine di individuare un modello capace di descrivere efficacemente la struttura fisica e logica del testo. L'orientamento attuale consiste nel predisporre modelli validi per ciascuna delle differenti tipologie di testi, ma basati su un linguaggio di descrizione comune: lo Standard Generalized Markup Language (SGML, documento ISO 8879:1986). Questa soluzione permette di conseguire tre obiettivi ritenuti di primaria importanza: a) consentire lo scambio di dati testuali fra singoli studiosi, istituzioni di ricerca, sistemi di elaborazione diversi; b) favorire il trattamento dei dati secondo un formato indipendente dai programmi utilizzati; c) offrire uno strumento che serva da guida nelle operazioni di codifica dei testi in formato leggibile dalla macchina. Come si può vedere, il problema della rappresentazione ha costituito uno degli aspetti più ardui e impegnativi dell'i. u., chiamata a cimentarsi con un processo di incessante trasposizione dal continuo al discreto, dall'analogico al digitale, processo che ha più volte richiamato altre fasi fondamentali per lo sviluppo della comunicazione nella storia dell'umanità: l'oralità, la scrittura, la stampa (McArthur 1986).

Le considerazioni e le proposte formulate in merito al problema della rappresentazione digitale dei dati rientrano tra gli aspetti più significativi di una fase di ripensamento e di riflessione metodologica che, a partire dagli anni Ottanta, ha impegnato molti ricercatori interessati all'applicazione dell'informatica nelle discipline umanistiche. La diffusione sempre più capillare del personal computer e la conseguente assunzione della totale responsabilità dell'applicazione da parte dei singoli studiosi o di interi centri di ricerca umanistica ne hanno offerto probabilmente l'occasione più immediata. Ma occorre anche considerare la situazione di difficoltà che in quel periodo si avvertiva in molti progetti nazionali e internazionali che, dopo avere accumulato nel corso degli anni ingenti patrimoni di dati informatizzati, cominciavano a interrogarsi sulla rapida obsolescenza di macchine, programmi e supporti di conservazione dell'informazione e sui criteri più idonei ad assicurare lo scambio e la fruibilità dei dati. Le grandi associazioni scientifiche internazionali che si erano costituite negli anni precedenti o si andavano formando in quegli anni, le loro pubblicazioni periodiche e i convegni organizzati sotto i loro auspici hanno fornito le sedi più idonee al confronto delle opinioni e alla formulazione di proposte sostenute dal riconoscimento e dal consenso della comunità scientifica internazionale. Un contributo significativo allo sviluppo del dibattito metodologico, al consolidamento e alla sistemazione organica della materia - mediante la realizzazione di convegni, manuali di studio, bibliografie e programmi integrati - è stato fornito anche da gruppi di ricerca interdisciplinare attivi nel contesto italiano (Moscati 1987; Picchi 1989; Orlandi 1990; Informatica e scienze umane, 1991; Fondazione IBM Italia 1992; Gigliozzi 1993; Adamo 1994; Discipline umanistiche e informatica, 1997).

All'inizio degli anni Novanta, l'architettura dei sistemi aperti ha determinato un nuovo impulso nell'affrontare i problemi dell'integrazione degli ambienti operativi, delle procedure e dei dati di diversa natura (Discipline umanistiche e informatica, 1993). Tra le proposte più efficaci, lo sviluppo di strumenti che, facendo uso di linguaggi di livello molto evoluto, consentano una reale integrazione tra funzioni logiche e apparecchiature informatiche, senza pretendere dall'utente nozioni tecniche di livello altamente specialistico. Una sfida ulteriore è stata lanciata dalla sorprendente diffusione di Internet, che ha suscitato grande interesse e ha contribuito a intensificare lo scambio di informazioni in rete anche nell'ambiente accademico e della ricerca. Le reti di calcolatori e i sistemi distribuiti permettono alle stazioni di lavoro individuali - corredate delle opportune unità periferiche per la gestione delle immagini, del suono e della comunicazione - di condividere le risorse di quella che è stata definita la biblioteca globale. Rimangono però ancora aperti tre grandi cantieri di lavoro: l'individuazione di soluzioni adeguate per la tutela dei diritti di proprietà intellettuale del materiale messo a disposizione in rete; l'adozione di modelli condivisi per la rappresentazione dei dati, volti a ottenere la massima flessibilità nell'elaborazione; la messa a punto di meccanismi di ricerca rapidi e puntuali, che permettano agli strumenti di navigazione virtuale di mantenere la rotta in un oceano di dati che non ha più confini.

bibliografia

L. Brandwood, Analysing Plato's style with an electronic computer, in Bulletin of the Institute for classical studies (University of London), 1956, pp. 45-54.

J.W. Ellison, Nelson's complete concordance of the Revised standard version Bible, New York 1957.

P. Guiraud, Problèmes et méthodes de la statistique linguistique, Dordrecht-Paris 1960.

A. Ellegård, A statistical method for determining authorship. The Junius letters, 1769-1772, Göteborg 1962.

B. Tuckerman, Planetary, Lunar and Solar positions 601 B.C. to A.D. 1 at five-day and ten-day intervals, in Memoirs of the American philosophical society, 1962.

W.O. Aydelotte, Voting patterns in the British House of Commons in the 1840s, in Comparative studies in society and history, 1963, pp. 134-63.

G. Herdan, Quantitative linguistics, London 1964 (trad. it. Bologna 1971).

The use of computers in anthropology, ed. D. Hymes, The Hague 1965.

Computers in humanistic research. Readings and perspectives, ed. E.A. Bowles, Englewood Cliffs (N.J.) 1967.

Accademia della Crusca, Novella del grasso legnaiuolo nella redazione del Codice Palatino 200. Testo, frequenze, concordanze, Firenze 1968.

Concordance du théâtre et des poésies de Jean Racine, ed. B.C. Freeman, A. Batson, Ithaca (N.Y.)-London 1968.

D.W. Packard, A concordance to Livy, Cambridge (Mass.) 1968.

J.-C. Gardin, Archéologie et calculateurs, Paris 1970.

E. Shorter, The historian and the computer. A practical guide, Englewood Cliffs (N.J.) 1971, New York 1975².

The dimensions of quantitative research in history, ed. W.O. Aydelotte, A.G. Bogue, R.W. Fogel, Princeton (N.J.) 1972.

R. Floud, An introduction to quantitative methods for historians, London 1973, 1979².

E. Le Roy Ladurie, Le territoire de l'historien, Paris 1973 (trad. it. Le frontiere dello storico, Roma-Bari 1976).

J.-C. Gardin, Les analyses de discours, Neuchâtel-Paris 1974 (trad. it. Napoli 1981).

J.E. Doran, F.R. Hodson, Mathematics and computers in archaeology, Edinburgh 1975.

Ch. Muller, Principes et méthodes de statistique lexicale, Paris 1977.

L. Stone, History and the social sciences in the twentieth century, in The future of history, ed. Ch.F. Delzell, Nashville 1977, pp. 3-42 (trad. it. La storia e le scienze sociali nel secolo XX, in L. Stone, Viaggio nella storia, Roma-Bari 1987, pp. 3-47).

T.H. Howard-Hill, Literary concordances. A guide to the preparation of manual and computer concordances, Oxford-New York-Toronto 1979.

S.M. Hockey, A guide to computer applications in the humanities, London 1980.

U. Berni Canani et al., L'analisi delle frequenze. Problemi di lessicologia, a cura di M. Fattori, M. Bianchi, Roma 1982.

A. Bietti, Tecniche matematiche nell'analisi dei dati archeologici, Roma 1982.

Global linguistic statistical methods to locate style identities, a cura di R. Busa, Roma 1982.

Musical grammars and computer analysis, a cura di M. Baroni, L. Callegari, Firenze 1984.

K.H. Jarausch, G. Arminger, M. Thaller, Quantitative Methoden in der Geschichtswissenschaft. Eine Einführung in die Forschung, Datenverarbeitung und Statistik, Darmstadt 1985.

Datenbanken und Datenverwaltungssysteme als Werkzeuge historischer Forschung, hrsg. M. Thaller, St. Katharinen 1986.

R. Grishman, Computational linguistics. An introduction, Cambridge 1986 (trad. it. Milano 1988).

T. McArthur, Worlds of reference. Lexicography, learning and language from the clay tablet to the computer, Cambridge 1986.

R. Busa, Fondamenti di informatica linguistica, Milano 1987.

J.-C. Gardin et al., Systèmes-experts et sciences humaines. Le cas de l'archéologie, Paris 1987.

J.J. Hughes, Bits, bytes & biblical studies, Grand Rapids (Mich.) 1987.

P. Moscati, Archeologia e calcolatori, Firenze 1987.

L. Corti, Terminologia controllata e sistemi di classificazione, Pisa 1988.

Computer in den Geisteswissenschaften. Konzepte und Berichte, hrsg. M. Thaller, A. Müller, Frankfurt a.M.-New York 1989.

M.T. Leoni Zanobini, Vedere l'arte col computer, Roma 1989.

E. Picchi, DBT. Data base testuale, Pisa 1989.

W. Aspray, John von Neumann and the origins of modern computing, Cambridge (Mass.)-London 1990.

L. Haskins, K. Jeffrey, Understanding quantitative history, Cambridge (Mass.) 1990.

T. Orlandi, Informatica umanistica, Roma 1990.

Informatica e scienze umane. Lo stato dell'arte, a cura di L. Gallino, Milano 1991.

I. Lancashire, The humanities computing yearbook 1989-90. A comprehensive guide to software and other resources, Oxford 1991.

Fondazione IBM Italia, Calcolatori e scienze umane, a cura di M. Morelli, Milano 1992.

Discipline umanistiche e informatica. Il problema dell'integrazione, a cura di T. Orlandi, Roma 1993.

Electronic information resources and historians. European perspectives, hrsg. S. Ross, E. Higgs, St. Katharinen 1993.

G. Gigliozzi, Letteratura, modelli e computer, Roma 1993.

O. Itzcovich, L'uso del calcolatore in storiografia, Milano 1993.

G. Adamo, Bibliografia di informatica umanistica, Roma 1994.

D.I. Greenstein, A historian's guide to computing, New York-Oxford 1994.

F.A. Marcos-Marín, Informática y humanidades, Madrid 1994.

Storia & multimedia. Atti del Settimo congresso internazionale. Association for history & computing, a cura di F. Bocchi, P. Denley, Bologna 1994.

Fabula in tabula. Una storia degli indici dal manoscritto al testo elettronico, a cura di C. Leonardi, M. Morelli, F. Santi, Spoleto 1995.

R. Köhler, Bibliography of quantitative linguistics, Amsterdam 1995.

L. Perilli, Filologia computazionale, Roma 1995.

R. Busa et al., Lingua letteratura computer, a cura di M. Ricciardi, Torino 1996.

Images and manuscripts in historical computing, hrsg. M. Thaller, St. Katharinen 1996.

Informatica ed egittologia all'inizio degli anni '90, a cura di F. Tiradritti, Roma 1996.

Storia & computer. Alla ricerca del passato con l'informatica, a cura di S. Soldani, L. Tomassini, Milano 1996.

N. Tangari, La codifica delle note. Analisi e diffusione dei dati musicali, Roma 1996.

Discipline umanistiche e informatica. Il problema della formalizzazione, a cura di T. Orlandi, Roma 1997.

Internet e le Muse. La rivoluzione digitale nella cultura umanistica, a cura di P. Nerozzi Bellmann, Milano 1997.

Repertori di parole e immagini. Esperienze cinquecentesche e moderni databases, a cura di P. Barocchi, L. Bolzoni, Pisa 1997.

A. Cadioli, Il critico navigante. Saggio sull'ipertesto e la critica letteraria, Genova 1998.

Formal ontology in information systems, ed. N. Guarino, Amsterdam 1998.

Informatica e analisi testuale

di Tullio Gregory

La strumentazione informatica e l'uso sempre più ampio e duttile dei calcolatori hanno aperto nuovi orizzonti e suggerito nuovi metodi all'analisi testuale nel campo delle scienze storiche, filosofiche e linguistiche.

I primi esperimenti di uso delle macchine calcolatrici elettroniche nel campo dell'analisi testuale risalgono a circa cinquant'anni or sono, quando alla fine degli anni Quaranta R. Busa lavorava a un progetto per l'impiego dei calcolatori nell'analisi delle opere di Tommaso d'Aquino. A pochi anni dalla costruzione delle prime 'macchine per pensare' o 'cervelli elettronici' - espressioni tra l'illusorio e lo spettacolare con cui verranno definiti i primi elementari calcolatori di Konrad Zuse, di Howard H. Aiken e quindi di J. Presper Eckert jr., John W. Mauchly ed Herman H. Goldstine - si tentava di applicare in maniera sistematica a testi scritti in lingua naturale le tecniche e le metodologie della scienza che prenderà poi il nome di informatica.

Fino ad allora i calcolatori avevano trovato applicazione in campo militare, industriale, produttivo e amministrativo, scientifico e tecnologico, ma sempre in rapporto al calcolo e all'elaborazione di realtà fisiche o complessi numerici; ora ci si rivolgeva all'opera scritta di un grande pensatore, esegeta, teologo, filosofo. La mole stessa del programma sembrava renderlo irrealizzabile, ma i risultati si sono imposti in tutta la loro monumentalità: l'Index thomisticus (prima in 56 volumi di formato Enciclopedia Italiana per complessive 70.000 pagine; poi in CD-ROM) nasce dagli spogli di 118 opere di Tommaso e di 61 testi di autori a lui collegati; dieci milioni e mezzo di parole latine ne costituiscono la trama. L'opera, accolta in un primo tempo con qualche scetticismo, si rivelò presto come una svolta determinante negli studi linguistici e lessicografici in campo umanistico.

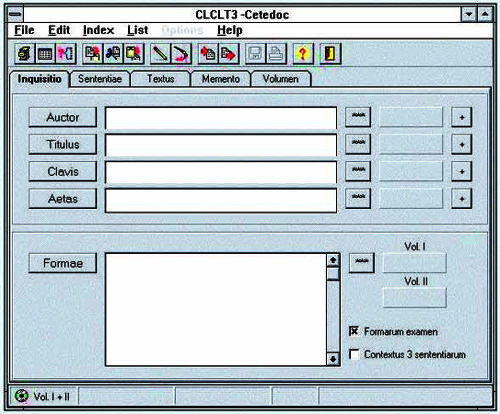

Altre imprese hanno poi assunto dimensioni ancor più vaste: l'Institut national de la langue française ha memorizzato un patrimonio sterminato di testi letterari e tecnici in lingua francese; il Cetedoc di Louvain-la-Neuve (fig. 3) produce sistematicamente spogli integrali di classici latini (Bibliotheca Teubneriana Latina) e di testi patristici e medievali (Thesaurus Patrum Latinorum e Thesaurus Patrum Graecorum oltre ai Thesauri di singoli Padri greci e latini); il Thesaurus linguae Graecae ha spogliato tutta la letteratura greca antica fino al 7° secolo, con il programma di estenderlo alla letteratura bizantina; ancora (per dire solo alcune realizzazioni pilota, di carattere settoriale) l'Omofonario della lingua italiana delle origini di D'A.S. Avalle, la banca dati della terminologia filosofica latina del Seicento e Settecento del Lessico intellettuale europeo (CNR).

L'applicazione di metodi informatici all'analisi del linguaggio, della comunicazione verbale e scritta, di una realtà cioè specificatamente umana e storica, imponeva nuovi e complessi problemi ai quali si accennerà nel seguito. Ma va detto subito che tutti possono essere ricondotti a un punto centrale: come trascrivere con serie numeriche il linguaggio umano, espresso e rappresentato per mezzo di segni portatori di significati variabili secondo i diversi contesti; da un lato un codice univoco di rappresentazione, dall'altro un sistema di segni e significati non univoci, spesso ambigui, comunque legati all'evoluzione della società, del pensiero, e alla complessità del linguaggio.

Questo problema - posto dal rapporto fra una realtà storica e una modellizzazione astratta - si verifica in tutta la sua complessità già in quello che è l'ambito più diffuso di applicazione dell'informatica nel campo delle discipline storico-filologiche: l'analisi di dati linguistici e testuali, cioè l'identificazione sistematica delle parole e delle strutture che costituiscono un discorso o un testo scritto, in modo da classificarle secondo schemi unificanti. Si tratta di un complesso di operazioni non meccaniche, che comportano scelte di fondamentale importanza e che investono problemi di critica testuale e di linguistica.

Si pone subito un problema che il calcolatore aiuta a mettere in evidenza con tutto il suo rigore formale: cos'è un testo. Senza entrare nelle molteplici definizioni che individuano il testo in quanto "struttura linguistica che realizza un sistema" (Segre 1991), e insistendo piuttosto, per ciò che qui più direttamente interessa, sulla sua identità materiale, affidata a manoscritti e stampati, inevitabile è la domanda di cosa sia da assumere come testo base per la memorizzazione. Nella gran parte dei casi - mancando il manoscritto autografo - la tradizione manoscritta è plurima e l'edizione critica (ove esista) ricostruisce non l'originale ma un testo ipoteticamente a esso vicino; anche per testi a stampa la bibliografia materiale ha insegnato la difficoltà di giungere a un 'esemplare ideale', spesso peraltro non rispondente ad alcun testimone. Dunque il lessicografo - che lavora quasi sempre su edizioni altrui - dovrà essere consapevole del carattere storicamente determinato del testo scelto per l'analisi lessicale, non coincidente con l'originale. Peraltro, esaminando un corpus di un autore o di un'epoca, ci si troverà di fronte edizioni (o manoscritti ) che riflettono usi e criteri diversi di scrittura e di edizione. Avvertiti di questo primo problema, si dovranno identificare gli aspetti del testo da codificare: le diverse grafie, anche di una stessa parola (che possono rispondere a normali oscillazioni o a scelte editoriali), la punteggiatura, i corsivi e i tondi, le maiuscole, le minuscole, gli 'a capo', i segni diacritici, i titoletti a margine, i frontespizi e gli indici, le abbreviazioni, le cifre e i simboli non alfabetici; ma sarà necessario anche codificare - è un elemento, questo, la cui importanza non può sfuggire - la collocazione delle parole nello spazio pagina (si pensi a una pagina di 'parolibere' futuriste o ai calligrammi di Apollinaire), le figure e la pagina figurata; ancora il tipo di carta, la filigrana e così via. Come si può vedere, l'orizzonte delle codifiche possibili è sconfinato, e pare non definibile in termini esatti, anche se nel corso degli anni Novanta si sono proposti sistemi automatici di elaborazione in cui potessero convergere segni e realtà prima non unificabili: il testo scritto, l'immagine (anche in movimento come nella ricostruzione di disegni di apparecchiature scientifiche, di macchine e strumenti) e se necessario il suono, così da tentare di codificare un documento nella sua complessa integrità.

Tuttavia, malgrado le più raffinate e flessibili forme di codifica, una modellizzazione non può essere la duplicazione di un testo manoscritto o stampato: si costituisce per questo una costante tensione fra l'esigenza di formalizzare nel modo più rigoroso possibile il documento, così da renderlo suscettibile di elaborazione attraverso procedimenti di calcolo o algoritmi, e la fondamentale complessità del documento, vero luogo della dissomiglianza (regio dissimilitudinis), in cui si rispecchia la complessità e ambiguità di ogni produzione culturale. È il rapporto fra gli algoritmi, con tutto il loro rigore formale, e la duttile realtà che sta innanzi allo storico.

La problematicità di questo rapporto si verifica, del resto, non appena si proceda alla memorizzazione di un testo: la sua trascrizione su supporto magnetico per essere elaborato dalla memoria del calcolatore comporta anzitutto stabilire cosa si intenda per unità lessicale; decisione mai amorfa, anche quando si stabilisca di considerare 'unità' il tratto grafico continuo, separato da altri tratti mediante spazi bianchi o segni di interpunzione, perché diversi sono alcuni usi scrittòri o editoriali (quamobrem è unità lessicale o tre unità quam ob rem; manuducere un'unità, o manu ducere due). Una volta memorizzato un testo - con le codifiche cui si è fatto cenno e con quelle concernenti le classificazioni grammaticali, morfologiche e sintattiche - si potranno ottenere indici e concordanze per forme. Un ulteriore passo, che sembra ormai necessario, è la lemmatizzazione, che impone di sciogliere le ambiguità del testo passando spesso, quasi inavvertitamente, da una lemmatizzazione formale (morfologica e sintattica) a una lemmatizzazione semantica, non esente da problemi per il valore diverso che una forma flessa può avere rispetto al lemma di base (per es. gli 'ottoni', strumenti musicali, da distinguere da 'ottone' lega metallica), per le diverse funzioni sintattiche di una parola (aggettivi sostantivati, verbi in funzione di nome, participi in funzione di sostantivi ecc.), per i problemi posti dalle omografie e dalle allografie, dai nomi propri e comuni (christus: unto, Christus: il Verbo incarnato, sono da distinguere?), dagli usi metaforici ('luci' per 'occhi'), dalle variazioni diacroniche e dalle stesse difformi grafie di un medesimo termine nel corso di un medesimo testo (difformità che la più accorta filologia conserva, contro l'uso di uniformare secondo astratti canoni normativi).

Si dovrà insistere sul carattere non meramente meccanico di queste operazioni: il testo trascritto nel calcolatore non è semplice copia dell'originale; è un testo trasposto dal linguaggio naturale al linguaggio di macchina, ove alle lettere dell'alfabeto si sostituisce un sistema binario che impone assoluta univocità (Mordenti 1994). In questo passaggio, il testo con tutte le sue informazioni non ha più come destinatario un lettore che spontaneamente utilizza criteri semantici; ma deve 'parlare' a un automa deterministico ove l'algoritmo impone passaggi certi e univoci per configurazioni successive e di numero finito.

In questa trasposizione e memorizzazione - che subito si manifesta come processo di interpretazione - l'intesa reciproca della codifica e del programma è determinante: esistono programmi sordi ai segnali del testo codificato e codifiche mute rispetto alle potenzialità dei programmi. Peraltro è necessario preliminarmente prevedere nel modo più completo e analitico le forme e gli obiettivi del trattamento di un testo, perché la macchina risponderà solo a quesiti previsti in sede di memorizzazione, cioè di codifica. Ma, com'è noto, non esiste un codice unico, universale non solo a livello di macchina, ma come outillage mentale di un ricercatore o di un'epoca.

A livello di codifica e di programma esiste una vera babele informatica, giacché non solo le grandi società ma anche i singoli ricercatori elaborano spesso programmi personali non compatibili fra loro, usando codici di memorizzazione proprietari, senza la preoccupazione di renderne possibile l'accesso a terzi. Si potrebbe parlare di formule segrete, quasi si trattasse di una nuova magia, la magia dell'informatica.

Ma anche se si utilizzano programmi standard, la loro applicazione è sempre condizionata dall'outillage mentale del ricercatore che codifica il testo: qui la situazione si fa ancor più complessa perché il codificatore nelle sue scelte è condizionato dalla situazione storica, dalle metodologie critiche, dagli orientamenti culturali, dai gusti personali e dal suo tempo. Inoltre, se è pressoché impossibile prevedere tutte la future domande di cui il testo memorizzato può essere oggetto, il codificatore deve tuttavia cercare di proporsi il più ampio spettro di interrogativi per codificare nel modo più ricco e flessibile. Per molto tempo, per es., si sono usati i criteri di codificazione che procedevano a una preliminare normalizzazione di un testo, così come si è fatto spesso nello stabilire le edizioni critiche, perdendo realtà segniche e semantiche di estremo rilievo. E se a volte la normalizzazione è giustificata dalle esigenze della codifica e dalla scarsa flessibilità dei programmi, prevale oggi un sempre maggiore interesse a codificare nella maniera più completa i dati testuali.

L'analisi testuale, attraverso le operazioni cui si è fatto cenno, ha come primo e più diffuso risultato gli indici e le concordanze: indici di parole ordinate alfabeticamente o sulla base della frequenza con cui le parole compaiono nel testo e liste di concordanze, ove ogni parola è illustrata dai contesti, forniti in misura più o meno ampia, nei quali essa ricorre. Indici e concordanze (per forme o per lemma) sono strumenti di primaria importanza per individuare gli usi lessicali di un determinato autore o di un complesso di autori e stimolano una lettura diversa, non più continua, ma 'sinottica', di un testo (di grande utilità soprattutto se offrirà la possibilità di periodizzare, in un'opera o in una tranche cronologica, la distribuzione delle forme e dei lemmi). Si tratta di strumenti di lettura e di analisi certamente non nuovi (anzi praticati ampiamente già agli inizi della galassia Gutenberg), anche se il calcolatore permette di controllare una quantità di documenti altrimenti non ordinabile.

Il problema di indicizzare - o, come si diceva nel Cinquecento, intabulare - si pone sistematicamente con l'invenzione della stampa, con la diffusione del libro (dopo le raccolte di loci communes, di parole e concordanze bibliche nella traduzione medievale). Forse Aldo Manuzio fu il primo ad apporre indici ai testi greci e latini già alla fine del Quattrocento, superando anche la difficoltà della mancanza di una paginazione continua, e si può dire che in poco più di mezzo secolo dall'invenzione della stampa si erano già esperite tutte le varie tipologie di indici (per parole, per significati, con contesti ecc.): alla metà del Cinquecento C. Gessner, nel secondo volume della sua Bibliotheca universalis, le Pandectae sive partitiones universales (1548), celebrava l'utilità, anzi la necessità degli indici nelle diverse tipologie, e al principio del Seicento Federico Cesi, il fondatore dell'Accademia dei Lincei, poteva ormai inserire fra le "belle e buone comodità che particolarmente in questo nostro secolo abbiamo per ben studiare", "gli indici e repertori copiosissimi, dittionari, lessici di tutte le professioni".

Oltre agli indici, un altro risultato offerto dagli spogli elettronici, che può essere utilmente applicato alle analisi testuali, è costituito dalle liste di frequenza: ma si tratta di uno strumento di ricerca estremamente problematico e anch'esso mai neutrale, perché dietro l'apparenza rigorosa delle cifre si cela una preliminare costruzione e scelta che rinvia a una più complessa analisi semantica: G.Th. Guilbaud - nel sottolineare le difficoltà e ambiguità che soggiacciono all'analisi delle frequenze - ha dato suggestivi esempi con il solo esame di penser e pensée nel Discours de la méthode di Descartes (Guilbaud 1982).

Inoltre la stessa valutazione delle frequenze come fatto statistico crea problemi: i filologi si sono variamente orientati nell'esame delle frequenze, privilegiando ora le basse (fino agli hapax), ora le alte, altre volte le medie; o ancora privilegiando ora le frequenze delle parole grammaticali, ora delle parole piene. Certo sembra essenziale tener conto dell'attendibilità, dell'omogeneità e delle dimensioni del corpus testuale preso in esame; aver presenti la diversa struttura e finalità di un testo, il suo genere (se, per es., il testo è destinato a un quotidiano di grande tiratura o a una lezione accademica; se si tratta di un romanzo o di una commedia), gli influssi che l'autore può aver subito in un determinato momento (letture, incontri occasionali ecc.), i destinatari (per es. un ente pubblico o una comunità religiosa), l'arco cronologico nel quale è stato composto un testo. Peraltro le frequenze (data per risolta la valutazione di quamobrem in una o tre parole) assumono diverso valore non solo all'interno di un complesso testuale, ma anche nella loro distribuzione (per es. se concentrate, per sequenza iterativa, in una pagina o disperse nel corpus): di qui la necessità di tener conto dell'intervallo che separa un'occorrenza nella sua frequenza in un contesto (perso dalla frantumazione delle occorrenze), e valutare il diverso valore delle frequenze di una singola parola o di unità sintagmatiche. Ma va anche detto che proprio le frequenze possono servire a disporre diacronicamente un processo di composizione, denunciare influenze, individuare citazioni nascoste, interpolazioni, sistemi stilistici e quindi stabilire attribuzioni (anche qui con esiti diversi).

Un passo ulteriore è costituito dall'analisi delle strutture sintattiche e stilistiche dei testi, degli usi e dei significati che una parola assume nei diversi contesti: si passa così da un impiego prevalentemente documentario dei calcolatori, volto principalmente alla costituzione di banche e basi di dati, a un uso più propriamente linguistico (informatica linguistica), che si propone di esaminare la dinamica del linguaggio, i valori semantici delle parole, ricollegando l'informatica alle scienze del linguaggio. Qui soprattutto si rende necessario il costante collegamento fra il testo destrutturato e frantumato in una serie di segni grafici assunti come unità e il complesso delle relazioni che strutturano un testo. In questo delicato e complesso settore delle analisi strutturali si possono individuare o intravedere nuovi possibili usi del calcolatore nel lavoro critico-testuale ed ermeneutico, realizzando le sue nozze con la filologia, imponendo a quest'ultima - cioè alla lettura dei testi - un assoluto rigore e ricevendone in cambio flessibilità e duttilità. Resta tuttavia ineludibile lo scarto fra 'modello', o algoritmo, e realtà, che non sembra superabile, se non a patto di tornare alla realtà abbandonando il modello o risalire all'idea presente sul cosmo intelligibile di platonica memoria.

Altre ancora le nuove frontiere dell'informatica, più ampie e ambiziose: è sufficiente pensare a campi di applicazione come quello del riconoscimento automatico delle immagini e dei caratteri grafici o del linguaggio parlato. Un rinnovato interesse appare anche rivolto alla traduzione automatica, problema annoso per il quale sembrano dischiudersi nuove possibilità di soluzione.

Contemporaneamente lo sviluppo crescente delle reti informatiche aumenta smisuratamente la disponibilità di testi memorizzati, variamente manipolabili. Anche qui, di fronte alle nuove e dinamiche banche dati - testuali, lessicali ecc. - da un lato torna a proporsi l'interrogativo sui metodi di codifica, sull'attendibilità stessa dei dati messi a disposizione da soggetti diversi, dall'altro si impone la necessità di metodi che semplifichino l'utilizzazione dei dati. Se non si giunge a un pacifico accordo su alcuni principi, la massa dei dati rischia di travolgere e fuorviare i ricercatori che vengono a trovarsi in una smisurata biblioteca virtuale fatta di fogli sparsi e lacerti testuali.

Questi problemi sono accentuati - e per alcuni aspetti avviati a soluzione - dalla rapida estensione di Internet, 'madre di tutte le reti'. Qui le procedure di codifica delle situazioni testuali hanno guadagnato in generalità. Per trasmettere pagine Web sempre più complesse e accurate dal punto di vista grafico, si è reso necessario mettere a punto veri e propri linguaggi di descrizione dei contenuti testuali e delle loro proprietà tipografiche (i cosiddetti linguaggi di markup), che tendenzialmente possono sostituire le tecniche di codifica finora adottate dai singoli produttori di testi in formato elettronico. Tuttavia una codifica HTML (HyperText Markup Language) non offre oggi tutta la ricchezza 'espressiva' propria dei sistemi tradizionali, più specializzati e sperimentali; né sembra facile aggiungere a tali linguaggi nuove specificazioni e pervenire a uno standard che valga a ridurre l'eterogeneità degli approcci e la babele dei metodi di codifica.

Ma un altro aspetto meriterebbe di essere sottolineato, relativamente alle architetture e alle tecniche di gestione dei grandi archivi testuali: in questo campo la rete ha operato come un fattore di riduzione della complessità e di standardizzazione delle tecniche, che si sono formate in rapporto alla crescita della quantità dei dati da governare in rete. Le banche tradizionali riunivano in un ambiente operativo compatto sia i testi, ridotti di solito a un formato interno proprietario, sia il complesso delle chiavi destinate alle funzioni di ricerca. Per massimizzare la velocità di reperimento, il software scaricava e delimitava ciò che poteva servire alla modifica e all'aggiornamento dei dati testuali. La chiave di volta del cambiamento è stata la netta separazione dei documenti da una parte, facilmente manipolabili nel loro formato nativo, e dei 'motori di ricerca' dall'altra, capaci di raccogliere le chiavi d'accesso da milioni di siti e di restituire il documento sulla base di un linguaggio di interrogazione ormai quasi universale. Mentre si implementano nei motori anche logiche probabilistiche e 'approssimative' di ricerca ('date tali chiavi, il documento x ha il 70% di probabilità di essere pertinente'), non va dimenticato che anche qui il progresso si basa su una semplificazione che ha i suoi limiti: la confusione di 'parole' e 'cose' nel Web rende problematico anche un semplice esame cursorio degli argomenti di ricerca disponibili e rende quasi impossibile trarre vantaggio da logiche di ricerca ancorate a determinate tipologie di chiavi.

Da questi spunti di riflessione emerge anzitutto una prima considerazione: l'uso del computer non è puramente strumentale, non è la semplice applicazione di una nuova tecnologia a tradizionali forme di scrittura testuale e di lettura lineare: l'informatica, al di là dello strumento, impone un metodo di analisi e di ricerca. Si può, per es., rinviare da un lato al rigore del sistema di codifica che impone di scoprire e di rilevare le "tassonomie semiclandestine dei testi scritti" (Avalle 1985), dall'altro alla messa in crisi del concetto stesso di testo, per la radicale differenza fra testo cartaceo e testo informatizzato, "sganciato dalle tecnologie della stampa" e ridotto a duttile sequenza di informazioni codificate in sistema binario e rese sempre più complesse nel rapporto testo-ipertesto alla cui stesura - sempre aperta - possono contribuire autori diversi (Mordenti 1994). Nuovi problemi nascono per la critica testuale, la quale per un verso può ricostruire più facilmente nella sua diacronicità la generazione di un testo, e sovrapporre le successive redazioni e varianti, dall'altro vede scomparire la generazione stessa dei testi, perché la scrittura elettronica - portata di fatto a cancellare e distruggere ciò che è stato corretto - ci conduce a conoscere solo le stesure finali. Al foglio con cancellature e ritocchi si sostituisce il disco pronto per la stampa. Se poi non fosse stampato, diventerebbe in breve tempo illeggibile per l'obsolescenza dei codici di memorizzazione e degli strumenti di decodifica.

Questa obsolescenza investe tutto il problema dell'uso dei calcolatori e della conservazione delle memorie: si verifica ormai una divaricazione radicale fra il gigantismo delle memorie informatiche capaci di gestire dati altrimenti non controllabili, e il rapido mutamento dei sistemi di codifica e degli strumenti tecnici di decodifica, ossia di lettura. Chi abbia lavorato vent'anni fa con nastri, sa che oggi essi non sono più leggibili. L'informazione rende i testi in qualche modo estremamente volatili e incerti per quanto riguarda la loro conservazione: ed è un problema che ricercatori e istituzioni dovranno affrontare se non si vuole che questi grandi strumenti di lettura e di analisi diventino un luogo ove le memorie si perdono e non si conservano.

Si dovrà tuttavia riconoscere che le nuove strumentazioni informatiche non sono solo un sussidio per la memoria, ma sono interlocutori attivi nell'imporre scelte, nel richiedere un metodo più rigoroso non solo nell'analisi testuale ma anche nella storia delle idee.

Se è vero infatti che le idee non vivono in un mondo iperuranio, che non si diffondono per verginale partenogenesi, ma esistono solo incarnate in segni e strutture semantiche e - per quel che più direttamente qui interessa - nel linguaggio, realtà mutevole o ambigua, allora ogni strumento e metodo di analisi che permetta di coglierne le costanti e le varianti, gli usi storicamente diversi, diviene strumento critico di fondamentale importanza. Non vanno perseguiti miti di obiettiva ricostruzione filologica e storica: si è insistito nel sottolineare lo scarto fra linguaggio naturale e modellizzazione informatica, ma proprio questa modellizzazione porta ad affrontare problemi forse mai consapevolmente percepiti e offre rigorosi strumenti di analisi e di trattamento di dati testuali. Ciò non significa che sia risolta la tensione fra i più raffinati mezzi di ricerca e la realtà storica sfuggente e ribelle: ma è proprio di questa tensione che vive il mestiere dello storico.

bibliografia

La pratique des ordinateurs dans la critique des textes, Éditions du Centre national de la recherche scientifique, Paris 1979.

G.Th. Guilbaud, Fréquences et probabilités, in U. Berni Canani et al., L'analisi delle frequenze. Problemi di lessicologia, a cura di M. Fattori, M. Bianchi, Roma 1982, pp. 39-61.

D'A.S. Avalle, I canzonieri: definizione di genere e problemi di edizione, in La critica del testo. Problemi di metodo ed esperienze di lavoro, Atti del convegno: Lecce 22-26 ottobre 1984, Roma 1985, pp. 363-82.

R. Busa, Fondamenti di informatica linguistica, Milano 1987; Studi di codifica e trattamento automatico di testi, a cura di G. Gigliozzi, Roma 1987.

Computer in den Geisteswissenschaften. Konzepte und Berichte, hrsg. M. Thaller, A. Müller, Frankfurt a.M.-New York 1989.

Trattamento, edizione e stampa di testi con il calcolatore, a cura di G. Adamo, Roma 1989.

T. Orlandi, Informatica umanistica, Roma 1990.

Informatica e scienze umane. Lo stato dell'arte, a cura di L. Gallino, Milano 1991.

I. Lancashire, The humanities computing yearbook 1989-90. A comprehensive guide to software and other resources, Oxford 1991.

C. Segre, Due lezioni di ecdotica, Pisa 1991; Computers and written texts, ed. C.S. Butler, Oxford-Cambridge (Mass.) 1992.

G.P. Landow, Hypertext. The convergence of contemporary critical theory and technology, Baltimore-London 1992 (trad. it. Ipertesto. Il futuro della scrittura, a cura di B. Bassi, Bologna 1993).

G. Adamo, Bibliografia di informatica umanistica, Roma 1994.

M. Lana, L'uso del computer nell'analisi dei testi, Milano 1994.

L. Lebart, A. Salem, Statistique textuelle, Paris 1994.

L'eclisse delle memorie, a cura di T. Gregory, M. Morelli, Roma-Bari 1994.

F.A. Marcos Marín, Informática y humanidades, Madrid 1994.

R. Mordenti, Filologia e computer, in Macchine per leggere. Tradizioni e nuove tecnologie per comprendere i testi, a cura di C. Leonardi, M. Morelli, F. Santi, Spoleto 1994, pp. 53-68.

Fabula in tabula. Una storia degli indici dal manoscritto al testo elettronico, a cura di C. Leonardi, M. Morelli, F. Santi, Spoleto 1995.

T. Orlandi, Alla base dell'analisi dei testi: il problema della codifica, in Scrivere comunicare apprendere con le nuove tecnologie, Atti del Convegno, Accademia Nazionale dei Lincei: Roma 8 ottobre 1991, a cura di M. Ricciardi, Torino 1995, pp. 69-86.

L. Perilli, Filologia computazionale, Roma 1995.

Album. I luoghi dove si accumulano i segni (dal manoscritto alle reti telematiche), a cura di C. Leonardi, M. Morelli, F. Santi, Spoleto 1996.

Discipline umanistiche e informatica. Il problema della formalizzazione, a cura di T. Orlandi, Roma 1997.

G. Gigliozzi, Il testo e il computer, Milano 1997.

Modi di scrivere. Tecnologie e pratiche della scrittura dal manoscritto al CD-ROM, a cura di C. Leonardi, M. Morelli, F. Santi, Spoleto 1997.

Time & bits: managing digital continuity, ed. M. MacLean, B.H. Davis, J. Paul Getty Trust, Los Angeles 1998.