Neuroscienze computazionali

Neuroscienze computazionali

In questo testo sarà illustrata una famiglia di modelli che formalizzano idee e ipotesi sulla logica che presiede alla formazione di rappresentazioni cognitive dell'ambiente in cui un organismo vive e apprende, e sulla cui base il cervello prende decisioni. Tali rappresentazioni devono assicurare, a seconda del contesto, la capacità di discriminare finemente segnali sensoriali, o piuttosto di raggruppare stimoli simili in classi e memorizzare la classificazione per un uso successivo. I modelli che verranno trattati mirano a descrivere funzioni quali la memoria e l'apprendimento come proprietà 'emergenti' espresse dal sistema-cervello e derivanti dai modi in cui un numero enorme di unità elementari (neuroni) interagiscono (attraverso sinapsi) in una rete fittamente interconnessa; nessuna di queste unità corrisponde a un 'atomo' del pensiero, così come non ci sono molecole 'vive', ma solo 'sistemi' che danno luogo in modo cooperativo alle caratteristiche della vita. In questi modelli, sia l'azione dello stimolo (in generale, dell'interazione con l'ambiente) sul cervello, sia la risposta allo stimolo stesso sono codificate attraverso l'attività dei neuroni coinvolti, in base alla quale si definisce lo stato del sistema. La capacità di classificazione di cui abbiamo detto si esprime nel fatto che i diversi stimoli che definiscono una classe evocano stati di attività neuronale simili (vale a dire la stessa risposta).

Non si impone inoltre una struttura 'topografica' alla distribuzione dei neuroni e delle sinapsi nel modello, sulla base del fatto che, se da un lato macroaree corticali sono disposte in modo riproducibile in individui della stessa specie, dall'altro l'organizzazione delle rappresentazioni neuronali al loro interno appare variabile in funzione dell'esperienza individuale e del modo in cui la rete neuronale sfrutta la sua plasticità per organizzarsi di conseguenza. La validità di un modello dipende dall'identificazione del livello ottimale di semplificazione, tale cioè da descrivere la fenomenologia di interesse mantenendosi abbastanza semplice da consentirne l'analisi. Nelle fasi iniziali, spesso l'efficacia del modello deriva da una 'sovrasemplificazione', che serve a mettere a punto idee e tecniche; quindi si cerca di migliorare l'aderenza con l'oggetto di studio reale. Così, in fisica trascurare l'attrito ha permesso lo sviluppo iniziale della meccanica, sebbene senza di esso sarebbero impossibili le relazioni tra i corpi in movimento che l'esperienza ci fornisce. Saranno di seguito analizzate alcune applicazioni di un simile approccio alla modellistica del sistema nervoso.

Principî teorici di base

Il primo elemento essenziale dei modelli computazionali è la relazione non lineare tra input e output del singolo neurone, che prende forme diverse a seconda del tipo di descrizione: (a) una non linearità a soglia, vale a dire il neurone a ogni istante si trova in uno stato quiescente o attivo (cioè con emissione di potenziali d'azione, o spike) a seconda che la somma degli input derivanti dall'attività di altri neuroni, 'pesati' con i corrispondenti valori di 'efficacia sinaptica', si trovi rispettivamente al di sotto o al di sopra di una certa soglia; (b) una non linearità di tipo sigmoide, in cui l'output continuo del neurone, analogico, si interpreta come la frequenza media di emissione di spike, dovuta alla media pesata degli input; (c) per i modelli in cui il 'livello di attività' si descrive esplicitamente in termini della sequenza di spike emessi, una relazione non lineare tra la frequenza di spike in input al neurone, e la sua frequenza di emissione di spike.

L'altro elemento essenziale dei modelli è stato fin dai primi sviluppi l'ipotesi che l'apprendimento (→ Apprendimento. Basi biologiche; Apprendimento. Basi molecolari) genericamente inteso (per es., la classificazione associativa di un insieme di stimoli o la realizzazione di una specifica 'regola' di associazione input-output) sia reso possibile da modifiche delle efficacie sinaptiche indotte in qualche modo (supervisionato o meno, locale o meno, ecc.) dagli stimoli. I modelli di reti neuronali fondati su questi ingredienti di base si sono storicamente articolati in almeno due filoni: quello, in gran parte originato dal lavoro di John J. Hopfield (1982) e sviluppato inizialmente soprattutto dai fisici, che ambiva a caratterizzare una dinamica neuronale in grado di dar corpo alla suggestiva ipotesi formulata da Donald Hebb (1949) sulla plasticità sinaptica indotta dall'attività neuronale; e quelli, originati soprattutto nell'ambito della psicologia cognitiva, che miravano a catturare e caratterizzare (come proprietà collettiva del sistema interagente di neuroni) la logica computazionale sottesa a funzioni cognitive complesse come, per esempio, la declinazione dei verbi o i disordini neuropsicologici della categorizzazione.

I modelli del primo tipo possono essere considerati come bottom-up: si mantiene un controllo concettuale forte sul legame tra gli oggetti formali del modello e le controparti biologiche e si cerca di identificare in modo sperimentalmente falsificabile la scala rilevante per i processi dinamici emergenti descritti dal modello. L'ambito sperimentale di riferimento è la neurofisiologia e le funzioni cognitive umane complesse rimangono più un contesto di motivazione e di riferimento prospettico che un terreno di confronto quantitativo. I modelli del secondo tipo, malgrado il dichiarato obiettivo di estrarre comportamenti complessi come proprietà emergenti del sistema, si possono considerare come approcci top-down. In effetti, l'identificazione del livello pertinente di descrizione in questi modelli ha lasciato spazio a una certa ambiguità nell'interpretazione. È chiaro, per esempio, che funzioni complesse come quelle linguistiche integrano un sistema di aree corticali interagenti, solo sommariamente caratterizzato a livello macroscopico e in larga parte da scoprire in termini microscopici. Un modello top-down di questo tipo (spesso definito 'connessionistico') possiede in generale un'architettura a strati, il primo dei quali descrive un insieme di neuroni sensoriali e l'ultimo una popolazione neuronale la cui attività è osservabile dall'esterno come output del sistema; i neuroni degli strati intermedi sono 'nascosti' e codificano, attraverso modifiche nelle efficacie sinaptiche delle loro connessioni, la specifica corrispondenza input-output richiesta (esistono molte varianti di questa architettura di base, che possono includere rami di feedback).

Nell'insieme, un modello top-down tipico può includere da poche decine a qualche centinaia di neuroni. Questo dato quantitativo non è di poco conto. Per esempio, la caratterizzazione del singolo neurone del modello mediante la funzione input-output sigmoide, per quanto rudimentale, ha senso se si pensa effettivamente di poter stabilire una corrispondenza tra le singole unità neuronali del modello e i neuroni di corrispondenti popolazioni identificate. Se, come accade inevitabilmente per una modellistica di funzioni cognitive complesse, la singola unità del modello deve rappresentare popolazioni neuronali di dimensioni macroscopiche, o perfino intere aree corticali, la plausibilità e il senso di una specifica relazione input-output appaiono problematici. D'altra parte, questi modelli connessionistici si sono dimostrati efficaci nell'adattare architetture neuronali generiche a molti compiti diversi e nel 'generalizzare', cioè inferire una regola a partire dagli esempi della regola stessa utilizzati per l'apprendimento. Forse anche come riflesso della progressiva divergenza di queste due categorie di modelli, si è recentemente affermata la consuetudine di adottare per essi una terminologia diversa: modelli di neuroscienza computazionale per i primi, modelli di reti neuronali per i secondi; questi ultimi, più recentemente, hanno originato un filone florido e indipendente di carattere statistico-applicativo, che a pieno diritto si colloca tra la statistica multivariata e le tecniche di machine learning.

All'interno della categoria dei modelli bottom-up è forse utile operare un'ulteriore distinzione tra modelli descrittivi e modelli dinamici. In entrambi i casi uno degli obiettivi principali è la comprensione del codice che il cervello adotta per sviluppare rappresentazioni del mondo in termini di attività neuronali (sequenze di spike), componendole ed elaborandole per scopi specifici. Definendo alcuni modelli come 'descrittivi', vogliamo indicare che non si tenta una modellizzazione dei meccanismi di interazione tra i neuroni che danno luogo a una certa attività, ma si cerca 'soltanto' di caratterizzare il codice che i neuroni utilizzano per scambiarsi informazioni, tipicamente con gli strumenti della teoria dell'informazione. Nei modelli che chiameremo 'dinamici' si cerca invece di costruire ipotesi quantitative sui modi in cui le interazioni tra neuroni semplificati generano dinamiche collettive correlabili a situazioni di interesse neurofisiologico e di formulare, sulla base di esse, predizioni verificabili sperimentalmente. Nella costruzione di questi modelli le conoscenze disponibili sulla biofisica di singoli neuroni e sinapsi vengono integrate con i dati sperimentali sull'attività di popolazioni neuronali in specifiche condizioni. Il punto di forza di questi modelli risiede nella capacità di generare predizioni; vi è però la difficoltà di individuare il livello appropriato di semplificazione dei singoli elementi neuronali e sinaptici, che deve permettere una trattazione analitica del problema e/o la simulazione di modelli su larga scala, conservando al contempo gli elementi biofisici essenziali ai fini del comportamento collettivo di grandi popolazioni di neuroni interagenti.

Prima di fornire qualche dettaglio sui modelli di tipo bottom-up di cui ci occuperemo, bisogna sottolineare che la costruzione di un buon modello non equivale di per sé alla formulazione di una teoria. Anche se disponessimo di modelli e simulazioni al computer molto più dettagliati e realistici di quelli oggi disponibili, non è chiaro se ciò migliorerebbe necessariamente la nostra comprensione del funzionamento del cervello, né se il maggior realismo renderebbe più facilmente intellegibili principî generali. Una teoria è, naturalmente, una struttura logica che lega tra loro in modo necessario gli elementi che i modelli possono contribuire a identificare, in grado di svelare principî generali di computazione e di rappresentazione e di contribuire realmente all'eterno dibattito sul 'rapporto mente-cervello'.

Un modello classico di neurone

Il modello di neurone integrate-and-fire (IF), la cui formulazione originaria risale agli inizi del secolo scorso, grazie alla sua semplicità e flessibilità è tuttora il più utilizzato nella modellistica di grandi sistemi di neuroni. Il modello IF realizza una drastica semplificazione delle proprietà sia attive sia passive del neurone, che è presentato innanzitutto come oggetto 'puntiforme', il cui stato è completamente descritto dal valore istantaneo del potenziale di membrana V; l'intera cellula è quindi considerata 'equipotenziale' e se ne ignora la complessa struttura spaziale, in particolare quella dell'albero dendritico. Nel caso più semplice, l'input sinaptico viene descritto da una successione di impulsi di corrente con ingresso diretto nel soma del neurone; ogni impulso provoca una variazione istantanea del potenziale di membrana, determinata dall'efficacia della corrispondente sinapsi, in forma di depolarizzazione per un input eccitatorio e di iperpolarizzazione per un input inibitorio. A completare la descrizione delle proprietà passive nel neurone IF si introduce un termine di 'perdita', che riassume i contributi di corrente dovuti al mantenimento degli equilibri ionici attraverso la membrana in assenza di spike in ingresso. La caratteristica 'attiva', e cioè la generazione dello spike, viene incorporata nel modello come una condizione a soglia su V: quando V raggiunge una soglia prefissata θ il neurone IF 'emette' convenzionalmente uno spike e il potenziale di membrana V viene riportato a un valore determinato H dal quale, eventualmente dopo un 'periodo refrattario', il neurone ricomincia a integrare la corrente in input.

La teoria si basa sull'ipotesi, considerata in genere valida per condizioni corticali realistiche, secondo la quale gli intervalli di tempo tra gli spike (ISI, Inter-spike-intervals) afferenti al neurone sono soggetti a fluttuazioni casuali. In effetti le osservazioni sperimentali mostrano spesso, in registrazioni di attività corticale in vivo, ISI molto irregolari. La corrente totale afferente al neurone, I(t), diventa quindi una sovrapposizione di processi stocastici puntuali (assunti, con buona approssimazione, come indipendenti). Nelle condizioni tipiche di interesse, risultati noti nella teoria della probabilità garantiscono che la I(t) può essere descritta da un processo stocastico con statistica di Poisson; ciò assicura che i risultati che seguono hanno validità in un'ampia gamma di situazioni. Il potenziale di membrana V(t) è un processo stocastico (perché stocastica è la corrente afferente) e caratterizza completamente la dinamica del neurone IF; esso è costituito da una serie di variazioni istantanee, corrispondenti ai tempi di ricezione degli spike presinaptici (distribuiti con buona approssimazione secondo una statistica di Poisson), e da una serie corrispondente di decadimenti deterministici tra due spike successivi, dettati dalla forma del termine di perdita. Se il decadimento è esponenziale, il processo è detto 'di Stein'.

La trattazione si può notevolmente semplificare introducendo la cosiddetta 'approssimazione di diffusione', che trasforma il processo discreto appena descritto in un processo continuo di diffusione. Tralasceremo i dettagli, menzionando solo la considerazione intuitiva per cui, se in un intervallo di tempo piccolo rispetto al tempo di integrazione del neurone quest'ultimo riceve un numero elevato di input presinaptici e ognuno di questi provoca variazioni del potenziale di membrana piccole rispetto alla soglia di emissione, I(t) risulta di fatto assimilabile a un processo stocastico continuo. Sotto queste ipotesi, il processo di Poisson I(t) tende a un processo gaussiano senza memoria ('rumore bianco') e, come tale, completamente definito dalla media e dalla varianza infinitesimali, μ e σ2. Di conseguenza, per una data realizzazione del processo I(t), il potenziale V(t) evolve secondo una 'equazione di Langevin' (mutuando la terminologia dalla teoria del moto browniano in fisica); il processo stocastico V(t) è descrivibile da una densità di probabilità dipendente dal tempo p(v,t), e pertanto all'equazione di Langevin per l'evoluzione di una singola realizzazione del processo V si può far corrispondere un'equazione per l'evoluzione della densità di probabilità p(v,t) (equazione di Fokker-Planck): la soglia θ di emissione dello spike è una 'barriera assorbente' per il processo.

Il neurone IF, indipendentemente dai dettagli del modello, può operare in due regimi dinamici nettamente distinti, che chiameremo 'dominati dal segnale' (SD, Signal-dominated) e 'dominati dal rumore' (ND, Noise-dominated). Nel primo caso, il valore medio della corrente I(t) è sufficiente da solo a provocare l'emissione di spike (per μ costante e σ2=0 si ha una sequenza periodica). In questo caso la presenza di fluttuazioni (σ2>0 e non troppo grande) rappresenta solo una correzione al comportamento deterministico: l'istogramma degli ISI è molto stretto intorno al valore deterministico. Nel regime ND le fluttuazioni sono invece una componente essenziale della dinamica; il valore medio della corrente afferente è sotto soglia e il neurone può emettere spike solo grazie a occasionali fluttuazioni che portano V sopra soglia. In questo regime gli ISI fluttuano molto e la loro distribuzione è tipicamente vicina a quella esponenziale caratteristica di un processo di Poisson.

È naturale chiedersi in che misura il modello IF descritto sia un buon modello del neurone biologico. L'adeguatezza del modello dipende dalla precisazione del suo fine ultimo, che è appunto l'analisi di popolazioni neuronali. Certamente una caratteristica peculiare e notevole del sistema nervoso è la natura fortemente stereotipata dei messaggi scambiati tra le cellule che lo compongono, gli spike: qualunque sia il codice attraverso il quale i neuroni si scambiano informazioni, l'alfabeto che essi usano è universale e semplice. Non è irragionevole, quindi, assumere che il neurone IF sia un buon modello nella misura in cui le proprietà statistiche delle sequenze di spike generate dal modello riproducono accettabilmente quelle dei neuroni reali per input realistici. Esperimenti recenti in cui una corrente stocastica veniva iniettata in neuroni corticali in vitro hanno dimostrato che il neurone IF riproduce in modo abbastanza soddisfacente le relazioni statistiche tra corrente di input e frequenza di spike in output osservate sperimentalmente.

Plasticità sinaptica e memoria

Sebbene esistano diversi tentativi di modellizzazione dettagliata della giunzione sinaptica chimica, ai fini della costruzione di modelli di apprendimento e memoria in popolazioni neuronali ci concentreremo su descrizioni molto semplificate e astratte di plasticità sinaptica a lungo termine, che sono state sviluppate soprattutto sotto l'influenza della suggestiva ipotesi avanzata da Hebb alla fine degli anni Quaranta. Hebb ‒ che era uno psicologo e non un neurofisiologo ‒ si era convinto che la relazione stimolo-risposta, frutto dell'elaborazione neuronale, non si potesse concepire nei termini di una specie di 'filtro istantaneo', ma che fosse necessario un meccanismo nervoso centrale per spiegare quel ritardo tra stimolo e risposta che sembra così caratteristico del pensiero. Hebb concepì, probabilmente per primo, l'idea che una 'attività riverberante' innescata dallo stimolo potesse dar conto del ritardo tra stimolo e risposta.

La questione del 'ritardo' spesso coinvolto nello svolgimento di un compito mentale è rimasta di centrale importanza e fonte di ispirazione nella riflessione sui meccanismi di funzionamento del sistema nervoso. Una serie di affascinanti esperimenti ha messo in luce in modo sistematico un aspetto particolare del problema: la cosiddetta 'memoria di lavoro', il meccanismo cioè che rende attiva un'informazione al fine di utilizzarla per uno scopo contingente. Si può trattare di un'informazione acquisita al momento o recuperata per l'occasione dal deposito della memoria a lungo termine (se dobbiamo eseguire a mente un'addizione, le singole cifre in quanto tali sono già stabilmente acquisite nella nostra memoria, ma il dover tenere provvisoriamente a mente il riporto pone la cifra corrispondente in un temporaneo stato attivo; lo stesso vale per un numero telefonico che dobbiamo temporaneamente memorizzare per comporlo poco dopo).

La proposta originaria di Hebb postulava l'esistenza di un meccanismo a doppia traccia: la 'riverberazione', come meccanismo a breve termine, e la modificazione dei valori di efficacia sinaptica, come traccia della memoria a lungo termine. Il legame tra i due livelli era enunciato assumendo che la persistenza o la ripetizione di un'attività riverberante (o 'traccia') tende a indurre modifiche cellulari durature che accrescono la sua stabilità. Hebb andò oltre, enunciando il meccanismo che porta il suo nome, per cui la contemporanea e ripetuta attivazione di due neuroni tende ad aumentare l'efficacia della sinapsi che li connette. Hebb ipotizzò che la memoria a lungo termine si costituisca in base a un meccanismo locale (nello spazio e nel tempo): ogni sinapsi modifica la sua efficacia in conseguenza della coattivazione dei neuroni che essa connette e nulla 'sa' di ciò che avviene nel resto della rete. Nello stesso tempo, il meccanismo a breve termine attraverso il quale questa memoria si esprime è 'distribuito': uno stimolo familiare (grazie all'insieme dei valori di efficacia sinaptica che la sua ripetuta presentazione ha indotto) innesca un processo dinamico che si autosostiene per effetto del feedback elevato: una riverberazione.

Anche se la proposta di Hebb rimane a un livello logico-funzionale, essa ha costituito una bussola per l'interpretazione dei dati relativi alle modificazioni sinaptiche. In particolare, la scoperta del potenziamento a lungo termine (LTP, Long term potentiation) e della depressione a lungo termine (LTD, Long term depression) nell'ippocampo e della sua natura 'associativa' ha spinto molti a ritenere che si fosse trovato il correlato neurobiologico del meccanismo proposto da Hebb. Il potenziamento sinaptico basato sul meccanismo di LTP, e quindi sulla coattivazione dei neuroni pre- e postsinaptici, è stato tradizionalmente trasferito nei modelli in termini di frequenze medie di emissione dei due neuroni in questione, assumendo la sinapsi potenziata quando entrambe le frequenze sono elevate. Questa formulazione costituisce tuttora una valida ipotesi di lavoro in grado di generare predizioni interessanti. Sono stati proposti anche modelli di plasticità sinaptica che sintetizzano i due fenomeni di LTP e LTD in un'unica dipendenza funzionale della variazione di efficacia sinaptica dalle frequenze medie pre- e postsinaptiche. Nello stesso tempo, risultati recenti sulla spike-timing dependent plasticity hanno stimolato un intenso impegno teorico per sviluppare modelli alternativi (o integrativi) di LTP e LTD. Gli scenari di apprendimento cui accenneremo sono conformi alla formulazione hebbiana della plasticità sinaptica basata sulle frequenze di emissione pre- e postsinaptica.

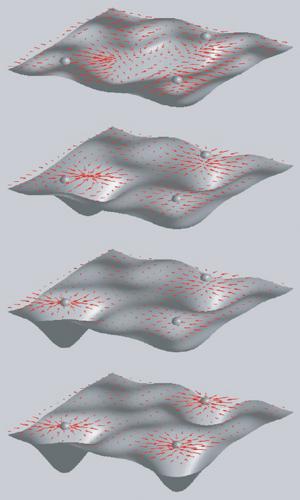

Il modello di Hopfield ha rappresentato un passo fondamentale nella formalizzazione del paradigma hebbiano, con la proposta di identificare gli stati di memoria con gli attrattori puntiformi della dinamica con feedback in una rete di neuroni. Per comprendere meglio la logica del modello è utile rifarsi alla metafora del paesaggio, in cui la dinamica della rete è analoga al rotolare di una palla in un paesaggio di valli e alture; la forma del paesaggio è determinata dall'interazione tra i neuroni, e cioè dall'insieme delle efficacie sinaptiche che, nella metafora fisica, diventano gli accoppiamenti che mediano l'interazione tra i gradi di libertà del sistema (i neuroni). Ogni punto del paesaggio corrisponde a una configurazione (stato di attività) della rete e la tendenza ad andare verso il basso è una conseguenza della dinamica neuronale; ogni fondovalle corrisponde a uno stato di equilibrio (attrattore) dove confluiscono tutti gli stimoli (condizioni iniziali della rete) che sono nel suo bacino di attrazione, ovvero che appartengono alla stessa classe. Lo stato a fondovalle costituisce una rappresentazione interna della classe. La struttura sinaptica determina l'altitudine del paesaggio in ogni punto e contiene l'informazione sull'ubicazione dei fondovalle e sulle dimensioni dei bacini di attrazione. A sua volta la struttura sinaptica viene costruita come risultato dell'apprendimento e dunque dipende dalla struttura degli stimoli presentati (fig. 2).

Il modello di Hopfield dà una prescrizione per la struttura sinaptica tale da generare un paesaggio con le proprietà desiderate. I neuroni hanno due stati (+1, −1), che corrispondono, rispettivamente, ad alta frequenza di emissione e a uno stato quiescente. Una rete di N neuroni di questo tipo può avere 2N stati differenti, e questa è la dimensione dello spazio nel quale è immerso il paesaggio. Ogni stato della rete è dunque una 'parola' a N bit; tali saranno in particolare gli stimoli (implicitamente identificati con gli stati di attività da loro indotti nella rete). Data una configurazione sinaptica, la dinamica neuronale procede con il calcolo, per ogni neurone, della somma degli stati degli altri neuroni, pesati con la corrispondente efficacia sinaptica; se il valore di tale somma pesata supera una soglia prefissata, il neurone passa (o resta) nello stato attivo (+1), altrimenti passa (o resta) in quello quiescente (−1). Per valori di efficacia sinaptica dati (a condizione che questi siano simmetrici, tali cioè che per ogni coppia di neuroni la sinapsi del primo sul secondo sia uguale a quella del secondo sul primo) è possibile definire in ogni punto, per ogni configurazione della rete, una funzione 'energia' del sistema tale che a ogni passo di questa dinamica essa diminuisce; ciò significa che il punto rappresentativo dello stato della rete nel paesaggio scende verso un fondovalle.

Nel modello di Hopfield, dato un insieme di stimoli da memorizzare, la matrice dei valori di efficacia sinaptica si ottiene moltiplicando, per ogni stimolo e per ogni coppia di neuroni, i valori assunti da questi ultimi in corrispondenza dello stimolo in questione e sommando i prodotti ottenuti su tutti gli stimoli da memorizzare. Opportunamente normalizzata, una tale matrice sinaptica garantisce che gli stati neuronali identificati dagli stimoli, se il loro numero non è troppo alto (entro cioè il 'limite di capacità' della rete), siano attrattori della dinamica neuronale (i fondivalle del paesaggio). Questa regola per la costruzione della matrice sinaptica è di tipo hebbiano, in quanto il potenziamento sinaptico dipende dalla contemporanea attivazione dei neuroni pre- e postsinaptici. Al di sotto del limite di capacità, la rete di Hopfield si comporta come una memoria indirizzabile a partire dal contenuto: fissato uno stato iniziale della rete, la dinamica di questa converge verso l'attrattore più vicino. Se consideriamo lo stato iniziale come una versione 'corrotta' del prototipo della classe cui lo stimolo corrispondente appartiene, la rete di Hopfield opera quindi una correzione di errore nel richiamo della memoria associata. Benché il modello di Hopfield non sia molto realistico dal punto di vista neurobiologico, la possibilità di analizzarlo quantitativamente con strumenti analitici tratti dalla meccanica statistica dei sistemi disordinati ne ha fatto un paradigma fecondo e un punto di partenza per un'enorme varietà di sviluppi tecnici e concettuali.

In un modello basato su neuroni IF si deve formulare una dinamica sinaptica che utilizzi i gradi di libertà che il modello neuronale mette a disposizione: gli spike e il potenziale di membrana. È in effetti possibile costruire modelli di sinapsi soggette a una dinamica guidata dagli spike e dalla dinamica del potenziale di membrana del neurone, tale da soddisfare i requisiti richiesti da LTP e LTD. Ci sono però considerazioni di carattere generale sulla dinamica sinaptica che a questo punto vanno fatte. È stato suggerito che una buona ipotesi di lavoro per la costruzione del modello sinaptico sia la natura discreta dell'efficacia sinaptica. Questa 'quantizzazione' si basa sull'ipotesi che qualsiasi dispositivo reale abbia una granularità intrinseca, in altre parole, che non abbia una 'profondità analogica' infinita. Secondo questa proposta la variabile dinamica, che nel modello descrive l'efficacia sinaptica, assume dunque un insieme discreto (e finito) di valori; per semplicità considereremo una sinapsi binaria a due stati (potenziato e depresso), ma le conclusioni che trarremo hanno carattere generale.

Consideriamo una rete in fase di apprendimento. A ogni stimolazione (corrispondente a una specifica distribuzione di attività dei neuroni della rete) ciascuna sinapsi potrà potenziarsi, deprimersi o rimanere invariata a seconda delle attività della coppia di neuroni pre- e postsinaptici, attraverso un meccanismo che per ora lasciamo non specificato, salvo precisare che esso deve realizzare LTP hebbiano e LTD. Nel caso di sinapsi binarie è stato dimostrato che, se a ogni stimolazione ciascuna sinapsi effettua deterministicamente la variazione di efficacia prevista dalla prescrizione di cui sopra, la sua capacità come dispositivo di memoria a lungo termine è molto bassa: per effetto del numero finito di stati sinaptici, la rete tende a perdere troppo velocemente memoria degli stimoli precedentemente memorizzati. La soluzione proposta da Daniel J. Amit e Stefano Fusi (1994) prevede che ogni sinapsi candidata a potenziarsi o a deprimersi compia effettivamente la variazione di efficacia secondo una legge probabilistica, in modo che a ogni stimolazione solo una frazione delle sinapsi candidate a modificare la propria efficacia lo faccia effettivamente. Il prezzo che si paga è che sono necessarie molte presentazioni dello stesso stimolo perché questo venga memorizzato (condizione d'altra parte plausibile), ma la rete si comporta come un buon dispositivo di memoria e le risorse sinaptiche sono equamente distribuite tra gli stimoli memorizzati. In funzione della frazione di neuroni attivata da ogni stimolo, è allora possibile prevedere teoricamente le probabilità di modificazione sinaptica ottimali rispetto alle prestazioni della rete come dispositivo di memoria.

L'apprendimento stocastico appare una soluzione logicamente soddisfacente al problema generale incontrato per reti con sinapsi discrete e deterministiche; rimane però il problema di un meccanismo plausibile che possa agire da sorgente di stocasticità. La soluzione proposta recentemente prevede che la stocasticità richiesta sia prodotta dalla rete stessa attraverso la variabilità dei tempi di emissione degli spike. Per ogni spike presinaptico, la sinapsi subisce una modificazione transitoria verso il potenziamento o la depressione a seconda dello stato del neurone postsinaptico, che però di per sé non è sufficiente a modificare stabilmente l'efficacia della sinapsi; un meccanismo a soglia si incarica di innescare una transizione di LTP o LTD quando un numero sufficiente di modifiche transitorie coerenti si accumula in un breve intervallo di tempo. È dunque disponibile un modello sinaptico che, sebbene sommariamente ispirato ai dati neurobiologici (peraltro ancora non conclusivi), realizza un meccanismo di tipo hebbiano basato sugli spike, e lo fa in modo stocastico per assicurare un impiego ottimale delle risorse sinaptiche.

Bibliografia

Amit 1989: Amit, Daniel J., Modeling brain function, Cambridge, Cambridge University Press, 1989.

Amit 1999: Amit, Daniel J. - Del Giudice, Paolo - Fusi, Stefano, Apprendimento dinamico della memoria di lavoro: una realizzazione elettronica, in: Frontiere della vita, Roma, Istituto della Enciclopedia Italiana, 1999, III, pp. 599-616.

Amit, Fusi 1994: Amit, Daniel J. - Fusi, Stefano, Learning in neural networks with material synapses, "Neural computation", 6, 1994, pp. 957-982.

Dayan, Abbott 2001: Theoretical neuroscience, edited by Peter Dayan, Laurence F. Abbott, Cambridge (Mass.), MIT Press, 2001.

Fusi 2000: Fusi, Stefano e altri, Spike-driven synaptic plasticity: theory, simulations, VLSI implementation, "Neural computation", 12, 2000, pp. 2227-2258.

Gerstner, Kistler 2002: Gerstner, Wulfram - Kistler, Werner, Spiking neuron models, Cambridge, Cambridge University Press, 2002.

Hebb 1949: Hebb, Donald O., The organization of behavior: a neuropsychological theory, New York, Wiley, 1949 (trad. it.: L'organizzazione del comportamento, Milano, Angeli, 1975).

Hopfield 1982: Hopfield, John J., Neural networks and physical systems with emergent selective computational abilities, "Proceedings of the National Academy of Sciences USA", 79, 1982, pp. 2554-2558.

Tuckwell 1988: Tuckwell, Henry C., Introduction to theoretical neurobiology, Cambridge, Cambridge University Press, 1988, 2v.